Können Lernalgorithmen interagieren wie im Gehirn? - Intelligent ...

Können Lernalgorithmen interagieren wie im Gehirn? - Intelligent ...

Können Lernalgorithmen interagieren wie im Gehirn? - Intelligent ...

Erfolgreiche ePaper selbst erstellen

Machen Sie aus Ihren PDF Publikationen ein blätterbares Flipbook mit unserer einzigartigen Google optimierten e-Paper Software.

4.1 Verwendete Architekturen<br />

Im Rahmen des 3. Kapitels wurden die drei Lernparadigmen Reinforcement, Unsupervised so<strong>wie</strong> Supervised Learning vorgestellt,<br />

doch es bleibt die Frage offen, <strong>wie</strong> diese Ideen miteinander verknüpft werden können. Dieser Abschnitt widmet<br />

sich den in diesem Exper<strong>im</strong>ent verwendeten Architekturen und erläutert die Intention und Vorgehensweise. Sei zunächst<br />

mit der Basis, dem Reinforcement Learning, begonnen.<br />

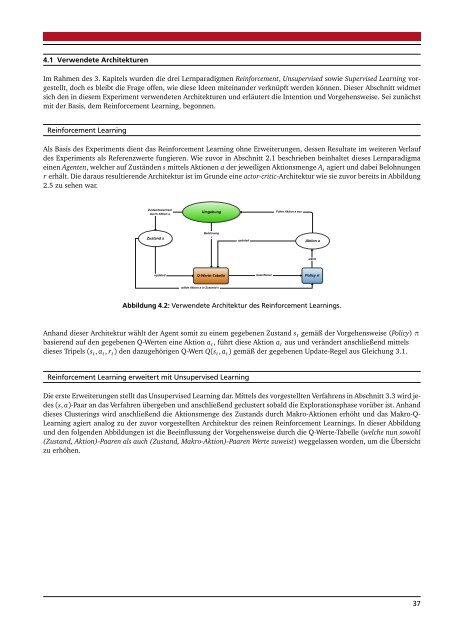

Reinforcement Learning<br />

Als Basis des Exper<strong>im</strong>ents dient das Reinforcement Learning ohne Erweiterungen, dessen Resultate <strong>im</strong> weiteren Verlauf<br />

des Exper<strong>im</strong>ents als Referenzwerte fungieren. Wie zuvor in Abschnitt 2.1 beschrieben beinhaltet dieses Lernparadigma<br />

einen Agenten, welcher auf Zuständen s mittels Aktionen a der jeweiligen Aktionsmenge A s agiert und dabei Belohnungen<br />

r erhält. Die daraus resultierende Architektur ist <strong>im</strong> Grunde eine actor-critic-Architektur <strong>wie</strong> sie zuvor bereits in Abbildung<br />

2.5 zu sehen war.<br />

Zustandswechsel<br />

durch Aktion a<br />

Umgebung<br />

Führe Aktion a aus<br />

Belohnung<br />

Zustand s<br />

r<br />

updated<br />

Aktion a<br />

wählt<br />

updated<br />

Q-Werte-Tabelle<br />

beeinflusst<br />

Policy π<br />

wähle Aktion a in Zustand s<br />

Abbildung 4.2: Verwendete Architektur des Reinforcement Learnings.<br />

Anhand dieser Architektur wählt der Agent somit zu einem gegebenen Zustand s t gemäß der Vorgehensweise (Policy) π<br />

basierend auf den gegebenen Q-Werten eine Aktion a t , führt diese Aktion a t aus und verändert anschließend mittels<br />

dieses Tripels (s t , a t , r t ) den dazugehörigen Q-Wert Q(s t , a t ) gemäß der gegebenen Update-Regel aus Gleichung 3.1.<br />

Reinforcement Learning erweitert mit Unsupervised Learning<br />

Die erste Erweiterungen stellt das Unsupervised Learning dar. Mittels des vorgestellten Verfahrens in Abschnitt 3.3 wird jedes<br />

(s, a)-Paar an das Verfahren übergeben und anschließend geclustert sobald die Explorationsphase vorüber ist. Anhand<br />

dieses Clusterings wird anschließend die Aktionsmenge des Zustands durch Makro-Aktionen erhöht und das Makro-Q-<br />

Learning agiert analog zu der zuvor vorgestellten Architektur des reinen Reinforcement Learnings. In dieser Abbildung<br />

und den folgenden Abbildungen ist die Beeinflussung der Vorgehensweise durch die Q-Werte-Tabelle (welche nun sowohl<br />

(Zustand, Aktion)-Paaren als auch (Zustand, Makro-Aktion)-Paaren Werte zuweist) weggelassen worden, um die Übersicht<br />

zu erhöhen.<br />

37