2 Nachricht und Information

2 Nachricht und Information

2 Nachricht und Information

Erfolgreiche ePaper selbst erstellen

Machen Sie aus Ihren PDF Publikationen ein blätterbares Flipbook mit unserer einzigartigen Google optimierten e-Paper Software.

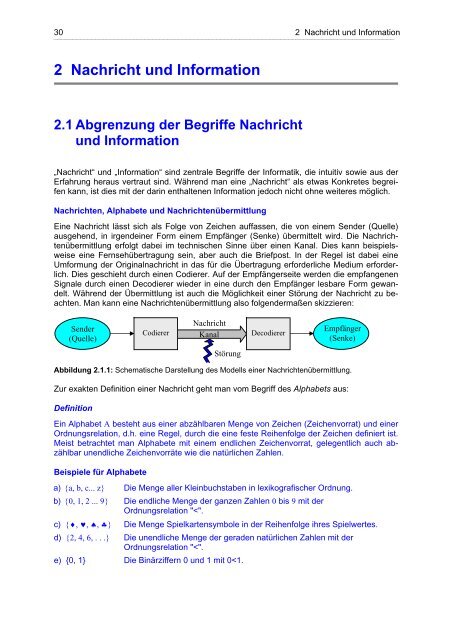

30 2 <strong>Nachricht</strong> <strong>und</strong> <strong>Information</strong>⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯2 <strong>Nachricht</strong> <strong>und</strong> <strong>Information</strong>2.1 Abgrenzung der Begriffe <strong>Nachricht</strong><strong>und</strong> <strong>Information</strong>„<strong>Nachricht</strong>“ <strong>und</strong> „<strong>Information</strong>“ sind zentrale Begriffe der Informatik, die intuitiv sowie aus derErfahrung heraus vertraut sind. Während man eine „<strong>Nachricht</strong>“ als etwas Konkretes begreifenkann, ist dies mit der darin enthaltenen <strong>Information</strong> jedoch nicht ohne weiteres möglich.<strong>Nachricht</strong>en, Alphabete <strong>und</strong> <strong>Nachricht</strong>enübermittlungEine <strong>Nachricht</strong> lässt sich als Folge von Zeichen auffassen, die von einem Sender (Quelle)ausgehend, in irgendeiner Form einem Empfänger (Senke) übermittelt wird. Die <strong>Nachricht</strong>enübermittlungerfolgt dabei im technischen Sinne über einen Kanal. Dies kann beispielsweiseeine Fernsehübertragung sein, aber auch die Briefpost. In der Regel ist dabei eineUmformung der Originalnachricht in das für die Übertragung erforderliche Medium erforderlich.Dies geschieht durch einen Codierer. Auf der Empfängerseite werden die empfangenenSignale durch einen Decodierer wieder in eine durch den Empfänger lesbare Form gewandelt.Während der Übermittlung ist auch die Möglichkeit einer Störung der <strong>Nachricht</strong> zu beachten.Man kann eine <strong>Nachricht</strong>enübermittlung also folgendermaßen skizzieren:Sender(Quelle)Codierer<strong>Nachricht</strong>KanalDecodiererEmpfänger(Senke)StörungAbbildung 2.1.1: Schematische Darstellung des Modells einer <strong>Nachricht</strong>enübermittlung.Zur exakten Definition einer <strong>Nachricht</strong> geht man vom Begriff des Alphabets aus:DefinitionEin Alphabet A besteht aus einer abzählbaren Menge von Zeichen (Zeichenvorrat) <strong>und</strong> einerOrdnungsrelation, d.h. eine Regel, durch die eine feste Reihenfolge der Zeichen definiert ist.Meist betrachtet man Alphabete mit einem endlichen Zeichenvorrat, gelegentlich auch abzählbarunendliche Zeichenvorräte wie die natürlichen Zahlen.Beispiele für Alphabetea) {a, b, c... z} Die Menge aller Kleinbuchstaben in lexikografischer Ordnung.b) {0, 1, 2 ... 9} Die endliche Menge der ganzen Zahlen 0 bis 9 mit derOrdnungsrelation "

2 <strong>Nachricht</strong> <strong>und</strong> <strong>Information</strong> 31⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯Damit lässt sich der Begriff <strong>Nachricht</strong> unter Bezugnahme auf Alphabete wie folgt definieren.DefinitionEine <strong>Nachricht</strong> ist eine aus den Zeichen eines Alphabets gebildete Zeichenfolge. Diese Zeichenfolgemuss nicht endlich sein, aber abzählbar (d.h. man muss die einzelnen Zeichendurch Abbildung auf die natürlichen Zahlen durchnummerieren können), damit die Identifizierbarkeitder Zeichen sichergestellt ist.Der <strong>Nachricht</strong>enraumDie Menge aller <strong>Nachricht</strong>en, die mit den Zeichen eines Alphabets A gebildet werden können,heißt <strong>Nachricht</strong>enraum N(A) oder A* über A. Bisweilen schränkt man den betrachteten<strong>Nachricht</strong>enraum auf Zeichenreihen mit einer maximalen Länge s ein; in diesem Fall umfasstder eingeschränkte <strong>Nachricht</strong>enraum A s nur endlich viele Elemente, sofern das zu Gr<strong>und</strong>eliegende Alphabet endlich ist. <strong>Nachricht</strong>en sind somit konkrete, wenn auch idealisiert immaterielleObjekte, die von einem Sender zu einem Empfänger übertragen werden können. Allerdingsdie <strong>Nachricht</strong> nicht in ihrer ursprünglichen immateriellen Form, sondern in einertechnisch angepassten Art <strong>und</strong> Weise übertragen, z.B. akustisch, optisch oder mit Hilfe vonelektromagnetischen Wellen.Interpretation <strong>und</strong> <strong>Information</strong>Die Extraktion von <strong>Information</strong> aus einer <strong>Nachricht</strong> setzt eine Zuordnung (Abbildung) zwischen<strong>Nachricht</strong> <strong>und</strong> <strong>Information</strong> voraus, die Interpretation genannt wird:<strong>Nachricht</strong>Interpretation<strong>Information</strong>Abbildung 2.1.2:Zusammenhang zwischen <strong>Nachricht</strong>,Interpretation <strong>und</strong> <strong>Information</strong>.Die Interpretation einer <strong>Nachricht</strong> ist jedoch nicht unbedingt eindeutig, sondern subjektiv. Innoch stärkerem Maße gilt das für die Bedeutung, die eine <strong>Nachricht</strong> tragen kann. Ein <strong>und</strong>dieselbe <strong>Nachricht</strong> kann bisweilen auf verschiedene Weisen interpretiert werden. Dies istetwa im Falle des Wortes „Fuchsschwanz“ möglich, wobei man je nach Kontext an denSchwanz eines Fuchses denken kann, oder aber an eine Säge. Die Interpretationsvorschriftmuss auch nicht unbedingt offensichtlich sein, wie etwa im Falle des Wortes KITAMROFNI;der Schlüssel zur <strong>Information</strong> ist in diesem Beispiel die Transposition oder Krebsverschlüsselung.Die Lehre von der Verschlüsselung von <strong>Nachricht</strong>en oder Kryptologie entwickeltesich als ein Teilgebiet der Informatik mit zunehmender Bedeutung. Davon wird in Kapitel 3.5noch ausführlicher die Rede sein.„<strong>Information</strong>“ ist also ein sehr vielschichtiger Begriff, der mathematisch nicht einfach <strong>und</strong> vorallem auch nicht allgemein in all seinen Facetten fassbar ist. Daher sind im Sinne der Informatik<strong>Information</strong>en, im Gegensatz zu <strong>Nachricht</strong>en, nicht exakt definierbare abstrakte Objekte.DV-Anlagen sind deshalb genau genommen nicht Geräte zur <strong>Information</strong>sverarbeitung,sondern zur <strong>Nachricht</strong>enverarbeitung.

32 2 <strong>Nachricht</strong> <strong>und</strong> <strong>Information</strong>⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯...2.4 Wahrscheinlichkeit <strong>und</strong> KombinatorikIn der Informatik geht man oft von einer statistischen Deutung des Begriffs <strong>Information</strong> aus;dies gilt insbesondere dann, wenn es um die Codierung <strong>und</strong> Übermittlung von <strong>Information</strong>enbzw. <strong>Nachricht</strong>en geht. Im Folgenden werden zunächst einige in diesem Zusammenhangwichtige mathematische Begriffe erläutert [Hüb00], [Har02].2.4.1 Die relative HäufigkeitDefinition der relativen HäufigkeitAls relative Häufigkeit h bezeichnet man den Quotienten aus der Anzahl von Dingen (Ereignissen),die ein bestimmtes Merkmal aufweisen <strong>und</strong> der Gesamtzahl der auf dieses Merkmalhin untersuchten Dinge. Diese Vorgehensweise zur Bestimmung der relativen Häufigkeitenwird auch als Abzählregel bezeichnet. Es gilt also:Anzahl der Ereignisse, die das gewünschte Merkmal aufweisenh = ___________________________________________________Anzahl der betrachteten EreignisseAus der Definition folgt, dass immer die Einschränkung 0< h

2 <strong>Nachricht</strong> <strong>und</strong> <strong>Information</strong> 33⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯2.4.2 Die mathematische WahrscheinlichkeitWahrscheinlichkeit <strong>und</strong> relative HäufigkeitDie mathematische Wahrscheinlichkeit lässt sich mit der relativen Häufigkeit in Beziehungbringen. Im Falle des Würfelspiels erfasst man intuitiv: Die Wahrscheinlichkeit, mit einemWürfel eine 6 zu werfen ist zahlenmäßig gleich dem erwarteten Grenzwert der relativen Häufigkeitfür eine sehr hohe Anzahl von Würfen, nämlich 1/6. Dieser als das Gesetz der großenZahl bekannte Zusammenhang kann auf beliebige Zufallsereignisse verallgemeinert werden.Man postuliert also für die Wahrscheinlichkeit w(A), dass das Ereignis A eintritt [Kre02]:w(A) = lim(h(A))n→∞Dabei steht A für das betrachtete Ereignis <strong>und</strong> n für die Anzahl der Versuche.Die Axiome der mathematischen WahrscheinlichkeitMathematisch ist der Begriff „Wahrscheinlichkeit“ jedoch nicht durch die relative Häufigkeit,sondern durch die nachstehend angegebenen Beziehungen definiert, die drei Kolmogorow’schenAxiome der mathematischen Wahrscheinlichkeitstheorie.Axiom 1: Die Wahrscheinlichkeit w(A) für das Eintreffen eines bestimmten Ereignisses A isteine reelle Funktion, die alle Werte zwischen Null <strong>und</strong> Eins annehmen kann:0 < w(A) < 1Axiom 2: Die Wahrscheinlichkeit für das Auftreten eines Ereignisses A, das mit Sicherheiteintrifft, hat den Wert 1:w(A) = 1Axiom 3: Für sich gegenseitig ausschließende Ereignisse A <strong>und</strong> B gilt:w(A oder B) = w(A) + w(B)Der Term w(A oder B) ist dabei als die Wahrscheinlichkeit zu interpretieren, dass entwederEreignis A oder Ereignis B eintritt, aber nicht beide Ereignisse zugleich, da sich A <strong>und</strong> B gegenseitigausschließen sollen. Dieses Additionsgesetz lässt sich auf beliebig viele, sich gegenseitigausschließende Ereignisse A 1 , A 2 , A 3 , ... erweitern:w(A 1 oder A 2 oder A 3 .... ) = w(A 1 ) + w(A 2 ) + w(A 3 ) + ...Dieser Zusammenhang ist sofort einleuchtend. Betrachtet man wieder das Würfelspiel, so istdie Wahrscheinlichkeit, bei einem Wurf mit einem Würfel eine 5 oder eine 6 zu würfelnnach der Abzählregel <strong>und</strong> in Übereinstimmung mit Axiom 3 offenbar 1/6 + 1/6 = 1/3.Es ist anzumerken, dass die für praktische Zwecke übliche Gleichsetzung der Wahrscheinlichkeitmit dem Grenzwert der relativen Häufigkeit im Sinne der Axiome zulässig, aber nichtzwingend ist. Die Axiome 1 bis 3 lassen sich auch mit anderen Zuordnungen erfüllen. DasAxiomensystem ist in diesem Sinne also nicht vollständig.Folgerungen aus den AxiomenAus den Axiomen 1 bis 3 lassen sich eine ganze Reihe von Folgerungen herleiten. So ergibtsich die Wahrscheinlichkeit w(A) für ein mit Sicherheit nicht eintretendes Ereignis A zu:w(A) = 0Die Wahrscheinlichkeit w(nicht A) dafür, dass das Ereignis A nicht eintritt, ist:w(nicht A) = 1 - w(A)

34 2 <strong>Nachricht</strong> <strong>und</strong> <strong>Information</strong>⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯Für die Wahrscheinlichkeit w(A <strong>und</strong> B) dafür, dass zwei Ereignisse A <strong>und</strong> B gemeinsam eintreten,findet man:w(A <strong>und</strong> B) = w(A)w(B)Voraussetzung dafür ist, dass die beiden Ereignisse A <strong>und</strong> B sich nicht gegenseitig ausschließen<strong>und</strong> voneinander unabhängig sind. Wirft man beispielsweise mit zwei unterscheidbarenWürfeln (z.B. einem roten <strong>und</strong> einem schwarzen) gleichzeitig, so ist die Wahrscheinlichkeitdafür, dass man mit dem roten Würfel eine 1 <strong>und</strong> mit dem schwarzen Würfel eine 2würfelt (1/6) . (1/6) = 1/36. Das gleiche Ergebnis erhält man, wenn man mit einem Würfelzweimal hintereinander würfelt <strong>und</strong> verlangt, dass man mit dem ersten Wurf eine 1 <strong>und</strong> mitdem zweiten Wurf eine 2 würfelt. Die Verhältnisse ändern sich etwas, wenn man mit zweiununterscheidbaren Würfeln würfelt <strong>und</strong> nach der Wahrscheinlichkeit fragt, dass eine 1 <strong>und</strong>eine 2 erscheint. Die Wahrscheinlichkeit ist nun (1/6+1/6) . (1/6) = 1/18. Dieses Resultat erhältman auch, wenn man mit nur einem Würfel zwei mal hintereinander würfelt <strong>und</strong> dabei nichtdarauf achtet, ob erst eine 1 <strong>und</strong> dann eine 2 fällt oder erst eine 2 <strong>und</strong> dann eine 1.Die bedingte WahrscheinlichkeitOft hängt die Wahrscheinlichkeit eines Ereignisses A davon ab, ob ein anderes Ereignis Beingetreten ist oder nicht. Es gilt dann für die bedingte Wahrscheinlichkeit w(A/B) für dasEintreffen des Ereignisses A unter der Bedingung, dass Ereignis B bereits eingetroffen ist:w(A/B) = w(A <strong>und</strong> B)/w(B)Sind die Ereignisse A <strong>und</strong> B voneinander unabhängig, so ist w(A/B)=w(A) <strong>und</strong> aus obigerGleichung wird wieder w(A <strong>und</strong> B) = w(A)w(B).Schließen sich zwei Ereignisse A <strong>und</strong> B nicht gegenseitig aus, so erhält man das verallgemeinerteAdditionsgesetz:w(A oder B) = w(A) + w(B) - w(A <strong>und</strong> B)Beispiel: KartenspielZur Verdeutlichung wird folgendes Beispiel betrachtet: In einem Kartenspiel mit 32 Kartenbefinden sich vier Damen. Man fragt nun nach folgenden Wahrscheinlichkeiten:a) Wie hoch ist die Wahrscheinlichkeit w(D 1 ) bei einmaligem Ziehen aus einem vollständigemKartenspiel eine Dame zu ziehen?Unter Verwendung der Abzählregel erhält man das Ergebnis: w(D 1 ) = 4/32 = 1/8b) Wie hoch ist die Wahrscheinlichkeit dafür, in zwei aufeinanderfolgenden Zügen jeweilseine Dame zu ziehen, wenn nach dem ersten Zug die gezogene Dame nicht ins Spiel zurückgelegtwird?Für den Zug der ersten Dame gilt wieder w(D 1 )=4/32. Nun sind nur noch 31 Karten mit 3Damen im Spiel, so dass man für die Wahrscheinlichkeit, im zweiten Zug ebenfalls eineDame zu ziehen w(D 2 ) = 3/31 ermittelt. Insgesamt ist also:w(D 1 <strong>und</strong> D 2 ) = w(D 1 )w(D 2 ) = (4/32)(3/31) ≈ 0.0121c) Wie hoch ist die Wahrscheinlichkeit dafür, in zwei aufeinanderfolgenden Zügen jeweilseine Dame zu ziehen, wenn nach dem ersten Zug die gezogene Dame wieder ins Spielzurückgelegt wird?Jetzt ist w(D 1 ) = w(D 2 ) = 4/32, da jeder Zug aus einem vollständigen Spiel gemacht wird.Das Ergebnis ist alsow(D 1 )w(D 2 ) = (4/32)(4/32) ≈ 0.0156

2 <strong>Nachricht</strong> <strong>und</strong> <strong>Information</strong> 35⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯d) Wie groß ist die Wahrscheinlichkeit dafür, aus einem Kartenspiel, dem in einem Zug einebeliebige Karte entnommen worden ist, in einem anschließenden Zug eine Dame zu ziehen?Gesucht ist also die Wahrscheinlichkeit w(D 2 ) für das Ziehen einer Dame im zweiten Zug.Es gibt nun zwei Möglichkeiten, nämlich erstens, dass im ersten Zug eine Dame gezogenwurde <strong>und</strong> zweitens, dass im ersten Zug keine Dame gezogen wurde. Diese beiden Ereignisseschließen sich gegenseitig aus, so dass die Gesamtwahrscheinlichkeit nachdem Additionsgesetz folgendermaßen berechnet werden kann:w(D 2 ) = w(D 2 <strong>und</strong> D 1 ) + w(D 2 <strong>und</strong> nicht D 1 )Für den ersten Summanden gilt: w(D 2 <strong>und</strong> D 1 ) = w(D 2 )w(D 1 ) = (3/31)(4/32)<strong>und</strong> für den zweiten Summanden: w(D 2 <strong>und</strong> nicht D 1 ) = w(nicht D 1 )w(D 2 /nicht D 1 )= [1-w(D 1 )]w(D 2 /nicht D 1 ) = (1-4/32)(4/31)Den Wert w(D 2 /nicht D 1 )=4/31 für die bedingte Wahrscheinlichkeit dafür, im zweiten Zugeine Dame zu ziehen, wenn im ersten Zug keine Dame gezogen worden war, erhält manmit der Abzählregel. Insgesamt berechnet man also:w(D 2 ) = (4/32)(3/31) + (1-4/32)(4/31) = 1/8Dies ist das gleiche Ergebnis wie in a)! Die Wahrscheinlichkeit, aus einem vollständigenKartenspiel in einem Zug eine Dame zu ziehen ist also genauso groß wie die Wahrscheinlichkeit,aus einem Kartenspiel, dem auf gut Glück eine Karte entnommen wordenist, eine Dame zu ziehen.Das Resultat d) des obigen Beispiels lässt sich noch auf eine Aussage verallgemeinern, dieauf den ersten Blick überraschend erscheinen mag: Die Wahrscheinlichkeit, aus einem vollständigenKartenspiel in einem Zug eine bestimmte Karte zu ziehen ist genauso groß, wiedie Wahrscheinlichkeit, aus einem Kartenspiel, dem zuvor eine beliebige Anzahl von zufälligausgewählten Karten entnommen worden ist, diese Karte zu ziehen. Dies läuft letztlich aufdie Selbstverständlichkeit hinaus, dass die Wahrscheinlichkeit, aus einem vollständigenSpiel mit 32 Karten eine bestimmte Karte zu ziehen identisch mit der Wahrscheinlichkeit ist,dass ebendiese Karte übrig bleibt, wenn man von dem Spiel 31 Karten wegnimmt.

36 2 <strong>Nachricht</strong> <strong>und</strong> <strong>Information</strong>⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯...2.5 <strong>Information</strong> <strong>und</strong> Wahrscheinlichkeit2.5.1 Der <strong>Information</strong>sgehalt einer <strong>Nachricht</strong>Statistischer <strong>Information</strong>sgehalt <strong>und</strong> ElementarentscheidungenAls statistischen <strong>Information</strong>sgehalt oder Entscheidungsinformation einer <strong>Nachricht</strong>, d.h. einesWortes aus dem <strong>Nachricht</strong>enraum A* über einem Alphabet A, bezeichnet man die Mindestanzahlder zur Erkennung (Identifizierung) aller Zeichen der <strong>Nachricht</strong> nötigen Elementarentscheidungen.In Abgrenzung von dem sehr weit gefassten intuitiven Begriff „<strong>Information</strong>“ spricht man indem hier betrachteten speziellen Fall von der mathematisch fassbaren Entscheidungsinformation,die ihrem Wesen nach statistischen Charakter trägt <strong>und</strong> insbesonderenicht nach der semantischen Bedeutung einer <strong>Information</strong> oder dem damit verfolgtenZweck fragt.Die Shannon’sche <strong>Information</strong>stheorieDie Shannon’sche <strong>Information</strong>stheorie wurde maßgeblichvon Claude Shannon bis ca. 1950 entwickelt[Sha48]. Für die mathematische Beschreibung desstatistischen <strong>Information</strong>sgehalts I(x) eines Zeichensoder Wortes x, das in einer <strong>Nachricht</strong> mit der Auftrittswahrscheinlichkeitw(x) vorkommt, stellt man einigeelementare Forderungen:1. Je seltener ein bestimmtes Zeichen x auftritt, d.h. jekleiner w(x) ist, desto größer soll der <strong>Information</strong>sgehaltdieses Zeichens sein. I(x) muss demnach zueiner Funktion, die von 1/w(x) abhängt, proportionalsein <strong>und</strong> streng monoton wachsen.2. Die Gesamtinformation einer Zeichenkette, z.B.x 1 x 2 x 3 soll sich aus der Summe der Einzelinformationenergeben, also:I(x 1 x 2 x 3 ) = I(x 1 ) + I(x 2 ) + I(x 3 ).3. Für den <strong>Information</strong>sgehalt eines mit Sicherheitauftretenden Zeichens x, also für den Fall w(x)=1,soll I(x)=0 gelten.Abbildung 2.5.1: Claude Shannon.Es ist durch Nachrechnen leicht zu zeigen, dass die Logarithmusfunktion die obigen Forderungenerfüllt. Tatsächlich kann man beweisen, dass die Logarithmusfunktion bis auf einenSkalenfaktor die einzige Funktion ist, die dies leistet [Ash90]. Für die Abhängigkeit des <strong>Information</strong>sgehaltseines Zeichens x von seiner Auftrittswahrscheinlichkeit w(x) schreibt mandaher:

2 <strong>Nachricht</strong> <strong>und</strong> <strong>Information</strong> 37⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯I(x) = logb1w(x)Das Bit als Maß für eine <strong>Information</strong>seinheitDie Basis b des Logarithmus bestimmt lediglich den Maßstab, mit dem man <strong>Information</strong>enschließlich messen möchte. Zur Festlegung dieses Maßstabes geht man von dem einfachstendenkbaren Fall einer <strong>Nachricht</strong> aus, die nur aus einer Folge der beiden Zeichen 0 <strong>und</strong> 1besteht, wobei die beiden Zeichen mit der gleichen Wahrscheinlichkeit w 0 =w 1 =0.5 auftretensollen. Dem <strong>Information</strong>sgehalt eines solchen Zeichens wird nun per definitionem der Zahlenwert1 mit der Maßeinheit Bit zugeordnet. Daraus ergibt sich log b (1/0.5)=log b (2)=1 <strong>und</strong> folglichdurch Auflösung dieser Gleichung nach b die Basis b=2. Man erhält also schließlich fürden statistischen <strong>Information</strong>sgehalt eines mit Wahrscheinlichkeit w(x) auftretenden Zeichensx den Zweierlogarithmus aus der reziproken Auftrittswahrscheinlichkeit:I(x) = ld 1w(x)[ Bit]Man kann die Basis b, die auch als Entscheidungsgrad bezeichnet wird, als die Anzahl derZustände interpretieren, die in der <strong>Nachricht</strong>enquelle angenommen werden können. Im Fallevon b=2 sind das nur zwei Zustände, die man ohne Beschränkung der Allgemeinheit mit 0<strong>und</strong> 1 bezeichnen kann. In dieser computergemäßen binären Darstellung gibt der <strong>Information</strong>sgehalteiner <strong>Nachricht</strong> die Anzahl der als Elementarentscheidungen bezeichneten Alternativentscheidungenan, die nötig sind, um eine <strong>Nachricht</strong> Zeichen für Zeichen eindeutigidentifizieren zu können.<strong>Information</strong>sgehalt <strong>und</strong> Stellenzahl eines BinärwortesDie binäre Darstellung von <strong>Nachricht</strong>en verdeutlicht auch, dass die Maßeinheit Bit eine sinnvolleWahl ist, denn der (auf die nächstgrößere ganze Zahl ger<strong>und</strong>ete) <strong>Information</strong>sgehalteines Zeichens ist gerade die Anzahl der Stellen des Binärwortes, das man für eine eindeutigebinäre Darstellung des Zeichens verwenden muss.Empfängt man eine <strong>Nachricht</strong> in Form eines Binärworts, so ist für jedes der empfangenenZeichen nacheinander die Elementarentscheidung zu treffen, ob es sich um das Zeichen 0oder das Zeichen 1 handelt. Die Anzahl der Entscheidungen, also der <strong>Information</strong>sgehalt der<strong>Nachricht</strong>, ist hier notwendigerweise mit der Anzahl der binären Stellen der <strong>Nachricht</strong> identisch.Einen derartigen Entscheidungsprozess kann man in Form eines Binärbaumes veranschaulichen.So hat beispielsweise der zur <strong>Nachricht</strong> 1011 gehörige Binärbaum die in Abbildung2.5.2 dargestellte Form.1110 10 1 0 1 0 1 01 0 1 0 1 0 1 0 1 0 1 0 1 0 1 000Abbildung 2.5.2:Entscheidungsbaum für einvierstelliges Binärwort. DerEntscheidungspfad zur Identifikationdes Wortes 1011 istmarkiert. Der Pfeil gibt dieLeserichtung von der Wurzelin Richtung zu den Endknotendes Baumes an.Die Definition <strong>und</strong> insbesondere der verwendete Maßstab „Bit“ für den statistischen <strong>Information</strong>sgehaltsind also insofern den Erfordernissen der Datenverarbeitung angepasst, als dieWortlänge <strong>und</strong> der <strong>Information</strong>sgehalt von Binärworten identisch sind, wenn die Auftrittswahrscheinlichkeitender Zeichen 0 <strong>und</strong> 1 beide den Wert 0.5 haben.

38 2 <strong>Nachricht</strong> <strong>und</strong> <strong>Information</strong>⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯Beispiel: Der <strong>Information</strong>sgehalt einer nicht-binären <strong>Nachricht</strong>Die Berechnung des <strong>Information</strong>sgehaltes lässt sich ohne weiteres auf nicht-binäre <strong>Nachricht</strong>en,etwa das lateinische Alphabet, übertragen, wie das folgende Beispiel zeigt.In einem deutschsprachigen Text tritt der Buchstabe b mit der Wahrscheinlichkeit 0.016 auf.Wie groß ist der <strong>Information</strong>sgehalt dieses Zeichens? Die Lösung dafür lautet:11log( 0.016)1.79588I(b) = ld( 0.016)= ≈ ≈ 5.97 Bitlog(2) 0.30103[ ]Für die tatsächliche binäre Codierung müsste man also – notwendigerweise aufger<strong>und</strong>et aufdie nächst größere natürliche Zahl – die Stellenzahl 6 wählen.Praktisches Rechnen mit ZweierlogarithmenFür die praktische Berechnung des Zweierlogarithmus, der ja auf Taschenrechnern meistnicht implementiert ist, wurde oben die folgende Gleichung benützt, welche einen Logarithmuszu einer beliebigen Basis durch den Zehnerlogarithmus ausdrückt:log10(x)log10(x)logb(x) = also log2(x) = ld(x) = mit loglog (b)log (2) 10 (2) = log(2) = 0.3010310Für log 10 (x) schreibt man üblicherweise einfach log(x) <strong>und</strong> für log 2 (x) einfach ld(x). In der Mathematikwird sehr häufig der natürliche Logarithmus zur Basis e≈2.71828... verwendet. Stattlog e (x) schreibt man dafür ln(x).102.5.2 Die Entropie einer <strong>Nachricht</strong>Die Entropie als mittlerer <strong>Information</strong>sgehaltEine <strong>Nachricht</strong> setzt sich im Allgemeinen aus Zeichen bzw. aus zu Worten verb<strong>und</strong>enen Zeichenzusammen, die einen unterschiedlichen <strong>Information</strong>sgehalt tragen, da sie mit unterschiedlicherHäufigkeit auftreten. Man führt daher den Begriff des mittleren <strong>Information</strong>sgehaltsoder der Entropie H einer <strong>Nachricht</strong> ein, die aus den Zeichen x 1 , x 2 , ... x n eines AlphabetsA besteht. Die Entropie ist durch den Mittelwert der mit den Auftrittswahrscheinlichkeitengewichteten <strong>Information</strong>sgehalte der Zeichen gegeben:n1H= w(xi)ld =w(x )∑ ∑i= 1i i=1nw(x )I(x )iiDie Bezeichnung Entropie wurde wegen der formalen <strong>und</strong> in gewisser Weise auch inhaltlichenÄhnlichkeit mit einem physikalischen Gesetz der Thermodynamik gewählt, die im Gr<strong>und</strong>eebenfalls eine Theorie mit statistischem Charakter ist.Der maximale <strong>Information</strong>sgehaltMan kann nun fragen, für welche Auftrittswahrscheinlichkeiten w(x i ) der mittlere <strong>Information</strong>sgehaltH einer aus den Zeichen x i bestehenden <strong>Nachricht</strong> maximal wird. Man findet durchAbleiten der Entropieformel nach w <strong>und</strong> Nullsetzen des Ergebnisses, dass dies dann der Fallist, wenn alle Auftrittswahrscheinlichkeiten w(x i ) gleich sind.Die Rechnung läuft für ein aus nur zwei Zeichen bestehendes Alphabet A = {x 1 , x 2 } mit denAuftrittswahrscheinlichkeiten w(x 1 )=w 1 <strong>und</strong> w(x 2 )=w 2 =1- w 1 folgendermaßen:Für die Entropie erhält man:

2 <strong>Nachricht</strong> <strong>und</strong> <strong>Information</strong> 39⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯2H w ld 1 w wld 1 1= ∑ i=1+ (1 − w1)ld =−wld(w) 1 1−(1−w)ld(1 1−w)1i=1iw11−w1Differentiation <strong>und</strong> Nullsetzen des Ergebnisses liefert nach der aus der Differentialrechnungbekannten Methode der Extremwertberechnung eine Bestimmungsgleichung für die Extremwerte:dHdw 0 dHw1ld(w )dwwln2 ld(1 w ) 1−w1= ⇒ =−1− + −1+ =− ld(w1) + ld(1− w1) = 01 11(1−w1)ln2⇒ w = 1−w ⇒ w = w = 0.51 1 1 2Nochmaliges Ableiten ergibt ein negatives Ergebnis, woraus folgt, dass es sich bei dem gef<strong>und</strong>enenExtremwert tatsächlich um ein Maximum handelt. Der höchste <strong>Information</strong>sgehaltergibt sich demnach, wenn alle Zeichen mit der gleichen Wahrscheinlichkeit auftreten.Die Ungewissheit (Surprisal) einer <strong>Nachricht</strong>enquelleDer Begriff Entropie lässt sich auch so interpretieren, dass bei einem Vergleich zweier <strong>Nachricht</strong>enquellenfür diejenige mit der kleineren Entropie das Auftreten eines bestimmten Zeichensmit größerer Sicherheit vorhersagbar ist. Um diesen Sachverhalt auszudrücken, führtman den Begriff Ungewissheit (Surprisal) ein. Je höher die Entropie einer <strong>Nachricht</strong>enquelleist, umso höher ist ihre Ungewissheit.BeispielEs werden zwei Alphabete A 1 <strong>und</strong> A 2 betrachtet:A 1 = {a, b, c, d}mit den Auftrittswahrscheinlichkeiten w(a)=11/16, w(b)=w(c)=1/8, w(d)=1/16<strong>und</strong> A 2 = {+, -, * } mit den Auftrittswahrscheinlichkeiten w(+)=1/6, w(-)=1/2, w( * )=1/3Für die zugehörigen Entropien berechnet man:H 111 16 1 1 1= ⋅ld+ ⋅ld8+⋅ld8+⋅ld16≈1.372[Bit/Zeichen]16 11 8 8 161 1 1H 2= ⋅ld6+⋅ld2+⋅ld3≈1.460[Bit/Zeichen]6 2 3In diesem Falle ist die Ungewissheit für A 2 größer als für A 1 , da H 2 größer ist als H 1 . Anschaulichbedeutet dies, dass man bei einer <strong>Nachricht</strong>enquelle, die Zeichen aus A 1 sendet,mit höherer Treffsicherheit vorhersagen kann, welches Zeichen als Nächstes gesendet wird,als dies bei einer <strong>Nachricht</strong>enquelle der Fall wäre, die Zeichen aus A 2 sendet.Die statistische Unabhängigkeit von ZeichenBei der Einführung der Entropie war vorausgesetzt worden, dass das Auftreten von Zeichenstatistisch voneinander unabhängig erfolgt. Mit anderen Worten, die Wahrscheinlichkeit fürdas Auftreten eines bestimmten Zeichens soll statistisch unabhängig davon sein, welchesZeichen unmittelbar vorher aufgetreten war. Diese Bedingung ist jedoch häufig nicht erfüllt.In der deutschen Sprache ist beispielsweise die Wahrscheinlichkeit dafür, dass das Zeichen„n“ auftritt etwa 10 mal höher, wenn unmittelbar zuvor das Zeichen „u“ aufgetreten war, alswenn unmittelbar zuvor das Zeichen „t“ aufgetreten war. Die Kombination „un“ kommt imDeutschen also 10 mal häufiger vor als die Kombination „tn“. Man sagt dann, diese Zeichensind miteinander korreliert. Diese Korrelation wird sehr deutlich, wenn man die in der folgendenTabelle aufgelisteten Auftrittswahrscheinlichkeiten der Einzelzeichen betrachtet. DasZeichen „u“ hat die Auftrittswahrscheinlichkeit 0.0319, das Zeichen „n“ hat die Auftrittswahrscheinlichkeit0.0884. Wären „u“ <strong>und</strong> „n“ nicht korreliert, dann wäre die Auftrittswahrschein-

40 2 <strong>Nachricht</strong> <strong>und</strong> <strong>Information</strong>⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯lichkeit von „un“ 0.0319⋅0.0884=0.0028; in Folge der starken Korrelation dieser beiden Zeichenfindet man aber durch Abzählen in deutschen Texten den viel größeren Wert 0.0173.Die Berechnung der Entropie unter Berücksichtigung von Korrelationen ist etwas aufwendigerals für unabhängige Zeichen, für Details wird auf weiterführende Literatur verwiesen.Die beiden folgenden Tabellen geben einen Eindruck von der Häufigkeitsverteilung derBuchstaben in deutschen Texten.Tabelle 2.5.1: Wahrscheinlichkeiten für das Auftreten von Buchstaben in einem typischen deutschenText. Zwischen Groß- <strong>und</strong> Kleinbuchstaben wird dabei nicht unterschieden.Buchstabe____________________________________________________________________________w i Buchstabe w iAndere Zeichen 0.1515 o 0.0177e 0.1470 b 0.0160n 0.0884 z 0.0142r 0.0686 w 0.0142i 0.0638 f 0.0136s 0.0539 k 0.0096t 0.0473 v 0.0074d 0.0439 ü 0.0058h 0.0436 p 0.0050a 0.0433 ä 0.0048u 0.0319 ö 0.0025l 0.0293 j 0.0016c 0.0267 y 0.0002g 0.0267 q 0.0001m 0.0213 x 0.0001Tabelle 2.5.2: Auftrittswahrscheinlichkeiten für die 20 häufigsten Kombinationen von zwei Buchstabenin einem typischen deutschen Text. Zwischen Groß- <strong>und</strong> Kleinbuchstaben wird nicht unterschieden.Gruppe____________________________________________________________________________w i Gruppe w ien 0.0447 ge 0.0168er 0.0340 st 0.0124ch 0.0280 ic 0.0119nd 0.0258 he 0.0117ei 0.0226 ne 0.0117de 0.0214 se 0.0117in 0.0204 ng 0.0107es 0.0181 re 0.0107te 0.0178 au 0.0104ie 0.0176 di 0.0102un 0.0173 be 0.0096

2 <strong>Nachricht</strong> <strong>und</strong> <strong>Information</strong> 41⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯2.5.3 Zusammenhang mit der physikalischen EntropieWie schon erwähnt, wurde die Bezeichnung „Entropie“ für den mittleren <strong>Information</strong>sgehaltnicht zufällig gewählt, sondern wegen der formalen <strong>und</strong> bis zu einem gewissen Grade auchinhaltlichen Verwandtschaft mit der aus der Thermodynamik, also der statistischen Wärmelehre,bekannten physikalischen Entropie.Maxwells Dämon <strong>und</strong> das Perpetuum Mobile zweiter ArtInteressant ist in diesem Zusammenhang ein Gedankenexperiment, das der Physiker J. C.Maxwell 1871 veröffentlicht hat. Danach könnte ein mikroskopisch kleines, intelligentes Wesen(„Maxwells Dämon“) den zweiten Hauptsatz der Thermodynamik auf molekularer Ebeneeventuell umgehen. Vereinfacht ausgedrückt verbietet es der zweite Hauptsatz, dass Wärmevon einem kühleren zu einem wärmeren Reservoir fließt, ohne dass dabei äußere Arbeit geleistet,also Energie zugeführt wird. Dies bedeutet unter anderem die Unmöglichkeit einesPerpetuum Mobiles zweiter Art. Ein solches wäre beispielsweise ein Schiff, das seine Antriebsenergieallein durch Abkühlung des ihn umgebenden Ozeans gewinnt. Maxwell stelltesich zwei gasgefüllte, miteinander durch ein Ventil verb<strong>und</strong>ene Gefäße vor, die zunächstbeide dieselbe Temperatur haben. Da sich die Temperatur eines Gases durch die statistischeBewegung der Gasmoleküle beschreiben lässt, könnte der Dämon nun das Ventil bedienen<strong>und</strong> Moleküle, deren Geschwindigkeit die mittlere Geschwindigkeit übersteigt, vomlinken Gefäß in das rechte wechseln lassen. Es schien, als könne dies durch eine sinnreicheKonstruktion ohne Energieaufwand (also unter Verletzung des zweiten Hauptsatzes) erreichtwerden; das wärmere Gefäß würde sich also „von selbst“ allein durch Abkühlung des kälterenGefäßes weiter erhitzen. Der Dämon muss dazu nicht wirklich intelligent sein, sondernlediglich ein Automat, der dazu in der Lage ist, eine Messung durchzuführen, die dadurchgewonnene binäre <strong>Information</strong> für kurze Zeit zu speichern <strong>und</strong> eine einfache mechanischeVerrichtungen (z.B. das Öffnen eines Ventils) vorzunehmen. Der Physiker Leo Szilard löste1929 das Rätsel, indem er zeigte, dass durch den Messprozess <strong>und</strong> die Speicherung desresultierenden Ja/Nein-Ergebnisses ein Mindestbetrag an (physikalischer) Entropie S min produziertwird, der mindestens so groß ist wie die dem Wärmebad entzogene Entropie [Szi29].Dafür berechnet Szilard den WertS min =k⋅ln(2)wobei k die in der Thermodynamik wichtige Boltzmann-Konstante ist. Man kann daher Szilardmit gewissem Recht als einen der Entdecker der <strong>Information</strong>seinheit „Bit“ betrachten,auch wenn diese Bezeichnung erst später eingeführt wurde. Der minimalen <strong>Information</strong>seinheiteines Ja/Nein-Messergebnisses entspricht also eine minimale physikalische Entropie,ohne dass diese beiden Größen allerdings indentisch wären. Hier wurde erstmals ein Zusammenhangzwischen physikalischer Entropie <strong>und</strong> <strong>Information</strong>s-Entropie hergestellt, nochlange bevor die <strong>Information</strong>stheorie entstand.<strong>Information</strong>sverarbeitung <strong>und</strong> EnergiebedarfSpätere Untersuchungen zeigten, dass der kritische Moment bei der physikalischen Untersuchungder <strong>Information</strong>sverarbeitung nicht etwa das Messen oder Speichern von <strong>Information</strong>ist, sondern das Löschen (oder auch Überschreiben). Erst Jahrzehnte nach SzilardsÜberlegungen gelang es Charles Bennet [Ben82], den mit dem Löschen von <strong>Information</strong>verb<strong>und</strong>enen Mindestbetrag an physikalischer Entropie <strong>und</strong> den dafür nötigen minimalenEnergieaufwand zu bestimmen.Auf den Punkt gebracht kann man sagen, dass bei der üblichen Art der <strong>Information</strong>sverarbeitungnicht nur keinerlei <strong>Information</strong> erzeugt wird, sondern dass vielmehr <strong>Information</strong> vernichtetwird. Dies wird bereits an einem einfachen Beispiel klar: Erscheint am Ausgang einesOR-Gatters das Ergebnis „1“, so kann daran nicht mehr unterschieden werden, welche derdrei Möglichkeiten (0,1), (1,0) oder (1,1) an den beiden Eingängen des Gatters vorgelegen

42 2 <strong>Nachricht</strong> <strong>und</strong> <strong>Information</strong>⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯⎯hatte. Es ging also tatsächlich <strong>Information</strong> verloren. Es wäre nun nahe liegend, in einemComputer bzw. einer Turing-Maschine (siehe Kapitel 9.2) nur Schaltkreise einzusetzen, beidenen keine <strong>Information</strong> gelöscht wird. Diese hypothetischen, so genannten Fredkin-Gatter[Fred82] würden im Prinzip den Aufbau einer Turing-Maschine zur reversiblen <strong>Information</strong>sverarbeitungermöglichen. Eine solche Maschine könnte also ohne Energieaufwand <strong>und</strong> ohneErhöhung der physikalischen Entropie <strong>Information</strong>en verarbeiten; auch wäre zu jedemZeitpunkt die gesamte <strong>Information</strong> in Form interner Zustände vorhanden.Die Brown’sche Turing-MaschineDem Prinzip einer reversiblen Turing-Maschine kommt die aus der Biochemie bekannteBrown’sche Turing-Maschine sehr nahe. Es handelt sich dabei um einen bei der Weitergabevon Erbanlagen während der Zellteilung wichtigen Prozess, bei dem Kopien von DNA-Segmenten der in den Chromosomen der Zelle enthaltenen Gene hergestellt werden. DerKopiervorgang ist quasi-reversibel: nahe am chemischen Gleichgewicht erfolgen fast ebensoviele Kopiervorgänge in der umgekehrten Richtung wie in Vorwärtsrichtung. Der Motor diesesKopiervorgangs ist die thermische Brown’sche Bewegung der umgebenden Moleküle,unterstützt durch eine schwach antreibende Kraft, die eine Vorzugsrichtung definiert. DieseKraft <strong>und</strong> damit die nötige Energie kann prinzipiell beliebig reduziert werden, die Ausführungszeitenwerden dann aber immer länger <strong>und</strong> streben bei verschwindender Kraft gegenUnendlich.Was ist <strong>Information</strong>?Da <strong>Information</strong> also weder Energie noch Materie ist, kann man sich darunter vielleicht amehesten eine immaterielle Qualität vorstellen [Sto90], etwa in Analogie zu abstrakten physikalischenGrößen wie Ladung, Spin etc. Es stellt sich aber die Frage, inwieweit <strong>Information</strong>unabhängig von einem Beobachter ist. Es leuchtet ein, dass ein DNA-Kristall viel mehr <strong>Information</strong>enthält als etwa ein Salzkristall, <strong>und</strong> zwar unabhängig davon, ob die DNA nun entziffertist oder nicht. Es scheint jedoch so zu sein, dass thermodynamische Aspekte wie E-nergieverbrauch <strong>und</strong> Entropieerhöhung erst ins Spiel kommen, wenn – vielleicht in Analogiezu einem quantenmechanischen Messprozess – ein Beobachter aktiv <strong>Information</strong>en im weitestenSinne verarbeitet.Man kann zusammenfassen:• Die Gewinnung, Verarbeitung <strong>und</strong> Übertragung von <strong>Information</strong> kann nur in Systemen mitmindestens zwei verschiedenen physikalischen Zuständen erfolgen.• <strong>Information</strong>ssysteme können nur arbeiten, wenn ihr thermodynamischer Zustand um eineMindestdistanz vom thermodynamischen Gleichgewicht entfernt ist.• Das Gewinnen oder Löschen eines <strong>Information</strong>sbetrags ist immer mit der Erzeugung physikalischerEntropie verb<strong>und</strong>en.• Die informationstheoretische Entropie ist eng mit der physikalischen Entropie verwandt,jedoch nicht mit dieser identisch.