GEOmedia_5_2021

La prima rivista italiana di geomatica

La prima rivista italiana di geomatica

Create successful ePaper yourself

Turn your PDF publications into a flip-book with our unique Google optimized e-Paper software.

Rivista bimestrale - anno XXV - Numero - 5/<strong>2021</strong> - Sped. in abb. postale 70% - Filiale di Roma<br />

TERRITORIO CARTOGRAFIA<br />

GIS<br />

CATASTO<br />

3D<br />

INFORMAZIONE GEOGRAFICA<br />

FOTOGRAMMETRIA<br />

URBANISTICA<br />

EDILIZIA<br />

GNSS<br />

BIM<br />

RILIEVO TOPOGRAFIA<br />

CAD<br />

REMOTE SENSING SPAZIO<br />

WEBGIS<br />

UAV<br />

SMART CITY<br />

AMBIENTE<br />

NETWORKS<br />

LiDAR<br />

BENI CULTURALI<br />

LBS<br />

Set/Ott <strong>2021</strong> anno XXV N°5<br />

Urban<br />

Digital<br />

twin<br />

OLTRE LE SDI:<br />

QUALI PROSPETTIVE<br />

LA SITUAZIONE DELLE<br />

IDT REGIONALI:<br />

PIEMONTE E VENETO<br />

SENSORE SENTERA<br />

6X A BORDO DI UN<br />

PHANTOM 4

Da IDT e INSPIRE alle<br />

DIGITAL TWIN<br />

Quanto la copia digitale dei nostri ecosistemi, in particolare città e territorio, è in grado di<br />

essere utilizzata per produrre previsioni di comportamento in grado di farci conoscere cosa<br />

succederà domani?<br />

È quello che esplorano gli autori del focus L’Urban Digital Twin, l’Incertezza<br />

e l’Osservazione della Terra: il Programma europeo Copernicus, portandoci a considerare<br />

quali siano i termini di incertezza dei risultati previsionali, derivati da modelli in cui i<br />

dati di base utilizzati sono fortemente approssimati. La misura dell’incertezza del dato<br />

di base è uno dei pilastri costituenti la scienza della misura che da sempre accompagna il<br />

rilievo sul campo dei dati geometrici della realtà che ci circonda, ma questa viene spesso<br />

sottovalutata specialmente nell’analisi di grandi moli di dati come quelli rilevati dai<br />

satelliti Copernicus, che, ci ricordano i nostri autori, non sono stati lanciati solamente<br />

per un semplice programma osservativo di monitoraggio satellitare. Le loro priorità<br />

sono le informazioni, anche previsionali, che possono essere rilanciate da piattaforme di<br />

simulazione di fenomeni osservabili.<br />

E quanto affidabili sono oggi le Infrastrutture di Dati Territoriali (IDT), anche<br />

omogeneizzate ed armonizzate nell’ambito del processo avviato dalla direttiva europea<br />

INSPIRE basata sulla interoperabilità delle infrastrutture di dati spaziali creati dagli stati<br />

membri, entrata in vigore nel 2007 e recepita in Italia con il D.Lgs. 32/2010?<br />

È questo l’oggetto dell’indagine avviata con il contributo di Franco Vico Oltre le SDI:<br />

quali prospettive, il quale constata che a 14 anni dall’entrata in vigore di INSPIRE non c’è<br />

un paese dell’Unione Europea che abbia dato piena implementazione in accordo con la<br />

roadmap inizialmente stabilita. Il concetto di SDI (Spatial Data Infrastructure), tradotto<br />

in Italia in IDT, introdotto all’inizio degli anni ’90, oggi subisce, a livello globale, un<br />

dibattito sul suo futuro. L’autore ci illustra le varie posizioni ed è interessante notare che,<br />

nonostante il quadro variato, emergono alcuni punti di convergenza tra le varie posizioni.<br />

Seguendo questo tema vi presentiamo le prime indagini, di una serie che speriamo<br />

possa essere esaustiva a livello nazionale, che inizia con questo numero di <strong>GEOmedia</strong><br />

e proseguirà con i successivi, finalizzata a conoscere quale sia la situazione delle varie<br />

strutture regionali dedite alla realizzazione e manutenzione delle IDT, attraverso delle<br />

interviste ai diretti responsabili.<br />

Alcune Regioni ci hanno dato questa disponibilità e vi riportiamo qui le risultanze di<br />

questi incontri eseguiti conducendo interviste ai funzionari che hanno in carico le gestioni<br />

delle SDI, quali Gian<br />

Bartolomeo Siletto, funzionario referente della IDT della Regione Piemonte e Umberto<br />

Trivelloni, Responsabile della IDT della Regione del Veneto.<br />

Un particolare ringraziamento va a Franco Vico che ha realizzato in collaborazione con la<br />

nostra Redazione queste prime interviste.<br />

Buona lettura,<br />

Renzo Carlucci

FOCUS<br />

in qUesto<br />

nUmero...<br />

FocUs<br />

rePort<br />

intervista<br />

l’URBAN DIGITAL<br />

TWIN, l’incertezza e<br />

l’osservazione Della<br />

terra: il Programma<br />

eUroPeo coPernicUs<br />

DI ANDREA TARAMELLI, BERNARDO<br />

DE BERNARDINIS, MARIA VITTORIA<br />

CASTELLANI E SERGIO FARRUGGIA<br />

6<br />

LE RUBRICHE<br />

42 MERCATO<br />

46 AGENDA<br />

18<br />

interviste aD alcUni<br />

resPonsabili Di iDt<br />

regionali: Presente<br />

e ProsPettive<br />

A CURA DI FRANCO VICO<br />

oltre le sDi:<br />

qUali ProsPettive<br />

DI FRANCO VICO<br />

14<br />

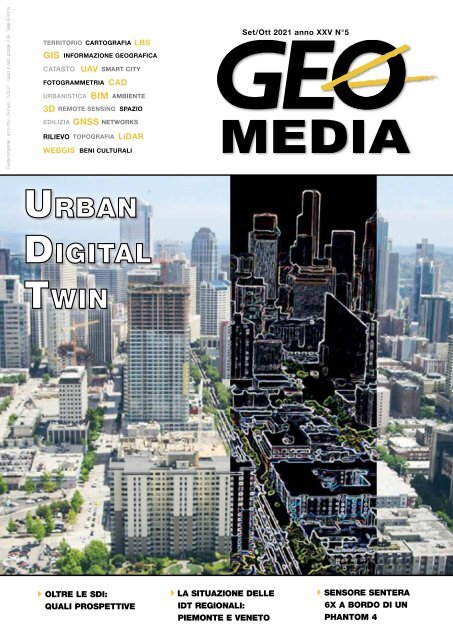

In copertina una<br />

immagine che<br />

iconicamente rappresenta<br />

il rapporto tra Urban<br />

Digital Twin e la realtà<br />

urbana. Fonte: ARUP<br />

Report 2019 http://<br />

www.arup.com/<br />

digitaltwinreport<br />

geomediaonline.it<br />

4 <strong>GEOmedia</strong> n°5-<strong>2021</strong><br />

<strong>GEOmedia</strong>, bimestrale, è la prima rivista italiana di geomatica.<br />

Da più di 20 anni pubblica argomenti collegati alle tecnologie dei<br />

processi di acquisizione, analisi e interpretazione dei dati,<br />

in particolare strumentali, relativi alla superficie terrestre.<br />

In questo settore <strong>GEOmedia</strong> affronta temi culturali e tecnologici<br />

per l’operatività degli addetti ai settori dei sistemi informativi<br />

geografici e del catasto, della fotogrammetria e cartografia,<br />

della geodesia e topografia, del telerilevamento aereo e<br />

spaziale, con un approccio tecnico-scientifico e divulgativo.

INSERZIONISTI<br />

26<br />

rilievo Digitale<br />

Di aree Urbane<br />

DI MARCO SANTONI,<br />

FLAVIA BORGIOLI<br />

Catalyst 25<br />

Codevintec 37<br />

Datronix 48<br />

Epsilon 43<br />

ESRI 41<br />

Geomax 45<br />

GIS3W 12<br />

Gter 24<br />

Planetek Italia 13<br />

Stonex 47<br />

integrazione Di Un<br />

sensore sentera 6X<br />

30<br />

<br />

Teorema 46<br />

a borDo Di Un Drone<br />

Phantom 4. Una<br />

sPerimentazione in<br />

camPo archeologico<br />

DI LAURA EBANISTA,<br />

ALESSANDRO MARIA JAIA,<br />

ANDREA POMPILI<br />

38<br />

sistemi Di<br />

Posizionamento,<br />

navigazione e<br />

sincronizzazione<br />

alternativi ai gnss<br />

DI MARCO LISI<br />

Nello sfondo Cancún, Messico<br />

(14 novembre <strong>2021</strong>)<br />

- Cancún, che è situata nel<br />

Quintana Roo sulla costa<br />

nord orientale della penisola<br />

messicana dello Yucatán, è<br />

mostrata in questa immagine<br />

catturata dalla missione Copernicus<br />

Sentinel-2.<br />

La posizione di Cancún sul<br />

Mar dei Caraibi, il suo clima<br />

tropicale ed il suo allineamento<br />

di spiagge hanno fatto della<br />

città e della Riviera Maya (a<br />

sud di Cancún) una delle più<br />

importanti mete turistiche del<br />

Messico. In questa immagine,<br />

acquisita il 16 aprile <strong>2021</strong>,<br />

la città nascosta dalle nubi è<br />

visibile nell’angolo in basso<br />

a destra. L’Aeroporto Internazionale<br />

di Cancún, il secondo<br />

aeroporto più trafficato del<br />

Messico, è posizionato 20km<br />

circa a sud della città.<br />

La zona di villeggiatura di<br />

Cancún, visibile appena al<br />

largo della costa, appare<br />

di una forma che ricorda il<br />

numero sette ed è lunga circa<br />

22km. L’isola è separata<br />

dalla città dalla laguna di<br />

Nichupté, ma ad ogni suo<br />

estremo è collegata attraverso<br />

una strada sopraelevata. Gran<br />

parte dell’industria turistica<br />

è concentrata nell’isola di<br />

Cancún con le sue spiagge<br />

che si affacciano sui Caraibi.<br />

(Fonte: ESA - Image of the<br />

week: "Cancún, Mexico".<br />

Traduzione: Gianluca Pititto)<br />

una pubblicazione<br />

Science & Technology Communication<br />

<strong>GEOmedia</strong>, la prima rivista italiana di geomatica.<br />

ISSN 1128-8132<br />

Reg. Trib. di Roma N° 243/2003 del 14.05.03<br />

Direttore<br />

RENZO CARLUCCI, direttore@rivistageomedia.it<br />

Comitato editoriale<br />

Vyron Antoniou, Fabrizio Bernardini, Mario Caporale,<br />

Roberto Capua, Luigi Colombo, Mattia Crespi, Luigi Di<br />

Prinzio, Michele Dussi, Michele Fasolo, Marco Lisi, Flavio<br />

Lupia, Luigi Mundula, Beniamino Murgante, Aldo Riggio,<br />

Mauro Salvemini, Attilio Selvini, Donato Tufillaro<br />

Direttore Responsabile<br />

FULVIO BERNARDINI, fbernardini@rivistageomedia.it<br />

Redazione<br />

VALERIO CARLUCCI, GIANLUCA PITITTO,<br />

redazione@rivistageomedia.it<br />

Diffusione e Amministrazione<br />

TATIANA IASILLO, diffusione@rivistageomedia.it<br />

Progetto grafico e impaginazione<br />

DANIELE CARLUCCI, dcarlucci@rivistageomedia.it<br />

Editore<br />

MediaGEO soc. coop.<br />

Via Palestro, 95 00185 Roma<br />

Tel. 06.64871209 - Fax. 06.62209510<br />

info@rivistageomedia.it<br />

Stampa: System Graphics Srl<br />

Via di Torre Santa Anastasia 61 00134 Roma<br />

Condizioni di abbonamento<br />

La quota annuale di abbonamento alla rivista Science è di € & 45,00. Technology Communication<br />

Il prezzo di ciascun fascicolo compreso nell’abbonamento è di € 9,00. Il prezzo di<br />

ciascun fascicolo arretrato è di € 12,00. I prezzi indicati si intendono Iva inclusa.<br />

L’editore, al fine di garantire la continuità del servizio, in mancanza di esplicita<br />

revoca, da comunicarsi in forma scritta entro il trimestre seguente alla scadenza<br />

dell’abbonamento, si riserva di inviare il periodico anche per il periodo successivo.<br />

La disdetta non è comunque valida se l’abbonato non è in regola con i pagamenti.<br />

Il rifiuto o la restituzione dei fascicoli della Rivista non costituiscono disdetta<br />

dell’abbonamento a nessun effetto. I fascicoli non pervenuti possono essere<br />

richiesti dall’abbonato non oltre 20 giorni dopo la ricezione del numero successivo.<br />

Gli articoli firmati impegnano solo la responsabilità dell’autore. È vietata la<br />

riproduzione anche parziale del contenuto di questo numero della Rivista in<br />

qualsiasi forma e con qualsiasi procedimento elettronico o meccanico, ivi inclusi i<br />

sistemi di archiviazione e prelievo dati, senza il consenso scritto dell’editore.<br />

Rivista fondata da Domenico Santarsiero.<br />

Numero chiuso in redazione il 20 novembre <strong>2021</strong>.

FOCUS<br />

L’“Urban Digital Twin”, l’Incertezza<br />

e l’Osservazione della Terra:<br />

il Programma europeo Copernicus<br />

di Andrea Taramelli, Bernardo De Bernardinis, Maria Vittoria Castellani e Sergio Farruggia<br />

Con l'avvento<br />

dell'informatica, attraverso<br />

tecnologie e modellazioni<br />

digitali, sentiamo parlare<br />

sempre più di “Digital<br />

Twin” del reale. Tuttavia,<br />

spesso ci dimentichiamo<br />

della necessità di una<br />

solida base di dati ed<br />

informazioni quale quella<br />

offerta da Copernicus<br />

e dell'incertezza che<br />

accompagna tale<br />

Figura 1 - Rappresentazione funzionale del programma Copernicus<br />

approccio<br />

Prima dell’avvento dell’informatica<br />

- e quindi<br />

delle tecnologie binarie<br />

nel mondo scientifico, tecnico<br />

e produttivo - lo strumento<br />

per “comprendere” il reale corrispondeva,<br />

assieme alla sperimentazione,<br />

ai modelli e alle<br />

simulazioni analogiche, fondate<br />

sulla dottrina della misura:<br />

pochi numeri, un pallottoliere<br />

o un regolo calcolatore e grandi<br />

intuizioni.<br />

Con l’avvento del bit e quindi<br />

del byte, l’ambiente e la simulazione<br />

digitale sono diventati<br />

largamente predominanti ed<br />

in moltissimi casi gli unici<br />

possibili, ma al tempo stesso<br />

eccessivamente ingombranti:<br />

sia rispetto ai numeri - ora tanti<br />

-, alla possibilità e potenza<br />

di calcolo sempre maggiori per<br />

produrli, usarli, gestirli e trasformarli<br />

in informazioni; sia<br />

riguardo alle piattaforme per<br />

la rappresentazione, sintetica e<br />

simbolica o anche quasi reale<br />

dei dati e delle informazioni<br />

prodotti.<br />

Digital Twin: “gemello digitale”<br />

della città e del territorio<br />

Nei fatti, l’idea concettuale<br />

di un “sistema gemello” ebbe<br />

origine e conobbe un ampio<br />

sviluppo nell’ambito dei programmi<br />

spaziali degli anni ’60,<br />

sperimentandone la validità in<br />

occasione dell’incidente occorso<br />

alla navicella spaziale Apollo<br />

13 (1970). Il salvataggio degli<br />

astronauti poté avvenire anche<br />

grazie alla disponibilità a terra<br />

di un sistema gemello, riproduzione<br />

identica in tutto e per<br />

tutto, della navicella nello spazio,<br />

attraverso il quale i tecnici<br />

della NASA eseguirono test di<br />

possibili soluzioni, prima di<br />

prendere le decisioni risolutive.<br />

Le soluzioni adottate per realizzare<br />

tali sistemi gemelli sono<br />

progredite di pari passo con<br />

lo sviluppo tecnologico. Alla<br />

fine del secolo scorso e, ancora,<br />

nei primi anni del nuovo<br />

millennio, il concetto è stato<br />

prevalentemente assimilato a<br />

quello di “modello (software)<br />

di simulazione” di un sistema<br />

fisico, messo a punto per studiarne<br />

il comportamento in<br />

fase di progetto.<br />

Il termine “Digital Twin” ha<br />

iniziato ad essere utilizzato<br />

6 <strong>GEOmedia</strong> n°5-<strong>2021</strong>

FOCUS<br />

Il modo enfatico con cui parliamo<br />

di “Digital Twin”, trasciall’inizio<br />

decennio appena<br />

conclusosi, per indicare una copia<br />

virtuale di un prodotto<br />

fisico integrata nel sistema di<br />

gestione del ciclo di vita del<br />

prodotto stesso. La comparsa<br />

dell’approccio sistemico<br />

“Industria 4.0” ha favorito lo<br />

sviluppo e la diffusione di tale<br />

tecnica implementativa, stimolando<br />

l’evoluzione del concetto:<br />

l’uso di questo termine è così<br />

diventato familiare con l’affermarsi<br />

di quel paradigma.<br />

La caratteristica saliente del<br />

gemello digitale è la sua sincronizzazione<br />

con l’entità fisica<br />

simulata e la sua capacità di<br />

reagire -continuativamente- ai<br />

mutamenti delle condizioni<br />

operative del gemello fisico,<br />

fornendo prontamente, ad<br />

esempio, indicazioni per la sua<br />

corretta gestione.<br />

Oggi, ambiziosamente e in<br />

modo anche troppo roboante,<br />

quest’approccio lo chiamiamo<br />

“Digital Twin”, tendendo a<br />

sottintendere o a suggerire “of<br />

the real world” quando lo estendiamo<br />

per descrivere, analizzare<br />

e gestire, se non governare, sistemi<br />

“umani” complessi, come<br />

quelli attribuibili alle nostre<br />

città attuali e non solo.<br />

Infatti, negli ultimi anni dello<br />

scorso decennio, sono stati<br />

avviati i primi progetti pilota<br />

di Digital Twin applicati alle<br />

aree urbane. Per le potenzialità<br />

che questo ambito applicativo<br />

esprime e stante lo sviluppo<br />

delle tecnologie utilizzate<br />

(Internet of Things, Artificial<br />

Intelligence, …), il numero<br />

di città dotate di una propria<br />

copia virtuale è destinato sicuramente<br />

a crescere nei prossimi<br />

anni. Il fenomeno sta interessando<br />

sia metropoli, sia città e<br />

-in generale- territori di diversa<br />

estensione.<br />

Tuttavia, occorre cautela nel<br />

proporlo perché, in particolare<br />

quando si fa riferimento ad<br />

Figura 2 - Rappresentazione a diverse scale dell'inquinamento atmosferico<br />

“Internet of things”, ci si limita<br />

ancora a pensare solo ad una<br />

parte del mondo reale, cioè<br />

quella relativa a manufatti,<br />

macchinari, infrastrutture e<br />

sistemi abitativi, produttivi, logistici<br />

e di monitoraggio, controllo<br />

e sorveglianza, ecc., cioè<br />

appunto a “things”. In questo<br />

caso, la realizzazione ed uso di<br />

un “Digital Twin”, più o meno<br />

completo e complesso, ci appare<br />

non solo realizzabile, ma anche<br />

affidabile e gestibile, mentre<br />

è necessario essere coscienti<br />

che la simulazione “of the real<br />

world” è ben più complessa.<br />

Digital Twin: più tecnologia<br />

impone maggiore consapevolezza,<br />

quindi cultura<br />

La recente introduzione delle<br />

tecniche e metodologie legate<br />

all’uso dell’Intelligenza<br />

Artificiale (IA) nell’ambito<br />

della realizzazione ed uso di<br />

“Digital Twin”, ad esempio nella<br />

medicina e chirurgia assistita,<br />

ed i recenti incidenti occorsi<br />

ai Boeing 737, quali esempi di<br />

competizione uomo-macchina<br />

mal gestita, se da una parte ci<br />

incitano giustamente ad andare<br />

avanti, dall’altra ci segnalano<br />

che molte sono ancora le problematiche<br />

irrisolte e gli aspetti<br />

oscuri e i terreni sconosciuti<br />

offerti alla nostra attenzione da<br />

questo approccio.<br />

L’orientamento “Digital Twin”<br />

non può essere ridotto ad una<br />

applicazione di tecnologie, ma<br />

è soprattutto una metodologia<br />

che si avvale di tecnologie delle<br />

telecomunicazioni e informatiche<br />

e per la sua applicazione<br />

alla simulazione del mondo<br />

reale alcuni elementi nontecnologici<br />

sono essenziali,<br />

debbono essere tenuti presenti,<br />

concorrere tra loro e non devono<br />

essere elusi.<br />

Infatti, dato un fenomeno/<br />

processo/evento da “simulare”,<br />

olisticamente o settorialmente,<br />

tali elementi, possono essere<br />

sinteticamente riportati:<br />

alla conoscenza, o quantomeno<br />

ad una ragionevole<br />

ipotesi teorica degli aspetti<br />

fisici, chimici, biologici,<br />

sociali, economici e quanti<br />

altri, ove presenti e significativi,<br />

e delle relazioni tra<br />

essi esistenti;<br />

al monitoraggio delle grandezze<br />

ritenute significative<br />

per descrivere il fenomeno,<br />

il suo manifestarsi e svilupparsi;<br />

alla conservazione e la disponibilità<br />

dei risultati di<br />

tale monitoraggio e delle conoscenze<br />

sviluppate e verificate<br />

al succedersi e ripetersi<br />

nel tempo di tale fenomeno.<br />

<strong>GEOmedia</strong> n°5-<strong>2021</strong> 7

FOCUS<br />

nati altresì dall’entusiasmo per<br />

uno sviluppo infrastrutturale<br />

e tecnologico assolutamente<br />

necessario, in particolare nel<br />

nostro Paese, dove il divario digitale<br />

e quello anche sociale ed<br />

economico tra le aree interne<br />

e rurali e quelle urbane, è più<br />

che significativo, diciamo pure<br />

inaccettabile, ci fa dimenticare<br />

l’infinita complessità e gli infiniti<br />

gradi di libertà con cui<br />

il mondo è reale e come tale si<br />

manifesta.<br />

Siamo assertivi. Se non annunciamo<br />

“domani pioverà”<br />

comunque affermiamo che<br />

“domani è prevista pioggia”,<br />

ma certamente non diremo<br />

che “domani è prevista un’alta<br />

probabilità che piova”. Siamo<br />

troppo sicuri della nostra “simulazione<br />

del mondo reale”,<br />

mentre “l’incertezza” accompagna<br />

e permea il nostro essere<br />

parte di questo mondo e ci<br />

impone delle “scelte” ad ogni<br />

istante.<br />

Vale la pena ricordare che lo<br />

stesso bit se rappresenta l’unità<br />

elementare di informazione, è<br />

anche la misura della probabilità<br />

tanto di successo che di<br />

insuccesso come nel caso del<br />

lancio di una moneta, pari a<br />

0.5, quando la quantità di “incertezza”<br />

è massima.<br />

Quindi il nostro “Digital<br />

Twin”, pur nella certezza dei<br />

suoi bit, è intrinsecamente permeato<br />

da una incertezza, animata<br />

da ciò che non conosciamo,<br />

né rileviamo, che è e deve<br />

essere oggetto di un nostro<br />

impegno, se non nel misurarla<br />

esattamente, almeno nel percepirla<br />

e possibilmente stimarla.<br />

Il ruolo del Programma<br />

Copernicus<br />

Il Programma europeo di<br />

Osservazione della Terra<br />

Copernicus, attraverso le sue<br />

infrastrutture e servizi rappresenta<br />

una tra le più estese<br />

ed avanzate fonti di dati e<br />

informazioni per realizzazioni<br />

di “Digital Twin” di alcune<br />

parti del mondo reale, relative<br />

all’ambiente terrestre e marino,<br />

ai territori che vi sono immersi,<br />

vi partecipano e che ne fanno<br />

uso. Il Programma stesso vanta<br />

applicazioni avanzate della<br />

metodologia “Digital Twin” a<br />

diverse scale temporali e spaziali,<br />

cioè da quella del tempo<br />

reale a quella dei cambiamenti<br />

climatici, da quelle globale<br />

ed europea a quelle urbana<br />

del giardino pubblico e rurale<br />

dell’appezzamento coltivato.<br />

Infatti, Copernicus non è un<br />

Programma semplicemente<br />

osservativo di monitoraggio<br />

satellitare, ma la sua priorità<br />

Figura 3 - Andamento temporale del NO2 per la città di Milano: gennaio – aprile 2020<br />

sono le informazioni, anche<br />

previsionali, prodotte da servizi<br />

che usano le osservazioni per<br />

alimentare piattaforme simulative,<br />

“Digital Twin”, di fenomeni/processi/eventi<br />

osservati<br />

e/o da osservare.<br />

Il Programma, infatti presenta<br />

ben tre Componenti strettamente<br />

connesse tra loro: le<br />

prime due relative ai servizi<br />

dedicati ai dati rispettivamente<br />

osservativi spaziali e quelli in<br />

situ; la terza, relativa ai servizi<br />

applicativi che producono le<br />

informazioni per le finalità<br />

operative dell’utente finale, sia<br />

esso una istituzione pubblica o<br />

una impresa privata (Figura 1).<br />

Esso rappresenta non solo<br />

una grande sfida per l’Earth<br />

Observation (EO),<br />

per la Geoinformation &<br />

Geomatic (GI) e per le<br />

Information&Comunication<br />

Technology (ICT) e le High<br />

Computing Facilities (HCF)<br />

attraverso, rispettivamente,<br />

la gestione dei Big Data e del<br />

relativo Number Crunching,<br />

ma anche una grande sfida culturale.<br />

Nel fare questo Copernicus è<br />

il primo Programma al mondo<br />

per impegno finanziario,<br />

organizzativo ed operativo nel<br />

monitoraggio ambientale e<br />

dei territori ed è il terzo quale<br />

fornitore di dati ed informazioni,<br />

con un volume di circa<br />

300.000.000 Mbyte giornalieri,<br />

cioè di oltre 30 PBytes al<br />

trimestre, e con oltre 400.000<br />

utenti registrati e fruitori dei<br />

numerosi servizi, offerti liberamente<br />

e gratuitamente a tutti<br />

gli abitanti europei. Infatti, al<br />

di là dei dati satellitari ottenuti<br />

dalle costellazioni di satelliti<br />

del sistema detto Sentinels ed<br />

anche adeguatamente processati<br />

per essere direttamente utilizzabili<br />

in un ambiente GIS,<br />

Copernicus rende disponibili<br />

attraverso i sui sei Core Service,<br />

8 <strong>GEOmedia</strong> n°5-<strong>2021</strong>

FOCUS<br />

cioè l’Emergency management,<br />

il Land, il Marine Environment,<br />

l’Atmosphere, il Climate Change<br />

ed il Security, oltre 800 prodotti<br />

di elevatissimo contenuto<br />

informativo, ufficialmente verificati<br />

e validati con cui è possibile<br />

costruire altri ” Digital<br />

Twin” di scenari complessi.<br />

A titolo di esempio, utilizzando<br />

il Copernicus Atmosphere<br />

Monitoring Service (CAMS)<br />

e la piattaforma di interesse<br />

nazionale che da questo si alimenta[1],<br />

si può seguire giornalmente<br />

l’andamento degli<br />

elementi inquinanti, come il<br />

NO2, e dei particolati, come<br />

il PM10, da una scala sinottica<br />

paneuropea ad una scala urbana<br />

(Figura 2.).<br />

Quindi, procedendo così come<br />

fatto da ECMWF [2], responsabile<br />

della implementazione<br />

e della gestione del CAMS, è<br />

possibile ricostruire ed analizzare<br />

gli effetti del “lockdown”<br />

conseguente al Covid-19 relativamente<br />

alla città di Milano,<br />

tra il 3 gennaio ed il 19 Aprile<br />

2020 (Figura 3).<br />

Tale ricostruzione non si basa<br />

solo sui dati osservati ma anche<br />

su modelli simulativi di “downscaling”<br />

sino alla scala urbana.<br />

È quindi il miglior “Digital<br />

Twin” che possiamo ottenere,<br />

già utile a capire e forse a fare<br />

delle scelte, ma certamente<br />

affetto da quella incompletezza<br />

conoscitiva e rappresentativa<br />

ricordata prima e quindi ancora<br />

insoddisfacente nella sua<br />

rappresentazione del mondo<br />

reale.<br />

Figura 4 - Confronto valori misurati e simulati del livello delle acque, in condizione<br />

di marea normale<br />

genza Artificiale (IA), ci consente<br />

di migliorare la rappresentazione<br />

della realtà.<br />

I dati nei domini spettrale,<br />

temporale e spaziale offrono<br />

possibilità uniche all’IA. Molte<br />

analisi e interpretazioni delle<br />

informazioni sono ancora<br />

eseguite operativamente da<br />

analisti di immagini. Tuttavia,<br />

alcune tecniche per automatizzare<br />

il processo di analisi<br />

stanno avanzando grazie all’inclusione<br />

dell’IA nella progettazione<br />

della maggior parte delle<br />

applicazioni di Digital Twin.<br />

Vengono, infatti, proposte<br />

tecniche ormai classiche di apprendimento<br />

automatico, dalle<br />

reti neurali alle regole Fuzzy<br />

ed agli algoritmi di Support<br />

Vector Machine, nonché nuovi<br />

approcci di Deep Learning per<br />

affrontare i problemi di modellistica<br />

più impegnativi. Ciò<br />

consente anche l’inclusione<br />

continua di input diversi e lo<br />

sfruttamento della capacità di<br />

affinamento per approssimazioni<br />

successive, necessari per<br />

raggiungere lo sviluppo del<br />

Digital Twin. I risultati di questa<br />

attività sono quindi elaborati<br />

ed integrati nello sviluppo<br />

Digital Twin Earth attraverso<br />

l’uso di approcci qualitativi o<br />

semiquantitativi che esplorano<br />

valori e modelli separati, come<br />

IA e saggezza:<br />

convergenza cognitiva<br />

Tuttavia, il riconoscimento<br />

dell’incertezza ci può offrire un<br />

punto di vista diverso, ben rappresentato<br />

dalla “teoria degli<br />

insiemi fuzzy” o “logica fuzzy”<br />

che, correttamente accoppiata<br />

alle metodologie dell’Intellila<br />

mappatura cognitiva fuzzy<br />

ottenibile attraverso la mappatura<br />

delle misure (Bozzeda,<br />

F., 2013) [3], la mappatura<br />

cognitiva (Eden, Colin., 2004)<br />

[4] e la mappatura concettuale<br />

(Baja, S., Chapman, D.<br />

M., & Dragovich, D., 2002)<br />

[5]. Sviluppo di un approccio<br />

congiunto fuzzy-Bayesiano<br />

per l’analisi e la modellizzazione<br />

degli ecosistemi: applicazione<br />

ad ecosistemi marini<br />

costieri.- http://amsdottorato.<br />

unibo.it/5225/#), la mappatura<br />

cognitiva (Eden, Colin.<br />

“Analyzing cognitive maps to<br />

help structure issues or problems.”<br />

European Journal of<br />

Operational Research 159.3<br />

(2004): 673-686.) e la mappatura<br />

concettuale (Baja,<br />

S., Chapman, D. M., &<br />

Dragovich, D. (2002). A conceptual<br />

model for defining and<br />

assessing land management<br />

units using a fuzzy modeling<br />

approach in GIS environment.<br />

Environmental management,<br />

29(5), 647-661.). L’approccio<br />

adottato consiste in una sequenza<br />

di fasi, in cui singoli<br />

elementi o prodotti separati<br />

dell’intero modello della gestione<br />

sostenibile degli eventi<br />

estremi in fascia costiera,<br />

vengono sviluppati in modo<br />

relativamente indipendente<br />

<strong>GEOmedia</strong> n°5-<strong>2021</strong> 9

FOCUS<br />

e con tempi diversi, per consentire<br />

un’ampia integrazione<br />

(Taramelli et al., 2017). I risultati<br />

possono:<br />

estendere set di dati e variabili<br />

coinvolte nella modellazione<br />

dei processi descritti<br />

nei casi applicativi,<br />

mappare i parametri in base<br />

al tipo di parametro e alle<br />

regioni geografiche in cui<br />

viene applicato.<br />

Un esempio particolarmente<br />

significativo è quello relativo<br />

alla simulazione degli eventi<br />

mareali estremi che interessano<br />

Venezia, per i quali, altresì,<br />

sono disponibili consistenti<br />

serie storiche di misure mareografiche<br />

delle variazioni medie<br />

del livello del mare in più siti<br />

lagunari e non.<br />

Bellafiore e Umgiesser<br />

(Venezia, CNR, 2012) hanno<br />

stabilito che gli eventi di acqua<br />

alta nella laguna di Venezia<br />

dipendono da diversi fattori,<br />

-anche locali- e l’applicazione<br />

dell’approccio precedentemente<br />

e sommariamente illustrato<br />

sopra ci permette di farne<br />

emergere le possibili conseguenze.<br />

Le simulazioni fatte si basano<br />

su 10 anni di dati (dal 2000 al<br />

2010) e tengono conto delle<br />

Figura 5 - Confronto valori misurati e simulati di dislivello delle acque, in condizione<br />

di marea estrema<br />

maree effettive, delle maree<br />

astronomiche, delle altezze<br />

delle onde, della direzione e<br />

della velocità del vento, nonché<br />

della pressione atmosferica,<br />

simulate attraverso misure ogni<br />

10 minuti. Esse utilizzano un<br />

semplice modello di Fuzzy-<br />

Bayes [6] (Taramelli et al.,<br />

2017), in cui la struttura del<br />

modello fisico è nascosta nei<br />

dati che vengono utilizzati per<br />

la stima.<br />

Una prima simulazione a cui si<br />

riferisce la figura 4, è relativa<br />

ad una marea normale e nulla<br />

emerge di particolarmente<br />

anomalo, se non una buona<br />

qualità della simulazione stessa.<br />

Invece, in una seconda simulazione,<br />

relativa ad un evento<br />

estremo in cui il livello dell’acqua<br />

alta raggiunge 1,6 metri al<br />

di sopra dell’altezza di marea<br />

media, così come calcolata<br />

rispetto all’insieme di tutti i<br />

dati utilizzati con un approccio<br />

fuzzy-bayesiano, viene identificata<br />

una potenziale biforcazione<br />

dell’andamento di marea<br />

a cui seguirebbe un regime<br />

di marea più alta e quindi un<br />

ritorno a regimi di marea più<br />

bassa, non evidenziabile attraverso<br />

altri approcci simulativi<br />

(Figura 5.).<br />

Tuttavia, ancora più complesso,<br />

e quindi ancor più<br />

affetto da incertezza, resta<br />

l’utilizzo di quanto prodotto<br />

da Copernicus, per alimentare<br />

piattaforma simulative “Digital<br />

Twin” in grado di costruire ed<br />

integrare, anche in combinazione<br />

tra loro, scenari multipli,<br />

destinati ad esempio a valutare<br />

il quadro complessivo dei costi<br />

e benefici conseguenti a diverse<br />

sorgenti di rischio ed alle possibili<br />

azioni di contrasto per<br />

contenerne e/o mitigarne gli<br />

effetti.<br />

Ciò diventa ancor più arduo se<br />

ci riferiamo ad ambienti urbani<br />

in cui le dinamiche sociali<br />

e della vita quotidiana sono<br />

“regolate” tanto da una ordinarietà,<br />

quanto da grandi eventi,<br />

anche eccezionali o considerabili<br />

tali, non solo di origine<br />

naturale, come potrebbero<br />

essere un grande concerto, una<br />

partita di calcio o un evento<br />

fieristico di rilevanza.<br />

Per le finalità della Protezione<br />

Civile Nazionale, il Centro<br />

Internazionale in Monitoraggio<br />

Ambientale (Fondazione<br />

CIMA) ha concorso allo<br />

sviluppo della piattaforma<br />

RASOR [7], alimentata con<br />

dati e informazioni rese disponibili<br />

tanto dal Copernicus<br />

Emergency Management<br />

Service (CEMS), gestita dal<br />

Joint Research Centre (JRC)<br />

europeo, quanto dagli altri Core<br />

Services e destinata a costruire<br />

scenari di rischio, attesi o in<br />

essere, assieme ai conseguenti<br />

scenari di danno. La piattaforma<br />

si applica ad eventi estremi<br />

complessi, senza o con interventi<br />

di mitigazione, tenendo<br />

altresì conto degli scenari di<br />

cambiamento climatico, ma<br />

è utilizzabile in tempo reale e<br />

può integrare altre informazioni<br />

di diversa natura e origine,<br />

come quelle prodotte dagli abitanti<br />

attraverso i media.<br />

Un buon esempio, seppur<br />

10 <strong>GEOmedia</strong> n°5-<strong>2021</strong>

FOCUS<br />

limitato ad un evento di sola<br />

origine naturale è l’applicazione<br />

di RASOR ad un caso<br />

idrometeorologico estremo che<br />

ha colpito la città di Genova,<br />

alluvionandola con significativi<br />

danni a persone e beni, e la<br />

simulazione degli effetti della<br />

realizzazione di possibile mitigazione<br />

conseguenti alla realizzazione<br />

del canale scolmatore<br />

del Torrente Bisagno, intervento<br />

infrastrutturale ad oggi non<br />

ancora realizzato (Figura 6).<br />

Anche in questo caso, ove si<br />

vogliano tenere in conto e simulare<br />

i comportamenti umani<br />

e sociali, un approccio cognitivo<br />

e Fuzzy potrebbe essere<br />

utilizzato, non solo utilizzando<br />

dati ed informazioni statistiche<br />

disponibili, ma anche quelli<br />

ottenibili attraverso metodi<br />

di rilevamento e analisi della<br />

messaggistica social, oppure attraverso<br />

indagini di campo mirate,<br />

come nel caso dell’analisi<br />

della percezione e dell’accettabilità<br />

dell’implementazione<br />

delle “Green Infrastructure”,<br />

definite dall’UE nel 2013, da<br />

parte della Comunità agricola<br />

nazionale.<br />

Copernicus ed i “Digital<br />

Twin” in un futuro europeo<br />

molto prossimo<br />

Copernicus, altresì, si dimostra<br />

un sistema, non solo abilitante,<br />

ma essenziale per lo sviluppo<br />

di una iniziativa chiave a livello<br />

europeo come “Destination<br />

Earth” che lega tra loro quelle<br />

promosse nell’ambito: (i) del<br />

“Green Deal”, volto al raggiungimento<br />

della neutralità<br />

climatica entro il 2050, (ii)<br />

dell’“European Strategy for<br />

Data“, mirata alla creazione<br />

all’interno dell’UE di una libera<br />

ed accessibile circolazione<br />

di dati ed informazioni, e (iii)<br />

del “Shaping Europe’s digital<br />

future”, destinato tanto a garantire<br />

la transizione digitale in<br />

Figura 6 - Descrizione sinottica della piattaforma RASOR applicata ad un evento idrometeorologico estremo<br />

Europa, quanto a diventare un<br />

modello di riferimento mondiale<br />

per l’economia digitale.<br />

Infatti “Destination Earth”<br />

mira a sviluppare un modello<br />

digitale della Terra, cioè un<br />

Digital Twin, di alta e tale<br />

qualità da essere in grado di<br />

monitorare e simulare eventi<br />

naturali ed attività umane,<br />

nonché di sviluppare e validare<br />

scenari utili:<br />

al raggiungimento degli<br />

obiettivi del Green Deal;<br />

alla protezione delle vite degli<br />

abitanti e dell’economia<br />

dell’UE;<br />

a promuovere, sostenere<br />

e realizzare le politiche<br />

dell’UE;<br />

a consolidare e rinforzare le<br />

capacità e la competitività<br />

tecnologica ed industriale<br />

dell’UE in materia di<br />

“advanced computing, simulation,<br />

modelling, predictive<br />

data analytics ad artificial<br />

intelligence”.<br />

Per il raggiungimento di tali<br />

obiettivi quattro sono i pilastri<br />

a cui l’iniziativa europea<br />

si affida, così come mostrato<br />

nella figura seguente, e non<br />

può non essere ravvisato come<br />

Copernicus, non solo ne faccia<br />

parte integrante, ma ne sia<br />

stato un prodomo nella sua<br />

architettura istituzionale, funzionale<br />

ed operativa, nonché<br />

nello sviluppo di ciascuna delle<br />

sue componenti e delle azioni<br />

poste in essere.<br />

Conclusioni e raccomandazioni<br />

finali<br />

In conclusione, l’approccio<br />

“Digital Twin” è tra noi da<br />

tempo, ma forse non ne eravamo<br />

coscienti e oggi ci rende<br />

disponibili informazioni ancora<br />

impensabili in un non<br />

lontanissimo passato, consegnandoci,<br />

tuttavia, anche la<br />

responsabilità della gestione<br />

dell’incertezza che le accompagna.<br />

La sua utilità, ma anche i<br />

suoi limiti, sono emersi dalla<br />

necessità e/o dalla volontà di<br />

simulare, fronteggiare e gestire<br />

scenari, significativamente più<br />

incerti e sfumati, di quelli pro-<br />

<strong>GEOmedia</strong> n°5-<strong>2021</strong> 11

FOCUS<br />

NOTE<br />

[1] La piattaforma è stata sviluppata nell’ambito di un Accordo<br />

ASI-ISPRA con il concorso di alcune Agenzie del Sistema Nazionale<br />

per la Protezione dell’Ambiente (SNPA)<br />

[2] European Centre for Medium range Weather Forecast (EC-<br />

MWF).<br />

[3] Bozzeda, F. (2013). Sviluppo di un approccio congiunto<br />

fuzzy-Bayesiano per l’analisi e la modellizzazione degli ecosistemi:<br />

applicazione ad ecosistemi marini costieri.- http://amsdottorato.<br />

unibo.it/5225/#<br />

[4] Eden, Colin. “Analyzing cognitive maps to help structure<br />

issues or problems.” European Journal of Operational Research<br />

159.3 (2004): 673-686.<br />

[5] Baja, S., Chapman, D. M., & Dragovich, D. (2002). A conceptual<br />

model for defining and assessing land management units<br />

using a fuzzy modeling approach in GIS environment. Environmental<br />

management, 29(5), 647-661.<br />

[6] Taramelli, A., Valentini, E., Cornacchia, L., & Bozzeda, F.<br />

(2017). A hybrid power law approach for spatial and temporal<br />

pattern analysis of salt marsh evolution. Journal of Coastal Research,<br />

(77), 62-72.<br />

[7] La piattaforma RASOR (Rapid Analysis and Spatialization<br />

Of Risk) è stata sviluppata dalla Fondazione CIMA, le, assieme<br />

ad altri soggetti nazionali ed europei, nell'ambito del Programma<br />

europeo FP7 Copernicus (www.rasor-project.eu)<br />

Figura 7 - Descrizione schematica dell’iniziativa europea “Destination Earth”<br />

posti dal “mondo delle cose”<br />

e di farlo anche a livello di<br />

dettaglio e particolare, pur<br />

conservandone la complessità<br />

e generalità della rappresentazione.<br />

Infine, la disponibilità di un<br />

“gemello digitale” del reale<br />

ci lascia con alcune questioni<br />

non secondarie a partire da<br />

quella di come comunicare<br />

all’utente finale, assieme alle<br />

indubbie positività offerte<br />

dal suo impiego, anche l’esistenza<br />

dell’incertezza che<br />

ineludibilmente lo accompagna<br />

ed affligge, e, in particolare,<br />

di come farlo verso la<br />

Pubblica Amministrazione,<br />

convincendola ad introdurre<br />

l’uso di tale metodologia nei<br />

propri processi tanto amministrativi<br />

quanto decisionali,<br />

nonchè ad avvalersi di nuovi<br />

profili professionali non solo<br />

tecnologici, ma anche gestionali,<br />

e ad accettare di essere<br />

informata, formata ed addestrata<br />

a tal fine.<br />

Tutto ciò richiede un grande<br />

dispiegamento oltre che di<br />

competenze, conoscitive,<br />

gestionali, di risorse tecnologiche,<br />

infrastrutturali,<br />

ma anche, se non soprattutto,<br />

umane e finanziarie<br />

così come il Programma<br />

Copernicus continua a dimostrarci<br />

a livello non solo<br />

europeo.<br />

PAROLE CHIAVE<br />

Digital twin; copernicus; monitoraggio; servizi;<br />

incertezza<br />

ABSTRACT<br />

The "digital twins" applied to cities and territories -as well as to<br />

their inhabitants- are already a reality and also at our disposal<br />

for the future. Therefore, being creators and/or beneficiaries of<br />

these artifacts, we all must learn to live with them. In fact, the<br />

increasing complexity of our living conditions and of the knowledge<br />

and technologies needed and used to deal with it, requires<br />

us to consider uncertainty unavoidable. We have to be aware of<br />

it and relate to it responsibly, particularly when we make use of<br />

the impressive amount of information that Earth Observation<br />

programs, such as Copernicus, produce and make available to us.<br />

AUTORE<br />

Andrea Taramelli<br />

andrea.taramelli@isprambiente.it<br />

Delegato Nazionale al Committee e allo User Forum<br />

europei di Copernicus<br />

Bernardo De Bernardinis<br />

bdb.posta@gmail.com<br />

Maria Vittoria Castellani<br />

maria.castellani@isprambiente.it<br />

Coordinamento Nazionale della Copernicus Academy<br />

Sergio Farruggia<br />

sergio.farruggia@statigeneralinnovazione.it<br />

Stati Generali dell'Innovazione<br />

12 <strong>GEOmedia</strong> n°5-<strong>2021</strong>

FOCUS<br />

<strong>GEOmedia</strong> n°5-<strong>2021</strong> 13

REPORT<br />

Oltre le SDI: quali prospettive<br />

di Franco Vico<br />

Il concetto di SDI è stato<br />

introdotto all’inizio degli anni ‘90:<br />

oggi è in corso, a livello globale,<br />

un dibattito sul suo futuro. Le<br />

ipotesi sono varie, e sono stati<br />

proposti anche nomi diversi. Non<br />

ostante il quadro frastagliato che<br />

emerge, in parte contraddittorio,<br />

in parte semplicemente vago,<br />

sono individuabili alcuni punti di<br />

Fig. 1 – La Geospatial infrastructure secondo Dangermont (fonte: https://www.youtube.com/watc<br />

h?v=MvyOQoiHAqU&list=PLaPDDLTCmy4YwK56yHaEdtRgNUoPBiZTz&index=3&t=0s<br />

convergenza tra le varie posizioni.<br />

Il concetto di Spatial Data<br />

Infrastructure è stato<br />

definito per la prima volta<br />

in una sede istituzionale nel<br />

1994 negli USA, più di un<br />

quarto di secolo fa. Oggi appare<br />

un po’ appannato.<br />

EUROGI: Beyond spatial<br />

data infrastructures<br />

Nel maggio 2020 EUROGI<br />

ha promosso una iniziativa<br />

intitolata “Beyond spatial data<br />

infrastructures” mettendo<br />

insieme 16 persone di spicco<br />

nel mondo dell’informazione<br />

geospaziale a livello globale, a<br />

cui ha chiesto una pagina di<br />

riflessioni sulle prospettive.<br />

Questa prima fase si è chiusa<br />

con un webinar. Nel maggio<br />

<strong>2021</strong> EUROGI ha organizzato<br />

un secondo webinar sullo stesso<br />

tema.<br />

Le opinioni presentate in<br />

queste sedi sono state piuttosto<br />

varie, salvo che su un punto: è<br />

necessario cambiare, innovare…<br />

Intervenendo al webinar<br />

EUROGI del 2020, il<br />

presidente di OGC, Bart de<br />

Lathouwer, ha notato che OGC<br />

non ha mai pubblicato un<br />

documento con SDI nel titolo,<br />

anche se ha messo a punto i<br />

building blocks delle SDI. Ora<br />

però OGC “is actively seeking<br />

... to further shape the future of<br />

SDIs in its Concept Development<br />

Study Modernizing SDI”.<br />

Tra gli esperti invitati c’era Ed<br />

Parson, che spesso si assume il<br />

compito, a nome di Google,<br />

di “evangelise geospatial data”.<br />

Parson afferma che le SDI<br />

sono morte, anzi non sono<br />

mai realmente nate. Una<br />

provocazione certo, che però ha<br />

un fondamento di verità.<br />

La suggestione di Parson è<br />

“to take a more conventional<br />

web based approcch”. Il suo<br />

riferimento è un documento<br />

intitolato Spatial Data on the<br />

web Best Practices., prodotto da<br />

un gruppo di lavoro congiunto<br />

OGC-W3C, rilasciato nel<br />

2017, che forse è restato un po’<br />

ignorato. L’idea è appunto il<br />

superamento delle SDI verso<br />

qualcosa di meno strutturato: i<br />

dati spaziali sono immersi nel<br />

web, loosly coupled...<br />

Altri partecipanti alle iniziative<br />

EUROGI 2020 e <strong>2021</strong> hanno<br />

espresso più o meno la stessa<br />

opinione (nessun altro però ha<br />

fatto esplicito riferimento al<br />

documento OGC-W3C 2017).<br />

La domanda è: questo<br />

approccio può essere efficiente<br />

ed efficace per la ricerca e<br />

concreto riuso dei dati spaziali?<br />

E c’è la questione della<br />

interoperabilità, in particolare<br />

per l’interoperabilità semantica:<br />

a meno di modelli dati<br />

dichiarati, almeno compatibili<br />

se non standardizzati, un<br />

effettivo riutilizzo dei dati mi<br />

sembra impossibile.<br />

Tornando al Documento<br />

OGC-W3C: “The key problems<br />

... are discoverability, accessibility<br />

and interoperability. Our<br />

overarching goal is to enable<br />

spatial data to be integrated<br />

within the wider Web of data;<br />

providing standard patterns and<br />

solutions that help solve these<br />

14 <strong>GEOmedia</strong> n°5-<strong>2021</strong>

REPORT<br />

problems” (OGC-W3C 2017,<br />

p. 1). Il documento OGC-<br />

W3C è certamente interessante:<br />

è scritto in modo piuttosto<br />

diverso rispetto ai documenti<br />

INSPIRE (per inciso, non viene<br />

mai citato INSPIRE); tocca<br />

anche aspetti molto pratici (ad<br />

es. differenti rappresentazioni<br />

dello stesso oggetto…). L’enfasi<br />

è sul web; ma ovviamente,<br />

senza web, le SDI non possono<br />

esistere. Questo documento<br />

non è stato aggiornato dopo<br />

il 2017, ma c’è, tuttora attivo,<br />

un Interest Group. È difficile<br />

però valutare quanto questa<br />

iniziativa congiunta di OGC e<br />

W3C (due soggetti certo non<br />

irrilevanti nel mondo del web e<br />

dell'informazione geospaziale)<br />

abbia avuto influenze pratiche:<br />

io non ho trovato riscontri,<br />

commenti...<br />

Geospatial infrastructure,<br />

Geospatial Knowledge<br />

Infrastructure<br />

L’idea che sta emergendo con<br />

più forza è una evoluzione del<br />

concetto di SDI verso quello<br />

di una infrastruttura che non<br />

sia solo fatta di dati. Nel luglio<br />

2020 nella plenaria di apertura<br />

della User Conferenze ESRI,<br />

Dangermond ha tratteggiato<br />

la sua vision, nella quale<br />

ha un ruolo importante la<br />

Geospatial Infrastructure. La<br />

Fig. 1 rappresenta questa vision.<br />

L’eliminazione del termine data<br />

corrisponde all’idea di andare<br />

oltre la SDI data-centric. L’idea<br />

è che, nell’infrastruttura, le<br />

“GIS capabilities are becoming<br />

embedded” e che ci saranno<br />

le app che devono fornire<br />

un “frictionless access” alla<br />

conoscenza geospaziale.<br />

Questi concetti espressi<br />

da Dangermon sono stati<br />

proposti anche da altri, in<br />

contesti diversi e magari con<br />

termini diversi. Non va nella<br />

stessa direzione anche, ad es.,<br />

Fig. 2 - Il rapporto tra urban digital twin e realtà urbana, rappresentato iconicamente da ARUP<br />

(fonte: ARUP 2019, p. 20)<br />

l’idea delle DIAS (Data and<br />

Information Access Services)<br />

proposta dal progetto europeo<br />

Copernicus?<br />

Nella stessa direzione è andata,<br />

nel febbraio di quest’anno,<br />

il Geospatial Knowledge<br />

Infrastructure Summit,<br />

una conferenza virtuale<br />

veramente globale (https://<br />

geospatialmedia.net). I punti<br />

chiave sono stati: non raw<br />

data ma “knowledge services<br />

on demand“, la creazione<br />

di un geospatial ecosystem<br />

focalizzato sui servizi e sulla<br />

domanda degli utenti, basato<br />

su open data, open tools per<br />

l’analisi e la visualizzazione,<br />

e sul partenariato pubblicoprivato.<br />

La Fig. 3 rappresenta<br />

la piramide Dati-Informazione-<br />

Conoscenza della Geospatial<br />

Knowledge Infrastructure.<br />

Geospatial Infrastrucure e<br />

Digital Twin<br />

Nel suo intervento di pochi<br />

minuti, in apertura della<br />

Conferenza ESRI Italia <strong>2021</strong>,<br />

Dangermon cita 6 volte il<br />

termine “digital twin”. L’idea del<br />

DT, nella sostanza, non è nuova<br />

e si può far risalire alle missioni<br />

spaziali americane degli anni<br />

‘60-’70. In particolare, nel<br />

caso dell’Apollo 13 nel 970,<br />

la disponibilità di un modello<br />

digitale della navicella fu<br />

decisivo per salvare i tre uomini<br />

di equipaggio, dopo una<br />

esplosione a bordo, simulando<br />

le diverse manovre da fare<br />

e inviando all’equipaggio le<br />

indicazioni necessarie.<br />

L’uso, per la prima volta,<br />

del termine “digital twin” è<br />

attribuito a Michael Grieves,<br />

nel 2003: nella diffusione<br />

del concetto ha certamente<br />

avuto un ruolo un nome<br />

così suggestivo. Negli anni<br />

più recenti, generalizzando<br />

la pratica che si era andata<br />

diffondendo nel mondo<br />

industriale, il concetto DT è<br />

stato anche applicato a temi<br />

che hanno una dimensione<br />

spaziale. Un esempio pratico<br />

molto chiaro riguarda le<br />

infrastruttura a rete, in cui il<br />

DT integra informazioni di<br />

<strong>GEOmedia</strong> n°5-<strong>2021</strong> 15

REPORT<br />

Fig. 3 - La piramide Dati-Informazione-Conoscenza della Geospatial Knowledge Infrastructure<br />

(fonte: Geospatial World media+communication, United Nation Statistic Division <strong>2021</strong>, p. 10).<br />

fonti molto diverse, relative alle<br />

localizzazione della reti, alle<br />

caratteristiche degli impianti...,<br />

con informazioni provenienti<br />

da sensori, con tools per la<br />

simulazione dei flussi e degli<br />

effetti di eventi imprevisti,<br />

per la gestione della azioni<br />

di manutenzione e la loro<br />

previsione, per la visualizzazione<br />

e la comunicazione…<br />

Le parole chiave sono<br />

quindi: integrazione di dati,<br />

modellazione, simulazione,<br />

comunicazione. Ampliando<br />

gli ambiti di applicazione, con<br />

riferimento alla dimensioni<br />

complessive di territori, si parla<br />

di urban digital twin (UDT),<br />

ma anche di National DT e di<br />

Earth DT.<br />

Nell’implementazione del<br />

concetto di UDT, il punto<br />

è ancora usare e integrare<br />

efficacemente le informazioni<br />

esistenti, cioè alla base ci sono<br />

i pilastri delle SDI: riuso dei<br />

dati, interoperabilità (e quindi<br />

standard).<br />

Ciò, oggi, è ampiamente<br />

riconosciuto. Il titolo della<br />

recente conferenza Geospatial<br />

Worls Forun <strong>2021</strong> (ad<br />

Amsterdam, a ottobre) è<br />

Geospatial Infrastrucure &<br />

Digital Twin.<br />

Ed è stato pubblicato su<br />

GW weekly del 19 Aprile<br />

<strong>2021</strong>, un editoriale intitolato<br />

“Geospatial Infrastructure. A<br />

Prerequisite for Efficient Digital<br />

Twins”: esattamente quello che<br />

sostengo.<br />

In alcuni esempi di UDT<br />

che ho visto, c’è una forte<br />

enfasi sulla forma fisica della<br />

città, con la creazione di<br />

visualizzazioni 3D dello spazio<br />

urbano, più o meno realistiche,<br />

navigabili… Ciò avvicina<br />

UDT al Building Information<br />

Modeling (BIM). La Fig. 2<br />

rappresenta in modo iconico<br />

il rapporto tra realtà urbana e<br />

UDT. Il risultato è certamente<br />

d’effetto, ma è chiaro che una<br />

città è di più degli edifici e<br />

degli spazi urbani: una città è<br />

la somma e l’interazione delle<br />

persone che in essa risiedono,<br />

lavorano, passano (per i più<br />

svariati motivi), delle attività<br />

economiche che si svolgono,<br />

del come le persone e le merci<br />

si muovono… Se si considera<br />

tutto questo il nesso UDT SDI<br />

diventa determinante: la SDI<br />

è il core del UDT, e il UDT<br />

fa crescere l’importanza della<br />

infrastruttura di dati.<br />

E INSPIRE?<br />

Come detto, nel documento<br />

OGC-W3C il termine<br />

INSPIRE non è citato. Ma<br />

INSPIRE, in cui l’Europa e gli<br />

Stati Membri hanno investito<br />

tante risorse, dal 2007 ad<br />

oggi, non è stata richiamata<br />

in nessuno dei vari eventi/<br />

documenti citati sopra.<br />

Ma qual è lo stato di INSPIRE?<br />

Non ho trovato alcuna analisi<br />

recente di soggetti terzi che<br />

dia un quadro. L’ultimo report<br />

ufficiale di monitoraggio,<br />

annuale, previsto dalla stessa<br />

Direttiva INSPIRE, è quello<br />

relativo al 2019 (Minghini<br />

2020). La sua caratteristica (il<br />

suo limite) è che è finalizzato<br />

a verificare se e quanto la<br />

macchina INSPIRE funziona<br />

come era stato previsto, e non<br />

se e quanto i suoi output sono<br />

usati e rispondono ai fabbisogni<br />

di informazione geospaziale. Il<br />

rapporto evidenzia che i risultati<br />

sono assolutamente eterogenei<br />

tra i diversi stati (“eterogenei”<br />

è un eufemismo: i numeri che,<br />

ad es. per quanto riguarda il<br />

numero dei dataset presenti, nel<br />

2019, variano da 42 a 42066!),<br />

e ammette che “after 13 years<br />

from the entry into force of the<br />

Directive, there is no single<br />

country which has yet achieved<br />

full implementation according to<br />

the roadmap” (Minghini 2020,<br />

p.1).<br />

A questo punto, all’interno<br />

dello stesso INSPIRE<br />

Maintenance and<br />

Implementation Group<br />

(MIG, a cui partecipano<br />

anche rappresentanti degli<br />

stati membri), è opinione<br />

condivisa che sia necessario<br />

rivedere parecchie cose:<br />

“The current architecture of<br />

INSPIRE is outdated…[Sono<br />

emerse] new data sources and<br />

new technologies... INSPIRE<br />

is often seen as a monolithic<br />

infrastructure with few links to<br />

16 <strong>GEOmedia</strong> n°5-<strong>2021</strong>

REPORT<br />

other existing infrastructures<br />

(INSPIRE MIG <strong>2021</strong> a ). La<br />

proposta è di focalizzarsi sui<br />

temi/dataset che possono<br />

portare tangibili benefici alla<br />

definizione delle politiche<br />

prioritarie europee, anzi,<br />

di più, di focalizzarsi su<br />

quei temi/datasets che sono<br />

connessi all’e-Reporting, cioè<br />

in qualche modo sono richiesti<br />

per rispondere a adempimenti<br />

previsti da regolamento o<br />

direttive (INSPIRE MIG<br />

<strong>2021</strong>b).<br />

Punti di convergenza<br />

Dai documenti, webinar,<br />

conferenze... richiamati qui<br />

sopra, tutti piuttosto recenti,<br />

riguardanti più il futuro che<br />

il presente delle SDI, emerge<br />

un quadro frastagliato, in<br />

parte contraddittorio, in parte<br />

semplicemente vago. Non ci<br />

sono riferimenti ad analisi<br />

sull’effettivo utilizzo delle SDI,<br />

sulla accessibilità e usabilità<br />

dei dati… (questo perché a<br />

mio avviso mancano: è un<br />

limite serio).<br />

In questi contributi c’è una<br />

forte focalizzazione sulla<br />

dimensione tecnologica,<br />

come quasi sempre avviene,<br />

una focalizzazione eccessiva<br />

se consideriamo che nei<br />

processi di implementazione<br />

ed evoluzione delle SDI<br />

(e di quello che verrà) la<br />

dimensione politica, e quella<br />

culturale (formazione e cultura<br />

delle persone) hanno avuto,<br />

e avranno ancora, un ruolo<br />

critico.<br />

Conclusivamente, non ostante<br />

la varietà degli approcci<br />

possono essere individuati<br />

alcuni punti di generale<br />

convergenza.<br />

- I fondamentali delle SDI,<br />

che stanno nell’acronimo,<br />

diventato di uso generale,<br />

FAIR (che sta per Findable,<br />

Accessible, Interoperable,<br />

Reusable), sono tuttora<br />

rilevanti. L’informazione<br />

geospaziale è più importante<br />

che mai, ed è ovunque. E i<br />

fondamentali delle SDI.<br />

- Se tradizionalmente nelle<br />

SDI i provider di dati sono<br />

soggetti pubblici, bisogna<br />

prendere atto che i produttori<br />

di geoinformazione si<br />

sono moltiplicati: non può<br />

essere ignorato il ruolo<br />

dell’informazione geografica<br />

commerciale, prodotta da<br />

soggetti come Google, ma<br />

anche il ruolo ad es. di Open<br />

Street Map, della volunteered<br />

geographic information e<br />

del crowdsourcing, e della<br />

geospatial information<br />

generata dai BigData.<br />

Questa constatazione viene<br />

accettata praticamente da<br />

tutti (INSPIRE incluso), e<br />

porta ad introdurre il termine<br />

geospatial ecosystem (o analoghe<br />

formulazioni) in cui settore<br />

pubblico e i molteplici<br />

soggetti privati interagiscono<br />

sinergicamente.<br />

- Mettere al centro gli<br />

utilizzatori: il geospatial<br />

ecosystem è al servizio di<br />

utilizzatori non immaginari,<br />

con la cui domanda di<br />

informazione geospaziale è<br />

indispensabile interagire.<br />

- Usabilità: non dati ma<br />

informazione, o forse meglio<br />

conoscenza, ovvero “actionable<br />

information” (espressione<br />

molto pragmatica usata da<br />

Nadine Alameh, CEO di<br />

OGC, nel webinar EUROGI<br />

del 25 maggio <strong>2021</strong>). Quindi,<br />

accessibilità, interoperabilità,<br />

strumenti.<br />

- Politiche chiare volte a<br />

facilitare l’uso di dati e<br />

strumenti, quindi Open Data<br />

o, più in generale, riferimento<br />

a sistemi di licenze consolidati<br />

(ad es. Creative Commons).<br />

BIBLIOGRAFIA<br />

ARUP (2019), Digital twin. Toward a<br />

meaninful framework, https://www.arup.<br />

com/perspectives/publications/research/<br />

section/digital-twin-towards-a-meaningful-framework<br />

(Retrived: 03-06-<strong>2021</strong>)<br />

Geospatial World media+communication,<br />

United Nation Statistic Division (<strong>2021</strong>),<br />

The power of where. Geospatial<br />

knowlegde infrastructure white paper,<br />

https://geospatialmedia.net/pdf/GKI-<br />

White-Paper.pdf (Retrived: 03/06/<strong>2021</strong>)<br />

INSPIRE MIG (<strong>2021</strong>a), Action 1.1<br />

Towards a digital ecosystem for the<br />

environment and sustainability, https://<br />

webgate.ec.europa.eu/fpfis/wikis/display/<br />

InspireMIG/Action+1.1+Towards+a+digit<br />

al+ecosystem+for+the+environment+and+<br />

sustainability (Retrieved: 31-05-<strong>2021</strong>)<br />

INSPIRE MIG (<strong>2021</strong>b), Action 2.1<br />

Need-driven data prioritisation, https://<br />

webgate.ec.europa.eu/fpfis/wikis/<br />

display/InspireMIG/Action+2.1+Needdriven+data+prioritisation<br />

(Retrieved:<br />

31-05-<strong>2021</strong>)<br />

Kotsev A. et al. (2020), From Spatial<br />

Data Infrastructures to Data Spaces. A<br />

Technological Perspective on the Evolution<br />

of European SDIs, ISPRS Int. J.<br />

Geo-Inf. 2020, 9, 176, https://www.mdpi.<br />

com/2220-9964/9/3/176 (Retrieved:<br />

31-05-<strong>2021</strong>)<br />

Minghini M. et. al (2020), Establishing a<br />

new baseline for monitoring the status of<br />

EU Spatial Data Infrastructure, https://<br />

publications.jrc.ec.europa.eu/repository/<br />

handle/JRC122351<br />

OGC-W3C (2017), Spatial Data on the<br />

web Best Practices, https://www.w3.org/<br />

TR/sdw-bp/ (Retrieved: 31-05-<strong>2021</strong>)<br />

PAROLE CHIAVE<br />

SDI; Geospatial Infrastrucure, Geospatial<br />

Ecosystem, INSPIRE, Urban<br />

Digital Twin<br />

ABSTRACT<br />

The SDI concept was introduced in the<br />

early 90s: today is underway, globally, a<br />

debate on its future.<br />

AUTORE<br />

Franco Vico<br />

Già docente di Analisi GIS per la<br />

pianificazione spaziale al Politecnico<br />

di Torino<br />

e-mail franco.vico@formerfaculty.<br />

polito.it<br />

<strong>GEOmedia</strong> n°5-<strong>2021</strong> 17

INTERVISTA<br />

Interviste ad alcuni responsabili<br />

di IDT regionali: presente e<br />

prospettive<br />

a cura di Franco Vico<br />

Le infrastrutture di dati geografici<br />

di livello regionale sono un tassello<br />

fondamentale nel sistema complessivo di<br />

produzione, catalogazione, distribuzione<br />

dell’informazione geografica. Questo lo<br />

pensiamo noi, ma non solo. Questo è<br />

certamente vero in Italia, ma anche, ad<br />

es., in Germania e in altri paesi europei.<br />

Le regioni hanno le capacità finanziarie e<br />

tecniche necessarie, quelle capacità che<br />

spesso mancano ai livelli sotto-ordinati, ad<br />

es. ai comuni. Mentre il livello nazionale è<br />

più lontano dal territorio e ha altri ruoli.<br />

Con questo in mente, abbiamo chiesto<br />

ai responsabili di alcune IDT regionali<br />

di parlarci delle loro esperienze,<br />

presentandole nella loro realtà concreta,<br />

ma confrontandosi anche con i “punti di<br />

convergenza” del dibattito internazionale<br />

sul futuro delle Spatial Data Infrastructure,<br />

individuati nell’articolo che precede.<br />

In questo numero sono pubblicate le<br />

interviste relative alle Regioni Veneto e<br />

Piemonte, nel prossimo saranno presentate<br />

quelle relative ad un paio di altre regioni.<br />

La IDT della Regione<br />

Piemonte: intervista a<br />

Gian Bartolomeo Siletto.<br />

A cura della Redazione<br />

<strong>GEOmedia</strong> intervista Gian<br />

Bartolomeo Siletto, funzionario<br />

referente della IDT<br />

della Regione Piemonte, che<br />

di formazione è un geologo.<br />

<strong>GEOmedia</strong> (G):<br />

Cominciamo inquadrando<br />

un po’ l’argomento.<br />

Gian Bartolomeo Siletto<br />

(GS): Vorrei fare alcune<br />

premesse, la prima riguarda<br />

la denominazione.<br />

Noi usiamo il termine<br />

Infrastruttura Geografica<br />

Regionale, così definita<br />

dalla l.r. 21/2017.<br />

L’interfaccia principale con<br />

gli utenti è il Geoportale,<br />

che possiamo dire è la<br />

facciata della IDT, facciata<br />

che ovviamente non sta in<br />

piedi se dietro non c’è un<br />

edificio, fatto di metadati,<br />

dati e servizi. Una seconda<br />

premessa: il Geoportale<br />

è in fase di “ristrutturazione”,<br />

ma ovviamente<br />

questa è una situazione<br />

che si ripresenta ciclicamente.<br />

Fra pochi mesi<br />

avrà una nuova interfaccia<br />

(speriamo più friendly) e<br />

soprattutto un nuovo motore<br />

(GeoNetwork3 più il<br />

nuovo Plugin RNDT).Una<br />

terza premessa è il ruolo<br />

di partner tecnologico e<br />

“compagno di avventure”<br />

del CSI-Piemonte, che gestisce<br />

insieme e per conto<br />

di Regione l’intera piattaforma<br />

geografica.<br />

Vorrei cominciare evidenziando<br />

alcune iniziative<br />

che ritengo punti di forza<br />

della IDT. La prima è la<br />

pubblicazione con un aggiornamento<br />

trimestrale<br />

del DB geotopografico<br />

regionale (BDTRE:<br />

Base Dati Territoriale<br />

di Riferimento degli<br />

Enti), conforme al DM<br />

10/11/2011, che è, come<br />

ovvio, uno dei dataset fondamentali<br />

della IDT. Poi,<br />

la mosaicatura catastale:<br />

qualche anno fa abbiamo<br />

provveduto alla scanneriz-<br />

18 <strong>GEOmedia</strong> n°5-<strong>2021</strong>

INTERVISTA<br />

zazione degli originali<br />

d’impianto catastale,<br />

con un progetto in collaborazione<br />

con l’allora<br />

Agenzia del Territorio, i<br />

Collegi dei Geometri e<br />

il Politecnico di Torino,<br />

che ha provveduto alla<br />

determinazione dei<br />

punti in doppie coordinate<br />

e quindi alla<br />

georeferenziazione sia<br />

nel sistema di riferimento<br />

catastale (Cassini-<br />

Soldner) che geografico.<br />

Questo bagaglio di<br />

dati ci ha consentito<br />

in tempi più recenti di<br />

procedere con la mosaicatura<br />

dei dati catastali<br />

aggiornati (ottenuti<br />

tramite il sistema di<br />

interscambio Sigmater)<br />

che ora sono disponibili<br />

sul territorio regionale.<br />

Ovviamente questa mosaicatura<br />

non ha più le<br />

caratteristiche del prodotto<br />

originariamente<br />

distribuito dall’Agenzia,<br />

ma costituisce una fonte<br />

informativa di indubbia<br />

utilità. Il migliore<br />

riposizionamento delle<br />

informazioni catastali e<br />

la successiva mosaicatura<br />

ovviano in parte al<br />

problema di coerenza<br />

tra il catasto e tutte le<br />

fonti geografiche ormai<br />

disponibili.<br />

G: Sul rapporto con gli<br />

utilizzatori della IDT,<br />

quanto li conoscete; e<br />

quanto conoscete gli<br />

utilizzi che vengono fatti<br />

dei dati?<br />

GS: La IDT espone sia<br />

servizi ad accesso autenticato<br />

sia servizi ad<br />

accesso libero. Per ovvi<br />

motivi per questi ultimi,<br />

in particolare per<br />

il Geoportale, non sono<br />

disponibili informazioni<br />

di dettaglio sugli utenti e<br />

sull’utilizzo che essi fanno<br />

dei vari servizi, se non in<br />

forma aggregata (numero<br />

totale di accessi, numero<br />

di chiamate ai geoservizi,<br />

ecc.). In particolare si registrano<br />

circa 5000 visitatori<br />

al mese al Geoportale<br />

e circa 1 milione (generanti<br />

circa 475 GB di traffico<br />

rete) di chiamate al<br />

giorno ai servizi WMS.<br />

Per quanto riguarda<br />

invece gli strumenti ad<br />

accesso autenticato, il<br />

G: Sempre sul rapporto<br />

con gli utilizzatori,<br />

quali azioni avete in<br />

piedi per interagire<br />

con loro e conoscere<br />

meglio gli utilizzi che<br />

fanno dei dati della<br />

IDT?<br />

GS: Conoscere utenti<br />

e utilizzi è sicuramente<br />

un punto di<br />

miglioramento atteso<br />

importante per l’intera<br />

Infrastruttura al fine<br />

di indirizzare la strategia<br />

di aggiornamento<br />

dei dati in relazione<br />

il mantenimento e la<br />

gestione di una IDT<br />

richiede un importante<br />

impegno economico<br />

ma anche di persone<br />

dedicate<br />

principale strumento<br />

è il Plugin Atlante di<br />

QGIS, sviluppato dal<br />

CSI Piemonte, utilizzato<br />

dagli utenti della<br />

PA (oltre la Regione,<br />

Città Metropolitana di<br />

Torino, Città di Torino,<br />

ARPA Piemonte, IPLA<br />

(Istituto regionale per<br />

le Piante da Legno e<br />

l’Ambiente) e altri, per<br />

accedere direttamente ai<br />

dati geografici vettoriali<br />

ufficiali dell’Infrastruttura.<br />

Complessivamente<br />

sono abilitati al servizio<br />

oltre 400 utenti. Per<br />

questi utenti non vengono<br />

raccolte ulteriori<br />

informazioni sull’utilizzo<br />

dei dati.<br />

<br />

all’utilizzo degli utenti<br />

stessi. Le azioni per<br />

rendere concrete queste<br />

aspettative risiedono<br />

nel miglioramento<br />

dei tools di controllo e<br />

monitoraggio informatico:<br />

non si prevedono<br />

invece azioni volte a<br />

restringere il perimetro<br />

dei servizi ad accesso<br />

libero.<br />

Per interagire e ricevere<br />

feedback dagli<br />

utilizzatori abbiamo<br />

attivato diversi canali.<br />

C’è un indirizzo mail<br />

dedicato al quale gli<br />

utenti possono indirizzare<br />

le richieste di<br />

chiarimenti e approfondimenti<br />

necessari.<br />

C’è uno strumento per<br />

la segnalazioni di errori<br />

cartografici sul visualizzatore<br />

del Geoportale:<br />

attraverso questo canale<br />

arrivano segnalazioni<br />

più puntuali delle problematiche<br />

specifiche<br />

riscontrate in particolare<br />

sulla BDTRE.<br />

Abbiamo elaborato, con<br />

l’aiuto di uno stagista<br />

di CdL in Ingegneria<br />

Civile del Politecnico di<br />

Torino, un questionario<br />

per misurare la soddisfazione<br />

degli utilizzatori,<br />

per ora sottoposto solo a<br />

un piccolo campione.<br />

G: Introduciamo qualche<br />

aspetto quantitativo,<br />

quanti dataset sono<br />

presenti e quali sono i<br />

più utilizzati (più scaricati)?<br />

GS: Attraverso il catalogo<br />

del Geoportale sono<br />

consultabili circa 1630<br />

metadati (750 di titolarità<br />

di Regione, 240 del<br />

Comune Torino, 209<br />

di Città Metropolitana<br />

di Torino, 150 di<br />

ARPA Piemonte, 280<br />

di altri enti (province<br />

o comuni), sia riferiti<br />

a dataset sia a servizi.<br />

Complessivamente<br />

i dataset scaricabili<br />

sono 595. I servizi<br />

raggiungibili 578,<br />

realizzati secondo gli<br />

standard OGC. Molti<br />

dei metadati presenti<br />

nel Catalogo della<br />

Infrastruttura Regionale<br />

(al momento 937)<br />

sono poi conferiti al<br />

Repertorio Nazionale<br />

dei Dati Territoriali<br />

(RNDT) di AgID,<br />

mediante harvesting periodico.<br />

<strong>GEOmedia</strong> n°5-<strong>2021</strong> 19

INTERVISTA<br />

G: Quindi possiamo<br />

dire che la IDT è della<br />