GuÃa de Comandos Oracle Clusterware, Oracle Restart & RAC

GuÃa de Comandos Oracle Clusterware, Oracle Restart & RAC

GuÃa de Comandos Oracle Clusterware, Oracle Restart & RAC

Create successful ePaper yourself

Turn your PDF publications into a flip-book with our unique Google optimized e-Paper software.

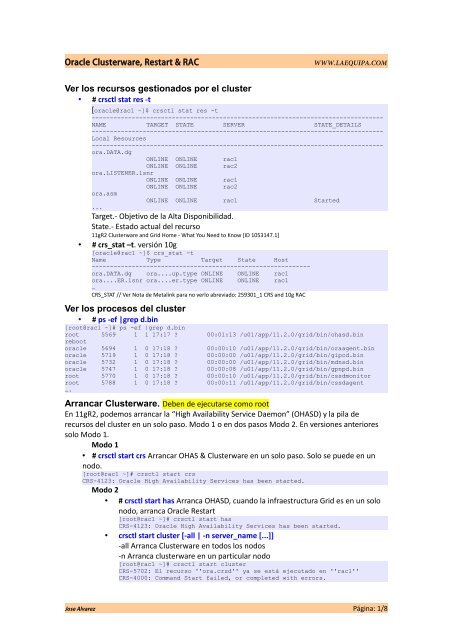

<strong>Oracle</strong> <strong>Clusterware</strong>, <strong>Restart</strong> & <strong>RAC</strong>WWW.LAEQUIPA.COMVer los recursos gestionados por el cluster• # crsctl stat res -t[oracle@rac1 ~]$ crsctl stat res -t--------------------------------------------------------------------------------NAME TARGET STATE SERVER STATE_DETAILS--------------------------------------------------------------------------------Local Resources--------------------------------------------------------------------------------ora.DATA.dgONLINE ONLINE rac1ONLINE ONLINE rac2ora.LISTENER.lsnrONLINE ONLINE rac1ONLINE ONLINE rac2ora.asmONLINE ONLINE rac1 Started...Target.- Objetivo <strong>de</strong> la Alta Disponibilidad.State.- Estado actual <strong>de</strong>l recurso11gR2 <strong>Clusterware</strong> and Grid Home - What You Need to Know [ID 1053147.1]• # crs_stat –t. versión 10g[oracle@rac1 ~]$ crs_stat -tName Type Target State Host------------------------------------------------------------ora.DATA.dg ora....up.type ONLINE ONLINE rac1ora....ER.lsnr ora....er.type ONLINE ONLINE rac1…CRS_STAT // Ver Nota <strong>de</strong> Metalink para no verlo abreviado: 259301_1 CRS and 10g <strong>RAC</strong>Ver los procesos <strong>de</strong>l cluster• # ps -ef |grep d.bin[root@rac1 ~]# ps -ef |grep d.binroot 5569 1 1 17:17 ? 00:01:13 /u01/app/11.2.0/grid/bin/ohasd.binrebootoracle 5694 1 0 17:18 ? 00:00:10 /u01/app/11.2.0/grid/bin/oraagent.binoracle 5719 1 0 17:18 ? 00:00:00 /u01/app/11.2.0/grid/bin/gipcd.binoracle 5732 1 0 17:18 ? 00:00:00 /u01/app/11.2.0/grid/bin/mdnsd.binoracle 5747 1 0 17:18 ? 00:00:08 /u01/app/11.2.0/grid/bin/gpnpd.binroot 5770 1 0 17:18 ? 00:00:10 /u01/app/11.2.0/grid/bin/cssdmonitorroot 5788 1 0 17:18 ? 00:00:11 /u01/app/11.2.0/grid/bin/cssdagent….Arrancar <strong>Clusterware</strong>. Deben <strong>de</strong> ejecutarse como rootEn 11gR2, po<strong>de</strong>mos arrancar la “High Availability Service Daemon” (OHASD) y la pila <strong>de</strong>recursos <strong>de</strong>l cluster en un solo paso. Modo 1 o en dos pasos Modo 2. En versiones anterioressolo Modo 1.Modo 1• # crsctl start crs Arrancar OHAS & <strong>Clusterware</strong> en un solo paso. Solo se pue<strong>de</strong> en unnodo.[root@rac1 ~]# crsctl start crsCRS-4123: <strong>Oracle</strong> High Availability Services has been started.Modo 2• # crsctl start has Arranca OHASD, cuando la infraestructura Grid es en un solonodo, arranca <strong>Oracle</strong> <strong>Restart</strong>[root@rac1 ~]# crsctl start hasCRS-4123: <strong>Oracle</strong> High Availability Services has been started.• crsctl start cluster [-all | -n server_name [...]]-all Arranca <strong>Clusterware</strong> en todos los nodos-n Arranca clusterware en un particular nodo[root@rac1 ~]# crsctl start clusterCRS-5702: El recurso ''ora.crsd'' ya se está ejecutado en ''rac1''CRS-4000: Command Start failed, or completed with errors.Jose Alvarez Página: 1/8

<strong>Oracle</strong> <strong>Clusterware</strong>, <strong>Restart</strong> & <strong>RAC</strong>WWW.LAEQUIPA.COMVer Configuración e instancias <strong>de</strong> la B.Datos <strong>RAC</strong>• Databaseo [oracle@server3]$srvctl config database• Instanciaso [oracle@server]$srvctl config database –d RDB –aGestión <strong>de</strong> Base <strong>de</strong> Datos, instancias, Servicios y aplicaciones <strong>de</strong> losnodos<strong>Comandos</strong>srvctl start instance -d -i srvctl start database -d srvctl stop database -d srvctl stop instance -d -i srvctl start service -d -s srvctl stop service -d -s srvctl status service -d srvctl status instance -d -i srvctl status database -d srvctl start no<strong>de</strong>apps -n srvctl stop no<strong>de</strong>apps -n srvctl relocate service -d -s -i -tVerificar el Cluster• # crsctl check cluster -all[oracle@rac1 ~]$ crsctl check clusterCRS-4537: Cluster Ready Services is onlineCRS-4529: Cluster Synchronization Services is onlineCRS-4533: Event Manager is onlineChequear es estado <strong>de</strong> los daemons <strong>de</strong>l <strong>Clusterware</strong>• # crsctl check crs Chequear todos[oracle@rac1 etc]$ crsctl check crsCRS-4638: <strong>Oracle</strong> High Availability Services is onlineCRS-4537: Cluster Ready Services is onlineCRS-4529: Cluster Synchronization Services is onlineCRS-4533: Event Manager is onlineChequear por separado: crsctl check cssd, crsctl check crsd, crsctl check evmdArrancar un recurso <strong>de</strong> los procesos <strong>de</strong>l Cluster en particular.• # crsctl start res ora.crsd -init[root@rac2 orarootagent_root]# crsctl start res ora.crsd -initCRS-2679: Attempting to clean 'ora.crsd' on 'rac2'CRS-2681: Clean of 'ora.crsd' on 'rac2' succee<strong>de</strong>dCRS-2672: Attempting to start 'ora.crsd' on 'rac2'CRS-2676: Start of 'ora.crsd' on 'rac2' succee<strong>de</strong>dVerificar Voting Disk• # crsctl query css votedisk[oracle@rac1 ~]$ crsctl query css votedisk## STATE File Universal Id File Name Disk group-- ----- ----------------- --------- ---------1. ONLINE 1e958a0440514f9ebf1a1e92bdf14065 (ORCL:DISK1) [DATA]Located 1 voting disk(s).Jose Alvarez Página: 3/8

<strong>Oracle</strong> <strong>Clusterware</strong>, <strong>Restart</strong> & <strong>RAC</strong>WWW.LAEQUIPA.COM• ASM. # crsctl replace votedisk +asm_disk_group. Forma <strong>de</strong> añadir y recuperaren ASM.[root@rac1 ~]# crsctl replace votedisk +FRASuccessful addition of voting disk 9858b2b388e54f50bf20a0ec1d68fd8f.Successful <strong>de</strong>letion of voting disk 645fe036e6ce4f94bff2e1fc6e0a905e.Successfully replaced voting disk group with +FRA.CRS-4266: Voting file(s) successfully replacedEn 10g y 11g R1 se recupera con el comando dd <strong>de</strong> un backup anterior.Backup & Recovery OCR. Ejecutar como root• Se hace backup automáticamente, para ver los backups # ocrconfig -showbackup auto–Cada 4 horas: CRS mantiene las tres últimas copias.–Al final <strong>de</strong> cada día: CRS mantiene las dos últimas copias.–Al final <strong>de</strong> cada semana: CRS mantiene las dos últimas copias.[root@rac1 ~]# ocrconfig -showbackup autorac2 2011/07/03 20:24:09 /u01/app/11.2.0/grid/cdata/rac-scan/backup00.ocrrac2 2011/06/30 21:51:37 /u01/app/11.2.0/grid/cdata/rac-scan/backup01.ocr• Cambiar la ubicación <strong>de</strong>l backup automático.# ocrconfig –backuploc • Backup Lógico: # ocrconfig -export [root@rac1 ~]# ocrconfig -export /home/oracle/ocr.backup• Backup Físico, como root. # ocrconfig -manualbackup[root@rac1 ~]# ocrconfig -manualbackuprac1 2011/07/08 11:43:55/u01/app/11.2.0/grid/cdata/rac-scan/backup_20110708_114355.ocr[root@rac2 ~]# ocrconfig -showbackup manualrac1 2011/07/08 11:43:55/u01/app/11.2.0/grid/cdata/rac-scan/backup_20110708_114355.ocr• Recuperar Si hay mirror:ooNo-ASM. # ocrconfig –repair -ocr ASM. # ocrconfig –repair -add Debemos ejecutar este comandoen el nodo que paremos el <strong>Clusterware</strong>.• Recuperación física: # ocrconfig –restore Como root1. Localizar un backup físico.# ocrconfig –showbackup2. Parar <strong>Oracle</strong> <strong>Clusterware</strong> en todos los nodos:# crsctl stop cluster -all3. Stop <strong>Oracle</strong> High Availability Services en todos los nodos, ejecutar en cada nodo:# crsctl stop crs4. Restaurar el OCR backup:# ocrconfig –restore /u01/app/.../cdata/cluster01/day.ocr5. Arrancar <strong>Oracle</strong> High Availability Services en todos los nodos:# crsctl start crs6. Chequear la integridad <strong>de</strong>l OCR:# cluvfy comp ocr -n all• Recuperación Lógica: # ocrconfig -import. Como root, seguir los pasos anteriores.Red.• # oifcfg iflist -p -n Lista <strong>de</strong> interfaces disponibles en el Cluster[root@rac1 ~]# oifcfg iflist -p -neth0 192.168.2.0 PRIVATE 255.255.255.0eth1 192.168.0.0 PRIVATE 255.255.255.0• # oifcfg getif Determinar la red pública y privada <strong>de</strong>l Cluster[root@rac1 ~]# oifcfg getifeth0 192.168.2.0 global publiceth1 192.168.0.0 global cluster_interconnect• # srvctl config no<strong>de</strong>apps -a Determinar la VIP <strong>de</strong> cada hostJose Alvarez Página: 5/8

<strong>Oracle</strong> <strong>Clusterware</strong>, <strong>Restart</strong> & <strong>RAC</strong>WWW.LAEQUIPA.COM[root@rac1 ~]# srvctl config no<strong>de</strong>apps -aVIP exists.:rac1VIP exists.: /rac1-vip/192.168.2.111/255.255.255.0/eth0VIP exists.:rac2VIP exists.: /rac2-vip/192.168.2.112/255.255.255.0/eth0SCAN Resolución. [ID 1188736.1] .Po<strong>de</strong>mos configurarlo con:DNS [ID 1107295.1]Necesitamos Configurar DNS serverIPs:• Una pública IP por cada nodo.• Una local VIP por cada nodo.• Una privada IP por cada nodo (Interconnect)• SCAN IP para el SCAN LISTENER. Al menos una, máximo 3.Definir el SCAN utilizando '/etc/hosts/'Nota.- <strong>Oracle</strong> recomienda encarecidamente que no se configuren las direcciones <strong>de</strong> SCAN VIP en el archivo hosts. Siutiliza el archivo hosts para resolver el nombre <strong>de</strong> SCAN, sólo pue<strong>de</strong> tener una dirección IP SCAN.Si el archivo <strong>de</strong> hosts se utiliza para resolver SCAN hostname, recibirá error <strong>de</strong> la utilidad Cluster Ver[root@rac1 ~]#cat /etc/hosts# Do not remove the following line, or various programs# that require network functionality will fail.127.0.0.1 localhost.localdomain localhost# Public192.168.2.101 rac1.localdomain rac1192.168.2.102 rac2.localdomain rac2#Private192.168.0.101 rac1-priv.localdomain rac1-priv192.168.0.102 rac2-priv.localdomain rac2-priv#Virtual192.168.2.111 rac1-vip.localdomain rac1-vip192.168.2.112 rac2-vip.localdomain rac2-vip# SCAN192.168.2.201 rac-scan.localdomain rac-scanGNS [ID 946452.1]Necesitamos:• servicio DHCP ejecutándose en la red pública.• DHCP <strong>de</strong>be proporcionar una IP VIP por cada nodo.• 3 IP VIP para SCAN LISTENER.[root@my-dns-server ~]# cat /etc/named.conf// Default initial "Caching Only" name server configuration...# Delegate to gns on cluster01#cluster01.example.com #cluster sub-domain# NS cluster01-gns.example.com# Let the world know to go to the GNS vip#cluster01-gns.example.com. 192.0.2.155 # cluster GNS Addresscluster01.nl.oracle.com NS gns.cluster01.nl.oracle.comgns.cluster01.nl.oracle.com. 10.161.102.55• Ver la información <strong>de</strong>l GNS. 11g R2# dig scan.cluster01.nl.oracle.com Ver la información <strong>de</strong>tallada <strong>de</strong>l GNS y las ipsasociadas:[root@dns-dhcp ~]# dig scan.cluster01.nl.oracle.com; DiG 9.3.4-P1 scan.cluster01.nl.oracle.com;; global options: printcmd;; Got answer:;; ->>HEADER

<strong>Oracle</strong> <strong>Clusterware</strong>, <strong>Restart</strong> & <strong>RAC</strong>WWW.LAEQUIPA.COMClusteware (Procesos)• CRSD Ejecutado como root, Alta disponibilidad <strong>de</strong>l Clustero Racgeut. Matar acciones que no terminan <strong>de</strong>spués <strong>de</strong> un periodo <strong>de</strong>terminadoo Racgmdb. Gestionar la B.Datoso Racgchsn. Gestionar Servicioso Racgons. Configuración <strong>de</strong>l ONS y OCRo Racgvip. Gestión <strong>de</strong> las VIPso Racgwrap. script copiado en todos los bin <strong>de</strong> cada oracle_home <strong>de</strong> cada nodo para elcontrol <strong>de</strong> los recursos con SRVCTL• EVMD Ejecutado como oracle, notificar eventos <strong>de</strong>l clustero Evmwatch –A –t “@timestamp @@”• OCSSD Ejecutado como oracle, controlar es estado entre nodos• OPROCD Ejecutado como root, <strong>de</strong>tecta nodos congelados y los mata, sustituye alhacker_timero Logging information en: /etc/oracle/oprocd/no<strong>de</strong>.oprocd.logo 2 parametros especificados en /etc/init.d/init.cssd: –t: tiempo <strong>de</strong> chequeo. Defecto 1000 milisegundos –m:margen. Defecto 500 milisegundos OPROCS_DEFAULT_TIMEOUT=1000 OPROCD_DEFAULT_MARGIN=500• OCLVMON. Monitorizar el cluster <strong>de</strong>l Ven<strong>de</strong>dor• OCLSOMON (10.2.0.2) Monitoriza el <strong>de</strong>monio CSS y pue<strong>de</strong> reiniciar un nodo si percibeun cuelgue.En 11g R2 OPROC, OCLVMON, OCLSOMON no existen.Jose Alvarez Página: 8/8