Create successful ePaper yourself

Turn your PDF publications into a flip-book with our unique Google optimized e-Paper software.

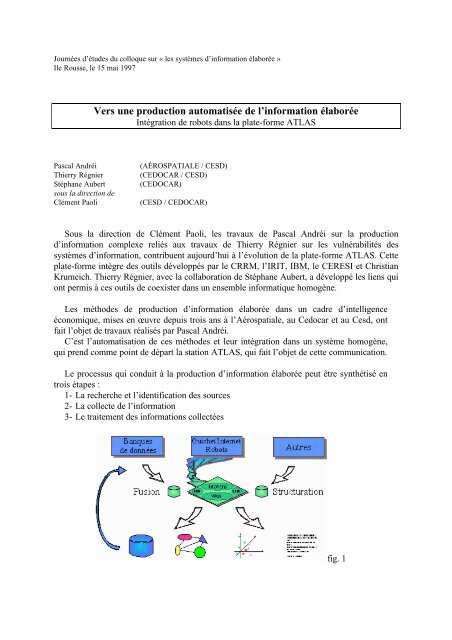

Journées d’études du colloque sur « les systèmes d’information élaborée »Ile Rousse, le 15 mai 1997Vers une production automatisée de l’information élaboréeIntégration de robots dans la plate-forme ATLASPascal AndréiThierry RégnierStéphane Aubertsous la direction deClément Paoli(AÉROSPATIALE / CESD)(CEDOCAR / CESD)(CEDOCAR)(CESD / CEDOCAR)Sous la direction de Clément Paoli, les travaux de Pascal Andréi sur la productiond’information complexe reliés aux travaux de Thierry Régnier sur les vulnérabilités dessystèmes d’information, contribuent aujourd’hui à l’évolution de la plate-forme ATLAS. Cetteplate-forme intègre des outils développés par le <strong>CRRM</strong>, l’IRIT, IBM, le CERESI et ChristianKrumeich. Thierry Régnier, avec la collaboration de Stéphane Aubert, a développé les liens quiont permis à ces outils de coexister dans un ensemble informatique homogène.Les méthodes de production d’information élaborée dans un cadre d’intelligenceéconomique, mises en œuvre depuis trois ans à l’Aérospatiale, au Cedocar et au Cesd, ontfait l’objet de travaux réalisés par Pascal Andréi.C’est l’automatisation de ces méthodes et leur intégration dans un système homogène,qui prend comme point de départ la station ATLAS, qui fait l’objet de cette communication.Le processus qui conduit à la production d’information élaborée peut être synthétisé entrois étapes :1- La recherche et l’identification des sources2- La collecte de l’information3- Le traitement des informations collectéesfig. 1

La recherche et la collecte d’informations sur les sources traditionnelles - bases dedonnées structurées sur les serveurs internationaux, bases de données internes, journaux,colloques et séminaires, etc. - ont été abondamment décrites dans la littérature. Nous nereviendrons pas dessus, bien que ces sources représentent aujourd’hui la principalecomposante de l’ensemble de la masse d’information traitée. Nous allons nous attacher toutparticulièrement aux sources en provenance du réseau Internet. En effet, par l’intermédiairede ce réseau sont diffusées des masses considérables d’informations. Internet est devenu unmedia incontournable qu’il est indispensable de maîtriser.1- La recherche et l’identification des sourcesLa pertinence des sources sélectionnées doit naturellement être la plus grande possible. Poursélectionner ces sources, les outils de recherche d’informations sur Internet sont devenusindispensables face à la somme considérable et toujours croissante de ressources accessiblessur ce réseau.A cette étape, il est surtout question d’éviter les « silences », c’est à dire les manquesd’informations. Il peut y avoir beaucoup de « bruit » (information non pertinente). Nousverrons comment le supprimer à la dernière étape.Sélectionner rapidement sur Internet les sources d’information pertinentes passenécessairement par une bonne connaissance des moteurs de recherche comme Altavista, Exciteou Dejanews.En effet, ils sont quasiment toujours le point de départ des recherches, mais leur utilisationest rarement optimisée. De par la diversité de leurs caractéristiques, une sélection fine de cesmoteurs influera fortement sur la qualité des résultats obtenus.Ainsi, Altavista indexe et restitue les ressources en donnant un poids d’autant plus fort auxmots clefs rencontrés qu’ils sont en tête de page. A moins que des « meta-tags » (systèmes quipermettent au propriétaire de la ressource de contrôler, dans une certaine mesure, les motsclefs qui seront indexés) ne soient utilisés.Typiquement, les réponses obtenues seront des pages dans lesquelles les mots clefs requisapparaîtront en entête, ou plus encore les pages de sites parfaitement au courant des méthodesd’indexation d’Altavista. Il est ainsi fréquent de trouver des pages où le même mot clef estrépété de nombreuses fois.Excite crée un résumé des pages avant de les indexer. Les phrases importantes, selonl’algorithme utilisé, sont sélectionnées afin de créer ce résumé automatique.Sur Excite toujours, la recherche d’information se fait par mot clef ou d’une façon qui seveut « conceptuelle » (association de mots clefs). L’intégration de l’outil « More Like This »permet de relancer la recherche en extrayant les mots clefs des résultats pertinents précédents.Altavista quand à lui met à disposition des utilisateurs « Live Topics », qui permet unesélection / désélection de mots clefs extraits de la recherche précédente et qui permet d’affinerou d’élargir sa recherche.Ces exemples illustrent les différences entre les moteurs. Il y a cependant de nombreusesquestions auxquelles il faut tenter de répondre dès lors que l’on veut exploiter au mieux lesmoteurs de recherches :

• Qu’est-ce qui est indexé ?♦ Quelles ressources ?(web, news, ... / texte, images, ... )♦ Combien de mots sont indexés pour chaque ressource ?♦ Comment ces mots sont-ils sélectionnés ?♦ Quel « poids » leur est attribué et en fonction de quel critère ?♦ Est-ce que les capitales, les accents, la ponctuation sont pris en compte ?• Quelle est la fréquence de mise à jour des données ?• Quelles sont les méthodes d’interrogation proposées ?♦ Mots clefs, concepts, thèmes, cartes, ...• Comment sont restitués les résultats ?♦ Calculs de pertinence (premiers mots, résumé, proximité des mots clefs, ...)♦ Intégration d’outils «évolués» (More Like This - Excite, Live Topics -AltaVista, ...)Connaître les moteurs de recherche pour mieux optimiser leur utilisation est un premierpoint. Il existe d’autres outils et notamment les agents intelligents qui vont rechercherl’information avec des techniques élaborées.S’il faut naturellement intégrer ces agents dans sa panoplie d’outils de recherchesd’information, il faut tout de même le faire avec une certaine prudence.En effet, certains échangent des informations avec leur site central ou avec d’autres agentset remettent en cause la confidentialité des recherches. Vos domaines d’intérêts peuvent êtreainsi parfaitement identifiés. Lorsque l’on parle d’intelligence économique, on sait l’importanceque cela prend.On peut citer Autonomy, Webfilter, Surfbot et un français : DigOut4U. Ce dernierintègre une analyse sémantique des réponses et, lorsqu’il est bien paramètré, fourni desrésultats dignes d’intérêt.A cette étape, la station Atlas dispose d’un intégrateur, c’est à dire d’un moteur derecherche qui s’appuie lui-même sur d’autres moteurs de recherche (voir fig. 2).Dans la démarche générale, il y a constitution, à cette étape, d’un « bookmark », d’unesuite d’adresses de sites Internet ou de sources pertinentes.Afin d’éviter de dévoiler trop précisément ses domaines d’intérêts, il faut rester très généraldans les questions posées sur les moteurs de recherche et au moyen des agents intelligents.Une solution consiste alors à créer une base de donnée thématique locale, que l’on vainterroger ensuite plus finement, sans laisser circuler sur Internet des questions trop précises.La multiplication des outils de recherche pour la constitution de cette base localepersonnalisée permet d ‘éviter à la fois les « silences » (absence ou manque d’information) etd’être « suivi à la trace ».

fig. 22- La collecte de l’informationLe rapatriement des informations sur un site local va permettre de s’assurer une bonneconfidentialité en ne dévoilant que des domaines d’intérêt généraux : les questions clefs dela recherche ou du thème de veille ne circuleront pas sur les réseaux.Le corpus constitué, une veille s’appuyant sur des outils produisant de l’informationélaborée, après les travaux d’experts, pourra se mettre en place. Une veille à long termemais également des réponses très rapides à des questions ponctuelles puisque les donnéessont conservées en local et mises à jour en temps réel s’il le faut.Ils y a deux grands écueils :Le temps nécessaire au rapatriement des donnéesune opération manuelle devient rapidement fastidieusesi vous êtes connecté au travers d’un modem, l’opération est forcémentlimitée par les débits et les coûtsLa mise à jour de ces donnéesLa procédure consiste à fournir aux robots de la station Atlas, la liste des sites pertinentsque l’on veut rapatrier et indexer en local. Le système est complètement automatisé. C’est àdire que vous copiez le contenu du bookmark, constitué à l’étape précédente, dans lafenêtre de la figure 3. Vous validez et le système va indexer ensuite et mettre à jourautomatiquement une base thématique dont vous fournissez le nom.Le contenu de cette base est constitué des informations recueillies sur les sites fournis.La mise à jour est quotidienne.Il est possible de créer ainsi différentes bases qui sont hébergées sur le serveur de lastation Atlas, à distance. Toute l’opération est pilotée depuis un navigateur standard.

fig. 33- Le traitement des informations collectéesLa collecte automatisée des informations achevée, il reste à sélectionner finementl’information pertinente, à l’extraire et à la traiter.Comme représenté à la figure 1, l’information peut être traitée ensuite de différentesfaçons. Cependant, chaque outil de production d’information élaborée possède ses propresformats spécifiques en entrée. Plus les outils sont nombreux, plus le problème est épineux.Nous nous efforçons avec la Station Atlas de simplifier ce problème en mettantdirectement au format désiré l’information extraite des bases de données.L ‘extraction de l’information se fait par l’intermédiaire d’écrans sous Netscape (voir fig.4). La ou les bases qui ont été constituées à l’étape précédente sont sélectionnées et uneinterrogation par mots clefs permet d’extraire les documents pertinents. A ce stade, lelangage d’interrogation est assez pauvre et est comparable à ceux que l’on trouve sur lesbases de données documentaires traditionnelles, avec des opérateurs booléens, desopérateurs de proximité, des troncatures, etc.

fig. 4Les résultats de la requête sont affichés (voir fig. 5) avec l’adresse de la source, le titrede la ressource, la date de dernière modification et le début du texte.A ce stade vous pouvez :- Cliquer sur l’adresse de la source et donc retourner sur le site qui a été indéxé pourvisualiser la source originale- Sélectionner les documents qui vous semblent pertinents en cochant les casessituées sur le coté- Sélectionner le format de sortie (ici format texte simple ou format Taïga)Vos questions « fines » ne circulent pas sur Internet puisque vous interrogez des baseslocales. Vous pouvez consulter simultanément de nombreuses ressources. Vous pouvezmultiplier les requêtes et les formats de sortie puisque vous travaillez en local et donc trèsrapidement.Dans l’exemple fourni (fig. 5 et fig. 6), le format de sortie final choisi est celui de Taïga.Le fichier des réponses formaté au format Taïga est automatiquement produit par lesystème. Vous pouvez ainsi sauvegarder sur votre disque dur le mini corpus créé etl’indexer directement avec Taïga pour un traitement sémantique de l’information.

fig. 5fig. 6

D’autres types de traitement peuvent être utilisés. S’inspirant largement de Dataview,nous avons intégré un module de traitement statistique. Des réseaux d’auteurs, d’affiliationou de mots sont automatiquement constitués à partir de corpus ou de forums de discussion.La première étape est la constitution d’un ensemble de données formatées. Il faut en effetque l’information soit structurée en champs.Dans le cas des forums de discussion ce reformatage est fait automatiquement par lesystème. Il suffit de sélectionner tous les forums qui portent sur un thème commun, -modulede reformatage de news - de valider, de passer sous le module Atlas-Mas (fig. 7) et lesréseaux d’auteurs sont constitués graphiquement en temps réel (fig. 8).fig. 7fig. 8

ConclusionLa méthode :• Une recherche thématique large en multipliant les outils de recherche♦ Une bonne connaissance des moteurs pour optimiser les recherches♦ Une utilisation « prudente » des agents intelligents♦ Des questions « larges » sur le réseau pour ne pas révéler trop précisément sesdomaines d’intérêt.• Un rapatriement des informations à partir des liens obtenus, une indexationlocale avec constitution de bases de données personnalisées• Une sélection fine des données à traiter en local• Une extraction des données pour l’analyse et/ou la production d’informationélaborée.Toute la chaîne de production d’information est automatisée, avec interventionpossible de l’utilisateur à toutes les étapes, depuis la recherche sur les moteurs jusqu’à laproduction d’information élaborée, en passant par la constitution de bases de données etl’interrogation en ligne.Les règles :Les volumes de données à traiter nous imposent de sélectionner de façon pertinenteles informations qui seront mises à disposition de l’utilisateur final, afin de les ramener àune échelle humaine.Chaque outil possède ses spécificités et c’est la conjugaison et l’intégration de cesoutils qui permet de répondre à un large spectre de questions.Evolutivité et modularité sont les maîtres mots d’un système qui intégre denombreux outils comme dataview, tétralogie, topic et Taïga à qui il fournit del’information en temps réel provenant d’Internet ou d’autres sources. De nouveauxoutils peuvent être intégrés aisément grâce à cette modularité.La synthèse :Le pilotage au travers d’une interface unique et conviviale de systèmes complexes detraitement de l’information permet de systématiser des traitements qui étaient autrefoistrès longs et fastidieux à mettre en œuvre. La systématisation des traitements est une desclefs qui permettent de s’affranchir des problèmes liés aux masses considérablesd’information à prendre en compte aujourd’hui.