Aula 2 - CESEC

Aula 2 - CESEC

Aula 2 - CESEC

Create successful ePaper yourself

Turn your PDF publications into a flip-book with our unique Google optimized e-Paper software.

UFPR – PPGMNE - TC-747 - REDES NEURAIS E APLICAÇÕES EM ENGENHARIA Profa. Andrea Sell Dyminski<br />

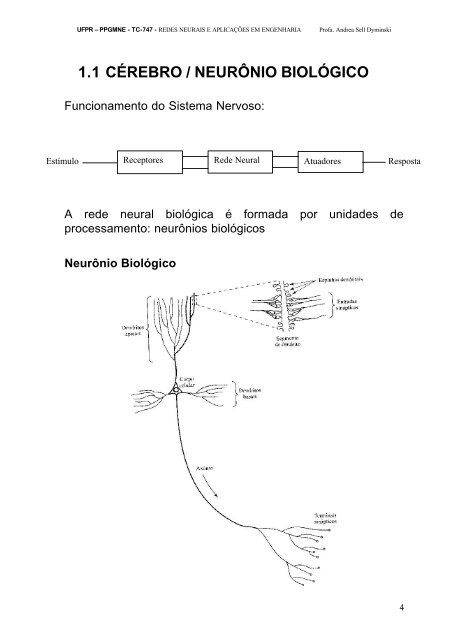

1.1 CÉREBRO / NEURÔNIO BIOLÓGICO<br />

Funcionamento do Sistema Nervoso:<br />

Estímulo Receptores Rede Neural Atuadores<br />

Resposta<br />

A rede neural biológica é formada por unidades de<br />

processamento: neurônios biológicos<br />

Neurônio Biológico<br />

4

Sinais de<br />

Entrada<br />

UFPR – PPGMNE - TC-747 - REDES NEURAIS E APLICAÇÕES EM ENGENHARIA Profa. Andrea Sell Dyminski<br />

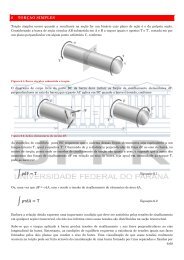

1.2 NEURÔNIO ARTIFICIAL<br />

Unidade de processamento da rede neural artificial<br />

Elementos básicos do neurônio artificial:<br />

a) Conjunto de Sinapses cada uma peso sináptico w kj<br />

correspondente, onde k é<br />

o número do neurônio e j<br />

o da sinapse.<br />

b) Somador gerando Combinador linear das<br />

entradas<br />

c) Função de Ativação aplicada ao valor de v k, gerando a<br />

saída y k<br />

Matematicamente:<br />

u<br />

k<br />

=<br />

m<br />

∑<br />

j=<br />

1<br />

x1<br />

x2<br />

...<br />

xm<br />

w<br />

kj<br />

x<br />

j<br />

Pesos<br />

Sinápticos<br />

wk1<br />

wk2<br />

...<br />

wkm<br />

Bias<br />

bk<br />

S<br />

vk<br />

Função de<br />

ativação<br />

ϕ(.)<br />

Saída<br />

yk<br />

5

UFPR – PPGMNE - TC-747 - REDES NEURAIS E APLICAÇÕES EM ENGENHARIA Profa. Andrea Sell Dyminski<br />

vk = uk + bk<br />

yk = j (uk + bk)<br />

Tipos de função de ativação j(v):<br />

a) Função de Limiar (ou step):<br />

j(v) =<br />

1 se v ≥ 0<br />

0 se v < 0<br />

b) Função Linear por partes:<br />

1 se v ≥ 1/2<br />

j(v) = v, se ½ > v > -1/2<br />

0 se v ≤ -1/2<br />

c) Função Sigmóide: Gráfico em forma de “S”. Exemplos:<br />

Função Logística:<br />

1<br />

( v)<br />

=<br />

1 + exp( −av)<br />

ϕ (varia de 0 a 1)<br />

onde: a parâmetro de inclinação da função sigmóide<br />

Função Tangente Hiperbólica: ϕ(v) = tanh (v)<br />

(pode assumir valores negativos)<br />

6

x =<br />

UFPR – PPGMNE - TC-747 - REDES NEURAIS E APLICAÇÕES EM ENGENHARIA Profa. Andrea Sell Dyminski<br />

d) Se neurônio estocástico (só podendo fornecer como saídas os<br />

valores 0 ou 1 – ligado ou desligado), pode-se fazer:<br />

0 com probabilidade P(v)<br />

1 com probabilidade 1 – P(v)<br />

onde: x representa o estado (ativo ou não ativo) do neurônio e P(v),<br />

probabilidade de liga-lo.<br />

7

UFPR – PPGMNE - TC-747 - REDES NEURAIS E APLICAÇÕES EM ENGENHARIA Profa. Andrea Sell Dyminski<br />

P(v) pode ser:<br />

1<br />

P(<br />

v)<br />

= (forma sigmóide)<br />

1 + exp( −v<br />

/ T )<br />

onde: T é a “pseudotemperatura” utilizada para controlar o nível de<br />

ruído sináptico.<br />

1.3 ARQUITETURAS DE REDE<br />

Redes Alimentadas Adiante (para frente) com camada única:<br />

8

UFPR – PPGMNE - TC-747 - REDES NEURAIS E APLICAÇÕES EM ENGENHARIA Profa. Andrea Sell Dyminski<br />

Redes Alimentadas Adiante (para frente) com múltiplas camadas<br />

(Multi-Layer Feedforward NN)<br />

Redes Recorrentes (possuem laços de realimentação)<br />

9

UFPR – PPGMNE - TC-747 - REDES NEURAIS E APLICAÇÕES EM ENGENHARIA Profa. Andrea Sell Dyminski<br />

1.4 REPRESENTAÇÃO DO CONHECIMENTO<br />

Conhecimento se refere à informação armazenada ou a<br />

modelos utilizados por uma pessoa ou máquina para<br />

interpretar, prever e responder apropriadamente ao mundo<br />

exterior.<br />

(Fischler e Firschein, 1987)<br />

Como representa-lo para a rede neural?<br />

Como saber se a mesma absorveu o conhecimento?<br />

Como escolher a arquitetura ideal?<br />

Inteligência Artificial X Redes Neurais Artificiais...<br />

(Vide bibliografia – Haykin, 2001).<br />

10

UFPR – PPGMNE - TC-747 - REDES NEURAIS E APLICAÇÕES EM ENGENHARIA Profa. Andrea Sell Dyminski<br />

2. PROCESSOS DE APRENDIZAGEM<br />

O processo de aprendizagem de uma RN compreende as seguintes<br />

etapas:<br />

a) A RN é estimulada por um ambiente;<br />

b) A RN sofre modificações em seus parâmetros livres (pesos<br />

sinápticos e bias), devido a este processo de estimulação;<br />

c) A RN responde de uma maneira nova ao ambiente, devido às<br />

modificações sofridas no passo “b”.<br />

2.1 APRENDIZAGEM POR CORREÇÃO DE ERRO<br />

Ajuste dos pesos sinápticos ocorre através da avaliação do erro.<br />

11

Novo<br />

UFPR – PPGMNE - TC-747 - REDES NEURAIS E APLICAÇÕES EM ENGENHARIA Profa. Andrea Sell Dyminski<br />

Cálculo do erro: e k(n) = d k(n) – y k(n)<br />

Minimizar a função de custo ou índice de desempenho ε(n):<br />

ε(n) = ½ . e k 2 (n)<br />

Minimização da função de custo ε(n) resulta na regra delta (ou regra de<br />

Widrow-Hoff). Assim, o ajuste aplicado ao peso w kj, no passo de tempo<br />

n, é:<br />

Δ w kj(n) = η . e k(n) . x j(n)<br />

onde η é a taxa de aprendizado.<br />

Assim, tem-se:<br />

w kj(n+1) = w kj(n) + Δ w kj(n)<br />

Antigo<br />

2.2 APRENDIZAGEM BASEADA EM MEMÓRIA<br />

Todas (ou a maioria das) experiências passadas são armazenadas<br />

explicitamente em uma grande memória de exemplos de entrada-saída<br />

classificados corretamente:<br />

{<br />

}<br />

N<br />

xi, d i ) i 1<br />

( =<br />

onde x i representa um vetor de entrada e d i, a resposta desejada<br />

correspondente.<br />

Usado para a classificação de padrões, baseada na vizinhança do<br />

vetor de teste x teste.<br />

12

UFPR – PPGMNE - TC-747 - REDES NEURAIS E APLICAÇÕES EM ENGENHARIA Profa. Andrea Sell Dyminski<br />

2.3 APRENDIZAGEM HEBBIANA<br />

Baseada nas seguintes regras:<br />

a) Se dois neurônios em ambos os lados de uma sinapse são<br />

ativados simultaneamente, então a força desta sinapse é<br />

seletivamente aumentada;<br />

b) Se dois neurônios em ambos os lados de uma sinapse são<br />

ativados assincronamente, então esta sinapse é seletivamente<br />

enfraquecida ou eliminada.<br />

Este tipo de sinapse é denominada de sinapse hebbiana.<br />

Matematicamente, o ajuste a ser realizado no peso sináptico w kj, no<br />

tempo n, é:<br />

Δw kj(n) = F(y k(n), x j(n))<br />

onde: x j sinal pré-sináptico<br />

y k sinal pós-sináptico<br />

Na hipótese de Hebb (forma mais simples – Regra do produto das<br />

atividades):<br />

Δw kj(n) = η. y k(n) . x j(n)<br />

onde: η é a taxa de aprendizado.<br />

Na hipótese da covariância, a fim de se evitar uma possível saturação<br />

da sinapse (que pode ocorrer na hipótese de Hebb), tem-se:<br />

Δw kj(n) = η. (x j(n) – x) . ( y k(n) – y)<br />

onde: x e y são os valores médios no tempo dos sinais pré e pós<br />

sinápticos, respectivamente.<br />

13

UFPR – PPGMNE - TC-747 - REDES NEURAIS E APLICAÇÕES EM ENGENHARIA Profa. Andrea Sell Dyminski<br />

2.4 APRENDIZAGEM COMPETITIVA<br />

Os neurônios de saída de uma rede neural competem entre si<br />

para se tornar ativos (disparar).<br />

Muito adequada para descobrir características<br />

estatisticamente salientes, visando a classificação de um<br />

conjunto de padrões de entrada.<br />

14