Neuronale Netze zur Auswertung von Delay Line Detektoren ...

Neuronale Netze zur Auswertung von Delay Line Detektoren ...

Neuronale Netze zur Auswertung von Delay Line Detektoren ...

Sie wollen auch ein ePaper? Erhöhen Sie die Reichweite Ihrer Titel.

YUMPU macht aus Druck-PDFs automatisch weboptimierte ePaper, die Google liebt.

Kapitel 2. <strong>Neuronale</strong> <strong>Netze</strong><br />

Für ein perfektes <strong>Neuronale</strong>s Netz müssten alle diese Parameter für jedes Neuron<br />

einzeln gefunden werden. Da dies nicht möglich ist, werden einige Vereinfachungen<br />

gemacht. Als erstes wird für alle Neuronen die gewichtete Summe als Propagierungsfunktion<br />

angenommen. Weiterhin werden die Aktivierungsfunktion und der Temperaturparameter<br />

für alle Neuronen einer Schicht gleich definiert. Als letzte Vereinfachung<br />

wird der Schwellwert mit in den Gewichtsvektor aufgenommen. Hierzu wird der Eingangsvektor<br />

um einen Bias genannten Eintrag erweitert. Dieser ist immer 1, aber das<br />

Gewicht zum Neuron ist der negative Schwellwert. Mithilfe dieser Tricks müssen später<br />

nur noch die Gewichtsvektoren aller Neuronen angepasst werden.<br />

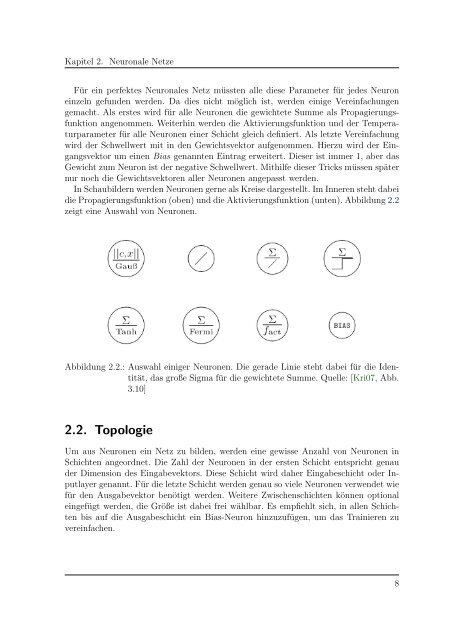

In Schaubildern werden Neuronen gerne als Kreise dargestellt. Im Inneren steht dabei<br />

die Propagierungsfunktion (oben) und die Aktivierungsfunktion (unten). Abbildung 2.2<br />

zeigt eine Auswahl <strong>von</strong> Neuronen.<br />

Abbildung 2.2.: Auswahl einiger Neuronen. Die gerade Linie steht dabei für die Identität,<br />

das große Sigma für die gewichtete Summe. Quelle: [Kri07, Abb.<br />

3.10]<br />

2.2. Topologie<br />

Um aus Neuronen ein Netz zu bilden, werden eine gewisse Anzahl <strong>von</strong> Neuronen in<br />

Schichten angeordnet. Die Zahl der Neuronen in der ersten Schicht entspricht genau<br />

der Dimension des Eingabevektors. Diese Schicht wird daher Eingabeschicht oder Inputlayer<br />

genannt. Für die letzte Schicht werden genau so viele Neuronen verwendet wie<br />

für den Ausgabevektor benötigt werden. Weitere Zwischenschichten können optional<br />

eingefügt werden, die Größe ist dabei frei wählbar. Es empfiehlt sich, in allen Schichten<br />

bis auf die Ausgabeschicht ein Bias-Neuron hinzuzufügen, um das Trainieren zu<br />

vereinfachen.<br />

8