Cutoff para $n$-muestras de procesos estocásticos ...

Cutoff para $n$-muestras de procesos estocásticos ...

Cutoff para $n$-muestras de procesos estocásticos ...

You also want an ePaper? Increase the reach of your titles

YUMPU automatically turns print PDFs into web optimized ePapers that Google loves.

UNIVERSIDAD DE CHILE<br />

FACULTAD DE CIENCIAS FÍSICAS Y MATEMÁTICAS<br />

ESCUELA DE POSTGRADO<br />

TESIS PARA OPTAR AL GRADO DE<br />

DOCTOR EN CIENCIAS DE LA INGENIERÍA<br />

MENCIÓN MODELACIÓN MATEMÁTICA<br />

EN COTUTELA CON LA UNIVERSIDAD DE PARIS 5<br />

CUTOFF PARA N-MUESTRAS DE PROCESOS ESTOCÁSTICOS<br />

EXPONENCIALMENTE CONVERGENTES Y PARTICIONES<br />

ALEATORIAS DEL INTERVALO [0, 1]<br />

JAVIERA PAULINA BARRERA MARTÍNEZ<br />

2005

UNIVERSIDAD DE CHILE<br />

FACULTAD DE CIENCIAS FÍSICAS Y MATEMÁTICAS<br />

ESCUELA DE POSTGRADO<br />

<strong>Cutoff</strong> <strong>para</strong> n-<strong>muestras</strong> <strong>de</strong> <strong>procesos</strong> <strong>estocásticos</strong> exponencialmente<br />

convergentes y particiones aleatorias <strong>de</strong>l intervalo [0, 1]<br />

JAVIERA PAULINA BARRERA MARTÍNEZ<br />

MIEMBROS DE LA COMISIÓN EVALUADORA<br />

Sr. Servet Martínez Profesor Guía Universidad <strong>de</strong> Chile<br />

Sr. Bernard Ycart Profesor Co-Guía Université <strong>de</strong> Paris 5<br />

Sr. Thierry Huillet Profesor Integrante Université <strong>de</strong> Cergy-Pontoise<br />

Sr. Jean-René Chazottes Profesor Integrante Ecole Polytechnique<br />

Sr. Joaquín Fontbona Profesor Integrante Universidad <strong>de</strong> Chile<br />

Sr. Alejandro Maass Profesor Integrante Universidad <strong>de</strong> Chile<br />

Sr. Jaime San Martín Profesor Integrante Universidad <strong>de</strong> Chile<br />

Sr. Roberto Fernán<strong>de</strong>z Profesor Integrante Université <strong>de</strong> Rouen<br />

TESIS PARA OPTAR AL GRADO DE<br />

DOCTOR EN CIENCIAS DE LA INGENIERÍA<br />

MENCIÓN MODELACIÓN MATEMÁTICA<br />

EN COTUTELA CON LA UNIVERSIDAD DE PARIS 5<br />

SANTIAGO DE CHILE<br />

DICIEMBRE 2005<br />

ii

Cuando acabe este verso que canto<br />

yo no sé, yo no sé, madre mía<br />

si me espera la paz o el espanto;<br />

si el ahora o si el todavía.<br />

Pues las causas me andan cercando<br />

cotidianas, invisibles.<br />

Y el azar se me viene enredando<br />

po<strong>de</strong>roso, invencible.<br />

Causas y azares<br />

Silvio Rodriguez

Agra<strong>de</strong>cimientos<br />

Esta tesis resume el trabajo <strong>de</strong> cuatro años <strong>de</strong> doctorado en co-tutela<br />

entre la Universidad <strong>de</strong> Chile y la Universidad <strong>de</strong> París 5. De estos cuatro años, dos<br />

transcurrieron en Chile y dos en Francia. Este trabajo trata dos temas tanto en lo<br />

formal como en lo personal; <strong>para</strong> saber qué es lo que trata formalmente basta leer los<br />

próximos 5 capítulos. En lo personal, trata sobre <strong>de</strong>jar el país que uno quiere <strong>para</strong><br />

apren<strong>de</strong>r a querer otro.<br />

Primero quiero agra<strong>de</strong>cer a mis dos profesores guías Servet Martínez<br />

y Bernard Ycart. Servet fue quien me motivó en el estudio <strong>de</strong> las probabilida<strong>de</strong>s<br />

en su curso <strong>de</strong> ca<strong>de</strong>nas <strong>de</strong> Markov y más tar<strong>de</strong>, calibrando mis cualida<strong>de</strong>s como<br />

matemática, me <strong>de</strong>safió con problemas muy interesantes. Bernard, por su parte, fue<br />

un profesor guía cuidadoso, exigiendo tanto pulir los resultados como presentarlos<br />

con elegancia. A ambos les agra<strong>de</strong>zco mucho el haber guiado esta tesis.<br />

Les agra<strong>de</strong>zco también a Thierry Huillet, Christian Paroissin y Béatrice<br />

Lachaud que colaboraron conmigo en este trabajo <strong>de</strong> investigación y con quienes fue<br />

un placer discutir.<br />

Les agra<strong>de</strong>zco a los profesores Roberto Fernán<strong>de</strong>z y Danièle Gardy por<br />

darse el tiempo <strong>de</strong> leer y emitir su opinión sobre esta tesis.<br />

Le agra<strong>de</strong>zco al Departamento <strong>de</strong> Ingeniería Matemática <strong>de</strong> la Universidad<br />

<strong>de</strong> Chile don<strong>de</strong> transcurrieron mis primeros años <strong>de</strong>l doctorado y tuve excelentes<br />

cursos y gran<strong>de</strong>s profesores. También les doy las gracias a los funcionarios<br />

quienes siempre han sido muy cariñosos conmigo. En la facultad que alberga a este<br />

<strong>de</strong>partamento hice mis mejores amigos. Algunos estudiando física un verano: Eduardo,<br />

Vicho, Andrés, Jordi, Eduardo, Pedro y Rocío; otros durante la carrera: Isabel,<br />

Matías, Ángela, Álvaro, Nicolás, Mariel, Joaquín, Anneli y la Mariela; y aquellas<br />

amista<strong>de</strong>s que hice en la cancha, jugando a la pelota: Daren, Ma Alejandra, Ai-ling,<br />

Daniela, Andrea, Lorna y Natalia. A todos ellos les agra<strong>de</strong>zco <strong>de</strong> corazón.<br />

En septiembre <strong>de</strong>l 2003 me fui a Francia con sentimientos encontrados.<br />

Se hacía difícil <strong>de</strong>jar Chile, pero al mismo tiempo Francia <strong>de</strong>spertaba mi curiosidad.<br />

En la Universidad <strong>de</strong> París 5 me esperaba el profesor Bernard Ycart, quien junto a<br />

los funcionarios me ayudaron a solucionar todo tipo <strong>de</strong> problemas. También conocí a<br />

los tesistas <strong>de</strong> la U. <strong>de</strong> París 5: Béatrice, Olivier, Raphaël y David. Luego encontré a<br />

las tesistas <strong>de</strong>l 4 piso Gwendoline, Claire y Amandine. Todos ellos fueron excelentes<br />

amigos y compañeros con los que resolvimos puzzles, enigmas y cultivamos plantas a<br />

la hora <strong>de</strong>l café. Gracias a Pedro conocí a los chicos <strong>de</strong>l Laboratorio PSE: Facundo,<br />

ii

Dimitris, Hector, Michael y Gregory con quienes visitamos diferentes restaurantes<br />

<strong>de</strong> París. También estudiaban en esa época por allá Eduardo y Anneli con quienes<br />

compartí esta experiencia. Gracias a todos ellos por hacer <strong>de</strong> París un hogar.<br />

Los últimos 8 años <strong>de</strong> mi vida no se pue<strong>de</strong>n se<strong>para</strong>r <strong>de</strong> Pedro. Juntos<br />

partimos a vivir en París y <strong>de</strong>scubrir Europa. Le agra<strong>de</strong>zco <strong>de</strong> corazón el apoyo y<br />

aliento que me brindó <strong>para</strong> llevar a cabo esta tesis. También le agra<strong>de</strong>zco a la familia<br />

<strong>de</strong> Pedro y a Bárbara por el apoyo incondicional que nos dieron y visitas que nos<br />

hicieron.<br />

Des<strong>de</strong> el fondo <strong>de</strong> mi alma les agra<strong>de</strong>zco a mi padres, a mis hermanos<br />

y al resto mi familia por estar siempre orgullosos <strong>de</strong> mi trabajo, no sería tan fácil<br />

gozar <strong>de</strong> esta disciplina sin su compresión.<br />

Agra<strong>de</strong>zco al Estado <strong>de</strong> Chile y <strong>de</strong> Francia por financiar mi doctorado<br />

y al Núcleo Milenio P01-005 y proyecto Mecesup por el apoyo brindado.<br />

iii

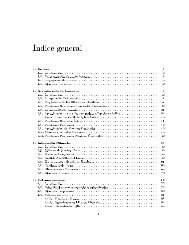

Índice general<br />

1. Introducción 1<br />

2. Distancias entre distribuciones <strong>de</strong> probabilidad 4<br />

2.1. Distancia en Variación total . . . . . . . . . . . . . . . . . . . . . . . 5<br />

2.2. Las distancias <strong>de</strong> Helliger, Chi-cuadrado y Kullback . . . . . . . . . . 7<br />

2.3. Distancia entre medidas productos . . . . . . . . . . . . . . . . . . . 10<br />

2.4. Ejemplos . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 12<br />

2.4.1. Bernoulli . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 12<br />

2.4.2. Poisson . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 16<br />

2.4.3. Normal . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 23<br />

3. <strong>Cutoff</strong> <strong>para</strong> n-tuplas <strong>de</strong> <strong>procesos</strong> exponencialmente convergentes 36<br />

3.1. Definición y algunos ejemplos clásicos . . . . . . . . . . . . . . . . . . 37<br />

3.1.1. ¿Qué es el <strong>Cutoff</strong>? . . . . . . . . . . . . . . . . . . . . . . . . 38<br />

3.1.2. Definición y un poco <strong>de</strong> historia . . . . . . . . . . . . . . . . . 39<br />

3.2. Procesos exponencialmente convergentes . . . . . . . . . . . . . . . . 41<br />

3.3. Tiempos <strong>de</strong> <strong>Cutoff</strong> . . . . . . . . . . . . . . . . . . . . . . . . . . . . 49<br />

iv

3.4. Ejemplos <strong>de</strong> <strong>procesos</strong> i.i.d. . . . . . . . . . . . . . . . . . . . . . . . . 58<br />

3.4.1. Proceso Binario . . . . . . . . . . . . . . . . . . . . . . . . . . 59<br />

3.4.2. La cola M/M/∞ . . . . . . . . . . . . . . . . . . . . . . . . . 60<br />

3.4.3. El proceso Ornstein-Uhlenbeck . . . . . . . . . . . . . . . . . 62<br />

4. Particiones aleatorias <strong>de</strong>l intervalo [0, 1] 64<br />

4.1. Particiones <strong>de</strong>l intervalo [0, 1] . . . . . . . . . . . . . . . . . . . . . . 66<br />

4.2. Particiones Aleatorias . . . . . . . . . . . . . . . . . . . . . . . . . . . 69<br />

4.2.1. El mo<strong>de</strong>lo <strong>de</strong> partición por renormalización . . . . . . . . . . . 69<br />

4.2.2. El mo<strong>de</strong>lo <strong>de</strong> localización aleatoria . . . . . . . . . . . . . . . 70<br />

4.3. La familia <strong>de</strong> particiones <strong>de</strong> Dirichlet . . . . . . . . . . . . . . . . . . 71<br />

4.3.1. Introducción <strong>de</strong>l mo<strong>de</strong>lo . . . . . . . . . . . . . . . . . . . . . 72<br />

4.3.2. Muestreo y permutación sesgada por tamaño . . . . . . . . . . 74<br />

4.3.3. Una com<strong>para</strong>ción <strong>de</strong>l costo <strong>de</strong> búsqueda en la partición <strong>de</strong><br />

Dirichlet y su permutación sesgada por tamaño . . . . . . . . 79<br />

4.4. El mo<strong>de</strong>lo <strong>de</strong> fragmentación <strong>de</strong> la vara . . . . . . . . . . . . . . . . . 85<br />

4.4.1. El promedio geométrico <strong>de</strong> los intervalos ocupados . . . . . . . 87<br />

4.4.2. La función partición . . . . . . . . . . . . . . . . . . . . . . . 90<br />

4.4.3. La ley unidimensional <strong>de</strong> un segmento . . . . . . . . . . . . . 93<br />

4.4.4. Or<strong>de</strong>n <strong>de</strong>creciente en tamaño: la distribución <strong>de</strong>l más pequeño<br />

y <strong>de</strong>l más largo <strong>de</strong> los intervalos . . . . . . . . . . . . . . . . . 94<br />

4.4.5. Permutación sesgada por tamaño . . . . . . . . . . . . . . . . 101<br />

5. Reglas <strong>de</strong> autorganización con popularida<strong>de</strong>s aleatorias 104<br />

v

5.1. Reglas <strong>de</strong> auto-organización <strong>de</strong> datos . . . . . . . . . . . . . . . . . . 106<br />

5.1.1. Motivación: ¿Cómo y dón<strong>de</strong> almacenar libros? . . . . . . . . . 107<br />

5.1.2. El mo<strong>de</strong>lo <strong>de</strong> Move-to-Front . . . . . . . . . . . . . . . . . . . 108<br />

5.1.3. Relación con otras estructuras aleatorias . . . . . . . . . . . . 110<br />

5.1.4. El Mo<strong>de</strong>lo <strong>de</strong> Move-to-Root . . . . . . . . . . . . . . . . . . . 111<br />

5.2. Move-to-Front con popularida<strong>de</strong>s aleatorias . . . . . . . . . . . . . . . 114<br />

5.2.1. Expresión exacta <strong>para</strong> la transformada <strong>de</strong> Laplace . . . . . . . 115<br />

5.2.2. Fórmula asintótica <strong>para</strong> la transformada <strong>de</strong> Laplace . . . . . . 120<br />

5.2.3. Ejemplos y algunas propieda<strong>de</strong>s . . . . . . . . . . . . . . . . . 131<br />

5.3. Move-to-root con popularida<strong>de</strong>s aleatorias . . . . . . . . . . . . . . . 137<br />

5.3.1. Los dos primeros momentos <strong>de</strong> or<strong>de</strong>n <strong>de</strong>l costo <strong>de</strong> búsqueda<br />

estacionario . . . . . . . . . . . . . . . . . . . . . . . . . . . . 137<br />

5.3.2. Ejemplos . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 140<br />

6. Conclusiones 146<br />

vi

RESUMEN DEL INFORME FINAL<br />

PARA OPTAR AL TÍTULO DE<br />

DOCTOR EN CIENCIAS DE LA INGENIERÍA<br />

POR: JAVIERA BARRERA MARTÍNEZ<br />

PROF. GUÍA: SR. SERVET MARTÍNEZ<br />

FECHA DE EXAMEN: 6 DICIEMBRE 2005<br />

<strong>Cutoff</strong> <strong>para</strong> n-<strong>muestras</strong> <strong>de</strong> <strong>procesos</strong> <strong>estocásticos</strong><br />

exponencialmente convergentes y particiones aleatorias <strong>de</strong>l<br />

intervalo [0, 1]<br />

En este trabajo abordamos dos temas <strong>de</strong> probabilida<strong>de</strong>s uno es el<br />

fenómeno <strong>de</strong> <strong>Cutoff</strong> en n-tuplas y el otro es sobre particiones aleatorias <strong>de</strong>l<br />

intervalo [0, 1]. Los resultados <strong>de</strong> <strong>Cutoff</strong> correspon<strong>de</strong>n al trabajo realizado<br />

en conjunto con B. Lachaud y B. Ycart. Los resultados en el tema <strong>de</strong><br />

particiones aleatorias en colaboración con T. Huillet y Ch. Paroissin.<br />

El <strong>Cutoff</strong> es una propiedad <strong>de</strong>finida <strong>para</strong> familias <strong>de</strong> <strong>procesos</strong> <strong>de</strong> Markov<br />

que refleja la convergencia abrupta a la distribución estacionaria. En<br />

esta tesis abordamos el tema <strong>de</strong> las distancias entre distribuciones <strong>de</strong> probabilidad,<br />

motivados por el fenómeno <strong>de</strong> <strong>Cutoff</strong>. Luego estudiamos este<br />

fenómeno <strong>para</strong> n-tuplas <strong>de</strong> <strong>procesos</strong> in<strong>de</strong>pendientes, tanto idénticamente<br />

distribuidos como no. El resultado principal <strong>de</strong> la primera parte da<br />

condiciones bajo las cuales una n-tupla <strong>de</strong> <strong>procesos</strong> que convergen exponencialmente<br />

tiene un <strong>Cutoff</strong> en el sentido <strong>de</strong> las distancias <strong>de</strong> Variación<br />

total, Hellinger, Chi-cuadrado y Kullback.<br />

La segunda parte <strong>de</strong> los resultados se centran en las particiones aleatorias.<br />

Estudiamos las características <strong>de</strong> la partición <strong>de</strong> Dirichlet (D) que<br />

<strong>de</strong>spués <strong>de</strong> una permutación sesgada por tamaño es una aproximación <strong>de</strong><br />

una partición GEM (Griffiths-Engen-McCloskey). También estudiamos<br />

la partición <strong>de</strong>l mo<strong>de</strong>lo <strong>de</strong> fragmentación <strong>de</strong> la vara que aproxima una<br />

partición GEM <strong>de</strong> parámetro 1. Ambos análisis se centran en la función<br />

generadora <strong>de</strong> momentos conjunta <strong>de</strong> las particiones.<br />

En este trabajo consi<strong>de</strong>ramos dos estrategias <strong>para</strong> organizar ítemes:<br />

<strong>de</strong>splazar al frente (MtF) que organiza una lista y <strong>de</strong>splazar a la raíz<br />

(MtR) que organiza un árbol binario <strong>de</strong> búsqueda. Los resultados en<br />

torno a las dos estrategias se centran en el análisis <strong>de</strong>l costo <strong>de</strong> búsqueda<br />

en régimen estacionario en el contexto <strong>de</strong> particiones aleatorias generadas<br />

por renormalización. El resultado principal <strong>para</strong> la regla MtF es la distribución<br />

asintótica en el número <strong>de</strong> ítemes <strong>de</strong>l costo <strong>de</strong> búsqueda y <strong>para</strong><br />

la estrategia MtR se encontró el comportamiento asintótico <strong>de</strong>l costo <strong>de</strong><br />

búsqueda <strong>para</strong> dos particiones particulares.

Introducción<br />

Como lo expresa el título, en esta tesis abordamos dos temas <strong>de</strong> pro-<br />

babilida<strong>de</strong>s uno es el fenómeno <strong>de</strong> <strong>Cutoff</strong> en n-tuplas y el otro es sobre particiones<br />

aleatorias <strong>de</strong>l intervalo [0, 1]. Los Capítulos 2 y 3 correspon<strong>de</strong>n al trabajo realizado<br />

sobre <strong>Cutoff</strong> en conjunto con B. Lachaud y B. Ycart [6]. Los Capítulos 4 y 5 abordan<br />

los trabajos realizado en el tema <strong>de</strong> particiones aleatorias en colaboración con T.<br />

Huillet [3], con Ch. Paroissin [7] y [8] y con ambos autores [4] y [5].<br />

El <strong>Cutoff</strong> es una propiedad <strong>de</strong>finida <strong>para</strong> familias <strong>de</strong> <strong>procesos</strong> <strong>de</strong> Mar-<br />

kov que refleja la convergencia abrupta a la distribución estacionaria. En el Capítulo 2<br />

abordamos el tema <strong>de</strong> las distancias entre distribuciones <strong>de</strong> probabilidad, motivados<br />

por el fenómeno <strong>de</strong> <strong>Cutoff</strong>. Básicamente <strong>de</strong>finimos las distancias <strong>de</strong> Variación total,<br />

Hellinger, Chi-cuadrado y Kullback. Resumimos aquellas propieda<strong>de</strong>s relevantes pa-<br />

ra el <strong>de</strong>sarrollo <strong>de</strong> nuestros resultados, las que se pue<strong>de</strong>n encontrar en [51] o [29] y<br />

calculamos algunos ejemplos. El concepto <strong>de</strong> <strong>Cutoff</strong> busca <strong>de</strong>scribir la convergencia<br />

abrupta que se observa en ciertos <strong>procesos</strong> <strong>estocásticos</strong> y está ligado una distancia.<br />

Tradicionalmente ha sido la distancia en Variación total, pero no ha sido la única,<br />

como discutiremos en el Capítulo 3.<br />

El objetivo <strong>de</strong>l Capítulo 3 es estudiar el fenómeno <strong>de</strong> <strong>Cutoff</strong> <strong>para</strong> n-<br />

tuplas <strong>de</strong> <strong>procesos</strong> in<strong>de</strong>pendientes, tanto idénticamente distribuidos como no. Para<br />

esto exten<strong>de</strong>mos la <strong>de</strong>finición <strong>de</strong> <strong>Cutoff</strong> <strong>para</strong> otras distancias (Definición 3.1.1) y<br />

damos la <strong>de</strong>finición <strong>de</strong> convergencia exponencial a taza ρ (Definición 3.2.1) que utili-<br />

zaremos don<strong>de</strong> buscamos que el logaritmo <strong>de</strong> la distancia en el instante t se comporte<br />

1

como −ρt. Es en la Sección 3.3 don<strong>de</strong> exponemos nuestro resultado principal <strong>de</strong> Cu-<br />

toff, el Teorema 3.3.1, que da condiciones bajo las cuales una n-tupla <strong>de</strong> <strong>procesos</strong><br />

exponencialmente convergentes tiene un <strong>Cutoff</strong> en el sentido <strong>de</strong> las distancias <strong>de</strong><br />

Variación total, Hellinger, Chi-cuadrado y Kullback. En conjunto estos dos capítu-<br />

los constituyen el artículo “<strong>Cutoff</strong> for exponentially converging processes” que fue<br />

enviado a una revista <strong>para</strong> su eventual publicación (ver [6]).<br />

El segundo tema <strong>de</strong> esta tesis es abordado en los Capítulos 4 y 5. En el<br />

primero <strong>de</strong> estos en la Sección 4.2 introducimos dos mo<strong>de</strong>los generales <strong>para</strong> generar<br />

particiones aleatorias. El primero que llamaremos partición por renormalización es<br />

generado por n variables in<strong>de</strong>pendientes que son normalizadas por la suma total <strong>de</strong><br />

ellas. El segundo, que llamaremos <strong>de</strong> localización aleatoria, es generado por n varia-<br />

bles in<strong>de</strong>pendientes con soporte en (0, 1) don<strong>de</strong> los segmentos se originan como el<br />

producto <strong>de</strong> las variables. En la Sección 4.3 introducimos formalmente la partición<br />

aleatoria <strong>de</strong> Dirichlet, Poisson-Dirichlet y GEM. Recordamos varias <strong>de</strong> sus propie-<br />

da<strong>de</strong>s y recopilamos algunos resultados nuevos que fueron publicados en el artículo<br />

“Size-biased permutation of Dirichlet Partitions and search-cost distribution” [4]. Fi-<br />

nalmente en la Sección 4.4 <strong>de</strong>finimos y estudiamos las propieda<strong>de</strong>s <strong>de</strong>l mo<strong>de</strong>lo <strong>de</strong><br />

partición <strong>de</strong> fragmentación <strong>de</strong> la vara que aproxima la partición <strong>de</strong> GEM <strong>para</strong> cierto<br />

parámetro. Los resultados <strong>de</strong>scritos en esta sección fueron objeto <strong>de</strong> la publicación<br />

“On the random spliting of the interval” [3].<br />

En el Capítulo 5 presentamos dos estrategias <strong>para</strong> or<strong>de</strong>nar ítemes: las<br />

estrategias <strong>de</strong> Move-to-front <strong>para</strong> or<strong>de</strong>nar en una lista y Move-to-root <strong>para</strong> or<strong>de</strong>nar<br />

en un árbol. En la Sección 5.1 se <strong>de</strong>scriben ambas estrategias y sus propieda<strong>de</strong>s,<br />

entre ellas el costo <strong>de</strong> búsqueda (Definiciones 5.1.1 y 5.1.5) que mi<strong>de</strong> <strong>de</strong>sempeño <strong>de</strong><br />

2

ambas estrategias en el instante t. Ambas reglas han sido ampliamente estudiadas en<br />

el contexto <strong>de</strong> ca<strong>de</strong>nas <strong>de</strong> Markov don<strong>de</strong> las probabilida<strong>de</strong>s <strong>de</strong> transición <strong>de</strong>pen<strong>de</strong>n<br />

<strong>de</strong> la probabilidad (pi) <strong>de</strong> solicitar cada uno <strong>de</strong> los ítemes ver <strong>para</strong> el Move-to-front<br />

los trabajos [60] y [31] y más recientemente [28] y [26] <strong>para</strong> el Move-to-root ver [20] y<br />

[19]. El análisis <strong>de</strong>l tema es diferente al realizado en los trabajos anteriores, pues las<br />

probabilida<strong>de</strong>s <strong>de</strong> requerir un ítem están dadas por una partición aleatoria por renor-<br />

malización. En la Sección 5.2 estudiamos la regla Move-to-front, nuestro resultado<br />

principal <strong>para</strong> esta estrategia es el Teorema 5.2.7 don<strong>de</strong> encontramos la distribución<br />

<strong>de</strong>l costo <strong>de</strong> búsqueda estacionario normalizado cuando el número <strong>de</strong> ítemes tien<strong>de</strong><br />

a infinito. Para el caso <strong>de</strong> la regla <strong>de</strong> Move-to-root, estudiada en la Sección 5.3, tam-<br />

bién analizamos el comportamiento asintótico en el número <strong>de</strong> ítemes, pero nuestro<br />

resultado se restringe al primer y segundo momento <strong>de</strong>l costo <strong>de</strong> búsqueda estacio-<br />

nario. Los resultado sobre la estrategia Move-to-front trabajos se pue<strong>de</strong>n encontrar<br />

en el artículo “On the distribution of the search cost for the move-to-front rule with<br />

random weights” ([7]) y su continuación el artículo “Limiting search cost distribution<br />

for move-to-front rule with random request probabilities” ([5]). Así como los resul-<br />

tados <strong>de</strong> Move-to-root fueron expuestos en el poster “On the stationary search cost<br />

for the move-to-root rule with random weight” ([8]).<br />

3

Distancias entre distribuciones<br />

<strong>de</strong> probabilidad<br />

Una pregunta fundamental en el ámbito <strong>de</strong> las probabilida<strong>de</strong>s y la<br />

estadística ha sido la convergencia <strong>de</strong> familias <strong>de</strong> distribuciones <strong>de</strong> probabilidad. En<br />

las aplicaciones surge la necesidad <strong>de</strong> cuantificar esta convergencia en términos <strong>de</strong><br />

una distancia. En la literatura existen muchas métricas y otras funciones que nos<br />

permiten tener una noción <strong>de</strong> “distancia” entre distribuciones. Por simplicidad nos<br />

referiremos a ellas como distancias, aún cuando en el sentido matemático no lo sean.<br />

Estas funciones, o métricas, han probado ser <strong>de</strong> gran utilidad en diferentes contextos<br />

ya sea por su interpretación, sus propieda<strong>de</strong>s teóricas o las relaciones existentes<br />

entre ellas. Por ejemplo, a fines <strong>de</strong> los años 40 y durante los 50 las distancias entre<br />

distribuciones <strong>de</strong> probabilidad se utilizan en el diseño <strong>de</strong> test estadísticos (ver e.g.<br />

[32]). Des<strong>de</strong> los años 70 gran<strong>de</strong>s esfuerzos se han realizado en el ámbito <strong>de</strong> la teoría<br />

<strong>de</strong> los valores extremos <strong>para</strong> establecer el rango <strong>de</strong> vali<strong>de</strong>z <strong>de</strong> las aproximaciones<br />

con respecto a diferentes distancias (ver las notas bibliográficas <strong>de</strong> los Capítulos 4<br />

y 5 <strong>de</strong> [51]). En los años 90 se <strong>de</strong>sarrollan los métodos <strong>de</strong> Monte-Carlo (ver [27]),<br />

que consisten en aproximar una probabilidad ν a partir <strong>de</strong> una ca<strong>de</strong>na <strong>de</strong> Markov<br />

reversible con ley estacionaria ν. En la aplicación <strong>de</strong> esta técnica es natural que surja<br />

la necesidad <strong>de</strong> imponer una distancia <strong>para</strong> <strong>de</strong>terminar cuándo <strong>de</strong>tener el algoritmo.<br />

Nuestra motivación <strong>para</strong> abordar el tema <strong>de</strong> las distancias es el fenó-<br />

meno <strong>de</strong> <strong>Cutoff</strong>. El concepto <strong>de</strong> <strong>Cutoff</strong> busca <strong>de</strong>scribir la convergencia abrupta que<br />

se observa en ciertos <strong>procesos</strong> <strong>estocásticos</strong> y está ligado una distancia. Tradicional-<br />

4

mente esta ha sido la distancia en Variación total, pero no ha sido la única, como<br />

discutiremos en el capítulo correspondiente.<br />

Abordar el tema <strong>de</strong> las distancias entre leyes <strong>de</strong> probabilidad nos toma-<br />

rías más que un capítulo <strong>de</strong> esta tesis. Escogimos aquellas que nos permiten estimar<br />

la distancia entre dos medidas producto: la distancia <strong>de</strong> Variación total (VT), He-<br />

llinger (H), Chi-cuadrado (χ 2 ) y Kullback (K). En la primera <strong>de</strong> cuatro secciones<br />

tratamos la distancia en VT <strong>para</strong> <strong>de</strong>scribir sus diferentes caracterizaciones y propie-<br />

da<strong>de</strong>s. La segunda está <strong>de</strong>dicada a las otras tres distancias, a sus propieda<strong>de</strong>s y a<br />

estudiar como se relacionan entre ellas y la distancia en VT. En la tercera sección<br />

tratamos las distancias entre medias productos y, finalmente, en la última sección<br />

proporcionamos el cálculo explícito <strong>de</strong> las distancias entre dos medidas <strong>de</strong> probabi-<br />

lidad generadas como un producto tensorial <strong>de</strong> una misma distribución <strong>para</strong> el caso<br />

<strong>de</strong> dos productos <strong>de</strong> Bernoulli, <strong>de</strong> Poisson y <strong>de</strong> Gaussianas.<br />

Si bien algunas <strong>de</strong> las distancias están <strong>de</strong>finidas en un contexto más<br />

amplio que el <strong>de</strong> medidas <strong>de</strong> probabilidad, nos restringiremos a este último espacio<br />

<strong>para</strong> estudiarlas, por lo que toda afirmación <strong>de</strong>berá consi<strong>de</strong>rarse en este contexto.<br />

2.1. Distancia en Variación total<br />

Consi<strong>de</strong>remos el espacio medible (E, F). Sean µ y ν dos medidas <strong>de</strong><br />

probabilidad <strong>de</strong>finidas en este espacio. Sea λ una distribución que domina a ambas<br />

medidas y <strong>de</strong>notemos por g (resp. h) la <strong>de</strong>nsidad <strong>de</strong> µ (resp. ν) con respecto a λ.<br />

La distancia en VT entre las dos medidas <strong>de</strong> probabilidad µ y ν se<br />

5

<strong>de</strong>fine como:<br />

dV T (µ, ν) = sup |µ(A) − ν(A)| . (2.1)<br />

A∈F<br />

De la <strong>de</strong>finición se <strong>de</strong>spren<strong>de</strong> que dV T (µ, ν) toma valores entre 0 y 1. De la ecua-<br />

ción (2.1) vemos que la distancia en VT entre dos medidas µ y ν es el peor error<br />

que cometeríamos al aproximar la medida µ(A) <strong>de</strong> un conjunto cualquiera por ν(A).<br />

Esta interpretación pue<strong>de</strong> ser una <strong>de</strong> las razones que la ha llevado a ser la más utili-<br />

zada en la literatura. Otra razón pue<strong>de</strong> ser sus otras múltiples caracterizaciones que<br />

han permitido <strong>de</strong>sarrollar diferentes técnicas <strong>para</strong> acotarla. La siguiente propiedad<br />

enumera tres <strong>de</strong> las más conocidas.<br />

Proposición 2.1.1.<br />

1. Sea µ(ϕ) = ϕ dµ entonces la distancia en VT entre µ y ν vale<br />

dV T (µ, ν) = 1<br />

sup{|µ(ϕ) − ν(ϕ)| : |ϕ| ≤ 1 y ϕ medible } .<br />

2<br />

2. La distancia en VT entre µ y ν es la norma L 1 (λ) entre las <strong>de</strong>nsida<strong>de</strong>s con<br />

respecto a λ <strong>de</strong> µ y ν,<br />

dV T (µ, ν) = 1<br />

<br />

|g − h|dλ .<br />

2 E<br />

3. Sean X e Y dos variables aleatorias distribuidas según µ y ν respectivamente,<br />

la distancia en VT entre µ y ν vale el ínfimo <strong>de</strong> la probabilidad que X e Y sean<br />

distintas sobre todas las posibles leyes conjuntas entre X e Y . Esta propiedad<br />

es conocida como la caracterización <strong>de</strong> “acoplamiento” (en inglés coupling).<br />

dV T (µ, ν) = ínf{P (X = Y ) : X, Y t.q. L(X) = µ y L(Y ) = ν} .<br />

6

La caracterización (2) permite trabajar la distancia en VT usando las<br />

técnicas <strong>de</strong> las normas L p . Por otros lado, la construcción <strong>de</strong> acoplamientos entre<br />

medidas se ha convertido en una importante técnica <strong>para</strong> estimar la distancia en VT<br />

(ver [40]).<br />

Aun cuando la distancia en VT posee estas y otras propieda<strong>de</strong>s, otras<br />

distancias han hecho su aparición en la literatura. Algunas porque son más simples<br />

<strong>de</strong> calcular y permiten acotar la distancia en VT. Mientras otras simplemente <strong>para</strong><br />

reemplazarla, pues la distancia en VT no es capaz <strong>de</strong> captar ciertos fenómenos como<br />

por ejemplo la convergencia <strong>de</strong> una sucesión <strong>de</strong> variables aleatorias discretas a una<br />

variable continua. La discusión realizada por Gibbs y Su en [29] ilustra bien los<br />

motivos generales que llevan a consi<strong>de</strong>rar otras distancias y las relaciones entre ellas.<br />

En la siguiente sección introducimos las distancias <strong>de</strong> Hellinger, Chi-cuadrado y<br />

Kullback que permiten obtener las cotas <strong>de</strong>l or<strong>de</strong>n correcto <strong>para</strong> la distancias entre<br />

medidas productos <strong>de</strong> la Sección 2.3.<br />

2.2. Las distancias <strong>de</strong> Helliger, Chi-cuadrado y Ku-<br />

llback<br />

De las diferentes distancias entre distribuciones que hay en la literatura<br />

escogimos estas tres porque tienen la propiedad <strong>de</strong> permitir trabajar la distancia entre<br />

medidas productos en términos <strong>de</strong> la distancia entre sus marginales. La distancia <strong>de</strong><br />

χ 2 <strong>de</strong>be su nombre al test estadístico pues, como veremos, el cuadrado <strong>de</strong> la distancia<br />

normalizado por por la talla <strong>de</strong> la muestra tiene la misma forma que el estadístico<br />

7

χ 2 . La distancia <strong>de</strong> K es también conocida como la distancia <strong>de</strong> Entropía relativa<br />

y fue <strong>de</strong>finida por Kullback y Leibler en 1951 como la generalización <strong>de</strong> la noción<br />

<strong>de</strong> entropía <strong>de</strong> Shannon. La distancia <strong>de</strong> H habría sido <strong>de</strong>finida y popularizada por<br />

Kakutani en 1948. Hellinger, quien dio el nombre a la distancia, utilizó una cantidad<br />

relacionada a esta distancia en la teoría <strong>de</strong> operadores. Para más <strong>de</strong>talles sobre el<br />

uso <strong>de</strong> estas distancias ver el artículo <strong>de</strong> [29] y las referencias citadas en él.<br />

Al igual que en la sección prece<strong>de</strong>nte, consi<strong>de</strong>remos el espacio medible<br />

(E, F). Sean µ y ν dos medidas <strong>de</strong> probabilidad <strong>de</strong>finidas en este espacio. Sea λ una<br />

distribución que domina a ambas medidas y <strong>de</strong>notemos por g (resp. h) la <strong>de</strong>nsidad<br />

<strong>de</strong> µ (resp. ν) con respecto a λ. Sea Sµ (resp. Sν) el soporte <strong>de</strong> µ (resp. ν).<br />

Definición 2.2.1.<br />

1. La distancia <strong>de</strong> Hellinger entre µ y ν es<br />

dH(µ, ν) = 1<br />

<br />

√<br />

2<br />

<br />

(<br />

E<br />

f − √ g) 2 1/2 <br />

1/2 dλ = 1 − fg dλ .<br />

E<br />

2. La distancia <strong>de</strong> L 2 (λ) entre µ y ν es<br />

<br />

dL2 (λ)(µ, ν) =<br />

3. La distancia <strong>de</strong> Kullback entre µ y ν es<br />

dK(µ, ν) =<br />

<br />

Sµ<br />

(f − g) 2 1/2 dλ<br />

f log(f/g) dλ<br />

1/2<br />

Las distancias <strong>de</strong> H y K son in<strong>de</strong>pendientes <strong>de</strong> la medida dominante λ.<br />

La distancia <strong>de</strong> H es una métrica y toma valores entre 0 y 1. La distancia <strong>de</strong> K no<br />

8<br />

.<br />

.

es simétrica en sus argumentos (µ, ν) y toman valores entre 0 e ∞ (ver [48] pág. 61).<br />

Si µ es absolutamente continua con respecto a ν luego d2 L2 (ν) (µ, ν) es la distancia <strong>de</strong><br />

Chi-cuadrado usual entre µ y ν. Como trataremos principalmente este caso, y <strong>para</strong><br />

asegurar la homogeneidad <strong>de</strong> los resultados, notaremos por d χ 2(µ, ν) la distancia <strong>de</strong><br />

Chi-cuadrado (χ 2 ) entre µ y ν a la distancia L 2 (ν):<br />

d χ 2(µ, ν) = d L 2 (ν)(µ, ν) .<br />

La distancia <strong>de</strong> χ 2 tampoco es simétrica y toma valores entre 0 e ∞.<br />

La siguiente proposición resume las cotas clásicas que relacionan las<br />

cuatro distancias (ver figura 1 <strong>de</strong> [58]).<br />

Proposición 2.2.2.<br />

1. dH(µ, ν) 2 ≤ dT V (µ, ν)<br />

2. dT V (µ, ν) ≤ dH(µ, ν) 2 − dH(µ, ν) 2 ≤ √ 2dH(µ, ν)<br />

3. dT V (µ, ν) ≤ 2d χ 2(µ, ν)<br />

4. dT V (µ, ν) ≤ 2/ √ 2dK(µ, ν)<br />

5. dH(µ, ν) ≤ √ 2dK(µ, ν)<br />

6. dK(µ, ν) ≤ log(1 + d χ 2(µ, ν) 2 ) ≤ d χ 2(µ, ν)<br />

De las dos primeras <strong>de</strong>sigualda<strong>de</strong>s <strong>de</strong> esta proposición se <strong>de</strong>spren<strong>de</strong> que<br />

la distancia en VT y <strong>de</strong> H son equivalentes en el sentido <strong>de</strong> que inducen la misma<br />

topología.<br />

9

2.3. Distancia entre medidas productos<br />

Como mencionamos en la introducción <strong>de</strong>l capítulo estamos interesados<br />

en la distancia entre medidas producto. Sea (E (n) , F (n) ) el espacio que resulta <strong>de</strong>l<br />

producto <strong>de</strong> los espacios (Ei, Fi) con i = 1, . . . , n, es <strong>de</strong>cir, E (n) = E1 × . . . × En y<br />

F (n) = F1 ⊗. . .⊗Fn. Consi<strong>de</strong>remos las medidas <strong>de</strong> probabilidad µ (n) y ν (n) <strong>de</strong>finidas<br />

en (E (n) , F (n) ) como el producto <strong>de</strong> medidas µ (n) = µ1 ⊗ . . . ⊗ µn don<strong>de</strong> cada µi esta<br />

<strong>de</strong>finida en (Ei, Fi). La siguiente proposición nos permite relacionar las distancias<br />

entre cada par <strong>de</strong> medidas µi y νi con la distancia entre las medidas producto µ (n) y<br />

ν (n) .<br />

Proposición 2.3.1.<br />

1. Variación total:<br />

1 − exp<br />

2. Hellinger:<br />

<br />

1 − exp<br />

3. Chi-cuadrado:<br />

− 1<br />

2<br />

<br />

−<br />

n<br />

i=1<br />

d 2 T V (µi, νi)<br />

<br />

d 2 H(µ (n) , ν (n) ) = 1 −<br />

n<br />

d 2 <br />

H(µi, νi)<br />

i=1<br />

d 2<br />

χ 2(µ(n) , ν (n) ) =<br />

≤ dT V (µ (n) , ν (n) ) ≤<br />

n<br />

i=1<br />

n<br />

dT V (µi, νi) . (2.2)<br />

i=1<br />

<br />

1 − d 2 <br />

H(µi, νi) .<br />

≤ d 2 H(µ (n) , ν (n) ) ≤<br />

n<br />

i=1<br />

n<br />

d 2 H(µi, νi) . (2.3)<br />

i=1<br />

<br />

1 + d 2<br />

χ2(µi, <br />

νi) − 1 .<br />

10

n<br />

d 2<br />

χ2(µi, νi) ≤ d 2<br />

χ2(µ(n) , ν (n) <br />

n<br />

) ≤ exp d 2<br />

χ2(µi, <br />

νi)<br />

i=1<br />

4. Kullback:<br />

d 2 K(µ (n) , ν (n) ) =<br />

i=1<br />

− 1 . (2.4)<br />

n<br />

d 2 K(µi, νi) . (2.5)<br />

i=1<br />

Esta proposición muestra que todas las distancias, salvo la distancia<br />

en variación total, se comportan como ( d(µi, νi) 2 ) 1/2 cuando la distancia en ca-<br />

da coor<strong>de</strong>nada d(µi, νi) es pequeña. Basta recordar que si x1, . . . , xn se comportan<br />

aproximadamente como Ki n con Ki constante, entonces se pue<strong>de</strong> hacer la siguiente<br />

aproximación:<br />

n<br />

(1 + xi) ∼ 1 +<br />

i=1<br />

Las relaciones expuestas en la Proposición 2.3.1 <strong>para</strong> la cota superior <strong>de</strong> VT y las<br />

expresiones <strong>para</strong> la distancias <strong>de</strong> H, χ 2 y K son conocidas y se pue<strong>de</strong>n encontrar en<br />

el Lema 3.3.10 p. 100 en [51]. La <strong>de</strong>mostración <strong>de</strong> la cota inferior <strong>de</strong> la distancia en<br />

n<br />

i=1<br />

xi .<br />

VT es una simple combinación <strong>de</strong> las Proposiciones 2.3.1 y 2.2.2.<br />

Demostración:<br />

dV T (µ (n) , ν (n) ) ≥ d 2 H(µ (n) , ν (n) )<br />

= 1 −<br />

n 2<br />

1 − dH(µi, νi) <br />

i=1<br />

≥ 1 − exp<br />

≥ 1 − exp<br />

<br />

<br />

−<br />

− 1<br />

2<br />

n<br />

d 2 <br />

H(µi, νi)<br />

i=1<br />

n<br />

i=1<br />

d 2 V T (µi, νi)<br />

<br />

.<br />

<br />

11

2.4. Ejemplos<br />

El objetivo <strong>de</strong> esta sección es dar algunos ejemplos <strong>de</strong> estimaciones pre-<br />

cisas <strong>de</strong> la distancia entre medidas producto. En general si consi<strong>de</strong>ramos dos medidas<br />

<strong>de</strong> la misma familia <strong>para</strong>métrica es razonable pensar que la distancia entre ellas será<br />

una función suave <strong>de</strong> la diferencia entre parámetros. En este caso consi<strong>de</strong>raremos<br />

las distribuciones <strong>de</strong> Bernoulli, Poisson y Normal. En estos resultados, ε y δ <strong>de</strong>ben<br />

ser interpretados como funciones <strong>de</strong> n. Observemos que en las Proposiciones 2.4.1 y<br />

2.4.3 tanto las cotas en el caso <strong>de</strong> VT como las expresiones <strong>para</strong> las otras distancias<br />

convergen a constantes positivas <strong>para</strong> ε = n −1/2 . De manera similar en la Proposi-<br />

ción 2.4.6, <strong>para</strong> máx{ε, δ} = n −1/2 . Los cálculos <strong>para</strong> las distancias <strong>de</strong> H, χ 2 y K<br />

son simples y la mayor dificultad que presentan es realizar algunos <strong>de</strong>sarrollos <strong>de</strong><br />

or<strong>de</strong>n. En el caso <strong>de</strong> la distancia en VT <strong>para</strong> las distribuciones <strong>de</strong> Poisson y Normal<br />

los cálculos son más complejos y <strong>para</strong> <strong>de</strong>mostrarlas utilizamos el mismo argumento<br />

que da Pollard en [48] (pág. 63) <strong>para</strong> la distancia entre dos Gaussianas <strong>de</strong> misma<br />

varianza.<br />

2.4.1. Bernoulli<br />

En esta subsección µ y ν son dos distribuciones <strong>de</strong> Bernoulli.<br />

Proposición 2.4.1. [6] Sea p y ε dos reales entre 0 y 1. Sea µ (respectivamente<br />

ν) una distribución <strong>de</strong> Bernoulli <strong>de</strong> parámetro p(1 − ε) (respectivamente p). Sea µ n<br />

12

(y respectivamente ν n ) el producto tensorial <strong>de</strong> n copias <strong>de</strong> µ (respectivamente ν).<br />

Luego,<br />

1. Variación total<br />

<br />

1−exp − n<br />

2 p2ε 2<br />

<br />

≤ dV T (µ n , ν n <br />

) ≤ 1 − exp −n<br />

2. Hellinger<br />

3. Chi-cuadrado<br />

4. Kullback<br />

dH(µ n , ν n ) =<br />

<br />

1 − exp −n<br />

d χ 2(µ n , ν n ) =<br />

dK(µ n , ν n ) = √ <br />

n<br />

p<br />

8(1 − p) ε2 + o(ε 2 )<br />

<br />

1 + p<br />

1 − p ε2<br />

n 1/2 − 1<br />

p<br />

2(1 − p) ε2 + o(ε 2 )<br />

p<br />

4(1 − p) ε2 + o(ε 2 )<br />

1/2<br />

1/2<br />

Demostración: Para la distancia <strong>de</strong> Hellinger <strong>de</strong> su <strong>de</strong>finición tenemos<br />

dH(µ, ν) 2 = 1 −<br />

<br />

p √ <br />

1 − ε + (1 − p) 1 + p<br />

1 − p ε<br />

<br />

.<br />

.<br />

.<br />

.<br />

1/2<br />

.<br />

13

Utilizando una aproximación <strong>de</strong> la función √ 1 + x encontramos que<br />

dH(µ, ν) 2 <br />

= 1 − p 1 − ε<br />

=<br />

−(1 − p)<br />

2<br />

ε2<br />

−<br />

8 + o(ε2 <br />

)<br />

<br />

1 +<br />

p<br />

8(1 − p) ε2 + o(ε 2 ) .<br />

p<br />

ε −<br />

2(1 − p)<br />

p2 8(1 − p) 2 ε2 + o(ε 2 <br />

)<br />

Luego la distancia <strong>de</strong> H entre las dos distribuciones <strong>de</strong> Bernoulli vale<br />

dH(µ, ν) = 1<br />

<br />

p<br />

|ε| + o(ε) .<br />

2 2(1 − p)<br />

Utilizando la proposición 2.2.2 po<strong>de</strong>mos calcular el producto.<br />

dH(µ n , ν n ) =<br />

=<br />

<br />

1 − 1 −<br />

<br />

1 − exp −n<br />

p<br />

8(1 − p) ε2 + o(ε 2 )<br />

Realizamos el mismo calculo <strong>para</strong> la distancia <strong>de</strong> χ 2 :<br />

d χ 2(µ, ν) =<br />

=<br />

=<br />

<br />

n 1/2<br />

p<br />

8(1 − p) ε2 + o(ε 2 1/2 )<br />

<br />

(1 − ε) 2 p + (1 − p) + 2εp + p2 ε 2<br />

<br />

ε 2 p + p2ε2 1/2 1 − p<br />

<br />

p<br />

|ε| .<br />

1 − p<br />

1 − p<br />

1/2 − 1<br />

Utilizando la proposición 2.3.1 po<strong>de</strong>mos calcular la distancia entre las medidas pro-<br />

14<br />

.

ducto µ n y ν n<br />

d χ 2(µ n , ν n ) =<br />

=<br />

Para la distancia <strong>de</strong> K tenemos<br />

<br />

1 + p<br />

<br />

exp<br />

<br />

n<br />

1 − p ε2<br />

n<br />

1/2 − 1<br />

p<br />

1 − p ε2 + o(ε 2 )<br />

<br />

1/2 − 1<br />

dK(µ, ν) 2 <br />

= (1 − ε)p log (1 − ε) + (1 − p + εp) log 1 + p<br />

1 − p ε<br />

<br />

.<br />

Para obtener una expresión similar a la obtenida <strong>para</strong> las otras distancias utilizamos<br />

la aproximación <strong>de</strong> Taylor <strong>de</strong> log(1 + x) en torno a 0,<br />

dK(µ, ν) 2 <br />

= (1 − ε)p −ε − ε2<br />

=<br />

+(1 − p + εp)<br />

2 + o(ε2 <br />

)<br />

<br />

p<br />

2(1 − p) ε2 + o(ε 2 ) .<br />

p 1<br />

ε −<br />

1 − p 2<br />

2 p<br />

ε<br />

1 − p<br />

2 + o(ε 2 <br />

)<br />

Entonces la distancia <strong>de</strong> K entre las dos leyes <strong>de</strong> Bernoulli esta dada por:<br />

dK(µ, ν) =<br />

<br />

p<br />

|ε| + o(ε) .<br />

2(1 − p)<br />

Utilizando la proposición 2.3.1 obtenemos que <strong>para</strong> el producto <strong>de</strong> n copias <strong>de</strong> Ber-<br />

noulli la distancia <strong>de</strong> K es:<br />

dK(µ, ν) = √ <br />

p<br />

n<br />

|ε| + o(ε)<br />

2(1 − p)<br />

.<br />

.<br />

15

Un sencillo cálculo nos permite obtener la distancia en VT:<br />

dV T (µ, ν) = 1<br />

2 |p − p′ + (1 − p ′ ) − (1 − p)|<br />

= p|ε| .<br />

Utilizando la proposición 2.3.1 po<strong>de</strong>mos acotar inferiormente la distancia en VT<br />

entre µ n y ν n y como cota superior utilizaremos la relación entre VT y H <strong>de</strong> la<br />

Proposición 2.2.2.<br />

<br />

1 − exp − n<br />

2 p2ε 2<br />

<br />

≤ dV T (µ n , ν n <br />

) ≤ 1 − exp −n<br />

p<br />

4(1 − p) ε2 + o(ε 2 )<br />

1/2<br />

Observación 2.4.2. Es importante notar que <strong>para</strong> los cuatro casos la distancia entre<br />

µ y ν se comporta <strong>de</strong> manera lineal con respecto a ε cuando este valor es pequeño:<br />

2.4.2. Poisson<br />

dV T (µ, ν) = p|ε| ,<br />

dH(µ, ν) = 1<br />

<br />

p<br />

|ε| + o(ε) ,<br />

2 2(1 − p)<br />

<br />

p<br />

dχ2(µ, ν) = |ε| ,<br />

1 − p<br />

<br />

p<br />

dK(µ, ν) =<br />

|ε| + o(ε) .<br />

2(1 − p)<br />

En esta subsección µ y ν son dos distribuciones <strong>de</strong> Poisson.<br />

Proposición 2.4.3. [6] Sea α un real positivo y ε un real en el intervalo (−∞, 1).<br />

16<br />

.

Sea µ (respectivamente ν) una distribución <strong>de</strong> Poisson <strong>de</strong> parámetro α(1 − ε) (res-<br />

pectivamente α). Sea µ n (y respectivamente ν n ) el producto tensorial <strong>de</strong> n copias <strong>de</strong><br />

µ (respectivamente ν). Luego,<br />

1. Variación total<br />

y<br />

con Rα = α⌊α⌋+1e−α . ⌊α⌋!<br />

2. Hellinger<br />

3. Chi-cuadrado<br />

4. Kullback<br />

<br />

1 − exp − n 2<br />

R<br />

2<br />

αε 2 + o(ε 2 ) <br />

≤ dT V (µ n , ν n ) ,<br />

dT V (µ n , ν n ) ≤<br />

dH(µ n , ν n ) =<br />

<br />

α<br />

1 − exp −n<br />

4 ε2 + o(ε 2 1/2 )<br />

<br />

1 − exp −nα 1 − ε<br />

2 − √ 1/2 1 − ε<br />

d χ 2(µ n , ν n ) = exp nαε 2 − 1 1/2 .<br />

dK(µ n , ν n ) = √ n [α(1 − ε) log(1 − ε) + αε] 1/2 .<br />

Demostración: Los cálculos realizados <strong>para</strong> las distancias <strong>de</strong> H, χ 2 y K son similares<br />

,<br />

.<br />

17

a los <strong>de</strong>sarrollados en el caso <strong>de</strong> Bernoulli. Sea β = α(1 − ε), <strong>para</strong> la distancia <strong>de</strong> H:<br />

dH(µ, ν) 2 = 1 −<br />

∞<br />

i=0<br />

= 1 − exp<br />

α i/2 exp (− α<br />

<br />

−<br />

(i!) 1/2<br />

α + β<br />

2<br />

Reemplazando β obtenemos la siguiente expresión:<br />

dH(µ, ν) =<br />

2 )<br />

β i/2 exp (− β<br />

2 )<br />

(i!) 1/2<br />

<br />

exp αβ .<br />

<br />

1 − exp −α + α<br />

2 ε + α√ 1/2 1 − ε<br />

Para simplificar esta expresión utilizamos la aproximación <strong>de</strong> Taylor <strong>de</strong> √ 1 + x y<br />

encontramos:<br />

dH(µ, ν) =<br />

=<br />

<br />

1 − exp<br />

−α + α<br />

ε + α<br />

2<br />

<br />

1 − exp − α<br />

8 ε2 + o(ε 2 )<br />

<br />

1 − ε<br />

1/2<br />

Por último aproximamos exp(x) con lo que obtenemos:<br />

dH(µ, ν) =<br />

.<br />

2<br />

√<br />

α<br />

2 √ |ε| + o(ε) .<br />

2<br />

ε2<br />

−<br />

8 + o(ε2 1/2 )<br />

La Proposición 2.3.1 nos permite obtener directamente la distancia entre µ n y ν n<br />

dH(µ n , ν n ) =<br />

<br />

1 − exp n − α<br />

8 ε2 + o(ε 2 1/2 )<br />

Realizamos el mismo cálculo <strong>para</strong> la distancia <strong>de</strong> χ 2 , nuevamente sea β = (1 − ε)α.<br />

.<br />

.<br />

18

Luego:<br />

Reemplazando β<br />

d χ 2(µ, ν) =<br />

=<br />

la distancia entre µ n y ν n será<br />

<br />

∞<br />

β<br />

i=0<br />

2i exp (−2β)<br />

(i!) 2<br />

i!<br />

αi − 1<br />

exp (−α)<br />

2 1/2<br />

(α − β)<br />

exp<br />

− 1 .<br />

α<br />

d χ 2(µ, ν) = exp(αε 2 ) − 1 1/2 ,<br />

d χ 2(µ n , ν n ) = exp(nαε 2 ) − 1 1/2 .<br />

Por último <strong>para</strong> la distancia <strong>de</strong> K <strong>para</strong> β = (1 − ε)α un cálculo análogo produce:<br />

dK(µ, ν) =<br />

=<br />

1/2<br />

<br />

∞<br />

β<br />

i=0<br />

i i exp (−β) β exp (−β)<br />

log<br />

i! αi <br />

exp (−α)<br />

1/2 1/2 β<br />

β log + α − β .<br />

α<br />

Reemplazando β y aproximando en torno a 0 la función log(1+x) y √ 1 + x tenemos<br />

dK(µ, ν) = ((1 − ε)α log(1 − ε) + αε) 1/2<br />

<br />

= (1 − ε)α(−ε − ε2<br />

2 + o(ε2 )) + αε<br />

<br />

= − α<br />

2 ε2 + αε 2 + o(ε 2 1/2 )<br />

<br />

α<br />

= |ε| + o(ε) .<br />

2<br />

1/2<br />

19

Obtenemos la distancia entre µ n y ν n :<br />

dK(µ n , ν n ) = (n [(1 − ε)α log(1 − ε) + αε]) 1/2<br />

= √ n<br />

<br />

α<br />

|ε| + o(ε)<br />

2<br />

Usando la segunda caracterización <strong>de</strong> la distancia en VT <strong>de</strong> la Proposición 2.1.1<br />

tenemos<br />

dV T (µ, ν) = 1<br />

2<br />

∞<br />

i=0<br />

αi exp (−α)<br />

|(1 − ε)<br />

i!<br />

i exp (αε) − 1|<br />

= 1<br />

2 IEν (| exp (αε + X log(1 − ε)) − 1|) .<br />

Sea f(ε, x) = exp (αε + x log(1 − ε)), luego dV T (µ, ν) = IEν(|f(ε, X) − 1|). Para<br />

estimar esta cantidad realizaremos un <strong>de</strong>sarrollo <strong>de</strong> Taylor <strong>de</strong> f(ε, x) como función<br />

<strong>de</strong> ε.<br />

∂f<br />

∂ε<br />

<br />

(ε, x) = f(ε, x)<br />

∂2f (ε, x) = f(ε, x)<br />

∂ε2 α − x<br />

<br />

,<br />

1 − ε<br />

α − x<br />

1 − ε<br />

luego obtenemos la siguiente aproximación <strong>de</strong> Taylor <strong>para</strong> f:<br />

f(ε, x) = 1 + (α − x)ε +<br />

1<br />

0<br />

2<br />

+<br />

.<br />

x<br />

(1 − ε) 2<br />

<br />

<br />

αθε+x log(1−θε)<br />

e (α − x<br />

1 − θε )2 x<br />

+<br />

(1 − θε) 2<br />

2 ε<br />

(1 − θ)dθ .<br />

2<br />

Llamemos ɛ(x, ε) al termino integral. Po<strong>de</strong>mos acotar la dV T (µ, ν) por<br />

IEν |α − X| |ε| − IEν |ɛ(X, ε)| ≤ 2dV T (µ, ν) ≤ IEν |α − X| |ε| + IEν |ɛ(X, ε)| .<br />

.<br />

20

Vamos a probar que la esperanza IEν |ɛ(X, ε)| se comporta como o(ε) y que por lo<br />

tanto dV T (µ, ν) ∼ 1<br />

2 IEν (|α − X|) |ε|. El teorema <strong>de</strong> Fubini nos permite intercambiar<br />

la esperanza con respecto X y la integral con respecto a θ.<br />

IEν |ɛ(X, ε)| = IEν<br />

=<br />

1<br />

0<br />

1<br />

<br />

αθε+X log(1−θε)<br />

e (α −<br />

0<br />

X<br />

1 − θε )2 X<br />

+<br />

(1 − θε) 2<br />

<br />

2 ε<br />

(1 − θ)dθ<br />

2<br />

e αθε <br />

X log(1−θε)<br />

IEν e (α − X<br />

1 − θε )2 X<br />

+<br />

(1 − θε) 2<br />

2 ε<br />

(1 − θ)dθ .<br />

2<br />

El siguiente lema nos permitirá calcular la esperanza al interior <strong>de</strong> la integral<br />

Lema 2.4.4. Sea K un real, α y m dos reales positivos. Sea Y una variable <strong>de</strong><br />

Poisson <strong>de</strong> parámetro α. Entonces<br />

IE(e Y K Y m ) = IE( ˜ Y m ) exp −α 1 − e K ,<br />

don<strong>de</strong> Y es una variable <strong>de</strong> Poisson <strong>de</strong> parámetro αe K .<br />

IEν<br />

<br />

Este lema nos permite obtener:<br />

X log(1−θε)<br />

e<br />

α − X<br />

2 +<br />

1 − θε<br />

X<br />

(1 − θε) 2<br />

<br />

= 2 α<br />

1 − θε e−αθε .<br />

Reemplazando este valor en la expresión integral <strong>de</strong> IEν(ɛ(ε, X)) obtenemos<br />

1 <br />

α<br />

IEν |ɛ(X, ε)| =<br />

ε<br />

0 1 − θε<br />

2 (1 − θ)dθ<br />

<br />

− log(1 − ε)ε − ε − log(1 − ε)<br />

= α<br />

ε2 <br />

ε 2<br />

= 3<br />

2 αε2 + o(ε 2 ) .<br />

Deducimos entonces que dV T (µ, ν) se comporta como 1<br />

2 IE |α − X|| ε| <strong>para</strong> ε pequeño.<br />

21

Aún <strong>de</strong>bemos calcular IEν|X − α|. Como IEν(X) = α, tendremos que IEν|X − α| =<br />

2IEν|X − α|+ luego<br />

IEν|X − α| =<br />

⌊α⌋ <br />

2 (α − i)<br />

i=0<br />

αi<br />

i! e−α<br />

⎛<br />

=<br />

⌊α⌋ <br />

2 ⎝α<br />

i=0<br />

αi i! e−α ⌊α⌋ <br />

− α<br />

i=1<br />

= 2αPν(X = ⌊α⌋) .<br />

αi−1 (i − 1)! e−α<br />

⎞<br />

⎠<br />

Con esto concluimos que la distancia en variación total entre µ y ν vale<br />

dV T (µ, ν) = α1+⌊α⌋<br />

⌊α⌋! e−α |ε| + o(ε) .<br />

Utilizando las cotas <strong>de</strong> la Proposición 2.3.1 po<strong>de</strong>mos acotar dV T (µ n , ν n ) por<br />

<br />

1 − exp − n 2<br />

R<br />

2<br />

αε 2 + o(ε 2 ) <br />

≤ dV T (µ n , ν n <br />

α<br />

) ≤ 1 − exp −n<br />

4 ε2 + o(ε 2 1/2 )<br />

con Rα = α⌊α⌋+1 e −α<br />

⌊α⌋! . <br />

Observación 2.4.5. Al igual que en la subsección anterior <strong>para</strong> los cuatro casos la<br />

distancia entre µ y ν se comporta <strong>de</strong> manera lineal con respecto a ε cuando este valor<br />

es pequeño:<br />

dV T (µ, ν) = α1+⌊α⌋<br />

dH(µ, ν) =<br />

⌊α⌋! e−α |ε| + o(ε) ,<br />

√<br />

α<br />

2 √ |ε| + o(ε) ,<br />

2<br />

dχ2(µ, ν) = √ α ε + o(ε) ,<br />

<br />

α<br />

dK(µ, ν) = |ε| + o(ε) .<br />

2<br />

,<br />

22

2.4.3. Normal<br />

En esta subsección µ y ν son dos distribuciones Normales.<br />

Proposición 2.4.6. [6] Sea m, ε dos reales, v un real positivo y δ un real mayor que<br />

−1. Sea µ (respectivamente ν) una distribución Normal <strong>de</strong> esperanza m+vε (respec-<br />

tivamente m) y varianza v 2 (1 + δ) (respectivamente v 2 ). Sea µ n (y respectivamente<br />

ν n ) el producto tensorial <strong>de</strong> n copias <strong>de</strong> µ (respectivamente ν). Luego,<br />

1. Variación total:<br />

<br />

1 − exp − n<br />

16π (C1(z)|δ| + C2(z)|ε| + o(||ε, δ||)) 2<br />

≤ dT V (µ n , ν n ) ,<br />

dT V (µ n , ν n ) ≤<br />

<br />

1 −<br />

√ n <br />

1 + δ<br />

exp −<br />

1 + δ/2<br />

nε2<br />

<br />

2(2 + δ)<br />

1/2 Don<strong>de</strong> z = |ε|/|δ|, y C1, C2 son tales que C1(∞) = 1, C2(∞) = 2, C1(0) =<br />

2e −1/2 , y C2(0) = e −1/2 ; más precisamente, C1(z) y C2(z) toman valores en los<br />

intervalos [e −1/2 , 1 + e −1/2 ] y [e −1/2 , 2] respectivamente.<br />

2. Hellinger:<br />

3. Chi-cuadrado:<br />

dH(µ n , ν n ) =<br />

<br />

d χ 2(µ n , ν n ) =<br />

1 −<br />

√ n/2 <br />

1 + δ<br />

exp −<br />

1 + δ/2<br />

nε2<br />

<br />

4(2 + δ)<br />

1/2 <br />

1 2<br />

− δ 2<br />

1/2<br />

−n/2 nε<br />

exp − 1<br />

1 − δ<br />

.<br />

.<br />

.<br />

23

4. Kullback:<br />

dK(µ n , ν n ) = √ <br />

2 1/2<br />

ε − 1<br />

n log(1 + δ) +<br />

2(1 + δ)<br />

Demostración: En primer lugar calcularemos la distancia entre dos distribuciones<br />

Normales <strong>para</strong> el caso particular <strong>de</strong> µ0 ∼ N(m0, v 2 0) y ν0 ∼ N(0, 1) y luego genera-<br />

lizaremos el resultado. Repetiremos el mismo argumento <strong>para</strong> cada distancia. En el<br />

caso <strong>de</strong> la distancia <strong>de</strong> H <strong>de</strong> su <strong>de</strong>finición tenemos<br />

<br />

dH(µ, ν) = 1 −<br />

Utilizando la siguiente igualdad<br />

1<br />

4<br />

x − m0<br />

v0<br />

po<strong>de</strong>mos concluir que<br />

dH(µ, ν) =<br />

2<br />

<br />

<br />

1<br />

√ √ exp −<br />

2π v0<br />

1<br />

4<br />

+ x 2<br />

<br />

1 − √ 2<br />

x − m0<br />

v0<br />

2<br />

= 1<br />

<br />

x −<br />

2<br />

m<br />

v2 2 2 1 + v0 1<br />

+<br />

0 + 1 2v2 4<br />

<br />

v0<br />

v2 1/2 <br />

exp −<br />

0 + 1<br />

1<br />

4<br />

− 1<br />

4 x2<br />

1/2 dx<br />

m2 0<br />

v2 0 + 1<br />

.<br />

m2 0<br />

v2 0 + 1 ,<br />

1/2<br />

Ahora consi<strong>de</strong>remos dos variables normales cualesquiera µ ∼ N(m1, v 2 1) y ν ∼<br />

N(m2, v 2 2). Sean m0 = m1−m2<br />

v2<br />

y v0 = v1 , tendremos que la distancia <strong>de</strong> H entre<br />

v2<br />

dos normales se pue<strong>de</strong> obtener como dH(µ, ν) = dH(N(m0, v 2 0), N(0, 1)). En nuestro<br />

caso m1 = m + vε, v1 = v √ 1 + δ m2 = m y v2 = v luego m0 = ε y v0 = δ, por lo<br />

tanto<br />

√ 1/2 <br />

1 + δ<br />

dH(µ, ν) = 1 −<br />

exp −<br />

1 + δ/2<br />

1 ε<br />

4<br />

2 <br />

(2 + δ)<br />

1/2 .<br />

.<br />

.<br />

24

Reemplazando esta expresión en la Propiedad 2.3.1 obtenemos<br />

dH(µ n , ν n ) =<br />

√ n/2 <br />

1 + δ<br />

1 −<br />

exp −<br />

1 + δ/2<br />

n ε<br />

4<br />

2 <br />

(2 + δ)<br />

1/2 .<br />

Utilizando las aproximaciones <strong>de</strong> Taylor <strong>de</strong> (1 + x) 1/k <strong>para</strong> simplificar la expresión<br />

<strong>de</strong> dH(µ, ν) obtenemos el siguiente <strong>de</strong>sarrollo <strong>de</strong> or<strong>de</strong>n<br />

√ 1/2<br />

1 + δ<br />

1 + δ/2<br />

=<br />

<br />

1 + δ 3<br />

−<br />

4 32 δ2 + o(δ 2 <br />

) 1 − δ 3<br />

+<br />

4 32 δ2 + o(δ 2 <br />

)<br />

= 1 − 1<br />

16 δ2 + o(δ 2 ) .<br />

Aproximando la segunda expresión<br />

1 ε<br />

4<br />

2<br />

(2 + δ)<br />

<br />

exp − 1 ε<br />

4<br />

2 <br />

2 + δ<br />

= ε2<br />

8 + o(||(ε, δ)||2 )<br />

= 1 − ε2<br />

8 + o(||(ε, δ)||2 ) .<br />

Reemplazando ambas aproximaciones en la última expresión <strong>de</strong> la distancia <strong>de</strong> H<br />

obtenemos,<br />

dH(µ, ν) = 1<br />

2 √ 2 δ<br />

2 2 + ε2 + o(||(ε, δ)|| 2 1/2 )<br />

Para el caso <strong>de</strong> la distancia <strong>de</strong> χ 2 , al igual que antes, primero consi<strong>de</strong>remos la dis-<br />

tancia entre µ0 ∼ N(m0, v 2 0) y ν0 ∼ N(0, 1)<br />

d χ 2(µ0, ν0) =<br />

=<br />

<br />

<br />

1<br />

2πv 2 0<br />

<br />

exp −<br />

1<br />

√ exp<br />

2 2πv0 (x − m0) 2<br />

v 2<br />

<br />

√2π 1<br />

exp<br />

<br />

2 (x − m0)<br />

−<br />

v2 +<br />

0<br />

x2<br />

2<br />

.<br />

2 x2<br />

<br />

dx − 1<br />

<br />

dx − 1<br />

1/2<br />

1/2<br />

25

consi<strong>de</strong>rando la siguiente igualdad,<br />

la expresión se reduce a<br />

2 (x − m0)<br />

2<br />

v2 0<br />

− x 2 <br />

= x −<br />

d χ 2(µ0, ν0) =<br />

<br />

v0<br />

1<br />

<br />

2 2 − v0 m0<br />

2 − v 2 0<br />

2<br />

2 − v2 0<br />

v2 − 2m20 2 − v2 ,<br />

0<br />

2 m0 exp<br />

2 − v2 1/2 − 1<br />

0<br />

Sean µ ∼ N(m1, v 2 1) y ν ∼ N(m2, v 2 2) con m2 = m, v2 = v, m1 = m + vε, v1 =<br />

v √ 1 + δ. Al igual que <strong>para</strong> H po<strong>de</strong>mos escribir la distancia <strong>de</strong> χ 2 entre µ y ν como<br />

d χ 2(µ, ν) = d χ 2(N(m, v 2 ), N(0, 1)). Luego tendremos<br />

d χ 2(µ, ν) =<br />

<br />

1<br />

√<br />

1 − δ2 exp<br />

2 ε<br />

1 − δ<br />

Pasando al producto con la Proposición 2.2.2<br />

d χ 2(µ n , ν n ) =<br />

1/2 − 1<br />

1<br />

1 − δ2 n/2 <br />

exp n ε2<br />

1/2 − 1<br />

1 − δ<br />

Utilizando una aproximación (1 + x) −1 y <strong>de</strong> exp(x)<br />

2 δ<br />

dχ2(µ, ν) =<br />

2 + ε2 + o(||(ε, δ)|| 2 1/2 )<br />

Finalmente consi<strong>de</strong>remos una vez más µ0 una distribución Normal N(m0, v 2 0) y ν0<br />

.<br />

.<br />

.<br />

.<br />

26

una N(0, 1). De la <strong>de</strong>finición <strong>de</strong> la distancia <strong>de</strong> K obtenemos:<br />

dK(µ0, ν0) =<br />

=<br />

⎡<br />

<br />

⎣<br />

⎛<br />

log ⎝ v exp − 1<br />

2x2 ⎞<br />

<br />

2<br />

exp<br />

− 1<br />

2<br />

x−m<br />

v<br />

<br />

log(v) − 1 1 + m2<br />

+<br />

2 2v2 ⎠ 1 1<br />

− √ e 2<br />

2π x2<br />

⎤<br />

dx⎦<br />

Nuevamente consi<strong>de</strong>ramos m1 = m + vε, v1 = v √ 1 + δ, m2 = m y v2 = v. Al<br />

igual que <strong>para</strong> la distancia <strong>de</strong> H po<strong>de</strong>mos escribir la distancia entre µ y ν como<br />

dK(µ, ν) = dK(N(m, v 2 ), N(0, 1)). Luego,<br />

dK(µ, ν) =<br />

<br />

1<br />

log(1 + δ) +<br />

2<br />

1/2<br />

.<br />

ε 2<br />

2(1 + δ) −<br />

Combinando la aproximación <strong>de</strong> x(1 + x) −1 y log(1 + x):<br />

log(1 + δ) − δ<br />

1 + δ<br />

y por otro lado <strong>de</strong> la aproximación <strong>de</strong> (1 + x) −1 :<br />

= δ2<br />

2 + o(δ2 ) ,<br />

ε 2<br />

1 + δ = ε2 + o(||(ε, δ)|| 2 ) .<br />

De estos dos <strong>de</strong>sarrollos <strong>de</strong> or<strong>de</strong>n <strong>de</strong>ducimos:<br />

dK(µ, ν) =<br />

δ 2<br />

4<br />

1/2 δ<br />

2(1 + δ)<br />

ε2<br />

+<br />

2 + o(||(ε, δ)||2 1/2 )<br />

De la Proposición 2.3.1 se <strong>de</strong>spren<strong>de</strong> que la distancia <strong>de</strong> K entre dos µ n y ν n vale:<br />

dK(µ n , ν n ) =<br />

1/2 1<br />

1 + ε2 1<br />

n log(1 + δ) + −<br />

2 2(1 + δ) 2<br />

.<br />

.<br />

.<br />

1/2<br />

27

Utilizando la aproximación<br />

dK(µ n , ν n ) =<br />

2 δ ε2<br />

n +<br />

4 2 + o(||(ε, δ)||2 1/2 )<br />

Usando la segunda caracterización <strong>para</strong> la distancia en VT <strong>de</strong> la Proposición 2.1.1<br />

obtenemos la siguiente expresión:<br />

dV T (µ, ν) = 1<br />

2<br />

<br />

1<br />

(x − ε)2<br />

√ √ exp − −<br />

2π 1 + δ 2(1 + δ)<br />

1<br />

<br />

√ exp −<br />

2π x2<br />

<br />

<br />

dx<br />

2<br />

= 1<br />

2 IE<br />

<br />

1<br />

1<br />

√ exp −<br />

1 + δ 2(1 + δ) (X − ε)2 − X2<br />

<br />

<br />

− 1<br />

2 .<br />

Don<strong>de</strong> X esta distribuida como una N(0, 1). Definimos la función f como:<br />

f(ε, δ, x) =<br />

<br />

1<br />

√ exp −<br />

1 + δ 1<br />

<br />

1<br />

2 1 + δ (x − ε)2 − x 2<br />

<br />

Vamos a utilizar un <strong>de</strong>sarrollo <strong>de</strong> Taylor en ε y δ <strong>para</strong> obtener una cota. Para esto<br />

calculamos sus <strong>de</strong>rivadas <strong>de</strong> primer y segundo or<strong>de</strong>n:<br />

∂<br />

x − ε<br />

f(ε, δ, x) = f(ε, δ, x)<br />

∂ε 1 + δ ,<br />

x 2 ∂<br />

− ε<br />

f(ε, δ, x) = f(ε, δ, x)1<br />

−<br />

∂δ 2 1 + δ<br />

1<br />

<br />

,<br />

1 + δ<br />

∂2 x 2 − ε<br />

f(ε, δ, x) = f(ε, δ, x)<br />

−<br />

∂ε2 1 + δ<br />

1<br />

<br />

,<br />

1 + δ<br />

∂2 2<br />

2<br />

1 (x − ε) 1 (x − ε)2 1<br />

f(ε, δ, x) = f(ε, δ, x)<br />

− − +<br />

∂δ2 4 (1 + δ) 2 1 + δ (1 + δ) 3 2(1 + δ) 2<br />

<br />

,<br />

∂2 <br />

2 1 (x − ε) 1 x − ε x − ε<br />

f(ε, δ, x) = f(ε, δ, x)<br />

− −<br />

∂ε∂δ 2 (1 + δ) 2 1 + δ 1 + δ (1 + δ) 2<br />

<br />

.<br />

.<br />

.<br />

28

Luego obtenemos la siguiente aproximación <strong>de</strong> Taylor en torno a (0, 0):<br />

f(ε, δ, x) = 1 + xε + x2 δ<br />

2<br />

don<strong>de</strong> ɛ(ε, δ, x) es el error y se <strong>de</strong>fine como<br />

ɛ(ε, δ, x) =<br />

1<br />

0<br />

∂ 2<br />

Como dV T (µ, ν) = 1<br />

2<br />

δ<br />

− + ɛ(ε, δ, x) ,<br />

2<br />

∂ε2 f(θε, θδ)ε2 + ∂2<br />

∂δ2 f(θε, θδ)δ2 + 2 ∂2<br />

f(θε, θδ)εδ<br />

∂ε∂δ<br />

<br />

(1 − θ)dθ .<br />

IE|1 − f(ε, δ, X)| po<strong>de</strong>mos aproximar la distancia en VT entre<br />

µ y ν por 1<br />

2IE <br />

<br />

Xε + X2 <br />

δ δ <br />

− 2 2,<br />

el error que cometemos esta acotado por:<br />

<br />

<br />

<br />

1<br />

2<br />

IE<br />

<br />

<br />

<br />

Xε + X2 <br />

δ δ <br />

− <br />

2 2<br />

− dV T (µ, ν)<br />

<br />

<br />

<br />

<br />

1<br />

≤ IE |ɛ(ε, δ, X)| , (2.6)<br />

2<br />

don<strong>de</strong> X se distribuye como una normal N(0, 1). Al igual que en el caso <strong>de</strong> la<br />

distribución <strong>de</strong> Poisson, <strong>de</strong>mostraremos que IE |ɛ(ε, δ, X)| es <strong>de</strong>spreciable frente a<br />

1<br />

2IE <br />

<br />

Xε + X2 <br />

δ <br />

2 ; luego, la aproximación será valida. Demostraremos que IE |ɛ(ε, δ, X)|<br />

se comporta como o(||(ε, δ)||), la última expresión será una buena aproximación <strong>de</strong><br />

la distancia que estamos estimando. Sean<br />

<br />

η1(ε, δ) = IE | ∂2<br />

<br />

f(ε, δ, X)| ,<br />

∂ε2 <br />

η2(ε, δ) = IE | ∂2<br />

<br />

f(ε, δ, X)| ,<br />

∂δ2 <br />

η3(ε, δ) = IE | ∂2<br />

<br />

f(ε, δ, X)| .<br />

∂ε∂δ<br />

Luego <strong>de</strong> intercambiar la esperanza con respecto a X con la integral con respecto a<br />

29

θ tenemos<br />

IE [|ɛ(ε, δ, X)|] ≤<br />

1<br />

0<br />

η1(θε, θδ)ε 2 + +η2(θε, θδ)δ 2 + 2η3(θε, θδ)εδ (1 − θ)dθ .<br />

Un simple cambio <strong>de</strong> variables nos permite afirmar que <strong>para</strong> cualquier función g<br />

IEX<br />

<br />

X − ε<br />

f(ε, δ, X)g √ = IEY (g(T )) .<br />

1 + δ<br />

Con X e Y dos variables Normales N(0, 1). Utilizando esta propiedad y recordando<br />

que X se distribuye como una normal N(0, 1), calculamos η1, η2 y η3:<br />

η1(ε, δ) =<br />

<br />

<br />

X − ε<br />

IE f(ε, δ, X) <br />

1 + δ<br />

=<br />

1<br />

1 + δ IE =<br />

2<br />

X − 1 <br />

1 4<br />

√2π e<br />

1 + δ<br />

−1/2<br />

<br />

=<br />

1<br />

K1<br />

1 + δ .<br />

2<br />

− 1<br />

<br />

<br />

<br />

<br />

1 + δ <br />

Para η2 consi<strong>de</strong>remos x1 = 3 − √ 6 y x2 = 3 + √ 6 <strong>de</strong> modo que {−x2, −x1, x1, x2}<br />

30

son las raíces <strong>de</strong>l polinomio x 4 + 6x 2 + 3. Sea A = [−x2, −x1] [x1, x2] obtenemos<br />

η2(ε, δ) =<br />

<br />

2<br />

2<br />

1<br />

(x − ε) 1 (x − ε)2 1<br />

IE f(ε, δ) <br />

− − +<br />

4<br />

(1 + δ) 2 1 + δ (1 + δ) 3 2(1 + δ) 2<br />

<br />

<br />

<br />

<br />

<br />

=<br />

=<br />

1<br />

<br />

<br />

2 2 2 <br />

IE X − 1 − 4X + 2<br />

4(1 + δ) 2<br />

1<br />

2(1 + δ) 2<br />

<br />

(x<br />

A<br />

4 − 6x 2 + 3) 1<br />

√ e<br />

2π −x2 =<br />

<br />

/2<br />

dx<br />

1<br />

(1 + δ) 2<br />

<br />

3<br />

π e−3/2<br />

3 + √ √ <br />

6<br />

6 exp − 3 −<br />

2<br />

√ <br />

−<br />

6 exp<br />

√ <br />

6<br />

2<br />

= K2<br />

1 4<br />

><br />

(1 + δ) 2<br />

3 1 √ e<br />

4 π<br />

− 3<br />

2 .<br />

Finalmente acotamos el último término η3. Sea x0 = √ 3 luego {−x0, 0, x0} son las<br />

raíces <strong>de</strong>l polinomio x 3 + 3x. Definimos el conjunto B = [|∞, −x0] [0, x0]<br />

η3(ε, δ) =<br />

<br />

<br />

2<br />

IE f(ε, δ, X) <br />

1 (x − ε) 1 X − ε X − ε<br />

<br />

− −<br />

2 (1 + δ) 2 1 + δ 1 + δ (1 + δ) 2<br />

<br />

<br />

<br />

<br />

=<br />

1<br />

2(1 + δ) 3/2 IE X 3 − 3X <br />

=<br />

1<br />

(1 + δ) 3/2<br />

<br />

− (x<br />

B<br />

3 − 3x) 1<br />

√ e<br />

2π −x2 =<br />

<br />

/2<br />

dx<br />

1<br />

(1 + δ) 3/2<br />

1 −3/2 √ 1 + 4e<br />

2π<br />

<br />

=<br />

1<br />

K3 .<br />

(1 + δ) 3/2<br />

Entonces el error queda acotado por<br />

IE (|ɛ(ε, δ, X)|) ≤<br />

1<br />

0<br />

<br />

K1<br />

1<br />

1 + θδ ε2 + K2<br />

1<br />

(1 + θδ) 2 δ2 + K3<br />

<br />

1<br />

εδ (1 − θ)dθ<br />

(1 + θδ) 3/2<br />

31

Estimamos el comportamiento asintótico <strong>de</strong> cada uno <strong>de</strong> los tres términos<br />

K1ε 2<br />

1<br />

0<br />

2 δ log(1 + δ) + log(1 + δ) − δ<br />

η1(θε, θδ)(1 − θ)dθ = K1ε<br />

δ2 = K1ε 2 δ (δ + o(δ)) + δ − δ2 /2 + o(δ 2 ) − δ<br />

2 1<br />

= K1ε<br />

2 (1 + oδ(1)) .<br />

Un calculo similar <strong>para</strong> los otros dos términos nos da<br />

K2δ 2<br />

2K3εδ<br />

1<br />

0<br />

1<br />

0<br />

2 1<br />

η2(θε, θδ)(1 − θ)dθ = K2δ<br />

2 (1 + oδ(1)) ,<br />

η3(θε, θδ)(1 − θ)dθ = K3εδ(1 + oδ(1)) .<br />

La combinación <strong>de</strong> los tres últimos términos nos permite afirmar que IE |ɛ(ε, δ, X)|<br />

es o(||(ε, δ)|| 2 ):<br />

IE |ɛ(ε, δ, X)| ≤ K1ε 2 + K2δ 2 + 2K3εδ 1<br />

2 (1 + oδ(1)) = o(||(ε, δ)|| 2 ) .<br />

Luego, <strong>de</strong> la <strong>de</strong>sigualdad (2.6) po<strong>de</strong>mos concluir que dV T (µ, ν) se pue<strong>de</strong> aproximar<br />

<strong>para</strong> δ y ε pequeños por<br />

dV T (µ, ν) = 1<br />

δ 2<br />

2 IE<br />

<br />

<br />

<br />

Xε + X2 <br />

δ δ <br />

− <br />

2 2<br />

+ o(||(ε, δ)||)<br />

<br />

<br />

Para finalizar <strong>de</strong>bemos estimar IE Xε + X2 <br />

δ δ <br />

− . Recor<strong>de</strong>mos que X se distribuye<br />

2<br />

2<br />

32

como una N(0, 1). Sean x1 y x2 las raíces <strong>de</strong> x 2 + 2ε<br />

δ x − 1 con x1 < x2.<br />

<br />

<br />

IE Xε + X2δ 2<br />

<br />

δ <br />

− <br />

2<br />

= |δ| IE |X 2 + 2ε<br />

<br />

X − 1|−<br />

δ<br />

= |δ|<br />

<br />

√ (x2 +<br />

2π<br />

2ε<br />

δ )e−x2 2 /2 − (x1 + 2ε<br />

δ )e−x2 1 /2<br />

Sea ˜z = ε/δ entonces las raíces <strong>de</strong>l polinomio valen x1 = −˜z − √ ˜z 2 + 1 y x2 =<br />

−˜z + √ ˜z 2 + 1. Reemplazando en la expresión se tiene<br />

<br />

<br />

IE Xε + X2δ 2<br />

<br />

δ <br />

− <br />

2<br />

= |δ|<br />

<br />

√ ˜z +<br />

2π<br />

√ ˜z 2 <br />

+ 1 exp − 1<br />

2 (√˜z 2 + 1 − ˜z) 2<br />

<br />

√ <br />

+ ˜z 2 + 1 − ˜z exp − 1<br />

2 (√˜z 2 + 1 + ˜z) 2<br />

<br />

= |δ|<br />

<br />

<br />

1<br />

√ √ exp −<br />

2π ˜z 2 + 1 + |˜z| 1<br />

2 (√˜z 2 + 1 + |˜z|) 2<br />

<br />

√ <br />

+ ˜z 2 + 1 + |˜z| exp − 1<br />

<br />

1<br />

<br />

2<br />

<br />

( √ ˜z 2 + 1 + |˜z|) 2<br />

Sea z = |ε/δ| y y(z) = √ z 2 + 1 + z. Luego dV T (µ, ν) se pue<strong>de</strong> aproximar <strong>para</strong> δ y ε<br />

pequeños por<br />

dV T (µ, ν) = |δ|<br />

2 √ <br />

1<br />

2π y(z) exp<br />

<br />

− 1<br />

2 (y(z))2<br />

<br />

+ y(z) exp − 1<br />

2 (y(z))−2<br />

<br />

+o(||(ε, δ)||) ,<br />

Nos gustaría obtener una aproximación más sencilla <strong>para</strong> po<strong>de</strong>r obtener una cota in-<br />

ferior <strong>de</strong> dV T (µ n , ν n ) utilizaremos la <strong>de</strong>sigualdad <strong>de</strong> la Proposición 2.2.2 y la relación<br />

.<br />

.<br />

33

y(z) − 1 = z(y(−z −1 ) + 1):<br />

dV T (µ, ν) = |δ|<br />

<br />

1<br />

√<br />

8π y(z) exp<br />

<br />

− 1<br />

2 (y(z))2<br />

+ |ε|<br />

√ 8π (y(−z −1 ) + 1) exp<br />

<br />

<br />

+ exp − 1<br />

<br />

2 (y(z))−2<br />

<br />

− 1<br />

2 (y(z))−2<br />

<br />

+ o(||(ε, δ)||) .<br />