Capitolo 3 Riduzione dei dati osservativi

Capitolo 3 Riduzione dei dati osservativi

Capitolo 3 Riduzione dei dati osservativi

Create successful ePaper yourself

Turn your PDF publications into a flip-book with our unique Google optimized e-Paper software.

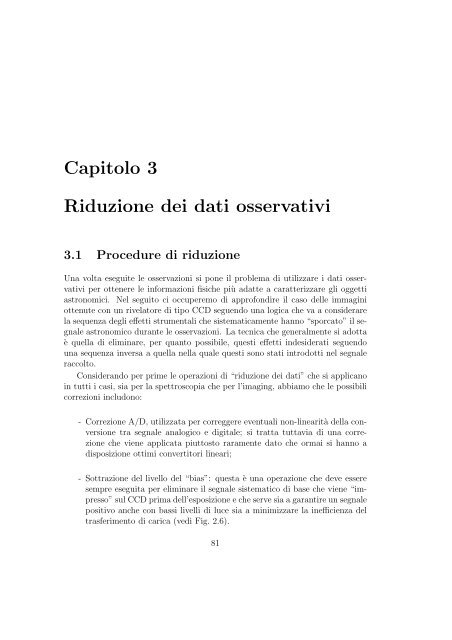

<strong>Capitolo</strong> 3<strong>Riduzione</strong> <strong>dei</strong> <strong>dati</strong> <strong>osservativi</strong>3.1 Procedure di riduzioneUna volta eseguite le osservazioni si pone il problema di utilizzare i <strong>dati</strong> <strong>osservativi</strong>per ottenere le informazioni fisiche più adatte a caratterizzare gli oggettiastronomici. Nel seguito ci occuperemo di approfondire il caso delle immaginiottenute con un rivelatore di tipo CCD seguendo una logica che va a considerarela sequenza degli effetti strumentali che sistematicamente hanno “sporcato” il segnaleastronomico durante le osservazioni. La tecnica che generalmente si adottaè quella di eliminare, per quanto possibile, questi effetti indesiderati seguendouna sequenza inversa a quella nella quale questi sono stati introdotti nel segnaleraccolto.Considerando per prime le operazioni di “riduzione <strong>dei</strong> <strong>dati</strong>” che si applicanoin tutti i casi, sia per la spettroscopia che per l’imaging, abbiamo che le possibilicorrezioni includono:- Correzione A/D, utilizzata per correggere eventuali non-linearità della conversionetra segnale analogico e digitale; si tratta tuttavia di una correzioneche viene applicata piuttosto raramente dato che ormai si hanno adisposizione ottimi convertitori lineari;- Sottrazione del livello del “bias”: questa è una operazione che deve esseresempre eseguita per eliminare il segnale sistematico di base che viene “impresso”sul CCD prima dell’esposizione e che serve sia a garantire un segnalepositivo anche con bassi livelli di luce sia a minimizzare la inefficienza deltrasferimento di carica (vedi Fig. 2.6).81

82 F.Strafella- Sottrazione delle strutture del bias (superbias), una operazione che spessoviene eseguita, ma la cui buona riuscita non sempre è garantita.- Correzioni della linearità: raramente applicata ai CCD, ma di solito usatacon osservazioni fatte con gli array IR.- Sottrazione della dark current (superdark): viene fatta occasionalmentedipendendo dal tipo di rivelatore (più o meno rumoroso) e dal tempo diintegrazione usato.- Sottrazione della carica differita (cosiddetto “preflash subtraction”): operazionerara con i moderni CCD.- Correzione per l’ombra prodotta dall’otturatore sull’array (shutter shading):da applicare quando l’effetto dell’otturatore è significativo (solo pertempi di esposizione brevissimi).- Correzione di “flat field” da applicarsi sempre.- Correzioni più complesse come quelle legate alla presenza di luce diffusa (cheproduce flat field con caratteristiche differenti da quelle vere), l’eliminazione<strong>dei</strong> pixel saturi (hot pixels), la sottrazione dell’eventuale immagine residua(detta anche ghost)....- Sottrazione del fringing e del fondo del cielo (sky subtraction): da applicarsioccasionalmente quando sono disponibili le misure accessorie che permettonodi valutare la brillanza del fondo del cielo e le frange di interferenzaprodotte da eventuali filtri usati per isolare le regioni spettrali di interessedurante le osservazioni. Queste frange sono prodotte da interferenza trariflessioni multiple all’interno <strong>dei</strong> filtri usati oppure anche all’interno deglistrati trasparenti di un CCD (specialmente se si usano CCD thinned).3.1.1 Sottrazione del biasSe durante l’acquisizione delle immagini viene anche acquisito il segnale da unaregione cosiddetta di overscan, allora questo segnale rappresenta il segnale di biasda sottrarre a tutta l’immagine. La regione di overscan, infatti, non è altro cheuna parte del rivelatore che viene accuratamente schermata dalla radiazione ed icui pixel vengono trattati nello stesso identico modo degli altri. La loro letturafornisce quindi il livello del segnale (detto anche pedestal o piedistallo) a partiredal quale l’immagine è stata poi costruita sui pixel esposti alla radiazione. La

Dip. di Fisica @ UNISALENTO 83Figura 3.1: Frange di interferenza che tipicamente appaiono nelle immagini ottenutein banda I con un CCD “thinned”. Sono prodotte dalla presenza, specie inbanda I, di righe spettrali emesse dai gas atmosferici (vedi Figura 1.4). Questaradiazione di fondo, soggetta alle riflessioni interne tra le superfici ottiche presentisullo stesso CCD, produce la figura di interferenza che è osservata come undisturbo sovrapposto al fondo del cielo. Si tratta di un disturbo di cui soffronoparrticolarmente i CCD thinned (vedi $ 2.2)successiva sottrazione di questo segnale quindi elimina il “piedistallo” su cui è statacostruita l’immagine restituendo quindi ai pixel il valore del segnale prodottodalla sola radiazione. Nel caso non vi sia l’overscan si usa acquisire le cosiddetteimmagini di bias oppure delle immagini ad otturatore chiuso (dette “darkframes”) con tempo di integrazione pari a quello delle immagini astronomiche.Notare che gli array IR dovrebbero già dare delle immagini “bias subtracted” seoperano con lettura a doppia correlazione (che corrisponde ad una lettura nondistruttiva, vedi paragrafo 2.3), tuttavia spesso rimane un bias residuo di minoreentità ma che va considerato perchè è spesso dipendente dall’esposizione. Inquesto caso è utile acquisire immagini dark con lo stesso tempo di integrazionedelle osservazioni, da sottrarre poi alle osservazioni stesse ottenendo così automaticamenteanche la sottrazione del segnale “dark”. Siccome il bias può subire

84 F.Strafelladelle fluttuazioni durante le osservazioni è buona norma acquisire molti framesper controllarne il livello; per questo è pratica comune acquisire molti frames dibias (anche alcune decine) prima e dopo le osservazioni.3.1.2 Sottrazione delle strutture del biasAbbiamo visto che l’elettronica di lettura introduce un rumore di lettura (dettoRON) che in alcuni casi può mostrare delle sistematicità (dette anche “pattern”)che possono essere poi evidenziate e sottratte dai nostri <strong>dati</strong>. Naturalmenteper sottrarre le sistematicità dobbiamo prima individuarle come tali e quindi ciaspettiamo che esse appaiano nelle immagini di bias sempre uguali come dovrebbeessere per i difetti ripetibili. Attenzione per esempio a verificare che il pattern noncambi con il puntamento del telescopio o col tempo, nel qual caso la correzionebasata su un pattern fisso peggiora il risultato finale se applicata ad immaginiottenute con tempi e puntamenti diversi.Attraverso l’istogramma <strong>dei</strong> bias ottenuti si può controllare se si ottiene unagaussiana con ampiezza data dal rumore di lettura. Questo istogramma del biasci permette di valutare il RON e se notiamo che questo è maggiore di quanto ciaspettiamo vale la pena di verificare se non vi siano <strong>dei</strong> pattern spaziali nel RONe se questi siano ripetibili. Se acquisiamo molti bias frames allora li possiamocombinare per ottenere un frame che viene detto di “superbias”. Costruendocosì più superbias si potrà poi verificare se i loro istogrammi sono effettivamenteripetibili.Il numero di bias richiesti dipende molto dalla qualità del singolo bias: sequesto è davvero peggiore di quanto prevedibile in base al RON del rivelatoreallora basterà mediare pochi bias per migliorare la situazione. Tuttavia la maggiorparte delle volte la struttura del bias è tanto modesta da essere di ampiezzaminore del RON stesso. In questi casi ricavare un superbias potrebbe addiritturapeggiorare la situazione rischiando di aggiungere rumore piuttosto che eliminarlo.In assenza di strutture nel bias possiamo calcolare il rumore nel superbias. Sequesto è ottenuto come media di N bias, il rumore è dato da RON/ √ N e quindil’immagine alla quale avremo sottratto il superbias avrà un rumore di letturaefficace pari a σ ≃ √ RON 2 (1 + 1/N), dove abbiamo considerato la composizionedi due incertezze indipendenti. Dalla relazione si vede che è sensato usare almenoN=10 frames di bias per ridurre il rumore di lettura dell’immagine bias subtractedal livello praticamente del RON.I <strong>dati</strong> IR non dovrebbero richiedere correzioni per la struttura del bias acausa della tecnica di lettura a doppia correlazione alla quale si è accennato nelparagrafo 2.3. Ricordiamo infine che è possibile accorpare insieme la sottrazione

Dip. di Fisica @ UNISALENTO 85del bias e del dark se si acquisiscono dark frames (che contengono già il segnaledi bias) di durata pari a quella delle osservazioni.3.1.3 Correzioni di linearitàPer alcuni rivelatori, specialmente quelli sensibili alla regione IR si deve tenereconto della non linearità. Per stimare la correzione si deve poter misurare l’outputottenuto al variare dell’intensità della radiazione incidente sul rivelatore. Perfar questo è necessario poter controllare accuratamente le intensità in ingressooppure, cosa che è più facile da farsi, usare diversi tempi di integrazione mantenendocostante l’intensità della luce incidente. Una buona determinazione dellalinearità richiede comunque di poter disporre di sorgenti di luce che siano stabilialmeno entro l’ 1% su una scala temporale dell’ordine del tempo necessario allemisure di linearità che andiamo a fare. Si tenga presente che la condizione distabilità entro l’ 1% non è sempre facile da ottenere per una sorgente di luce. Sela si ottiene, tenendo conto che gli otturatori utilizzati sono di solito molto precisinel determinare i tempi di esposizione, il rapporto <strong>dei</strong> flussi integrati nel temposarà uguale al rapporto <strong>dei</strong> rispettivi tempi di integrazione usati. Quindi, facendomisure con diversi tempi di integrazione, si potrà costruire una sequenza di valorisperimentali che riportati in un grafico chiariscono il tipo di relazione che avretetra il livello del segnale ottenuto con il tempo di integrazione utilizzato.Le eventuali non linearità nel segnale ottenuto sul rivelatore, apparirannochiaramente come una deviazione da una retta ideale che passi attraverso i puntisperimentali. Da un punto di vista pratico la misura si potrebbe realizzare comeuna sequenza di esposizioni con tempi di t exp = 1s, 2s, 1s, 4s, 1s, 8s, 1s, 16s ....in cui le misure ottenute con tempo di integrazione crescente servono a costruirela curva di linearità, mentre le misure ripetute con t exp =1s servono a controllaree valutare la effettiva stabilità della sorgente di radiazione utilizzata.Una volta ottenuta la curva di linearità del rivelatore e accertata la ripetibilitàdi questa curva, si potranno correggere le osservazioni per gli effetti di non nonlinearità di quel particolare rivelatore.Nella maggior parte degli osservatori non sarà necessario costruirsi la curvadi linearità perchè questa viene fornita come una informazione di supportoall’osservatore.3.1.4 Sottrazione della “dark current”Ogni rivelatore, oltre a produrre un segnale in seguito alla interazione con laradiazione incidente, produce un segnale che viene detto di “oscurità”(o anche

86 F.Strafella“dark”) e che è riconducibile alla agitazione termica del materiale con cui il rivelatoreviene realizzato. Questo segnale di oscurità è prodotto anche in assenzadi radiazione incidente ed e’ una funzione del tempo per cui spesso viene ancheindicato come“corrente di oscurità” (dark current). In generale in un array ladark current cambia da un pixel all’altro, anche se di solito questo segnale è resominimo abbassando la temperatura di operazione dell’array. I pixel che mostranouna dark current più alta del dovuto vengono detti “warm pixels”, mentre quelliche sono particolarmente rumorosi vengono indicati come “hot pixels”. In questanomenclatura entrano anche i “cold pixels” che sono quelli che non mostranoalcuna o pochissima sensibilità sia alla radiazione incidente che alla dark current.Per quanto abbiamo detto, il segnale dark è ovviamente legato al tempo di integrazioneusato per acquisire le immagini e quindi la correzione da applicare, percompensare questo segnale non voluto, deve essere stimata a partire dal tempo diintegrazione usato per ogni frame acquisito. Una stima della dark current si puòfare sia acquisendo una immagine con otturatore chiuso di pari durata, sia utilizzandomolti dark frames, da mediare, per realizzare il cosiddetto “superdark”in cui il rumore di lettura (RON) ed il rumore di conteggio (shot noise, o rumorepoissoniano) sono meno importanti che in un singolo frame.In un caso ideale acquisiremo dark frames con tempi di integrazione uguali aquelli usati per le osservazioni; nella realtà però si deve tener conto che i darkframes consumano una parte consistente di tempo e quindi si preferisce acquisirlinei momenti in cui le osservazioni sono impedite o dalla luce del crepuscolo odalle nuvole. In generale si evita di acquisirli di giorno per evitare la possibilitàche gli strumenti al piano focale del telescopio non siano perfettamente schermatirispetto alla luce diurna dell’ambiente.Disponendo di moltissimi dark frames si possono raggiungere ottimi livellidi accuratezza nella correzione anche di quei pixel con bassissima dark currentche sono dominati dal RON. Di solito tuttavia non si dispone di moltissimi darkframes e la strategia di riduzione può essere di mediare su tutti i frames perprodurre un superdark, ma considerando nulla la dark current per i pixel conbasso contributo dark. In questo modo si correggono i pixel “warm” (che sonodominati dalla dark current) senza aggiungere rumore di lettura ai pixel buoni.3.1.5 Sottrazione del pre-flash e correzione per “deferredcharge”Per i CCD con problemi di deferred charge ai bassi livelli di luce (problema piùimportante per i CCD più vecchi, vedi anche Figura 2.6), le non-linearità possonoessere evitate con un pre-flash di luce che crei un “piedistallo” di segnale cui poi

Dip. di Fisica @ UNISALENTO 87si costruisce l’immagine durante l’esposizione. Per poter sottrarre il valore delsegnale di piedistallo si deve valutare bene il suo livello prendendo una serie diframes con lo stesso valore di pre-flashing che possono poi essere combinati perdeterminarne uno medio. Questa procedura e’ comunque ormai poco utilizzatagrazie al miglioramento dell’efficienza di trasferimento della carica nei CCD.3.1.6 Correzione dell’ombra prodotta dall’otturatorePoichè un otturatore impiega un tempo finito per aprirsi e chiudersi, il tempo diesposizione effettivo è una funzione della posizione sull’array. Naturalmente leosservazioni che potranno subire una influenza significativa da questo fenomenosaranno quelle con un breve o brevissimo tempo di integrazione. Si tenga tuttaviapresente che l’aumento delle dimensioni <strong>dei</strong> rivelatori tende a fare riemergerequesto problema anche per osservazioni con tempi brevi di esposizione.Se ci proponiamo di ottenere una una precisione fotometrica dell’1% ancdhecon tempi brevi di esposizione (attenzione: spesso l’osservazione di campicontenenti stelle di calibrazione impone l’uso di tempi brevi) allora dovremmocorreggere questo effetto. Per valutare la correzione da apportare alle osservazionisi va a confrontare il risultato di N esposizioni di breve durata t con una unicaesposizione di pari tempo di integrazione nominale N t. Per ogni frame il numerodi conteggi osservati sarebbe O t = S(t+∆t(x, y)), dove con S abbiamo indicato ilflusso di conteggi veri, t è il tempo di integrazione utilizzato, ∆t è la differenza tratempo di integrazione nominale ed effettivo in funzione della posizione del pixel.Si può scrivere quindi che, con tempi di integrazione brevi, per ogni esposizioneavremo:NO t = NS(t + ∆t)mentre per un’unica lunga esposizione di durata N t:O Nt = S(Nt + ∆t)Dalle precedenti si vede che se il tempo di esposizione è abbastanza lungo il∆t dovuto all’otturatore diventa trascurabile e quindi in prima approssimazionepossiamo scrivere O Nt ≃ NO t . Otteniamo allora:NO t (t + ∆t)=O Nt te quindi dal rapporto di due frames possiamo calcolare ∆t ed usare la primaequazione per correggere le esposizioni brevi ricavando il valore vero del segnale:S =NS(t + ∆t)NS t= O tt + ∆t

88 F.StrafellaSi noti che il ∆t è una quantità che dipende dalla posizione del pixel e quindi larelazione precedente andrà utilizzata pixel per pixel.3.1.7 Correzione di flat fieldQuesta correzione corrisponde alla compensazione delle differenze di sensibilitàtotale che sono sempre presenti tra i pixel di un array. Queste possono esseredovute sia ad una differente sensibilità intrinseca (che dipende dal processo dicostruzione dell’array) tra i diversi pixel, sia a differenze nel cammino ottico(filtri, ottica, diaframmi, ...) che la radiazione percorre prima di raggiungere idiversi pixel dove viene poi rivelata. Tutte queste cause producono un errore ditipo moltiplicativo che dipendente dalla posizione sull’array.La procedura per correggere queste differenze è , in linea di principio, abbastanzasemplice e corrisponde ad osservare una sorgente di radiazione che siaugualmente brillante (cioè “flat”, ovvero “piatta”) su tutto il campo osservato (dacui il nome di flat field). In questo modo tutte le differenze di segnale osservatesui pixel saranno riconducibili alle effettive differenze in sensibilità tra i pixel e trai cammini ottici della radiazione. Si ottiene così una mappa della sensibilità <strong>dei</strong>pixel che viene anche detta pixel to pixel sensitivity map. Da quanto detto appareevidente che le osservazioni ottenute con un dato array saranno influenzate dallaparticolare struttura di sensibilità dello stesso array e quindi richiederanno unaqualche forma di correzione per ripristinare i rapporti di segnale effettivamenteraccolto sui pixel. A questo scopo è necessario dividere, pixel per pixel, i frameottenuti durante le osservazioni per il frame del flat-field che, di solito, vieneprima normalizzato rispetto alla media <strong>dei</strong> valori <strong>dei</strong> pixel.La difficoltà più importante, nel procedere a questa operazione di correzione,consiste nel trovare un campo da osservare che sia davvero uniformementebrillante per garantire una correzione accurata. In effetti, questa richiesta non èfacile da soddisfare e quindi si usano più tecniche per ottenere il flat-frame peril quale divideremo le nostre immagini originali. A questa difficoltà di ottenereun buon flat frame si aggiunge anche il fatto che c’è anche una dipendenza dalcolore della radiazione e quindi sarà necessario determinare un flat-field per ognilunghezza d’onda coinvolta nelle osservazioni. Se poi si usano filtri a banda largadiventa anche importante considerare che lo spettro delle sorgenti usate perottenere i flat-frames differisce da quello delle sorgenti astronomiche osservate equesto puo’ portare ad errori sistematici.Un’altro aspetto importante riguarda la precisione con cui si richiede generalmentedi conoscere la risposta di un pixel che è dell’ordine di qualche frazionedi percento, il che corrisponde a richiedere ad un alto rapporto S/N per il flat

Dip. di Fisica @ UNISALENTO 89frame. A questo proposito va anche detto che un alto S/N in una data regione diun flat-frame non garantisce, di per se, che tutto il frame abbia lo stesso valore diS/N. Questo proprio a causa delle limitazioni sulla uniformità dell’illuminazionedel campo e sul colore della sorgente usata. Quanto abbiamo detto ci fa concludereche il principale fattore che limita l’accuratezza di un flat-field non sono glierrori casuali, ma quelli sistematici.Le tecniche più usate per valutare il flat-field sono tre, e precisamente:Dome flat: con una lampada a spettro continuo (luce bianca) si illuminal’interno della cupola (o uno schermo in cupola) su cui si punta il telescopioper acquisire i flat-frames. Siccome la cupola è un oggetto fuori fuoco lasua immagine non sarà coniugata al rivelatore e quindi le irregolarità nell’illuminazionedella cupola, che sono sempre presenti, tendono a mediarsisul rivelatore. Nonostante questo vantaggio, i flat ottenuti in cupola sonosufficienti a correggere solo ad un primo livello di accuratezza perchèle condizioni di illuminazione del rivelatore da parte di un oggetto non afuoco non sono le stesse di quando si fanno immagini del cielo. P.es., seun oggetto e’ fuori fuoco i cammini ottici <strong>dei</strong> raggi che vanno su un datopixel passano da parti diverse dell’ottica rispetto al caso di una immaginea fuoco.Questo tipo di flat è utile per valutare la variazione di sensibilità tra ipixel se la corrispondenza tra il colore della radiazione usata per il flat equello delle sorgenti astronomiche è abbastanza buona, cosa che di solito èabbastanza verificata. In ogni caso, a causa <strong>dei</strong> problemi di illuminazionea cui si è prima accennto, l’accuratezza di questa tecnica sulle grandi scalespaziali è dell’ordine di alcuni percento e non di frazioni di percento comeauspicabile per una fotometria accurata.Twilight flat Con questa tecnica si utilizzano i momenti di crepuscolo perottenere immagini del cielo quando questo è ancora abbastanza brillanteper richiedere brevi tempi di integrazione. Tuttavia, a causa della brevedurata del crepuscolo, questa modalità è applicabile solo se abbiamo a chefare con un numero limitato di filtri e se i tempi di lettura dell’array nonsono troppo lunghi. Anche con il crepuscolo i flats possono avere problemidi non perfetta corrispondenza tra la forma spettrale della luce usata peril flat e quella delle osservazioni ma, come si è potuto intuire, il problemaprincipale è quello della breve durata del crepuscolo per cui si cerca diutilizzare sia il momento dell’alba che quello del tramonto.Un problema minore che spesso si verifica con questa tecnica è che neiflat-frames possono apparire le stelle più brillanti del campo. Per superare

90 F.Strafellaquesto inconveniente si usa ottenere più flats nello stesso filtro, spostandoleggermente il puntamento del telescopio di una decina di secondi d’arcotra un frame e l’altro. Questa tecnica (detta anche dithering ) permettedi eliminare successivamente le stelle quando, combinando i diversi framesacquisiti, se ne ricava uno finale e senza stelle.Dark sky flat Un’altra tecnica per ottenere un flat-frame si basa sull’osservazionedi una regione di cielo presumibilmente vuota, ovvero senza stelleo nebulosità rilevanti. Il problema è che la brillanza del cielo è bassa (nellaregione ottica) e quindi si ottengono spesso bassi valori del rapporto S/N.Il vantaggio di questa tecnica è che il colore della sorgente (cioè del cielonotturno) corrisponde esattamente a quello del cielo durante le osservazioni.Per ottenere la miglior correzione di flat field possibile si può procedere adutilizzare prima i flat ottenuti con una lampada in cupola per valutare la pixel-topixelresponse function, cioè le variazioni relative tra un pixel ed i suoi adiacenti(variazioni a piccola scala). Poi, per avere anche una buona correzione a piùgrande scala spaziale, è opportuno evitare l’uso del “dome flat” usando invece ilflat ottenuto sul cielo che non contiene l’errore sistematico (che agisce alle scalespaziali piu’ grandi) prodotto dalla non uniforme illuminazione del dome-flat.Figura 3.2: Immagine rozza.Figura 3.3: Immagine di Bias.Errori nella correzione di flat-fieldPer valutare le incertezze in gioco in queste operazioni di data-reduction consideriamoche, in assenza di background, gli errori relativi che avremmo nelle

Dip. di Fisica @ UNISALENTO 91Figura 3.4: Immagine di flat-field.Figura 3.5: Immagine finale.osservazioni sarebbero pari a quelli che facciamo nel flat-field per il quale dividiamole osservazioni. Nella realtà però abbiamo a che fare con immagini chepresentano sempre un fondo e quindi ci poniamo il problema di valutare comel’incertezza sul flat si propaga quando valutiamo il flusso di una sorgente astronomica.Il flusso rivelato F è infatti la somma di quello della sorgente S più quellodel fondo B e siccome non possiamo valutare il fondo esattamente sulla posizionedella sorgente dobbiamo accontentarci di farne una valutazione nelle vicinanzedella sorgente.In questo caso, se invece di stimare correttamente il background come B lovalutiamo come x · B avremo che, quando lo sottrarremo al flusso osservato Fper ottenere il segnale originale faremo un errore relativo dato da:∆SS=(S + B) − xBS= 1 + (1 − x) B S(3.1)Si vede quindi che, quando il segnale da rivelare è pari al fondo, un erroredell’1% (cioè x=0.99) nella valutazione di questo fondo corrisponde ad un errorerelativo dell”1% sul segnale ricavato per la sorgente. Se però il fondo è dell’ordinedi B ∼ 100 S allora l’errore sarebbe di un fattore 2, ovvero del 100% da cuisi capisce che la correzione di flat-field è cruciale nel caso della fotometria disorgenti deboli rispetto al fondo. Questo caso si realizza nella regione otticasolo per sorgenti particolarmente deboli ma è invece la regola nella regione IRdove la brillanza del cielo è particolarmente alta. Si noti anche che il problemanon cambia nel caso noi avessimo a che fare con sorgenti brillanti su un fondospazialmente non uniforme come spesso accade nella regione IR nella quale ilcontributo dell’emissione termica del telescopio e della cupola sono importanti.

92 F.StrafellaQuesto contributo termico è un grosso problema perchè può cambiare nel corsodella notte con il cambiare della temperatura dell’ambiente e con la direzione dipuntamento.Da quanto abbiamo visto possiamo considerare che, se tutti i frame sonosoggetti agli stessi errori di background (additivi) e flat field (moltiplicativi) allorapossiamo risolvere il nostro problema di minimizzare gli errori osservando il cielosugli stessi pixel che hanno osservato l’oggetto. In questo caso sottraendo il frameottenuto sul cielo da quello sull’oggetto otteniamo come risultato un’immaginein cui il livello del fondo del cielo è molto minore che nel frame di partenza. Diconseguenza si attenueranno gli errori provenienti dalla procedura di flat-fieldcome abbiamo visto in accordo alla relazione 3.1. Si paga per questo un aumentodi un fattore √ (2) (se il cielo è il contributo dominante) nel rumore poissonianodell’immagine finale ottenuta dalla sottrazione “oggetto-cielo”.Due cose ancora: i) questa procedura è vantaggiosa solo nei casi in cui il cieloè più brillante dell’oggetto da studiare; ii) se l’oggetto da studiare è angolarmentepiccolo rispetto al campo coperto da un frame allora si può osservare ilcielo contemporaneamente alle osservazioni dell’oggetto semplicemente facendopiù esposizioni con la tecnica cosiddetta del dithering, che consiste nel muoverel’oggetto nel campo prima di ogni successiva esposizione.Infine ricordiamo che la principale sorgente di inaccuratezza nella fotometriasono gli errori sistematici e pertanto una stima degli errori per via analitica èimpraticabile. La miglior cosa da farsi per stimare l’accuratezza del flat field è diacquisire diverse immagini dello stesso oggetto che occupa diverse posizioni nelcampo di vista (cioe’ la suddetta tecnica del dithering). Con queste osservazionia disposizione si può provare a determinare empiricamente il grado di ripetibilitàdelle misure. Questa tecnica è assolutamente consigliabile se si usano strumentidi osservazione nell’IR.3.1.8 Flat-field nell’IRLa correzione di flat-field è particolarmente complicata nella regione IR dello spettropoichè ogni frame che si acquisisce, compresi i flat frames, contiene una componenteadditiva del segnale che è prodotta dall’emisione propria del telescopio edella sua cupola. Per le osservazioni da terra questo problema è particolarmenteserio a lunghezze d’onda λ > 2µm dove l’emissione termica del telescopio dominasulla componente del fondo del cielo. In questi casi una tecnica può essere quelladi puntare la cupola ed ottenere frames con e senza illuminamento, in modo taleda poter procedere poi successivamente ad una sottrazione <strong>dei</strong> due frame perottenere una stima del flat field. Naturalmente questa modalità lascia irrisolti i

Dip. di Fisica @ UNISALENTO 93tipici problemi <strong>dei</strong> flat in cupola: l’illuminamento non uniforme della cupola ela non corrispondenza del colore della radiazione usata con quella del cielo. Sesi vuol provare a far meglio, sarà utile acquisire anche i flat sul cielo (sky-flats).Questi ultimi potranno essere usati con miglori risultati nel caso in cui il contributoadditivo e spazialmente variabile del telescopio sia modesto rispetto a quellodel cielo.3.2 Operazioni durante le osservazioni• Bias Il numero di immagini da acquisire dipende dalla natura e dall’ampiezzadel pattern di rumore sistematico. Non implicano perdite di tempodi osservazione perchè si possono acqisire durante il giorno.• Flat Sono frames critici perchè determinano la qualità del risultato scientifico.Se possibile conviene prenderne sia in cupola (dome flats) che sul cielo(twilight flats) per poter correggere le immagini con grande accuratezza siaa grande che a piccola scala spaziale. Se si prendono frames sul cielo (skyflats) bisogna usare la tecnica del dithering per avere la possibilità di eliminarele stelle che inevitabilmente compaiono nei flat frames presi sul cielo.Se si acquisiscono immagini di twilight flats conviene prenderli a diversealtezze sull’orizzonte, se possibile.• Dark Il numero di frames da acquisire dipende dalla natura e ampiezzadel segnale dark. Naturalmente bisogna accertarsi che effettivamente duranteil tempo di esposizione le condizioni di illuminamento del CCD sianoeffettivamente “dark”.• Istogramma Per un controllo rapido della qualità <strong>dei</strong> <strong>dati</strong> e del comportamentodel rivelatore è consigliabile dare uno sguardo all’istogramma delleimmagini.• Linearità Usualmente nel caso degli array IR è consigliabile prendere unasequenza di immagini per un controllo della linearità nella risposta.• Rumore di lettura (RON) e guadagno (G) Consideriamo di aver acquisitoun insieme di misure ad un livello di luce L con uno strumento il cuiguadagno sia G. Il rumore in elettroni che ci aspettiamo su un pixel di questeimmagini sarà dato da σ 2 = LG + RON 2 . Se facessimo questo tipo diconsiderazioni per diversi livelli di illuminamento L potremmo ottenere ungrafico di σ 2 vs. L, la cui pendenza ed intercetta darebbero rispettivamente

94 F.Strafellail guadagno G ed il quadrato del rumore di lettura RON 2 . Questo tipo digrafico è un ottimo test per un rivelatore e permette anche di valutarne lalinearità.Questo test richiede però di acquisire per ogni valore di illuminazione L ungran numero, diciamo N, di immagini che dovranno poi essere analizzateper valutare il rumore di lettura RON ed il guadagno G per ogni pixel.Data la mole di <strong>dati</strong> da trattare si preferisce allora utilizzare l’insieme <strong>dei</strong>valori <strong>dei</strong> pixel come rappresentativi delle diverse misure alla stessa illuminazione.Tuttavia questo non si può fare direttamente poichè ogni pixel hauna diversa sensibilità ed un differente livello di RON cosicchè non possiamoconsiderarli un vero insieme statistico rappresentativo delle N misureper ogni valore di L. Per evitare questi problemi possiamo utilizzare invecepiù immagini ottenute con una data illuminazione L, per considerere poile loro differenze in modo da eliminare così su ogni pixel, il segnale ed evidenziareil rumore. In pratica il rumore che ci aspettiamo nella differenzatra due immagini alla stessa L è :σ 2 = 2(LG + RON 2 )Poichè la relazione tra elettroni e conteggi è tale che σ 2 (elettroni)=Gσ conteggi ,in termini <strong>dei</strong> conteggi la precedente si scrive:σ 2 conteggi = 2(L G + RON2G 2 ) (3.2)Un’immagine differenza darà direttamente il valore di σ 2 conteggi per cui saràabbastanza semplice prendere differenze di immagini per diversi livelli di illuminamentoe quindi realizzare un grafico di σ 2 conteggi in funzione di L. Daun grafico di questo tipo si potrà ricavare il valore di 2/G e di 2RON 2 /G 2 )che sono rispettivamente la pendenza e l’intercetta. Se una retta non rappresentabene l’andamento <strong>dei</strong> punti sul grafico allora questo è un sintomoche qualcosa non funziona correttamente e sarà bene capirne il motivo.È anche possibile abbreviare i tempi di queste stime se vogliamo solo avereun’idea di prima approssimazione. In questo caso prenderemo un paio dibias frames, che corrispondono al livello zero di illuminamento, e ne facciamola differenza. Quindi il rumore della differenza sarà 2σ 2 diff = 2 RON2 .Ora acquisiamo due frames ad alto valore di illuminamento: in questa condizioneil RON è praticamente trascurabile e la valutazione del guadagno èpresto ottenuta dalla precedente eq. 3.2:G = 2(Lσ 2 conteggi)

Dip. di Fisica @ UNISALENTO 953.3 Trattamento delle immagini astronomicheLa maggior parte dell’informazione raccolta dalle osservazioni astronomiche è informa di immagini e con il termine “trattamento delle immagini” (image processing)si intende indicare una serie di operazioni che sono legate a specificistrumenti operativi che ci consentono di indagare i nostri <strong>dati</strong> attraverso:- operazioni di lettura e/o scrittura che vengono generalmente indicate conl’abbreviazione I/O (da Input/Output);- produzione di una appropriata rappresentazione grafica (display);- un’aritmetica che operi sulle imagini- una statistica che dia informazioni sul segnale contenuto nelle immagini.Questi strumenti costituiscono la base per l’analisi delle immagini astronomicheche può avere vari scopi tra cui:- fotometria di campi stellari (oggetti puntiformi o non risolti);- fotometria di superficie (oggetti estesi);- simulazione di immagini;- analisi di Fourier;- riduzioni ed analisi spettroscopiche.3.3.1 Display delle immaginiPer ottenere una corretta rappresentazione delle immagini è essenziale capirecome rendere i <strong>dati</strong> come “vedere” tutta l’informazione che essi contengono. Lecomplicazioni nascono dal fatto che l’intervallo dinamico (dynamic range) dell’occhioumano e della maggior parte <strong>dei</strong> display normalmente usati è sempre minoredi quello <strong>dei</strong> <strong>dati</strong> astronomici. La maggior parte <strong>dei</strong> display usa 8 bit, e quindisolo 256 valori, per rappresentare l’intensità del segnale. È quindi comprensibilecome un’immagine che contiene pixel con intensità variabili, per esempio, nell’intervallo[0 − 65535 ] se “riscalata” (rescaling) in 8 bit perderà fatalmente tuttal’informazione che corrisponde alle variazioni più fini delle intensità <strong>dei</strong> pixel.Alternativamente si può scegliere di rappresentare correttamente, cioè a risoluzionepiena, solo una parte del segnale contenuto nell’immagine in modo chetra il massimo ed il minimo segnale vi siano meno <strong>dei</strong> 256 livelli disponibili per

96 F.Strafellail display. In quest’ultimo caso nel display avremo preservato l’informazione contenutanella regione prescelta, ma avremo rinunciato a “vedere” correttamente idettagli in tutta la restante parte dell’immagine. Converrà quindi evitare l’usodi software che stabiliscono automaticamnete lo scaling di un’immagine perchèquesta comodità si paga poi con la perdita di informazione apparente. La sceltamanuale delle modalità con cui si andrà a rappresentare l’immagine rende invececonsapevoli <strong>dei</strong> valori che i pixel assumono nelle immagini analizzate e quindianche di eventuali problemi che sono intervenuti durante l’acquisizione <strong>dei</strong> <strong>dati</strong>.P.es. sarà più o meno facile capire se i valori <strong>dei</strong> pixel sono vicini o lontani dallivello di saturazione.I parametri per lo scaling di un’immagine saranno <strong>dati</strong> in termini di un limiteinferiore ed uno superiore ( oppure di un limite inferiore ed un intervallo ): entroquesti limiti i valori nei <strong>dati</strong> verranno poi scalati ad 8 bit nella rappresentazionesul display. Naturalmente si potrà anche stabilire uno scaling non lineare <strong>dei</strong> <strong>dati</strong>che potrà essere variamente definito da una funzione come p.es. il logaritmo, laradice quadrata, ....Una volta stabilito lo scaling si potrà poi stabilire la tabella <strong>dei</strong> colori con laquale si realizza una corrispondenza tra il valore (livello) del segnale da rappresentaree colore da usare. Questa tabella può consistere in vari livelli di grigio(immagini in greylevels) oppure ad una particolare sequenza di colori (immaginiin pseudo-colors)). La maggior parte <strong>dei</strong> software permettono di variare anchela brillanza ed il contrasto nel display per mettere in maggiore evidenza particolaridettagli: se si utilizzano queste possibilità allora è consigliabile scegliere unintervallo di valori dell’immagine da rappresentare che sia sempre maggiore <strong>dei</strong>256 valori disponibili nel display. Oltre a questo i software permettono anche dileggere il valore individuale di un generico pixel puntato dal cursore sul display.Naturalmente in questi casi si pretende che il valore restituito dal software nonsia il valore della tabella di colori usata nel display, ma il valore vero del segnalesul pixel puntato dal cursore.Il software in generale dovrà anche fornire la possibilità di effettuare zoomsull’immagine, alternare due o più immagini, avere una qualche funzione di analisiinterattiva come mediare sui valori <strong>dei</strong> pixel vicini al cursore, valutare il picco ela FWHM di una regione definita dal cursore, selezionare “oggetti”, etc....3.3.2 Formato FITSAvendo a che fare con grandi quantità di <strong>dati</strong>, specialmente nel caso delle immaginiastronomiche, ci si pone il problema di immagazzinarli in un formato chesia efficiente sia nel minimizzare lo spazio di memoria richiesto sia nel recuperare

Dip. di Fisica @ UNISALENTO 97tutta l’informazione al momento dell’analisi. Per questo motivo le immagini nonsono quasi mai immagazzinate come numeri “formattati” (cioè leggibili con uneditor). Siccome il valore di un pixel viene codificato generalmente in 16 bit,potrà coprire l’intervallo da -32768 a 32767 e se vogliamo scriverlo formattatoabbiamo bisogno di almeno 5 byte quando evidentemente basterebbero solo 2bytes (cioè 16 bit) per rappresentarli in una memoria binaria. Per questo motivole immagini in memoria vengono rappresentate con numeri “sformattati” (informa binaria) che però vengono rappresentati con modalità che dipendono daidiversi hardware/software. Nella maggior parte <strong>dei</strong> casi la modalità usata nellarappresentazione è quella del complemento a 2 per rappresentare gli interi, mentresi usa lo standard IEEE per i numeri reali (floating point). Invece ci sonosempre delle differenze tra le diverse macchine per quanto riguarda l’ordine incui vengono interpretati i bytes di queste rappresentazioni: alcune architettureusano il primo byte come il più significativo, altre come il meno significativo !Comunque, una volta scelta la rappresentazione, i valori <strong>dei</strong> pixel possonoessere semplicemente scaricati sequenzialmente in un file. Questo file dovrà peròanche contenere qualche altra informazione, come p.es. le 2 dimensioni (x,y) inpixel dell’immagine, che potrà poi consentire la ricostruzione fedele dell’immagineoriginale a partire dalla lettura sequenziale <strong>dei</strong> numeri. All’informazione di basesulle dimensioni dell’immagine se ne potranno poi aggiungere altre per specificarela scala lungo i due assi, il telescopio usato, il tempo di esposizione, ecc. ecc.Il formato usato come standard per rappresentare e trasportare i <strong>dati</strong> astronomiciprende il nome di FITS (Flexible Image Transportation System) ed èdescritto in dettaglio in una serie di articoli ( A&AS 44, 363; A&AS 44, 371;A&AS 73, 359 ). Questo formato usa la codifica del complemento a 2 per gliinteri e quella IEEE per i floating point, con il byte più significativo per primo.Nel formato FITS i <strong>dati</strong> sono organizzati in due sezioni: una detta di intestazione,detta image header , alla quale è collegata l’altra, detta image data , checointiene i <strong>dati</strong> veri e propri in formato binario. L’header è la parte leggibilecon un normale editor ed è costituito da un numero variabile di linee di 80 byte,scritte con caratteri ASCII, che contengono l’informazione necessaria per interpretarei <strong>dati</strong> e per “spacchettare” correttamente i <strong>dati</strong> binari che, nello stessofile, seguono l’header. L’header contiene una serie di chiavi di lettura dette imagekeywords che possono avere lunghezza fino ad 8 caratteri. Quelle sempre presentinell’header sono1. SIMPLE = T (per “True”) oppure F (per “False”), a seconda che si trattio no di una estensione speciale del formato FITS2. BITPIX che dà il numero di bit/pixel e quindi informa sulla codifica <strong>dei</strong>

98 F.Strafellanumeri (p.es. 16 bit interi, a 32 bit floating, ...)3. NAXIS che dà il numero di assi, cioè la dimensionalità <strong>dei</strong> <strong>dati</strong>, che puòessere 1 nel caso di immagini 1-dimensionali (spettri), NAXIS = 2 per leimmagini, ma può avere anche valori maggiori come NAXIS = 3 se vi sonopiù immagini 2-dimensionali “impilate” (stacked) l’una sull’altra. È possibileanche avere dimensionalità maggiore se è necessario rappresentareopportunamente <strong>dati</strong> multidimensionali. Nella ricostruzione di un’immaginebidimensionale l’ordine in un file FITS è tale che l’indice delle colonnevaria prima di quello delle righe.4. NAXIS[n] una serie di keywords di questo tipo per indicare per ogni dimensionela lunghezza dell’asse5. END per indicare la fine dell’headerNel seguito diamo altri esempi di keywords opzionali che sono riferite in particolareal caso di immagini del cielo: CRVAL[N], CRPIX[N], CRDELT[N], CTY-PE[N], OBJECT, DATE-OBS, INSTRUME, OBSERVER, TELESCOP, RA, DEC,EPOCH, COMMENT, HISTORY, etc...L’utilità di queste informazioni è evidente se notiamo che per un arbitrariosistema di assi (p.es. RA, DEC, lunghezza d’onda, ...) la coordinata di un pixellungo l’asse n-esimo è data da:coordinata[n] = CRVAL[n] + (pixel-CRPIX[n])*CRDELT[n]dove:- CRVAL[n] rappresenta la coordinata del punto indicato da CRPIX- CRPIX[n] è il pixel corrispondente al centro dell’immagine- CRDELT[n] è la distanza angolare coperta da un pixel nel cielo (la scala<strong>dei</strong> pixel)Spesso per aumentare l’intervallo dinamico <strong>dei</strong> <strong>dati</strong> rappresentati si utilizzanodue altre keywords, BZERO e BSCALE, attraverso le quali il valore di un pixelpuò essere recuperato davalore vero = (valore nel pixel * BSCALE) + BZEROSi noti che, per assicurare la compatibilità del formato FITS con diversi tipi dimacchine, la sezione dell’header e quella <strong>dei</strong> <strong>dati</strong> sono completate rispettivamenteda blank e da zeri fino a raggiungere una lunghezza totale pari ad un multiplodi 2880 bytes. Quindi aprendo con un editor un file FITS ci dobbiamo aspettareuna serie di righe di 80 caratteri (header) che terminano con la riga di END. A

Dip. di Fisica @ UNISALENTO 99seguire ci saranno un numero variabile di blank fino a raggiungere una lunghezzapari ad un multiplo di 2880 bytes. Seguiranno subito dopo i <strong>dati</strong> originali (rawdata) in un flusso continuo di bytes che alla fine sono completati da tanti zeriquanti ne servono per raggiungere la lunghezza di un multiplo di 2880 bytes.La lettura/scrittura di questi files è facilitata da molte routine distribuitepubblicamente e sempre presenti nei software di riduzione ed analisi di <strong>dati</strong>astronomici. I software di analisi <strong>dati</strong> più diffusi in ambito astronomico sonotre:IDL (Interactive Data Analysis): è un pacchetto commerciale di larghissimadiffusione e per il quale sono state sviluppate moltissime librerie diprocedure per scopi specifici. Una vasta raccolta di procedure si può trovareall’indirizzo: http://idlastro.gsfc.nasa.gov/homepage.html Si tratta diun linguaggio di programmazione nel quale l’operatore ha massima libertàdi intervenire ad ogni livello <strong>dei</strong> codici.MIDAS (Munich Image Data Analysis System) sviluppato dall’ESO (EuropeanSouthern Observatory) e distribuito gratuitamente (http://www.eso.org).L’operatore utilizza delle procedure di riduzione ed analisi <strong>dei</strong> <strong>dati</strong> nellequali può variare una serie di parametri.IRAF (Image Reduction and Analysis Facility) sviluppato dall’NOAO (NationalOptical Astronomy Observatory, http://iraf.noao.edu/). Come nelcaso di MIDAS l’operatore, variando i parametri di input delle procedure,può svolgere il suo compito di riduzione ed analisi <strong>dei</strong> <strong>dati</strong>.Va detto infine che il formato FITS ha subito negli anni varie modifiche, detteanche estensioni, per permettere di immagazzinare più informazioni e non solo<strong>dati</strong> relativi ad immagini. In particolare anche <strong>dati</strong> in forma di tabelle (<strong>dati</strong> tabulari)i cui elementi possono rappresentare diversi tipi di <strong>dati</strong>. File FITS di questotipo vengono anche detti “FITS tables” e possono essere scritti sia in ASCII chein formato binario. Un’altra estensione FITS che si può incontrare è stata introdottaper rappresentare nello stesso file un gruppo di immagini diverse, ciascunacon il proprio header, e con un header comune a tutte le immagini. Questo tipodi estensione è utile per immagazzinare un’immagine ripresa da un rivelatorecomposito che viene realizzato come un mosaico di rivelatori che coprono unaampia regione di cielo durante l’osservazione.

100 F.Strafella3.3.3 Combinare immaginiIn molte situazioni osservative si acquisiscono numerose immagini che poi vengonocombinate per ottenere un dato risultato. Esempi di casi di questo tipo sono ladeterminazione del flat field, la realizzazione del superdark, la valutazione delfondo del cielo (specialmente nell’IR) ottenuta con la tecnica del “dithering”, laricerca di un migliore rapporto S/N ripetendo la misura più volte e poi sommandoi frames, etc.Sappiamo che, una volta ottenuto un campione di misure della stessa grandezzafisica, la migliore stima del valore intrinseco della grandezza è data, nelsenso della massima probabilità, dalla media del campione. Tuttavia la mediacampionaria non è particolarmente robusta quando siamo in presenza di outliers,ovvero di misure che danno valori molto al di fuori di quello che è ragionevolmenteatteso. Gli outliers sono infatti spesso associati alle misure sperimentalie sono il prodotto di eventi inattesi come l’arrivo di raggi cosmici sul rivelatore,flickering delle stelle, letture del rivelatore con “bad data”. Qui ci occupiamo diun aspetto cruciale nella riduzione ed analisi <strong>dei</strong> <strong>dati</strong> astronomici che consistenel saper combinare più immagini per ottenere il risultato voluto, escludendo allostesso tempo gli “outliers”.È intuitivo che la combinazione di più immagini di uguale formato può esserefatta mediando tutti i valori ottenuti su un dato pixel. Siccome la presenza di“outliers” è inevitabile, per valutare il valore di un pixel sull’immagine combinatapossiamo utilizzare la mediana che, in presenza di outliers, è uno stimatorepiù robusto, anche se in linea di principio meno accurato, della media della popolazionecampionata dalle misure. Alternativamente si potrebbe utilizzare laconoscenza a-priori degli outliers sfruttando p.es. il fatto che i segnali di raggicosmici e stelle sono sempre positivi: in questo caso potremmo eliminare dalcomputo della media il massimo valore ottenuto su ogni pixel. Tuttavia questascelta porterebbe ad un bias per tutti i pixel che non hanno outliers e quindisi preferisce cercare di compensare questo bias eliminando sia il valore massimoche il minimo. Anche questa procedura ha i suoi inconvenienti perchè produceun bias (anche se minore) sui pixel con un outlier e toglie comunque segnale (i 2valori min e max) sui pixel buoni. Probabilmente la procedura migliore è quelladi eliminare dai <strong>dati</strong> i valori che si trovano al difuori di n-sigma per poi ricalcolarela media. Il problema in questo caso viene dal fatto che la valutazione dellasigma è molto sensibile proprio alla presenza degli outliers che vogliamo isolareed eliminare e quindi questa procedura è di semplice applicazione solo quando siha una conoscenza del modello giusto che descrive la distribuzione (non sempreè la gaussiana) del mix tra outliers e valori del segnale. Comunque in generale si

Dip. di Fisica @ UNISALENTO 101può adottare un modo di procedere abbastaza diffuso, cioè si calcola la media e lavarianza della distribuzione dopo aver eliminato il valore massimo dal campione.Un caso più complicato lo incontriamo quando le immagini da combinare sonoriferite a diverse intensità. È il caso per esempio <strong>dei</strong> flats che vengono ottenuti sulcielo crepuscolare e quindi sono ottenuti ad intensità che crescono o decresconoa seconda che siano riferiti all’alba o al tramonto. Bisognerà trovare quindi unmodo per normalizzarli prima di combinarli considerando eventualmente ancheil diverso livello di rumore.Un’altra situazione che implica la combinazione di più immagini è legata alladeterminazione della brillanza superficiale del cielo eliminando dall’immagine glioggetti astronomici. Ricordiamo che un’immagine stellare è costituita da un piccodi intensità che decresce rapidamente allontanandosi dal massimo e producendopoi ali estese sulle quali l’intensità va lentamente a zero. Queste ali non hannogrande importanza se si considerano gli effetti su un solo pixel, mentre sono unnotevole problema se si vuole sottrarre la brillanza del cielo ad una immagineprima di fare la fotometria degli oggetti astronomici. Infatti anche se la brillanzadell’immagine stellare su questi pixel è modesta rispetto al picco, il fatto che motipixel sono coinvolti nelle ali rende importante questo punto.Finora, nel fare le nostre considerazioni, abbiamo pensato ad un singolo pixelalla volta senza sfruttare nessuna informazione su quello che accade ai pixeladiacenti. Un caso in cui emergono molte delle sottigliezze insite nel trattamentodelle immagini che facciamo è quello della valutazione (e poi sottrazione) delbackground del cielo prima di passare all’analisi scientifica delle immagini. Ovviamenteavremo bisogno di determinare il valore della brillanza del fondo e perfar questo si adotta spesso la tecnica di ottenere più immagini dithered, cioè conpiccoli shift nel puntamento (tipicamente una decina di arcsec), della stessa regionedi cielo vogliamo sottrarre le sorgenti per ottenere un’immagine contenenteil solo segnale di fondo. Ovviamente tutte questi immagini conterranno sia ilfondo che gli oggetti astronomici e quindi per eliminare questi ultimi potremmoestrarre un’immagine in cui ogni pixel è dato dalla mediana <strong>dei</strong> pixel della piladi immagini ottenute (le immagini “impilate” sono dette anche “stack” di immagini).Il risultato di questa semplice operazione, che chiameremo supersky ,potrebbe sembrare più che soddisfacente ad occhio, anche se non bisogna farsiingannare dalle apparenze perchè si tratta solo di una prima approssimazionedel background effettivo. Infatti, se proviamo a ripetere la procedura per ottenereun altro supersky e dividiamo poi i due supersky tra loro ci accorgeremoche appaiono gli effetti della brillanza contenuta nelle ali degli oggetti presentinell’immagine. Queste ali permangono nel supersky e quindi aggiungono un’effettosistematico nelle analisi successive. Per evitare questa situazione è utile

102 F.Strafellaindividuare prima le posizioni delle stelle e quindi mascherare i pixel adiacentiintorno ad ognuna di esse prima di combinare i frames dello stack per ottenereil supersky. Per un risultato migliore conviene prima allineare (ricentraggio orecentering) e sommare le immagini per ottenere una buona rivelazione anche distelle deboli. Poi si adotterà una opportuna mascheratura da applicare a tuttele immagini originali prima di valutare il fondo del cielo. Naturalmente nel valutarela mediana su ogni pixel non terremo conto <strong>dei</strong> frames in cui quel pixel siastato mascherato. Siccome il background valutato in questo modo utilizza tuttii frames acquisiti, permetterà di rivelare anche gli oggetti più deboli che usandola semplice mediana sarebbero irrimediabilmente persi.Nel caso il fondo del cielo cambi col tempo allora con questa tecnica si potrannoottenere più immagini del background, usando in particolare le due piùvicine in tempo ad ogni immagine che si voglia ridurre.La tecnica che abbiamo descritto, prevedendo la mascheratura degli oggetti(in particolare le stelle), funziona bene solo quando i campi osservati non sonoaffollati. Nei casi in cui il campo sia affollato di stelle (si usa il termine “crowdedfield”) bisognerà individuare un campo vicino non affollato su cui ricavare ilbackground tenendo conto che si tratterà sempre di una approssimazione.Sommare immaginiUna condizione essenziale per sommare immagini ottenute con il dithering sullastessa regione di cielo è di saper individuare una trasformazione che riposizionitutti i frames su uno stesso sistema di riferimento spaziale. In altre parole bisogneràindividuare lo shift che interviene nelle due coordinate delle immagini perfar sì che l’immagine di un oggetto capiti nella stessa posizione spaziale in ogniframe prima di poter sommare coerentemente. Precisiamo che in questa discussioneabbiamo a che fare con immagini ottenute con shift di piccola ampiezza inmodo tale che eventuali distorsioni dell’ottica, presenti sul campo dell’immagine,non siano un problema. Infatti ricentrare immagini con forti distorsioni è moltopiù complicato e diventa una necessità nel caso si vogliano realizzare <strong>dei</strong> mosaici apartire da immagini che ne costituiscono le tessere. Questo perchè le tessere sonoda sorapporre l’una sul bordo dell’altra e quindi proprio laddove le aberrazionidell’ottica sono maggiori.La tecnica del dithering è essenziale nelle osservazioni IR che quindi si svolgonoottenendo un gran numero di frames con piccoli shift di puntamento. Questoapproccio ha molti vantaggi:si possono ottenere lunghi tempi di integrazione senza rischiare la saturazionedel rivelatore

Dip. di Fisica @ UNISALENTO 103si può valutare il fondo del cielosi possono eliminare i pixel difettosi senza perdere parti dell’immagine finalesi possono eliminare le tracce eventualmente lasciate dai raggi cosmiciCi sono poi altri casi in cui può essere richiesto di shiftare e ricampionare leimmagini come nel caso in cui si vogliano combinare e sommare immagini ottenuteda diversi telescopi, oppure ottenute a due diverse lunghezze d’onda, magari conlo stesso strumento ma con ottiche interne diverse (p.es.: shift causati dal cambiodel filtro usato).Prima di applicare gli shift opportuni abbiamo quindi bisogno di valutarneaccuratamente l’ampiezza a partire dalle immagini che sono state ottenute altelescopio. Per questo scopo possiamo utilizzare varie tecniche:valutare il primo momento (cioè la media) dell’immagine lungo le duedimensioni: ∑ij〈x〉 =xI ∑ijij∑ij I 〈y〉 =yI ij∑ijij I ijper poi shiftare le immagini di quantità definite dalle differenze delle mediein x ed y;utilizzare una gaussiana per fare un fit all’immagine di molte stelle rispettoad x, y ed all’intensità; quindi, determinati i centroidi delle immagini stellari,utilizzarli per determinare i ∆x e ∆y di tutte le stelle per valutarnepoi una media che fornisce lo shift migliore da applicare alle immagini;fit gaussiani alle distribuzioni marginali (proiettando le immagini delle stellelungo x ed y) delle stelle per individuare con accuratezza i centroidiQuesti metodi ovviamente implicano la presenza nel campo osservato di immaginistellari con alto rapporto S/N e quindi incontrano difficoltà in quei casi in cuil’immagine contiene solo oggetti estesi e/o solo stelle deboli. In questo caso sipuò usare la correlazione tra due immagini (cross-correlation). In pratica questaoperazione si può realizzare così- moltiplicate le due immagini pixel per pixel;- ripetete l’operazione avendo shiftato le due immagini progressivamente inx ed y;- costruite un’immagine le cui coordinate siano gli shift che sono stati applicatie riportate i valori ottenuti per la correlazione ai vari shift

104 F.Strafella- approssimate una superficie a questi valori e trovatene il massimo: le coordinatedel massimo indicano lo shift da applicare per la sovrapposizionedelle due immagini.La correlazione è la tecnica che si usa anche in spettroscopia per valutare loshift doppler delle linee spettrali. Attenzione però: lo shift doppler non è ugualea tutte le lunghezze d’onda per cui la correlazione va calcolata tra spettri espressiin funzione del logaritmo della lunghezza d’onda !“Shiftare” immaginiLa richiesta di acquisire immagini con shift diversi ci porta a ridiscutere il temadel campionamento di un’immagine: ci domandiamo che informazione si ottienee che cosa si perde dell’immagine originale se abbiamo a che fare solo con unsuo campionamento spaziale ottenuto con i nostri pixel. Ci interessa sapere selo shift delle immagini conserva il flusso e mantiene l’informazione spaziale, duecaratteristiche che noi certamente richiediamo alle nostre osservazioni e che sonocruciali se poi andiamo a sommare immagini che sono state ricentrate con uncerto shift. La Figura 3.6 illustra questo problema in modo schematico.Immaginiamo quindi di campionare, col nostro rivelatore a pixel, un’immagineche possiamo rappresentare come una funzione continua della posizione. Seteniamo presente che il seeing limita l’osservazione delle caratteristiche spazialiad alta frequenza, possiamo pensare di avere a che fare con una funzione limitatain frequenza. In queste condizioni l’analisi di Fourier ci assicura, attraverso ilcosiddetto “teorema del campionamento”, che un segnale limitato in frequenzapuò essere completamente ricostruito se viene opportunamente campionato. Inquesto caso la “ricetta” del buon campionamento dice che è necessario prelevaresegnale ad una frequenza spaziale pari almeno al doppio della frequenza di cut-offimposta dal seeing. Per. esempio, se il seeing sparpaglia la luce stellare su unascala spaziale di 0.8 arcsec noi l dove dovremmo campionare almeno ogni 0.4arcsec.Generalmente in astronomia si intende per “campionamento critico” (o campionamentodi Nyquist) quello che corrispondente a due punti per una FWHM(Full Width at Half Maximum) del disco di seeing. Nel caso di osservazioni allimite di diffrazione (p.es.: da piattaforma spaziale o utilizzando tecniche di otticaadattiva) si parlerà invece della FWHM del disco di Airy 1 . In pratica peròle immagini vengono ottenute con pixel quadrati e non circolari per cui è generalmenteconsigliabile usare la regola approssimativa di tre campionamenti perFWHM.1 La funzione di Airy descrive il fenomeno della diffrazione da parte di una apertura circolare

Dip. di Fisica @ UNISALENTO 105Figura 3.6: Sono illustrati nove pixel adiacenti (quadrati) e tre possibili posizioni(indicate dai cerchi) in cui si può venire a trovare il centroide di una immaginestellare. Si noti che se la FWHM delle immagini stellari fosse dell’ordine delpixel-size il flusso totale misurato sarebbe dipendente dalla posizione del centroiderispetto alla geometria <strong>dei</strong> pixel. In conseguenza è preferibile che più pixel sianocontenuti nella FWHM delle immagini stellari (vedi testo).A questo punto la domanda è : come ci comportiamo se lo shift che determiniamoper ricentrare un’immagine non è un numero intero di pixel ? La rispostanon è univoca e dipende da come il nostro apparato osservativo ha campionatole immagini.caso A) Se disponiamo di immagini campionate a frequenze maggiori di quella critica(sovracampionate) possiamo pensare di convolvere l’immagine campionatacon una funzione sinc di opportuna ampiezza spaziale. Questaviene determinata usando il fatto che l’immagine originale non contienefrequenze spaziali superiori alla frequenza spaziale del seeing, per cui unafunzione a box di larghezza pari a 1/FWHM può essere usata nello spaziodelle frequenze (spazio di Fourier) per delimitare lo spettro delle frequenze

106 F.Strafelladell’immagine. Siccome questa operazione corrisponde, nello spazio dell’immagine,ad una convoluzione con una funzione Sinc di periodo pari allaFWHM allora se convolviamo la nostra immagine sovracampionata conuna funzione sinc otterremo una nuova immagine che comunque rappresenteràcorrettamente l’immagine originale. Con questa tecnica possiamoquindi ricampionare le nostre immagini originali ottenute con pixel shiftatidi quantità anche frazionarie, rispettando comunque la conservazione delflusso e delle caratteristiche spaziali delle sorgenti.caso B) Se le immagini di cui disponiamo sono campionate alla frequenza critica osono addirittura sottocampionate, l’operazione di Fourier non funziona piùbene e quindi è meglio evitare ricostruzioni azzardate dell’immagine originaleattraverso la convoluzione dell’immagine campionata con una funzioneSinc. Il rischio è di non conservare il flusso e introdurre artefatti nella distribuzionespaziale dell’intensità. Conclusione: molto meglio, se possibile,shiftare le immagini di un numero di pixel interi scegliendo questo numero ilpiù vicino possibile a quello che si stima possa essere un ragionevole valoreper lo shift.Molte routines calcolano lo shift frazionario di immagini usando schemi diinterpolazione sofisticati piuttosto che la convoluzione con una Sinc. Tuttaviaqueste non necessariamente fanno un lavoro migliore dello shift intero quando sihanno immagini campionate alla frequenza critica o subcritica. Spesso si usanopolinomi di ordine n che interpolano gli n + 1 punti intorno al punto interessatodall’interpolazione (interpolazione Lagrangiana). Se n = 1 l’interpolazione èquella lineare, o bi-lineare se in due dimensioni. L’ordine dell’interpolazione puòessere aumentato e spesso si usa anche l’interpolazione bi-cubica. Per andareoltre bisogna essere cauti perchè gli schemi di interpolazione più semplici nonconservano il flusso. Ribadiamo che nel caso di immagini ben campionate tuttigli schemi funzionano bene, ma passando ad immagini campionate meno bene iproblemi crescono e conviene usare valori di shift che corrispondano ad un numerointero di pixel.3.4 L’Arte della fotometriaIn questa parte ci occuperemo delle tecniche che si usano per la fotometria dioggetti puntiformi (stelle) e per la calibrazione della fotometria a larga banda.Per altri tipi di fotometria (p.es. la fotometria di oggetti estesi) si rimanda adapprofondimenti esterni al programma di questo corso.

Dip. di Fisica @ UNISALENTO 1073.4.1 Fotometria con diaframma (aperture photometry)Al piano focale di un telescopio la luce di una stella è usualmente distribuita sualcuni pixel del rivelatore secondo una forma bidimensionale detta PSF(i, j) (daPoint Spread Function), dove i e j rappresentano indici che identificano le duecoordinate di un pixel. Il segnale raccolto S è tuttavia prodotto dalla somma <strong>dei</strong>contributi della stella Stella(i, j) e del fondo del cielo B(i, j) per cui si pone ilproblema di sottrarre quest’ultimo per valutare correttamente la brillanza dellasorgente stellare.Per differenza possiamo determinare il segnale netto S della stella comeS = ∑ i,j[Stella(i, j) + B(i, j)] − N Bdove la somma è estesa ad N pixel ed il background medio per pixel è B. Il lineadi principio il segnale dovuto alla sola stella si ottiene quando N → ∞ visto chele ali della PSF si estendono molto oltre la dimensione del seeing e quindi copronomolti pixel sull’immagine. In pratica cerchiamo di scegliere il numero di pixel Nin modo che la frazione di luce stellare che cade entro la regione prescelta non siadipendente dal particolare tempo di esposizione usato per una data immagine.Per determinare l’incertezza, teniamo conto della statistica di Poisson <strong>dei</strong>fotoni e scriviamoσ 2 S= ∑ i,j[Stella(i, j) + B(i, j) + RON 2 ] + N 2 σ 2 B (3.3)= S + N RON 2 + N B + N 2 σ 2 B (3.4)Per valutare il fondo del cielo B nel caso più semplice ci allontaniamo dallaposizione della stella e misuriamo il fondo in una regione adiacente di cielo adottandoneun valore medio da sottrarre al segnale della nostra stella. Per attenuareil problema posto dalla non uniformità del cielo si preferisce valutare la media suun anello intorno alla stella per cui se l’anello contiene N a pixel il valore mediodel fondo per pixel sarà:B = 1 ∑B(i, j)N acon un errore associatoσ 2 B = 1N 2 aa∑(B(i, j) + RON 2 )aDa quest’ultima si vede che l’errore sulla valutazione del background è moltoridotto se viene valutato utilizzando molti pixel, come spesso avviene.

108 F.StrafellaSe quindi gli errori sulla determinazione del fondo diventano trascurabili allorail rapporto segnale/rumore è dato da:S/N =S√S + N RON2 + N Bun importante risultato che abbiamo già visto prima, con la differenza che oracompare esplicitamente il numero di pixel interessati. Usando questo risultatosi può ora valutare il numero ottimale di pixel per ottenere il segnale/rumorepiù favorevole. Chiaramente il S/N tende a diminuire all’aumentare del numero<strong>dei</strong> pixel contenuti nel diaframma (l’apertura) che usiamo. Questo aspetto èparticolarmente critico per le stelle deboli tanto che, mentre per le stelle brillanticonviene aumentare l’apertura più possibile per non perdere il segnale nelle ali,per quelle deboli vale il contrario. Ma attenzione, se si stringe troppo l’aperturail numero di pixel considerati può diventare troppo piccolo per garantire unastabilità della fotometria tra frames diversi a causa della variazione della PSF dauna esposizione all’altra o anche tra una regione e l’altra della stessa immagine.Queste considerazioni portano alla tecnica, abbastanza diffusa, di considerarepiccole aperture per tutte le stelle, eccetto che per poche stelle più brillanti per lequali si usa un’apertura più grande. Le poche stelle più brillanti vengono assuntecome rappresentative della PSF dell’immagine e quindi la fotometria fatta usandoaperture più piccole sulle stelle più deboli può essere successivamente correttaper la parte di area della PSF che viene tagliata dall’apertura scelta (aperturecorrected photometry).In questo ultimo caso il rapporto S/N viene migliorato per il fatto che usiamol’informazione supplementare sulla forma della PSF che possiamo ottenere dallesorgenti più brillanti nel campo.Se conosciamo bene la PSF e la posizione (centroide) della nostra sorgentepossiamo, utilizzando argomenti legati ai minimi quadrati, ricavare che:σ S = S + N eff (B + RON 2 )doveN eff =1∑ PSF 2(i, j)Si noti che il rapporto S/N sarà effettivamente aumentato solo se la PSFche abbiamo valutato sulle stelle brillanti è effettivamente la PSF applicabile atutte le stelle dell’immagine. Questo ci porta naturalmente a considerare ora ilcaso di campi stellari molto affollati in cui l’apertura non può mai essere sceltamolto ampia per evitare di mescolare la luce di una data sorgente con quella

Dip. di Fisica @ UNISALENTO 109proveniente da altre sorgenti adiacenti. In questi casi la fotometria di apertura èsconsigliabile e dobbiamo usare un approccio diverso basato sulla PSF valutatasulle stelle brillanti.3.4.2 Campi affollati (Crowding)La tecnica a cui abbiamo accennato nel precedente paragrafo è tanto meno consigliabilequanto più la densità superficiale delle stelle in una immagine cresce. Siparla in questo caso di “affollamento” (crowding) del campo, cosa che porta a dueconseguenze: le immagini stellari si sovrappongono in parte e le regioni anulari sucui si valuta il fondo del cielo contengono stelle. In queste condizioni è necessarioutilizzare opportuni accorgimenti che permettano di ottenere comunque unafotometria delle singole sorgenti in campi affollati (crowded field photometry).In queste applicazioni l’idea di base è di cercare di sfruttare la conoscenza dellaPSF per ottenere simultaneamente la brillanza di tutte le stelle che si affollano(anche sovrapponendosi in parte) in una data regione dell’immagine. In pocheparole la tecnica consiste nel realizzare una sequenza di operazioni che nell’ordinesono:- Identificazione delle stelle. Si tratta di trovare, in modo automatico,le posizioni delle stelle sull’immagine utilizzando i picchi del segnale2-dimensionale. Naturalmente in questa fase sarà importante considerarela fluttuazione del fondo del cielo per cui si definirà una soglia di rumore aldisotto della quale eventuali picchi non hanno senso. In modo più attento sipuò dire che, tra tutti i picchi di segnale che sono rappresentati nell’immaginecerchiamo di selezionare solo quelli che più somigliano ad una immaginestellare (PSF, vedi punto successivo). Per svolgere questo compito vi sonodiverse tecniche, la più diffusa delle quali è quella di usare una specie diwavelet che convolve l’immagine per cercare le posizioni <strong>dei</strong> picchi significativi(fuori dal rumore). Questa fase è poi seguita da una selezione <strong>dei</strong>picchi sulla base di criteri di “sharpness” e “roundness” che distinguono leimmagini di stelle da immagini di oggetti estesi, di raggi cosmici, di difettidel rivelatore, ecc. Alla fine, per avere una lista con le posizioni <strong>dei</strong> soli oggettiche appaiono stellari, bisognerà escludere gli oggetti spuri sulla basedel rispetto <strong>dei</strong> criteri stabiliti di roundness e sharpness.Point Spread Function (PSF) che caratterizza l’immagine . Perquesto si utilizzano le stelle più isolate e brillanti dell’immagine, riportandoin una tabella il segnale letto sui vari pixel il cui segnale sia dovuto allestelle prescelte. Siccome il posizionamento <strong>dei</strong> picchi (che abbiamo anche

110 F.Strafellachiamato centroidi) delle stelle rispetto ai pixel del rivelatore è vario, è necessariodeterminare una funzione che interpoli accuratamente tra i valoritabulati per ricavare una em PSF analitica da utilizzare nella stima dellebrillanze di tutte le altre stelle. Siccome si tratta pur sempre di unaapprossimazione sarà utile memorizzare anche i residui ottenuti dopo averfittato la PSF analitica. Se questi residui sono sistematici, cioe’ se tuttele stelle mostrano le stesse deviazioni dalla funzione analitica, è opportunoregistrarli in una tabella (detta “look-up table”) che potrà poi essere usataper correggere il risultato ottenuto fittando la funzione analitica su tutte lesorgenti del campo. Un esempio di come si presenta una PSF è mostratoin Figura 3.7 in cui sono evidenti le differenze tra una funzione analiticaregolare e la realtà del segnale ottenuto.Figura 3.7: Point Spread Function (PSF) di due immagini ottenute con duestrumenti diversi e corrispondenti ad oggetti stellari. Si noti che nella figura inalto compare un piccolo oggetto visibile sotto la sorgente astronomica: la suaestensione angolare molto più piccola rispetto alla PSF ed è quindi consideratocome un artefatto.

Dip. di Fisica @ UNISALENTO 111Raggruppare le stelle in “cluster”. In linea di principio si dovrebberocontemporaneamente fittare tutte le stelle in una immagine perche’ in teoriale ali nel segnale prodotto da una stella coinvolgono l’intera immagine.Tuttavia, siccome il fit implica un processo iterativo che richiede un tempotanto maggiore quante più stelle si vogliono risolvere contemporaneamente,è necessario raggrupparle in cluster che vengono poi considerati uno allavolta. Un criterio ragionevole per farlo è di determinare le zone in cui lestelle si sovrappongono di più rispetto all’ambiente adiacente. In questomodo il bordo di un cluster è scelto in modo che la luce delle stelle piùvicine al bordo non influenzi molto la brillanza delle stelle del cluster.Approssimazione del profilo stellare Per ogni cluster si vanno a “fittare”simultaneamente le brillanze stellari e le posizioni usando una primastima ottenuta adattando la PSF alle posizioni delle stelle che sono stateindividuate in fase di rivelazione (detta di “detection”). Prima di fittare laPSF ad una singola stella però bisognerà aver cura di sottrarre il contributodelle stelle adiacenti alla brillanza <strong>dei</strong> pixel interessati dal fit della datasorgente. Questo contributo stimato proprio utilizzando la forma della PSFche abbiamo ottenuto nei passi precedenti. Una volta ottenuta una stimadella brillanza delle stelle, avendo sottratto il contributo delle stelle adiacenti,si possono sottrarre le singole stelle dall’immagine originale, ottenendoin questo modo un’immagine <strong>dei</strong> residui che potrà essere opportunamenteutilizzata per raffinare la nostra fotometria attraverso una nuova iterazionedell’operazione di fit fino ad ottenere una soluzione soddisfacente.- Sottigliezze: nella stima del cielo si potrà usare la regolasky = 3 ∗ mediana − 2 ∗ mediache tiene conto della difficoltà che si ha in campi affollati nell’avere un buonnumero di pixel che si trovano sul cielo e che quindi misurano il fondo. Sinoti che nel caso di distribuzioni simmetriche media e mediana coincidonoed il risultato è pari alla media.Se si itera l’intera procedura si potrà meglio definire la PSF perchè nel determinarlasi potrà anche tenere conto di eventuali contributi dalle stellevicine. Se questi contributi vengono sottratti, allora sarà possibile ottenereuna PSF più accurata. Questa stessa possibilità di sottrarre all’immagineiniziale il modello di PSF che ci siamo costruiti permette inoltre di evidenziareeventuali altre stelle deboli che ricadono spazialmente sulle ali delleimmagini di stelle più brillanti.

112 F.StrafellaCompletezza: dare la “completezza” della nostra fotometria significa dareun valore della brillanza che risponde alla domanda: “qual’è la brillanzadelle stelle pi˘’ deboli che riusciamo a rivelare al 100%, cioè senza perderne?”. È intuitivo che ci sarà un limite di brillanza al disotto del quale nonriusciamo a rivelare tutte le stelle. Si intuisce infatti che una sorgente debolesarà più probabilmente rivelata se è isolata piuttosto che in condizionidi crowding. La completezza quindi dipende non solo dalla sensibilità <strong>dei</strong>nostri strumenti di osservazine, ma anche dal tipo di campo che andiamoad indagare. In genere la magnitudine di completezza di una fotometriasi giudica a partire da un istogramma logaritmico delle magnitudini stellari.In Figura 3.8 si vede un simile diagramma che mostra un andamentolineare per una gran parte dell’intervallo di magnitudini fino a cambiareandamento per valori che superano un dato limite (detto magnitudine dicompletezza). L’altra indicazione data da questa figura è la magnitudinelimite che corrisponde alla più piccola brillanza rivelata.Figura 3.8: Istogramma delle magnitudini per un campo osservato a 4 lunghezzed’onda (indicate su ogni diagramma). Il numero di stelle con una data magnitudineè mostrato con la linea continua. Si noti come questo numero crescalinearmente all’aumentare della magnitudine (cioè al diminuire della brillanza) finoad un valore di magnitudine, detto magnitudine di completezza (linea verticaletratteggiata) oltre il quale l’andamento non è più lineare. La magnitudine limitedi queste osservazioni corrisponde al limite massimo <strong>dei</strong> valori di magnitudineriportati (vedi testo).

Dip. di Fisica @ UNISALENTO 1133.4.3 Estinzione atmosfericaAbbiamo già incontrato (nella prima parte delle lezioni) questo tema dell’estinzionedella luce causata da scattering e assorbimento nell’atmosfera terrestre. SeF λ ed F λ0 sono rispettivamente il flusso osservato ad una data lunghezza d’ondaed il corrispondente flusso incidente al di fuori dell’atmosferaF λ = F λ0 e −[X τ λ(z=0)](3.5)dove con X, z e τ λ (z = 0) abbiamo rispettivamente indicato la massa d’ariadell’osservazione, l’angolo zenitale , e la profondità ottica (o spessore ottico) dell’atmosferain direzione dello zenit. Questa relazione in termini di magnitudini siriscrive:m λ = m λ0 + 1.086 τ λ (z = 0)X = m 0 + κ λ X (3.6)dove con κ λ abbiamo indicato il coefficiente di assorbimento. Come si è già dettoκ λ può variare da notte a notte cosicchè , se siamo interessati ad una fotometriaaccurata (migliore di ∆F/F 2%), il coefficiente di assorbimento va misuratocon una certa frequenza: se le condizioni atmosferiche sono buone almeno unavolta ogni notte, altrimenti anche di più.Il coefficiente di estinzione κ può essere determinato facendo una serie dimisure F di una stella a differenti masse d’aria X. Questo permette di ottenereun grafico di m in funzione di X da cui si potrà ricavare m 0 e κ usando un fitai minimi quadrati della equazione 3.6 . Nel far questo è buona norma cercaredi ottenere misure su un grande intervallo di masse d’aria per meglio definire laretta fittante e per comprendere all’interno di questo intervallo le masse d’aria acui si sono ottenute le osservazioni degli oggetti in studio.Tuttavia, nel lavorare con filtri a larga banda entra in gioco una altra accortezzache è necessario considerare se si vuole ottenere una fotometria accurata.Si tratta di considerare il fatto che entro un filtro a banda larga la lunghezzad’onda della radiazione può cambiare notevolmente e quindi anche il coefficientedi estinzione da applicare può essere una quantità che varia sensibilmente entrola banda passante. Siccome stelle fredde e calde hanno una diversa proporzionetra radiazione a corte e lunghe lunghezze d’onda, ne discende che osservando duestelle di colore diverso (e quindi diverso tipo spettrale) potremmo ottenere valoridiversi per il coefficiente di estinzione, pur utilizzando lo stesso filtro.Questo inconveniente si supera se si introduce una correzione, detta di “secondoordine”, che sia funzione non solo della lunghezza d’onda ma anche delcolore della stella:m λ = m λ0 + κ λ X + κ ′ colore X (3.7)