(1/4) :*: c' (1/4) - Technische Fakultät - Universität Bielefeld

(1/4) :*: c' (1/4) - Technische Fakultät - Universität Bielefeld

(1/4) :*: c' (1/4) - Technische Fakultät - Universität Bielefeld

Erfolgreiche ePaper selbst erstellen

Machen Sie aus Ihren PDF Publikationen ein blätterbares Flipbook mit unserer einzigartigen Google optimierten e-Paper Software.

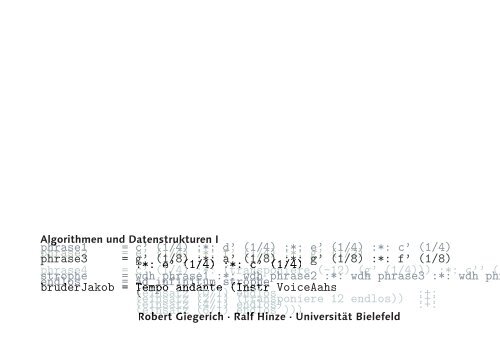

Algorithmen und Datenstrukturen I<br />

phrase1<br />

phrase2<br />

=<br />

c’<br />

e’<br />

c’<br />

e’<br />

c’ (1/4)<br />

(1/4)<br />

(1/4)<br />

(1/4)<br />

(1/4) :*:<br />

:*:<br />

:*:<br />

:*:<br />

:*: d’<br />

f’<br />

d’<br />

f’<br />

d’ (1/4)<br />

(1/4)<br />

(1/4)<br />

(1/4)<br />

(1/4) :*:<br />

:*:<br />

:*:<br />

:*:<br />

:*: e’<br />

g’<br />

e’<br />

g’<br />

e’ (1/4)<br />

(1/2)<br />

(1/4)<br />

(1/2)<br />

(1/4) :*: c’ (1/4)<br />

phrase3 = g’<br />

e’<br />

g’<br />

e’<br />

g’ (1/8)<br />

(1/4)<br />

(1/8)<br />

(1/4)<br />

:*:<br />

:*:<br />

:*:<br />

:*:<br />

a’<br />

f’<br />

a’<br />

f’<br />

(1/8)<br />

(1/4)<br />

(1/8)<br />

(1/4)<br />

:*:<br />

:*:<br />

:*:<br />

:*:<br />

g’<br />

g’<br />

g’<br />

g’<br />

(1/8)<br />

(1/2)<br />

(1/8)<br />

(1/2)<br />

:*:<br />

g’<br />

e’<br />

g’<br />

e’<br />

(1/8)<br />

(1/4)<br />

(1/8)<br />

(1/4)<br />

e’ (1/4)<br />

:*:<br />

:*:<br />

:*:<br />

:*:<br />

a’<br />

:*:<br />

a’<br />

f’<br />

a’<br />

f’<br />

(1/8)<br />

(1/4)<br />

(1/8)<br />

(1/4)<br />

c’ (1/4)<br />

:*:<br />

:*:<br />

:*:<br />

:*:<br />

g’<br />

g’<br />

g’<br />

g’<br />

(1/8)<br />

(1/2)<br />

(1/8)<br />

(1/2)<br />

:*:<br />

g’<br />

e’<br />

g’<br />

(1/4)<br />

(1/8)<br />

(1/4)<br />

(1/8)<br />

:*:<br />

e’ (1/4)<br />

:*:<br />

:*:<br />

:*:<br />

f’<br />

:*:<br />

a’<br />

f’<br />

a’<br />

(1/4)<br />

(1/8)<br />

(1/4)<br />

(1/8)<br />

:*: g’ (1/2)<br />

c’ (1/4)<br />

:*:<br />

:*:<br />

:*: g’<br />

g’<br />

g’ (1/8)<br />

(1/2)<br />

(1/8) :*: f’ (1/8)<br />

phrase4 = c’<br />

:*:<br />

(1/8) :*: a’ (1/8) :*: g’ (1/8) :*: f’ (1/8)<br />

c’<br />

:*:<br />

g’<br />

:*:<br />

g’ (1/8)<br />

(1/4)<br />

e’ (1/4)<br />

:*:<br />

:*: (transponiere<br />

:*:<br />

(transponiere<br />

:*:<br />

a’<br />

:*:<br />

a’ (1/8)<br />

c’ (1/4)<br />

:*: g’ (1/8) :*: f’ (1/8)<br />

c’<br />

:*:<br />

g’ (1/8)<br />

(1/4)<br />

e’ (1/4)<br />

:*: a’<br />

:*: (transponiere<br />

:*:<br />

a’ (1/8)<br />

c’ (1/4)<br />

:*: g’ (1/8) :*: f’ (1/8)<br />

strophe<br />

phrase4<br />

strophe<br />

phrase4<br />

= wdh<br />

c’<br />

wdh<br />

c’ (1/4)<br />

phrase1<br />

:*:<br />

:*:<br />

(transponiere<br />

wdh phrase2<br />

(-12)<br />

:*: wdh<br />

(g’<br />

phrase3<br />

(1/4)))<br />

:*:<br />

:*:<br />

wdh<br />

c’’<br />

phr<br />

(1<br />

endlos<br />

strophe<br />

endlos<br />

strophe<br />

= wdh phrase1 :*: wdh phrase2 :*: wdh phrase3 :*: wdh phr<br />

phrase1 c’ (1/4) :*: d’ (1/4) :*: e’ (1/4) :*: c’ (1/4)<br />

ad_infinitum<br />

wdh phrase1 :*:<br />

strophe<br />

wdh phrase2 :*: wdh phrase3 :*: wdh phr<br />

bruderJakob<br />

endlos<br />

bruderJakob<br />

endlos<br />

wdh phrase1 :*: wdh phrase2 :*: wdh phrase3 :*: wdh phr<br />

= Tempo<br />

ad_infinitum<br />

Tempo<br />

ad_infinitum<br />

wdh<br />

ad_infinitum<br />

wdh phrase1 :*:<br />

andante<br />

strophe<br />

wdh phrase2 :*: wdh phrase3 :*: wdh phr<br />

Tempo<br />

ad_infinitum<br />

wdh phrase1 :*:<br />

andante<br />

strophe<br />

wdh phrase2 :*: wdh phrase3 :*: wdh phr<br />

Tempo<br />

(<br />

Tempo<br />

ad_infinitum<br />

Tempo<br />

ad_infinitum<br />

andante<br />

strophe<br />

(<br />

Tempo<br />

ad_infinitum<br />

Tempo<br />

ad_infinitum<br />

Tempo<br />

ad_infinitum<br />

Tempo<br />

ad_infinitum<br />

Tempo andante<br />

strophe<br />

einsatz<br />

andante<br />

strophe<br />

einsatz<br />

andante<br />

strophe<br />

(0/1)<br />

(Instr<br />

endlos<br />

VoiceAahs<br />

(einsatz<br />

(<br />

(einsatz<br />

(<br />

Tempo<br />

(<br />

Tempo andante (Instr VoiceAahs<br />

(einsatz<br />

(<br />

Tempo<br />

einsatz<br />

andante<br />

(0/1)<br />

(Instr VoiceAahs<br />

(einsatz<br />

einsatz<br />

andante<br />

(0/1)<br />

(Instr<br />

(2/1)<br />

endlos<br />

VoiceAahs<br />

(einsatz<br />

einsatz<br />

andante<br />

(0/1)<br />

(Instr<br />

(2/1)<br />

endlos<br />

VoiceAahs<br />

(einsatz (2/1) (transponiere 12 endlos))<br />

:+:<br />

(einsatz<br />

(einsatz<br />

(4/1)<br />

(2/1)<br />

endlos)<br />

(transponiere 12 endlos)) :+:<br />

(einsatz<br />

(einsatz<br />

(einsatz<br />

(einsatz<br />

(einsatz<br />

(einsatz<br />

(einsatz<br />

(6/1)<br />

(4/1)<br />

(6/1)<br />

(4/1)<br />

(2/1)<br />

(4/1)<br />

(2/1)<br />

endlos<br />

endlos)<br />

endlos<br />

endlos)<br />

(transponiere<br />

endlos)<br />

(transponiere 12 endlos))<br />

(einsatz<br />

(einsatz<br />

(einsatz<br />

(6/1)<br />

(4/1)<br />

(2/1)<br />

endlos<br />

endlos)<br />

(transponiere 12 endlos))<br />

(einsatz (6/1) endlos )))<br />

:+:<br />

Robert Giegerich · Ralf Hinze · <strong>Universität</strong> <strong>Bielefeld</strong>

A&D interaktiv<br />

<strong>Universität</strong> <strong>Bielefeld</strong><br />

<strong>Technische</strong> <strong>Fakultät</strong><br />

WS 2003/2004

Inhaltsverzeichnis<br />

1. Einleitung 1<br />

1.1. Rechnen und rechnen lassen . . . . . . . . . . . . . . . . . . . . . . . . . . 1<br />

1.2. Die Aufgabengebiete der Informatik . . . . . . . . . . . . . . . . . . . . . 3<br />

1.3. Einordnung der Informatik in die Familie der Wissenschaften . . . . . . . 5<br />

2. Modellierung 7<br />

2.1. Eine Formelsprache für Musik . . . . . . . . . . . . . . . . . . . . . . . . . 7<br />

2.2. Typen als Hilfsmittel der Modellierung . . . . . . . . . . . . . . . . . . . . 11<br />

2.3. Die Rolle der Abstraktion in der Modellierung . . . . . . . . . . . . . . . . 13<br />

2.4. Modellierung in der molekularen Genetik . . . . . . . . . . . . . . . . . . 14<br />

2.5. Anforderungen an Programmiersprachen . . . . . . . . . . . . . . . . . . . 23<br />

3. Eine einfache Programmiersprache 25<br />

3.1. Datentypen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 25<br />

3.1.1. Datentypdefinitionen . . . . . . . . . . . . . . . . . . . . . . . . . . 25<br />

3.1.2. Typsynonyme . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 30<br />

3.1.3. Typdeklarationen, Typprüfung und Typinferenz . . . . . . . . . . . 30<br />

3.1.4. Typklassen und Typkontexte . . . . . . . . . . . . . . . . . . . . . . 32<br />

3.2. Wertdefinitionen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 34<br />

3.2.1. Muster- und Funktionsbindungen . . . . . . . . . . . . . . . . . . . 34<br />

3.2.2. Bewachte Gleichungen . . . . . . . . . . . . . . . . . . . . . . . . . 36<br />

3.2.3. Gleichungen mit lokalen Definitionen . . . . . . . . . . . . . . . . 37<br />

3.2.4. Das Rechnen mit Gleichungen . . . . . . . . . . . . . . . . . . . . . 40<br />

3.2.5. Vollständige und disjunkte Muster . . . . . . . . . . . . . . . . . . 41<br />

3.3. Ausdrücke . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 43<br />

3.3.1. Variablen, Funktionsanwendungen und Konstruktoren . . . . . . . 43<br />

3.3.2. Fallunterscheidungen . . . . . . . . . . . . . . . . . . . . . . . . . . 44<br />

3.3.3. Funktionsausdrücke . . . . . . . . . . . . . . . . . . . . . . . . . . 46<br />

3.3.4. Lokale Definitionen . . . . . . . . . . . . . . . . . . . . . . . . . . . 48<br />

3.4. Anwendung: Binärbäume . . . . . . . . . . . . . . . . . . . . . . . . . . . 49

ii Inhaltsverzeichnis<br />

3.5. Vertiefung: Rechnen in Haskell . . . . . . . . . . . . . . . . . . . . . . . . 53<br />

3.5.1. Eine Kernsprache/Syntaktischer Zucker . . . . . . . . . . . . . . . . 53<br />

3.5.2. Auswertung von Fallunterscheidungen . . . . . . . . . . . . . . . . 53<br />

3.5.3. Auswertung von Funktionsanwendungen . . . . . . . . . . . . . . 54<br />

3.5.4. Auswertung von lokalen Definitionen . . . . . . . . . . . . . . . . . 56<br />

4. Programmiermethodik 59<br />

4.1. Spezifikation . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 59<br />

4.2. Strukturelle Rekursion . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 62<br />

4.2.1. Strukturelle Rekursion auf Listen . . . . . . . . . . . . . . . . . . . 62<br />

4.2.2. Strukturelle Rekursion auf Bäumen . . . . . . . . . . . . . . . . . . 66<br />

4.2.3. Das allgemeine Rekursionsschema . . . . . . . . . . . . . . . . . . 67<br />

4.2.4. Verstärkung der Rekursion . . . . . . . . . . . . . . . . . . . . . . . 67<br />

4.3. Strukturelle Induktion . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 69<br />

4.3.1. Strukturelle Induktion auf Listen . . . . . . . . . . . . . . . . . . . 69<br />

4.3.2. Strukturelle Induktion auf Bäumen . . . . . . . . . . . . . . . . . . 72<br />

4.3.3. Das allgemeine Induktionsschema . . . . . . . . . . . . . . . . . . 73<br />

4.3.4. Verstärkung der Induktion . . . . . . . . . . . . . . . . . . . . . . . 74<br />

4.3.5. Referential transparency . . . . . . . . . . . . . . . . . . . . . . . . 76<br />

4.4. Anwendung: Sortieren durch Fusionieren . . . . . . . . . . . . . . . . . . 76<br />

4.4.1. Phase 2: Sortieren eines Binärbaums . . . . . . . . . . . . . . . . . 76<br />

4.4.2. Phase 1: Konstruktion von Braun-Bäumen . . . . . . . . . . . . . . 78<br />

4.5. Wohlfundierte Rekursion . . . . . . . . . . . . . . . . . . . . . . . . . . . . 80<br />

4.5.1. Das Schema der wohlfundierten Rekursion . . . . . . . . . . . . . . 80<br />

4.6. Vertiefung: Wohlfundierte Induktion . . . . . . . . . . . . . . . . . . . . . 82<br />

5. Effizienz und Komplexität 85<br />

5.1. Grundlagen der Effizienzanalyse . . . . . . . . . . . . . . . . . . . . . . . . 85<br />

5.1.1. Maßeinheiten für Zeit und Raum beim Rechnen . . . . . . . . . . . 85<br />

5.1.2. Detaillierte Analyse von insertionSort . . . . . . . . . . . . . . 86<br />

5.1.3. Asymptotische Zeit- und Platzeffizienz . . . . . . . . . . . . . . . . 89<br />

5.2. Effizienz strukturell rekursiver Funktionen . . . . . . . . . . . . . . . . . . 92<br />

5.3. Effizienz wohlfundiert rekursiver Funktionen . . . . . . . . . . . . . . . . . 97<br />

5.4. Problemkomplexität . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 98<br />

5.5. Anwendung: Optimierung von Programmen am Beispiel mergeSort . . . 101<br />

5.5.1. Varianten der Teile-Phase . . . . . . . . . . . . . . . . . . . . . . . 102<br />

5.5.2. Berücksichtigung von Läufen . . . . . . . . . . . . . . . . . . . . . 106<br />

5.6. Datenstrukturen mit konstantem Zugriff: Felder . . . . . . . . . . . . . . . 107<br />

5.7. Anwendung: Ein lineares Sortierverfahren . . . . . . . . . . . . . . . . . . 112<br />

5.8. Vertiefung: Rolle der Auswertungsreihenfolge . . . . . . . . . . . . . . . . 115

Inhaltsverzeichnis iii<br />

6. Abstraktion 117<br />

6.1. Listenbeschreibungen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 117<br />

6.2. Funktionen höherer Ordnung . . . . . . . . . . . . . . . . . . . . . . . . . 121<br />

6.2.1. Funktionen als Parameter . . . . . . . . . . . . . . . . . . . . . . . 121<br />

6.2.2. Rekursionsschemata . . . . . . . . . . . . . . . . . . . . . . . . . . 125<br />

6.2.3. foldr und Kolleginnen . . . . . . . . . . . . . . . . . . . . . . . . 128<br />

6.2.4. map und Kolleginnen . . . . . . . . . . . . . . . . . . . . . . . . . . 133<br />

6.3. Typklassen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 137<br />

6.3.1. Typpolymorphismus und Typklassen . . . . . . . . . . . . . . . . . 137<br />

6.3.2. class- und instance-Deklarationen . . . . . . . . . . . . . . . . 140<br />

6.3.3. Die Typklassen Eq und Ord . . . . . . . . . . . . . . . . . . . . . . 141<br />

6.3.4. Die Typklassen Show und Read . . . . . . . . . . . . . . . . . . . . 143<br />

6.3.5. Die Typklasse Num . . . . . . . . . . . . . . . . . . . . . . . . . . . 145<br />

6.4. Anwendung: Sequenzen . . . . . . . . . . . . . . . . . . . . . . . . . . . . 148<br />

6.4.1. Klassendefinition . . . . . . . . . . . . . . . . . . . . . . . . . . . . 148<br />

6.4.2. Einfache Instanzen . . . . . . . . . . . . . . . . . . . . . . . . . . . 150<br />

6.4.3. Generische Instanzen . . . . . . . . . . . . . . . . . . . . . . . . . . 152<br />

6.4.4. Schlangen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 152<br />

6.4.5. Konkatenierbare Listen . . . . . . . . . . . . . . . . . . . . . . . . . 154<br />

A. Lösungen aller Übungsaufgaben 155<br />

B. Mathematische Grundlagen<br />

oder: Wieviel Mathematik ist nötig? 167<br />

B.1. Mengen und Funktionen . . . . . . . . . . . . . . . . . . . . . . . . . . . . 167<br />

B.1.1. Der Begriff der Menge . . . . . . . . . . . . . . . . . . . . . . . . . 167<br />

B.1.2. Der Begriff der Funktion . . . . . . . . . . . . . . . . . . . . . . . . 169<br />

B.2. Relationen und Halbordnungen . . . . . . . . . . . . . . . . . . . . . . . . 169<br />

B.3. Formale Logik . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 170<br />

B.3.1. Aussagenlogik . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 170<br />

B.3.2. Prädikatenlogik . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 171<br />

B.3.3. Natürliche und vollständige Induktion . . . . . . . . . . . . . . . . 172

iv Inhaltsverzeichnis

1. Einleitung<br />

1.1. Rechnen und rechnen lassen<br />

Man kann vorzüglich Rechnen lernen, ohne sich jemals zu fragen, was denn das Rechnen<br />

vom sonstigen Gebrauch des Verstandes unterscheidet. Wir stellen diese Frage jetzt und<br />

betrachten dazu das Rechnen so wie es uns im Leben zuerst begegnet — als Umgang mit<br />

den Zahlen. Wir werden also die Natur des Rechnens an der Arithmetik studieren, und<br />

dabei am Ende feststellen, daß die Zahlen bei weitem nicht das Einzige sind, womit wir<br />

rechnen können.<br />

Zweifellos ist Rechnen ein besonderer Gebrauch des Verstandes. Eine gewisse Ahnung<br />

vom Unterschied zwischen Denken im allgemeinen und Rechnen im besonderen hat jeder,<br />

der einmal mit seinem Mathematiklehrer darüber diskutiert hat, ob der Fehler in seiner<br />

Schularbeit „bloß“ als Rechenfehler, oder aber als „logischer“ Fehler einzuordnen sei. Grit Garbo ist Mathematikerin der alten Schule. Für sie gibt es<br />

Richtig Rechnen heißt Anwendung der Rechenregeln für Addition, Multiplikation etc.<br />

Dies allein garantiert das richtige Ergebnis — und neben ihrer Beachtung und Anwendung<br />

ist als einzige weitere Verstandesleistung die Konzentration auf diese eintönige Tätigkeit<br />

gefragt. Kein Wunder, daß nur wenige Menschen zum Zeitvertreib siebenstellige Zahlen<br />

multiplizieren! 1<br />

Damit soll nicht etwa das Rechnen diffamiert werden — es entspricht so gerade der<br />

Natur dessen, worum es dabei geht, nämlich den Zahlen. Diese sind Größen, abstrakte<br />

Quantitäten ohne sonstige Eigenschaft. Bringe ich sie in Verbindung, ergeben sich neue,<br />

andere Größen, aber keine andere Qualität. Der Unterschied von 15 und 42 ist 27, und<br />

daraus folgt — nichts. Die mathematische Differenz zweier Größen ist, so könnte man<br />

sagen, der unwesentliche Unterschied.<br />

Nur zum Vergleich: Stelle ich meinen Beitrag zum Sportverein und meine Einkommenssteuer<br />

einander gegenüber, so ergibt sich auch ein Unterschied im Betrag. Daneben aber<br />

auch einer in der Natur der Empfänger, dem Grad der Freiwilligkeit, meine Einflußmöglichkeiten<br />

auf die Verwendung dieser Gelder und vieles andere mehr. Dies sind wesentliche<br />

Unterschiede, aus ihnen folgt allerhand. Unter anderem erklären sie auch die Differenz<br />

der Beträge, und rechnen sie nicht bloß aus.<br />

Für das Rechnen jedoch spielt es keine Rolle, wovon eine Zahl die Größe angibt. Jede<br />

sonstige Beschaffenheit der betrachteten Objekte ist für das Rechnen mit ihrer Größe oh-<br />

1 Denkaufgabe: Was folgt daraus, wenn einer gut rechnen kann?<br />

eigentlich keine Wissenschaft der Informatik — soweit Informatik<br />

wissenschaftlich ist, gehört sie zur Mathematik, alles andere<br />

ist Ingeniertechnik oder Programmierhandwerk. Fragen der<br />

Programmiersprachen oder des Software Engineering sieht sie<br />

als bloße Äußerlichkeiten an. Sie kann es nicht ganz verschmerzen,<br />

daß die Mathematik von ihrer Tochter Informatik heute in<br />

vielerlei Hinsicht überflügelt wird.

Harry Hacker ist ein alter Programmierfuchs, nach dem Motto:<br />

Eine Woche Programmieren und Testen kann einen ganzen<br />

Nachmittag Nachdenken ersetzen. Er ist einfallsreich und ein<br />

gewitzter Beobachter; allerdings liegt er dabei oft haarscharf<br />

neben der Wahrheit. Zu Programmiersprachen hat er eine dezidiert<br />

subjektive Haltung: Er findet die Sprache am besten, die<br />

ihm am besten vertraut ist.<br />

2 1. Einleitung<br />

ne Belang. Deshalb kann das Rechnen in starre Regeln gegossen werden und nimmt darin<br />

seinen überraschungsfreien Verlauf. Die kreative gedankliche Leistung liegt woanders: Sie<br />

manifestiert sich in der Art und Weise, wie man die abstrakten Objekte der Zahlen konkret<br />

aufschreibt. Wir sind daran gewöhnt, das arabische Stellenwertsystem zu verwenden.<br />

Dieses hat sich im Laufe der Geschichte durchgesetzt, da sich darauf relativ einfach Rechenregeln<br />

definieren und auch anwenden lassen. Das römische Zahlensystem mit seinen<br />

komplizierten Einheiten und der Vor- und Nachstellung blieb auf der Strecke: Den Zahlen<br />

XV und XLII sieht man den Unterschied XXVII nicht an. Insbesondere das Fehlen eines<br />

Symbols für die Null macht systematisches Rechnen unmöglich — gerade wegen der Null<br />

war das Rechnen mit den arabischen Zahlen im Mittelalter von der Kirche verboten.<br />

Einstweiliges Fazit: Das Rechnen ist seiner Natur nach eine äußerliche, gedankenlose, in<br />

diesem Sinne mechanische Denktätigkeit. Kaum hatte die Menschheit Rechnen gelernt,<br />

schon tauchte die naheliegende Idee auf, das Rechnen auf eine Maschine zu übertragen.<br />

Die Geschichte dieser Idee — von einfachen Additionsmaschinen bis hin zu den ersten<br />

programmgesteuerten Rechenautomaten — ist an vielen Stellen beschrieben worden und<br />

soll hier nicht angeführt werden. An ihrem Endpunkt steht der Computer, der bei entsprechender<br />

Programmierung beliebig komplexe arithmetische Aufgaben lösen kann —<br />

schneller als wir, zuverlässiger als wir und (für uns) bequemer.<br />

Wenn dieses Gerät existiert, stellt sich plötzlich eine ganz neue Frage: Jetzt, wo wir<br />

rechnen lassen können, wird es interessant, Aufgaben in Rechenaufgaben zu verwandeln,<br />

die es von Natur aus nicht sind (und die wir mit unserem Verstand auch nie so behandeln<br />

würden). Es gilt, zu einer Problemstellung die richtigen Abstraktionen zu finden, sie durch<br />

Formeln und Rechengesetze, genannt Datenstrukturen und Algorithmen, so weitgehend<br />

zu erfassen, daß wir dem Ergebnis der Rechnung eine Lösung des Problems entnehmen<br />

können. Wir bilden also abstrakte Modelle der konkreten Wirklichkeit, die diese im Falle<br />

der Arithmetik perfekt, in den sonstigen Fällen meist nur annähernd wiedergeben. Die<br />

Wirklichkeitstreue dieser Modelle macht den Reiz und die Schwierigkeit dieser Aufgabe,<br />

und die Verantwortung des Informatikers bei der Software-Entwicklung aus.<br />

Die eigentümliche Leistung der Informatik ist es also, Dinge in Rechenaufgaben zu verwandeln,<br />

die es von Natur aus nicht sind. Die Fragestellung „Was können wir rechnen<br />

lassen?“, ist neu in der Welt der Wissenschaften — deshalb hat sich die Informatik nach<br />

der Konstruktion der ersten Rechner schnell aus dem Schoße der Mathematik heraus zu<br />

einer eigenständigen Disziplin entwickelt. Die Erfolge dieser Bemühung sind faszinierend,<br />

und nicht selten, wenn auch nicht ganz richtig, liest man darüber in der Zeitung: „Computer<br />

werden immer schlauer“.

1.2. Die Aufgabengebiete der Informatik 3<br />

1.2. Die Aufgabengebiete der Informatik<br />

Informatik ist die Wissenschaft vom maschinellen Rechnen. Daraus ergeben sich verschiedene<br />

Fragestellungen, in die sich die Informatik aufgliedert.<br />

Zunächst muß sie sich um die Rechenmaschine selbst kümmern. In der <strong>Technische</strong>n Informatik<br />

geht es um Rechnerarchitektur und Rechnerentwurf, wozu auch die Entwicklung<br />

von Speichermedien, Übertragungskanälen, Sensoren usw. gehören. Der Fortschritt dieser<br />

Disziplin besteht in immer schnelleren und kleineren Rechnern bei fallenden Preisen. In<br />

ihren elementaren Operationen dagegen sind die Rechner heute noch so primitiv wie zur<br />

Zeit ihrer Erfindung. Diese für den Laien überraschende Tatsache erfährt ihre Erklärung in<br />

der theoretischen Abteilung der Informatik. Lisa Lista ist die ideale Studentin, den Wunschvorstellungen ei-<br />

Mit der Verfügbarkeit der Computer erfolgt eine Erweiterung des Begriffs „Rechnen“.<br />

Das Rechnen mit den guten alten Zahlen ist jetzt nur noch ein hausbackener Sonderfall.<br />

Jetzt werden allgemeinere Rechenverfahren entwickelt, genannt Algorithmen, die<br />

aus Eingabe-Daten die Ausgabe-Daten bestimmen. Aber — was genau läßt sich rechnen,<br />

und was nicht? Mit welcher Maschine? Die Theoretische Informatik hat diese Frage beantwortet<br />

und gezeigt, daß es nicht berechenbare Probleme 2 gibt, d.h. Aufgaben, zu deren<br />

Lösung es keinen Algorithmus gibt. Zugleich hat sie gezeigt, daß alle Rechner prinzipiell<br />

gleichmächtig sind, sofern sie über einige wenige primitive Operationen verfügen. Dagegen<br />

erweisen sich die berechenbaren Aufgaben als unterschiedlich aufwendig, so daß die<br />

Untersuchung des Rechenaufwands, Komplexitätstheorie, heute ein wichtiges Teilgebiet<br />

der Theoretischen Informatik darstellt.<br />

Zwischen den prinzipiellen Möglichkeiten des Rechnens und dem Rechner mit seinen<br />

primitiven Operationen klafft eine riesige Lücke. Die Aufgabe der Praktischen Informatik<br />

ist es, den Rechner für Menschen effektiv nutzbar zu machen. Die „semantische Lücke“<br />

wird Schicht um Schicht geschlossen durch Programmiersprachen auf immer höherer Abstraktionsstufe.<br />

Heute können wir Algorithmen auf der Abstraktionsstufe der Aufgabenstellung<br />

entwickeln und programmieren, ohne die ausführende Maschine überhaupt zu<br />

kennen. Dies ist nicht nur bequem, sondern auch wesentliche Voraussetzung für die Übertragbarkeit<br />

von Programmen zwischen verschiedenen Rechnern. Ähnliches gilt für die Benutzung<br />

der Rechner (Betriebssysteme, Benutzeroberflächen), für die Organisation großer<br />

Datenmengen (Datenbanken) und sogar für die Kommunikation der Rechner untereinander<br />

(Rechnernetze, Verteilte Systeme). Das World Wide Web (WWW) ist das jüngste und<br />

bekannteste Beispiel für das Überbrücken der semantischen Lücke: Es verbindet einfach-<br />

2 Man kann solche Aufgaben auch als Ja/Nein-Fragestellungen formulieren und nennt sie dann „formal unentscheidbare“<br />

Probleme. Läßt man darin das entscheidende Wörtchen „formal“ weg, eröffnen sich tiefsinnige,<br />

aber falsche Betrachtungen über Grenzen der Erkenntnis.<br />

nes überarbeitetenn Hochschullehrers entsprungen. Sie ist unvoreingenommen<br />

und aufgeweckt, greift neue Gedanken auf<br />

und denkt sie in viele Richtungen weiter. Kein Schulunterricht<br />

in Informatik hat sie verdorben. Lisa Lista ist 12 Jahre alt.

Peter Paneau ist Professor der Theoretischen Informatik. Er<br />

sieht die Informatik im wesentlichen als eine formale Disziplin.<br />

Am vorliegenden Text stört ihn die saloppe Redeweise und die<br />

Tatsache, daß viele tiefgründige theoretische Probleme grob vereinfacht<br />

oder einfach umgangen werden. An solchen Stellen erhebt<br />

er mahnend der Zeigefinger . . .<br />

4 1. Einleitung<br />

ste Benutzbarkeit mit globalem Zugriff auf Informationen und andere Ressourcen in aller<br />

Welt. Heute bedarf es nur eines gekrümmten Zeigefingers, um tausend Computer in aller<br />

Welt für uns arbeiten zu lassen.<br />

In der Angewandten Informatik kommt endlich der Zweck der ganzen Veranstaltung<br />

zum Zuge. Sie wendet die schnellen Rechner, die effizienten Algorithmen, die höheren<br />

Programmiersprachen und ihre Übersetzer, die Datenbanken, die Rechnernetze usw. an,<br />

um Aufgaben jeglicher Art sukzessive immer vollkommener zu lösen. Je weiter die Informatik<br />

in die verschiedensten Anwendungsgebiete vordringt, desto spezifischer werden<br />

die dort untersuchten Fragen. Vielleicht werden wir bald erleben, daß sich interdisziplinäre<br />

Anwendungen als eigenständige Disziplinen von der „Kerninformatik“ abspalten.<br />

Wirtschaftsinformatik und Bioinformatik sind mögliche Protagonisten einer solchen Entwicklung.<br />

Während es früher Jahrhunderte gedauert hat, bis aus den Erfolgen der Physik<br />

zunächst die anderen Natur-, dann die Ingenieurwissenschaften entstanden, so laufen<br />

heute solche Entwicklungen in wenigen Jahrzehnten ab.<br />

Wenn die Rechner heute immer mehr Aufgaben übernehmen, für die der Mensch den<br />

Verstand benutzt, so ist insbesondere für Laien daran längst nicht mehr erkennbar, auf<br />

welche Weise dies erreicht wird. Es entsteht der Schein, daß das analoge Resultat auch<br />

in analoger Weise zustande käme. Diesen Schein nennt man künstliche Intelligenz, und<br />

seiner Förderung hat sich das gleichnamige Arbeitsfeld der Informatik gewidmet. Es lohnt<br />

sich, die Metapher von der Intelligenz des Rechners kurz genauer zu betrachten, weil<br />

sie — unter Laien wie unter Informatikern — manche Verwirrung stiftet. Es ist nichts<br />

weiter dabei, wenn man sagt, daß ein Rechner (oder genauer eine bestimmte Software)<br />

sich intelligent verhält, wenn er (oder sie) eine Quadratwurzel zieht, eine WWW-Seite<br />

präsentiert oder einen Airbus auf die Piste setzt. Schließlich wurden viele Jahre Arbeit<br />

investiert, um solche Aufgaben rechnergerecht aufzubereiten, damit der Rechner diese<br />

schneller und zuverlässiger erledigen kann als wir selbst. Nimmt man allerdings die Metapher<br />

allzu wörtlich, kommt man zu der Vorstellung, der Rechner würde dadurch selbst<br />

so etwas wie eine eigene Verständigkeit erwerben. Daraus entsteht gelegentlich sogar die<br />

widersprüchliche Zielsetzung, den Rechner so zu programmieren, daß er sich nicht mehr<br />

wie ein programmierter Rechner verhält. Der Sache nach gehört die „Künstliche Intelligenz“<br />

der Angewandten Informatik an, geht es ihr doch um die erweiterte Anwendbarkeit<br />

des Rechners auf immer komplexere Probleme. Andererseits haben diese konkreten<br />

Anwendungen für sie nur exemplarischen Charakter, als Schritte zu dem abstrakten Ziel,<br />

„wirklich“ intelligente künstliche Systeme zu schaffen. So leidet diese Arbeitsrichtung unter<br />

dem Dilemma, daß ihr Beitrag zum allgemeinen Fortschritt der Informatik vom Lärm<br />

der immer wieder metaphorisch geweckten und dann enttäuschten Erwartungen übertönt<br />

wird.<br />

Unbeschadet solch metaphorischer Fragen geht der Vormarsch der Informatik in allen<br />

Lebensbereichen voran — der „rechenbare“ Ausschnitt der Wirklichkeit wird ständig er-

1.3. Einordnung der Informatik in die Familie der Wissenschaften 5<br />

weitert: Aus Textverarbeitung wird DeskTop Publishing, aus Computerspielen wird Virtual<br />

Reality, und aus gewöhnlichen Bomben werden „intelligent warheads“. Wie gesagt: die<br />

Rechner werden immer schlauer. Und wir?<br />

1.3. Einordnung der Informatik in die Familie der<br />

Wissenschaften<br />

Wir haben gesehen, daß die Grundlagen der Informatik aus der Mathematik stammen,<br />

während der materielle Ausgangspunkt ihrer Entwicklung die Konstruktion der ersten Rechenmaschinen<br />

war. Mutter die Mathematik, Vater der Computer — wissenschaftsmoralisch<br />

gesehen ist die Informatik ein Bastard, aus einer Liebschaft des reinen Geistes mit<br />

einem technischen Gerät entstanden.<br />

Die Naturwissenschaft untersucht Phänomene, die ihr ohne eigenes Zutun gegeben<br />

sind. Die Gesetze der Natur müssen entdeckt und erklärt werden. Die Ingenieurwissenschaften<br />

wenden dieses Wissen an und konstruieren damit neue Gegenstände, die selbst<br />

wieder auf ihre Eigenschaften untersucht werden müssen. Daraus ergeben sich neue Verbesserungen,<br />

neue Eigenschaften, und so weiter.<br />

Im Vergleich dieser beiden Abteilungen der Wissenschaft steht die Informatik eher den<br />

Ingenieurwissenschaften nahe: Auch sie konstruiert Systeme, die — abgesehen von denen<br />

der <strong>Technische</strong>n Informatik — allerdings immateriell sind. Wie die Ingenieurwissenschaften<br />

untersucht sie die Eigenschaften ihrer eigenen Konstruktionen, um sie weiter zu<br />

verbessern. Wie bei den Ingenieurwissenschaften spielen bei der Informatik die Aspekte<br />

der Zuverlässigkeit und Lebensdauer ihrer Produkte eine wesentliche Rolle.<br />

Eine interessante Parallele besteht auch zwischen Informatik und Rechtswissenschaft.<br />

Die Informatik konstruiert abstrakte Modelle der Wirklichkeit, die dieser möglichst nahe<br />

kommen sollen. Das Recht schafft eine Vielzahl von Abstraktionen konkreter Individuen.<br />

Rechtlich gesehen sind wir Mieter, Studenten, Erziehungsberechtigte, Verkehrsteilnehmer,<br />

etc. Als solche verhalten wir uns entsprechend der gesetzlichen Regeln. Der Programmierer<br />

bildet reale Vorgänge in formalen Modellen nach, der Jurist muß konkrete Vorgänge<br />

unter die relevanten Kategorien des Rechts subsumieren. Die Analogie endet allerdings,<br />

wenn eine Diskrepanz zwischen Modell und Wirklichkeit auftritt: Bei einem Programmfehler<br />

behält die Wirklichkeit recht, bei einem Rechtsbruch das Recht.<br />

Eine wissenschaftshistorische Betrachtung der Informatik und ihre Gegenüberstellung<br />

mit der hier gegebenen deduktiven Darstellung ist interessant und sollte zu einem späteren<br />

Zeitpunkt, etwa zum Abschluß des Informatik-Grundstudiums, nachgeholt werden.<br />

Interessante Kapitel dieser Geschichte sind das Hilbert’sche Programm, die Entwicklung<br />

der Idee von Programmen als Daten, die oben diskutierte Idee der „Künstlichen Intelligenz“,<br />

der Prozeß der Loslösung der Informatik von der Mathematik, die Geschichte der

6 1. Einleitung<br />

Programmiersprachen, die Revolution der Anwendungssphäre durch das Erscheinen der<br />

Mikroprozessoren, und vieles andere mehr.

2. Modellierung<br />

Wir haben im ersten Kapitel gelernt: Programmieren heißt, abstrakte Modelle realer Objekte<br />

zu bilden, so daß die Rechenregeln im Modell die relevanten Eigenschaften in der<br />

Wirklichkeit adäquat nachbilden.<br />

Wir werden den Vorgang der Modellierung nun anhand von zwei Beispielen kennen<br />

lernen.<br />

2.1. Eine Formelsprache für Musik<br />

Wir haben gelernt, daß die Welt der Zahlen wegen ihres formalen Charakters die natürliche<br />

Heimat des Rechnens ist. Es gibt ein zweites Gebiet, in dem ein gewisser Formalismus<br />

in der Natur der Sache liegt: die Musik.<br />

Das Spielen eines Musikstückes mag vieles sein – ein künstlerischer Akt, ein kulturelles<br />

oder emotionales Ereignis. Im Kern jedoch steht das Musikstück – es bringt die Musikvorstellung<br />

des Komponisten in eine objektive Form und ist nichts anderes als ein Programm<br />

zur Ausführung durch einen Musiker (oder heute über eine Midi-Schnittstelle auch durch<br />

einen elektronischen Synthesizer). Wer immer als erster ein Musikstück niedergeschrieben<br />

hat, hat damit den Schritt vom Spielen zum Spielen lassen begründet.<br />

Diese kulturhistorische Leistung ist viel älter als die Idee einer Rechenmaschine. In der<br />

traditionellen Notenschrift ist der formale Anteil der Musik manifestiert. Die Modellierung<br />

ist hier also bereits erfolgt, allerdings ausschließlich im Hinblick auf die Wiedergabe durch<br />

einen menschlichen Interpreten, und nicht bis hin zur Entwicklung von dem Rechnen<br />

vergleichbaren Regeln. Zwar sind viele Gesetze z.B. der Harmonielehre bekannt, man kann<br />

sie aber in der Notenschrift nicht ausdrücken. So kann man zwar jeden Dur-Dreiklang<br />

konkret hinschreiben – aber die allgemeine Aussage, daß ein Dur-Dreiklang immer aus<br />

einem großen und einem kleinen Terz besteht, muß auf andere Art erfolgen. In diesem<br />

Abschnitt setzen wir die Notenschrift (natürlich nur einen kleinen Ausschnitt davon) in<br />

eine Formelsprache samt den zugehörigen Rechenregeln um.<br />

Musikstücke sind aus Noten zusammengesetzt, die gleichzeitig oder nacheinander gespielt<br />

werden. Jede Note hat einen Ton und eine Dauer. Dem Stück als Ganzem liegt ein<br />

bestimmter Takt zugrunde, und die Dauer einzelner Töne wird in Takt-Bruchteilen gemessen.<br />

Die Tonskala besteht aus 12 Halbtönen, die sich in jeder Oktave wiederholen.

8 2. Modellierung<br />

Wir legen das tiefe C als untersten Ton zugrunde und numerieren die Halbtöne von 0<br />

ab aufwärts. Angaben zum Spieltempo (in Taktschlägen pro Minute) und zur Wahl des<br />

Instruments werden global für ganze Musikstücke gemacht.<br />

Formeln, die Musik bedeuten, können wir uns z.B. so vorstellen:<br />

Note 0 (1/4) -- Viertelnote tiefes C<br />

Note 24 (1/1) -- ganze Note c’<br />

Pause (1/16) -- Sechzehntelpause<br />

Note 24 (1/4) :*: Note 26 (1/4) :*: Note 28 (1/4)<br />

-- Anfang der C-Dur Tonleiter<br />

Note 24 (1/4) :+: Note 28 (1/4) :+: Note 31 (1/4)<br />

-- C-Dur Akkord<br />

Tempo 40 m -- Musik m als Adagio<br />

Tempo 100 m -- Musik m als Presto<br />

Instr Oboe m -- Musik m von Oboe gespielt<br />

Instr VoiceAahs m -- Musik m gesummt<br />

Wir konstruieren nun die Formelwelt, deren Bürger die obigen Beispiele sind. Wir gehen<br />

davon aus, daß es Formeln für ganze Zahlen, Brüche und ein bißchen Arithmetik bereits<br />

gibt in der Formelwelt und führen neue Typen von Formeln ein: Ton, Dauer, Instrument<br />

und Musik.<br />

infixr 7 :*:<br />

infixr 6 :+:<br />

type GanzeZahl = Int -- Ganze Zahlen und Brueche setzen wir<br />

type Bruch = Rational -- als gegeben voraus.<br />

type Ton = GanzeZahl<br />

type Dauer = Bruch<br />

data Instrument = Oboe | HonkyTonkPiano |<br />

Cello | VoiceAahs deriving Show<br />

data Musik = Note Ton Dauer |<br />

Pause Dauer |<br />

Musik :*: Musik |<br />

Musik :+: Musik |<br />

Instr Instrument Musik |<br />

Tempo GanzeZahl Musik deriving Show<br />

Die neuen Formeltypen Ton und Dauer sind nur Synonyme für ganze Zahlen und Brüche<br />

entsprechend der besonderen Bedeutung, in der wir sie gebrauchen. Sie tragen keine<br />

neuen Formeln bei. Anders bei Instrument und Musik. Die Symbole Note, Pause,<br />

:*:, :+:, Instr, Tempo sind die Konstruktoren für neuartige Formeln, die Musikstücke<br />

darstellen. In der Formel m1 :*: m2 dürfen (und müssen!) m1 und m2 beliebige<br />

Formeln für Musikstücke sein, insbesondere selbst wieder zusammengesetzt.

2.1. Eine Formelsprache für Musik 9<br />

In Anlehnung an die Punkt-vor-Strich Regel der Algebra geben wir der Verknüpfung<br />

von Noten zu einer zeitlichen Abfolge (:*:) Vorrang vor der zeitlich parallelen Verknüpfung<br />

mehrerer Stimmen (:+:). Damit ist die Formel m1 :+: m2 :*: m3 zu lesen als<br />

m1 :+: (m2 :*: m3).<br />

Umfangreiche Musikstücke können nun als wahre Formelgebirge geschrieben werden.<br />

Zuvor erleichtern wir uns das Leben in der Formelwelt, indem wir einige Abkürzungen<br />

einführen. Etwa für die Pausen:<br />

gP = Pause (1/1)<br />

hP = Pause (1/2)<br />

vP = Pause (1/4)<br />

aP = Pause (1/8)<br />

sP = Pause (1/16)<br />

Diese Definitionen sind zugleich Rechenregeln. Sie bedeuten einerseits, daß man die<br />

neuen Symbole gP, hP, vP, aP, sP überall in Musikstücken einsetzen kann – es erweitert<br />

sich damit die Formelwelt. Zugleich kann man jedes Symbol jederzeit durch die<br />

rechte Seite der Definition ersetzen – so daß die Musikstücke in der Formelwelt nicht<br />

mehr geworden sind.<br />

Hier sind klangvolle Namen für einige Tempi:<br />

adagio = 70; andante = 90; allegro = 140; presto = 180<br />

Die üblichen Bezeichnungen für die 12 Halbtöne führen wir so ein:<br />

ce = 0; cis = 1; des = 1<br />

de = 2; dis = 3; es = 3<br />

eh = 4; eis = 5; fes = 4<br />

ef = 5; fis = 6; ges = 6<br />

ge = 7; gis = 8; as = 8<br />

ah = 9; ais = 10; be = 10<br />

ha = 11; his = 12<br />

Diese Töne sind in der untersten Oktave angesiedelt, und wir brauchen sie hier kaum.<br />

Dagegen brauchen wir eine bequeme Notation für Noten (beliebiger Dauer) aus der C-<br />

Dur Tonleiter in der dritten Oktave:<br />

c’ u = Note (ce+24) u; d’ u = Note (de+24) u<br />

e’ u = Note (eh+24) u; f’ u = Note (ef+24) u<br />

g’ u = Note (ge+24) u; a’ u = Note (ah+24) u<br />

h’ u = Note (ha+24) u; c’’ u = Note (ce+36) u<br />

Als Beispiele hier der C-Dur Akkord in neuer Schreibweise, sowie eine (rhythmisch beschwingte)<br />

C-Dur Tonleiter:

10 2. Modellierung<br />

cDurTonika = c’ (1/1) :+: e’ (1/1) :+: g’ (1/1)<br />

cDurSkala = Tempo allegro(<br />

c’ (3/8) :*: d’ (1/8) :*: e’ (3/8) :*: f’ (4/8)<br />

:*: g’ (1/8) :*: a’ (1/4) :*: h’ (1/8) :*: c’’ (1/2))<br />

Allgemein gesagt, besteht ein Dur-Dreiklang aus einen Grundton t sowie der großen<br />

Terz und der Quinte über t.<br />

Dieses Gesetz als Formel:<br />

durDreiklang t = Note t (1/1) :+: Note (t+4) (1/1) :+: Note (t+7) (1/1)<br />

Wie wär’s mit einer allgemeinen Regel zur Umkehrung eines Dreiklangs (der unterste<br />

Ton muß eine Oktave nach oben)?<br />

umk ((Note t d) :+: n2 :+: n3) = n2 :+: n3 :+: (Note (t+12) d)<br />

Als komplexe Operation auf ganzen Musikstücken betrachten wir das Transponieren.<br />

Es bedeutet, daß Töne um ein gewisses Intervall verschoben werden, während alles andere<br />

gleich bleibt. Wie muß die Rechenregel lauten, um Musikstück m um Intervall i zu<br />

transponieren? Wir geben eine Regel für jede mögliche Form von m an:<br />

transponiere i (Pause d) = Pause d<br />

transponiere i (Note t d) = Note (t+i) d<br />

transponiere i (m1 :*: m2) = (transponiere i m1) :*: (transponiere i m2)<br />

transponiere i (m1 :+: m2) = (transponiere i m1) :+: (transponiere i m2)<br />

transponiere i (Instr y m) = Instr y (transponiere i m)<br />

transponiere i (Tempo n m) = Tempo n (transponiere n m)<br />

gDurTonika = transponiere 7 cDurTonika<br />

Da das Transponieren Intervalle nicht ändert, führt es einen Dur-Dreiklang wieder in<br />

einen Dur-Dreiklang über. Es gilt folgendes Gesetz für beliebigen Grundton g und beliebiges<br />

Intervall i:<br />

transponiere i (durDreiklang t) = durDreiklang(t+i)<br />

Zur Überprüfung rechnen wir beide Seiten mittels der Definition von transponiere<br />

und durDreiklang aus und erhalten beide Male<br />

Note (t+i) (1/1) :+: Note (t+4+i) (1/1) :+: Note (t+7+i) (1/1)

2.2. Typen als Hilfsmittel der Modellierung 11<br />

Hier haben wir eine Methode zur Validierung von Modellen kennengelernt: Wenn man<br />

beweisen kann, daß ein Gesetz der realen Welt auch in der Formelwelt gilt, so gibt das<br />

Modell die Wirklichkeit zumindest in dieser Hinsicht treu wieder.<br />

Bevor wir ein komplettes Lied zusammenstellen, hier zwei Regeln zur Wiederholung:<br />

wdh m = m :*: m<br />

ad_infinitum m = m :*: ad_infinitum m<br />

Einen um Dauer d verzögerten Einsatz erhält man durch Vorschalten einer Pause.<br />

einsatz d m = (Pause d) :*: m<br />

Unser letztes Beispiel beschreibt den Kanon „Bruder Jakob“, wobei wir die 2. Stimme<br />

eine Oktave über den anderen notieren.<br />

phrase1 = c’ (1/4) :*: d’ (1/4) :*: e’ (1/4) :*: c’ (1/4)<br />

phrase2 = e’ (1/4) :*: f’ (1/4) :*: g’ (1/2)<br />

phrase3 = g’ (1/8) :*: a’ (1/8) :*: g’ (1/8) :*: f’ (1/8)<br />

:*: e’ (1/4) :*: c’ (1/4)<br />

phrase4 = c’ (1/4) :*: (transponiere (-12) (g’ (1/4))) :*: c’’ (1/2)<br />

strophe = wdh phrase1 :*: wdh phrase2 :*: wdh phrase3 :*: wdh phrase4<br />

endlos = ad_infinitum strophe<br />

bruderJakob = Tempo andante (Instr VoiceAahs<br />

(einsatz (0/1) endlos :+:<br />

(einsatz (2/1) (transponiere 12 endlos)) :+:<br />

(einsatz (4/1) endlos) :+:<br />

(einsatz (6/1) endlos )))<br />

Natürlich gehört zu einer praktischen Formelsprache für Musik noch vieles, was wir hier<br />

nicht betrachtet haben – Text, Artikulation, Kontrapunkt, eine Möglichkeit zur Übersetzung<br />

der Formeln in die traditionelle Notation und in eine Folge von Midi-Befehlen, um<br />

damit einen Synthesizer zu steuern.<br />

2.2. Typen als Hilfsmittel der Modellierung<br />

In der realen Welt verhindert (meistens) die Physik, daß unpassende Operationen mit<br />

untauglichen Objekten ausgeführt werden. Man kann eben einen Golfball nicht unter einer<br />

Fliege verstecken oder einen Rosenbusch mit einer Steuererklärung paaren. Macht

12 2. Modellierung<br />

es Sinn, einer streikenden (?) Waschmaschine gut zuzureden? Das Problem in einer Formelwelt<br />

ist, daß man zunächst alles hinschreiben kann, weil die Formeln sich nicht selbst<br />

dagegen sträuben.<br />

Aus diesem Grund gibt man jedem Objekt des Modells einen Typ, der eine Abstraktion<br />

der natürlichen Eigenschaften des realen Objekts ist.<br />

In der Formelsprache für Musik haben wir die Typen Ton (synonym für ganzeZahl) und<br />

Dauer (synonym für positive rationale Zahl) vorausgesetzt und die Typen Musik und<br />

Instrument neu eingeführt. Die Typendeklaration legt nicht nur fest, daß Musik auf<br />

sechs verschiedene Weisen zusammengesetzt werden kann, und zwar durch die (Formel-)<br />

Konstruktoren Note bis Tempo. Sie sagt auch, welche Formeln zusammengefügt werden<br />

dürfen. Note muß stets einen Ton mit einer Dauer verknüpfen. Mit :*: kann man zwei<br />

Musikstücke verknüpfen, nicht aber ein Musikstück mit einem Ton. Folgende Formeln<br />

sind fehlerhaft:<br />

Note 3/4 ce Pause (1/2 :*: 1/4)<br />

Pause Cello Instr (Cello :+: Oboe) cDurTonika<br />

Tempo Oboe 100 c’ :+: e’ :+: g’<br />

Möglicherweise hat sich der Autor dieser Formeln etwas Sinnvolles gedacht – aber es<br />

muß in unserer Formelsprache anders ausgedrückt werden. Auch die durch Definitionen<br />

eingeführten Namen erhalten einen Typ. Er ergibt sich aus der rechten Seite der definierenden<br />

Gleichung. Wir schreiben a, b, c :: t für die Aussage „Die Namen (oder Formeln)<br />

a, b, c haben Typ t“ und stellen fest:<br />

ce, cis, des, de, dis, es, eh, eis, fes, ef, fis :: Ton<br />

ges, ge, gis, as, ah, ais, be, ha, his :: Ton<br />

gP, hP, vP, aP, sP :: Musik<br />

cDurTonika :: Musik<br />

adagio, andante, allegro, presto :: GanzeZahl<br />

Die Namen c’, d’ etc. bezeichnen Funktionen, die eine Dauer als Argument und<br />

Musik als Ergebnis haben. umk, wdh und ad_infinitum wandeln Musikstücke um.<br />

c’, d’, e’, f’, g’, a’, h’, c’’ :: Dauer -> Musik<br />

umk, wdh, ad_infinitum :: Musik -> Musik<br />

transponiere schließlich hat zwei Argumente, was wir – etwas gewöhnugsbedürftig<br />

– mit zwei Funktionspfeilen ausdrücken.<br />

transponiere :: GanzeZahl -> Musik -> Musik

2.3. Die Rolle der Abstraktion in der Modellierung 13<br />

Hinter dieser Notation steht die Sichtweise, daß man einer zweistelligen Funktion wie<br />

transponiere manchmal nur ein Argument geben möchte: Unter<br />

(transponiere 7) stellen wir uns eine abgeleitete Funktion vor, die Musikstücke um<br />

eine Quinte nach oben transponiert. Natürlich hat (transponiere 7) dann den „restlichen“<br />

Typ Musik -> Musik.<br />

2.3. Die Rolle der Abstraktion in der Modellierung<br />

Unsere Formelsprache für Musik erlaubt es, in direkter Analogie zur Notenschrift Musikstücke<br />

als Formeln hinzuschreiben. Darüberhinaus können wir aber auch abstrakte Zusammenhänge<br />

zwischen Musikstücken darstellen, wie etwa den Aufbau eines Dur-Dreiklangs<br />

oder das Transponieren. Worauf beruht dies Möglichkeit?<br />

Sie beginnt damit, daß wir beliebige Formeln mit einem Namen versehen können, wie<br />

etwa bei gP, hP oder phrase1 bis phrase4. Diese Namen sind kürzer und (hoffentlich)<br />

lesbarer als die Formeln, für die sie stehen, aber noch nicht abstrakter. Die Abstraktion<br />

kommt mit dem Übergang zu Funktionen ins Spiel. Vergleichen wir die beiden folgenden<br />

Definitionen eines Zweiklangs:<br />

tritonus_f_1 = Note ef (1/1) :+: Note ha (1/1)<br />

tritonus t d = Note t d :+: Note (t+6) d<br />

tritonus_f_1 beschreibt einen Zweiklang von konkreter Tonlage und Dauer.<br />

tritonus dagegen abstrahiert von Tonlage und Dauer, und hält nur fest, was für den als<br />

Tritonus bekannten Zweiklang wesentlich ist — ein Intervall von 6 Halbtonschritten.<br />

Dieser Unterschied macht sich auch an den Typen bemerkbar. Wir finden:<br />

tritonus_f_1 :: Musik<br />

tritonus :: Ton -> Dauer -> Musik<br />

Hier verrät uns bereits der Typ, daß in der Formel tritonus erst Ton und Dauer konkretisiert<br />

werden müssen, ehe spielbare Musik entsteht. Bei den Noten der eingestrichenen<br />

C-Dur-Skala (c’, d’, ...) haben wir von der Dauer abtrahiert, sonst hätten wir Definitionen<br />

für 40 oder noch mehr Namen einführen müssen. Andererseits haben wir hier<br />

natürlich nicht vom Ton abstrahiert, wir wollten ja Namen für bestimmte Töne einführen.<br />

Und außerdem gibt es diese Abstraktion bereits: Eine Note von beliebigem Ton und<br />

Dauer wird gerade von dem Konstruktor Note repräsentiert, dem wir daher auch den Typ<br />

Ton -> Dauer -> Musik zuordnen.<br />

Typen halten die Objekte der Formelwelt auseinander, Funktionen stiften Zusammenhänge.<br />

Wollten wir ohne Abstraktion das Prinzip der Umkehrung eines Dreiklangs beschreiben,<br />

kämen wir über konkrete Beispiele nicht hinaus. Die Funktion umk leistet das

14 2. Modellierung<br />

Gewünschte mühelos. Und schließlich hält uns nichts davon ab (Übungsaufgabe!), im Kanon<br />

bruderJakob von der eigentlichen Melodie zu abstrahieren und ein allgemeines<br />

Konstruktionsprinzip für einen vierstimmigen Kanon anzugeben.<br />

Hier haben wir die Methode der funktionalen Abstraktion kennengelernt. Technisch<br />

gesehen besteht sie lediglich darin, in einer Formel einige Positionen als variabel zu betrachten.<br />

So wird aus der Formel eine Funktion, die mit einem Namen versehen und in<br />

vielfältiger Weise eingesetzt werden kann, und die zugleich selbst ein abstraktes Prinzip<br />

repräsentiert. Wir werden später noch andere Formen der Abstraktion kennenlernen, aber<br />

die funktionale Abstraktion ist sicher die grundlegendste von allen.<br />

2.4. Modellierung in der molekularen Genetik<br />

Die Basen Adenin, Cytosin, Guanin und Thymin bilden zusammen mit Phosphor und Ribose<br />

die Nukleotide, die Bausteine der Erbsubstanz.<br />

data Nucleotide = A | C | G | T deriving (Eq, Show)<br />

Die 20 Aminosäuren sind die Bausteine aller Proteine:<br />

data AminoAcid = Ala -- Alanin<br />

| Arg -- Arginin<br />

| Asn -- Asparagin<br />

| Asp -- Aspartat<br />

| Cys -- Cystein<br />

| Gln -- Glutamin<br />

| Glu -- Glutamat<br />

| Gly -- Glycin<br />

| His -- Histidin<br />

| Ile -- Isoleucin<br />

| Leu -- Leucin<br />

| Lys -- Lysin<br />

| Met -- Methionin<br />

| Phe -- Phenylalanin<br />

| Pro -- Prolin<br />

| Ser -- Serin<br />

| Thr -- Threonin<br />

| Trp -- Tryptophan<br />

| Tyr -- Tyrosin<br />

| Val -- Valin<br />

| Stp -- keine Aminosaeure; siehe unten<br />

deriving (Eq, Show)

2.4. Modellierung in der molekularen Genetik 15<br />

Lange Ketten von Nukleotiden bilden die Nukleinsäure, lange Ketten von Aminosäuren<br />

bilden Proteine. Chemisch werden diese Ketten auf unterschiedliche Weise gebildet:<br />

Bei den Nukleotiden verknüpfen die Phosphor-Atome die Ribose-Ringe, zwischen den<br />

Aminosäuren werden Peptidbindungen aufgebaut. Da wir aber die Chemie der Moleküle<br />

nicht modellieren wollen, wollen wir auch nicht unterscheiden, auf welche Weise die<br />

Ketten konstruiert werden. Als Formel für Kettenmoleküle schreiben wir<br />

A:C:C:A:G:A:T:T:A:T:A:T: ..., oder<br />

Met:Ala:Ala:His:Lys:Lys:Leu: ...<br />

Im Unterschied zur Molekularbiologie kennt also unsere Formelwelt einen Konstruktor<br />

(:), der Ketten jeglicher Art aufbaut:<br />

data [a] = [] -- leere Kette<br />

| a:[a] -- (:) verlaengert Kette von a’s um ein a.<br />

Den Datentyp [a] nennt man einen polymorphen Listentyp. Hier ist a ein Typparameter.<br />

Dies bedeutet, das Elemente beliebigen, aber gleichen Typs mittels der Konstruktoren<br />

(:) und [] zu Listen zusammengefügt werden können. Für Listen führen wir eine spezielle<br />

Notation ein: Statt a:b:c:[] schreiben wir auch [a,b,c].<br />

Damit können wir nun sagen, welcher Datentyp in der Formelwelt den realen Nukleinsäuren<br />

und Proteinen entsprechen soll:<br />

type DNA = [Nucleotide]<br />

type Protein = [AminoAcid]<br />

type Codon = (Nucleotide, Nucleotide, Nucleotide)<br />

Im Ruhezustand (als Informationsspeicher) ist die DNA allerdings ein Doppelmolekül:<br />

Zwei DNA-Stränge bilden die berühmte, von Watson und Crick entdeckte Doppelhelix.<br />

Sie beruht darauf, daß bestimmte Basen zueinander komplementär sind - sie können Wasserstoffbrückenbindungen<br />

aufbauen, wenn sie einander gegenüber stehen.<br />

wc_complement A = T<br />

wc_complement T = A<br />

wc_complement C = G<br />

wc_complement G = C<br />

Wir können die dopplesträngige DNA auf zwei verschiedene Weisen darstellen, als Paar<br />

von Listen oder als Liste von Paaren.<br />

type DNA_DoubleStrand = (DNA,DNA) -- als Paar zweier Einzelstraenge<br />

type DNA_DoubleStrand’ = [(Nucleotide,Nucleotide)]<br />

-- als Kette von Watson-Crick-Paaren<br />

dnaDS_Exmpl1 = ([A,C,C,G,A,T],[T,G,G,C,T,A])<br />

dnaDS_Exmpl2 = [(A,T),(C,G),(C,G),(G,C),(A,T),(T,A)]

16 2. Modellierung<br />

Dabei ist die erste Version deutlich vorzuziehen. Sie deutet an, was in der Zelle auch<br />

stattfindet: Das Aufspalten oder Zusammenfügen des Doppelstrangs aus zwei Einzelsträngen.<br />

Die zweite Version dagegen suggeriert, daß existierende Watson-Crick Basenpaare zu<br />

einer Doppelkette verknüpft werden. Einzelne solche Paare sind jedoch wegen der sehr<br />

schwachen Wasserstoffbindung nicht stabil und kommen daher in der Zelle nicht vor.<br />

Wir entscheiden uns also für den Datentyp DNA_DoubleStrand. So naheliegend seine<br />

Definition auch erscheint, sie ist nicht ohne Gefahren: Formeln vom Typ<br />

DNA_DoubleStrand sollen beliebige doppelsträngige DNA-Moleküle darstellen. Das können<br />

sie auch. Aber darüber hinaus können wir formal korrekte Formeln des Typs<br />

DNA_DoubleStrand hinschreiben, denen keine Doppelhelix entspricht.<br />

incorrectDoubleStrand = ([A,C,C,G,A,T],[T,G,G,C,A,T,C])<br />

incorrectDoubleStrand ist in zweifacher Weise falsch: Erstens sind die jeweiligen<br />

Basen an mehreren Stellen nicht komplementär, und zweitens haben die beiden Einzelstränge<br />

gar noch unterschiedliche Länge. Wir stoßen hier auf eine grundlegende Schwierigkeit<br />

bei jeder Modellierung: Es gibt Objekte in der Modellwelt, die nichts bedeuten,<br />

d.h. denen keine Objekte der Wirklichkeit entsprechen. Solche Formeln, die wohlgebaut,<br />

aber ohne Bedeutung sind, nennt man syntaktisch korrekt, aber semantisch falsch. Alles<br />

geht gut, solange beim Rechnen mit den Formeln auch keine solchen Objekte erzeugt<br />

werden. Wenn doch, sind die Folgen meist unabsehbar. Im besten Fall bleibt die Rechnung<br />

irgendwann stecken, weil eine Funktion berechnet werden soll, die für solche Fälle<br />

keine Regel vorsieht. Manchmal passen die Rechenregeln auch auf die nicht vorgesehenen<br />

Formeln, und dann kann es im schlimmsten Fall geschehen, daß die Rechnung ein<br />

Ergebnis liefert, dem man nicht ansieht, daß es falsch ist.<br />

Wir werden sehen, daß selbst die Natur im Falle der DNA-Replikation dieses Problem<br />

erkannt und einen Weg zu seiner Lösung gefundenhat. Zunächst betrachten wir<br />

den „Normalfall“ der Replikation. Weil das Komplement jeder Base eindeutig definiert<br />

ist, kann man zu jedem DNA-Einzelstrang den komplementären Doppelstrang berechnen.<br />

In der Tat geschieht dies bei der Zellteilung. Der Doppelstrang wird aufgespalten, und<br />

die DNA-Polymerase synthetisiert zu jedem der beiden Stränge den jeweils komplementären<br />

Strang. Die DNA-Polymerase können wir auf zwei verschiedene Weisen darstellen:<br />

Enerseits ist sie ein Enzym, also selbst ein Protein:<br />

dnaPolymerase_Sequenz = Met:Ala:Pro:Val:His:Gly:Asp:Asp:Ser ...<br />

Dies hilft uns allerdings nicht dabei, die Wirkungsweise dieses Enzyms auszudrücken.<br />

Noch viele Jahrzehnte werden vergehen, ehe die Wissenschaft die Funktion eines Proteins<br />

aus der Kette seiner Aminosäuren ableiten kann. Was liegt also näher, als die Funktion der<br />

Polymerase durch eine Funktion zu modellieren:

2.4. Modellierung in der molekularen Genetik 17<br />

dnaPolymerase :: DNA -> DNA_DoubleStrand<br />

dnaPolymerase x = (x, complSingleStrand x) where<br />

complSingleStrand [] = []<br />

complSingleStrand (a:x) = wc_complement a:complSingleStrand x<br />

Will man prüfen (lassen), ob ein Dopplestrang tatsächlich korrekt aufgebaut ist, kann<br />

man dies nun einfach tun.<br />

data Bool = True | False -- die abstrakten Urteile Wahr und Falsch<br />

wellFormedDoubleStrand :: DNA_DoubleStrand -> Bool<br />

wellFormedDoubleStrand (x,y) = (x,y) == dnaPolymerase x<br />

(Zur Unterscheidung von der definierenden Gleichung schreiben wir den Vergleich zweier<br />

Formeln als ==. Dabei werden beide Formeln zunächst ausgerechnet und dann verglichen.)<br />

Blickt man etwas tiefer ins Lehrbuch der Genetik, so findet man, daß auch die Natur<br />

nicht ohne Fehler rechnet: Mit einer (sehr geringen) Fehlerrate wird in den neu polymerisierten<br />

Strang ein falsches (nicht komplementäres) Nukleotid eingebaut. Dadurch wird die<br />

Erbinformation verfälscht. Daher gibt es ein weiteres Enzym, eine Exonuclease, die fehlerhafte<br />

Stellen erkennt und korrigiert. Sie muß dabei ein subtiles Problem lösen: Gegeben<br />

ein Doppelstrang mit einem nicht komplementären Basenpaar darin – welcher Strang ist<br />

das Original, und welcher muß korrigiert werden? Die Natur behilft sich dadurch, daß der<br />

Originalstrang beim Kopieren geringfügig modifiziert wird – durch Anhängen von Methylgruppen<br />

an seine Nukleotide.<br />

Diese Technik können wir nicht einsetzen, da wir die Chemie der Nukleotide nicht modellieren.<br />

Wir behelfen uns auf eine nicht weniger subtile Art: Im Unterschied zur Wirklichkeit<br />

(Doppelhelix) kann man im Modell (DNA_DoubleStrand) einen „linken“ und<br />

„rechten“ Strang unterscheiden. Übereinstimmend mit der Modellierung der Polymerase<br />

legen wir fest, daß stets der „linke“ Strang als Original gilt, der „rechte“ als die Kopie.<br />

Auch die Exonuclease modellieren wir durch ihre Funktion:<br />

exonuclease :: DNA_DoubleStrand -> DNA_DoubleStrand<br />

exonuclease ([],[]) = ([],[])<br />

exonuclease ([],x) = ([],[]) -- Kopie wird abgeschnitten<br />

exonuclease (x,[]) = dnaPolymerase x -- Kopie wird verlaengert<br />

exonuclease (a:x,b:y) = if b == ac then (a:x’,b:y’)<br />

else (a:x’,ac:y’)<br />

where ac = wc_complement a<br />

(x’,y’) = exonuclease (x,y)<br />

Damit erhalten wir z.B. die erwünschte Korrektur des fehlerhaften Doppelstrangs:

18 2. Modellierung<br />

exonuclease incorrectDoubleStrand ==> ([A,C,C,G,A,T],[T,G,G,C,T,A])<br />

Unsere Definition der Exonuclease ist der Natur abgelauscht. Vom Standpunkt des Rechenergebnisses<br />

aus betrachtet (man nennt diesen Standpunkt extensional) können wir<br />

das Gleiche auch einfacher haben: Verläßt man sich darauf, daß unsere DNA-Polymerase<br />

im Modell keine Fehler macht, kann man einfach den kopierten Strang gleich neu polymerisieren.<br />

dnaCorr :: DNA_DoubleStrand -> DNA_DoubleStrand<br />

dnaCorr (x,y) = dnaPolymerase x<br />

Es ist nicht ganz überflüssig, die gleiche Funktion auf verschiedene Weisen zu beschreiben.<br />

Daraus ergibt sich die Möglichkeit, das Modell an sich selbst zu validieren. Es muß<br />

ja nun die folgende Aussage gelten:<br />

Für alle d::DNA_DoubleStrand gilt dnaCorr d == exonuclease d.<br />

Außerdem muß die dnaPolymerase eine Idempotenzeigenschaft aufweisen:<br />

Für alle x::DNA gilt: x == z where (x,y) == dnaPolymerase x<br />

(y,z) == dnaPolymerase y<br />

Wir formulieren solche Eigenschaften, die wir aus der Wirklichkeit kennen, in der Sprache<br />

der Modellwelt. Können wir sie dort als gültig nachweisen, so wissen wir erstens,<br />

daß unser Modell im Hinblick auf genau diese Eigenschaften der Realität entspricht. Aber<br />

noch mehr: Sofern wir diese Eigenschaften beim Formulieren des Modells nicht explizit<br />

bedacht haben, fördert ihr Nachweis auch unser generelles Vertrauen in die Tauglichkeit<br />

des Modells. Wir werden später Techniken kennenlernen, wie man solche Eigenschaften<br />

nachweist.<br />

Fast ohne Ausnahme benutzen alle Lebewesen den gleichen genetischen Code. Bestimmte<br />

Dreiergruppen (genannt Codons) von Nukleotiden codieren für bestimmte Aminosäuren.<br />

Da es 4 3 = 64 Codons, aber nur 20 Aminosäuren gibt, werden viele Aminosäuren<br />

durch mehrere Codons codiert. Einige Codons codieren für keine Aminosäure; man<br />

bezeichnet sie als Stop-Codons, da ihr Auftreten das Ende eines Gens markiert.<br />

Der genetische Code ist also eine Funktion, die Codons auf Aminosäuren abbildet. (Wir<br />

abstrahieren hier davon, daß die DNA zunächst in RNA transkribiert wird, wobei die Base<br />

Thymin überall durch Uracil ersetzt wird.)<br />

genCode :: Codon -> AminoAcid<br />

genCode (A,A,A) = Lys; genCode (A,A,G) = Lys<br />

genCode (A,A,C) = Asn; genCode (A,A,T) = Asn<br />

genCode (A,C,_) = Thr

2.4. Modellierung in der molekularen Genetik 19<br />

genCode (A,G,A) = Arg; genCode (A,G,G) = Arg<br />

genCode (A,G,C) = Ser; genCode (A,G,T) = Ser<br />

genCode (A,T,A) = Ile; genCode (A,T,C) = Ile<br />

genCode (A,T,T) = Ile<br />

genCode (A,T,G) = Met<br />

genCode (C,A,A) = Glu; genCode (C,A,G) = Glu<br />

genCode (C,A,C) = His; genCode (C,A,T) = His<br />

genCode (C,G,_) = Arg<br />

genCode (C,C,_) = Pro<br />

genCode (C,T,_) = Leu<br />

genCode (G,A,A) = Glu; genCode (G,A,G) = Glu<br />

genCode (G,A,C) = Asp; genCode (G,A,T) = Asp<br />

genCode (G,C,_) = Ala<br />

genCode (G,G,_) = Gly<br />

genCode (G,T,_) = Val<br />

genCode (T,A,A) = Stp; genCode (T,A,G) = Stp<br />

genCode (T,G,A) = Stp<br />

genCode (T,A,C) = Tyr; genCode (T,A,T) = Tyr<br />

genCode (T,C,_) = Ser<br />

genCode (T,G,G) = Trp<br />

genCode (T,G,C) = Cys; genCode (T,G,T) = Cys<br />

genCode (T,T,A) = Leu; genCode (T,T,G) = Leu<br />

genCode (T,T,C) = Phe; genCode (T,T,T) = Phe<br />

Ein Gen beginnt stets mit dem „Startcodon“ (A,T,G) , setzt sich dann mit weiteren<br />

Codons fort und endet mit dem ersten Auftreten eines Stopcodons. Die Translation, d.h.<br />

die Übersetzung des Gens in das codierte Protein erfolgt am Ribosom. Dies ist ein sehr<br />

komplexes Molekül, ein Verbund aus Proteinen und Nukleinsäuren. Wir modellieren es<br />

durch seine Funktion:<br />

ribosome :: DNA -> Protein<br />

ribosome (A:T:G:x) = Met:translate (triplets x) where<br />

triplets :: [a] -> [(a,a,a)]<br />

triplets [] = []<br />

triplets (a:b:c:x) = (a,b,c):triplets x<br />

translate :: [Codon] -> Protein<br />

translate [] = []<br />

translate (t:ts) = if aa == Stp then []<br />

else aa:translate ts where<br />

aa = genCode t<br />

Auch hier haben wir wieder einige Modellierungsentscheidungen getroffen, die man<br />

sich klarmachen muß. Dies betrifft die Behandlung inkorrekt aufgebauter Gene, die auch

20 2. Modellierung<br />

in der Natur gelegentlich vorkommen. Fehlt das Startcodon, wird kein Protein produziert.<br />

Ist das Gen unvollständig, d.h. bricht es ohne Stopcodon ab, so ist ein unvollständiges<br />

Proteinprodukt entstanden, das entsorgt werden muß. Im Modell ist dies so ausgedrückt:<br />

• Fehlt das Startcodon, gibt es keine passende Rechenregel für ribosome, und die<br />

Rechnung beginnt gar nicht erst.<br />

• Ist das letzte Triplett unvollständig, bleibt die Rechnung in einer Formel der Art<br />

triplets [a] oder triplets[a,b] stecken, für die wir keine Rechenregel vorgesehen<br />

haben. Ein Fehlen des Stopcodons wird verziehen. Wer dies nicht will,<br />

streicht die erste Regel für translate, so daß ohne Stopcodon die Rechnung am Ende<br />

in translate [] steckenbleibt.<br />

Eine frühere Entscheidung hat sich hier gelohnt: Da wir den Listentyp polymorph eingeführt<br />

haben, können wir hier auch ganz nebenbei Listen von Codons, d.h. den Typ<br />

[Codon] verwenden.<br />

Bisher haben wir Vorgänge modelliert, die in der Natur selbst vorkommen. Zum Abschluß<br />

nehmen wir den Standpunkt des Naturforschers ein. Heute liefern die großen<br />

Sequenzierprojekte dank weitgehender Automatisierung eine Fülle von DNA-Sequenzen<br />

immer mehr Organismen. Von einigen ist sogar bereits das komplette Genom bekannt,<br />

etwa vom Koli-Bakterium (ca. 3 Millionen Basenpaare) oder der Bäckerhefe (ca. 14 Millionen<br />

Basenpaare). Den Forscher interessiert nun unter anderem, welche Gene eine neue<br />

DNA-Sequenz möglicherweise enthält. Sequenzabschnitte, die den Aufbau eines Gens haben,<br />

nennt man ORFs (open reading frames). Ob es sich bei ihnen tatsächlich um Gene<br />

handelt, hängt davon ab, ob sie jemals vom Ribosom als solche behandelt werden. Dies<br />

kann man der Sequenz heute nicht ansehen. Wohl aber ist es interessant, in einer neuen<br />

DNA-Sequenz nach allen ORFs zu suchen und ihre Übersetzung in hypothetische Proteine<br />

vorzunehmen. Wir wollen also für unsere Kollegin aus der Molekularbiologie eine<br />

Funktion definieren, die genau dieses tut.<br />

Damit ist unsere Aufgabe so bestimmt: Wir gehen von einem DNA-Doppelstrang aus,<br />

der zu untersuchen ist. Als Ergebnis möchten wir alle ORFs in übersetzter Form sehen, die<br />

in dem Doppelstrang auftreten.<br />

Wir wollen diese Aufgabe durch eine Funktion analyseORFs lösen. Schon beim Versuch,<br />

den Typ dieser Funktion anzugeben, wird klar, daß die Aufgabe zwar halbwegs ausreichend,<br />

aber keineswegs vollständig beschrieben ist.<br />

Was genau bedeutet „alle ORFs“? Weder in der DNA, noch in unserem Modell liegt<br />

eine feste Einteilung der Nukleotidsequenz in Codons vor. Das Auftreten einer Dreiergruppe<br />

A,T,G definiert implizit die Lage der folgenden Codons. Ein einzelnes Nukleotid<br />

kann so drei verschiedenen Leserastern angehören, in denen es jeweils als 1., 2. oder 3.<br />

Element eines Codons interpretiert wird. Damit kann ein DNA-Abschnitt überlappende

2.4. Modellierung in der molekularen Genetik 21<br />

ORFs enthalten. Das gleiche gilt für den Gegenstrang, der dabei in umgekehrter Richtung<br />

abzulesen ist.<br />

„Alle ORFs“ zu finden ist also etwas komplizierter als es zunächst erscheint. Das führt<br />

zu der Frage, wie eigentlich das Ergebnis aussehen soll. Einfach eine Liste aller ORFs,<br />

die vorkommen? Oder will man zu jedem ORF auch wissen, in welchem Leseraster auf<br />

welchem Strang er liegt? Möchte man gar zusätzliche Informationen erhalten, wie etwa<br />

Länge eines ORF und seine Lage relativ zum Anfang der DNA-Sequenz? Schließlich –<br />

wir wissen ja was unsere Kollegin letzlich interessiert – könnte man die hypothetischen<br />

Proteine noch mit einer Proteindatenbank abgleichen, um zu sehen, ob ein solches (oder<br />

ein ähnliches) Protein an anderer Stelle bereits nachgewiesen wurde ...<br />

Es ist immer ein gutes Entwurfsprinzip<br />

• möglicherweise interessante Information, die während der Rechnung anfällt, auch<br />

im Ergebnis sichtbar zu machen. Dies gilt hier für die Verteilung der ORFs auf die<br />

Leseraster.<br />

• die Funktionalität eines Entwurfs nicht zu überfrachten. Was gut und logisch einleuchtend<br />

durch zwei getrennte Funktionen realisiert werden kann, wird auch getrennt.<br />

Dadurch entstehen kleine Bausteine von überschaubarer Komplexität, die<br />

möglicherweise auch in anderem Kontext wiederverwendbar sind.<br />

Wir entscheiden, daß das Ergebnis eine Liste von 6 Listen übersetzter ORFs sein soll,<br />

getrennt nach Leseraster. Wir halten diesen Beschluß durch die entsprechende Typdeklaration<br />

fest.<br />

analyzeORFs :: DNA_DoubleStrand -> [[Protein]]<br />

Da ein Startcodon an beliebiger Stelle stehen kann, bilden wir zunächst 6 verschiedene<br />

Leseraster, die dann alle nach ORFs durchsucht werden.<br />

frames3 :: DNA -> [[Codon]]<br />

frames3 x = if length x < 3 then [[],[],[]]<br />

else [triplets x, triplets (tail x),<br />

triplets (tail(tail x))] where<br />

triplets :: [a] -> [(a,a,a)]<br />

triplets [] = []<br />

triplets [_] = []<br />

triplets [_,_] = []<br />

triplets (a:b:c:x) = (a,b,c):triplets x<br />

findStartPositions :: [Codon] -> [[Codon]]<br />

findStartPositions [] = []<br />

findStartPositions (c:x) = if c == (A,T,G) then (c:x):findStartPositions x<br />

else findStartPositions x

22 2. Modellierung<br />

analyzeORFs (strain,antistrain)<br />

= map (map translate) orfs where<br />

sixframes = frames3 strain ++ frames3 (reverse antistrain)<br />

orfs = map findStartPositions sixframes<br />

Der polymorphe Listendatentyp wird hier in verschiedener Weise benutzt; das Ergebnis<br />

z.B. ist eine Liste von Listen von Listen von Aminosäuren. Wir unterstellen Funktionen<br />

(++) und reverse, die Listen aller Art verketten bzw. umkehren. Die Umkehrung des<br />

Gegenstrangs ist notwendig, weil dieser am Ribosom in gegenläufiger Richtung gelesen<br />

wird. Die Funktion map schließlich wendet eine Funktion f auf alle Elemente einer Liste<br />

an, so daß z.B. gilt map f [x,y,z] = [f x, f y, f z].<br />

Einige Beispiele:<br />

dna_seq3 = dnaPolymerase [A,A,T,G,T,C,C,A,T,G,A,A,T,G,C]<br />

dna_seq4 = dnaPolymerase [A,T,G,A,T,G,A,A,T,G,C,C,G,G,C,A,T,T,C,A,T,C,A,T]<br />

analyzeORFs dna_seq3 ==><br />

[[],<br />

[[Met, Ser, Met, Asn], [Met, Asn]],<br />

[[Met]],<br />

[[Met, Asp, Ile]],<br />

[],<br />

[]]<br />

analyzeORFs dna_seq4 ==><br />

[[[Met, Met, Asn, Ala, Gly, Ile, His, His],<br />

[Met, Asn, Ala, Gly, Ile, His, His]],<br />

[[Met, Pro, Ala, Phe, Ile]],<br />

[],<br />

[[Met, Met, Asn, Ala, Gly, Ile, His, His],<br />

[Met, Asn, Ala, Gly, Ile, His, His]],<br />

[[Met, Pro, Ala, Phe, Ile]],<br />

[]]<br />

Daß bei dna_seq4 auf Strang und Gegenstrang die gleichen hypothetischen Proteine<br />

gefunden werden, liegt am besonderen Aufbau dieser Beispielsequenz: Strang und reverser<br />

Gegenstrang (in umgekehrter Leserichtung) sind gleich.

2.5. Anforderungen an Programmiersprachen 23<br />

2.5. Anforderungen an Programmiersprachen<br />

Aus der Sprache der Mathematik haben wir den Umgang mit Formeln übernommen. Dabei<br />

zeigt sich gleich ein wichtiger Unterschied: Die „Sprache“ der Mathematik ist im wesentlichen<br />

fertig – die meisten Anwender kommen ein Leben lang mit den einmal erlernten<br />

Formeln und Begriffen – sagen wir einmal aus Arithmetik, Algebra und Analysis – aus.<br />

Erweiterungen dieser Sprache, die Einführung neuer Begriffe und Notationen bleibt einer<br />

kleinen Gemeinde von Forschern vorbehalten, die in dieser Hinsicht keinen Regeln unterliegen.<br />

In der Informatik ist das Gegenteil der Fall. Modellierung bedeutet Schaffung<br />

neuer Formelwelten. Jeder Programmierer führt neue Objekte (Typen) und Beziehungen<br />

zwischen ihnen (Funktionen) ein. Wenn ein Formalismus ständig erweitert wird und trotzdem<br />

allgemein verständlich und sogar durch den Computer ausführbar sein soll, dann muß<br />

es einen festen Rahmen dafür geben, was man wie hinschreiben darf. Dies begründet die<br />

besondere Rolle der Programmiersprachen in der Informatik. Ihre Syntax legt fest, wie<br />

etwas aufgeschrieben wird. Ihre Semantik bestimmt, wie mit diesen Formeln zu rechnen<br />

ist, sei es durch uns selbst, sei es durch den Computer. Eine präzise definierte Syntax und<br />

Semantik ist die Mindestanforderung an eine Programmiersprache.<br />

Anhand der vorangehenden Abschnitte können wir einige Beobachtungen dazu machen,<br />

was eine Programmiersprache darüber hinaus leisten muss.<br />

• Ein strenges, aber flexibles Typkonzept hält die Formelwelt in Ordnung. Streng bedeutet,<br />

daß jeder Formel ein Typ zugeordnet wird und sich daher fast alle Programmierfehler<br />

bereits als Typfehler bemerkbar machen. Flexibel heißt andererseits, daß<br />

uns das Typkonzept nicht zwingen darf, die gleiche Operation mehrfach zu programmieren,<br />

nur weil sich die Typen unwesentlich unterscheiden.<br />

• Ein hierarchisch organisierter Namensraum erlaubt die Kontrolle über die Sichtbarkeit<br />

von Namen. Definitionen können ihrerseits lokale Bezeichnungen einführen, die<br />

nach außen hin nicht sichtbar sind. Die Funktion triplets haben wir zweimal und<br />

leicht unterschiedlich definiert, jeweils als lokale Definition innerhalb der Definitionen<br />

von ribosome und frames3. Ohne lokal beschränkte Sichtbarkeit könnte<br />

man sich bei größeren Programmen vor Namenskonflikten nicht retten – man denke<br />

allein an die vielfache Verwendung der Variablen „x“ . . . .<br />

• Methoden zum Nachweis von Programmeigenschaften erlauben uns, die Übereinstimmung<br />

des Modells mit wesentlichen Aspekten der modellierten Wirklichkeit zu<br />

verifizieren. Auch die Korrektheit einzelner Funktionen sollte man einfach nachweisen<br />

können, indem man algebraische Eigenschaften wie im Fall der exonuclease<br />

benutzt.

24 2. Modellierung<br />

• Ein hohes Abstraktionsniveau der Programmiersprache gewährleistet eine überschaubare<br />

Beziehung zwischen Modell und Wirklichkeit. Wir wollen Rechenregeln formulieren,<br />

die für uns nachvollziehbar sind. Schließlich müssen zuerst wir selbst unsere<br />

Programme verstehen. Vom Computer nehmen wir einfach an, daß er damit klarkommt.<br />

(Dafür zu sorgen ist natürlich die Aufgabe des Übersetzers für die jeweilige<br />

Programmiersprache.) Sprachen auf geringem Abstraktionsniveau verlangen doppelten<br />

Aufwand, weil die formale Beschreibung der Modellwelt und die Programmierung<br />

auseinanderfallen.<br />

Wir haben Haskell als Programmiersprache gewählt, weil es derzeit die obigen Kriterien<br />

am besten erfüllt. Wir werden im Laufe der Vorlesung noch weitere Anforderungen an<br />

Programmiersprachen kennenlernen, und nicht alle sehen Haskell als Sieger.

3. Eine einfache Programmiersprache<br />

Ziele des Kapitels: Im Kapitel Modellierung haben wir uns darauf konzentriert, wie man<br />

Objekte und Zusammenhänge der Realität durch Formeln und ihr Verhalten rechnerisch<br />

nachbildet. Wir haben uns darauf verlassen, daß jeder mit Formeln rechnen kann, auch<br />

wenn diese etwas anders aussehen als aus der Mathematik gewohnt. In diesem Kapi- Grit Garbo: Mit anderen Worten: ganz schön ungewohnt.<br />

tel nehmen wir die umgekehrte Perspektive ein und betrachten näher, wie die Formeln<br />

aussehen, mit denen wir rechnen (lassen) wollen. Mit anderen Worten: wir legen eine<br />

Programmiersprache fest. Diese Sprache wollen wir möglichst einfach halten, da sie uns<br />

nur als Vehikel dient, um über weitere Grundkonzepte der Informatik reden zu können.<br />

Wir werden also nur einen Auschnitt aus der Sprache Haskell einführen.<br />

Gliederung des Kapitels: Ein Haskell-Programm besteht aus einer Folge von Definitionen<br />

und Deklarationen: Definiert werden Werte, meistens Funktionen, und neue Datentypen;<br />

deklariert werden die Typen von Werten. Für Rechnungen spielen Deklarationen keine<br />

Rolle; sie sind nur der „Ordnung halber“ da. Aber wie sagt man so schön: „Ordnung ist<br />

das halbe Leben.“.<br />

3.1. Datentypen<br />

3.1.1. Datentypdefinitionen<br />

Neue Typen und die dazugehörigen Werte werden mittels einer Datentypdefinition definiert.<br />

Sie führen Daten-Konstruktoren (kurz Konstruktoren) ein, die unsere Formelwelt<br />

bereichern. Beispiele aus Abschnitt 2.1 sind Musik und Instrument, die wir hier noch<br />

einmal wiederholen:<br />