Algorithmische Geometrie - Vorlesungsskript

Algorithmische Geometrie - Vorlesungsskript

Algorithmische Geometrie - Vorlesungsskript

Sie wollen auch ein ePaper? Erhöhen Sie die Reichweite Ihrer Titel.

YUMPU macht aus Druck-PDFs automatisch weboptimierte ePaper, die Google liebt.

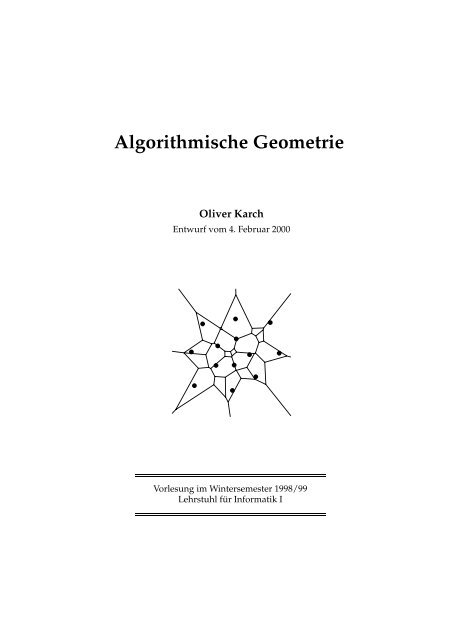

<strong>Algorithmische</strong> <strong>Geometrie</strong><br />

Oliver Karch<br />

Entwurf vom 4. Februar 2000<br />

Vorlesung im Wintersemester 1998/99<br />

Lehrstuhl für Informatik I

ii<br />

Dies ist das vorläufige Skript zur Vorlesung »<strong>Algorithmische</strong><br />

<strong>Geometrie</strong>« (10703) im Wintersemester<br />

1998/99. Über Kritik, Verbesserungsvorschläge<br />

oder gefundene Tippfehler würde ich<br />

mich sehr freuen!<br />

¡<br />

Oliver Karch<br />

���������������������������������

Inhaltsverzeichnis<br />

1 Einleitung 1<br />

1.1 Was ist »<strong>Algorithmische</strong> <strong>Geometrie</strong>«? . . . . . . . . . . . . . . . . . . . . . . . . . . . . 1<br />

1.2 Beispiele geometrischer Fragestellungen . . . . . . . . . . . . . . . . . . . . . . . . . . . 2<br />

1.3 Literatur . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 3<br />

1.4 Informationsquellen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 4<br />

1.5 WWW-Seiten zur Vorlesung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 4<br />

2 Grundbegriffe 5<br />

2.1 Topologie . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 5<br />

2.1.1 Der Abstandsbegriff und innere Punkte . . . . . . . . . . . . . . . . . . . . . . . 5<br />

2.1.2 Stetigkeit, Wege und Zusammenhang . . . . . . . . . . . . . . . . . . . . . . . . 8<br />

2.2 Graphentheorie . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 10<br />

2.2.1 Gerichtete Graphen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 10<br />

2.2.2 Ungerichtete Graphen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 12<br />

2.2.3 Wege und Kreise . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 13<br />

2.2.4 Geometrische Realisierungen und Planarität . . . . . . . . . . . . . . . . . . . . 14<br />

2.3 Komplexität von Algorithmen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 15<br />

2.3.1 Größenordnung von Funktionen . . . . . . . . . . . . . . . . . . . . . . . . . . . 15<br />

2.3.2 Berechnungsmodell . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 17<br />

2.3.3 Komplexitätsklassen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 17<br />

2.3.4 Das Entscheidungsbaummodell . . . . . . . . . . . . . . . . . . . . . . . . . . . 20<br />

3 Grundlegende <strong>Geometrie</strong> in der Ebene 23<br />

3.1 Elementare geometrische Objekte . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 23<br />

3.2 Elementare Lokationsprobleme . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 25<br />

3.2.1 Point-in-half-plane-Test . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 25<br />

3.2.2 Lage eines Punktes bezüglich eines Strahls . . . . . . . . . . . . . . . . . . . . . 25<br />

3.2.3 Schnitt zweier Strecken . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 27<br />

3.2.4 Die angulare Ordnung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 28<br />

3.2.5 Sektorbestimmung – Single-shot-Anfrage . . . . . . . . . . . . . . . . . . . . . . 30<br />

3.2.6 Sektorbestimmung – Multiple-shot-Anfrage . . . . . . . . . . . . . . . . . . . . 30

iv<br />

4 Polygone 33<br />

4.1 Spezialfall »Konvexe Polygone« . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 34<br />

4.1.1 Test auf Konvexität . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 36<br />

4.1.2 Point-in-polygon-Test . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 38<br />

4.2 Spezialfall »Sternförmige Polygone« . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 39<br />

4.2.1 Point-in-polygon-Test . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 41<br />

4.2.2 Erzeugen eines (sternförmigen) Polygons mit vorgegebener Eckenmenge . . . 43<br />

4.3 Point-in-polygon-Test bei allgemeinen Polygonen . . . . . . . . . . . . . . . . . . . . . 44<br />

5 Das Plane-sweep-Paradigma 47<br />

5.1 Das Problem des dichtesten Punktepaares . . . . . . . . . . . . . . . . . . . . . . . . . . 47<br />

5.2 Schnitt konvexer Polygone . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 51<br />

5.3 Anwendung »Schnitt von Halbebenen« . . . . . . . . . . . . . . . . . . . . . . . . . . . 52<br />

5.4 Schnitt von Liniensegmenten . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 55<br />

5.4.1 Schnittest . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 56<br />

5.4.2 Bestimmen aller Schnittpunkte . . . . . . . . . . . . . . . . . . . . . . . . . . . . 58<br />

5.5 Anwendung »Test auf Einfachheit« . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 61<br />

5.6 Anwendung »Überlagerung von PSLGs« und »Arrangement-Berechnung« . . . . . . 62<br />

6 Konvexe Hüllen ebener Punktmengen 67<br />

6.1 Eigenschaften und untere Schranke . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 67<br />

6.2 Inkrementelle Konstruktion . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 69<br />

6.3 Jarvis’s march . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 71<br />

6.4 Graham’s scan . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 73<br />

6.5 Konstruktion mittels Divide-and-conquer . . . . . . . . . . . . . . . . . . . . . . . . . . 74<br />

6.6 Quickhull . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 77<br />

6.7 Dynamische Verfahren . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 77<br />

7 Lokationsprobleme in der Ebene 79<br />

7.1 Die Slab-Methode . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 80<br />

7.2 Das Verfahren der verfeinerten Triangulationen . . . . . . . . . . . . . . . . . . . . . . 81<br />

7.2.1 Einschub »Die Eulersche Formel« . . . . . . . . . . . . . . . . . . . . . . . . . . 81<br />

7.2.2 Die Methode von Kirkpatrick . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 84<br />

7.2.3 Subdivision-Hierarchien . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 85<br />

8 Nachbarschaftsprobleme 89<br />

8.1 Definition und Eigenschaften des Voronoi-Diagramms . . . . . . . . . . . . . . . . . . 89<br />

8.2 Der Delaunay-Graph . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 94<br />

8.3 Verallgemeinerungen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 96<br />

8.4 Konstruktion des Voronoi-Diagramms . . . . . . . . . . . . . . . . . . . . . . . . . . . . 98<br />

8.4.1 Divide-and-conquer-Verfahren . . . . . . . . . . . . . . . . . . . . . . . . . . . . 98<br />

8.4.2 Sweep-line-Verfahren . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 100<br />

A Abkürzungen und Symbole 103<br />

Literaturverzeichnis 107

Einleitung<br />

1.1 Was ist »<strong>Algorithmische</strong> <strong>Geometrie</strong>«?<br />

Die <strong>Algorithmische</strong> <strong>Geometrie</strong> (engl. computational geometry) ist ein Teilgebiet<br />

der theoretischen Informatik, welches sich mit geometrischen Objekten<br />

(wie z. B. Punkten, Linien, Kreisen, Ebenen) beschäftigt.<br />

Die Ziele und Aufgabenstellungen hierbei sind<br />

• der Entwurf von effizienten Algorithmen zur Lösung geometrischer<br />

Probleme, bei denen sehr oft große Mengen geometrischer Objekte<br />

involviert sind,<br />

• die Bestimmung der algorithmischen Komplexität geometrischer<br />

Probleme, d. h. die Beantwortung von Fragen wie z. B. »Was sind<br />

untere Schranken für die Laufzeit und den Speicherbedarf eines<br />

Algorithmus?« oder »Gibt es zur Lösung eines Problems überhaupt<br />

einen praktikablen Algorithmus?«.<br />

Hierdurch grenzt sich die <strong>Algorithmische</strong> <strong>Geometrie</strong> von anderen Gebieten<br />

ab, die sich ebenfalls mit geometrischen Objekten beschäftigen<br />

(z. B. die Algebraische <strong>Geometrie</strong> oder die Differentialgeometrie). Als eigenständiges<br />

Gebiet der Informatik hat sich die <strong>Algorithmische</strong> <strong>Geometrie</strong><br />

Ende der 70er Jahre etabliert und spielt mittlerweile in vielen realen Anwendungen<br />

eine große Rolle:<br />

Computergrafik Möglichst realistische Berechnung von Bildern oder<br />

Filmen geometrisch modellierter Szenen, z. B. mittels Ray Tracingund<br />

Radiosity-Verfahren (Schlagwort Virtual Reality)<br />

1<br />

CAD/CAM (engl. computer aided design/manufacturing) Erzeugung<br />

geometrischer Objekte, beispielsweise mittels Vereinigung und<br />

Durchschnitt von Grundobjekten (z. B. Quader, Kugel usw.) oder<br />

mittels interpolierender Flächen durch vorgegebene Stützpunkte.<br />

Bekanntes Beispiel ist die Dresdner Frauenkirche, die im Zweiten Dresdner Frauenkirche<br />

Weltkrieg fast vollständig zerstört und zunächst am Computer<br />

realitätsgetreu rekonstruiert wurde (siehe z. B. ���������������<br />

�������������������). Weitere Schlagworte: Assemblierpla- WWW☞

2 Einleitung<br />

Map Overlay<br />

Industrieroboter<br />

KUKA KR 125/1<br />

konvexe Hülle<br />

nung und Digital Mock-Up bei der Fertigung von aus mehreren<br />

Teilen bestehenden Gütern (z. B. den Motorraum eines Autos), die<br />

in der richtigen Reihenfolge zusammengesetzt werden müssen<br />

Geographische Informationssysteme (GIS) Ein geographisches Informationssystem<br />

speichert geographische Daten (z. B. Länderkonturen,<br />

Flüsse, Bevölkerungsdichten usw.) und dient dazu, Anfragen<br />

zu beantworten, bei denen geometrische Eigenschaften miteinander<br />

kombiniert werden müssen. Beispielsweise könnte man<br />

einen Platz für ein neues Naherholungsgebiet suchen: ein günstiges<br />

Stück Land (Quadratmeterpreis ≤ x DM) einer gewissen Mindestfläche<br />

≥ y km 2 , das außerdem von den zu versorgenden Städten<br />

gut zu erreichen ist (Entfernung ≤ z km). Dies würde drei<br />

Anfragen an verschiedene geographische Datenbanken nach sich<br />

ziehen; die resultierenden Gebiete, welche die Kriterien erfüllen,<br />

müssen dann noch überlagert werden; ihre Schnittmenge (Stichwort<br />

Map Overlay) beantwortet dann die ursprüngliche Anfrage.<br />

Robotik (engl. robotics) Roboter sind meist Fahrzeuge (Fahrerlose<br />

Transportsysteme, FTS) oder mit Manipulatoren ausgestattete<br />

Industrieroboter. Typische Problemstellungen für solche Roboter<br />

sind<br />

• die Bewegungs- bzw. Bahnplanung, d. h. das Finden einer Bewegung<br />

von einer Anfangskonfiguration in eine Endkonfiguration,<br />

die zum einen Kollisionen mit der Umgebung vermeidet<br />

und zum anderen möglichst effizient ist,<br />

• die Lokalisation, d. h. die Bestimmung der eigenen Position anhand<br />

von Sensoren und Karten,<br />

• die Exploration einer unbekannten Umgebung, um z. B. eine<br />

Karte zu generieren.<br />

1.2 Beispiele geometrischer Fragestellungen<br />

Die folgenden realen Probleme lassen sich jeweils als geometrische Fragestellung<br />

modellieren und motivieren eine theoretische Untersuchung<br />

des jeweiligen Gebietes:<br />

Einzäunen von Apfelbäumen Auf einem Feld stehen einige Apfelbäume,<br />

die eingezäunt werden sollen.<br />

Frage: Wieviel Meter Zaun braucht man mindestens, um alle Bäume<br />

einzuzäunen? Wie muß der Zaun verlaufen?<br />

Geometrische Formulierung: Modelliere die Bäume als Punkte in<br />

der Ebene und bestimme die konvexe Hülle (siehe Kapitel 6) dieser<br />

Punktmenge.<br />

Christos Reichstag Gegeben die Pläne des Berliner Reichstages.

1.3 Literatur 3<br />

Frage: Wieviel Stoff wird mindestens benötigt, um den Reichstag<br />

zu verhüllen? Wie muß der Stoff zugeschnitten werden?<br />

Geometrische Formulierung: Bestimme die dreidimensionale konvexe<br />

Hülle des Reichstages.<br />

Nähestes Telefon Sie sind auf dem Unicampus und wollen telefonieren.<br />

Frage: Welches Telefon ist das näheste?<br />

Geometrische Formulierung: Modelliere die Telefone wieder als<br />

Punkte in der Ebene und bestimme eine Einteilung in Regionen<br />

mit gleichem nähesten Telefon. Diese Karte nennt man das Voronoi-Diagramm<br />

(siehe Kapitel 8). Voronoi-Diagramm<br />

Versorgung Mit einem Sender möglichst geringer Leistung wollen Sie<br />

eine Menge von Haushalten erreichen.<br />

Frage: Wo soll der Sender plaziert werden? Welche Leistung muß<br />

der Sender besitzen?<br />

Geometrische Formulierung: Suche die kleinste Kreisscheibe<br />

(engl. smallest enclosing circle), die alle Häuser überdeckt. smallest enclosing circle<br />

1.3 Literatur<br />

Lehrbücher zum Thema sind<br />

Buch Preis<br />

[5] M. de Berg, M. v. Kreveld, M. Overmars,<br />

O. Schwarzkopf. Computational Geometry: Algorithms<br />

and Applications.<br />

[8] H. Edelsbrunner. Algorithms in Combinatorial<br />

Geometry.<br />

54,– DM<br />

102,– DM<br />

[14] R. Klein. <strong>Algorithmische</strong> <strong>Geometrie</strong>. 58,– DM<br />

[19] J. O’Rourke. Computational Geometry in C. ca. 50,– DM<br />

[22] F. P. Preparata, M. I. Shamos. Computational Geometry:<br />

An Introduction.<br />

102,– DM<br />

Das Buch von Preparata und Shamos [22] zählt hierbei sicherlich zu<br />

den „Klassikern“ der <strong>Algorithmische</strong>n <strong>Geometrie</strong> und gibt einen guten<br />

Überblick über das Stoffgebiet. Es ist allerdings schon etwas in die Jahre<br />

gekommen; randomisierte Algorithmen werden dort beispielsweise<br />

überhaupt nicht behandelt.<br />

Einen aktuelleren Querschnitt erhält man in den Büchern von de Berg<br />

et al. [5] (jeweils anhand motivierender Beispiele und Anwendungen)<br />

und Klein [14], die beide sehr empfehlenswert sind. Das Buch von

4 Einleitung<br />

☞ WWW<br />

☞ WWW<br />

☞ WWW<br />

☞ WWW<br />

Edelsbrunner [8] ist ebenfalls ein „Klassiker“, behandelt aber mehr kombinatorische<br />

Aspekte der <strong>Algorithmische</strong>n <strong>Geometrie</strong>.<br />

Im Buch von O’Rourke [19], dessen überarbeitete zweite Auflage gerade<br />

erschienen ist, wird besonders auf die Implementierung geometrischer<br />

Algorithmen in C (und auch in Java) eingegangen.<br />

1.4 Informationsquellen<br />

Nützliche Informationen (z. B. zu Tagungen, Literaturdatenbanken,<br />

Mailinglisten usw.) finden sich auf der Homepage der GI-<br />

Fachgruppe 0. 1. 2 unter<br />

�������������������������������������������������<br />

Darüberhinaus sind die WWW-Seiten von Jeff Erickson (»Computational<br />

Geometry Pages«) unter<br />

�������������������������������������������<br />

und von David Eppstein (»Geometry in Action«) unter<br />

������������������������������������������<br />

sehr empfehlenswert.<br />

1.5 WWW-Seiten zur Vorlesung<br />

Die WWW-Seiten zur Vorlesung sind zu erreichen unter<br />

���������������������������������������������<br />

��������������������������������������

2.1 Topologie<br />

Referenzwerke: [9, 11, 23]<br />

Grundbegriffe<br />

In vielen Bereichen der <strong>Algorithmische</strong>n <strong>Geometrie</strong> spielen Abstände<br />

geometrischer Objekte eine Rolle, deshalb soll dieser Begriff zunächst<br />

formal dargestellt werden, um danach Begriffe wie »Stetigkeit«, »Weg«<br />

usw. ableiten zu können.<br />

2.1.1 Der Abstandsbegriff und innere Punkte<br />

Definition 2.1 (Metrik) Sei X eine Menge und d: X × X → R≥0 eine<br />

Abbildung, die je zwei Elementen x und y aus X einen Abstand d(x, y)<br />

zuordnet.<br />

Die Abbildung d ist eine Metrik, falls für alle x, y, z aus X folgendes gilt: Metrik<br />

d(x, y) = 0 ⇐⇒ x = y<br />

d(x, y) = d(y, x) (Symmetrie)<br />

d(x, z) ≤ d(x, y) + d(y, z) (Dreiecksungleichung)<br />

Das Paar (X, d) heißt dann metrischer Raum. metrischer Raum<br />

Befinden wir uns im d-dimensionalen reellen Raum R d , dann ist für zwei<br />

Punkte x = (x1, . . . , xd) und y = (y1, . . . , yd) die euklidische Metrik euklidische Metrik<br />

�<br />

�<br />

�<br />

|x y| := � d �<br />

(xi − yi) 2 (2.1)<br />

i=1<br />

definiert. Der Einfachheit halber bezeichnet man den R d zusammen<br />

mit der euklidischen Metrik auch als den d-dimensionalen euklidischen<br />

Raum, oder kurz E d . Im Rahmen dieser Vorlesung wird für uns fast ausschließlich<br />

der E 2 oder der E 3 eine Rolle spielen. Hier beschreibt die euklidische<br />

Metrik den gewohnten (euklidischen) Abstand zweier Punkte<br />

in der Ebene bzw. im Raum.<br />

2

6 Grundbegriffe<br />

Skalarprodukt<br />

Minkowski-Metriken<br />

x<br />

ε<br />

U ε(x)<br />

ε-Umgebung<br />

innerer Punkt<br />

Berührpunkt<br />

Randpunkt<br />

Bemerkung 2.2 Eine andere Möglichkeit die euklidische Metrik zu definieren,<br />

ist mittels des kanonischen Skalarprodukts des R d ,<br />

〈x, y〉 :=<br />

d�<br />

i=1<br />

xiyi .<br />

Bekanntlich ist das Skalarprodukt 〈x, y〉 = |x| |y| cos α, wobei |x| die euklidische<br />

Länge des Vektors x bezeichnet und α der Winkel zwischen den<br />

beiden Vektoren x und y ist.<br />

Somit gilt dann für die euklidische Distanz |x y| = |x − y| =<br />

� 〈x − y, x − y〉. ⊳<br />

Die euklidische Metrik ist nur ein spezielles Mitglied aus der Familie der<br />

Minkowski-Metriken Lp(x, y), die folgendermaßen definiert sind:<br />

Lp(x, y) :=<br />

und<br />

� d�<br />

i=1<br />

|xi − yi| p<br />

L∞(x, y) := d<br />

max<br />

i=1 |xi − yi|<br />

�1/p<br />

für 1 ≤ p < ∞<br />

(2.2)<br />

Für p = 2 erhält man also die euklidische Metrik, für p = 1 die sog.<br />

Manhattan-Metrik und für p = ∞ die sog. Maximum-Metrik.<br />

Mittels des Metrikbegriffes können nun auch die üblichen topologischen<br />

Begriffe definiert werden.<br />

Definition 2.3 Sei x ∈ X ein Punkt und A ⊆ X eine Teilmenge eines<br />

metrischen Raumes (X, d).<br />

• Für eine reelle Zahl ε > 0 heißt die Menge<br />

die ε-Umgebung von x.<br />

U ε(x) := { y ∈ X � � d(x, y) < ε } (2.3)<br />

• Ein Punkt x ∈ X heißt innerer Punkt von A, wenn es eine<br />

ε-Umgebung Uε(x) von x gibt, die ganz in A enthalten ist. Die<br />

Menge aller inneren Punkte von A heißt das Innere oder der offene<br />

Kern von A und wird mit A ◦ bezeichnet.<br />

• Ein Punkt x ∈ X heißt Berührpunkt von A, wenn in jeder<br />

ε-Umgebung Uε(x) von x ein Punkt aus A liegt. Die Menge aller<br />

Berührpunkte von A heißt die abgeschlossene Hülle von A und<br />

wird mit A bezeichnet.<br />

• Ein Punkt x ∈ X heißt Randpunkt von A, wenn in jeder<br />

ε-Umgebung Uε(x) von x sowohl ein Punkt aus A als auch ein<br />

Punkt aus dem Komplement A c := X \ A liegt, d. h. wenn x Berührpunkt<br />

von A und von A c ist. Die Menge aller Randpunkte<br />

von A heißt der Rand von A und wird mit ∂A bezeichnet.

2.1 Topologie 7<br />

• Die Menge A heißt offen (in X), falls jeder ihrer Punkte ein innerer offen und abgeschlossen<br />

Punkt ist. Sie heißt abgeschlossen (in X), falls ihr Komplement A c<br />

offen ist. Die Familie aller offenen Teilmengen eines metrischen<br />

Raumes (X, d) bezeichnet man auch als eine Topologie von X.<br />

Für eine Menge A ⊆ X erhalten wir hieraus einige einfache Folgerungen:<br />

• Die Menge A ist genau dann abgeschlossen, wenn sie alle ihre Berührpunkte<br />

enthält. Denn es gilt<br />

A ist abgeschlossen ⇐⇒ A c = X \ A ist offen<br />

⇐⇒ ∀ x∈X\A ∃ε>0 U ε(x) ⊆ X \ A<br />

⇐⇒ ∀ x∈X\A ∃ε>0 U ε(x) ∩ A = ∅<br />

⇐⇒ ∀ x∈X\A x ist kein Berührpunkt von A<br />

⇐⇒ (X \ A) ∩ A = ∅<br />

⇐⇒ A ⊆ A .<br />

• Es gilt immer die Inklusion A ◦ ⊆ A ⊆ A, denn jede<br />

ε-Umgebung U ε(x) für einen Punkt x enthält diesen selbst.<br />

Daraus folgt<br />

A ist offen ⇐⇒ A = A ◦ ∧ A ist abgeschlossen<br />

⇐⇒ A = A .<br />

• Es gelten die beiden Dualitätsbeziehungen<br />

(A ◦ ) c = X \ A ◦ = X \ A = A c , und<br />

(A) c = X \ A = (X \ A) ◦ = (A c ) ◦ , wegen<br />

x ∈ X \ A ◦ ⇐⇒ ∄ε>0 U ε(x) ⊆ A<br />

⇐⇒ ∀ε>0 U ε(x) � A<br />

⇐⇒ ∀ε>0 U ε(x) ∩ X \ A �= ∅<br />

⇐⇒ x ∈ X \ A , und<br />

x ∈ X \ A ⇐⇒ x /∈ A<br />

⇐⇒ ¬∀ε>0 U ε(x) ∩ A �= ∅<br />

⇐⇒ ¬∀ε>0 U ε(x) � X \ A<br />

⇐⇒ ∃ε>0 U ε(x) ⊆ X \ A<br />

⇐⇒ x ∈ (X \ A) ◦ .<br />

Damit erhält man dann für den Rand ∂A einer Menge A<br />

∂A = A ∩ A c = A ∩ (A ◦ ) c = A \ A ◦ .

8 Grundbegriffe<br />

E 2<br />

1<br />

U ε<br />

−1 S 1 E<br />

−1<br />

Relativtopologie<br />

stetig<br />

Weg<br />

einfacher Weg<br />

Beispiel 2.4 Die Strecke S = [−1, 1] ist in E abgeschlossen, ihr Rand ist<br />

die Menge R = {−1, 1} und ihr Inneres die Menge I = (−1, 1). Die punktierte<br />

Strecke S ′ = S \ {0} ist weder abgeschlossen noch offen und ihr<br />

Rand ist die Menge R ′ = {−1, 0, 1}.<br />

Faßt man E als Teilmenge des E 2 auf (in der Form E × {0} ⊆ E 2 ), dann<br />

ist S (genauer, die Menge S × {0}) immer noch abgeschlossen. Im E 2<br />

besitzt S aber keine inneren Punkte mehr, denn eine ε-Umgebung im E 2<br />

ist eine (offene) Kreisfläche, die in S keinen Platz findet. ⊳<br />

Oft möchte man über das Innere einer Menge reden können, auch wenn<br />

diese wie im letzten Beispiel in einen höherdimensionalen Raum eingebettet<br />

ist.<br />

Definition 2.5 (Relativtopologie) Sei R ⊆ X eine Teilmenge eines metrischen<br />

Raumes (X, d), dann ist für einen Punkt x ∈ R dessen ε-Umgebung<br />

in R definiert durch<br />

U R ε (x) := { y ∈ R � � d(x, y) < ε } = U ε(x) ∩ R . (2.4)<br />

Die hierdurch auf R entstehende Topologie heißt die von X induzierte<br />

Topologie oder Relativtopologie.<br />

Die übrigen Definitionen übertragen sich, indem man jeweils U ε(x)<br />

durch U R ε (x) und X durch R ersetzt. Im obigen Beispiel verwenden<br />

wir R = E × {0} und erhalten dann – wie erwartet – für das relative Innere<br />

von S × {0} die Menge (−1, 1) × {0} in Analogie zu Beispiel 2.4.<br />

2.1.2 Stetigkeit, Wege und Zusammenhang<br />

Mit Hilfe des durch die Metrik festgelegten Abstandsmaßes können wir<br />

nun definieren, wann eine Abbildung von einem metrischen Raum in<br />

einen anderen stetig ist und darauf aufbauend den Begriff des Weges<br />

einführen.<br />

Definition 2.6 (Stetigkeit) Seien (X, d) und (Y, e) metrische Räume<br />

und f: X → Y eine Abbildung. f ist genau dann im Punkt ˜x ∈ X stetig,<br />

wenn zu jedem ε > 0 ein δ > 0 existiert, so daß<br />

e(f(x), f(˜x)) < ε für alle x ∈ X mit d(x, ˜x) < δ .<br />

Definition 2.7 (Wege und Zusammenhang)<br />

Unter einem Weg w von a ∈ X nach b ∈ X verstehen wir das Bild einer<br />

stetigen Abbildung<br />

�w: [0, 1] → X mit �w(0) = a und �w(1) = b<br />

und nennen �w eine Parametrisierung des Weges w.<br />

• Der Weg w heißt geschlossen, wenn �w(0) = �w(1) gilt.<br />

• Der Weg w heißt einfach oder doppelpunktfrei, wenn �w auf [0, 1)<br />

injektiv ist.

2.1 Topologie 9<br />

• Eine Menge A ⊆ X heißt wegzusammenhängend, wenn je zwei wegzusammenhängend<br />

Punkte von A durch einen Weg verbunden werden können, der<br />

ganz in A verläuft.<br />

»Wegzusammenhang« ist eine Äquivalenzrelation und induziert<br />

eine Zerlegung von A in disjunkte Zusammenhangskomponenten.<br />

Abbildung 2.1 zeigt einige Beispiele für Wege in der Ebene: Alle vier<br />

Wege mit Ausnahme von w1 sind geschlossen; nur die Wege w1 und w4<br />

sind doppelpunktfrei.<br />

Bemerkung 2.8 Zu jedem Weg w (außer zum trivialen Weg �w([0, 1]) ≡<br />

a) gibt es unendlich viele Parametrisierungen. Wir können uns eine Parametrisierung<br />

vorstellen als die Art und Weise, wie der Weg abgelaufen<br />

wird. Die Ableitung �w ′ entspräche dann der „Geschwindigkeit“ beim<br />

Ablaufen des Weges. ⊳<br />

Zusammenhangskomponenten<br />

Für einen einfachen geschlossenen Weg w im E 2 (wie z. B. der Weg w4<br />

in Abbildung 2.1) besagt der Jordansche Kurvensatz, daß R 2 \ w aus ge- Jordanscher Kurvensatz<br />

nau zwei Gebieten (offene und wegzusammenhängende Mengen) besteht,<br />

deren Rand w ist: einem von w umschlossenen inneren und einem<br />

unbeschränkten äußeren Gebiet. Der Beweis dieser alles andere als<br />

trivialen Aussage findet sich für Interessierte z. B. in [17].<br />

Definition 2.9 (Einfacher Wegzusammenhang) Eine wegzusammenhängende<br />

Menge A ⊆ E2 heißt einfach-wegzusammenhängend, wenn<br />

für jeden in A verlaufenden einfachen geschlossenen Weg sein inneres<br />

Gebiet ebenfalls in A enthalten ist.<br />

Anschaulich bedeutet der einfache Wegzusammenhang einer Menge,<br />

daß sie keine „Löcher“ besitzt. Siehe hierzu das Beispiel in Abbildung<br />

2.2 auf der folgenden Seite.<br />

Beim Umgang mit den oben definierten Wegen interessiert natürlich<br />

auch deren Länge. Diese kann man durch Approximation mit Streckenzügen<br />

definieren: Man wählt n Stützstellen 0 = t1 < . . . < tn = 1<br />

und bildet die Summe �i=n−1 i=1 d( �w(ti), �w(ti+1) über alle Abstände. Der<br />

Limes für n → ∞ des Supremums dieser Summe für alle möglichen<br />

Wahlen von n aufeinanderfolgenden Stützstellen im Intervall [0, 1] bezeichnet<br />

man als die Länge des Weges w. Wenn dieser Wert endlich ist,<br />

nennt man w rektifizierbar.<br />

Für einen Weg w im E 2 , der durch �w(t) = (x(t), y(t)) parametrisiert ist,<br />

kann man die Integralformel für die Weglänge<br />

a<br />

w1<br />

b<br />

a = b<br />

w2<br />

a = b<br />

w3<br />

a = b<br />

w4<br />

einfachwegzusammenhängend<br />

a<br />

Weglänge mittels<br />

Approximation durch<br />

Streckenzüge<br />

Integralformel für die<br />

Weglänge<br />

b<br />

Abbildung 2.1<br />

Die Wege w1 und w4 sind<br />

einfach, w2, w3, w4 sind<br />

geschlossen

10 Grundbegriffe<br />

Abbildung 2.2<br />

Menge A ist einfach<br />

wegzusammenhängend,<br />

Menge B nicht<br />

gerichteter Graph<br />

Schlinge<br />

A<br />

w<br />

Länge(w) =<br />

� 1<br />

0<br />

B<br />

�<br />

x ′ (t) 2 + y ′ (t) 2 dt (2.5)<br />

benutzen, sofern die Koordinatenfunktionen stetig differenzierbar sind.<br />

2.2 Graphentheorie<br />

Referenzwerke: [12, 15, 18]<br />

Für viele Aufgabenstellungen in der <strong>Algorithmische</strong>n <strong>Geometrie</strong> ist eine<br />

Modellierung mittels eines Graphen hilfreich oder die auftretenden Objekte<br />

selbst sind Graphen bzw. durch solche beschreibbar (siehe z. B. das<br />

Voronoi-Diagramm und der dazu duale Delaunay-Graph in Kapitel 8).<br />

2.2.1 Gerichtete Graphen<br />

Definition 2.10 (Gerichteter Graph) Ein Quadrupel G = (V, R, α, ω) ist<br />

ein gerichteter Graph (oder kurz Graph), wenn folgendes gilt:<br />

1. Die Eckenmenge V �= ∅ und die Pfeilmenge R des Graphen sind<br />

disjunkt, V ∩ R = ∅.<br />

2. Die Abbildungen α: R → V und ω: R → V weisen jedem Pfeil r ∈<br />

R eine Anfangsecke α(r) und eine Endecke ω(r) zu.<br />

Der Graph G heißt endlich, wenn |V ∪ R| < ∞ gilt.<br />

Definition 2.11 Sei G = (V, R, α, ω) ein Graph. Ein Pfeil r ∈ R heißt<br />

Schlinge, wenn α(r) = ω(r). Der Graph G heißt schlingenfrei, wenn er<br />

keine Schlingen enthält.<br />

Zwei Pfeile r �= r ′ heißen parallel, wenn α(r) = α(r ′ ) und ω(r) = ω(r ′ ).<br />

Die Pfeile r �= r ′ heißen invers, wenn α(r) = ω(r ′ ) und ω(r) = α(r ′ ).<br />

w

2.2 Graphentheorie 11<br />

α ω<br />

r1 v1 v2<br />

r2 v1 v2<br />

r3 v2 v3<br />

r4 v3 v3<br />

r5 v4 v3<br />

r6 v3 v4 v1 v5<br />

r1<br />

r2<br />

Der Graph G heißt einfach oder schlicht, wenn er schlingenfrei ist und einfach<br />

keine Parallelen enthält. In diesem Fall ist jeder Pfeil r eindeutig durch<br />

das Paar (α(r), ω(r)) charakterisiert. Man kann dann auch einfach G =<br />

(V, R) schreiben, mit R ⊆ V × V.<br />

Beispiel 2.12 Der in Abbildung 2.3 dargestellte Graph besitzt eine<br />

Schlinge (r4), zwei parallele Pfeile (r1 und r2), sowie zwei inverse Pfeile<br />

(r5 und r6). Aufgrund der Schlinge und der beiden Parallelen ist er also<br />

nicht einfach. ⊳<br />

v2<br />

r3<br />

r5<br />

v3<br />

v4<br />

r4<br />

r6<br />

Abbildung 2.3<br />

Ein Graph und seine<br />

geometrische Realisierung<br />

im E 2<br />

Definition 2.13 Sei G = (V, R, α, ω) ein Graph. Zwei Ecken u und v<br />

heißen adjazent oder benachbart, wenn es einen Pfeil r ∈ R gibt mit adjazente Ecken<br />

α(r) = u ∧ ω(r) = v oder α(r) = v ∧ ω(r) = u.<br />

Eine Ecke u und ein Pfeil r heißen inzident, wenn u ∈ {α(r), ω(r)}. Zwei inzident<br />

Pfeile r und r ′ heißen inzident, wenn es eine Ecke v gibt, die mit r und<br />

mit r ′ inzidiert.<br />

Für eine Ecke v ∈ V heißt<br />

B + (v) := { r ∈ R � � α(r) = v }<br />

das von v ausgehende Pfeilbüschel,<br />

B − (v) := { r ∈ R � � ω(r) = v }<br />

das in v mündende Pfeilbüschel,<br />

N(v) := { u ∈ V � � ∃r∈R α(r) = v ∧ ω(r) = u }<br />

die Nachfolgermenge von v,<br />

V(v) := { u ∈ V � � ∃r∈R α(r) = u ∧ ω(r) = v }<br />

die Vorgängermenge von v,<br />

g + (v) := |B + (v)| der Außengrad von v,<br />

g − (v) := |B − (v)| der Innengrad von v,<br />

g(v) := g + (v) + g − (v) der Grad von v.<br />

Beispiel 2.14 Im Graph von Abbildung 2.3 münden in die Ecke v2 zwei<br />

Pfeile (r1 und r2) und ihr Innengrad ist somit gleich 2. Ihre Vorgängermenge<br />

enthält dagegen nur die eine Ecke v1.<br />

Für die isolierte Ecke v5 gilt: B + (v5) = B − (v5) = N(v5) = V(v5) = ∅<br />

und g + (v5) = g − (v5) = g(v5) = 0. ⊳

12 Grundbegriffe<br />

Teilgraph<br />

Obergraph<br />

Partialgraph<br />

Subgraph<br />

ungerichteter Graph<br />

Bemerkung 2.15 Für Graphen mit endlicher Pfeilmenge, d. h. |R| < ∞,<br />

gilt<br />

1. �<br />

v∈V g+ (v) = �<br />

v∈V g− (v) = |R| und<br />

2. �<br />

v∈V g(v) = 2 |R|. ⊳<br />

Definition 2.16 (Teilgraph und Obergraph)<br />

Ein Graph G ′ = (V ′ , R ′ , α ′ , ω ′ ) heißt Teilgraph eines Graphen G =<br />

(V, R, α, ω) (i. Z. G ′ ⊑ G), wenn gilt<br />

1. V ′ ⊆ V und R ′ ⊆ R sowie<br />

2. α|R ′ = α ′ und ω|R ′ = ω ′ .<br />

In diesem Fall heißt G dann Obergraph von G ′ (i. Z. G ⊒ G ′ ).<br />

Bemerkung 2.17 Die Relation „⊑“ ist (ebenso wie „⊒“)<br />

1. reflexiv (G ⊑ G),<br />

2. antisymmetrisch (G ⊑ G ′ ∧ G ′ ⊑ G =⇒ G = G ′ ) und<br />

3. transitiv (G ⊑ G ′ ∧ G ′ ⊑ G ′′ =⇒ G ⊑ G ′′ ). ⊳<br />

Definition 2.18 (Partialgraph und Subgraph)<br />

Sei G = (V, R, α, ω) ein Graph und R ′ ⊆ R eine Kantenteilmenge.<br />

Der durch R ′ induzierte Partialgraph GR ′ ist definiert durch GR ′<br />

(V, R<br />

:=<br />

′ , α|R ′, ωR ′).<br />

Für eine Eckenteilmenge V ′ ⊆ V ist der durch V ′ induzierte Subgraph<br />

definiert durch G[V ′ ] := (V ′ , RV ′, α|R V ′ , ωR V ′ ) mit RV ′ := { r ∈ R � �<br />

α(r) ∈ V ′ ∧ ω(r) ∈ V ′ }.<br />

Ein Graph H heißt Partialgraph (bzw. Subgraph) von G, wenn es eine<br />

Kantenteilmenge R ′ ⊆ R (bzw. Eckenteilmenge V ′ ⊆ V) gibt, so daß<br />

H = GR ′ (bzw. H = G[V ′ ]) gilt.<br />

2.2.2 Ungerichtete Graphen<br />

Definition 2.19 (Ungerichteter Graph) Ein Tripel G = (V, E, γ) ist ein<br />

ungerichteter Graph, wenn folgendes gilt:<br />

1. Die Eckenmenge V �= ∅ und die Kantenmenge E des Graphen<br />

sind disjunkt, V ∩ E = ∅.<br />

2. Die Abbildung γ: E → { X � � X ⊆ V ∧ 1 ≤ |X| ≤ 2 } weist jeder<br />

Kante zwei Endpunkte zu (bzw. einen Endpunkt im Fall einer<br />

Schlinge).<br />

Der Graph G heißt endlich, wenn |V ∪ R| < ∞ gilt.

2.2 Graphentheorie 13<br />

Begriffe wie parallel, einfach, Adjazenz, Inzidenz usw. sind analog zu den<br />

Begriffen in gerichteten Graphen definiert.<br />

Im Falle eines einfachen Graphen G = (V, E, γ), der also weder Schlingen<br />

noch Parallelen enthält, ist jede Kante e ∈ E eindeutig durch die zweielementige<br />

Menge γ(e) = {u, v} ihrer Endpunkte charakterisiert. Man<br />

kann dann auch G = (V, E) für den ungerichteten Graphen schreiben.<br />

Bemerkung 2.20 Oft werden wir unter leichtem Mißbrauch der Notation<br />

auch (u, v) anstelle von {u, v} für eine ungerichtete Kante schreiben.<br />

⊳<br />

2.2.3 Wege und Kreise<br />

Definition 2.21 (Weg und Kreis) Ein Weg w in einem Graphen G = Weg<br />

(V, R, α, ω) ist eine endliche Folge w = (r1, . . . , rn), n ≥ 1, von Pfeilen<br />

ri ∈ R (für i = 1, . . . , n), für die gilt<br />

ω(ri) = α(ri+1) für i = 1, . . . , n − 1.<br />

Die Startecke des Weges ist α(w) := α(r1) und die Endecke ist ω(w) :=<br />

ω(rn). Die Länge |w| des Weges w ist die Anzahl n der durchlaufenen<br />

Pfeile.<br />

Ein Weg w mit α(w) = ω(w) heißt Kreis. Kreis<br />

Die Eckenmenge s(w) := {α(r1), . . . , α(rn), ω(rn)} bezeichnen wir als<br />

die Spur des Weges w. Eine Ecke v wird von w berührt, wenn v ∈ s(w)<br />

gilt.<br />

Ein Weg w heißt einfach, wenn ri �= rj für i �= j, d. h. wenn er keinen<br />

Pfeil mehr als einmal durchläuft.<br />

Ein Weg w heißt elementar, wenn α(ri) �= α(rj) und ω(ri) �= ω(rj)<br />

für i �= j, d. h. wenn er keine Ecke mehr als einmal durchläuft – mit<br />

Ausnahme des Falles, daß Anfangs- und Endecke übereinstimmen.<br />

Beispiel 2.22 In Abbildung 2.3 auf Seite 11 ist der Weg w =<br />

(r1, r3, r6, r5) zwar einfach, aber nicht elementar, da die Ecke v3 zweimal<br />

besucht wird.<br />

Der Weg w = (r5, r6) ist ein elementarer (und damit auch einfacher)<br />

Kreis. ⊳<br />

Definition 2.23 (Weg und Kreis im ungerichteten Graphen)<br />

Ein Weg w in einem ungerichteten Graphen G = (V, E, γ) ist eine endli- Weg<br />

che Folge w = (e1, . . . , en), n ≥ 1, von Kanten ei ∈ E (für i = 1, . . . , n),<br />

für die es Ecken v0, . . . , vn ∈ V gibt, so daß gilt<br />

γ(ei) = {vi−1, vi} für i = 1, . . . , n.<br />

Die Startecke des Weges ist α(w) := v0 und die Endecke ist ω(w) := vn.

14 Grundbegriffe<br />

erreichbar<br />

Zusammenhang<br />

geometrische Realisierung<br />

geometrischer Graph<br />

Die Begriffe Länge, Spur, einfach und elementar sind analog zum gerichteten<br />

Fall definiert.<br />

Definition 2.24 (Erreichbarkeit) Eine Ecke v ′ in einem (gerichteten oder<br />

ungerichteten) Graphen G heißt von einer Ecke v aus erreichbar, wenn<br />

entweder v = v ′ gilt oder es einen Weg w gibt mit α(w) = v und ω(w) =<br />

v ′ . Die (in G) von v aus erreichbaren Ecken werden mit EG(v) bezeichnet,<br />

oder kurz E(v), wenn klar ist, um welchen Graphen es sich handelt.<br />

Beispiel 2.25 In Abbildung 2.3 auf Seite 11 ist die Menge der von v2 erreichbaren<br />

Ecken E(v2) = {v2, v3, v4} und die Menge der von v5 erreichbaren<br />

Ecken E(v5) = {v5}. ⊳<br />

Definition 2.26 (Zusammenhang)<br />

Ein gerichteter Graph G = (V, R, α, ω) heißt (stark) zusammenhängend,<br />

wenn für jede Ecke v ∈ V gilt EG(v) = V.<br />

Ein ungerichteter Graph G = (V, E, γ) heißt zusammenhängend, wenn<br />

für jede Ecke v ∈ V gilt EG(v) = V.<br />

Anschaulich bedeutet also der (starke) Zusammenhang eines Graphen,<br />

daß jede Ecke eines Graphens jede andere Ecke über einen Weg erreichen<br />

kann.<br />

2.2.4 Geometrische Realisierungen und Planarität<br />

Einen Graphen durch Angabe seiner Ecken- und Pfeilmenge sowie der<br />

Abbildungen α und ω zu beschreiben ist meist mühsam, wie Abbildung<br />

2.3 auf Seite 11 (links) zeigt. Intuitiver ist eine geometrische Realisierung<br />

des Graphen, z. B. in der Ebene (rechte Seite der Abbildung).<br />

Definition 2.27 (Geometrischer Graph) Sei G = (V, R, α, ω) ein Graph<br />

und (X, d) ein metrischer Raum. Eine geometrische Realisierung des<br />

Graphen G bildet die Ecken auf paarweise verschiedene Punkte in X ab.<br />

Die Pfeile werden auf einfache Wege abgebildet, welche die Bildpunkte<br />

der entsprechenden Ecken verbinden und sonst keine Bildpunkte anderer<br />

Ecken berühren. Das Ergebnis nennt man einen zu G gehörenden<br />

geometrischen Graphen.<br />

Bemerkung 2.28 Oftmals werden wir unter leichtem Mißbrauch der<br />

Notation die beiden Begriff »(abstrakter) Graph« und »geometrischer<br />

Graph« gleichsetzen und schlicht von einem Graphen sprechen. ⊳<br />

Für uns spielen fast ausschließlich geometrische Realisierungen in der<br />

Ebene E 2 (oder in anderen „flächigen“ Räumen, z. B. auf der Oberfläche<br />

einer Kugel) eine Rolle. Besonders interessant sind hierbei solche<br />

Realisierungen, bei denen sich keine Pfeile kreuzen.

2.3 Komplexität von Algorithmen 15<br />

Definition 2.29 (Planarer Graph) Ein geometrischer Graph, dessen<br />

Pfeile sich ausschließlich in den Endpunkten berühren, heißt<br />

kreuzungsfrei. kreuzungsfrei<br />

Ein Graph, der sich in der Ebene E 2 kreuzungsfrei realisieren läßt, heißt<br />

planar. planar<br />

Beispiel 2.30 In Abbildung 2.4 sehen wir links zwei verschiedende geometrische<br />

Realisierungen desselben planaren Graphen: eine kreuzungsfreie<br />

und eine, bei der der Pfeil r6 den Pfeil r5 schneidet. (Genauer: Das<br />

Bild des Pfeiles r6 schneidet das Bild des Pfeiles r5.)<br />

Der in der Abbildung rechts dargestellte Graph besitzt dagegen keine<br />

geometrische Realisierung in der Ebene (wohl aber auf der Oberfläche<br />

eines Torus) und ist somit nicht planar. ⊳<br />

r1<br />

v2<br />

v1<br />

r6<br />

r5<br />

r2<br />

r4<br />

r3<br />

v3<br />

v4<br />

r1<br />

v2<br />

v1<br />

2.3 Komplexität von Algorithmen<br />

Referenzwerke: [21, 10, 4]<br />

r5<br />

r2<br />

r4<br />

Die Effizienz eines Algorithmus ermittelt man üblicherweise anhand<br />

seines Verbrauchs an Rechenzeit und Speicherplatz. Außer bei ganz einfachen<br />

Problemen hängt dieser Bedarf in irgendeiner Weise von der Problemgröße<br />

ab, z. B. von der Anzahl n der einzuzäunenden Apfelbäume<br />

in unserem Einführungsbeispiel in Abschnitt 1.2 auf Seite 2).<br />

Beim Vergleich zweier Algorithmen interessiert uns hierbei nicht der<br />

exakte Zeit- und Platzbedarf einer Implementation für eine konkrete<br />

Eingabe. Stattdessen wollen wir für einen Algorithmus seine Laufzeit<br />

und seinen Speicherplatzbedarf als Funktion der Eingabegröße darstellen<br />

und diese – größenordnungsmäßig – mit den Zeit- und Speicheranforderungen<br />

anderer Algorithmen vergleichen.<br />

2.3.1 Größenordnung von Funktionen<br />

Sei M die Menge aller reellwertigen Funktionen f: N → R auf den natürlichen<br />

Zahlen.<br />

r3<br />

v3<br />

v4<br />

r6<br />

Abbildung 2.4<br />

Zwei geometrische<br />

Realisierungen eines<br />

planaren Graphen sowie<br />

ein nicht-planarer Graph<br />

Rechenzeit und<br />

Speicherplatz

16 Grundbegriffe<br />

O-Notation<br />

Ω-Notation<br />

Θ-Notation<br />

o-Notation<br />

anonyme Funktion<br />

insertion sort<br />

Definition 2.31 Für eine Funktion g ∈ M definieren wir die folgenden<br />

Klassen von Funktionen:<br />

• O(g) := { f ∈ M � � ∃c∈R≥0 ∃n0∈N ∀n≥n0 |f(n)| ≤ c · |g(n)| },<br />

alle Funktionen höchstens von der Größenordnung von g<br />

• Ω(g) := { f ∈ M � � ∃c∈R≥0 ∃n0∈N ∀n≥n0 |f(n)| ≥ c · |g(n)| },<br />

alle Funktionen mindestens von der Größenordnung von g<br />

• Θ(g) := O(g) ∩ Ω(g),<br />

alle Funktionen genau von der Größenordnung von g<br />

• o(g) := { f ∈ M � � ∀c∈R>0 ∃n0∈N ∀n≥n0 |f(n)| < c · |g(n)| },<br />

alle Funktionen von geringerer Größenordnung als g<br />

Am häufigsten wird uns die O-Notation zur Angabe von oberen Schranken<br />

und die Ω-Notation zur Angabe von unteren Schranken (z. B. für die<br />

Laufzeit eines Algorithmus) begegnen.<br />

Bemerkung 2.32 Die oben definierten Klassen sind Mengen von Funktionen.<br />

Deshalb sollte man korrekterweise für eine Funktion f(n) von<br />

genau quadratischer Größenordnung auch schreiben f(n) ∈ Θ(n 2 ) und<br />

nicht f(n) = Θ(n 2 ).<br />

Manchmal möchte man aber auch mit dem Klassensymbol rechnen können,<br />

z. B. um eine untere Schranke für die Funktion h(n) zu definieren:<br />

h(n) = g(n) + Ω(f(n)). Das Symbol Ω(f(n)) spielt dann die Rolle ei-<br />

ner anonymen Funktion mindestens von der Größenordnung von f(n),<br />

die wir aber nicht genau spezifieren wollen (oder können). Beim Rechnen<br />

mit solchen anonymen Funktionen, sollte man sich immer an die<br />

zugrundeliegende Definition erinnern! ⊳<br />

Beispiel 2.33 Der Ausdruck �n i=1 O(i) beschreibt eine obere Laufzeitschranke<br />

für das naive Sortieren von n Zahlen durch Einfügen (engl. insertion<br />

sort). Hier ist es nicht zulässig, die anonyme Funktion O(i) in der<br />

Summe in n verschiedene anonyme Funktionen aufzuteilen. Dies würde<br />

zum falschen Ergebnis �n i=1 O(i) = O(1) + O(2) + · · · + O(n) = O(n)<br />

führen.<br />

Denn in �n i=1 O(i) gibt es nur eine einzige anonyme Funktion, die von i<br />

(und nicht von n) abhängt, nämlich i ↦→ i. Richtig ist deshalb<br />

n�<br />

n�<br />

O(i) = { f ∈ M � � ∃c∈R≥0 ∃i0∈N ∀i≥i0 |f(i)| ≤ c · |i| }<br />

i=1<br />

i=1<br />

= { f ∈ M � � ∃c∈R≥0 ∃n0∈N<br />

n�<br />

∀n≥n0 |f(n)| ≤ c · |i| }<br />

i=1<br />

= { f ∈ M � � ∃c∈R≥0 ∃n0∈N<br />

� �<br />

�<br />

∀n≥n0 |f(n)| ≤ c · �<br />

n(n + 1) �<br />

�<br />

� 2 � }<br />

= O(n 2 ) .<br />

Die Summation muß also in den O-Ausdruck „hineingezogen“ werden!<br />

⊳

2.3 Komplexität von Algorithmen 17<br />

2.3.2 Berechnungsmodell<br />

Bei Laufzeitanalysen verwenden wir das Maschinenmodell der Unit-<br />

Cost Real RAM (Random Access Machine), siehe [22,21]. Diese Maschine Unit-Cost Real RAM<br />

verfügt über abzählbar unendlich viele Speicherzellen, die jeweils eine<br />

beliebige reelle Zahl aufnehmen können. Folgende Operationen können<br />

jeweils in einem Maschinentakt ausgeführt werden:<br />

Ein- oder Ausgabe eines Registers, Vergleich zweier Register E/A, �, (+, −, ·, /),<br />

und bedingte Verzweigung sowie die arithmetischen Operationen<br />

Addition, Subtraktion, Multiplikation und Division.<br />

if . . . then . . .<br />

Die Speicherzellen können dabei jeweils direkt oder indirekt adressiert<br />

werden.<br />

Für bestimmte Fälle wird manchmal die Menge der erlaubten arithmetischen<br />

Grundoperationen noch erweitert, so daß auch analytische Funktionen<br />

(also z. B. das Ziehen der k-ten Wurzel, trigonometrische Funktionen<br />

usw.) in einem Takt berechnet werden können. Hierauf wird dann<br />

aber gesondert hingwiesen.<br />

Obwohl die Arbeitsweise der Unit-Cost Real RAM derjenigen realer<br />

Rechner sehr ähnlich ist, muß man beachten, daß sie in einem Takt Zah- reale Rechner<br />

len beliebiger Größe verarbeiten kann. Auf diese Weise können ausgedehnte<br />

Berechnungen durch eine geeignete Codierung in einem einzigen<br />

Takt „versteckt“ werden. Damit ist dieses Modell echt mächtiger als<br />

das der Turing-Maschine.<br />

Um dieses Problem auszuschließen, kann man fordern, daß alle auftretenden<br />

Zahlen eine nach oben beschränkte Codierungslänge besitzen,<br />

d. h. rational sind in der Form p<br />

q mit p, q ∈ Q und |p| , |q| ≤ C für eine<br />

Konstante C. Dann kann die Real RAM mit polynomiellem Mehraufwand<br />

auch auf einem realen Rechner simuliert werden. Der Einfachheit<br />

halber bleiben wir aber beim Modell der Unit-Cost Real RAM.<br />

2.3.3 Komplexitätsklassen<br />

Sei Π ein Problem, welches ein Algorithmus1 A lösen kann (z. B. das<br />

Sortieren einer Menge von Zahlen). Um die Komplexität des Algorith-<br />

mus A zu beschreiben, sei die Funktion TA : Π → N definiert als die Zahl<br />

der Taktzyklen, die zur Lösung einer konkreten Probleminstanz P ∈ Π<br />

(z. B. das Sortieren der Zahlen {8.1, 24, −3.4, 56}) benötigt werden. Die<br />

Funktion SA : Π → N sei hierbei die maximale Anzahl belegter Speicherzellen<br />

während der Ausführung des Algorithmus. Die Größe der<br />

Probleminstanz (d. h. die Anzahl der zu sortierenden Zahlen in obigem<br />

Beispiel) bezeichnen wir mit |P|.<br />

1 Ein solcher Algorithmus kann auch nichtdeterministisch sein, d. h. er kann seine Berechnung<br />

in mehrere parallele Wege aufspalten, von denen nur einer das gewünschte Resultat<br />

liefern muß. Bei einem deterministischen Algorithmus gibt es solche Verzweigungen nicht.<br />

beschränkte<br />

Codierungslänge<br />

Instanz<br />

Problem Π<br />

Lösung<br />

Algorithmus<br />

A

18 Grundbegriffe<br />

Worst-case-Laufzeit<br />

Worst-case-Speicherbedarf<br />

Average-case-Analyse<br />

randomisierter<br />

Algorithmus<br />

Definition 2.34 (Worst-case-Laufzeit und -Speicherbedarf)<br />

Sei A ein Algorithmus für ein Problem Π, dann bezeichnen<br />

die Worst-case-Laufzeit und<br />

tA(n) := max<br />

P∈Π,|P|=n TA(P)<br />

sA(n) := max<br />

P∈Π,|P|=n SA(P)<br />

den Worst-case-Speicherbedarf des Algorithmus A.<br />

Bemerkung 2.35 Wir betrachten hier ausschließlich den Worst case, der<br />

sich für die schlimmstmögliche Probleminstanz der Größe n ergibt und<br />

unter Umständen nur in ganz wenigen Fällen auftritt. Hat man für die<br />

auftretenden Probleminstanzen eine Wahrscheinlichkeitsverteilung zur<br />

Hand, kann in obiger Definition anstelle des Maximums auch der Erwartungswert<br />

der Laufzeit bzw. des Speicherbedarfs verwendet werden<br />

und man erhält eine Average-case-Analyse.<br />

Schließlich kann auch der Algorithmus selbst Zufallsentscheidungen<br />

treffen, die seine weitere Ausführung bestimmen (z. B. die Reihenfolge,<br />

in der die Zahlen beim Sortieren abgearbeitet werden). Für einen sol-<br />

chen randomisierten Algorithmus gibt es nicht nur eine Möglichkeit die<br />

korrekte Lösung des Problems zu berechnen (wie beim deterministischen<br />

Algorithmus), sondern mehrere. Die Zahlen TA(P) und SA(P) ergeben<br />

sich dann als Erwartungswert der entsprechenden Zahlen über alle<br />

verschiedenen Möglichkeiten des Algorithmus ans Ziel zu gelangen.<br />

Hierbei ist wichtig, daß diese Zahlen nicht von der Wahrscheinlichkeitsverteilung<br />

der zu bearbeitenden Probleminstanzen abhängen. ⊳<br />

Probleme mit vergleichbarer Komplexität können zu Komplexitätsklassen<br />

zusammengefaßt werden. Einige wichtige Klassen (für Entscheidungsprobleme<br />

2 ) sind<br />

• P := { Π � � Π kann von einem deterministischen Algorithmus A<br />

gelöst werden mit tA(n) ∈ O(n k ) für ein k ∈ N },<br />

• NP := { Π � � Π kann von einem nichtdeterministischen Algorithmus<br />

A gelöst werden mit tA(n) ∈ O(n k ) für ein k ∈ N } und<br />

• PSPACE := { Π � � Π kann von einem deterministischen Algorithmus<br />

A gelöst werden mit sA(n) ∈ O(n k ) für ein k ∈ N }.<br />

Zwischen diesen Klassen gelten die Inklusionsbeziehungen<br />

P ⊆ NP ⊆ PSPACE<br />

und die Frage, ob diese Inklusionen echt sind (d. h., ob P = NP oder<br />

P �= NP gilt), ist ein zentrales Problem der Theoretischen Informatik<br />

und noch immer unbeantwortet, obwohl vieles auf P �= NP hindeutet.<br />

Man vergleiche hierzu auch [21, 10].<br />

2 Bei einem Entscheidungsproblem muß der Algorithmus nur eine Ja/Nein-Antwort<br />

zurückliefern.

2.3 Komplexität von Algorithmen 19<br />

Definition 2.36 (Reduktion) Seien Π1 und Π2 zwei Probleme. Wir sagen,<br />

Problem Π1 ist auf Problem Π2 τ(n)-reduzierbar (i. Z. Π1 �τ(n) Π2)<br />

für eine Funktion τ: N → R, wenn es Algorithmen A1→2 und A2→1<br />

gibt mit tA1→2 (n), tA2→1 (n) ∈ O(τ(n)), so daß für alle Probleminstanzen<br />

P1 ∈ Π1 folgendes gilt:<br />

1. Algorithmus A1→2 transformiert die Probleminstanz P1 ∈ Π1 in<br />

eine Instanz P2 des Problems Π2.<br />

2. Algorithmus A2→1 transformiert die Lösung für die Probleminstanz<br />

P2 ∈ Π2 zurück in eine korrekte Lösung der ursprünglichen<br />

Instanz P1.<br />

Die Idee einer solchen Reduktion besteht darin, ein Problem auf ein anderes<br />

Problem zu reduzieren, um damit untere oder obere Schranken für<br />

die Laufzeit eines der beiden Probleme zu erhalten:<br />

Untere Schranken Falls wir wissen, daß jeder Algorithmus für ein Problem<br />

Π1 mindestens einen Zeitbedarf von Ω(t1(n)) besitzt und Π1<br />

auf das Problem Π2 τ(n)-reduziert werden kann, dann hat jeder<br />

Algorithmus zur Lösung von Π2 mindestens einen Zeitbedarf<br />

von Ω(t1(n) − τ(n)). Hierbei wird natürlich vorausgesetzt, daß<br />

τ(n) ∈ O(t1(n)). Sonst wäre die Reduktion nämlich völlig nutzlos,<br />

da der Zeitbedarf zum Transformieren des Problems Π1 größer<br />

wäre als der zu seiner Lösung.<br />

Π1<br />

Π1<br />

A1→2<br />

τ(n)-Reduktion<br />

A2→1<br />

untere Schranke<br />

τ(n)-Reduktion<br />

obere Schranke<br />

Durch die Reduktion von Π1 auf Π2 haben wir also aus einer unteren<br />

Schranke für Π1 eine untere Schranke für Π2 erhalten. untere Laufzeitschranke<br />

Obere Schranke Falls wir ein Problem Π2 mit einem Zeitbedarf<br />

von O(t2(n)) lösen können und ein Problem Π1 auf Π2<br />

τ(n)-reduziert werden kann, dann kann das Problem Π1 mit<br />

einem Zeitbedarf von O(t2(n) + τ(n)) gelöst werden.<br />

Durch die Reduktion von Π1 auf Π2 haben wir also aus einer oberen<br />

Schranke für Π2 eine obere Schranke für Π1 erhalten. obere Laufzeitschranke<br />

Beispiel 2.37 Das Problem des dichtesten Paares (engl. closest pair) closest pair<br />

im E 1 besteht darin, für n reelle Zahlen x1, . . . , xn zwei Zahlen xi und xj<br />

mit minimalem Abstand |xi − xj| (unter allen Zahlenpaaren) zu bestimmen.<br />

Da wir hierzu nur solche Paare betrachten müssen, die der Größe<br />

nach benachbart sind, können wir dieses Problem in linearer Zeit auf<br />

das Sortierproblem reduzieren: Sortierproblem<br />

1. Algorithmus A1→2 bleibt leer, da wir die n Zahlen direkt als Eingabe<br />

für das Sortierproblem benutzen können.<br />

2. Das Sortieren der n Zahlen hat einen Zeitbedarf von O(n log n),<br />

indem wir beispielsweise Heapsort verwenden.<br />

3. Algorithmus A2→1 durchläuft die sortierte Folge x ′ 1 ≤ . . . x ′ n in<br />

einem Sweep vom kleinsten zum größten Element und bestimmt in Sweep<br />

linearer Zeit das Paar (x ′ i , x ′ i+1 ) aufeinanderfolgender Zahlen mit<br />

kleinstem Abstand.<br />

Π2<br />

Π2

20 Grundbegriffe<br />

Entscheidungsbaum<br />

algebraisches<br />

Entscheidungsbaummodell<br />

Somit haben wir auch für das Closest-pair-Problem eine obere Laufzeitschranke<br />

von O(n log n) + O(n) = O(n log n) gewonnen. ⊳<br />

2.3.4 Das Entscheidungsbaummodell<br />

Die Ausführung eines (deterministischen) Algorithmus A auf unserem<br />

Maschinenmodell der Unit-Cost Real RAM können wir uns vorstellen<br />

als das Durchlaufen eines Baums von höchstens dem Grad 2, ausgehend<br />

von der Wurzel bis zu einem Blatt. Die inneren Knoten entsprechen<br />

dabei den durchzuführenden Aktionen:<br />

• In Knoten der Ordnung 1 werden Ein-/Ausgabe- sowie arithmetische<br />

Operationen durchgeführt.<br />

• An einem Knoten der Ordnung 2 erfolgt eine bedingte Verzweigung<br />

zu einem seiner beiden Söhne.<br />

Jeder Eingabe P entspricht also einem Weg von der Wurzel des Baums<br />

zu einem seiner Blätter, wobei die Länge des Weges der Zahl der benötigten<br />

Taktzyklen TA(P) entspricht. Einen solchen Baum nennen wir<br />

einen Entscheidungsbaum.<br />

Bemerkung 2.38 Man kann den Entscheidungsbaum auch als reinen<br />

Binärbaum, der ausschließlich aus Entscheidungsknoten besteht, definieren.<br />

Die übrigen (Rechen-) Operationen werden denn vernachlässigt.<br />

Ebenso kann man auch mächtigere Entscheidungsbaumkonzepte<br />

betrachten, bei denen in den Entscheidungsknoten nicht nur<br />

zwei Zahlen miteinander verglichen werden können, sondern beispielsweise<br />

das Vorzeichen linearer oder algebraischer Ausdrücke ermittelt<br />

werden kann. Dies führt dann zum linearen bzw. algebraischen<br />

Entscheidungsbaummodell. Allerdings würde diesen Modellen auch ein<br />

mächtigeres Maschinenmodell als das unsrige entsprechen. ⊳<br />

Mit dem Konzept des Entscheidungsbaums können wir nun eine untere<br />

Schranke für das Sortierproblem bestimmen:<br />

Satz 2.39 Das Sortieren von n Zahlen durch Vergleichen hat im Entscheidungsbaummodell<br />

die Komplexität Ω(n log n).<br />

Beweis: Sei A ein Algorithmus, der das Sortierproblem löst. Für jede der<br />

n! Permutationen der n Zahlen muß mindestens ein Blatt im Entscheidungsbaum<br />

zu A vorhanden sein. Denn sonst gäbe es zwei verschiedene<br />

Permutationen, die von dem Sortieralgorithmus nicht unterschieden<br />

werden könnten, und der Algorithmus A wäre nicht korrekt. Somit können<br />

wir die Höhe des Entscheidungsbaums folgendermaßen ganz grob

2.3 Komplexität von Algorithmen 21<br />

nach unten abschätzen: 3<br />

Höhe ≥ log2 (n!)<br />

�<br />

n<br />

� n<br />

2<br />

≥ log2 2<br />

≥ n<br />

2 log �<br />

n<br />

�<br />

2 2<br />

∈ Ω(n log n)<br />

Somit gibt es mindestens eine Permutation, für die der Algorithmus A<br />

mindestens Ω(n log n) Vergleiche ausführen muß. ✷<br />

3 Die Knoten der Ordnung 1 brauchen wir hier gar nicht zu betrachten, denn sie ver-<br />

größern die Höhe ja nur.

Grundlegende <strong>Geometrie</strong><br />

in der Ebene<br />

3.1 Elementare geometrische Objekte<br />

Wir definieren zunächst einige wichtige geometrische Grundobjekte<br />

im R d . 1<br />

Definition 3.1 Seien p und q zwei verschiedene Punkte im R d .<br />

• Das Liniensegment oder die Strecke zwischen den beiden Punk-<br />

ten ist die Menge<br />

[p q] := { p + λ(q − p) � � λ ∈ R mit 0 ≤ λ ≤ 1 } . (3.1)<br />

• Der Halbstrahl (oder kurz Strahl) von p aus in Richtung q ist de-<br />

finiert durch<br />

[p q} := { p + λ(q − p) � � λ ∈ R mit λ ≥ 0 } . (3.2)<br />

Analog ist der Strahl {p q] definiert, obwohl man dafür auch [q p}<br />

schreiben kann.<br />

• Die Gerade durch die beiden Punkte ist die Menge<br />

p q := { p + λ(q − p) � � λ ∈ R } . (3.3)<br />

Bemerkung 3.2 Neben der parametrisierten Zwei-Punkte-Darstellung in<br />

obiger Definition läßt sich insbesondere die Gerade noch auf viele andere<br />

Arten beschreiben. Eine wichtige Darstellung einer Geraden g im R 2<br />

ist die Normalenform,<br />

g(n, a) := { x ∈ R 2 � � n T x − a = 0 }<br />

= { x ∈ R 2 � � 〈n, x〉 = a } .<br />

(3.4)<br />

1 Obwohl wir in diesem Kapitel und im Rahmen fast der gesamten Vorlesung nur zweidimensionale<br />

Objekte benötigen, werden wir – wo dies ohne Mehraufwand möglich ist –<br />

die Definitionen so allgemein wie möglich halten.<br />

q<br />

[p q]<br />

p<br />

Liniensegment<br />

[p q}<br />

p<br />

Halbstrahl<br />

p q<br />

p<br />

Gerade<br />

3<br />

q<br />

q

24 Grundlegende <strong>Geometrie</strong> in der Ebene<br />

Normalenvektor<br />

n<br />

g(n, a)<br />

a<br />

0<br />

Hesseform einer Geraden<br />

Abstand eines Punktes von<br />

einer Geraden<br />

H +<br />

H −<br />

positive und negative<br />

Halbebene<br />

Hierbei ist n ∈ R2 \ (0, 0) ein Normalenvektor der Geraden (d. h. n steht<br />

senkrecht auf g) und a eine reelle Zahl.<br />

Hat der Vektor n außerdem die Länge 1 und ist a ∈ R≥0 (d. h. der Vektor<br />

n muß „vom Ursprung weg zeigen“), dann spricht man von der Hes-<br />

seform der Geraden g. Die Zahl a gibt in diesem Fall den (euklidischen)<br />

Abstand der Geraden zum Ursprung an. Eine einfache Merkregel für<br />

die Richtung des Normalenvektors bei der Hesseform: Für jeden Vektor<br />

x auf der Geraden muß das Skalarprodukt 〈n, x〉 = n T x positiv sein.<br />

Mit Hilfe der Hesseform läßt sich sehr einfach der Abstand eines Punktes<br />

p von einer Geraden g(n, a) bestimmen. Es gilt nämlich<br />

dist(p, g) = � � n T p − a � � , (3.5)<br />

wobei das Vorzeichen des Ausdrucks n T p − a darüber entscheidet, auf<br />

welcher Seite der Geraden der Punkt p liegt:<br />

positives Vorzeichen p liegt auf der Seite von g(n, a), in die auch der<br />

Normalenvektor n zeigt; somit liegen p und der Koordinatenursprung<br />

auf verschiedenen Seiten von g(n, a).<br />

negatives Vorzeichen p liegt auf der dem Normalenvektor abgewandten<br />

Seite von g; somit liegen p und der Koordinatenursprung auf<br />

derselben Seite von g(n, a).<br />

Ganz analog definiert man im R 3 die Normalenform einer Ebene<br />

bzw. allgemein im R d die Normalenform einer (d − 1)-dimensionalen<br />

Hyperebene (d. h. eines (d − 1)-dimensionalen affinen Unterraums<br />

des R d ). ⊳<br />

Definition 3.3 (Halbebene/Halbraum) Sei g(n, a) die Normalenform<br />

einer Geraden im R 2 . Dann nennt man<br />

• H + (n, a) := { x ∈ R 2 � � n T x − a ≥ 0 } = { x ∈ R 2 � � 〈n, x〉 ≥ a }<br />

die (abgeschlossene) positive Halbebene (engl. positive halfplane)<br />

zu g(n, a),<br />

• H − (n, a) := { x ∈ R 2 � � n T x − a ≤ 0 } = { x ∈ R 2 � � 〈n, x〉 ≤ a }<br />

die (abgeschlossene) negative Halbebene (engl. negative halfplane)<br />

zu g(n, a).<br />

Die offenen Halbebenen H + (n, a) ◦ und H − (n, a) ◦ erhält man, indem<br />

man in obiger Definition anstelle von »≥« (bzw. »≤«) jeweils »>«<br />

(bzw. »

3.2 Elementare Lokationsprobleme 25<br />

3.2 Elementare Lokationsprobleme<br />

3.2.1 Point-in-half-plane-Test<br />

Gegeben eine (abgeschlossene positive) Halbebene H + (n, a) = { x ∈<br />

R d � � n T x − a ≥ 0 } und ein Punkt p ∈ R d . Dann kann der Test<br />

„p ∈ H + (n, a)?“ mit einem Zeitbedarf von O(d) beantwortet werden.<br />

Denn aus der Definition von H + (n, a) folgt sofort „p ∈ H + (n, a) ⇐⇒<br />

n T p − a ≥ 0“ und die Berechnung dieses Ausdrucks erfordert O(d)<br />

Additionen und Multiplikationen. Da die Komplexität der Eingabe<br />

»(n, a, p)« schon aus Ω(d) ist, ist diese Schranke scharf und der Zeitbedarf<br />

ist aus Θ(d).<br />

Ist die Dimension d fest, dann kann der Point-in-half-plane-Test also in<br />

konstanter Zeit entschieden werden.<br />

3.2.2 Lage eines Punktes bezüglich eines Strahls<br />

Gegeben ein Strahl [p q} ⊂ R 2 (bzw. eine orientierte Strecke [p q] oder<br />

eine orientierte Gerade p q) und ein Punkt r ∈ R 2 , dann interessiert uns,<br />

ob r links oder rechts vom Strahl [p q} liegt (oder auf der vom Strahl induzierten<br />

Geraden).<br />

Ein naheliegender Ansatz ist, dieses Problem auf einen Point-in-halfplane-Test<br />

zurückzuführen. Hierzu muß aber zunächst eine Normalenform<br />

g(n, a) der durch den Strahl induzierten Geraden bestimmt werden,<br />

und zwar so, daß der Normalenvektor n z. B. immer in die linke<br />

Halbebene zeigt. Denn andernfalls wäre nicht sofort klar, ob auf eine<br />

positive oder auf eine negative Halbebene hin getestet werden muß und<br />

es wären Fallunterscheidungen nötig, um dies zu unterscheiden.<br />

� � � �<br />

p1<br />

q1<br />

Sei nun p = und q =<br />

gegen den<br />

p2<br />

q2<br />

, dann ist z. B. der um π<br />

2<br />

Uhrzeigersinn gedrehte Richtungsvektor des Strahls [p q},<br />

� �<br />

p2 − q2<br />

n =<br />

,<br />

q1 − p1<br />

ein Normalenvektor zu p q, der immer in die linke Halbebene zeigt.<br />

Durch Auflösen der Normalenform nach a und Einsetzen eines Punktes,<br />

der auf dem Strahl liegt (z. B. p), erhält man dann den passenden<br />

Wert für a,<br />

a = n T p<br />

= (p2 − q2)p1 + (q1 − p1)p2<br />

= p2q1 − p1q2 .<br />

Nun kann man den im letzten Abschnitt beschriebenen Point-in-halfplane-Test<br />

auf den Punkt r und die (offene) Halbebene H + (n, a) ◦ an-<br />

konstanter Zeitbedarf bei<br />

fester Dimension<br />

p<br />

links<br />

rechts<br />

q<br />

Reduktion auf<br />

Point-in-half-plane-Test

26 Grundlegende <strong>Geometrie</strong> in der Ebene<br />

p<br />

a × b<br />

b<br />

r1<br />

a<br />

r2<br />

q<br />

Vektorprodukt<br />

wenden und erhält die Äquivalenz:<br />

mit<br />

„r liegt (echt) links von [p q}“<br />

⇐⇒<br />

r ∈ H + (n, a) ◦<br />

⇐⇒<br />

n T r − a > 0<br />

n T r − a = (p2 − q2)r1 + (q1 − p1)r2 − p2q1 + p1q2<br />

= p2r1 − q2r1 + q1r2 − p1r2 − p2q1 + p1q2 .<br />

Bemerkung 3.4 Obige Formel zum Testen der Lage eines Punktes läßt<br />

sich auch noch auf andere Weise herleiten, nämlich unter Verwendung<br />

des Vektorprodukts:<br />

Denn offensichtlich gilt folgender Zusammenhang:<br />

„r liegt (echt) links von [p q}“<br />

⇐⇒<br />

„Die drei Punkte (p, q, r) sind im Gegenuhrzeigersinn orientiert“<br />

Dies läßt sich mittels des Vektorprodukts auf einfache Weise testen. Für<br />

zwei Vektoren a, b ∈ R3 ergibt nämlich das Vektorprodukt<br />

⎛<br />

a × b := ⎝<br />

a2b3 − a3b2<br />

a3b1 − a1b3<br />

a1b2 − a2b1<br />

⎞<br />

(∗)<br />

⎠ (3.6)<br />

einen zu a und b senkrecht stehenden Vektor, dessen Länge dem Flächeninhalt<br />

des von a und b aufgespannten Parallelogramms entspricht<br />

und der so orientiert ist, daß (a, b, a × b) ein Rechtssystem 2 bilden.<br />

Für zwei Vektoren a, b ∈ R 2 ergibt sich dann für das Vektorprodukt der<br />

in die x1-x2-Ebene eingebetteten Vektoren<br />

⎛<br />

⎝ a1<br />

a2<br />

⎞<br />

⎛<br />

b1<br />

⎞<br />

⎛<br />

⎠ × ⎝b2⎠<br />

= ⎝<br />

0 0<br />

0<br />

0<br />

a1b2 − a2b1<br />

und für die dritte Komponente des Vektorprodukts gilt die Äquivalenz:<br />

„Die drei Punkte (0, a, b) sind im Gegenuhrzeigersinn orientiert“<br />

⇐⇒<br />

a1b2 − a2b1 > 0<br />

2 Drei Vektoren bilden ein Rechtssystem, wenn sie die gleiche Orientierung zueinander<br />

besitzen wie Daumen, Zeigefinger und Mittelfinger der rechten Hand.<br />

⎞<br />

⎠

3.2 Elementare Lokationsprobleme 27<br />

Setzt man jetzt a = q − p und b = r − p, dann erhält man für diese dritte<br />

Komponente des Vektorprodukts<br />

a1b2 − a2b1 = (q1 − p1)(r2 − p2) − (q2 − p2)(r1 − p1)<br />

= q1r2 − p2q1 − p1r2 + p1p2<br />

− q2r1 + p1q2 + p2r1 − p1p2<br />

= (p1q2 − p2q1) + (q1r2 − q2r1) + (p2r1 − p1r2)<br />

(∗∗)<br />

und kann damit die Orientierung der drei Punkte p, q und r bestimmen.<br />

⊳<br />

Die beiden identischen Ausdrücke (∗) und (∗∗) lassen sich auch als<br />

Determinante einer 3×3-Matrix schreiben. Wir definieren deshalb die<br />

Funktion ccw: R2 × R2 × R2 → R (von engl. counter clockwise)<br />

� �<br />

�p1<br />

p2 � 1�<br />

�<br />

ccw(p, q, r) := �q1<br />

q2 � 1�<br />

� . (3.7)<br />

� �<br />

Somit gilt<br />

ccw(p, q, r)<br />

⎧<br />

⎪⎨<br />

⎪⎩<br />

r1 r2 1<br />

< 0 falls r (echt) rechts von [p q} liegt,<br />

= 0 falls r auf p q liegt,<br />

> 0 falls r (echt) links von [p q} liegt.<br />

Der Zeitbedarf für diesen Test ist wiederum aus Θ(1).<br />

(3.8)<br />

Bemerkung 3.5 Aufgrund der Eigenschaft des Vektorprodukts hat<br />

das Dreieck mit den Eckpunkten a, b und c gerade den Flächenin-<br />

|ccw(a, b, c)|. ⊳<br />

halt 1<br />

2<br />

3.2.3 Schnitt zweier Strecken<br />

Gegeben zwei Strecken p := [p1 p2] und q := [q1 q2] im R2 , dann möch- p2<br />

ten wir wissen, ob die beiden Strecken sich schneiden (und gegebenenfalls<br />

die Schnittmenge p ∩ q bestimmen).<br />

Offensichtlich ist „p und q schneiden sich“ äquivalent zu<br />

1. Die Strecken p und q sind kollinear und überlappen sich, oder<br />

2. die Strecken p und q sind nicht kollinear und es gilt<br />

die Endpunkte von q liegen auf verschiedenen<br />

Seiten von p<br />

und<br />

die Endpunkte von p liegen auf verschiedenen<br />

Seiten von q.<br />

(3.9)<br />

Flächeninhalt eines<br />

Dreiecks<br />

q1<br />

p1<br />

q2

28 Grundlegende <strong>Geometrie</strong> in der Ebene<br />

Abbildung 3.1<br />

Sonderfälle beim Schnitt<br />

zweier Strecken<br />

Fall „p und q sind<br />

kollinear“<br />

Die verschiedenen Fälle können jeweils durch Verwendung der ccw-<br />

Funktion getestet werden:<br />

1. „p und q sind kollinear“ ⇐⇒<br />

ccw(p1, p2, q1) = ccw(p1, p2, q2) = 0<br />

(bzw. ccw(q1, q2, p1) = ccw(q1, q2, p2) = 0, aber es muß nur eine<br />

der beiden Aussagen überprüft werden)<br />

Der Test auf Überlappung (bzw. Inklusion, siehe Abbildung 3.1<br />

links) soll hier nicht weiter ausgeführt werden, ist jedoch nicht<br />

schwierig, z. B. indem man für die Punkte q1 und q2 die entsprechenden<br />

λ-Werte in<br />

q1 = p1 + λ1(p2 − p1) q2 = p1 + λ2(p2 − p1)<br />

ausrechnet und das sich so ergebende [λ1, λ2]- bzw.<br />

[λ2, λ1]-Intervall mit dem Intervall [0, 1] schneidet.<br />

Fall „p und q sind nicht 2. Falls p und q nicht kollinear sind, ist Eigenschaft (3.9) auf der<br />

kollinear“ vorhergehenden Seite äquivalent zu<br />

konstanter Zeitbedarf für<br />

Streckenschnitt<br />

ccw(p1, p2, q1) · ccw(p1, p2, q2) ≤ 0<br />

∧<br />

ccw(q1, q2, p1) · ccw(q1, q2, p2) ≤ 0 .<br />

(3.10)<br />

Hierbei werden auch gleich die Sonderfälle berücksichtigt (durch<br />

Verwendung von »≤« anstelle von »

3.2 Elementare Lokationsprobleme 29<br />

welche Punkte gleichen Winkels zu Äquivalenzklassen („Richtungen“)<br />

[a]R := { b ∈ R 2 \ (0, 0) � � a ∼R b }<br />

zusammenfaßt und bezeichnen mit<br />

�<br />

W := { [a]R � a ∈ R 2 \ (0, 0) }<br />

die Menge aller Äquivalenzklassen (bez. der Relation R).<br />

Nun wählen wir eine beliebige Richtung [z] ∈ W als „minimales Element“<br />

und definieren die Relation »� [z]« wie folgt:<br />

[a] � [z] [b]<br />

def<br />

⇐⇒<br />

ccw(a, z) ≤ 0 ∧ ccw(b, z) > 0 ∨<br />

ccw(a, z) · ccw(b, z) > 0 ∧ ccw(a, b) ≥ 0 ∨<br />

ccw(a, z) ≤ 0 ∧ ccw(b, z) = 0 ∧ 〈b, z〉 ≤ 0 ∨<br />

ccw(a, z) = 0 ∧ ccw(b, z) ≤ 0 ∧ 〈a, z〉 ≥ 0 .<br />

(3.12)<br />

0<br />

Die Menge W der<br />

Äquivalenzklassen<br />

Diese etwas längliche Definition ist notwendig, um auch alle Sonderfälle<br />

(z. B. »a, b, z sind kollinear«) zu berücksichtigen: Vorsicht bei Sonderfällen!<br />

• Die erste Zeile behandelt den Fall, daß a links von z und b (echt)<br />

rechts von z liegt;<br />

• die zweite Zeile ermittelt die Relation von a und b zueinander,<br />

wenn beide Punkte auf derselben Seite von z liegen;<br />

• die letzten beiden Zeilen behandeln die Sonderfälle, wenn (mindestens)<br />

einer der beiden Punkte kollinear zu z liegt.<br />

Die Relation »�« besitzt die folgenden Eigenschaften:<br />

∀ [a] [a] � [a] (Reflexivität)<br />

∀ [a],[b] [a] � [b] ∧ [b] � [a] =⇒ [a] = [b] (Antisymmetrie)<br />

∀ [a],[b] [a] � [b] ∨ [b] � [a] (Linearität)<br />

∀ [a],[b],[c] [a] � [b] ∧ [b] � [c] =⇒ [a] � [c] (Transitivität)<br />

Somit ist »� [z]« eine Ordnungsrelation auf der Menge W der Richtungen,<br />

die angulare Ordnung (bez. des Strahls [0 z}), und wir können »� [z]« angulare Ordnung<br />

verwenden, um z. B. Punkte nach ihrem Winkel zu sortieren.<br />

Bemerkung 3.6 Die Wahl des „minimalen Elements“ [z] hat keinen Wahl des „minimalen<br />

Elements“ [z]<br />

großen Einfluß auf die angulare Ordnung. Denn sei<br />

[p1] � [z1] [p2] � [z1] · · · � [z1] [pn] ,<br />

dann gibt es für jedes andere „minimale Element“ [z2] ein k ∈ {1, . . . , n−<br />

1}, so daß gilt<br />

[p1+k] � [z2] [p2+k] � [z2] · · · � [z2] [pn+k] ,<br />

wobei [pn+1] = [p1], . . . , [p2n−1] = [pn−1] ist (siehe Abbildung 3.2 auf<br />

der nächsten Seite; hier ist k = 8 beim Wechsel von [z1] zu [z2]). ⊳

30 Grundlegende <strong>Geometrie</strong> in der Ebene<br />

Abbildung 3.2<br />

Einfluß des „minimalen<br />

Elements“ auf die angulare<br />

Ordnung<br />

0<br />

pl<br />

q<br />

pr<br />

Linearer Zeitbedarf bei<br />

Single-shot-Anfrage<br />

4<br />

5<br />

3<br />

6<br />

2<br />

1<br />

10<br />

z1<br />

0<br />

9 7<br />

0<br />

7<br />

8<br />

Bemerkung 3.7 Im folgenden benutzen wir der Einfachheit halber beim<br />

Vergleichen von Punkten anstelle der etwas umständlichen Notation<br />

[a] � [z] [b] die intuitivere Schreibweise a �z b, sind uns dabei jedoch<br />

im klaren, daß anstelle der Punkte eigentlich deren Äquivalenzklassen<br />

gemeint sind. ⊳<br />

Bemerkung 3.8 Oft ist es gar nicht notwendig, die Richtung [z] bezüglich<br />

derer die angulare Ordnung bestimmt wird, besonders auszuzeichnen.<br />

Deshalb verwenden wir im folgenden – wenn nicht anders angegeben<br />

– die positive x-Achse als Referenzstrahl für die angulare Ordnung<br />

und schreiben dafür kurz »�«. ⊳<br />

3.2.5 Sektorbestimmung – Single-shot-Anfrage<br />

Gegeben n Punkte p1, . . . , pn ∈ R 2 , die n Sektoren induzieren, sowie<br />

ein weiterer Anfragepunkt q ∈ R 2 . In welchem Sektor befindet sich q?<br />

Bei einer Single-shot-Anfrage wird für die gegebene Datenmenge (hier,<br />

die n Punkte) nur eine einzige Anfrage gestellt, im Gegensatz zu einer<br />

Multiple-shot-Anfrage, bei der für dieselbe Datenmenge mehrere Anfragen<br />

bearbeitet werden müssen (z. B. hier, m Anfragepunkte q1, . . . , qm).<br />

Eine evtl. aufwendige Vorverarbeitung (engl. preprocessing) lohnt sich also<br />

in der Regel nicht.<br />

Zur Lösung des Problems betrachten wir die angulare Ordnung »�q«<br />

der Punkte bez. des Strahl [0 q}. Dann wird offensichtlich der gesuchte<br />

Sektor von denjenigen Punkten pl und pr begrenzt, für die gilt<br />

∀1≤i≤n pl �q pi und ∀1≤i≤n pi �q pr .<br />

Diese beiden Punkte werden von Algorithmus 3.1 auf der folgenden Seite<br />

mit einem Zeitaufwand von O(n) bestimmt.<br />

3.2.6 Sektorbestimmung – Multiple-shot-Anfrage<br />

Gegeben wiederum n Punkte p1, . . . , pn ∈ R 2 wie in Abschnitt 3.2.5.<br />

Dieses Mal ist es uns jedoch erlaubt, einen gewissen Preprocessing-Aufwand<br />

zu investieren, damit eine Folge von Anfragen schneller beantwortet<br />

werden kann als in Abschnitt 3.2.5, d. h. schneller als in Ω(n) pro<br />

Anfrage.<br />

6<br />

5<br />

8<br />

4<br />

9<br />

3<br />

10<br />

2<br />

1<br />

z2

3.2 Elementare Lokationsprobleme 31<br />

Algorithmus 3.1 Sektorbestimmung – Single-shot-Anfrage<br />

SEKTORSS(q)<br />

Input: n Punkte p1, . . . , pn ∈ R 2<br />

Anfragepunkt q<br />

1 r ← 1 {pr ist der rechte Randpunkt des gesuchten Sektors}<br />

2 l ← 1 {pl ist der linke Randpunkt des gesuchten Sektors}<br />

3 for i ← 2, . . . , n do<br />

4 if pi �q pl then<br />

5 l ← i<br />

6 end if<br />

7 if pr �q pi then<br />

8 r ← i<br />

9 end if<br />

10 end for<br />

Output: q befindet sich im Sektor der beiden Punkte pl und pr<br />

Hierzu sortieren wir in der Preprocessing-Phase die Punkte p1, . . . , pn Preprocessing<br />

bez. ihrer angularen Ordnung »�«. Dies erfordert einen einmaligen Preprocessing-Zeitbedarf<br />

von O(n log n).<br />

Für einen Anfragepunkt q können wir dann denjenigen Sektor, der q<br />

enthält, mittels binärer Suche gemäß Algorithmus 3.2 auf der folgenden binäre Suche<br />

Seite bestimmen. Somit erhalten wir folgenden Satz:<br />

Satz 3.9 Für n Punkte p1, . . . , pn ∈ R 2 , die gemäß ihrer angularen<br />

Ordnung sortiert sind (d. h. p1 � · · · � pn), und einen Anfragepunkt<br />

q ∈ R 2 kann der Sektor, in dem sich q befindet, mit einem Zeitbedarf<br />

von O(log n) bestimmt werden.<br />

logarithmischer Zeitbedarf<br />

bei Multiple-shot-Anfrage

32 Grundlegende <strong>Geometrie</strong> in der Ebene<br />

Algorithmus 3.2 Sektorbestimmung – Multiple-shot-Anfrage<br />

SEKTORMS(q)<br />

Input: n Punkte p1 � · · · � pn ∈ R 2<br />

Anfragepunkt q<br />

1 r ← 0 {pr ist der rechte Randpunkt des gesuchten Sektors}<br />

2 l ← n + 1 {pl ist der linke Randpunkt des gesuchten Sektors}<br />

3 while l − r > 1 do<br />

4 m ← ⌊ l+r<br />

2 ⌋<br />

5 if q � pm then<br />

6 l ← m {q ist „rechts“ von pm, also streiche linke Hälfte}<br />

7 else<br />

8 r ← m {q ist „links“ von pm, also streiche rechte Hälfte}<br />

9 end if<br />

10 end while<br />

11 if r = 0 then<br />

12 r ← n<br />

13 end if<br />

14 if l = n + 1 then<br />

15 l ← 1<br />

16 end if<br />

Output: q befindet sich im Sektor der beiden Punkte pl und pr

Polygone<br />

Definition 4.1 (Polygon) Ein Weg w ⊆ E d , der aus einer endlichen Folge<br />

von Liniensegmenten [p1 p2], [p2 p3], . . . , [pn−1 pn] besteht, heißt eine<br />

polygonale Kette. polygonale Kette<br />