2. Bayesin päätösteoria

2. Bayesin päätösteoria

2. Bayesin päätösteoria

You also want an ePaper? Increase the reach of your titles

YUMPU automatically turns print PDFs into web optimized ePapers that Google loves.

<strong>2.</strong> <strong>Bayesin</strong> <strong>päätösteoria</strong><br />

<strong>2.</strong>1. Johdanto<br />

Oulun yliopisto, Hahmontunnistus ja neuroverkot (521497S), TS<br />

13 / 99<br />

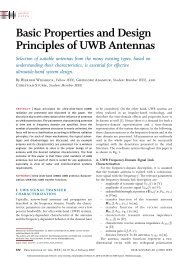

<strong>Bayesin</strong> <strong>päätösteoria</strong>n (Bayesian decision theory) avulla on mahdollista johtaa optimaalisia<br />

tilastollisia luokittelijoita. Perustuu todennäköisyyslaskentaan ja olettaa<br />

tarvittavat todennäköisyydet tunnetuiksi.<br />

Merkitään asiaintilaa (state of nature) symbolilla ω<br />

• kalanlajittelun esimerkissä tarkoittaa tarkasteltavan kalan lajia: ω = ω 1, kun kala<br />

on meriahven ja ω = ω 2 , kun kala on lohi<br />

• koska asiaintila on niin ennustamaton, tulkitaan ω muuttujaksi, joka täytyy<br />

kuvailla probabilistisesti<br />

Asiaintila ω on tässä diskreettiarvoinen, koska sillä on vain kaksi tilaa. Sen tiloihin<br />

liittyy a priori todennnäköisyydet P(ω j), jotka kuvastavat tilojen suhteellisia esiintymiskertoja<br />

populaatiossa:<br />

• P(ω 1 ): meriahvenien suhteellinen osuus saaliskaloissa<br />

• P(ω 2 ): lohien suhteellinen osuus saaliskaloissa<br />

• jos muita tiloja ei ole, P(ω 1 ) + P(ω 2 ) = 1<br />

Mikäli luokittelijalla ei ole muuta tietoa kaloista kuin a priori todennäköisyydet,<br />

päätössääntö on yksinkertainen:<br />

• päätä ω 1 jos P(ω 1 ) > P(ω 2 ), muutoin päätä ω 2<br />

Tavallisesti käytettävissä on muutakin tietoa, nimittäin aiemmin mainittuja kohteita<br />

luonnehtivia piirteitä. Olkoon x kalan kirkkautta kuvaava jatkuva-arvoinen satunnaismuuttuja,<br />

jonka jakauma p( x ω)<br />

riippuu asiaintilasta. Jakaumaa kutsutaan luokkaehdolliseksi<br />

todennäköisyystiheysfunktioksi (class-conditional probability<br />

density function): satunnaismuuttujan x tiheysfunktio oletuksella että asiaintila on<br />

ω. Tällöin tiheysfunktioiden p( x ω1) ja p( x ω2) välinen ero kuvastaa näiden kalalajien<br />

kirkkauseroja populaatiossa (kuva alla):

Oulun yliopisto, Hahmontunnistus ja neuroverkot (521497S), TS<br />

14 / 99<br />

Tiheysfunktioita voidaan käyttää hyväksi luokittelussa <strong>Bayesin</strong> kaavan avulla.<br />

Tämän johtamiseksi kirjoitetaan ensin yhteistodennäköisyystiheys (joint probability<br />

density) sille, että hahmo kuuluu luokkaan ω j JA sillä on piirteen arvo x:<br />

p( ωj, x)<br />

= P( ωj x)p<br />

( x)<br />

= p( x ωj)P ( ωj) Tästä saadaan kuuluisa <strong>Bayesin</strong> kaava (Bayes formula):<br />

P( ωj x)<br />

p( x ωj)P ( ωj) = --------------------------------- =<br />

p( x)<br />

Tämä voidaan ilmaista sanallisesti seuraavasti:<br />

p( x ωj)P ( ωj) --------------------------------------------<br />

2<br />

i = 1<br />

p( x ωi)P ( ωi) • “likelihood” : uskottavuus<br />

• a priori todennäköisyydestä lasketaan siis a posteriori todennäköisyys<br />

∑<br />

likelihood × prior<br />

posterior =<br />

----------------------------------------evidence

Oulun yliopisto, Hahmontunnistus ja neuroverkot (521497S), TS<br />

15 / 99<br />

A posteriori todennäköisyys P( ωj x)<br />

kuvastaa todennäköisyyttä, että asiaintila on<br />

ω j , kun piirrearvo x on havaittu.<br />

Tiheysfunktiota p( x ω)<br />

kutsutaan uskottavuusfunktioksi (likelihood function). Se<br />

kuvastaa asiaintilan ωj uskottavuutta suhteessa mittausarvoon x siten, että mitä<br />

suurempi funktion arvo on piirreavaruuden pisteessä x, sitä uskottavammin asiaintila<br />

on ωj .<br />

Nimittäjässä esiintyvä termi p(x) on lähinnä skaalaustekijä, jolla varmistetaan se,<br />

että posteriori-todennäköisyydet summautuvat arvoon 1 kaikkialla piirreavaruudessa.<br />

Se kuvastaa muuttujan x tiheyttä yli koko populaation.<br />

Tästä saadaan <strong>Bayesin</strong> päätössääntö (Bayes decision rule):<br />

Ekvivalentti päätössääntö:<br />

Päätä ω1 jos P( ω1 x)<br />

> P( ω2 x)<br />

, muutoin päätä ω2 Päätä ω1 jos p( x ω1)P ( ω1) ><br />

p( x ω2)P ( ω2) , muutoin päätä ω2

Oulun yliopisto, Hahmontunnistus ja neuroverkot (521497S), TS<br />

16 / 99<br />

<strong>Bayesin</strong> päätössääntö minimoi luokitteluvirheen keskimääräisen todennäköisyyden,<br />

mikä nähdään seuraavasti:<br />

Virheen keskimääräinen todennäköisyys saadaan lausekkeesta:<br />

∞<br />

∞<br />

∫<br />

P( virhe)<br />

= P( virhe, x)<br />

dx<br />

=<br />

– ∞<br />

P( virhe x)p<br />

( x)<br />

dx<br />

Tämä saa pienimmän arvonsa, kun P( virhe x)<br />

saa pienimmän arvonsa kaikissa<br />

kohdissa x.<br />

Yleisesti ottaen, kun havaitaan piirrearvo x, virheellisen luokittelupäätöksen todennäköisyys<br />

on:<br />

P( virhe x)<br />

=<br />

Noudatettaessa <strong>Bayesin</strong> päätössääntöä pätee jokaisessa pisteessä x:<br />

⎧<br />

⎨<br />

Siispä virheen keskimääräinen todennäköisyys saa pienimmän mahdollisen arvonsa<br />

käytettäessä <strong>Bayesin</strong> päätössääntöä! M.O.T.<br />

Mikään muu päätössääntö ei voi alittaa <strong>Bayesin</strong> luokitteluvirhettä. Mikäli siis<br />

todennäköisyydet tunnetaan (priorit ja jakaumat), kannattaa käyttää <strong>Bayesin</strong><br />

päätössääntöön perustuvaa luokittelijaa. Muut luokittelijat tuottavat korkeintaan<br />

yhtä hyviä tuloksia, todennäköisesti huonompia. Käytännön vaikeus on tietysti<br />

määrätä todennäköisyydet tarkasti.<br />

∫<br />

– ∞<br />

P( ω1 x),<br />

kun päätetään ω2 ⎩P(<br />

ω2 x),<br />

kun päätetään ω1 P( virhe x)<br />

=<br />

min[ P( ω1 x)<br />

, P( ω2 x)<br />

]

<strong>2.</strong><strong>2.</strong> <strong>Bayesin</strong> <strong>päätösteoria</strong> - jatkuva-arvoiset piirremuuttujat<br />

Oulun yliopisto, Hahmontunnistus ja neuroverkot (521497S), TS<br />

17 / 99<br />

Yleistetään edellisen kappaleen tulokset:<br />

• sallitaan useita piirteitä<br />

• d-ulotteinen piirrevektori (satunnaismuuttuja) x piirreavaruudessa Rd • sallitaan useita asiaintiloja<br />

• { ω1 , ... , ωc} • sallitaan muitakin toimintoja (action) kuin päätöksenteko asiaintilasta (kuten<br />

kieltäytyminen päätöksenteosta, mikäli hahmon luokka ei näytä selvältä)<br />

• { α1 , ... , αa} • käyttämällä virheen todennäköisyyttä yleisempää kustannusfunktiota (cost function)<br />

• kustannusfunktio λ( αi ωj) ilmaisee kuinka suuri kustannus syntyy<br />

tekemällä toiminto α i asiaintilassa ω j<br />

<strong>Bayesin</strong> kaava on samaa muotoa kuin aiemmin:<br />

Oletetaan nyt, että havaitaan piirrevektori x ja halutaan tehdä sen perusteella toiminto<br />

α i . Tähän toiminnon tekemiseen liittyvän kustannuksen odotusarvo on:<br />

Päätösteoreettisessa terminologiassa kustannuksen odotusarvoa (expected loss) kutsutaan<br />

riskiksi (risk), ja suuretta R( αi x)<br />

kutsutaan ehdolliseksi riskiksi (condi-<br />

tional risk).<br />

P( ωj x)<br />

<strong>Bayesin</strong> päätösproseduuri:<br />

p( x ωj)P ( ωj) = --------------------------------- =<br />

p( x)<br />

c<br />

∑<br />

p( x ωj)P ( ωj) -------------------------------------------c<br />

i = 1<br />

p( x ωi)P ( ωi) Valitse se toiminto αi , jota vastaava ehdollinen riski R( αi x)<br />

on pienin<br />

∑<br />

R( αi x)<br />

= λ( αi ωj)P ( ωj x)<br />

j = 1

<strong>Bayesin</strong> päätössääntö tuottaa optimaalisen suorituskyvyn, mikä nähdään<br />

seuraavasti:<br />

Oulun yliopisto, Hahmontunnistus ja neuroverkot (521497S), TS<br />

18 / 99<br />

Ongelmana on löytää kokonaisriskin minimoiva päätössääntö. Yleinen<br />

päätössääntö on funktio α(x), joka kertoo mikä toiminto αi ∈ { α1 , ... , αc} tulee valita<br />

kunkin tapauksen x kohdalla. Kokonaisriski on tiettyyn päätössääntöön liittyvä<br />

kustannuksen odotusarvo:<br />

R = R( α( x)<br />

) = R( α( x)<br />

, x)<br />

dx<br />

=<br />

Kun α(x) päätyy valintaan αi siten, että R( αi x)<br />

on pienin kaikilla x, ylläoleva<br />

lauseke saa pienimmän arvonsa. M.O.T.<br />

Pienintä kokonaisriskiä kutsutaan <strong>Bayesin</strong> riskiksi (Bayes risk) R*, joka on samalla<br />

pienin saavutettavissa oleva riski.<br />

Tarkastellaan 2-luokkaista erikoistapausta:<br />

jossa on yksinkertaistettu merkintöjä käyttämällä λ ij =<br />

Valitaan siis α1 , jos R( α1 x)<br />

< R( α2 x)<br />

, eli jos:<br />

∫<br />

∫R(<br />

α( x)<br />

x)p<br />

( x)<br />

dx<br />

R( α1 x)<br />

= λ11P( ω1 x)<br />

+ λ12P( ω2 x)<br />

R( α2 x)<br />

= λ21P( ω1 x)<br />

+ λ22P( ω2 x)<br />

λ( αi ωj) ( λ21– λ11)P ( ω1 x)<br />

> ( λ12– λ22)P ( ω2 x)<br />

eli<br />

( λ21– λ11)p ( x ω1)P ( ω1) > ( λ12– λ22)p ( x ω2)P ( ω2) eli<br />

p( x ω1) ( λ12– λ22) -----------------------------------------p( x ω2) ( λ21– λ11) P ω ( 2)<br />

><br />

--------------<br />

P( ω1) Alinta muotoa kutsutaan likelihood ratio -suureeksi ja sen käyttöä päätössääntönä<br />

LR-testiksi, jossa verrataan kahden uskottavuusfunktion suhdetta kynnysarvoon.

Oulun yliopisto, Hahmontunnistus ja neuroverkot (521497S), TS<br />

19 / 99<br />

Johdetaan aiemmin esitelty minimivirheluokittelija (minimum-error-rate classifier):<br />

Toiminto α i olkoon nyt hahmon luokittelu luokkaan ω i . Oikean ja väärän luokittelun<br />

kustannukset olkoon 0-1-kustannusfunktion mukaiset:<br />

Oikealla päätöksellä ei siis ole kustannuksia, ja kaikki väärät päätökset maksavat<br />

saman verran. Tätä kustannusfunktiota vastaava ehdollinen riski on nyt:<br />

Päätössääntö:<br />

eli:<br />

eli:<br />

Valitse α i , jos<br />

Valitse α i , jos<br />

Valitse α i , jos<br />

λ( αi ωj) 0 i = j<br />

1 i ≠ j<br />

Alla kuva, jossa piirretty LR-suhde edellisen kuvan esimerkille:<br />

=<br />

⎧<br />

⎨<br />

⎩<br />

R( αi x)<br />

c<br />

= ∑ λ( αi ωj)P ( ωj x)<br />

= ∑ P( ωj x)<br />

= 1 – P( ωi x)<br />

j = 1<br />

j ≠ i<br />

R( αi x)<br />

< R( αj x)<br />

kaikilla j ≠ i<br />

1– P(<br />

ωi x)<br />

< 1– P(<br />

ωj x)<br />

kaikilla j ≠ i<br />

P( ωi x)<br />

><br />

P( ωj x)<br />

kaikilla j ≠ i

<strong>2.</strong>3. Luokittelijat, diskriminanttifunktiot ja päätöspinnat<br />

Oulun yliopisto, Hahmontunnistus ja neuroverkot (521497S), TS<br />

20 / 99<br />

Luokittelijat voidaan esittää monella tavalla yhden suosituimmista ollessa diskriminanttifunktiot<br />

g i(x), i=1,...,c. Suomeksi voidaan käyttää nimeä erottelufunktiot.<br />

Jokaiselle luokalle siis suunnitellaan oma diskriminanttifunktio. Luokittelija sijoittaa<br />

piirrevektorin x omaavan hahmon luokkaan ω i, jos:<br />

gi( x)<br />

> gj( x)<br />

kaikilla j ≠ i<br />

eli suurimman lukuarvon tuottavan funktion luokkaan.<br />

Riskin minimointiin perustuvalle <strong>Bayesin</strong> luokittelijalle voidaan valita:<br />

gi (x) = - R( αi x)<br />

, jolloin suurimman diskriminanttifunktion arvo vastaa pienintä ehdollista riskiä.<br />

Minimivirheeseen perustuvalle <strong>Bayesin</strong> luokittelijalle voidaan valita:<br />

gi (x) = P( ωi x)<br />

, jolloin suurimman diskriminanttifunktion arvo vastaa suurinta a posteriori todennäköisyyttä

Oulun yliopisto, Hahmontunnistus ja neuroverkot (521497S), TS<br />

21 / 99<br />

Diskriminanttifunktiota voidaan muokata vaikuttamatta päätössääntöön. Esimerkiksi,<br />

toimivasta d-funktiosta g i(x) saadaan uusi muunnoksella f(g i(x)), jossa f()<br />

on monotonisesti kasvava funktio.<br />

Eräitä suosittuja diskriminanttifunktioita ovat:<br />

gi( x)<br />

= P( ωi x)<br />

=<br />

p( x ωi)P ( ωi) -------------------------------------------c<br />

p( x ωj)P ( ωj) Päätössäännön tarkoitus on jakaa piirreavaruus päätösalueisiin (decision regions)<br />

R1 ,...,Rc . Mikäli siis gi( x)<br />

><br />

gj( x)<br />

kaikilla j ≠ i , niin piirevektori x kuuluu<br />

päätösalueeseen R i , ja päätössääntö luokittelee hahmon luokkaan ω i .<br />

Päätösalueita erottaa toisistaan päätöspinnat (decision boundary):<br />

∑<br />

gi( x)<br />

=<br />

j = 1<br />

p( x ωi)P ( ωi) gi( x)<br />

= ln p( x ωi) + ln P( ωi)

Kaksiluokkaisessa tapauksessa luokittelijaa kutsutaan Englanniksi dichotomizer,<br />

joka tulee jakamisesta kahteen osaan. Kahden diskriminanttifunktion sijasta<br />

käytetään yhtä, joka määritellään seuraavasti:<br />

Päätössääntö on:<br />

Usein käytetään seuraavia funktioita:<br />

g( x)<br />

= g1( x)<br />

– g2( x)<br />

Päätä ω1 , jos g( x)<br />

> 0 , muutoin päätä ω2 g( x)<br />

= P( ω1 x)<br />

– P( ω2 x)<br />

g( x)<br />

ln p x ω ( 1)<br />

------------------- ln<br />

p( x ω2) P ω ( 1)<br />

=<br />

+ --------------<br />

P( ω2) Oulun yliopisto, Hahmontunnistus ja neuroverkot (521497S), TS<br />

22 / 99

<strong>2.</strong>4. Normaalijakauma<br />

Oulun yliopisto, Hahmontunnistus ja neuroverkot (521497S), TS<br />

23 / 99<br />

<strong>Bayesin</strong> luokittelijan rakenteen määrittelee ehdolliset tiheysfunktiot p( x ωi) ja prioritodennäköisyydet<br />

P(ωi). Eniten tutkittu tiheysfunktiomuoto on normaalijakauma<br />

(normal density, Gaussian), koska sen analyyttinen käsiteltävyys on hyvä ja koska<br />

se sopii hyvin mallintamaan usein esiintyvää signaaliin summautunutta kohinaa.<br />

Ensialkuun palautetaan mieleen skalaariarvoisen funktion f(x) tilastollisen odotusarvon<br />

(expected value) määritelmä, kun x on jatkuva-arvoinen muuttuja:<br />

∞<br />

ε[ f( x)<br />

] ≡ f( x)p<br />

( x)<br />

dx<br />

Diskreetin muuttujan x ∈ D tapauksessa odotusarvo lasketaan kaavalla:<br />

Huomaa, että jatkuva muuttujan x tapauksessa käytetään todennäköisyystiheysfunktiota<br />

p(x) (pienellä p:llä), kun diskreetin muuttujan x tapauksessa käytetään<br />

todennäköisyysjakaumaa (todennäköisyysmassaa) P(x) (isolla P:llä).<br />

Jatkuva-arvoisen skalaarimuuttujan x normaalijakauma eli Gaussin jakauma:<br />

Muuttujan x odotusarvo ja neliöllisen poikkeaman odotusarvo eli varianssi:<br />

∞<br />

∫<br />

– ∞<br />

ε[ f( x)<br />

] = f( x)P<br />

( x)<br />

p( x)<br />

=<br />

∑<br />

x ∈ D<br />

1<br />

– -- ⎛----------- x – µ ⎞<br />

--------------e<br />

1 2⎝<br />

σ ⎠<br />

2πσ<br />

2<br />

µ ≡ ε[ x ] = xp( x)<br />

dx<br />

∫<br />

– ∞<br />

σ 2 ε ( x – µ ) 2 ≡ [ ] ( x – µ ) 2 =<br />

p( x)<br />

dx<br />

∞<br />

∫<br />

– ∞

Usein merkitään p( x)<br />

N µ σ , katso kuva alla:<br />

2<br />

∼ ( , )<br />

<strong>2.</strong>4.1. Piirrevektorin tiheysfunktio<br />

Monimuuttujainen (multivariate) normaalijakauma p( x)<br />

∼ N( m, Σ)<br />

:<br />

p( x)<br />

1<br />

d 2<br />

( 2π)<br />

⁄ 1 2<br />

Σ ⁄<br />

1<br />

– -- ( x – m)<br />

2<br />

-----------------------------------e<br />

t Σ 1 – ( x – m)<br />

, jossa m on x:n d-ulotteinen odotusarvovektori (mean vector), ja Σ on dxd-<br />

Oulun yliopisto, Hahmontunnistus ja neuroverkot (521497S), TS<br />

=<br />

24 / 99<br />

kokoinen kovarianssimatriisi (covariance matrix), Σ ja Σ ovat kovarianssimatriisin<br />

determinantti ja käänteismatriisi, yläindeksi t tarkoittaa transpoosia.<br />

1 –<br />

∞<br />

m ≡ ε[ x ] = xp( x)<br />

dx<br />

∫<br />

– ∞<br />

Σ ε ( x – m)<br />

( x – m)<br />

t ≡ [<br />

] ( x – m)<br />

( x – m)<br />

t =<br />

p( x)<br />

dx<br />

∞<br />

∫<br />

– ∞

Oulun yliopisto, Hahmontunnistus ja neuroverkot (521497S), TS<br />

25 / 99<br />

Odotusarvo vektorista saadaan ottamalla odotusarvo vektorin komponenteista erikseen:<br />

= ε[ xi ]<br />

m i<br />

Kovarianssimatriisin elementti σij edustaa komponenttien xi ja xj välistä kovarianssia<br />

ja määritellään seuraavasti:<br />

σij = ε[ ( xi – mi) ( xj – mj) ]<br />

Kovarianssimatriisi on aina symmetrinen ja positiivinen semidefiniitti (eli determinantti<br />

nolla tai positiivinen). Determinantti on nolla esimerkiksi silloin, kun osa<br />

piirrevektorin komponenteista ovat identtisiä tai korreloivat täydellisesti keskenään.<br />

Jos komponentit x i ja x j ovat tilastollisesti riippumattomia (statistically independent),<br />

elementti σ ij = 0. Mutta ei välttämättä toisinpäin, sillä kovarianssianalyysissä<br />

arvioidaan lineaarista riippumattomuutta, ja riippuvuuksiahan on olemassa epälineaarisiakin!<br />

Diagonaalielementit σ ii = σ i 2 ovat komponenttien xi varianssit. Alla esimerkki 2ulotteisen<br />

piirrevektorijoukon kovarianssimatriisista:<br />

S<br />

2<br />

σ11 σ12 σ1 σ12<br />

= = =<br />

σ21 σ 2<br />

22 σ21 σ2 2<br />

σ1 σ12<br />

2<br />

σ12 σ2 Monimuuttujaisen normaalijakauman määrittelee siis d+d(d+1)/2 parametria, eli<br />

odotusarvovektori ja kovarianssimatriisin riippumattomat elementit.<br />

Esimerkiksi diskreetin muuttujan x tapauksessa lasketaan näitä suureita vastaavat<br />

otoskeskiarvo ja otoskovarianssimatriisi seuraavasti:<br />

N<br />

1<br />

x = --- x<br />

N ∑ i<br />

i = 1<br />

S<br />

1<br />

--- ( x<br />

N i – x)<br />

( xi – x)<br />

t<br />

N<br />

=<br />

∑<br />

i = 1

Alla kuva 2-ulotteisesta Gaussin jakaumasta.<br />

Jakauma on vino, koska esimerkkitapauksessa piirteet x 1 ja x 2 korreloivat positiivisesti<br />

(esimerkiksi kalan pituus ja paino). Ellipsit kuvastavat pisteitä, joissa<br />

Oulun yliopisto, Hahmontunnistus ja neuroverkot (521497S), TS<br />

r 2<br />

( x – m)<br />

t Σ 1 – = ( x – m)<br />

=<br />

vakio<br />

26 / 99<br />

Suuretta r kutsutaan Mahalanobis-etäisyydeksi piirrevektorin x ja luokan jakauman<br />

odotusarvon m välillä. (Kuvassa odotusarvoa m merkitään symbolilla µ.) Sitä<br />

käytetään usein luokittelijoissa mitattaessa sitä kuinka etäällä/lähellä hahmo on eri<br />

luokkia, tähän palataan pian.<br />

Ellipsien akselit voidaan haluttaessa laskea ominaisarvoanalyysin kautta.<br />

Tyypillisesti kuvat piirretään siten, että sisin ellipsi on yhden keskihajonnan (standard<br />

deviation) etäisyydellä keskipisteestä, seuraava kahden keskihajonnan, jne.

<strong>2.</strong>5. Diskriminanttifunktioita normaalijakaumalle<br />

Käytettäessä diskriminanttifunktiona aiemmin esitettyä muotoa<br />

Oulun yliopisto, Hahmontunnistus ja neuroverkot (521497S), TS<br />

27 / 99<br />

normaalijakautuneen satunnaismuuttujan x tapauksessa p( x ωi) ∼ N( mi, Σi) ja:<br />

gi( x)<br />

=<br />

Tarkastellaan seuraavaksi eräitä usein käytännössä esiintyviä erikoistapauksia.<br />

<strong>2.</strong>5.1. Tapaus Σ i = σ 2 I<br />

gi( x)<br />

= ln p( x ωi) + ln P( ωi) 1<br />

-- ( x – m<br />

2 i)<br />

t – 1 d<br />

– Σi ( x – mi)<br />

-- ln 2π<br />

2<br />

1<br />

– – -- ln Σ<br />

2 i<br />

ln P( ωi) Tässä tapauksessa kaikkien luokkien kovarianssimatriisi on identtinen ja on<br />

yksikkömatriisin muotoinen päädiagonaalielementin saadessa arvon σ 2 . Esim.:<br />

Σ<br />

=<br />

σ 2 0<br />

0 σ 2<br />

Näin käy jos piirrevektorin komponentit eli piirteet ovat tilastollisesti lineaarisesti<br />

riippumattomia ja jokaisen piirteen varianssi on sama σ 2 . Geometrisesti tulkittuna<br />

tämä tarkoittaa ympyrämäisesti samalla tavalla jakautuneita luokkia, jotka sijaitsevat<br />

piirreavaruuden kohdissa m i.<br />

+

Tällöin<br />

Oulun yliopisto, Hahmontunnistus ja neuroverkot (521497S), TS<br />

Σ i<br />

σ 2d<br />

= ja Σ 1 – 1<br />

σ 2<br />

= ----- I<br />

28 / 99<br />

Koska <strong>2.</strong> ja 3. termi diskriminanttifunktiossa ovat riippumattomia luokasta, ne eivät<br />

vaikuta erottelukykyyn ja voidaan siten jättää pois. Saadaan siis:<br />

gi( x)<br />

=<br />

2<br />

x – mi 2σ 2<br />

– ---------------------- + ln P( ωi) Ensimmäisen termin osoittajassa esiintyvä lauseke on pisteiden x ja mi välinen<br />

Euklidinen etäisyys:<br />

2<br />

x – mi ( x – mi) t ( x – mi) ( xj – mij) 2<br />

d<br />

= =<br />

x 2<br />

x<br />

x-m i<br />

m i<br />

∑<br />

j = 1<br />

x 1

Oulun yliopisto, Hahmontunnistus ja neuroverkot (521497S), TS<br />

29 / 99<br />

Edellä esitettyä diskriminanttifunktiota voidaan muokata edelleen laskemalla etäisyyslauseke<br />

auki, jolloin saadaan:<br />

gi( x)<br />

=<br />

1<br />

2σ 2<br />

– -------- x t t t<br />

[ x – 2mix + mi mi]<br />

+ ln P( ωi) Termi x t x on sama kaikille luokille, joten se voidaan jättää pois. Merkitään nyt:<br />

1<br />

wi σ<br />

Tällöin saadaan muoto, jota kutsutaan lineaariseksi diskriminanttifunktioksi:<br />

2<br />

1<br />

= ----- mi ja wi0 2σ 2<br />

t<br />

= – -------- mi mi + ln P( ωi) t<br />

gi( x)<br />

= wix + wi0<br />

Lineaarista diskriminanttifunktiota käyttävää luokittelijaa kutsutaan lineaariseksi<br />

koneeksi (linear machine). Voidaan osoittaa, että lineaarisella koneella luokkia erottelevina<br />

päätöspintoina toimivat hypertasot, jotka voidaan laskea suoraviivaisesti<br />

jokaisen luokkaparin i-j välille asettamalla g i (x)=g j (x):<br />

w i<br />

gi( x)<br />

– gj( x)<br />

= 0<br />

t t<br />

x + wi0 – wjx – wj0 = 0<br />

1<br />

----- ( mi – mj) t 1 t<br />

x --------m<br />

1 t<br />

– imi<br />

+ ln P( ωi) + --------m jmj<br />

– ln P( ωj) = 0<br />

σ 2<br />

( mi – mj) t x<br />

( mi – mj) t x<br />

2σ 2<br />

( mi – mj) t x<br />

Yhtälö ( mi – mj) edustaa pisteen x0 kautta kulkevaa hypertasoa L,<br />

joka on kohtisuorassa luokkien i ja j keskipisteitä yhdistävää janaa mi-mj vastaan.<br />

t ( x – x0) =<br />

0<br />

2σ 2<br />

1 t t<br />

– -- ( m<br />

2 imi<br />

– mj mj)<br />

σ 2 ln P ω ( i)<br />

+ ------------- = 0<br />

P( ωj) 1<br />

-- ( m<br />

2 i – mj) t<br />

mi – mj –<br />

( mi + mj) -------------------------σ<br />

2<br />

mi – mj 2 ln P ω ( i)<br />

+ ------------- = 0<br />

P( ωj) 1<br />

-- ( m<br />

2 i – mj) t ( mi – mj) –<br />

( mi + mj) t<br />

-------------------------σ<br />

2<br />

mi – mj 2 ln P ω ( i)<br />

+ ------------- ( m<br />

P( ωj) i – mj) = 0<br />

( mi – mj) t 1<br />

x – -- ( m<br />

2 i + mj) -------------------------ln<br />

2<br />

mi – mj P ω ⎧ ( i)<br />

⎫<br />

⎨ +<br />

------------- ( m<br />

P( ωj) i – mj) ⎬<br />

⎩ ⎭<br />

σ 2<br />

( mi – mj) t ( x – x0) = 0<br />

2<br />

=<br />

0

Oulun yliopisto, Hahmontunnistus ja neuroverkot (521497S), TS<br />

30 / 99

Mikäli prioritodennäköisyydet ovat yhtäsuuret P(ω i)=P(ω j), lausekkeista nähdään<br />

että x0 =<br />

1<br />

-- ( m<br />

2 i + mj) eli hypertaso kulkee luokkakeskipisteiden puolivälistä.<br />

Mikäli P( ωi) > P( ωj) , leikkauspiste x0 siirtyy poispäin luokasta ωi . Alla olevassa<br />

piirroksessa uusi leikkauspiste on x’ 0 ja ε>0 tulee lausekkeesta:<br />

x 2<br />

Oulun yliopisto, Hahmontunnistus ja neuroverkot (521497S), TS<br />

ε<br />

m i<br />

=<br />

x 0<br />

σ 2<br />

--------------------------ln<br />

2<br />

mi – mj P ω ( i)<br />

-------------<br />

P( ωj) m i-m j<br />

x’ 0<br />

−ε(m i -m j )<br />

31 / 99<br />

Mikäli priorit ovat samat kaikille luokille, diskriminanttifunktiota voidaan yksinkertaistaa<br />

edelleen poistamalla vastaavat termit. Lisäksi voidaan poistaa luokasta<br />

riippumattomat σ-termit, joten päätössäännöksi saadaan:<br />

Tätä kutsutaan minimietäisyysluokittelijaksi (minimum distance classifier), jota<br />

käytetään monissa sovelluksissa. Tämän luvun perusteella nähdään mitä matemaattisia<br />

oletuksia on oltava voimassa, jotta päätössääntö toimisi optimaalisesti.<br />

m j<br />

Päätä ωi mikäli x – mi <<br />

x – mj ∀j<br />

≠ i<br />

L<br />

L’<br />

x 1

Oulun yliopisto, Hahmontunnistus ja neuroverkot (521497S), TS<br />

32 / 99<br />

<strong>2.</strong>5.<strong>2.</strong> Tapaus Σ i = Σ<br />

Luokkien kovarianssimatriisit ovat identtiset, mutta muutoin mielivaltaiset. Geometrisen<br />

tulkinnan mukaan luokkien muodot on piirreavaruudessa ovat samanlaiset,<br />

mutta ne sijaitsevat eri paikoissa m i. Koska osa diskriminanttifunktion termeistä on<br />

jälleen luokasta riippumattomia, saadaan yksinkertaistamisen jälkeen:<br />

gi( x)<br />

=<br />

1<br />

-- ( x – m<br />

2 i)<br />

t Σ 1 – – ( x – mi) – ln P( ωi) Mikäli luokkien priorit ovat samat, saadaan päätössäännöksi yksinkertaistamisen<br />

jälkeen:<br />

Päätä ωi mikäli ( x – mi) t Σ 1 – ( x – mi) ( x – mj) t Σ 1 – <<br />

( x – mj) ∀j<br />

≠ i<br />

Etäisyysmittana käytetään tässä Mahalanobis-etäisyyttä, joka siis huomioi luokkaellipsien<br />

kiertymisen piirreavaruudessa. Alla olevassa kuvassa esiintyvät luokan<br />

jakauman muotoa kuvastavan ellipsin kaksi pistettä ovat yhtä etäällä luokan keskipisteestä<br />

tämän metriikan mukaan!<br />

x 2<br />

x 1

Vastaavalla tavalla kuin edellisessä kappaleessa diskriminanttifunktiosta voidaan<br />

jättää pois luokasta riippumattomia termejä ja muuntaa se lineaariseen muotoon:<br />

, jossa<br />

wi Σ 1 – = mi ja wi0 t<br />

gi( x)<br />

= wix + wi0<br />

Päätöspinnat ovat siis jälleen hypertasoja, mutta nyt tasot eivät ole yleisesti ottaen<br />

kohtisuorassa luokkien keskipisteitä yhdistäviä janoja vastaan. Tasojen yhtälöt<br />

voidaan johtaa vastaavalla tavalla kuin edellä.<br />

Oulun yliopisto, Hahmontunnistus ja neuroverkot (521497S), TS<br />

1 t – 1<br />

=<br />

– -- m<br />

2 iΣ<br />

mi + ln P( ωi) 33 / 99

Oulun yliopisto, Hahmontunnistus ja neuroverkot (521497S), TS<br />

34 / 99<br />

<strong>2.</strong>5.3. Tapaus Σi = mielivaltainen<br />

Kullakin luokalla on mielivaltainen kovarianssimatriisi, joten alkuperäisestä diskriminanttifunktiosta<br />

voidaan pudottaa pois vain termi (d/2)ln 2π . Pienen manipulaation<br />

jälkeen saadaan kvadraattinen (neliöllinen) muoto:<br />

gi( x)<br />

x t t<br />

= Wix + wix<br />

+ wi0<br />

, jossa<br />

W i<br />

1 – 1 – 1<br />

– --Σ<br />

1 t – 1<br />

=<br />

2 i , wi = Σi mi ja w --<br />

1<br />

i0 =<br />

– m<br />

2 iΣi<br />

mi – -- ln Σ<br />

2 i + ln P( ωi) Kaksiluokkaisessa ongelmassa päätöspinnat ovat hyperkvadreja (hyperquadrics):<br />

• hypertasot<br />

• hypertasoparit<br />

• hyperpallot<br />

• hyperellipsoidit<br />

• hyperparaboloidit<br />

• hyperhyperboloidit<br />

Jopa 1-ulotteisessa tapauksessa päätösalueet saattavat jakaantua moneen osaan:<br />

Seuraavilla sivuilla on esitetty lisää esimerkkejä päätöspinnoista.

Oulun yliopisto, Hahmontunnistus ja neuroverkot (521497S), TS<br />

35 / 99

Oulun yliopisto, Hahmontunnistus ja neuroverkot (521497S), TS<br />

36 / 99

Allaolevassa kuvassa pyritään erottelemaan neljä Gaussista luokkaa toisistaan:<br />

Oulun yliopisto, Hahmontunnistus ja neuroverkot (521497S), TS<br />

37 / 99<br />

Luokittelija tekee päätöksen jakaumien muodot huomioiden. Alla olevassa kuvassa<br />

keskellä oleva piste x kuuluu luokkaan ω 2 , vaikka se on lähempänä luokan ω 1<br />

keskipistettä! Minimietäisyysluokittelija sijoittaisi hahmon siis luokkaan ω 1 .<br />

x 2<br />

ω 1<br />

ω 2<br />

x 1

<strong>2.</strong>6. Virheen todennäköisyydestä<br />

Oulun yliopisto, Hahmontunnistus ja neuroverkot (521497S), TS<br />

38 / 99<br />

Tarkastellaan kaksiluokkaista tapausta, jossa luokittelijalle on opetettu päätöspinta.<br />

Koska luokkajakaumat ovat yleensä osittain päällekkäiset, tapahtuu ajoittain luokitteluvirhe:<br />

• piirrevektori x kuuluu päätösalueeseen R 1 , vaikka hahmo kuuluu luokkaan ω 2<br />

• piirrevektori x kuuluu päätösalueeseen R 2, vaikka hahmo kuuluu luokkaan ω 1<br />

Virheen todennäköisyys saadaan seuraavasti:<br />

P( virhe)<br />

= P( x ∈ R2, ω1) + P( x ∈ R1, ω2) =<br />

=<br />

P( x ∈ R2 ω1)P ( ω1) + P( x ∈ R1 ω2)P ( ω2) ∫<br />

R2 p( x ω1)P ( ω1) dx<br />

p( x ω2)P ( ω2) dx<br />

Tulosta havainnollistetaan seuraavassa kuvassa. Päätöspinta on tässä pelkkä kynnys<br />

x* ja se on selvästi asetettu epäoptimaaliseen kohtaan; <strong>Bayesin</strong> valinta on x B .<br />

Kuvankin mukaan <strong>Bayesin</strong> päätössääntö johtaa pienimpään luokitteluvirheeseen,<br />

koska virhettä edustava pinta-ala on pienin mahdollinen.<br />

+<br />

∫<br />

R1

Oulun yliopisto, Hahmontunnistus ja neuroverkot (521497S), TS<br />

39 / 99<br />

Moniluokkaisessa tapauksessa on helpompaa laskea oikean luokittelun todennäköisyys:<br />

P( oikein)<br />

= P( x ∈ Ri, ωi) =<br />

=<br />

i = 1<br />

c<br />

<strong>Bayesin</strong> luokittelija maksimoi tämän todennäköisyyden valitsemalla päätösalueet<br />

siten, että integroitava lauseke on suurin mahdollinen kaikilla x. Tämän johdosta<br />

virheen todennäköisyys on pienin mahdollinen: P(virhe)=1-P(oikein) .<br />

c<br />

∑<br />

∑<br />

i = 1<br />

c<br />

∑<br />

i = 1<br />

P( x ∈ Ri ωi) P ( ωi) ∫<br />

Ri p( x ωi)P ( ωi) dx

<strong>2.</strong>7. Spesifisyys, sensitiivisyys, testin ennustearvo, ROC-käyrät<br />

Oulun yliopisto, Hahmontunnistus ja neuroverkot (521497S), TS<br />

40 / 99<br />

Kaksiluokkaisessa ongelmassa on usein hyödyllistä tarkastella spesifisyyttä ja sensitiivisyyttä,<br />

jotka kuvastavat luokittelijan kykyä erotella luokat toisistaan. Tarkastellaan<br />

esimerkkinä hiihtäjien doping-testausta, jossa tavoitteena on erottaa<br />

dopingia käyttäneet. Seuraava nelikenttä kuvastaa minkä verran hiihtäjiä luokittelija<br />

on luokitellut oikein ja väärin:<br />

Sensitiivisyys:<br />

Spesifisyys:<br />

Test<br />

positive<br />

Test<br />

negative<br />

Sensitivity<br />

Specificity<br />

Positiivisen testin ennustearvo:<br />

Negatiivisen testin ennustearvo:<br />

Doping<br />

present<br />

Predictive value of positive test<br />

True<br />

positives<br />

False<br />

negatives<br />

Predictive value of negative test =<br />

=<br />

=<br />

Doping<br />

absent<br />

False<br />

positives<br />

True<br />

negatives<br />

----------------------------------------------------------------------------<br />

True positives<br />

True positives + False negatives<br />

True negatives<br />

----------------------------------------------------------------------------<br />

True negatives + False positives<br />

=<br />

---------------------------------------------------------------------------<br />

True positives<br />

True positives + False positives<br />

-----------------------------------------------------------------------------<br />

True negatives<br />

True negatives + False negatives

Oulun yliopisto, Hahmontunnistus ja neuroverkot (521497S), TS<br />

41 / 99<br />

Voidaan käyttää myös seuraavia nimikkeitä kentille:<br />

• oikea hälytys (hit): true positives, TP<br />

• väärä hälytys (false alarm): false positives, FP<br />

• väärä hylkäys (miss): false negatives, FN<br />

• oikea hylkäys (correct rejection): true negatives, TN<br />

Tarkastellaan tilannetta, jossa käytetään vain yhtä piirrettä. Oletetaan, että jakaumat<br />

ovat osittain päällekkäiset kuten kuvassa (esittää tutkapulssin ilmaisemista vastaanotetun<br />

signaalin amplitudimittauksella):<br />

TN<br />

FN<br />

Kuvaan on piirretty päälle edellä esitetyn nelikentän mukaiset merkinnät (TP, FP,<br />

TN, FN), joille on näin saatu geometriset tulkinnat. Kun kynnysarvo x*<br />

(päätöspinta) on kiinnitetty, sensitiivisyys ja spesifisyys saadaan laskettua helposti<br />

luokittelutuloksista kun tapausten luokat tunnetaan.<br />

Luokkien erottuvuuden mittana voidaan käyttää suuretta:<br />

d'<br />

µ 2 – µ 1<br />

=<br />

-------------------σ<br />

, joka ilmaisee Gaussisesti jakautuneiden luokkien keskipisteiden välisen etäisyyden<br />

(yhteisen) keskihajonnan monikertana. Mitä suurempi d’ on, sitä paremmin<br />

luokat erottuvat toisistaan ja luokittelija suoriutuu hyvällä suorituskyvyllä.<br />

TP<br />

FP

Oulun yliopisto, Hahmontunnistus ja neuroverkot (521497S), TS<br />

42 / 99<br />

Jos oletetaan tietyllä etäisyydellä d’ sijaitsevat jakaumat ja muutellaan luokittelijan<br />

kynnysarvoa x* systemaattisesti, saadaan jokaisella asetuksella (aineisto läpiajamalla)<br />

yksi sensitiivisyys-spesifisyys-lukupari. Nämä lukuparit voidaan esittää<br />

koordinaattipisteinä koordinaatistossa, jossa vaaka-akselina on väärien hälytysten<br />

todennäköisyys (1-Spesifisyys) ja pystyakselina oikean hälytyksen todennäköisyys<br />

(Sensitiivisyys):<br />

Sensitiivisyys<br />

1-Spesifisyys<br />

Jokaisella d’-suureen arvolla saadaan erillinen käyrä, ROC-käyrä. Jos d’=0, jakaumat<br />

ovat täysin päällekkäisiä ja erottuvuus huonoin. Erottuvuus on sitä parempi,<br />

mitä lähempää käyrä menee vasenta ylänurkkaa. Tutkaesimerkissämme valittu x*kynnysarvo<br />

on johtanut osumaan täplän osoittamaan kohtaan. Vaihtelemalla kynnysarvoa,<br />

täplä liikkuisi pitkin käyrää d’=3.

Kuvasta tehdään tärkeä havainto:<br />

Jakaumien ollessa kiinnitetyt, kun sensitiivisyys kasvaa suureksi niin spesifisyys<br />

pienenee huomattavasti, ja päinvastoin.<br />

Mitä tämä tarkoittaa tutkasignaalin ilmaisussa?<br />

Jakaumien ollessa monimutkaiset ROC-käyrä on monimutkaisempi:<br />

<strong>2.</strong>8. <strong>Bayesin</strong> <strong>päätösteoria</strong> diskreeteille muuttujille<br />

Oulun yliopisto, Hahmontunnistus ja neuroverkot (521497S), TS<br />

43 / 99<br />

Useissa sovelluksissa piirteet ovat kokonaislukumuuttujia, jotka voivat saada arvot<br />

v 1 ,...,v m . Todennäköisyystiheysfunktioista tulee singulaarisia ja integraalimerkinnät<br />

joudutaan vaihtamaan summamerkintöihin. Esimerkiksi <strong>Bayesin</strong> kaava saa<br />

muodon:<br />

P( ωj x)<br />

P( x ωj)P ( ωj) P( x ωj)P ( ωj) = --------------------------------- =<br />

--------------------------------------------<br />

P( x)<br />

c<br />

i = 1<br />

P( x ωi)P ( ωi) Ehdollisen riskin määritelmä ei muutu, joten toiminnon α valinta saadaan kaavasta:<br />

∑

α* = arg min R( ωi x)<br />

i<br />

Suurimpaan posterioritodennäköisyyteen perustuvan päätössäännön muoto ei<br />

myöskään muutu, eikä aiemmin esiteltyjen diskriminanttifunktioiden muodot.<br />

<strong>2.</strong>9. <strong>Bayesin</strong> verkot<br />

Kaikissa sovelluksissa tietämyksemme ratkaistavasta ongelmasta ei sisällä tietoa<br />

piirteiden jakaumista, vaan osassa tiedetään jotain piirteiden välisistä riippuvuuksista<br />

tai riippumattomuuksista. <strong>Bayesin</strong> verkot (Bayesian networks) on kehitetty<br />

mallintamaan tällaista tietoa ja tekemään sen perusteella tilastollista päättelyä.<br />

Muita nimikkeitä ovat <strong>Bayesin</strong> uskomusverkot (Bayesian belief networks),<br />

kausaaliverkot (causal neworks) ja uskomusverkot (belief networks).<br />

Oulun yliopisto, Hahmontunnistus ja neuroverkot (521497S), TS<br />

44 / 99<br />

Mikäli kahdelle satunnaismuuttujalle x ja y pätee: p(x, y) = p(x)p(y), näiden muuttujien<br />

sanotaan olevan tilastollisesti riippumattomia. Samoin jonkin piirrevektorin<br />

komponentit voivat olla tilastollisesti riippumattomia. Alla olevassa kuvassa on<br />

esitetty 3-ulotteisten piirrevektorien avulla erään luokan sijoittuminen piirreavaruuteen.<br />

Muuttujat x 1 ja x 3 ovat toisistaan tilastollisesti riippumattomia, mutta muut<br />

eivät. Mistä tämä nähdään?<br />

<strong>Bayesin</strong> verkot ovat suunnattuja syklittömiä verkkoja, joka sisältää solmuja ja niitä<br />

yhdistäviä suunnattuja linkkejä. Linkit esittävät muuttujien välisiä riippuvuussuhteita,<br />

kuten syy-seuraus-suhteita. Verkot voivat toimia myös moniulotteisten jatkuvien<br />

jakaumien esitystapana, mutta käytännössä niitä on eniten sovellettu<br />

diskreettien todennäköisyysmassojen esittämiseen.<br />

Kukin solmu A, B,... esittää yhtä ongelman muuttujaa. Kullakin diskreetillä muuttujalla<br />

voi olla useita eri tiloja, joita merkitään pienellä kirjaimella vastaavasti ai, bj,... alaindeksin merkitessä tiettyä tilaa. Esimerkiksi A voi merkitä binäärisen kytkimen<br />

tilaa: a1 = ‘on’ ja a2 = ‘off’, jolloin vaikkapa P(a1 )=0,739 ja P(a2 )=0,261.<br />

Todennäköisyydet summautuvat ykköseksi kaikissa muuttujissa. Alla olevassa<br />

kuvassa solmusta A solmuun C kulkeva linkki esittää ehdollisia todennäköisyyksiä<br />

P( ci aj) , joka tiiviimmin ilmaistaan muodossa P( c a)<br />

, jossa a ja c ovat muut-<br />

tujien A ja C tilat koottuina vektoreiksi: a [ a1, …, an] .<br />

T ja c [ c1, …, cm] T<br />

=<br />

=

Oulun yliopisto, Hahmontunnistus ja neuroverkot (521497S), TS<br />

45 / 99<br />

<strong>Bayesin</strong> päättelyn avulla voidaan verkkoa hyödyntäen laskea kunkin muuttujan eri<br />

arvojen todennäköisyydet. Itse asiassa, mikä tahansa useasta muuttujasta koostuvan<br />

yhdistelmän todennäköisyys (yhteistodennäköisyys, joint probability) on mahdollista<br />

laskea verkosta. Todennäköisyyksien laskennassa huomioidaan verkon<br />

ilmoittamat riippuvuudet, jolloin päästään yksinkertaistamaan (ja nopeuttamaan)<br />

laskentaa merkittävästi. Tarkastellaan ensin yksittäisen muuttujan arvojen<br />

todennnäköisyyksien laskemista esimerkkien avulla.<br />

Ennen esimerkkejä kolme tärkeää seikkaa:<br />

1) Marginalisointi, jossa todennäköisyyksiä summataan määrättyjen muuttujien

P(a) P(b|a) P(c|b) P(d|c)<br />

A B<br />

kaikkien vaihtoehtojen ylitse. Alla esiintyvissä merkinnöissä esiintyy kaksin- ja<br />

kolminkertaisia summauslausekkeita, esimerkiksi:<br />

2) <strong>Bayesin</strong> kaava, eli:<br />

C D<br />

Oulun yliopisto, Hahmontunnistus ja neuroverkot (521497S), TS<br />

P(f|e)<br />

F<br />

P(e)<br />

E<br />

H<br />

P(h|f,g)<br />

Figure <strong>2.</strong>25. Vasemmalla lineaarinen ketju, oikealla silmukka.<br />

∑<br />

a, b, c<br />

P( a, b, c)<br />

↔<br />

∑∑∑<br />

P( a, b)<br />

=<br />

P( a)P<br />

( b a)<br />

a<br />

b<br />

c<br />

P( a, b, c)<br />

G<br />

P(g|e)<br />

46 / 99

3) Vakiotermien siirtäminen summalausekkeen vasemmalle puolelle nopeuttaa<br />

laskentaa.<br />

Oulun yliopisto, Hahmontunnistus ja neuroverkot (521497S), TS<br />

47 / 99<br />

Seuraavaksi havainnollistetaan verkon muuttujien todennäköisyyksien laskemista.<br />

Vasemman puoleiselle verkolle voidaan laskea esimerkiksi P(d):<br />

=<br />

=<br />

P( d)<br />

= P( a, b, c, d)<br />

a, b, c<br />

Huomaa, että viimeisellä rivillä kyseessä on sisäkkäiset silmukat. Entä kuinka lasketaan<br />

P(b) samalle verkolle? Aivan vastaavalla tavalla:<br />

Vastaavasti oikeanpuoleiselle silmukkarakenteelle voidaan laskea esimerkiksi P(h):<br />

Entä kuinka lasketaan P(g) samalle verkolle?<br />

=<br />

∑<br />

a, b, c<br />

=<br />

∑<br />

c<br />

=<br />

∑<br />

a, b, c<br />

Edellä olevissa lausekkeissa viimeisen muodon johtaminen edelliseltä riviltä<br />

vaikuttaa vain laskennan määrään.<br />

∑<br />

∑ P( a)P<br />

( b, c, d a)<br />

a, b, c<br />

P( a)P<br />

b a<br />

P( a)P<br />

b a<br />

∑<br />

a, b, c<br />

( )P( c, d a, b)<br />

( )P( c a, b)P<br />

( d a, b, c)<br />

P( a)P<br />

( b a)P<br />

( c b)P<br />

( d c)<br />

∑<br />

∑<br />

P( d c)<br />

P( c b)<br />

P( b a)P<br />

( a)<br />

b<br />

a

=<br />

=<br />

=<br />

∑<br />

P( b)<br />

= P( a, b, c, d)<br />

a, c, d<br />

∑ P( a)P<br />

( b, c, d a)<br />

a, c, d<br />

Oulun yliopisto, Hahmontunnistus ja neuroverkot (521497S), TS<br />

=<br />

∑<br />

a, c, d<br />

=<br />

∑<br />

c<br />

=<br />

∑<br />

a, c, d<br />

P( a)P<br />

b a<br />

P( a)P<br />

b a<br />

∑<br />

a, c, d<br />

P( c b)<br />

( )P( c, d a, b)<br />

( )P( c a, b)P<br />

( d a, b, c)<br />

P( a)P<br />

( b a)P<br />

( c b)P<br />

( d c)<br />

∑<br />

d<br />

P( d c)<br />

P( b a)P<br />

( a)<br />

48 / 99<br />

Edellä laskettiin tiettyjien muuttujien arvojen todennäköisyyksiä, kun verkon<br />

muiden muuttujien arvoja ei tunnettu. Tällöin laskelmissa tuli käydä kaikki mahdolliset<br />

muuttujien arvot läpi ja laskea näiden vaihtoehtojen todennäköisyyksillä painotettu<br />

tulos.<br />

Seuraavaksi havainnollistetaan <strong>Bayesin</strong> verkon käyttämistä tiettyjen muuttujien<br />

posteriotodennäköisyyksien laskemisessa, kun eräiden muuttujien arvot tunnetaan.<br />

Käytännön sovelluksissa muuttujien arvot saadaan esimerkiksi muista sovelluksista<br />

syötteinä tai vaikkapa mittaamalla ohjattavan toimilaitteen sensoreilla. Tätä ulkoista<br />

informaatiota voidaan kutsua todisteaineistoksi (evidence) toimintaympäristön<br />

tilasta.<br />

Merkitään muuttujajoukon X a posteriori todennäköisyyttä symbolilla P( X e)<br />

.<br />

Muuttuja e merkitsee muuttujajoukkoon X muista verkon osista saatavaa todistu-<br />

∑<br />

⎛ ⎞ ⎛ ⎞<br />

⎜∑ P( b a)P<br />

( a)<br />

⎟ ⎜ P( c b)<br />

⎝ ⎠ ∑ ∑P(<br />

d c)<br />

⎟<br />

⎝ ⎠<br />

a<br />

c d<br />

a

=<br />

=<br />

∑<br />

P( h)<br />

= P( e, f, g, h)<br />

e, f, g<br />

∑ P( e)P<br />

( f, g, h e)<br />

e, f, g<br />

saineistoa siitä missä tilassa X on. Voidaankin määritellä, että uskomus (belief)<br />

tarkoittaa ehdollista todennäköisyyttä P( X e)<br />

että muuttujajoukko X on tietyssä<br />

tilassa, kun verkon sisältämä todennäköisyystieto tunnetaan. Ajatuksena on hyödyntää<br />

päättelyssä ulkoisen informaation lisäksi kaikki verkon sisältämä todennäköisyystieto<br />

linkkien esittämän riippuvuustiedon mukaisesti minkä tahansa<br />

muuttujan posteriorien laskemiseksi.<br />

Oulun yliopisto, Hahmontunnistus ja neuroverkot (521497S), TS<br />

=<br />

∑<br />

e, f, g<br />

=<br />

=<br />

∑<br />

e, f, g<br />

∑<br />

e, f, g<br />

∑<br />

f, g<br />

P( e)P<br />

f e<br />

P( e)P<br />

f e<br />

( )P( g, h e, f)<br />

( )P( g e, f)P<br />

( h e, f, g)<br />

P( e)P<br />

( f e)P<br />

g e<br />

P( h f, g)<br />

∑<br />

e<br />

( )P( h f, g)<br />

P( e)P<br />

( f e)P<br />

( g e)<br />

49 / 99<br />

Tyypillisesti halutaan laskea tietyn muuttujan todennäköisin tila; esimerkiksi onko<br />

saaliskala todennäköisemmin lohi vai meriahven, kun vuodenaika, kalastuspaikkakunta<br />

ja muita mittaustietoja on käytettävissä. Oleellisessa roolissa on<br />

<strong>Bayesin</strong> kaavasta saatava lauseke:<br />

P( X e)<br />

P( X, e)<br />

=<br />

----------------- = αP( X, e)<br />

P( e)<br />

Tämä posterioritodennäköisyyden lauseke lasketaan jokaiselle muuttujan X tilalle<br />

erikseen, minkä jälkeen suurin todennäköisyysarvo määrää todennäköisimmän

=<br />

P( g)<br />

= P( e, f, g, h)<br />

e, f, h<br />

Oulun yliopisto, Hahmontunnistus ja neuroverkot (521497S), TS<br />

=<br />

∑<br />

e, f, h<br />

=<br />

=<br />

=<br />

∑<br />

e, f, h<br />

∑<br />

e, f, h<br />

∑<br />

f, h<br />

50 / 99<br />

tilan. Termiä α<br />

voidaan laskea aivan lopuksi; lausekkeen käyttöä havainnollistetaan<br />

seuraavaksi.<br />

Esimerkki: Kalalajin päätteleminen <strong>Bayesin</strong> verkon avulla<br />

Kuvatkoon alla esitetty kaavio käytettävää <strong>Bayesin</strong> verkkoa:<br />

Seuraavat taulukot kuvaavat asiantuntijan asettamia todennäköisyyksiä:<br />

∑<br />

∑ P( e)P<br />

( f, g, h e)<br />

e, f, h<br />

P( e)P<br />

f e<br />

P( e)P<br />

f e<br />

( )P( g, h e, f)<br />

( )P( g e, f)P(<br />

h e, f, g)<br />

P( e)P<br />

( f e)P<br />

g e<br />

P( h f, g)<br />

∑<br />

e<br />

( )P( h f, g)<br />

P( e)P<br />

( f e)P<br />

( g e)

a 1 = talvi<br />

a 2 = kevät<br />

a 3 = kesä<br />

a 4 = syksy<br />

c 1 = kirkas<br />

c 2 = keskink.<br />

c 3 = tumma<br />

P(a) P(b)<br />

A<br />

aika<br />

B<br />

paikka<br />

P(x a) P(x b)<br />

X<br />

laji<br />

P(c x) P(d x)<br />

C<br />

kirkkaus<br />

P(a i ) 0,25 0,25 0,25 0,25<br />

P(b i) 0,6 0,4<br />

P(c i|x 1) 0,6 0,2 0,2<br />

P(c i |x 2 ) 0,2 0,3 0,5<br />

P(d i |x 1 ) 0,3 0,7<br />

P(d i |x 2 ) 0,6 0,4<br />

D<br />

pituus<br />

Oulun yliopisto, Hahmontunnistus ja neuroverkot (521497S), TS<br />

b 1 = Pohjois-Atlantti<br />

b 2 = Etelä-Atlantti<br />

x 1 = lohi<br />

x 2 = meriahven<br />

d 1 = pitkä<br />

d 2 = lyhyt<br />

i,j P(x 1|a i,b j) P(x 2|a i,b j)<br />

1,1 0,5 0,5<br />

1,2 0,7 0,3<br />

2,1 0,6 0,4<br />

2,2 0,8 0,2<br />

3,1 0,4 0,6<br />

3,2 0,1 0,9<br />

4,1 0,2 0,8<br />

4,2 0,3 0,7<br />

51 / 99<br />

Käytetään nyt esiteltyä <strong>Bayesin</strong> verkkoa päättelemään kalalaji. (Päätelmiä voitaisiin<br />

tehdä mistä tahansa muustakin verkon muuttujasta.) Kirjoitetaan ensin verkon

Oulun yliopisto, Hahmontunnistus ja neuroverkot (521497S), TS<br />

52 / 99<br />

muuttujien tilastollisten riippuvuuksien mukainen yhteistodennäköisyyden lauseke:<br />

P( a, b, x, c, d)<br />

= P( a)P<br />

( b a)P<br />

( x a, b)P<br />

( c a, b, x)P<br />

( d a, b, x, c)<br />

Kerätään todistusaineistoa kullekin muuttujalle olettaen että muuttujat ovat tilastollisesti<br />

riippumattomia:<br />

• kala on väriltään vaalea (c 1)<br />

• kala on saalistettu Etelä-Atlantilta (b 2 )<br />

• ei tiedetä mihin vuodenaikaan kala on saatu<br />

• pituustietoa ei ole käytettävissä.<br />

Millä todennäköisyydellä kala on lohi?<br />

=<br />

P( a)P<br />

( b)P<br />

( x a, b)P<br />

( c x)P<br />

( d x)<br />

Millä todennäköisyydellä kala on meriahven?<br />

=<br />

P( x1 c1, b2) =<br />

∑<br />

=<br />

=<br />

P( x1, c1, b2) ------------------------------ = αP( x<br />

P( c1, b2) 1, c1, b2) ∑<br />

α P( x1, a, b2, c1, d)<br />

a, d<br />

α P( a)P<br />

( b2)P ( x1 a, b2)P ( c1 x1)P ( d x1) a, d<br />

⎛ ⎞<br />

αP( b2)P ( c1 x1) ⎜∑ P( a)P<br />

( x1 a, b2) ⎟<br />

⎝ ⎠<br />

a<br />

P( x2 c1, b2) =<br />

=<br />

α( 0, 114)<br />

⎛ ⎞<br />

⎜∑ P( d x1) ⎟<br />

⎝ ⎠<br />

d<br />

P( x2, c1, b2) ------------------------------ = αP( x<br />

P( c1, b2) 2, c1, b2) =<br />

α( 0, 066)<br />

Kala on joko lohi tai meriahven, joten posteriorit summautuvat arvoon 1. Tästä

saadaan, että α=1/0,18 , P(x 1|c 1,b 2)=0,63 ja P(x 2|c 1,b 2)=0,27.<br />

Oulun yliopisto, Hahmontunnistus ja neuroverkot (521497S), TS<br />

53 / 99<br />

Saaliskala on siis todennäköisemmin lohi! Esimerkki loppuu.<br />

Mikäli ei tiedetä mitään ongelmaa kuvaavien muuttujien tilastollisista riippuvuuksista,<br />

voidaan käyttää esimerkiksi Naiivia <strong>Bayesin</strong> verkkoa (Naive Bayes network).<br />

Tällöin muuttujat oletetaan ehdollisesti riippumattomiksi ja verkon rakenne on erityisen<br />

yksinkertainen:<br />

Kuvassa juurimuuttuja (solmu) X on muuttuja, jonka suhteen tilastollisen riippumattomuuden<br />

oletus tehdään. X voi olla esimerkiksi luokkamuuttuja, jonka avulla<br />

(A/B/C/D)-muuttujien edustama hahmo pyritään tunnistamaan. Päättely perustuu<br />

posterioritodennäköisyyksien laskentaan kuten edellä.<br />

Mikäli riippumattomuusoletus pitää paikkansa sovelluksessa, kyseessä on minimivirheluokittelija.<br />

Naiivia Bayes-verkkoa on käytetty suurella menestyksellä<br />

monissa käytännön sovelluksissa.<br />

Toinen vaihtoehto on käyttää algoritmeja, jotka pyrkivät rakentamaan verkon<br />

automaattisesti opetusaineiston perusteella tarkastelemalla muuttujien välisiä riippuvuuksia.<br />

X<br />

A B C D<br />

P( x a, b, c, d)<br />

=<br />

αP( x)P<br />

( a x)P<br />

( b x)P<br />

( c x)P<br />

( d x)