Modèle logistique et scoring - Université Rennes 2

Modèle logistique et scoring - Université Rennes 2

Modèle logistique et scoring - Université Rennes 2

You also want an ePaper? Increase the reach of your titles

YUMPU automatically turns print PDFs into web optimized ePapers that Google loves.

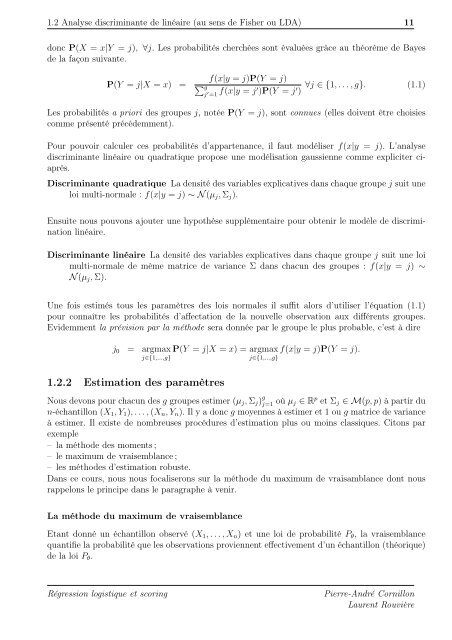

1.2 Analyse discriminante de linéaire (au sens de Fisher ou LDA) 11<br />

donc P(X = x|Y = j), ∀j. Les probabilités cherchées sont évaluées grâce au théorème de Bayes<br />

de la façon suivante.<br />

P(Y = j|X = x) =<br />

f(x|y = j)P(Y = j)<br />

g<br />

j ′ =1 f(x|y = j′ )P(Y = j ′ )<br />

∀j ∈ {1,...,g}. (1.1)<br />

Les probabilités a priori des groupes j, notée P(Y = j), sont connues (elles doivent être choisies<br />

comme présenté précédemment).<br />

Pour pouvoir calculer ces probabilités d’appartenance, il faut modéliser f(x|y = j). L’analyse<br />

discriminante linéaire ou quadratique propose une modélisation gaussienne comme expliciter ciaprès.<br />

Discriminante quadratique La densité des variables explicatives dans chaque groupe j suit une<br />

loi multi-normale : f(x|y = j) ∼ N(µj, Σj).<br />

Ensuite nous pouvons ajouter une hypothèse supplémentaire pour obtenir le modèle de discrimination<br />

linéaire.<br />

Discriminante linéaire La densité des variables explicatives dans chaque groupe j suit une loi<br />

multi-normale de même matrice de variance Σ dans chacun des groupes : f(x|y = j) ∼<br />

N(µj, Σ).<br />

Une fois estimés tous les paramètres des lois normales il suffit alors d’utiliser l’équation (1.1)<br />

pour connaître les probabilités d’affectation de la nouvelle observation aux différents groupes.<br />

Evidemment la prévision par la méthode sera donnée par le groupe le plus probable, c’est à dire<br />

j0 = argmax<br />

j∈{1,...,g}<br />

1.2.2 Estimation des paramètres<br />

P(Y = j|X = x) = argmax f(x|y = j)P(Y = j).<br />

j∈{1,...,g}<br />

Nous devons pour chacun des g groupes estimer (µj, Σj) g<br />

j=1 où µj ∈ R p <strong>et</strong> Σj ∈ M(p,p) à partir du<br />

n-échantillon (X1,Y1),...,(Xn,Yn). Il y a donc g moyennes à estimer <strong>et</strong> 1 ou g matrice de variance<br />

à estimer. Il existe de nombreuses procédures d’estimation plus ou moins classiques. Citons par<br />

exemple<br />

– la méthode des moments ;<br />

– le maximum de vraisemblance ;<br />

– les méthodes d’estimation robuste.<br />

Dans ce cours, nous nous focaliserons sur la méthode du maximum de vraisamblance dont nous<br />

rappelons le principe dans le paragraphe à venir.<br />

La méthode du maximum de vraisemblance<br />

Etant donné un échantillon observé (X1,...,Xn) <strong>et</strong> une loi de probabilité Pθ, la vraisemblance<br />

quantifie la probabilité que les observations proviennent effectivement d’un échantillon (théorique)<br />

de la loi Pθ.<br />

Régression <strong>logistique</strong> <strong>et</strong> <strong>scoring</strong> Pierre-André Cornillon<br />

Laurent Rouvière