KLASIFIKASI NON LINIER - Teknik Elektro UGM

KLASIFIKASI NON LINIER - Teknik Elektro UGM

KLASIFIKASI NON LINIER - Teknik Elektro UGM

Create successful ePaper yourself

Turn your PDF publications into a flip-book with our unique Google optimized e-Paper software.

memenuhi kriteria tertentu, yang menjamin bahwa algoritma gradient descent menyatu untuk<br />

solusi tersebut, asalkan satu ada. Kelas ini fungsi biaya dikenal sebagai fungsi well-formed.<br />

Sekarang kita akan menyajikan fungsi biaya jenis ini, yang cocok untuk tugas-tugas<br />

pengenalan pola.<br />

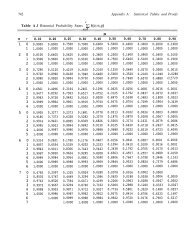

Jaringan multilayer melakukan pemetaan nonlinear dari vektor input x ke nilai output<br />

untuk masing-masing node output k = 1,2,. . . k L , dimana ketergantungan<br />

pemetaan pada nilai-nilai bobot ditampilkan secara eksplisit. Dalam bab 3 kita telah melihat<br />

bahwa, jika kita mengadopsi fungsi kuadrat biaya termurah dan output yang diinginkan y k<br />

adalah biner (milik atau tidak dalam kelas ω k ), kemudian untuk nilai optimal bobot ω* output<br />

yang sesuai jaringan, ŷ k , adalah pengaruh optimal kuadrat terkecil dari probabilitas<br />

posterior P (ω k │x) (pertanyaan tentang baik atau buruk perkiraan ini akan menarik untuk<br />

kami). Pada titik ini kita akan mengadopsi interpretasi probabilistik dari output riil ŷ k sebagai<br />

dasar fungsi biaya kami akan dibangun. Mari kita berasumsi bahwa output yang diinginkan<br />

nilai-nilai, ŷ k , bersifat independen variabel-variabel biner acak dan ŷ k yang masing-masing<br />

probabilitas posterior bahwa variabel acak adalah 1 [Hint90, Baum 88].<br />

Fungsi biaya cross-entropi kemudian didefinisikan oleh<br />

J mengambil nilai minimum ketika y k (i) = ŷ k (i) dan untuk minimum nilai respon yang<br />

diinginkan biner adalah nol. Ada berbagai penafsiran dari fungsi biaya [Hint 90, Baum 88,<br />

Gish 90, Rich 91]. Mari kita mempertimbangkan, untuk contoh, vektor keluaran y(i) bila x(i)<br />

muncul di input. Ini terdiri dari 1 di node kelas benar dan nol untuk lainnya. Jika kita<br />

memperhitungkan bahwa probabilitas node k menjadi l(0) adalah ŷ k (i)(l - ŷ k (i)) dan dengan<br />

mempertimbangkan node secara independen, kemudian<br />

dimana ketergantungan pada i telah tertekan untuk kenyamanan notasi. Kemudian mudah<br />

untuk memeriksa bahwa hasil J dari loglikelihood negatif pelatihan sepasang sampel. Jika<br />

y k (i) adalah probabilitas benar pada (0,1) kemudian mengurangkan nilai minimum dari J<br />

(4.30) menjadi<br />

Untuk nilai biner y k di atas masih berlaku jika kita menggunakan nilai batas 0 ln0 =0.<br />

Hal ini tidak sulit untuk menunjukkan(Masalah 4.5) bahwa fungsi biaya cross entropi<br />

tergantung pada kesalahan relatif dan bukan pada kesalahan mutlak, seperti pasangan<br />

kuadrat kecil, sehingga memberikan bobot yang sama untuk nilai kecil dan besar.<br />

Selanjutnya, telah menunjukkan bahwa itu memenuhi kondisi fungsi terbentuk baik [Adal<br />

97]. Akhirnya, dapat ditunjukkan bahwa mengadopsi fungsi biaya cross entropi dan nilai