KLASIFIKASI NON LINIER - Teknik Elektro UGM

KLASIFIKASI NON LINIER - Teknik Elektro UGM

KLASIFIKASI NON LINIER - Teknik Elektro UGM

Create successful ePaper yourself

Turn your PDF publications into a flip-book with our unique Google optimized e-Paper software.

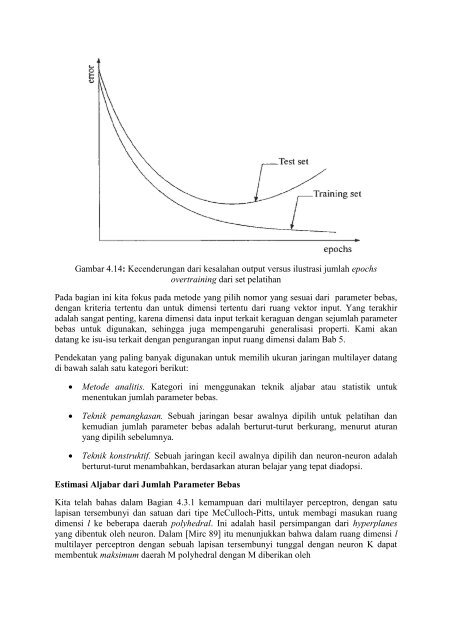

Gambar 4.14: Kecenderungan dari kesalahan output versus ilustrasi jumlah epochs<br />

overtraining dari set pelatihan<br />

Pada bagian ini kita fokus pada metode yang pilih nomor yang sesuai dari parameter bebas,<br />

dengan kriteria tertentu dan untuk dimensi tertentu dari ruang vektor input. Yang terakhir<br />

adalah sangat penting, karena dimensi data input terkait keraguan dengan sejumlah parameter<br />

bebas untuk digunakan, sehingga juga mempengaruhi generalisasi properti. Kami akan<br />

datang ke isu-isu terkait dengan pengurangan input ruang dimensi dalam Bab 5.<br />

Pendekatan yang paling banyak digunakan untuk memilih ukuran jaringan multilayer datang<br />

di bawah salah satu kategori berikut:<br />

<br />

<br />

<br />

Metode analitis. Kategori ini menggunakan teknik aljabar atau statistik untuk<br />

menentukan jumlah parameter bebas.<br />

<strong>Teknik</strong> pemangkasan. Sebuah jaringan besar awalnya dipilih untuk pelatihan dan<br />

kemudian jumlah parameter bebas adalah berturut-turut berkurang, menurut aturan<br />

yang dipilih sebelumnya.<br />

<strong>Teknik</strong> konstruktif. Sebuah jaringan kecil awalnya dipilih dan neuron-neuron adalah<br />

berturut-turut menambahkan, berdasarkan aturan belajar yang tepat diadopsi.<br />

Estimasi Aljabar dari Jumlah Parameter Bebas<br />

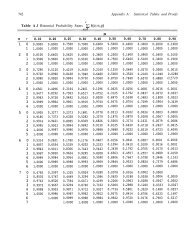

Kita telah bahas dalam Bagian 4.3.1 kemampuan dari multilayer perceptron, dengan satu<br />

lapisan tersembunyi dan satuan dari tipe McCulloch-Pitts, untuk membagi masukan ruang<br />

dimensi l ke beberapa daerah polyhedral. Ini adalah hasil persimpangan dari hyperplanes<br />

yang dibentuk oleh neuron. Dalam [Mirc 89] itu menunjukkan bahwa dalam ruang dimensi l<br />

multilayer perceptron dengan sebuah lapisan tersembunyi tunggal dengan neuron K dapat<br />

membentuk maksimum daerah M polyhedral dengan M diberikan oleh