Penggenerasian Ciri I : Transformasi Linier - Teknik Elektro UGM

Penggenerasian Ciri I : Transformasi Linier - Teknik Elektro UGM

Penggenerasian Ciri I : Transformasi Linier - Teknik Elektro UGM

Create successful ePaper yourself

Turn your PDF publications into a flip-book with our unique Google optimized e-Paper software.

<strong>Penggenerasian</strong> <strong>Ciri</strong> I : <strong>Transformasi</strong> <strong>Linier</strong><br />

Octa Heriana, 05906-TE<br />

Sumarna, 06248-TE<br />

Jurusan <strong>Teknik</strong> <strong>Elektro</strong> FT <strong>UGM</strong>,<br />

Yogyakarta<br />

6.1 PENDAHULUAN<br />

Tujuan dari bab ini adalah penggenerasian ciri-ciri melalui transformasi linier pada cuplikan-cuplikan<br />

masukan (pengukuran). Konsep dasarnya adalah mentransformasikan (mengalih-ragamkan) sekumpulan<br />

hasil pengkuran menjadi kumpulan ciri baru. Jika transformasi tersebut dipilih yang sesuai, maka ciri-ciri<br />

domain transformasi dapat menunjukkan sifat-sifat ‘kemasan informasi’ yang tinggi dibandingkn dengan<br />

cuplikan masukan aslinya. Ini berarti bahwa sebagian besar informasi kaitan klasifikasi terperas menjadi<br />

ciri-ciri dalamjumlah yang relative kecil, sehingga mengurangi dimensi ruang ciri yang diperlukan.<br />

Alasan yang mendasari ciri-ciri berbasis transformasi tersebut adalah bahwa kesesuaian transformasi<br />

yang dipilih dapat menggali dan menghilangkan kelebihan informasi yang biasanya ada dalam sejumlah<br />

cuplikan yang diperoleh dengan piranti pengukuran. Sebagai contoh suatu citra yang dihasilkan dari suatu<br />

piranti pengukuran, misalnya piranti sinar-X atau kamera. Piksel-piksel (cuplikan masukan) pada berbagai<br />

posisi di dalam citra mempunyai korelasi berderajad besar, terkait dengan konsistensi morpologik internal<br />

citra nyata yang membedakannya dari derau (noise). Kemudian jika digunakan piksel-piksel tersebut<br />

sebagai ciri-ciri, maka akan terdapat informasi berlebihan yang berderajad besar. Secara alternatif, misalnya<br />

jika diperoleh transformasi Fourier dari suatu citra nyata, maka hal tersebut menjelaskan bahwa sebagian<br />

besar energy yang terletak pada komponen frekuensi rendah berhubungan dengan adanya korelasi tinggi<br />

antar aras keabuan (gray level) piksel-piksel tersebut. Sehingga penggunaan koefisien Fourier sebagai ciri<br />

menunjukkan suatu pilhan yang rasional, sebab energy rendah memungkinkan kehilangan informasi kecil,<br />

koefisien-koefisien frekuensi tinggi dapat diabaikan.<br />

6.2 VEKTOR-VEKTOR BASIS DAN CITRA<br />

Misalkan x(0), x(1), x(2), …, x(N-1) merupakan sejumlah cuplikan masukan dan x adalah suatu vector<br />

Nx1 yang sesuai,<br />

x T = [x(0), x(1), x(2), …, x(N-1)].<br />

Diberikan suatu matrik unitary NxN yaitu A 1 , mendefinisikan suatu vector tertransformasi y dari x sebagai :<br />

y = A H x ≡<br />

H<br />

⎡ a ⎤<br />

0<br />

⎢ H ⎥<br />

⎢ a1<br />

⎥<br />

⎢ . ⎥ x (6.1)<br />

⎢ ⎥<br />

⎢ . ⎥<br />

⎢ H ⎥<br />

⎣a<br />

N −1<br />

⎦

di mana “H” menyatakan suatu opersi Hermitian, yaitu konjugasi komplek dan transposisi. Dari (6.1) dan<br />

definisi matrik unitary diperoleh :<br />

N<br />

x = Ay = ∑ −<br />

1<br />

i=<br />

0<br />

y(<br />

i)<br />

a i (6.2)<br />

Kolom-kolom pada A, a i , i = 0, 1, 2, …, (N-1), disebut vector-vektor basis dari suatu transformasi. Elemenelemen<br />

y(i) dari y bukan sesuatu tetapi yang penting adalah proyeksi-proyeksi x pada vector-vektor basis<br />

tersebut. Pengambilan inner-product dari x dengan a j diperoleh :<br />

〈 a j , x 〉 ≡ a H N<br />

j x = ∑ −<br />

1<br />

i=<br />

0<br />

N<br />

y ( i)<br />

〈 a j , a i 〉 = ∑ −<br />

1<br />

i=<br />

0<br />

y(<br />

i)<br />

δ<br />

ij<br />

= y(j) (6.3)<br />

Hal ini terkait dengan sifat unitary dari A, yaitu A H A = I atau 〈 a j , a i 〉 = a H i a j = δ<br />

ij<br />

.<br />

Dalam banyak persoalan, seperti pada analisis citra, sekumpulan cuplikan masukan merupakan runtun<br />

(sequence) dua dimensi X (i,j); i, j = 0, 1, 2, ..., (N-1), pendefinisian NxN matrik X alih-alih sebuah vektor.<br />

Pada kasus tersebut dapat ditentukan suatu ekivalensi N 2 vektor x, sebagai contoh dengan urutan baris<br />

matrik satu sesudah yang lain (urutan lexicographic)<br />

x T = [X(0,0), ..., X(0, N-1), ..., X(N-1, 0), ..., X(N-1, N-1)]<br />

dan kemudian mentransformasikan vektor ekivalen ini. Tetapi hal ini bukan cara kerja yang paling efisien.<br />

Jumlah operasi yang diperlukan untuk N 2 x N 2 kwadrat matrik (A) dengan N 2 x1 vector x adalah dalam orde<br />

O(N 4 ) yang menjadi penghalang pada banyak aplikasi. Kemungkinan alternatif adalah mentransformasikan<br />

matrik X melalui sekelompok matrik basis atau citra basis. Misalkan U dan V adalah matrik unitary NxN.<br />

Menentukan matrik tertransformasi Y dari X sebagai<br />

Y = U H X V (6.4)<br />

atau X = U Y V H (6.5)<br />

Jumlah operasinya sekarang berkurang menjadi O(N 3 ). Persamaan (6.5) secara alternatif dapat dituliskan<br />

sebagai :<br />

N<br />

X = ∑ −<br />

1<br />

i=<br />

0<br />

N<br />

∑ − 1<br />

j=<br />

0<br />

H<br />

Y(<br />

i,<br />

j)<br />

u i v j<br />

(6.6)<br />

di mana u i merupaka vector kolom dari U dan v j adalah vektor kolom dari V. Setiap outer product u i v j<br />

H<br />

merupakan sebuah matrik NxN

⎡ ui0v<br />

⎢<br />

u i v H j = ⎢ .<br />

⎢ .<br />

⎢<br />

⎢⎣<br />

u v<br />

*<br />

j0<br />

*<br />

iN −1<br />

j0<br />

.<br />

.<br />

.<br />

.<br />

.<br />

.<br />

.<br />

.<br />

u<br />

u<br />

i0<br />

v<br />

iN −1<br />

*<br />

jN −1<br />

.<br />

.<br />

v<br />

*<br />

jN −1<br />

⎤<br />

⎥<br />

⎥ ≡ А<br />

⎥ ij<br />

⎥<br />

⎥⎦<br />

dan (6.6) merupakan ekspansi dari matrik X dalam suku-suku N 2 citra basis (matrik basisi). Tanda *<br />

menyatakan konjugasi komplek. Jika Y menghasilkan diagonal, maka (6.6) menjadi :<br />

N<br />

X = ∑ − 1<br />

H<br />

Y ( i,<br />

i)<br />

u i v i<br />

i=<br />

0<br />

dan jumlah citra basis direduksi menjadi N. Interpretasi yang sama terhadap (6.3) juga mungkin. Terhadap<br />

yang terakhir tersebut, selanjutnya mendefinisikan inner product antara dua matrik sebagai :<br />

Dapat ditunjukkan bahwa<br />

N 1<br />

〈 A, B 〉 ≡ ∑ −<br />

m=<br />

0<br />

N<br />

∑ − 1<br />

n=<br />

0<br />

A * (m,n) B(m,n) . (6.7)<br />

Y(i,j) = 〈 А ij , X 〉. (6.8)<br />

Sebenarnya elemen (i,j) dari matrik tertransformasi dihasilkan dari perkalian setiap elemen X dengan<br />

konjugasi dari elemen A ij yang bersesuaian dan menjumlahkannya untuk semua produk.<br />

<strong>Transformasi</strong>-transformasi jenis (6.4) juga dikenal sebagai separable. Alasannya adalah bahwa itu dapat<br />

dicari dari mereka sebagai rangkaian transformasi satu dimensi, pertama dioperasikan pada vektor kolom<br />

dan kemudian pada vektor-vektor baris. Sebagai contoh hasil perantara pada (6.4), Z = U H X, adalah<br />

ekivalen dengan N transformasi yang dikenakan pada vektor-vektor kolom dari X, dan (U H X)V = (V H Z H ) H<br />

adalah ekivalen dengan urutan ke dua dari N transformasi yang bekerja pada baris-baris Z.<br />

Contoh 6.1.<br />

Diberikan citra X dan matrik tansformasi ortogonal U sebagai<br />

X =<br />

⎡1<br />

⎢<br />

⎣2<br />

2⎤<br />

3<br />

⎥ , U =<br />

⎦<br />

1<br />

2<br />

⎡1<br />

⎢<br />

⎣1<br />

1 ⎤<br />

−1<br />

⎥<br />

⎦<br />

citra tertransformasi Y = U T XU adalah<br />

Y = 2<br />

1<br />

⎡1<br />

⎢<br />

⎣1<br />

1 ⎤<br />

−1<br />

⎥<br />

⎦<br />

⎡1<br />

⎢<br />

⎣2<br />

2⎤<br />

⎡1<br />

3<br />

⎥ ⎢<br />

⎦ ⎣1<br />

1 ⎤<br />

−1<br />

⎥<br />

⎦<br />

⎡ 4 −1⎤<br />

= ⎢ ⎥ .<br />

⎣−1<br />

0 ⎦<br />

Citra basis yang bersesuaian adalah :<br />

A 00 =<br />

1<br />

2<br />

1 [ 1]<br />

⎡ ⎤ 1<br />

⎢ ⎥ 1 =<br />

⎣1⎦<br />

2<br />

⎡1<br />

⎢<br />

⎣1<br />

1⎤<br />

1<br />

⎥ .<br />

⎦

A 11 =<br />

1<br />

2<br />

⎡ 1 ⎤<br />

⎢ ⎥<br />

⎣−1⎦<br />

[ 1 − 1]<br />

=<br />

1<br />

2<br />

⎡ 1<br />

⎢<br />

⎣−1<br />

−1⎤<br />

1<br />

⎥ .<br />

⎦<br />

Dengan cara yang sama dapat diperoleh :<br />

A 01 =<br />

T 1<br />

A 10<br />

= 2<br />

⎡1<br />

⎢<br />

⎣1<br />

−1⎤<br />

−1<br />

⎥ .<br />

⎦<br />

6.3 TRANSFORMASI KARHUNEN-LOEVE<br />

Misalkan x adalah vektor dari cuplikan masukan. Pada kasus larik (array) citra, x dapat dibentuk dengan<br />

urutan lexicographic terhadap elemen-elemen larik. Sifat-sifat yang diinginkan dari ciri-ciri yang digenerasi<br />

adalah tak terkorelasi timbal-balik dengan maksud untuk menghindari berlebihnya informasi. Tujuan dari<br />

bagian ini adalah menggenerasi ciri-ciri yang secara optimal tak terkorelasi, yaitu E[y(i)y(j)] = 0, i ≠ j.<br />

Misalkan data nyata :<br />

y = A T x. (6.9)<br />

Dari definisi matrik korelasi diperoleh :<br />

R y ≡ E[yy T ] = E[A T xx T A] = A T R x A. (6.10)<br />

Tetapi R x adalah matrik simetris, dan karenanya vektor-vektor eigen yang saling ortogonal. Kemudian, jika<br />

matrik A dipilih sedemikian hingga kolom-kolomnya merupakan vektor eigen ortogonal a i , i = 0, 1, 2, ...,<br />

N-1, dari R x , maka R y adalah diagonal<br />

R y = A T R x A = Λ (6.11)<br />

di mana Λ adalah matrik diagonal dengan elemen-elemen pada diagonalnya masing-masing nilai eigen λ i ,<br />

dengan i = 0, 1, 2, ..., N-1, dari R x . Selanjutnya, pengambilan R x positif memastikan nilai eigen-nya positif.<br />

<strong>Transformasi</strong> yang dihasilkan tersebut dikenal sebagai transformasi Karhunen-Loeve (KL). <strong>Transformasi</strong> KL<br />

sangat fundamental di dalam pengenalan pola serta dalam aplikasi pemrosesan sinyal dan citra. Sifat-sifat<br />

pentingnya meliputi :<br />

Mean square error approximation. Dari persamaan (6.2) dan (6.3) diperoleh :<br />

N<br />

x = ∑ −<br />

1<br />

i=<br />

0<br />

T<br />

y(<br />

i)<br />

a i dan y(i) = a i x (6.12)<br />

Sekarang mendefinisikan vektor baru dalam subspace berdimensi m sebagai :<br />

m<br />

xˆ = ∑ − 1<br />

y(<br />

i)<br />

a i (6.13)<br />

i=<br />

0

di mana hanya m vektor-vektor basis yang dicakup. Dengan jelas, ini bukanlah sesuatu tetapi proyeksi x<br />

pada subspace dijangkau oleh m vector-vektor eigen (ortonormal) yang tercakup dalam somasi. Jika<br />

diusahakan untuk mendekati x dengan proyeksinya xˆ , hasil mean square error (MSE) diberikan oleh :<br />

2<br />

E [ ˆx ]<br />

x − = E<br />

⎡ N −<br />

⎢ ∑<br />

⎢ i=<br />

⎣<br />

1<br />

m<br />

2<br />

⎤<br />

y ( i)<br />

a i ⎥<br />

(6.14)<br />

⎥⎦<br />

Selanjutnya memilih vektor-vektor eigen yang menghasilkan MSE minimum. Dari (6.14) dan mengingat<br />

akan sifat ortonormalitas dari vektor-vektor eigen tersebut diperoleh :<br />

E<br />

⎡ N −<br />

⎢ ∑<br />

⎢ i=<br />

⎣<br />

1<br />

m<br />

2<br />

⎤ ⎡<br />

⎤<br />

T<br />

y ( i)<br />

a i ⎥ = E ⎢∑ ∑ ( y ( i)<br />

ai<br />

)( y(<br />

j)<br />

a<br />

j<br />

) ⎥<br />

⎥⎦<br />

⎣ i j<br />

⎦<br />

(6.15)<br />

N<br />

= ∑ − 1<br />

N<br />

2<br />

E [ y ( i)]<br />

= ∑ − 1<br />

T T<br />

a E[<br />

xx ] a<br />

(6.16)<br />

i=<br />

m<br />

i=<br />

m<br />

i<br />

i<br />

Kombinasi ini dengan persamaan (6.14) dan pendefinisian vektor eigen, akhirnya diperoleh :<br />

N<br />

x − = ∑ −<br />

N<br />

T<br />

a λ a = ∑ −<br />

λ (6.17)<br />

2<br />

E [ ˆx ]<br />

1<br />

i=<br />

m<br />

i<br />

i<br />

i<br />

1<br />

i=<br />

m<br />

Jika dipilih dalam (6.13) vektor-vektor eigen yang bersesuaian dengan nilai eigen m terbesar dari matrik<br />

korelasi, maka error pada (6.17) diminimisasi, merupakan jumlah dari N-m nilai-nilai eigen terkecil.<br />

Selanjutnya dapat ditunjukkan bahwa ini juga merupakan MSE minimum, dibandingkan dengan pendekatan<br />

lain untuk x oleh vektor berdimensi m. Hal ini menjadi alasan bahwa transformasi KL juga dikenal sebagai<br />

Analisis Komponen Utama (PCA : Principal Component Analysis).<br />

Bentuk lain dari transformasi KL diperoleh jika penghitungan A dalam suku-suku vektor-vektor eigen<br />

pada matrik kovarian. <strong>Transformasi</strong> ini mendiagonaisasi matrik kovarian Σ y ,<br />

i<br />

Σ y = A T Σ x A = Λ. (6.18)<br />

Pada umumnya keduanya berbeda dan serupa untuk vektor-vektor acak rerata nol. Dalam praktek ini<br />

biasanya kasus, sebab jika ia salah dapat mengganti setiap vektor dengan x – E[x]. Hal itu dapat<br />

ditunjukkan bahwa dalam kasus ini basis ortonormal yang dihasilkan (Σ x vektor-vektor eigen â<br />

i<br />

) menjamin<br />

bahwa MSE antara x dan pendekatannya diberikan oleh :<br />

1<br />

m<br />

xˆ = ∑ −<br />

i=<br />

0<br />

N<br />

y(<br />

i)<br />

â + ∑ −<br />

E [ y(<br />

i)]ˆ<br />

, y(i) ≡<br />

i<br />

1<br />

i=<br />

m<br />

a i<br />

T<br />

âi<br />

x adalah minimum. (6.19)<br />

Komponen terakhir N-m tidak acak tetapi dibekukan masing-masing nilai reratanya.<br />

Optimalitas transformasi KL, terhadap pendekatan MSE, membawa ke sifat-sifat utama dari kemasan<br />

informasi dan memberikan alat untuk memilih ciri-ciri dominan m keluar dari N cuplikan pengukuran.<br />

Tetapi meskipun ini mungkin merupakan kriteria yang baik, dalam banyak kasus ia tidak perlu dibawa ke

separabilitas kelas maksimum dalam subspace berdimensi lebih rendah. Hal ini beralasan karena reduksi<br />

dimensionalitas bukan dioptimisasi terhadap separabilitas kelas. Pada Gambar 6.1, vektor-vektor ciri pada<br />

kedua kelas mengikuti distribusi Gauss dengan matrik kovarian sama. Ellip-ellip tersebut menunjukkan<br />

kurva dengan nilai pdf konstan. Vektor eigen a 1 adalah yang bersesuaian dengan nilai eigen terbesar.<br />

Proyeksi pada a 1 membuat kedua kelas hampir serupa. Tetapi proyeksi pada a 2 menjadikan kedua kelas<br />

terpisah.<br />

x 2<br />

a 2<br />

a 1<br />

x 1<br />

Gambar 6.1. <strong>Transformasi</strong> KL tidak selalu terbaik untuk pengenalan pola.<br />

Dalam contoh ini, proyeksi pada vektor eigen dengan nilai eigen yang lebih<br />

besar membuat kedua kelas serupa. Dengan kata lain, proyeksi pada vektor<br />

eigen yang lain menjadikan kelas-kelas tersebut terpisah.<br />

Varian Total. Misalkan E[x] adalah nol. Jika ini bukan kasus, reratanya selalu dapat dikurangi. Misalkan y<br />

2<br />

adalah KL tertransformasi vektor x. Dari masing-masing definisi diperoleh bahwa σ<br />

y(i)<br />

≡ E[y 2 (i)] = λ i<br />

.<br />

Yaitu bahwa nilai-nilai eigen dari matrik korelasi masukan sama dengan variansi ciri-ciri tertransformasi.<br />

T<br />

Kemudian pemilihan ciri-ciri itu, y(i) ≡ a i x, bersesuaian dengan nilai-nilai eigen terbesar m yang membuat<br />

jumlah variansinya Σ i λ<br />

i<br />

maksimum. Dengan kata lain, ciri-ciri m yang terpilih menahan sebagian besar<br />

varian total yang terkait dengan variable acak aslinya x(i). Tentu saja, yang terakhir itu sama dengan trace<br />

dari R x , yang diketahui dari aljabar linier sama dengan jumlah dari nilai-nilai eigen, yakni :<br />

N<br />

∑ − 1<br />

i=<br />

0<br />

λ .<br />

i<br />

Dapat ditunjukkan bahwa hal tersebut merupakan sifat yang lebih umum, yaitu bahwa dari semua<br />

kemungkinan kumpulan ciri-ciri m, diperoleh melalui transformasi linier ortogonal pada x, salah satunya<br />

dihasilkan dari transformasi KL yang memiliki jumlah varian terbesar.

Entropy. Diketahui bahwa entropy suatu proses didefinisikan sebagai H y = -E[ln p y (y)] dan merupakan<br />

ukuran keacakan suatu proses. Untuk Gaussian dengan rerata nol dari proses berdimensi m multivariabel,<br />

entropy tersebut menjadi :<br />

H y =<br />

1 E[y<br />

T −1<br />

1<br />

Ry<br />

y] + ln R<br />

y +<br />

2<br />

2<br />

1 m ln (2π). (6.20)<br />

2<br />

Tetapi E[y T R −1<br />

y<br />

y] = E[trace {y T −1<br />

−1<br />

Ry<br />

y}] = E[trace { Ry<br />

y y T }] = trace (I) = m dengan menggunakan sifat<br />

yang telah diketahui dari aljabar linier, maka determinannya adalah<br />

ln<br />

R<br />

y = ln (λ 0 λ 1 λ 2 ... λ m-1 ).<br />

Pemilihan terhadap ciri-ciri m yang bersesuaian nilai eigen terbesar m akan memaksimumkan entropy<br />

proses. Hal ini diharapkan karena varian dan keacakan berhubungan langsung.<br />

Catatan. Konsep subspace vektor eigen utama juga diekspliotasi sebagai pengklasifikasi. Pertama, rerata<br />

cuplikan dari seluruh pelatihan dikurangkan dari vektor-vektor ciri. Untuk setiap kelas, ω i , matrik korelasi<br />

R i diestimasi dan menghitung vektor-vektor eigen utama m (bersesuaian dengan nilai-nilai eigen terbesar<br />

m). Suatu matrik A i dibentuk menggunakan masing-masing vektor eigen sebagai kolom. Vektor ciri x yang<br />

tidak diketahui kemudian diklasifikasi ke dalam kelas ω j dengan :<br />

A T j<br />

x > A T i<br />

x , ∀ i ≠ j<br />

(6.21)<br />

yaitu bahwa kelas tersebut sesuai dengan norm maksimum proyeksi subspace dari x. Dari teorema<br />

Pythagoras, ini ekivalen dengan pengklasifikasian sebuah vektor dalam subspace kelas terdekat. Decision<br />

surface-nya merupakan hyperplanes jika semua subspace memiliki dimensi yang sama atau surface kuadrik<br />

dalam kasus yang lebih umum. Pengklasifikasian subspace mengintegrasi tahapan-tahapan penggenerasian<br />

atau pemilihan ciri dan rancangan klasifikasi.<br />

Contoh 6.2. Matrik korelasi dari sebuah vektor x diberikan sebagai :<br />

R x =<br />

⎡0,3<br />

⎢<br />

⎢<br />

0,1<br />

⎢⎣<br />

0,1<br />

0,1<br />

0,3<br />

− 0,1<br />

0,1 ⎤<br />

− 0,1<br />

⎥<br />

⎥<br />

0,3 ⎥⎦<br />

Menghitung transformasi KL dari vektor masukan tersebut.<br />

Nilai-nilai eigen dari R x adalah λ 0 = 0,1; λ 1 = λ 2 = 0,4. Karena matrik R x simetrik, maka selalu dapat disusun<br />

vektor-vektor eigen ortonormal. Untuk kasus ini dapat diperoleh :<br />

a 0 =<br />

1<br />

3<br />

⎡ 1 ⎤<br />

⎢ ⎥<br />

⎢<br />

−1<br />

, a<br />

⎥ 1 =<br />

⎢⎣<br />

−1⎥⎦<br />

1<br />

6<br />

⎡2⎤<br />

⎢ ⎥<br />

⎢<br />

1 , a<br />

⎥ 2 =<br />

⎢⎣<br />

1⎥⎦<br />

1<br />

2<br />

⎡ 0 ⎤<br />

⎢ ⎥<br />

⎢<br />

1 .<br />

⎥<br />

⎢⎣<br />

−1⎥⎦

<strong>Transformasi</strong> KL kemudian ditentukan dengan :<br />

⎡ y(0)<br />

⎤<br />

⎢ ⎥<br />

⎢<br />

y(1)<br />

⎥<br />

⎢⎣<br />

y(2)<br />

⎥⎦<br />

=<br />

⎡2 / 6<br />

⎢<br />

⎢ 0<br />

⎢<br />

⎣<br />

1/ 3<br />

1/<br />

1/<br />

−1/<br />

6<br />

2<br />

3<br />

1/<br />

−1/<br />

−1/<br />

6 ⎤<br />

⎥<br />

2⎥<br />

3⎥<br />

⎦<br />

⎡x(0)<br />

⎤<br />

⎢ ⎥<br />

⎢<br />

x(1)<br />

⎥<br />

⎢⎣<br />

x(2)<br />

⎥⎦<br />

di mana y(0), y(1) besesuaian dengan dua nilai eigen terbesar.<br />

6.4 DEKOMPOSISI NILAI SINGULAR<br />

Diberikan sebuah matrik X dengan rank r, akan ditunjukkan bahwa ada NxN matrik-matrik unitary U<br />

dan V sedemikian hingga :<br />

X = U<br />

1/<br />

⎡Λ<br />

⎢<br />

⎣ O<br />

2<br />

O⎤<br />

⎥ V<br />

H<br />

0 ⎦<br />

atau Y ≡<br />

1/<br />

⎡Λ<br />

⎢<br />

⎣ O<br />

2<br />

O ⎤<br />

⎥ = U H XV (6.22)<br />

0 ⎦<br />

1/ 2<br />

di mana Λ matrik diagonal r x r dengan elemen-elemen λ<br />

i<br />

dan λ<br />

i<br />

adalah nilai-nilai eigen bukan nol r<br />

dari matrik X H X yang terkait. O menyatakan matrik elemen nol. Dengan kata lain, ada matrik unitary U dan<br />

V sedemikian hingga matrik tertransformasi Y adalah diagonal. Dari (6.22) dapat ditunjukkan bahwa :<br />

r 1<br />

X = ∑ −<br />

=<br />

i 0<br />

H<br />

λi<br />

u i v i<br />

(6.23)<br />

di mana u i , v i berturut-turut merupakan kolom pertama r dari U dan V. Lebih tepatnya, u i , v i berturutturut<br />

adalah vektor-vektor eigen dari XX H dan X H X. Nilai-nilai eigen λ<br />

i<br />

dikenal sebagai nilai-nilai singular<br />

dari X dan pengekspansian menurut (6.23) sebagai dekomposisi nilai singular (SVD : singular value<br />

decomposition) dari X atau representasi spektral dari X.<br />

Contoh 6.3. Diberikan suatu matrik X sebagai berikut. Tujuannya adalah menghitung dekomposisi nilai<br />

singularnya.<br />

X =<br />

⎡6<br />

⎢<br />

⎢<br />

0<br />

⎢4<br />

⎢<br />

⎣0<br />

Langkah 1 : Mencari nilai-nilai eigen dan vektor-vektor eigen dari X T ⎡52<br />

36⎤<br />

X = ⎢ ⎥<br />

⎣36<br />

73 ⎦<br />

Ini adalah λ 0 = 100, λ 1 = 25 dan vektor eigen yang bersesuaian adalah v 0 = [0,6 ; 0,8] T ; v 1 = [0,8 ; -0,6] T .<br />

6⎤<br />

1<br />

⎥<br />

⎥<br />

0⎥<br />

⎥<br />

6⎦

Langkah 2 : Menghitung vektor-vektor eigen dari XX T . Yakni matrik 4x4 dengan rank-2. Vektor-vektor<br />

eigen yang bersesuaian dengan nilai-nilai eigen bukan nol λ 0 , λ 1 dihitung melalui (6.26), yaitu u 0 = 0,1X v 0 ,<br />

u 1 = 0,2X v 1 atau masing-masing [0,84; 0,08; 0,24; 0,48] T dan [0,24; -0,12; 0,64; -0,72] T .<br />

Langkah 3 : Menghitung SVD dari X, yaitu :<br />

X = 10 [0,84; 0,08; 0,24; 0,48] T [0,6 ; 0,8] + 5 [0,24; -0,12; 0,64; -0,72] T [0,8 ; -0,6].<br />

Jika dipertahankan suku-suku ke dua yang pertama, maka hasil pendekatannya adalah yang terbaik, dalam<br />

rasa (sense) Frobenius, pendekatan rank-1 dari X.<br />

6.5 ANALISIS KOMPONEN INDEPENDEN<br />

Analisis komponen utama (PCA) dilakukan dengan transformasi KL yang menghasilkan ciri-ciri y(i), i<br />

= 0, 1, 2, ..., N-1, yang tak terkorelasi timbal-balik. Solusi yang diperoleh dengan transformasi KL akan<br />

optimal ketika pereduksian dimensionalitasnya menjadi tujuan dan menginginkan minimisasi pendekatan<br />

MSE. Tetapi untuk aplikasi khusus seperti ilustrasi pada Gambar 6.1 solusi yang diperoleh jauh dari yang<br />

diharapkan. Analisis komponen independen (ICA : Independent Component Analysis) berusaha untuk<br />

mencapai lebih banyak dari pada dekorelasi sederhana terhadap data.<br />

Diberikan sejumlah cuplikan masukan x, ditentukan matrik invertibel W berukuran NxN sedemikian<br />

masukan-masukan y(i), i = 0, 1, 2, ..., N-1, dari vektor yang tertransformasi :<br />

y = W x (6.34)<br />

adalah independen timbal-balik. Tujuan dari independensi secara statistik adalah kondisi yang lebih kuat<br />

dari pada ke-tidak korelasi-an yang diperlukan oleh PCA. Kedua keadaan hanya ekivalen untuk variabel<br />

acak Gaussian.<br />

Pencarian ciri-ciri independent dari pada tak terkorelasi memberikan arti penggalian informasi yang<br />

sedikit lebih, tersembunyi di dalam statistik orde tinggi pada data. Seperti contoh Gambar 6.1 menyarankan<br />

bahwa pemaksaan pencarian dengan menggali informasi dalam statistic orde ke dua hanya menghasilkan<br />

sedikit yang menarik, untuk persoalan tersebut, arah proyeksi seperti pada a 1 . Tetapi a 2 sudah pasti arah<br />

yang lebih menarik dari pandangan titik pemisahan kelas. Penggunaan ICA dapat membuka selubung dari<br />

statistik data orde tinggi suatu kelumit informasi yang menunjuk a 2 sebagai sesuatu yang paling menarik.<br />

Selanjutnya, pencarian ciri-ciri independent secara statistik yang sejalan dengan sifat pembangun peta<br />

kognitif dunia luar di dalam otak, dengan pemrosesan data masukan dari indera. Hipotesis Barlow<br />

mengatakan bahwa hasil pemrosesan awal yang terbentuk dari detector ciri-ciri visual dapat menghasilkan<br />

proses reduksi kelebihan. Dengan kata lain, keluaran syaraf dimungkinkan secara statistik independen<br />

timbal-balik, terkondisi, tentu saja pada penerimaan pesan sensor.<br />

Dipastikan dahulu bahwa persoalan yang demikian terdefinisi dengan baik, memiliki solusi, dan dalam<br />

kondisi apa. Diasumsikan bahwa vektor data acak masukan x adalah sungguh-sungguh tergenerasi oleh<br />

kombinasi linier komponen-komponen (sumber) yang secara statistik independen dan stasioner dalam rasa<br />

(sense) yang seksama, yaitu :<br />

x = A y (6.35)<br />

Tugas berikutnya adalah di bawah kondisi yang bagaimana matrik W dapat dihitung sehingga mencakup<br />

komponen-komponen y dari persamaan (6.34) dengan penggalian informasi yang tersembunyi di dalam x.<br />

Biasanya A diketahui sebagai matrik pencampur (mixing) dan W sebagai matrik pengurai (de-mixing).

ICA Berdasarkan Cumulant Orde-Empat dan -Dua.<br />

Pendekatan ini dalam menjalankan ICA merupakan generalisasi langsung dari teknik PCA. Tansformasi<br />

KL berfokus pada statistik orde dua dan bergantung pada korelasi silang E[y(i)y(j)] menjadi nol. Ketika pada<br />

ICA bergantung pada komponen y menjadi independen secara statistik, hal ini setara dengan<br />

kebergantungan semua cross-cumulant orde tinggi menjadi nol. Disarankan untuk membatasi hingga<br />

cumulant orde empat sudah cukup untuk banyak aplikasi. Tiga yang pertama dari cumulant adalah sama<br />

dengan tiga yang pertama dari moment, yaitu<br />

κ 1 (y(i)) = E[y(i)] = 0<br />

κ 2 (y(i)y(j)) = E[y(i)y(j)]<br />

κ 3 (y(i)y(j) y(k)) = E[y(i)y(j) y(k)]<br />

dan cumulant orde empat diberikan oleh :<br />

κ 4 (y(i)y(j) y(k) y(r)) = E[y(i)y(j) y(k) y(r)] - E[y(i)y(j)] E[y(k)y(r)]<br />

- E[y(i)y(k)] E[y(j)y(r)] - E[y(i)y(r)] E[y(j)y(k)]<br />

di mana telah diasumsikan pemrosesan rerata nol. Asumsi lain yang biasanya digunakan dalam praktek<br />

adalah terkait dengan kesimetrian pdf-pdf. Hal ini membuat semua cumulant orde ganjil nol. Persoalannya<br />

sekarang direduksi untuk mendapatkan matrik W sehingga orde dua korelasi silang dan orde empat cross<br />

cumulant dari variabel transformasi adalah nol. Hal ini dicapai dengan langkah-langkah berikut :<br />

Langkah 1. Mengenakan PCA pada data masukan, yakni :<br />

ŷ = A T x (6.36)<br />

A adalah matrik transformasi unitary pada transformasi KL. Komponen dari vektor acak tertransformasi ŷ<br />

adalah tak terkorelasi.<br />

Langkah 2. Menghitung matrik unitary lain  sehingga cross cumulant orde empat dari komponen vektor<br />

acak tertransformasi memenuhi<br />

y =<br />

T<br />

ŷ = 0. (6.37)<br />

Ini adalah sama dengan pencarian sebuah matrik  yang membuat jumlah kwadrat auto-cumulant orde<br />

empat maksimum, yaitu :<br />

max Ψ( Â ) ≡ ∑ −<br />

Aˆ<br />

A ˆT<br />

= I<br />

N 1<br />

i=<br />

0<br />

κ 4 (y(i)) 2 (6.38)

Jumlah kwadrat cumulant orde empat adalah invarian terhadap transformasi linier oleh matrik unitary.<br />

Sehingga jumlah kwadrat cumulant orde empat tersebut tetap untuk ŷ , pemaksimuman jumlah kwadrat<br />

auto-cumulant y akan memaksa cross-cumulant yang bersesuaian nol. Ruas kanan (6.38) merupakan fungsi<br />

dari (a) elemen-elemen matrik  yang tidak diketahui, (b) elemen-elemen matrik A yang diketahui, dan (c)<br />

cumulant komponen acak dari vektor data masukan x, yang mana diestimasi mendahului penerapan metode<br />

tersebut. Dalam praktek, peng-nol-an cross-cumulant adalah dicapai dengan pendekatan. Hal ini disebabkan<br />

(a) data masukan tidak patuh pada model linier (6.35), (b) data masukan dikorupsi oleh derau, yang tidak<br />

akan diingat, dan (c) cumulant masukan hanya diketahui dengan pendekatan, sehingga mereka diestimasi<br />

dengan sejumlah data masukan yang tersedia.<br />

Ketika kedua langkah tersebut lengkap, vektor ciri final merupakan komponen independen (secara<br />

pendekatan) yang diberikan dengan kombinasi transformasi :<br />

y = (A Â ) T x ≡ W x (6.39)<br />

Ketika  merupakan unitary ketakterkorelasian yang telah dicapai pada langkah pertama diwarisi oleh<br />

elemen-elemen y, yang sekarang memiliki cross-cumulant orde-empat dan –dua adalah nol.<br />

ICA Berdasarkan Informasi Timbal-Balik (Mutual).<br />

Pendekatan berdasarkan pada peng-nol-an cross-cumulant orde-empat dan –dua, walaupun sangat luas<br />

digunakan dalam praktek, bagaimanapun juga kekurangan dalam generalitas dan juga secara eksternal<br />

memaksakan struktur dalam matrik transformasi. Alternatifnya, pendekatan yang lebih nyaman secara teori<br />

adalah estimasi W dengan minimisasi informasi timbal-balik antar variabel-variabel acak yang<br />

ditransformasi. Informasi timbal-balik I(y) antar komponen y didefinisikan sebagai :<br />

N 1<br />

I(y) = -H(y) + ∑ −<br />

i=<br />

0<br />

H(y(i)) (6.40)<br />

di mana H(y(i)) merupakan entropy dari y(i) yang bersesuaian, didefinisikan sebagai :<br />

H(y(i)) == - ∫ p i(y(i)) ln p i (y(i)) dy(i) (6.41)<br />

di mana p i (y(i)) adalah pdf kecil dari y(i). Ternyata I(y) sama dengan jarak probabilitas Kullbach-Leibler<br />

N<br />

antar joint-pdf p(y) dan hasil kali dari masing-masing densitas probabilitas kecil ∏ − 1<br />

p ( y(<br />

i))<br />

.<br />

Jarak ini (informasi timbal-balik terkait I(y)) alah nol jika komponen-komponen y(i) secara statistik<br />

independen. Kombinasi (6.34), (6.40), (6.41) dan memperhatikan rumus hubungan kedua pdf yang terkait<br />

dengan x dan y (y fungsi dari x), maka :<br />

i=<br />

0<br />

i<br />

I(y) = -H(x) – ln )<br />

N −1<br />

det(W - ∑∫<br />

i=<br />

0<br />

p i (y(i)) ln p i (y(i)) dy(i) (6.42)<br />

di mana det(W) menyatakan determinan dari W. Elemen-elemen matrik tak diketahui W tersembunyi<br />

dalam pdf-pdf kecil dari variabel-variabel yang ditransformasi y(i). Tetapi tidak mudah untuk menyatakan<br />

dependensi ini secara eksplisit. Pendekatan yang dipakai adalah mengekspansi setiap probabilitas kecil di

sekitar pdf Gaussian g(y), mengikuti ekaspansi Edgeworth, dan memotong deret pada pendekatan yang<br />

masuk akal. Misalnya mengambil hingga suku ke dua yang pertama dari ekspansi Edgeworth, diperoleh :<br />

p(y) = g(y) (1 +<br />

1<br />

κ3 (y)H 3 (y) +<br />

3!<br />

1<br />

κ4 (y)H 4 (y) (6.43)<br />

4!<br />

di mana H k (y) adalah polynomial Hermit pada orde k. Untuk mendapatkan pernyataan pendekatan I(y)<br />

dalam suku-suku cumulant dari y(i) dan W, kita dapat (a) menyisipkan ke dalam (6.42) pendekatan pdf di<br />

dalam (6.43), (b) mengadopsi pendekatan ln(1+ y) ≈ y – y 2 , dan (c) menjalankan integrasi. Untuk kasus<br />

persamaan (6.43) dan batasan W harus unitary, maka :<br />

N 1<br />

I(y) ≈ C – ∑ −<br />

i=<br />

0<br />

1 2 1 2 7 4 1 2<br />

( κ<br />

3<br />

( y(<br />

i))<br />

+ κ<br />

4<br />

( y(<br />

i))<br />

+ κ<br />

4<br />

( y(<br />

i))<br />

- κ<br />

3<br />

( y(<br />

i))<br />

κ<br />

4<br />

( y(<br />

i))<br />

) (6.44)<br />

12 48 48 8<br />

di mana C dalam sesbuah independen variabel dari W. Di bawah asumsi bahwa pdf-pdf simetris (cumulant<br />

orde tiga nol) dapat ditunjukkan maka minimisasi pernyataan pendekatan informasi timbal-balik (6.44)<br />

adalah ekivalen dengan minimisasi jumlah kwadrat cumulant orde empat. Minimisasi I(y) pada (6.44)<br />

dapat ditempuh dengan teknik menurunkan gradien, di mana ekspektasi yang tercakup (terkait dengan<br />

cumulant) digantikan dengan masing-masing nilai sesaatnya.<br />

Kembali ke persamaan (6.42) sebelum menerapkan pendekatan. Karena H(x) tidak tergantung pada W,<br />

minimisasi I(y) adalah ekivalen dengan memaksimumkan :<br />

⎤<br />

J(W) = ln det(W ) + E ⎢<br />

⎡ N<br />

∑ − 1<br />

ln p<br />

i<br />

( y(<br />

i))<br />

⎥ (6.45)<br />

⎣ i=<br />

0 ⎦<br />

Pengambilan gradien fungsi cost terhadap W menghasilkan :<br />

di mana<br />

∂ J(<br />

W)<br />

∂W<br />

= W -T – E[φ(y) x T ] (6.46)<br />

dan<br />

⎡<br />

φ(y) ≡ ⎢−<br />

⎣<br />

'<br />

p i<br />

( y(<br />

i))<br />

≡<br />

T<br />

'<br />

"<br />

p y p<br />

N<br />

y N ⎤<br />

0<br />

( (0))<br />

−1<br />

( ( −1))<br />

,..., −<br />

⎥<br />

(6.47)<br />

p0<br />

( y(0))<br />

p<br />

N −1<br />

( y(<br />

N −1))<br />

⎦<br />

dp i<br />

( y(<br />

i))<br />

. (6.48)<br />

dy(<br />

i)<br />

Jelas bahwa turunan dari densitas probabilitas kecil tergantung pada jenis pendekatan yang diadopsi dalam<br />

setiap kasus. Skema kenaikan gradien umum pada langkah iterasi ke t dapat dituliskan :<br />

W(t) = W(t – 1) + μ(t) (W -T (t – 1) - E[φ(y) x T ])<br />

W(t) = W(t – 1) + μ(t) (I – E[φ(y) y T ] ) W -T (t – 1). (6.49)

Catatan<br />

Dari gradient pada (6.46) terlihat bahwa pada titik stasioner berlaku :<br />

∂ J(<br />

W)<br />

W T = E[I – φ(y) y T ] = 0. (6.50)<br />

∂W<br />

Dengan kata lain, apa yang telah dicapai dengan ICA merupakan generalisasi non linier dari PCA. Kondisi<br />

ke-tak terkorelasi-an dapat dituliskan :<br />

E[I - y y T ] = 0. (6.51)<br />

Pembaruan persamaan (6.49) yang mencakup inversi dari transpose estimasi W yang sedang berjalan. Di<br />

samping isu kerumitan komputasi, juga tidak ada jaminan invertibilitas proses adaptasi. Penggunaan<br />

gradient alami (natural) sebagai penggan gradient pada (6.46) dihasilkan :<br />

W(t) = W(t – 1) + μ(t) (I – E[φ(y) y T ] ) W T (t – 1). (6.52)<br />

yang tidak memuat inversi matrik dan pada saat yang sama meningkatkan konvergensi.<br />

6.6 TRANSFORMASI FOURIER DISKRET (DFT)<br />

Vektor basis / citra basis untuk ekspansi KL dan SVD adalah tidak tetap tetapi merupakan persoalan<br />

kebebasan dan merupakan hasil dari proses optimisasi. Hal ini menjadi alasan untuk optimalitasnya terhadap<br />

sifat-sifat dekorelasi dan kemasan informasi, tetapi dalam waktu yang bersamaan tercatat kelemahan<br />

utamanya memiliki kerumitan komputasional yang tinggi. Selanjutnya akan dibahas transformasi yang<br />

menggunakan vector/citra basis yang tetap. Suboptimalitasnya terhadap sifat dekorelasi dan kemasan<br />

informasi terkompensasi dengan tuntutan komputasionalnya yang rendah.<br />

DFT Satu-Dimensi<br />

Diberikan cuplikan masukan N yakni x(0), x(1), x(2), ..., x(N-1), maka DFT-nya didefinisikan sebagai :<br />

y(k) =<br />

1<br />

N<br />

N 1<br />

∑ −<br />

n=<br />

0<br />

2π<br />

x(<br />

n)exp(<br />

− j kn)<br />

, k = 0, 1, 2, …, N-1 (6.53)<br />

N<br />

dan DFT balik (inverse) sebagai :<br />

x(n) =<br />

1<br />

N<br />

N 1<br />

∑ −<br />

k = 0<br />

2π<br />

y(<br />

k)exp(<br />

j kn)<br />

, k = 0, 1, 2, …, N-1 (6.54)<br />

N<br />

di mana j ≡ − 1 . Pengumpulan semua x(n) dan y(k) bersama-sama ke dalam dua vektor Nx1 dan<br />

mendefinisikan :<br />

2 π<br />

W N = exp(-j ) (6.55)<br />

N<br />

maka (6.53), (6.54) dapat ditulisakan dalam bentuk matrik sebagai :

y = W H x, x = W y (6.56)<br />

di mana :<br />

W H =<br />

1<br />

N<br />

⎡1<br />

⎢<br />

⎢<br />

1<br />

⎢.<br />

⎢<br />

⎣1<br />

W<br />

1<br />

W<br />

.<br />

N<br />

N −1<br />

N<br />

W<br />

1<br />

W<br />

2<br />

N<br />

.<br />

2( N −1)<br />

N<br />

.<br />

.<br />

.<br />

.<br />

W<br />

W<br />

1<br />

N −1<br />

N<br />

.<br />

( N −1)(<br />

N −1)<br />

N<br />

⎤<br />

⎥<br />

⎥<br />

⎥<br />

⎥<br />

⎦<br />

(6.57)<br />

Hal itu tidak sulit untuk melihat bahwa W adalah matrik unitary dan simetrik W -1 = W H = W * .<br />

Vektor-vektor basis adalah kolom-kolom dari W. Sebagai contoh untuk N = 4<br />

W = 2<br />

1<br />

⎡1<br />

⎢<br />

⎢<br />

1<br />

⎢1<br />

⎢<br />

⎣1<br />

1<br />

j<br />

−1<br />

− j<br />

1<br />

−1<br />

1<br />

−1<br />

1 ⎤<br />

− j<br />

⎥<br />

⎥<br />

−1⎥<br />

⎥<br />

j ⎦<br />

dan vektor-vektor basis tersebut adalah<br />

1<br />

w 0 = [1, 1, 1, 1]<br />

T<br />

2<br />

1<br />

w 1 = [1, j, -1, -j]<br />

T<br />

2<br />

1<br />

w 2 = [1, -1, 1, -1]<br />

T<br />

2<br />

1<br />

w 3 = [1, -j, -1, j]<br />

T<br />

2<br />

dan<br />

3<br />

x = ∑ y(<br />

i)<br />

w i .<br />

i=<br />

0<br />

Komputasi langsung dari (6.56) memerlukan O(N 2 ) penghitungan. Tetapi dengan mengambil keuntungan<br />

dari struktur spesifik matrik W, penghematan mendasar dalam penghitungan dimungkinkan melalui<br />

algoritma FFT yang cerdas, di mana penghitungan setiap persamaan (6.56) dalam O(Nlog 2 N) operasi.<br />

DFT telah diperkenalkan sebagai jenis khusus dari transformasi unitary linier dari satu vektor ke yang lain.<br />

DFT sebagai alat ekspansi runtun x(n) ke dalam sejumlah N basis runtun h k (n) sebagi :<br />

di mana<br />

N 1<br />

x(n) = ∑ −<br />

=<br />

h k (n) =<br />

k<br />

0<br />

y ( k)<br />

h k (n)<br />

1<br />

N<br />

2π<br />

exp(j kn), untuk n = 0, 1, 2, ..., N-1<br />

N

h k (n) = 0, untuk yang lainnya,<br />

dan y(k) merupakan koefisien-koefisien ekspansi. Runtun basis DFT termasuk kelompok yang lebih umum<br />

dari runtun yang diketahui ortonormal, yaitu :<br />

〈h l (n), h k (n)〉 ≡ ∑<br />

n<br />

h ( n)<br />

h ( n)<br />

k<br />

*<br />

l<br />

= δ<br />

kl<br />

(6.58)<br />

di mana 〈., .〉 dikenal sebagai inner product dari runtun h k (n), h l (n). Untuk ekspansi DFT tersebut diperoleh<br />

〈h k (n), h l (n)〉 = N 1 ∑ −<br />

=<br />

N<br />

n<br />

N<br />

= N 1 ∑ −<br />

=<br />

n<br />

1<br />

0<br />

1<br />

0<br />

exp<br />

exp<br />

2π<br />

2π<br />

(j kn) exp(-j kn)<br />

N N<br />

Tetapi hal itu dapat ditunjukkan dengan mudah bahwa :<br />

2 π<br />

(j (k - l) n), k, l = 0, 1, 2, ..., N-1.<br />

N<br />

Sehingga :<br />

1 N<br />

∑ − 1<br />

2 π<br />

exp (j (k - l) n) = 1, untuk l = k + rN, r = 0, ±1, ±2, ...<br />

N n=<br />

0 N<br />

= 0, untuk yang lainnya. (6.59)<br />

〈h k (n), h l (n)〉 = δ<br />

kl<br />

.<br />

DFT Dua-Dimensi<br />

Diberikan suatu matrik/citra NxN, maka DFT dua-dimensinya didefinisikan sebagai :<br />

Y(k, l) =<br />

1 N<br />

∑ −<br />

N =<br />

1<br />

m 0<br />

N<br />

∑ − 1<br />

m=<br />

0<br />

X(m, n)<br />

km<br />

W N<br />

ln<br />

W<br />

N<br />

(6.60)<br />

dan DFT balik (inverse) adalah<br />

X(m,n) =<br />

1 N<br />

∑ −<br />

N =<br />

k<br />

1<br />

0<br />

N<br />

∑ − 1<br />

l=<br />

0<br />

Y(k, l)<br />

km<br />

W −<br />

N<br />

W −ln<br />

N<br />

. (6.61)<br />

Jelas terbaca bahwa hal itu dapat dituliskan dalam bentuk yang lebih kompak sebagai :<br />

Y = W H X W H , X = W Y W. (6.62)<br />

DFT 2-D merupakan transformasi yang dapat dipisahkan dengan citra basis w i w j T ; i, j = 0, 1, 2, ..., N-1.<br />

Jelas kelihatan dari (6.62) bahwa jumlah operasi yang diperlukan untuk masing-masing komputasi adalah<br />

O(N 2 log 2 N), yaitu banyaknya penjumlahan dan perkalian yang diperlukan untuk komputasi DFT satudimensi<br />

2N melalui algiritma FFT.

6.7 TRANSFORMASI KOSINUS DAN SINUS DISKRET<br />

Diberikan cuplikan masukan N yakni x(0), x(1), x(2), ..., x(N-1), maka transformasi kosinus diskret<br />

(DCT : Discrete cosine transform) di definisikan sebagai :<br />

N 1<br />

y(k) = α(k) ∑ −<br />

=<br />

n 0<br />

⎛ π (2n<br />

+ 1) k ⎞<br />

x(<br />

n)<br />

cos ⎜ ⎟ , k = 0, 1, 2, …, N-1 (6.63)<br />

⎝ 2N<br />

⎠<br />

dan invers dari DCT tersebut diberikan oleh :<br />

di mana :<br />

N<br />

x(n) = ∑ − 1<br />

⎛ π (2n<br />

+ 1) k ⎞<br />

α(<br />

k)<br />

y(<br />

k)<br />

cos ⎜ ⎟ , n = 0, 1, 2, …, N-1 (6.64)<br />

k=<br />

0<br />

⎝ 2N<br />

⎠<br />

α(k) =<br />

=<br />

1 , untuk k = 0, dan<br />

N<br />

2 , untuk k ≠ 0.<br />

N<br />

Dalam bentuk vector transformasi tersebut diberikan oleh<br />

di mana elemen-elemen matrik C diberikan oleh :<br />

y = C T x<br />

C(n,k) =<br />

=<br />

1 , k = 0, 0 ≤ n ≤ N-1<br />

N<br />

2 ⎛ π (2n<br />

+ 1) k ⎞<br />

cos ⎜ ⎟⎠ , 1 ≤ k ≤ N-1, 0 ≤ n ≤ N-1.<br />

N ⎝ 2N<br />

Matrik C memiliki elemen-elemen riil, dan mudah dilihat bahwa ia ortogonal, C -1 = C T .<br />

DCT 2-D merupakan transformasi yang dapat dipisah dan didefinisikan sebagai :<br />

Y = C T X C, X = C Y C T (6.65)<br />

<strong>Transformasi</strong> sinus diskret (DST : Discrete Sine Transform) didefinisikan melalui matrik transformasi<br />

S(k,n) =<br />

2 ⎛ π ( k + 1)( n + 1) ⎞<br />

sin ⎜<br />

⎟ ; k, n = 0, 1, 2, …, N-1<br />

N + 1 ⎝ N + 1 ⎠<br />

dan ia juga merupakan transformasi orthogonal.

6.8 TRANSFORMASI HADAMARD<br />

<strong>Transformasi</strong> Hadamard dan transformasi Haar memberikan keuntungan komputasi yang serius dari<br />

transformasi DFT, DCT, dan DST. Matrik unitary-nya terdiri dari ±1 dan transformasi tersebut dihitung<br />

melalui penjumlahan dan pengurangan saja, tanpa memuat perkalian. Sehingga diperoleh penghematan yang<br />

mendasar terhadap operasi yang menghabiskan waktu ketika prosesor melakukan perkalian.<br />

Matrik unitary Hadamard orde n adalah matrik NxN, N = 2 n , dihasilkan dari aturan iterasi berikut :<br />

di mana:<br />

H n = H 1 ⊗ H n-1 (6.66)<br />

1 ⎡1<br />

1 ⎤<br />

H 1 = ⎢ ⎥<br />

(6.67)<br />

2 ⎣1<br />

−1⎦<br />

dan ⊗ menyatakan hasil kali Kronecker dari dua matrik :<br />

A ⊗ B =<br />

⎡ A(1,1)<br />

B<br />

⎢<br />

⎢<br />

.<br />

⎢⎣<br />

A(<br />

N,1)<br />

B<br />

A(1,2)<br />

B<br />

.<br />

A(<br />

N,2)<br />

B<br />

.<br />

.<br />

.<br />

A(1,<br />

N ) B ⎤<br />

.<br />

⎥<br />

⎥<br />

A(<br />

N,<br />

N ) B⎥⎦<br />

di mana A(i,j) adalah elemen-elemen (i,j) dari A; i,j = 0, 1, 2, …, N. Kemudian sesuai dengan (6.66) dan<br />

(6.67) diperoleh :<br />

dan untuk n = 3<br />

H 2 = H 1 ⊗ H 1 =<br />

H 3 = H 1 ⊗ H 2 =<br />

1<br />

2<br />

⎡1<br />

⎢<br />

⎢<br />

1<br />

⎢1<br />

⎢<br />

⎣1<br />

1<br />

2<br />

1<br />

−1<br />

1<br />

−1<br />

⎡H<br />

⎢<br />

⎣H<br />

1<br />

1<br />

−1<br />

−1<br />

H<br />

2 2<br />

2<br />

− H 2<br />

1 ⎤<br />

−1<br />

⎥<br />

⎥<br />

−1⎥<br />

⎥<br />

1 ⎦<br />

⎤<br />

⎥ .<br />

⎦<br />

−1<br />

Tidak sulit untuk menunjukkan ortogonalitas dari H n , n = 1, 2, 3, ... yaitu bahwa H<br />

n<br />

=<br />

Untuk sebuah vektor x dari N cuplikan dan N = 2 n pasangan transformasinya adalah<br />

T<br />

H<br />

n<br />

= H n .<br />

y = H n x, x = H n y (6.68)<br />

<strong>Transformasi</strong> Hadamard 2-D ditentukan dengan :<br />

Y = H n X H n , X = H n Y H n . (6.69)<br />

<strong>Transformasi</strong> Hadamard memiliki keuntungan terhadap sifat pengemasan energinya sangat baik.

6.9 TRANSFORMASI HAAR<br />

Titik awal pendefinisian untuk transformasi Haar adalah h k (z), yang ditentukan dalam interval tertutup<br />

[0,1]. Orde k dari fungsi diuraikan secara unik ke dalam dua bilangan integer p, q<br />

di mana :<br />

k = 2 p + q – 1, k = 0, 1, 2, ..., L-1, dan L = 2 n .<br />

0 ≤ p ≤ n-1, 0 ≤ q ≤ 2 p untuk p ≠ 0 dan q = 0 atau 1 untuk p = 0.<br />

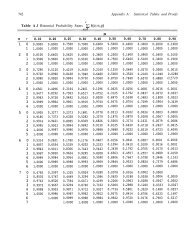

Tabel 6.1 merangkum masing-masing nilai pada L = 8. Fungsi Haar tersebut adalah<br />

h 0 (z) ≡ h 00 (z) =<br />

1 , z ∈ [0,1] (6.70)<br />

L<br />

1<br />

h k (z) ≡ h pq (z) = 2 p/2 −1<br />

−1/ 2<br />

q q<br />

, ≤ z <<br />

p<br />

p<br />

L 2 2<br />

1<br />

= -2 p/2 −1/ 2<br />

q q<br />

, ≤ z <<br />

p<br />

p<br />

L 2 2<br />

= 0 untuk yang lain di dalam [0,1].<br />

(6.71)<br />

Tabel 6.1. Parameter-parameter untuk Fungsi Haar<br />

k 0 1 2 3 4 5 6 7<br />

p 0 0 1 1 2 2 2 2<br />

q 0 1 1 2 1 2 3 4<br />

Matrik transformasi Haar orde L terdiri dari baris-baris yang dihasilkan fungsi sebelumnya yang terhitung<br />

pada titik-titik z = m/L, m = 0, 1, 2, ..., L-1. Sebagai contoh matrik transformasi 8 x 8 adalah<br />

H =<br />

⎡ 1<br />

⎢<br />

⎢<br />

1<br />

⎢ 2<br />

⎢<br />

1 ⎢ 0<br />

8 ⎢ 2<br />

⎢<br />

⎢ 0<br />

⎢ 0<br />

⎢<br />

⎢⎣<br />

0<br />

1<br />

1<br />

2<br />

0<br />

− 2<br />

0<br />

0<br />

0<br />

1<br />

1<br />

− 2<br />

0<br />

0<br />

2<br />

0<br />

0<br />

1<br />

1<br />

− 2<br />

0<br />

0<br />

− 2<br />

0<br />

0<br />

1<br />

−1<br />

0<br />

2<br />

0<br />

0<br />

2<br />

0<br />

1<br />

−1<br />

0<br />

2<br />

0<br />

0<br />

− 2<br />

0<br />

1<br />

−1<br />

0<br />

− 2<br />

0<br />

0<br />

0<br />

2<br />

1 ⎤<br />

−1<br />

⎥<br />

⎥<br />

0 ⎥<br />

⎥<br />

− 2⎥<br />

0 ⎥<br />

⎥<br />

0 ⎥<br />

0 ⎥<br />

⎥<br />

− 2 ⎥⎦<br />

(6.72)<br />

Tidak sulit untuk melihat bahwa H -1 = H T , yakni H adalah ortogonal. Sifat kemasan energi dari transformasi<br />

Haar tidak sangat baik. <strong>Transformasi</strong> Haar tersebut digunakan sebagai kendaraan untuk mendapatkan dari<br />

dunia transformasi unitary hingga analisis multi-resolusi.

6.10 REVISIT PENGEMBANGAN HAAR<br />

Split (bagi) set asal dari sampel-sampel input N (N genap) x(0), x(1),...,x(N-1) menjadi dua bagian<br />

suksesif yaitu, (x(2k), x(2k+1)), k= 0, 1,..., -1, dan gunakan transformasi Haar pada L=2. Pasangan sampelsampel<br />

yang ditransformasi adalah sebagai berikut.<br />

Yaitu,<br />

, k=0, 1,..., (6.73)<br />

(6.74)<br />

, k=0, 1,..., (6.75)<br />

Dapat diinterpretasikan dengan N sampel input pada dua filter nonkausal dengan respon impuls<br />

(h 1 (0)= ,h 1 (-1)= ) dan h 0 (0)= ,h 0 (-1)=- secara respektif. Fungsi transfernya adalah sebagai berikut.<br />

(6.76)<br />

(6.77)<br />

Dengan kata lain, pada L=2, transformasi Haar menghitung sampel-sampel output pada kedua filter<br />

ketika diumpankan dengan input sequence x(n), n=0,1,2,...,N-1.<br />

(a)<br />

(b)<br />

Gambar 6.4. (a) Operasi subsampling dan (b) Interpretasi pemfilteran transformasi Haar.

(6.78)<br />

Dengan operasi subsampling pada cabang yang lebih rendah setelah filter H 0 dan H 1 , identitas Nobel<br />

diarahkan menjadi:<br />

(6.79)<br />

Gambar 6.5. Pemfilteran dua tingkat yang diikuti dengan operasi subsampling<br />

(6.80)<br />

Dari fungsi transfer diatas dan mengambil operasi subsampling 4 (2x2), dua sampel pertama dari y 1 (k)<br />

diberikan dengan.<br />

(6.81)<br />

Kemudian di-split satu langkah berikutnya sebagai:

(a)<br />

(b)<br />

Gambar 6.6. (a) Identitas Nobel I dan (b) equivalent bank filter dari Gambar 6.5.<br />

Gambar 6.7. Bank filter tiga-struktur<br />

Berdasarkan Gambar 6.7, menunjukkan bahwa<br />

(6.82)<br />

Dan<br />

(6.83)<br />

Persamaan ini merupakan hasil pada baris kedua dan pertama dari transformasi Haar pada vektor input.<br />

Gambar 6.7 menunjukkan (tiga-tingkat) struktur pohon bank filter yang dibangkitkan dari H 0 (z) dan H 1 (z).<br />

Gambar 6.8 menunjukkan respon-respon frekuensi dari kedua filter tersebut.

Gambar 6.8. Magnitude dari respon frekuensi untuk dua filter Haar. H 1 adalah lowpass dan H 0 adalah<br />

highpass.<br />

6.11 DISKRETE TIME WAVELET TRANSFORM (DTWT)<br />

(a)<br />

(b)<br />

Gambar 6.9. Respon frekuensi ideal untuk (a) low-pass dan (b) high-pass filter.<br />

Kasus Dua Band<br />

Melihat dari kasus sederhana dua-band pada Gambar 6.4b, dimana sekarang dapat diasumsikan bahwa<br />

filter-filter bukan hanya Haar saja. Jika h 0 (k), h 1 (k) adalah respon impulse respektif, maka kemudian dapat<br />

ditulis:

Dimana y 1 (k) adalah output dari cabang yang lebih rendah pada Gambar 6.4b. Dengan mengumpulkan<br />

y 0 (k), y 1 (k), k=0, 1, 2,..., dalam bentuk vektor didapat:<br />

(a)<br />

Gambar 6.10. Tiga-struktur bank filter sintesis

Y=T i x (6.84)<br />

Dapat diasumsikan bahwa filter-filter itu dapat berupa nonkausal, dan merupakan juga Finite Impulse<br />

Response (FIR). T i pada dasarnya terdiri dari dua baris, satu dengan respon impuls dari H 0 dan yang lainnya<br />

dengan H 1 . Gambar 6.10b menunjukkan struktur kombinasi dari y0(k), y1(k), melalui filter G0, G1 untuk<br />

membentuk sequence . Simbol input dari filter-flter menunjukkan upsampling dengan M operasi, yang<br />

didefinisikan pada Gambar 6.10a. pada kasus ini M=2. Dengan kata lain ekuivalen dengan M-1 bernilai nol<br />

diantara dua sampel. Input sequence dari filter G0, G1 akan menjadi:<br />

Dan<br />

...0 y 0 (0) 0 y 0 (1) 0 y 0 (2) 0...<br />

...0 y 1 (0) 0 y 1 (1) 0 y 1 (2) 0...<br />

Filter Gi diketahui sebagai filter sintesis dan koresponding Hi, dari Gambar 6.4b, sebagai filter analisis.<br />

Dengan mengumpulkan (n) bersama-sama, dapat dilihat bahwa:<br />

Atau<br />

=T 0 y (6.85)<br />

Dengan =x dapat diberikan [Vett 92]<br />

T 0 T i = I = T i T 0 (6.86)<br />

Dengan mengalikan T i dengan kolom T 0 , persamaan ekuivalen dengan:<br />

, i,j = 0, 1 (6.87)

Atau berdasarkan pada definisi dari inner product dalam (6.58),<br />

(hi(2k-n),gj(n-2l))=δ kl δ ij<br />

Bisa dikatakan bahwa bank filter dua-band adalah rekunstruksi sempurna dan (n)=x(n), maka<br />

(6.88)<br />

Persamaan diatas dapat dilihat dari perspektif yang berbeda. Sebuah perluasan dari x(n) ke sekuen basis<br />

{g0(n-2k),g1(n-2k)}, k Є Z<br />

Dimana Z adalah himpunan dari bilangan bulat. Dari berbagai sudut pandang y 0 (k), y 1 (k) adalah masingmasing<br />

koefisien perluasan. Hal ini dikenal sebagai waktu diskrit transformasi wavelet (DTWT) dan<br />

koefisien y 0 (k), y 1 (k) sebagai waktu diskrit koefisien wavelet. Jadi, diberi rekonstruksi yang sempurna duaband<br />

Filter bank (sebagai contoh pada kondisi (6,87)) pasangan transformasi berikut didefinisikan<br />

(6.89)<br />

Keterangan<br />

Dua set fungsi dasar yang terlibat, yaitu<br />

h i (2k - n) ≡ Ø ik (n), g j (n – 2l) ≡ ψ jl (n) i, j = 0, 1 dan k, l Є Z<br />

Persamaan (6.87) adalah kondisi ortogonal antara Ø ik (n) dan ψ jl (n), yaitu,<br />

(Ø ik (n), ψ jl (n) = δ kl δ ij<br />

dan dikenal sebagai kondisi biorthogonality. Wavelet waktu diskrit mengubah pasangan pada (6.89) adalah<br />

ekspansi biorthogonal.<br />

Urutan dasar Ø ik (n) dan ψ jl (n) dari ekspansi tersebut adalah menyusun jumlah sampel genap<br />

sebanyak empat urutan dasar sekuen g 0 (n), g 1 (n), h 0 (-n), h l (- n), yang merupakan respon impuls sintesis<br />

dan filter analisis time-reversed. Untuk pemulihan x (n) dari koefisien wavelet waktu diskritnya, setiap<br />

koefisien y i (k) membobot dan menambahkan salinan sekuen g i (n) digeser oleh 2k.<br />

Ketika urutan Ø ik (n) = h i (2k - n) itu sendiri ortogonal, yaitu.

, i, j = 0, 1 dan k, l Є Z<br />

Kemudian<br />

g i (n) = h i (n)<br />

h l (0) 0.4829629 0.33267 0.2303778 0.1601024<br />

h l (1) 0.8365163 0.806891 0.7148466 0.6038293<br />

h l (2) 0.2241439 0.459877 0.6308808 0.7243085<br />

h l (3) -0.1294095 -0.135011 -0.0279838 0.1384281<br />

h l (4) -0.08544 -0.1870348 -0.2422949<br />

h l (5) 0.03522 0.0308414 -0.0322449<br />

h l (6) 0.0328830 0.0775715<br />

h l (7) -0.0105974 -0.006241 5<br />

h l (8) -0.0125807<br />

h l (9) 0.0033357<br />

Artinya, filter sintesis adalah membalikkan waktu dari filter analisis yang lainnya. Seperti halnya bank<br />

filter dikenal sebagai ortogonal atau paraunitary, dan memiliki set yang sama untuk sekuen (h i saja) yang<br />

terlibat dalam kedua persamaan transformasi wavelet waktu diskrit (6.89).<br />

Sejumlah orthogonal dan rekonstruksi yang sempurna biorthogonal pasang filter telah diusulkan dalam<br />

literatur, [Daub 90, Vett 95]. Tabel 6.2 memberikan koefisien untuk empat pertama filter Daubechies<br />

ortogonal maksimal datar. Versi low-pass h 1 (n) ditampilkan.<br />

Versi tinggi-pass diperoleh sebagai h 0 (n) = (-l) n h l (-n +2L - l), dimana L adalah panjang dari filter.<br />

Selain kasus urutan dasar wavelet dengan nilai-nilai yang telah ditetapkan, besar upaya penelitian telah<br />

dikhususkan untuk membangun urutan seperti yang dioptimalkan untuk masalah tertentu yang menarik. Ini<br />

juga telah digunakan dalam aplikasi pengenalan pola. Misalnya, dalam [Mall 97] diusulkan untuk<br />

merancang filter bank untuk mengoptimalkan kelas kriteria diskriminan. Pendekatan yang lain diikuti pada<br />

[Szu 92] mana kombinasi linear optimal basis standar dicari untuk klasifikasi sinyal suara.<br />

Ketika menerapkan filter bank dalam praktek, filter noncausal harus menunda tepat untuk membuatnya<br />

terealisasi (Lampiran D). Hal inimenjadikan penting diperlukan untuk melibatkan unsur-unsur penundaan<br />

tertentu pada titik-titik yang berbeda, dalam rangka menjaga properti rekonstruksi sempurna dari bank<br />

analisis-sintesis (Soal 6.19).<br />

Dalam prakteknya, jumlah sampel input x (n) terbatas, yaitu, n = 0, 1,. . . ,N - 1. Jadi, untuk perhitungan<br />

(6.89), beberapa kondisi awal adalah diperlukan. Zero, periodik, atau ekstensi simetris dari data yang<br />

populer alternatif. Seperti masalah pelaksanaan serta algoritma untuk efisiensi perhitungan koefisien DTWT<br />

yang dibahas dalam [Vett 95, Bab 6].

Gambar 6.11. Tiga-struktur bank filter sintesis<br />

Kasus Banyak Band<br />

Gambar 6.11 menunjukkan bagian sintesis sesuai dengan analisis bank pada Gambar 6.7, dan merupakan<br />

generalisasi dari konsep sintesis dua-band. Menggunakan identitas Noble yang ditunjukkan pada Gambar<br />

6.12 (Soal 6.17), akhirnya dengan struktur yang setara dengan bagian sintesis, ditunjukkan pada Gambar<br />

6.13. Biarkan f i (n) menjadi tanggapan impuls dari filter F i . Sangat mudah untuk melihat kontribusi masingmasing<br />

urutan y i (k) ke output (n) adalah<br />

i=0, 1,...,J-2<br />

Gambar 6.12. Bank filter sintesis struktur-pohon<br />

Gambar 6.11 menunjukkan sintesis sesuai analisis bank. Gambar 6,7, dan merupakan generalisasi dari<br />

konsep sintesis dua-band. Menggunakan Identitas Noble yang ditunjukkan pada Gambar 6.12 (Soal 6.17),<br />

Diakhiri dengan struktur ekuivalen dari bagian sintesis yang ditunjukkan pada Gambar 6.13. Biarkan f i (n)<br />

menjadi tanggapan impuls dari filter F i . Sangat Mudah untuk Melihat bahwa masing-masing kontribusi y i<br />

(k) ke output (n) adalah.<br />

Identitas Nobel II

Gambar 6.13. Ekuivalen dari tiga-struktur bank filter dari Gambar 6.11<br />

Rekonstruksi sempurna dari bank filter, yaitu,<br />

(6.90)<br />

Dimana<br />

(6.91)<br />

(6.92)<br />

Kemudian dari (6.90), (6.91), dan (6.92) kita mendapatkan Tabel 6.3.

Keterangan<br />

Karakteristik terkemuka DTWT adalah bahwa dasar urutan untuk masing-masingi tingkat adalah daya<br />

dari 2 shift sekuen yang sesuai urutan<br />

Dari transformasi wavelet kontinyu, semua analisa (sintesis) fungsi dasar yang dihasilkan dari analisis<br />

tunggal (sintesis) fungsi sekuen dengan dilasi (skala waktu) dan pergeseran [Meye 93, Daub 90, Vett 95].<br />

Jumlah ajaib 2, yang menentukan pergeseran kekuasaan di dasar urutan sekuen, hasil dari split berturut-turut<br />

oleh dua pada struktur pohon bank filter, yang telah didopsi untuk memperkenalkan DTWT tersebut. Bank<br />

filter tipe ini dikenal sebagai band oktaf-filter. Karakteristiknya adalah bahwa bandwidth dari masingmasing<br />

filter di bank adalah sama dalam skala logaritmik. Kadang-kadang mereka juga disebut konstan-Q<br />

bank filter untuk menekankan fakta bahwa rasio bandwidth filter dengan frekuensi masing-masing pusat<br />

konstan. Generalisasi dari DTWT dengan M integer yang lain di tempat 2 juga dapat didefinisikan dan<br />

digunakan [Stef 93].<br />

Contoh 6.4. <strong>Transformasi</strong> Haar-Epilog<br />

Kita telah melihat bahwa transformasi Haar setara dengan analisis struktur pohon filter bank. Mari kita<br />

melihat masalah sintesis. Untuk 8 x 8 Haar mentransformasi dan setelah reshuffle baris dari matriks yang<br />

sesuai Haar, didapatkan<br />

Atau

Y= x<br />

Dengan demikian transformasi Haar 8 x 8 memberikan empat koefisien pada resolusi terbaik tingkat 0,<br />

dua dan tingkat 1, dan satu untuk masing-masing resolusi tingkat 2 dan 3. Kemudian akan desain bank<br />

sintesis yang sesuai untuk mendapatkan x (n) dari koefisien ini. Respon impuls dari analisis filter Haar<br />

adalah<br />

Dapat dilihat bahwa<br />

Maka filter sintesis dapat didefinisikan sebagai<br />

Maka<br />

Dari ekuivalen struktur bank sintesis dari Gambar 6.13 didapat<br />

Dan respektif respon impuls adalah

Dengan argumen yang sama<br />

Didapat<br />

Atau<br />

6.12 INTERPRETASI MULTIRESOLUSI<br />

Tujuan dari bagian ini adalah untuk menyorot, tanpa menggunakan rincian matematika, aspek penting<br />

dari transformasi wavelet yang bertanggung jawab atas keberhasilannya sebagai alat dalam pengenalan pola<br />

serta berbagai aplikasi lain. Mari kita asumsikan untuk kesederhanaan bahwa dua filter di bank analisissintesis<br />

dari filter bank paraunitary yang ideal. Gambar 6.14 menunjukkan besarnya respon dari filter<br />

masing-masing dalam ekuivalen dari band oktaf filter bank struktur-pohon dari Gambar 6.13. Lebar respon<br />

frekuensi (bandwidth) yang dibelah dua untuk setiap tingkat pohon (Gambar 6.14d). Artinya, "detail"<br />

resolusi (high-pass) filter memiliki bandwidth yang lebar dan "kasar" resolusi (low-pass) filter adalah dari<br />

bandwidth sempit. Filter F 3 dan F 2 , dua resolusi kasar, dari bandwidth yang sama. Pengamatan ini adalah<br />

benar untuk setiap band oktaf bank filter sejumlah tingkat J. Artinya, lebar F i (z) adalah setengah dari lebar<br />

F i - 1 (z) dan lebar dari F J-2 dan F J - 1 adalah sama.

Gambar 6.14. Bandwidth filter dalam filter band oktaf<br />

<strong>Transformasi</strong> wavelet menyediakan sarana menganalisa sinyal input menjadi beberapa tingkat resolusi<br />

yang berbeda secara hirarkis. Ini juga dikenal sebagai analisis multiresolusi. Dengan demikian, komponen<br />

sinyal yang berbeda sesuai dengan kegiatan fisik dapat diwakili menjadi yang terbaik pada tingkat resolusi<br />

yang berbeda: kegiatan frekuensi tinggi pendek pada resolusi yang lebih baik dan panjang frekuensi rendah<br />

yang berada di tingkat resolusi tersebut.<br />

Pada bagian sintesis, sinyal dapat direkonstruksi dari komponen multiresolusinya. Lihat, sebagai contoh,<br />

Gambar 6.13. Urutan x (n) disintesis pertama oleh komponen kasar nya x 3 (n) dan kemudian frekuensi lebih<br />

tinggi (rinci) komponen ditambahkan, sehingga pendekatan yang berturut-turut lebih halus. Ketika<br />

komponen dari detail terbaik, x 0 (n), ditambahkan, sinyal asli diperoleh. Filosofi ini adalah inti dari sejumlah<br />

skema kompresi sinyal.<br />

Keterangan<br />

Analisis sinyal di sejumlah komponen melalui bank filter adalah tidak baru dan kembali ke pekerjaan Gabor<br />

di tahun 1940-an. Hal tersebut terkait langsung ke <strong>Transformasi</strong> Fourier waktu pendek didefinisikan sebagai<br />

[Gabo 46 Vett 95]<br />

(6.93)

dimana θ (n) adalah urutan jendela, yang pusatnya adalah berturut-turut pindah ke m poin yang berbeda.<br />

Jadi, setiap kali, bagian dari urutan x (n) sekitar m (tergantung lebar efektif jendela) dipilih dan<br />

ditransformasi Fourier. Hal ini dapat menunjukkan bahwa ini setara dengan menyaring sinyal x (n) dengan<br />

bank filter, masing-masing berpusat pada frekuensi yang berbeda tetapi semua dari mereka memiliki<br />

bandwidth yang sama (Soal 6.20). Ini adalah kelemahan, karena komponen sinyal frekuensi rendah dan<br />

tinggi adalah "tampak" melalui jendela dalam waktu yang sama. Apa yang sebenarnya dibutuhkan adalah<br />

jendela panjang untuk menganalisis perlahan waktu bervariasi komponen frekuensi rendah dan jendela<br />

sempit untuk mendeteksi frekuensi tinggi kegiatan waktu-pendek. Seperti kita lihat, dari sebuah band oktaf<br />

bank filter struktur-pohon, terkait dengan DTWT tersebut.<br />

Dapat dikatakan tentang transformasi wavelet dan analisis multiresolusi adalah hanya sekilas cerita dari<br />

keseluruhan, cerita yang benar-benar layak dilihat lebih lanjut, pada [Daub 90].<br />

6.13 PAKET-PAKET WAVELET<br />

DTWT ini telah diperkenalkan melalui band filter bank-oktaf, dan koefisien wavelet hasil pada output<br />

bank, ketika masukannya diumpankan dengan sinyal yang menarik. Band oktaf filter bank dibangun<br />

berturut-turut oleh dua pita frekuensi terendah dari bank struktur-pohon (Gambar 6.7). Namun, ada banyak<br />

kasus di mana sebagian besar kegiatan tersebut tidak ada di band frekuensi rendah tapi di bagian tengah<br />

frekuensi tinggi atau spektrum. Dalam kasus, mungkin berguna untuk dapat menempatkan frekuensi<br />

bandwidth yang lebih halus dalam band dimana kegiatan tersebut terjadi. Sebagaimana akan kita lihat nanti<br />

dalam bab ini, hal ini dapat meningkatkan kekuatan diskriminatif sistem dari sudut pandang klasifikasi.<br />

Gambar 6.15a menunjukkan contoh bank filter struktur-pohon dengan membelah frekuensi halus yang<br />

terjadi pada band frekuensi tengah. Gambar 6.15b menunjukkan bandwidth yang dihasilkan untuk masingmasing<br />

filter (ideal) di bank (f-axis) dan panjang jendela masing-masing tanggapan impuls dalam domain<br />

waktu (n-sumbu). Dengan kata lain, filter 2 dan 3 memiliki setengah bandwidth dan dua kali respon impuls<br />

4. Selain itu, mereka memiliki satu keempat bandwidth dan impuls respon empat kali lebih lama daripada 1.<br />

Sebagai perbandingan, Gambar 6.16 menunjukkan frekuensi-waktu resolusi plot untuk band-oktaf filter<br />

bank (a) dan untuk sebuah bank dengan bandwidth yang sama (b), terkait dengan DTWT dan transformasi<br />

Fourier waktu singkat, masing-masing. Setelah membebaskan diri dari band-oktafstruktur-pohon, bank filter<br />

dapat dibangun oleh berbagai strategi pertumbuhan pohon, dengan Gambar 6.15 yang hanya satu<br />

kemungkinan. Seperti halnya dengan filosofi-band oktaf, struktur-struktur pohon juga mengakibatkan satu<br />

set urutan dasar untuk perluasan sinyal diskrit [Coif 92] disebut paket wavelet.<br />

6.14 PANDANGAN GENERALISASI DUA-DIMENSI<br />

Semua konsep yang dibahas sejauh ini dapat dipindahkan ke dalam kasus dua dimensi. Bagaimana<br />

seseorang bisa mendefinisikan subsampling di sini Cara langsung adalah melalui filosofi "terpisah".<br />

Artinya, pertama-tama kita mengubah (filter) kolom di urutan dua dimensi dan kemudian dihasilkan baris.<br />

Ini mengarah pada subsampling yang ditunjukkan pada Gambar 6.17. Dengan kata lain, kita meninggalkan<br />

setiap baris yang lain dan setiap kolom lainnya (untuk subsampling oleh 2). Gambar 6.18 menunjukkan<br />

struktur Filter bank yang sesuai. Urutan gambar (m, n) muncul dalam filter kolom tahap 1 setelah kolom dan<br />

output masing-masing di subsampel oleh 2. gambar yang dihasilkan subsampel pada gilirannya disaring<br />

pada tahap dua, yang sebelumnya dimasukkan ke dalam filter baris demi baris.

Gambar 6.15. Struktur-pohon paket wavelet<br />

Dengan asumsi H0 menjadi filter high-pass dan H1 low-pass, empat frekuensi band yang dibentuk oleh<br />

prosedur sebelumnya diilustrasikan dalam Gambar 6.19a. Kawasan H1 H1 sesuai dengan kolom low-pass<br />

dan baris, H1 Ho untuk kolom low-pass dan baris high-pass, dan sebagainya. Gambar 6.19b menunjukkan<br />

hasil segmentasi dari domain frekuensi ketika daerah low-pass H1 H1 adalah berturut split dengan<br />

mengulangi prosedur.<br />

Gambar 6.16. Frekuensi versus resolusi waktu untuk (a) band-oktaf dan (b) bandwidth bank filter yang sama<br />

Gambar 6.17. Jarak subsampling 2 untuk gambar

Contoh 6.5. Gambar 6.20 menunjukkan gambar 64 x 64 dari segitiga. Tiga "baris" gambar adalah 32 x<br />

32 gambar yang dihasilkan ketika melewati gambar segitiga melalui struktur Gambar 6.18. Dalam<br />

penyaringan kolom tahap pertama garis vertikal berjalan melalui low-pass filter H 1 (tidak ada variasi di<br />

atasnya) dan garis horizontal dan diagonal melalui high-pass H 0 . Hal ini karena dalam penyaringan kolom<br />

ini muncul sebagai impuls di masing-masing kolom, sehingga kaya pada frekuensi tinggi. Dalam baris<br />

scanning tahap kedua garis horizontal yang akan melalui low-pass filter. penalaran serupa menjelaskan<br />

posisi berbagai bagian segitiga dalam band yang berbeda. Meskipun ini jelas merupakan contoh yang sangat<br />

sederhana, sangat instruktif. Ini menunjukkan bagaimana gambar asli dapat diperoleh dari komponen<br />

multiresolusi dan juga bagaimana karakteristik yang berbeda (arah dalam kasus ini) dari keseluruhan dapat<br />

diisolasi<br />

di<br />

band berbeda.<br />

Gambar 6.18. Elemen dasar untuk bank filter dua dimensi<br />

Gambar 6.19. (a) divisi domain frekuensi (b) hasil divisi suksesif low-pass

Gambar 6.20. Gambar segitiga dan versi yang terfilter<br />

6.15 APLIKASI<br />

Pengenalan Karakter tulisan tangan<br />

Gambar 6.21 menunjukkan karakter "3" serta kontur batasnya setelah penerapan algoritma kontur<br />

melacak [Pita 92], sekarang menjadi tugas salah satu bentuk pengalan. Seperti dijelaskan secara lebih rinci<br />

dalam Bab 7, batas dapat direpresentasikan sebagai kurva parametrik tertutup dalam bidang kompleks<br />

(6.94)<br />

dengan N adalah jumlah sampel (piksel) menelusuri kontur dan x (n), y (n) yang sesuai koordinat. Titik<br />

pertama (x (0), y (0)) dari urutan dianggap sebagai asal.<br />

Gambar 6.21. Koefisien wavelet untuk kurva batas karakter 3

Klasifikasi Tekstur<br />

Gambar 6.22. (a) contoh gambar tekstur (b) transformasi paket wavelet<br />

REFERENCES<br />

[Akan 93] Akansu A.N., Hadda R.A. Multiresolution Signal Decomposition, Academic Press, 1992.<br />

[Arbt 90] Arbter K., Snyder W. E., Burkhardt H., Hirzinger G “Application of affineinvariant Fourier<br />

descriptors to recognition of 3-D objects,” IEEE Transactions on Pattern Analysis and Machine<br />

Intelligence, Vol. 12(7), pp. 640-647, 1990.<br />

[Atti 92] Attick J.J. “Entropy minimization: A design principle for sensory perception,” International<br />

Journal of Neural Systems, Vol. 3, pp. 81-90, 1992.<br />

[Barl 89] Barlow H.B. “Unsupervised learning,” Neural Computation, Vol. 1, pp. 295-3 11, 1989.<br />

[Bell 00] Bell A.J. “Information theory, independent component analysis, and applications,” in<br />

Unsupervised Adaptive Filtering, Part I: Blind Source Separation (Haykin S., ed.), pp. 237-264, John<br />

Wiley & Sons, 2000.<br />

[Bovi 90] Bovic A.C., Clark M., Geisler W.S. “Multichannel texture analysis using localized spatial filters,”<br />

IEEE Transactions on Pattern Analysis and Machine Intelligence, Vol. 12fl), pp. 55-73, 1990.<br />

[Bovi 91] Bovic A.C. “Analysis of multichannel narrow-band filters for image texture segmentation,” IEEE<br />

Transactions on Signal Processing, Vol. 39(9), pp. 2025-2044, 199 I.<br />

[Brod 66] Brodatz P. Textures: A Photographic Album for Artists and Designers, Dover, New York, 1966.<br />

[Burt 83] Burt P.J., Adelson E.H. “The Laplacian pyramid as a compact image code,” IEEE Transactions on<br />

Communications, Vol. 31(4), pp. 532-540, 1983.<br />

[Camp 66] Campell E, Kulikowski J. “Orientation selectivity of the human visual system,” Journal of<br />

Physiology, Vol. 197, pp. 4 3 7 4 1 , 1966.<br />

[Camp 68] Campell E, Robson J. “Application of Fourier analysis to the visibility of gratings,” Journal of<br />

PhysiuZugy, Vol. 197, pp. 55 1-566, 1968.<br />

[Chan 93] Chang T., Kuo C.C.J. “Texture analysis and classification with tree structured wavelet<br />

transform,” IEEE Transactions on Image Processing, Vol. 2(4), pp. 429-442, 1993.<br />

[Chua 96] Chuang GC.H., Kuo C.C.J. “Wavelet descriptor of planar curves: Theory and applications,” IEEE<br />

Transactions on Image Processing, Vol. 5( l), pp. 56-71, 1996.<br />

[Coif 92] Coifman R.R., Meyer Y., Wickerhauser M.V. “Wavelet analysis and signal processing,” in<br />

Wavelets and Their Applications (Ruskai M.B. et al. eds.), pp. 153-178, Jones and Barlett, 1992.

[Como 94] Comon P. “Independent component analysis-A new concept’ Signal Processing, Vol. 36, pp.<br />

287-314, 1994.<br />

[Crim 82] Crimmins T.R. “A complete set of Fourier descriptors for two dimensional shapes,” IEEE<br />

Transactions on Systems, Man Cybernetics, Vol. 12(6), pp. 848-855, 1982.<br />

[Daub 90] Daubechies I. Ten Lectures on Wavelets, SIAM, Philadelphia, 1991.<br />

[Daug 85] Daugman J.G “Uncertainty relation for resolution in space, spatial frequency. and orientation<br />

optimized by two dimensional visual cortical filters,” Journal of Optical Society ofAmerica, Vol. 2, pp.<br />

1160-1.169, 1985.<br />

[Deco 95] Deco G, Obradovic D. “Linear redundancy reduction learning,” Neural Networks, Vol. 8(5), pp.<br />

751-755, 1995.<br />

[Diam 96] Didmantaras K.I.. Kung S.Y. Principal Componenr Neural Nefworks, John Wiley, 1996.<br />

[Doug 00] Douglas S.C., Amari S. “Natural gradient adaptation,” in Unsupervised Adaptive Filtering, Part<br />

I: Blind Source Separation (Haykin S. ed.), pp. 13-61, John Wiley & Sons, 2000.<br />

[Este 77] Esteban D., Galand C. “Application of quadrature mirror filters to split band voice coding<br />

schemes,” Proceedings of the IEEE Conference on Acoustics Speech and Signal Pmcesing, pp. 191-<br />

195, May 1977.<br />

[Fie194] Field D.J. “What is the goal of sensory coding’ Neural Computation, Vol. 6, pp. 559-601,1994.<br />

[Flan 72] Flanagan J.L. Speech Analysis, Synthesis and Perception, Springer Verlag, New York, 1972.<br />

[Gabo 46] Gabor D. “Theory of communications,” Journal of the Institute of Elec. Eng., Vol. 93, pp.<br />

429457,1946.<br />

[Geze 00] Gezerlis V., Theodoridis, S. “An optical music recognition system for the notation of Orthodox<br />

Hellenic Byzantine music,” Proceedings of the International Conference on Pattern Recognition<br />

(ICPR), Barcelona, 2000.<br />

[Geze 02] Gezerlis V., Theodoridis S. “Optical character recognition of the Orthodox Hellenic Byzantine<br />

music,” Pattern Recognition, Vol. 35(4), pp. 895-914,2002.<br />

[Hale 95] Haley G., Manjunath B.S. “Rotation-invariant texture classification using modified Gabor filters,”<br />

IEEE International Conference on Image Processing, pp. 262-265, 1995.<br />

[Hale 99] Haley G., Manjunath B.S. “Rotation-invariant texture classification using complete space<br />

frequency model,” IEEE Transactions on Imuge Prucessing, Vol. 8(2), pp. 255-269, 1999.<br />

[Hayk 99] Haykin S. Neural Networks-A Comprehensive Foundation, 2nd edition, Prentice Hall, 1999.<br />

[Hayk 00] Haykin S. (ed.) Unsupervised Adaptive Filtering, Part I: Blind Source Separtion, John Wiley &<br />

Sons, 2000.<br />

[Hube 85] Huber P.J. “Projection pursuit,” The Annals of Statistics, Vol. 13(2), pp. 435- 47S, 1985.<br />

[Hui 96] Hui Y., Kok C.W., Nguyen T.Q. “Theory and design of shift invariant filter banks,” Proceeding of<br />

IEEE TFTS’96, June 1996.<br />

[Hyva 01] Hyvarien A., Karhunen J., Oja E. Independent Component Analysis, Wiley Interscience, 2001.<br />

[Jain 89] Jain A.K. Fundamentals of Digital Image Processing, Prentice Hall, 1989.<br />

[Jain 91] Jain A.K., Farrokhnia E “Unsupervised texture segmentation using Gabor filters,” Pattern<br />

Recognition, Vol. 24(12), pp. 1167-1 186, 1991.<br />

[Jone 87] Jones M.C., Sibson R. “What is projection pursuit’ Journal of the Royal Statistical Society, Ser.<br />