Anwendungen im Tourismus

Anwendungen im Tourismus

Anwendungen im Tourismus

Sie wollen auch ein ePaper? Erhöhen Sie die Reichweite Ihrer Titel.

YUMPU macht aus Druck-PDFs automatisch weboptimierte ePaper, die Google liebt.

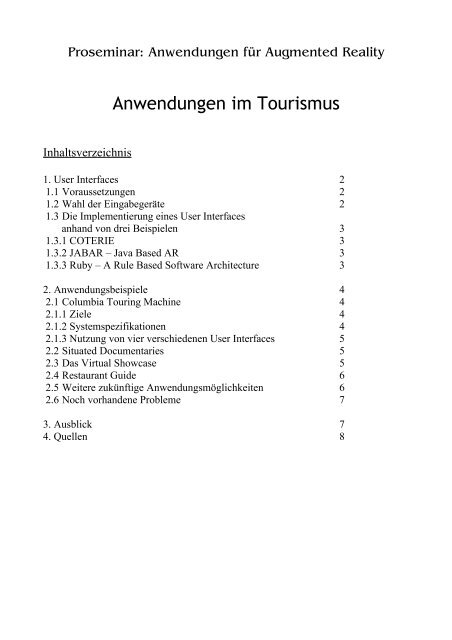

Proseminar: <strong>Anwendungen</strong> für Augmented Reality<br />

Inhaltsverzeichnis<br />

<strong>Anwendungen</strong> <strong>im</strong> <strong>Tourismus</strong><br />

1. User Interfaces 2<br />

1.1 Voraussetzungen 2<br />

1.2 Wahl der Eingabegeräte 2<br />

1.3 Die Implementierung eines User Interfaces<br />

anhand von drei Beispielen 3<br />

1.3.1 COTERIE 3<br />

1.3.2 JABAR – Java Based AR 3<br />

1.3.3 Ruby – A Rule Based Software Architecture 3<br />

2. Anwendungsbeispiele 4<br />

2.1 Columbia Touring Machine 4<br />

2.1.1 Ziele 4<br />

2.1.2 Systemspezifikationen 4<br />

2.1.3 Nutzung von vier verschiedenen User Interfaces 5<br />

2.2 Situated Documentaries 5<br />

2.3 Das Virtual Showcase 5<br />

2.4 Restaurant Guide 6<br />

2.5 Weitere zukünftige Anwendungsmöglichkeiten 6<br />

2.6 Noch vorhandene Probleme 7<br />

3. Ausblick 7<br />

4. Quellen 8

1. User Interfaces<br />

1.1 Voraussetzungen<br />

Die Grundvoraussetzungen für ein User Interface, dass sich mobil nutzen lässt, sind zuerst mal die<br />

relativ trivial erscheinende Unterstützung von World- und Screen-stabilized Grafiken, idealerweise<br />

sowohl in 2D, als auch in 3D, um eine Augmentierung überhaupt erst zu ermöglichen.<br />

Wünschenswert sind zusätzlich noch Mult<strong>im</strong>ediafähigkeiten, um auch Sound und Videos abspielen<br />

zu können. Ebenso banal wie selbstverständlich stellt sich auch die Unterstützung verschiedenster<br />

Ein- und Ausgabegeräte dar, die von einer UI unterstützt werden müssen. Ebenso sollte das System<br />

auf dem ganzen zugänglichen Gebiet, <strong>im</strong> Idealfall also weltweit, <strong>im</strong>mer verfügbar sein, sowie<br />

natürlich ortsabhängig anders reagieren. Das User Interace muss natürlich auch in der Lage sein mit<br />

dem riesigem Bewegunsspielraum, den ein Nutzer hat, zurechtzukommen. Wünschenswert wären<br />

natürlich auch Interaktionsmöglichkeiten, um überhaupt erst sinnvolle <strong>Anwendungen</strong> zu<br />

ermöglichen. Mit Blick auf eine zukünftige kommerzielle Nutzung wäre zudem eine intuitive<br />

Bedienbarkeit ein wichtiges Element, um Akzeptanz bei potentiellen Nutzern zu erzielen. Sobald<br />

sich Augmented Reality <strong>im</strong> Alltag durchsetzt, wäre auch eine Datenfilterung, ähnlich eines Spam-<br />

Blockers eines Mailprogramms oder eines Pop-Up-Blockers eines Browsers nötig, um einen Nutzer<br />

nicht durch eine überhöhte Anzahl an Augmentierungen zu verwirren. Da die äußeren Umstände<br />

eines Nutzers, also etwa Wetter oder Trackinggenauigkeit, nahezu unkontrollierbar sind muss die<br />

UI außerdem in der Lage sein, sich flexibel und kontextbezogen an alle möglichen Ereignisse<br />

anzupassen.<br />

1.2 Wahl der Eingabegeräte<br />

Es stellt sich nun also die Frage, welche Eingabegeräte für mobilen Einsatz am besten geeignet<br />

wären. Offensichtlich ist, dass eine Tastatur nicht in Frage kommt, da es den Mobilitätsansatz ad<br />

absurdum führt. Ebenso ist auch ein Datenhandschuh eher unpraktikabel, obwohl dieser sehr<br />

zuverlässige Daten liefert, da auch dieser die Bewegungsfreiheit in gewissen Maße einschränkt.<br />

Außerdem ist es sicherlich keinem Touristen zuzumuten, sich in seinem Urlaub mit etwas derart<br />

unkomfortablem und auch nicht sonderlich hübsch anzusehendem zu bewegen. In etwas<br />

handlichere Gefilde kommt man, falls man sich für die Benutzung einer (kabellosen) Maus oder<br />

eines Trackballs entscheidet. Diese sind zwar sicherlich kein Musterbeispiel für Komfort oder<br />

intuitive Bedienung, gehören allerdings <strong>im</strong> Augenblick zu den besten und auch am meisten<br />

eingesetzten Alternativen.<br />

Relativ gut funktioniert hingegen die Eingabe von Daten mittels eines Mikrofons, da die<br />

Spracherkennung in den letzten Jahren rasante Sprünge gemacht hat und sich wohl noch weiter<br />

entwickeln wird. Jedoch ist diese Eingabemöglichkeit leider nicht sonderlich universell, da durch<br />

Störgeräusche <strong>im</strong> Hintergrund die Spracherkennung deutlich erschwert, wenn nicht gar unmöglich<br />

gemacht wird, etwa falls sich der Nutzer innerhalb einer Menschenmenge befindet.<br />

Bereits erprobt ist auch die Möglichkeit der Dateneingabe über einen PDA oder eines Palmtops<br />

mittels eines Stiftes. Da diese Geräte sehr handlich sind und man sich durchaus die<br />

Implementierung in ein Mobiltelefon vorstellen kann, was für einen Großteil der Gesellschaft auch<br />

keine zusätzliche Hardware darstellen würde, ist diese Methode eine der besten Alternativen, zumal<br />

eine große Funktionalität dadurch gegeben ist, dass derartige Geräte auch als Ausgabegeräte<br />

verwendet werden können. Als unterstützendes “Eingabegerät” kann man sich auch noch die<br />

Eingabe über Pupillentracking vorstellen. Dadurch kann das System nachvollziehen, worauf der<br />

Benutzer sein Augenmerk legt. Fokussiert er nun ein Objekt über eine gewisse Zeitspanne hinweg,<br />

so wird dieses selektiert, weitere Interaktion ist allerdings nur schwerlich möglich.

1.3 Die Implemtierung eines User Interfaces anhand von drei Beispielen<br />

1.3.1 COTERIE<br />

COTERIE wurde 1996 von MacIntyre an der Columbia University entwickelt und stellte eine<br />

Weiterentwicklung von Modula-3 und Repo dar, welches unter Verwendung von Repo-3D (einer<br />

Version von Obliq-3D, welche um Funktionalitäten für Virtual und Augmented Reality erweitert<br />

wurde) Grundfunktionalitäten eines User Interfaces zur Verfügung stellte. So wurden Tracking und<br />

AR-<strong>Anwendungen</strong> unterstützt. Einzige erwähnenswerte Besonderheit war die Möglichkeit, Objekte<br />

als “Shared Objects” zu definieren. Unter Verwendung dieses Features konnte man ein Objekt auf<br />

mehreren gleichzeitig genutzten Interfaces auch synchron erscheinen lassen, anstelle jedes Interface<br />

einzeln zu ändern. Eine größere Anzahl an Problemen verhinderte jedoch den breiten Einsatz von<br />

COTERIE. Zum einen war Repo eine sehr spezielle, weitgehend unbekannte Sprache, bei<br />

Problemen konnte man also nicht auf kompetenten Support vertrauen, des weiteren wurde neuere<br />

AR-Ausrüstung nicht standardmäßig unterstützt. Eine Implementierung war zwar möglich, aber<br />

relativ umständlich. Auch konnte man eigentlich nur durch das Hintertürchen, dass Netscape von<br />

COTERIE unterstützt wurde, auf Mult<strong>im</strong>edia-Fähigkeiten zurückgreifen und dann über diesen Java-<br />

Applets oder Videos aufrufen. Außerdem war COTERIE in der Zahl der Nutzer, die sich<br />

gleichzeitig in der AR bewegen konnten sehr beschränkt, eine breitere und letzlich möglicherweise<br />

sogar kommerzielle Nutzung von COTERIE war also allein dadurch schon nahezu ausgeschlossen.<br />

COTERIE wurde unter anderem bei der Columbia Touring Machine benutzt.<br />

1.3.2 JABAR – Java Based AR<br />

JABAR wurde 1999 an der Columbia University von T. Höllerer entwickelt mit dem<br />

Hintergedanken, die Einschränkungen, die COTERIE hatte, möglichst aufzuheben. So war dank der<br />

Nutzung von Java nun ein plattformübergreifender Einsatz möglich (COTERIE war auf Windows<br />

beschränkt). Auch waren und sind für Java sehr viel mehr Programmbibliotheken zu finden als dies<br />

bei Repo der Fall ist. Zwar müssen auch in JABAR neue Geräte einzeln <strong>im</strong>plementiert werden,<br />

allerdings ist dies deutlich einfacher möglich als in COTERIE, ebenso brauchte man bei Problemen<br />

oder gewünschten Erweiterungen des Systems “nur” jemanden finden, der Ahnung von Java hat,<br />

was ein ganzes Stück einfacher sein sollte, als einen Repo-Experten aufzutreiben. Auch das<br />

Problem der sehr beschränkten Nutzerzahl von COTERIE wurde mit JABAR weitestgehend gelöst.<br />

Zusätzlich erhielt JABAR neben deutlich verbesserter Mult<strong>im</strong>edia-Fähigkeiten auch noch neue<br />

Funktionalitäten <strong>im</strong> Bereich der Objekt-Interaktion.<br />

1.3.3 Ruby – A Rule based Software Architecture<br />

Ruby wurde auf Basis von CGUI Lab AR (einem User Interface, das von Blaine Bell entwickelt<br />

wurde und das JABAR sehr ähnlich war) und von JESS (der Java Expert System Shell) von T.<br />

Höllerer an der Columbia University entwickelt. Ruby war darauf ausgelegt eine hohe Flexibilität<br />

hinsichtlich Informationsfilterung, Blickfeldmanagment und der Reaktion auf kontextbezogene<br />

Ereignisse zu bieten; so sollte das System beispielweise eingreifen können, wenn sich mehrere<br />

Labels überlappten, die Tracking-Qualität oder das Wetter sich änderte. Dies geschah mittels einer<br />

Bewertung durch die Regeln einer zentralen “Knowledge Base”, weswegen die Funktionalität des<br />

User Interfaces sich auch sehr einfach mittels Hinzufügen von weiteren Regeln erweitern lässt.<br />

Dadurch sollte ein User Interface entstehen, dass sich “angenehm” anfühlt und einen intuitiven<br />

Zugang zur Augmented Reality ermöglichen soll.<br />

Realisiert wurde dies durch die Beobachtung verschiedenster “Facts”, für den Benutzer unsichtbare<br />

Meta-Informationen. Dazu gehörten die aktuelle Position des Nutzers, Objekte, die sich momentan

innerhalb oder außerhalb des Sichtfelds des Nutzers befinden oder welche Ein- und Ausgabegeräte<br />

dieser augenblicklich benutzen kann. Insgesamt werden zwischen 1200 und 2500 derartiger Facts<br />

vom System verwaltet. Außerdem besitzen alle Objekte Attribute, etwa die Sichtbarkeit, die<br />

Transparenz, die Priorität oder die Tracking-Qualität, die nötig ist um dieses Objekt nicht bloß auf<br />

der Min<strong>im</strong>ap anzuzeigen. Zusätzlich werden Objekte, wie auch Ereignisse nochmals in<br />

Unterklassen aufgeteilt, auf die jeweils anders reagiert werden kann (bei Objekten etwa Knopf,<br />

Menüpunkt, Information oder Verbindung und bei Ereignissen etwa Kopfbewegung, Verdeckung<br />

eines Objekts oder Sichtkontakt zu einem Objekt). Die Knowledge Base verwaltet eine ganze Reihe<br />

von Regeln (2004 waren es 264), welche sich auf alle Facts, Objektattribute oder Ereignisse<br />

anwenden lassen und sogar während der Laufzeit des Systems geändert werden können. Verändert<br />

sich also lediglich ein einzelner “Fact”, so führt dies potenziell zu einer Änderung der gesamten<br />

Anzeige. Je nachdem wie komplex und objektreich die aktuelle Umgebung ist, wird das User<br />

Interface zwischen 15 und 60 mal pro Sekunde upgedatet. Um Lags zu verhindern, die durch das<br />

Laden von Mult<strong>im</strong>edia oder anderen Daten entstehen, teilt das System die Umgebung in gewisse<br />

“Szenen” ein, welche wiederum aus kleineren “Räumen” bestehen. Betritt ein Nutzer nun eine neue<br />

Szene, so werden präventiv möglicherweise später benötigte Daten heruntergeladen, um auf diese<br />

<strong>im</strong> Bedarfsfall ohne Verzögerung zuzugreifen zu können. Be<strong>im</strong> Betreten einer Szene werden<br />

zuerste solche Daten geladen, welche relativ wahrscheinlich innerhalb der nächsten Zeit benötigt<br />

werden, also zuerst die näherliegenden Räume.<br />

2. Anwendungsbeispiele<br />

2.1 Columbia Touring Machine<br />

2.1.1 Ziele<br />

Das Hauptziel der Columbia Touring Machine bestand daraus, ein auf Augmented Reality<br />

basierendes “Navigationssystem” zu erstellen, dass einen Nutzer über den Campus der Columbia<br />

University führen können sollte. Außerdem sollte jederzeit eine World-in-Miniature, eine durch den<br />

User frei bewegliche und drehbare Min<strong>im</strong>ap, einblendbar sein. Desweiteren wollte man die<br />

Möglichkeit haben, zu vielen Objekten zusätzliche Informationen oder Mult<strong>im</strong>ediadaten übers<br />

Internet aufrufen zu können. Auch sollte ein virtueller “Wiederaufbau” von nicht mehr existenten<br />

Gebäuden realisiert werden. Als Besonderheit sollte noch die Möglichkeit bestehen, dass der mobile<br />

Nutzer mit einem <strong>im</strong>mobilem Nutzer, einer Art Administrator kollaborativ zusammenarbeitet.<br />

2.1.2 Systemspezifikationen<br />

Zum ersten Testlauf bestand die Hardware des Systems aus einem Head-Mounted-Display mit einer<br />

Auflösung von 263x230 Pixeln, einem Mitsubishi AMiTY Handheld mit einer 75 Mhz DX4-CPU,<br />

auf dem Windows95 lief und der über ein Trackpad gesteuert werden konnte. Zusätzlich musste der<br />

Nutzer noch einen Laptop auf dem Rücken tragen. Dieser hatte eine 133 Mhz CPU eingebaut und<br />

war als Besonderheit mit einer 3D-Karte ausgestattet, um die für den Nutzer sichtbaren<br />

Augmentierungen ohne Umweg über eine Workstation direkt vor Ort erzeugen zu können. Das<br />

Tracking lief über einen InterSense IS6000 Mark II Hybrid Tracker mit Ultraschall und Inertial-<br />

Tracking ab. Zusätzlich war der Nutzer noch mit einem GPS-Tracker ausgestattet. Der Zugriff ins<br />

Internet wurde über das Universitäts-eigene WLan gewährleistet und erlaubte Geschwindigkeiten<br />

bis zu 2 MBit. Die meisten Geräte wurden jedoch <strong>im</strong> Laufe des Projektes gegen leistungsstärkere<br />

Versionen ausgetauscht.

2.1.3 Nutzung von vier verschiedenen User Interfaces<br />

Wie bereits angedeutet wurden bei der Columbia Touring Machine vier verschiedene UIs<br />

gleichzeitig eingesetzt. Zum einen war dies natürlich diejenige, welche der mobile Nutzer auf<br />

seinem HMD dargestellt bekam. Die Entwickler entschieden sich dafür, Labels, Fahnen und<br />

virtuelle Gebäude world-stabilized zu setzen, während sie Menüs, Richtungsweiser-Pfeile und die<br />

einblendbare World-in-Miniature screen-stabilized <strong>im</strong>plementiert hatten.<br />

Außerdem wurde auf dem Handheld eine Karte des Campus eingeblendet, auf welcher man<br />

erkennen konnte, wo man sich selbst befand und mit einem Stift ein Gebäude auswählen konnte.<br />

Dann wurde ein Pfeil auf dem Handheld eingeblendet, der einen dort hinleiten sollte. Hatte der<br />

Nutzer zusätzlich sein HMD auf, so wurde ihm auch dort ein Pfeil eingeblendet, der <strong>im</strong>mer in<br />

Richtung seines Zieles weisen sollte. Der Handheld war jedoch sowohl mit oder ohne Einsatz eines<br />

HMDs nutzbar.<br />

In eine ganz andere Richtung geht hingegen die Nutzung einer Indoor UI. Innerhalb des Campus<br />

befand sich ein relativ <strong>im</strong>mobiler Nutzer, vergleichbar mit einem Administrator, der auf einem<br />

Bildschirm eine Karte, ähnlich der des Handhelds hatte und damit den mobilen Nutzer überwachen<br />

konnte. Er hatte die Möglichkeit mit diesem zu kommunizieren (was auch in die andere Richtung<br />

möglich war) und er konnte ihm den Weg weisen, indem er durch Setzen von Fähnchen auf der<br />

Karte eine Route markierte, die dann auch gleichzeitig für den mobilen Nutzer sichtbar wurde. Auf<br />

diese Weise sollte die Möglichkeit bestehen, dass der Administrator dem mobilen Nutzer<br />

alternative, <strong>im</strong> Idealfall natürlich bessere Wege, zu best<strong>im</strong>mten Orten weist.<br />

Zu Demonstrationszwecken wurde ausserdem die Möglichkeit <strong>im</strong>plementiert, dass der<br />

Administrator nicht an einem Bildschirm sitzt, sondern über ein HMD eine 3D-Karte eingeblendet<br />

bekommt, auf der er dann die gleiche Funktionalität besitzt und weiterhin Fähnchen setzen kann<br />

zwecks Wegweisung. Besonders erwähnenswert ist die bereits angeschnittene Tatsache, dass die<br />

Änderung in einem User Interface, etwa das Setzen eines Fähnchens, oder das Auswählen eines<br />

Objektes über den Handheld dazu führt, dass diese Änderung für alle verfügbaren User Interfaces<br />

übernommen wird.<br />

2.2 Situated Documentaries<br />

Situated Documentaries sollte eine Erweiterung der Columbia Touring Machine sein. Basierend auf<br />

eben dieser wurde unter Verwendung von JABAR deren Funktionalität vergrößert; so war etwa<br />

deutlich bessere Interaktion mit dem Handheld möglich, ebenso wurden die Mult<strong>im</strong>edia-<br />

Fähigkeiten verbessert. Der Nutzer sollte die Gelegenheit haben, eine zusammenhängende<br />

Dokumentation zu erleben. Dies wollte man unter anderem durch Einführung kontextbasierender<br />

Ereignisse erreichen. Hatte ein Benutzer den ersten Mult<strong>im</strong>edia-Clip gesehen, so wurde der nächste<br />

Clip am dafür fortgesehenen Ort freigeschaltet und dem Nutzer mitgeteilt, wie dieser zu erreichen<br />

sei. Da ein dauerhafter Internet-Zugang über das Univeritäts-eigene WLan sichergestellt werden<br />

konnte, wurden Daten präventiv auf den Handheld übertragen, um bei Bedarf dadurch sofort zur<br />

Verfügung zu stehen. Erwähnenswert ist, dass zu diesem Projekt ein Editor erstellt wurde, der die<br />

Schaffung einer eigenen AR-Dokumentation ohne Programmier-Kenntnisse und in nur geringer<br />

Zeit erlaubt; ein notwendiger Schritt für eine kommerzielle Verwertung zukünftiger User Interfaces.<br />

2.3 Das Virtual Showcase<br />

Das Ziel des Virtual Showcase war es, antiken Ruinen wieder Leben einzuhauchen. Mittels<br />

Augmented Reality sollten fehlende Stücke einer Ruine ergänzt werden und möglicherweise sogar<br />

einstige Bewohner eben dieser sich dort bewegen und – eine ausgereifte KI vorausgesetzt – sich<br />

sogar zu einem Gespräch mit den Ruinenbesuchern hinreißen lassen. Anstatt die fehlenden Stücke

einer Ruine zu ergänzen, wäre es sogar denkbar eine komplette Ruine via AR an einen anderen<br />

Punkt zu transferieren. Denkbar wäre etwa ein ausgedientes Flugfeld (welches eine größere ebene<br />

Fläche bietet) in einen Ruinenpark mit wöchentlich wechselnder begehbarer Ruine zu verwandeln.<br />

So wäre auch die Begehung von Ruinen möglich, die aufgrund von Baufälligkeit für den<br />

Publikumsverkehr gesperrt sind. Eine derartige Funktionalität besitzt das Virtual Showcase jedoch<br />

noch bei weitem nicht. Der momentane Prototyp besteht aus einem einzigem durchsichtigem<br />

Bildschirm, der in der Gegend des Heidentors in Österreich aufgestellt wurde. Dieser ist mit<br />

mehreren Kameras verbunden, die die Anwesenheit eines Besuchers registrieren und dessen<br />

Blickrichtung tracken. Darauf basierend ist dann auf dem Bildschirm eine Augmentierung des<br />

dahinter liegenden Heidentors zu sehen. Außerdem tritt auf dem Bildschirm dann eine Person in<br />

Erscheinung, die anbietet, dem Besucher die Geschichte des Heidentors zu erklären. Die<br />

Kommunikation mit dieser Person läuft <strong>im</strong> Augenblick jedoch auch ausschließlich durch<br />

Auswählen eines Buttons, der auf dem Bildschirm eingeblendet wird, ab. Dieses System hat<br />

dadurch zwar den Vorteil, dass der Besucher keinerlei Hardware mit sich herumtragen muss, besitzt<br />

aber die gravierenden Nachteile, dass es zum einen nicht mobil ist, d.h. nicht die Betrachtung des<br />

Heidentors aus jedem erdenklichen Blickwinkel heraus gestattet, als auch natürlich nicht für<br />

mehrere Benutzer geeignet, da nur ein einziger Bildschr<strong>im</strong> zur Augmentierung zur Verfügung steht.<br />

Man kann sich jedoch durchaus eine Erweiterung des Systems vorstellen, die dann schon nahezu<br />

die gewünschte Funktionalität bieten würde.<br />

2.4 Der Restaurant Guide<br />

Dieses Projekt sollte einen mobilen Restaurant-Führer darstellen, der das Gebiet um die<br />

Morningside Heights in Manhatten abdeckt. Innerhalb eines Gebiets von 16 Blocks sind darin 40<br />

Lokale verzeichnet. Mittels eines World Models wurde das fragliche Gebiet nachgebildet, um die<br />

Möglichkeit zu haben, einzelne Objekte zu annotieren. Da allerdings in Manhattan kein<br />

flächendeckendes WLan-Netz zur Verfügung steht, wurden alle relevanten Daten in einer SQL-<br />

Datenbank auf dem Notebook des Nutzers gespeichert. Befand dieser sich nun <strong>im</strong> Gebiet eines<br />

Restaurants, dass in der Datenbank verzeichnet war, wurde dieses annotiert. Wählte der Nutzer die<br />

Annotation dann durch Eingabe mit einem Trackball aus, öffnete sich ein Pop-Up-Fenster. Dieses<br />

wurde, dank der Verwendung von Ruby, automatisch so positioniert, dass es nicht die Sicht auf das<br />

Restaurant oder andere relevante Objekte verdeckte und enthielt ein Bild des Inneren des Lokals,<br />

einen kurzen Beschreibungstext und mehrere Buttons, um die Homepage des Restaurants, dessen<br />

aktuelles Menu oder eine Seite mit Kommentaren verschiedener Nutzer des Systems zu dem Lokal<br />

angezeigt zu bekommen – sofern denn eine Internet-Verbindung bestand, was bei diesem Projekt<br />

nicht der Fall war. Zur Orientierungshilfe konnte der Nutzer sich eine World-in-Miniature<br />

einblenden lassen. Auch auf dieser waren alle Restaurants in der Datenbank eingezeichnet und auch<br />

direkt auswählbar.<br />

2.5 Weitere zukünftige Anwendungsmöglichkeiten<br />

Besonders die Idee des Restaurantführers scheint besonders dafür geeignet auf weitere Bereiche<br />

ausgedehnt zu werden. Man kann sich durchaus einen Museumsführer vorstellen, der einzelne<br />

Ausstellungsstücke annotiert und auf Wunsch weitere Informationen aus dem Internet oder<br />

Videoclips zur Geschichte des Objektes präsentiert. Denkbar wäre auch eine Stadtführung via<br />

Augmented Reality. Man könnte sich von dem System zu allen interessanten Sehenswürdigkeiten<br />

leiten lassen und bei Bedarf weitergehende Informationen dazu abrufen, ebenso wie dies bei einer<br />

echten Stadtführung wäre, jedoch kostengünstiger, weiterführender und individueller.<br />

Auch historische Präsentationen liessen sich damit glaubwürdiger (und kostengünstiger) inszenieren<br />

Beispielsweise werden in Amerika jedes Jahr wichtige Schlachten des Bürgerkrieges nachgespielt.

Dies geschähe etwa unter Einsatz von Augmented Reality deutlich glaubwürdiger und würde den<br />

Zuschauern auch ermöglichen vom Standpunkt des aussenstehenden Beobachters sogar in eine<br />

Perspektive direkt innerhalb des Schlachtfeldes zu wechseln. Eine weitere Anwendung, die sich<br />

nahezu sicher durchsetzen wird, sobald Augmented Reality zum Massenprodukt wird, gehört<br />

jedoch auch erwähnt. Mit Sicherheit werden wir uns in Zukunft nicht mehr bloß <strong>im</strong> Internet mit<br />

Werbung herumärgern müssen, sondern auch in der Augmented Reality als “erweitertem Internet”.<br />

Sicherlich ist aber noch eine ganze Reihe weiterer sinnvoller Anwendungsmöglichkeiten denkbar.<br />

2.6 Noch vorhandene Probleme<br />

Spekuliert man auf einen zukünftigen kommerziellen Erfolg von Augmented Reality, so ist zu<br />

beachten, dass der Nutzer vor allem Komfort erwartet. So ist etwa ein Datenhandschuh als<br />

Eingabegerät unzumutbar, da dieser die freie Nutzung der Hände einschränkt. Doch auch die<br />

letzlich verwendete Hardware muss möglichst geringe Größe aufweisen. Gleichzeitig soll sie aber<br />

eine hohe Leistung ermöglichen, ein hohes qualitatives Niveau erreichen und dennoch<br />

kostengünstig – und damit erschwinglich – sein. Auch soll die Batterie eine hohe Laufzeit bieten.<br />

Erschwerend kommt noch hinzu, dass sich diese Wünsche (zumindest teilweise) gegenseitig<br />

widersprechen.<br />

Doch es gibt auch noch eine ganze Reihe technischer Probleme, die bisher höchstens ansatzweise<br />

gelöst sind. Man sollte schließlich auch bedenken, dass die Outdoor Environment, <strong>im</strong> Gegensatz zur<br />

Laborumgebung, unberechenbar ist und einem System durch einen Wechsel der Lichtverhältnisse<br />

oder der Trackinggenauigkeit massive Schwierigkeiten bereitet werden könnten. Auch ist zu<br />

beachten, dass verschiedenste Ein- und Ausgabegeräte für die AR existieren und diese in nahezu<br />

unendlich vielen Kombinationsmöglichkeiten miteinander genutzt werden können; wobei jede<br />

einzelne natürlich auch sinnvoll unterstützt werden muss. Und letzlich bleibt, trotz der sehr guten<br />

Ansätze, die Ruby bietet, wohl dennoch noch einiges zu tun <strong>im</strong> Bereich der Datenfilterung. Auch ist<br />

für eine sinnvolle Nutzung der AR eine Verbindung zum Internet beinahe notwendig, allein schon<br />

um aktuelle Daten bereitstellen zu können. Dies dürfte sich nahezu ausschließlich über ein<br />

flächendeckendes WLan-Netzwerk errreichen lassen, momentan fällt die gebietsmäßige Abdeckung<br />

allerdings noch nicht mal in den Promille-Bereich. Als problematisch wird sich auch gestalten, dass<br />

die ganze Welt Teil des zugänglichen Environments ist. Deswegen ist es unmöglich eine<br />

Annotation von Objekten über World Models zu gewährleisten, da ein derartiges Modell deutlich zu<br />

komplex und zu großem Wandel unterworfen wäre. Auch hier muss wohl noch eine Alternative<br />

gefunden werden, um einen effektiven Einsatz zu ermöglichen.<br />

3. Ausblick<br />

Besonders mit Blick auf Abschnitt 2.6 erscheint es offensichtlich, dass ein flächendeckender<br />

Einsatz mobiler AR-Systeme noch nicht ansteht. Da allerdings ein großes Potential <strong>im</strong> Bereich der<br />

AR steckt und sich vermehrt auch Forscher und Firmen dafür begeistern lassen, kann man durchaus<br />

die Behauptung wagen, dass eine hohe Wahrscheinlichkeit besteht, dass Augmented Reality<br />

zukünftig ein genau so akzeptierter und selbstverständlicher Teil unserer Kultur darstellen wird, wie<br />

es heutzutage be<strong>im</strong> Internet der Fall ist. Mehr noch: dadurch, dass AR-Systeme pr<strong>im</strong>är das Internet<br />

als Datenquelle nutzen werden, wäre es nicht verwunderlich, wenn Augmented Reality dereinst<br />

seinem Namen entsprechend eine Erweiterung des Internets werden würde. Doch gerade aus der<br />

Sicht eines potentiellen Anbieters von AR-Diensten gibt es neben den in Abschnitt 2.6 genannten<br />

Problemen noch weitere, bei denen man sich um eine Lösung bemühen sollte. Momentan würden<br />

etwa noch rechtliche Unklarheiten den Einsatz erschweren. Wer wäre schuld, wenn ein Anwender<br />

einen Unfall verursacht, weil er durch Daten aus der AR abgelenkt wäre? Der Nutzer, weil er sich<br />

ablenken liess? Der Entwickler des User Interface, weil die Datenfilterung nicht wie gewünscht

funktioniert hat? Oder der Anbieter, da von ihm die Daten stammen, die den Nutzer letztendlich<br />

abgelenkt haben? Auch stellt sich das Problem wie man einen Unternehmer überhaupt dazu<br />

überreden kann, AR-Dienste anzubieten. Geld würde durch die Benutzung von AR wohl nicht in<br />

die Taschen des Unternehmers gespült, auch würden Einnahmequellen, etwa durch<br />

Fremdenführungen zusätzlich wegfallen. Im Laufe der Zeit würden derartige Dienste zwar wohl<br />

auch durch Privatpersonen angeboten, aber die Entwicklung und die Akzeptanz der Augmented<br />

Reality könnten durch Unternehmern, die demgegenüber skeptisch eingestellt sind, durchaus<br />

verzögert werden.<br />

4. Quellen<br />

1) A Survey of Augmented Reality - Azuma (1997) - www.cs.unc.edu/~azuma/ARpresence.pdf<br />

2) Location Aware Scheduling with Min<strong>im</strong>al Infrastructure - Heidemann & Shah (2000) -<br />

http://citeseer.ist.psu.edu/cache/papers/cs/15242/http:zSzzSzsys192.cs.washington.eduzSzRelatedz<br />

SzHeidemann00b.pdf/heidemann00locationaware.pdf<br />

3) Exploring MARS: Developing Indoor and Outdoor User Interfaces to a Mobile Augmented<br />

Reality System - T. Höllerer et al. (1999) -<br />

http://www1.cs.columbia.edu/graphics/publications/CandG99.pdf<br />

4) User Interfaces for Mobile Augmented Reality Systems - T. Höllerer (2004) -<br />

http://www.cs.ucsb.edu/~holl/pubs/hollerer-2004-diss.pdf<br />

5) A touring machine: Prototyping 3D mobile augmented reality systems for exploring the urban<br />

environment - Feiner et al. (1997) -<br />

http://www1.cs.columbia.edu/graphics/courses/mobwear/resources/feiner-iswc97.pdf<br />

6) Wearing it out: First steps towards Mobile Augmented Reality Systems - Feiner et al. (1999) -<br />

http://www.cc.gatech.edu/~blair/papers/ismr99.pdf<br />

7) Authoring 3D Hypermedia for Wearable Augmented and Virtual Reality - Güven & Feiner<br />

(2003) - http://www.cs.columbia.edu/graphics/people/sinem/papers/Authoring-<br />

ISWC2003/S.Guven-ISWC2003.pdf<br />

8) Wearable Computing and Contextual Awareness - Starner (1999) -<br />

http://hdl.handle.net/1721.1/9543<br />

9) Presenting Past and Present of an Archaeological Site in the Virtual Showcase - Ledermann &<br />

Schmalstieg (2003) - http://www.<strong>im</strong>s.tuwien.ac.at/media/documents/publications/vast2003draft.pdf<br />

10) Wearable Computing: A First Step Toward Personal Imaging - Mann (1997) -<br />

http://www.wearcam.org/ieeecomputer/r2025.htm<br />

11) http://www1.cs.columbia.edu/graphics/projects/mars/mars.html<br />

Stefan Knipl (knipl@in.tum.de), 2005