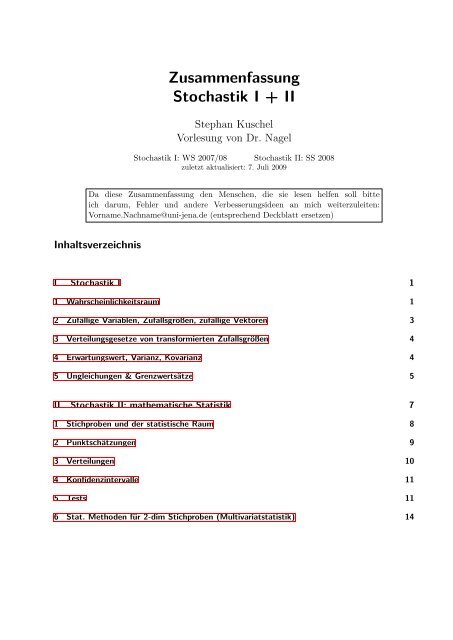

Zusammenfassung Stochastik I + II

Zusammenfassung Stochastik I + II

Zusammenfassung Stochastik I + II

Erfolgreiche ePaper selbst erstellen

Machen Sie aus Ihren PDF Publikationen ein blätterbares Flipbook mit unserer einzigartigen Google optimierten e-Paper Software.

<strong>Zusammenfassung</strong><br />

<strong>Stochastik</strong> I + <strong>II</strong><br />

Stephan Kuschel<br />

Vorlesung von Dr. Nagel<br />

<strong>Stochastik</strong> I: WS 2007/08 <strong>Stochastik</strong> <strong>II</strong>: SS 2008<br />

zuletzt aktualisiert: 7. Juli 2009<br />

Da diese <strong>Zusammenfassung</strong> den Menschen, die sie lesen helfen soll bitte<br />

ich darum, Fehler und andere Verbesserungsideen an mich weiterzuleiten:<br />

Vorname.Nachname@uni-jena.de (entsprechend Deckblatt ersetzen)<br />

Inhaltsverzeichnis<br />

I <strong>Stochastik</strong> I 1<br />

1 Wahrscheinlichkeitsraum 1<br />

2 Zufällige Variablen, Zufallsgrößen, zufällige Vektoren 3<br />

3 Verteilungsgesetze von transformierten Zufallsgrößen 4<br />

4 Erwartungswert, Varianz, Kovarianz 4<br />

5 Ungleichungen & Grenzwertsätze 5<br />

<strong>II</strong> <strong>Stochastik</strong> <strong>II</strong>: mathematische Statistik 7<br />

1 Stichproben und der statistische Raum 8<br />

2 Punktschätzungen 9<br />

3 Verteilungen 10<br />

4 Konfidenzintervalle 11<br />

5 Tests 11<br />

6 Stat. Methoden für 2-dim Stichproben (Multivariatstatistik) 14

<strong>Stochastik</strong> I Wahrscheinlichkeitsraum 1<br />

Teil I<br />

<strong>Stochastik</strong> I<br />

Inhaltsverzeichnis<br />

1 Wahrscheinlichkeitsraum 1<br />

1.1 Wahrscheinlichkeitsraum . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 1<br />

1.2 Beschreibungsmöglichkeiten für Wahrscheinlichkeitsmaße . . . . . . . . . . . . . . . 2<br />

1.3 Spezielle Wahrscheinlichkeitsräume . . . . . . . . . . . . . . . . . . . . . . . . . . . 2<br />

1.4 Bedingte Wahrscheinlichkeiten . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 2<br />

1.5 stochastische Unabhängigkeit . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 2<br />

2 Zufällige Variablen, Zufallsgrößen, zufällige Vektoren 3<br />

2.1 Zufällige Variablen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 3<br />

2.2 Zufallsgrößen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 3<br />

2.3 Unabhängigkeit von Zufallsgrößen . . . . . . . . . . . . . . . . . . . . . . . . . . . 3<br />

2.3.1 diskrete Zufallsgrößen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 3<br />

2.3.2 stetige Zufallsgrößen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 3<br />

3 Verteilungsgesetze von transformierten Zufallsgrößen 4<br />

3.1 Transformationen von 1dim. Zufallsgrößen . . . . . . . . . . . . . . . . . . . . . . . 4<br />

3.2 Summe zweier Zufallsgrößen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 4<br />

3.3 Produkt & Quotient zweier Zufallsgrößen . . . . . . . . . . . . . . . . . . . . . . . 4<br />

3.4 Injektive diffbare Transformationen von zufälligen Vektoren . . . . . . . . . . . . . 4<br />

4 Erwartungswert, Varianz, Kovarianz 4<br />

4.1 Erwartungswert . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 4<br />

4.2 Varianz . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 5<br />

4.3 Kovarianz . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 5<br />

4.4 Die Kovarianzmatrix . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 5<br />

5 Ungleichungen & Grenzwertsätze 5<br />

5.1 Markov-Ungleichung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 5<br />

5.2 Tschebyscheff Ungleichung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 5<br />

5.3 Gesetz der großen Zahlen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 5<br />

5.4 Der zentrale Grenzwertsatz . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 6<br />

1 Wahrscheinlichkeitsraum<br />

1.1 Wahrscheinlichkeitsraum<br />

Wahrscheinlichkeitsraum [Ω, A, P ], Ereignis A ∈ A, dann gilt:<br />

• Ω ∈ A<br />

• A ∈ A ⇒ A ∁ ∈ A ∀A ⊆ Ω<br />

• ∀Ai ∈ A ⇒ � ∞ i=1 Ai ∈ A<br />

Axiomensystem von Kolmogorov: P : A → [0, 1]<br />

A ⊆ p(Ω) ist σ-Algebra.

<strong>Stochastik</strong> I Wahrscheinlichkeitsraum 2<br />

• P (Ω) = 1<br />

•<br />

Folgerungen:<br />

Ai ∩ Aj �<br />

= ∅<br />

∞�<br />

�<br />

∞�<br />

P<br />

= P (Ai)<br />

i=1<br />

Ai<br />

i=1<br />

• P (∅) = 0 P (Ω) = 1<br />

• P (A ∁ ) = 1 − P (A)<br />

• P (A ∪ B) = P (A) + P (B) − P (A ∩ B)<br />

• A ⊆ B ⇒ P (A) ≤ P (B)<br />

⇒ P (B \ A) = P (B) − P (A)<br />

• A1 ⊆ A2 ⊆ ... ⇒ P ( �<br />

i Ai) = limi→∞ P (Ai)<br />

• A1 ⊇ A2 ⊇ ... ⇒ P ( �<br />

i Ai) = limi→∞ P (Ai)<br />

(σ-Additivität von P )<br />

1.2 Beschreibungsmöglichkeiten für Wahrscheinlichkeitsmaße<br />

1.3 Spezielle Wahrscheinlichkeitsräume<br />

siehe Verteilungen<br />

1.4 Bedingte Wahrscheinlichkeiten<br />

P (A|B) =<br />

P (A) = �<br />

P ({ω})<br />

P (A ∩ B)<br />

P (B)<br />

ω∈A<br />

• A1, A2 disjunkt ⇔ P (A1 ∪ A2|B) = P (A1|B) + P (A2|B)<br />

• P (A ∩ B) = P (A|B) · P (B)<br />

= P (B|A) · P (A)<br />

• Entnahme ohne Zurücklegen:<br />

1.5 stochastische Unabhängigkeit<br />

⇒ P (B|A) = P (A|B) ·<br />

P (B)<br />

P (A)<br />

P (A1 ∩ ... ∩ An) = P (A1) · P (A2|A1) · P (A3|A2 ∩ A1) · ...<br />

A, B stochastisch unabhängig ⇔ P (A ∩ B) = P (A) · P (B)<br />

Ai stochastisch vollständig unabhängig ⇔ P ( �<br />

i Ai) = �<br />

i P (Ai)<br />

• paarweise stochastische Unabhängigkeit ist etwas anderes!<br />

• (A, B) unabhängig ⇒ (A, B ∁ ), (A ∁ , B), (A ∁ , B ∁ ) unabhängig

<strong>Stochastik</strong> I Zufällige Variablen, Zufallsgrößen, zufällige Vektoren 3<br />

2 Zufällige Variablen, Zufallsgrößen, zufällige Vektoren<br />

2.1 Zufällige Variablen<br />

g : Ω → Ω ′<br />

g −1 : p(Ω ′ ) → p(Ω)<br />

g −1 (A ′ ) : {ω ∈ Ω : g(ω) ∈ A ′ } mit A ′ ⊆ Ω ′<br />

2.2 Zufallsgrößen<br />

X : Ω → R<br />

PX(B) = P (X −1 (B)) B ∈ R<br />

Verteilungsfunktion: FX(x) = P (X ≤ x) x ∈ R<br />

• P (a < X < b) = FX(b) − FX(a)<br />

• P (X = a) = FX(a) − FX(a − 0)<br />

• FX(−∞) = 0<br />

• FX(∞) = 1<br />

2.3 Unabhängigkeit von Zufallsgrößen<br />

X, Y sollen unabh. heißen, wenn all Paare von Ereignissen, die Mithilfe von X, Y formuliert werden<br />

können unabhängig sind.<br />

• P (X ∈ B1, Y ∈ B2) = P (X ∈ B1) · P (Y ∈ B2) ⇐⇒ X, Y unabh.<br />

• P (X1 ∈ B1, X2 ∈ B2, . . . Xn ∈ Bn) = P (X1 ∈ B1) · . . . · P (Xn ∈ Bn)<br />

=⇒ X1, . . . , Xn vollständig unabhängig<br />

=⇒ X1, . . . , Xn i.i.d., falls X1, . . . , Xn Zufallsgrößen über demselben W.-Raum<br />

2.3.1 diskrete Zufallsgrößen<br />

X, Y unabhängig ⇐⇒ P (X = x, Y = y) = P (X = x) · P (Y = y)<br />

X ∼ geometrisch verteilt: („Gedächtnislosigkeit“)<br />

P (X = k + l|X ≥ k) = P (X = l)<br />

2.3.2 stetige Zufallsgrößen<br />

X = (X1, . . . , Xn)<br />

• Randverteilungsfunktion: FXi (x) = P (X1 ∈ R, . . . , xi ≤ x, . . . , Xn ∈ R)<br />

• gemeinsame Verteilungsfunktion: FX(x1, . . . , xn) = P (X1 ≤ x1, . . . , Xn ≤ xn)<br />

X1, . . . , Xn unabhängig ⇐⇒ FX(x1, . . . , xn) = FX1 (x1) · . . . · FXn(xn)<br />

� � xn x1<br />

Dichtefunktion FX(x1, . . . , xn) = . . . fX(t1, . . . , tn)dt1 . . . dtn<br />

�<br />

−∞ −∞<br />

mit fX(t)dt = 1 ⇐⇒ f heißt Dichtefunktion<br />

R n<br />

Randdichte fxi =<br />

�<br />

R\span(xi)<br />

fX(t)

<strong>Stochastik</strong> I Erwartungswert, Varianz, Kovarianz 4<br />

3 Verteilungsgesetze von transformierten Zufallsgrößen<br />

3.1 Transformationen von 1dim. Zufallsgrößen<br />

Fg(x)(x) = P (g(X) ≤ x) = P (X ∈ g−1 ((−∞, x]))<br />

� x<br />

oder Darstellung F g(x)(x) =<br />

−∞<br />

3.2 Summe zweier Zufallsgrößen<br />

k(t)dt ⇒ g(x) hat VD k<br />

Seien X1, X2 unabhängig<br />

P (X1 + X2 = s) = �<br />

P (X1 = x1, X2 = s − x2) = �<br />

P (X1 = x1) · P (X2 = s − x1)<br />

x1<br />

⇒ X1 ∼ Πλ1 , X2 ∼ Πλ2 , X1 + X2 ∼ Πλ1+λ2<br />

fX1+X2 =<br />

� ∞<br />

fX1 (t)fX2 (s − t)dt<br />

−∞<br />

⇒ X1 ∼ N µ1,σ 2 1 , X2 ∼ N µ2,σ 2 2 , X1 + X2 ∼ N µ1+µ2,σ 2 1 +σ2 2<br />

fX1−X2 =<br />

� ∞<br />

fX1 (t)fX2 (t − s)dt<br />

−∞<br />

3.3 Produkt & Quotient zweier Zufallsgrößen<br />

fX1·X2<br />

f X1 (s) =<br />

X2<br />

� ∞<br />

(s) =<br />

� ∞<br />

−∞<br />

1<br />

|t| fX1<br />

|t|fX1<br />

−∞<br />

� �<br />

s<br />

fX2<br />

t<br />

(t)dt<br />

(st) fX2 (t)dt<br />

3.4 Injektive diffbare Transformationen von zufälligen Vektoren<br />

fY (u) = fX(T −1 (u))<br />

| det T ′ (T −1 (u))|<br />

4 Erwartungswert, Varianz, Kovarianz<br />

• Erwartungswert ˆ= Mittelwert<br />

• Varianz ˆ= mittlere quadratische Abweichung<br />

4.1 Erwartungswert<br />

� ∞<br />

� ∞<br />

EX = xfX(x)dx, Eg(X) = g(x)fX(x)dx<br />

−∞�<br />

−∞<br />

∞<br />

Existenz: |x|fX(x)dx < ∞<br />

−∞<br />

• E(aX1 + b) = aEX + b<br />

• E(X1 + X2) = EX1 + EX2<br />

• E(X1 · X2) = EX1 · EX2<br />

(gilt immer)<br />

x1<br />

(Zgr. unabhängig!)

<strong>Stochastik</strong> I Ungleichungen & Grenzwertsätze 5<br />

4.2 Varianz<br />

varX = E(X − EX) 2 = EX 2 − (EX) 2<br />

• var(aX + b) = a 2 varX<br />

• var(X1 ± X2) = varX1 + varX2, X1, X2 unabhängig<br />

4.3 Kovarianz<br />

• cov(X1, X2) = E(X1 · X2) − (EX1) · (EX2)<br />

• var(X1 + X2) = varX1 + varX2 + 2cov(X1X2)<br />

• cov(X1, X2) = 0 ⇔ X1, X2 unkorreliert<br />

• cov(X, aX + b) = avarX<br />

• cov(X, X) = varX<br />

• Xi ∼ N µiσ 2 i : cov(X1, X2) = ρσ1σ2<br />

ρX1,X2 = cov(X1, X2)<br />

√ varX1 · varX2<br />

4.4 Die Kovarianzmatrix<br />

X = (X1, . . . , Xn) zufälliger Vektor<br />

ΣX = E(X − EX) T (X − EX) = (cov(Xi, Xj))ij<br />

n-dim Normalverteilung: �<br />

σ<br />

Nµ,Σ, n = 2 : Σ =<br />

2 �<br />

1 ρσ1σ2<br />

ρσ1σ2<br />

5 Ungleichungen & Grenzwertsätze<br />

5.1 Markov-Ungleichung<br />

P (|X| ≥ c) ≤ E(g(|X|))<br />

g(c)<br />

σ 2 2<br />

5.2 Tschebyscheff Ungleichung<br />

P (|X − EX| ≥ c) ≤ varX<br />

c 2<br />

g monoton, nicht fallend<br />

• X ∼ N µ,σ 2 : P (|X − µ| ≥ kσ) ≤ σ2<br />

k 2 σ 2 = 1<br />

k 2<br />

5.3 Gesetz der großen Zahlen<br />

(Xi)i i.i.d.<br />

lim<br />

n→∞ P<br />

� 1<br />

n<br />

n�<br />

|Xi − EX1| > ɛ<br />

i=1<br />

�<br />

= 0

<strong>Stochastik</strong> I Ungleichungen & Grenzwertsätze 6<br />

5.4 Der zentrale Grenzwertsatz<br />

(Xi)i i.i.d. mit EX 2 i < ∞, varXi = σ 2 > 0, EXi = m<br />

mit Φ(x) VF von N0,1<br />

lim<br />

n→∞ P<br />

��ni=1 �<br />

Xi − nµ<br />

√ ≤ x = Φ(x)<br />

nσ<br />

• Summen von i.i.d.Zgr. sind asymptotisch normalverteilt.<br />

• P (Xi = 1) = p = 1 − P (Xi = 0)<br />

lim<br />

n→∞ P<br />

�� �<br />

ni=1<br />

Xi − np<br />

� ≤ x = Φ(x)<br />

np(1 − p)<br />

mit Korrekturformel: P ( �<br />

i Xi ≤ k) = P ( �<br />

i Xi < k) = Φ<br />

Approx der Binomialverteilung:<br />

• Poissonverteilung: λ = np, n groß, p klein<br />

• Normalverteilung: µ = np, σ 2 = np(1 − p)<br />

�<br />

1<br />

k+ 2 −np<br />

�<br />

√<br />

np(1−p)

<strong>Stochastik</strong> <strong>II</strong>: mathematische Statistik Ungleichungen & Grenzwertsätze 7<br />

Teil <strong>II</strong><br />

<strong>Stochastik</strong> <strong>II</strong>: mathematische Statistik<br />

Inhaltsverzeichnis<br />

1 Stichproben und der statistische Raum 8<br />

1.1 Liste wichtiger Statistiken . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 8<br />

2 Punktschätzungen 9<br />

2.1 Punktschätzungen für Erwartungswert . . . . . . . . . . . . . . . . . . . . . . . . . 9<br />

2.2 Punktschätzung für die Varianz . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 9<br />

2.3 Gütekriterien . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 9<br />

2.4 Die Maximum-Likelihood-Methode . . . . . . . . . . . . . . . . . . . . . . . . . . . 10<br />

3 Verteilungen 10<br />

3.1 χ 2 -Verteilung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 10<br />

3.2 t-Verteilung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 10<br />

3.3 F-Verteilung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 11<br />

4 Konfidenzintervalle 11<br />

4.1 Konfidenzintervall für Erwartungswert bei bekannter Varianz . . . . . . . . . . . . 11<br />

4.2 Konfidenzintervall für Erwartungswert bei unbekannter Varianz . . . . . . . . . . . 11<br />

4.3 Konfidenzintervall für Varianz bei unbekanntem Erwartungswert . . . . . . . . . . 11<br />

5 Tests 11<br />

5.1 Grundbegriffe . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 11<br />

5.2 Tests für Normalverteilte Grundgesamtheit . . . . . . . . . . . . . . . . . . . . . . 12<br />

5.2.1 Gausstest: Prüfung des Erwartungswertes bei bekannter Varianz . . . . . . 12<br />

5.2.2 t-Test: Prüfung des Erwartungswertes bei unbekannter Varianz . . . . . . . 12<br />

5.2.3 χ 2 -Test: Prüfung der Varianz bei unbekanntem Erwartungswert . . . . . . . 13<br />

5.3 Zwei Testprobleme für disjunkte Verteilungen . . . . . . . . . . . . . . . . . . . . . 13<br />

5.3.1 Likelihood-Quotienten Methode . . . . . . . . . . . . . . . . . . . . . . . . . 13<br />

5.3.2 Testen von Hypothesen über Parameter der hypergeometrischen Verteilung 13<br />

5.4 Anpassungstests (Kolmogorov-Smirnov) . . . . . . . . . . . . . . . . . . . . . . . . 14<br />

5.5 Zwei-Stichproben Test . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 14<br />

6 Stat. Methoden für 2-dim Stichproben (Multivariatstatistik) 14<br />

6.1 Test auf Unabhängigkeit von Beobachtungsparametern . . . . . . . . . . . . . . . . 14<br />

6.1.1 Randverteilungen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 14<br />

6.1.2 Korrelationskoeffizient . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 14<br />

6.1.3 χ 2 Unabhängigkeitstest . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 14<br />

6.2 Regressionsanalyse . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 15

<strong>Stochastik</strong> <strong>II</strong>: mathematische Statistik Stichproben und der statistische Raum 8<br />

1 Stichproben und der statistische Raum<br />

Stichproben<br />

• math. Stichprobe: X1, . . . , Xn<br />

• konkrete Stichprobe: x1, . . . , xn<br />

Der statistische Raum: [R n , Rn, {P ⊗n<br />

θ , θ ∈ Θ}]<br />

Θ ⊆ R l , l ≥ 1, Pθ ist Wahrscheinlichkeitsmaß auf [R, R] ∀θ<br />

1.1 Liste wichtiger Statistiken<br />

1. Stichprobenmittel / empirischer Erwartungswert<br />

T (x1, . . . , xn) = 1<br />

n<br />

2. r-tes Stichprobenmoment / empirisches r-tes Moment<br />

3. Stichprobenstreuung / empirische Varianz<br />

n�<br />

xi = ¯x<br />

i=1<br />

T (x1, . . . , xn) = 1<br />

n<br />

T (x1, . . . , xn) = 1<br />

n<br />

n�<br />

n�<br />

x<br />

i=1<br />

r i<br />

(xi − ¯x)<br />

i=1<br />

2 = ¯σ 2<br />

4. korrigierte Stichprobenstreuung / korrigierte empirische Varianz<br />

T (x1, . . . , xn) = 1<br />

n − 1<br />

5. konkrete geordnete Stichprobe / Variationsreihe<br />

6. i-te geordnete Statistik / i-te Rangstatistik<br />

7. Spannweite einer Stichprobe<br />

n�<br />

(xi − ¯x)<br />

i=1<br />

2 = ˆσ 2 = n<br />

n − 1 ¯σ2<br />

T (x1, . . . , xn) = (x ∗ 1, . . . , x ∗ n) (sortieren)<br />

T (x1, . . . , xn) = x ∗ i<br />

8. Stichprobenmedian / empirischer Zentralwert<br />

T (x1, . . . , xn) = ˜x 1<br />

2<br />

mit x ∗ 1 ≤ . . . ≤ x ∗ n<br />

(nach Sortieren, i-tes Element)<br />

T (x1, . . . , xn) = x ∗ n − x ∗ 1<br />

⎧<br />

⎨x<br />

=<br />

⎩<br />

∗ n+1<br />

�2<br />

1<br />

2<br />

x ∗ n<br />

2<br />

+ x ∗ n<br />

2 +1<br />

�<br />

falls n ungerade<br />

falls n gerade

<strong>Stochastik</strong> <strong>II</strong>: mathematische Statistik Punktschätzungen 9<br />

9. Stichproben-α-Quantil / empirisches α-Quantil,<br />

⎧<br />

α ∈ (0, 1)<br />

⎨x<br />

T (x1, . . . , xn) = ˜xα =<br />

⎩<br />

∗ ⌊nα⌋+1<br />

1<br />

�<br />

falls nα nicht ganzzahlig<br />

falls nα ganzzahlig<br />

10. empirische Verteilungsfunktion<br />

�<br />

2 x∗ nα + x∗ nα+1<br />

T (x1, . . . , xn) = ˆ F (s) = 1<br />

n�<br />

1<br />

n<br />

[xi,α)(s)<br />

i=1<br />

= 1<br />

n |{i ∈ 1, . . . , n : xi ≤ s}|<br />

11. Histogramm oder rel. Häufigkeiten zu einer Vorgegebenen Klasseneinteilung ∆1, . . . , ∆k<br />

�<br />

n� 1<br />

T (x1, . . . , xn) = 1∆1<br />

n<br />

(xi), . . . , 1<br />

n�<br />

1∆k n<br />

(xi)<br />

�<br />

12. Box-Plot<br />

i=1<br />

• ∆1, . . . ∆k paarweise Disjunkt, äquidistant<br />

• Faustregel von STURGES: k = 1 + 3.32 log 10 n<br />

2 Punktschätzungen<br />

2.1 Punktschätzungen für Erwartungswert<br />

ˆµ(x1, . . . , xn) = ¯x<br />

varθ ˆµ(X1, . . . , Xn) = 1<br />

n varθX1<br />

2.2 Punktschätzung für die Varianz<br />

ˆσ 2 (x1, . . . , xn) = 1<br />

n − 1<br />

2.3 Gütekriterien<br />

n�<br />

(xi − ¯x)<br />

i=1<br />

2<br />

i=1<br />

T (x1, . . . , xn) = (˜x0.1, ˜x0.25, ˜x0.5, ˜x0.75, ˜x0.9)<br />

falls X1, . . . , Xn i.i.d.<br />

• T erwartungstreue Punktschätzung für γ<br />

⇔ EθT (X1, . . . , Xn) = γ(θ) ∀θ ∈ Θ<br />

• T1 effizienter als T2<br />

⇔ varθT1(X1, . . . , Xn) < varθT2(X1, . . . , Xn) < ∞<br />

• T ∗ bester erwartungstreuer Schätzer (BUE - best unbiased estimator)<br />

⇔ varθT ∗ (X1, . . . , Xn) ≤ varθTi(X1, . . . , Xn) ∀θ ∈ Θ und Ti erwartungstreu ∀i<br />

Mögliche andere Kriterien<br />

• Eθ(T (X1, . . . , Xn) − θ) 2<br />

• Asymptot. Verhalten für n → ∞<br />

Anmerkung: ˆµ = ¯x ist bester erwartungstreuer Schätzer, falls Grundgesamtheit normalverteilt,<br />

poissonverteilt, binomialverteilt, aber nicht bei Gleichverteilung auf (a, b), a, b unbekannt.

<strong>Stochastik</strong> <strong>II</strong>: mathematische Statistik Verteilungen 10<br />

2.4 Die Maximum-Likelihood-Methode<br />

θ ∈ Θ suchen für das diese Stichprobe den Maximalwert der Wahrscheinlichkeitsdichte liefert.<br />

• Likelihood-Funktion:<br />

L : θ × Rn → [0, ∞)<br />

L(θ, x1, . . . , xn)<br />

n�<br />

= fθ(xi) (stetig)<br />

i=1<br />

n�<br />

= Pθ(Xi = xi)<br />

i=1<br />

(diskret)<br />

• Maximum-Likelihood Schätzwert ˆ θ ∗<br />

L( ˆ θ ∗ , x1, . . . , xn) ≥ L(θ, x1, . . . , xn) ∀θ ∈ Θ<br />

• Zur Berechnung häufig ln L betrachten.<br />

3 Verteilungen<br />

Xi ∼ N0,1<br />

Zi ∼ N µ,σ 2<br />

3.1 χ 2 -Verteilung<br />

r�<br />

• X<br />

i=1<br />

2 i ∼ χ 2 r<br />

• 1<br />

σ2 �<br />

n(Zi − µ)<br />

i=1<br />

2 ∼ χ 2 n<br />

• 1<br />

σ2 �<br />

n(Zi −<br />

i=1<br />

¯ Z) 2 ∼ χ 2 n−1<br />

• Y1 ∼ χ 2 r1 Y2 ∼ χ 2 r2 Y1 + Y2 ∼ χ 2 r1+r2<br />

• χ 2 2 = ε 1<br />

2<br />

3.2 t-Verteilung<br />

• fY (−x) = fY (x)<br />

• r = 1: Cauchy-Verteilung<br />

⎧<br />

⎪⎨ 0 x < 0<br />

fY (x) =<br />

⎪⎩<br />

1<br />

2 r 2 Γ( r<br />

r<br />

x 2<br />

2) −1 x2<br />

− e 2 x ≥ 0<br />

fY (x) =<br />

�<br />

r+1 Γ( 2 )<br />

Γ( r<br />

2) √ �<br />

πr<br />

• r → ∞: Normalverteilung mit µ = 0, σ 2 = 1<br />

•<br />

� 1<br />

r<br />

• √ n<br />

X0<br />

� ri=1 X 2 i<br />

� 1<br />

n−1<br />

∼ tr<br />

¯Z − µ<br />

�ni=1 (Xi − ¯ ∼ tn−1<br />

X) 2<br />

1 + x2<br />

r<br />

� − r+1<br />

2<br />

x ∈ R

<strong>Stochastik</strong> <strong>II</strong>: mathematische Statistik Tests 11<br />

3.3 F-Verteilung<br />

•<br />

1 �r+s s i=r+1 X2 i<br />

1 �ri=1 r X2 i<br />

∼ Fs,r<br />

4 Konfidenzintervalle<br />

⎧<br />

⎨0<br />

x < 0<br />

fY (x) = �<br />

⎩ s<br />

r<br />

� s<br />

2 x s<br />

2 −1 � 1 + s<br />

r x� − s+r<br />

2 x ≥ 0<br />

(1 − α)-Konfidenzintervall P ⊗n<br />

θ (C(X1, . . . , Xn) ∋ γ(θ)) ≥ 1 − α ∀θ ∈ Θ<br />

Häufig (1 − α) ∈ {0.9; 0.95; 0.99}<br />

4.1 Konfidenzintervall für Erwartungswert bei bekannter Varianz<br />

ist (1 − α)-KI<br />

C(x1, . . . , xn) =<br />

�<br />

¯x − σ √ Φ<br />

n −1 (1 − α<br />

2 ), ¯x + σ √ Φ<br />

n −1 (1 − α<br />

2 )<br />

�<br />

4.2 Konfidenzintervall für Erwartungswert bei unbekannter Varianz<br />

ist (1 − α)-KI<br />

C(x1, . . . , xn) =<br />

�<br />

¯x −<br />

√ ˆσ 2<br />

√ t α<br />

n−1,1− , ¯x +<br />

n 2<br />

√ �<br />

ˆσ 2<br />

√ t α<br />

n−1,1−<br />

n 2<br />

4.3 Konfidenzintervall für Varianz bei unbekanntem Erwartungswert<br />

weil<br />

(n − 1)ˆσ2<br />

σ 2<br />

5 Tests<br />

∼ χ 2 n−1<br />

5.1 Grundbegriffe<br />

Θ partitionieren in Θ0, Θ1<br />

H0 : θ ∈ Θ0 Nullhypothese<br />

H1 : θ ∈ Θ1 Alternativhypothese<br />

⎡<br />

(n − 1)ˆσ2<br />

C(x1, . . . , xn) = ⎣ , (n − 1)ˆσ2<br />

H0 wahr H1 wahr<br />

H0 wählen � Fehler 2. Art<br />

H0 ablehnen Fehler 1. Art �<br />

• Test: D : R n → {H0, H1}<br />

• Testgröße: T : R n → R<br />

χ 2 n−1,1− α<br />

2<br />

χ 2 n−1, α<br />

2<br />

⎤<br />

⎦<br />

2.Art: irrtümliche Annahme von H1<br />

1.Art: irrtümliche Ablehnung von H0

<strong>Stochastik</strong> <strong>II</strong>: mathematische Statistik Tests 12<br />

• Kritischer Bereich K ⊆ R sodass<br />

T (x1, . . . , xn) ∈ K ⇒ H1 wählen<br />

T (x1, . . . , xn) �∈ K ⇒ H0 wählen<br />

• Gütefunktion des Tests D<br />

βD : θ → [0, 1] mit<br />

β(θ) = P ⊗n<br />

θ (D(X1, . . . , Xn) = H1)<br />

• Signifikanzniveau zum Niveau α<br />

βD(θ) ≤ α ∀θ ∈ Θ<br />

βD(θ) ≥ sup<br />

θ ′ βD(θ<br />

∈Θ0<br />

′ ) ∀θ ∈ Θ1 (Unverfälschtheit)<br />

5.2 Tests für Normalverteilte Grundgesamtheit<br />

5.2.1 Gausstest: Prüfung des Erwartungswertes bei bekannter Varianz<br />

(a) H0 : µ = µ0<br />

H1 : µ �= µ0<br />

T (X1, . . . , Xn) = √ n ¯ X − µ0<br />

K =<br />

(b) H0 : µ ≥ µ0 H1 : µ < µ0<br />

Testgröße wie bei Punkt a<br />

�<br />

−∞, Φ −1<br />

K =<br />

σ0<br />

� �� �<br />

α<br />

∪ Φ<br />

2<br />

−1<br />

∼ ↑<br />

falls µ=µ0 (!)<br />

�<br />

�<br />

−∞, −Φ −1 �<br />

(1 − α)<br />

N0,1<br />

1 − α<br />

� �<br />

, ∞<br />

2<br />

5.2.2 t-Test: Prüfung des Erwartungswertes bei unbekannter Varianz<br />

(a) H0 : µ = µ0<br />

H1 : µ �= µ0<br />

T (X1, . . . , Xn) =<br />

K = (−∞, −t n−1,1− α<br />

√<br />

n<br />

√<br />

ˆσ 2 ( ¯ X − µ0) ∼ tn−1<br />

↑<br />

falls µ=µ0 (!)<br />

2 ) ∪ (tn−1,1− α<br />

2<br />

K ist ein wenig kleiner als beim entsprechenden Gauss-Test<br />

, ∞)<br />

• α kann auch als Überschreitungswahrscheinlichkeit gelesen werden, sodass<br />

P Ü (X1, . . . , Xn) < α<br />

(b) H0 : µ ≥ µ0 H1 : µ < µ0<br />

Testgröße wie bei Punkt a<br />

K = (−∞, −tn−1,1−α)

<strong>Stochastik</strong> <strong>II</strong>: mathematische Statistik Tests 13<br />

5.2.3 χ 2 -Test: Prüfung der Varianz bei unbekanntem Erwartungswert und normalverteilter<br />

Grundgesamtheit<br />

(a) H0 : σ 2 = σ 2 0<br />

(b) H0 : σ 2 ≥ σ 2 0<br />

H1 : σ 2 �= σ 2 0<br />

T (X1, . . . , Xn) = ˆσ2 (n − 1)<br />

H1 : σ < σ 2 0<br />

Testgröße wie bei Punkt a<br />

= 1<br />

σ 2 0<br />

K = [0, χ 2 n−1, α<br />

2<br />

σ2 0<br />

n�<br />

(Xi −<br />

i=1<br />

¯ X) 2<br />

∼<br />

↑<br />

falls σ2 =σ2 0 (!)<br />

χ 2 n−1<br />

) ∪ (χ 2 n−1,1− α , ∞)<br />

2<br />

T (X1, . . . , Xn) �∈ K ⇐⇒ α<br />

2 ≤ pü ≤ 1 − α<br />

2<br />

K = (0, χ 2 n−1,α)<br />

5.3 Zwei Testprobleme für disjunkte Verteilungen<br />

5.3.1 Likelihood-Quotienten Methode<br />

Allgemeines Prinzip zur Konstruktion von Tests bzw von Testgrößen.<br />

Betrachten [Rn , Rn{Pθ0 , Pθ1 }] d.h. θ = {Pθ0 , Pθ1 }<br />

H0 : θ = θ0<br />

H1 : θ = θ1<br />

L(θ1, x1, . . . , xn)<br />

L(θ0, x1, . . . , xn) > c dann H0 ablehnen<br />

c so wählen, dass Wahrscheinlichkeit für Fehler 1.Art β(θ0) ≤ α0<br />

Man kann zeigen, dass dieser Test, falls β(θ0) = α bester α-Signifikanztest ist, in dem Sinne, dass<br />

β(θ1) ≥ βD(θ1) ∀α-Signifikanztests D.<br />

5.3.2 Testen von Hypothesen über Parameter der hypergeometrischen Verteilung<br />

N - Gesamtzahl der Produkte in einer Lieferung<br />

θ - Anzahl der fehlerhaften Produkte (unbekannt), θ ∈ {0, 1, 2, . . . , N} = Θ<br />

m - Anzahl geprüfter Produkte<br />

Zufallsgröße: κ - Anzahl der fehlerhaften Produkte unter den geprüften Produkten. κ besitzt eine<br />

hypergeometrische Verteilung mit Parametern N, θ, m = HN,θ,m<br />

H0 : θ ≤ θ0 H1 : θ ≥ θ1<br />

Kritischen Bereich aus Quantilen wählen.<br />

• N >> m ⇒ HN,θ,m ≈ B m, θ<br />

N<br />

Pθ(κ = k) =<br />

�θ��N−θ� k m−k<br />

�N� m<br />

• Diese Binomialverteilung gegebenenfalls mithilfe des zentralen Grenzwertsatzes durch Normalverteilung<br />

oder durch Poissonverteilung mit λ = m·θ<br />

N nähern.

<strong>Stochastik</strong> <strong>II</strong>: mathematische Statistik Stat. Methoden für 2-dim Stichproben (Multivariatstatistik) 14<br />

5.4 Anpassungstests (Kolmogorov-Smirnov)<br />

H0 : F = F0<br />

H1 : F �= F0<br />

5.5 Zwei-Stichproben Test<br />

H0 : µ1 ≤ µ2<br />

H1 : µ1 > µ2<br />

T (X1, . . . , Xn, Y1, . . . , Yn) =<br />

• Vergleich der Varianzen: F-Test<br />

• σ 2 1 �= σ2 2<br />

: Welch Test<br />

T (x1, . . . , xn) = √ n sup<br />

t∈R<br />

� n · m<br />

n + m<br />

�<br />

�<br />

� ˆ �<br />

�<br />

F (t) − F0(t) �<br />

¯X − ¯ Y<br />

�ˆσ 2<br />

ˆσ 2 1<br />

=<br />

n + m − 2<br />

K = (tm+n−2,1−α, ∞)<br />

∼ ↑<br />

falls µ1=µ2<br />

und varX1=varX2=σ2 �<br />

(n − 1)ˆσ 2 X + (m − 1)ˆσ 2 �<br />

Y<br />

tn+m−2<br />

6 Stat. Methoden für 2-dim Stichproben (Multivariatstatistik)<br />

6.1 Test auf Unabhängigkeit von Beobachtungsparametern<br />

6.1.1 Randverteilungen<br />

F (X,Y )(x, y) = FX(x) · FY (y) ⇐⇒ Unabhängigkeit von X und Y<br />

mit F (X,Y )(x, y) = P (X ≤ x, Y ≤ y)<br />

6.1.2 Korrelationskoeffizient<br />

ρX,Y =<br />

cov(X, Y )<br />

√ varX · varY<br />

6.1.3 χ 2 Unabhängigkeitstest<br />

Es seien a1, . . . , ar ∈ R und b1, . . . , bs ∈ R<br />

Bezeichnung:<br />

nur falls X, Y normalverteilt ⇒<br />

⇐ gilt immer<br />

pij = P (X1 = ai, Y1 = bj) mit �<br />

pij = 1<br />

i,j<br />

X, Y unabhängig<br />

s�<br />

pi· = pij = P (X1 = ai)<br />

r�<br />

p·j = pij = P (Y1 = bj)<br />

j=1<br />

i=1<br />

H0 : pij = pi· · p·j ∀i,j<br />

H1 : pij �= pi· · p·j für wenigstens ein Paar (i, j)

<strong>Stochastik</strong> <strong>II</strong>: mathematische Statistik Stat. Methoden für 2-dim Stichproben (Multivariatstatistik) 15<br />

Zufallsgröße: Hij - Anzahl {l : Xl = ai, Yl = bj} ˆ= Absolute Häufigkeit des Auftretens ddes Paares<br />

(ai, bj) in der Stichprobe.<br />

Testgröße:<br />

Kritischer Bereich:<br />

T = n ·<br />

s�<br />

s�<br />

Hi· = Hij<br />

j=1<br />

j=1 i=1<br />

�<br />

r� Hij − Hi··H·j<br />

n<br />

K =<br />

Hi· · H·j<br />

� 2<br />

r�<br />

H·j = Hij<br />

i=1<br />

�<br />

χ 2 �<br />

(r−1)(s−1),1−α , ∞<br />

∼ χ<br />

↑<br />

asymptot. n→∞<br />

H0 wahr<br />

2 (r−1)(s−1)<br />

• Falls X1 und Y1 nicht diskret mithilfe von Klasseneinteilung diskretisieren<br />

• ACHTUNG: Falls H0 abgelehnt wird, dann Annahme dass notwendige Bedingung für die Unabhängigkeit<br />

verletzt ist!<br />

Falls H0 angenommen wird, dann also keine Aussage über die Unabhängigkeitshypothese möglich<br />

6.2 Regressionsanalyse<br />

MKQ is BLUE<br />

Gauss Markov Theorem<br />

Zufällige Prozesse !