Ãbersicht Reinforcement Learning Betrachtete Agententypen ...

Ãbersicht Reinforcement Learning Betrachtete Agententypen ...

Ãbersicht Reinforcement Learning Betrachtete Agententypen ...

Erfolgreiche ePaper selbst erstellen

Machen Sie aus Ihren PDF Publikationen ein blätterbares Flipbook mit unserer einzigartigen Google optimierten e-Paper Software.

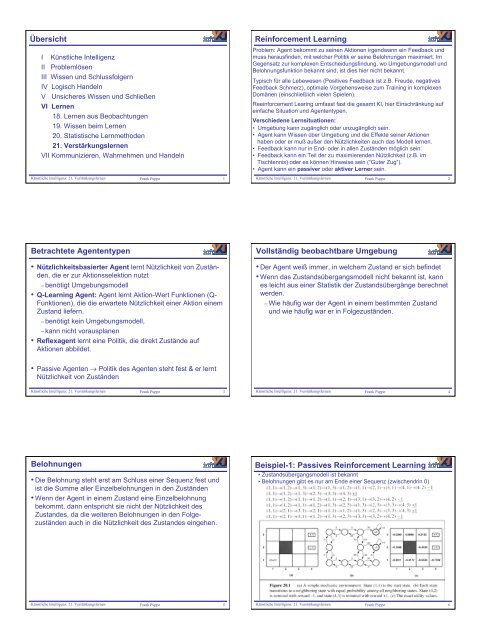

Beispiel-2: Passives <strong>Reinforcement</strong> <strong>Learning</strong>(a) gibt die Politik an (Zustandsübergangsmodell ist unbekannt)(b) die aufgrund der 3 Beispielsequenzen unten gelernten NützlichkeitenBasisüberlegungen• falls Zustandsübergangsmodell unbekannt, kann esleicht gelernt werden: durch Auszählen der Zustandsübergängefür jeden Zustand, z.B. im Beispiel-2:• von Zustand (1,2) nach (1,3) in 3 von 3 Fällen (100%)• von Zustand (1,3) nach (1,2) in 1 von 3 Fällen (33%)• von Zustand (1,3) nach (2,3) in 2 von 3 Fällen (67%)• Die Belohnung in einem Zustand ist die direkte Belohnungdes Zustandes + die zukünftige Belohnung unter derAnnahme einer bestimmten Politik. Dabei wird davonausgegangen, das die direkte Belohnung in jedem Zustandwahrnehmbar ist:Künstliche Intelligenz: 21. Verstärkungslernen Frank Puppe 7Künstliche Intelligenz: 21. Verstärkungslernen Frank Puppe 8Vorgehensweisen zum LernenBasisalgorithmus:Der Agent aktualisiert mit jeder Trainingssequenz die erwartetenNützlichkeiten der betroffenen Zustände. Dabei gibt esverschiedene Möglichkeiten:• Direkte Nützlichkeitsschätzung• Adaptives dynamisches Programmieren• Zeitliches DifferenzlernenDatenstrukturen:U: Tabelle der aktuellen Nützlichkeitswerte aller ZuständeN: Tabelle der Häufigkeiten aller ZuständeM: Tabelle der Übergangswahrscheinlichkeiten zwischen denZuständenKünstliche Intelligenz: 21. Verstärkungslernen Frank Puppe 9Direkte NützlichkeitsschätzungIn einer Trainingssequenz werden für alle Zustände der Sequenzihre beobachteten Nützlichkeiten rückwärts berechnet.Diese werden entsprechend der Häufigkeit der Zustände über alleTrainingssequenzen gewichtet und daraus die Gesamtnützlichkeitdes Zustandes berechnet.Aus Beispiel-1:Zustand (1,1) kommt in erster Sequenz 2 Mal mit jeweils -1 vor,insgesamt: Häufigkeit: 12; Summe: -2, Bewertung = -0,167Zustand (1,2): Häufigkeit: 10; Summe: -2, Bewertung = -0,2Zustand (1,3): Häufigkeit: 6; Summe: 0, Bewertung = 0Problem: Der Algorithmus berücksichtigt nicht das Wissen überÜbergangswahrscheinlichkeiten zwischen den Zuständen undkonvergiert deswegen extrem langsam, z.B. müsste Zustand (1,2)in der Mitte zwischen Zustand (1,1) und (1,3) liegen!Künstliche Intelligenz: 21. Verstärkungslernen Frank Puppe 10Ergebnisse für Beispiel-1Schwäche der direkten NützlichkeitsschätzungIllustratives Beispiel für Schwäche der direktenNützlichkeitsschätzung: Der neue Knoten NEW wirdaufgrund einer Epoche entlang des gestrichelten Pfadesbewertet und bekommt daher die Bewertung +1, obwohlbereits bekannt ist, das der Knoten OLD, der die gleicheBewertung wie NEW haben muss, die Bewertung -0,8 hat.Künstliche Intelligenz: 21. Verstärkungslernen Frank Puppe 11Künstliche Intelligenz: 21. Verstärkungslernen Frank Puppe 12

Adaptives Dynamisches ProgrammierenTatsächlich ist die Nützlichkeit eines Zustandes seine direkte Belohnungplus der entsprechend der Übergangswahrscheinlickeiten gewichteteDurchschnitt der Nützlichkeiten der Nachbarzustände, d.h.U π (s) = R(s) + γ∑ s' T(S, π(s), s') U π (s')U = Nützlichkeit (Utility) bei Politik πR = Belohnung (Reward)T = Übergangswahrscheinlichkeit zwischen Zuständen gemäß Politik πDa die Übergangswahrscheinlichkeiten leicht vorberechnet werdenkönnen, kann der Agent ein lineares Gleichungssystem von Gleichungenlösen, wenn er genügend (d.h. ≈ |Zustände|) Pfade beobachtet hat.Allerdings können die Gleichungssysteme extrem groß und damit nichtmehr handhabbar werden, z.B. bei Backgammon 10 50 Gleichungen mit10 50 Unbekannten.Alternativ kann das Gleichungssystem für die Nützlichkeiten auch miteiner modifizierten Politik-Iteration approximiert werden.Künstliche Intelligenz: 21. Verstärkungslernen Frank Puppe 13Zeitliches Differenzlernen (Temporal Difference; TD)Kombination der Vorteile des direkten & des ADP-Ansatzes (Einfachheitbei Berücksichtigung von Übergangswahrscheinlichkeiten)Idee: Die Übergangswahrscheinlichkeiten werden nicht berechnet,sondern es wird nur eine Anpassung an den Nachfolgezustandvorgenommen. Wenn man z.B. von einem Zustand i nach jkommt und derzeit galt: U(i) = -0,5 und U(j) = +0,5 dann sollte U(i)an seinen Nachfolger angepaßt werden.Das lässt sich durch folgende Aktualisierungsregel korrigieren:U π (s) ← U π (s) + α (R(i) + U π (s') - U π (s) )Wobei α ein Parameter “Lernrate” ist, der mit zunehmender Zeitverkleinert wird (ähnlich wie bei simulated annealing).Künstliche Intelligenz: 21. Verstärkungslernen Frank Puppe 14Unterschiede zwischen ADP und TD• TD adaptiert einen Zustand nur an seinen beobachtetenVorgänger, ADP an alle Nachbarn.→ Unterschied gering bei vielen Trainingssequenzen• TD macht nur eine Anpassung pro beobachtete TransitionADP für alle Nachbarn und propagiert diese weiter→ TD grobe Approximation von ADP• Unterschied kann verringert werden, wenn für TD Pseudo-Erfahrungen auf der Basis des bisherigen Wissen überZustandsübergänge generiert werden.• Entsprechend kann ADP angepasst werden, indem nurgroße Wertänderungen an wahrscheinliche Nachbarnpropagiert werden→ approximatives ADPKünstliche Intelligenz: 21. Verstärkungslernen Frank Puppe 15Aktives Lernen in unbekannten UmgebungenEin aktiver Agent hat die Möglichkeit, in jedem Zustand diejeweils beste Aktion zu wählen.Im Vergleich zum passiven Lernen ändert sich:• die Auswirkungen aller Aktionen (nicht nur die einer Politik)• Die Berechung der Nützlichkeit eines Zustandes, bei der immer diebeste Aktion (optimale Politik) zugrunde gelegt wird.• Die Verhaltenskomponente fragt die gelernten Funktionen ständig ab.‣ Die Lernalgorithmen ändern sich dadurch nicht wesentlich.Allerdings ist die Aktionsselektion kompliziert, da sie einenKompromiss zwischen gegenwärtigem und zukünftigem Nutzen(letzteres durch erkundende Aktionen) finden muss.Optimale Erkundungspolitik – "Bandit Problem": N-armiger Bandit(Las Vegas): Welcher "Bandit", d.h. welche Investion ist amlukrativsten?Künstliche Intelligenz: 21. Verstärkungslernen Frank Puppe 16ErkundungspolitikProblem: In welchem Umfang sollen unbekannte (und dahereventuell sehr schlechte) Aktionen durchgeführt werden.Strategie: Grad des Konservativismus sollte proportional zumWissensstand sein.Umsetzung: Wenig erkundete Pfade bekommen einebelohnungsunabhängige Verstärkung, die mit häufigeremDurchlaufen abnimmt.U + (s) = R(s) + γ max a f (∑ s' T(S, a, s') U + (s'), N(a, s)f (u, n) ist Erkundungsfunktion, z.B. = R + if n

Direktes Lernen von Aktionen: Q-Lernen (2)Während sich das dynamische adaptive Programmieren nichtübertragen lässt, da es Nützlichkeiten der Zustände benötigt,kann das zeitliche Differenzenlernen leicht angepasst werden:Q(a, s) ← Q(a, s) + α (R(s) + γ max a‘ Q(a‘,s') – Q(a,s))das nach jedem Übergang von Zustand s nach Zustand s'berechnet wird.Beim aktiven Lernen werden wiederum seltene Aktionen inZuständen belohnt.Q-Lernen benötigt kein Modell der Welt und kann daher keindeklaratives Wissen repräsentieren: Eignung eher für einfacheUmgebungen.Künstliche Intelligenz: 21. Verstärkungslernen Frank Puppe 19Generalisierung beim <strong>Reinforcement</strong>-LernenIm allgemeinen ist es unmöglich, alle Zustände explizit zu bewerten (z.B.Schach mit ca. 10 80 Stellungen). Stattdessen werden impliziteRepräsentationen der Nützlichkeiten benötigt, die häufig als lineare Funktionenvon Zustandsvariablen dargestellt werden:U(s) = w 1 f 1 (s) + w 2 f 2 (s) + ... + w n f n (s)wobei die Nützlichkeitsfunktion durch n Gewichte w i repräsentiert wird. Das istnicht nur eine enorme Speicherreduktion, sondern auch eineVerallgemeinerung, so dass der Agent nicht mehr alle Zustände kennen muss.In den Lernfunktionen muss beim Zeitliches Differenzlernen (analog beimdirekten Nützlichkeitslernen und beim Q-<strong>Learning</strong>) nur die Nützlichkeit einesZustandes durch die Nützlichkeit der Zustandsfunktion ersetzt werden, Sei w =w 1 , w 2 , .... w n ein Gewichtsvektor und U w (s) die Nützlichkeit eines Zustandes sbei gegebenem w. Dann gilt:w ← w + α [R(s) + γ U w (s') – U w (s)] ∇ (w) U w (s)was einem Gradienten-Abstiegs-Verfahren wie bei neuralen Netzen entspricht,die sich gut für diese Lernverfahren eignen.Künstliche Intelligenz: 21. Verstärkungslernen Frank Puppe 20AnwendungenAnwendungen in Spielen:• Checker-Programm (Samuel 59, 67):Unterschiede zu obiger Formel:- Es wird die aktuelle Stellungsbewertungsbewertung mit derdurch Vorausberechnung im Suchbaum entstandenenStellungsbewertung verglichen.- Es werden nicht die Endzustände im Spiel bewertet, sondern dieoben berechneten. Allerdings wird Materialvorteil immer positivbewertet.• Backgamman-Programm (Tesauro 89, 92):1. Version (Neurogammon): Neuronales Netz auf der Basis vom Q-Lernen mit Bewertungen von menschlichen Experten.2. Version (TD-Gammon): Neuronales Netz auf der Basis vom TD-Lernen ohne menschliche Bewertungen: bessere Ergebnisse.Anwendungen für Roboter-Steuerung:• Inverses PendelKünstliche Intelligenz: 21. Verstärkungslernen Frank Puppe 21Stab-Balancieren-ProblemKünstliche Intelligenz: 21. Verstärkungslernen Frank Puppe 22Politik-Suche• Idee: Suche zu gegebener Politik iterativ eine bessere Politik• Repräsentation: Politik bildet Zustände in Aktionen ab, wobeidie Zustände durch Parameter (wie beim Generalisieren)dargestellt werden sollen.• Beispiel: Politik π wird durch (mit Gewichtsvektor w)parametrisierte Q-Funktion (Erwartungswert ^Q) repräsentiert:π (s) = max a ^Q w (a, s)• Politik-Suche verändert Parameter w, um Politik zu verbessern• Bei deterministischer Umgebung relativ gut lösbar (SoftmaxFunktion), bei stochastischer Umgebung komplizierter, aberauch lösbar (PEGASUS Algorithmus).Künstliche Intelligenz: 21. Verstärkungslernen Frank Puppe 23