Distribución Gaussiana Multivariable

Distribución Gaussiana Multivariable

Distribución Gaussiana Multivariable

You also want an ePaper? Increase the reach of your titles

YUMPU automatically turns print PDFs into web optimized ePapers that Google loves.

<strong>Distribución</strong> <strong>Gaussiana</strong> <strong>Multivariable</strong><br />

Carlos Belaustegui Goitia, Juan Augusto Maya<br />

8 de Agosto de 2010<br />

Resumen<br />

En este documento presentamos la deducción de la expresión de la función<br />

densidad de probabilidad (f.d.p.) <strong>Gaussiana</strong> multivariable. También se muestran<br />

ejemplos de variables aleatorias conjuntamente <strong>Gaussiana</strong>s y de otras<br />

variables aleatorias que no lo son. Para terminar mostramos una interpretación<br />

gráfica de la distribución <strong>Gaussiana</strong> multivariable.<br />

1. La <strong>Distribución</strong> <strong>Gaussiana</strong> <strong>Multivariable</strong><br />

A continuación, obtendremos la expresión de la f.d.p. de un vector aleatorio<br />

X = [X1,...,XN] T<br />

cuyas componentes son conjuntamente <strong>Gaussiana</strong>s1 , de media nula y matriz de<br />

covarianza CX.<br />

Definimos un vector Z de N variables aleatorias <strong>Gaussiana</strong>s independientes,<br />

idénticamente distribuidas (i.i.d.) Z = [Z1,...,ZN] T , cada una de ellas con media<br />

nula y varianza σ2 i. El hecho que las zi estén idénticamente distribuidas significa que<br />

sus funciones distribución son iguales, y por lo tanto, sus funciones de densidad de<br />

probabilidad y sus momentos son los mismos. En particular, esto se cumple para la<br />

varianza: σ2 1 = ··· = σ2 N = σ2 . La f.d.p. de la variable zi es<br />

fZi (zi)<br />

<br />

exp −<br />

=<br />

z2 i<br />

2σ2 <br />

√ i = 1,...,N<br />

2πσ<br />

y la f.d.p. del vector Z es<br />

fZ(z) =<br />

N<br />

i=1<br />

fZi (zi) =<br />

1<br />

(2π) N/2 exp<br />

σN <br />

−<br />

N i=1z2 i<br />

2σ2 <br />

=<br />

1<br />

(2π) N/2 <br />

exp −<br />

σN z2<br />

2σ2 <br />

.<br />

(1)<br />

La primera igualdad se debe a que las variables aleatorias zi son independientes, y<br />

por ello, la f.d.p. conjunta es el producto de las f.d.p. individuales.<br />

1 En la siguiente sección veremos cuándo un grupo de variables aleatorias es conjuntamente<br />

Gaussiano y cuando, no.<br />

1

La matriz de covarianza de Z es una matriz diagonal de dimensión N × N:<br />

CZ = σ 2 IN, ya que las componentes de Z son independientes, y por lo tanto, no<br />

correlacionadas o descorrelacionadas.<br />

Ahora definimos la siguiente transformación lineal,<br />

X = AZ, (2)<br />

donde la matriz A ∈ R N×N es no singular o invertible. La matriz de covarianza de<br />

X es<br />

CX = E[XX T ] = E[AZZ T A T ] = AE[ZZ T ]A T = ACZA T = σ 2 AINA T = σ 2 AA T<br />

Entonces, la matriz σA es la raíz cuadrada simétrica de la matriz de covarianza<br />

de X: σA = C 1/2<br />

X , que existe puesto que CX es definida positiva.<br />

La f.d.p. del vector X se obtiene mediante la transformación<br />

fX(x) = fZ(z(x))<br />

|detJ(x)|<br />

donde J(x) es el Jacobiano del vector x,<br />

J(x) = ∂(x)<br />

∂(z) =<br />

⎡ ⎤ ⎡<br />

∇x1<br />

⎢ ⎥ ⎢<br />

⎣ . ⎦ = ⎣<br />

∇xN<br />

Utilizando esta expresión,<br />

∂x1<br />

∂z1<br />

.<br />

∂xN<br />

∂z1<br />

∂x1<br />

∂z2<br />

∂xN<br />

∂z2<br />

J(x) = A = C1/2<br />

X<br />

σ<br />

1/2<br />

(detCX)<br />

detJ(x) =<br />

σN .<br />

Por otro lado, en el exponente de (1) aparece<br />

z 2 = z T z = A −1 x T A −1 x = x T A T −1 A −1 x = x T AA T −1 x =σ 2 x T C −1<br />

X x<br />

y la f.d.p. de X queda<br />

fX(x) =<br />

1<br />

(2π) N/2 exp 1/2<br />

(detCX)<br />

...<br />

...<br />

∂x1<br />

∂zN<br />

∂xN<br />

∂zN<br />

⎤<br />

⎥<br />

⎦.<br />

<br />

− 1<br />

2 xTC −1<br />

X x<br />

<br />

. (3)<br />

Si la media de X es E(X) = mX = 0, tenemos que redefinir el cambio de variable<br />

en (2) utilizando una transformación que ya no es lineal sino afín,<br />

Entonces, Z = A −1 (X−mX) y la f.d.p. queda<br />

fX(x) =<br />

1<br />

(2π) N/2 exp 1/2<br />

(detCX)<br />

X = AZ+mX. (4)<br />

2<br />

<br />

− 1<br />

2 (x−mX) T C −1<br />

X (x−mX)<br />

<br />

(5)

2. Independencia y Correlación<br />

En esta sección abordaremos el tema de correlación e independencia estadística 2<br />

de variables aleatorias. De manera general, dos o más variables aleatorias independientes<br />

entre sí están descorrelacionadas. Esto se cumple para variables aleatorias<br />

con cualquier tipo de distribución. Para demostrarlo, definimos N variables aleatorias<br />

A1,A2,...,AN independientes y nos proponemos calcular la covarianza de dos<br />

variables aleatorias cualesquiera. Sea mAi = E[Ai], la covarianza de Ai y Aj es<br />

CAi,Aj = E[(Ai −mAi )(Aj −mAj )]<br />

∞ ∞<br />

i = j (6)<br />

=<br />

−∞<br />

(ai −mAi<br />

−∞<br />

)(aj<br />

∞<br />

−mAj )fAi,Aj (ai,aj)daidaj<br />

∞<br />

(7)<br />

=<br />

indep.<br />

(ai −mAi )fAi (ai)dai<br />

−∞<br />

(aj −mAj<br />

−∞<br />

)fAj (aj)daj (8)<br />

= E[Ai −mAi ]E[Aj −mAj ] (9)<br />

= 0. (10)<br />

Entonces, el coeficiente de correlación es<br />

ρ = CAi,Aj<br />

σAi σAj<br />

= 0.<br />

Por lo tanto, las variables aleatorias Ai y Aj están descorrelacionadas ∀i = j. Adicionalmente,<br />

esto implica que la matriz de covarianza del vector aleatorio definido<br />

como A = [A1,A2,...,AN] es diagonal, es decir,<br />

Entonces, en general se cumple,<br />

CA = diag[σ 2 A1 ,...,σ2 AN ]. (11)<br />

Independencia ⇒ Descorrelación<br />

En cambio, no siempre es cierto que la descorrelación de variables aleatorias implica<br />

que ellas son independientes. Un caso para el cual sí se cumple esto es cuando<br />

las variables aleatorias son conjuntamente <strong>Gaussiana</strong>s. Se dice que N variables aleatorias<br />

X1,X2,...,XN son conjuntamente <strong>Gaussiana</strong>s si su distribución conjunta es<br />

la distribución <strong>Gaussiana</strong> multivariable, es decir, la f.d.p. conjunta es (5).<br />

Sean X1,X2,...,XN N variables aleatorias conjuntamente <strong>Gaussiana</strong>s descorrelacionadas,<br />

entonces X1,X2,...,XN son independientes. Para comodidad de notación,<br />

definimos los siguientes vectores aleatorios: X = [X1,X2,...,XN] y X0 =<br />

X−mX, donde mX = E[X]. La i-ésima componente de X0 es X0i = Xi −mXi . La<br />

2 Siempre que hablemos de independencia nos referiremos a independencia estadística, salvo que<br />

se indique lo contrario.<br />

3

f.d.p. de X es (5) con CX = diag[σ2 X1 ,...,σ2 ]. Entonces, XN<br />

fX(x) =<br />

=<br />

=<br />

(2π) N/2<br />

N<br />

i=1<br />

N<br />

i=1<br />

1<br />

N<br />

i=1 σXi<br />

1<br />

√ exp<br />

2πσXi<br />

exp<br />

<br />

<br />

− 1 x<br />

2<br />

2 0i<br />

σ2 <br />

Xi<br />

− 1<br />

2<br />

N<br />

i=1<br />

x 2 0i<br />

σ 2 Xi<br />

<br />

(12)<br />

(13)<br />

fXi (xi) (14)<br />

La última igualdad implica que las Xi’s son independientes. Entonces, para el caso<br />

de variables aleatorias conjuntamente <strong>Gaussiana</strong>s,<br />

Independencia ⇔ Descorrelación<br />

3. Interpretación Geométrica<br />

Es conveniente interpretar esta expresión para un vector bidimensional X =<br />

[X1,X2] T de media nula y matriz de covarianza<br />

<br />

σ<br />

CX =<br />

2 <br />

1 ρσ1σ2<br />

,<br />

ρσ1σ2 σ 2 2<br />

donde ρ es el coeficiente de correlación entre X1 y X2, y σ 2 1, σ 2 2 son sus varianzas. La<br />

forma de la superficie fX(x) = fX1X2(x1,x2) está determinada por el exponente de<br />

(3), ya que el factor que multiplica la exponencial es constante. La intersección de<br />

esta superficie con un plano de f.d.p. constante, es una curva de nivel definida por<br />

x T C −1<br />

X x−K = 0 (15)<br />

con K constante. Puesto que CX es definida positiva, su inversa también lo es, y<br />

la forma cuadrática xTC −1<br />

X x es siempre positiva para cualquier vector x no nulo.<br />

La ecuación (15) define una elipse en el plano (x1,x2), que llamamos elipse de concentración.<br />

La excentricidad e inclinación de los ejes de la elipse depende de los<br />

parámetros de la matriz de covarianza. En el caso de trabajar con N variables aleatorias,<br />

el espacio pasa a ser N-dimensional y la ecuación (15) representa un elipsoide<br />

de concentración.<br />

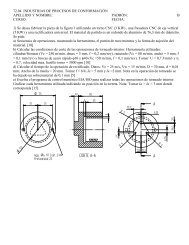

A continuación analizamos dos casos en dos dimensiones: variables aleatorias<br />

<strong>Gaussiana</strong>s correlacionadas y descorrelacionadas.<br />

3.1. Variables Aleatorias Correlacionadas<br />

En la Fig. 1 se muestran gráficos correspondientes a dos variables aleatorias<br />

conjuntamente <strong>Gaussiana</strong>s, de media nula, varianzas unitarias y coeficiente de correlaciónnonulo,yaquelasvariablesaleatoriasestáncorrelacionadas.Enparticular,<br />

elegimosρ = 0,8.EnlaFig.1(a)semuestralaf.d.p.conjuntade(X1,X2)yenlaFig.<br />

4

fX(x1,x2)<br />

0.4<br />

0.3<br />

0.2<br />

0.1<br />

0<br />

4<br />

2<br />

0<br />

x2<br />

−2<br />

−4<br />

−4<br />

(a) Función densidad de probabilidad <strong>Gaussiana</strong> bivariable.<br />

x2<br />

4<br />

3<br />

2<br />

1<br />

0<br />

−1<br />

−2<br />

−3<br />

−2<br />

x1<br />

−4<br />

−4 −2 0 2 4<br />

x1<br />

(b) Elipses de concentración y realizaciones () de (X1,X2).<br />

Figura 1: <strong>Gaussiana</strong> bivariable con los siguientes parámetros: ρ = 0,8 y σ1 = σ2 = 1.<br />

1(b) se muestran las elipses de concentración y 10 3 realizaciones (o experimentos)<br />

del par de variables aleatorias (X1,X2).<br />

En estas figuras se puede ver el significado de la correlación de dos variables. En<br />

la sección anterior vimos que para variables aleatorias conjuntamente <strong>Gaussiana</strong>s se<br />

cumple: Independencia ⇔ Descorrelación. Esto es lo mismo que decir: Dependencia<br />

⇔ Correlación. Entonces, dado que ρ = 0, las variables X1 y X2 son dependientes.<br />

Es decir, condicionar una de las variables a la otra cambia la distribución de<br />

probabilidades,<br />

fX2|X1(x2|x1) = fX2(x2).<br />

Es claro que para distintos valores de x1, la f.d.p. condicional cambia por lo que X1<br />

5<br />

0<br />

2<br />

4

y X2 son dependientes. Por ejemplo,<br />

P(X2 > 0|X1 = 2) > P(X2 > 0)<br />

con lo cual el hecho de conocer el valor de una de las realizaciones de X1 modifica<br />

la probabilidad del evento X2 > 0.<br />

3.2. Variables Aleatorias Descorrelacionadas<br />

En la Fig. 2 graficamos la f.d.p. y realizaciones de dos variable aleatorias conjuntamente<br />

<strong>Gaussiana</strong>s descorrelacionadas (ρ = 0) y, por lo tanto, independientes.<br />

fX(x1,x2)<br />

0.2<br />

0.15<br />

0.1<br />

0.05<br />

0<br />

10<br />

5<br />

0<br />

x2<br />

−5<br />

−10<br />

−10<br />

(a) Función densidad de probabilidad <strong>Gaussiana</strong> bivariable.<br />

x2<br />

6<br />

4<br />

2<br />

0<br />

−2<br />

−4<br />

−5<br />

x1<br />

−6<br />

−6 −4 −2 0 2 4 6<br />

x1<br />

(b) Elipses de concentración y realizaciones () de (X1,X2).<br />

Figura 2: <strong>Gaussiana</strong> bivariable de componentes descorrelacionadas con los siguientes<br />

parámetros: ρ = 0, σ1 = 1 y σ2 = 2.<br />

6<br />

0<br />

5<br />

10

Condicionar una variable sobre otra no cambia la distribución de probabilidades.<br />

Las curvas de nivel de la f.d.p. mostradas en la Fig. 2(b) son elipses centradas en el<br />

origen cuyos ejes coinciden con los ejes de x1 y x2, algo que se debe cumplir para<br />

que X1 y X2 sean independientes. El hecho de que sus varianzas sean distintas sólo<br />

modifica la excentricidad de las elipses de concentración pero no la relación entre<br />

las variables.<br />

4. Casos Particulares<br />

En esta sección analizamos varios ejemplos para los cuales las f.d.p. marginales<br />

son <strong>Gaussiana</strong>s pero la conjunta no es la <strong>Gaussiana</strong> multivariable, es decir, que<br />

las variables aleatorias no son conjuntamente <strong>Gaussiana</strong>s. No alcanza con que las<br />

distribuciones marginales sean <strong>Gaussiana</strong>s para que las variables aleatorias sean<br />

conjuntamente <strong>Gaussiana</strong>s.<br />

Ejemplo 1. Sea X una variable aleatoria <strong>Gaussiana</strong> de media nula y varianza<br />

unitaria, definimos otra variable aleatoria Y tal que,<br />

<br />

X si |X| > c<br />

Y =<br />

(16)<br />

−X si |X| ≤ c<br />

Es claro que Y es <strong>Gaussiana</strong> debido a la simetría de la f.d.p. alrededor de 0. Sin<br />

embargo, como puede apreciarse en la Figura 3 a través de varias realizaciones de<br />

(X,Y), la conjunta no es la <strong>Gaussiana</strong> multivariable.<br />

y<br />

3<br />

2<br />

1<br />

0<br />

−1<br />

−2<br />

−3<br />

−3 −2 −1 0 1 2 3<br />

Figura 3: (Ejemplo 1) 500 realizaciones de (X,Y) definidas por (16) para c ≃ 1,54.<br />

Incluso, se puede demostrar que las variables X e Y se encuentran descorrelacionadas.<br />

Sin embargo, esto no implica que las variables sean independientes ya que<br />

no son conjuntamente <strong>Gaussiana</strong>s.<br />

7<br />

x

Ejemplo 2. Sea X una variable aleatoria <strong>Gaussiana</strong> de media nula y varianza<br />

unitaria. Sea W una variable aleatoria Bernoulli equiprobable e independiente de<br />

X,<br />

W =<br />

Definimos una nueva variable aleatoria<br />

1 p = 0,5<br />

−1 p = 0,5<br />

(17)<br />

Y = WX. (18)<br />

De manera similar al caso anterior y debido a la simetría de la f.d.p. <strong>Gaussiana</strong>, Y<br />

es <strong>Gaussiana</strong>. Sin embargo, como puede apreciarse en la Fig. 4 a través de varias<br />

realizaciones de (X,Y), la conjunta no es la <strong>Gaussiana</strong> multivariable.<br />

y<br />

4<br />

3<br />

2<br />

1<br />

0<br />

−1<br />

−2<br />

−3<br />

−4<br />

−4 −2 0 2 4<br />

Figura 4: (Ejemplo 2) 500 realizaciones de (X,Y) definidas por (18).<br />

Calculemos el coeficiente de correlación entre X e Y. Para eso, necesitamos<br />

primero realizar algunos cálculos. La media de W es,<br />

y la media de Y es,<br />

mW = E[W] = (1)(0,5)+(−1)(0,5) = 0,<br />

mY = E[Y] = E[WX] =<br />

indep. E[W]E[X] = 0,<br />

Finalmente, la covarianza entre X e Y es,<br />

CXY = E[(X −mX)(Y −mY)] =<br />

mX=mY =0 E[XY] = E[WX2 ] = E[W]E[X 2 ] =<br />

mW=0 0,<br />

Por lo que X e Y están descorrelacionadas. Sin embargo, al igual que el ejemplo<br />

anterior, las variables no son independientes ya que, por definición de Y en (18), su<br />

valor absoluto depende de X. Nuevamente, X e Y no son conjuntamente <strong>Gaussiana</strong>s<br />

y, por lo tanto, descorrelación no implica independencia.<br />

8<br />

x

5. Diagonalización de la Matriz de Covarianza<br />

Buscamos la matriz de transformación P tal que el vector aleatorio Y = PX<br />

tenga una matriz de covarianza CY diagonal:<br />

⎡ ⎤<br />

CY =<br />

⎢<br />

⎣<br />

σ 2 1 ... 0<br />

.<br />

...<br />

.<br />

0 ... σ 2 N<br />

Los elementos de la diagonal principal de CY son las varianzas de las componentes<br />

de Y. En otros términos, lo que se busca es una transformación lineal que descorrelacione<br />

las componentes de X.<br />

Imponemoslacondicióndepreservarlanormadelvector,esdecirx 2 = y 2 =<br />

y T y = x T P T Px, lo que implica que P T = P −1 (matriz ortogonal). Una transformación<br />

de este tipo es una rotación. Por conveniencia, definimos Q = P T = P −1 .<br />

Entonces,<br />

⎥<br />

⎦<br />

CY = PCXP T = PCXP −1 = Q −1 CXQ<br />

QC Y = CXQ<br />

Por la forma diagonal de CY, esto implica<br />

qiσ 2 i = CXqi i = 1,...,N,<br />

donde qi es la i-ésima columna de Q. Esto es, Q es una matriz de autovectores de<br />

CX y las varianzas de las componentes de Y son los autovalores de CX.<br />

Por ser CX definida positiva, todos sus autovalores son reales y positivos, como<br />

corresponde a las varianzas de variables aleatorias reales. Por ser una matriz real<br />

y simétrica, todos sus autovectores son ortogonales. Pueden ser normalizados para<br />

tener así una base ortonormal. Las matrices CX y CY se dicen similares, pues existe<br />

una matriz de transformación Q de N ×N con detQ = 0 tal que Q−1CXQ = CY. La transformación ahora se puede escribir<br />

⎡ ⎤<br />

Y = Q T X =<br />

⎢<br />

⎣<br />

q T 1<br />

.<br />

q T N<br />

⎥<br />

⎦X<br />

Es decir, las nuevas variables descorrelacionadas se obtienen proyectando el vector<br />

X en la dirección de los autovectores de la matriz de covarianza CX. La interpretación<br />

gráfica de esta transformación se ve en la Fig. 5. Los ejes principales de<br />

la elipse están alineados con los autovectores, que definen un nuevo sistema de ejes<br />

coordenados. En ese nuevo sistema, las componentes del vector aleatorio no están<br />

correlacionadas.<br />

6. Ejercicios<br />

Ejercicio √ 1. Demostrarquelosejesprincipalesdelelipsoidedeconcentraciónmiden<br />

2σi K, donde K es la constante de la ecuación (15).<br />

9

y2<br />

ay2<br />

q2<br />

ax2<br />

x2<br />

Figura 5: Diagonalización de la matriz de covarianza.<br />

Ejercicio 2. Demostrar que en el sistema transformado, la ecuación (15) se escribe<br />

Interpretar esta expresión.<br />

N<br />

i=1<br />

y2 i<br />

σ2 i<br />

q1<br />

a<br />

ax1<br />

−K = 0<br />

Ejercicio 3. Generar 500 puntos de coordenadas (X1,X2) conjuntamente <strong>Gaussiana</strong>s,<br />

con matriz de covarianza<br />

<br />

1 ρ<br />

CX =<br />

ρ 1<br />

para distintos valores del coeficiente de correlación ρ (Por ejemplo: 0.50, -0.90, 0.0).<br />

Sugerencia: Generar dos secuencias de 500 números aleatorios normales, de media<br />

nula y varianza unitaria mediante la función randn:<br />

Z = (randn(1,500);randn(1,500));<br />

Aplicar a los vectores Z(i,:) así generados, la transformación lineal X=A*Z;<br />

donde A es una matriz de 2×2 apropiada.<br />

Ejercicio 4. Demostrar que la f.d.p. de dos variables X1,X2 conjuntamente <strong>Gaussiana</strong>s,<br />

de media nula, varianza σ2 y coeficiente de correlación ρ se puede escribir<br />

1<br />

fX1X2(x1,x2) =<br />

2πσ2 <br />

−1<br />

exp<br />

1−ρ 2 2σ2 (1−ρ 2 2<br />

x1 −2ρx1x2 +x<br />

)<br />

2 2<br />

<br />

Ejercicio 5. Demostrar que las marginales de una <strong>Gaussiana</strong> son <strong>Gaussiana</strong>s para<br />

el caso bivariable.<br />

Ejercicio 6. Sean X1,X2,...,XN, N variables aleatorias <strong>Gaussiana</strong>s independientes.<br />

Demostrar que su distribución conjunta es la <strong>Gaussiana</strong> multivariable, es decir,<br />

X1,X2,...,XN son conjuntamente <strong>Gaussiana</strong>s.<br />

10<br />

ay1<br />

y1<br />

x1