Perceptron, Hopfieldova síť - eAMOS

Perceptron, Hopfieldova síť - eAMOS

Perceptron, Hopfieldova síť - eAMOS

You also want an ePaper? Increase the reach of your titles

YUMPU automatically turns print PDFs into web optimized ePapers that Google loves.

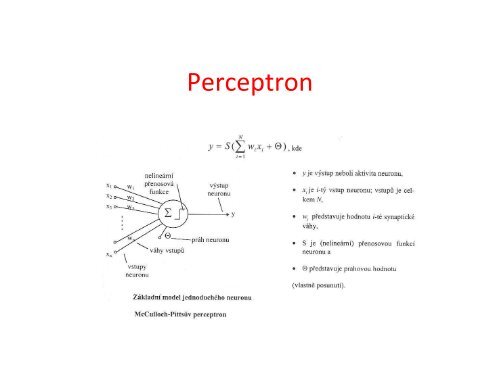

<strong>Perceptron</strong>

Přenosové funkce

Rosenblattův perceptron Rosenblatt – r. 1958. Inspirace lidským okem Podle fyziologického vzoru je třívrstvá: Vstupní vrstva – rozvětvovací – jejím úkolem je mapovánídvourozměrného pole čidel na jednorozměrný vektorpřenosových elementů Druhá vrstva – detektory rysů – detekce příznaků (démony) Třetí vrstva – rozpoznávače vzorů Váhy na první a druhé vrstvě jsou pevné, váhy natřetí nastavujeme při učení (proto tuto vrstvupočítáme mezi jednovrstvé, i když jsou zde třivrstvy)

Rosenblattův perceptron

Rosenblattův perceptron Vlastní procesorové elementy se liší podlevrstev (další obrázek) Přenosová charakteristika neuronu Přenosová charakteristika neuronuperceptronové vrstvy je následující: výstupje nulový, je-li vážený součet všech jehovstupů nulový nebo záporný. V opačnémpřípadě je výstup roven jedné(Heavisideova aktivační funkce)

Rosenblattův perceptron –základní prvky

<strong>Perceptron</strong>Rozdíl mezi McCulloch-Pittsovýmperceptronem a perceptronem podleRosenblatta lze vyjádřit takto:Rosenblatt = McCulloch-Pitts + učící algoritmu

Učící algoritmus perceptronuMP perceptron – zjednodušený Rosenblattův(základem je vždy McCulloch-Pittsův perceptron)

Učící algoritmus perceptronu

Učící algoritmus perceptronu je chyba perceptronu (odchylka jehoskutečného binárního výstupu y odpožadovaného d, s j je jeho vnitřní potenciál symbol η značí učící krok (učící koeficient -nabývá hodnot

Geometrická interpretace učení

Geometrická interpretace učeníperceptron naučený pro klasifikaci

Lineárně separovatelné a neseparovatelné množiny(XOR funkce, kritika neuronových sítí 1969)

ADALINE (Adaptive Linear Neuron)

ADALINE (Adaptive Linear Neuron) Zatímco u klasického perceptronu je vstupem doučícího bloku dvouhodnotový výstup neuronu je uADALINE vstupem vnitřní potenciál neuronu Učící algoritmus minimalizuje Euklidovu vzdálenostpožadované odezvy sítě a vnitřního potenciáluneuronu, tedy střední kvadratickou odchylku (LMS-Least Mean Squares) Tomuto algoritmu se také říká Widrow-Hoffovo deltapravidlo (jde o gradientní metodu)

<strong>Hopfieldova</strong> <strong>síť</strong>Jednovrstvá <strong>síť</strong>, zpětnovazební (rekurzivní) a binárníNeuronem Hopfieldovy sítě je klasický McCulloh-Pitsův perceptronSkládá se z tolika neuronů, kolik má vstupů (pokud např. učíme <strong>síť</strong>obrázky, odpovídá každý pixel jednomu neuronuVýstup každého neuronu se vede zpět na vstupy ostatních neuronůpřes synaptické váhy w ij (tak vznikají zpětnovazebné smyčky) – tímvzniká diagonálně symetrická matice vah (váhy na spojích z jednohodo druhého neuronu jsou stejné v obou směrechPráh je nulový Všechny signály jsou binární (nabývají hodnot 0,1 nebo –1,+1)<strong>Hopfieldova</strong> <strong>síť</strong> patří mezi asociativní paměti. Její odpovědí napředložený vzor je přímo nalezený vzor

<strong>Hopfieldova</strong> <strong>síť</strong>

<strong>Hopfieldova</strong> <strong>síť</strong> – jiné znázornění(funkčně stejné s předchozím)

<strong>Hopfieldova</strong> <strong>síť</strong> Vstupy x 0 ,x 1 , …,x N-1 jsou vstupy sítě, μ 0 , μ 1 , …, μ N-1jsou stavy v jednotlivých časových krocích, kterése v následujícím kroku stávají opět vstupy.Výstupy y 0 ,y 1 , …y N-1 jsou po téměř celou dobufunkce sítě neaktivní. To se změní až po dosaženístabilního stavu při vybavování, kdy se jejichhodnota nastaví na μ 0 , μ 1 , …, μ N-1 . Vybavování jeiteračním procesem, a proto je smysluplnýmvýstupem až stav neuronů po posledním časovémkroku

<strong>Hopfieldova</strong> <strong>síť</strong> – učeníPro každý vzor vytvoříme dílčí matici dimenze NxN (N je počet vstupů). Tuto matici tvoříprvky, které vzniknou vynásobením i-tého vstupu s j-tým výstupem (je-li i=j, je prveknulový). Výsledná čtvercová matice vah vznikne jako součet všech dílčích maticjednotlivých vzorů, kterých je MPoužívá se Hammingova metrika (součet absolutních hodnot rozdílu soběodpovídajících vektorových souřadnic)

<strong>Hopfieldova</strong> <strong>síť</strong> – vybavování

<strong>Hopfieldova</strong> <strong>síť</strong> – příklad Příklad – <strong>Hopfieldova</strong> <strong>síť</strong> s120 neurony (obrazce12x10 = 120 bodů) Trénování bude pomocí120 2 =14400 vahami Bylo natrénováno 8 vzorů.Ty byly vybrány tak, abymezi vzory byla velkáHammingova vzdálenost(jinak by si byly vzorypodobné a docházelo kchybám při vybavování)

<strong>Hopfieldova</strong> <strong>síť</strong> – příkladVybavování – trojka, která bylaz 25% poškozena (náhodněbylo invertováno 30 pixelů).Potom takto poškozený obrazby přiložen na vstup –jednotlivé fáze iterace jsoupatrné z obrázku.Při vybavování hledá<strong>Hopfieldova</strong> <strong>síť</strong> ten vzor, kterýmá nejmenší Hammingovuvzdálenost od vstupního obrazu