kombiniertes data mining – klassifikation unter verwendung von ...

kombiniertes data mining – klassifikation unter verwendung von ...

kombiniertes data mining – klassifikation unter verwendung von ...

Erfolgreiche ePaper selbst erstellen

Machen Sie aus Ihren PDF Publikationen ein blätterbares Flipbook mit unserer einzigartigen Google optimierten e-Paper Software.

Kombiniertes Data Mining <strong>–</strong> Klassifikation anhand <strong>von</strong> Hilfsinformationen<br />

Die Entropie ist ein Maß für die Unreinheit einer Verteilung, d.h. z.B. für entropie(T) =<br />

0, dass eine Verteilung mit einem Splitwert S absolut rein ist und alle Objekte<br />

verschiedener Klassenzugehörigkeiten <strong>von</strong> einander getrennt wurden, während bei<br />

entropie(T) = 1 alle durch S erzeugten Partitionen die gleiche Menge an Objekten mit<br />

<strong>unter</strong>schiedlicher Klassenzugehörigkeit beinhalten.<br />

Der Informationsgewinn eines Attributs A in Bezug auf die Menge T ist nach [ES00]<br />

definiert als<br />

| Ti<br />

|<br />

informationsgewinn(T,A) = entropie ( T ) − ∑ ⋅ entropie(<br />

Ti<br />

),<br />

(2.7)<br />

| T |<br />

wobei das Attribut A jenes Attribut ist, dessen Attributausprägungen mittels eines<br />

Splitkriteriums in die vollständigen, disjunkten Partitionen T1, …, Ti geteilt wurden.<br />

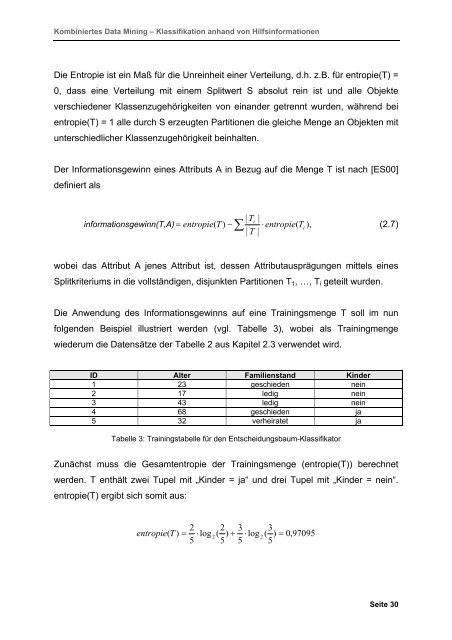

Die Anwendung des Informationsgewinns auf eine Trainingsmenge T soll im nun<br />

folgenden Beispiel illustriert werden (vgl. Tabelle 3), wobei als Trainingmenge<br />

wiederum die Datensätze der Tabelle 2 aus Kapitel 2.3 verwendet wird.<br />

ID Alter Familienstand Kinder<br />

1 23 geschieden nein<br />

2 17 ledig nein<br />

3 43 ledig nein<br />

4 68 geschieden ja<br />

5 32 verheiratet ja<br />

Tabelle 3: Trainingstabelle für den Entscheidungsbaum-Klassifikator<br />

Zunächst muss die Gesamtentropie der Trainingsmenge (entropie(T)) berechnet<br />

werden. T enthält zwei Tupel mit „Kinder = ja“ und drei Tupel mit „Kinder = nein“.<br />

entropie(T) ergibt sich somit aus:<br />

2 2 3 3<br />

entropie ( T ) = ⋅ log 2 ( ) + ⋅ log 2 ( ) = 0,<br />

97095<br />

5 5 5 5<br />

Seite 30