Können Lernalgorithmen interagieren wie im Gehirn? - Intelligent ...

Können Lernalgorithmen interagieren wie im Gehirn? - Intelligent ...

Können Lernalgorithmen interagieren wie im Gehirn? - Intelligent ...

Erfolgreiche ePaper selbst erstellen

Machen Sie aus Ihren PDF Publikationen ein blätterbares Flipbook mit unserer einzigartigen Google optimierten e-Paper Software.

2. Das Kleinhirn enthält ein internes Modell der Umgebung (Supervised Learning) und dient somit der<br />

Repräsentation der Umgebung mit zusätzlicher Fehlermin<strong>im</strong>ierung.<br />

3. Die Basalganglien werden zur Evaluierung eines gegebenen Zustands benutzt um auf der resultierenden<br />

Evaluierung basierend eine Aktion auszusuchen (Reinforcement Learning). Sie dienen somit der Aktionsselektion.<br />

Dieser Aufbau der Prinzipien entsteht aus ihren Aufgabenbereichen und lässt sich <strong>wie</strong> folgt auf das Beispiel Schw<strong>im</strong>men<br />

übertragen.<br />

1. Der Körper n<strong>im</strong>mt wahr das er sich <strong>im</strong> Wasser befindet und leitet diese Informationen weiter (Mapping von<br />

Umgebung → internes Modell).<br />

2. Die weitergereichten Informationen rufen die <strong>im</strong> Kleinhirn abgespeicherten Bewegungsabläufe ab (repräsentiert<br />

den Status „Im Wasser” mit „Schw<strong>im</strong>mbewegung”).<br />

3. Die Großhirnrinde leitet diese Informationen an die Basalganglien weiter, welche die nun geforderten Aktionen<br />

ausführt und unter Umständen andere fürs Schw<strong>im</strong>men irrelevante Aktionen hemmt.<br />

Anhand dieser drei Konstruktionsprinzipien wurden folgende Architekturen zusammengefasst, welche versuchen die<br />

gegenseitige Unterstützung der zuvor behandelten <strong>Gehirn</strong>areale abzubilden. Sie wurden zuvor bereits in [10]<br />

beschrieben und seien hier erneut benannt, um als Basis des Exper<strong>im</strong>ents zu fungieren.<br />

Aktionsselektion<br />

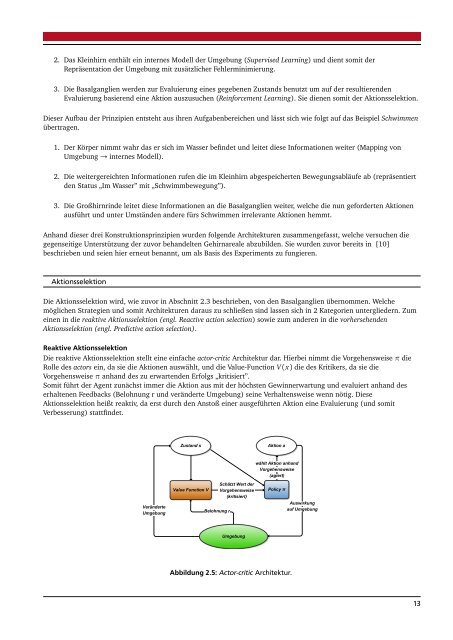

Die Aktionsselektion wird, <strong>wie</strong> zuvor in Abschnitt 2.3 beschrieben, von den Basalganglien übernommen. Welche<br />

möglichen Strategien und somit Architekturen daraus zu schließen sind lassen sich in 2 Kategorien untergliedern. Zum<br />

einen in die reaktive Aktionsselektion (engl. Reactive action selection) so<strong>wie</strong> zum anderen in die vorhersehenden<br />

Aktionsselektion (engl. Predictive action selection).<br />

Reaktive Aktionsselektion<br />

Die reaktive Aktionsselektion stellt eine einfache actor-critic Architektur dar. Hierbei n<strong>im</strong>mt die Vorgehensweise π die<br />

Rolle des actors ein, da sie die Aktionen auswählt, und die Value-Function V (x) die des Kritikers, da sie die<br />

Vorgehensweise π anhand des zu erwartenden Erfolgs „kritisiert”.<br />

Somit führt der Agent zunächst <strong>im</strong>mer die Aktion aus mit der höchsten Gewinnerwartung und evaluiert anhand des<br />

erhaltenen Feedbacks (Belohnung r und veränderte Umgebung) seine Verhaltensweise wenn nötig. Diese<br />

Aktionsselektion heißt reaktiv, da erst durch den Anstoß einer ausgeführten Aktion eine Evaluierung (und somit<br />

Verbesserung) stattfindet.<br />

Zustand s<br />

Aktion a<br />

wählt Aktion anhand<br />

Vorgehensweise<br />

(agiert)<br />

Veränderte<br />

Umgebung<br />

Value Function V<br />

Belohnung r<br />

Schätzt Wert der<br />

Vorgehensweise<br />

(kritisiert)<br />

Policy π<br />

Auswirkung<br />

auf Umgebung<br />

Umgebung<br />

Abbildung 2.5: Actor-critic Architektur.<br />

13