Skript - Universität Bayreuth

Skript - Universität Bayreuth

Skript - Universität Bayreuth

Sie wollen auch ein ePaper? Erhöhen Sie die Reichweite Ihrer Titel.

YUMPU macht aus Druck-PDFs automatisch weboptimierte ePaper, die Google liebt.

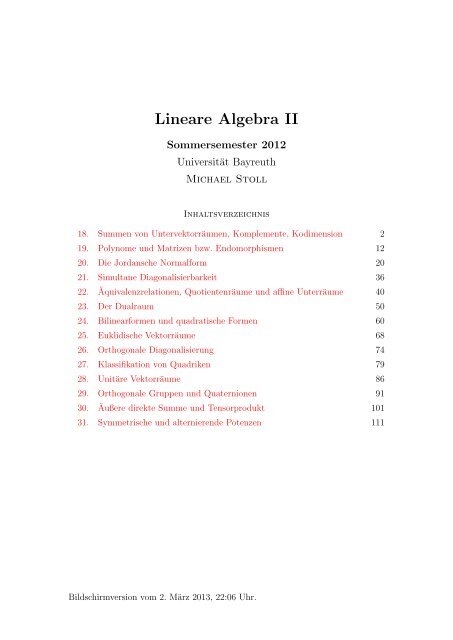

Lineare Algebra II<br />

Sommersemester 2012<br />

<strong>Universität</strong> <strong>Bayreuth</strong><br />

Michael Stoll<br />

Inhaltsverzeichnis<br />

18. Summen von Untervektorräumen, Komplemente, Kodimension 2<br />

19. Polynome und Matrizen bzw. Endomorphismen 12<br />

20. Die Jordansche Normalform 20<br />

21. Simultane Diagonalisierbarkeit 36<br />

22. Äquivalenzrelationen, Quotientenräume und affine Unterräume 40<br />

23. Der Dualraum 50<br />

24. Bilinearformen und quadratische Formen 60<br />

25. Euklidische Vektorräume 68<br />

26. Orthogonale Diagonalisierung 74<br />

27. Klassifikation von Quadriken 79<br />

28. Unitäre Vektorräume 86<br />

29. Orthogonale Gruppen und Quaternionen 91<br />

30. Äußere direkte Summe und Tensorprodukt 101<br />

31. Symmetrische und alternierende Potenzen 111<br />

Bildschirmversion vom 2. März 2013, 22:06 Uhr.

§ 18. Summen von Untervektorräumen, Komplemente, Kodimension 2<br />

18. Summen von Untervektorräumen, Komplemente, Kodimension<br />

Unser nächstes größeres Ziel ist die Vervollständigung der Klassifikation der Endomorphismen<br />

eines endlich-dimensionalen Vektorraums V (oder äquivalent: der<br />

Klassifikation von n × n-Matrizen bis auf Ähnlichkeit) im Fall, dass das charakteristische<br />

Polynom in Linearfaktoren zerfällt (was über einem algebraisch abgeschlossenen<br />

Körper wie C immer der Fall ist). Das wird auf die sogenannte<br />

Jordan-Normalform“ führen. In diesem Zusammenhang wird es hilfreich sein,<br />

”<br />

den Vektorraum V zu zerlegen“, sodass der Endomorphismus auf den einzelnen<br />

”<br />

Teilen“ von V ein leicht überschaubares Verhalten zeigt. Dafür brauchen wir den<br />

”<br />

Begriff der direkten Summe“ von (Unter-)Vektorräumen.<br />

”<br />

Sei V ein Vektorraum. Wir erinnern uns daran, dass beliebige Durchschnitte von<br />

Untervektorräumen von V wieder Untervektorräume sind (Lemma 7.2), dass das<br />

im Allgemeinen aber nicht für Vereinigungen von Untervektorräumen gilt. Statt<br />

dessen können wir aber den kleinsten Untervektorraum betrachten, der alle betrachteten<br />

Untervektorräume (und damit ihre Vereinigung) enthält. Das führt auf<br />

folgende Definition.<br />

∗ 18.1. Definition. Seien V ein Vektorraum und (U i ) i∈I eine Familie von Unter- DEF<br />

vektorräumen von V. Dann heißt der von der Vereinigung ⋃ i∈I U i erzeugte Untervektorraum<br />

von V die Summe der Untervektorräume U i ; wir schreiben<br />

∑<br />

U i = 〈 ⋃<br />

i∈I<br />

Im Fall I = {1, 2, . . . , n} schreibt man auch<br />

statt ∑ i∈I U i.<br />

U 1 + U 2 + . . . + U n<br />

i∈I<br />

U i<br />

〉<br />

.<br />

oder<br />

Die Schreibweise erklärt sich durch die folgende Eigenschaft.<br />

n∑<br />

i=1<br />

U i<br />

♦<br />

Summe von<br />

Unter-VR<br />

18.2. Lemma. Sei V ein Vektorraum. LEMMA<br />

Elemente<br />

(1) Sind U 1 , U 2 , . . . , U n Untervektorräume von V , dann ist<br />

der Summe<br />

U 1 + U 2 + . . . + U n = {u 1 + u 2 + . . . + u n | u 1 ∈ U 1 , u 2 ∈ U 2 , . . . , u n ∈ U n } .<br />

(2) Ist (U i ) i∈I eine Familie von Untervektorräumen von V , dann ist<br />

∑ {∑<br />

}<br />

U i = u i | J ⊂ I endlich, u i ∈ U i für alle i ∈ J .<br />

i∈I<br />

i∈J<br />

Beweis. Es ist klar, dass die jeweils rechts stehende Menge in der links stehenden<br />

enthalten ist, denn ihre Elemente sind Linearkombinationen von Elementen von<br />

U 1 ∪ . . . ∪ U n bzw. ⋃ i∈I U i (Satz 7.8). Wir zeigen, dass die rechts stehende Menge<br />

ein Untervektorraum von V ist. Dann folgt analog zum Beweis von Satz 7.8, dass<br />

sie das Erzeugnis der Vereinigung der U i ist. Sei U die Menge auf der rechten Seite.<br />

Wir prüfen die drei Bedingungen für einen Untervektorraum nach (Definition 6.1).<br />

Dabei nutzen wir aus, dass die U i Untervektorräume sind.<br />

• 0 ∈ U: Wir können alle u i = 0 wählen (bzw. im zweiten Fall für J die leere<br />

Menge nehmen).

§ 18. Summen von Untervektorräumen, Komplemente, Kodimension 3<br />

• Abgeschlossenheit unter der Addition: Im ersten Fall seien<br />

u = u 1 + u 2 + . . . + u n und u ′ = u ′ 1 + u ′ 2 + . . . + u ′ n<br />

zwei Elemente von U (mit u i , u ′ i ∈ U i für alle i ∈ {1, 2, . . . , n}). Dann ist<br />

auch<br />

u + u ′ = (u 1 + u ′ 1) + (u 2 + u ′ 2) + . . . + (u n + u ′ n) ∈ U .<br />

Im zweiten Fall seien J, J ′ ⊂ I endlich und<br />

u = ∑ i∈J<br />

u i und u ′ = ∑ i∈J ′ u ′ i<br />

zwei Elemente von U. Wenn wir u i = 0 (bzw. u ′ i = 0) setzen für i ∈ J ′ \ J<br />

(bzw. i ∈ J \ J ′ ), dann gilt<br />

u + u ′ = ∑ u i + ∑ u ′ i = ∑<br />

u i + ∑<br />

u ′ i = ∑<br />

(u i + u ′ i) ∈ U .<br />

i∈J i∈J ′ i∈J∪J ′ i∈J∪J ′ i∈J∪J ′<br />

• Abgeschlossenheit unter der Skalarmultiplikation: Seien λ ein Skalar und<br />

u = u 1 + u 2 + . . . + u n bzw. u = ∑ i∈J u i ein Element von U. Dann ist<br />

λu = λu 1 + λu 2 + . . . + λu n bzw. λu = ∑ i∈J<br />

λu i<br />

wieder ein Element von U.<br />

□<br />

18.3. Beispiele. BSP<br />

Summen von<br />

• Ist I = ∅, dann ist ∑ i∈I U i = {0} der Null-Vektorraum.<br />

Unter-VR<br />

• Ist U ⊂ V ein Untervektorraum, dann gilt U + U = U.<br />

• Ist V ein Vektorraum, I eine Menge und sind (für i ∈ I) A i ⊂ V beliebige<br />

Teilmengen, dann gilt<br />

∑<br />

〈A i 〉 = 〈 ⋃ 〉<br />

A i .<br />

i∈I<br />

i∈I<br />

(Beweis als Übung.) Das bedeutet: Ist A i ein Erzeugendensystem von U i<br />

(für alle i ∈ I), dann ist ⋃ i∈I A i ein Erzeugendensystem von ∑ i∈I U i. ♣<br />

Was kann man über die Dimension von U = U 1 + U 2 sagen? Da U 1 ⊂ U und<br />

U 2 ⊂ U, gilt jedenfalls<br />

dim U ≥ max{dim U 1 , dim U 2 }<br />

(und Gleichheit ist möglich, nämlich genau dann, wenn U 1 ⊂ U 2 oder U 2 ⊂ U 1 ).<br />

Wie groß kann dim U höchstens werden? Wenn B 1 eine Basis von U 1 und B 2 eine<br />

Basis von U 2 ist, dann ist nach dem obigen Beispiel B 1 ∪B 2 ein Erzeugendensystem<br />

von U, also gilt<br />

dim U ≤ #(B 1 ∪ B 2 ) ≤ #B 1 + #B 2 = dim U 1 + dim U 2 .<br />

Der folgende Satz gibt genauere Auskunft.

§ 18. Summen von Untervektorräumen, Komplemente, Kodimension 4<br />

∗ 18.4. Satz. Sei V ein Vektorraum mit Untervektorräumen U 1 und U 2 . Dann gilt SATZ<br />

Dimension<br />

dim(U 1 + U 2 ) + dim(U 1 ∩ U 2 ) = dim U 1 + dim U 2 .<br />

der Summe<br />

Daran sieht man, dass dim(U 1 + U 2 ) = dim U 1 + dim U 2 genau dann gilt, wenn U 1<br />

und U 2 den kleinstmöglichen Durchschnitt {0} haben (vorausgesetzt, alle Dimensionen<br />

sind endlich).<br />

Beweis. Ist dim U 1 = ∞ oder dim U 2 = ∞, dann ist auch dim(U 1 + U 2 ) = ∞<br />

(denn U 1 , U 2 ⊂ U 1 + U 2 ), und die Gleichung stimmt. Wir können also annehmen,<br />

dass U 1 und U 2 beide endlich-dimensional sind, etwa dim U 1 = n 1 und dim U 2 =<br />

n 2 . Sei m = dim(U 1 ∩ U 2 ) ≤ min{n 1 , n 2 }. Wir wählen eine Basis (b 1 , b 2 , . . . , b m )<br />

von U 1 ∩U 2 , die wir einerseits zu einer Basis (b 1 , . . . , b m , b ′ m+1, b ′ m+2, . . . , b ′ n 1<br />

) von U 1<br />

und andererseits zu einer Basis (b 1 , . . . , b m , b ′′ m+1, b ′′ m+2, . . . , b ′′ n 2<br />

) von U 2 ergänzen<br />

(Basisergänzungssatz mit Folgerung 8.16). Ich behaupte, dass<br />

B = (b 1 , . . . , b m , b ′ m+1, b ′ m+2, . . . , b ′ n 1<br />

, b ′′ m+1, b ′′ m+2, . . . , b ′′ n 2<br />

)<br />

eine Basis von U 1 + U 2 ist. Daraus folgt die Gleichung im Satz, denn<br />

dim(U 1 + U 2 ) = #B = m + (n 1 − m) + (n 2 − m) = n 1 + n 2 − m .<br />

Es bleibt die Behauptung zu zeigen. Es ist klar, dass B ein Erzeugendensystem<br />

von U 1 + U 2 ist, denn B enthält Erzeugendensysteme von U 1 und von U 2 . Wir<br />

müssen also noch nachweisen, dass B linear unabhängig ist. Seien also λ i (für<br />

i ∈ {1, 2, . . . , m}), λ ′ i (für i ∈ {m + 1, . . . , n 1 }) und λ ′′<br />

i (für i ∈ {m + 1, . . . , n 2 })<br />

Skalare mit<br />

λ 1 b 1 + . . . + λ m b m + λ ′ m+1b ′ m+1 + . . . + λ ′ n 1<br />

b ′ n 1<br />

+ λ ′′ m+1b ′′ m+1 + . . . + λ ′′ n 2<br />

b ′′ n 2<br />

= 0 .<br />

Wir schreiben diese Gleichung als<br />

u = λ 1 b 1 + . . . + λ m b m + λ ′ m+1b ′ m+1 + . . . + λ ′ n 1<br />

b ′ n<br />

} {{ } 1<br />

= −λ ′′ m+1b ′′ m+1 − . . . − λ ′′ n 2<br />

b ′′ n<br />

} {{ } 2<br />

∈U 1<br />

∈U 2<br />

.<br />

Wir sehen, dass u ∈ U 1 ∩ U 2 ist, also ist u eine Linearkombination von b 1 , . . . , b m .<br />

Da b 1 , . . . , b m , b ′ m+1, . . . , b ′ n 1<br />

und b 1 , . . . , b m , b ′′ m+1, . . . , b ′′ n 2<br />

jeweils linear unabhängig<br />

sind (als Basen von U 1 und U 2 ), müssen<br />

λ ′ m+1 = . . . = λ ′ n 1<br />

= λ ′′ m+1 = . . . = λ ′′ n 2<br />

= 0<br />

sein; daraus folgt dann auch λ 1 = . . . = λ m = 0.<br />

Man kann sich die Aussage ganz gut mit Hilfe der analogen Aussage über Kardinalitäten<br />

von Mengen merken:<br />

#(M 1 ∪ M 2 ) + #(M 1 ∩ M 2 ) = #M 1 + #M 2 .<br />

Tatsächlich beruht obiger Beweis auf dieser Relation, wobei die Mengen Basen der<br />

vorkommenden Untervektorräume sind. Allerdings darf man diese Analogie auch<br />

nicht zu weit treiben: Die für Mengen gültige Relation<br />

#(M 1 ∪ M 2 ∪ M 3 ) + #(M 1 ∩ M 2 ) + #(M 1 ∩ M 3 ) + #(M 2 ∩ M 3 )<br />

= #M 1 + #M 2 + #M 3 + #(M 1 ∩ M 2 ∩ M 3 )<br />

übersetzt sich nicht in eine analoge Dimensionsformel (Übung).<br />

Besonders interessant ist der Fall U 1 ∩ U 2 = {0}.<br />

□

§ 18. Summen von Untervektorräumen, Komplemente, Kodimension 5<br />

18.5. Lemma. Sei V ein Vektorraum mit Untervektorräumen U 1 und U 2 . Dann LEMMA<br />

sind die folgenden Aussagen äquivalent:<br />

Summe direkt<br />

(1) U 1 ∩ U 2 = {0}.<br />

(2) Jedes Element u ∈ U 1 + U 2 lässt sich eindeutig schreiben als u = u 1 + u 2<br />

mit u 1 ∈ U 1 und u 2 ∈ U 2 .<br />

Ist U 1 + U 2 endlich-dimensional, dann sind beide Aussagen äquivalent zu<br />

(3) dim(U 1 + U 2 ) = dim U 1 + dim U 2 .<br />

Beweis. Die Äquivalenz von (1) und (3) (unter der angegebenen Voraussetzung)<br />

folgt direkt aus der Dimensionsformel in Satz 18.4. Wir zeigen noch die Äquivalenz<br />

von (1) und (2).<br />

Es gelte (1) und es sei u = u 1 + u 2 = u ′ 1 + u ′ 2 mit u 1 , u ′ 1 ∈ U 1 und u 2 , u ′ 2 ∈ U 2 .<br />

Daraus folgt u 1 − u ′ 1 = u ′ 2 − u 2 ∈ U 1 ∩ U 2 = {0}, also u 1 = u ′ 1 und u 2 = u ′ 2.<br />

Jetzt gelte (2) und es sei u ∈ U 1 ∩ U 2 . Dann sind 0 = 0 + 0 = u + (−u) zwei<br />

Darstellungen des Nullvektors; aus der Eindeutigkeit der Summendarstellung folgt<br />

also u = 0.<br />

□<br />

18.6. Definition. Wenn die Aussagen in Lemma 18.5 gelten, dann heißt die DEF<br />

Summe von U 1 und U 2 direkt.<br />

♦ direkte<br />

Eigenschaft (1) in Lemma 18.5 lässt sich auch so ausdrücken:<br />

∀u 1 ∈ U 1 , u 2 ∈ U 2 : ( u 1 + u 2 = 0 ⇒ u 1 = u 2 = 0 ) .<br />

Summe<br />

zweier UVR<br />

In dieser Form lässt sie sich verallgemeinern.<br />

∗ 18.7. Definition. Seien V ein Vektorraum und (U i ) i∈I eine Familie von Unter- DEF<br />

vektorräumen von V. Dann heißt die Summe der U i direkt, wenn für jede endliche direkte<br />

Teilmenge J ⊂ I und beliebige Elemente u i ∈ U i für i ∈ J gilt<br />

Summe<br />

∑<br />

u i = 0 =⇒ ∀i ∈ J : u i = 0 .<br />

i∈J<br />

Ist V = ∑ i∈I U i und die Summe direkt, dann schreiben wir auch<br />

V = ⊕ i∈I<br />

U i<br />

bzw. V = U 1 ⊕ U 2 ⊕ . . . ⊕ U n , wenn I = {1, 2, . . . , n} ist.<br />

♦<br />

Lemma 18.5 hat dann die folgende Verallgemeinerung.<br />

18.8. Lemma. Seien V ein Vektorraum und (U i ) i∈I eine Familie von Untervek- LEMMA<br />

torräumen von V. Dann sind die folgenden Aussagen äquivalent:<br />

(1) Für jedes i ∈ I gilt U i ∩ ∑ j∈I\{i} U j = {0}.<br />

direkte<br />

Summe<br />

(2) Die Summe der U i ist direkt.<br />

Ist I endlich und ∑ i∈I U i endlich-dimensional, dann sind die Aussagen äquivalent<br />

zu<br />

(3) dim ∑ i∈I U i = ∑ i∈I dim U i.

§ 18. Summen von Untervektorräumen, Komplemente, Kodimension 6<br />

Beweis. (1)⇒(2)“: Sei J ⊂ I endlich und seien u ” i ∈ U i für i ∈ J mit ∑ i∈J u i = 0.<br />

Sei i 0 ∈ J. Dann ist<br />

u i0 =<br />

∑<br />

(−u i ) ∈ U i0 ∩<br />

∑<br />

U i = {0} ,<br />

i∈J\{i 0 }<br />

i∈I\{i 0 }<br />

also ist u i0 = 0. Da i 0 ∈ J beliebig war, müssen alle u i = 0 sein; damit ist die<br />

Summe direkt.<br />

” (2)⇒(1)“: Sei i ∈ I und u ∈ U i ∩ ∑ j∈I\{i} U j. Dann gibt es J ⊂ I \ {i} endlich<br />

und Elemente u j ∈ U j für j ∈ J, sodass<br />

∑<br />

u j = u , also (−u) + ∑ u j = 0<br />

j∈J<br />

j∈J<br />

ist, wobei −u als Element von U i betrachtet wird. Definition 18.7 besagt dann,<br />

dass u = 0 sein muss.<br />

” (2)⇒(3)“: Ist ∑ i∈I U i endlich-dimensional, dann gilt das auch für alle U i (denn<br />

sie sind in der Summe enthalten). Für jedes i ∈ I sei B i eine Basis von U i , dann<br />

ist B = ⋃ i∈I B i ein (endliches) Erzeugendensystem von ∑ i∈I U i.<br />

B ist linear unabhängig: Sei B i = {b i1 , b i2 , . . . , b imi } mit m i = dim U i und seien λ ij<br />

Skalare mit<br />

∑ ∑m i<br />

λ ij b ij = 0 .<br />

i∈I j=1<br />

} {{ }<br />

∈U i<br />

Weil die Summe direkt ist, folgt ∑ m i<br />

j=1 λ ijb ij = 0 für alle i ∈ I und dann λ ij = 0<br />

für alle j ∈ {1, 2, . . . , m i }, weil B i eine Basis ist. Als linear unabhängiges Erzeugendensystem<br />

ist B eine Basis von ∑ i∈I U i, also gilt<br />

dim ∑ i∈I<br />

U i = #B = ∑ i∈I<br />

#B i = ∑ i∈I<br />

dim U i .<br />

” (3)⇒(1)“: Es gilt ∑<br />

dim U i = dim ∑ U i ≤ dim U i + dim ∑<br />

U j<br />

i∈I<br />

i∈I<br />

j∈I\{i}<br />

≤ dim U i + ∑<br />

dim U j = ∑ dim U i ,<br />

j∈I\{i} i∈I<br />

also muss überall Gleichheit herrschen. Aus Satz 18.4 folgt dann<br />

U i ∩ ∑<br />

U j = {0} .<br />

j∈I\{i}<br />

□<br />

18.9. Beispiel. Hier ist ein Beispiel, das zeigt, dass die vielleicht erst einmal BSP<br />

näher liegende Version ”<br />

∀i, j ∈ I : i ≠ j ⇒ U i ∩ U j = {0}“ für Bedingung (1)<br />

nicht ausreichend ist.<br />

Seien V = R 2 , U 1 = 〈(1, 0)〉, U 2 = 〈(0, 1)〉 und U 3 = 〈(1, 1)〉. Dann gilt offenbar<br />

U 1 ∩ U 2 = U 1 ∩ U 3 = U 2 ∩ U 3 = {(0, 0)} ,<br />

aber die Summe U 1 + U 2 + U 3 ist nicht direkt. Zum Beispiel gilt<br />

(0, 0) = (1, 0) + (0, 1) + (−1, −1)<br />

als Summe je eines Elements von U 1 , U 2 und U 3 .<br />

♣

§ 18. Summen von Untervektorräumen, Komplemente, Kodimension 7<br />

Eine Zerlegung von V als direkte Summe, V = U 1 ⊕ U 2 , führt in natürlicher Weise<br />

zu zwei linearen Abbildungen π 1 : V → U 1 und π 2 : V → U 2 . Wir erhalten sie<br />

wie folgt: Jedes v ∈ V lässt sich eindeutig schreiben als v = u 1 + u 2 mit u 1 ∈ U 1<br />

und u 2 ∈ U 2 . Dann ist π 1 (v) = u 1 und π 2 (v) = u 2 . Diese Abbildungen sind linear,<br />

weil λv = λu 1 + λu 2 ist, und für v ′ = u ′ 1 + u ′ 2 gilt v + v ′ = (u 1 + u ′ 1) + (u 2 + u ′ 2).<br />

Außerdem sind π 1 und π 2 surjektiv, denn π 1 | U1 = id U1 und π 2 | U2 = id U2 .<br />

18.10. Definition. Die Abbildungen π 1 und π 2 heißen die Projektionen von V DEF<br />

auf U 1 bzw. U 2 bezüglich der Zerlegung V = U 1 ⊕ U 2 .<br />

♦ Projektionen<br />

Wenn wir mit p 1 , p 2 : V → V die Abbildungen bezeichnen, die durch p i (v) = π i (v)<br />

gegeben sind (sie unterscheiden sich von π 1 und π 2 nur durch den vergrößerten<br />

Wertebereich), dann gilt<br />

p 1 ◦ p 1 = p 1 , p 2 ◦ p 2 = p 2 und p 1 + p 2 = id V .<br />

Umgekehrt gilt: Ist p : V → V ein ”<br />

Projektor“, d.h. eine lineare Abbildung mit<br />

p ◦ p = p, dann gilt V = im(p) ⊕ ker(p), wobei ker(p) = im(id V −p) ist (Übung).<br />

Mit p ′ = id V −p gilt dann auch p ′ ◦ p ′ = p ′ und p + p ′ = id V .<br />

Wir führen jetzt noch zwei Begriffe ein, die manchmal nützlich sind.<br />

∗ 18.11. Definition. Seien V ein Vektorraum und U ⊂ V ein Untervektorraum. DEF<br />

Ein weiterer Untervektorraum U ′ ⊂ V heißt komplementär zu U oder ein Komplement<br />

von U in V, wenn V = U ⊕ U ′ gilt. (Das bedeutet U ∩ U ′ = {0} und<br />

Komplement<br />

U + U ′ = V .)<br />

♦<br />

18.12. Beispiele. BSP<br />

• V ist das einzige Komplement von {0} in V und {0} ist das einzige Komplement<br />

Komplemente<br />

von V in<br />

V.<br />

• Normalerweise gibt es aber viele Komplemente. Sei zum Beispiel V = R 2<br />

und U = 〈(1, 0)〉 ⊂ V. Dann sind die Komplemente von U gerade alle<br />

Untervektorräume der Form U ′ = 〈(a, 1)〉 mit a ∈ R beliebig. ♣<br />

Gibt es immer ein Komplement?<br />

18.13. Satz. Seien V ein endlich-dimensionaler Vektorraum und U ⊂ V ein SATZ<br />

Untervektorraum. Dann gibt es ein Komplement U ′ von U in V. Es gilt dann<br />

dim U + dim U ′ = dim V .<br />

Existenz von<br />

Komplementen<br />

Beweis. Sei m = dim U ≤ dim V = n. Wir wählen eine Basis (b 1 , b 2 , . . . , b m )<br />

von U und ergänzen sie zu einer Basis (b 1 , . . . , b m , b m+1 , . . . , b n ) von V. Dann ist<br />

U ′ = 〈b m+1 , . . . , b n 〉 ein Komplement von U:<br />

U + U ′ = 〈b 1 , . . . , b m , b m+1 , . . . , b n 〉 = V und U ∩ U ′ = {0} ,<br />

weil b 1 , . . . , b n linear unabhängig sind. Die Dimensionsformel folgt aus Lemma 18.5.<br />

□

§ 18. Summen von Untervektorräumen, Komplemente, Kodimension 8<br />

Derselbe Beweis zeigt, dass es auch in beliebigen Vektorräumen stets Komplemente gibt,<br />

wenn man den Basisergänzungssatz für Mengen verwendet, der mit Hilfe des Zornschen<br />

Lemmas bewiesen wurde. Vergleiche die Diskussion nach Satz 8.14.<br />

Wir sehen hier insbesondere, dass alle Komplemente von U dieselbe Dimension<br />

dim V −dim U haben. Das gilt ganz allgemein, auch wenn V unendliche Dimension<br />

hat.<br />

18.14. Lemma. Seien V ein Vektorraum und U ⊂ V ein Untervektorraum. Seien LEMMA<br />

weiter U 1 ′ und U 2 ′ zwei Komplemente von U in V. Dann sind U 1 ′ und U 2 ′ isomorph;<br />

insbesondere gilt dim U 1 ′ = dim U 2.<br />

′ Komplemente<br />

sind<br />

isomorph<br />

Beweis. Wir betrachten die lineare Abbildung φ = π ◦ ι : U 1<br />

′ → U 2; ′ dabei sei<br />

ι : U 1 ′ → V die Inklusionsabbildung und π : V → U 2 ′ die Projektion bezüglich der<br />

Zerlegung V = U ⊕ U 2. ′ Dann gilt<br />

ker(φ) = ker(π) ∩ U ′ 1 = U ∩ U ′ 1 = {0} ,<br />

also ist φ injektiv. (Die erste Gleichheit folgt daraus, dass ι injektiv ist.) Wir<br />

müssen noch zeigen, dass φ auch surjektiv ist, dann ist φ ein Isomorphismus und<br />

U 1 ′ und U 2 ′ sind isomorph. Sei dazu u 2 ∈ U 2. ′ Dann gibt es eindeutig bestimmte<br />

u ∈ U und u 1 ∈ U 1 ′ mit u 2 = u + u 1 . Wir können das auch als u 1 = (−u) + u 2<br />

lesen, woraus φ(u 1 ) = u 2 folgt.<br />

□<br />

Damit ist folgende Definition sinnvoll.<br />

∗ 18.15. Definition. Seien V ein Vektorraum und U ⊂ V ein Untervektorraum, DEF<br />

der ein Komplement U ′ in V hat. Dann heißt<br />

Kodimension<br />

die Kodimension von U in V.<br />

codim V U = dim U ′<br />

Es gilt dim U + codim V U = dim V : Ist die Kodimension klein, dann ist U ”<br />

groß“,<br />

also nicht weit davon entfernt, ganz V zu sein.<br />

18.16. Beispiel. Die Kodimension kann auch für unendlich-dimensionale Unter- BSP<br />

vektorräume endlich sein. Sei zum Beispiel P der reelle Vektorraum der Polynomfunktionen,<br />

sei a ∈ R und sei U a = {p ∈ P | p(a) = 0} = ker ev a . Dann ist<br />

Kodimension<br />

der eindimensionale Untervektorraum C = 〈x ↦→ 1〉 der konstanten Funktionen ein<br />

Komplement von U a in P (für p ∈ P gilt eindeutig p = (p−p(a))+p(a) ∈ U a +C),<br />

also ist codim P U a = 1. Dieselbe Überlegung zeigt, dass der Untervektorraum der<br />

in einem Punkt a verschwindenden Funktionen auch in anderen Funktionenräumen<br />

(alle Funktionen, stetige Funktionen, n-mal stetig differenzierbare Funktionen<br />

usw.) Kodimension 1 hat.<br />

Mit Polynomdivision (Satz 14.18) sieht man analog: Sind a 1 , a 2 , . . . , a n ∈ R paarweise<br />

verschieden und ist U a1 ,...,a n<br />

= U a1 ∩ U a2 ∩ . . . ∩ U an der Untervektorraum der<br />

Polynomfunktionen, die in a 1 , . . . , a n verschwinden, dann ist der Untervektorraum<br />

P

§ 18. Summen von Untervektorräumen, Komplemente, Kodimension 9<br />

Der Begriff der Kodimension erlaubt eine etwas genauere Formulierung des ”<br />

Rangsatzes“<br />

9.18. Zur Erinnerung: Der Satz besagt, dass für eine lineare Abbildung<br />

φ : V → W gilt<br />

dim ker(φ) + rk(φ) = dim ker(φ) + dim im(φ) = dim V .<br />

Wenn V unendlich-dimensional ist, dann ist das eine relativ schwache Aussage.<br />

Die folgende Version gibt zusätzliche Information, wenn der Rang von φ endlich<br />

ist:<br />

18.17. Satz. Sei φ : V → W eine lineare Abbildung mit rk(φ) < ∞. Dann gilt SATZ<br />

Rangsatz mit<br />

codim V ker(φ) = dim im(φ) = rk(φ) .<br />

Kodimension<br />

Beweis. Wir wählen eine Basis (b 1 , b 2 , . . . , b m ) von im(φ) (mit m = dim im(φ)).<br />

Seien weiter v 1 , v 2 , . . . , v m ∈ V Urbilder von b 1 , b 2 , . . . , b m unter φ. Dann sind<br />

v 1 , v 2 , . . . , v m linear unabhängig, denn aus<br />

folgt<br />

λ 1 v 1 + λ 2 v 2 + . . . + λ m v m = 0<br />

0 = φ(λ 1 v 1 + λ 2 v 2 + . . . + λ m v m ) = λ 1 b 1 + λ 2 b 2 + . . . + λ m b m<br />

und damit λ 1 = λ 2 = . . . = λ m = 0, weil b 1 , b 2 , . . . , b m linear unabhängig sind. Wir<br />

setzen<br />

U = 〈v 1 , v 2 , . . . , v m 〉 ⊂ V ;<br />

dann ist U ein Komplement von ker(φ) in V und dim U = m, woraus die Behauptung<br />

folgt.<br />

• U + ker(φ) = V : Sei v ∈ V , dann gibt es Skalare λ 1 , . . . , λ m mit<br />

φ(v) = λ 1 b 1 + . . . + λ m b m .<br />

Sei v ′ = v − (λ 1 v 1 + . . . + λ m v m ), dann ist<br />

φ(v ′ ) = φ(v) − (λ 1 b 1 + . . . + λ m b m ) = 0 ,<br />

also v ′ ∈ ker(φ) und v = v ′ + (λ 1 v 1 + . . . + λ m v m ) ∈ ker(φ) + U.<br />

• U ∩ ker(φ) = {0}: Sei v ∈ U ∩ ker(φ), dann gibt es Skalare λ 1 , . . . , λ m mit<br />

v = λ 1 v 1 + . . . + λ m v m . Außerdem gilt<br />

0 = φ(v) = λ 1 b 1 + . . . + λ m b m ,<br />

woraus λ 1 = . . . = λ m = 0 und damit v = 0 folgt.<br />

□<br />

Zum Abschluss dieses Abschnitts werden wir untersuchen, wann eine Zerlegung<br />

eines Vektorraums V als direkte Summe V = U 1 ⊕ U 2 ⊕ . . . ⊕ U n einer analogen<br />

Zerlegung eines Endomorphismus f von V entspricht. Dazu müssen wir erst einmal<br />

sagen, was Letzteres bedeutet.

§ 18. Summen von Untervektorräumen, Komplemente, Kodimension 10<br />

18.18. Lemma. Sei V = U 1 ⊕ U 2 ⊕ . . . ⊕ U n eine Zerlegung eines Vektorraums V LEMMA<br />

als direkte Summe von Untervektorräumen. Seien weiter<br />

direkte<br />

Summe von<br />

f 1 : U 1 → U 1 , f 2 : U 2 → U 2 , . . . , f n : U n → U n<br />

Endomorphismen<br />

lineare Abbildungen. Dann gibt es einen eindeutig bestimmten Endomorphismus f<br />

von V mit f(v) = f i (v) für alle i ∈ {1, 2, . . . , n} und alle v ∈ U i .<br />

Beweis. Jedes v ∈ V lässt sich eindeutig schreiben als v = u 1 + u 2 + . . . + u n mit<br />

u 1 ∈ U 1 , u 2 ∈ U 2 , . . . , u n ∈ U n . Wenn f(u i ) = f i (u i ) gelten soll, dann müssen wir<br />

f definieren durch<br />

f(v) = f 1 (u 1 ) + f 2 (u 2 ) + . . . + f n (u n ) .<br />

Dann gilt auch f(v) = f i (v) für v ∈ U i ; es bleibt nur noch zu zeigen, dass f linear<br />

ist. Das folgt aus<br />

f = ι 1 ◦ f 1 ◦ π 1 + ι 2 ◦ f 2 ◦ π 2 + . . . + ι n ◦ f n ◦ π n ,<br />

wobei π i : V → U i die Projektion auf U i und ι i : U i → V die Inklusionsabbildung<br />

ist. (Alternativ kann man das auch wie vor Definition 18.10 nachrechnen.) □<br />

18.19. Definition. Die Abbildung f in Lemma 18.18 heißt die direkte Summe DEF<br />

von f 1 , f 2 , . . . , f n ; wir schreiben<br />

f = f 1 ⊕ f 2 ⊕ . . . ⊕ f n .<br />

♦<br />

direkte<br />

Summe von<br />

Endomorphismen<br />

Wenn ein Endomorphismus f als direkte Summe von Endomorphismen f i geschrieben<br />

werden kann, dann muss offenbar f(U i ) ⊂ U i gelten. Wir geben dieser<br />

Eigenschaft einen Namen:<br />

18.20. Definition. Seien V ein Vektorraum, U ⊂ V ein Untervektorraum und DEF<br />

f ein Endomorphismus von V. Dann heißt U f-invariant oder invariant unter f, invarianter<br />

wenn f(U) ⊂ U gilt.<br />

♦ Untervektorraum<br />

18.21. Satz. Sei V = U 1 ⊕ U 2 ⊕ . . . ⊕ U n eine Zerlegung eines Vektorraums V als SATZ<br />

direkte Summe von Untervektorräumen. Sei weiter f ∈ End(V ). Dann lässt sich<br />

f genau dann als direkte Summe von Endomorphismen f i ∈ End(U i ) schreiben,<br />

wenn alle Untervektorräume U i invariant unter f sind.<br />

Zerlegung<br />

von Endomorphismen<br />

Beweis. Wir hatten schon gesehen, dass die Bedingung notwendig ist. Wir müssen<br />

noch zeigen, dass sie auch hinreichend ist. Es gelte also f(U i ) ⊂ U i für alle<br />

i ∈ {1, 2, . . . , n}. Dann können wir f i ∈ End(U i ) definieren durch f i (u) = f(u)<br />

für u ∈ U i ; damit gilt f = f 1 ⊕ f 2 ⊕ . . . ⊕ f n .<br />

□

§ 18. Summen von Untervektorräumen, Komplemente, Kodimension 11<br />

18.22. Beispiel. Ist f ein Endomorphismus von V und λ ein Skalar, dann ist der BSP<br />

Eigenraum E λ (f) unter f invariant (denn f(v) = λv für v ∈ E λ (f)).<br />

Ist V endlich-dimensional und f ∈ End(V ) diagonalisierbar mit paarweise verschiedenen<br />

Eigenwerten λ 1 , λ 2 , . . . , λ m , dann gilt<br />

V = E λ1 (f) ⊕ E λ2 (f) ⊕ . . . ⊕ E λm (f)<br />

(denn V hat eine Basis aus Eigenvektoren von f) und<br />

f = f 1 ⊕ f 2 ⊕ . . . ⊕ f m<br />

mit f i = λ i id Eλi (f). In diesem Fall lässt sich f also in besonders einfach gebaute<br />

Abbildungen zerlegen.<br />

♣<br />

Zerlegung<br />

bei Diagonalisierbarkeit

§ 19. Polynome und Matrizen bzw. Endomorphismen 12<br />

19. Polynome und Matrizen bzw. Endomorphismen<br />

Als wir in der Linearen Algebra I über Polynome gesprochen haben, haben wir<br />

gesehen, dass man Elemente des zu Grunde liegenden Körpers in ein Polynom<br />

einsetzen kann (Definition 14.14). Man kann aber auch allgemeinere Objekte einsetzen,<br />

zum Beispiel Matrizen.<br />

19.1. Definition. Sei K ein Körper, sei n ∈ N und seien p ∈ K[X] ein Poly- DEF<br />

nom und A ∈ Mat(n, K). Wie üblich setzen wir A 0 = I n (das Einselement des<br />

Matrizenrings Mat(n, K)) und A k+1 = A · A k für k ∈ N. Ist<br />

p = a 0 + a 1 X + a 2 X 2 + . . . + a m X m ,<br />

dann definieren wir<br />

Einsetzen<br />

von Matrizen<br />

und Endomorphismen<br />

in Polynome<br />

m∑<br />

p(A) = a j A j = a 0 I n + a 1 A + a 2 A 2 + . . . + a m A m ∈ Mat(n, K) .<br />

j=0<br />

Ist V ein K-Vektorraum und f ein Endomorphismus von V, dann setzen wir analog<br />

f ◦0 = id V und f ◦(k+1) = f ◦ f ◦k und definieren<br />

m∑<br />

p(f) = a j f ◦j = a 0 id V +a 1 f + a 2 f ◦2 + . . . + a m f ◦m ∈ End(V ) . ♦<br />

j=0<br />

Dann ist Folgendes klar: Ist A die Matrix von f bezüglich einer Basis B von V,<br />

dann ist p(A) die Matrix von p(f) bezüglich B.<br />

Wir zeigen noch, dass die Abbildungen K[X] → Mat(n, K), p ↦→ p(A), und<br />

K[X] ↦→ End(V ), p ↦→ p(f), schöne Eigenschaften haben.<br />

19.2. Lemma. In der Situation von Definition 19.1 gilt für p, q ∈ K[X]: LEMMA<br />

Einsetzungs-<br />

(p + q)(A) = p(A) + q(A) und (pq)(A) = p(A) · q(A)<br />

homomor-<br />

phismus<br />

bzw.<br />

(p + q)(f) = p(f) + q(f) und (pq)(f) = p(f) ◦ q(f) .<br />

Außerdem ist 1(A) = I n und 1(f) = id V , wobei 1 das konstante Polynom 1 bezeichnet.<br />

Beweis. Das folgt aus den Rechenregeln für Matrizen bzw. Endomorphismen (also<br />

daraus, dass Mat(n, K) und End(V ) Ringe sind), zusammen mit<br />

λA = (λI n )A = A(λI n ) und λf = (λ id V ) ◦ f = f ◦ (λ id V ) . □<br />

Sind R und R ′ zwei Ringe, dann heißt eine Abbildung φ : R → R ′ ein Ringhomomorphismus,<br />

wenn φ(1 R ) = 1 R ′ und für alle r 1 , r 2 ∈ R gilt φ(r 1 + r 2 ) = φ(r 1 ) + φ(r 2 ) und<br />

φ(r 1 r 2 ) = φ(r 1 )φ(r 2 ) (d.h., φ bildet die Einselemente aufeinander ab und ist mit Addition<br />

und Multiplikation verträglich). Die Abbildungen K[X] → Mat(n, R), p ↦→ p(A), und<br />

K[X] → End(V ), p ↦→ p(f), sind also Ringhomomorphismen. Weil sie dadurch gegeben<br />

sind, dass man etwas in die Polynome einsetzt, heißen sie auch Einsetzungshomomorphismen.<br />

Mehr über Ringe im Allgemeinen und Polynomringe im Besonderen gibt es in der<br />

Einführung in die Zahlentheorie und algebraische Strukturen“.<br />

”

§ 19. Polynome und Matrizen bzw. Endomorphismen 13<br />

19.3. Beispiel. Sei A ∈ Mat(n, K), sei v ∈ E λ (A) und p ∈ K[X]. Dann gilt BSP<br />

p(A) · v = p(λ)v .<br />

♣<br />

Sei eine Matrix A ∈ Mat(n, K) gegeben. Dann kann man sich fragen, ob es stets<br />

ein Polynom p ∈ K[X] gibt mit p(A) = 0 (und p ≠ 0), bzw. was man über die<br />

Menge solcher Polynome mit ”<br />

Nullstelle“ A aussagen kann.<br />

Die erste Frage kann man leicht beantworten.<br />

19.4. Lemma. Seien K ein Körper und A ∈ Mat(n, K). Dann gibt es ein nor- LEMMA<br />

miertes Polynom p ∈ K[X] mit deg(p) ≤ n 2 , sodass p(A) = 0 ist.<br />

Beweis. Der Beweis ist eine schöne Anwendung grundlegender Resultate der Linearen<br />

Algebra. Mat(n, K) ist ein K-Vektorraum der Dimension n 2 , also müssen<br />

die n 2 + 1 Elemente A 0 , A 1 , A 2 , . . . , A n2 ∈ Mat(n, K) linear abhängig sein. Es<br />

gibt also λ 0 , λ 1 , . . . , λ n 2 ∈ K, nicht alle null, mit ∑ n 2<br />

j=0 λ jA j = 0. Wir setzen<br />

m = max{j | λ j ≠ 0}. Nach eventueller Multiplikation mit λ −1<br />

m können wir λ m = 1<br />

annehmen. Die Behauptung folgt dann mit p = ∑ m<br />

j=0 λ jX j . □<br />

Die zweite Frage kann man wie folgt beantworten:<br />

19.5. Lemma. Seien K ein Körper und A ∈ Mat(n, K). Sei LEMMA<br />

P (A) = {p ∈ K[X] | p(A) = 0} .<br />

Dann gilt:<br />

(1) 0 ∈ P (A).<br />

(2) Aus p, q ∈ P (A) folgt p + q ∈ P (A).<br />

(3) Aus p ∈ P (A), q ∈ K[X] folgt qp ∈ P (A).<br />

Beweis. Die erste Aussage ist klar. Die beiden anderen sieht man so:<br />

(p+q)(A) = p(A)+q(A) = 0+0 = 0 und (qp)(A) = q(A)·p(A) = q(A)·0 = 0 .<br />

□<br />

Sei R ein kommutativer Ring. Eine Teilmenge I ⊂ R heißt ein Ideal von R, wenn I die<br />

obigen Eigenschaften hat:<br />

0 ∈ I , r, r ′ ∈ I ⇒ r + r ′ ∈ I , r ∈ R, r ′ ∈ I ⇒ rr ′ ∈ I .<br />

Ist φ : R → R ′ ein Ringhomomorphismus, dann zeigt derselbe Beweis wie oben, dass<br />

sein Kern ker(φ) = {r ∈ R | φ(r) = 0} ein Ideal von R ist.<br />

Die Tatsache, dass es im Polynomring eine ”<br />

Division mit Rest“ gibt, führt zu einer<br />

einfachen Beschreibung von P (A).

§ 19. Polynome und Matrizen bzw. Endomorphismen 14<br />

19.6. Satz. Seien K ein Körper, n ∈ N und A ∈ Mat(n, K). Dann gibt es ein SATZ<br />

eindeutig bestimmtes normiertes Polynom m A ≠ 0 kleinsten Grades in P (A), und<br />

P (A) = {qm A | q ∈ K[X]}<br />

Minimalpolynom<br />

besteht genau aus den Vielfachen von m A .<br />

Beweis. Nach Lemma 19.4 gibt es Polynome ≠ 0 in P (A), also gibt es normierte<br />

(denn man kann durch den Leitkoeffizienten teilen) Polynome in P (A). Sei m A ein<br />

solches mit minimalem Grad. Ist p ein weiteres normiertes Polynom in P (A) mit<br />

deg(p) = deg(m A ), dann ist p−m A ∈ P (A) entweder das Nullpolynom (und damit<br />

p = m A ) oder 0 ≤ deg(p − m A ) < deg(m A ). Nach Division durch den Leitkoeffizienten<br />

würde man dann ein normiertes Polynom in P (A) mit kleinerem Grad<br />

als deg(m A ) erhalten, im Widerspruch zur Wahl von m A . Also ist m A eindeutig<br />

bestimmt. Wir sehen auch, dass deg(m A ) = min{deg(p) | 0 ≠ p ∈ P (A)} ist.<br />

Nach Lemma 19.5 ist klar, dass {qm A | q ∈ K[X]} ⊂ P (A) ist. Sei umgekehrt<br />

p ∈ P (A). Dann gibt es q, r ∈ K[X] mit p = qm A + r und deg(r) < deg(m A )<br />

(Satz 14.18). Es folgt r ∈ P (A), und wegen deg(r) < deg(m A ) muss r = 0 sein.<br />

Damit ist p = qm A , also hat man auch die umgekehrte Inklusion.<br />

□<br />

Derselbe Beweis zeigt, dass jedes Ideal I von K[X] die Form I = {pa | p ∈ K[X]} hat mit<br />

einem geeigneten a ∈ K[X] (a = 0 ist möglich, dann ist I = {0}). So ein Ideal, dessen<br />

Elemente genau die Vielfachen eines Elements a sind, heißt ein Hauptideal, und ein Ring,<br />

in dem jedes Ideal ein Hauptideal ist, ist ein Hauptidealring. Wir haben also gezeigt,<br />

dass K[X] ein solcher Hauptidealring ist. Ein anderes Beispiel für einen Hauptidealring<br />

ist der Ring Z der ganzen Zahlen. Der Beweis ist im Wesentlichen der gleiche, nur dass<br />

man Division mit Rest von ganzen Zahlen verwendet statt der Polynomdivision.<br />

19.7. Definition. Das Polynom m A in Satz 19.6 heißt das Minimalpolynom DEF<br />

von A. Ist f ein Endomorphismus eines endlich-dimensionalen Vektorraums, der<br />

bezüglich einer geeigneten Basis durch A beschrieben wird, dann heißt m f = m A<br />

Minimalpolynom<br />

das Minimalpolynom von f.<br />

♦<br />

19.8. Beispiele. Seien n ≥ 1 und A ∈ Mat(n, K). BSP<br />

Minimalpolynome<br />

(1) Sei A = 0 die Nullmatrix. Dann ist m A = X.<br />

(2) Ist A = λI n , dann ist m A = X − λ. Die Umkehrung gilt ebenfalls.<br />

(3) Ist A diagonalisierbar und hat die (paarweise verschiedenen) Eigenwerte<br />

λ 1 , . . . , λ m , dann ist<br />

m A = (X − λ 1 )(X − λ 2 ) · · · (X − λ m ) .<br />

Das Minimalpolynom zerfällt also in Linearfaktoren und hat keine mehrfachen<br />

Nullstellen. Das sieht man so: Jedes Element v von K n lässt sich<br />

schreiben als v = v 1 + . . . + v m mit v j ∈ E λj (A). Wegen Av j = λ j v j ist<br />

dann mit p = (X − λ 1 )(X − λ 2 ) · · · (X − λ m )<br />

p(A) · v = p(A) · v 1 + p(A) · v 2 + . . . + p(A) · v m<br />

= p(λ 1 )v 1 + p(λ 2 )v 2 + . . . + p(λ m )v m = 0 ,<br />

also ist p ein Vielfaches von m A . Auf der anderen Seite gibt es für jedes<br />

j ∈ {1, 2, . . . , m} ein 0 ≠ v j ∈ E λj (A), und es muss gelten<br />

0 = m A (A) · v j = m A (λ j )v j , also ist m A (λ j ) = 0 .

§ 19. Polynome und Matrizen bzw. Endomorphismen 15<br />

Das Minimalpolynom m A muss also alle λ j als Nullstellen haben und damit<br />

ist m A ein Vielfaches von p. Weil beide normiert sind, müssen sie gleich<br />

sein.<br />

Da das charakteristische Polynom von A die Form<br />

(X − λ 1 ) e 1<br />

(X − λ 2 ) e2 · · · (X − λ m ) em<br />

hat, wobei die e j ≥ 1 (für j ∈ {1, 2, . . . , m}) die algebraischen Vielfachheiten<br />

der Eigenwerte sind, sehen wir, dass das charakteristische Polynom<br />

ein Vielfaches des Minimalpolynoms ist. Hat A n verschiedene Eigenwerte,<br />

dann sind die beiden Polynome gleich.<br />

♣<br />

19.9. Definition. Wir schreiben χ A = det(XI n − A) für das charakteristische DEF<br />

Polynom einer Matrix A ∈ Mat(n, K) und analog χ f für das charakteristische χ A<br />

Polynom eines Endomorphismus f eines endlich-dimensionalen Vektorraums. ♦<br />

Das dritte Beispiel oben wirft zwei Fragen auf:<br />

• Für A diagonalisierbar gilt, dass χ A ein Vielfaches von m A ist. Ist das auch<br />

allgemein richtig?<br />

• Gilt die Umkehrung der Beobachtung im Beispiel: Wenn m A in Linearfaktoren<br />

zerfällt und keine mehrfachen Nullstellen hat, muss dann A diagonalisierbar<br />

sein?<br />

Die erste Frage wird durch den Satz von Cayley-Hamilton beantwortet, den wir<br />

bald beweisen werden. Die zweite können wir gleich behandeln.<br />

∗ 19.10. Satz. Seien K ein Körper, n ∈ N und A ∈ Mat(n, K). Dann ist A genau SATZ<br />

dann diagonalisierbar, wenn das Minimalpolynom m A in Linearfaktoren zerfällt<br />

und keine mehrfachen Nullstellen hat.<br />

Die analoge Aussage gilt natürlich auch für Endomorphismen endlich-dimensionaler<br />

Vektorräume.<br />

Beweis. Es ist nur noch die Rückrichtung zu zeigen. Es gelte also<br />

m A = (X − λ 1 )(X − λ 2 ) · · · (X − λ m )<br />

mit paarweise verschiedenen λ 1 , λ 2 , . . . , λ m ∈ K. Für j ∈ {1, 2, . . . , m} sei<br />

p j = ∏ i≠j<br />

X − λ i<br />

λ j − λ i<br />

∈ K[X] .<br />

Dann gilt p j (λ i ) = δ ij und deg(p j ) ≤ m − 1. Für die Summe p = p 1 + p 2 + . . . + p m<br />

gilt also p(λ j ) = 1 für alle j und deg(p) < m. Es folgt p = 1, denn das Polynom<br />

p − 1 vom Grad < m hat mindestens m Nullstellen. Außerdem ist (X − λ j )p j ein<br />

Vielfaches von m A , also ist (A − λ j I n )p j (A) = 0.<br />

Sei U j = im(p j (A)) ⊂ K n . Dann gelten die folgenden Aussagen:<br />

(1) U j ⊂ E λj (A): Sei u ∈ U j , also u = p j (A) · v für ein v ∈ K n . Es folgt<br />

0 = (A − λ j I n )p j (A) · v = (A − λ j I n ) · u , also A · u = λ j u .<br />

(2) U 1 + U 2 + . . . + U m = K n : Sei v ∈ K n . Dann gilt<br />

v = p(A) · v = p 1 (A) · v + p 2 (A) · v + . . . + p m (A) · v ∈ U 1 + U 2 + . . . + U m .<br />

Kriterium<br />

für Diagonalisierbarkeit

§ 19. Polynome und Matrizen bzw. Endomorphismen 16<br />

Außerdem wissen wir ganz allgemein, dass die Summe der Eigenräume E λj (A)<br />

direkt ist (Satz 14.8). Zusammen mit den obigen beiden Aussagen folgt daraus<br />

K n = E λ1 (A) ⊕ E λ2 (A) ⊕ . . . ⊕ E λm (A), also ist A diagonalisierbar.<br />

□<br />

Damit wir dieses Kriterium anwenden können, müssen wir in der Lage sein, das<br />

Minimalpolynom zu bestimmen. Dabei wird uns die Antwort auf die erste Frage<br />

von oben helfen. Wir betrachten erst einmal 2 × 2-Matrizen (für 1 × 1-Matrizen<br />

ist die Aussage trivialerweise richtig).<br />

19.11. Beispiel. Sei A = ( a c d b ) ∈ Mat(2, K). Dann ist<br />

( )<br />

BSP<br />

a<br />

A 2 =<br />

2 + bc (a + d)b<br />

(a + d)c d 2 = (a + d)A − (ad − bc)I<br />

+ bc<br />

2 ,<br />

also χ A (A) = 0, denn χ A = X 2 − (a + d)X + (ad − bc).<br />

♣<br />

Cayley-<br />

Hamilton<br />

für n = 2<br />

Es ist jetzt vielleicht nicht mehr überraschend, dass das auch für beliebige n × n-<br />

Matrizen gilt.<br />

∗ 19.12. Satz. Seien K ein Körper, n ∈ N und A ∈ Mat(n, K). Dann ist SATZ<br />

Cayleyχ<br />

A (A) = 0 .<br />

Hamilton<br />

Warum ist der folgende ”<br />

Beweis“ nicht korrekt?<br />

χ A (X) = det(XI n − A) =⇒ χ A (A) = det(AI n − A) = det(0) = 0 .<br />

Wenn wir an dieser Stelle die richtigen Hilfsmittel zur Verfügung hätten, dann<br />

könnten wir so argumentieren: Die Aussage gilt für diagonalisierbare Matrizen<br />

nach Beispiel 19.8(3). Diagonalisierbare Matrizen sind ”<br />

dicht“ (in einem geeigneten<br />

Sinn) in allen n × n-Matrizen; die Aussage folgt dann, weil die Abbildung<br />

Mat(n, A) → Mat(n, A), A ↦→ χ A (A) stetig ist (wiederum in einem geeigneten<br />

Sinn). Das wird im Kleingedruckten unten genauer erklärt.<br />

Beweis. Wir gehen hier anders vor. Wir stellen erst einmal fest, dass wir auch<br />

mit Matrizen über kommutativen Ringen (statt über Körpern) rechnen können,<br />

solange wir nicht durch Ringelemente dividieren müssen. Insbesondere können<br />

wir Determinanten bilden und damit auch die adjungierte Matrix (siehe Definition<br />

13.12). Wir wenden das an auf den Ring K[X], für den wir schon mit Determinanten<br />

gearbeitet haben, denn χ A ist ja definiert als det(XI n − A). Sei also<br />

B = XI n −A ∈ Mat(n, K[X]) und ˜B die adjungierte Matrix zu B (deren Einträge<br />

bis aufs Vorzeichen Determinanten von (n − 1) × (n − 1)-Untermatrizen von B<br />

sind). Dann gilt (Satz 13.13)<br />

(19.1) ˜B(XIn − A) = ˜BB = det(B)I n = χ A (X)I n .<br />

Die Einträge von ˜B sind Polynome in X vom Grad < n, wie man sich leicht<br />

überlegt; wir können also schreiben<br />

˜B = ( b (n−1)<br />

ij X n−1 + . . . + b (1)<br />

ij X + )<br />

b(0) ij<br />

mit geeigneten Koeffizienten b (k)<br />

ij ∈ K. (Wir schreiben den oberen Index in Klammern,<br />

um eine Verwechslung mit Potenzen zu vermeiden.) Nach den Rechenregeln<br />

für Matrizen können wir das auch schreiben als<br />

˜B = ˜B n−1 X n−1 + . . . + ˜B 1 X + ˜B 0<br />

i,j

§ 19. Polynome und Matrizen bzw. Endomorphismen 17<br />

mit ˜B k = (b (k)<br />

ij ) i,j ∈ Mat(n, K). Sei außerdem<br />

Wir setzen in (19.1) ein und erhalten<br />

χ A (X) = X n + a n−1 X n−1 + . . . + a 1 X + a 0 .<br />

˜B n−1 X n + ( ˜B n−2 − ˜B n−1 A)X n−1 + . . . + ( ˜B 1 − ˜B 2 A)X 2 + ( ˜B 0 − ˜B 1 A)X − ˜B 0 A<br />

= I n X n + a n−1 I n X n−1 + . . . + a 2 I n X 2 + a 1 I n X + a 0 I n .<br />

Koeffizientenvergleich zeigt dann<br />

˜B n−1 = I n , ˜Bn−2 − ˜B n−1 A = a n−1 I n , . . . , ˜B0 − ˜B 1 A = a 1 I n , − ˜B 0 A = a 0 I n .<br />

Wir multiplizieren diese Gleichungen von rechts mit A n , A n−1 , . . . , A, I n und<br />

summieren auf:<br />

˜B n−1 A n<br />

= A n<br />

− ˜B n−1 A n + ˜B n−2 A n−1<br />

= a n−1 A n−1<br />

.. .<br />

.. . .<br />

. . .<br />

. . . .<br />

− ˜B 1 A 2 + ˜B 0 A = a 1 A<br />

− ˜B 0 A = a 0 I n<br />

0 = χ A (A)<br />

□<br />

Ein Beweis, wie er oben angedeutet wurde, könnte etwa wie folgt aussehen. Wir zeigen<br />

die Aussage erst einmal für Matrizen über C. Sei also A ∈ Mat(n, C). Ist A diagonalisierbar,<br />

dann ist χ A (A) = 0 und wir sind fertig. Sonst können wir A beliebig wenig<br />

stören, sodass das charakteristische Polynom der gestörten Matrix A ′ keine mehrfachen<br />

Nullstellen hat. Dann ist A ′ diagonalisierbar, also gilt χ A ′(A ′ ) = 0. Da χ A (A) eine stetige<br />

Funktion von A ist (d.h., die Einträge dieser Matrix hängen stetig von den Einträgen<br />

von A ab), folgt χ A (A) = 0.<br />

Nun gilt ganz allgemein, dass die Einträge von χ A (A) Polynome in den Einträgen von A<br />

mit ganzzahligen Koeffizienten sind (diese Polynome haben den Grad n in dem Sinne,<br />

dass sie ganzzahlige Linearkombinationen von Produkten von jeweils n Einträgen von A<br />

sind) — daraus folgt auch die oben schon verwendete Stetigkeit. Wir haben gesehen,<br />

dass diese Polynome stets den Wert null annehmen, wenn man beliebige komplexe Zahlen<br />

einsetzt. Daraus folgt aber, dass die Polynome null sind (als Polynome). Das zeigt<br />

dann, dass χ A (A) = 0 für Matrizen über beliebigen Körpern (oder sogar kommutativen<br />

Ringen) gilt.<br />

19.13. Folgerung. Das charakteristische Polynom χ A einer Matrix A ist ein FOLG<br />

Vielfaches des Minimalpolynoms m A . Jede Nullstelle von χ A ist auch eine Nullstelle<br />

von m A<br />

m A teilt χ A<br />

.<br />

Beweis. Jedes Polynom p ∈ K[X] mit p(A) = 0 ist ein Vielfaches von m A ,<br />

vgl. Satz 19.6, und χ A (A) = 0.<br />

Ist λ eine Nullstelle von χ A , dann ist λ ein Eigenwert von A, es gibt also einen<br />

Eigenvektor 0 ≠ v ∈ K n mit A · v = λv. Es folgt<br />

wegen v ≠ 0 also m A (λ) = 0.<br />

0 = m A (A) · v = m A (λ)v ,<br />

□

§ 19. Polynome und Matrizen bzw. Endomorphismen 18<br />

19.14. Beispiel. Folgerung 19.13 hilft uns, das Minimalpolynom zu bestimmen. BSP<br />

Sei zum Beispiel<br />

⎛<br />

Minimalpolynom<br />

A = ⎝ 0 1 0<br />

⎞<br />

−1 2 0⎠ ∈ Mat(3, R) .<br />

1 −1 1<br />

Es ist<br />

X −1 0<br />

χ A =<br />

1 X − 2 0<br />

∣−1 1 X − 1∣ = ( X(X − 2) + 1 ) (X − 1) = (X − 1) 3 ,<br />

also ist m A ∈ {X − 1, (X − 1) 2 , (X − 1) 3 }. Wir probieren die Möglichkeiten der<br />

Reihe nach durch:<br />

⎛<br />

(X − 1)(A) = A − I 3 = ⎝ −1 1 0<br />

⎞<br />

−1 1 0⎠<br />

1 −1 0<br />

ist nicht die Nullmatrix, aber (X − 1) 2 (A) = (A − I 3 ) 2 = 0, also ist m A = (X − 1) 2<br />

(und A ist nicht diagonalisierbar).<br />

♣<br />

Wir werden jetzt sehen, wie man eine Zerlegung p = p 1 p 2 · · · p m eines Polynoms p<br />

mit p(A) = 0 in eine Zerlegung des zugehörigen Endomorphismus von K n ”übersetzen“<br />

kann. Dazu müssen die Faktoren p 1 , p 2 , . . . , p m allerdings eine Bedingung<br />

erfüllen.<br />

19.15. Definition. Sei K ein Körper und seien p, q ∈ K[X]. Dann heißen p DEF<br />

und q relativ prim oder teilerfremd, wenn es Polynome r, s ∈ K[X] gibt mit relativ prim<br />

rp + sq = 1.<br />

♦<br />

Man kann zeigen, dass zwei Polynome p und q, die keinen (nicht konstanten) gemeinsamen<br />

Teiler haben (es gilt also für alle a, b, c ∈ K[X], dass aus p = ab und q = ac<br />

folgt, dass a konstant ist), relativ prim sind. Die Umkehrung ist einfach zu sehen. Das<br />

erklärt die Bezeichnung ”<br />

teilerfremd“. Siehe die ”<br />

Einführung in die Zahlentheorie und<br />

algebraische Strukturen“.<br />

Hier ist eine typische Anwendung:<br />

19.16. Lemma. Seien K ein Körper, V ein K-Vektorraum und f ein Endomor- LEMMA<br />

phismus von V. Sei weiter p ∈ K[X] mit p(f) = 0; es gebe eine Faktorisierung<br />

p = p 1 p 2 mit p 1 , p 2 ∈ K[X] relativ prim. Wir setzen f 1 = p 1 (f) und f 2 = p 2 (f).<br />

Dann gilt:<br />

Zerlegung<br />

von Endomorphismen<br />

(1) U 1 = im(f 1 ) und U 2 = im(f 2 ) sind f-invariant.<br />

(2) U 1 = ker(f 2 ) und U 2 = ker(f 1 ).<br />

(3) V = U 1 ⊕ U 2 .<br />

Beweis. Nach Voraussetzung gibt es Polynome r 1 , r 2 ∈ K[X] mit r 1 p 1 + r 2 p 2 = 1.<br />

(1) Sei u ∈ U 1 , dann gibt es v ∈ V mit u = f 1 (v). Es folgt<br />

f(u) = (f ◦ f 1 )(v) = ( (Xp 1 )(f) ) (v) = ( (p 1 X)(f) ) ( )<br />

(v) = f 1 f(v) ∈ U1 ,<br />

also ist U 1 unter f invariant. Die Aussage für U 2 zeigt man analog.

§ 19. Polynome und Matrizen bzw. Endomorphismen 19<br />

(2) Es gilt f 2 (u) = (f 2 ◦ f 1 )(v) = 0 (denn f 2 ◦ f 1 = p(f) = 0), also ist<br />

U 1 ⊂ ker(f 2 ). Sei umgekehrt u ∈ ker(f 2 ). Dann gilt<br />

u = ( (p 1 r 1 +r 2 p 2 )(f) ) (u) = f 1<br />

(<br />

(r1 (f))(u) ) +(r 2 (f))(f 2 (u)) = f 1<br />

(<br />

(r1 (f))(u) ) ∈ U 1 ,<br />

also ist auch ker(f 2 ) ⊂ U 1 . Die Aussage für U 2 zeigt man analog.<br />

(3) Für v ∈ V gilt<br />

v = id V (v) = ( (p 1 r 1 + p 2 r 2 )(f) ) (v) = f 1<br />

(<br />

(r1 (f))(v) ) + f 2<br />

(<br />

(r2 (f))(v) ) ∈ U 1 + U 2 .<br />

Ist andererseits v ∈ U 1 ∩ U 2 = ker(f 2 ) ∩ ker(f 1 ), dann ist f 2 (v) = f 1 (v) = 0<br />

und damit<br />

v = id V (v) = ( (r 1 p 1 + r 2 p 2 )(f) ) (v) = r 1 (f) ( f 1 (v) ) + r 2 (f) ( f 2 (v) ) = 0 .<br />

Damit gilt V = U 1 + U 2 und U 1 ∩ U 2 = {0}.<br />

Um das anwenden zu können, brauchen wir Beispiele für relativ prime Polynome.<br />

19.17. Lemma. Seien K ein Körper, λ ∈ K und p ∈ K[X] mit p(λ) ≠ 0. Dann LEMMA<br />

sind die Polynome X − λ und p relativ prim.<br />

relativ prime<br />

Polynome 1<br />

Beweis. Wir schreiben p = q · (X − λ) + α mit α = p(λ) ≠ 0 und q ∈ K[X]. Dann<br />

gilt<br />

−α −1 q · (X − λ) + α −1 · p = 1 ,<br />

also sind X − λ und p relativ prim.<br />

□<br />

19.18. Lemma. Seien K ein Körper und p, q 1 , q 2 ∈ K[X], sodass p, q 1 und p, q 2 LEMMA<br />

jeweils relativ prim sind. Dann sind auch p und q 1 q 2 relativ prim.<br />

relativ prime<br />

Polynome 2<br />

Beweis. Nach Voraussetzung gibt es Polynome r 1 , s 1 , r 2 , s 2 ∈ K[X] mit<br />

Multiplikation liefert<br />

r 1 p + s 1 q 1 = 1 und r 2 p + s 2 q 2 = 1 .<br />

1 = (r 1 p + s 1 q 1 )(r 2 p + s 2 q 2 ) = (r 1 r 2 p + r 1 s 2 q 2 + s 1 q 1 r 2 )p + s 1 s 2 · q 1 q 2 ,<br />

also sind p und q 1 q 2 relativ prim.<br />

19.19. Folgerung. Sei K ein Körper, seien λ 1 , λ 2 , . . . , λ m ∈ K paarweise ver- FOLG<br />

schieden und seien e 1 , e 2 , . . . , e m ≥ 1. Dann sind die Polynome (X − λ j ) e j<br />

für<br />

j ∈ {1, 2, . . . , m} paarweise relativ prim.<br />

Beweis. Seien i, j ∈ {1, 2, . . . , m} mit i ≠ j. Nach Lemma 19.17 sind X − λ i und<br />

(X −λ j ) e j<br />

relativ prim (wir wenden das Lemma an mit λ = λ i und p = (X −λ j ) e j<br />

).<br />

Eine einfache Induktion unter Verwendung von Lemma 19.18 zeigt dann, dass<br />

auch (X − λ i ) e i<br />

und (X − λ j ) e j<br />

relativ prim sind (Anwendung mit p = (X − λ j ) e j<br />

,<br />

q 1 = (X − λ i ) n , q 2 = X − λ i ).<br />

□<br />

□<br />

□

§ 20. Die Jordansche Normalform 20<br />

20. Die Jordansche Normalform<br />

Nach den Vorbereitungen aus dem letzten Abschnitt können wir den wesentlichen<br />

Schritt für die Klassifikation von Endomorphismen formulieren.<br />

20.1. Satz. Seien K ein Körper, V ein K-Vektorraum und f ∈ End(V ). Seien SATZ<br />

weiter λ 1 , λ 2 , . . . , λ m ∈ K paarweise verschieden und e 1 , e 2 , . . . , e m ≥ 1, sodass Zerlegung<br />

p(f) = 0 ist, wobei<br />

von Endomorphismen<br />

p = (X − λ 1 ) e 1<br />

(X − λ 2 ) e2 · · · (X − λ m ) em .<br />

Dann gibt es f-invariante Untervektorräume U 1 , U 2 , . . . , U m von V mit<br />

(1) V = U 1 ⊕ U 2 ⊕ . . . ⊕ U m , und<br />

(2) für jedes j ∈ {1, 2, . . . , m} gilt (f − λ j id V ) ◦e j<br />

(U j ) = {0}; genauer ist<br />

U j = ker ( (f − λ j id V ) ◦e j)<br />

.<br />

Das verallgemeinert die (interessante Richtung in der) Aussage von Satz 19.10:<br />

Sind alle Exponenten e j = 1, dann erhält man die Zerlegung in Eigenräume wie<br />

dort.<br />

Beweis. Induktion über m. Der Fall m = 1 ist klar (und der Fall m = 0 ist trivial;<br />

dann muss V = {0} sein). Sei die Aussage für ein m bewiesen; wir wollen sie für<br />

m + 1 zeigen. Dazu setzen wir<br />

p 1 = (X − λ 1 ) e 1<br />

(X − λ 2 ) e2 · · · (X − λ m ) em und p 2 = (X − λ m+1 ) e m+1<br />

.<br />

Nach Folgerung 19.19 und Lemma 19.18 sind p 1 und p 2 relativ prim, also können<br />

wir Lemma 19.16 anwenden. Das liefert uns f-invariante Untervektorräume U m+1<br />

und U von V mit<br />

U m+1 = im ( p 1 (f) ) = ker ( (f − λ m+1 id V ) ◦e m+1 )<br />

und<br />

U = im ( (f − λ m+1 id V ) ◦e m+1 ) = ker ( p 1 (f) ) ,<br />

die f-invariant sind und V = U ⊕ U m+1 erfüllen. Sei jetzt ˜f ∈ End(U) die Einschränkung<br />

von f auf U. Dann gilt p 1 ( ˜f) = 0 (denn U = ker ( p 1 (f) ) ), und<br />

wir können die Induktionsannahme anwenden. Das liefert ˜f- und damit auch<br />

f-invariante Untervektorräume U 1 , U 2 , . . . , U m von U (und damit von V ) mit<br />

U j = ker ( ( ˜f − λ j id U ) j) ◦e und U1 ⊕ U 2 ⊕ . . . ⊕ U m = U. Damit gilt bereits<br />

V = U ⊕ U m+1 = (U 1 ⊕ U 2 ⊕ . . . ⊕ U m ) ⊕ U m+1 = U 1 ⊕ U 2 ⊕ . . . ⊕ U m ⊕ U m+1 .<br />

Es bleibt zu zeigen, dass U j = ker ( (f − λ j id V ) ◦e j)<br />

ist für j ≤ m. Es gilt jedenfalls<br />

U j = ker ( (f − λ j id V ) ◦e j)<br />

∩ U, sodass es genügt zu zeigen, dass der Kern in U<br />

enthalten ist. Das folgt aber aus<br />

v ∈ ker ( (f − λ j id V ) ◦e j ) =⇒ ( (X − λ j ) e j<br />

(f) ) (v) = 0 =⇒ ( p 1 (f) ) (v) = 0<br />

=⇒ v ∈ ker ( p 1 (f) ) = U . □<br />

Das legt folgende Definition nahe. Wir bemerken zuerst, dass für zwei lineare<br />

Abbildungen V 1<br />

f<br />

→ V2<br />

g<br />

→ V3 gilt ker(f) ⊂ ker(g ◦ f) (denn aus f(v) = 0 folgt<br />

(g ◦ f)(v) = g(0) = 0). Insbesondere ist für f ∈ End(V )<br />

{0} = ker(id V ) ⊂ ker(f) ⊂ ker(f ◦2 ) ⊂ ker(f ◦3 ) ⊂ . . .<br />

eine aufsteigende Kette von Untervektorräumen von V .

§ 20. Die Jordansche Normalform 21<br />

∗ 20.2. Definition. Sei f ein Endomorphismus eines endlich-dimensionalen K- DEF<br />

Vektorraums V und sei λ ∈ K. Dann heißt der Untervektorraum<br />

Hauptraum<br />

H λ (f) = ⋃ m∈N<br />

ker ( (f − λ id V ) ◦m) ⊂ V<br />

der Hauptraum oder verallgemeinerte Eigenraum von f zum Eigenwert λ. Analog<br />

definieren wir H λ (A) für Matrizen A ∈ Mat(n, K).<br />

♦<br />

Nach Lemma 7.4 ist H λ (f) als aufsteigende Vereinigung von Untervektorräumen<br />

ein Untervektorraum von V .<br />

20.3. Lemma. In der Situation von Satz 20.1 oben gilt U j = H λj (f) für alle LEMMA<br />

j ∈ {1, 2, . . . , m}.<br />

Zerlegung<br />

in Haupträume<br />

Beweis. Da U j = ker ( (f − λ j id V ) j) ◦e ist, müssen wir zeigen, dass für m ≥ ej<br />

aus (f − λ j id V ) ◦m (v) = 0 schon v ∈ U j folgt. Sei q = p/(X − λ j ) e j<br />

(also p ohne<br />

den j-ten Faktor), dann sind q und (X − λ j ) m−e j<br />

relativ prim wie im Beweis von<br />

Satz 20.1. Es gibt also Polynome r, s ∈ K[X] mit r(X − λ j ) m−e j<br />

+ sq = 1 und<br />

damit<br />

r(X − λ j ) m + sp = (X − λ j ) e j<br />

.<br />

Einsetzen von f und Anwenden auf v ergibt<br />

(f − λ j id V ) ◦e j<br />

(v) = ( r(f) )( (f − λ j id V ) ◦m (v) ) + ( s(f) )( (p(f))(v) )<br />

= ( r(f) ) (0) + ( s(f) ) (0) = 0<br />

(unter Verwendung von (f − λ j id V ) ◦m (v) = 0 und p(f) = 0) wie gewünscht.<br />

Da V endlich-dimensional ist, kann die aufsteigende Kette von Untervektorräumen<br />

ker ( (f − λ id V ) ◦m) nicht unendlich oft echt aufsteigen, also muss es ein m ∈ N<br />

geben mit<br />

ker ( (f − λ id V ) ◦m) = ker ( (f − λ id V ) ◦(m+1)) = ker ( (f − λ id V ) ◦(m+2)) = . . . .<br />

Auf H λ (f) können wir also f schreiben als λ id Hλ (f) +g mit g ◦m = 0. Diese Eigenschaft<br />

von g hat einen Namen.<br />

∗ 20.4. Definition. Sei f ein Endomorphismus eines Vektorraums V . f heißt nil- DEF<br />

potent, wenn es m ∈ N gibt mit f ◦m = 0. Analog heißt eine Matrix A ∈ Mat(n, K) nilpotent<br />

nilpotent, wenn es m ∈ N gibt mit A m = 0.<br />

♦<br />

20.5. Lemma. Sei V = U 1 ⊕ U 2 ⊕ . . . ⊕ U n eine Zerlegung des Vektorraums V LEMMA<br />

als direkte Summe und seien für i ∈ {1, 2, . . . , n} jeweils f i , g i ∈ End(U i ). Seien<br />

weiter f = f 1 ⊕ f 2 ⊕ . . . ⊕ f n und g = g 1 ⊕ g 2 ⊕ . . . ⊕ g n .<br />

(1) Sind alle g i nilpotent, so ist auch g nilpotent.<br />

(2) Gilt f i ◦ g i = g i ◦ f i für alle i ∈ {1, 2, . . . , n}, dann gilt auch f ◦ g = g ◦ f.<br />

(3) Es gilt f + g = (f 1 + g 1 ) ⊕ (f 2 + g 2 ) ⊕ . . . ⊕ (f n + g n ).<br />

(4) Es gilt f ◦ g = (f 1 ◦ g 1 ) ⊕ (f 2 ◦ g 2 ) ⊕ . . . ⊕ (f n ◦ g n ).<br />

(5) ker(f) = ker(f 1 ) ⊕ ker(f 2 ) ⊕ . . . ⊕ ker(f n ).<br />

□

§ 20. Die Jordansche Normalform 22<br />

Beweis.<br />

(1) Nach Voraussetzung gibt es zu jedem i ein m i ∈ N mit g ◦m i<br />

i = 0. Wir<br />

setzen m = max{m 1 , m 2 , . . . , m n }, dann gilt gi<br />

◦m = 0 für alle i. Damit ist<br />

g ◦m (u i ) = gi ◦m (u i ) = 0 für u i ∈ U i und es folgt für v = u 1 +u 2 +. . .+u n ∈ V,<br />

dass g ◦m (v) = 0 ist. (Beachte g ◦m = g1 ◦m ⊕ . . . ⊕ gn<br />

◦m nach Teil (4) unten.)<br />

Also ist g ◦m = 0 und g ist nilpotent.<br />

(2) Das folgt aus Teil (4).<br />

(3) Für u i ∈ U i gilt (f + g)(u i ) = f(u i ) + g(u i ) = f i (u i ) + g i (u i ) = (f i + g i )(u i ),<br />

also ist f + g die direkte Summe der f i + g i .<br />

(4) Für u i ∈ U i gilt<br />

(f ◦ g)(u i ) = f ( g(u i ) ) = f ( g i (u i ) ) = f i<br />

(<br />

gi (u i ) ) = (f i ◦ g i )(u i ) ,<br />

also ist f ◦ g die direkte Summe der f i ◦ g i .<br />

(5) Zunächst einmal ist klar, dass die Summe der Kerne rechts direkt ist: Sind<br />

u 1 ∈ ker(f 1 ) ⊂ U 1 , u 2 ∈ ker(f 2 ) ⊂ U 2 , . . . , u n ∈ ker(f n ) ⊂ U n mit<br />

u 1 + u 2 + . . . + u n = 0, dann folgt u 1 = u 2 = . . . = u n = 0, weil die Summe<br />

der U i direkt ist. Es ist also nur zu zeigen, dass<br />

ker(f) = ker(f 1 ) + ker(f 2 ) + . . . + ker(f n )<br />

ist. Die Inklusion ”<br />

⊃“ folgt aus ker(f i ) ⊂ ker(f) für alle i ∈ {1, 2, . . . , n}<br />

(denn für u i ∈ U i gilt f(u i ) = f i (u i )), damit enthält der Untervektorraum<br />

ker(f) auch die Summe der ker(f i ). Für die Inklusion ”<br />

⊂“ sei jetzt<br />

v ∈ ker(f). Wir können v (eindeutig) schreiben als v = u 1 + u 2 + . . . + u n<br />

mit u i ∈ U i , dann ist<br />

0 = f(v) = f(u 1 + u 2 + . . . + u n )<br />

= f(u 1 ) + f(u 2 ) + . . . + f(u n ) = f 1 (u 1 ) + f 2 (u 2 ) + . . . + f n (u n ) .<br />

Aus f i (u i ) ∈ U i und daraus, dass die Summe der U i direkt ist, folgt dann<br />

f 1 (u 1 ) = f 2 (u 2 ) = . . . = f n (u n ) = 0, also u i ∈ ker(f i ) für alle i. Das<br />

bedeutet v ∈ ker(f 1 ) + ker(f 2 ) + . . . + ker(f n ).<br />

□<br />

20.6. Beispiel. Wenn V unendlich-dimensional ist, dann braucht die aufsteigen- BSP<br />

de Kette der Kerne nicht stationär“ zu werden. Sei zum Beispiel V = K[X] der<br />

”<br />

Polynomring und f ∈ End(V ) die Division durch X ohne Rest“, gegeben durch<br />

”<br />

f(p) = (p − p(0))/X. Dann gilt ker(f ◦m ) = K[X]

§ 20. Die Jordansche Normalform 23<br />

Beweis. Wir beweisen die Version für Endomorphismen; der Beweis für Matrizen<br />

ist analog. Sei<br />

χ f = (X − λ 1 ) e 1<br />

(X − λ 2 ) e2 · · · (X − λ m ) em .<br />

Nach Satz 19.12 gilt χ f (f) = 0. Satz 20.1 liefert dann f-invariante Untervektorräume<br />

U 1 , U 2 , . . . , U m mit V = U 1 ⊕ U 2 ⊕ . . . ⊕ U m ; nach Lemma 20.3 gilt<br />

U j = ker ( (f − λ j id V ) j) ◦e = Hλj (f) für alle j. Die Einschränkung f j von f auf U j<br />

(als Endomorphismus von U j ) hat also die Form f j = d j + g j mit d j = λ j id Uj<br />

und g ◦e j<br />

j = 0; es gilt d j ◦ g j = λ j g j = g j ◦ d j . Mit d = d 1 ⊕ d 2 ⊕ . . . ⊕ d m und<br />

g = g 1 ⊕ g 2 ⊕ . . . ⊕ g m gilt dann f = d + g, und nach Lemma 20.5 gilt d ◦ g = g ◦ d<br />

und g ist nilpotent. Schließlich ist d diagonalisierbar, weil U j = E λj (d) ist; damit<br />

ist V die direkte Summe der Eigenräume von d.<br />

□<br />

Um daraus eine stärkere Version abzuleiten, die eine Normalform für Matrizen<br />

ähnlich den Diagonalmatrizen ergibt, müssen wir uns die Struktur von nilpotenten<br />

Endomorphismen noch genauer ansehen. Sei also g ∈ End(V ) nilpotent und sei<br />

m ∈ N die kleinste natürliche Zahl mit g ◦m = 0. Dann haben wir die Kette<br />

{0} ker(g) ker(g ◦2 ) . . . ker(g ◦(m−1) ) V<br />

von Untervektorräumen von V . Dass die Inklusionen echt sind, ergibt sich aus dem<br />

folgenden Lemma.<br />

20.8. Lemma. Seien V ein Vektorraum, g ∈ End(V ) und m ∈ N. Dann folgt LEMMA<br />

aus ker(g ◦(m+1) ) = ker(g ◦m ), dass ker(g ◦n ) = ker(g ◦m ) ist für alle n ≥ m.<br />

Beweis. Übung.<br />

□<br />

∗ 20.9. Definition. Seien K ein Körper, n ∈ N und A = (a ij ) ∈ Mat(n, K). Dann DEF<br />

heißt A eine obere Dreiecksmatrix, wenn gilt a ij = 0 für alle j < i, und eine Dreiecksmatrix<br />

strikte obere Dreiecksmatrix, wenn gilt a ij = 0 für alle j ≤ i. Analog definiert man<br />

(strikte) untere Dreiecksmatrizen (mit j > i bzw. j ≥ i).<br />

♦<br />

In einer oberen Dreiecksmatrix sind also alle Einträge echt unterhalb der Diagonalen<br />

null, in einer strikten oberen Dreiecksmatrix sind zusätzlich die Einträge auf<br />

der Diagonalen null.<br />

20.10. Satz. Seien V ein endlich-dimensionaler K-Vektorraum und g ∈ End(V ) SATZ<br />

nilpotent. Dann gibt es eine Basis B von V, sodass Mat B,B (g) eine strikte obere<br />

Dreiecksmatrix ist.<br />

Analog gilt: Ist A ∈ Mat(n, K) nilpotent, dann ist A zu einer strikten oberen<br />

Dreiecksmatrix ähnlich.<br />

Umgekehrt ist jede strikte obere Dreiecksmatrix A ∈ Mat(n, K) nilpotent; genauer<br />

gilt A n = 0.<br />

Beweis. Sei U j = ker(g ◦j ), dann gilt {0} = U 0 U 1 . . . U m = V , wobei<br />

m minimal ist mit g ◦m = 0. Außerdem ist g(U j ) ⊂ U j−1 für alle j > 0 (denn<br />

g ◦j (v) = 0 impliziert g ◦(j−1) (g(v)) = 0). Wir wählen eine Basis von U 1 , die wir<br />

sukzessive zu Basen von U 2 , U 3 , . . . , U m erweitern; sei B = (b 1 , b 2 , . . . , b n ) die<br />

resultierende Basis von V. Dann ist (b 1 , b 2 , . . . , b dim Uj ) eine Basis von U j , und<br />

g(b k ) ist Linearkombination von Basiselementen b i mit i < k, für alle k. Die k-<br />

te Spalte von A = Mat B,B (g) hat also höchstens in den ersten k − 1 Positionen<br />

Trigonalisierung<br />

nilpotenter<br />

Endomorphismen

§ 20. Die Jordansche Normalform 24<br />

von oben Einträge ungleich null; das bedeutet gerade, dass A eine strikte obere<br />

Dreiecksmatrix ist.<br />

Die Aussage über nilpotente Matrizen folgt aus der Aussage über Endomorphismen,<br />

indem man A als Endomorphismus von K n betrachtet.<br />

Die letzte Behauptung folgt aus Satz 19.12, denn für eine strikte Dreiecksmatrix<br />

A ∈ Mat(n, K) gilt χ A = X n .<br />

□<br />

Wir überlegen uns jetzt noch, wie die Matrix von f = f 1 ⊕ f 2 ⊕ . . . ⊕ f n bezüglich<br />

einer an die direkte Summenzerlegung angepassten Basis aussieht.<br />

20.11. Lemma. Sei V ein endlich-dimensionaler Vektorraum mit einer Zerle- LEMMA<br />

gung V = U 1 ⊕ U 2 ⊕ . . . ⊕ U n , seien f i ∈ End(U i ) für i ∈ {1, 2, . . . , n} und sei<br />

f = f 1 ⊕ f 2 ⊕ . . . ⊕ f n . Seien B i Basen von U i und B die durch Aneinanderhängen<br />

Matrix<br />

einer<br />

von B 1 , B 2 , . . . , B n gegebene Basis von V. Dann ist<br />

direkten<br />

⎛<br />

⎞<br />

Summe<br />

M 1 0 · · · 0<br />

0 M<br />

Mat B,B (f) =<br />

2 · · · 0<br />

⎜ .<br />

⎝ . . .. ⎟ . ⎠<br />

0 0 · · · M n<br />

eine Block-Diagonalmatrix, wobei M i = Mat Bi ,B i<br />

(f i ) die Matrizen von f i bezüglich<br />

der Basen B i sind.<br />

Beweis. Das folgt aus f(b) = f i (b) ∈ U i für Elemente b ∈ B i : in den den Elementen<br />

von B i entsprechenden Spalten von Mat B,B (f) können nur die den Elementen<br />

von B i entsprechenden Zeilen von null verschiedene Einträge enthalten, und die<br />

sich daraus ergebende Untermatrix ist die Matrix von f i bezüglich B i . □<br />

Da die Determinante einer Block-Diagonalmatrix das Produkt der Determinanten<br />

der Diagonalblöcke ist, folgt daraus auch<br />

und<br />

det(f) = det(f 1 ) det(f 2 ) · · · det(f n )<br />

χ f = χ f1 χ f2 · · · χ fn .<br />

Damit können wir eine Aussage über die Dimension des Hauptraums H λ (f) beweisen.<br />

20.12. Lemma. Seien V ein endlich-dimensionaler K-Vektorraum und f ein LEMMA<br />

Endomorphismus von V, sei weiter λ ∈ K. Dann ist die Dimension von H λ (f)<br />

gleich der algebraischen Vielfachheit von λ als Eigenwert von f (also gleich der<br />

Dimension des<br />

Hauptraums<br />

Vielfachheit von λ als Nullstelle von χ f ).<br />

Beweis. Ist λ kein Eigenwert von f, dann sind beide Seiten der zu beweisenden<br />

Gleichung null. Anderenfalls ist χ f = (X − λ) e · p mit p ∈ K[X] relativ prim zu<br />

(X −λ) e ; dabei ist e die algebraische Vielfachheit von λ als Eigenwert von f (dann<br />

ist p(λ) ≠ 0; nach Lemma 19.17 und Lemma 19.18 sind die Faktoren relativ prim).<br />

Nach Lemma 19.16 entspricht dieser Faktorisierung eine Zerlegung V = U 1 ⊕U 2 mit<br />

U 1 = ker ( (f −λ id V ) ◦e) = H λ (f) und U 2 = ker ( p(f) ) . Sei f 1 = f| U1 ∈ End(U 1 ) und<br />

f 2 = f| U2 ∈ End(U 2 ). Dann ist f 1 = λ id U1 +g 1 mit g 1 nilpotent; nach Satz 20.10 ist<br />

dann f 1 bezüglich einer geeigneten Basis von U 1 durch eine obere Dreiecksmatrix<br />

dargestellt, deren Diagonaleinträge alle gleich λ sind. Es folgt χ f1 = (X − λ) dim U 1<br />

.

§ 20. Die Jordansche Normalform 25<br />

Auf der anderen Seite ist λ kein Eigenwert von f 2 (ist v ∈ U 2 mit f(v) = λv, dann<br />

ist v ∈ U 1 ∩ U 2 = {0}, also v = 0), also gilt χ f2 (λ) ≠ 0. Aus der Gleichheit<br />

(X − λ) e · p = χ f = (X − λ) dim U1 · χ f2<br />

und p(λ) ≠ 0, χ f2 (λ) ≠ 0 folgt dann<br />

dim H λ (f) = dim U 1 = e<br />

wie behauptet.<br />

□<br />

Da der Eigenraum E λ (f) stets im Hauptraum H λ (f) enthalten ist, liefert dies<br />

auch einen weiteren Beweis der Aussage, dass die geometrische Vielfachheit eines<br />

Eigenwerts nicht größer als die algebraische Vielfachheit sein kann.<br />

∗ 20.13. Folgerung. Seien V ein endlich-dimensionaler K-Vektorraum und f ein FOLG<br />

Endomorphismus von V, sodass das charakteristische Polynom χ f ∈ K[X] in Linearfaktoren<br />

zerfällt. Dann gibt es eine Basis B von V, sodass Mat B,B (f) eine<br />

obere Dreiecksmatrix ist.<br />

Analog gilt: Ist A ∈ Mat(n, K) eine Matrix, sodass χ A in Linearfaktoren zerfällt,<br />

dann ist A ähnlich zu einer oberen Dreiecksmatrix.<br />

Beweis. Wie im Beweis von Satz 20.7 haben wir eine Zerlegung<br />

V = U 1 ⊕ U 2 ⊕ . . . ⊕ U m<br />

mit U j = H λj (f)<br />

in die Haupträume von f, sodass f auf U j die Form λ j id +g j hat mit g j nilpotent.<br />

Wir wählen Basen B j von U j , sodass Mat Bj ,B j<br />

(g j ) eine strikte obere Dreiecksmatrix<br />

ist (das ist möglich nach Satz 20.10). Die Matrix bezüglich B j der Einschränkung<br />

von f auf U j ist dann M j = λ j I dim Uj +Mat Bj ,B j<br />

(g j ); dies ist eine obere<br />

Dreiecksmatrix. Wir setzen die Basis B von V aus den Basen B j zusammen. Nach<br />

Lemma 20.11 ist dann Mat B,B (f) eine Block-Diagonalmatrix mit Blöcken M j ; da<br />

die M j obere Dreiecksmatrizen sind, gilt das auch für Mat B,B (f). Die Aussage für<br />

Matrizen folgt in der üblichen Weise.<br />

□<br />

Die Voraussetzung, dass das charakteristische Polynom in Linearfaktoren zerfällt,<br />

ist stets erfüllt, wenn der Körper K algebraisch abgeschlossen ist, wie zum Beispiel<br />

K = C.<br />

Für viele Anwendungen sind die Aussagen von Satz 20.7 oder Folgerung 20.13<br />

ausreichend. Manchmal möchte man aber eine im Wesentlichen eindeutige Normalform<br />

von Matrizen bis auf Ähnlichkeit haben. Dazu betrachten wir noch einmal<br />

nilpotente Endomorphismen und daran angepasste Basen.<br />

Zur Vorbereitung noch ein Lemma zur Struktur von nilpotenten Endomorphismen.<br />

Darin leisten wir die Hauptarbeit für den Beweis der (starken) Jordanschen<br />

Normalform.<br />

Trigonalisierung<br />

von Endomorphismen<br />

20.14. Lemma. Sei V ≠ {0} ein endlich-dimensionaler Vektorraum und sei LEMMA<br />

f ∈ End(V ) nilpotent mit f ◦m = 0 und m ∈ N minimal mit dieser Eigenschaft. Sei<br />

weiter v ∈ V mit f ◦(m−1) (v) ≠ 0 und U = 〈v, f(v), f ◦2 (v), . . . , f ◦(m−1) (v)〉 ⊂ V .<br />

Dann gilt:<br />

(1) dim U = m (d.h., v, f(v), f ◦2 (v), . . . , f ◦(m−1) (v) sind linear unabhängig).<br />

Struktur<br />

nilpotenter<br />

Endomorphismen<br />

(2) Es gibt ein f-invariantes Komplement U ′ von U in V.

§ 20. Die Jordansche Normalform 26<br />

Beweis. Wir zeigen zuerst, dass v, f(v), f ◦2 (v), . . . , f ◦(m−1) (v) linear unabhängig<br />

sind. Seien dazu λ 0 , λ 1 , . . . , λ m−1 Skalare mit<br />

λ 0 v + λ 1 f(v) + λ 2 f ◦2 (v) + . . . + λ m−1 f ◦(m−1) (v) = 0 .<br />

Wenn wir f ◦(m−1) auf diese Gleichung anwenden und beachten, dass f ◦m = 0 ist,<br />

dann erhalten wir λ 0 f ◦(m−1) (v) = 0, wegen f ◦(m−1) (v) ≠ 0 also λ 0 = 0. Durch<br />

Anwenden von f ◦(m−2) bekommen wir dann analog λ 1 = 0, und in der gleichen<br />

Art dann nacheinander λ 2 = 0, . . . , λ m−1 = 0. Also sind die Vektoren linear<br />

unabhängig.<br />

Wir zeigen nun die Existenz eines f-invarianten Komplements von U in V. Dazu<br />

sei U ′ ein Untervektorraum von V maximaler Dimension mit den beiden Eigenschaften<br />

U ∩ U ′ = {0} und U ′ invariant unter f (der Null-Vektorraum ist ein<br />

Untervektorraum mit diesen Eigenschaften, also gibt es so ein U ′ ). Wir müssen<br />

noch zeigen, dass V = U + U ′ ist. Sei anderenfalls w ∈ V \ (U + U ′ ). Dann gibt<br />

es ein minimales k ∈ N mit f ◦k (w) ∈ U + U ′ ; es gilt k ≥ 1, denn w /∈ U + U ′ , und<br />

k ≤ m, denn f ◦m (w) = 0 ∈ U + U ′ . Wir können dann schreiben<br />

f ◦k (w) = λ 0 v + λ 1 f(v) + . . . + λ m−1 f ◦(m−1) (v) + u ′<br />

mit Skalaren λ 0 , λ 1 , . . . , λ m−1 und u ′ ∈ U ′ . Anwenden von f ◦(m−k) liefert (unter<br />

Beachtung von f ◦m = 0)<br />

0 = f ◦m (w)<br />

= λ 0 f ◦(m−k) (v) + λ 1 f ◦(m−k+1) (v) + . . . + λ k−1 f ◦(m−1) (v) + f ◦(m−k) (u ′ ) .<br />

} {{ } } {{ }<br />

∈U<br />

∈U ′<br />

Die lineare Unabhängigkeit der noch vorkommenden Vektoren (beachte dafür, dass<br />

U ∩ U ′ = {0} ist) erzwingt dann λ 0 = λ 1 = . . . = λ k−1 = 0, also gilt<br />

f ◦k (w) = λ k f ◦k (v) + λ k+1 f ◦(k+1) (v) + . . . + λ m−1 f ◦(m−1) (v) + u ′<br />

= f ◦k( λ k v + λ k+1 f(v) + . . . + λ m−1 f ◦(m−1−k) (v) ) + u ′ .<br />

Sei<br />

u = λ k v + λ k+1 f(v) + . . . + λ m−1 f ◦(m−1−k) (v) ∈ U<br />

und w ′ = w − u, dann ist w ′ /∈ U + U ′ (denn w − w ′ = u ∈ U ⊂ U + U ′ ) und<br />

f ◦k (w ′ ) = u ′ ∈ U ′ . Außerdem ist (wir verwenden hier k ≥ 1, also k − 1 ≥ 0)<br />

w ′′ = f ◦(k−1) (w ′ ) = f ◦(k−1) (w) − f ◦(k−1) (u) /∈ U + U ′ ,<br />

da f ◦(k−1) (w) /∈ U + U ′ . Sei U ′′ = U ′ + 〈w ′′ 〉. Dann gilt:<br />

• dim U ′′ > dim U ′ , denn w ′′ /∈ U ′ , also ist U ′ U ′′ .<br />

• U ′′ ∩U = {0}, denn sei u ′ 1 +λw ′′ = u 1 ∈ U mit u ′ 1 ∈ U ′ und einem Skalar λ,<br />

dann folgt λw ′′ = u 1 − u ′ 1 ∈ U + U ′ , aber w ′′ /∈ U + U ′ . Daraus ergibt sich,<br />

dass λ = 0 ist; die Behauptung folgt dann, weil U ′ ∩ U = {0} ist.<br />

• U ′′ ist f-invariant, denn sei u ′′ = u ′ 1 + λw ′′ ∈ U ′′ mit u ′ 1 ∈ U ′ und einem<br />

Skalar λ, dann ist<br />

f(u ′′ ) = f(u ′ 1) + λf(w ′′ ) = f(u ′ 1) + λf ◦k (w ′ ) = f(u ′ 1) + λu ′ ∈ U ′ ⊂ U ′′ ,<br />

denn f(u ′ 1) ∈ U ′ , weil U ′ unter f invariant ist.<br />

Insgesamt sehen wir, dass U ′′ ein f-invarianter Untervektorraum von V ist, der<br />

U ′′ ∩ U = {0} erfüllt, aber größere Dimension als U ′ hat. Das ist ein Widerspruch<br />

zur Wahl von U ′ , also ist die Annahme U + U ′ ≠ V falsch. Also muss U + U ′ = V<br />

gelten; damit ist U ′ das gesuchte f-invariante Komplement von U in V. □

§ 20. Die Jordansche Normalform 27<br />

Der obige Beweis ist, so wie er formuliert ist, nicht konstruktiv. Man kann das Argument,<br />

das zum Widerspruch führt, aber auch dazu verwenden, ein f-invariantes Komplement<br />

schrittweise (ausgehend von {0}) zu konstruieren.<br />

20.15. Definition. Sei V ein endlich-dimensionaler K-Vektorraum. Ein Endo- DEF<br />

morphismus f von V heißt nilzyklisch, wenn f nilpotent ist und es v ∈ V gibt, nilzyklisch<br />

sodass V = 〈v, f(v), f ◦2 (v), . . .〉 ist.<br />

Nach Lemma 20.14 sind v, f(v), . . . , f ◦(m−1) (v) linear unabhängig, bilden also eine<br />

Basis von V, wobei m ∈ N die kleinste Zahl ist mit f ◦m = 0. Wir ordnen um und<br />

setzen B = ( f ◦(m−1) (v), . . . , f(v), v ) , dann ist<br />

⎛<br />

⎞<br />

0 1 0 · · · · · · 0<br />

0 0 1 0 · · · 0<br />

.<br />

Mat B,B (f) = J m =<br />

. . . .<br />

. . .<br />

. . . .<br />

⎜0 0 · · · 0 1 0<br />

∈ Mat(m, K) .<br />

⎟<br />

⎝0 0 · · · · · · 0 1⎠<br />

0 0 · · · · · · · · · 0<br />

Die Matrizen J m heißen ebenfalls nilzyklisch.<br />

20.16. Satz. Sei f ein nilpotenter Endomorphismus eines endlich-dimensionalen SATZ<br />

Vektorraums V. Dann gibt es eine Zerlegung V = U 1 ⊕U 2 ⊕. . .⊕U m in f-invariante<br />

Untervektorräume, sodass f| Uj nilzyklisch ist für alle j ∈ {1, 2, . . . , m}.<br />

Beweis. Induktion über dim V . Im Fall dim V = 0, also V = {0}, ist nichts<br />

zu zeigen (m = 0). Sei also dim V > 0. Dann gibt es nach Lemma 20.14 eine<br />

Zerlegung V = U 1 ⊕ V ′ in f-invariante Untervektorräume mit U 1 ≠ {0},<br />

sodass f| U1 nilzyklisch ist (U 1 ist U in Lemma 20.14, V ′ ist U ′ ). Nach Induktionsannahme<br />

(beachte dim V ′ = dim V − dim U 1 < dim V ) gibt es eine Zerlegung<br />

V ′ = U 1⊕. ′ . .⊕U m ′ in f-invariante Untervektorräume, sodass f| ′ U j ′ nilzyklisch ist für<br />

alle j ∈ {1, 2, . . . , m ′ }. Wenn wir m = m ′ +1 und (für j ∈ {2, 3, . . . , m}) U j = U j−1<br />

′<br />

setzen, dann erhalten wir insgesamt die gewünschte Zerlegung von V. □<br />

♦<br />

Struktur<br />

nilpotenter<br />

Endomorphismen<br />

20.17. Folgerung. Sei V ein endlich-dimensionaler Vektorraum und sei f ein FOLG<br />

nilpotenter Endomorphismus von V. Dann gibt es eine Basis B = (b 1 , b 2 , . . . , b n ) Normalform<br />

von V und Zahlen m 1 , m 2 , . . . , m k ∈ N + mit m 1 + m 2 + . . . + m k = n, sodass für nilpotente<br />

⎛<br />

⎞<br />

Endomorphismen<br />

0 J<br />

J m1 0 · · · 0<br />

Mat B,B (f) =<br />

m2 · · · 0<br />

⎜<br />

⎝ . .<br />

.. .<br />

⎟ . ⎠<br />

0 0 · · · J mk<br />

ist. Die Zahlen m 1 , m 2 , . . . , m k sind bis auf ihre Reihenfolge eindeutig bestimmt.<br />

Analog gilt: Jede nilpotente Matrix A ∈ Mat(n, K) ist zu einer Matrix der obigen<br />

Form ähnlich. Diese Matrix ist bis auf die Reihenfolge der J mi eindeutig bestimmt.<br />

Beweis. Nach Satz 20.16 gibt es eine Zerlegung<br />

V = U 1 ⊕ U 2 ⊕ . . . ⊕ U k<br />

in f-invariante Untervektorräume mit f| Ui nilzyklisch. Sei B i für i ∈ {1, 2, . . . , k}<br />

eine Basis von U i wie in Definition 20.15; sei B die durch Aneinanderhängen

§ 20. Die Jordansche Normalform 28<br />

von B 1 , B 2 , . . . , B k gegebene Basis von V. Die erste Behauptung folgt dann mit<br />

Lemma 20.11; dabei ist m i = dim U i .<br />

Zur Eindeutigkeit: Für j ∈ N gilt<br />

dim ker(f ◦j ) =<br />

k∑<br />

i=1<br />

dim ker(f| ◦j<br />

U i<br />

) =<br />

k∑<br />

min{j, m i }<br />

i=1<br />

(die erste Gleichung folgt aus ker(f ◦j ) = ⊕ k<br />

i=1 ker(f|◦j U i<br />

), siehe Lemma 20.5(5), die<br />

zweite gilt, weil ker(f| ◦j<br />

U i<br />

) = 〈f ◦(mi−j) (v i ), f ◦(mi−j+1) (v i ), . . . , f ◦(mi−1) (v i )〉 ist für<br />

j ≤ m i und ker(f| ◦j<br />

U i<br />

) = U i für j ≥ m i , wenn U i = 〈v i , f(v i ), . . . , f ◦(mi−1) (v i )〉 ist)<br />

und damit<br />

dim ker(f ◦(j+1) ) − dim ker(f ◦j ) =<br />

=<br />

k∑ (<br />

min{j + 1, mi } − min{j, m i } )<br />

i=1<br />

k∑<br />

i=1<br />

{<br />

1, falls mi > j<br />

0, falls m i ≤ j<br />

}<br />

= # { i ∈ {1, 2, . . . , k} | m i > j } ,<br />

also auch (für j ≥ 1)<br />

(<br />

dim ker(f ◦j ) − dim ker(f ◦(j−1) ) ) − ( dim ker(f ◦(j+1) ) − dim ker(f ◦j ) )<br />

= # { i ∈ {1, 2, . . . , k} | m i ≥ j } − # { i ∈ {1, 2, . . . , k} | m i > j }<br />

= # { i ∈ {1, 2, . . . , k} | m i = j } ;<br />