Shannon: Informationstheorie - Dies ist unser Püffki, nur ...

Shannon: Informationstheorie - Dies ist unser Püffki, nur ...

Shannon: Informationstheorie - Dies ist unser Püffki, nur ...

Sie wollen auch ein ePaper? Erhöhen Sie die Reichweite Ihrer Titel.

YUMPU macht aus Druck-PDFs automatisch weboptimierte ePaper, die Google liebt.

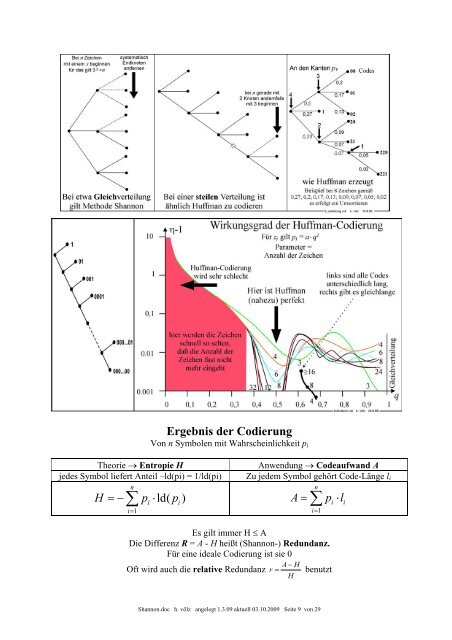

Ergebnis der Codierung<br />

Von n Symbolen mit Wahrscheinlichkeit pi<br />

Theorie → Entropie H Anwendung → Codeaufwand A<br />

jedes Symbol liefert Anteil –ld(pi) = 1/ld(pi) Zu jedem Symbol gehört Code-Länge li<br />

n<br />

∑<br />

H =− p ⋅ld(<br />

p )<br />

i=<br />

1<br />

i i<br />

i=<br />

1<br />

<strong>Shannon</strong>.doc h. völz angelegt 1.3.09 aktuell 03.10.2009 Seite 9 von 29<br />

n<br />

∑<br />

A = p ⋅l<br />

Es gilt immer H ≤ A<br />

Die Differenz R = A - H heißt (<strong>Shannon</strong>-) Redundanz.<br />

Für eine ideale Codierung <strong>ist</strong> sie 0<br />

A − H<br />

Oft wird auch die relative Redundanz r = benutzt<br />

H<br />

i i