Elektronika 2009-11.pdf - Instytut Systemów Elektronicznych

Elektronika 2009-11.pdf - Instytut Systemów Elektronicznych

Elektronika 2009-11.pdf - Instytut Systemów Elektronicznych

Create successful ePaper yourself

Turn your PDF publications into a flip-book with our unique Google optimized e-Paper software.

konstrukcje technologie zastosowania<br />

MIESIECZNIK NAUKOWO-TECHNICZNY<br />

rok L nr 11/<strong>2009</strong><br />

• MATERIAŁY • KONSTRUKCJE • UKŁADY<br />

• SYSTEMY • MIKROELEKTRONIKA<br />

• OPTOELEKTRONIKA • FOTONIKA<br />

• ELEKTRONIKA MIKROFALOWA<br />

• MECHATRONIKA<br />

• ENERGOELEKTRONIKA • INFORMATYKA<br />

ZESPÓŁ REDAKCYJNY<br />

prof. dr hab. inż. Jerzy Klamka - redaktor naczelny,<br />

Bożena Lachowicz - sekretarz redakcji<br />

Stali współpracownicy: mgr inż. Wiesław Jabłoński,<br />

mgr inż. Krzysztof Kowalski, mgr inż. Cezary Rudnicki, dr Juliusz Szczęsny<br />

Adres redakcji: ul. Chmielna 6 m.6, 00-020 Warszawa,<br />

tel./fax: (022) 827 38 79; tel.: (022) 826 65 64,<br />

e-mail: elektronika@red.pl.pl, www.elektronika.orf.pl<br />

Zamówienia na reklamę przyjmuje redakcja lub Dział Reklamy<br />

i Marketingu, ul. Mazowiecka 12, 00-950 Warszawa, skr. 1004,<br />

tel./fax (022) 8274366, 8268016, e-mail: reklama@sigma-not.pl<br />

Kolportaż: ul. Ku Wiśle 7, 00-716 Warszawa, tel.: (022) 840 35 89;<br />

tel./fax:: (022) 840 59 49, (022)891 13 74<br />

RADA PROGRAMOWA<br />

prof. dr hab. inż. Władysław Torbicz (PAN) - przewodniczący<br />

prof. dr hab. inż. Leonard Bolc, prof. dr hab. Zdzisław Drozd, prof. dr<br />

hab. inż. Jerzy Fraczek, dr inż. Józef Gromek, mgr inż. Jan Grzybowski,<br />

prof. dr hab. Ryszard Jachowicz, prof. dr hab. Włodzimierz<br />

Janke, prof. dr hab. Andrzej Jakubowski, prof. dr hab. Włodzimierz<br />

Kalifa, inż. Stefan Kamiński, prof. dr hab. inż. Marian P. Kaźmierkowski,<br />

dr inż. Wojciech Kocańda, prof. dr hab. Bogdan Kosmowski, mgr<br />

inż. Zbigniew Lange, prof. dr hab. Benedykt Licznerski, dr inż. Zygmunt<br />

Łuczyński, prof. dr hab. inż. Józef Modelski, prof. dr hab. Tadeusz<br />

Morawski, prof. dr hab. Bohdan Mroziewicz, prof. dr hab. Andrzej<br />

Napieralski, prof. dr hab. Tadeusz Pałko, prof. dr hab. inż. Marian<br />

Pasko, prof. dr hab. Józef Piotrowski, dr hab. inż. Ryszard Romaniuk,<br />

dr hab. inż. Grzegorz Różański, prof. dr hab. inż. Edward Sędek,<br />

prof. dr hab. Ludwik Spiralski, prof. dr hab. inż. Zdzisław Trzaska,<br />

mgr inż. Józef Wiechowski, prof. dr hab. inż. Marian Wnuk, prof.<br />

dr hab. inż. Janusz Zarębski<br />

Czasopismo dotowane przez Ministerstwo Nauki<br />

i Szkolnictwa Wyższego. Za opublikowane w nim artykuły<br />

MNiSzW przyznaje 6 punktów.<br />

“<strong>Elektronika</strong>” jest wydawana<br />

przy współpracy Komitetu Elektroniki<br />

i Telekomunikacji Polskiej Akademii Nauk<br />

IEEE<br />

WYDAWNICTWO<br />

CZASOPISM I KSIĄŻEK<br />

TECHNICZNYCH<br />

SIGMA - NOT<br />

Spółka z o. o.<br />

00-950 Warszawa<br />

skrytka pocztowa 1004<br />

ul. Ratuszowa 11<br />

tel.: (0 22)818 09 18, 818 98 32<br />

fax: (0 22) 619 21 87<br />

Internet<br />

http://www.sigma-not.pl<br />

Prenumerata<br />

e-mail: kolportaz@sigma-not.pl<br />

Informacja<br />

e-mail: informacja@sigma-not.pl<br />

Redakcja współpracuje<br />

z Polską Sekcją IEEE<br />

“<strong>Elektronika</strong>” jest notowana<br />

w międzynarodowej bazie IEE<br />

Inspec<br />

Publikowane artykuły nukowe były<br />

recenzowane przez samodzielnych<br />

pracowników nauki<br />

Redakcja nie ponosi odpowiedzialności<br />

za treść ogłoszeń. Zastrzega<br />

sobie prawo do skracania i adjustacji<br />

nadesłanych materiałów.<br />

Indeks 35722<br />

Nakład do 2000 egz.<br />

Druk: Drukarnia SIGMA-NOT Sp. z o.o.<br />

SPIS TREŚCI • CONTENTS<br />

Medical pattern intelligent recognition based on linguistic<br />

modelling of 3D coronary vessels visualisations (Lingwistyczne<br />

modelowanie przestrzennych rekonstrukcji unaczynienia<br />

wieńcowego w inteligentnym rozpoznawaniu zmian patologicznych)<br />

- M. Trzupek, M. R. Ogiela, R. Tadeusioewicz ................<br />

Average Individual Classification Probability Function (Przeciętna<br />

indywidualna funkcja prawdopodobieństwa klasyfikacji) -<br />

M. Landowski, A. Piegat ............................................................<br />

Evolutionary sets of cooperating ship trajectories: open waters<br />

and restricted waters (Ewolucyjne zbiory bezpiecznych<br />

trajektorii statków dla wód otwartych i obszarów ograniczonych)<br />

- R. Szłapczyński ....................................................................<br />

The role of fuzzy modeling in creation of knowledge base’s<br />

for intelligent decision’s support systems in the conditions<br />

of the dangerous hydrometeorological phenomenon threat<br />

(Rola modelowania rozmytego w kształtowaniu baz wiedzy dla<br />

inteligentnych systemów wspomagania decyzji w warunkach zagrożenia<br />

niebezpiecznym zjawiskiem natury) - T. Tretyakova .....<br />

Generation of harmonic sequences in accordance to tonal<br />

harmony rules with artificial neural networks (Generacja<br />

sekwencji harmonicznych w zgodzie z zasadami harmonii tonalnej<br />

przy użyciu sieci neuronowych) - W. Zabierowski,<br />

A. Napieralski ..........................................................................<br />

The correction of digital images obtained by means of low<br />

quality scanner using FIR filter generated by a neural network<br />

in opposition to the digital images obtained by means<br />

of model scanner (Poprawa obrazów cyfrowych pozyskanych<br />

skanerem niskiej klasy z wykorzystaniem filtru FIR generowanym<br />

przez siec neuronową) - J. Peksiński, G. Mikołajczak .........<br />

Global multicriteria optimization in weather routing (Wielokryterialna<br />

optymalizacja globalna w nawigacji meteorologicznej)<br />

- J. Szłapczyńska .............................................................<br />

Signed electronic document and its probative value in certificate<br />

and certificateless public key cryptosystem infrastructures<br />

(Podpisany dokument elektroniczny i jego wartość<br />

dowodowa w certyfikatowej i bezcertyfikatowej infrastrukturze<br />

kryptosystemu klucza publicznego) - J. Pejaś .........................<br />

Ontology-based approach to scada systems vulnerabilities<br />

representation for CIP (Podejście ontologiczne do reprezentacji<br />

podatności systemów scada dla ochrony infrastruktur krytycznych)<br />

- M. Choraś, A. Stachowicz, R. Kozik, A. Flizikowski,<br />

R. Renk ..................................................................................<br />

Synthesis and management of system with parallel multiprocessors<br />

and fault tolerance (Synteza i zarządzanie komputerowych<br />

systemów z równoległymi wieloprocesorami<br />

i tolerowaniem uszkodzeń) - M. Drabowski ...............................<br />

The security level of particular blind steganographic systems<br />

(Zabezpieczenie określonego poziomu niewidoczności<br />

w systemach steganograficznych) - J. Korostil ...........................<br />

The efficient data authentication in Web GIS (Efektywne uwierzytelnianie<br />

danych w systemach Web GIS) - W. Maćków ..........<br />

An experiment of implementation of DLP system working as<br />

a Linux kernel loadable module (Próba implementacji systemu<br />

ochrony przed utratą danych (DLP) pracującego na poziomie<br />

jądra dla systemu Linux) - A. Rakowski, I. El Fray .....<br />

A buffer thresholds policy in linked in series servers with<br />

blocking (Buforowanie z progami w połączonych serwerach<br />

z blokadami) - W. Oniszczuk ..................................................<br />

9<br />

12<br />

15<br />

18<br />

22<br />

25<br />

27<br />

30<br />

35<br />

38<br />

41<br />

45<br />

48<br />

51<br />

ELEKTRONIKA 11/<strong>2009</strong> 1

A system automating repairs of IT systems (System automatyzujący<br />

naprawy systemów IT) - M. Kamiński ...........................<br />

Influence of the number of bins on the recognition results<br />

using Point Distance Histogram (Wpływ liczby przedziałów<br />

w histogramie na wyniki rozpoznawania z użyciem algorytmu<br />

Point Distance Histogram) - D. Frejlichowski .............................<br />

Open Virtual Steganographic Laboratory (Otwarte Wirtualne Laboratorium<br />

Steganograficzne) - P. Forczmański, M. Węgrzyn .......<br />

The use of speech recognition and user verification in<br />

closed-circuit television systems (Zastosowanie rozpoznawania<br />

mowy i weryfikacji użytkownika w systemach telewizji<br />

przemysłowej) - M. Kubanek ....................................................<br />

SMS-B project of educational platform for e-business (Projekt<br />

systemu SMS-B jako platformy edukacyjnej dla e-biznesu) -<br />

P. Jałowiecki, T. Woźniakowski, A. Orłowski ...............................<br />

TECHNIKA PRÓŻNI I TECHNOLOGIE PRÓŻNIOWE: Biuletyn<br />

Polskiego Towarzystwa Próżniowego 1 (48) <strong>2009</strong> ................<br />

TECHNIKA SENSOROWA: Zastosowanie technik immunoenzymatycznych<br />

i mikrofluidycznych do amperometrycznego<br />

oznaczania stężenia białka C-reaktywnego (Application of immunoenzymatic<br />

and microfluidic techniques for amperometric determination<br />

of C-reactive protein concentration) - A. Baraniecka,<br />

B. Kazimierczak, J. Kruk, D. G. Pijanowska, W. Torbicz ................<br />

54<br />

58<br />

60<br />

65<br />

68<br />

71<br />

79<br />

TECHNIKA MIKROFALOWA I RADIOLOKACJA: Ochrona własności<br />

przemysłowej w Przemysłowym Instytucie Telekomunikacji<br />

S.A. na przestrzeni 75 lat Jego historii -<br />

J. Kobierzycki, W. Kęska ............................................................ 84<br />

TECHNIKA INFORMATYCZNA: Wielopoziomowy trening symulacyjny<br />

w szkoleniu operatorów urządzeń. Zastosowanie<br />

do szkolenia operatorów robotów mobilnych (Multi-level<br />

simulation training of devices operators. An application to mobile<br />

robots operators) - A. Kaczmarczyk, M. Kacprzak,<br />

A. Masłowski ............................................................................... 92<br />

Radary pasywne - nowa technika radiolokacji (Passive radars<br />

- a new radar technology) - Z. Czekała ........................................ 100<br />

System dalekosiężnej identyfikacji i śledzenia statków (Long<br />

Range Identification and Tracking of ships) - J. Czajkowski,<br />

K. Łyszyk .................................................................................... 115<br />

Szkło dla fotoniki. Część 14. Parametry szklanego włókna<br />

optycznego (Glasses for photonics. Part 14. Parameters of<br />

glass optical fibers) - R. Romaniuk .............................................. 119<br />

Wpływ konstrukcji cyfrowych układów scalonych na generację<br />

zaburzeń elektromagnetycznych (Influence of the IC<br />

construcion on electromagnetic disturbance) - J. Szczęsny ....... 129<br />

Streszczenia artykułów • Summaries of the articles<br />

TRZUPEK M., OGIELA M. R., TADEUSIEWICZ R.: Lingwistyczne<br />

modelowanie przestrzennych rekonstrukcji unaczynienia wieńcowego<br />

w inteligentnym rozpoznawaniu zmian patologicznych<br />

<strong>Elektronika</strong> (L), nr 11/<strong>2009</strong>, s. 9<br />

Celem artykułu jest przedstawienie sposobów rozwinięcia metodyki<br />

wcześniej opracowanej dla potrzeb automatycznego rozumienia dwuwymiarowych<br />

zobrazowań medycznych na zobrazowania 3D. Badana<br />

dają możliwości zdefiniowania w tych zobrazowaniach<br />

elementów opisu morfologii zmian patologicznych oraz możliwości<br />

zastosowania lingwistycznego podejścia, a także kognitywnej analizy<br />

obrazów do opisu i modelowania przestrzennych struktur biomedycznych.<br />

Rozważania w warstwie szczegółowej nawiązywać będą<br />

do trójwymiarowej struktury drzewa naczyń wieńcowych, która opisywana<br />

będzie z wykorzystaniem grafowych języków opisu cech<br />

kształtów.<br />

Słowa kluczowe: rozumienie zobrazowań medycznych, sztuczna<br />

inteligencja, inżynieria biomedyczna, lingwistyka matematyczna<br />

LANDOWSKI M., PIEGAT A.: Przeciętna indywidualna funkcja<br />

prawdopodobieństwa klasyfikacji<br />

<strong>Elektronika</strong> (L), nr 11/<strong>2009</strong>, s. 12<br />

Jednym z głównych zadań sztucznej inteligencji jest stworzenie<br />

sztucznego komputerowego mózgu realizującego sztuczne myślenie<br />

bazujące na konceptach lingwistycznych. Podstawą realizacji tego<br />

zadania jest opracowanie modelu ludzkich percepcji wyrażonego<br />

w formie kwantyfikatorów lingwistycznych. Artykuł prezentuje metodę<br />

tworzenia przeciętnej indywidualnej funkcji prawdopodobieństwa klasyfikacji.<br />

Funkcja ta przedstawia funkcję klasyfikacji przeciętnej indywidualnej<br />

osoby w grupie (populacji). Według wiedzy autorów<br />

przeciętna indywidualna funkcja prawdopodobieństwa klasyfikacji jest<br />

nowością w literaturze światowej.<br />

Słowa kluczowe: teoria prawdopodobieństwa, model probabilistyczny,<br />

przeciętna indywidualna funkcja prawdopodobieństwa klasyfikacji,<br />

koncept lingwistyczny<br />

TRZUPEK M., OGIELA M. R., TADEUSIEWICZ R.: Medical pattern<br />

intelligent recognition based on linguistic modelling of 3D coronary<br />

vessels visualisations<br />

<strong>Elektronika</strong> (L), no 11/<strong>2009</strong>, p. 9<br />

The goal of this article is to present the ways of taking the methodology<br />

that has been developed earlier for the needs of automatic understanding<br />

of 2D medical visualisations to the level of 3D<br />

visualisations. The research will cover the potential of defining, in<br />

these visualisations, of elements describing the morphology of pathologic<br />

changes and the possibility of applying the linguistic approach as<br />

well as cognitive image analysis for the description and modelling of<br />

spatially visualised coronary vessels. The considerations will make<br />

reference especially to the 3D structure of the coronary vascular tree,<br />

which will be described with the use of graph-based languages of<br />

shape feature description.<br />

Keywords: syntactic pattern analysis, medical image understanding,<br />

artificial intelligence, Computer-Aided Diagnosis<br />

LANDOWSKI M., PIEGAT A.: Average Individual Classification<br />

Probability Function<br />

<strong>Elektronika</strong> (L), no 11/<strong>2009</strong>, p. 12<br />

One of the main tasks of artificial intelligence is the creation of artificial<br />

computer brain able to realize artificial thinking based on linguistic<br />

concept. The basis of the realization of this task is the working out<br />

of models of human perception expressed in the form of linguistic<br />

quantifiers. The article presents the method of finding average individual<br />

classification probability function. The function is to present<br />

classification function of the average person in the group (population).<br />

According to the authors’ knowledge average individual classification<br />

probability function are the novelty in the word literature.<br />

Keywords: probability theory, probabilistic model, average individual<br />

classification probability function, linguistic concept<br />

2 ELEKTRONIKA 11/<strong>2009</strong>

Streszczenia artykułów • Summaries of the articles<br />

SZŁAPCZYŃSKI R.: Ewolucyjne zbiory bezpiecznych trajektorii<br />

statków dla wód otwartych i obszarów ograniczonych<br />

<strong>Elektronika</strong> (L), nr 11/<strong>2009</strong>, s. 15<br />

W artykule przedstawiono nową metodę rozwiązywania sytuacji spotkań<br />

wielu statków na wodach otwartych i wodach ograniczonych. Metoda<br />

łączy niektóre z elementów podejścia opartego na teorii gier<br />

z programowaniem ewolucyjnym i szuka optymalnego zbioru bezpiecznych<br />

trajektorii wszystkich statków zaangażowanych w potencjalną<br />

sytuację kolizyjną. Pozwala ona nawigatorowi przewidzieć<br />

najbardziej prawdopodobne zachowanie statków obcych i zaplanować<br />

z wyprzedzeniem manewry statku własnego.<br />

Słowa kluczowe: algorytmy ewolucyjne, unikanie kolizji statków,<br />

optymalne trajektorie statków<br />

TRETYAKOVA T.: Rola modelowania rozmytego w kształtowaniu<br />

baz wiedzy dla inteligentnych systemów wspomagania decyzji<br />

w warunkach zagrożenia niebezpiecznym zjawiskiem natury<br />

<strong>Elektronika</strong> (L), nr 11/<strong>2009</strong>, s. 18<br />

Do przygotowania zawartości baz wiedzy inteligentnych systemów<br />

doradczych i nauczania (trenażerów), wykorzystując wyniki estymacji<br />

informacji hydrometeorologicznej proponuje się wykorzystywać<br />

zbiory rozmyte i logikę rozmytą Lotfi Zadeha, które pozwalają sformalizować<br />

wiedzę jakościową i operować tą wiedzą. W artykule<br />

przedstawiono schemat blokowy procesu wyboru strategii reagowania<br />

na niebezpieczne zjawiska natury oraz przykładowe zbiory rozmyte<br />

i zmienne lingwistyczne, pozwalające sformalizować wiedzę<br />

jakościową dla inteligentnych systemów tej klasy.<br />

Słowa kluczowe: inteligentne systemy, modele rozmyte, wspomaganie<br />

decyzji, informacja hydrometeorologiczna<br />

ZABIEROWSKI W., NAPIERALSKI A.: Generacja sekwencji harmonicznych<br />

w zgodzie z zasadami harmonii tonalnej przy użyciu<br />

sieci neuronowych<br />

<strong>Elektronika</strong> (L), nr 11/<strong>2009</strong>, s. 22<br />

Artykuł przedstawia badania w dziedzinie Computer Generated<br />

Music [1], a dokładnie w zakresie generacji sekwencji harmonicznych.<br />

Do uzyskania postawionego celu zostały użyte sieci neuronowe.<br />

Do przygotowania danych użyto mechanizmów MIDI wraz<br />

z syntezatorem muzycznym. Artykuł zawiera także dyskusję otrzymanych<br />

wyników w odniesieniu do rzeczywistego procesu kompozycji<br />

utworów muzycznych.<br />

Słowa kluczowe: harmonia tonalna, muzyka, sieci neuronowe, muzyka<br />

komputerowa<br />

PEKSIŃSKI J., MIKOŁAJCZAK G.: Poprawa obrazów cyfrowych<br />

pozyskanych skanerem niskiej klasy z wykorzystaniem filtru FIR<br />

generowanym przez siec neuronową<br />

<strong>Elektronika</strong> (L), nr 11/<strong>2009</strong>, s. 25<br />

Dynamiczny rozwój sprzętu akwizycji obrazów opartego na matrycach<br />

CCD (Charge Coupled Device) doprowadził do tego, że stał się<br />

on obecny niemal w każdym domu. Jakość obrazów pozyskanych za<br />

pomocą takiego sprzętu w dużej stopniu zależy od jakości zastosowanej<br />

matrycy. Celem artykułu jest zaprezentowanie sposobu poprawy<br />

jakości obrazów cyfrowych pozyskanych skanerem o niskich<br />

parametrach tak, aby ich jakość zbliżyła się do obrazów pozyskanych<br />

przy pomocy skanera wysokiej klasy.<br />

Słowa kluczowe: obraz cyfrowy, siec neuronowa, błąd średniokwadratowy<br />

SZŁAPCZYŃSKI R.: Evolutionary sets of cooperating ship trajectories:<br />

open waters and restricted waters<br />

<strong>Elektronika</strong> (L), no 11/<strong>2009</strong>, p. 15<br />

The paper presents a new method of solving multi-ship encounter situations<br />

for both open waters and restricted water regions. The method<br />

combines some of the assumptions of game theory with evolutionary<br />

programming and aims to find optimal set of cooperating trajectories<br />

of all ships involved in an encounter situation. It enables the navigator<br />

to predict the most probable behaviour of target ships and to plan<br />

the own manoeuvres in advance.<br />

Keywords: evolutionary algorithm, collision avoidance, optimal ship<br />

trajectories<br />

TRETYAKOVA T.: The role of fuzzy modeling in creation of knowledge<br />

base’s for intelligent decision’s support systems in the conditions<br />

of the dangerous hydrometeorological phenomenon<br />

threat<br />

<strong>Elektronika</strong> (L), no 11/<strong>2009</strong>, p. 18<br />

The design of fuzzy models is one of the problems in creation of the<br />

intelligent systems supporting a choice of strategy of reaction to<br />

threats of the nature. In this paper are submitted some methodological<br />

approaches for creation of knowledge bases for intelligent decision<br />

support systems for bodies of regional management which are intended<br />

to realization of protective actions.<br />

Keywords: intelligent systems, fuzzy models, decision support, hydrometeorological<br />

information<br />

ZABIEROWSKI W., NAPIERALSKI A.: Generation of harmonic sequences<br />

in accordance to tonal harmony rules with artificial neural<br />

networks<br />

<strong>Elektronika</strong> (L), no 11/<strong>2009</strong>. p. 22<br />

The article presents research in the domain of Computer Generated<br />

Music [1], more precisely - in the area of harmonic sequences generation.<br />

To achieve the goal set for the research, artificial neural networks<br />

were used. Research data have been made using MIDI<br />

mechanisms and a musical synthesizer. In addition, the article contains<br />

a discussion of obtained results in regard to actual process of<br />

composing musical works as done by a human.<br />

Keywords: tonal harmony, music, neural network, computer generated<br />

music<br />

PEKSIŃSKI J., MIKOŁAJCZAK G.: The correction of digital images<br />

obtained by means of low quality scanner using FIR filter<br />

generated by a neural network in opposition to the digital images<br />

obtained by means of model scanner<br />

<strong>Elektronika</strong> (L), no 11/<strong>2009</strong>, p. 25<br />

Dynamic development of the image acquisition equipment, which<br />

bases on CCD matrice, that has occurred in recent years was the<br />

cause of the abundance of those devices in household usage. However,<br />

this equipment has many disadvantages caused mainly by the<br />

quality of the CCD matrice and electronics used to build it. Professional<br />

equipment that has high quality parameters and truly mapps<br />

an image is still expensive and is owned mainly by professional companies<br />

that deal with digital image processing. The aim of this article<br />

is to present the possibilities of improvement the quality of images acquired<br />

by low class devices, so that their quality is comparable to images<br />

acquired by high class devices.<br />

Keywords: digital image, neural network, mean square error<br />

ELEKTRONIKA 11/<strong>2009</strong> 3

Streszczenia artykułów • Summaries of the articles<br />

SZŁAPCZYŃSKA J.: Wielokryterialna optymalizacja globalna<br />

w nawigacji meteorologicznej<br />

<strong>Elektronika</strong> (L), nr 11/<strong>2009</strong>, s. 27<br />

Proces optymalizacji tras statku zdefiniować można jako wielokryterialne<br />

zadanie optymalizacyjne z ograniczeniami. W artykule prezentowane<br />

jest, zaimplementowane wcześniej, narzędzie służące do<br />

rozwiązywania zadania optymalizacji tras. Wykorzystuje ono dwa mechanizmy<br />

optymalizacji wielokryterialnej: ewolucyjny algorytm SPEA<br />

oraz metodę rankingową Fuzzy TOPSIS. Uzyskane wyniki badań prezentowanego<br />

narzędzia wskazują na konieczność redukcji łącznego<br />

czasu wykonania algorytmu. Dlatego też w artykule przedstawiono<br />

przegląd alternatywnych metod optymalizacji wielokryterialnej, możliwych<br />

do zastosowania w badanym przypadku. Dodatkowo podjęto<br />

próbę wskazania rozwiązania najkorzystniejszego z punktu wiedzenia<br />

rozpatrywanego problemu.<br />

SZŁAPCZYŃSKA J.: Global multicriteria optimization in weather<br />

routing<br />

<strong>Elektronika</strong> (L), no 11/<strong>2009</strong>, p. 27<br />

Route optimization for ships may be defined as a constrained multicriteria<br />

optimization problem. This paper presents an already implemented<br />

solution to the problem based on a multicriteria evolutionary<br />

algorithm (SPEA) and a ranking method (Fuzzy TOPSIS). Research<br />

results of the solution indicate the necessity of reduction of total execution<br />

time of the algorithm. Thus, in the paper applicable alternative<br />

optimization methods in weather routing are reviewed and the most<br />

suitable methods are appointed in the final conclusions.<br />

Keywords: global optimization, multicriteria optimization, weather<br />

routing<br />

Słowa kluczowe: optymalizacja globalna, optymalizacja wielokryterialna,<br />

nawigacja meteorologiczna<br />

PEJAŚ J.: Podpisany dokument elektroniczny i jego wartość dowodowa<br />

w certyfikatowej i bezcertyfikatowej infrastrukturze<br />

kryptosystemu klucza publicznego<br />

<strong>Elektronika</strong> (L), nr 11/<strong>2009</strong>, s. 30<br />

W artykule zaproponowano model długookresowego certyfikowanego<br />

elektronicznego schematu podpisu (LT-CESS), będącego rozwinię -<br />

ciem standardowego certyfikatowanego schematu podpisu elektronicznego<br />

(CESS). Zaproponowany schemat LT-CESS może być<br />

stosowany zarówno w certyfikatowym kryptosystemie klucza pu blicznego<br />

(PKC), opartym na jawnych certyfikatach klucza publicznego,<br />

jak również w bezcertyfikatowym kryptosystemie klucza publicznego<br />

(CL-PKC), opartym na niejawnych certyfikatach klucza publicznego<br />

Słowa kluczowe: schemat podpisu elektronicznego, długookresowa<br />

wartość dowodowa dokumentu elektronicznego, kryptografia oparta<br />

na tożsamości, certyfikatowy i bezcertyfikatowy kryptosystem klucza<br />

publicznego.<br />

CHORAŚ M., STACHOWICZ A., KOZIK R., FLIZIKOWSKI A., RENK<br />

R.: Podejście ontologiczne do reprezentacji podatności systemów<br />

scada dla ochrony infrastruktur krytycznych<br />

<strong>Elektronika</strong> (L), nr 11/<strong>2009</strong>, s. 35<br />

W niniejszym artykule przedstawiono opis podatności systemów<br />

SCADA będący częścią projektu mającego na celu ochronę infrastruktur<br />

krytycznych CIP (Critical Infrastructure Protection). Zastosowane<br />

w tym celu ontologiczne podejście zapewnia klasyfikacje,<br />

relacje i wnioskowanie na temat podatności i ich powiązań z innymi<br />

zagadnieniami bezpieczeństwa. Zaprojektowano także INSPIRE DAT<br />

(Decision Aid Tool) - narzędzie wspomagające decyzje dot. ochrony<br />

systemów SCADA i krytycznych infrastruktur.<br />

Słowa kluczowe: ontologia, podatności, ochrona krytycznych infrastruktur,<br />

SCADA, bezpieczeństwo<br />

DRABOWSKI M.: Synteza i zarządzanie komputerowych systemów<br />

z równoległymi wieloprocesorami i tolerowaniem uszkodzeń<br />

<strong>Elektronika</strong> (L), nr 11/<strong>2009</strong>, s. 38<br />

Artykuł prezentuje spójne podejście do rozwiązania problemów<br />

współbieżnego szeregowania w kompleksie procesów i zasobów.<br />

Takie problemy są charakterystyczne dla syntezy i zarządzania systemów<br />

wieloprocesorowych i tolerujących uszkodzenia. Złożoność<br />

obliczeniowa takich problemów jest NP-zupełna. Artykuł prezentuje<br />

model dla syntezy i zarządzania oraz praktyczny przykład rozwiązywania<br />

takich problemów.<br />

Słowa kluczowe: operacje, zasoby, szeregowanie, wieloprocesorowość,<br />

tolerancja uszkodzeń<br />

PEJAŚ J.: Signed electronic document and its probative value<br />

in certificate and certificateless public key cryptosystem infrastructures<br />

<strong>Elektronika</strong> (L), no 11/<strong>2009</strong>, p. 30<br />

The paper contains a proposal of a new model of a long-term certificate<br />

electronic signature scheme (LT-CESS) being an extension of a<br />

standard certificate electronic signature scheme (CESS). The LT-<br />

CESS scheme can be used in a certificate Public Key Cryptosystem<br />

(PKC) based on explicit public key certificates and in a Certificateless<br />

Public Key Cryptosystem (CL-PKC) based on implicit public key certificates<br />

as well.<br />

Keywords: electronic signature scheme, long-term probative value<br />

of an electronic document, identity-based cryptography, certificate and<br />

certificateless public key cryptosystem<br />

CHORAŚ M., STACHOWICZ A., KOZIK R., FLIZIKOWSKI A., RENK<br />

R.: Ontology-based approach to scada systems vulnerabilities<br />

representation for CIP<br />

<strong>Elektronika</strong> (L), no 11/<strong>2009</strong>, p. 35<br />

In this paper description of vulnerabilities in SCADA systems for CIP<br />

(Critical Infrastructure Protection) will be presented. Ontology-based<br />

approach applied for this purpose provides classification, relationships<br />

and reasoning about vulnerabilities and their connections with other<br />

security issues. Our approach is connected with solutions proposed<br />

in INSPIRE Project for increasing security and protection through infrastructure<br />

resilience.<br />

Keywords: ontology, vulnerabilities, critical infrastructure protection,<br />

SCADA, security<br />

DRABOWSKI M.: Synthesis and management of system with parallel<br />

multiprocessors and fault tolerance<br />

<strong>Elektronika</strong> (L), no 11/<strong>2009</strong>, p. 38<br />

The paper presents a coherent approach to solving the problems of<br />

concurrent scheduling of complex of operations and resources frameworks.<br />

These problems are specific for synthesis and management of<br />

system with multiprocessors and fault tolerance. Computational complexity<br />

of those problems is in general NP-complete. The paper presents<br />

model for synthesis and management and presents practical<br />

example for solving problems of this system.<br />

Keywords: operations, resources, scheduling, multiprocessors, foult<br />

tolerance<br />

4 ELEKTRONIKA 11/<strong>2009</strong>

Streszczenia artykułów • Summaries of the articles<br />

KOROSTIL J., NOZDRZYKOWSKI Ł.: Zabezpieczenie określonego<br />

poziomu niewidoczności w systemach steganograficznych<br />

<strong>Elektronika</strong> (L), nr 11/<strong>2009</strong>, s. 41<br />

W artykule przedstawiono sposób wykorzystania ocen jakości obrazów<br />

zgodnych z percepcją ludzkiego systemu wzrokowego, do określania<br />

niewidoczności zniekształceń powodowanych przez steganograficzne<br />

ukrywanie informacji w kolorowych obrazach cyfrowych.<br />

Przez wykorzystanie metod oceny niewidoczności istnieje możliwość,<br />

aby użytkownik żądając otrzymania danego poziomu niewidoczności,<br />

otrzymywał ją. Obraz wykorzystywany w celach steganograficznych<br />

powinien być starannie wybierany, aby fakt steganograficznego ukrycia<br />

wiadomości, nie był możliwy do wizualnego wykrycia [1].<br />

Słowa kluczowe: steganografia, obrazy cyfrowe, ukrywanie informacji<br />

MAĆKÓW W.: Efektywne uwierzytelnianie danych w systemach<br />

Web GIS<br />

<strong>Elektronika</strong> (L), nr 11/<strong>2009</strong>, s. 45<br />

W artykule przedstawiono wydajny schemat uwierzytelniania danych<br />

geograficznych. Schemat oparty jest na podpisie cyfrowym i łańcuchowaniu<br />

skrótów. Jest on dedykowany dla internetowych systemów<br />

GIS, umożliwiając uwierzytelnianie danych geograficznych przesyłanych<br />

z internetowych serwisów mapowych w odpowiedzi na zapytania<br />

klienta. Odpowiedzi serwera mogą być generowane np.<br />

podczas sesji WMS lub WFS.<br />

KOROSTIL J., NOZDRZYKOWSKI Ł.: The security level of particular<br />

blind steganographic systems<br />

<strong>Elektronika</strong> (L), no 11/<strong>2009</strong>, p. 41<br />

This article illustrates the utilization of evaluation of images quality in<br />

accordance with the perception of human visual system and to determine<br />

the invisibility of distortions caused by the steganographic information<br />

hiding in digital color images. There is a possibility that the<br />

user could get certain level of invisibility through the use of blind assessment<br />

method. The image used for the purpose of steganography<br />

should be carefully chosen that steganographic information hiding<br />

could not be possible to visual detection [1].<br />

Keywords: steganography, digital image, information hiding<br />

MAĆKÓW W.: The efficient data authentication in Web GIS<br />

<strong>Elektronika</strong> (L), no 11/<strong>2009</strong>, p. 45<br />

The article presents a scheme of efficient geodata authentication,<br />

based on digital signature and hash chaining. The proposal is dedicated<br />

to the Web GIS systems, for authentication of geographical data<br />

send by web mapping services as an answer to user requests. Server<br />

responses could be generated for example during WMS or WFS communication<br />

session.<br />

Keywords: hash chaining, data authentication, web mapping<br />

Słowa kluczowe: łańcuchowanie skrótów, uwierzytelnianie danych,<br />

webmapping<br />

RAKOWSKI A., EL FRAY l.: Próba implementacji systemu<br />

ochrony przed utratą danych (DLP) pracującego na poziomie<br />

jądra dla systemu Linux<br />

<strong>Elektronika</strong> (L), nr 11/<strong>2009</strong>, s. 48<br />

W pracy omówiono ogólnie ideę systemów DLP i kilku wybranych realizacji<br />

programowych dedykowanych platformie Windows. W artykule<br />

opisano także możliwe kanały wycieku informacji wrażliwej oraz<br />

przedstawiono autorską próbę utworzenia prostego systemu zapobiegania<br />

przed utratą danych. Utworzony system o nazwie PXX jest<br />

aplikacją złożoną z modułu jądra dla systemu Linux rodziny 2.6 oraz<br />

daemonem pracującym w przestrzeni administratora. Celem pracy<br />

jest określenie możliwości realizacji seryjnego i biznesowego rozwiązania<br />

rodziny DLP dla systemu Linux.<br />

Słowa kluczowe: System ochrony przed utratą danych, wyciek danych,<br />

bezpieczeństwo informacji<br />

ONISZCZUK W.: Buforowanie z progami w połączonych serwerach<br />

z blokadami<br />

<strong>Elektronika</strong> (L), nr 11/<strong>2009</strong>, s. 51<br />

Zastosowania progów w buforach, koncepcja blokad i odpowiednia<br />

strategia obsługi, to szeroko używane sposoby przeciwdziałania przeciążeniom<br />

w systemach komputerowych. Często więc, obiektami<br />

badań są kolejkowe systemy obsługi z blokadami, recyklingiem<br />

(obsługa priorytetowa) i ograniczonymi buforami z dynamicznymi progami.<br />

W niniejszej pracy założono, że zewnętrzny strumień zadań jest<br />

strumieniem Poissona, a losowe czasy obsługi mają rozkład wykładniczy.<br />

Badana sieć składa się z trzech węzłów, a w buforach mamy<br />

progi o rozmiarach tm1 i tm2. Na bazie formalizmów łańcuchów Markowa,<br />

powstały efektywne modele analityczne takich systemów<br />

obsługi, a seria eksperymentów numerycznych pokazała, że koncepcja<br />

blokad, recyklingu z priorytetami, oraz z dynamicznymi progami<br />

dobrze opisuje procesy obsługi w takich systemach.<br />

Słowa kluczowe: sieci z progami, kontrola przeciążeń, łańcuchy Markowa,<br />

blokady<br />

RAKOWSKI A., EL FRAY l.: An experiment of implementation of<br />

DLP system working as a Linux kernel loadable module<br />

<strong>Elektronika</strong> (L), no 11/<strong>2009</strong>, p. 48<br />

This article covers general description of DLP systems and some software<br />

implementations dedicated to Windows operating system. Also<br />

possible channels of loss of sensitive data were mentioned and described.<br />

Authors discuss their own experiment of creating simple data<br />

loss prevention system. Created system called PXX is made up of<br />

Linux’s kernel loadable module for 2.6 family and root space daemon.<br />

The aim was to determine possibility of implementation of universal<br />

Linux-based business DLP solution.<br />

Keywords: data loss prevention (DLP), data leakage, information security<br />

ONISZCZUK W.: A buffer thresholds policy in linked in series<br />

servers with blocking<br />

<strong>Elektronika</strong> (L), no 11/<strong>2009</strong>, p. 51<br />

The use of buffer thresholds, blocking and adequate service strategies<br />

are well-known techniques for computer networks traffic congestion<br />

control. This motivates the study of series queues with<br />

blocking, feedback (service under Head of Line (HoL) priority discipline)<br />

and finite capacity buffers with thresholds. In this paper, the external<br />

traffic is modelled using the Poisson process and the service<br />

times have been modelled using the exponential distribution. We consider<br />

a three-station network with two finite buffers, for which a set of<br />

thresholds (tm1 and tm2) is defined. Using an open Markovian queuing<br />

schema with blocking, priority feedback service and thresholds,<br />

a closed form cost-effective analytical solution is obtained. Based on<br />

numerical experiments and collected results we conclude that the<br />

proposed model with blocking, feedback and thresholds can provide<br />

accurate performance estimates of linked in series servers.<br />

Keywords: threshold-base networks, congestion control, Markov<br />

chains, blocking<br />

ELEKTRONIKA 11/<strong>2009</strong> 5

KAMIŃSKI M.: System automatyzujący naprawy systemów IT<br />

<strong>Elektronika</strong> (L), nr 11/<strong>2009</strong>, s. 54<br />

Artykuł ten dotyczy dwóch istotnych problemów: problemu monitorowania<br />

systemów IT oraz problemu ich naprawiania. Zaprezentowano<br />

w nim rozwiązanie umożliwiające automatyzację istniejących procesów<br />

naprawczych oraz ich integrację z przemysłowymi systemami<br />

i mechanizmami monitorującymi. Opisane rozwiązanie jest częścią<br />

większego projektu, nazwanego RMF (Repair Management Framework).<br />

W artykule tym zamieszczono również skrótowe studium przypadku<br />

dotyczące wytworzonego oraz zaimplementowanego systemu,<br />

pokazujące w jaki sposób został on użyty do rozwiązywania rzeczywistego<br />

problemu dotyczącego funkcjonowania systemów zarządzania<br />

bazami danych.<br />

Słowa kluczowe: systemy IT, wytwarzanie oprogramowania, metody<br />

formalne, monitorowanie i naprawa<br />

FREJLICHOWSKI D.: Wpływ liczby przedziałów w histogramie na<br />

wyniki rozpoznawania z użyciem algorytmu Point Distance Histogram<br />

<strong>Elektronika</strong> (L), nr 11/<strong>2009</strong>, s. 58<br />

Artykuł przedstawia wyniki eksperymentu przeprowadzonego<br />

z użyciem konturowych kształtów znaków firmowych a oparciu o algorytm<br />

Point Distance Histogram. Jednym z ważnych elementów tego<br />

algorytmu jest wybór liczby przedziałów (oznaczonej jako r) w wynikowym<br />

histogramie. W trakcie eksperymentów badano wpływ zmiennej<br />

wartości tego parametru na rezultaty rozpoznawania. Głónym<br />

celem badań było ustalenie najlepszych wartości współczynnika r dla<br />

małych konturowych kształtów binarnych. Jako ogólne podejście do<br />

problemu rozpoznawania wybrano porównywanie ze wzorcami (ang.<br />

template matching).<br />

Słowa kluczowe: opis kształtu, rozpoznawanie znaków firmowych,<br />

histogram, współrzędne biegunowe<br />

FORCZMAŃSKI P., WĘGRZYN M.: Otwarte Wirtualne Laboratorium<br />

Steganograficzne<br />

<strong>Elektronika</strong> (L), nr 11/<strong>2009</strong>, s. 60<br />

Jednym z najbardziej popularnych i wydajnych podejść do steganografii<br />

jest ukrywanie wiadomości w obrazach cyfrowych. Niestety większość<br />

z programów, które oferują szeroki zakres metod bazujących<br />

na LSB (osadzanie w najmniej znaczącym bicie) lub algorytmie JPEG<br />

jest podatna na współczesną steganalizę. Z drugiej strony, na rynku<br />

brakuje oprogramowania, które pozwalałoby na symulowanie i badanie<br />

różnych innych metod steganoraficznych i steganalitycznych. Powyższe<br />

potrzeby wymusiły powstanie oprogramowania opisanego w<br />

niniejszej pracy, które pozwala na ukrywanie informacji w danych graficznych,<br />

przeprowadzanie procedury steganalizy i umożliwia użycie<br />

tzw. wtyczek (plug-in). W opracowanym laboratorium przetwarzanie<br />

może odbywać się w sposób zarówno sekwencyjny, jak i równoległy.<br />

Aplikacja może być obsługiwana przez stosunkowo mało doświadczonych<br />

użytkowników, ponieważ dysponuje graficznym interfejsem<br />

użytkownika (zgodnym z technologią drag-and-drop). Może być wykorzystana<br />

w badaniach naukowych i edukacji.<br />

Słowa kluczowe: wirtualne laboratorium, steganografia, staganaliza,<br />

znakowanie wodne, Java<br />

KUBANEK M.: Zastosowanie rozpoznawania mowy i weryfikacji<br />

użytkownika w systemach telewizji przemysłowej<br />

<strong>Elektronika</strong> (L), nr 11/<strong>2009</strong>, s. 65<br />

Systemy rozpoznawania mowy i weryfikacji osób na podstawie mowy<br />

niezależnej są coraz częściej powszechnie używane. W systemach<br />

rozpoznawania mowy musimy wiedzieć, co zostało wypowiedziane<br />

przez testowaną osobę. Takie rozpoznane słowa można stosować do<br />

sterowania różnymi urządzeniami, kontrolowanymi przez komputer.<br />

W przypadku weryfikacji tożsamości nie jest ważne, co zostało wypowiedziane,<br />

ale kto to wypowiedział. W systemach weryfikacji tożsamości,<br />

gdzie każdy z zarejestrowanych użytkowników posiada swój<br />

własny unikalny login, zarejestrowana wypowiedź weryfikowanego<br />

użytkownika jest porównywana z wszystkimi wypowiedziami z bazy.<br />

Jeśli login się zgadza i charakterystyki głosowe są zgodne, wówczas<br />

system akceptuje weryfikowaną osobę.<br />

W artykule zaproponowano rozpoznawanie mowy do sterowania<br />

ruchem kamery przemysłowej, oraz weryfikację użytkownika na podstawie<br />

mowy niezależnej do logowania do systemu. Do ekstrakcji i kodowania<br />

charakterystyk głosowych zastosowano analizę cepstralną<br />

mowy. Jako aparat rozpoznający przyjęto ukryte modele Markowa.<br />

Głównym zadaniem tej pracy - oprócz oczywiście praktycznej implementacji<br />

opisanych metod - jest pokazanie, w jaki sposób należy<br />

zmodyfikować mechanizm analizy cepstralnej na potrzeby rozpoznawania<br />

mowy, a w jaki sposób na potrzeby weryfikacji tożsamości na<br />

podstawie mowy niezależnej.<br />

Słowa kluczowe: weryfikacja użytkownika, rozpoznawanie mowy,<br />

mowa niezależna, kodowanie mowy<br />

KAMIŃSKI M.: A system automating repairs of IT systems<br />

<strong>Elektronika</strong> (L), no 11/<strong>2009</strong>, p. 54<br />

This paper presents two problems that are important nowadays: the<br />

problem of IT systems monitoring and the problem of repairing them.<br />

It shows the developed solution, aimed to automate the existing industrial<br />

repair process and to integrate it with the existing monitoring<br />

solutions and mechanisms. Described solution is a part of a bigger<br />

whole, called the Repair Management Framework (RMF). This paper<br />

presents also briefly a case study related to the developed and implemented<br />

system, showing how it was used to solve the real problem<br />

regarding the functioning of database management systems.<br />

Keywords: IT systems, software development, formal methods, monitoring<br />

and repair<br />

FREJLICHOWSKI D.: Influence of the number of bins on the<br />

recognition results using Point Distance Histogram<br />

<strong>Elektronika</strong> (L), no 11/<strong>2009</strong>, p. 58<br />

The paper presents the results of an experiment performed on trademark<br />

contour shapes using Point Distance Histogram. One of the important<br />

stages in the algorithm is the selection of the number of bins<br />

(denoted as r) in the resultant histogram. The experiments explored<br />

the influence of this varying value on the recognition results. The main<br />

goal was to establish the best value for small binary contour shapes.<br />

The template matching was used as the whole approach to the recognition<br />

problem.<br />

Keywords: shape description, trademark recognition, histogram,<br />

polar coordinates<br />

FORCZMAŃSKI P., WĘGRZYN M.: Open Virtual Steganographic<br />

Laboratory<br />

<strong>Elektronika</strong> (L), no 11/<strong>2009</strong>, p. 60<br />

One of the most popular and efficient steganographic approaches is<br />

to embed messages into digital images. However, most of available<br />

applications that provide wide range of Least Significant Bit methods<br />

or different JPEG techniques no longer resist modern steganalysis.<br />

On the other hand, there is no application for still images, that could<br />

simulate and test multiple methods both steganographic and steganalytic,<br />

thus the purpose of this paper is to propose a software for hiding<br />

and detecting data in digital images that uses several different<br />

adjustable steganographic techniques, allows testing their security<br />

level with steganalysis and provides simple plug-in architecture. The<br />

processing can be performed in both batch and parallel form. The application<br />

can be operated even by relatively inexperienced users since<br />

it provides legible graphical user interface (conforming with drag-anddrop<br />

technology) and it can be employed both in research and in educational<br />

areas.<br />

Keywords: virtual laboratory, steganography, steganalysis, watermarking,<br />

Java<br />

KUBANEK M.: The use of speech recognition and user verification<br />

in closed-circuit television systems<br />

<strong>Elektronika</strong> (L), no 11/<strong>2009</strong>, p. 65<br />

Speech recognition systems, and the verification of persons on the<br />

basis of independent speech are widely used. In the speech recognition<br />

systems, we need to know what said examined person. These<br />

recognized words we can used to controlling any devices, which is<br />

controlled by computer. In a speaker verification, the prime interest is<br />

not in recognizing the words but determining who is speaking the<br />

words. In systems of speaker verification, a test of signal from an<br />

known speaker, user gives his own login, is compared to all known<br />

speaker signals in the set. If the vocal is the same and the user login<br />

is the same, the system accepts the user.<br />

In this work, it was proposed use speech recognition method to<br />

control the movement of the camera of closed-circuit television<br />

system, and use user verification method to log on to this system. Extraction<br />

of the audio features of person’s speech is done using modified<br />

mechanism of cepstral speech analysis. Speech recognition is<br />

done using hidden Markov models.<br />

The main aim of this work, excepting the practical implementation<br />

of both methods, is show, how to modify the MFCC for speech<br />

recognition and user verification.<br />

Keywords: user verification, speech recognition, independent<br />

speech, speech coding<br />

6 ELEKTRONIKA 11/<strong>2009</strong>

Streszczenia artykułów • Summaries of the articles<br />

JAŁOWIECKI P., WOŹNIAKOWSKI T., ORŁOWSKI A.: Projekt systemu<br />

SMS-B jako platformy edukacyjnej dla e-biznesu<br />

<strong>Elektronika</strong> (L), nr 11/<strong>2009</strong>, s. 68<br />

Funkcjonowanie współczesnych instytucji i organizacji komercyjnych<br />

opiera się na systemach informatycznych zaliczanych do kategorii<br />

Business Intelligence. Wydaje się, że pożyteczne jest oparcie procesu<br />

edukacji na takich kierunkach studiów jak: ekonomia, finanse<br />

i rachunkowość, informatyka, ekonometria oraz zarządzanie<br />

o dedykowane platformy IT wystarczająco wiernie odtwarzające<br />

rzeczywiste, informatyczne środowisko pracy.<br />

W pracy przedstawiono koncepcję systemu SMS-B (System Modelowania<br />

i Symulacji Biznesowych) zaprojektowanego do symulowania<br />

procesów biznesowych jako propozycję platformy edukacyjnej<br />

oferującej zintegrowane rozwiązania współczesnych systemów informatycznych<br />

klasy BI. Architektura systemu SMS-B tak blisko jak to<br />

możliwe imituje rzeczywiste środowisko pracy w dużych instytucjach<br />

finansowych. Funkcjonalność systemu zakłada wykorzystywanie<br />

danych generowanych w oparciu o biznesowe modele symulacyjne.<br />

Możliwości oferowane przez system w zakresie zastosowań<br />

edukacyjnych stanowią połączenie funkcjonalności oferowanej przez<br />

rzeczywiste, współczesne systemy IT wielu kategoriom użytkowników<br />

końcowych, w szczególności pracownikom obsługi IT, użytkownikom<br />

biznesowym, analitykom i różnym kategoriom konsumentów informacji.<br />

Ponadto system SMS-B oferuje różne możliwości użytkownikom<br />

szczebla kierowniczego z zakresu statystyki, ekonometrii<br />

i zarządzania organizacjami.<br />

JAŁOWIECKI P., WOŹNIAKOWSKI T., ORŁOWSKI A.: SMS-B pro -<br />

ject of educational platform for e-business<br />

<strong>Elektronika</strong> (L), no 11/<strong>2009</strong>, p. 68<br />

Present institutions and commercial organizations work is based on<br />

systems count to Business Intelligence class. It seems to be advisable<br />

to base education process in such faculties as: economy, finance and<br />

accounting, computer science, econometrics and management on the<br />

dedicated modeling IT platform suitable to achieve practical experience<br />

in real market environment.<br />

In this article we present the concept of system designated to simulate<br />

business processes SMS-B (Simulation and Modeling System<br />

for Business) as proposition of educational platform offering integrated<br />

end-to-end solution of modern BI computer system. SMS-B architecture<br />

as close as possible to the real world imitates essential processes<br />

meet in financial enterprise. These functions operate on the base on<br />

data generated by business simulation models.<br />

The capabilities offered by system for educational purposes are<br />

essential for many categories of end-users worked every day with information<br />

systems. Especially for IT people, business users, analysts<br />

and other sorts of information consumers. The SMS-B system offers<br />

as well as a range of executive services for studies such as statistics,<br />

econometrics and enterprise management.<br />

Keywords: business Intelligence, Information Technologies, educational<br />

platform<br />

Słowa kluczowe: informacja zarządcza, technologie informacyjne,<br />

platforma edukacyjna<br />

BARANIECKA A., KAZIMIERCZAK B., KRUK J., PIJANOWSKA D.<br />

G., TORBICZ W.: Zastosowanie technik immunoenzymatycznych<br />

i mikrofluidycznych do amperometrycznego oznaczania stężenia<br />

białka C-reaktywnego<br />

<strong>Elektronika</strong> (L), nr 11/<strong>2009</strong>, s. 79<br />

CRP jest białkiem ostrej fazy i jednym z najlepszych niespecyficznych<br />

markerów określającym ryzyko oraz zaawansowanie choroby niedokrwiennej<br />

serca. Bardzo przydatne stają się w tym przypadku wielofunkcyjne<br />

urządzenia diagnostyczne z szybką amperometryczną<br />

detekcją oraz funkcją wstępnego rozdziału próbki. Układy mikroprzepływowe<br />

umożliwiają taki rozdział przy małej objętości badanych<br />

próbek i reagentów, co znacząco obniża koszty testu. Z wyjątkiem<br />

nowych aptaczujników, jedynie immunoczujniki zapewniają specyficzność<br />

wobec poszukiwanego analitu w próbce. W nieprzezroczys -<br />

tych próbkach, jakimi są płyny fizjologiczne, niemożliwe jest<br />

zastosowanie optycznych metod detekcji, stąd konieczne jest zastosowanie<br />

metody znakowania enzymem przeciwciał w immunoczujnikach<br />

i użycie innego rodzaju detekcji np. elektrochemicznej. Ze<br />

względu na niski poziom szumów tła i możliwość szybkiej detekcji,<br />

najczęściej stosuje się detekcję amperometryczną. Celem naszych<br />

prac jest opracowanie amperometrycznych immunoczujników mikroprzepływowych<br />

do diagnostyki medycznej do oznaczania CRP.<br />

BARANIECKA A., KAZIMIERCZAK B., KRUK J., PIJANOWSKA D.<br />

G., TORBICZ W.: Application of immunoenzymatic and microfluidic<br />

techniques for amperometric determination of C-reactive<br />

protein concentration<br />

<strong>Elektronika</strong> (L), no 11/<strong>2009</strong>, p. 79<br />

CRP is acute phase protein and one of the best nonspecific diagnostic<br />

markers in heart diseases. Microfluidic systems offer function of<br />

preliminary probe separation with small consumption of probes and<br />

reagents, which decrease cost of unit test. Except newly developed<br />

aptasensors, only immunosensors provide specificity to determined<br />

analit in composed analyzed probe. In the case of nontransparent<br />

samples, like physiological fluids, immunosensors with electrochemical<br />

detection are sensors of choice, e.g. amperometric. For electrochemical<br />

detection enzyme labeled antibody is used. In order to<br />

decrease background noise and obtain fast response, amperometric<br />

sensors are mostly applied. An aim of our research is development of<br />

microfluidic type amperometric immunosensors for medical diagnostics,<br />

in particular for CRP determination.<br />

Keywords: C-reactive protein, immunosensor, microfluidic system,<br />

amperometric detection, ELISA test<br />

Słowa kluczowe: białko C-reaktywne, immunoczujnik, układ mikrofluidyczny,<br />

detekcja amperometryczna, test ELISA<br />

KACZMARCZYK A., KACPRZAK M., MASŁOWSKI A.: Wielopoziomowy<br />

trening symulacyjny w szkoleniu operatorów urządzeń.<br />

Zastosowanie do szkolenia operatorów robotów mobilnych<br />

<strong>Elektronika</strong> (L), nr 11/<strong>2009</strong>, s. 92<br />

Wielopoziomowy trening symulacyjny ma umożliwiać efektywne - co<br />

do kosztów i czasu przygotowanie wysokokwalifikowanych operatorów<br />

urządzeń dzięki użyciu tańszego wyposażenia i metod treningu<br />

do nabycia podstawowych umiejętności i bardziej złożonych do ich<br />

doskonalenia. Przedstawiono koncepcję treningu wielopoziomowego<br />

operatorów robotów mobilnych naziemnych, wyposażonych w kamerę<br />

TV i inne sensory oraz manipulator. Ponadto, artykuł zawiera<br />

ocenę tej koncepcji dokonaną przez polskiego producenta i użytkowników<br />

takich robotów oraz wnioski dotyczące rozwoju metod treningu.<br />

Słowa kluczowe: e-trening, wielopoziomowy trening symulacyjny,<br />

szkolenie operatorów urządzeń (robotów mobilnych)<br />

KACZMARCZYK A., KACPRZAK M., MASŁOWSKI A.: Multi-level<br />

simulation training of devices operators. An application to mobile<br />

robots operators<br />

<strong>Elektronika</strong> (L), no 11/<strong>2009</strong>, p. 92<br />

Multi-level simulation training is to enable cost and time efficient<br />

preparation of a great number of devices operators with advanced<br />

skills thanks to use of no costly equipment and methods to get basic<br />

expertise, and more sophisticated ones to perfect it. A concept of<br />

multi-level training of operators of the on-earth-mobile robots<br />

equipped with TV-cameras, other sensors, and manipulator arm is<br />

presented. Moreover, results of this concept evaluation by a Polish<br />

manufacturer and users of such robots, and conclusions related to<br />

the development of training methods are included in the paper.<br />

Keywords: e-training, multi-level simulation training, training of devices<br />

(mobile robots) operators<br />

ELEKTRONIKA 11/<strong>2009</strong> 7

Streszczenia artykułów • Summaries of the articles<br />

CZEKAŁA Z.: Radary pasywne - nowa technika radiolokacji<br />

<strong>Elektronika</strong> (L), nr 11/<strong>2009</strong>, s. 100<br />

Artykuł przedstawia podstawy funkcjonowania radarów pasywnych,<br />

które nie mają własnego nadajnika, lecz wykorzystują fale radiowe<br />

promieniowane przez „okazjonalne” nadajniki przeznaczone do innych<br />

celów. Wskazano istotne różnice w działaniu radaru impulsowego<br />

i radaru przetwarzającego sygnał ciągły o charakterze szumu.<br />

Wyjaśniono zasady odbioru korelacyjnego i przetwarzania sygnału<br />

oraz wyznaczania odległości echa. Opisano poszczególne komponenty<br />

radaru pasywnego na podstawie zrealizowanego demonstratora.<br />

Pokazano i skomentowano przykłady praktycznej realizacji<br />

znanych radarów pasywnych.<br />

Słowa kluczowe: radar pasywny, PCL, radar szumowy, funkcja korelacji,<br />

oval Cassiniego,<br />

CZAJKOWSKI J., ŁYSZYK K.: System dalekosiężnej identyfikacji<br />

i śledzenia statków<br />

<strong>Elektronika</strong> (L), nr 11/<strong>2009</strong>, s. 115<br />

W artykule przedstawiono system dalekosiężnej identyfikacji i śledzenia<br />

statków, którego celem jest zapewnienie światowego monitoringu<br />

ruchu statków w celu poprawienia bezpieczeństwa żeglugi.<br />

Opisano ostateczną koncepcję systemu, omówiono przyjętą strukturę<br />

oraz części składowe. Przedstawiono charakterystykę funkcjonalnych<br />

składowych systemu LRIT.<br />

Słowa kluczowe: bezpieczeństwo żeglugi, monitoring statków<br />

ROMANIUK R.: Szkło dla fotoniki. Część 14. Parametry szklanego<br />

włókna optycznego<br />

<strong>Elektronika</strong> (L), nr 11/<strong>2009</strong>, s. 119<br />

Szkła, obok półprzewodników i metali, są podstawowym materiałem<br />

do budowy elementów w optoelektronice i mikroelektronice. Praktyczna<br />

wiedza o szkłach rozszerza się wraz z silnym rozwojem ich<br />

zastosowań w telekomunikacji, czujnikach i budowie mikrosystemów.<br />

Wiele elementów funkcjonalnych fotoniki budowanych jest ze szkieł<br />

laserowych. Optyczne zjawiska nieliniowe indukowane w szkle pozwalają<br />

na budowę nowych mikro-elementów fotonicznych zastępujących<br />

złożone rozwiązania klasycznej optyki objętościowej. Szkła<br />

gradientowe zastępują klasyczne szkła optyczne.<br />

W artykule, który jest czternastą częścią cyklu prac o szkłach dla<br />

fotoniki, dokonano przeglądu parametrów szklanych włókien optycznych<br />

dla celów transmisyjnych i instrumentalnych. W powszechnym<br />

mniemaniu włókno szklane jest prostym optycznym elementem biernym,<br />

którego głównym parametrem jest tłumienność i średnica rdzenia<br />

oraz refrakcja. Nic bardziej błędnego. Artykuł pokazuje kilkadziesiąt<br />

ważnych parametrów włókna szklanego, które jest jednym<br />

z bardziej zaawansowanych obiektów inżynierii materiałowej.<br />

Słowa kluczowe: szkła optyczne, fotonika, szkła światłowodowe,<br />

szklane włókna optyczne, parametry światłowodu szklanego, apertura<br />

numeryczna, częstotliwość znormalizowana, dyspersja chromatyczna<br />

światłowodu, światłowody aktywne, światłowody polaryzacyjne<br />

SZCZĘSNY J.: Wpływ konstrukcji cyfrowych układów scalonych<br />

na generację zaburzeń elektromagnetycznych<br />

<strong>Elektronika</strong> (L), nr 11/<strong>2009</strong>, s. 129<br />

Przedstawiono wyniki pomiarów emisji pól EM w funkcji częstotliwości<br />

zegara taktującego ze ścieżek zasilania, masy oraz ze środka<br />

obudowy układu scalonego matrycy cyfrowej FPGA realizującej<br />

mnożenie metodą sekwencyjną i kombinacyjną. Porównano poziomy<br />

emisji zaburzeń opracowanych projektów IC w zależności od rozmieszczenia<br />

bloków logicznych w obszarze matrycy, liczby aktywnych<br />

bloków logicznych i wielkości prądów zasilania w funkcji<br />

częstotliwości taktowania.<br />

CZEKAŁA Z.: Passive radars - a new radar technology<br />

<strong>Elektronika</strong> (L), no 11/<strong>2009</strong>, p. 100<br />

The article presents fundamentals of operation of passive radars,<br />

which have no dedicated transmitter, but use radio waves radiated by<br />

transmitters of opportunity that normally serve other purposes. Important<br />

differences in operation of a pulsed radar and one that<br />

processes continuous noise-like signal have been indicated. Principles<br />

of the correlation reception, signal processing and target range<br />

finding have been explained. The particular components of a passive<br />

radar have been described, basing on a real demonstrator. Examples<br />

of practical implementation of well-known passive radars have been<br />

shown and commented.<br />

Keywords: passive radar, PCL, noise radar, correlation function,<br />

Cassini oval<br />

CZAJKOWSKI J., ŁYSZYK K.: Long Range Identification and<br />

Tracking of ships<br />

<strong>Elektronika</strong> (L), nr 11/<strong>2009</strong>, s. 115<br />

The article presents the main assumption of the Long Range Identification<br />

and Tracking of ships. The maim aim of the system is to improve<br />

the safety of navigation and to create global ships monitoring<br />

system. The main function preformed by the by the subsystems have<br />

been also presented.<br />

Key words: safety of navigation, global ships monitoring system<br />

ROMANIUK R.: Glasses for photonics. Part 14. Parameters of<br />

glass optical fibers<br />

<strong>Elektronika</strong> (L), no 11/<strong>2009</strong>, p. 119<br />

Glasses, together with semiconductors and metals, are fundamental<br />

materials for building of components for optoelectronics and microelectronics.<br />

Practical knowledge about glasses extends considerably<br />

with strong development of their applications in telecommunications,<br />

sensors and the construction of microsystems. Many functional components<br />

of the photonics is manufactured of laser glasses. Nonlinear<br />

optical phenomena induced in glasses allow for building of new microcomponents,<br />

replacing complex solutions of classical volume optics.<br />

Gradient glasses are replacing classical optical glasses.<br />

The paper, which is the fourteenth part of a cycle on glasses for<br />

photonics, is a concise review of the most frequently used parameters<br />

of optical fibers used for transmission and instrumentation purposes.<br />

A common belief is that an optical fiber is a simple passive optical object<br />

with the major parameters such as: losses, core dimension and<br />

refraction. It is a big mistake. The papers discusses a few tens of parameters<br />

of optical fibers used to characterize this very complex component.<br />

Advanced optical fibers are nowadays very complex products<br />

of material engineering.<br />

Keywords: optical glasses, photonics, optical fiber glasses, glass optical<br />

fibers, parameters of optical fibers, numerical aperture, normalized<br />

frequency, optical fiber chromatic dispersion, active optical fibers,<br />

polarization maintaining optical fibers<br />

SZCZĘSNY J.: Influence of the IC construcion on electromagnetic<br />

disturbance<br />

<strong>Elektronika</strong> (L), no 11/<strong>2009</strong>, p. 129<br />

In the paper some investigations of the electromagnetic emission from<br />

supply and ground pins of the circuits and middle zone of the Xilinx<br />

FPGA XCV800 package as a function of the clock rate are presented.<br />

To check the influence of IC floor plan, number of logic blocs and the<br />

circuit function on its electromagnetic emissions was tested.<br />

Keywords: Digital circuits, electromagnetic emission, FPGA floor plan<br />

and electric function, disturbances<br />

Słowa kluczowe: układy scalone, emisja elektromagnetyczna,<br />

FPGA, mapa bloków logicznych, zaburzenia EM<br />

8 ELEKTRONIKA 11/<strong>2009</strong>

Medical pattern intelligent recognition based<br />

on linguistic modelling of 3D coronary vessels<br />

visualisations<br />

(Lingwistyczne modelowanie przestrzennych rekonstrukcji unaczynienia<br />

wieńcowego w inteligentnym rozpoznawaniu zmian patologicznych)<br />

mgr inż. MIROSŁAW TRZUPEK, prof. dr hab. MAREK R. OGIELA,<br />

prof. dr hab. inż. RYSZARD TADEUSIEWICZ<br />

AGH University of Science and Technology, Institute of Automatics, Bio-Cybernetics Laboratory, Krakow<br />

Characteristic for the coronary vessels in different patients with<br />

various pathologic forms observed on flat, i.e. 2D, images is a<br />

certain level of repetitiveness and regularity. The same images<br />

registered by a machine rendering 3D images (helical CT<br />

scanner) feature a much greater number of visible details,<br />

which, however, results also in the increase of the number of<br />

both individual differences and those between various examinations<br />

of the same patient. Having considering these difficulties,<br />

a decision was made to apply the methods of automatic<br />

image understanding for the interpretation of the images considered,<br />

which consequently leads to their semantic descriptions.<br />

Thanks to such posing of the problem, the diagnosis put<br />

forth (being naturally but a suggestion for the physician making<br />

the actual decision) will account for a greater number of<br />

factors and use better the available medical information.<br />

Additionally, it is worth pointing out that - even though this<br />

is not the main focus of the work presented here - that the solution<br />

of problems related to the automatic production of intelligent<br />

(cognitive) descriptions of the 3D medical images in<br />

question may be a significant contribution to solving at least<br />

some of the problems connected to the smart archiving of this<br />

type of data and the finding of semantic image data meeting<br />

the semantic criteria delivered through sample image patterns<br />

in medical multimedia databases.<br />

The goal of research and description<br />

of the problem<br />

Problems of modelling biomedical structure shapes are extremely<br />

interesting from the scientific point of view, but also in<br />

connection with the development of medical diagnostic support<br />

systems. They concern various structures diagnosed<br />

using various modalities. However, in such research, we extremely<br />

frequently see the use of an approach based on neutral<br />

networks for shape modelling. For instance, such models<br />

can be built using Kohonen networks [1]. However, it is worth<br />

noting that such solutions are usually limited by the network<br />

topology, which, although it allows you to operate on vectors<br />

of features informative for the objects researched, does not<br />

allow the image to be analysed or the organ to be reconstructed<br />

in a holistic fashion, i.e. taking into account the full<br />

dimensions of the image [2-4]. This only becomes possible<br />

when we create linguistic descriptions using image grammars<br />

based on graph formalisms. By definition, such grammars<br />

have been dedicated for analysing image scenes, which in the<br />

case of medical visualisation means that they can be used to<br />

model multi-object structures or to conduct the meaning analysis<br />

of spatial reconstructions of heart tomograms, which will be<br />

demonstrated later in this publication.<br />

Graph-based semantic models<br />

of the heart’s coronary vessels<br />

In order to analyze a 3D reconstruction (visualisations for various<br />

patients obtained during diagnostic examinations of the<br />

heart with a helical CT scanner with 64 detectors), it becomes<br />

necessary to select the appropriate projection showing lesions<br />

in vessels in a way that enables them to be analysed on<br />

a plane. In our research we have attempted to automate the<br />

procedure of finding such a projection by using selected geometric<br />

transformations during image processing. Next, to enable<br />

a linguistic representation of the spatial reconstructions<br />

studied, the coronary vessels shown in them had been subjected<br />

to the operation of thinning, referred to as skeletonizing.<br />

This operation allows us to obtain a skeleton of the arteries<br />

under consideration with the thickness of one unit. This skeleton<br />

can then be subjected to the operation of labelling, which<br />

determines the start and end points of main and surrounding<br />

branches of coronary arteries in it. These points will constitute<br />

the peaks of a graph modelling the spatial structure of the<br />

coronary vessels of the heart.<br />

The next step is labeling them by giving each located informative<br />

point the appropriate label from the set of peak labels<br />

which unambiguously identify individual coronary arteries<br />

forming parts of the structure analysed. For the left coronary<br />

artery they have been defined as follows: LCA - left coronary<br />

artery, LAD - anterior interventricular branch (left anterior descending),<br />

CX - circumflex branch, L - lateral branch, LM - left<br />

marginal branch. And for the right coronary artery they have<br />

been defined as follows: RCA - right coronary artery, A - atrial<br />

branch, RM - right marginal branch, PI - posterior interventricular<br />

branch, RP - right posterolateral branch. This way, all<br />

initial and final points of coronary vessels as well as all points<br />

where main vessels branch or change into lower level vessels<br />

have been determined and labelled as appropriate. After this<br />

operation, the coronary vascularization tree is divided into<br />

sections which constitute the edges of a graph modelling the<br />

examined coronary arteries. Mutual spatial relations that may<br />

occur between elements of the vascular structure represented<br />

by a graph are described by the set of edge labels. The elements<br />

of this set have been defined by introducing the appropriate<br />

spatial relations; vertical - defined by the set of labels<br />

α, β,…, µ and horizontal - defined by the set of labels 1, 2,…,<br />

24 on a hypothetical sphere surrounding the heart muscle.<br />

These labels designate individual final intervals, each of which<br />

has the angular spread of 15°. Then, depending on the location,<br />

terminal edge labels are assigned to all branches identified<br />

by the beginnings and ends of the appropriate sections of<br />

coronary arteries.<br />

ELEKTRONIKA 11/<strong>2009</strong> 9

The presented methodology draws upon the method of<br />

determining the location of a point on the surface of our planet<br />

in the system of geographic coordinates, where a similar cartographic<br />

projection is used to make topographic maps. This<br />

representation of mutual spatial relationships between the<br />

analysed arteries yields a convenient access to and a unanimous<br />

description of all elements of the vascular structure.<br />

As the structure of coronary vascularization may be characterised<br />

by three different types of artery distribution over the<br />

heart surface, in the following part we will propose a grammar<br />

for the left dominance artery distribution. The left dominance<br />

artery distribution is present in on average 10...14% of cases,<br />

with a variety of intermediate forms possible. Before we define<br />

the representation of the analysed image in the form of IE<br />

graphs, we have to introduce the following order relationship<br />

1 ≤ 2 ≤ 3 ≤ … ≤ 24 and α ≤ β ≤ γ ≤ … ≤ µ in the set of Г edge<br />

labels shown in Fig. 1. This way, we index all peaks according<br />

to the ≤ relationship in the set of edge labels which connect<br />

the main peak marked 1 to the adjacent peaks and we index<br />

in the ascending order (i = 2, 3, …, n). This gives us IE graphs<br />

for the right and the left coronary arteries, respectively, presented<br />

in Fig. 1.<br />

When graphs shown in Fig. 1 are represented by their<br />

characteristic descriptions, they look as follows:<br />

For the right coronary artery:<br />

The graph structure created in this way will form elements<br />

of a graph language defining the spatial topology of the heart<br />

muscle vascularization including its possible morphological<br />

changes.<br />

For IE graphs defined as above, in order to locate the<br />

place where stenoses occur in the case of a balanced artery<br />

distribution, the graph grammar may take the following form:<br />

for the right coronary artery:<br />

G P = (S, ∆, Γ, P, Z)<br />

S = {ST, RCA, PI, RM, C_Right},<br />

D = {ST, RCA, PI, RM},<br />

G = {16η, 11ι, 12λ, 14ε}<br />

The start graph Z and the set of productions shown in Fig. 2.<br />

for the left coronary artery:<br />

G L = (S, ∆, Γ, P, Z)<br />

S = {ST, LCA, LM_CX, L_LAD, CX, LM, L, LAD, C_Left,<br />

C_Left_ant, C_Left_circum}<br />

For the left coronary artery:<br />

ST 1 RCA 2 PI 3 RM 4 ST 1 LCA 2 LM_CX 3 L_LAD 4 CX 5 LM 6 L 7 LAD 8<br />

1 2 1 - 1 2 2 2 1 - 1 -<br />

16η 11ι 12λ 1ε - 2κ 13ι 16ι 13θ 1λ 2λ 18ι 22κ - 23η -<br />

2 3 4 4 - 2 3 4 5 6 7 8 6 - 8 -<br />

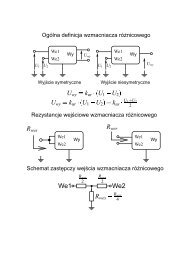

Fig. 1. The representation of the right (A) and the left (B) coronary artery using IE graphs<br />

Rys. 1. Reprezentacja prawej (A) oraz lewej (B) tętnicy wieńcowej za pomocą grafów IE<br />

10 ELEKTRONIKA 11/<strong>2009</strong>

Fig. 2. Start graph Z and the set of productions for grammar G P Rys. 2. Graf startowy Z i zbiór produkcji dla gramatyki G P<br />

D = {ST, LCA, LM_CX, L_LAD, CX, LM, L, LAD},<br />

G = {2κ, 13ι, 16ι, 13θ, 22κ, 1λ, 2λ, 18ι, 23η}<br />

Z is the start graph shown in Fig. 3. P is the set of productions<br />

shown in Fig. 4.<br />

This way, we have defined a mechanism in the form of<br />

ETPL(k) graph grammars which create a certain linguistic representation<br />