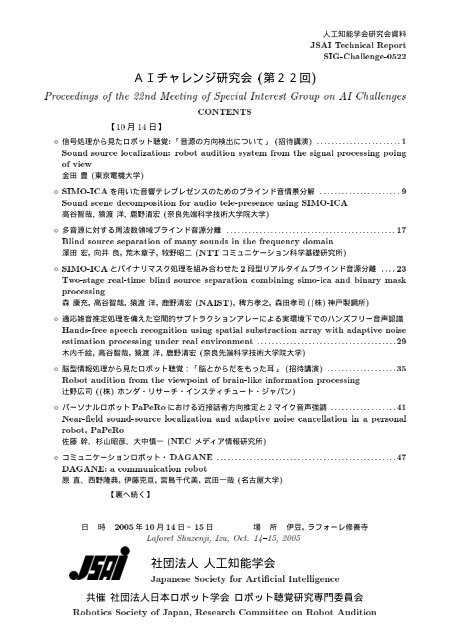

第22回 ロボット聴覚特集 - 奥乃研究室 - 京都大学

第22回 ロボット聴覚特集 - 奥乃研究室 - 京都大学

第22回 ロボット聴覚特集 - 奥乃研究室 - 京都大学

Create successful ePaper yourself

Turn your PDF publications into a flip-book with our unique Google optimized e-Paper software.

SCOT(Smoothed Coherence Transform)PHAT(Phaseτs= d sinθs/ c (3) Transform)[4]d: : s SCOT−θ sin 1ψs( ω)= 1/ Φ11(ω)Φ22( ω) (9)s= ( cτs/ d) (4) Φ11( ω)Φ22( ω)x ( t 1)x ( t 2) TDE(Time Delay Estimation)[3]Φ12( ω)jτ = ∫ω tR12 ( )e dω(10)Φ11(ω)Φ22( ω)(a) φ12( τ )γ12( ω)Φ12( ω)γ12( ω)= (11)φ12 ( τ ) = ∫ x1(t)x2( t + τ ) dt (5)Φ11(ω)Φ22( ω)(1)(2)φ12 ( τ ) = ∫ s(t)s(t −τs+ τ ) dt = φss( τ −τs) (6) SN SN ) φ ss(τ s(t)SN φss ( τ ) = ∫ s(t)s(t + τ ) dt (7) s(t)φ ss(τ )τ = 0 PHATφ12 ( τ ) = φss( τ −τs)ψp( ω)= 1/ Φ12 ( ω) (12)τ = τ 0Φ12( ω)jφ12 ( τ )τ = ∫ ω tR12 ( )e dω (13)Φ12( ω)φ12 ( τ ) τ s (b) (generalized correlation) [4][5]CSP[6]SN SN R12 ( τ ) [4][7]jR τ = ∫ψω Φ ω eω t12( ) ( )12( ) dω (8) [7]) Φ12 ( ω φ12 ( τ )x 1(t )x ( t)2 (8)φ12 ( τ ) (c) s Φ12 ( ω) ψ (ω )s(t)s( t −τs) Φ12( ω)− jψ (ω) sΦsse ωτ12( ω)= Φ ( ω) (14) Φss(ω) s(t)SN Φ12 ( ω) ϕ(ω)ϕ ( ω)= ωτ s(15)s - 2 -

x t),x ( )2 t1( 2tx ( ) x t)+ x ( t − ) 1( 2τE[{ x ( t)+ x ( t −τ)}1= E[x212( t)]+ E[x222]( t)]+ E[x ( t)x( t −τ)] 1 2 1,2 3 Fig.3 Beam aliasing and frequency averaging.(b) [ ]MV MUSIC 3 302 M 100Hz, 300Hz, 500Hz, 200Hz 30 60cm 500Hz 10 [ ]1500Hz 1) - 4 -

Particle (a)(b)φ12(τ )[14]x ( t )t15) x 2( t)tt0(c)1()x ttx 2( t)t(d) (e) φ12(τ ) [15]6) tt 0 HRTF [16][17][18]Fig.6 Peak-hold processing.[19][20]Fig.7 Direct and reflected sound.(c) 26dB(a)2020dBx ( t10)x 1( t 1)tt(b)(d) 2010 10x ( t)x 6( t1 1)tt Fig.8 Logarithmic operation. t- 6 -

Fig.9 Example of peak-hold wave form. 45d Fig.10 Experimental set up.Fig.11 Experimental result (conventional). Fig.11 Experimental result (with peak-hold).- 7 -

- 8 -

社 団 法 人 人 工 知 能 学 会Japanese Society forArtificial Intelligence人 工 知 能 学 会 研 究 資 料JSAI Technical ReportSig-Challenge-0522-2 (10/14)SIMO-ICA Sound Scene Decomposition for Audio Tele-Presence Using SIMO-ICA, , Tomoya TAKATANI, Hiroshi SARUWATARI, Kiyohiro SHIKANO Nara Institute of Science and Technology, Graduate School of Information Science{tomoya-t, sawatari, shikano}@is.naist.jphttp://www.aist-nara.ac.jp/ ∼ tomoya-t/index.htmlAbstractIn this paper, we address a blind decompositionproblem of binaural mixed signals observed atthe ears of humanoid robot, and we introduce anovel blind signal decomposition algorithm usingSingle-Input Multiple-Output-model-basedICA (SIMO-ICA). The SIMO-ICA consists ofmultiple ICAs and a fidelity controller, andeach ICA runs in parallel under the fidelitycontrol of the entire separation system. TheSIMO-ICA can separate the mixed signals, notinto monaural source signals but into SIMOmodel-basedsignals from independent sourcesas they are at the microphones in the robotear. Thus, the separated signals of SIMO-ICAcan maintain the spatial qualities of each soundsource, i.e., they represent the decomposedsound scenes. Obviously the attractive featureof SIMO-ICA is highly applicable to not onlyspeech recognition but also, e.g., humanoidrobot-basedauditory tele-existence technology.The experimental results reveal that the spatialquality of the separated sound in SIMO-ICAis remarkably superior to that of the conventionalmethod, particularly for the fidelity ofthe sound reproduction.1 (BSS) (ICA)[1] BSS [2,3,4]. , . [5], [6], tele-presence (tele-existence)[7, 8] ., Single-Input Multiple-Output(SIMO) SIMO ICA (SIMO-ICA) [9, 10, 11, 12] , SIMOSIMO SIMO SIMO-ICA ICA fidelitycontroller , ICA . SIMO-ICA , SIMO , SIMO-ICA , . 1 SIMO-ICA MINT [13] 2 SIMO-ICA [14] 3 SIMO-ICA [15]9

1 () 2 SIMO-ICA 3 SIMO-ICA tele-presence SIMO-ICA head and torso simulator (HATS) SIMO-ICA , (ITD) (ILD) SIMO-ICA .2 BSS 2.1 , K 2, L 2 . .x(t) ===N−1∑a(n)s(t − n) =A(z)s(t)n=0[][ ]A 11 (z) A 12 (z) s 1 (t)[A 21 (z) A 22 (z) s 2 (t)]A 11 (z)s 1 (t)+A 12 (z)s 2 (t)A 21 (z)s 1 (t)+A 22 (z)s 2 (t), a(n) =[a kl (n)] kl N , A(z) =[A kl (z)] kl =[ ∑ N−1n=0 a kl(n)z −n ] kl a(n) Z . , z −1 z −n · s(t) =s(t − n) [X] ij i j X 2.2 ICA BSS (1), FIR ICA s1(t)s2(t)A11(z)A22(z)A12(z)A21(z)x1(t)x2(t)Head of Humanoid robotICAB1(z)=A11(z), A21(z)B1(z)s1(t)B2(z)s2(t)DistortedmonauralsignalsB2(z)=A12(z), A22(z)Figure 1: ICA B l (z)(B l (z) ̸=A kl (z)) FIR , . ICA.y(t) =[y 1 (t),y 2 (t)] T =D−1∑n=0w(n)x(t − n), (2), w(n) , D . y(t) y l (t) Kullback-Leibler divergence (KLD) . Choi et al. [16].D−1∑{w [j+1] (n) = w [j] (n)− α off-diagd=0y [j] (t − n + d) T〉 t〈ϕ(y [j] (t))}w [j] (d), (3), α , [j] 〈·〉 t . off-diag X X ϕ(y(t)) =[ϕ(y 1 (t)),ϕ(y 2 (t))] T [tanh(y 1 (t)), tanh(y 2 (t))] T ICA , 2 .• • , . SIMO , K()× L() , , L . ICA s i (t) , b i (n) B i (z)s i (t) 10

ICA ICA K × LSIMO ICA , Matsuoka et al. Minimal Distortion Principle[17] ICA . ICA KLD FIR B l (z) , , .2.3 SIMO ICA BSS , , . , w(n) ([18]). SIMO [19, 20], y l (t) , k [21, 22]. , Null space ,, IIR ICA[23] , . Cardoso SIMO MultidimensionalICA (MICA) [24] MICA., FIR SIMO SIMO ICA 3 : SIMO-ICA 2 SIMO SIMO-ICA [9,10,11,12]. SIMO-ICA, 2 2 ICA fidelity controller (FC) 1 [11, 12]SIMO-ICA ICA y (ICA) (t) = [y (ICA)1 (t),y (ICA)2 (t)]=D−1∑n=0w (ICA) (n)x(t − n), (4), w (ICA) (n) ICA . FC, .y (FC) (t) = [y (FC)1 (t),y (FC)2 (t)]= x(t − D 2 ) − y (ICA)(t). (5), y FC (t) ICA , ICA .w FC (n) =Iδ(n − D 2 ) − w ICA(n). (6)δ(n) δ(0) = 1, δ(n) =0(n ̸= 0), (6) (5) .y FC (t) =D−1∑n=0w FC (n)x(t − n). (7)ICA , FC w (FC) (n) w (ICA) (n) , , “” . (5) , FC.[ ]0y (ICA) (t)+y (FC) (t) − x(t − D/2) = . (8)0 y (ICA) (t)+y (FC) (t) SIMO [ ∑ Ll=1 A kl(z)s l (t−D/2)] k1 (= x(t−D/2)). , D/2 ., (4) , (5) , . , [10]11

ICAy FCy FCy SIMO-ICAs 1(t)x 1(t)1( )A 11 (z)s 1(t)tA 11 (z)s 1(t- D/2)(z)s A 1 21(t)A 12 (z)s 2(t)ICA+ -- + ICA( ) y21t( )tA 21 (z)s 1 (t- D/2)A 12 (z)s 2(t- D/2)A 22 (z)s 2(t)2( )A 22 (z)s 2(t- D/2)tx 2(t)Fidelitys 2(t)ControllerFigure 2: SIMO-ICA (4) , (5) , .. , [ ]yICA1 (t)y2 ICA (t)[ ]y1 FC (t)y2 FC(t)[[y1 ICA (t)y2 ICA (t)y FC1 (t)y FC2 (t)]]==or==[A11 (z)s 1 (t − D/2)[[[A 22 (z)s 2 (t − D/2)A 12 (z)s 2 (t − D/2)A 21 (z)s 1 (t − D/2)A 12 (z)s 2 (t − D/2)A 21 (z)s 1 (t − D/2)A 11 (z)s 1 (t − D/2)A 22 (z)s 2 (t − D/2)]]]], (9), (10), (11). (12)ICA (3) (5) KLD w ICA (n) naturalgradient[4] nonholonomic [16] .w [j+1](ICA) (n)D−1= w [j ](ICA) (n) − α ∑ [{ 〈off-diag ϕ ( y [j](ICA) (t))d=0}y [j](ICA) (t − n + d)T〉 w [j ](ICA) (d)t{ 〈 (− off-diag ϕ x(t − D )2 ) − y[j] (ICA) (t)(x(t − n + d − D ) T2 ) − y[j] (ICA)〉t(t − n + d) (Iδ(d − D 2 ) − w[j] (ICA))], (d) (13)4 4.1 Brüel & Kjær Head AndTorso Simulator (HATS) }Figure3 2 2 θ 1 = {−90 ◦ , −75 ◦ , −60 ◦ , −45 ◦ , −30 ◦ , −15 ◦ , 0 ◦ }, θ 2 ={0 ◦ , 15 ◦ , 30 ◦ , 45 ◦ , 60 ◦ , 75 ◦ , 90 ◦ } HATS 1.5 m SNR 0dB 200 ms ASJ 2 4 12 8kHz 3 512 , 5000 . (3) ICA ±60 ◦ [5] SIMO SIMO-model Accuracy (SA) SA .SA = 1 ‖ A 11 (z)s 1 (t − {10log D 2 ) ‖24 10‖ y (ICA)1 (t)−A 11 (z)s 1 (t − D 2 ) ,‖24.2 ‖ A 21 (z)s 1 (t − D 2+10log ) ‖210‖ y (FC)2 (t)−A 21 (z)s 1 (t − D 2 ) ,‖2‖ A 12 (z)s 2 (t − D 2+10log ) ‖210‖ y (FC)1 (t)−A 12 (z)s 2 (t − D 2 ) ,‖2‖ A 22 (z)s 2 (t − D 2+10log ) ‖2 }10‖ y (ICA)2 (t)−A 22 (z)s 2 (t − D 2 ) .‖2(14)Figure 4, 5 . , , SIMO-ICA SA SA . , SIMO-ICA ICA 12

., SIMO-ICA , SIMO tele-presence 4.3 Sound Demonstrations SIMO-ICA WEB .http://www.aist-nara.ac.jp/~tomoya-t/demo_index.html, , .5 ConclusionSIMO-ICA tele-presence SIMO-ICA , SIMO ICA . , HATS. SIMO-ICA , SIMO-ICA [1] P. Comon, “Independent component analysis, a newconcept?,” Signal Processing, vol.36, pp.287–314,1994.[2] P. Smaragdis, “Blind separation of convolved mixturesin the frequency domain,” Neurocomputing,vol.22, pp.21–34, 1998.[3] H. Saruwatari, T. Kawamura, and K. Shikano,“Blind source separation for speech based on fastconvergencealgorithm with ICA and beamforming,”Proc. of Eurospeech, pp.2603–2606, Sept.2001.[4] A. Cichocki and S. Amari, Adaptive Blind Signaland Image Processing: Learning Algorithms andApplications, John Wiley & Sons, Ltd, West Sussex,2002.[5] J. Blauert, Spatial Hearing (revised ed.), Cambridge,MA: The MIT Press, 1997.[6] Y. Tatekura, H. Saruwatari, and K. Shikano,“Sound reproduction system including adaptivecompensation of temperature fluctuation effect forbroad-band sound control,” IEICE Trans. Fundamentals,vol.E85–A, no.8, pp.1851–1860, Aug. 2002.[7] I. Toshima, H. Uematsu, T. Hirahara, “A steerabledummy head that tracks three-dimensionalhead movement: TeleHead,” Acoustical Science andTechnology, vol.24, no.5, pp.327–329, 2003.[8] S. Tachi, K. Komoriya, K. Sawada, T. Nishiyama,T. Itoko, M. Kobayashi and K. Inoue, “Telexistencecockpit for humanoid robot control,” AdvancedRobotics, vol.17, no.3, pp.199–217, 2003.[9] T. Takatani, T. Nishikawa, H. Saruwatari, K.Shikano, “High-fidelity blind separation of acousticsignals using SIMO-model-based Independentcomponent analysis,” IEICE Trans. Fundamentas,vol.E87–A, no.8, pp.2063–2072, 2004.[10] T. Takatani, T. Nishikawa, H. Saruwatari, K.Shikano, “High-fidelity blind source separationof acoustic signals using SIMO-model-based ICAwith information-geometric learning,” Proc. ofIWAENC, pp.251–254, 2003.[11] T. Takatani, T. Nishikawa, H. Saruwatari, K.Shikano, “”Comparison between SIMO-ICA withleast squares criterion and SIMO-ICA withinformation-geometric learning,” Proc. of InternationalCongress on Acoustics, pp.I-329–332, 2004.[12] T. Takatani, S. Ukai, T. Nishikawa, H. Saruwatari,K. Shikano, “Evaluation of simo separation methodsfor blind decomposition of binaural mixed signals,”Proc. of IWAENC, pp.233–236, 2005.[13] H. Saruwatari, H. Yamajo, T. Takatani, T.Nishikawa, K. Shikano, “Blind separation anddeconvolution for convolutive mixture of speechcombining SIMO-model-based ICAand multichannelinverse filtering,” IEICE Trans. Fundamentas,vol.E88–A, no.9, pp.2387–2400, 2004.[14] H.Saruwatari,S.Ukai,T.Takatani,T.Nishikawa,K. Shikano, “Two-stage blind source separationcombining SIMO-model-based ICA and adaptivebeamforming,” Proc. of EUSIPCO, TueAmPO2,2005.14

[15] Y. Mori, H. Saruwatari, T. Takatani, S. Ukai, K.Shikano, T. Hiekata T. Morita “Real-time implementationof two-stage blind sources separationcombining SIMO-ICA and binary masking,” Proc.of IWAENC, pp.229–232, 2005.[16] S. Choi, S. Amari, A. Cichocki, and R. Liu, “Naturalgradient learning with a nonholonomic constraintfor blind deconvolution of multiple channels,”Proc. of International Workshop on ICA andBSS, pp.371–376, Jan. 1999.[17] K. Matsuoka and S. Nakashima, “Minimal distortionprinciple for blind source separation,” Proc. ofInternational Conference on ICA and BSS, pp.722–727, Dec. 2001.[18] N. Murata and S. Ikeda, “An on-line algorithm forblind source separation on speech signals,” Proc. of1998 International Symposium on Nonlinear Theoryand its Application (NOLTA), vol.3, pp.923–926, Sep. 1998.[19] T. Nishikawa, H. Saruwatari, and K. Shikano,“Stable learning algorithm for blind separationof temporally correlated acoustic signals combiningmultistage ICA and linear prediction,” IEICETrans. Fundamentals, vol.E86-A, no.8, pp.2028–2036, 2003.[20] H. Saruwatari, H. Yamajo, T. Takatani, T.Nishikawa, and K. Shikano, “Blind separation anddeconvolution of MIMO-FIR system with coloredsound inputs using SIMO-model-based ICA”, Proc.IEEE Workshop on SSP, pp.421–424, Sept. 2003.[21] C. Simon, P. Loubaton, C. Vignat, C. Jutten, G.d’Urso, “Separation of a class of convolutive mixturesacontrat: a contrast function approach,” Proc.of ICASSP, 1429–1432, March 1999.[22] J.K. Tugnait, “Identification and deconvolution ofmultichannel linear non-gaussian processes usinghigher order statistics and inverse filter criteria,”IEEE trans. on signal processing, Vol. 45. pp 658–672, 1997.[23] N. Charkani, and Y. Deville, “A convolutive separationmethod with self-optimizing non-linearities,”Proc. of ICASSP, pp.2909–2912, Mar. 1999.[24] J.-F. Cardoso, “Multidimensional independentcomponent analysis,” Proc. of ICASSP, vol. 4,pp.1941–1944, May 1998.15

12]Bd10 [sec8 nerfe6 ifDle4 veLl2 aruar0tenI-2(a)Real impulse responseImpulse responseestimated by SIMO-ICA-90 -60 -30 0Direction of s 1 [deg]12]Bd10 [sec8 nerfe6 ifDle4 veLl2 aruar0tenI-2(b)0 30 60 90Direction of s 2 [deg]Real impulse responseImpulse responseestimated by SIMO-ICAFigure 6: (a) h (ICA)1 (t) h (FC)2 (t) ILD , (b) h (ICA)2 (t) h (FC)1 (t) ILD ]0s-100s[μ-200 ecne-300 rife-400 De-500 imTl-600 rauarte -700In-800(a)-90 -60 -30 0Direction of s 1 [deg]Real impulse responseImpulse responseestimated by SIMO-ICA800]s700s[μ600 ecne500 rife400 De300 imTla200 ruar100 teIn0(b)0 30 60 90Direction of s 2 [deg]Real impulse responseImpulse responseestimated by SIMO-ICAFigure 7: (a) h (ICA)1 (t) h (FC)2 (t) ITD (b) h (ICA)2 (t) h (FC)1 (t) ITD 0-10-20]ge-30 [dn-40 tioa-50 timse-60 AO-70 D-80-90(a)-90 -60 -30 0Direction of s 1 [deg]Real impulse responseImpulse responseestimated by SIMO-ICA908070]ge60 [dn50 tioa40 timse30 AO20 D100(b)0 30 60 90Direction of s 2 [deg]Real impulse responseImpulse responseestimated by SIMO-ICAFigure 8: (a) Figure 7 (a) ITD s 1 (b) Figure 7 (b) ITD s 2 16

社 団 法 人 人 工 知 能 学 会Japanese Society forArtificial Intelligence人 工 知 能 学 会JSAI Technical ReportSIG-CHallege-0522-3 (10/14)Blind source separation of many sounds in the frequency domain Hiroshi Sawada, Ryo Mukai, Shoko Araki and Shoji Makino NTT NTT Communication Science Laboratories, NTT Corporation{sawada, ryo, shoko, maki}@cslab.kecl.ntt.co.jpAbstractThis paper describes the frequency-domain approachto the blind source separation (BSS) ofconvolutively mixed acoustic signals. The advantageof the frequency-domain approach is that convolutivemixtures in the time domain can be approximatedas multiple simple mixtures in the frequencydomain. However the permutation ambiguityshould be solved to group the frequency componentsof the same source together. This paperpresents effective methods to align the permutationambiguity. Based on the methods, we succeeded inseparating many sources in real-world situations.1 [1] (BSS: Blind Source Separation [2]) (ICA: Independent Component Analysis [3])BSS ICA ICA ICA [4–6] ICA [7–10]ICA permutation [11–16] permutation 2 2 3 6 3 2 N s 1 (t),...,s N (t) M x 1 (t),...,x M (t) N∑ ∑x j (t) = h jk (l)s k (t − l) (1)k=1 lh jk k j BSS N M N M [16] M 17

観 測 信 号STFTICA時 間 領 域周 波 数 領 域permutationの 解 決(クラスタリング)分 離 信 号ISTFT時 間 周 波 数マスキングFigure 1: BSS L STFT: Short-Time FourierTransformx j (f,τ) =L/2−1∑r=−L/2x j (τ + r)win(r) e −j2πfr (2)f ∈{0, 1 L f s, ..., L−1Lf s} win(r) 1 2πr2(1 + cosL) 0 Lτ STFT (1) f x j (f,τ) ≈N∑h jk (f)s k (f,τ) (3)k=1h jk (f) k j s k (f,τ) (2) x =[x 1 ,...,x M ] T h k =[h 1k ,...,h Mk ] T (3) N∑x(f,τ) ≈ h k (f)s k (f,τ) (4)k=1 x(f,τ) k h k (f)s k (f,τ) ICAy(f,τ) =W(f) x(f,τ), (5)W = [w 1 ,...,w N ] H , w i =[w 1i ,...,w Mi ] T N × M y =[y 1 ,...,y N ] T N N

• 音 源 位 置マイク配 置 情 報ICA• 正 規 化 基 底 ベクトルICA基 底 ベクトル基 底 ベクトルマイク 間 隔 の 最 大 値音 源 位 置推 定周 波 数正 規 化音 源 位 置正 規 化 基 底 ベクトルクラスタリングクラスタリングFigure 2: permutation 2 残 響 時 間 :RT 60 = 130 ms音 源 :3 秒 の 音 声STFT フレーム:size = 128 msshift = 16 ms4cm部 屋 のサイズ:4.45 m × 3.55 m × 2.50 m1.2m1.2ma 30 °b 110 °Figure 4: 音 源マイクFigure 3: permutation [12] a i 2 2 3.2 permutation h jk (f) ≈ exp [ j2πfc −1 p T ]j q k (9) k j h jk (f) (DOA: Direction-Of-Arrival) c p j j 3 q k k 1||q k || =1 3 3 j j ′ Figure 5: ICA (4) (8) a i (f) a ji (f) a j′ i(f) a ji (f)a j′ i(f) = a jiy ia j′ iy i≈ h jks kh j′ ks k= h jk(f)h j′ k(f)(12) i k permutation (12) (11) ˆθ jj′i(f) = arccos arg[a ji(f)/a j′ i(f)]2πfc −1 (13)||p j − p j ′|| 4 BSS (13) 4 STFT L = 1024 permutation q k (12) (10) h jk (f)h j ′ k(f)≈ exp [ j2πfc −1 (p j − p j ′) T q k]= exp][j2πfc −1 ||p j − p j ′|| cos θ jj′k(10)(11)2πfc −1 (p j −p j ′) T q k ≈ arg[a ji (f)/a j′ i(f)] (14)u (j 1 ,j 1 ′ ),...,(j u,j u ′ ) q k (j, j ′ ) θ jj′k 2 [13, 14] 2πfc −1 Dq k = r i (f) (15)D = [p j1 −p j ′1, ..., p ju −p j ′ u] T ,r i (f) = [arg(a j1i/a j ′1i), ..., arg(a jui/a j ′ ui)] T .19

q k Moore-Penrose D + ˆq i (f) = D+ r i (f)2πfc −1 , ˆq i(f) ← ˆq i(f)||ˆq i (f)||(16)4.1 3 BSS (16) 3.3 a i (f) ā i (f) permutation ā i (f) =[ā 1i (f),...,ā Mi (f)] T ā ji (f) [ā ji (f) ←|a ji (f)| exp j arg[a ]ji(f)/a Ji (f)]4fc −1 (17)d maxFigure 6: 3 6 4cm 8 J d max J scaling 1 ā i (f) ← ā i (f) / ||ā i (f)|| (18) ā i (f) (9) q k p 1 ,...,p M (14) ā ji (f) ≈ √ 1 [exp j π (p j − p J ) T ]q k,M 2 d max f [15] ā i C 1 ,...,C M C k c k |C k | C k c k ← ∑ā/|C k |, c k ← c k /||c k ||, (19)ā∈C kā ∈ C k c k J J =M∑J k , J k = ∑k=1ā∈C k||ā − c k || 2 . (20)Figure 7: f Π f Π f =argmin ΠM ∑k=1||ā Π(k) (f) − c k || 2 . (21)4.2 3 4 2 4.1 3 6 6 3 6 8 BSS 8 6 BSS 2GHz PentiumM PC 25 (16) 7 20

Table 1: 6 : SIR (dB)SIR 1 SIR 2 SIR 3 SIR 4 SIR 5 SIR 6 SIR −11.6 −9.0 −9.0 −6.6 −6.9 −2.5 −7.6SIR 19.2 21.2 25.4 21.0 20.5 16.2 20.670cm90cma120主 要 音 源80cm445 cmb120270cm25cm80cmSquared distance10.80.60.40.2Squared distances from corresponding centroid11100 2 40.80.60.40.200 2 40.80.60.40.200 2 4Frequency (kHz)0.80.60.40.200 2 4Figure 9: 1 355 cmc170 ( 高 さ170 cm)2.5cmMic. 3 Mic. 14cm2.5cm2.3cmMic. 43.5cm Mic. 2背 景 雑 音マイクロホン80cm150cm80cm25cm25cm• 部 屋 の 高 さ: 250 cm • 残 響 時 間 : RT 60= 130 ms• スピーカとマイクロホンの 高 さは120cm,ただしc170は170cmSquared distance10.80.60.40.2Squared distances from corresponding centroid11100 2 40.80.60.40.200 2 40.80.60.40.200 2 4Frequency (kHz)0.80.60.40.200 2 4Figure 8: 3 Figure 10: 3 ˆq i (f) 1 6 permutation permutation SIR: Signal-to-Interference Ratio 1 SIR 20dB4.2 8 6 3 9 4 4 ICA permutation 3.3 9 10 4 M 4 J k /|C k | 9 1 10 3 3 11 1 1 6 7 4 ICA 11 2) [15] 3) 4) 3 SIR 2 10 4 9 3 6 10dB SIR http://www.kecl.ntt.co.jp/icl/signal/sawada/demo/dominant/ 21

Frequency (kHz)2102102102101) Mixture20 40 60 802) Only ICA20 40 60 803) ICA and T−F masking20 40 60 804) Target source component20 40 60 80Time frameFigure 11: : 1)2) ICA 3) ICA (T-F masking)4) Table 2: 9 3 : SIR (dB) a120 b120 c170 SIR −3.9 −3.6 −5.9ICA 12.5 13.6 14.5ICA 15.1 16.5 17.65 BSS 2permutation ICA BSS permutation [16][1] B. D. Van Veen and K. M. Buckley, “Beamforming: a versatileapproach to spatial filtering,” IEEE ASSP Magazine, vol. 5, pp.4–24, Apr. 1988.[2] S. Haykin, Ed., Unsupervised Adaptive Filtering (Volume I:Blind Source Separation). John Wiley & Sons, 2000.[3] A. Hyvärinen, J. Karhunen, and E. Oja, Independent ComponentAnalysis. John Wiley & Sons, 2001.[4] K. Matsuoka and S. Nakashima, “Minimal distortion principlefor blind source separation,” in Proc. ICA 2001, Dec. 2001, pp.722–727.[5] S. C. Douglas and X. Sun, “Convolutive blind separation ofspeech mixtures using the natural gradient,” Speech Communication,vol. 39, pp. 65–78, 2003.[6] S. C. Douglas, H. Sawada, and S. Makino, “A spatio-temporalFastICA algorithm for separating convolutive mixtures,” inProc. of 2005 IEEE International Conference on Acoustics,Speech, and Signal Processing (ICASSP 2005), vol. V, Mar.2005, pp. 165–168.[7] P. Smaragdis, “Blind separation of convolved mixtures inthe frequency domain,” Neurocomputing, vol. 22, pp. 21–34,1998.[8] N. Murata, S. Ikeda, and A. Ziehe, “An approach to blindsource separation based on temporal structure of speech signals,”Neurocomputing, vol. 41, no. 1-4, pp. 1–24, Oct. 2001.[9] F. Asano, S. Ikeda, M. Ogawa, H. Asoh, and N. Kitawaki,“Combined approach of array processing and independentcomponent analysis for blind separation of acoustic signals,”IEEE Trans. Speech Audio Processing, vol. 11, no. 3, pp. 204–215, May 2003.[10] H. Saruwatari, S. Kurita, K. Takeda, F. Itakura, T. Nishikawa,and K. Shikano, “Blind source separation combining independentcomponent analysis and beamforming,,” EURASIP Journalon Applied Signal Processing, vol. 2003, no. 11, pp. 1135–1146, Nov. 2003.[11] H. Sawada, R. Mukai, S. Araki, and S. Makino, “Polar coordinatebased nonlinear function for frequency domain blindsource separation,” IEICE Trans. Fundamentals, vol. E86-A,no. 3, pp. 590–596, Mar. 2003.[12] ——, “A robust and precise method for solving the permutationproblem of frequency-domain blind source separation,”IEEE Trans. Speech Audio Processing, vol. 12, no. 5, pp. 530–538, Sept. 2004.[13] R. Mukai, H. Sawada, S. Araki, and S. Makino, “Frequencydomain blind source separation for many speech signals,”in Proc. of the 5th International Conference on IndependentComponent Analysis and Blind Signal Separation (ICA 2004 /LNCS 3195). Springer-Verlag, Sept. 2004, pp. 461–469.[14] H. Sawada, R. Mukai, S. Araki, and S. Makino, “Frequencydomainblind source separation,” in Speech Enhancement,J. Benesty, S. Makino, and J. Chen, Eds. Springer, Mar. 2005,pp. 299–327.[15] H. Sawada, S. Araki, R. Mukai, and S. Makino, “Blind extractionof a dominant source from mixtures of many sources usingICA and time-frequency masking,” in Proc. of 2005 IEEE InternationalSymposium on Circuits and Systems (ISCAS 2005),May 2005, pp. 5882–5885.[16] S. Araki, H. Sawada, R. Mukai, and S. Makino, “A novel blindsource separation method with observation vector clustering,”in Proc. 2005 International Workshop on Acoustic Echo andNoise Control (IWAENC 2005), Sept. 2005.22

社 団 法 人 人 工 知 能 学 会Japanese Society forArtificial Intelligence人 工 知 能 学 会JSAI Technical ReportSIG-CHallege-0522-4 (10/14)SIMO-ICA 2 Two-Stage Real-Time Blind Source Separation Combining SIMO-ICA and Binary Mask Processing † † † † ‡ ‡Y. Mori † , T. Takatani † , H. Saruwatari † , K. Shikano † ,T.Hiekata ‡ ,T.Morita ‡† Nara Institute of Science and Technology‡() Kobe Steel,Ltd.E-mail: †{yoshim-m, tomoya-t, sawatari, shikano}@is.naist.jp,‡{t-hiekata, takashi-morita}@kobelco.jpAbstractWe newly propose a real-time two-stage blindsource separation (BSS) for binaural mixed signalsobserved at the ears of humanoid robot, inwhich a Single-Input Multiple-Output (SIMO)-model-based independent component analysis(ICA) and binary mask processing are combined.SIMO-model-based ICA can separatethe mixed signals, not into monaural source signalsbut into SIMO-model-based signals fromindependent sources as they are at the microphones.Thus, the separated signals ofSIMO-model-based ICA can maintain the spatialqualities of each sound source, and thisyields that binary mask processing can be appliedto efficiently remove the residual interferencecomponents after SIMO-model-basedICA. The experimental results obtained witha human-like head reveal that the separationperformance can be considerably improved byusing the proposed method in comparison tothe conventional ICA-based and binary-maskbasedBSS methods.1 (BSS) (DOA) BSS BSS [1] [2, 3] (ICA) [4] BSS [5,6,7,8] BSS ICA ICA [9] ICA () 2 BSS BSS 2 Single-Input Multiple-Output (SIMO) ICA (SIMO-ICA) [10, 11] SIMO-ICA SIMO – [12, 13, 14] “SIMO” SIMO-ICA SIMO SIMO-ICA SIMO-ICA BSS23

S 1 (f)S 2 (f)+θ 1 θ 2Sound sourcesS (f) LMicrophonesHead ofhumanoid robotFigure 1: 2 BSS2.1 K L L θ l (l =1, ··· ,L) (Figure 1)K = L ...X (f) =A(f)S (f) (1) X (f) =[X 1 (f) ,...,X K (f)] T S (f,t) =[S 1 (f) ,...,S L (f)] T A(f) =[A kl (f)] kl[·] ij i j · A(f)2.2 ICA BSS ICA (FDICA) (DFT) X(f,t) =[X 1 (f,t),...,X K (f,t)] T – W (f) =[W lk (f)] lk Y (f,t) =[Y 1 (f,t),...,Y K (f,t)] T Y (f,t) =W (f)X(f,t) (2) W (f) [ 〈W [i+1] (f) =η I − Φ (Y (f,t)) Y (f,t) H〉 ]W [i] (f)t+ W [i] (f) (3) I 〈·〉 tX H [i] i η Φ (Y (f,t)) [15]Φ (Y (f,t)) ≡[e j·arg(Y1(f,t)) ,...,e j·arg(YL(f,t))] T(4)arg(·) [8, 16] (a) Proposed two-stage BSSSourcesignalsS 1(f)A(f)S (f)2ObservedsignalsX (f) 1X (f)2SIMOmodelbasedICA(b) Simple combination of conventional ICA and binary maskSourcesignalsS (f)2ObservedsignalsS 1(f) X (f)A(f)ICAA 11(f)S 1(f,t)A 21(f)S 1(f,t)Binary maskprocessingY 1(f,t)A 12(f)S 2(f,t)Binary maskA (f)S (f,t) processing22 2Y 2(f,t)B 1(z)s 1(t)1 Y 1(f,t)X (f)2B (z)s (t)2 2Binary maskprocessingY 2(f,t)Figure 2: (a) 2 BSS(b) ICA (K = L =2)2.3 BSS [12, 13, 14] ICA BSS () –l l L =2l Ŷ l (f,t) =m l (f,t) X l (f,t) (5) m l (f,t) |X l (f,t)| >|X k (f,t)| (k ≠ l) m l (f,t) = 1m l (f,t) =0– ()3 2 BSS 3.1 SIMO-ICA [10,11] SIMO 24

SIMO-ICA SIMO Figure 2(a)SIMO-ICA 2 BSS SIMO-ICA ICA 2 (Figure 2(b)) [17] ICA Y l (f,t) =B l (f)S l (f,t) +E l (f,t) (l =1, ··· ,L)( B l (f) E l (f,t) ICA) E l (f,t) – 0 () Y 1 (f,t) Y 2 (f,t) ICA BSS SIMO-ICA SIMO-ICA SIMO A kl (f)S l (f,t) SIMO SIMO-ICA 3.2 SIMO-ICA [10] ICA SIMO SIMO-ICA SIMO-ICA (FD-SIMO-ICA) FD-SIMO-ICA (L − 1) FDICA fidelity controller(FC) ICA FD-SIMO-ICA l ICA (l =1,...,L− 1) []Y (ICAl) (f,t) = Y (ICAl)k(f,t) = W (ICAl) (f) X (f,t)k1(6)UnknownKnownS1(f) X1(f)A11(f)A12(f)A21(f)A22(f)S2(f) X2(f)FD-SIMO-ICAICA1-+-+++Fidelity controllerTo beindependent(ICA1)Y1(ICA1)Y2YY(ICA2)1(ICA2)2To beindependent(f,t)(f,t)(f,t)(f,t)Figure 3: K = L =2 FD-SIMO-ICA W (ICAl) (f) =[W (ICAl)ij (f)] ij l FDICAFC L−1∑Y (ICAL) (f,t) =X (f,t) − Y (ICAl) (f,t) (7)l=1Y (ICAL) (f,t) L ICA L ICA ICA Y (ICAL) (f,t) W (ICAl) (f) (l =1, ··· ,L− 1) (− ∑ L−1l=1 Y (ICAl)(f,t)) (7) ICA ∑ Ll=1 Y (ICAl)(f,t) SIMO [ ∑ Ll=1 A kl(f)S l (f,t)] k1 (= X(f,t)) (6) (7) SIMO Y (ICAl) (f,t) =diag [ A(f)PlT ]Pl S (f,t) (8) P l (l =1,...,L) ∑ Ll=1 P l =[1] ij [10] (8) l SIMO A kl (f)S l (f,t)SIMO-ICA L = K =2ICA [] TY (ICA1)1 (f,t), Y (ICA1)2 (f,t)=[A 11 (f)S 1 (f,t), A 22 (f)S 2 (f,t)] T , (9)[] TY (ICA2)1 (f,t), Y (ICA2)2 (f,t)=[A 12 (f)S 2 (f,t), A 21 (f)S 1 (f,t)] T , (10)P 1 = IP 2 =[1] ij − I 25

θ 1s 2 (8) (7) Kullback-Leibler Divergence W (ICAl) (f) Natural Gradient l (l =1,...,L−1) ICA Nonholonomic [5] FD-SIMO-ICA l (l =1,...,L− 1) ICA 4.25 0.58 mmLoudspeakersm)(Height:1.17 ( )t s 1 ) ( tm0.74W [j+1](ICAl) (f)[ { 〈= W [j](ICAl) (f) − α off-diagΦ}Y [j](ICAl) (f,t)H〉 · W [j](ICAl) (f)t{ 〈− off-diag Φ ( L−1∑X (f,t) −l ′ =1· (X L−1∑〉 }(f,t) − Y [j](ICAl ′ ) (f,t)) Htl ′ =1(Y [j](ICAl) (f,t) )Y [j](ICAl ′ ) (f,t))( L−1∑) ]· I − W [j](ICAl ′ ) (f) (11)l ′ =1m 1.50Microphones2.04 mm)(Height:1.17 ReverberationTime: 200 msθ 2m2.02HATSm4.25Figure 4: α Φ(·) [15]Φ (Y (f,t)) ≡ [ tanh(|Y 1 (f,t)|)e j·arg(Y1(f,t)) , ··· ,tanh(|Y L (f,t)|)e j·arg(YL(f,t))] T. (12)W (ICAl) (f) FD-SIMO-ICA FD-SIMO-ICA (9), (10) 1 Ŷ 1 (f,t) =m 1 (f,t) Y (ICA1)1 (f,t) (13)m 1 (f,t) |Y (ICA1)1 (f,t)| > |Y (ICA2)2 (f,t)| m 1 (f,t) = 1 m 1 (f,t) =0 2 Ŷ 2 (f,t) =m 2 (f,t) Y (ICA1)2 (f,t) (14)m 2 (f,t) |Y (ICA1)2 (f,t)| > |Y (ICA2)1 (f,t)| m 2 (f,t) = 1 m 2 (f,t) =0L = K>2 4 4.1 Figure 4 2 2 2 200 ms Brüel & Kjær Head And Torso Simulator(HATS; Figure 5 ) 2 (θ 1 ,θ 2 ) Figure 5: Head And Torso Simulator (θ 1 ,θ 2 )=(−60 ◦ , 60 ◦ ), (−60 ◦ , 0 ◦ ) 2 2 4 HumanSpeechLikeNoise 2 3 8kHz 1024 ±15 ◦ ±30 ◦ HRTF 4.2 A∼D 4 (A) (5) (B) (2) ICA(C) ICA (D) DOA HATS() Signal-to-NoiseRatio (SNR) dB Noise Reduction Rate(NRR) [8] SNR Figure 6 NRR 12 26

Binary maskConventional ICAConventional ICA + Binary maskProposed method]252525B25(a) (b) (c) (d)[dte202020a20Rn15io151515tcu1010d1010eRe5555isoFigure 6: NRR(a) (−60 ◦ , 60 ◦ ) ±30 ◦ ,(b) (−60 ◦ , 60 ◦ ) ±15 ◦ ,(c) (−60 ◦ , 0 ◦ ) ±30 ◦ ,(d) (−60 ◦ , 0 ◦ ) ±15 ◦ ,0000NBinary maskConventional ICAConventional ICA + Binary maskProposed method]25252525B(a) (b) (c) (d)[d20202020teaRn15151515tiocu10 d101010eR5555eisoFigure 7: NRR(a) (−60 ◦ , 60 ◦ ) ±30 ◦ ,(b) (−60 ◦ , 60 ◦ ) ±15 ◦ ,(c) (−60 ◦ , 0 ◦ ) ±30 ◦ ,(d) (−60 ◦ , 0 ◦ ) ±15 ◦0000NFigure 7 NRR 2 BSS SIMO-ICA 5 DSP 2 BSS (TI-C67, 200 MHz, 150 g; Figure 8) Figure 9 1. (FFT) -2. SIMO-ICA 3 3 SIMO-ICA 3 3. SIMO-ICA SIMO-ICA 4. FFT SIMO-ICA 3 ICA SIMO-ICA 6 SIMO ICA BSS 2 BSS NRR 27

Figure 8: BSS ......FFTLeft-channel inputRight-channel input......FFT FFT FFT FFT FFT FFT FFT FFTSIMO-ICAFilter updatingin 3 s durationReal-time filteringSIMO-ICAFilter updatingin 3 s duration... ...W(f)W(f)Real-time filteringW(f)Binary Binary Binary Binary Binary Binary Binary BinaryMask Mask Mask Mask Mask Mask Mask MaskSeparated signal reconstruction with Inverse FFT...TimeFigure 9: ICA [1] K. Nakadai, D. Matsuura, H. Okuno, and H. Kitano,“Applying scattering theory to robot auditionsystem: robust sound source localization and extraction,”Proc. IROS-2003, pp.1147–1152, 2003.[2] R. Nishimura, T. Uchida, A. Lee, H. Saruwatari, K.Shikano, and Y. Matsumoto, “ASKA: Receptionistrobot with speech dialogue system,” Proc. IROS-2002, pp.1314–1317, 2002.[3] R. Prasad, H. Saruwatari, and K. Shikano, “Robotsthat can hear, understand and talk,” AdvancedRobotics, vol.18, pp.533–564, 2004.[4] P. Comon, “Independent component analysis, a newconcept?,” Signal Processing, vol.36, pp.287–314,1994.[5] N. Murata and S. Ikeda, “An on-line algorithm forblind source separation on speech signals,” Proc.NOLTA98, vol.3, pp.923–926, 1998.[6] P. Smaragdis, “Blind separation of convolved mixturesin the frequency domain,” Neurocomputing,vol.22, pp.21–34, 1998.[7] L. Parra and C. Spence, “Convolutive blind separationof non-stationary sources,” IEEE Trans. Speech&AudioProcessing, vol.8, pp.320–327, 2000.[8] H. Saruwatari, S. Kurita, K. Takeda, F. Itakura,T. Nishikawa, and K. Shikano, “Blind source separationcombining independent component analysisand beamforming,” EURASIP Journal on AppliedSignal Processing, vol.2003, pp.1135–1146, 2003.[9] S. F. Boll, “Suppression of acoustic noise inspeech using spectral subtraction,” IEEE Trans.Acoust., Speech & Signal Process., vol.ASSP-27,no.2, pp.113–120, 1979.[10] T. Takatani, T. Nishikawa, H. Saruwatari,and K. Shikano, “High-fidelity blind separationof acoustic signals using SIMO-model-basedICA with information-geometric learning,” Proc.IWAENC2003, pp.251–254, 2003.[11] T. Takatani, T. Nishikawa, H. Saruwatari, and K.Shikano, “High-fidelity blind separation of acousticsignals using SIMO-model-based independentcomponent analysis,” IEICE Trans. Fundamentals,vol.E87-A, no.8, pp.2063–2072, 2004.[12] R. Lyon, “A computational model of binaural localizationand separation,” Proc. ICASSP83, pp.1148–1151, 1983.[13] N. Roman, D. Wang, and G. Brown, “Speechsegregation based on sound localization,” Proc.IJCNN01, pp.2861–2866, 2001.[14] M. Aoki, M. Okamoto, S. Aoki, H. Matsui, T.Sakurai, and Y. Kaneda, ”Sound source segregationbased on estimating incident angle of each frequencycomponent of input signals acquired by multiplemicrophones,” Acoustical Science and Technology,vol.22, no.2, pp.149–157, 2001.[15] H. Sawada, R. Mukai, S. Araki, and S. Makino,“Polar coordinate based nonlinear function for frequencydomain blind source separation,” IEICETrans. Fundamentals, vol.E86-A, no.3, pp.590–596,2003.[16] H. Sawada, R. Mukai, S. Araki, and S. Makino, “Arobust and precise method for solving the permutationproblem of frequency-domain blind sourceseparation,” Proc. Int. Sympo. on ICA and BSS,pp.505–510, 2003.[17] M. Aoki and K. Furuya, ”Using spatial informationfor speech enhancement,” Technical Report of IE-ICE, vol.EA2002-11, pp.23–30, 2002 (in Japanese).28

社 団 法 人 人 工 知 能 学 会Japanese Society forArtificial Intelligence人 工 知 能 学 会JSAI Technical ReportSIG-CHallege-0522-5 (10/14)Hands-Free Speech Recognition Using Spatial Subtraction Arraywith Adaptive Noise Estimation Prosessing under Real EnvironmentChie Kiuchi, Tomoya Takatani, Hiroshi Saruwatari, Kiyohiro ShikanoNara Institute of Science and Technologychie-k@is.naist.jpAbstractWe newly propose an improved spatial subtractionarray (SSA) with an adaptive noise estimationprocessing, which aims at the achievementof robust hands-free speech recognition in realenvironments. The previously proposed SSAcan recognise a target speech with a high accuracyunder a laboratory environment. Howeverthe conventional SSA used an ideally designednull beamformer (NBF) for noise estimation,and consequently it cannot take intoaccount the reverberation effect which arises inan actual environment. The proposed SSA introducesadaptive beamformer (ABF) for theaccurate noise estimation, and thereby remarkablyimproves the noise subtraction performanceeven under real reverberant conditions.The speech recognition experiments reveal thatthe word accuracy of the proposed SSA is superiorto that of the conventional SSA as wellas the conventional delay-and-sum beamformerand adaptive beamformer.1 (SSA) [1]SSA Delay-and-Sum (DS)[2] Griffith-Jim (GJ)[2],[3] DSDSGJ DS GJ DS GJ GJ DS GJSSA Mel FrequencyCepstrum Coefficient (MFCC)[4] (NBF)[5] NBF SSA [1] () NBF SSA () NBF SSA SSA(ABF SSA) NBF SSA ABF SSA 29

2 : GJ [2],[3]SSA SSA DS SSA GJ GJ 2.1 GJ GJ 1 x j (t) (j =1, ,J) J GJ GJ z(t) Z(k) =Y DS (k) − A T ADF(k)Y SUB (k) (1)T k Y DS (k) DS Y SUB (k) =[Y1 SUB (k), ···,YJ−1 SUB(k)]TA ADF (k) =[A ADF1 (k), ···,A ADFJ−1 (k)]T (LMS) |Z(k)| 2 A (h+1)ADF(k) =A(h)ADF (k)+μ·Z(h) (k)Y (h)SUB(k) (2)μ (h) 2.2 GJ GJ (2) J − 1 DS GJ GJ SSA 3 SSA[1]3.1 SSA 2 x j (t)(j =1, ,J) User’sSpeechθd sinθNoisex 1() t()PhaseCompensationMain Passd FFY DS( k)θ∑x JtT+-+-YSUB,1YSUB,J -1( k)( k)J-1 chAdaptiveFilter+∑Reference Pass-Z( k)Figure 1: GJ User’sPhase Main PassSpeechx 1() t Compensationm()1θFY()kLogdMel-scale+SpectralTransformF θ ∑ Filterd sinθSubtract andTBankDCTx J() tm( L)Z()kNoiseBeam-FormerMel-scaleFilterBankReference Pass-Figure 2: SSA IFFTz() tMFCC()iJ Y (k) θZ(k) SSA GJ DS SSA MFCC [4] SSA Y (k) Z(k) 3.2 [4]SSA MFCC L W (k; l) (l =1, ···,L) 3 ⎧k − k lo (l) (⎪⎨klo (l)≤k≤k c (l) )W (k; l) =k c (l) − k lo (l)k hi (l) − k (⎪⎩kc (l)≤k≤k hi (l) ) (3)k hi (l) − k c (l)30

k lo (l), k c (l), k hi (l) l k c (l) =k hi (l − 1) = k lo (l + 1) (4)k c (l) k c (l) Mel kc(l) {Mel kc(l) = 2595 log 10 1+ k }c(l)f s(5)1400(N − 1) f s N FFT 3.3 (6) Y (k) Z(k) (7) m(l) =k hi (l)∑k=k lo (l)W (k; l){|Y (k)| 2 − α(l) · β·|Z(k)| 2} 1 2(6)(if |Y(k)| 2 − α(l) · β·|Z(k)| 2 ≥ 0)k hi (l)∑m(l) = W (k; l) { γ ·|Y (k)| } ( otherwise ) (7)k=k l o (l)m(l) l β L γ α(l) 0 ( ) 2 mY (l)α(l) =m Z (l)⎛⎞2k hi (l)∑W (k; l)|Y (k)|k=k=l o (l) k⎜ hi (l)(8)∑⎟⎝ W (k; l)|Z(k)| ⎠k=k l o (l)m Y (l), m Z (l) SSA m(l) 24 SSA m(l) GJ 1( k l)W ;l −1 l l + 1・・・・ ・・・k c( l −1)k hi( l −1)k hi() lk lo() l k c() l k c( l +1)( l +1)k loFigure 3: SSA SSA MFCC (6) (7) m(l) √2L∑{ }{ } (l 1)iπMFCC(i) = logL e m(l) cos − (9)2 Ll=1i MFCC 3.4 [5]SSA NBF SSA NBF NBF SSA X(k) [x 1 (t), ,x J (t)] T NBF Y NBF (k) (10) 31Y NBF (k) =A T NBF(k)X(k) (10)A NBF (k) NBF A NBF (k) =[A NBF1 (k), ···,A NBFJ (k)] T= { [1, 0] · [e NBF (k, θ N ), e NBF (k, θ U )] +} T(11)θ N θ U e NBF (k, θ) (12) e NBF (k, θ) = [ exp(j2π k K f sd 1 sinθ/c)···, exp(j2π k K f sd J sinθ/c) ] T(12)c d 1 d J k

??????3.5 NBF SSA NBF NBF NBF NBFTrainingNoiseProcessingUserNoiseTrainingUserx 1() t???x J() tx 1() tx J() tFilter gFilter g1g2 FilterFilter gJ++Figure 4: ABF x 1() t??????x???J() t+OutputMinimizeNoiseOutputOutputUserMinimizeUser3.6 SSA [6] SSA MFCC [1]4 : ABF SSA (ABF SSA)4.1 3.5 NBF SSA (ABF) SSA (ABF SSA) 1 Frost [7] Frost ABF 1 Frost ABF SSA Frost ABF 4 5 Frost ABF 4 4 ProcessingUserNoisex 1() tx J() tFilter gFilter g1g2 FilterFilter gJ+OutputFigure 5: SSA ABF Noise SSA Frost ABF 5 SSA 5 SSA 4.2 ABF ABF SSA SSA θ N SSA DFT -X(k, n) ABF G(k) X(k, n) X(k, n) G(k) Y (k, n) (13) Y (k, n) =G(k) T X(k, n) (13)G(k) = [G 1 (k), ,G J (k)] T (14)n ABF , () θ N 1 Y (k, n) G(k) 32

5.75 m4.33 mNoise1.15 mUser 40°2.151.15 mcm・Reverberation time : 200 msNumber of microphones : 4, 8Figure 6: 13.33 mReverberation time : 260 msNumber of microphones : 4, 8Figure 8: NBF 2.94 m1 mUser1 m 60°2.15 cmFigure 7: 2Noise (15) G(k) =d θN (k) H R(k) −1d θN (k) H R(k) −1 d θN (k)(15)Gain [dB]100-10-20-30-40-50-90-450Direction [degree] 45200090 0Figure 9: ABF 800060004000Frequency [Hz]R(k) 〈X(k, n)X(k, n) H 〉 t B (16)⎡exp[j2π k K f ⎤sd 1 sin(θ N )/c]d θN (k) ⎢⎥⎣.⎦ (17)exp[j2π k K f sd J sin(θ N )/c]R(k) d θN (k) θ N [2] B H 5 5.1 6 7 6 7 1 25.2 1: NBF ABF 3 8 9 NBF ABF 0 NBF 8 0 ABF 9 NBF 5.3 2: 6 7 NBF SSA ABF SSA DS GJ 6 7 SNR 10 dB β γ PTM[8](2000 64 ) [6] 33

Word Accuracy[%]Word Accuracy[%]807060504030204 mics.8 mics.Upper limit: 73.49%100Unprocessed DS GJ NBF-type ABF-type(1 mic.)SSA SSAFigure 10: 1 807060504030204 mics.8 mics.Upper limit: 75.73%100Unprocessed DS GJ NBF-type ABF-type(1 mic.)SSA SSAFigure 11: 2 5.4 10 11 (Upper limit) 1 NBF SSA DS GJ ABF SSA NBF SSADS GJ 2 NBF SSA DS GJ 1 2 2 1 NBF SSA 2 GJ DS ABF SSA NBF SSADS GJ ABF SSA ABF SSA 6 (ABF SSA) ABF SSA 1 NBF ABF ABF ABFNBF 2 NBF SSA ABF SSA ABF SSA e-Society 34[1] Y. Ohashi, T. Nishikawa, H. Saruwatari, A. Lee,K. Shikano, “Noise-Robust Hands-free SpeechRecognition Based on Spatial Subtraction Arrayand Known Noise Superimposition,” IEEE/RSJ InternationalConference on Intelligent Robots andSystems, pp.533–537, 2005.[2] , , , “,” , 1995.[3] L. J. Griffith, and C. W. Jim, “An alternative approachto linearly constrained adaptive beamforming,”IEEE Trans. Antennas & Propagation, vol.30,no.1, pp.27–34, 1982.[4] , , , , , “,” , 2001.[5] H. Saruwatari, S. Kurita, K. Takeda, F. Itakura,T. Nishikawa, K. Shikano, “Blind source separationcombining independent component analysisand beamforming,” EURASIP Journal on AppliedSignal Processing, vol.2003, no.11, pp.1135–1146,2003.[6] , , , , , , , vol.J-87-D-II, no.4,pp.933–941, 2004.[7] O.L. Frost, “An algorithm for linearly constrainedadaptive array processing,” Proceedings of theIEEE, vol.60, no.8, pp.926–935, 1972.[8] A. Lee, T. Kawahara, K. Takeda, K. Shikano, “Anew phonetic tied-mixture model for efficient decoding,”Proc. ICASSP, vol. III, pp.1269–1272, 2000.

おける 方 法 論 に 関 しては 制 約 が 多 い。 最 大 の 制 約 は言 語 を 扱 える 動 物 が「ヒト」しか 見 当 たらないという 点 である。しかし、 近 年 は fMRI などの 非 侵 襲 の 脳 計 測 手 法 が発 達 し、ヒトの 脳 の 活 動 がある 程 度 計 測 できるようになった。そのような 画 像 化 手 法 と 脳 損 傷 の 観 測 をあわせることで、 新 たな 知 見 が 加 速 度 的 に 増 えている。 言 語 処 理 に 関 わる 脳 領 域 に 関 しても、その 領 域は Broca 野 ,Wernicke 野 だけでなく、かなり 広 範 な 部分 が 重 要 な 機 能 を 果 たしていることがわかりつつある[20]。つまり、 脳 における 言 語 情 報 処 理 を 解 明 するためには、どこかが 活 動 しているというような 場 所 の 情報 解 析 より 各 脳 部 位 活 動 との 時 空 間 的 関 係 や 変 化 の情 報 の 解 析 が 必 要 である。そのような 観 点 で、 聴 覚情 報 を 軸 に、 脳 を 眺 めてみる。Fig.1 に 感 覚 信 号 ・ 運動 信 号 と 脳 の 主 要 部 位 との 関 係 を 図 示 した。Figure 1. Hierarchical structure of a brain.身 体 から 得 られる 感 覚 情 報 は 脳 幹 を 通 し、 基 底 核や 間 脳 に 至 り、さらに 辺 縁 系 、そして 最 後 に 大 脳 新皮 質 へ 至 る。 信 号 を 伝 達 するのには 時 間 がかかるため、このようなシステムでは、 実 時 間 の 処 理 や 実 行は 下 位 で 行 われ、 実 時 間 性 の 少 ないものが 上 位 に 配置 されると 考 えられる。聴 覚 処 理 では 実 時 間 性 は 必 須 である。 言 語 対 話 などの 能 力 を 外 した 動 物 聴 覚 においては、 実 時 間 性 は敵 や 餌 を 見 つける 上 で 極 めて 重 要 である。 言 語 対 話でも、 対 話 の 概 のシナリオをもって 話 すこともあるが、 大 抵 の 対 話 は 反 射 的 だったりその 場 的 だったりする。 瞬 時 に 入 力 情 報 を 認 識 し 発 話 することが 大 切であるが、 一 方 で 意 味 は 後 からわかったりする。 聴覚 処 理 では Fig.7 の 下 位 部 の 重 要 性 が 高 い。ヒトの 脳 は 進 化 により 発 達 したものであり、その構 造 は 進 化 的 に 古 いものの 上 に 新 しい 脳 を 重 ねるようにしてできている。Fig.1 の 場 合 、 下 位 部 にあたる脳 幹 、 基 底 核 、 小 脳 、 間 脳 は 魚 類 から 引 き 継 いだ 脳構 造 であり、 両 生 類 、 爬 虫 類 で 基 底 核 がさらに 発 達すると 共 に 原 始 的 な 辺 縁 系 ができ、 哺 乳 類 は 大 脳 皮質 をもつに 至 った。ヒトの 対 話 は、 動 物 聴 覚 にヒトのみがもつのであろう 広 範 囲 の 皮 質 内 連 合 情 報 処 理が 加 わったことにより 実 現 されている。このような 古 い 脳 と 新 しい 脳 の 階 層 化 は、 聴 覚 以外 にも 共 通 したものであるが、 脳 における 聴 覚 処 理が 他 の 感 覚 情 報 と 異 なる 点 は、 古 い 聴 覚 情 報 処 理 経路 が 種 の 進 化 を 経 ても 保 持 されている 点 にある。 対極 は 視 覚 である。 視 覚 の 古 い 情 報 経 路 である 視 蓋 は残 存 してはいるが、 主 要 経 路 とはなっていない。 視覚 情 報 は 進 化 の 過 程 で、 脳 幹 を 通 らずに 間 脳 にある視 床 経 由 で 新 皮 質 に 入 る 経 路 ができ、 新 と 旧 の 並 列経 路 を 用 いるようになっている。 聴 覚 の 場 合 、 哺 乳類 が 言 語 を 話 すようになって 間 もないので、 古 い 脳の 動 物 聴 覚 を 保 持 しているとも 考 えられるが、それだけではなさそうである。その 一 つが、 古 い 脳 での 情 報 処 理 の 複 雑 性 にある。聴 覚 情 報 の 場 合 、 蝸 牛 からの 聴 神 経 は 蝸 牛 核 、 上 オリーブ 核 、 外 側 毛 帯 核 、 下 丘 を 経 て 視 床 に 向 かう。一 方 、 視 覚 情 報 の 古 い 経 路 は、 網 膜 神 経 節 細 胞 からの 信 号 が 中 脳 視 蓋 で 処 理 され、すぐに 視 床 に 向 かう。ところが、この 中 脳 視 蓋 の 処 理 だけで、 両 生 類 などの 動 物 は 敵 と 餌 を 見 分 けたり、 障 害 物 を 検 知 したりするのである[8]。さらに 複 雑 な 回 路 をもつ 古 い 脳 での 聴 覚 処 理 は、 想 像 を 超 えた 処 理 を 行 っている 可 能性 が 高 く、そのため、もはや 捨 てることができない回 路 となっているのであろう。二 つめは、 新 しい 脳 である 新 皮 質 との 協 調 処 理 である。 前 述 の 複 雑 性 も 関 係 するが、 古 い 脳 の 聴 覚 処理 においては、 蝸 牛 核 、 上 オリーブ 核 、 外 側 毛 帯 核 、下 丘 といった 核 群 間 でのインタラクションが 頻 繁 になされる。それらを 通 して、 音 の 定 位 、マスク、 分離 、 分 類 などがなされているが、その 相 互 作 用 処 理が 新 皮 質 を 輪 の 中 に 入 れることを 容 易 にすると 共 に、輪 の 中 に 入 った 新 皮 質 との 関 係 をより 強 固 なものにしていると 考 えられる。三 つめが、 身 体 に 最 も 近 いが 所 以 の 身 体 性 である。身 体 と 感 覚 情 報 や 運 動 情 報 をやりとりする 最 前 線 が脳 幹 である。そこでは、 感 覚 情 報 以 外 にも、 身 体 の状 況 を 表 すドーパミン、セロトニン、アセチルコリン、ノルアドレナリンなどを 放 出 する 細 胞 が 群 居 している。 中 脳 終 端 では、 視 覚 、 聴 覚 、 運 動 といった情 報 が 上 丘 ( 視 蓋 )で 結 びついている。 基 底 核 では、感 覚 情 報 を 運 動 情 報 と 結 びつけ 無 意 識 に 運 動 できるしくみがあり、 前 述 のように 言 語 処 理 に 強 く 関 わっている 可 能 性 が 示 されている。次 節 では、この 古 い 脳 の 聴 覚 処 理 を 中 心 にいくつかの 知 見 を 紹 介 する。2.2. 古 い 脳 での 聴 覚 処 理聴 覚 に 関 する 研 究 は 古 くはピタゴラスによる「 音が 空 気 の 振 動 である」という 洞 察 に 始 まるだろうか。その 後 、16 世 紀 に Vesalius, Fallopio, 18 世 紀 にCorti らにより 耳 の 解 剖 学 的 構 造 が 明 らかにされ、1936

世 紀 初 めに Wever,Bray らにより 聴 神 経 が 音 の 周 波数 に 同 期 して 放 電 するという 電 気 生 理 的 知 見 が 得 られるに 至 った。この 聴 神 経 に 関 しての 研 究 は 1960-70年 ころより 本 格 化 し、1980 年 代 には 非 常 に 多 くの 知見 を 得 られた。1990 年 代 は 聴 神 経 の 投 射 先 である 蝸牛 核 に 関 する 知 見 が 増 え、 近 年 では、 下 丘 や 皮 質 に関 する 知 見 が 出 てきている。2.2.1. 脳 幹 における 聴 覚 処 理Figure 4. Characteristic of auditory nerve.蝸 牛 核 に 至 る 聴 神 経 までの 処 理 の 一 般 的 理 解 は 以下 である。Figure 5. Firing behaviors of neurons.Figure 2. Pathway of the ascending auditorysystem.Fig.2 の 下 部 のように、まず、 蝸 牛 にある 基 底 膜 に鼓 膜 からの 振 動 が 伝 わると、この 膜 が 振 動 。 高 い 音は 基 底 膜 のうち 蝸 牛 の 入 り 口 に 近 い 方 を、 低 い 音 は奥 の 方 を 大 きく 振 動 させる。この 結 果 、どの 場 所 がどのくらい 振 動 するかによって、 音 の 周 波 数 分 析 ができる。 基 底 膜 には 硬 い 毛 の 生 えた 有 毛 細 胞 という特 殊 な 神 経 細 胞 が、びっしりと 並 んでおり、 有 毛 細胞 は 基 底 膜 のその 場 所 が 振 動 すると 神 経 パルスの 列を 発 生 し、 有 毛 細 胞 につながっている 聴 神 経 に 伝 える。 神 経 パルスの 大 きさはほぼ 一 定 (Fig.4)だが、 頻度 は 基 底 膜 の 振 動 が 大 きいほど 多 くなり、 周 波 数 成分 の 強 さが 神 経 の 信 号 に 変 換 される。さらに、4~5kHz 以 下 の 音 の 場 合 、 神 経 パルスは 基 底 膜 が 一 回 振動 する 間 の 特 定 のタイミングで 発 生 されるので、 周波 数 成 分 の 位 相 も 聴 神 経 に 伝 えられる。 周 波 数 成 分の 強 さと 位 相 がわかるので、スペクトル 解 析 を 行 っているといわれている。実 際 の 神 経 細 胞 の 発 火 形 式 は 複 雑 で、 環 境 、 入 力 、細 胞 の 種 類 などで Fig.5 のように 様 々な 形 をとる。聴 神 経 の 投 射 を 受 ける 蝸 牛 核 でも 複 雑 な 発 火 パターンが 観 測 されている。このような 発 火 パターンは樹 状 突 起 形 状 、シナプス 特 性 、 細 胞 体 膜 特 性 などを起 因 とする、 膜 電 位 の 昇 降 や 休 止 電 位 変 化 の 微 分 係数 などの 変 化 により 生 じるものである。 従 来 は 情 報処 理 としては 無 視 されていたこのような 神 経 細 胞 の発 火 形 式 だが、これらも 情 報 表 現 の 形 式 と 考 えると神 経 情 報 処 理 の 潜 在 能 力 が 格 段 に 向 上 する。蝸 牛 核 では 上 記 の 複 雑 発 火 とともに 音 周 波 数 マップが 形 成 され、 上 オリーブ 複 合 体 へ 投 射 され IID( 両耳 間 強 度 差 ),ITD( 両 耳 間 時 間 差 )が 求 められるとされている(Fig.2 下 部 参 照 )。聴 神 経 の 活 動 様 式 を 知 った 上 で、 脳 幹 における 聴覚 処 理 の 発 達 をみることも 参 考 になる。Figure 6. Development of ABR.人 間 の 場 合 、 脳 幹 における 聴 覚 のハードウェア 構造 ( 細 胞 と 細 胞 間 のおよその 結 合 )は 胎 生 時 にほとんどできあがっている。 生 後 は 軸 策 のミエリン 化 と結 合 の 詳 細 化 がなされていると 考 えてよい[1]。37

Fig.6 は 幼 児 の ABR (Auditory Brainstem Response)の 変 化 を 図 表 化 したものである。ABR は 音 刺 激 に 対 する 脳 幹 の 反 応 で、クリック 音 刺 激 を 与 え 頭 皮 上 から微 弱 な 電 位 変 化 を 計 測 し、 通 常 は 10ms 以 内 に 陽 性 波が 出 現 する(Fig.6 の 右 にあるような 時 系 列 の 反 応 )。Ⅰは 聴 神 経 、Ⅱは 蝸 牛 核 、Ⅲは 上 オリーブ 核 、Ⅳは外 側 毛 帯 、Ⅴは 下 丘 、Ⅵは 内 側 膝 状 体 、Ⅶは 聴 覚 野の 反 応 であるとされている。 図 の 縦 軸 は 反 応 時 間 を表 し、 横 軸 は 月 齢 および 年 齢 を 表 す。たとえば、 一番 左 の 棒 グラフは 0-2 ヶ 月 の 幼 児 であり、 新 皮 質 の反 応 まで 9msec 強 を 用 している。 赤 丸 は 前 月 齢 より反 応 時 間 が 短 縮 した 部 分 を 示 し、 青 丸 は 反 対 に 反 応時 間 が 延 びた 部 分 を 示 している。つまり、2-4 ヶ 月では 0-2 ヶ 月 に 比 べ、 上 オリーブ 核 、 外 側 毛 帯 の 反応 時 間 が 短 縮 し、 皮 質 の 反 応 時 間 が 延 びている。幼 児 期 は 聴 覚 経 路 の 身 体 化 と 詳 細 化 がなされるので、 処 理 が 短 縮 していることはそのような 回 路 が 最適 化 されたこと、 処 理 が 延 びたときは 追 加 の 回 路 が形 成 されたことに 相 当 すると 考 えられる。すると、 幼 児 期 の 聴 覚 は 2-4 ヶ 月 までに 第 一 期 の発 達 が 脳 幹 で 生 じ、その 発 達 に 伴 い 新 皮 質 の 回 路 が形 成 され 始 めると 推 定 できる。 実 際 、たとえば 音 源の 定 位 は 生 後 直 後 にある 程 度 できるのであるが、その 後 1,2 ヶ 月 はうまくできなくなり、3,4ヶ 月 で再 びできるようになる[3]。Ⅲの 上 オリーブは 特 に 定位 に 関 連 する 部 分 なので、この 間 に 身 体 化 がなされているのだろう。 遅 れて 4-6 ヶ 月 から 新 しい 質 の 聴覚 情 報 の 回 路 が 蝸 牛 核 で 形 成 され、それは 月 齢 と 共に 上 オリーブ、 外 側 毛 帯 、 下 丘 と 伝 播 していく。 回路 形 成 が 下 丘 にいたる 1-2 才 のころから、 新 皮 質 で第 2 次 の 回 路 形 成 が 進 む。 実 は 2-4 ヶ 月 のころの 幼児 は4KHz 未 満 の 低 周 波 音 や 広 い 周 波 数 スペクトルをもった 音 に 強 く 反 応 する[25]。このことは、4KHz 未 満 の 音 に 対 し 位 相 に 合 った 発 火 を 行 う 聴 神経 が 回 路 形 成 を 誘 導 しているとも 考 えられる。 聴 神経 の 中 でも 自 発 発 火 率 の 低 い L 型 といわれるものは少 数 だがダイナミックレンジが 大 きくフォルマント等 の 大 局 構 造 の 表 現 が 可 能 なため、この L 型 の 発 火活 動 が 回 路 形 成 をこの 誘 導 を 行 っている 可 能 性 が 高い。このような 機 能 は、 生 後 母 親 の 音 声 を 優 位 に 検知 するのに 役 立 つものとして、ある 程 度 組 み 込 まれているのかもしれない。この 2-4 ヶ 月 ころに、 声 を発 することができる 程 度 に 発 声 器 官 が 発 達 する。この 時 期 以 降 の 第 2 次 発 達 は、 自 分 の 声 への 対 応 、 視覚 などとの 情 報 融 合 、 高 周 波 表 現 に 向 けた 発 達 が 行われているのだろう。2. 2.2. 基 底 核 や 小 脳 における 聴 覚 処 理Fig.2 からもわかるように、 脳 幹 により 聴 覚 情 報 の前 処 理 が 行 われ、 大 脳 により 言 語 の 認 識 や 発 声 の 高次 処 理 が 行 われるとされている。 大 脳 でも 特 にブローカ 野 とウェルニケ 野 がそれぞれ 運 動 性 、 感 覚 性 の言 語 処 理 中 枢 とされている。しかし、 近 年 計 測 手 法の 発 展 に 伴 い、 言 語 や 概 念 の 扱 いはこの 2 つの 領 野だけでなく、 脳 の 多 くの 部 分 が 内 容 に 応 じて 分 担 し関 与 していることがわかりつつある[20] 。Damasio[4]は 169 人 の 脳 損 傷 患 者 と 55 人 のコントロールに 対 して、 名 詞 、カテゴリ 化 を 中 心 に 脳 画 像 を用 いた 網 羅 的 解 析 を 行 い 大 脳 各 部 位 と 言 語 処 理 の 関係 を 示 した。 Watkins[24]は 遺 伝 的 言 語 障 害 をもつKE 家 系 では 基 底 核 の 尾 状 核 が 小 さいことを 計 測 し、言 語 処 理 と 基 底 核 の 強 い 関 与 を 示 した。 小 脳 の 損 傷が 構 音 生 成 障 害 を 起 こすことも 知 られている。ブローカ 野 が 損 傷 しても 基 底 核 に 損 傷 がなければ 言 語 機能 は 回 復 するが、 逆 に 基 底 核 に 損 傷 があるとブローカ 野 が 無 事 でも 言 語 機 能 は 回 復 しないという 知 見 もある[13]。Ullman[23] は 神 経 科 学 的 認 知 心 理 の 観 点 から、 基底 核 を 手 続 き 的 な 文 法 知 識 の 場 、 小 脳 を 獲 得 された手 続 き 情 報 の 修 正 の 場 と 考 え、 新 皮 質 の 各 領 野 との機 能 的 関 係 を 認 知 モデル 化 し、Dominey[6]は 言 語 のような 継 時 的 情 報 の 処 理 モデルとして、 新 皮 質 と 基底 核 からなる 計 算 モデルを 提 案 し、 幼 児 からの 言 語習 得 過 程 を 説 明 した。しかし、 脳 幹 の 処 理 に 比 べ、このような 機 能 的 モデルの 研 究 は 少 ない。3. 脳 型 情 報 処 理 と 聴 覚脳 を 参 考 に 新 しい 情 報 処 理 方 式 を 開 拓 しようとするアプローチは、 脳 において 観 測 される 現 象 に 注 目し、その 現 象 を 人 工 的 に 再 現 するモデル 化 を 行 い、次 に 情 報 科 学 的 洞 察 を 行 い、 情 報 科 学 的 意 味 をもった 情 報 処 理 方 式 を 提 案 するものである。 従 って、 具体 化 しようと 着 目 する 現 象 により、 開 発 される 方 式は 様 々である。 神 経 細 胞 といった 小 規 模 な 素 子 による 並 列 分 散 活 動 に 着 目 したものが、パーセプトロン、連 想 記 憶 、バックプロパゲーションなどの 神 経 回 路である。その 場 合 、その 他 の 要 素 である 脳 の 構 造 や神 経 細 胞 の 挙 動 などは 特 に 関 知 しない。並 列 分 散 活 動 に 加 えて、 我 々は 解 剖 学 的 関 係 、 解剖 学 的 構 造 、 神 経 細 胞 の 特 性 ( 放 電 パターン、 可 塑性 )に 着 目 している。 前 節 で 述 べたように、 脳 の 各部 位 はある 程 度 の 機 能 的 意 味 づけがされているので、それらの 解 剖 学 的 関 係 から、システム 構 造 が 推 定 できる。また、 解 剖 学 的 構 造 からは、 神 経 が 結 合 して構 成 される 回 路 構 造 の 青 写 真 が 描 ける。そして、そこに 神 経 細 胞 の 特 性 を 入 れ 込 むことで、 回 路 の 中 で行 われている 情 報 処 理 への 仮 説 が 形 成 できる。すでに 我 々はこれら 着 目 点 から、 脳 における 散 逸的 自 己 組 織 化 [30]、 双 方 向 の 仮 説 制 御 システム[12],スパイキングニューロンによる 時 間 符 号 化 [11], 変動 を 組 み 込 んだスパイキングニューロン 学 習 モデル[22]などを 提 案 してきた。 本 稿 では、スパイキングニューロンによる 情 報 処 理 モデルの 考 えをもとに 聴覚 処 理 を 考 察 する。38

3.1. スパイキングニューロン神 経 細 胞 の 多 くは Fig.4 のように 細 胞 の 電 位 が 一時 的 にプラスからマイナスになる 活 動 電 位 (スパイク)という 現 象 を 示 す。この 現 象 を 含 め、 神 経 細 胞レベルの 物 理 的 モデル 化 はかなり 厳 密 に 行 われている[10]。スパイキングニューロンのモデルはその 中でも、 形 式 神 経 細 胞 [18]と 異 なり、スパイクの 現 象に 着 目 した 神 経 情 報 処 理 モデルである。この 情 報 処理 の 特 徴 は 動 的 特 性 にあり、 大 きくは 確 率 的 モデルである Spike Response Model と 決 定 論 的 モデルである Integrate and Fire Model に 分 かれる。 確 率 的 には 後 者 は 前 者 の 特 殊 な 例 とも 解 釈 でき、 目 的 により使 い 分 けが 必 要 である。 数 学 的 記 述 や 生 物 学 的 意 味に 関 しては[5] [16]などの 書 籍 を 参 照 されたい。このようなモデルにより 再 現 可 能 なスパイクイベントは、Fig.5 のような 時 間 イベントである。このようなイベント 系 列 により 情 報 を 表 現 することにより、時 間 的 に 動 的 な 情 報 処 理 が 可 能 になる。たとえば、2つの 細 胞 のスパイク 間 の 時 間 関 係 は2つの 情 報 の位 相 関 係 とその 動 的 変 化 を 表 し、1つの 細 胞 におけるスパイクの 時 間 間 隔 は 情 報 の 周 波 数 とその 動 的 変化 を 表 し、スパイクや 膜 電 位 の 時 間 パターンは 情 報の 強 弱 や 動 的 特 性 を 表 現 できる。さらに、スパイクは 情 報 を 伝 達 するだけでなく、 制 御 信 号 としても 用いることができるため、 時 間 軸 を 用 いて 情 報 を 統 合したり 分 離 したりすることもできる。また、 電 位 に変 化 を 与 えることで、ニューロンの 処 理 周 期 を 変 えたり、 他 のニューロンと 周 期 を 合 わせたりする 処 理制 御 を 行 うことができる。生 物 はこれらの 処 理 をサブミリ 秒 の 時 間 解 像 度 で行 っており、 神 経 細 胞 による 処 理 は、 柔 軟 性 、 適 応性 の 基 盤 となっているのだろう。しかし、 一 方 でこのような 処 理 を 現 在 のコンピュータで 行 おうとすると 非 常 に 効 率 が 悪 い。なぜなら、コンピュータの 情報 表 現 はビット 列 のみであり 時 間 情 報 はない。しかも、 神 経 細 胞 の 処 理 は 非 同 期 超 並 列 を 前 提 にしているのに 対 し、コンピュータは 同 期 逐 次 処 理 を 前 提 にしているからである。心 に 開 発 は 進 んでいるが、 音 源 位 置 、 環 境 変 化 が 限定 されたなかでの 技 術 となっている。行 動 実 験 による 反 響 ( 時 間 差 をもった音 )に 関 する生 物 の 聴 覚 特 性 からは 以 下 のような 知 見 が 報 告 されている[14][15][27]。まず、2つの 音 が1ミリ 秒 以 内 で 来 た 場 合 は1つの音 とされる。 例 えば、 対 面 する2つのスピーカーから 同 じ 音 を1ミリ 秒 以 内 で 聞 かせると、 仮 想 音 源が 定 位 される。1 ミリ 秒 を 超 え、20 ミリ 秒 程 度 ずれた 場 合 は、1つの 音 に 聞 こえるが、 先 に 聞 こえた 音の 位 置 に 定 位 する。20 ミリ 秒 を 超 え 30 ミリ 秒 くらいまでは2つの 音 に 聞 こえるが、 定 位 位 置 は 先 に 聞 こえた 音 に 引 っ 張 られ、30 ミリ 秒 を 超 えるようになって、2 つの 音 を 2 つの 位 置 に 定 位 できる。このことから 生 物 の 場 合 、20 ミリ 秒 以 内 の反 響 は先 行 する 音 を 優 先 し、 他 の 反 響 音 は 時 間 的 に 引 き 込まれるか 抑 制 されていると 考 えられる。Pollak[21]は、 下 丘 はその 下 位 で 処 理 された 様 々な 特 徴 を 統 合する 場 と 考 え、 外 側 毛 帯 と 上 オリーブ 複 合 体 が 反 響音 抑 制 に 関 与 していると 提 案 している。 外 側 上 オリーブ 核 は 同 側 の 外 側 毛 帯 背 側 にグリシンによる 抑 制性 の 投 射 、 対 側 の 外 側 毛 帯 背 側 に 興 奮 性 投 射 、 外 側毛 帯 背 側 は 対 側 に GABA による 抑 制 性 の 投 射 があることから、 下 記 のような 機 能 図 を 描 くことができる。3.2. スパイキングニューロンを 用 いた 聴 覚 処 理前 述 のようなスパイキングニューロンによる 情 報処 理 の 特 性 は、 聴 覚 のように 情 報 が 時 間 にのっており、しかも 実 時 間 性 を 必 要 とする 対 象 に 非 常 に 適 している。 特 にロボット 聴 覚 においては、 音 源 やロボットが 移 動 するため、 動 的 特 性 への 要 求 度 は 高 い。ここでは、 例 題 を 用 いて 簡 単 なモデルを 作 成 する。例 題 は 反 響 抑 制 である。ロボットが 環 境 中 で 音 源定 位 する 場 合 、ロボットは 移 動 するため、 環 境 ・ 位置 により 異 なる 反 響 にいかに 対 応 するかが 大 きな 問題 となる。 人 間 もあんまりひどい 反 響 があると 音 声認 識 が 困 難 になる。こうした 反 響 音 への 対 応 は 電 話などでも 重 要 な 技 術 であるため、 適 応 フィルタを 中Figure 7. Functional scheme of brainstem auditorysystem.この 機 能 図 では、 相 対 的 に「 強 度 の 強 い 音 に 関 する IID 情 報 と 周 波 数 」が 到 来 した 場 合 、その 音 源 方向 が 一 時 的 (20 ミリ 秒 ほど)に 優 先 され、それ 以 外 を抑 制 (マスク)する。 実 線 は 興 奮 性 、 破 線 は 抑 制 性の 結 合 である。 結 合 はすべてを 記 していない。これだけを 動 作 させるのであればアルゴリズムを書 いてもよいのだが、スパイキングニューロンで 構成 することでより 単 純 かつロバストになる。なぜなら、Fig.7 で 記 したようなインターフェースは 特 定 の機 能 的 側 面 を 見 ただけのものなので、 少 し 問 題 が 変わると 対 応 できない。スパイキングニューロンのイ39

ンターフェースはスパイクイベントと 決 まっており、その 時 間 情 報 に 位 相 、 強 度 、 周 波 数 など 必 要 な 情 報が 準 備 されているので、 受 け 側 で 選 択 し 利 用 すればいい。また、 個 々の 処 理 が 単 純 なため、 冗 長 ではあるが 多 数 のニューロンを 用 意 し 関 係 付 けることで、時 間 的 にも 空 間 的 にも 補 完 的 な 処 理 が 可 能 になる。このモデルは 学 習 発 達 型 でも 利 用 可 能 である。 発達 型 にするのであれば、2.2.1 などを 参 考 に、 低 周 波選 択 で 位 相 発 火 型 の 聴 神 経 をベースに 内 側 上 オリーブ- 下 丘 間 の 結 合 を 学 習 し、 下 丘 に 方 向 マップを 概ね 作 成 した 後 に 外 側 オリーブや 外 側 毛 帯 を 導 入 し、上 下 で 挟 むことで 学 習 を 進 めればいい。また、このモデルにおいてマスクを 形 成 する 外 側毛 帯 の 活 動 は、 一 時 の 入 力 に 対 し 20 ミリ 秒 ほどの 継続 的 発 火 を 伴 うものなのだが、そのような 特 性 も 細胞 特 性 に 組 み 込 むだけでよい。IID などは、 計 算 方 式はアルゴリズムで 記 述 するものと 異 なるが 内 容 に 大きな 差 はないが、 同 じ 計 算 原 理 で Fig.7 のモデルをすべて 動 かせることが 何 よりも 重 要 である。しかし、3.1 で 述 べたように 原 理 は 実 時 間 向 きでも、 処 理 が 実時 間 でないことは 大 きな 課 題 であり、ロボット 応 用に 向 けてはさらなる 技 術 蓄 積 が 必 要 である。。4. おわりに脳 型 情 報 処 理 の 立 場 から、ロボット 聴 覚 を 考 察 した。 本 稿 ではスパイキングニューロンの 処 理 に 関 してのみ 述 べたが、3 節 冒 頭 で 述 べたように、 脳 型 情 報処 理 はシステム、 回 路 、 素 子 の 3 要 素 からなり、それらの 相 乗 効 果 が 大 きい。 三 位 一 体 の 研 究 展 開 が 重要 である。ロボット 聴 覚 は 情 報 処 理 として 求 められる 動 的 特 性 、 学 習 能 力 の 観 点 から、 脳 型 情 報 処 理 の研 究 において 最 適 な 課 題 といえる。 今 後 、 両 研 究 領域 の 相 互 発 展 を 期 待 したい。参 考 文 献1) Berg, BO., Principles of Child Neurology, McGraw-Hill,New York NY, 1995.2) Brooks, RA. : A Robust Layered Control System for aMobile Robot, IEEE Journal of Robotics and Automation 2(1), 14–2, 1986.3) Clifton RK., The development of spatial hearing in humaninfants, in Werner LA, Rubel EW (eds): Developmental Psycholoacoutics.,American psychological Association, Washington,DC, 135-157, 1992.4) Damasio, H., Tranel, D., Grabowski, T., Adolphs, R.,Damasio, A., Neural systems behind word and concept re-trieval, Cognition, 92, 179-229, 2004.5) Dayan, P., Abbott, LF., Theoretical Neuroscience: Computationaland Mathematical Modeling of Neural Systems,MIT Press, Cambridge MA, 2001.6) Dominey PF.,Hoen M.,Blanc JM.,Lelekov-Boissard T.,7)Neurological basis of language and sequential cognition:evidence from simulation, aphasia, and ERP studies., Brainand Language, 86(2),207-25, 2003.D’Esposito M, Alexander MP., Subcortical aphasia: distinctprofiles following left putaminal hemorrhage. Neuorol-ogy, 45, 38–41, 1995.8) Ewert, J.-P. and Arbib, M.A., Eds., Visuomotor Coordina-Amphibians, Comparisons, Models and Robots, Newtion:York: Plenum Press, 1989.9) Jordan, MI. (Ed.), Learning in graphical models., MITPress, Cambridge MA, 1999.10) Koch, C. (ed.), Biophysics of Computation, Oxford UniversityPress, New York, 1999.11) Koerner, E., Gewaltig, M-O., Koerner, U., Richter, A. andRodemann, T., A model of computation in neocorticalarchitecture., Neural Networks, 12:989–1006, 1999.12) Koerner, E., Tsujino, H. and Masutani, T.: A Cortical-typeModular Neural Network for Hypothetical Reasoning,Neural Networks 10, 791-814, 1997.13) Lieberman, P., On the nature and evolution of the neuralbases of human language, Yearbook of physical anthropology,45, 36-62, 2002.14) Litovsky RY, Colburn HS, Yost WA, Guzman SJ., Theprecedence effect, J Acoust Soc Am.,106(4 Pt 1),1633-54,1999.15) Litovsky RY, Shinn-Cunningham BG., Investigation of therelationship among three common measures of precedence:fusion, localization dominance, and discrimination suppression,J Acoust Soc Am., 109(1),346-58, 2001.16) Maas W., Bishop, CM. (eds), Pulsed neural networks, MITPress, Cambridge MA, 1998.17) McCarthy, J., Minsky ML., Rochester, N., Shannon CE., Aproposal for the Dartmouth summer research project on artificialintelligence”, 1955.18) McCulloch, W.S. and Pitts, W.H., A logical calculus of theideas immanent in neural nets, Bulletin of MathematicalBiophysics, 5 : 115-133, 1943.19) Nilsson, NJ. : Shakey The Robot, Technical Note 323. AICenter, SRI International, 1984.20) Poeppel, D., Hickok, G., Towards a new functional anatomyof language, Cognition, 92(1-2), 1-12, 2004.21) Pollak GD, Burger RM, Klug A., Dissecting the circuitryof the auditory system, Trends Neuroscience, 26(1),33-9,2003.22) Tsujino, H., Output-driven operation and memory-basedarchitecture principles embedded in a real-world device,Journal of Integrative Neuroscience, 3(2), 133-42, 2004.23) Ullman, MT., Contribution of memory circuits to language:the declarative/procedural model, Cognition, 92, 231-270,2004.24) Watkins KE, Vargha-Khadem F, Ashburner J, PassinghamRE, Connelly A, Friston KJ, Frackowiak RS, Mishkin M,Gadian DG., MRI analysis of an inherited speech and languagedisorder: structural brain abnormalities., Brain, 125( Pt3), 465-78, 2002.25) Werner LA., Gillenwater JM., Pure-tone sensitivity of 2-to5-week-old infants, Infant Behavior and Development,13(355), 355-375, 1990.26 ) Wolpert D, Kawato M: Multiple paired forward and inversemodels for motor control. Neural Networks11,1317-1329, 1998.27) Yang X, Grantham DW., Echo suppression and discriminationsuppression aspects of the precedence effect, PerceptPsychophys, 59(7),1108-17, 1997.28) 井 上 博 充 : 人 間 型 ロボットが 拓 く 未 来 社 会 と 新 産 業の 創 成 , 日 本 ロボット 学 会 誌 , 22 (1), 2-5 , 2004.29) 奥 乃 博 , 中 臺 一 博 , ロボット 聴 覚 の 課 題 と 現 状 , 情 報処 理 , 44(11), 104-113, Nov. 2003.30) 松 本 元 、 辻 野 広 司 : 脳 のこころ、「 情 と 意 の 脳 科 学 」、松 本 元 ・ 小 野 武 年 共 編 、 培 風 館 , 2002.40

社 団 法 人 人 工 知 能 学 会Japanese Society forArtificial Intelligence人 工 知 能 学 会JSAI Technical ReportSIG-CHallege-0522-7 (10/14)パーソナルロボット PaPeRo における 近 接 話 者 方 向 推 定 と 2 マイク 音 声 強 調Near-Field Sound-Source Localization and Adaptive Noise Cancellationin a Personal Robot, PaPeRoAbstract—This paper presents implementation andevaluation of speech interface for a personal robot,PaPeRo, based on sound-source localization and noisecancellation. Sound-source localization incorporates anew formula taking near-field conditions into account foroffsetting errors caused by the relative altitude of thespeech source to the microphones. In noise cancellation,a novel stepsize control assuming a wide range of signal-to-noiseratios of the input signal helps achieve bothsmall residual noise and distortion in the noise-cancelledsignal. Evaluation results with recorded signals in thereal environment demonstrates 40% highersource-localization performance and as much as 65%higher speech recognition rates in noisy environment.1. はじめに〇 佐 藤 幹 (NEC メディア 情 報 研 究 所 )杉 山 昭 彦 (NEC メディア 情 報 研 究 所 )大 中 慎 一 (NEC メディア 情 報 研 究 所 )* Miki SATO(NEC.), Akihiko SUGIYAMA(NEC.), Shin’ichi Ohnaka(NEC.)m-sato@dh.jp.nec.com, aks@ak.jp.nec.com, s-ohnaka@cp.jp.nec.com近 年 、 人 間 と 共 生 することを 目 的 としたパートナー 型 ロボットの 研 究 が 盛 んに 行 われている [1]。これらのロボットは、 通 常 、 音 声 コマンドによって、離 れた 位 置 から 制 御 される。 背 景 雑 音 や 妨 害 信 号 の影 響 を 低 減 して、 正 確 に 音 声 コマンドを 認 識 するために、 指 向 性 マイクロホンが 広 く 使 われている。このため、 音 声 の 到 来 する 方 向 を 推 定 し、 推 定 方 向 にマイクロホンの 指 向 性 を 一 致 させることが 重 要 となる。遠 隔 会 議 などの 通 信 応 用 と 異 なり、 人 間 とロボットの 対 話 では、 話 者 の 口 、すなわち 音 源 とマイクロホンは、 同 一 平 面 上 にあると 見 なすことはできない。しかし、ロボットにおける 話 者 方 向 推 定 では、 暗 黙のうちに 音 源 とマイクロホンが 同 一 平 面 上 にあると仮 定 してきた。この 仮 定 が 話 者 方 向 推 定 結 果 に 与 える 影 響 は、 人 間 とロボットとの 距 離 が 近 くなるほど大 きくなる。すなわち、 近 接 音 場 を 想 定 した 方 向 推定 が 重 要 となるのである。一 方 、マイクロホンの 指 向 性 だけで 抑 圧 できない雑 音 や 妨 害 信 号 は、 音 声 強 調 処 理 によって、その 影響 を 軽 減 する。 応 用 毎 に 異 なる 要 求 条 件 に 応 じて、1つ 又 は 多 数 のマイクロホンを 用 いた 雑 音 及 び 妨 害 信号 の 抑 圧 が、 広 く 行 われている [2]。 人 間 とロボットの 対 話 においては、2 つのマイクロホンを 用 いた適 応 ノイズキャンセラが、マイクロホン 数 、 雑 音 除去 性 能 、 及 び 歪 の 観 点 から 見 て、 良 い 妥 協 策 である。適 応 ノイズキャンセラは、 音 声 用 と 雑 音 用 の 2 つFigure. 1: PaPeRo の 外 観のマイクロホンを 用 いて、 雑 音 の 消 去 を 行 う。 符 号化 や 音 声 認 識 の 前 処 理 に 用 いるために、 係 数 更 新 ステップサイズを 音 声 対 雑 音 比 (SN 比 )に 応 じて 制 御することで、 高 い 雑 音 消 去 性 能 と 小 さな 音 声 歪 を 両立 することができるノイズキャンセラ [3] が 提 案されている。このノイズキャンセラは、ヘッドセットなどのように、 音 声 用 マイクロホンが 話 者 の 口 元にあることを 想 定 しているため、 様 々な 距 離 から 話しかけられるロボットに 適 用 することはできない。音 声 用 マイクロホンと 口 との 距 離 に 応 じて、SN 比 が広 範 囲 に 変 化 するためである。本 稿 では、 音 声 対 話 機 能 をもつ 自 律 移 動 型 パーソナルロボット PaPeRo[4]における、 近 接 音 場 を 想 定した 話 者 方 向 推 定 と、 広 範 囲 な SN 比 に 対 応 できるノイズキャンセラについて 紹 介 する。2 節 で、PaPeRoの 構 成 と 音 声 インタフェースについて 説 明 する。3節 では 近 接 話 者 方 向 推 定 、4 節 ではノイズキャンセラをとりあげる。5 節 では 評 価 結 果 を 用 いて 性 能 を明 らかにし、6 節 で 今 後 の 課 題 について 述 べる。2. パーソナルロボット PaPeRo2.1. ハードウェアパーソナルロボットPaPeRoの 外 観 を、Fig. 1に 示 す。PaPeRoは、 高 さ385mm、 幅 248mm、 奥 行 245mm、重 量 5.0kgの 自 律 移 動 型 ロボットである。 胴 体 正 面 に4 個 、 左 右 にそれぞれ1 個 、 背 面 に1 個 の 無 指 向 性41

マイクロホン[ 正 面 ][ 左 ][ 右 ][ 背 面 ][ 頭 部 ][ 右 ][ 左 ]スピーカ8 chA/Dボードマルチリングバッファ話 者方 向 推 定ノイズキャンセラエコーキャンセラ音 声 認 識エンジン制 御ロボットプラットフォームFigure. 2: PaPeRo の 音 声 インターフェースマイクロホン、 及 び 頭 部 に1 個 の 指 向 性 マイクロホン、さらにCCDカメラ、 超 音 波 センサ、 赤 外 線 センサ、プッシュスイッチを 搭 載 し、4 個 のモータによって動 作 する。これらのセンサ 及 びモータは、Windows XPで 動 作 するPentiumM 1.6GHz CPUによって 制 御 する。2.2. 音 声 インターフェースPaPeRoの 音 声 インターフェースは、Fig. 2に 示 す 構成 を 有 する。 前 記 マイクロホンに 入 力 された 信 号 を8チャンネルAD 変 換 ボード( 東 京 エレクトロンデバイス、TD-BD-8CSUSB)を 用 いてディジタル 化 し、マルチリングバッファに 格 納 する。 格 納 された 信 号 から必 要 な 信 号 を 選 択 して、 所 望 の 処 理 を 行 う。 話 者 方向 推 定 では、 正 面 、 左 、 右 の3マイクロホンに 入 力 された 信 号 を 使 用 する。 推 定 された 方 向 の 情 報 は、ロボットの 方 向 を 制 御 するロボットプラットフォームに 供 給 される。ノイズキャンセラでは、 頭 部 と 背 面の2つのマイクロホンに 入 力 された 信 号 を 使 用 する。雑 音 が 低 減 された 出 力 は、 出 力 用 リングバッファに格 納 される。ロボットプラットフォームは、 必 要 に応 じて 出 力 用 リングバッファから 音 声 認 識 エンジンに 信 号 を 供 給 し、 音 声 認 識 が 行 われる。2.3. AD 変 換 ボードパーソナルロボットPaPeRoに 内 蔵 可 能 な 小 型 の8チャンネルAD 変 換 ボード(TD-BD-8CSUSB)を、 東 京 エレクトロンデバイスと 共 同 で 開 発 した。ボードの 外観 を、Fig. 3に 示 す。8チャンネルのマイクロホン 入力 信 号 を 同 時 にサンプリングし、USB2.0またはUSB1.1インターフェースで、パーソナルコンピュータ(パソコン) 等 へ 取 り 込 むことができる。ボードは、ASIOドライバに 準 拠 しており、USB 経 由 で 供 給 された 電 力 による 動 作 (バスパワー 動 作 )が 可 能 であ56mmる。バスパワーとは 別 に、 外 部 電 源 供 給 の 端 子 も 有している。サンプリング 周 波 数 は、48kHz、44.1kHz、22.05kHz、11.025kHz、 又 は8kHzのいずれかを 選 択 することができる。マイクロホン 入 力 アンプ 及 びAD 変換 利 得 調 整 機 能 を 内 蔵 しており、60dB 以 上 のSN 比 を達 成 している。3. 近 接 音 場 における 話 者 方 向 推 定 [5]3.1. 方 向 推 定 の 原 理話 者 方 向 推 定 は、 複 数 のマイクロホンに 入 力 された信 号 の 時 間 差 に 基 づいて 行 う。Fig. 4に 示 すように、マイクロホンを 結 ぶ 直 線 と 直 角 の 方 向 に 対 して、 角度 θをなす 方 向 から 音 が 到 来 する 例 を 考 える。2つのマイクロホンへの 入 力 信 号 をx1(t)、x2(t)、これらの 時 間 差 をτとする。 時 間 差 τは、 入 力 信 号 x1(t) とx2(t)に 関 する 相 互 相 関 の 最 大 値 として 求 めることができる。このτを 用 いて、θは(1)で 与 えられる。− cτθ = sin 1 ( )M93mmFigure. 3. 8 チャンネルAD 変 換 ボード(1)42

音 波マイクロホンX 1 (t)θMθX 2 (t)cτFigure. 4: 音 の 到 来 方 向 と 受 音 信 号l+cτ nM/2θ:h=0の 時φ:h≠0の 時Zφθ dM/2マイクロホン音 源YhlX ただし、Mはマイクロホン 間 隔 、cは 音 速 である。入 力 がサンプリング 周 波 数 fsの 離 散 信 号 である 場合 は、τに 対 応 するサンプル 数 の 差 k 及 びfsを 用 いて、θは(2)で 表 される。ただし、kは 整 数 である。− ckθ = sin 1 ( )(2)Mf3.2. 近 接 音 場 における 方 向 推 定s人 間 とロボットの 対 話 では、 話 者 の 口 とマイクロホンが 同 一 水 平 面 上 に 位 置 せず、 距 離 も 十 分 に 遠 くないため、(1) 又 は(2)を 用 いた 方 向 推 定 を 直 接 適 用 することができない。このため、 近 接 音 場 特 有 の 方 向推 定 が 必 要 となる。Fig. 5に、 人 間 とロボットの 対 話 における、 音 源( 話 者 の 口 )とマイクロホンの 位 置 関 係 を 示 す。θとφはそれぞれ、 音 源 の 高 さhが0に 等 しいとき 及 び0でないときに 対 応 した、 音 声 の 到 来 方 向 を 示 す。 一般 に、φ>θの 関 係 が 成 立 する。2つのマイクロホンに 入 力 された 信 号 の 時 間 差 をτ n とすると、 音 の 到 来 方 向 φは、2つのマイクロホンの 中 心 から 音 源 までの 水 平 距 離 dと、 音 源 の 高 さhを 用 いて(3)で 表 される。= sin⎧cτ ncτ+ ⎫n/ l⎨ ⋅ ⎬2 2⎩ M d + h ⎭φ (3)−1 2ただし、l は 音 源 からマイクロホンまでの 距 離 のうち 小 さい 方 の 値 で、2 22l = h + d(d − M sinθ ) + M / 4 (4)で 表 される。 人 間 とロボットの 対 話 において、h、d、l は 数 メートルであるのに 対 し、cτ n 、M は 高 々 数 センチメートルである。この 事 実 に 基 づいて、(4)は 次式 で 近 似 することができる。l +2 2 2≈ h d(5)同 様 の 近 似 及 び(5)を(3)に 適 用 すると、−1⎧cτ⎫φ = sin n⎨ ⎬⎩ M ⎭(6)を 得 る。 音 声 の 到 来 方 向 θは、(6)のφを 用 いて、(7)Figure. 5: 音 源 の 高 さと 到 来 方 向π−2左X前Z後YFigure. 6: マイク 配 置で 求 めることができる。⎛ 2 2 ⎞−1⎜d + hθ = sinsinφ ⎟⎜⎟⎝d⎠3.3. 前 後 方 向 の 決 定右π22 つのマイクロホンを 用 いた 方 向 推 定 では、マイクロホンを 結 ぶ 直 線 に 関 して 対 称 な 2 つの 方 向 ( 前後 方 向 )を 区 別 できない。そのため、PaPeRo では、Fig. 6 に 示 すように 配 置 した 3 つのマイクロホンを使 って、 前 後 方 向 を 決 定 する。 図 において、XZ=YZ=M short 、XY=M long 、∠ZXY=∠ZYX=γとする。また、φ PQ はマイクロホン P 及 び Q によって 得 られた 推 定 方 向 を 表 し、-π/2≦φ≦π/2 とする。前 後 方 向 決 定 は、 方 向 推 定 精 度 に 関 する 以 下 の 2つの 性 質 に 基 づいて 行 う。(a) 方 向 推 定 分 解 能 は、マイクロホン 間 隔 が 大 きいほど 向 上 する(b) 方 向 推 定 精 度 は、φが±π/2 に 近 づくほど 低 下するこれらの 特 徴 を 考 慮 して、φ XY を 主 推 定 方 向 、φ XZ 、φ YZ を 補 助 推 定 方 向 として 用 いる。 前 後 方 向 の 決 定は、 例 えば-π/2

s(k)Crosstalkn(k)R S(k)X P(k)X R(k)R N(k)POWAVESNRESTPOWAVEZ -LZ -L+∑-y 3(k)MF1e 4(k)∑-+μ MF1(k)+∑-μ SF1(k) y 1(k)f S(.)SF1e 2(k)SNR P(k)+ -∑g S(.)μ SF2(k)e 3(k)MF2f M(.)e 1(k)SF2y 2(k)y 4(k)g M(.)雑 音 抑 圧 音 声POW P S(k)AVE SNRESTPOWPAVE N(k)POWAVEPOWAVEμ MF2(k)Figure. 7: ノイズキャンセラの 構 成SNR 2(k)SNR 1(k)Q N(k)SNRESTQ S(k)(ⅰ) サブフィルタ0.100.080.06SF10.040.02SF20.00-15 -10 -5 0 5 10 15(ⅱ) メインフィルタSNR [dB]0.0200.015MF10.010MF20.0050.000-15 -10 -5 0 5 10 15SNR [dB]Figure. 8: 推 定 SN 比 と 係 数 更 新 ステップサイズStepsizeStepsize⎧φXY⎪⎪φ = ⎨⎪−φ⎪⎩XY−π4. ノイズキャンセラ [6]4.1. ノイズキャンセラの 原 理for φfor φ> 0 and φノイズキャンセラは、 雑 音 用 マイクロホンに 入 力された 信 号 を 適 応 フィルタで 処 理 することによって擬 似 雑 音 を 生 成 し、 音 声 用 マイクロホンに 入 力 された 信 号 から 減 算 することによって、 音 声 に 混 入 する雑 音 を 消 去 する。PaPeRo では、 雑 音 用 マイクロホンに 混 入 する 音 声 信 号 (クロストーク)の 推 定 ・ 消 去も 合 わせて 行 うため、クロストーク 推 定 用 の 適 応 フィルタも 備 えている。Fig. 7 に、PaPeRo におけるノイズキャンセラの 構 成 を 示 す。メインフィルタ(MF1、MF2)2 つ、サブフィルタ(SF1、SF2)2 つ、 合 計 4 つの 適 応 フィルタによってororφφXYXYXYXY< 0 and φ> 0 and φ< 0 and φXYXYXYXY−φXZ+ γ < −φXY+ φYZ− γ−φXZ−γ< −φXY+ φYZ+ γ−φ− γ < −φ+ φ + γ (8)XZXY YZ−φXZ+ γ < −φXY+ φYZ− γ構 成 され、それぞれ 擬 似 雑 音 と 擬 似 クロストークを生 成 する。 雑 音 用 マイクロホンの 入 力 信 号 X R (k)から MF2 の 出 力 する 擬 似 クロストーク y 4 (k)を 減 算 したクロストーク 消 去 信 号 e 4 (k)を、MF1 に 入 力 する。MF1 の 出 力 する 擬 似 雑 音 y 3 (k)を、 音 声 用 マイクロホンの 入 力 信 号 X P (k)から 減 算 した 雑 音 消 去 信 号 e 3 (k)を、 強 調 音 声 として 出 力 する。MF1、MF2 の 係 数 更新 ステップサイズは、それぞれ SF1、SF2 の 出 力 を用 いて 制 御 する。SF1、SF2 の 係 数 更 新 ステップサイズは、 入 力 信 号 X P (k)と X R (k)を 用 いて 制 御 する。4.2. ステップサイズ 制 御適 応 フィルタの 係 数 更 新 ステップサイズは、 係 数更 新 に 対 する 妨 害 信 号 が 大 きいときに、 小 さな 値 とする。 例 えば、SF1 と MF1 のステップサイズμ SF1 (k)、μ MF1 (k)は、 入 力 信 号 X P (k)の SN 比 が 高 いとき、すなわち、X P (k)における 音 声 成 分 が 支 配 的 であるときに、 小 さな 値 にする。 一 方 、SN 比 が 低 いときは、 雑音 に 対 する 追 従 性 を 向 上 させるために、 大 きな 値 に設 定 する。SF2 と MF2 のステップサイズμ SF2 (k)、μMF2(k)に 関 しては、 音 声 と 雑 音 が 入 れ 替 えるだけで、同 様 の 制 御 を 行 う。MF1 のステップサイズは、X P (k)の SN 比 推 定 値SNR1(k)を 用 いて 制 御 する。SNR1(k)は、SF1 の 出 力する 擬 似 雑 音 y 1 (k) 及 び 雑 音 消 去 信 号 e 1 (k)の 平 均 電力 P S (k)、P N (k)の 比 として 求 める。MF2 のステップサイズに 関 しても 同 様 に、 擬 似 音 声 信 号 y 2 (k)とクロストーク 消 去 信 号 e 2 (k)に 基 づいて 求 めた、X R (k)のSN 比 推 定 値 SNR2(k)を 用 いて 制 御 する。SF1 と SF2のステップサイズは、 入 力 信 号 における SN 比 の 推定 値 SNR P (k)を 用 いて 制 御 する。SNR P (k)は、 入 力 信号 X P (k)と X R (k)の 平 均 電 力 R S (k)、R N (k)の 比 として求 める。メインフィルタとサブフィルタにおける 推定 SN 比 とステップサイズの 関 係 を、Fig. 8 に 示 す。5. 評 価 結 果5.1. 話 者 方 向 推 定PaPeRo を 用 いて、 以 下 の 3 方 式 を 比 較 評 価 した。1 非 近 接 音 場 方 向 推 定 + 多 数 決 による 前 後 決 定2 近 接 音 場 方 向 推 定 + 多 数 決 による 前 後 決 定3 近 接 音 場 方 向 推 定 +3 マイクロホンによる 前後 決 定評 価 環 境 をFig. 9に、パラメータ 値 を 表 1に 示 す。人 間 とロボットの 対 話 において、d、hは 通 常 未 知なので、 表 1に 示 す 代 表 的 な 値 に 設 定 した。PaPeRo44

5.4m5.5mLoudspeaker(Height:1.2m)Room Height:2.5m1.5m2.5mFigure. 9: 評 価 環 境PaPeRoTable 1: 評 価 パラメータM longM shortfscdh2m21[cm]14[cm]16[kHz]340[m/s]1.5[m]1.0[m]をπ/4ずつ 回 転 させ、8 方 向 から10 回 ずつ 収 録 音 声 をスピーカで 再 生 したときの 方 向 推 定 正 解 率 を 求 めた。ただし、 人 物 検 出 可 能 なカメラ 画 角 の 制 約 によって、±π/9 以 内 のずれまでを 正 解 として 許 容 した。 得 られた 方 向 推 定 結 果 を、Fig. 10に 示 す。1と2の 結 果 を 比 較 すると、 近 接 音 場 方 向 推 定 によって、 正 解 率 を 16% 改 善 できたことがわかる。(8)に 示 した 前 後 方 向 の 選 択 手 法 を 用 いることにより、正 解 率 をさらに 23% 改 善 することができた。 近 接 方向 推 定 と(8)を 合 わせて 用 いることにより、 正 解 率 は約 40% 改 善 したことになる。PaPeRo を 用 いた 音 源 方向 推 定 の 正 解 率 は、85%に 達 した。5.2. ノイズキャンセラ5.2.1. 雑 音 消 去 性 能サブフィルタにおけるステップサイズ 制 御 の 有( 提 案 法 )と 無 ( 従 来 法 )に 対 するノイズキャンセラの 雑 音 消 去 性 能 を 比 較 した。 男 性 音 声 の 収 録 音 声をスピーカで 再 生 し、 距 離 0.5m に 配 置 した PaPeRoを 使 って 収 録 したデータを 用 いて 評 価 した。 雑 音 は、距 離 1.0m、 方 向 180 度 、 音 量 57dB で 再 生 したテレビの 音 を 用 いた。 収 録 は、 幅 5.5[m]、 奥 行 5.0[m]、高 さ 2.4[m]のカーペット 敷 きの 部 屋 で、ロボットシナリオを 動 作 させて 行 った。MF1、MF2 のステップサイズ 制 御 結 果 を Fig. 11 に、 出 力 信 号 の 雑 音 抑 圧 量を Fig. 12 に、 音 声 歪 を 図 8 に 示 す。 各 グラフ 上 に 発話 の 有 無 の 状 態 を 示 す。 雑 音 抑 圧 量 R 3 (k)、 音 声 歪D 3 (k)は、 式 (9)、(10)で 求 める。RN⎡ Σj⎢ N⎢⎣Σj=−12= 0 33( k)= 10log10−120XPe ( k − j)⎤⎥( k − j)⎥⎦(9)正 解 率 [% ]100806040200123従 来近 接 音 場Figure. 10: PaPeRo による 方 向 推 定 正 解 率(ⅰ) MF1( 雑 音 推 定 )発 話 ありス発 話 なしテッ0.02プサ0.01イズ0.000 5 10 15 20 25時 間 [s](ⅱ) MF2(クロストーク 推 定 )D ( k)=310log発 話 ありス発 話 なしテ0.02ップサ0.01イズ0.000 5 10 15 20 25時 間 [s]従 来 法提 案 法Figure. 11: ステップサイズ10⎡Σ⎢⎢⎣N −1j=0{ e ( k − j)− S(k − j)}3N −1j=0ΣX2P( k − j)2⎤⎥⎥⎦(10)Fig. 11 を 参 照 すると、 提 案 法 を 用 いた 場 合 、MF1のステップサイズは、 妨 害 信 号 となる 音 声 信 号 がある 区 間 で、 小 さな 値 となることが 確 認 できる。 一 方 、MF2 のステップサイズは、 発 話 区 間 で、 大 きな 値 となることが 確 認 できる。Fig. 12、Fig. 13 を 参 照 すると、 雑 音 抑 圧 量 は、 最 大 20dB、 音 声 歪 は、 最 大 20dB改 善 した。5.2.2. 音 声 認 識 性 能PaPeRo を 用 いて、Fig. 14 に 示 す 環 境 で、ノイズキャンセラ 有 と 無 に 対 する 音 声 認 識 性 能 を 比 較 した。 男女 子 供 30 名 による 1500 単 語 の 収 録 音 声 をスピーカで 再 生 し、 正 面 方 向 、 距 離 0.5m 及 び 1.5m に 配 置 した PaPeRo における 認 識 率 を 評 価 した。 距 離 1.0m、方 向 30、60、90、135、180 度 の 5 方 向 から、 音 量57dB、67dB で 再 生 したテレビの 音 を 雑 音 とした。音 声 認 識 には、PaPeRo の 認 識 語 600 単 語 の 辞 書 を 有45

する 隠 れマルコフモデルに 基 づく 離 散 単 語 認 識 シス出力[dB]発 話 あり発 話 なし音声歪[dB]100-10-20-30発 話 あり発 話 なし40200-20-40Figure. 12: 出 力 信 号 の 雑 音 抑 圧 量Figure. 13: 音 声 歪テムを 用 いた。 得 られた 認 識 率 を、Fig. 15 に 示 す。棒 グラフは、ノイズキャンセラによる 認 識 率 改 善 の最 大 値 と 最 小 値 を 示 す。例 えば、 話 者 距 離 0.5m、 雑 音 音 量 57dB に 対 する結 果 を 参 照 すると、 雑 音 方 向 が 90 度 より 後 方 のときは、 無 雑 音 と 同 等 の 認 識 率 を 達 成 している。このとき、 認 識 率 の 最 大 改 善 値 は 65%に 達 した。 他 の 3 例においても、 雑 音 方 向 の 前 方 への 回 り 込 み、 話 者 -ロボット 間 距 離 の 増 加 、 雑 音 音 量 増 大 のいずれかが存 在 すると、 認 識 率 が 低 下 することが 確 認 できる。6. 今 後 の 課 題今 後 は、 複 数 話 者 が 存 在 する 環 境 で、 各 々の 話 者方 向 推 定 を 行 うことが 課 題 となる。また、 音 声 認 識では、 雑 音 環 境 下 での 遠 距 離 発 話 認 識 率 の 向 上 が 課題 である。これら 課 題 の 解 決 には、 本 稿 で 紹 介 した手 法 の 改 良 、 他 の 音 響 信 号 処 理 技 術 の 統 合 、さらに非 音 響 センシングを 統 合 した、より 高 精 度 な 音 声 ・雑 音 制 御 が 必 要 となる。そのためには、フィールドテストを 通 じたデータの 収 集 ・ 評 価 、その 分 析 を 通じた 問 題 点 の 明 確 化 と 対 策 が 重 要 となる。7. おわりに0 5 10 15 20 25従 来 法時 間 [s]提 案 法0 5 10 15 20 25従 来 法時 間 [s]提 案 法PaPeRo における、 近 接 話 者 方 向 推 定 と 広 範 囲 な SN比 に 対 応 できるノイズキャンセラについて 紹 介 した。実 環 境 評 価 により、 近 接 音 場 方 向 推 定 が 従 来 よりも40% 高 い 正 解 率 を 達 成 することを 示 した。また、ノイズキャンセラの 実 環 境 評 価 結 果 を 用 いて、 雑 音 抑圧 量 が 最 大 20dB、 音 声 歪 が 20dB、 音 声 認 識 率 が 最大 65% 改 善 し、57dB の 雑 音 に 対 して 無 雑 音 と 同 等 の180認 識 率 [%]1008060401.5m 0.5m1.0m57dB話 者雑 音300Figure. 14: 実 験 環 境ノイズなし(0.5m)ノイズなし(1.5m):0.5m:1.5m13560902067dB最 大 改 善 値0最 小 改 善 値-2030 60 90 135 180雑 音 方 向 [ 度 ]Figure. 15: 雑 音 消 去 による 音 声 認 識 率 の 違 い認 識 率 を 達 成 できることを 示 した。 本 研 究 の 一 部 はNEDO 実 用 システム 化 推 進 事 業 の 助 成 を 受 けて 行っており、この 技 術 に 基 づいたチャイルドケアロボットは、2005 年 愛 知 で 開 催 された 愛 ・ 地 球 博 において、 技 術 実 証 運 用 を 行 った。参 考 文 献1) Special Issue on Entertainment and Amusement RobotTecnologies, J. of Robotics and Mechatronics, Vol.14,No.1, Feb. 2002.2) M. Brandstein and D. Ward, “Microphone Arrays,”Springer Verlag, Berlin, 2001.3) S. Ikeda and A. Sugiyama, “An Adaptive Noise Cancellerwith Low Signal-Distortion in the Presence ofCrosstalk,” IEICE Trans. Fund, pp.1517-1525, Aug.1999.4) Y. Fujita,“Personal Robot PaPeRo,” J. of Robotics andMechatronics, Vol.14, No.1, Jan.2002.5) M. Sato, A. Sugiyama, O. Hoshuyama, N. Yamashita,and Y. Fujita, “Near-Field Sound-Source LocalizationBased on a Signed Binary Code,” IEICE Trans. Fund,pp.2078-2086, Vol.E88-A, No.8, Aug. 20056) M. Sato, A. Sugiyama and S. Ohnaka,“An AdaptiveNoise Canceller with Low Signal -Distortion based onVariable Stepsize Subfilters for Human-Robot Communication,”IEICE Trans. Fund, pp.2055-2061,Vol.E88-A, No.8, Aug. 200546

社 団 法 人 人 工 知 能 学 会Japanese Society forArtificial Intelligence人 工 知 能 学 会JSAI Technical ReportSIG-CHallege-0522-8 (10/14)ÆÆ ÓÑÑÙÒØÓÒ ÊÓÓØ ËÙÒÓ ÀÖ¸ ÌÒÓÖ Æ×ÒÓ¸ ÃØÙÒÓÙ ÁØÓÙ¸ ÝÓÑ ÅÝѸ Ò ÃÞÙÝ ÌºÖÙØ ËÓÓÐ Ó ÁÒÓÖÑØÓÒ ËÒ¸ ÆÓÝ ÍÒÚÖ×ØÝÖ×ԺѺ׺ÒÓݹٺºÔ×ØÖØÌ× ÔÔÖ ÔÖ×ÒØ× ÑÙÐعÙ×Ö Ò ÑÙÐعÐÒÙÐ ÓÑÑÙÒØÓÒ ÖÓÓØ Æ ´¹ÐÓÙ ÒØ ÔÔÐ ØÓ ÆÚØÓÒ ÒÒ¹ÑÒص ØØ Ò ÒØÙÖÐÐÝ ÓÑÑÙÒØ ÛØØÛÓ ÓÖ ÑÓÖ ÔÓÔÐ ×ÑÙÐØÒÓÙ×ÐÝ ØÖÓÙ×ÔÓÒ ÐÓÙ Ò ×ØÙÖº Æ ÑÒÐÝÓÒ××Ø× Ó ØÖ ÑÓÙÐ× ÒÐÙÒ ×ÔÖÓÒÞÖ¸ ÐÓÙ ÑÒÖ Ò ÖÓÓØºÌ ×Ô ÖÓÒÞÖ × ÐÒÙ¹ÔÒÒØÓÙ×Ø ÑÓÐ× Ò ÒØÛÓÖ ÖÑÑÖ× ÓØÖ ÐÒÙ× ÂÔÒ׸ ÒÐ׸ Ò ¹Ò׺ Ì ÐÓÙ ÑÒÖ × ÐÒÙ¹ÒÔÒÒØ ×ØØ ØÖÒ×ØÓÒ ÑÓÐ ØÓ ÙÒÖ¹×ØÒ Ø ÓÒØÜØ Ò ×ÑÒØ Ð×× ÓØ Ù×ÖÙØØÖÒ׺ Ì ×Ò ÓØ ÖÓÓØ ÓÙ×× ÓÒ ÖÒÐÝ ÐÓÓÒ Ò ÐÓÚÐÝ ÖØÖ×Ó ØØ ÔÓÔÐ Ò ÓÑÑÙÒØ ÛØ Ø ÖÓÓØÒ ÖÐÜ Ò «Ð ÑÓÓº Æ Û×ÑÓÒ×ØÖØ Ø Ø ÈÖÓØÓØÝÔ ÊÓÓØ Ü¹ØÓÒ ×ÔÓÒ×ÓÖ Ý ÆÇ ´Ø ÆÛ ÒÖÝ ÒÁÒÙ×ØÖÐ ÌÒÓÐÓÝ ÚÐÓÔÑÒØ ÇÖÒÞ¹ØÓÒµ Ø Ø ÏÓÖÐ ÜÔÓ ¾¼¼ Ò ÔÖ¹ÓÖÑ ÙÒ Ó ÐÓÐ ØÓÙÖ×Ø ØØÖØÓÒ×Ò ÓÓ Ó Ø ØÖ ÔÖØÙÖ× Ò ÌÓ Öº½ »» Æ ´ÐÓÙ ÒØ ÔÔÐ ØÓÆÚØÓÒ ÒÒÑÒص ÆÇ ´µ ´¾¼¼ ½ µ ¾ Æ ´µ ´¿ µ ¾º½ ´µ 47

123ÙÖ ½ ¾º¾ ´º ½µ ´º ¾µ ¸ ½¸ ¾℄ È ÙÖ ¾ ¿ ¾º¿ Í Æ Í Í 48

½¼ ¿ ¾º º ¿ ÙÖ ¿ Æ ¿ ¿º½ º ´µ ´µ ÙÖ ÌÐ ½ 49

ÌÐ ½ ¿º¾ ÅÎÆÇÂǼ½ºÔ ÅÌÙÖÒÌÓÍ×ÖºØ Ù×Ö ÎÆÇÂǺÛÚ ´µËÅϾ¼ ´¾¼ µÊÆÇÂǼ¾ºÔ ÎϽ¼ ´½¼ µÎÓØÓÙÓºÛÚ ´µÅØ×O ÅÀ¾ËÅϾ¼ ´¾¼ µÁÆÇÂǼ¾ºÔ ÎϽ¼ ´½¼ µÎÓØÓÙÓºÛÚµÅØ×ÔºØÅÀ¾ËÆÇÂǼ¿ºÔ ´º Ë ¸ θ Å ÆǼ¼¿ºÔ ÙÖ ÎÓØÓÙÓºÛÚµÅØ×ÔºØÅÀ¾ ´ËÅϾ¼ ´¾¼ µÁ Ø×O 50

¾¼ ¿º¿ Á Á » ¾¼¼ Á ¾ Á ÆÇ ´µ ´¾¼¼ ½ µ ´º µ ´¾ µ ËÆÊ ´ ¿℄ µËÆÊ º ¾¿º 発 話 数100908070605040302010010 20 30 40SNR [dB]ÙÖ ËÆÊ Æ ÅÁÌÅ ÄÓÖØÓÖÝ ÅÖÓ×ÓØ Ê×Ö × ÙÖ ½℄ ùÝÙ À×Ó¸ ÆÓÐÓ× ÅÚÖ× Ò ÊÓݸÓÙÔÐÒ ÈÖÔØÓÒ Ò ËÑÙÐØÓÒ ËØÔ× ÌÓ¹ÛÖ× ÓÒÚÖ×ØÓÒÐ ÊÓÓØ׸ ÈÖÓº Á»ÊËÂ51

ÁÒØÖÒØÓÒÐ ÓÒÖÒ ÓÒ ÁÒØÐÐÒØ ÊÓÓØ× ÒËÝ×ØÑ× ´¾¼¼¿µº¾℄ ÊÓݸ ù٠À×Ó¸ Ò ÆÓÐÓ× ÅÚÖ׸ÅÒØÐ ÁÑÖÝ ÓÖ ÓÒÚÖ×ØÓÒÐ ÊÓÓظ ÁÌÖÒ×ØÓÒ× ÓÒ ËÝ×ØÑ׸ ÅÒ¸ Ò ÝÖÒØ׸ÈÖØ ¸ ÎÓÐÙÑ ¿ ¸ Á××Ù ¿¸ Ô× ½¿¹½¿¿ ´¾¼¼µº¿℄ ú ̸ ̺ Àº ظ Àº ÙÑÙÖ¸ Ò º ÁØÙÖ¸ËÆÊ Ò ÐÓÐ ÒÓ× ÔÓÛÖ ×ØÑØÓÒ× × ÓÒÙ××Ò ÑÜØÙÖ ÑÓÐÒ ÓÒ Ø ÐÓ¹ÔÓÛÖ Ó¹ÑÒ¸ ÈÖÓº ÁËËȳ¼¸ ÔÔºÁ¹½¹¸ ¾¼¼º52

社 団 法 人 人 工 知 能 学 会Japanese Society forArtificial Intelligence人 工 知 能 学 会JSAI Technical ReportSIG-CHallege-0522-9 (10/14)ハフ 変 換 を 用 いた 音 源 音 のクラスタリングとロボット 用 聴 覚 への 応 用Clustering of sound-source signals using Hough transformation,and application to omni-directional acoustic sense for robots〇 鈴 木 薫 , 古 賀 敏 之 , 廣 川 潤 子 , 小 川 秀 樹 , 松 日 楽 信 人株 式 会 社 東 芝 研 究 開 発 センター ヒューマンセントリックラボラトリー* Kaoru SUZUKI, Toshiyuki KOGA, Junko HIROKAWA,Hideki OGAWA, and Nobuto MATSUHIRAHumancentric Laboratory, Corporate Research & Development Center, Toshiba Corporationkaoru3.suzuki@toshiba.co.jpAbstract— In this paper, we proposed a new method ofomni-directional acoustic sense with which a robot couldlocalize and recognize multiple sounds from unlimiteddirection even under a noisy environment. We usedHough transformation to detect straight lines from thefrequency phase difference space for detection and localizationof sound sources. Experimental results with ourrobot, ApriAlpha were shown to verify the efficacy ofthis method.1. はじめに筆 者 らは、 家 庭 内 環 境 で 利 用 者 と 音 声 でインタラクションすることを 想 定 したロボット『ApriAlphaTM 』を 開 発 している。 家 庭 内 環 境 には 様 々な 雑 音 が存 在 する。 他 方 で、ロボットはこれら 雑 音 にさらされながら 命 令 権 限 のある 利 用 者 の 音 声 をどの 方 向 からでも 受 け 付 けて 個 々に 認 識 し、サービスを 提 供 できなければならない。また、ロボットはより 高 度 に状 況 を 認 識 するために、 利 用 者 の 命 令 音 声 に 限 らず、室 内 のドアの 開 閉 音 、シャワーの 断 続 音 、ガラスの破 壊 音 などの 環 境 音 を 聞 き 分 け、その 発 生 源 の 位 置を 特 定 できると 都 合 が 良 い。そのため、ロボット 用の 聴 覚 システムは、(1) 四 方 八 方 から 到 来 する 音 声を、(2) 音 源 毎 に 分 離 抽 出 して、(3) 個 別 に 定 位し 認 識 できる 必 要 がある。 本 稿 では、このような 全方 位 性 を 持 つロボット 用 聴 覚 (Fig.1)の 1 方 式 について 報 告 する。て、 音 源 を 制 約 せずに 空 間 相 関 行 列 を 解 く 方 法 [1]や、音 源 音 声 が 調 波 構 造 を 持 つことを 利 用 する 方 法 [2]が報 告 されている。 前 者 は 音 源 数 を 超 える 数 のマイクを 利 用 する 場 合 に 優 れた 方 式 であり、 後 者 は 人 間 の音 声 を 扱 う 場 合 に、より 少 ないマイクでマイク 数 以上 の 音 源 を 扱 える 方 式 である。 本 稿 で 報 告 する 方 式は 上 記 後 者 のアプローチに 類 似 しているが、 音 源 検出 に 調 波 構 造 を 用 いる 代 わりに、 周 波 数 と 位 相 差 の関 係 に 着 目 し、 音 源 の 数 と 方 向 の 推 定 を 周 波 数 - 位相 差 空 間 における 直 線 検 出 問 題 に 帰 着 させてハフ 変換 により 解 く。 検 出 された 直 線 を 複 数 のマイク 対 について 対 応 付 けて 音 源 候 補 の 空 間 定 位 を 行 い、 適 応アレイ 処 理 によって 音 源 音 を 分 離 して 認 識 する。以 下 、 本 稿 では、 開 発 中 の 聴 覚 処 理 方 式 の 動 作 原理 を 説 明 するとともに、4 話 者 順 次 発 話 時 と 2 話 者 同時 発 話 時 で 全 方 位 性 を 確 認 した 実 験 について 報 告 する。2. 本 方 式 の 動 作 原 理2.1. 音 源 方 向 φ・ 到 達 時 間 差 ΔT・ 周 波 数 毎 の 位 相差 ΔPh の 関 係マイク 1 と 2 から 成 るマイク 対 を 考 える。 音 源 がマイク 間 距 離 d に 比 べて 十 分 遠 く、 途 中 に 障 害 物 がないと 仮 定 するなら、 音 源 を 発 してマイク 対 に 到 達する 波 面 はほぼ 平 面 となっている。この 平 面 波 を 観測 すると、 両 マイクを 結 ぶベースラインに 対 する 音源 方 向 の 角 度 に 応 じて、 両 マイクで 観 測 される 音 響信 号 に 所 定 の 到 達 時 間 差 ΔT が 観 測 される。 到 達 時間 差 ΔT は±ΔTmax の 範 囲 で 変 化 し 得 る。ΔTmaxは、 音 速 を Vs として、ΔTmax=d/Vs として 定 められる 到 達 時 間 差 の 理 論 上 の 最 大 値 である。このとき、音 源 の 方 向 φをマイク 間 ベースラインの 中 点 を 基 点にベースライン 垂 直 方 向 を 0 として 式 1 を 用 いて 計算 する。なお、ΔT はマイク 対 を 構 成 するマイクの一 方 に 対 する 他 方 の 到 達 時 間 差 となるため 符 号 付 きの 量 であり、φも 符 号 付 きとなる。φ=sin -1 (ΔT/ΔTmax) ・・・( 式 1)Fig.1 A scene of omni-directional acoustic sense上 述 したような 聴 覚 機 能 の 代 表 的 な 研 究 成 果 としマイク 1 とマイク 2 で 到 達 時 間 差 ΔT を 持 つ 音 響 信号 を FFT によって 周 波 数 成 分 毎 に 分 解 してその 位 相差 ΔPh を 眺 めると、 両 者 に 比 例 関 係 が 認 められる。53

例 えば、 同 一 時 間 差 ΔT に 対 して、 周 波 数 f の 波 は1/2 周 期 、すなわちπだけの 位 相 区 間 を 含 むとすると、2 倍 の 周 波 数 2f の 波 では1 周 期 、すなわち 2πの 位相 区 間 を 含 む。このように、 同 一 時 間 差 ΔT に 対 する 位 相 差 ΔPh は 周 波 数 に 比 例 して 大 きくなる。したがって、 同 一 音 源 から 発 せられてΔT を 共 通 にする各 周 波 数 成 分 の 位 相 差 を、Fig.2 に 例 示 するように 横軸 を 位 相 差 、 縦 軸 を 周 波 数 とする 2 次 元 座 標 系 上 にプロットすると、 各 周 波 数 成 分 の 位 相 差 を 表 す 座 標点 が 1 本 の 直 線 上 に 並 ぶ。ΔT が 大 きいほど、すなわち 両 マイク 間 で 音 源 までの 距 離 が 異 なるほど、この 直 線 の 傾 きは 大 きくなる。このとき、ΔPh とΔTの 関 係 は 式 2 のようになる。在 するが、 原 点 O から 各 直 線 に 下 ろした 垂 線 の X 軸からの 傾 きをθ、この 垂 線 の 長 さをρとして 表 現 すると、1つの 直 線 についてθとρは 一 意 に 決 まり、ある 点 p(x, y)を 通 る 直 線 の 取 り 得 るθとρの 組 は、θρ 座 標 系 上 で 固 有 の 軌 跡 (ρ=x・cosθ+y・sinθ)を 描 くことが 知 られている。このような、(x,y) 座 標値 からそこを 通 り 得 る 直 線 の(θ,ρ) 軌 跡 への 変 換 を直 線 ハフ 変 換 という。 複 数 の 点 を 共 通 に 通 る 直 線 は各 点 の 軌 跡 が 1 点 で 交 差 するため、 所 定 の 投 票 バッファに 軌 跡 を 投 票 することで、 多 数 の 点 を 通 る 有 力な 直 線 を 高 得 票 位 置 に 検 出 することができる。これをハフ 投 票 という。なお、このとき、 直 線 が 左 に 傾いているときθは 正 値 、 垂 直 のとき 0、 右 に 傾 いているとき 負 値 であるとし、また、θの 定 義 域 は{θ:-π

ている。図 中 (b)は、マイク 対 の 正 面 から 発 声 したときの結 果 を 表 したものであり、 位 相 差 スペクトルは 回 転せずに 0 付 近 ( 赤 色 )に 留 まっている。図 中 (c)は、マイク 対 の 左 から 発 声 したときの 結果 を 示 したものである。 位 相 差 は 周 波 数 の 高 い 領 域に 行 くにつれて 赤 紫 色 から 橙 色 へ 変 化 するグラデーション、すなわち 色 円 環 上 で(a)の 逆 方 向 への 回 転を 示 している。いずれの 場 合 も 音 源 は 移 動 していないため、 周 波数 成 分 毎 の 位 相 差 は 時 間 軸 方 向 でほぼ 一 定 に 安 定 している。すなわち、 位 相 差 スペクトルは 音 源 の 方 向を 知 るための 情 報 として 信 頼 できる。そして、この位 相 差 スペクトルの 各 周 波 数 成 分 値 ΔPh は 前 述 の 直線 の 傾 きθから 式 3 によって 知 ることができる。なお、 位 相 差 ΔPh が 負 値 となるとき、θは 正 値 となる。そのために、θの 符 号 を 反 転 させている。ΔPh(θ, f)=f・tan(-θ) ・・・( 式 3)2.4. ρ=0 の 制 約マイク 1 と 2 の 信 号 が 同 相 で A/D 変 換 される 場 合 、検 出 されるべき 直 線 は 必 ずρ=0、すなわち XY 座 標系 の 原 点 を 通 る。したがって、 音 源 の 推 定 問 題 は、ハフ 投 票 バッファ 上 の 得 票 分 布 S(θ,ρ)でρ=0 となるθ 軸 上 の 1 次 元 の 得 票 分 布 S(θ,0)からローカルピークを 探 索 する 問 題 に 帰 着 する。Fig.5 に 実 際 の 単 独 発 話 音 声 を 使 って 直 線 を 検 出 した 例 を 示 す。この 例 は、 室 内 雑 音 環 境 下 で 1 人 の 人物 がマイク 対 の 正 面 約 20 度 左 から 発 話 した 実 際 の 音声 を 用 いて 処 理 した 結 果 である。 図 中 にマイク 1 と 2のパワースペクトル 及 び 位 相 差 スペクトル(a)、 図中 (b)に FFT 結 果 から 得 た 周 波 数 成 分 毎 の 位 相 差 プロット 図 を、 図 中 (c)に 位 相 差 プロット 図 から 得 たハフ 投 票 結 果 を、 図 中 (d)にρ=0 上 の 得 票 分 布 を、図 中 (e)に 検 出 されたローカルピーク( 直 線 候 補 )を、 図 中 (f)に 得 票 1 位 のピークをプロット 図 上 に描 画 した 直 線 ( 赤 )をそれぞれ 示 す。マイク 対 で 取 得 された 音 声 は、 周 波 数 成 分 毎 のパワー 値 と 位 相 値 のデータに 変 換 される。これを 受 けて、 周 波 数 成 分 毎 の 位 相 差 が 求 められ、その(x,y)座 標 値 が 算 出 される。この 座 標 値 の 集 合 をプロットした 図 を 確 認 すると、 原 点 から 左 に 傾 いた 直 線 に 沿う 点 群 分 布 が 認 められる。このような 分 布 を 示 している 各 点 の(θ,ρ) 軌 跡 がハフ 投 票 バッファに 投 票 されて 得 票 分 布 S(θ,ρ)を 形 成 する。θ 軸 上 の 得 票 分 布 S(θ,0)を H(θ)として 抜 き 出 して 棒 グラフにしたものが 図 中 (d)である。この 得 票分 布 H(θ)には 幾 つか 極 大 部 が 存 在 している。 図 中(e)にローカルピークの 探 索 結 果 を 示 す。このようにすることで 十 分 な 得 票 を 得 た 直 線 のθを 割 り 出 すことができる。この 例 では、 検 出 された 4 つのピークのうち、 閾 値 処 理 によって 1 位 のみが 検 出 されている。Fig.5 An experimental result of line detection with ρ=0 constraint in a case of single speaker2.5. 位 相 差 の 循 環 性ところで、 両 マイク 間 の 位 相 差 ΔPh(f)が Fig.2 に 示したように 全 域 で 周 波 数 に 比 例 するのは、 解 析 対 象となる 最 低 周 波 数 から 最 高 周 波 数 まで 通 して 真 の 位相 差 が±πを 逸 脱 しない 場 合 に 限 られる。この 条 件はΔT が、 最 高 周 波 数 Fr/2[Hz](サンプリング 周 波 数Fr の 半 分 )の 1/2 周 期 分 の 時 間 、すなわち 1/Fr[ 秒 ]以 上 とならないことである。もし、ΔT が 1/Fr 以 上となる 場 合 には、 次 に 述 べるように 位 相 差 が 循 環 性を 持 つ 値 としてしか 得 られないことを 考 慮 しなければならない。手 に 入 れることのできる 周 波 数 成 分 毎 の 位 相 値 は例 えば-πからπの 間 というように 2πの 幅 でしか得 ることができない。これはその 周 波 数 成 分 における 実 際 の 位 相 差 が 両 マイク 間 で 1 周 期 以 上 開 いていても、データとして 得 られる 位 相 角 からそれを 知 ることができないことを 意 味 する。 要 するに、ΔT に起 因 する 真 の 位 相 差 は、データとして 得 られた 位 相差 の±2πや、さらに±4πや±6πの 値 である 可 能 性がある。これを 模 式 的 に 示 すと Fig.6 のようになる。図 中 の○がΔT を 同 じくする 真 の 位 相 差 だが、 観 測されるのは 左 に 2π 平 行 移 動 して 現 れる●となる。Fig.6 Circulation of phase differenceρ=0 の 制 約 では 原 点 を 通 る 直 線 のみを 探 すことになるので、このように 2πの 剰 余 系 として 循 環 した 位置 に 現 れる 点 群 をカウントしていない。これは 傾 きの 大 きな 直 線 ほど 得 票 で 不 利 になることを 意 味 している。そのことは Fig.5(d)に 示 した 得 票 分 布 にお55

いて、θの 絶 対 値 が 大 きくなる 左 右 端 付 近 にほとんど 得 票 値 のないことから 見 てとれる。θの 全 域 に 渡る 公 平 な 探 索 を 実 現 するためには、 循 環 して 現 れる平 行 線 群 を 得 票 分 布 H(θ)に 加 えなければならない。なお、 平 行 線 の 間 隔 Δρは 直 線 の 傾 きθの 関 数 Δρ(θ)として 式 4 で 定 義 される 符 号 付 きの 値 となる。Δρ(θ)= 2π・cosθ :θ>0Δρ(θ)=-2π・cosθ :θ

室 内 雑 音 環 境 下 で 2 人 の 人 物 が 異 なる 方 向 から 同 時発 声 したときのストリーム 追 跡 結 果 である。0~4 番までの 5 つのストリームが 追 跡 により 検 出 されている。このうち、1 番 と 3 番 が 正 解 、0 番 と 4 番 が 背 景での 人 の 話 し 声 、2 番 が 偽 のストリームである。なお、 音 源 が 大 きく 移 動 しないと 仮 定 すれば、ストリームを 構 成 する 各 時 刻 の 直 線 群 によるθを 平 均したものをストリームのθとすることができる。を 使 ったときの 音 源 定 位 の 概 念 を 示 した 図 である。各 マイク 対 から 得 られた 音 源 方 向 φ1 とφ2 について最 小 二 乗 誤 差 となるドーム 上 の 仮 想 音 源 を 探 索 する。Fig.9 Principle of sound source localization with φ1and φ2Fig.8 An experimental result of stream tracking2.9. 成 分 推 定 とストリーム 照 合以 上 で 説 明 した 処 理 は、1 つのマイク 対 においてそれぞれ 実 行 される 処 理 である。ロボットは 複 数 のマイク 対 を 実 現 できるので、マイク 対 をまたぐ 処 理 によって、さらに 音 源 についての 情 報 を 得 ることができる。異 なるマイク 対 で 検 出 されたストリームでも、 同一 音 源 に 由 来 する 限 り、その 継 続 期 間 と 周 波 数 成 分は 似 ているはずである。 既 に 述 べたように、 各 マイク 対 で 検 出 される 音 源 の 主 な 周 波 数 成 分 は、その 証拠 となった 直 線 群 の 近 傍 に 分 布 するプロット 図 上 の点 を 選 別 することで 推 定 することができる。このように 音 源 の 周 波 数 成 分 を 粗 く 推 定 し、 推 定 された 周波 数 成 分 を 例 えば 単 純 類 似 度 法 などで 比 較 照 合 することで、あるマイク 対 のある 直 線 群 が、 別 のマイク対 のどの 直 線 群 と 似 ているかを 評 価 することができる。ストリーム 照 合 は、 推 定 された 音 源 の 周 波 数 成 分と 継 続 期 間 を 評 価 することで、 同 時 期 に 似 た 周 波 数成 分 を 持 っている 音 源 をマイク 対 間 で 対 応 付 ける 処理 である。 対 応 付 けられるべき 相 手 が 見 つからないストリームはノイズとして 削 除 される。2.10. 音 源 定 位ストリーム 照 合 によって 対 応 付 けられたストリームは、 各 マイク 対 に 対 する 音 源 方 向 φ(θから 計 算 )を、 対 応 付 けられたマイク 対 の 数 だけ 持 っている。これをマイク 対 の 数 n を 使 って 表 すと、 音 源 方 向 情報 ={φ1…φn}となる。この 集 合 は、ある 空 間 位 置にある 音 源 が、それぞれのマイク 対 から 見 てどの 方向 にあるかを 示 したデータである。そこで、ロボットを 中 心 に 仮 想 的 なドームを 考 え、そのドーム 表 面に 適 度 な 間 隔 で 離 散 した 仮 想 的 な 音 源 を 配 置 し、 各仮 想 音 源 が 各 マイク 対 のどの 方 向 にあるかを 予 め 計算 してテーブル 化 しておく。Fig.9 は 2 つのマイク 対3. 動 作 確 認 実 験3.1. システム 構 成2 章 で 説 明 した 処 理 によって 全 方 位 聴 覚 を 実 現 するシステム 構 成 を Fig.10 に 示 す。Fig.10 System block diagramロボットは Mic1~6 の 6 つのマイクを 装 備 している。システムは 1 つの 音 源 推 定 プロセスと 最 大 6 つの 音 声 認 識 プロセスとで 構 成 されており、プロセス間 は 共 有 メモリで 結 ばれている。 音 源 推 定 プロセスは 前 述 した 音 響 信 号 処 理 を 行 って、 各 マイク 対 に 対する 音 源 数 と 方 向 の 推 定 処 理 と、 複 数 のマイク 対 を使 った 音 源 の 空 間 定 位 処 理 を 行 う。 音 声 認 識 プロセスは 認 識 エンジンの 前 段 に 適 応 アレイ 処 理 を 配 したプロセスであり、マイク 対 に 対 する 音 源 の 方 向 φを使 って 適 応 アレイの 追 従 範 囲 を 設 定 し、 音 源 音 の 抽出 と 抽 出 された 音 声 の 認 識 を 行 う。 音 声 認 識 プロセスは 音 源 推 定 プロセスによって 方 向 の 異 なる 音 源 毎に 処 理 対 象 を 割 り 当 てられて 認 識 を 実 行 する。マイクからの 音 響 信 号 は 新 開 発 のメディア 処 理 ボード(MFeP2)によって 全 チャンネル 同 期 取 り 込 みがされるため、ローカルピーク 探 索 時 には 原 点 を 通 る 直線 群 ( 基 準 直 線 とその 循 環 延 長 線 )を 探 索 すればよい。3.2. 処 理 の 流 れ57