HVAC in der Bauindustrie - Fujitsu

HVAC in der Bauindustrie - Fujitsu

HVAC in der Bauindustrie - Fujitsu

Sie wollen auch ein ePaper? Erhöhen Sie die Reichweite Ihrer Titel.

YUMPU macht aus Druck-PDFs automatisch weboptimierte ePaper, die Google liebt.

White Paper – FUJITSU PRIMERGY HPC Cluster – <strong>HVAC</strong> <strong>in</strong> <strong>der</strong> Bau<strong>in</strong>dustrie<br />

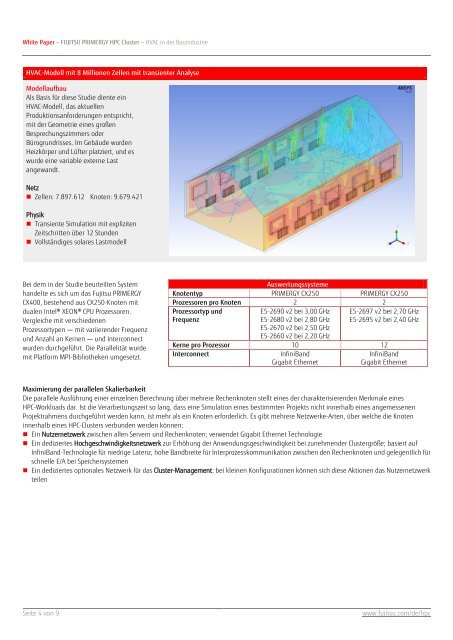

<strong>HVAC</strong>-Modell mit 8 Millionen Zellen mit transienter Analyse<br />

Modellaufbau<br />

Als Basis für diese Studie diente e<strong>in</strong><br />

<strong>HVAC</strong>-Modell, das aktuellen<br />

Produktionsanfor<strong>der</strong>ungen entspricht,<br />

mit <strong>der</strong> Geometrie e<strong>in</strong>es großen<br />

Besprechungszimmers o<strong>der</strong><br />

Bürogrundrisses. Im Gebäude wurden<br />

Heizkörper und Lüfter platziert, und es<br />

wurde e<strong>in</strong>e variable externe Last<br />

angewandt.<br />

Netz<br />

• Zellen: 7.897.612 Knoten: 9.679.421<br />

Physik<br />

• Transiente Simulation mit expliziten<br />

Zeitschritten über 12 Stunden<br />

• Vollständiges solares Lastmodell<br />

Bei dem <strong>in</strong> <strong>der</strong> Studie beurteilten System<br />

handelte es sich um das <strong>Fujitsu</strong> PRIMERGY<br />

CX400, bestehend aus CX250-Knoten mit<br />

dualen Intel® XEON® CPU Prozessoren.<br />

Vergleiche mit verschiedenen<br />

Prozessortypen ― mit variieren<strong>der</strong> Frequenz<br />

und Anzahl an Kernen ― und Interconnect<br />

wurden durchgeführt. Die Parallelität wurde<br />

mit Platform MPI-Bibliotheken umgesetzt.<br />

Auswertungssysteme<br />

Knotentyp PRIMERGY CX250 PRIMERGY CX250<br />

Prozessoren pro Knoten 2 2<br />

Prozessortyp und<br />

Frequenz<br />

E5-2690 v2 bei 3,00 GHz<br />

E5-2680 v2 bei 2,80 GHz<br />

E5-2670 v2 bei 2,50 GHz<br />

E5-2660 v2 bei 2,20 GHz<br />

E5-2697 v2 bei 2,70 GHz<br />

E5-2695 v2 bei 2,40 GHz<br />

Kerne pro Prozessor 10 12<br />

Interconnect<br />

Inf<strong>in</strong>iBand<br />

Inf<strong>in</strong>iBand<br />

Gigabit Ethernet<br />

Gigabit Ethernet<br />

Maximierung <strong>der</strong> parallelen Skalierbarkeit<br />

Die parallele Ausführung e<strong>in</strong>er e<strong>in</strong>zelnen Berechnung über mehrere Rechenknoten stellt e<strong>in</strong>es <strong>der</strong> charakterisierenden Merkmale e<strong>in</strong>es<br />

HPC-Workloads dar. Ist die Verarbeitungszeit so lang, dass e<strong>in</strong>e Simulation e<strong>in</strong>es bestimmten Projekts nicht <strong>in</strong>nerhalb e<strong>in</strong>es angemessenen<br />

Projektrahmens durchgeführt werden kann, ist mehr als e<strong>in</strong> Knoten erfor<strong>der</strong>lich. Es gibt mehrere Netzwerke-Arten, über welche die Knoten<br />

<strong>in</strong>nerhalb e<strong>in</strong>es HPC-Clusters verbunden werden können:<br />

• E<strong>in</strong> Nutzernetzwerk zwischen allen Servern und Rechenknoten; verwendet Gigabit Ethernet Technologie<br />

• E<strong>in</strong> dediziertes Hochgeschw<strong>in</strong>digkeitsnetzwerk zur Erhöhung <strong>der</strong> Anwendungsgeschw<strong>in</strong>digkeit bei zunehmen<strong>der</strong> Clustergröße; basiert auf<br />

Inf<strong>in</strong>iBand-Technologie für niedrige Latenz, hohe Bandbreite für Interprozesskommunikation zwischen den Rechenknoten und gelegentlich für<br />

schnelle E/A bei Speichersystemen<br />

• E<strong>in</strong> dediziertes optionales Netzwerk für das Cluster-Management; bei kle<strong>in</strong>en Konfigurationen können sich diese Aktionen das Nutzernetzwerk<br />

teilen<br />

Seite 4 von 9<br />

www.fujitsu.com/de/hpc