Statistik II SoSe 2013

Statistik II SoSe 2013

Statistik II SoSe 2013

Sie wollen auch ein ePaper? Erhöhen Sie die Reichweite Ihrer Titel.

YUMPU macht aus Druck-PDFs automatisch weboptimierte ePaper, die Google liebt.

<strong>Statistik</strong> <strong>II</strong> <strong>SoSe</strong> <strong>2013</strong><br />

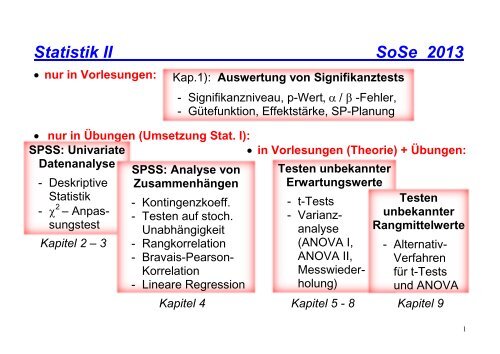

nur in Vorlesungen:<br />

nur in Übungen (Umsetzung Stat. I):<br />

SPSS: Univariate<br />

in Vorlesungen (Theorie) + Übungen:<br />

Datenanalyse<br />

- Deskriptive<br />

<strong>Statistik</strong><br />

- 2 – Anpassungstest<br />

Kapitel 2 – 3<br />

Kap.1): Auswertung von Signifikanztests<br />

- Signifikanzniveau, p-Wert/ -Fehler,<br />

- Gütefunktion, Effektstärke, SP-Planung<br />

SPSS: Analyse von<br />

Zusammenhängen<br />

- Kontingenzkoeff.<br />

- Testen auf stoch.<br />

Unabhängigkeit<br />

- Rangkorrelation<br />

- Bravais-Pearson-<br />

Korrelation<br />

- Lineare Regression<br />

Testen unbekannter<br />

Erwartungswerte<br />

- t-Tests<br />

- Varianzanalyse<br />

(ANOVA I,<br />

ANOVA <strong>II</strong>,<br />

Messwiederholung)<br />

Testen<br />

unbekannter<br />

Rangmittelwerte<br />

- Alternativ-<br />

Verfahren<br />

für t-Tests<br />

und ANOVA<br />

Kapitel 4 Kapitel 5 - 8 Kapitel 9<br />

1

VORLESUNGSSKRIPT STATISTIK <strong>II</strong> <strong>SoSe</strong> <strong>2013</strong><br />

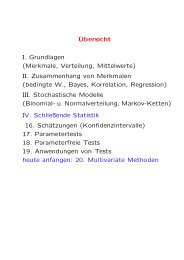

1. Grundlegendes zur Auswertung von Signifikanztests<br />

Sig.nivau , p-value, Fehler 1./2. Art, Gütefunktion, optimale SP-Umfänge<br />

2. Einführung in die <strong>Statistik</strong>-Software SPSS<br />

Erstellen und Bearbeiten von Datensätzen<br />

3. Univariate Datenanalyse mit SPSS (Theorie: <strong>Statistik</strong> I WiSe 2012/13)<br />

Darstellung von 1D-Verteilungen, Lage- und Streuparameter<br />

2 -Anpassungstest (Test eines diskreten Verteilungsmodells) für<br />

Rohdaten / Daten in Form einer Häufigkeitstabelle<br />

Gruppierte Datenanalyse: geeignete Grafiken, Lage/Streuparameter<br />

4. Zusammenhangsanalyse mit SPSS (Theorie: <strong>Statistik</strong> I WiSe 2012/13)<br />

Darstellung von 2D- Verteilungen: Keuztabellen, Diagramme<br />

Zusammenhangsmaße für nominal/ordinal erfasste Merkmale<br />

2 -Unabhängigkeitstest und Exakter Fisher-Test für Rohdaten /<br />

Daten in Form einer Kreuztabelle<br />

Zusammenhangsanalyse metrisch erfasster Merkmale<br />

2

(Scatterplot, Kovarianz, Bravais-Pearson-Korrelation r XY )<br />

Einfache Lineare Regression<br />

5. Durchführen von t-Tests mit SPSS (Theorie: <strong>Statistik</strong> I WiSe 2012/13)<br />

Test auf Normalverteilung im Vorfeld von t-Tests<br />

Testentscheidung: Bestimmen des p-value aus dem SPSS-Output<br />

1 Stichproben t-Test, gepaarter t-Test und 2 SP t-Test mit SPSS<br />

Konfidenzintervalle für das Populationsmittel <br />

-Fehler-Kumulierung bei multiplen t-Tests<br />

6. Einfaktorielle Varianzanalyse „ANOVA I“<br />

Ziel und Modell der einfaktoriellen Varianzanalyse<br />

Quadratsummenzerlegung und F-Test der ANOVA I<br />

ANOVA I mit SPSS; A-Priori-Verfahren und Post-Hoc-Tests<br />

ANOVA I und Lineare Regressionsanalyse<br />

7. Zweifaktorielle Varianzanalyse „ANOVA <strong>II</strong>“ (2 feste Faktoren)<br />

Ziel und Modell der zweifaktoriellen Varianzanalyse<br />

Quadratsummenzerlegung und F-Tests der ANOVA <strong>II</strong><br />

Haupteffekte und Interaktionseffekt, Interaktionsdiagramme<br />

Durchführen einer ANOVA <strong>II</strong> mit SPSS<br />

3

8. Weitere varianzanalytische Modelle<br />

Einfaktorielle Varianzanalyse mit Messwiederholung<br />

9. Nichtparametrische Alternativen für t-Tests und ANOVA<br />

Mann-Whitney U-Test (Rangvariante für 2 unabhängige SP)<br />

Kruskal-Wallis H-Test (Rangvariante für >2 unabhängige SP)<br />

Wilcoxon-Vorzeichen-Rangtest (Rangvariante für 2 gepaarte SP)<br />

Friedman-Test (Rangvariante für > 2 korrelierende SP)<br />

Literatur-Vorschläge (Theorie und/oder Anwendung mit SPSS / R):<br />

- J. Bortz, C. Schuster: <strong>Statistik</strong> für Human- und Sozialwissenschaftler, Springer, 2010.<br />

- D.C. Howell: Statistical Methods for Psychology, 8 th edition, Wadsworth, 2012.<br />

- C. Nachtigall, M.Wirtz: Statistische Methoden für Psychologen Teil 1+2, Juventa, 2012.<br />

- F. Brosius: SPSS 21, Mitp-Verlag, <strong>2013</strong>.<br />

- R. Hatzinger, H. Nagel: <strong>Statistik</strong> mit SPSS, Pearson, <strong>2013</strong>.<br />

- J. Janssen, W. Laatz: Statistische Datenanalyse mit SPSS, Springer, <strong>2013</strong>.<br />

- R. Leonhart: Datenanalyse mit SPSS, Hogrefe-Verlag, 2010.<br />

- M.J. Crawley: <strong>Statistik</strong> mit R, Wiley VCH Verlag GmbH, <strong>2013</strong>.<br />

- G. Faes: Einführung in R, Books on Demand, 2010.<br />

- M. Luhmann: R für Einsteiger, Verlagsgruppe Beltz, 2010.<br />

4

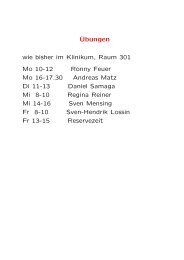

Vorlesung (2 SWS, Nr. 5501630): Montag 8:15 - 9:45 im HS1<br />

12 Termine (frei: Pfingstmontag, 20.Mai <strong>2013</strong>)<br />

08.04.<strong>2013</strong> | 15.04.<strong>2013</strong> | 22.04.<strong>2013</strong> | 29.04.<strong>2013</strong> | 06.05.<strong>2013</strong> | 13.05.<strong>2013</strong> |<br />

27.05.<strong>2013</strong> | 03.06.<strong>2013</strong> | 10.06.<strong>2013</strong> | 17.06.<strong>2013</strong> | 24.06.<strong>2013</strong> | 01.07.<strong>2013</strong> |<br />

Übung (2 SWS, Nr. 5501632): Die oder Fr im RTK, Felix-Hausdorff-Straße 16<br />

5

Gruppe 1 (ca. 30 Personen) Dienstag 8:15- 9:45 (13 Termine)<br />

09.04.<strong>2013</strong> | 16.04.<strong>2013</strong> | 23.04.<strong>2013</strong> | 30.04.<strong>2013</strong> | 07.05.<strong>2013</strong> | 14.05.<strong>2013</strong> | 21.05.<strong>2013</strong> |<br />

28.05.<strong>2013</strong> | 04.06.<strong>2013</strong> | 11.06.<strong>2013</strong> | 18.06.<strong>2013</strong> | 25.06.<strong>2013</strong> | 02.07.<strong>2013</strong> |<br />

Gruppe 2 (ca. 30 Personen) Freitag 12:00 (15?) - 13:30 (45?) (13 Termine)<br />

12.04.<strong>2013</strong> | 19.04.<strong>2013</strong> | 26.04.<strong>2013</strong> | 03.05.<strong>2013</strong> | 10.05.<strong>2013</strong> | 17.05.<strong>2013</strong> | 24.05.<strong>2013</strong> |<br />

31.05.<strong>2013</strong> | 07.06.<strong>2013</strong> | 14.06.<strong>2013</strong> | 21.06.<strong>2013</strong> | 28.06.<strong>2013</strong> | 05.07.<strong>2013</strong> |<br />

Ablauf der Übungen: - Theorie-Aufgaben des Übungsblattes zu Hause lösen<br />

- SPSS-Befehle, SPSS-Auswertung im RTK trainieren<br />

Wo gibt es Skript und Aufgabenzettel??? Homepage Petra Gummelt<br />

http://www.math-inf.uni-greifswald.de/mathe/index.php/mitarbeiter/130-dr-petragummelt<br />

→ „<strong>Statistik</strong> <strong>II</strong> <strong>SoSe</strong> <strong>2013</strong>“<br />

Klausur: (bei Diplom Psychologie ist der Schein <strong>Statistik</strong> I Voraussetzung)<br />

schriftlicher Teil (Theorie 60 Min.): Mo 01.07.<strong>2013</strong> im HS1 ab 8.15 ?<br />

PC-Teil (SPSS 30 Minuten): Die 02.07.<strong>2013</strong> / Fr 05.07.<strong>2013</strong> ?<br />

im RTK (in den Übungszeiten)<br />

6

(1) GRUNDLEGENDES ZUR AUSWERTUNG VON SIGNIFIKANZTESTS<br />

Grundlage jedes Signifikanztests: Hypothesenpaar aus H 0 und H 1<br />

- Nullhypothese H 0 (in Ω wird kein Effekt vermutet „Normalzustand“)<br />

- Alternativhypothese H 1 (in Ω wird ein Effekt vermutet „Alternativzustand“)<br />

Prinzip jedes Signifikanztests:<br />

- Datenerhebung Beobachtung vereinbar mit H 0 oder starke Indizien für H 1 ?<br />

Ergebnis jedes Signifikanztests: Testentscheidung für bzw. gegen H 0<br />

bisher (siehe <strong>Statistik</strong> I WiSe 2012/13): Testentscheidung “per Hand“:<br />

• Akzeptanzbereich von H 0 bestimmen: Ablesen von t crit aus Tafeln<br />

• t emp in H 0 -Akzeptanzbereich einordnen H 0 beibehalten /ablehnen<br />

Testentscheidung mit SPSS:<br />

• p-value aus SPSS-Output erschließen<br />

• p-value mit gewähltem Signifikanzniveau vergleichen (i.a. =5%)<br />

SPSS-Output enthält t emp und Prüfverteilung (Typ, df), aber nicht t crit !<br />

H 0 -Akzeptanzbereich nicht direkt aus SPSS-Output ablesbar<br />

7

SPSS führt viele Tests für eine feste Standardsituation (i.a. 2-seitig) aus<br />

Output enthält unter „Signifikanz“ einen Wert, der nicht immer dem p-value<br />

des Nutzers entspricht, sondern eventuell erst bearbeitet werden muss!<br />

Direkte Testentscheidung in SPSS: ²-Anpassungstest, ²-Unabhängigkeitstest/<br />

Fisher-Test, NV-Tests, Anova I+<strong>II</strong>, Kruskal-Wallis-H-Test, Friedman-Test<br />

Testentscheidung mit notwendiger SPSS-Output-Bearbeitung:<br />

t-Tests, Mann-Whitney-U-Test, Wilcoxon-Test, Binomial-Test<br />

R (Download unter http://www.r-project.org/) ermöglicht die direkte Umsetzung<br />

2-seitiger bzw. links / rechtsseitiger H 1 mit zugehörigem p-value als Output<br />

EXCEL bietet gute Möglichkeiten zur Dateneingabe sowie einige Tests als<br />

Standard (z.B. t-Tests, ANOVA I+<strong>II</strong>) und weitere Verfahren mit <strong>Statistik</strong>-Zusatz<br />

(1.1) BEGRIFFE, DIE AUF DER NULLHYPOTHESE H 0 AUFBAUEN<br />

Sei 0 der Parameter, auf den sich die H 0 des betrachteten Tests in Ω bezieht.<br />

Prüfverteilung (basiert auf SP-Kennwerteverteilung bei in Ω wahrer H 0 ):<br />

- beschreibt, welche t emp -Werte der Teststatistik T möglich sind und wie wahrscheinlich<br />

diese wären, wenn der Parameter 0 aus H 0 tatsächlich in Ω zutrifft.<br />

8

Problem: Wie sind in SP beobachtete starke Abweichungen von 0 zu bewerten?<br />

- können zufallsbedingt auftreten, obwohl H 0 in Ω tatsächlich gilt<br />

- können Indiz für systematische Abweichung (H 1 -Parameter 1 ≠ 0 ) in Ω sein<br />

Lösung: Ergebnis wird als statistisch signifikant (d.h. „überzufällig“) bewertet,<br />

wenn zugehöriger p-value unter vorher vorgegebener Schranke bleibt<br />

p-value („p-Wert“, „Signifikanz“):<br />

- beschreibt die Wahrscheinlichkeit, dass die Abweichungen zwischen SP-<br />

Befund und H 0 -Parameter 0 rein zufälliger (nicht systematischer) Natur sind<br />

- Wahrscheinlichkeit, mittels Zufallsversuch unter Annahme keines Effektes in<br />

Ω die vorliegenden (oder noch extremer abweichende) Daten zu realisieren<br />

ein großer p-value spricht FÜR die H 0 , ein kleiner p-value spricht GEGEN H 0<br />

Definition(p-value):<br />

Der p-value (bezogen auf H 0 /H 1 und vorliegende SP vom Umfang n des Nutzers)<br />

ist die Übertretenswahrscheinlichkeit, für SP vom Umfang n bei in Ω gültiger H 0<br />

unseren konkreten Wert t emp oder für H 0 noch schlechtere t emp -Werte der zum<br />

gewählten Verfahren gehörenden Teststatistik T zu erhalten.<br />

9

Bemerkungen:<br />

- jeder p-value ist eine Wahrscheinlichkeit, d.h. stets ein Wert zwischen 0 und 1<br />

- p-value verkörpert „Übersetzung“ des aus den Daten erhaltenen t emp -Wertes<br />

- 1- und 2-seitige Hypothesen definieren einen anderen p-value („extremere“<br />

Abweichungen im 2-seit. Fall sind positiv UND negativ, im 1-seit. Fall nicht!)<br />

- p-values werden völlig unabhängig vom Signifikanzniveau bestimmt !!!<br />

- p-values basieren auf exakten oder asymptotischen (Näherungs)-Verteilungen<br />

Mögliche Testentscheidungen:<br />

H 0 beibehalten<br />

- t emp liegt im H 0 -Akzeptanzbereich<br />

- wenn p-value ≥ gilt<br />

H 0 ablehnen = „signifikantes Ergebnis“<br />

- t emp liegt nicht im H 0 -Akzeptzanzbereich<br />

- wenn p-value < gilt<br />

Frage: Was genau wird durch das sogenannte Signifikanzniveau beschrieben?<br />

( verkörpert eine „Übersetzung“ von t crit - Werten)<br />

Fehler 1. Art (irrtümliches Verwerfen von H 0 ): falsch positives Ergebnis<br />

- Der in Ω vorliegende „Normalzustand“ 0 wird nicht als Wahrheit erkannt<br />

(Man lehnt H 0 anhand der SP ab, obwohl 0 der wahre Parameter in Ω ist.)<br />

- Man "findet" anhand der SP einen Effekt, der in Ω gar nicht existiert.<br />

10

Signifikanzniveau (= “Irrtumswahrscheinlichkeit“) :<br />

- Wahrscheinlichkeit, bei Testentscheidung einen Fehler 1. Art zu begehen<br />

(wird vor Durchführung jedes Signifikanztests vom Nutzer gewählt)<br />

P(Fehler 1. Art) = P(H 0 anhand einer SP ablehnen | H 0 ist in Ω richtig) = <br />

<br />

Bsp:=5% Gilt H 0 in Ω, wird in 5 von 100 Fällen durch eine Testentscheidung<br />

anhand von SP-Daten ein Effekt "aufgedeckt", der in Ωgarnicht vorliegt.<br />

Verhält sich Ω wirklich wie in der Nullhypothese H 0 beschrieben, so wird dies also<br />

bei einer Testentscheidung zum Signifikanzniveau <br />

- fälschlicherweise mit Wahrscheinlichkeit verneint<br />

- richtig mit Wahrscheinlichkeit (1-) „erkannt“<br />

P(H 0 anhand einer SP beibehalten | H 0 ist in Ω richtig) = 1-<br />

llustration für einen rechtsseitigen Test: (1- <br />

Verteilungen von T unter H 0 und H 1<br />

H 0 beibehalten<br />

H 0 ablehnen<br />

11

(1.2) BEGRIFFE, DIE ZUR ALTERNATIVHYPOTHESE H 1 GEHÖREN<br />

Sei 1 der Parameter, auf den sich die H 1 des betrachteten Tests in Ω bezieht<br />

(geht nur bei sogenannter spezifischer H 1 , bei unseren unspezifischen H 1 nicht).<br />

T-Verteilung unter H 1 (basiert auf SP-Kennwerteverteilung bei in Ω wahrer H 1 ):<br />

- beschreibt, welche t emp -Werte möglich sind und wie wahrscheinlich diese<br />

wären, wenn der in H 1 formulierter Parameter 1 tatsächlich in Ω zutrifft.<br />

Fehler 2. Art (irrtümliches Beibehalten von H 0 ): falsch negatives Ergebnis<br />

- Man behält H 0 aufgrund der SP bei (entscheidet also gegen H 1 ) obwohl<br />

nicht 0, sondern 1 der wahre Parameter in Ω ist.<br />

- Man sieht keinen Effekt, obwohl er in Ω da ist ("verpasste Chance").<br />

Wahrscheinlichkeit für Begehen eines Fehlers 2. Art:<br />

P(Fehler 2. Art) = P(H 0 anhand einer SP beibehalten | H 1 ist in Ω richtig) = <br />

Verhält sich Ω wirklich wie in H 1 postuliert, so wird dies bei Testentscheidungen<br />

- fälschlicherweise mit Wahrscheinlichkeit verneint<br />

- richtig mit Wahrscheinlichkeit (1-) „erkannt“<br />

P(H 0 anhand einer SP ablehnen | H 1 ist in Ω richtig) = 1-<br />

12

llustration für einen rechtsseitigen Test:<br />

<br />

<br />

H 0 beibehalten H 0 ablehnen H 0 beibehalten H 0 ablehnen<br />

Problem: - hängt vom wahren Parameter 1 der Alternativhypothese H 1 ab!<br />

- bei unspezifischer H 1 (z.B. ) ist 1 aber unbekannt !!!<br />

Bei unspezifischer H 1 kann der Nutzer nicht wie das Sig.niveau steuern!<br />

Kurs Satistik I / <strong>II</strong> behandelt nur unspezifische H 1 Einfluss auf , auf nicht<br />

Definition (-Fehler ( 1 ), Power g( 1 ))<br />

Sei 0 der Parameter, auf den die betrachtete H 0 in Ω Bezug nimmt. Dann definiert<br />

•( 1 ) = P(H 0 anhand SP beibehalten | 1 ist der wahre Parameter in Ω)<br />

den -Fehler (auch Operationscharakteristik OC, OC-Kurve, OC-Funktion)<br />

in Abhängigkeit verschiedener in Ω in Wahrheit gültiger Parameter 1<br />

• g( 1 ) = 1- ( 1 ) = P(H 0 anhand SP ablehnen | 1 gilt in Ω) die Güte (auch<br />

Power, Macht, Trennschärfe) des verwendeten Testverfahrens. <br />

13

Bem: Die Funktionen( 1 ) und g( 1 ) werden nicht nur von 0 , 1 und , sondern<br />

auch von den in die t emp -Formel eingehenden Größen (z.B. n) beeinflusst!<br />

Sind Testverfahren, H 0 , und SP gegeben, beschreibt die Güte (Trennschärfe)<br />

die Fähigkeit des Verfahrens, eine richtige H 1 -Hypothese als richtig zu erkennen.<br />

Illustration: Fehler in Abhängigkeit von 1 (rechtsseitiger Test)<br />

( 1a ) ( 1b ) , … , ( 1c )<br />

Bsp: Binomialtest 1: wahrer Anteil p in Ω (vermuteter Anteil unter H 0 : p 0 =0.15)<br />

• X: Altersdepression (Ja/Nein), =5%; SP: n=100 Personen > 60J.<br />

• rechtsseitige Fragestellung: H 0 : p = 0.15, H 1 : p > 0.15 0: : p 0 = 0.15<br />

Fehler:(p) = P(H 0 anhand SP beibehalten | p ist der wahre AD-Anteil in Ω)<br />

Power: g(p) = 1- ( p) = P(H 0 anhand SP ablehnen | p gilt in Ω)<br />

14

Bem: Ist der 0 der in Ω wahre Parameter, so ergibt sich ( 0 ) = 1-; g( 0 )=<br />

Bsp: wahrer Anteil p=0.2 40% Power ; wahrer Anteil p=0.3 98% Power<br />

- mgl. #AD in SP: binomialverteilte ZG mit n=100 und wahrer "Erfolgsw.keit" p in Ω<br />

- gilt H 0 : Näherung durch N n p , n<br />

p (1<br />

))<br />

, da n∙p 0 ∙(1-p 0 )= 12.575 > 9 erfüllt<br />

(<br />

0 0<br />

p0<br />

- gilt H 1 : Approximation durch N( n<br />

p,<br />

n p (1<br />

p)<br />

) für ein p>p 0<br />

15

- H 0 beibehalten, wenn t emp =<br />

Anzahl Erfolge in SP n p<br />

0<br />

n p<br />

(1<br />

p )<br />

0 0<br />

z.B: • (p=0.2) =<br />

20.8738 100<br />

0.2<br />

( ) (<br />

z 0.218) 0.5863<br />

100 0.2 0.8<br />

Gilt in Ω nicht der H 0 -Wert p=0.15, sondern der H 1 -Wert p=0.2, so haftet<br />

an der Testentscheidung „H 0 beibehalten“ ein Fehler von 58.63%!<br />

• zugehörige Power:<br />

g( 0.2) 1<br />

0.5863 0.4137<br />

Gilt in Ω nicht p=0.15, sondern p=0.2, so hat die Testentscheidung „H 0<br />

verwerfen“ zwar nur ein Fehlerrisiko 1. Art von 5%, aber auch nur eine<br />

Güte („Macht“, "Trennschärfe“) von 41.37%!<br />

Bem: Gilt p>0.15 in Ω, so kann ein 2-seitiger Test mit H 0 : p=0.15, H 1 :p ≠0.15<br />

dies nur mit geringerer Power aufdecken, als der passende 1-seitige Test!<br />

rechtsseitiger Test<br />

2-seitiger Test<br />

z.B: g 1-seitig (p=0.2) = 0.4137 > g 2-seitig (p=0.2) = 0.311<br />

17

Achtung! Die Wahrscheinlichkeit P(H 0 anhand SP beibehalten | H 0 ist in Ω falsch)<br />

ist nicht dasselbe wie P(H 0 anhand SP beibehalten | H 1 ist in Ω richtig), denn<br />

unterscheidet sich für verschiedene Parameter 1 der Alternativhypothese H 1 !!!<br />

-Fehler (Risiko einer Fehlentscheidung<br />

bei „H 0 beibehalten“) wächst:<br />

Power (Güte einer zu Recht gefällten<br />

Testentscheidung „H 0 ablehnen“) steigt:<br />

- mit fallendem Signifikanzniveau - mit steigendem Signifikanzniveau <br />

- mit stärkerer Überlappung der<br />

Prüfverteilungen unter H 0 und H 1<br />

- mit geringerer Überlappung der<br />

Prüfverteilungen unter H 0 und H 1<br />

je größer die Streuung<br />

je kleiner der SP-Umfang n<br />

je weniger 0 und 1 differieren<br />

je trennschwächer das Verfahren<br />

je geringer die Streuung d. Verteilungen<br />

je größer der SP-Umfang n<br />

je stärker 0 und 1 differieren<br />

je trennschärfer das Verfahren<br />

18

Als Distanzmaß von H 0 und H 1 dient die Effektgröße (Effektstärke, Effekt).<br />

Effekt(größe/stärke): "Abstand" zwischen H 0 und H 1 in Einheiten der Streuung<br />

Abhängig vom Testverfahren werden spezifische Effektstärke-Formeln verwendet<br />

und gewisse Zahlenwerte als schwacher, mittlerer bzw. starker Effekt eingestuft.<br />

(Details zu Effektmaßen: weiterführende VL / Seminare; kein Stoff <strong>Statistik</strong> I / <strong>II</strong>)<br />

Post-Hoc Analyse: Wird ein Testergebnis signifikant zum Signifikanzniveau ,<br />

kann nach bereits durchgeführter Studie („a posteriori“) bestimmt werden:<br />

• der empirische Effekt (d.h. der im Datensatz realisierte „Unterschied zur H 0 -<br />

Situation“), um einzuschätzen, ob dieser als relevant zu werten ist (oft wird<br />

bei sehr großen n schon die kleinste Abweichung formal „signifikant“)<br />

• die zum empirischen Effekt bei und n korrespondierende realisierte Power<br />

A-Priori Analyse: Wird ein konkreter Effekt in Ω vermutet (z.B. aufgrund älterer<br />

Studien), kann vor einem geplanten Signifikanztest („a priori“) bestimmt werden:<br />

• Fehler bzw. Power, die abhängig von und SP-Umfang n gelten würden<br />

• optimaler Stichprobenumfang n abhängig von und Power<br />

19

Software-Empfehlungen:<br />

G*Power (Download: http://www.psycho.uni-duesseldorf.de/aap/projects/gpower)<br />

SPSS: Zusatz-Programm “Sample Power”<br />

Zusammenfassung:<br />

Ist H 0 „Wunschhypothese“, so gilt für Testentscheidung „H 0 beibehalten“:<br />

- Ist der Wunsch H 0 die Wahrheit in Ω, erkennt der Test dies zu (1-)%.<br />

- Ist der Wunsch H 0 gar nicht die Wahrheit in Ω, , sondern H 1 mit 1 , so hängt<br />

an unserem „bestätigten Wunsch“ ein Fehlerrisiko von ( 1 ).<br />

Auf jede Testentscheidung „H 0 beibehalten“ müsste eigentlich folgen:<br />

• Kontrolle des -Fehlers ( 1 ), Kontrolle des SP-Umfangs n (klein?)<br />

Ist H 1 mit 1 „Wunschhypothese“, gilt für Testentscheidung „H 0 verwerfen“:<br />

- Ist der Wunsch H 1 die Wahrheit in Ω, erkennt der Test dies mit (1-)%.<br />

- Ist der Wunsch H 1 gar nicht die Wahrheit in Ω, , sondern H 0 , so hängt an<br />

dem „aufgedeckten Effekt“ ein Fehlerrisiko, das wir mit beschränken<br />

Auf jede Testentscheidung „H 0 ablehnen“ müsste eigentlich folgen:<br />

• Einschätzung der Power g( 1 ) = 1 - ( 1 ), Kontrolle der Effektstärke<br />

20

(1.3) SP - PLANUNG: DIE BEDEUTUNG OPTIMALER SP - UMFÄNGE<br />

Ziel: Ein in Ω vermuteter Effekt soll mit gewünschter Power aufdeckt werden<br />

Idee: SP-Umfang n opt so berechnen, dass bei gegebenem vermuteten Effekt<br />

sowie gegebenem und eine eindeutige Testentscheidung möglich ist<br />

Bei in Ω gültigem Effekt korrespondiert H 0 zu 0 und H 1 zu 1. Dann ergibt sich bei<br />

festem und für die zugehörigen Verteilungen der Teststatistik T:<br />

SP-Umfang < n opt. SP-Umfang = n opt. SP-Umfang > n opt.<br />

H 0 H 1<br />

H 0 H 1<br />

H 0 H 1<br />

FÜR H 0 und H 1<br />

GEGEN H 1 GEGEN H 0<br />

GEGEN H 0 und H 1<br />

Bsp: Berechnung von n opt beim rechtsseitigen t-Test mit bekannter Streuung :<br />

1 0<br />

Formel für Effektstärke beim rechtsseitigen t-Test: d <br />

<br />

<br />

H 0 : µ µ 0 , unspezifische H 1 : µ > µ 0 , spezifische H 1 : µ µ 1 = µ 0 + d•<br />

21

n<br />

~ z <br />

<br />

(1<br />

)<br />

0<br />

=<br />

<br />

n<br />

~ z <br />

1<br />

Abl.bereich H 0 :<br />

Abl.bereich H 1 :<br />

x <br />

<br />

~ <br />

0<br />

n<br />

0<br />

n z<br />

~<br />

(1<br />

)<br />

x z(1<br />

<br />

)<br />

x <br />

<br />

~ z ~<br />

<br />

z ) ( ) <br />

(<br />

( 1 ) 1<br />

0<br />

~ <br />

1<br />

n<br />

1<br />

n z<br />

~<br />

<br />

x z<br />

n<br />

²( ~ z ~<br />

(1<br />

)<br />

z<br />

n<br />

opt<br />

<br />

( )²<br />

1<br />

0<br />

<br />

)²<br />

~ z<br />

~<br />

z<br />

(1<br />

)<br />

; d=<br />

1<br />

0<br />

<br />

<br />

; µ 1 >µ 0<br />

z<br />

2<br />

<br />

(1 )<br />

z(1<br />

)<br />

2<br />

1 <br />

n <br />

~ ~<br />

opt<br />

d n opt aufrunden<br />

Bsp: Haben Studierende überdurchschnittlichen IQ? geg: =5%, =20%, d=0.25<br />

Effekt d ( 1 0)/<br />

0. 25 = 0.25∙15 =3.75 <br />

1<br />

100<br />

3.75 103.<br />

75<br />

H 0 : µ µ 0 = 100, unspezifische H 1 : µ > µ 0 =100, spezifische H 1 : µ µ 1 = 103.75<br />

= 5% ~ z ~ z<br />

(1 )<br />

<br />

0. 95 = 1.64, = 20% <br />

= 0.84<br />

n opt =<br />

15²<br />

3.75²<br />

<br />

(1.64 0.84)² <br />

<br />

1<br />

0.25<br />

<br />

<br />

<br />

<br />

1<br />

0<br />

2<br />

~ z ~ z ~ z<br />

<br />

(1<br />

)<br />

2.48²<br />

98.4<br />

Aufrunden gibt n opt = 99<br />

0.8<br />

22