FORMELSAMMLUNG STATISTIK B

FORMELSAMMLUNG STATISTIK B

FORMELSAMMLUNG STATISTIK B

Erfolgreiche ePaper selbst erstellen

Machen Sie aus Ihren PDF Publikationen ein blätterbares Flipbook mit unserer einzigartigen Google optimierten e-Paper Software.

Somersemester 2012<br />

<strong>FORMELSAMMLUNG</strong><br />

<strong>STATISTIK</strong> B<br />

Prof. Kneip / Dr. Scheer / Dr. Arns<br />

Version vom April 2012<br />

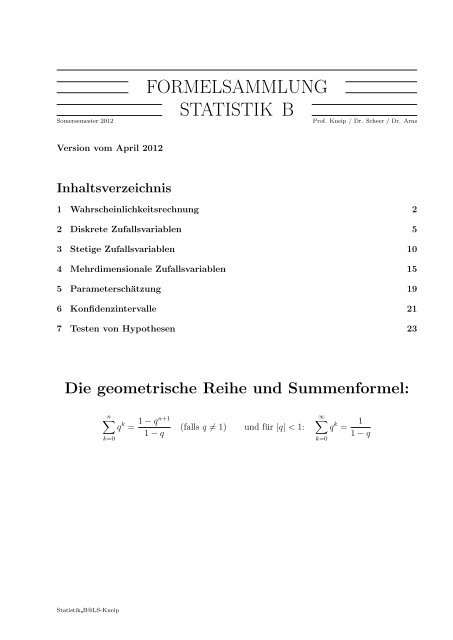

Inhaltsverzeichnis<br />

1 Wahrscheinlichkeitsrechnung 2<br />

2 Diskrete Zufallsvariablen 5<br />

3 Stetige Zufallsvariablen 10<br />

4 Mehrdimensionale Zufallsvariablen 15<br />

5 Parameterschätzung 19<br />

6 Konfidenzintervalle 21<br />

7 Testen von Hypothesen 23<br />

Die geometrische Reihe und Summenformel:<br />

n∑<br />

k=0<br />

q k = 1 − qn+1<br />

1 − q<br />

(falls q ≠ 1) und für |q| < 1:<br />

∞∑<br />

k=0<br />

q k = 1<br />

1 − q<br />

Statistik B@LS-Kneip

Formelsammlung zur Statistik B Seite 2<br />

1 Wahrscheinlichkeitsrechnung<br />

Kombinatorik<br />

✎<br />

Anzahl der möglichen Ziehungen von n Kugeln aus einer Urne mit N Kugeln:<br />

☞<br />

✍<br />

Reihenfolge wichtig<br />

Reihenfolge nicht wichtig<br />

” Sortieren nicht erlaubt“ Sortieren erlaubt“<br />

”<br />

( ) N<br />

ohne Zurücklegen N · (N − 1) · · · (N − (n − 1))<br />

n<br />

( )<br />

n + N − 1<br />

mit Zurücklegen N n =<br />

n<br />

( )<br />

n + N − 1<br />

N − 1<br />

✌<br />

Binomialkoeffizienten<br />

✎<br />

• Definition: ( n<br />

=<br />

k)<br />

n · (n − 1) · · · (n − (k − 1))<br />

k · (k − 1) · · · 1<br />

=<br />

n!<br />

k!(n − k)!<br />

☞<br />

• Rechenregeln:<br />

( ( n n<br />

= = 1<br />

0)<br />

n)<br />

( n<br />

=<br />

k)<br />

( ( )<br />

n<br />

n<br />

=<br />

n − k)<br />

k<br />

( ( )<br />

n n<br />

= = n<br />

1)<br />

n − 1<br />

( ) n − 1<br />

+<br />

k<br />

( ) n − 1<br />

k − 1<br />

✍<br />

Rechenregeln für Mengen<br />

☛<br />

• Kommutativgesetz:<br />

A ∩ B = B ∩ A<br />

A ∪ B = B ∪ A<br />

• Distributivgesetz:<br />

(A ∪ B) ∩ C = (A ∩ C) ∪ (B ∩ C)<br />

(A ∩ B) ∪ C = (A ∪ C) ∩ (B ∪ C)<br />

• Assoziativgesetz:<br />

(A ∩ B) ∩ C = A ∩ (B ∩ C)<br />

(A ∪ B) ∪ C = A ∪ (B ∪ C)<br />

• De Morgansche Regeln:<br />

(A ∪ B) = Ā ∩ ¯B<br />

(A ∩ B) = Ā ∪ ¯B<br />

✌<br />

✟<br />

✡<br />

• Aus A ⊂ B folgt ¯B ⊂ Ā<br />

• Für die Differenzmenge A\B gilt:<br />

A\B = A ∩ ¯B<br />

✠<br />

Statistik B@LS-Kneip

Formelsammlung zur Statistik B Seite 3<br />

Wahrscheinlichkeiten und Axiome von Kolmogoroff<br />

✛<br />

✘<br />

• Endlicher Wahrscheinlichkeitsraum (S, P(S), P )<br />

– Grundraum S = {ω 1 , ω 2 , . . . ω N }.<br />

– Ereignisse P(S) = Menge aller Teilmengen A ⊂ S<br />

– Wahrscheinlichkeit P P (A) = Wahrscheinlichkeit für das Eintreten von A<br />

Die Wahrscheinlichkeitsverteilung P erfüllt die Axiome von Kolmogoroff:<br />

(A1) (Nichtnegativität) P (A) ≥ 0<br />

(A2) (Normiertheit) P (S) = 1<br />

(A3) (Additivität) P (A ∪ B) = P (A) + P (B) für A ∩ B = ∅<br />

• Für nicht endliche Wahrscheinlichkeitsräume wird das Axiom (A3) ersetzt<br />

durch das Axiom<br />

(A3’) (σ−Additivität)<br />

∞∪<br />

∞∑<br />

P ( A k ) = P (A k ) für A i ∩ A j = ∅, i ≠ j<br />

✚<br />

k=1 k=1<br />

✙<br />

Rechenregeln für Wahrscheinlichkeiten<br />

✗<br />

✔<br />

1. P (∅) = 0, P (S) = 1, 0 ≤ P (A) ≤ 1<br />

2. A ⊆ B ⇒ P (A) ≤ P (B)<br />

3. P (Ā) = 1 − P (A) mit Ā = S\A<br />

4. Additionssatz: P (A ∪ B) = P (A) + P (B) − P (A ∩ B)<br />

5. P (A 1 ∪ A 2 ∪ · · · ∪ A n ) = P (A 1 ) + P (A 2 ) + · · · + P (A n ),<br />

falls A 1 , A 2 , . . . , A n paarweise disjunkt, d.h. A i ∩ A j = ∅<br />

6. P (A 1 ∪ A 2 ∪ · · · A n ) ≤ P (A 1 ) + P (A 2 ) + · · · + P (A n )<br />

✖<br />

7. Wenn die Elementarwahrscheinlichkeiten p i = P ({ω i }), i = 1, 2, . . . bekannt sind,<br />

dann gilt für die Wahrscheinlichkeit eines Ereignisses A:<br />

P (A) = ∑<br />

P ({ω i }) = ∑<br />

i:ω i ∈A<br />

i:ω i ∈A<br />

p i<br />

✕<br />

Statistik B@LS-Kneip

Formelsammlung zur Statistik B Seite 4<br />

Laplace-Modell<br />

✞<br />

1. Annahme: Endlicher Grundraum S = {ω 1 , . . . , ω N }<br />

☎<br />

2. Annahme: P ({ω 1 }) = P ({ω 2 }) = · · · = P ({ω N })<br />

Wahrscheinlichkeiten: P (A) = Anzahl ω i in A<br />

Anzahl ω<br />

✝<br />

i in S = #A<br />

#S = #A<br />

N<br />

Bedingte Wahrscheinlichkeit<br />

✄<br />

Bedingte Wahrscheinlichkeit von A gegeben B<br />

✆<br />

<br />

✂<br />

P (A|B) =<br />

P (A ∩ B)<br />

P (B)<br />

für A, B ⊂ S mit P (B) > 0<br />

✁<br />

Unabhängigkeit von Ereignissen<br />

✞<br />

• Zwei Ereignisse A und B heißen stochastisch unabhängig, wenn<br />

P (A ∩ B) = P (A) · P (B)<br />

☎<br />

✝<br />

• Ereignisse A 1 , . . . , A n heißen stochastisch unabhängig, wenn für jede Auswahl<br />

A i1 , . . . , A ik mit k ≤ n gilt: P (A i1 ∩ . . . ∩ A ik ) = P (A i1 ) · P (A i2 ) · · · P (A ik )<br />

✆<br />

Multiplikationssatz<br />

✞<br />

• Für Ereignisse A 1 , . . . , A n gilt:<br />

P (A 1 ∩ . . . ∩ A n ) = P (A 1 ) · P (A 2 |A 1 ) · P (A 3 |A 1 ∩ A 2 ) · · · P (A n |A 1 ∩ . . . ∩ A n−1 )<br />

☎<br />

✝<br />

• Falls die Ereignisse A 1 , . . . , A n unabhängig sind, gilt:<br />

P (A 1 ∩ A 2 ∩ . . . ∩ A n ) = P (A 1 ) · P (A 2 ) · · · P (A n )<br />

✆<br />

Totale Wahrscheinlichkeit und Satz von Bayes<br />

✓<br />

✏<br />

Seien A 1 , . . . , A k Ereignisse, die eine Zerlegung von S bilden (d.h. S ist disjunkte Vereinigung<br />

der A i ; es gilt: A i ≠ ∅, A i ∩ A j = ∅, i ≠ j, und A 1 ∪ A 2 ∪ . . . ∪ A k = S).<br />

B sei ein Ereignis mit P (B) > 0.<br />

P (B|A j ) · P (A j ) = P (B ∩ A j ) = P (A j |B) · P (B)<br />

k∑<br />

k∑<br />

P (B) = P (B|A i ) · P (A i ) = P (B ∩ A i )<br />

i=1<br />

i=1<br />

(totale Wahrscheinlichkeit)<br />

✒<br />

P (A j |B) = P (B|A j) · P (A j )<br />

P (B)<br />

= P (B|A j) · P (A j )<br />

k∑<br />

P (B|A i ) · P (A i )<br />

i=1<br />

(Satz von Bayes)<br />

✑<br />

Statistik B@LS-Kneip

Formelsammlung zur Statistik B Seite 5<br />

2 Diskrete Zufallsvariablen<br />

✬<br />

✩<br />

Es sei X eine diskrete Zufallsvariable mit Werten x 1 , x 2 , . . . , x k , . . .<br />

• Wahrscheinlichkeitsverteilung von X:<br />

P [X = x i ] = p i , i = 1, 2, . . . , k, . . .<br />

• Wahrscheinlichkeitsfunktion von X:<br />

⎧<br />

⎪⎨ P [X = x] für x ∈ {x 1 , x 2 , . . . , x k , . . .}<br />

f(x) =<br />

⎪⎩<br />

0 sonst<br />

• Verteilungsfunktion von X:<br />

F (x) = P [X ≤ x] = ∑ x i ≤x<br />

f(x i )<br />

• Erwartungswert von X:<br />

E(X) = µ X = ∑ x i p i = ∑ x i f(x i )<br />

i≥1<br />

i≥1<br />

• Varianz von X:<br />

Var(X) = σ 2 X = E(X − µ X ) 2 = E(X 2 ) − µ 2 X = ∑ i≥1<br />

(x i − µ X ) 2 p i = ∑ i≥1<br />

x 2 i p i − µ 2 X<br />

• Standardabweichung: σ X = √ Var(X)<br />

• Transformationsregel für Erwartungswerte:<br />

Sei g(x) eine reelle Funktion. Dann gilt für Y = g(X)<br />

✫<br />

E(Y ) = E(g(X)) = ∑ i≥1<br />

g(x i )p i = ∑ i≥1<br />

g(x i )f(x i )<br />

✪<br />

Statistik B@LS-Kneip

Formelsammlung zur Statistik B Seite 6<br />

Diskrete Gleichverteilung<br />

✗<br />

✔<br />

• X diskret gleichverteilt (auf a 1 < . . . < a k )<br />

• Verteilung von X<br />

X = a 1 , a 2 , . . . , a k<br />

mit P ({X = a i }) = 1 k<br />

• Werte der Verteilungsfunktion<br />

• Erwartungswert und Varianz<br />

P ({X ≤ a i }) = i k<br />

E(X) = 1 k<br />

k∑<br />

a i<br />

Var(X) = 1 k<br />

k∑<br />

(a i − E(X)) 2<br />

✖<br />

i=1<br />

i=1<br />

✕<br />

Bernoulli-Verteilung<br />

✓<br />

✏<br />

• Notation: X ∼ B(1, p) mit 0 ≤ p ≤ 1<br />

• Verteilung von X<br />

X =<br />

{<br />

1 mit P ({X = 1}) = p<br />

0 mit P ({X = 0}) = 1 − p<br />

• Erwartungswert und Varianz<br />

✒<br />

E(X) = p Var(X) = p · (1 − p)<br />

✑<br />

Statistik B@LS-Kneip

Formelsammlung zur Statistik B Seite 7<br />

Geometrische Verteilung<br />

✤<br />

✜<br />

• Notation: X ∼ Geo(p) mit 0 < p ≤ 1<br />

• Verteilung von X<br />

X = 1, 2, 3 . . . mit P ({X = k}) = (1 − p) k−1 p<br />

• Werte der Verteilungsfunktion<br />

P ({X ≤ i}) =<br />

i∑<br />

P ({X = k})<br />

k=0<br />

• Erwartungswert und Varianz<br />

E(X) = 1 p<br />

Var(X) = 1 − p<br />

p 2<br />

• Rekursionsformel<br />

✣<br />

P ({X = k + 1})<br />

P ({X = k})<br />

= (1 − p)<br />

✢<br />

Binomialverteilung<br />

✛<br />

• Notation: X ∼ B(n, p) mit 0 ≤ p ≤ 1<br />

✘<br />

• Verteilung von X<br />

X = 0, 1, . . . , n mit P ({X = k}) =<br />

• Werte der Verteilungsfunktion<br />

( n<br />

k)<br />

p k (1 − p) n−k<br />

P ({X ≤ i}) =<br />

i∑<br />

P ({X = k})<br />

k=0<br />

• Erwartungswert und Varianz<br />

• Rekursionsformel<br />

E(X) = np Var(X) = np(1 − p)<br />

✚<br />

P ({X = k + 1})<br />

P ({X = k})<br />

= n − k<br />

k + 1 · p<br />

1 − p<br />

✙<br />

Statistik B@LS-Kneip

Formelsammlung zur Statistik B Seite 8<br />

Hypergeometrische Verteilung<br />

★<br />

• Notation: X ∼ H(n, M, N) mit M ≤ N, n ≤ N<br />

✥<br />

• Verteilung von X<br />

P ({X = k}) =<br />

( M<br />

)( N−M<br />

)<br />

k n−k<br />

( N<br />

n)<br />

wobei<br />

X =<br />

{<br />

0, 1, . . . , n falls n ≤ min(M, N − M)<br />

max(0, n + M − N), . . . , min(n, M)<br />

sonst<br />

• Werte der Verteilungsfunktion<br />

P ({X ≤ i}) =<br />

i∑<br />

P ({X = k})<br />

k=0<br />

• Erwartungswert und Varianz<br />

• Rekursionsformel<br />

E(X) = n M N<br />

Var(X) = n M N<br />

(<br />

1 − M ) N − n<br />

N N − 1<br />

✧<br />

P ({X = k + 1})<br />

P ({X = k})<br />

= n − k<br />

k + 1 · M − k<br />

N − M − (n − k − 1)<br />

✦<br />

Approximation der Hypergeometrischen Verteilung<br />

durch eine Binomialverteilung<br />

✞<br />

Für X ∼ H(n, M, N) und n klein gegenüber N, M und N − M gilt approximativ:<br />

☎<br />

X ∼ B (n, p) ,<br />

p = M N<br />

d.h. P ({X = k}) =<br />

( M<br />

)( N−M<br />

)<br />

k n−k<br />

( N<br />

≈<br />

n)<br />

( n<br />

k)<br />

p k (1 − p) n−k<br />

✝<br />

✆<br />

Statistik B@LS-Kneip

Formelsammlung zur Statistik B Seite 9<br />

Poisson-Verteilung<br />

✛<br />

✘<br />

• Notation: X ∼ Po(λ) mit λ > 0<br />

• Verteilung von X<br />

X = 0, 1, 2, 3 . . . mit P ({X = k}) = λk<br />

k! e−λ<br />

• Werte der Verteilungsfunktion<br />

P ({X ≤ i}) =<br />

i∑<br />

P ({X = k})<br />

k=0<br />

• Erwartungswert und Varianz<br />

E(X) = λ<br />

Var(X) = λ<br />

• Rekursionsformel<br />

✚<br />

P ({X = k + 1})<br />

P ({X = k})<br />

= λ<br />

k + 1<br />

✙<br />

Approximation der Binomialverteilung durch eine Poisson-Verteilung<br />

✞<br />

Für X ∼ B(n, p) und großes n bei gleichzeitig kleiner ”<br />

Erfolgswahrscheinlichkeit“ p<br />

(Faustregel: np < 5 oder n(1 − p) < 5) gilt approximativ:<br />

☎<br />

✝<br />

X ∼ P o(λ), λ = n · p d.h. P ({X = k}) =<br />

( n<br />

k)p k (1 − p) n−k ≈ (np)k e −np<br />

k!<br />

✆<br />

Statistik B@LS-Kneip

Formelsammlung zur Statistik B Seite 10<br />

3 Stetige Zufallsvariablen<br />

✬<br />

Es sei X stetige Zufallsvariable (mit Werten x ∈ R)<br />

• (Wahrscheinlichkeits-) Dichte von X<br />

Funktion f(x) ≥ 0, so dass für jedes Intervall [a, b]:<br />

✩<br />

∫ b<br />

P [a ≤ X ≤ b] = f(x)dx;<br />

a<br />

es gilt:<br />

∫ ∞<br />

−∞<br />

f(x)dx = 1<br />

• Verteilungsfunktion von X<br />

F (x) = P [X ≤ x] =<br />

∫ x<br />

−∞<br />

f(x)dx<br />

• Erwartungswert von X<br />

E(X) = µ X =<br />

∫ ∞<br />

x · f(x)dx<br />

−∞<br />

• Varianz von X<br />

Var(X) = σ 2 X = E(X − µ X ) 2 = E(X 2 ) − µ 2 X =<br />

∫ ∞<br />

(x − µ X ) 2 f(x)dx<br />

−∞<br />

• Standardabweichung von X<br />

σ X = √ Var(X)<br />

• Quantile Für 0 < p < 1 ist das p-Quantil x p der Wert, für den gilt:<br />

✫<br />

F (x p ) = P [X ≤ x p ] = p und 1 − F (x p ) = P [X ≥ x p ] = 1 − p<br />

✪<br />

Statistik B@LS-Kneip

Formelsammlung zur Statistik B Seite 11<br />

Exponentialverteilung, X ∼ Ex(λ), mit λ > 0<br />

☛<br />

• Dichte- und Verteilungsfunktion<br />

{<br />

λe −λx für x ≥ 0<br />

f Ex (x) =<br />

0 sonst<br />

• Erwartungswert und Varianz<br />

F Ex (x) =<br />

{<br />

0 für x < 0<br />

1 − e −λx für x ≥ 0<br />

✟<br />

✡<br />

E(X) = 1 λ<br />

Var(X) = 1 λ 2<br />

✠<br />

Stetige Gleichverteilung, X ∼ U(a, b), mit a < b<br />

✎<br />

• Dichte- und Verteilungsfunktion<br />

f U (x) =<br />

{<br />

1<br />

b−a<br />

0 sonst<br />

für a ≤ x ≤ b<br />

⎧<br />

⎪⎨ 0 für x < a<br />

x−a<br />

F U (x) = für a ≤ x ≤ b<br />

b−a ⎪⎩<br />

1 für x > b<br />

☞<br />

• Erwartungswert und Varianz<br />

✍<br />

E(X) = a + b<br />

2<br />

Var(X) =<br />

(b − a)2<br />

12<br />

✌<br />

Standardnormalverteilung, X ∼ N(0, 1)<br />

☛<br />

• Dichte- und Verteilungsfunktion<br />

φ(x) = √ 1<br />

)<br />

exp<br />

(− x2<br />

2π 2<br />

für x ∈ R Φ(x) = 1 √<br />

2π<br />

∫x<br />

−∞<br />

( )<br />

exp − t2 dt<br />

2<br />

✟<br />

✡<br />

• Erwartungswert und Varianz<br />

E(X) = 0 Var(X) = 1<br />

✠<br />

Statistik B@LS-Kneip

Formelsammlung zur Statistik B Seite 12<br />

Normalverteilung (Gauß-Verteilung), X ∼ N(µ, σ 2 )<br />

✬<br />

• Dichte- und Verteilungsfunktion (für x ∈ R)<br />

f N (x) = √ 1<br />

)<br />

(x − µ)2<br />

exp<br />

(− 2πσ 2σ 2<br />

F N (x) = 1 √<br />

2πσ<br />

∫x<br />

−∞<br />

)<br />

(t − µ)2<br />

exp<br />

(− dt<br />

2σ 2<br />

✩<br />

• Erwartungswert und Varianz<br />

E(X) = µ Var(X) = σ 2<br />

• Lineare Transformation: (a, b beliebige Zahlen)<br />

X ∼ N(µ, σ 2 ) und Y = a · X + b ⇒ Y ∼ N(a · µ + b, a 2 · σ 2 )<br />

• Linearkombination: X i ∼ N(µ i , σi 2 ) und unabhängig, a 1 , . . . , a n beliebige Zahlen<br />

⇒ Y = a 1 · X 1 + · · · + a n · X n ∼ N(a 1 · µ 1 + · · · + a n · µ n , a 2 1 · σ1 2 + · · · + a 2 n · σn)<br />

2<br />

• Rückführung auf die Standardnormalverteilung<br />

– Standardisierung<br />

X ∼ N(µ, σ 2 ) ⇒ Z = X − µ<br />

σ<br />

∼ N(0, 1)<br />

✫<br />

– Verteilungsfunktion<br />

X ∼ N(µ, σ 2 ) ⇒<br />

( ) x − µ<br />

P [X ≤ x] = F N (x) = Φ<br />

σ<br />

– Quantile (Für 0 < p < 1)<br />

x p p-Quantil von N(µ, σ 2 ) ⇒ x p = µ + σz p wobei z p p-Quantil von N(0, 1)<br />

✪<br />

Statistik B@LS-Kneip

Formelsammlung zur Statistik B Seite 13<br />

χ 2 -Verteilung<br />

✎<br />

☞<br />

• Definition und Bezeichnung<br />

X 1 , . . . , X n unabhängige und N(0, 1)-verteilte Zufallsvariablen. Die Verteilung von<br />

χ 2 = X1 2 + · · · + Xn 2 heißt Chi-Quadrat-Verteilung“ mit n Freiheitsgraden, kurz<br />

”<br />

χ 2 ∼ χ 2 (n).<br />

• Erwartungswert und Varianz<br />

E(χ 2 ) = n<br />

Var(χ 2 ) = 2n<br />

• Approximation durch die Normalverteilung<br />

✍<br />

für n > 30: χ 2 (n) ≈ N(n, 2n) für Quantile χ 2 p;n ≈ 1 2 (z p + √ 2n − 1) 2<br />

✌<br />

t-Verteilung, Student-Verteilung<br />

✎<br />

• Definition und Bezeichnung<br />

X ∼ N(0, 1) und Y ∼ χ 2 (n) unabhängig. Die Verteilung von T =<br />

Verteilung“ mit n Freiheitsgraden, kurz T ∼ t(n).<br />

√ X heißt t-<br />

Y/n ”<br />

☞<br />

• Erwartungswert und Varianz<br />

E(T ) = 0 Var(T ) = n<br />

n − 2<br />

(n > 2)<br />

• Approximation durch die Normalverteilung<br />

✍<br />

für n > 100: t(n) ≈ N(0, 1) für Quantile t p;n ≈ z p<br />

✌<br />

Fisher-Verteilung, F -Verteilung<br />

✎<br />

• Definition und Bezeichnung<br />

Seien X ∼ χ 2 (m) und Y ∼ χ 2 (n) unabhängig. Dann heißt die Verteilung von<br />

☞<br />

F = X/m<br />

Y/n<br />

Fisher- oder F -Verteilung mit den Freiheitsgraden m und n, kurz F ∼ F (m, n).<br />

✍<br />

• Erwartungswert<br />

E(F ) =<br />

n<br />

n − 2<br />

(n > 2)<br />

✌<br />

Statistik B@LS-Kneip

Formelsammlung zur Statistik B Seite 14<br />

Ungleichung von Tschebyscheff<br />

✓<br />

• Zufallsvariable X mit E(X) = µ und Var(X) = σ(X) 2 .<br />

✏<br />

• Ungleichung von Tschebyscheff<br />

Für c > 0 gilt: P [{|X − µ| ≥ c}] ≤ Var(X)<br />

c 2<br />

• Ungleichung von Tschebyscheff als untere Schranke<br />

• Zentrale Schwankungsintervalle<br />

Für c > 0 gilt: P [{|X − µ| < c}] ≥ 1 − Var(X)<br />

c 2<br />

✒<br />

Für κ = 2, 3, 4, ...<br />

]E[X] − κσ(X), E[X] + κσ(X)[<br />

✑<br />

Zentraler Grenzwertsatz<br />

✞<br />

☎<br />

Seien X 1 , . . . , X n unabhängig und identisch verteilte Zufallsvariablen mit Mittelwert µ und<br />

Varianz σ 2 . Dann gilt für großes n approximativ:<br />

✝<br />

P<br />

[ ]<br />

( )<br />

¯X − µ<br />

σ/ √ n ≤ z ≈ Φ(z) d.h. ¯X ∼ N µ, σ2<br />

n<br />

bzw.<br />

n∑<br />

X i ∼ N(nµ, nσ 2 )<br />

Approximation der Binomialverteilung durch eine Normalverteilung<br />

☛<br />

Sei X ∼ B(n, p). Für großes n gilt approximativ<br />

X − np<br />

√<br />

np(1 − p)<br />

∼ N(0, 1)<br />

i=1<br />

✆<br />

✟<br />

Anwendung mit Stetigkeitskorrektur:<br />

(<br />

) (<br />

)<br />

x 2 + 0, 5 − np x<br />

P [x 1 ≤ X ≤ x 2 ] ≈ Φ √ 1 − 0, 5 − np<br />

− Φ √<br />

np(1 − p) np(1 − p)<br />

✡<br />

✠<br />

Statistik B@LS-Kneip

Formelsammlung zur Statistik B Seite 15<br />

4 Mehrdimensionale Zufallsvariablen<br />

Zweidimensionale diskrete Zufallsvariablen<br />

✬<br />

(X, Y ) sei eine bivariate diskrete Zufallsvariable mit k bzw. m Ausprägungen<br />

• Gemeinsame Wahrscheinlichkeitsfunktion (gemeinsame Verteilung)<br />

✩<br />

{ P [X = x, Y = y] für (x, y) = (x1 , y<br />

f(x, y) =<br />

1 ), . . .<br />

0 sonst<br />

• Gemeinsame Verteilungsfunktion<br />

F (x, y) = P [X ≤ x, Y ≤ y] = ∑ ∑<br />

f(x i , y j )<br />

x i ≤x y j ≤y<br />

• Randverteilung von X<br />

f X (x) = P [X = x] =<br />

m∑<br />

f(x, y j )<br />

j=1<br />

• Randverteilung von Y<br />

f Y (y) = P [Y = y] =<br />

k∑<br />

f(x i , y)<br />

i=1<br />

• Bedingte Wahrscheinlichkeitsfunktion (bedingte Verteilung)<br />

– Bedingte Wahrscheinlichkeitsfunktion von X gegeben Y = y<br />

f X (x|y) = P [X = x|Y = y] =<br />

f(x, y)<br />

f Y (y)<br />

(f X (x|y) = 0, falls f Y (y) = 0.)<br />

– Bedingte Wahrscheinlichkeitsfunktion von Y gegeben X = x<br />

f Y (y|x) = P [Y = y|X = x] =<br />

f(x, y)<br />

f X (x)<br />

(f Y (y|x) = 0, falls f X (x) = 0.)<br />

• Bedingter Erwartungswert von Y gegeben X = x<br />

µ Y |X=x = E(Y |X = x) =<br />

m∑<br />

y j f Y (y j |x)<br />

j=1<br />

• Bedingter Erwartungswert von X gegeben Y = y<br />

✫<br />

Statistik B@LS-Kneip<br />

µ X|Y =y = E(X|Y = y) =<br />

k∑<br />

x i f X (x i |y)<br />

i=1<br />

✪

Formelsammlung zur Statistik B Seite 16<br />

Zweidimensionale stetige Zufallsvariablen<br />

✬<br />

(X, Y ) sei eine bivariate stetige Zufallsvariable (mit Werten (x, y) ∈ R 2 )<br />

• (Wahrscheinlichkeits-) Dichte von (X, Y )<br />

2-dimensionale Funktion f(x, y) ≥ 0, so dass für jedes Rechteck [a, b] × [c, d]:<br />

✩<br />

∫ b ∫ d<br />

P [a ≤ X ≤ b, c ≤ Y ≤ d] = f(x, y) dx dy;<br />

es gilt:<br />

∫ ∞<br />

∫ ∞<br />

f(x, y) dx dy = 1<br />

a<br />

c<br />

−∞ −∞<br />

Das Doppelintegral entspricht dem von der Funktion f(x, y) eingeschlossenen Volumen<br />

über der Grundfläche [a, b] × [c, d].<br />

• Gemeinsame Verteilungsfunktion<br />

F (x, y) = P [X ≤ x, Y ≤ y] =<br />

∫ x<br />

∫ y<br />

f(s, t) ds dt<br />

−∞ −∞<br />

• Randdichten von X bzw. Y<br />

f X (x) =<br />

∫ ∞<br />

−∞<br />

f(x, y) dy bzw. f Y (y) =<br />

∫ ∞<br />

−∞<br />

f(x, y) dx<br />

• Bedingte Dichte von X gegeben Y = y bzw. von Y gegeben X = x<br />

f X (x|y) =<br />

f(x, y)<br />

f Y (y)<br />

bzw. f Y (y|x) =<br />

f(x, y)<br />

f X (x)<br />

• Bedingter Erwartungswert von Y gegeben X = x<br />

µ Y |X=x = E(Y |X = x) =<br />

∫ ∞<br />

yf Y (y|x) dy<br />

−∞<br />

• Bedingter Erwartungswert von X gegeben Y = y<br />

µ X|Y =y = E(X|Y = y) =<br />

∫ ∞<br />

xf X (x|y) dx<br />

✫<br />

−∞<br />

✪<br />

Statistik B@LS-Kneip

Formelsammlung zur Statistik B Seite 17<br />

Kovarianz und Korrelation<br />

✬<br />

Zufallsvariablen X und Y , mit µ X = E(X), µ Y = E(Y ), Var(X) = σX 2 , Var(Y ) = σ2 Y<br />

• Kovarianz von X und Y<br />

✩<br />

σ XY = Cov(X, Y ) = E ((X − µ X )(Y − µ Y )) = E(X · Y ) − E(X) · E(Y )<br />

• Erwartungswert E(X · Y )<br />

⎧∑<br />

∑<br />

x i y j f(x i , y j )<br />

⎪⎨ i j<br />

E(X · Y ) = ∫ ∞ ∫ ∞<br />

xy f(x, y)dx dy<br />

⎪⎩<br />

−∞ −∞<br />

X, Y diskret<br />

X, Y stetig<br />

• Symmetrie<br />

Cov(X, Y ) = Cov(Y, X)<br />

• Lineare Transformationen<br />

Für X ∗ = aX + b und Y ∗ = cY + d gilt Cov(X ∗ , Y ∗ ) = a · c · Cov(X, Y )<br />

• Korrelation zwischen X und Y<br />

ρ XY =<br />

Cov(X, Y )<br />

√<br />

Var(X)<br />

√<br />

Var(Y )<br />

=<br />

• Varianz der Summe zweier Zufallsvariablen<br />

σ XY<br />

σ X · σ Y<br />

Var(X + Y ) = Var(X) + Var(Y ) + 2 · Cov(X, Y )<br />

Falls X, Y unkorreliert ⇒ Var(X + Y ) = Var(X) + Var(Y )<br />

• Gewichtete Summe von Zufallsvariablen<br />

Zufallsvariablen X 1 , . . . , X k , Zahlen a 1 , . . . , a k ; für X = a 1 · X 1 + · · · + a k · X k gilt:<br />

✫<br />

E(X) = a 1 · E(X 1 ) + · · · + a k · E(X k )<br />

k∑<br />

Var(X) = a 2 i · X i + 2 ∑ a i · a j · Cov(X i , X j )<br />

i

Formelsammlung zur Statistik B Seite 18<br />

Unabhängigkeit von zwei Zufallsvariablen<br />

✗<br />

• Definition: X und Y heißen unabhängig, falls<br />

✔<br />

f(x, y) = f X (x) · f Y (y)<br />

für alle x, y<br />

bzw. P [X ≤ x, Y ≤ y] = P [X ≤ x] · P [Y ≤ y] für alle x, y<br />

• Zusätzliche Rechenregeln: Falls X und Y unabhängig sind, gilt:<br />

E(X · Y ) = E(X) · E(Y )<br />

Var(X + Y ) = Var(X) + Var(Y )<br />

f Y (y|X = x) = f Y (y) für alle x f X (x|Y = y) = f X (x) für alle y<br />

E(Y |X = x) = E(Y ) für alle x E(X|Y = y) = E(X) für alle y<br />

• Zwei diskrete Zufallsvariablen sind unabhängig, falls<br />

✖<br />

P [X = x, Y = y] = P [X = x] · P [Y = y]<br />

für alle x, y<br />

✕<br />

Unabhängigkeit mehrerer Zufallsvariablen<br />

✎<br />

• Defintion: Zufallsvariablen X 1 , . . . , X n heißen unabhängig, falls<br />

☞<br />

P [X 1 ≤ x 1 , . . . , X n ≤ x n ] = P [X 1 ≤ x 1 ] · · · P [X n ≤ x n ]<br />

für alle x 1 , . . . , x n<br />

bzw. f(x 1 , . . . , x k ) = f X1 (x 1 ) · · · f Xn (x n ) für alle x 1 , . . . , x n<br />

f(x 1 , . . . , x n ) bezeichnet die gemeinsame Dichte von X 1 , . . . , X n .<br />

f Xi (x i ) bezeichnet die Randdichte von X i , 1 ≤ i ≤ n.<br />

• Diskrete Zufallsvariablen X 1 , . . . , X n sind unabhängig, falls<br />

✍<br />

P [X 1 = x 1 , . . . , X n = x n ] = P [X 1 = x 1 ] · · · P [X n = x n ]<br />

für alle x 1 , . . . , x n<br />

✌<br />

Statistik B@LS-Kneip

Formelsammlung zur Statistik B Seite 19<br />

5 Parameterschätzung<br />

✬<br />

• Statistisches Modell<br />

✩<br />

– X 1 , . . . , X n Zufallsstichprobe<br />

– Verteilung von X hängt von einem Parameter θ ab<br />

– Beobachtete (realisierte) Werte: x 1 , . . . , x n<br />

• Schätzer für θ: ˆθn = g(X 1 , . . . , X n ) (Zufallsvariable)<br />

• Schätzwert für θ: ˆθn = g(x 1 , . . . , x n ) (reelle Zahl)<br />

• Bias (Verzerrung, systematischer Schätzfehler von ˆθ n ):<br />

Bias(ˆθ n ) = E(ˆθ n ) − θ<br />

• Varianz (zufallsbedingter Schätzfehler):<br />

Var(ˆθ n ) = E(ˆθ n − E(ˆθ n )) 2<br />

• Mittlerer quadratischer Schätzfehler (MSE, Mean Squared Error):<br />

)<br />

MSE(ˆθ n ) = E<br />

((ˆθ n − θ) 2 = Var(ˆθ n ) + Bias(ˆθ n ) 2<br />

• Schwache Konsistenz:<br />

ˆθ n ist schwach konsistent für θ, falls<br />

für jedes c > 0 :<br />

P (|ˆθ n − θ| ≥ c) → 0 für n → ∞ gilt.<br />

• MSE-Konsistenz:<br />

ˆθ n ist MSE-konsistent für θ, falls<br />

MSE(ˆθ n ) → 0 für n → ∞ gilt.<br />

✫MSE-Konsistenz ⇒ schwache Konsistenz<br />

✪<br />

Statistik B@LS-Kneip

Formelsammlung zur Statistik B Seite 20<br />

Maximum Likelihood–Schätzung<br />

★<br />

• Statistisches Modell<br />

✥<br />

– X 1 , . . . , X n einfache Zufallsstichprobe, d.h. unabhängige Wiederholungen von X<br />

– Verteilung von X hängt von einem Parameter θ ab<br />

– Beobachtete (realisierte) Werte: x 1 , . . . , x n<br />

• Likelihood–Funktion L(θ)<br />

L(θ) ≡ L(x 1 , . . . , x n |θ) =<br />

n∏<br />

f(x i |θ) = f(x 1 |θ) · · · f(x n |θ)<br />

i=1<br />

f(x) ≡ f(x|θ) bezeichnet für diskretes X die Wahrscheinlichkeitsfunktion und für<br />

stetiges X die Dichtefunktion.<br />

• Maximum Likelihood–Schätzung von θ<br />

– Schätzfunktion: ˆθ ⇔ arg max L(X 1 , . . . , X n |θ)<br />

θ<br />

– Schätzwert: ˆθ ⇔ arg max L(x 1 , . . . , x n |θ)<br />

θ<br />

• Log-Likelihood-Funktion ln L(θ) (rechentechnisch oft günstiger)<br />

✧<br />

ln L(θ) = ln L(x 1 , . . . , x n |θ) =<br />

n∑<br />

ln f(x i |θ)<br />

i=1<br />

✦<br />

Statistik B@LS-Kneip

Formelsammlung zur Statistik B Seite 21<br />

6 Konfidenzintervalle<br />

★<br />

✥<br />

• (1 − α)-Konfidenzintervall für θ<br />

Stichprobenfunktionen G u = g u (X 1 , . . . , X n ) und G o = g o (X 1 , . . . , X n ), so dass (zu<br />

vorgegebener Irrtumswahrscheinlichkeit α)<br />

P [G u ≤ G o ] = 1 und P [θ ∈ [G u , G o ]] = P [G u ≤ θ ≤ G o ] = 1 − α<br />

⇒ [G u , G o ] = [g u (X 1 , . . . , X n ), g o (X 1 , . . . , X n )] ist ein (1 − α)-Konfidenzintervall für θ.<br />

• Konfidenzniveau (Überdeckungs- , Vertrauenswahrscheinlichkeit): 1 − α<br />

• Realisiertes (1 − α)-Konfidenzintervall<br />

Beobachtete Werte x 1 , . . . , x 2 ⇒ [g u , g o ] = [g u (x 1 , . . . , x n ), g o (x 1 , . . . , x n )]<br />

• Symmetrisches (1 − α)–Konfidenzintervall<br />

erfüllt zusätzlich: P [θ < G u ] = P [θ > G o ] = α 2<br />

• Einseitiges (1 − α)-Konfidenzintervall (mit unterer Schranke)<br />

[G u , ∞[ mit P [G u ≤ θ] = 1 − α<br />

• Einseitiges (1 − α)-Konfidenzintervall (mit oberer Schranke)<br />

✧<br />

] − ∞, G o ] mit P [θ ≤ G o ] = 1 − α<br />

✦<br />

Konfidenzintervall für einen Erwartungswert, bekannte Varianz<br />

✓<br />

• Annahmen:<br />

✏<br />

– X 1 , . . . , X n unabhängig und identisch verteilt<br />

– X i ∼ N(µ, σ 2 )<br />

– Bekannte Varianz σ 2<br />

• (1 − α)-Konfidenzintervall für µ und bekannter Varianz σ 2 :<br />

[<br />

¯X − z 1−α/2<br />

σ √n , ¯X + z 1−α/2<br />

σ √n<br />

]<br />

✒<br />

• Anmerkung:<br />

Falls die Annahme der Normalverteilung zutrifft, handelt es sich um ein exaktes<br />

(1 − α)-Konfidenzintervall andernfalls (d.h. für nicht normalverteilte Zufallsvariablen<br />

aber großem Stichprobenumfang) um ein approximatives.<br />

✑<br />

Statistik B@LS-Kneip

Formelsammlung zur Statistik B Seite 22<br />

Konfidenzintervall für einen Erwartungswert, unbekannte Varianz<br />

✬<br />

• Annahmen:<br />

✩<br />

– X 1 , . . . , X n unabhängig und identisch verteilt<br />

– X i ∼ N(µ, σ 2 )<br />

– Unbekannte Varianz σ 2<br />

• (1 − α)-Konfidenzintervall für µ:<br />

[X − t 1−α/2;n−1<br />

S √n , X + t 1−α/2;n−1<br />

S √n<br />

]<br />

mit S 2 = 1<br />

n − 1<br />

n∑<br />

(X i − X) 2<br />

i=1<br />

• Anmerkung:<br />

Falls die Annahme der Normalverteilung zutrifft, handelt es sich um ein exaktes<br />

(1 − α)-Konfidenzintervall andernfalls (d.h. für nicht normalverteilte Zufallsvariablen<br />

aber großem Stichprobenumfang) um ein approximatives.<br />

Konfidenzintervall für eine Varianz<br />

• Annahmen:<br />

– X 1 , . . . , X n unabhängig und identisch verteilt<br />

– X i ∼ N(µ, σ 2 )<br />

• (1 − α)-Konfidenzintervall für σ 2 :<br />

[<br />

]<br />

(n − 1)S 2 (n − 1)S2<br />

,<br />

χ 2 1−α/2;n−1<br />

χ 2 α/2;n−1<br />

mit S 2 = 1<br />

n − 1<br />

n∑<br />

(X i − ¯X) 2<br />

i=1<br />

Approximatives Konfidenzintervall für einen Anteilswert<br />

• Annahmen:<br />

– X 1 , . . . , X n unabhängig und identisch verteilt<br />

– X i ∼ Bernoulli(p)<br />

– Großer Stichprobenumfang; Faustregel: n > 30, np > 5<br />

• Approximatives (1 − α)-Konfidenzintervall für p:<br />

[ √ √ ]<br />

ˆp(1 − ˆp)<br />

ˆp(1 − ˆp)<br />

✫<br />

ˆp − z 1−<br />

α<br />

2<br />

n<br />

, ˆp + z 1−<br />

α<br />

2<br />

n<br />

mit<br />

ˆp = X<br />

✪<br />

Statistik B@LS-Kneip

Formelsammlung zur Statistik B Seite 23<br />

7 Testen von Hypothesen<br />

Allgemein gelten folgende Annahmen und Hypothesen:<br />

✎<br />

• Annahmen:<br />

☞<br />

– X 1 , . . . , X n unabhängig und identisch verteilt<br />

– X i ∼ N(µ, σ 2 )<br />

– Bekannte Varianz σ 2<br />

• Hypothesen:<br />

✍<br />

✎<br />

(1) H 0 : µ = µ 0 gegen H 1 : µ ≠ µ 0<br />

(2) H 0 : µ = µ 0 gegen H 1 : µ > µ 0<br />

(3) H 0 : µ = µ 0 gegen H 1 : µ < µ 0<br />

H 0 : µ = µ 0 H 0 : µ = µ 0 H 0 : µ = µ 0<br />

H 1 : µ ≠ µ 0 H 1 : µ > µ 0 H 1 : µ < µ 0<br />

✌<br />

☞<br />

Gauß AB |z beob | > z 1−α/2 z beob > z 1−α z beob < −z 1−α<br />

p-Wert 2 · P [Z ≥ |z beob |] P [Z ≥ z beob ] P [Z ≤ z beob ]<br />

t-test AB |t beob | > t 1−α/2;n−1 t beob > t 1−α;n−1 t beob < −t 1−α;n−1<br />

p-Wert 2 · P [T ≥ |t beob |] P [T ≥ t beob ] P [T ≤ t beob ]<br />

approx. AB |z beob | > z 1−α/2 z beob > z 1−α z beob < −z 1−α<br />

Binomi<br />

✍<br />

p-Wert 2 · P [Z ≥ |z beob |] P [Z ≥ z beob ] P [Z ≤ z beob ]<br />

✌<br />

Statistik B@LS-Kneip

Formelsammlung zur Statistik B Seite 24<br />

Gauß-Test<br />

✛<br />

• Teststatistik:<br />

• Verteilung von Z unter H 0 :<br />

√ n( ¯X − µ0 )<br />

Z =<br />

σ<br />

Z ∼ N(0, 1)<br />

✘<br />

• Ablehnungsbereich (Test zum Niveau α):<br />

(1) |z beob | > z 1−α/2<br />

(2) z beob > z 1−α<br />

(3) z beob < −z 1−α<br />

• Überschreitungswahrscheinlichkeit: Für Z ∼ N(0, 1)<br />

(1) p-Wert = P [|Z| ≥ |z beob |] = 2 · P [Z ≥ |z beob |]<br />

(2) p-Wert = P [Z ≥ z beob ]<br />

(3) p-Wert = P [Z ≤ z beob ]<br />

• Anmerkung: Ohne Normalverteilungsannahme ist die Verteilung von Z für großen<br />

Stichprobenumfang i.Allg. approximativ gültig.<br />

✚<br />

✙<br />

Statistik B@LS-Kneip

Formelsammlung zur Statistik B Seite 25<br />

t-Test (Ein-Stichproben-Fall, σ 2 unbekannt)<br />

✤<br />

• Teststatistik:<br />

T =<br />

√ n( ¯X − µ0 )<br />

S<br />

mit S 2 = 1<br />

n − 1<br />

n∑<br />

(X i − ¯X) 2<br />

i=1<br />

✜<br />

• Verteilung von T unter H 0 :<br />

T ∼ t(n − 1)<br />

• Ablehnungsbereich (Test zum Niveau α):<br />

(1) |t beob | > t 1−α/2;n−1<br />

(2) t beob > t 1−α;n−1<br />

(3) t beob < −t 1−α;n−1<br />

• Überschreitungswahrscheinlichkeit: Für T ∼ t(n − 1)<br />

(1) p-Wert = P [|T | ≥ |t beob |] = 2 · P [T ≥ |t beob |]<br />

(2) p-Wert = P [T ≥ t beob ]<br />

(3) p-Wert = P [T ≤ t beob ]<br />

• Anmerkung: Ohne Normalverteilungsannahme ist die Verteilung von T für großen<br />

Stichprobenumfang i.Allg. approximativ gültig.<br />

✣<br />

✢<br />

Statistik B@LS-Kneip

Formelsammlung zur Statistik B Seite 26<br />

Approximativer Binomialtest<br />

✤<br />

• Teststatistik:<br />

Z =<br />

ˆp − p 0<br />

√<br />

p0 (1 − p 0 )/n<br />

mit<br />

ˆp = X<br />

✜<br />

• Aproximative Verteilung von Z unter H 0 :<br />

Z ∼ N(0, 1)<br />

• Ablehnungsbereich (Test zum Niveau α):<br />

(1) |z beob | > z 1−α/2<br />

(2) z beob > z 1−α<br />

(3) z beob < −z 1−α<br />

• Überschreitungswahrscheinlichkeit: Für Z ∼ N(0, 1)<br />

(1) p-Wert = P [|Z| ≥ |z beob |] = 2 · P [Z ≥ |z beob |]<br />

(2) p-Wert = P [Z ≥ z beob ]<br />

(3) p-Wert = P [Z ≤ z beob ]<br />

• Anmerkung:<br />

Unter H 0 gilt (exakt): nˆp ∼ B(n, p 0 ). Mit den entsprechenden Quantilen der Binomialverteilung<br />

erhält man den sogenannten exakten Binomialtest.<br />

✣<br />

✢<br />

Statistik B@LS-Kneip

Formelsammlung zur Statistik B Seite 27<br />

Vergleich der Erwartungswerte, σ 2 x, σ 2 y bekannt<br />

✤<br />

• Teststatistik:<br />

• Verteilung von Z unter H 0 :<br />

Z =<br />

X − Y √<br />

σ<br />

2<br />

X<br />

n + σ2 Y<br />

m<br />

Z ∼ N(0, 1)<br />

✜<br />

• Ablehnungsbereich (Test zum Niveau α):<br />

(1) |z beob | > z 1−α/2<br />

(2) z beob > z 1−α<br />

(3) z beob < −z 1−α<br />

• Überschreitungswahrscheinlichkeit: Für Z ∼ N(0, 1)<br />

(1) p-Wert = P [|Z| ≥ |z beob |] = 2 · P [Z ≥ |z beob |]<br />

(2) p-Wert = P [Z ≥ z beob ]<br />

(3) p-Wert = P [Z ≤ z beob ]<br />

• Anmerkung: Ohne Normalverteilungsannahme ist die Verteilung von Z für große<br />

Stichprobenumfänge m, n i.Allg. approximativ gültig.<br />

✣<br />

✢<br />

Statistik B@LS-Kneip

Formelsammlung zur Statistik B Seite 28<br />

t-Test (Zwei-Stichproben-Fall), σ i unbekannt, aber σ 2 x=σ 2 y<br />

✤<br />

• Teststatistik:<br />

✜<br />

T =<br />

X − Y<br />

S √ 1/n + 1/m<br />

mit<br />

S 2 = (n − 1)S2 X + (m − 1)S2 Y<br />

n + m − 2<br />

• Verteilung von T unter H 0 :<br />

T ∼ t(n + m − 2)<br />

• Ablehnungsbereich (Test zum Niveau α):<br />

(1) |t beob | > t 1−α/2;n+m−2<br />

(2) t beob > t 1−α;n+m−2<br />

(3) t beob < −t 1−α;n+m−2<br />

• Überschreitungswahrscheinlichkeit: Für T ∼ t(n + m − 2)<br />

(1) p-Wert = P [|T | ≥ |t beob |] = 2 · P [T ≥ |t beob |]<br />

(2) p-Wert = P [T ≥ t beob ]<br />

(3) p-Wert = P [T ≤ t beob ]<br />

• Anmerkung: Ohne Normalverteilungsannahme ist die Verteilung von T für große<br />

Stichprobenumfänge m, n i.Allg. approximativ gültig.<br />

✣<br />

✢<br />

Statistik B@LS-Kneip

Formelsammlung zur Statistik B Seite 29<br />

t-Test (Zwei-Stichproben-Fall), σ i unbekannt, σ 2 x ≠ σ 2 y<br />

✬<br />

• Teststatistik:<br />

• Verteilung von T unter H 0 :<br />

T =<br />

X − Y √<br />

S<br />

2<br />

X<br />

n + S2 Y<br />

m<br />

✩<br />

T ∼ t(k) wobei k größte ganze Zahl mit k ≤<br />

• Ablehnungsbereich (Test zum Niveau α):<br />

(1) |t beob | > t 1−α/2;k<br />

(2) t beob > t 1−α;k<br />

(3) t beob < −t 1−α;k<br />

• Überschreitungswahrscheinlichkeit: Für T ∼ t(k)<br />

(1) p-Wert = P [|T | ≥ |t beob |] = 2 · P [T ≥ |t beob |]<br />

(2) p-Wert = P [T ≥ t beob ]<br />

(3) p-Wert = P [T ≤ t beob ]<br />

1<br />

n − 1<br />

( S<br />

2<br />

X<br />

n<br />

( S<br />

2<br />

X<br />

n + S2 Y<br />

m<br />

• Anmerkung: Ohne Normalverteilungsannahme ist die Verteilung von T für große<br />

Stichprobenumfänge m, n i.Allg. approximativ gültig.<br />

✫<br />

✪<br />

) 2<br />

) 2<br />

+ 1<br />

m − 1<br />

( S<br />

2<br />

Y<br />

m<br />

) 2<br />

Statistik B@LS-Kneip

Formelsammlung zur Statistik B Seite 30<br />

t-Test (verbundene Stichproben)<br />

✤<br />

• Teststatistik:<br />

T =<br />

√ nD<br />

S D<br />

mit S 2 D = 1<br />

n − 1<br />

n∑<br />

(D i − D) 2 D i = X i − Y i<br />

i=1<br />

✜<br />

• Verteilung von T unter H 0 :<br />

T ∼ t(n − 1)<br />

• Ablehnungsbereich (Test zum Niveau α):<br />

(1) |t beob | > t 1−α/2;n−1<br />

(2) t beob > t 1−α;n−1<br />

(3) t beob < −t 1−α;n−1<br />

• Überschreitungswahrscheinlichkeit: Für T ∼ t(n − 1)<br />

(1) p-Wert = P [|T | ≥ |t beob |] = 2 · P [T ≥ |t beob |]<br />

(2) p-Wert = P [T ≥ t beob ]<br />

(3) p-Wert = P [T ≤ t beob ]<br />

• Anmerkung: Ohne Normalverteilungsannahme ist die Verteilung von T für großen<br />

Stichprobenumfang i.Allg. approximativ gültig.<br />

✣<br />

✢<br />

χ 2 -Unabhängigkeitstest<br />

✗<br />

• Teststatistik:<br />

χ 2 =<br />

k∑<br />

i=1<br />

m∑<br />

j=1<br />

(<br />

h ij − h i·h·j<br />

n<br />

h i·h·j<br />

n<br />

• Approximative Verteilung von χ 2 unter H 0 :<br />

) 2<br />

✔<br />

χ 2 ∼ χ 2 ((k − 1)(m − 1))<br />

falls<br />

h i·h·j<br />

n<br />

≥ 5<br />

für alle i, j<br />

• Ablehnungsbereich (Test zum Niveau α):<br />

χ 2 beob > χ2 1−α;(k−1)(m−1)<br />

• Überschreitungswahrscheinlichkeit: Für χ 2 ∼ χ 2 ((k − 1)(m − 1))<br />

✖<br />

p-Wert = P [χ 2 ≥ χ 2 beob ]<br />

✕<br />

Statistik B@LS-Kneip