Entscheidungsunterstützungssysteme - TU Chemnitz

Entscheidungsunterstützungssysteme - TU Chemnitz

Entscheidungsunterstützungssysteme - TU Chemnitz

Sie wollen auch ein ePaper? Erhöhen Sie die Reichweite Ihrer Titel.

YUMPU macht aus Druck-PDFs automatisch weboptimierte ePaper, die Google liebt.

Vorlesung<br />

<strong>Entscheidungsunterstützungssysteme</strong><br />

WS 2013/2014<br />

Christian Schieder<br />

Professur Wirtschaftsinformatik II<br />

cschie@tu-chemnitz.eu

3<br />

Ausgewählte Methoden des Data Mining<br />

GLIEDERUNG<br />

1. Entscheidungsbaumverfahren<br />

2. Clusterverfahren<br />

3. Neuronale Netze<br />

4. Assoziationsanalyse

Entscheidungsbaumverfahren – Allgemein<br />

• Ziel:<br />

• Vorgehensweise:<br />

Zuordnung anhand von Regeln<br />

(Darstellung mit Klassifikationsbäumen)<br />

• Beispiel:<br />

Einteilung von Datensätzen mit Angaben über Kunden derart, dass<br />

damit die Käufergruppe erkannt werden kann, in die ein neuer Kunde<br />

voraussichtlich gehört<br />

• Voraussetzung:<br />

<strong>Entscheidungsunterstützungssysteme</strong><br />

© Christian Schieder | Professur Wirtschaftsinformatik II | Vorlesung WS 2013/2014 3 | 26

Grundsätzliche Arbeitsweise<br />

•<br />

• Sukzessive Aufteilung der Trainingsmenge, so dass sich daraus<br />

homogenere Gruppen von Datensätzen bezüglich der<br />

Klassifikationsvariablen ergeben<br />

• Darstellung der Aufteilung der Datenmengen durch einen Baum, in dem<br />

jeder Knoten eine Datenmenge indiziert, dem ein Homogenitätsmaß<br />

zugeordnet wird<br />

•<br />

•<br />

<strong>Entscheidungsunterstützungssysteme</strong><br />

© Christian Schieder | Professur Wirtschaftsinformatik II | Vorlesung WS 2013/2014 4 | 26

Beispiel<br />

Es liege für eine Kreditwürdigkeitsprüfung eine Menge von Kundendatensätzen<br />

vor. Dabei werden 70 % der Kunden als kreditwürdig und 30 % der<br />

Kunden als nicht-kreditwürdig eingestuft.<br />

Durch eine Aufteilung des Gesamtdatenbestandes anhand eines<br />

Merkmales sollen zwei Teilmengen derart entstehen, dass sich in der<br />

einen Teilmenge mehr Kundendatensätze mit der Eigenschaft<br />

kreditwürdig und in der anderen Teilmenge mehr Kundendatensätze mit<br />

der Eigenschaft nicht-kreditwürdig befinden. Beide Teilmengen weisen<br />

damit eine bessere Homogenität bezüglich der Klassifikationsvariablen<br />

auf, als der Ausgangsdatenbestand.<br />

<strong>Entscheidungsunterstützungssysteme</strong><br />

© Christian Schieder | Professur Wirtschaftsinformatik II | Vorlesung WS 2013/2014 5 | 26

Beispiel<br />

<strong>Entscheidungsunterstützungssysteme</strong><br />

© Christian Schieder | Professur Wirtschaftsinformatik II | Vorlesung WS 2013/2014 6 | 26

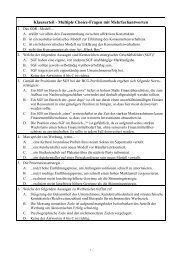

Regeln<br />

Schrittfolge:<br />

1)<br />

2)<br />

Im Beispiel sind dies folgende Regeln:<br />

WENN Attribut A die Bedingung K1 erfüllt, DANN gehört das zugehörige<br />

Objekt der Klasse Y an.<br />

WENN Attribut A nicht die Bedingung K1 erfüllt und Attribut B nicht die<br />

Bedingung K2, DANN gehört das zugehörige Objekt der Klasse Y an.<br />

WENN Attribut A nicht die Bedingung K1 erfüllt und Attribut B die<br />

Bedingung K2, DANN gehört das zugehörige Objekt der Klasse X an.<br />

<strong>Entscheidungsunterstützungssysteme</strong><br />

© Christian Schieder | Professur Wirtschaftsinformatik II | Vorlesung WS 2013/2014 7 | 26

Regeln<br />

• Unterscheidung der Entscheidungsbaumverfahren durch die zugehörigen<br />

Splitkriterien (kurz: Split)<br />

• Splitkriterien basieren auf einem Homogenitätsmaß<br />

Beispiel:<br />

• Homogenitätsmaß wird definiert mit Hilfe der relativen Häufigkeit p i des Auftretens bestimmter<br />

Datensätze einer bestimmten Klasse i<br />

Von 1000 Datensätzen sind 700 der Klasse 1 und 300 der Klasse 2 zugeordnet. Damit<br />

gilt für den Datenbestand:<br />

Ziel:<br />

p 1 = 70 %, p 2 = 30 %<br />

• Datensätze einzelnen Knoten zuzuordnen und dabei möglichst ausgeprägte<br />

Klassenzugehörigkeiten erreichen<br />

• Je unterschiedlicher die knotenspezifischen Häufigkeiten sind, desto homogener ist der<br />

Knoten ideal wäre eine Verteilung (100%, 0 %)<br />

• Erzeugung eines Modells, durch welches unbekannte Datenobjekte bestimmten<br />

vorgegebenen Klassen zugeordnet werden können<br />

<strong>Entscheidungsunterstützungssysteme</strong><br />

© Christian Schieder | Professur Wirtschaftsinformatik II | Vorlesung WS 2013/2014 8 | 26

Entropie<br />

• Als Maß für die Homogenität des Knoten T kann die Entropie<br />

verwendet werden.<br />

k<br />

<br />

Entropie ( T)<br />

p i<br />

log 2<br />

p i mit(<br />

0log<br />

2<br />

0 0)<br />

i1<br />

• Gilt Entropie = 0, so ist der Knoten homogen.<br />

• Die Entropie nimmt ihren Maximalwert an (log 2 der Klassenanzahl),<br />

wenn eine Gleichverteilung vorliegt.<br />

<strong>Entscheidungsunterstützungssysteme</strong><br />

© Christian Schieder | Professur Wirtschaftsinformatik II | Vorlesung WS 2013/2014 9 | 26

Informationsgewinn<br />

• Es wird der Split gewählt, der den größten Informationsgewinn (IG) bringt.<br />

• Der IG beschreibt die erwartete Reduktion der Entropie, wenn der Wert des Attributs A<br />

bekannt ist.<br />

Informationsgewinn (IG) durch Split der Menge T in m Teilmengen T i (i=1,…,m):<br />

IG<br />

<br />

Entropie ( T)<br />

<br />

m<br />

<br />

i1<br />

| Ti<br />

| T<br />

|<br />

|<br />

Entropie ( T )<br />

i<br />

• Ein neuer Knoten T a enthält alle Elemente, bei denen das Attribut A die Ausprägung a<br />

annimmt.<br />

• Der Informationsgewinn ergibt sich als Entropie des noch nicht weiter unterteilten<br />

Knotens T minus der Summe der Entropien der neuen Knoten T a , wobei als<br />

Gewichtung die relative Größe der neuen Knoten T a bezogen auf den Ausgangsknoten<br />

T gewählt wird.<br />

<strong>Entscheidungsunterstützungssysteme</strong><br />

© Christian Schieder | Professur Wirtschaftsinformatik II | Vorlesung WS 2013/2014 10 | 26

• Als weiteres Maß für die Homogenität des Knoten T kann der Gini-Index<br />

verwendet werden.<br />

Gini(<br />

T )<br />

1<br />

<br />

i1<br />

<strong>Entscheidungsunterstützungssysteme</strong><br />

© Christian Schieder | Professur Wirtschaftsinformatik II | Vorlesung WS 2013/2014 11 | 26<br />

k<br />

2<br />

p i<br />

• Gilt Gini (T) = 0, so ist der Knoten homogen.<br />

• Der Gini-Index nimmt seinen Maximalwert an, wenn eine<br />

Gleichverteilung vorliegt.<br />

• Es wird dann der Split gewählt, der den kleinsten Gini-Index für eine<br />

Partition des Knotens T mittels Attribut A bringt:<br />

| T<br />

<br />

a<br />

|<br />

Gini ( T,<br />

A)<br />

Gini(<br />

Ta<br />

)<br />

aA<br />

| T |

• Messung der Güte eines Entscheidungsbaumes anhand der Fehlklassifikationsquote<br />

a) Fehlklassifikationsquote als Anteil der durch das Modell fehlerhaft klassifizierten Datensätze zur<br />

Gesamtanzahl der klassifizierten Datensätze<br />

‣ sollte nicht auf dem Trainingsdatenbestand, sondern auf einer davon unabhängigen<br />

Testmenge ermittelt werden<br />

b) Fehlklassifikationsquote bezüglich des zur Modellierung eingesetzten Datenbestandes<br />

‣ ist in der Regel ungleich Null, da in einem Endknoten alle Datensätze derselben Klasse<br />

zugeordnet werden, unabhängig von der tatsächlich vorliegenden Klassenzugehörigkeit<br />

‣ in Aussagefähigkeit beschränkt, da sie durch weitere Aufteilungen der Endknoten in<br />

homogenere Knoten verringert werden kann<br />

‣ dient dennoch als erster Hinweis auf die Güte des Baums<br />

<strong>Entscheidungsunterstützungssysteme</strong><br />

© Christian Schieder | Professur Wirtschaftsinformatik II | Vorlesung WS 2013/2014 12 | 26

Overfitting<br />

• Overfitting<br />

‣ „auswendig lernen“ von Trainingsdaten<br />

‣ Modell enthält zusätzliche (zu viele und z. T. irrelevante) erklärende Variablen<br />

‣ Problem: Modell funktioniert nur auf den Trainingsdaten<br />

• Strategien zur Reduzierung des Overfitting-Problems<br />

‣ Entfernen von fehlerhaften Trainingsdaten<br />

‣ Reduzierung der Größe der Trainingsmenge<br />

‣ Transformation der Trainingsdaten, z. B. Dimensionsreduktion<br />

‣ Beschränkung der maximal erlaubte Homogenität in Knoten<br />

‣ Mindestanzahl von Datensätzen in den Knoten<br />

‣ Pruning<br />

<strong>Entscheidungsunterstützungssysteme</strong><br />

© Christian Schieder | Professur Wirtschaftsinformatik II | Vorlesung WS 2013/2014 13 | 26

Pruning<br />

• …ist das nachträgliche Modifizieren des Entscheidungsbaumes<br />

• mit dem Ziel die Fehlklassifikationsquote auf unbekannten<br />

Datensätzen zu verringern<br />

Eine Pruning-Strategie ist das Fehlerreduktions-Pruning:<br />

• Hierbei wird in jedem Pruning-Schritt derjenige Teilbaum T des<br />

Gesamtbaumes E bestimmt, durch dessen Entfernung der<br />

Klassifikationsfehler auf der Validierungsmenge am stärksten<br />

verringert wird.<br />

• Dieser Teilbaum wird anschließend entfernt.<br />

<strong>Entscheidungsunterstützungssysteme</strong><br />

© Christian Schieder | Professur Wirtschaftsinformatik II | Vorlesung WS 2013/2014 14 | 26

Beispiel Mailingaktion<br />

In einem Versandhaus sollen Spezialkataloge versendet werden. Für<br />

einige Kunden wurden bereits Entscheidungen über die zu versendenden<br />

Kataloge getroffen.<br />

Als Attribute der Kunden stehen die Anzahl der gekauften Artikel in den<br />

Gruppen Textilien und Geschenkartikel sowie der dabei angefallene<br />

Durchschnittsumsatz zur Verfügung.<br />

Die Ausprägungen sind qualitativer Natur. Es wird nur unterschieden<br />

zwischen wenig, mittel und viel bzw. niedrig, mittel und hoch.<br />

Für die Kataloge stehen die Varianten Textil (T)-Katalog, ein<br />

Geschenkartikel (G)-Katalog oder kein (N-)Katalog zur Verfügung.<br />

<strong>Entscheidungsunterstützungssysteme</strong><br />

© Christian Schieder | Professur Wirtschaftsinformatik II | Vorlesung WS 2013/2014 15 | 26

Beispiel Mailingaktion<br />

12 Kundenkaufprofile<br />

Kunden Textilien Geschenkartikel O-Preis Katalog<br />

X1 mittel wenig mittel T<br />

X2 wenig mittel niedrig N<br />

X3 mittel viel mittel T G<br />

X4 viel wenig hoch T<br />

X5 wenig mittel hoch G<br />

X6 viel mittel niedrig T G<br />

X7 wenig viel niedrig G<br />

X8 mittel wenig niedrig N<br />

X9 viel wenig niedrig T<br />

X10 wenig wenig hoch N<br />

X11 wenig viel mittel G<br />

X12 viel viel hoch T G<br />

<strong>Entscheidungsunterstützungssysteme</strong><br />

© Christian Schieder | Professur Wirtschaftsinformatik II | Vorlesung WS 2013/2014 16 | 26

Beispiel Mailingaktion<br />

Textilien<br />

1,..,12<br />

<br />

3<br />

12<br />

3<br />

12<br />

3<br />

12<br />

3<br />

<br />

12<br />

2, 5, 7, 10, 11 1, 3, 8 4, 6, 9, 12<br />

p <br />

3 2<br />

i<br />

0 0<br />

1 0 1 1<br />

2 2<br />

0 0 <br />

3 3 3<br />

4 4<br />

5<br />

5<br />

T, G, TG, N T, G, TG, N T, G, TG, N<br />

Entropie<br />

0,9710 1,5850 1<br />

4<br />

IG(Textilien) = <br />

5 (0,9710) <br />

3 (1,5850) (1) 0, 8658<br />

2<br />

12<br />

12<br />

12<br />

<strong>Entscheidungsunterstützungssysteme</strong><br />

© Christian Schieder | Professur Wirtschaftsinformatik II | Vorlesung WS 2013/2014 17 | 26

Beispiel Mailingaktion<br />

Geschenkartikel<br />

1,..,12<br />

Textilien<br />

1, 4, 8, 9, 10 2, 5, 6 3, 7, 11, 12<br />

Textilien<br />

Textilien<br />

N<br />

Preis<br />

10 1, 8 4, 9<br />

T, N<br />

2, 5 6 7, 11 3 12<br />

N, G ? TG G TG TG<br />

Preis<br />

8 1 2 5<br />

N T ? N ? G<br />

<strong>Entscheidungsunterstützungssysteme</strong><br />

© Christian Schieder | Professur Wirtschaftsinformatik II | Vorlesung WS 2013/2014 18 | 26

Beispiel Mailingaktion<br />

Beim Splitkriterium Gini-Koeffizient ergibt sich der gleiche Baum.<br />

Für den Split des Wurzelknotens gilt:<br />

Gini(Textil)= 0,53 ; Gini(Geschenk)=0,53 ; Gini(Preis)=0,72<br />

Die Splits in der zweiten Phase erfolgen gemäß der Werte<br />

<strong>Entscheidungsunterstützungssysteme</strong><br />

© Christian Schieder | Professur Wirtschaftsinformatik II | Vorlesung WS 2013/2014 19 | 26

Beispiel Mailingaktion<br />

Geschenkartikel<br />

wenig<br />

1,..,12<br />

1, 4, 8, 9, 10<br />

Textilien<br />

m<br />

Regel:<br />

Preis<br />

T<br />

1, 8<br />

m<br />

1<br />

IF Geschenkartikel: wenig AND<br />

Textilien: mittel AND Preis: mittel<br />

THEN T<br />

<strong>Entscheidungsunterstützungssysteme</strong><br />

© Christian Schieder | Professur Wirtschaftsinformatik II | Vorlesung WS 2013/2014 20 | 26

Fragen?<br />

<strong>Entscheidungsunterstützungssysteme</strong><br />

© Christian Schieder | Professur Wirtschaftsinformatik II | Vorlesung WS 2013/2014 21 | 26