Dialoggesteuerte Handlungskontrolle eines bimanualen ...

Dialoggesteuerte Handlungskontrolle eines bimanualen ...

Dialoggesteuerte Handlungskontrolle eines bimanualen ...

Sie wollen auch ein ePaper? Erhöhen Sie die Reichweite Ihrer Titel.

YUMPU macht aus Druck-PDFs automatisch weboptimierte ePaper, die Google liebt.

<strong>Dialoggesteuerte</strong> <strong>Handlungskontrolle</strong> <strong>eines</strong><strong>bimanualen</strong> KonstruktionsrobotersC. Scheering, B. Hildebrandt, A. KnollUniversitat Bielefeld, Postfach 100131, 33501 Bielefeld10. August 1998Keywords: Konstruktionshandlung, Sprachverstehenssystem, Interaktive Robotik, Instruktionen,inkrementelle Sprachverarbeitung, Multisensor-Interaktion, Mensch-Maschine-Interaktion1 EinleitungWir entwickeln ein Robotersystem fur Konstruktionshandlungen, das durch spontan gesprocheneAnweisungen gesteuert wird. Die Architektur des Systems ist kognitiv motiviert(z. B. Zhang, Collani & Knoll 1998 Hildebrandt, Moratz, Rickheit & Sagerer 1995), wobeidie technischen Rahmenbedingungen teilweise enge Grenzen setzen. Um die Vielfalt vonKonstruktionsaufgaben einzuschranken, haben wir uns auf ein Szenario konzentriert, daszum einen ubersichtlich genug und zum anderen ausreichend allgemeingultig ist. In demausgewahlten Szenario erteilt der menschliche Instrukteur anhand <strong>eines</strong> Bauplans einemkunstlichen Konstrukteur, d.h. einem Robotersystem, Anweisungen, um aus Holzbauteilenein Modellugzeug zu konstruieren.2 Die SystemkomponentenDie Hauptkomponenten des Systems sind ein Spracherkennungs- und ein Sprachverstehenssystemsowie ein multi-sensorgesteuertes Zwei-Arm-Robotersystem. Das Spracherkennungssystembasiert auf dem Diktiersystem IBM Via Voice Gold. Um die Erkennungsleistungzu erhohen, wurde das Vollformen-Lexikon dem Vokabular des Szenarios angepatund das System um grammatische Bedingungen und einfache Wortkompositionsregeln erweitert.Das Spracherkennungssystem ist als Frontend zur Sprachverstehenskomponenteangelegt. Falls eine Auerung nur partiell korrekt erkannt wurde, ist in der Regel eineInterpretation durch die Sprachverstehenskomponente moglich.1

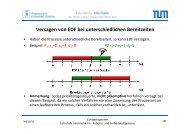

Die Sprachverstehenskomponente basiert auf einer von Mark Steedman entwickeltenVariante der Kategorialgrammatik, der Combinatory Categorial Grammar (z. B. Steedman1987, 1996). Um kognitiven Verarbeitungsprinzipien der Sprachrezeption, wie z. B. derinkrementellen Verarbeitung, und der exiblen Konstituentenstellung im Deutschen zuentsprechen, wurde die Grammatik modiziert und an das Deutsche angepat. Dadurchkonnen selbst komplexe und (lokal) ambige Anweisungen (z. B. steck die lange Schraube indas zweite Loch von links der siebenlochrigen Leiste) ezient interpretiert werden. Aus densprachlichen Anweisungen leitet die Sprachverstehenskomponente semantische Strukturenab, aus denen wiederum elementare Operationen fur den Roboter generiert werden. Hierbeiwird die aktuelle Szenensituation berucksichtigt.Die Arme des Konstruktionsroboters sind in einer Montagezelle hangend nebeneinandermontiert. Dadurch wird ihnen ein den menschlichen Armen ahnlicher Aktionsradiuserlaubt. Neben einem externen Multi-Kamera-System zur Objekterkennung und grobenLagepositionierung (Scheering 1998) ist auf jedem Arm eine Eye-on-Hand\ Kamera montiert,durch die im Nahbereich mittels <strong>eines</strong> visuellen Regelungsprozesses Bauteile exakt"gegrien werden konnen (Meinicke 1997). Zusatzlich sind an den Handgelenken der ArmeKraftmomentensensoren montiert. Sie erlauben dem System, komplexe Montageoperationenwie Schrauben und Stecken als kraft-positionsgeregelte Bewegungen zu steuern.Zusatzliche visuelle Informationen der Handkameras werden ebenfalls darin einbezogen(Collani 1998).3 Die KontrollarchitekturZur Steuerung des Roboters verwenden wir die in Abbildung 1 dargestellte, in drei Ebenenstrukturierte Kontrollarchitektur: Cognition:Hier ndet die Interaktion mit dem menschlichen Instrukteur statt. Diese geschiehtvornehmlich uber gesprochene Sprache, geplant ist daruber hinaus die Integrationvon Zeigegesten. Hauptaufgabe dieser Ebene ist es, elementare Anweisungen ausder sprachlichen Auerung unter Berucksichtigung des aktuellen Szenenzustandes furden Roboter zu generieren. Sollte eine Anweisung mehrdeutig sein, wird ein Dialogzur Verikation angestoen. Konnte eine Anweisung nicht von der unteren Ebeneausgefuhrt werden, wird ebenfalls in den Dialog mit dem Instrukteur getreten. Scheduling:Auf der Ebene der Ablaufsteuerung wird eine Sequenz primitiver Roboteroperationentsprechend des aktuellen Roboterzustands zur Durchfuhrung elementarer Anweisungengeneriert. Aus einer von der Ebene Cognition gelieferten Schraub-Operationwird z. B. ein1. find contact(nut, bolt) (Stelle Kontakt her).2. find thread() (Finde die Gewindebohrung).2

3. find notch point() (Finde den Gewindeeinstieg).4. screw() (Schraube ein).Bevor ein im Monitormodul erkannter Fehler an die ubergeordnete Ebene Cognitionweitergereicht wird, versucht die Ebene autonom, sie zu beheben. Der durchAnweisungen geandert Szenenzustand wird automatisch aktualisiert.Human CommunicatorWhich one?Grasp theleft screwCognitionNL-ProductionLexicon/GrammarNL-ProcessingHand-GesturePerceptionAction IdentificationObject IdentificationInitialOperation VerificationWorld ModelMonitoringRobot /Assembly StateDisambiguatedOperationCoordinationSchedulingAgendasubgoal 1subgoal 2primitive 2-1primitive 2-2......InterpreterUpdateExecutionSkill-SM Skill-M Skill-SEventSkill-SM Skill-SM Skill-M Skill-S Skill-SReal-Time SensingOther SensingAbbildung 1: Kontrollarchitektur des Konstruktionsroboters3

Execution:Der Interpreter aus der vorherigen Ebene verwendet sogenannte Konstruktionstechniken(skills), um Sequenzen von elementaren Operationen abzuarbeiten. Wir unterscheidendabei drei Arten von Skills:{ Motorische Skills sind direkte einzelne Roboterbewegungen, wie z. B. open/closehand, move-to, move-joint-to, rotate hand.{ Sensorische Skills stellen Information fur die Ablaufebene oder andere sensomotorischeSkills zur Verfugung. Wir unterscheiden dabei echtzeitfahige Skills(z. B. fur Kraft/Momentenregelung, visuelle Regelung) von anderen Skills. Beispielefur sensorische Skills sind get joint, get force, get torque, track object,detect moving robot, grab an image.{ Sensomotorische Skills verbinden Perzeption und Aktion zumeist in Bewegungsregelungen,wie z. B. bei kraftuberwachten Bewegungen.Zusatzlichwerden auf dieser Ebene sogenannte Events generiert, um die Ausfuhrungsebeneuber unerwartete Ereignisse wie z. B. Kraftuberschreitung, Singularitaten, Ableben<strong>eines</strong> Moduls etc. zu informieren.4 Erhohte Robustheit durch Interaktion und RedundanzWahrend der Handlungsinterpretation und -ausfuhrung haben wir es mit einem komplexenInteraktionsgeecht zu tun. Bei einer unterspezizierten Anweisung wie steck die Dreilochleisteauf den Wurfel wird aufgrund semantischen Wissens inferiert, da ein Instrumentbenotigt wird. Bezogen auf unser Szenario sind dies Schrauben. Sind mehrere Schraubenin der Szene, dann kann das System im Prinzip nachfragen, ob beispielsweise eine langeoder eine kurze Schraube erforderlich ist. Halt das Robotersystem die erforderlichen Objektenoch nicht in den Handen\ sind vor der benannten Steckhandlung Greifhandlungen"notig. Erkennt der Instruktuer, da der Roboter ein ungewolltes Objekt greifen will, kanner sprachlich intervenieren (stop) undeine laufenden Handlung modizieren. Eine weitereIntervention kann sich durch den Sensoreinsatz ergeben. Wird z. B. das zu greifendenObjekt wahrend der Feinpositionierung durch Einwirkung von Auen verschoben, regeltdie visuelle Regelung sofort nach. Daruber hinaus erlaubt das System die Interventionwahrend einer gefugigen Bewegung durch Anfassen des Manipulators. Durch die dabeiauftretenden Krafte wird die Position von auen beeinut. Durch den massiven Sensoreinsatzwird die Robustheit der Handlungskompenente stark erhoht. So wird z. B. durchdie redundante Auslegung der externen Kameras sowohl eine bessere Positionierung erreichtals auch eine hohere Toleranz gegenuber Bildausfall (z. B. durch Verdeckung) undschlechter Signalqualitat. Durch die Handkameras werden Fehler in Lage und Orientierungdes Greifers weitgehend ausgeglichen. Trotzdem auftretende Greifungenauigkeiten werdenbei den Steck- bzw. Schrauboperation durch die Kraftmomentensensoren ausgeglichen.4

LiteraturHildebrandt, B., Moratz, R., Rickheit, G. & Sagerer, G. (1995). Integration von BildundSprachverstehen in einer kognitiven Architektur. Kognitionswissenschaft, 4, 118-128.Meinicke, P. &Zhang, J. (1997). Calibration of a "Self-Viewing" Eye-on-Hand CongurationProceedings of the IMACS Multiconference on Computational Engineering SystemsApplications, Lille, France, July, 1996.Scheering, C. & Kersting, B. (1998). Uncalibrated Hand-Eye Coordination with a RedundantCamera System. Proceedings of the IEEE International Conference on Roboticsand Automation, Leuven, Belgium, 1998.Steedman, M. (1987). Combinatory grammars and parasitic gaps In N. J. Haddock,E. Klein & G. Morrill (Eds.) Edinburgh Working Papers in Cognitive Science, Vol.1,Categorial grammar, unication grammar and parsing (pp. 29-70). Edinburgh: Universityof Edinburgh.Steedman, M. (1996) Surface structure and interpretation. Cambridge, MA: MIT Press.von Collani, Y., Zhang, J., & Knoll, A. (1998). A neuro-fuzzy solution for ne-motioncontrol based on vision and force sensors Proceedings of the IEEE International Conferenceon Robotics and Automation, Leuven, Belgium, 1998.Zhang, J., v. Collani, Y., & Knoll, A. (1998). Development of a Robot Agent for InteractiveAssembly Proceedings of the 4th International Symposium on Distributed Robotic Systems,Karlsruhe, 1998.5