Konzeption und Implementierung eines ... - Stephan, Daniel

Konzeption und Implementierung eines ... - Stephan, Daniel

Konzeption und Implementierung eines ... - Stephan, Daniel

Erfolgreiche ePaper selbst erstellen

Machen Sie aus Ihren PDF Publikationen ein blätterbares Flipbook mit unserer einzigartigen Google optimierten e-Paper Software.

auth+xml+doc=sxdoc<br />

gpg<br />

<strong>Konzeption</strong> <strong>und</strong> <strong>Implementierung</strong> <strong>eines</strong><br />

Clusteringmechanismus für ein Online<br />

Informationssystem<br />

instant messaging<br />

group mail/forum<br />

images<br />

graphs<br />

authenticate doc publish doc to the net<br />

xml+doc=xdoc archive<br />

map a:b multiple vocabularies<br />

forward query to specialized system<br />

crawl and index only certain websites<br />

group chat<br />

Diplomarbeit<br />

<strong>Daniel</strong> <strong>Stephan</strong><br />

stephan@danielstephan.com<br />

share bibliographies bibster<br />

related docs in the net<br />

jambalaya<br />

search the net<br />

protégé<br />

eclipse rcp<br />

webobjects<br />

springframework<br />

struts<br />

webwork 2<br />

jung<br />

judge<br />

weka<br />

yellow pages<br />

mail<br />

job offers<br />

networking<br />

tables numeric<br />

textual<br />

graphic<br />

binary<br />

classify<br />

postnuke PHP<br />

12. August 2005<br />

share documents docster<br />

meta search<br />

classify page in cluster<br />

java<br />

.NET<br />

java<br />

Paperball<br />

specialized system<br />

experts<br />

communication<br />

data entries<br />

desktop search<br />

nutch<br />

crawl<br />

rich client<br />

web client<br />

java algorithms<br />

knowledge<br />

p2p<br />

Search Engine<br />

technology<br />

DataMining<br />

Clustering<br />

goal<br />

prediction<br />

description<br />

Recommendations<br />

Navigation<br />

Orienteering<br />

Teleporting<br />

Classification<br />

vis ually<br />

textually<br />

list clusters to in- or exclude from search<br />

formulate query<br />

create set<br />

name sets<br />

noname sets<br />

information trends<br />

purchase need (if like a then like b)<br />

infer information from data<br />

provide overview<br />

Usage based<br />

Content based<br />

graph<br />

list<br />

tree<br />

search within search results<br />

add links to the cluster(s) the doc. belongs to<br />

step by step navigating<br />

navigate to similar documents<br />

search by example<br />

grouping search results<br />

flat<br />

hierarchical<br />

alternative thesaurus<br />

automate procedure<br />

ordering by similarity<br />

aid navigation<br />

vivisim o<br />

clusty.com<br />

bmj.com<br />

aaas.org

Inhaltsverzeichnis<br />

I. Einleitung 1<br />

1. Überblick über Inhalt <strong>und</strong> Prozesse 3<br />

1.1. Einleitung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 3<br />

1.2. Der Prozess . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 4<br />

1.3. Entwicklungsumgebung . . . . . . . . . . . . . . . . . . . . . . . 5<br />

2. Business Analyse 9<br />

2.1. Ausgangssituation . . . . . . . . . . . . . . . . . . . . . . . . . . 9<br />

2.2. Ziele . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 10<br />

2.3. Herausforderungen . . . . . . . . . . . . . . . . . . . . . . . . . . 11<br />

3. Marktanalyse 15<br />

3.1. Kriterien Auswahl . . . . . . . . . . . . . . . . . . . . . . . . . . 15<br />

3.2. Konkurrenten . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 17<br />

3.2.1. FIZ-Technik e.V. . . . . . . . . . . . . . . . . . . . . . . . 17<br />

3.2.2. FIZ Karlsruhe / STN Online Services . . . . . . . . . . . 19<br />

3.2.3. Deutsches Maritimes Kompetenz Netz (DMKN) . . . . . 20<br />

3.2.4. HWWA - Hamburgisches Welt-Wirtschafts-Archiv . . . . 20<br />

3.2.5. MarineTalk . . . . . . . . . . . . . . . . . . . . . . . . . . 22<br />

3.2.6. MarineNet . . . . . . . . . . . . . . . . . . . . . . . . . . 23<br />

3.3. Wissenschaftliche Angebote . . . . . . . . . . . . . . . . . . . . . 23<br />

3.3.1. Netacademy, a scientific community . . . . . . . . . . . . 23<br />

3.3.2. SpringerLink . . . . . . . . . . . . . . . . . . . . . . . . . 26<br />

3.3.3. ACM Portal . . . . . . . . . . . . . . . . . . . . . . . . . . 27<br />

3.4. Technisch Relevantes . . . . . . . . . . . . . . . . . . . . . . . . . 29<br />

3.4.1. Clusty / Vivísimo . . . . . . . . . . . . . . . . . . . . . . 29<br />

3.4.2. carrot 2 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 30

Inhaltsverzeichnis iv<br />

II. Definition 33<br />

4. Technische Analyse 35<br />

4.1. Ist-Analyse . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 35<br />

4.1.1. Komponenten <strong>und</strong> Schnittstellen . . . . . . . . . . . . . . 35<br />

4.1.2. Prozesse . . . . . . . . . . . . . . . . . . . . . . . . . . . . 36<br />

4.1.3. Datenmodell . . . . . . . . . . . . . . . . . . . . . . . . . 37<br />

4.1.4. Einschränkungen . . . . . . . . . . . . . . . . . . . . . . . 42<br />

4.2. Prototyp . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 43<br />

4.2.1. Oberflächenprototyp . . . . . . . . . . . . . . . . . . . . . 43<br />

4.2.2. Prozess: Cluster erzeugen . . . . . . . . . . . . . . . . . . 45<br />

4.2.3. Datenmodell . . . . . . . . . . . . . . . . . . . . . . . . . 47<br />

4.2.4. Komponenten <strong>und</strong> Schnittstellen . . . . . . . . . . . . . . 47<br />

5. Wissenschaftliche Analyse 51<br />

5.1. Information Retrieval . . . . . . . . . . . . . . . . . . . . . . . . 51<br />

5.2. Knowledge Discovery in Databases . . . . . . . . . . . . . . . . . 54<br />

5.3. Repräsentation von Dokumenten . . . . . . . . . . . . . . . . . . 56<br />

5.3.1. Einordnung in Situation des ISL . . . . . . . . . . . . . . 57<br />

5.3.2. Das Dokument als Wortsack (aka word-bag) . . . . . . . . 57<br />

5.3.3. Methoden für die Beschränkung auf wesentliche Features 59<br />

5.3.4. Latent Semantic Indexing . . . . . . . . . . . . . . . . . . 62<br />

5.4. Clustering . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 66<br />

III. Umsetzung 69<br />

6. Statisches Modell 71<br />

6.1. Data Objects . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 71<br />

6.2. Data Access Objects . . . . . . . . . . . . . . . . . . . . . . . . . 71<br />

6.3. Data Access Commands . . . . . . . . . . . . . . . . . . . . . . . 75<br />

7. Dynamisches Modell 83<br />

7.1. Stoppworte finden . . . . . . . . . . . . . . . . . . . . . . . . . . 83<br />

7.2. Term-Dokument-Matrix erstellen . . . . . . . . . . . . . . . . . . 84<br />

7.3. Matrix Berechnungen . . . . . . . . . . . . . . . . . . . . . . . . 87<br />

7.4. Cluster Analyse . . . . . . . . . . . . . . . . . . . . . . . . . . . . 89<br />

7.5. Cluster Benennung <strong>und</strong> Matrizen . . . . . . . . . . . . . . . . . . 90

v Inhaltsverzeichnis<br />

8. Verwendung des Programms 93<br />

8.1. Installation . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 93<br />

8.2. Benutzeroberfläche . . . . . . . . . . . . . . . . . . . . . . . . . . 94<br />

8.3. Konfiguration . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 96<br />

IV. Abschluss 99<br />

9. Ergebnisse <strong>und</strong> Fazit 101<br />

9.1. Technische Perspektive . . . . . . . . . . . . . . . . . . . . . . . . 101<br />

9.1.1. Testdaten . . . . . . . . . . . . . . . . . . . . . . . . . . . 101<br />

9.1.2. Laufzeit . . . . . . . . . . . . . . . . . . . . . . . . . . . . 101<br />

9.1.3. Qualität . . . . . . . . . . . . . . . . . . . . . . . . . . . . 102<br />

9.1.4. Ausblick . . . . . . . . . . . . . . . . . . . . . . . . . . . . 104<br />

9.2. Fachliche Perspektive . . . . . . . . . . . . . . . . . . . . . . . . . 106<br />

9.2.1. Potentiale . . . . . . . . . . . . . . . . . . . . . . . . . . . 106<br />

9.2.2. Ausblick . . . . . . . . . . . . . . . . . . . . . . . . . . . . 107<br />

9.3. Fazit . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 110<br />

Glossar 111<br />

Literaturverzeichnis 115

Inhaltsverzeichnis vi

Tabellenverzeichnis<br />

4.1. Dataobject . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 40<br />

4.2. Dataobject (Fortsetzung) . . . . . . . . . . . . . . . . . . . . . . 41<br />

9.1. Laufzeit bei 521 Dokumenten . . . . . . . . . . . . . . . . . . . . 102<br />

9.2. Laufzeit bei 1684 Dokumenten . . . . . . . . . . . . . . . . . . . 102

Tabellenverzeichnis viii

Abbildungsverzeichnis<br />

1.1. Das Prototypen-Modell . . . . . . . . . . . . . . . . . . . . . . . 5<br />

2.1. ISL-Strategie-Komponenten . . . . . . . . . . . . . . . . . . . . . 10<br />

3.1. Vergleichstabelle . . . . . . . . . . . . . . . . . . . . . . . . . . . 18<br />

3.2. Beispiel einer MarineNet Suchmaske . . . . . . . . . . . . . . . . 24<br />

3.3. Inhalt von Drewry, angeboten von MarineNet . . . . . . . . . . . 25<br />

3.4. Erweiterte Suche im ACM Portal . . . . . . . . . . . . . . . . . . 28<br />

4.1. System-Komponenten . . . . . . . . . . . . . . . . . . . . . . . . 36<br />

4.2. Erfassungsprozess . . . . . . . . . . . . . . . . . . . . . . . . . . . 38<br />

4.3. Rechercheprozess . . . . . . . . . . . . . . . . . . . . . . . . . . . 39<br />

4.4. Screenshot der Suchmaske . . . . . . . . . . . . . . . . . . . . . . 41<br />

4.5. Recherche-Formular . . . . . . . . . . . . . . . . . . . . . . . . . 44<br />

4.6. Verweis auf ähnliche Dokumente . . . . . . . . . . . . . . . . . . 45<br />

4.7. Clustering Prozess . . . . . . . . . . . . . . . . . . . . . . . . . . 46<br />

4.8. Datenstruktur . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 48<br />

4.9. System-Komponenten . . . . . . . . . . . . . . . . . . . . . . . . 48<br />

5.1. Tabellarische Darstellung aus [VR79] . . . . . . . . . . . . . . . 54<br />

5.2. KDD Prozess von Fayyad et al. . . . . . . . . . . . . . . . . . . . 55<br />

6.1. Datenobjekte, relationale Sicht . . . . . . . . . . . . . . . . . . . 72<br />

6.2. Datenobjekte, objektorientierte Sicht, Teil 1 . . . . . . . . . . . . 73<br />

6.3. Datenobjekte, objektorientierte Sicht, Teil 2 . . . . . . . . . . . . 74<br />

6.4. DAO Struktur, Teil 1 . . . . . . . . . . . . . . . . . . . . . . . . . 76<br />

6.5. DAO Struktur, Teil 2 . . . . . . . . . . . . . . . . . . . . . . . . . 77<br />

6.6. DAO Struktur, Teil 3 . . . . . . . . . . . . . . . . . . . . . . . . . 78<br />

6.7. Data Access Commands, Teil 1 . . . . . . . . . . . . . . . . . . . 79<br />

6.8. Data Access Commands, Teil 2 . . . . . . . . . . . . . . . . . . . 80<br />

6.9. Beispiel: BatchAssign Command . . . . . . . . . . . . . . . . . . 81

Abbildungsverzeichnis x<br />

7.1. Wort Häufigkeiten . . . . . . . . . . . . . . . . . . . . . . . . . . 84<br />

7.2. Ablauf Text Analyse . . . . . . . . . . . . . . . . . . . . . . . . . 85<br />

7.3. Ablauf Matrix Berechnung . . . . . . . . . . . . . . . . . . . . . . 87<br />

7.4. Ablauf Cluster Analyse . . . . . . . . . . . . . . . . . . . . . . . 89<br />

7.5. Klassendiagramm Cluster Algorithmen . . . . . . . . . . . . . . . 91<br />

7.6. Klassendiagramm für Matrizen <strong>und</strong> SVD Ergebnisse . . . . . . . 92<br />

8.1. Bildschirmfoto des Cluster Browsers . . . . . . . . . . . . . . . . 94<br />

8.2. Bildschirmfoto des Menüs . . . . . . . . . . . . . . . . . . . . . . 95<br />

8.3. Ausschnitt der Komponentenkonfiguration . . . . . . . . . . . . . 96

Teil I.<br />

Einleitung

1. Überblick über Inhalt <strong>und</strong> Prozesse<br />

1.1. Einleitung<br />

Diese Diplomarbeit entsteht in Zusammenarbeit mit dem Institut für Seever-<br />

kehrswirtschaft <strong>und</strong> Logistik (ISL) im Rahmen der neuen sich dort entwickeln-<br />

den Online-Strategien. Aus den Gesprächen, die mit dem ISL geführt wurden,<br />

kristallisierte sich heraus, dass sich das ISL unter anderem als Anbieter für<br />

spezialisierte Informationen sehen <strong>und</strong> auf dieser Basis neuartige Dienstleistun-<br />

gen generieren möchte. Das derzeitig existierende Angebot umfasst die Litera-<br />

turdatenbank Seabase, dabei soll es jedoch k<strong>eines</strong>falls bleiben. Es ist geplant,<br />

zusätzlich zu den Literaturhinweisen aus dem F<strong>und</strong>us des ISL weitere Quellen<br />

zu erfassen <strong>und</strong> verstärkt Online-Resourcen oder gar Informationen von Part-<br />

nerunternehmen einzubeziehen. Zudem ergibt die ausschließliche Ausrichtung<br />

des ISL auf Literaturhinweise aus den Bereichen Seewirtschaft <strong>und</strong> Logistik ein<br />

vergleichsweise konzentriertes System aus Schlagworten <strong>und</strong> zugehörigen Lite-<br />

raturhinweisen, so dass deren Unterschiede subtil sind. Die Schwierigkeit für die<br />

Nutzer besteht darin, die richtigen Schlagworte oder Deskriptoren auszuwählen,<br />

damit die Ergebnisse wirklich für das Suchziel relevant sind. Bei größerem Um-<br />

fang der angebotenen Information wächst die Anforderung an die Methodik der<br />

Recherche, auch bei großen Datenmengen hilfreiche Ergebnisse zu ermöglichen.<br />

Aus diesem Gr<strong>und</strong> entschied man sich dafür, den Kontext der Arbeit bei der Re-<br />

cherchemethodik anzusiedeln. Die Arbeit zielt nun darauf ab, einen innovativen<br />

Recherche-Mechanismus zu entwickeln. Mehr zum ISL findet sich in Abschnitt<br />

2.1 (Seite 9).<br />

Die Arbeit beginnt zunächst mit einer generellen Betrachtung der Umgebung,<br />

in der sich das Informationssystem des ISL befindet. Dazu wurden Angebote<br />

anderer Firmen kurz betrachtet <strong>und</strong> beschrieben, um zeigen zu können, wie sich<br />

das Angebot des ISL (in Bezug auf die Suchmethodik) im Vergleich darstellt.<br />

Dies geschieht in Kapitel 3 (Seite 15).<br />

In Kapitel 6 (Seite 71) wird die Architektur der technischen Realisierung

1.2. DER PROZESS 4<br />

beschrieben <strong>und</strong> Kapitel 9 (Seite 101) erläutert die erzielten Ergebnisse <strong>und</strong><br />

gibt einen Ausblick auf weitere Möglichkeiten.<br />

Sofern in den Formulierungen dieser Arbeit der Nutzer oder beispielsweise<br />

der Suchende angesprochen wird, so sei hiermit versichert, dass natürlich auch<br />

weibliche Suchende <strong>und</strong> Nutzer, sprich Nutzerinnen, mit eingeschlossen sind.<br />

1.2. Der Prozess<br />

Im Rahmen dieser Arbeit wird ermittelt, wie ein Clustering Verfahren eingesetzt<br />

werden kann, um Rechercheergebnisse zu optimieren. Dabei wird eine mögliche<br />

Lösung vorgeschlagen, <strong>und</strong> für diese ein Prototyp (vgl. Seite 116 in [Bal98])<br />

entworfen <strong>und</strong> dargestellt. Der Prototyp soll die Funktionsfähigkeit des Algo-<br />

rithmus an einem Beispiel mit echten Daten des ISL demonstrieren. Der Ablauf<br />

der Arbeit orientiert sich wegen der Forschungsnatur am Prototypen-Prozess-<br />

Modell (vgl. Seiten 114ff in [Bal98]).<br />

Das Modell wird laut Quelle unter anderem dann verwendet, wenn sich die<br />

Realisierbarkeit nicht vorab garantieren lässt. Das Modell erlaube es zudem, den<br />

Auftraggeber von der prinzipiellen Durchführbarkeit der Idee zu überzeugen.<br />

Beides sind im Kontext dieser Arbeit zutreffende <strong>und</strong> überzeugende Argumente.<br />

Abbildung 1.1 gibt die Darstellung der Quelle wieder. Der hellblaue Bereich<br />

kennzeichnet die Aspekte, die das Prototypen-Modell anderen Modellen hin-<br />

zufügt. ” Die Gesamtgrafik zeigt eine Ergänzung der traditionellen Modelle um<br />

Prototypen.“ (vgl. Seite 118 in [Bal98]) Die vier Kernprozesse finden sich in den<br />

traditionellen Modellen ebenso wieder, werden aber jeweils durch Prototypen-<br />

Aspekte erweitert <strong>und</strong> sind deshalb nur zum Teil in den blauen Bereich gezeich-<br />

net.<br />

Die Quelle merkt an, eine Voraussetzung für ein erfolgreiches Umsetzen des<br />

Modells sei die aktive Beteiligung der Endbenutzer am Prototyping-Prozess,<br />

erwähnt aber ebenso, dass die Vorgehensweise letztlich von der untersuchten<br />

Fragestellung abhängt. Im Rahmen dieser Diplomarbeit wurde sicherlich we-<br />

niger Kontakt zu den Nutzern gepflegt, als dies die Erdenker des Modells im<br />

Kopf hatten. Aber schließlich handelt es sich hierbei um eine Diplomarbeit <strong>und</strong><br />

um kein (wirtschaftlich motiviertes) Softwareprojekt. Das zu erreichende Ziel<br />

ist viel eher die Darstellung der generellen Anwendbarkeit in dem konkreten<br />

Umfeld des ISL.<br />

Diese Arbeit vollzieht also keinen vollständigen Entwicklungsprozess, an des-

5 1.3. ENTWICKLUNGSUMGEBUNG<br />

K<strong>und</strong>e<br />

Aquirieren<br />

Demo Prototyp<br />

Planen<br />

Prototypen-Modell<br />

Prototyp Labormuster Pilotsystem<br />

Definieren Entwerfen Implementieren<br />

Durchführbarkeitsstudie Produktmodell Produktarchitektur Produkt<br />

Änderungen<br />

Benutzer<br />

Erweiterungen<br />

Änderungen<br />

Abbildung 1.1.: Das Prototypen-Modell<br />

sen Ende ein einsatzfähiges Produkt steht, denn dies würde den Rahmen der<br />

Diplomarbeit sprengen. Der Autor hat sich stattdessen auf die ersten Schritte<br />

beschränkt. Es wird geplant, definiert <strong>und</strong> entworfen, jedoch nicht implemen-<br />

tiert. Dementsprechend beschränkt sich die <strong>Implementierung</strong>sleistung auf die<br />

erstellten Prototypen <strong>und</strong> Labormuster. Es gibt einen Demo-Prototypen, der<br />

in Abschnitt 4.2 (Seite 43) dargestellt wird <strong>und</strong> einen (vertikalen) Prototypen,<br />

der in Kapitel 6 (Seite 71) beschrieben wird.<br />

1.3. Entwicklungsumgebung<br />

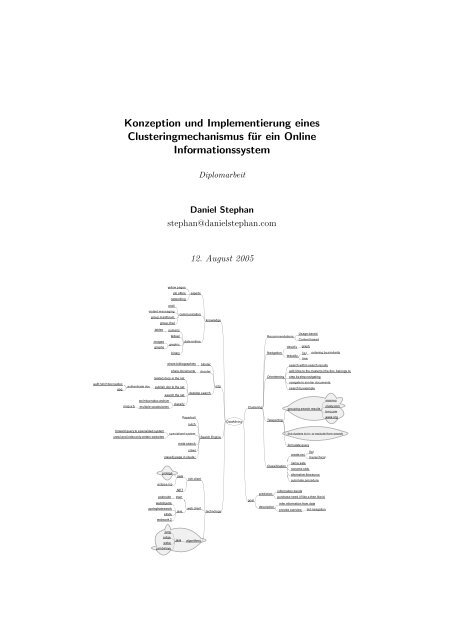

Diese Arbeit entsteht mithilfe von spezialisierten Werkzeugen, die jeweils ihre<br />

Aufgabe im Gesamtprozess haben. Beispielsweise werden, um die Gedanken zu<br />

strukturieren <strong>und</strong> zielgerichteter vorzugehen, einige Mindmaps entworfen. Eine

1.3. ENTWICKLUNGSUMGEBUNG 6<br />

Mindmap fixiert ziellos umherirrende Gedanken <strong>und</strong> ermöglicht oder erleich-<br />

tert es, nützliche Ideen von solchen zu trennen, die das Thema nicht treffen.<br />

Die hierfür verwendete Software heißt FreeMind <strong>und</strong> ist unter der URL free-<br />

mind.sourceforge.net 1 herunterzuladen. Ein Exemplar einer solchen Map ist auf<br />

der Titelseite zu sehen.<br />

Während der Ermittlung der Anforderungen des ISL wird das generische<br />

Werkzeug Protégé verwendet. Dieses erlaubt, eine beliebige Datenstruktur zu<br />

definieren, <strong>und</strong> bietet automatisch passende Eingabeformulare für die verschie-<br />

denen Datenobjekte an. Das Werkzeug ist für die Entwicklung von Ontologien<br />

gedacht <strong>und</strong> spezialisiert sich somit begrifflich auf Dinge wie Klassen, Instanzen<br />

<strong>und</strong> benannte Beziehungen dazwischen. Für die Dokumentation der Anforde-<br />

rungen wird eine passende Datenstruktur mit Protégé definiert. Diese beinhaltet<br />

Klassen wie Requirement oder Person <strong>und</strong> vervollständigt diese mit Beziehun-<br />

gen wie ” depends-on“ zwischen Requirements oder ” needs“ zwischen Person <strong>und</strong><br />

Requirement. Um das Ergebnis kommunizieren zu können, wird ein einfaches<br />

Export-Plugin entwickelt, welches die Daten in eine XML Datei exportiert, die<br />

daraufhin mittels XSL-T in eine für gängige Browser lesbare Form (HTML <strong>und</strong><br />

PDF) umgewandelt werden kann. Auf diese Weise hat der Anforderungsanalyst<br />

auf der einen Seite eine strukturierte Eingabemöglichkeit, die die Beziehungen<br />

der Anforderungen untereinander in einer logisch formell korrekten Form ablegt,<br />

<strong>und</strong> auf der anderen Seite kann er eine lesbare Form der Anforderungen auto-<br />

matisch erzeugen. Dies ist jedoch durch kommerzielle Produkte, die sich auf<br />

die Dokumentation <strong>und</strong> Verwaltung von Anforderungen spezialisieren, besser<br />

möglich. Insbesondere können diese Werkzeuge mehrere Mandanten verwalten<br />

<strong>und</strong> professionell Versionierung betreiben, was mit dieser generischen Art <strong>und</strong><br />

Weise schlecht bis gar nicht funktioniert. Protégé ist somit zwar kein perfek-<br />

tes Werkzeug für diese Aufgabe, aber es ist kostenlos <strong>und</strong> durch eigene Plug-<br />

ins erweiterbar. Herunterzuladen auf protege.stanford.edu 2 . Das Export-Plugin<br />

liegt zusammen mit dem nötigen XSL-T Stylesheet <strong>und</strong> der verwendeten Klas-<br />

senstruktur für Protégé unter dieser URL vor: www.danielstephan.com/thesis/<br />

prot-req.zip 3 .<br />

Zur Unterstützung des Softwaredesigns wird der Enterprise Architect von<br />

Sparx Systems 4 in der Version 5.0 verwendet. Um Ro<strong>und</strong>trip-Engineering durchführen<br />

1 WWW Adresse: http://freemind.sourceforge.net<br />

2 WWW Adresse: http://protege.stanford.edu<br />

3 WWW Adresse: http://www.danielstephan.com/thesis/prot-req.zip<br />

4 WWW Adresse: http://www.sparxsystems.com.au/

7 1.3. ENTWICKLUNGSUMGEBUNG<br />

zu können, muss die Software Java-Quellcode erzeugen sowie selbigen mittels<br />

Reverse Engineering wieder einlesen können. Vergleichbare Software mit dieser<br />

Funktion von Borland (Together 2005 for JBuilder, derzeit für EUR 1740) <strong>und</strong><br />

NoMagic (MagicDraw Professional, derzeit für EUR 255) erwiesen sich vergli-<br />

chen mit dem Enterprise Architect, USD 95, als zu kostspielig.<br />

Die Implementation verwendet die aktuellste Version der Sprache Java (ja-<br />

va.sun.com/j2se/1.5.0 5 ) <strong>und</strong> wird mit der leistungsfähigen Open-Source Ent-<br />

wicklungsumgebung Eclipse (www.eclipse.org 6 ) durchgeführt.<br />

Der Text der Arbeit selber wird, der innovativen Natur ihres Inhalts folgend,<br />

weder mit einer üblichen Textverarbeitung noch (direkt) mit Latex, des im wis-<br />

senschaftlichen Umfeldes üblichen Textsatzsystems, verfasst. Stattdessen wird<br />

die XML Variante des ursprünglich auf SGML basierenden Formats Docbook<br />

verwendet (siehe www.oasis-open.org/docbook 7 ). Der Gr<strong>und</strong> für diese Wahl ist<br />

in erster Linie die Neugier des Autors. Da es sich um ein XML basiertes Format<br />

handelt, wird der Text mit einem XML Editor verfasst. Es handelt sich bei dem<br />

XML Editor um , der unter www.oxygenxml.com 8 zu beziehen ist.<br />

Die Software liefert sämtliche für Docbook nötigen Stylesheets mit. Die Styles-<br />

heets sind alternativ unter docbook.sourceforge.net/projects/xsl/ 9 zu beziehen.<br />

Da der Autor im Rahmen des Schreibens festgestellt hat, dass die mit Docbook<br />

erzeugten Ergebnisse nicht ausreichend perfekt gesetzt sind, hat er nach Alter-<br />

nativen gesucht. Das Ergebnis dieser Suche kann auf www.danielstephan.com/<br />

dbp.html 10 nachgelesen werden.<br />

Somit existiert letztendlich der Text in Form von XML im Docbook For-<br />

mat, der Satz jedoch wird von LATeX durchgeführt. Dank DBP existiert ein<br />

funktionierender Prozess von XML über LATeX zu PDF.<br />

5 WWW Adresse: http://java.sun.com/j2se/1.5.0/<br />

6 WWW Adresse: http://www.eclipse.org/eclipse/<br />

7 WWW Adresse: http://www.oasis-open.org/committees/tc home.php?wg abbrev=<br />

docbook<br />

8 WWW Adresse: http://www.oxygenxml.com<br />

9 WWW Adresse: http://docbook.sourceforge.net/projects/xsl/<br />

10 WWW Adresse: http://www.danielstephan.com/dbp.html

1.3. ENTWICKLUNGSUMGEBUNG 8

2. Business Analyse<br />

2.1. Ausgangssituation<br />

Das ISL besitzt nach eigenen Aussagen mit einem Bestand von über 80000 er-<br />

fassten Einträgen eine der größten Literatur-Datenbanken im Bereich der See-<br />

verkehrswirtschaft. Diese Daten hätten für das ISL bzw. für dessen K<strong>und</strong>en<br />

einen hohen Wert. Da Informationen per se immer mehr ausschließlich im In-<br />

ternet gesucht würden <strong>und</strong> sich immer weniger K<strong>und</strong>en persönlich in die Räume<br />

des Instituts begäben, würde das nicht genutzte Potential der Datenbank im-<br />

mer größer <strong>und</strong> der Betrieb der Datenbank infolgedessen immer teurer werden.<br />

Daher wurde schnell klar, dass der Datenbestand ins Internet gebracht werden<br />

muss, um hier der Nachfrage zu begegnen, der ” offline“ immer seltener entge-<br />

gengetreten werden kann.<br />

Belegt wurde die Einsicht durch eine Studie [ISL01], die das ISL zusammen<br />

mit Roland Berger <strong>und</strong> PriceWaterhouseCoopers im Auftrage des B<strong>und</strong>esmini-<br />

steriums für Wirtschaft <strong>und</strong> Technologie (BMWi) bis Ende 2001 durchgeführt<br />

hatte. Diese Studie belegte insbesondere den gewachsenen Stellenwert des Inter-<br />

nets in Bezug auf die Informationsbeschaffung in Unternehmen der maritimen<br />

Wirtschaft. Obwohl laut Studie nur 17,5% der Informationen aus dem Internet<br />

bezogen würden (der persönliche Kontakt erbringt nach wie vor die meisten<br />

relevanten Informationen), wäre das Internet als ein wichtiges Medium der In-<br />

formationsbeschaffung zu sehen, weil die Tendenz zur online Nutzung immanent<br />

gegeben sei. Der Gr<strong>und</strong> der noch eher geringen Nutzung könnte im mangelhaf-<br />

ten Angebot liegen. Die Studie stellt fest, dass mehr als 90% der Befragten<br />

die übermäßige Informationsflut als Belastung empfänden. Die Menge an In-<br />

formationen führe zu einem hohen Aufwand bei der Selektion der relevanten<br />

Informationen. Zudem seien die Informationen oft nicht aktuell.<br />

Diesen Erkenntnissen folgend wurde die Strategie etabliert, Inhalte des ISL im<br />

Rahmen <strong>eines</strong> Portals online anzubieten <strong>und</strong> ein Geschäftsmodell zu entwickeln,<br />

das die erkannten Herausforderungen adressiert.

2.2. ZIELE 10<br />

Business Strategie<br />

Profile<br />

Selektion<br />

Inhalte<br />

Abbildung 2.1.: ISL-Strategie-Komponenten<br />

Ein Ergebnis dieser Bemühungen ist bereits zum jetzigen Zeitpunkt erkenn-<br />

bar. Und zwar werden bereits einige Angebote online verkauft. Für diesen Zweck<br />

hat das ISL einen Online-Shop eingerichtet. Dort werden eine Handvoll re-<br />

gelmäßiger Publikationen des ISL angeboten. Diese Publikationen werden nach<br />

Aussage des ISL vom Markt nachgefragt. Es handelt sich dabei um vergleichs-<br />

weise hochwertige Publikationen. Eine Publikationen wie das Jahrbuch kostet<br />

zum Beispiel inklusive CD-ROM knapp 300 Euro. Zusätzlich gibt es das Ship-<br />

ping Statistics and Market Review, welches 9 Mal im Jahr erscheint, jeweils mit<br />

etwas unterschiedlichen Schwerpunkten. Es kostet inkl. CD-ROM 470 Euro pro<br />

Jahr 1 .<br />

2.2. Ziele<br />

Das übergeordnete strategische Ziel des ISL ist es, Informationen anzubieten<br />

<strong>und</strong> über deren Individualisierung Geld zu verdienen. Dieses Hauptziel lässt<br />

sich, wie in Abbildung 2.1 dargestellt, aus drei Komponenten aufbauen, ohne<br />

die es nicht oder schwer verwirklicht werden kann.<br />

Ein Kernpunkt <strong>und</strong> somit die erste Komponente sind die Inhalte, die ange-<br />

1 Stand: Juli 2005

11 2.3. HERAUSFORDERUNGEN<br />

boten werden sollen. Hier gilt es, eine ansprechende Auswahl sicherzustellen. In<br />

diesem Zusammenhang strebt das ISL eine Zusammenarbeit mit Partnerorgani-<br />

sationen an, deren Inhalte zusammen mit denen des ISL in einem gemeinsamen<br />

System angeboten werden sollen. Zudem wurde erkannt, dass die Nutzer die<br />

Inhalte in aller Regel unverzüglich erwarten. Sofern möglich sollen somit In-<br />

halte in digitaler Form (Volltexte, Statistiken, Tabellen) vorgehalten <strong>und</strong> vom<br />

zahlenden K<strong>und</strong>en auf Knopfdruck abgerufen werden.<br />

Das Angebot kann nur dann für die K<strong>und</strong>en interessant sein, wenn die Men-<br />

ge an hilfreichen Inhalten groß genug ist. Diese Erkenntnis liefert im Um-<br />

kehrschluss die Forderung, dass K<strong>und</strong>en die gewünschten Inhalte auf einfache<br />

Weise aus dem F<strong>und</strong>us selektieren können müssen <strong>und</strong> somit das System ent-<br />

sprechend mächtige Recherchemechanismen aufweist, die die zweite Komponen-<br />

te darstellen. Diese soll die Strukturen der Informationslandschaft offensichtlich<br />

machen <strong>und</strong> geeignete Navigationselemente bereitstellen, damit sich der K<strong>und</strong>e<br />

zurechtfindet <strong>und</strong> einfach eine Vielzahl für ihn relevante Inhalte finden kann.<br />

Um das Informationsangebot wertvoller zu gestalten, soll es individuell auf<br />

den Nutzer zugeschnitten werden, dies schließt den Kreis. Das wiederum setzt<br />

die Existenz von individuellen K<strong>und</strong>enprofilen voraus, auf deren Basis perso-<br />

nalisierte Angebote maßgeschneidert werden können. Diese Angebote beinhal-<br />

ten einen automatischen Benachrichtigungsdienst über neue Dokumente, die<br />

zum K<strong>und</strong>enprofil passen, der mittels E-Mail realisiert werden soll, sowie ei-<br />

ne Möglichkeit, fehlende Informationen (unbefriedigte Nachfrage) online zu<br />

bemängeln. Letzte Funktion soll die K<strong>und</strong>enwünsche erkennbar machen <strong>und</strong><br />

das ISL in die Lage versetzen, auf die Nachfrage besser zu reagieren.<br />

Auf diese Arbeit bezogen können natürlich nicht alle Ziele des ISL umgesetzt<br />

werden. Daher konzentriert sie sich auf die zweite Komponente <strong>und</strong> entwickelt<br />

eine innovative Recherchetechnologie.<br />

2.3. Herausforderungen<br />

Um zu verstehen, welche Herausforderungen für die Recherche in Informations-<br />

systemen wie dem des ISL existieren, sollte man zunächst wissen, wie eine solche<br />

Recherche abläuft. Was ist also Recherche? Recherche wird hier als Oberbegriff<br />

für die Suche nach Informationen verstanden. Im Kontext dieser Arbeit sind<br />

es speziell die Suchvorgänge, die mit Hilfe <strong>eines</strong> Informationssystems wie der<br />

ISL Seabase durchgeführt werden. Aber betrachten wir einmal, wie das typische

2.3. HERAUSFORDERUNGEN 12<br />

Nutzerverhalten während einer solchen Suche aussieht.<br />

Der Ablauf einer typischen Recherche beginnt, sobald ein Nutzer ein Defizit<br />

oder ein Interesse entwickelt <strong>und</strong> nach Informationen sucht, die den neu aufge-<br />

kommenen Bedarf befriedigen. Der Nutzer wird möglicherweise nicht zuerst das<br />

Internet aufsuchen, sondern stattdessen zunächst seine eigenen Bücher, sowie<br />

Dateien <strong>und</strong> Datenbanken durchforsten <strong>und</strong> eventuell noch jemanden anrufen,<br />

aber spätestens danach sucht er das Internet auf <strong>und</strong> landet hoffentlich zügig<br />

auf den Webseiten des ISL.<br />

Wie in [TAAK04] von Teevan et al. dargelegt wurde, gibt es für den Nutzer<br />

im Internet im groben zwei Methoden, ans Ziel zu gelangen. Die eine Methode<br />

besteht darin, eine möglichst exakte Suchanfrage zu formulieren, die die gesuch-<br />

ten Informationen ausreichend exakt beschreibt, so dass das System direkt das<br />

Gesuchte liefert. Diese Vorgehensweise nennt das genannte Paper Teleporting.<br />

Der Nutzer teleportiert sich im übertragenen Sinne direkt zu der gewünschten<br />

Information. Im Buch [RM02] von Rosenfeld <strong>und</strong> Morville wird es The Perfect<br />

Catch genannt <strong>und</strong> jedoch dargelegt, dass dieses sehr simple Vorgehen alleine<br />

oft nicht zum Ziel führt.<br />

Dafür gibt es mehrere Gründe, zum einen weiß der Nutzer manchmal nicht<br />

genau genug, wonach er sucht. In diesem Falle muss er seine Suche allgemeiner<br />

halten, sich erst einmal umschauen <strong>und</strong> das Angebot ” spielerisch“ erforschen.<br />

Anders ausgedrückt: der Nutzer muss sich zunächst orientieren <strong>und</strong> Teleporting<br />

ist für ihn nicht möglich.<br />

Und selbst wenn er weiß, wonach er sucht, so ist die Sprache, die er für<br />

die Suche verwendet nicht notwendigerweise die selbe, mit der die gesuchte<br />

Information erfasst wurde. Dabei ist mit Sprache noch nicht einmal Sprache<br />

im Sinne von Französich oder Deutsch, sondern eher die Wortwahl gemeint, die<br />

bei unterschiedlichen Menschen unterschiedlich ausfällt. [RM02] fragt in diesem<br />

Zusammenhang ” ’PDA’, ’Handheld’ oder ’Handheld PC’“?<br />

Alle hier betrachteten Autoren stellen jeweils auf ihre Weise fest, dass ein<br />

Nutzer die Schwierigkeiten durch ein mehrschrittiges Vorgehen zu überwinden<br />

versucht, bei dem sich Orientierung/Browsen <strong>und</strong> Direktsuche abwechseln. Tee-<br />

van et al. nennen dies Orienteering <strong>und</strong> belegen empirisch dessen bevorzugte<br />

Nutzung. [Bat89] nennt es Berrypicking, weil der Nutzer über verschlungene<br />

Pfade durch den Informationsraum wandert <strong>und</strong> auf dem Wege die Beeren<br />

pflückt, die ihn interessieren. Im Paper von Teevan et al. wird vermutet, dass<br />

diese kombinierte, aus mehreren Schritten bestehende Suche die kognitiven Pro-

13 2.3. HERAUSFORDERUNGEN<br />

zesse von Nutzern weniger fordert <strong>und</strong> deshalb bevorzugt wird. Sie haben empi-<br />

risch festgestellt, dass Nutzer bevorzugen, einigen Verweisen zu folgen <strong>und</strong> sich<br />

dadurch Schritt für Schritt dem Ziel anzunähern, anstatt eine exakte Anfrage<br />

anzugeben <strong>und</strong> direkt zum Ziel zu gelangen. Das gilt sogar, wenn der Suchende<br />

genau weiß, wo das Gesuchte liegt, <strong>und</strong> er oder sie sogar ohne weiteres in der<br />

Lage wäre, die Anfrage exakt genug zu formulieren.<br />

Ein Informationssystem sollte folglich ein mehrschrittiges, iteratives Vorge-<br />

hen erlauben oder gar besonders unterstützen. Das ISL ist dafür bereits gut<br />

aufgestellt, denn der gepflegte, ausführliche Thesaurus ist eine gute Gr<strong>und</strong>la-<br />

ge dafür, Orientierungshilfen anbieten zu können. Ein darüber hinausgehendes<br />

Clustering kann dies noch verbessern.

2.3. HERAUSFORDERUNGEN 14

3. Marktanalyse<br />

3.1. Kriterien Auswahl<br />

Es gilt nun herauszufinden, wie die Suche in online Informationssystemen in der<br />

Praxis vom Rest der Welt organisiert wird. Es sollen dadurch übliche Vorge-<br />

hensweisen demonstriert <strong>und</strong> der Ansatz dieser Arbeit in einen Kontext gesetzt<br />

werden. Dokumente, Webseiten oder Dateien in Datenbanken zu suchen ist ein<br />

ganz zentraler Faktor, der sich mit der Zunahme der Menge an Informationen,<br />

die sich in den Datenbanken dieser Welt verstecken, an zunehmender Wich-<br />

tigkeit erfreut. Daher bieten so gut wie alle Informationssysteme mehr oder<br />

weniger ausführliche Unterstützung für die Recherche in ihren Systemen an.<br />

Die Auswahl der betrachteten Informationssysteme beinhaltet eine Reihe de-<br />

rer, die bereits vom ISL als relevante Konkurrenz auf dem Markt erkannt wor-<br />

den waren. Darüberhinaus werden einige allgemein bekannte Online-Dienste<br />

betrachtet, sowie auch solche die ähnliche Ansätze in anderen Märkten verfol-<br />

gen. All diese Dienste werden hier nach einer Reihe von Kriterien ausgewertet.<br />

Die Kriterien stützen sich sowohl auf die technische Umsetzung des Angebots,<br />

als auch auf dessen Wirksamkeit in Bezug auf wirtschaftliche Faktoren. Im fol-<br />

genden sollen die Kriterien aufgelistet <strong>und</strong> erläutert werden.<br />

Community Beinhaltet das Angebot Dienste für eine virtuelle Gemeinschaft?<br />

Derartige Dienste erlauben die Wertschöpfung zwischen K<strong>und</strong>en <strong>und</strong> erhöhen<br />

somit die Wertigkeit des Angebots mit Hilfe von Netzwerkeffekten.<br />

Zielgruppe An wen richtet sich das Angebot in erster Linie?<br />

Erfassung Auf welche Weise kommen die Daten ins System? Erfasst der Anbie-<br />

ter selber oder verkauft er den Zugriff auf Datenbanken anderer Firmen?<br />

Erfassung durch K<strong>und</strong>en Können K<strong>und</strong>en eigene Dokumente in das System<br />

einpflegen?

3.1. KRITERIEN AUSWAHL 16<br />

Suche mittels boolschen Operatoren Sind Begriffe mittels UND/ODER be-<br />

liebig kombinierbar?<br />

Suche auf der Basis einer Taxonomie Sind die Dokumente mit Schlagworten<br />

versehen, die untereinander in einer oder mehreren Spezialisierungsbezie-<br />

hungen stehen (Taxonomie)?<br />

Suche ähnlicher Begriffe möglich Ist das System in der Lage, trotz Tippfehler<br />

sinnvolle Ergebnisse zu liefern?<br />

Volltextsuche Suche im Volltext des Angebots ist möglich.<br />

Clustering Der Suchmechanismus gruppiert die Suchergebnisse automatisch.<br />

Angebot ist aktuell Ist das Angebot aktuell? Monate alte Neuigkeiten weisen<br />

auf ein schlecht gepflegtes System hin <strong>und</strong> werden kaum Nutzer anziehen.<br />

Viele brandaktuelle Artikel wiederum zeugen von einem erfolgreichen An-<br />

gebot mit echtem Nutzwert .<br />

Angebot beinhaltet digitale Dokumente Sind die Dokumente online zu bezie-<br />

hen <strong>und</strong> zu lesen?<br />

Angebot beinhaltet Reports über Rohdaten Steht hinter dem Angebot eine<br />

Datenbank , deren Inhalte in Form von Tabellen <strong>und</strong> Graphen ohne text-<br />

liche Beschreibung dargeboten werden?<br />

Angebot beinhaltet kostenpflichtige Suchergebnisse Sind die Ergebnisse des<br />

verwendeten Suchmechanismus kostenpflichtig?<br />

Angebot beinhaltet kostenpflichtige Dokumente Sind einzelne Dokumente käuf-<br />

lich zu erwerben?<br />

Angebot beinhaltet kostenpflichtigen Systemzugang Ist der Zugang zum Sy-<br />

stem oder zu Teilen des Systems pauschal kostenpflichtig?<br />

Marketingplattform Es besteht eine Möglichkeit für Partner <strong>und</strong> andere Fir-<br />

men, auf der Web Site Werbung zu machen. Sei es durch Banner oder<br />

” sponsored news“.<br />

Werbefinanziert Die Angebote finanzieren sich hauptsächlich durch Werbung.<br />

Yellow Pages Das System beinhaltet Verzeichnisse von Firmen <strong>und</strong> Produkten.

17 3.2. KONKURRENTEN<br />

Die Ergebnisse sind in Abbildung 3.1 (Seite 18) nachzulesen.<br />

3.2. Konkurrenten<br />

3.2.1. FIZ-Technik e.V.<br />

FIZ Technik e.V. 1 ist ein gemeinnütziger technisch-wissenschaftlicher<br />

Verein. Mitglieder sind: VDMA e.V. (Verband Deutscher Maschinen-<br />

<strong>und</strong> Anlagenbau), VTDI e.V. (Textil) <strong>und</strong> FWD e.V. (Werkstoffe)<br />

sowie die Industrieunternehmen <strong>und</strong> Forschungseinrichtungen: Ro-<br />

bert Bosch GmbH, Stuttgart, DaimlerChrysler AG, Stuttgart, Sie-<br />

mens AG, München, MAN B&W Diesel AG, Augsburg <strong>und</strong> Fraunhofer-<br />

Gesellschaft, München.<br />

Das Fachinformationszentrum Technik erstellt bibliographische Datenbanken<br />

<strong>und</strong> bietet diese in elektronischer Form an. Dazu werden jährlich ca. 120000 Do-<br />

kumente aus Fachzeitschriften, Tagungsbänden, Forschungsberichten <strong>und</strong> Dis-<br />

sertationen ausgewertet <strong>und</strong> gespeichert. Über 300 Mitarbeiter sind mit dieser<br />

Aufgabe betreut. Auch hier wird, ebenso wie beim ISL, jedes ausgewertete<br />

Dokument mit einem Kurzreferat versehen, in Kategorien einsortiert <strong>und</strong> ver-<br />

schlagwortet. Der dazugehörige Thesaurus umfasst jeweils etwa 50000 deutsche<br />

<strong>und</strong> englische Begriffe.<br />

Die Recherche in den Datenbanken ist prinzipiell kostenpflichtig. Dabei un-<br />

terscheidet die Preisliste 2 zwischen dem normalen Zugriff über die Online-Suche<br />

sowie einem speziellen Pauschaltarif für größere Organisationen, die die Recher-<br />

che aus dem eigenen Intranet heraus erlauben möchten. Der Preis für den nor-<br />

malen Zugriff setzt sich aus der Login-Gebühr von e5,40, die entsprechend bei<br />

jedem Login-Vorgang anfällt, einer sog. Anschaltzeit, die auf eine nicht näher<br />

spezifizierte Art <strong>und</strong> Weise aus dem Suchaufwand der Datenbank errechnet<br />

wird (durchschnittlicher Preis ca. e100 pro St<strong>und</strong>e), sowie einer Dokumentaus-<br />

gabegebühr , die je nach Datenbank <strong>und</strong> Format zwischen e1,50 <strong>und</strong> e2,50<br />

schwankt <strong>und</strong> pro angezeigter Bibliographie abgerechnet wird, zusammen. Die<br />

Anschaltzeiten <strong>und</strong> Dokumentausgabegebühren schwanken je nach abgefragter<br />

Datenbank, ebenso wie die Pauschalpreise. Diese schwanken für Großunterneh-<br />

men von e3885,- bis e65200,- pro Datenbank pro Jahr. KMUs <strong>und</strong> Fachhoch-<br />

1 WWW Adresse: http://www.fiz-technik.de<br />

2 WWW Adresse: http://www.fiz-technik.de/download/preise.pdf

3.2. KONKURRENTEN 18<br />

T : Techniker / Ingenieure<br />

W : Wissenschaftler<br />

M : Manager<br />

Community<br />

☑ ☑<br />

Zielgruppe TW MTW MTW WM TMW TMW M TMW TW<br />

Erfassung durch Anbieter ☑ ☑ ☑ ☑ ☑ ☑ ☑<br />

Erfassung durch K<strong>und</strong>en ☑ ☑ ☑<br />

Suche mittels booleschen Operatoren ☑ ☑ ☑ ☑ ☑ ☑<br />

Suche syntaktisch ähnlicher Begriffe möglich ☑ ☑ ☑ ☑ ☑<br />

Volltextsuche ☑ ☑ ☑ ☑ ☑ ☑ ☑<br />

Clusteranalyse ☑<br />

Suche auf der Basis einer Taxonomie ☑ ☑<br />

Angebot ist relativ aktuell ☑ ☑ ☑ ☑ ☑ ☑ ☑/- ☑ ☑<br />

Angebot beinhaltet digitale Dokumente ☑ ☑ ☑ ☑ ☑ ☑<br />

Angebot beinhaltet Reports über Rohdaten ☑<br />

Angebot beinhaltet kostenpflichtige Suchergebnisse ☑<br />

Angebot beinhaltet kostenpflichtige Dokumente ☑ ☑ ☑ ☑<br />

Angebot beinhaltet kostenpflichtigen Systemzugang ☑ ☑ ☑<br />

Marketingplattform ☑ ☑ ☑ ☑<br />

Werbe finanziert ☑ ☑<br />

Yellow Pages<br />

☑ ☑ ☑ ☑ ☑ ☑<br />

Abbildung 3.1.: Vergleichstabelle<br />

www.fiz-technik.de<br />

www.hwwa.de<br />

www.dmkn.de<br />

www.netacademy.org<br />

www.springerlink.com<br />

www.marinetalk.com<br />

www.marine-net.com<br />

www.clusty.com<br />

portal.acm.org<br />

Marktvergleich

19 3.2. KONKURRENTEN<br />

schulen zahlen zwischen e788,- <strong>und</strong> e13020,-. Es gibt 10 FIZ-Technik-eigene<br />

Datenbanken <strong>und</strong> 16/17 fremde Datenbanken, die FIZ-Technik lizensiert <strong>und</strong><br />

integriert hat. Der Autor stellt fest, dass das Preissystem auf ihn durch die<br />

vielen Einzelposten abschreckend wirkt. Hier wäre eine Mischkalkulation mit<br />

weniger einzelnen Posten eventuell eher anzuraten.<br />

FIZ Technik nutzt Volltextsuche <strong>und</strong> erlaubt die Verknüpfung mittels bool-<br />

schen Operatoren. Zusammen mit dem aufwendigen Thesaurus ist die Methodik<br />

recht fortschrittlich, wenn auch kompliziert. Es wird kein Clustering durch-<br />

geführt.<br />

3.2.2. FIZ Karlsruhe / STN Online Services<br />

Das FIZ Karlsruhe ist eine 1977 gegründete gemeinnützige Gesellschaft mit<br />

dem Auftrag, Fachinformationen bereitzustellen. Dieses tut sie insbesondere<br />

dadurch, dass sie im Rahmen des STN Online Service in Kooperation mit der<br />

American Chemical Society (ACS) <strong>und</strong> der Japan Science and Technology Cor-<br />

poration (JST) weltweit existierende Datenbanken in ihr System integriert. Fer-<br />

ner werden auch eigene Datenbanken erstellt <strong>und</strong> gepflegt. Unter anderem zählt<br />

hierzu die Zeitschriftendatenbank der Thieme Verlagsgruppe 3 sowie das System<br />

von vascoda 4 . Die Preise 5 sind nicht sehr weit von denen von FIZ-Technik ent-<br />

fernt <strong>und</strong> sind eher etwas höher. Die Anschaltzeit ist auch hier zu finden <strong>und</strong><br />

scheint ein branchenübliches Phänomen darzustellen. Auffällig ist im Vergleich<br />

zu FIZ-Technik, dass die Gebühr für die Anzeige bzw. den Druck (Dokument-<br />

ausgabegebühr ) drei mal so hoch ist <strong>und</strong> je nach Datenbank auch Preise von<br />

über e20,- für diesen Posten zu sehen sind.<br />

Der Fokus liegt hier eher in der Integration von Datenbanken (im Rahmen<br />

von STN) sowie im Auftritt als IT Dienstleister. Dadurch ist die Anzahl der<br />

Datenbanken wesentlich höher als bei FIZ Technik, deren Hauptarbeit in der<br />

Erfassung <strong>und</strong> Pflege der eigenenen Datenbanken zu stecken scheint. Die genaue<br />

Anzahl der Datenbanken geht aus der oben genannten Preisliste, in der jede<br />

Datenbank einzeln aufgelistet ist, hervor.<br />

3 WWW Adresse: http://www.thieme-connect.de<br />

4 WWW Adresse: http://www.vascoda.de<br />

5 WWW Adresse: http://www.stn-international.de/service/prices/EUROde.pdf

3.2. KONKURRENTEN 20<br />

3.2.3. Deutsches Maritimes Kompetenz Netz (DMKN)<br />

Das DMKN hat den Anspruch, Wissen im maritimen Umfeld zu sammeln <strong>und</strong><br />

verfügbar zu machen. Ins Leben gerufen hat es das Deutsche Marine Insti-<br />

tut, die Marine-Offizier-Vereinigung (MOV) e.V. <strong>und</strong> die Marine-Offizier-Hilfe<br />

(MOH) e.V. gemeinsam mit Kooperationspartnern. Auf der Website kann man<br />

nach Artikeln, Studien, Berichten <strong>und</strong> ähnlichen Dokumenten recherchieren <strong>und</strong><br />

bekommt die Dokumente auch gleich in elektronischer Form auf den Schirm<br />

geliefert. Zudem kann man sich im ExpertNet ein Bild von den Experten aus<br />

Wirtschaft <strong>und</strong> Wissenschaft im Bereich der maritimen Wirtschaft <strong>und</strong> Technik<br />

machen. Als <strong>eines</strong> der wenigen maritimen Angebote im Internet beinhaltet das<br />

DMKN auch ein Forum , in dem sich Interessierte untereinander austauschen<br />

können.<br />

Interessant ist, dass das öffentliche Forum von den Nutzern dieses Systems<br />

fast völlig ignoriert wird. Obwohl offenbar die Artikel <strong>und</strong> sonstigen informa-<br />

tiven Beiträge regelmäßig aktualisiert werden <strong>und</strong> somit von einem lebendigen<br />

System zeugen, gibt es keinerlei Interesse am persönlichen Austausch. Die mei-<br />

sten im System verzeichneten Experten sind offenbar damit zufrieden, aufge-<br />

listet worden zu sein <strong>und</strong> haben keine eigenen Beiträge ins System gebracht.<br />

Die absolute Mehrheit der Beiträge stammt aus der Zeitschrift MarineForum,<br />

die von den Betreibern des DMKN herausgegeben wird. Diese Erkenntnis re-<br />

lativiert den zuerst entstandenen Eindruck <strong>eines</strong> lebendigen Systems. Offenbar<br />

ist der größte <strong>und</strong> beinahe einzige Anbieter von Informationen im DMKN der<br />

Betreiber des DMKNs selber.<br />

Seit Ende 2004 beteiligt sich das ISL am DMKN <strong>und</strong> bietet im Rahmen <strong>eines</strong><br />

Kompetenzzentrums für die Seeverkehrswirtschaft eigene Inhalte an.<br />

Die Recherchemöglichkeiten des DMKN erlauben Anfragen mit boolschen<br />

Operatoren (AND/OR). Zusätzlich erlaubt das System die Suche mittels Wort<br />

Varianten, sowie mittels einer syntaktischen Ähnlichkeit (dort Fuzzy Suche ge-<br />

nannt).<br />

3.2.4. HWWA - Hamburgisches Welt-Wirtschafts-Archiv<br />

Das Hamburgische Welt-Wirtschafts-Archiv ist eine wissenschaftliche Service-<br />

einrichtung, dessen Ziel es ist, Informationen zu sammeln, aufzubereiten, zu<br />

bewerten <strong>und</strong> verfügbar zu machen. Es analysiert weltwirtschaftliche Fragestel-

21 3.2. KONKURRENTEN<br />

lungen, informiert <strong>und</strong> berät. Aktueller Hinweis 6 : Das HWWA ist aktuell als<br />

Auslaufmodell zu betrachten. Es gehörte lange Zeit zur Leibniz Gemeinschaft<br />

<strong>und</strong> wurde damit öffentlich gefördert. Nach einigen sehr kritischen Evaluierun-<br />

gen hat sich die Gemeinschaft jedoch dazu entschlossen, das Institut nicht weiter<br />

zu fördern. Teile des HWWA werden zukünftig im neugegründeten Wirtschafts-<br />

institut HWWI aufgehen <strong>und</strong> bleiben daher mindestens zum Teil erhalten.<br />

Alle Dienstleistungen des HWWA zu beleuchten, würde zu weit führen. Im<br />

Kontext dieser Arbeit ist allerdings der Bereich der Kataloge <strong>und</strong> der Online-<br />

Publikationen interessant. Das HWWA bietet keine Community Features an.<br />

Der online Zugriff wird über die URL http://webopac.hwwa.de/seitevor.htm 7<br />

ermöglicht.<br />

Kataloge<br />

Das HWWA bietet online Nachweise von Büchern, Periodika, <strong>und</strong> Aufsätzen<br />

aus Zeitschriften <strong>und</strong> Sammelwerken in gedruckter oder elektronischer Form,<br />

Firmen <strong>und</strong> Körperschaften mit weiterführenden Links an. Ausserdem Presse-<br />

artikel, Geschäftsberichte, Spezialsammlungen etc.<br />

Für diesen Zweck existiert ein ausgefeilter Suchmechanismus, der auf ei-<br />

nem komplexen Thesaurus basiert. Alle wichtigen Suchfunktionen (Ähnlichkeit,<br />

boolsche Operationen, Volltext. . . ) sind vorhanden.<br />

Online Publikationen<br />

Das Angebot umfasst im Zusammenhang mit dem elektronischen Dokumen-<br />

tenarchiv des HWWA sowohl Nachweise nicht-elektronischer Dokumente als<br />

auch solche von elektronischen Dokumenten. Letztere sind im Archiv teilweise<br />

im Volltext verfügbar. Dabei unterscheidet der Katalog zwischen frei verfügba-<br />

ren, HWWA-intern verfügbaren, sowie kostenpflichtig verfügbaren Dokumen-<br />

ten. Falls möglich verweist der Katalog auf den Anbieter des Dokumentes, bei<br />

dem es dann bezogen werden kann. Verfügbare Volltexte liegen im PDF-Format<br />

auf HWWA-Servern oder beim Anbieter selber. Im letzteren Fall verweist der<br />

Katalog auf den Anbieter.<br />

Neben den Angeboten, die über den Katalog zu erreichen sind, bietet das<br />

HWWA spezielle Informationsdienste an. Häufig sind die Produkte online im<br />

6 Pressemitteilung: http://idw-online.de/pages/de/news117649<br />

7 WWW Adresse: http://webopac.hwwa.de/seitevor.htm

3.2. KONKURRENTEN 22<br />

PDF oder HTML Format verfügbar - teilweise kostenfrei <strong>und</strong> teilweise kosten-<br />

pflichtig.<br />

3.2.5. MarineTalk<br />

MarineTalk versteht sich als Informationsanbieter im maritimen Sektor. Das<br />

Angebot umfasst Informationen über spezielle Produkte <strong>und</strong> darüber, wer sie<br />

herstellt. Zudem werden ca. alle sechs Wochen aktuelle Entwicklungen im ma-<br />

ritimen Sektor sowohl über neue Produkte als auch über allgemeine Themen in<br />

den News-Bereich eingepflegt.<br />

Das Angebot beinhaltet im Rahmen der Wer-Macht-Was-Suche (Buyers Gui-<br />

de) Kurzvorstellungen der Unternehmen, die als Werbe-Möglichkeit für die ver-<br />

zeichneten Unternehmen beworben werden. Den Unternehmen werden verschie-<br />

dene Werbe-Pakete angeboten, von denen <strong>eines</strong> gratis, <strong>eines</strong> 10 USD im Monat<br />

<strong>und</strong> <strong>eines</strong> 20 USD im Monat kostet. Im letzten Falle wird eine bis zu 6 Seiten<br />

umfassende Firmendarstellung angeboten, während in der Gratisversion weder<br />

Email noch Homepage des verzeichneten Unternehmens angegeben werden kann<br />

<strong>und</strong> sich ausschließlich auf Adresse <strong>und</strong> Telefon beschränkt wird. Das mittlere<br />

Angebot bietet die Möglichkeit, Verweise auf die Firmen Homepage sowie eine<br />

Email Adresse hinzuzufügen <strong>und</strong> erlaubt zusätzlich, eine textliche Kurzbeschrei-<br />

bung der Firma mit in das Listing aufzunehmen. Diese Beschreibung ist auch<br />

für die Suche effektiv. Wie viele K<strong>und</strong>en welches Angebot nutzen fällt laut Ma-<br />

rineTalk allerdings unter das Geschäftsgeheimnis, so dass auf diese Information<br />

verzichtet werden muss.<br />

Die Suchfunktion umfasst eine Schlagwortsuche, sowie spezifische Eingren-<br />

zungen. Beispielsweise ist es möglich, die Suche nach Anbietern auf ein Land<br />

oder auch einen bestimmten Hafen zu beschränken. Firmen, die sich in das Ver-<br />

zeichnis eintragen lassen möchten, haben die Möglichkeit, bis zu 50 Stichworte<br />

anzugeben, unter denen sie gef<strong>und</strong>en werden können. Die Stichworte sind aller-<br />

dings beliebig <strong>und</strong> unterliegen keiner festen Struktur, wie es in einem Thesaurus<br />

der Fall wäre.<br />

Das MarineNet bearbeitet jede Einsendung manuell <strong>und</strong> prüft insbesonde-<br />

re die gewünschten Schlagwörter auf Duplikate. Je nach Qualität der einge-<br />

sendeten Artikel/News wird der Beitrag entweder editiert oder auf der Basis<br />

der eingesendeten Information neu geschrieben. Dieses Vorgehen garantiert ein<br />

gleichbleibend hohes Qualitätsniveau der Beiträge.

23 3.3. WISSENSCHAFTLICHE ANGEBOTE<br />

3.2.6. MarineNet<br />

Das MarineNet ist eine japanische Unternehmung, die Informationen <strong>und</strong> Dienst-<br />

leistungen für die maritime Wirtschaft anbietet. Der Fokus des Angebots liegt<br />

dabei auf dem Zusammenbringen von Käufer <strong>und</strong> Verkäufer maritimer Produk-<br />

te <strong>und</strong> Dienstleistungen. Dem entsprechend bietet das Unternehmen Schiffs-<br />

Auktionen , Preisinformationen von Gebraucht-Schiffen sowie die Möglichkeit,<br />

online nach Chartering-Informationen zu suchen <strong>und</strong> somit die Frage zu beant-<br />

worten, ob im Hafen X ein geeignetes Schiff liegt, welches gechartert werden<br />

kann. Im letzteren Falle vermittelt MarineNet kostenfrei zwischen dem Suchen-<br />

den <strong>und</strong> dem Schiffs-Eigner bzw. stellt mindestens den Kontakt her.<br />

Die meisten Funktionalitäten sind nur für Mitglieder des Systems (kosten-<br />

pflichtig) zu erreichen. Es gab in keinem gratis zu erreichenden Teil des Online-<br />

Angebots eine Suche.<br />

Es gibt jedoch in den verschiedenen nach Bezahlung zu erreichenden Berei-<br />

chen jeweils spezielle, auf das jeweilige Angebot zugeschnittene Suchmethoden.<br />

Dezu gehören allerdings keine Schlagwort-Suche oder gar hinterlegte Thesauri<br />

. Die Leistungen umfassen meistens Listen, beispielsweise von zu verkaufenden<br />

Frachtern oder in der letzten Zeit durchgeführten Besitzänderungen etc.<br />

Von Interesse dürfte allerdings sein, dass das MarineNet ausgewählte Sta-<br />

tistiken aus dem F<strong>und</strong>us der Beratungsfirma Drewry 8 in das eigene Angebot<br />

integriert. Die Bedingungen des Nutzungsvertrages zwischen MarineNet <strong>und</strong><br />

Drewry fallen sicherlich unter das Geschäftsgeheimnis, so dass hier auch nicht<br />

weiter geforscht wurde.<br />

Dazu ist zu bemerken, dass vereinzelt veraltete Inhalte (Statistik überarbeitet<br />

2002. . . ) im System zu finden sind.<br />

3.3. Wissenschaftliche Angebote<br />

3.3.1. Netacademy, a scientific community<br />

Die Netacademy ist ein System für wissenschaftliche Gemeinschaften, das vom<br />

MCM, Institut für Medien <strong>und</strong> Kommunikationsmanagement 9 ins Leben geru-<br />

fen wurde <strong>und</strong> die von den Teilnehmern für die Publikation von Forschungser-<br />

gebnissen <strong>und</strong> News genutzt wird. Auf diese Weise soll ein zentrales Repository<br />

8 WWW Adresse: http://www.drewry.co.uk<br />

9 WWW Adresse: http://www.mcm.unisg.ch/

3.3. WISSENSCHAFTLICHE ANGEBOTE 24<br />

Abbildung 3.2.: Beispiel einer MarineNet Suchmaske

25 3.3. WISSENSCHAFTLICHE ANGEBOTE<br />

Abbildung 3.3.: Inhalt von Drewry, angeboten von MarineNet

3.3. WISSENSCHAFTLICHE ANGEBOTE 26<br />

entstehen, wodurch es Nachfragern erleichtert wird, die Dokumente zu finden.<br />

Wissenschaftler bieten ihre Ergebnisse zwar häufig online an, tun dies aber in<br />

der Regel über ihre Homepage . Wenn man nun die Menge der wissenschaftlich<br />

tätigen Personen zugr<strong>und</strong>e legt <strong>und</strong> daraus die Zahl der Homepages ableitet,<br />

wird man sicherlich eine stolze Menge an Orten im Internet ermitteln, an denen<br />

wissenschaftliche Dokumente abgelegt sein könnten. Die Netacademy konsoli-<br />

diert nun zumindest schon mal die Ergebnisse der teilnehmenden Wissenschaft-<br />

ler, sofern diese Ihre Dokumente in das System einpflegen.<br />

Viele Publikationen sind kostenlos zu bekommen, sofern man sich am System<br />

angemeldet hat. Interessant wird es jedoch bei kostenpflichtigen Dokumenten,<br />

die ebenso in der Netacademy registriert sind. Konkret handelt es sich dabei um<br />

regelmäßig erscheinende Journale, die es einerseits in Form <strong>eines</strong> Abonnements<br />

gedruckt zu kaufen gibt <strong>und</strong> deren Beiträge andererseits neben einigen weiteren<br />

kostenpflichtigen Dokumenten einzeln über das Portal Ingenta 10 zu erwerben<br />

sind, welches sich auf wissenschaftliche Publikationen spezialisiert hat. Einzeln<br />

sind die Dokumente ausschließlich in elektronischer Form zu bekommen.<br />

Über die Usability der Netacademy lässt sich streiten, aber das Prinzip des<br />

Modells ist klar: Sämtliche kostenpflichtigen elektronischen Inhalte werden über<br />

das größere Portal abgewickelt. Dort sind die Dokumente durch die Suchfunk-<br />

tion einer vermutlich größeren Nutzergruppe zugänglich. Zudem werden die<br />

Bezahlungsmodalitäten weitgehend von Ingenta übernommen, was den admi-<br />

nistrativen Aufwand verringert.<br />

Die Suchfunktion ist simpel gehalten <strong>und</strong> erlaubt die freie Eingabe <strong>eines</strong> oder<br />

mehrerer Begriffe. Die Ergebnisse lassen sich auf Dokumentarten einschränken.<br />

3.3.2. SpringerLink<br />

Hierbei handelt es sich um das Online Informationssystem des Springer Ver-<br />

lages, der sich in erster Linie an den professionellen <strong>und</strong> wissenschaftlichen<br />

Nutzer wendet <strong>und</strong> hochwertige Publikationen aus dem wissenschaftlichen <strong>und</strong><br />

wirtschaftlichen Umfeld verlegt.<br />

Das SpringerLink Angebot des Verlages konzentriert sich ausschließlich auf<br />

Produkte des Verlages. Es ermöglicht dem Leser, hochwertige wissenschaftliche<br />

Journale online zu lesen. Zu diesem Zweck bietet SpringerLink eine ausgefeilte<br />

Suchfunktion, sowie den Zugriff auf Abstracts <strong>und</strong> Inhaltsangaben der Publika-<br />

10 WWW Adresse: http://www.ingentaselect.com

27 3.3. WISSENSCHAFTLICHE ANGEBOTE<br />

tionen kostenfrei an. Volltexte werden ausschließlich kostenpflichtig für 35 USD<br />

pro Artikel angeboten.<br />

Es gibt keine Community Features, Experten Verzeichnisse o.ä.<br />

3.3.3. ACM Portal<br />

Die ACM ist bereits seit langer Zeit (1947 gegründet) in der Informatik eine<br />

feste Größe. Sie nennt sich selbst eine Society, also eine Gesellschaft. Sie strebt<br />

an, das wissenschaftliche Arbeiten im Computing-Sektor zu unterstützen <strong>und</strong><br />

bietet ihren Mitgliedern einiges an Unterstützung. Sie finanziert sich vermutlich<br />

in erster Linie über die Mitgliedsbeiträge <strong>und</strong> ihre Publikationen, die sie ver-<br />

legt <strong>und</strong> die, so wie zum Beispiel ihr Journal ” Communications of the ACM“,<br />

weltweit höchste Anerkennung erlangt haben.<br />

Das Angebot umfasst neben einer langen Liste selbstverlegter Journale <strong>und</strong><br />

Konferenzprotokolle den Zugang zu ausgewählten Büchern <strong>und</strong> Kursen für<br />

Software-Entwickler <strong>und</strong> Studenten, die für zahlendes Publikum sogar im Voll-<br />

text vorliegen. Die Bücher sind nicht herunterladbar, aber jederzeit online ein-<br />

sehbar - jedenfalls solange die Subskription der ACM-Mitgliedschaft aktiv ist.<br />

Es gibt jedoch auch Netzwerk-Lizenzen für Firmen <strong>und</strong> Universitäten, die es<br />

erlauben, bestimmte IP-Bereiche freizuschalten, so dass alle Zugriffe aus den<br />

jeweiligen Netzen heraus automatisch erlaubt sind. Die hiesigen Universitäten<br />

nutzen dieses attraktive Angebot in der Regel auch. (Der Autor dieser Zeilen<br />

ist dennoch ACM Mitglied, denn so hat er auch von zu Hause direkten Zugriff.)<br />

Als besonders interessant im Kontext dieser Arbeit stellt sich das ACM Por-<br />

tal 11 dar. Es handelt sich dabei um ein Informationssystem, welches den Zugriff<br />

auf Publikationen des ACM mit Hilfe <strong>eines</strong> Such-Mechanismus erlaubt. Die-<br />

ses Portal integriert zusätzlich den sogenannten ACM Guide, der das Angebot<br />

auf Publikationen anderer Verlage ausdehnt. Laut ACM Angaben beinhaltet<br />

der Guide bibliographische Daten von mehr als 800000 Publikationen, die von<br />

wissenschaftlichen Anbietern weltweit angeboten werden. Die Integration dieser<br />

weltweiten Quellen beschränkt sich auf die Erfassung <strong>und</strong> Verlinkung der Pu-<br />

blikationen. Um auf die Volltexte Zugriff zu haben, muss der Nutzer mit dem<br />

jeweiligen Anbieter Kontakt aufnehmen <strong>und</strong> zum Beispiel das Buch kaufen,<br />

wenn es <strong>eines</strong> ist, oder auch eine kostenpflichtige Mitgliedschaft eingehen.<br />

Der Suchmechanismus ist wie üblich zweigeteilt. Es gibt eine einfache Suche,<br />

die für alle kostenlos benutzbar ist, <strong>und</strong> eine erweiterte Suche (siehe Abbildung<br />

11 WWW Adresse: http://portal.acm.org

3.3. WISSENSCHAFTLICHE ANGEBOTE 28<br />

Abbildung 3.4.: Erweiterte Suche im ACM Portal

29 3.4. TECHNISCH RELEVANTES<br />

3.4) für den zahlenden K<strong>und</strong>enkreis. Bei der Benutzung des Systems fiel bereits<br />

auf, dass oft die erweiterte Suche nötig wurde, um die gewünschten Suchergeb-<br />

nisse hinreichend exakt zu beschreiben. Besonders wichtig wird dieses Feature<br />

in Zusammenhang mit der Beschränkung auf 200 ausgegebene Publikationen,<br />

denn selbst wenn sich das gesuchte Dokument in der Liste befinden müsste, so<br />

hat man doch erst darauf Zugriff, wenn es sich unter den ersten 200 befindet.<br />

Um das zu garantieren, sind so exakte Suchanfragen nötig, die nur durch die<br />

erweiterte Suche möglich sind.<br />

Die erweiterte Suche ermöglicht wie in Abbildung 3.4 gezeigt, dass die Suche<br />

gezielt auf einzelne Felder wie zum Beispiel Autorname, ISBN oder Titel be-<br />

schränkt werden kann. Außerdem wird eine Klassifikation angeboten ( ” CCS“),<br />

die die Dokumente thematisch in eine hierarchische Struktur einbindet <strong>und</strong> die<br />

natürlich auch für die Suche verwendet werden kann.<br />

Volltexte des ACM sind direkt über das Portal online als PDF zu bekommen,<br />

sofern es sich um Journal-Artikel oder Konferenzprotokolle handelt. Bücher<br />

sind nicht als Volltext vorhanden. Da das ACM sehr anerkannte Journale be-<br />

sitzt <strong>und</strong> die Artikel durchweg von hoher wissenschaftlicher Qualität sind, sind<br />

die Volltexte bei der wissenschaftlichen Auseinandersetzung mit informations-<br />

technischen Themen unabkömmlich. Diese Volltexte stellen also einen deutlich<br />

wahrnehmbaren Wert dar. Daher ist der Zugriff auf sie den zahlenden K<strong>und</strong>en<br />

vorbehalten.<br />

Lange Rede kurzer Sinn: das Portal ist zwar zunächst gratis zu testen. Um<br />

es aber wirklich effektiv <strong>und</strong> erfolgreich zu nutzen, benötigt man zwingend<br />

eine kostenpflichtige vollwertige Mitgliedschaft. Die Gratisnutzung ist somit ein<br />

Köder für K<strong>und</strong>en, die durch die spielerische Erforschung des Gratisbereichs<br />

des Portals einen Eindruck des Umfanges des Angebots bekommen können.<br />

Dieses Vorgehen kann nach Ansicht des Autors auch für das ISL eine mögliche<br />

Herangehensweise darstellen.<br />

3.4. Technisch Relevantes<br />

3.4.1. Clusty / Vivísimo<br />

Die Firma Vivísimo stellt Clustering Software her, die sie (sicherlich nicht bil-<br />

lig) unter der Bezeichnung Vivísimo Clustering Engine (VCE) anbietet. Eine<br />

Besonderheit des Vorgehens ist, dass das Clustering on-the-fly ausgeführt wird.<br />

Es gibt kein vollständiges Clustering des Datenbestandes. Stattdessen werden

3.4. TECHNISCH RELEVANTES 30<br />

ausschließlich die Such-Ergebnisse einem Ad-Hoc Clustering unterworfen. Da<br />

das System darauf ausgerichtet ist, die Ergebnisse einer Suchmaschine zu clu-<br />

stern, betrachtet es Titel <strong>und</strong> Abstract, den Suchmaschinen üblicherweise au-<br />

tomatisch liefern. Laut Vivísimo beinhaltet der Clustering Algorithmus zwar<br />

keinerlei Vorwissen (Thesauri oder Ähnliches), wurde aber von den Entwick-<br />

lern speziell darauf ausgerichtet Cluster zu erzeugen, die beachten, ” what users<br />

wish to see when they examine clustered documents“ (vivisimo.com 12 ).<br />

Zudem bietet sie ein Produkt namens Clusty 13 an. Dabei handelt es sich<br />

um eine Meta-Suchmaschine, die verschiedene Suchmaschinen abfragt, deren<br />

Ergebnisse sammelt <strong>und</strong> mittels VCE clustert. Interessanterweise fragt Clus-<br />

ty nicht mehr nur gewöhnliche Suchmaschinen ab, sondern erlaubt zusätz-<br />

lich die Suche in weiteren Quellen wie zum Beispiel einer Preissuchmaschine<br />

(www.bizrate.com 14 ) oder einer Bildersuchmaschine (picsearch.com 15 ). Es exi-<br />

stiert somit eine gemeinsame Oberfläche für die Suche in mehreren unterschied-<br />

lichen Quellen. Hervorzuheben ist die Integration der Kategorisierung von biz-<br />

rate.com. Bizrate hat die Produkte in Kategorien einsortiert, wie zum Beispiel<br />

Men’s T-Shirts oder Women’s T-Shirts bei Shirts. Diese Kategorien zeigt es<br />

zusätzlich zu den automatisch ermittelten Clustern an. Probier-Link 16<br />

Mit Clusty lassen sich sehr einfach eigene Erfahrungen mit Clustering Ange-<br />

boten sammeln. Das Vorgehen von Clusty wäre nach Meinung des Autors auch<br />

für das ISL sehr interessant.<br />

3.4.2. carrot 2<br />

Dies 17 ist ein Programmierframework in Java, welches sich als Experimentier-<br />

plattform in Bezug auf das Clustering von Suchergebnissen versteht. Daher<br />

passt es sehr gut zur Zielsetzung der Arbeit <strong>und</strong> soll hier mit aufgeführt wer-<br />

den. Der von carrot 2 verwendete Ansatz unterscheidet sich von dieser Arbeit<br />

insofern, als dass dort für das Clustern ein eigener Algorithmus (LINGO) ver-<br />

wendet wird. LINGO basiert auf einem durch LSI (siehe auch Abschnitt 5.3.4)<br />

erzeugten approximierten Datenraum, der durch die drei Matrizen T S D T dar-<br />

12<br />

WWW Adresse: http://vivisimo.com/docs/howitworks.pdf<br />

13<br />

WWW Adresse: http://clusty.com<br />

14<br />

WWW Adresse: http://www.bizrate.com<br />

15<br />

WWW Adresse: http://picsearch.com<br />

16<br />

WWW Adresse: http://clusty.com/search?v%3aproject=clusty-shopping&query=<br />

shirt<br />

17 WWW Adresse: http://www.cs.put.poznan.pl/dweiss/carrot/

31 3.4. TECHNISCH RELEVANTES<br />

gestellt wird. Dabei ist S eine diagonale Matrix (alle Werte auf 0, außer in der<br />

Diagonalen), die die Singulärwerte enthält. Der Unterschied ist beim Finden<br />

der Cluster am größten. Und zwar errechnet LINGO für jeden Singulärwert<br />

einen dazu passenden Begriff, bzw. eine dazu passende Phrase (LINGO sucht<br />

auch nach Begriffsgruppen). Jeder gef<strong>und</strong>ene Begriff wird nun flugs zum Clu-<br />

ster erklärt. Dann werden noch die Dokumente entsprechend ihrer Ähnlichkeit<br />

zu diesen gef<strong>und</strong>enen Clustern jeweils einem dieser Cluster zugeordnet, fertig.<br />

Das System macht einen sehr guten Eindruck <strong>und</strong> die Idee hinter LINGO<br />

besticht ebenso durch ihre Einfachheit wie durch ihre Effektivität.

3.4. TECHNISCH RELEVANTES 32

Teil II.<br />

Definition

4. Technische Analyse<br />

4.1. Ist-Analyse<br />

Ziel ist die Klärung der derzeitigen Situation im Kontext des Seabase Infor-<br />

mationssystems. Identifikation des aktuellen Datenmodells, Definitionen von<br />

existierenden Schnittstellen, Identifikation der beteiligten Software Komponen-<br />

ten sowie insbesondere die Klärung, wie die Prozesse aktuell für Erfassung <strong>und</strong><br />

Recherche ablaufen.<br />

4.1.1. Komponenten <strong>und</strong> Schnittstellen<br />

Die beiden Systeme, die hauptsächlich zusammenarbeiten, um die Systemfunk-<br />

tionalität bereitzustellen, sind die Software Faust <strong>und</strong> der Webserver, der eine<br />

Apache+PHP Konfiguration nutzt.<br />

Bei Faust handelt es sich um ein Datenbanksystem mit einfachen Dokumen-<br />

tenmanagement Funktionen, das für den Einsatz in Bibliotheken <strong>und</strong> ähnli-<br />

chen Einrichtungen, in denen bibliographische Objekte (Dokumente, Bücher,<br />

Zeitschriften,. . . ) erfasst <strong>und</strong> verwaltet werden müssen, optimiert ist. Die Do-<br />

kumenttypen sind sehr weitgehend flexibel definierbar; die für die Erfassung<br />

benötigten Felder können frei benannt <strong>und</strong> angelegt werden. Es erlaubt Ver-<br />

knüpfungen mit Online-Quellen <strong>und</strong> das Erfassen <strong>und</strong> Speichern beliebiger di-<br />

gitaler Dokumente. Im ISL werden zwar die digitalen Dokumente sowie die<br />

Online-Quellen nach <strong>und</strong> nach stärker ins Blickfeld gerückt, Literaturhinweise<br />

auf Publikationen, die in der ISL-Bibliothek tatsächlich auch in Papierform vor-<br />

handen sind, nehmen aber nach wie vor den größten Teil des Datenbestandes<br />

ein.<br />

Die Schnittstelle zwischen der auf PHP basierenden Suche <strong>und</strong> der Faust-<br />

Datenbank definiert sich über eine Textdatei, die durch ein speziell entwickeltes<br />

Makro aus Faust heraus produziert wird. Deren Format ist sehr simpel aufge-<br />

baut. Es besteht aus einer Textzeile pro bibliographisches Objekt. Die Textzeile<br />

wiederum ist wie folgt aufgebaut:

4.1. IST-ANALYSE 36<br />

id Component Model<br />

«artifact»<br />

Logical Model::Export data<br />

import script<br />

«artifact»<br />

Index data<br />

FAUST system<br />

Seabase<br />

Abbildung 4.1.: System-Komponenten<br />

«executable»<br />

Logical Model::<br />

Faust<br />

search mask<br />

Zeile ::= Feld1 "|" ... "|" Feldx "|" Deskriptoren<br />

Deskriptoren ::= Deskriptor ";" Deskriptoren | Deskriptor<br />

Sie besteht somit aus x durch | getrennten Feldern <strong>und</strong> einer Liste von durch<br />

; getrennten Deskriptoren. Um welche Felder es sich handelt <strong>und</strong> in welcher<br />

Reihenfolge diese jeweils in den Zeilen zu finden sind ist aus Tabelle 4.1 (Seite<br />

40) <strong>und</strong> Tabelle 4.2 (Seite 41) ersichtlich.<br />

Damit der Zugriff auf die Daten aus der Suche heraus performant ablau-<br />

fen kann, wird diese Textdatei zunächst eingelesen, es werden die signifikanten<br />

Informationen erkannt (Listen von Autoren, Deskriptoren,. . . ) <strong>und</strong> in für die<br />

Suche optimierter Form abgelegt.<br />

4.1.2. Prozesse<br />

Es gibt im Wesentlichen zwei Hauptprozesse. Dabei handelt es sich zum einen<br />

um den Prozess ” Erfassung“ <strong>und</strong> den Prozess ” Recherche“. Beide sind beim ISL

37 4.1. IST-ANALYSE<br />

aktuell im Einsatz. Die Erfassung wird von Mitarbeitern des ISL durchgeführt.<br />

Der Prozess Erfassung (Abbildung 4.2 (Seite 38), Anwendungsfälle sind grün,<br />

Systemzustände sind rot dargestellt <strong>und</strong> produzierte Datenobjekte in blau) be-<br />

ginnt, sobald ein neues Dokument im ISL angeschafft wird oder der Erfassungs-<br />

bedarf anderweitig aufkommt, z.B. durch eigene Recherchen im Internet. Ein<br />

solches Dokument wird zunächst inhaltlich intellektuell analysiert <strong>und</strong> erfasst.<br />

Die Ergebnisse können dann in das Faust-System eingetragen werden. Dabei<br />

wird unter anderem eine inhaltliche Zusammenfassung (auch Kurzreferat ge-<br />

nannt) des Dokuments im System hinterlegt. Des weiteren werden bibliogra-<br />

phische Informationen eingegeben <strong>und</strong> das Dokument in die Begriffshierarchie<br />

des ISL (ISL-Thesaurus) eingegliedert.<br />

Sofern sich hierbei der Bedarf ergibt, den Thesaurus zu erweitern, wird das<br />

getan.<br />

Am Ende <strong>eines</strong> Arbeitstages dann wird der vierte Anwendungsfall, der Ex-<br />

port, angestoßen. Dieser besteht im Wesentlichen aus der Auswahl <strong>eines</strong> Makros<br />

im Faust-System, welches selbständig eine Liste mit den bibliographischen In-<br />

formationen in eine Textdatei schreibt, die für das online Suchformular zugängig<br />

ist.<br />

Die K<strong>und</strong>en reagieren auf Informationsbedarf mit einer Suchanfrage, die sie<br />

im online Suchformular eintragen. Dabei haben sie Zugriff auf eine Schlagwort-<br />

liste sowie auf eine Liste aller verzeichneten Autoren. Siehe Darstellung des<br />

Ablaufs, Abbildung 4.3 (Seite 39).<br />

Die Suchmaske, zu sehen in Abbildung 4.4 (Seite 41), erlaubt die Eingabe von<br />

Autor, Titel, zwei Schlagworten (Deskriptoren), Erscheinungsjahr, Sachgebiet<br />

<strong>und</strong> der Bibliothekssignatur sowie zusätzlich <strong>eines</strong> Stichwortes, nach welchem<br />

das System in den Zusammenfassungen sucht. Alle Eingaben sind mit UND<br />

verknüpft.<br />

4.1.3. Datenmodell<br />

Das Datenmodell, welches sich letztlich online wiederspiegelt, wird durch den<br />

Export-Vorgang aus der Software Faust heraus erzeugt. Es besteht für jede<br />

Publikation aus einer langen Liste an Feldern mit ihren Werten <strong>und</strong> einer Liste<br />

an zugehörigen Deskriptoren. Da die Deskriptoren als Liste exportiert werden,<br />

sind die hierarchischen Beziehungen, die im Faust existieren, online nicht mehr<br />

verfügbar <strong>und</strong> tauchen somit auch im Datenmodell nicht auf.<br />

Siehe Tabelle 4.1 (Seite 40).

4.1. IST-ANALYSE 38<br />

Thesaurus<br />

aktualisiert<br />

Ereignis<br />

Information<br />

Funktion<br />

Publikation<br />

V<br />

Thesaurus<br />

V<br />

Legende<br />

V<br />

V<br />

oder<br />