3D/6D-Visionsysteme und Lasermessverfahren in der Robotik und ...

3D/6D-Visionsysteme und Lasermessverfahren in der Robotik und ...

3D/6D-Visionsysteme und Lasermessverfahren in der Robotik und ...

Sie wollen auch ein ePaper? Erhöhen Sie die Reichweite Ihrer Titel.

YUMPU macht aus Druck-PDFs automatisch weboptimierte ePaper, die Google liebt.

J. Wollnack<br />

Die heute überwiegend <strong>in</strong> <strong>der</strong> <strong>Robotik</strong> e<strong>in</strong>gesetzten<br />

„Teach“-Verfahren s<strong>in</strong>d wirtschaftlich<br />

attraktiv bei ausreichend großen Losgrößen.<br />

Sowohl bei ger<strong>in</strong>gen Losgrößen als auch nicht<br />

vernachlässigbaren Fertigungstoleranzen <strong>der</strong><br />

Objekte werden die technologisch <strong>und</strong> wirtschaftlichen<br />

Grenzen dieser Konzepte mehr <strong>und</strong><br />

mehr sichtbar. E<strong>in</strong>e erhöhte Produktflexibilität<br />

bei entsprechenden großen Fertigungstoleranzen<br />

letztlich bis h<strong>in</strong>unter zum Unikat macht e<strong>in</strong>e<br />

<strong>in</strong>dividuelle dreidimensionale Messung von<br />

Geometriemerkmalen nötig. Hierdurch können<br />

die E<strong>in</strong>satzbereiche bestehen<strong>der</strong> Industrieroboter<br />

<strong>in</strong> den verschiedenen Wirtschaftszweigen<br />

wirtschaftlich attraktiv teilweise auch zu Lasten<br />

von Son<strong>der</strong>masch<strong>in</strong>en erweitert werden.<br />

1 Problemstellung <strong>und</strong> Zielsetzung<br />

Flexibilität <strong>und</strong> Automatisierung gew<strong>in</strong>nen <strong>in</strong> <strong>der</strong> roboterunterstützten<br />

Fertigungs<strong>in</strong>dustrie zunehmend an Bedeutung.<br />

Die dreidimensionale videometrische Messung<br />

<strong>3D</strong>/<strong>6D</strong>-<strong>Visionsysteme</strong> <strong>und</strong><br />

<strong>Lasermessverfahren</strong> <strong>in</strong> <strong>der</strong><br />

<strong>Robotik</strong> <strong>und</strong><br />

Fertigungstechnik <strong>der</strong><br />

Luftfahrt<strong>in</strong>dustrie<br />

von geometrischen Merkmalen sowie die Messung von<br />

Positions- <strong>und</strong> Orientierungsdaten <strong>der</strong> Handhabungs<strong>und</strong><br />

Montageobjekte stellen auf diesem Weg mögliche Lösungen<br />

dar. Die heute verwendeten roboterunterstützten<br />

Fertigungs- <strong>und</strong> Montageanlagen können diesen Anfor<strong>der</strong>ungen<br />

h<strong>in</strong>sichtlich <strong>der</strong> Produktflexibilität nur bed<strong>in</strong>gt gerecht<br />

werden, da <strong>der</strong> systematische Posefehler (Pose steht<br />

für Position <strong>und</strong> Orientierung <strong>in</strong> <strong>6D</strong>) gegenüber <strong>der</strong> Wie<strong>der</strong>holgenauigkeit<br />

(Nur bei Teach-Prozessen nutzbar) zumeist<br />

um e<strong>in</strong>e Größenordnung schlechter ausfällt.<br />

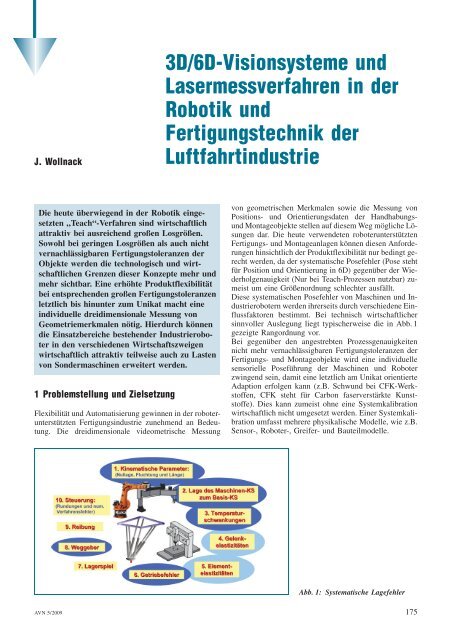

Diese systematischen Posefehler von Masch<strong>in</strong>en <strong>und</strong> Industrierobotern<br />

werden ihrerseits durch verschiedene E<strong>in</strong>flussfaktoren<br />

bestimmt. Bei technisch wirtschaftlicher<br />

s<strong>in</strong>nvoller Auslegung liegt typischerweise die <strong>in</strong> Abb. 1<br />

gezeigte Rangordnung vor.<br />

Bei gegenüber den angestrebten Prozessgenauigkeiten<br />

nicht mehr vernachlässigbaren Fertigungstoleranzen <strong>der</strong><br />

Fertigungs- <strong>und</strong> Montageobjekte wird e<strong>in</strong>e <strong>in</strong>dividuelle<br />

sensorielle Poseführung <strong>der</strong> Masch<strong>in</strong>en <strong>und</strong> Roboter<br />

zw<strong>in</strong>gend se<strong>in</strong>, damit e<strong>in</strong>e letztlich am Unikat orientierte<br />

Adaption erfolgen kann (z.B. Schw<strong>und</strong> bei CFK-Werkstoffen,<br />

CFK steht für Carbon faserverstärkte Kunststoffe).<br />

Dies kann zumeist ohne e<strong>in</strong>e Systemkalibration<br />

wirtschaftlich nicht umgesetzt werden. E<strong>in</strong>er Systemkalibration<br />

umfasst mehrere physikalische Modelle, wie z.B.<br />

Sensor-, Roboter-, Greifer- <strong>und</strong> Bauteilmodelle.<br />

Abb. 1: Systematische Lagefehler<br />

AVN 5/2009 175

J. Wollnack – <strong>3D</strong>/<strong>6D</strong>-<strong>Visionsysteme</strong> <strong>und</strong> <strong>Lasermessverfahren</strong> <strong>in</strong> <strong>der</strong> <strong>Robotik</strong> <strong>und</strong> Fertigungstechnik <strong>der</strong> Luftfahrt<strong>in</strong>dustrie<br />

Die Genauigkeitsanfor<strong>der</strong>ungen <strong>in</strong> <strong>der</strong> <strong>Robotik</strong> <strong>und</strong> Flugzeugmontage<br />

erzw<strong>in</strong>gen <strong>in</strong>sbeson<strong>der</strong>e bei Weitw<strong>in</strong>kelobjektiven<br />

e<strong>in</strong>e Modellierung <strong>der</strong> L<strong>in</strong>senverzerrungen. Zudem<br />

s<strong>in</strong>d die Modelle dreidimensionaler videometrischer<br />

Messsysteme sensibel h<strong>in</strong>sichtlich numerischer Rangdefekte,<br />

was bei e<strong>in</strong>er nicht strukturierten hierarchischen<br />

Systemkalibrationsstrategie typischerweise nicht zu den<br />

angestrebten Genauigkeiten führt. Trotz dieser schwierigen<br />

Randbed<strong>in</strong>gungen lässt sich e<strong>in</strong>e vollautomatische<br />

Systemkalibration realisieren.<br />

In <strong>der</strong> Praxis werden hierfür preiswerte <strong>und</strong> robuste Lösungen<br />

benötigt, die marktgängige Kamerasysteme e<strong>in</strong>setzen.<br />

Das Verfahren muss zudem „werkergerecht“<br />

<strong>und</strong> e<strong>in</strong>fach bedienbar se<strong>in</strong>.<br />

2 Ansatz<br />

In <strong>der</strong> videometrisch geführten roboterunterstützen Fertigungs-<br />

<strong>und</strong> Montagetechnik s<strong>in</strong>d e<strong>in</strong>e Reihe von Koord<strong>in</strong>atensystemen<br />

<strong>und</strong> Modellen entsprechend Abb. 2 heranzuziehen.<br />

Für die <strong>3D</strong>-Videometrie werden Multikameramodelle<br />

bzw. Zweikameramodelle e<strong>in</strong>gesetzt. Das diesen<br />

Modellen zugr<strong>und</strong>e liegende Kameramodell basiert auf<br />

den Arbeiten von Tsai <strong>und</strong> Lenz [19]. Die Relationen zwischen<br />

den kartesischen Koord<strong>in</strong>atensystemen werden mittels<br />

homogenen Koord<strong>in</strong>atentransformationen mit sechs<br />

Freiheitsgraden <strong>der</strong> Pose beschrieben. Drei <strong>in</strong> <strong>der</strong> Position<br />

<strong>und</strong> drei <strong>in</strong> <strong>der</strong> Orientierung.<br />

Das Robotermodell sollte mittels Denavit-Hartenberg-<br />

Achsmodellen o<strong>der</strong> an<strong>der</strong>en je nach Achsübergang geeigneten<br />

Modellen charakterisiert werden [1, 6, 12, 15, 17,<br />

29, 30, 33]. Anstatt serieller lassen sich auch parallele<br />

K<strong>in</strong>ematiken e<strong>in</strong>setzen. Bei ihnen erfolgt die Kalibration<br />

jedoch über die k<strong>in</strong>ematische <strong>in</strong>verse Transformation.<br />

Ausgehend von <strong>der</strong> Problemstellung liegt somit folgende<br />

Situation vor:<br />

– <strong>3D</strong>-Kamerasystem unkalibriert (Zweikamerasystem)<br />

– Mess- zu TCP-KOS unbekannt (TCP: ¼ Tool Center<br />

Po<strong>in</strong>t, KOS: ¼ Koord<strong>in</strong>atensystem)<br />

– Greifer- zu TCP-KOS unbekannt<br />

– Objekt- zu Roboter-KOS unbekannt<br />

– Pose lokaler Objektmerkmale unbekannt (Fertigungstoleranzen)<br />

o<strong>der</strong> Pose des Objekt unbekannt<br />

– Robotersteuerung teil- o<strong>der</strong> unkalibriert<br />

Abb. 2: Sensor-Roboter-Weltmodell<br />

Unbekannt bzw. unkalibriert bedeutet <strong>in</strong> diesem Zusammenhang,<br />

dass die Parameter des Modells nicht mit <strong>der</strong><br />

erfor<strong>der</strong>lichen Genauigkeit aus konstruktiven Daten ableitbar<br />

s<strong>in</strong>d. Im Allgeme<strong>in</strong>en ist e<strong>in</strong>e Verr<strong>in</strong>gerung <strong>der</strong><br />

Fertigungstoleranzen sowohl technisch als auch wirtschaftlich<br />

nicht zielführend.<br />

Aus diesem Gr<strong>und</strong>e ist e<strong>in</strong>e Kalibration <strong>der</strong> parametrischen<br />

Modelle erfor<strong>der</strong>lich. Hierzu wird die nicht l<strong>in</strong>eare<br />

Parameteridentifikationsaufgabe als M<strong>in</strong>imierungsproblem<br />

formuliert. Die L<strong>in</strong>earisierung des vektoriellen Residuums<br />

führt unmittelbar auf das allgeme<strong>in</strong>e Newton-<br />

Verfahren. Die numerische Umsetzung dieses Algorithmus<br />

kann z.B. mit dem Powell-Verfahren geschehen<br />

[24, 25]. Diese Verfahren s<strong>in</strong>d jedoch so zu modifizieren,<br />

dass man über e<strong>in</strong>e Indextabelle auswählen kann, über<br />

welche Parameter die M<strong>in</strong>imierung vollzogen werden<br />

soll [33].<br />

Zu optimierende Parameter werden dabei mit (konstruktiven)<br />

Nom<strong>in</strong>alwerten o<strong>der</strong> mit Werten aus e<strong>in</strong>em vorherigen<br />

M<strong>in</strong>imierungslauf <strong>in</strong>itialisiert <strong>und</strong> nicht zu optimierende<br />

Parameter werden mit Nom<strong>in</strong>alwerten belegt.<br />

Dieses Konzept ermöglicht e<strong>in</strong>e strukturierte hierarchische<br />

Kalibration <strong>der</strong> Modelle. Man kann so schrittweise<br />

die Strukturen des Systemmodells erweitern <strong>und</strong> dieses<br />

hierarchisch kalibrieren. Die hierarchische Kalibration<br />

kommt dann zum E<strong>in</strong>satz, wenn nicht vollständige Modelle<br />

mit schlechter Kondition bzw. numerischen Rangdefekten<br />

vorliegen (Kamera-/Sensormodell). Man m<strong>in</strong>imiert<br />

hierbei zunächst die l<strong>in</strong>ear unabhängigen Parameter,<br />

die den größten E<strong>in</strong>fluss auf das Modellverhalten nehmen<br />

<strong>und</strong> gibt dann schrittweise weitere Parameter frei. Vollständige<br />

Modelle spielen hierbei letztlich e<strong>in</strong>e untergeordnete<br />

Rolle, da man nicht sämtliche (systematischen) physikalischen<br />

Effekte modellieren kann <strong>und</strong> deshalb pr<strong>in</strong>zipiell<br />

strukturelle Modellfehler vorliegen werden.<br />

Das F<strong>in</strong>den <strong>der</strong> erfolgreichen Strategie erfor<strong>der</strong>t e<strong>in</strong>e Mischung<br />

aus systematischem Vorgehen <strong>und</strong> heuristischem<br />

Ansatz. Man zieht hierbei sowohl das Wissen über die<br />

Modelle, die nach <strong>der</strong> Empf<strong>in</strong>dlichkeit geordneten Parameter<br />

<strong>und</strong> die SVD-Werte (S<strong>in</strong>gular-Value-Decomposition)<br />

<strong>der</strong> Jacobi-Matrix <strong>der</strong> Modellparameter als auch die<br />

gesammelte Erfahrung beim hierarchischen M<strong>in</strong>imieren<br />

zu Rate (Wichtige Parameter ohne Rangdefekte zuerst<br />

m<strong>in</strong>imieren, dann wichtige Parameter mit Rangdefekten<br />

zusätzlich m<strong>in</strong>imieren <strong>und</strong> folgend weitere Parameter<br />

nach <strong>der</strong> Signifikanz geordnet sukzessive <strong>in</strong> die M<strong>in</strong>imierung<br />

mit e<strong>in</strong>beziehen) [33]. Die erfolgreiche Strategie<br />

kann dann ohne weiteres auf e<strong>in</strong>e Serie von Systemen<br />

bzw. <strong>in</strong> <strong>der</strong> Praxis angewendet werden, so dass die <strong>in</strong>nere<br />

Problematik dem Anwen<strong>der</strong> verborgen bleiben kann.<br />

Variiert <strong>der</strong> Anwen<strong>der</strong> das Kalibrationsszenario, so kann<br />

man mit Hilfe <strong>der</strong> numerischen Ranguntersuchung feststellen,<br />

ob das modifizierte Szenarium zielführend ist<br />

o<strong>der</strong> nicht <strong>und</strong> vollautomatisch entsprechende H<strong>in</strong>weise<br />

geben<br />

3Stationäres Systemmodell<br />

Zur Beschreibung des <strong>3D</strong>-videometrischen Sensor-Roboter-Systems<br />

<strong>in</strong> e<strong>in</strong>er stationären Messpose muss das Ge-<br />

176 AVN 5/2009

samtsystem entsprechend Abb. 2 mathematisch beschrieben<br />

werden. Sowohl das Roboter- als auch Sensormodell<br />

lassen sich h<strong>in</strong>sichtlich geometrischer Aspekte durch<br />

parametrische vektorielle Funktionen charakterisieren.<br />

Diese Systemgleichungen s<strong>in</strong>d Ausgangspunkt für die<br />

M<strong>in</strong>imierungsansätze <strong>der</strong> strukturierten hierarchischen<br />

Parameteridentifikation. Das Robotermodell umfasst dabei<br />

sowohl geometrische als auch elastische Effekte.<br />

Bei diesen Ansätzen geht man davon aus, dass sich mit<br />

dem videometrischen Messsystem drei o<strong>der</strong> mehrere<br />

<strong>3D</strong>-Positionen <strong>in</strong> verschiedenen TCP-Posen messen lassen.<br />

Letztlich ließe sich analog zur Koord<strong>in</strong>atenmesstechnik<br />

e<strong>in</strong>e beliebige Merkmalsmessung heranziehen, mittels<br />

<strong>der</strong>er entwe<strong>der</strong> mehrere <strong>3D</strong>-Positionsmessungen vollzogen<br />

o<strong>der</strong> e<strong>in</strong>deutig e<strong>in</strong> Objektkoord<strong>in</strong>atensystem festgelegt<br />

werden kann (Komb<strong>in</strong>ationen von Bohrungen, Ebenen,<br />

Zyl<strong>in</strong><strong>der</strong>n usw.).<br />

Damit erhält man für e<strong>in</strong>e Roboter- bzw. Messpose die<br />

Systemgleichung:<br />

Tðp TCP<br />

A Þ¼TðpR AÞT 1 ðp R MÞT 1 ðp M TCPÞ; p R M p R MðpC; xC1; xC2; xC3Þ ð1Þ<br />

Robotermodell<br />

p TCP<br />

A<br />

¼ fAðp A; xAÞ; Tðp TCP<br />

Sensormodell<br />

J. Wollnack – <strong>3D</strong>/<strong>6D</strong>-<strong>Visionsysteme</strong> <strong>und</strong> <strong>Lasermessverfahren</strong> <strong>in</strong> <strong>der</strong> <strong>Robotik</strong> <strong>und</strong> Fertigungstechnik <strong>der</strong> Luftfahrt<strong>in</strong>dustrie<br />

A Þ¼Y<br />

g<br />

r M m ¼ fCðpC; xCmÞ; mit xCm ¼ r rt<br />

0m ; rrt 1m<br />

Tðp Ag; xgÞ ð2Þ<br />

t <strong>und</strong><br />

m 2f1; ...; Mg; M 3 ð3Þ<br />

xCm : ¼ korrespondierende Markerpixelkoord<strong>in</strong>aten im<br />

RAM-KOS<br />

xA : ¼ Masch<strong>in</strong>enkoord<strong>in</strong>aten<br />

pC :<br />

pA :<br />

m :<br />

¼ Sensormodellparameter<br />

¼ Robotermodellparameter<br />

¼ Marker<strong>in</strong>dizes<br />

TCP : ¼ Tool-Center-Po<strong>in</strong>t-KOS<br />

R: ¼ Referenz-KOS am Markersystem<br />

(drei <strong>3D</strong>-Positionen)<br />

M: ¼ Sensor-KOS<br />

A: ¼ Robotersteuerungs-KOS<br />

Hierbei s<strong>in</strong>d Tðpa bÞ2

J. Wollnack – <strong>3D</strong>/<strong>6D</strong>-<strong>Visionsysteme</strong> <strong>und</strong> <strong>Lasermessverfahren</strong> <strong>in</strong> <strong>der</strong> <strong>Robotik</strong> <strong>und</strong> Fertigungstechnik <strong>der</strong> Luftfahrt<strong>in</strong>dustrie<br />

Verfahren <strong>in</strong> <strong>der</strong> Regel sehr empf<strong>in</strong>dlich gegenüber<br />

Fremdlichte<strong>in</strong>flüssen.<br />

Deshalb sollten bei automatisierten Applikationen <strong>in</strong> <strong>in</strong>dustriellen<br />

Bereichen entwe<strong>der</strong> passiv retroreflektierende<br />

o<strong>der</strong> aktiv leuchtende Referenzmarken verwendet werden.<br />

Beim E<strong>in</strong>satz aktiver Referenzmarken können zur<br />

Kontrasterhöhung getriggerte, pulsartig leuchtende Lichtquellen<br />

e<strong>in</strong>gesetzt werden o<strong>der</strong> <strong>der</strong> Wellenlängenbereich<br />

<strong>der</strong> aktiven Zielmarken durch optische Filter im Kamerasystem<br />

selektiert werden (z.B. Infrarotbereich). Auch e<strong>in</strong>e<br />

Komb<strong>in</strong>ation <strong>der</strong>artiger Maßnahmen ist möglich.<br />

Die aktiven Triangulationsverfahren unterscheiden sich<br />

von passiven <strong>in</strong> <strong>der</strong> Verwendung e<strong>in</strong>er strukturierten Objektbeleuchtung,<br />

<strong>der</strong>en optische <strong>und</strong> geometrische Eigenschaften<br />

bekannt s<strong>in</strong>d. Dieser Informationsgew<strong>in</strong>n vere<strong>in</strong>facht<br />

das F<strong>in</strong>den <strong>der</strong> Korrespondenzen erheblich. Die Abbildungsmuster<br />

werden <strong>in</strong> punktförmige, l<strong>in</strong>ienförmige<br />

<strong>und</strong> codierte Systeme e<strong>in</strong>geteilt. Mit punktförmigen Projektionen<br />

lassen sich <strong>3D</strong>-Positionsdaten, mit l<strong>in</strong>ienförmigen<br />

Projektionen <strong>3D</strong>-Konturl<strong>in</strong>ien <strong>und</strong> mit codierten Systemen<br />

<strong>3D</strong>-Konturdaten messen.<br />

Zur <strong>3D</strong>-Positionsmessung können Sensoren <strong>in</strong> Form von<br />

CCD/CMOS-Arrays (Charge Coupled Device/Complementary<br />

Metal Oxide Semiconductor) o<strong>der</strong> drei CCD-Zeilen<br />

herangezogen werden, soweit diese <strong>in</strong> e<strong>in</strong>er Ebene liegen<br />

(zwei orthogonal <strong>und</strong> zwei parallel zue<strong>in</strong>an<strong>der</strong> ausgerichtet).<br />

Hiermit lassen sich relativ kostengünstig sehr<br />

hohe Auflösungen verwirklichen. E<strong>in</strong> 1D-Laserabstandssensor<br />

kann als Spezialfall dieser Messsysteme gedeutet<br />

werden; er besteht aus e<strong>in</strong>er Punktlichtquelle <strong>und</strong> e<strong>in</strong>er<br />

CCD-Zeile o<strong>der</strong> e<strong>in</strong>em PSD-Sensor (Position Sens<strong>in</strong>g Detector).<br />

Durch def<strong>in</strong>ierte Ablenkung von punktförmigen<br />

o<strong>der</strong> l<strong>in</strong>ienförmigen Projektionen über Spiegel-Servo-<br />

Kreise lassen sich <strong>3D</strong>-Punkt- o<strong>der</strong> L<strong>in</strong>ienscanner zu topographischen<br />

Messsystemen erweitern. Bei Systemen mit<br />

hohen Anfor<strong>der</strong>ungen an die Messgenauigkeit s<strong>in</strong>d <strong>in</strong><br />

<strong>der</strong> Regel monochromatische Laserprojektoren vorzuziehen.<br />

Am Beispiel e<strong>in</strong>es Multi- bzw. Zweikamerasystems mit<br />

retroreflektierenden Kugelmarkern sei das pr<strong>in</strong>zipielle<br />

Vorgehen verdeutlicht. Hierbei werden sowohl geometrische<br />

als auch videometrische Effekte zu berücksichtigen<br />

se<strong>in</strong>. Letztere sollen nicht Gegenstand dieser Erörterungen<br />

se<strong>in</strong>. Ebenso wird auf e<strong>in</strong>e detaillierte Darstellung<br />

<strong>der</strong> Bildverarbeitungsverfahren verzichtet. Hierfür sei<br />

Abb. 3: <strong>3D</strong>-Videometrie<br />

auf die e<strong>in</strong>schlägige Literatur [7, 8, 10, 11, 22, 33] verwiesen.<br />

Die Idee <strong>der</strong> dreidimensionalen Positionsmessung geht<br />

von korrespondierenden Messmarkenkoord<strong>in</strong>aten m<strong>in</strong>destens<br />

zweier Kamerasysteme aus, <strong>der</strong>en Sehstrahlenschnittpunkt<br />

die <strong>3D</strong>-Koord<strong>in</strong>ate angibt (siehe Abb. 3).<br />

Mit steigenden Genauigkeitsanfor<strong>der</strong>ungen unterhalb<br />

1/5 bis 1/10 Pixel werden <strong>in</strong> zunehmendem Maße die E<strong>in</strong>flussfaktoren<br />

des nicht l<strong>in</strong>earen geometrischen Kameramodels<br />

zum Tragen kommen, weshalb dann die unverzerrten,<br />

kippw<strong>in</strong>kelfehlerfreien Sensorkoord<strong>in</strong>aten über<br />

die Inversen des geometrischen Kameramodells aus den<br />

RAM-Koord<strong>in</strong>aten zu berechnen s<strong>in</strong>d. Dies gilt analog bereits<br />

beim E<strong>in</strong>satz von Weitw<strong>in</strong>kelobjektiven, <strong>der</strong>en L<strong>in</strong>senverzerrungen<br />

am Rand des Sichtbereiches auch bei<br />

nicht m<strong>in</strong><strong>der</strong>wertigen Objektiven <strong>in</strong> <strong>der</strong> Größenordnung<br />

von 6 Pixel liegen. Aus diesem Gr<strong>und</strong>e lassen sich die<br />

relativ e<strong>in</strong>fachen l<strong>in</strong>earen Kameramodelle <strong>in</strong> <strong>der</strong> Praxis<br />

zumeist nicht e<strong>in</strong>setzen [33].<br />

Zur Vere<strong>in</strong>fachung <strong>der</strong> Korrespondenzsuche bedient man<br />

sich <strong>der</strong> epipolaren L<strong>in</strong>ie. Die epipolare L<strong>in</strong>ie stellt den<br />

virtuellen Sehstrahl e<strong>in</strong>er Kamera <strong>in</strong> <strong>der</strong> „RAM-Ebene“<br />

(Random Access Memory) e<strong>in</strong>er an<strong>der</strong>en Kamera dar.<br />

In <strong>der</strong> Standardanordnung, bei <strong>der</strong> die Zeilen <strong>der</strong> Bildpaare<br />

parallel zur Verb<strong>in</strong>dungsgeraden zwischen den optischen<br />

Zentren (Ursprung Kameras-KOS) liegen o<strong>der</strong><br />

die Bildkoord<strong>in</strong>atensysteme so def<strong>in</strong>iert s<strong>in</strong>d, dass zue<strong>in</strong>an<strong>der</strong><br />

kol<strong>in</strong>eare Bildzeilen gleiche Zeilenkoord<strong>in</strong>aten aufweisen,<br />

beschränkt sich die Korrespondenzsuche <strong>der</strong> epipolaren<br />

L<strong>in</strong>ie auf die Suche längs e<strong>in</strong>er Zeilen bzw. e<strong>in</strong>es<br />

Bandes um die Zeilen. Dieser e<strong>in</strong>fache Fall kann <strong>in</strong> <strong>der</strong><br />

Regel nicht umgesetzt werden, da e<strong>in</strong> möglichst großer<br />

Basisabstand für e<strong>in</strong>e hohe z-Genauigkeit <strong>und</strong> die notwendige<br />

Überlappung <strong>der</strong> Bildbereiche, die für die Existenz<br />

von Korrespondenzen zw<strong>in</strong>gend ist, nur durch e<strong>in</strong>e zue<strong>in</strong>an<strong>der</strong><br />

gerichtete Drehung um die y-Achsen <strong>der</strong> Kamerakoord<strong>in</strong>atensysteme<br />

zu verwirklichen ist. E<strong>in</strong>e Drehung<br />

<strong>der</strong> Kamerasysteme hat zur Folge, dass die Bildebenen<br />

nicht mehr parallel s<strong>in</strong>d.<br />

Zur Bewertung <strong>der</strong> Plausibilität e<strong>in</strong>er Projektanfor<strong>der</strong>ung<br />

im H<strong>in</strong>blick auf den E<strong>in</strong>satz subpixelgenauer videometrische<br />

Messsysteme haben sich die Beziehungen<br />

178 AVN 5/2009

0<br />

B<br />

0 1 B<br />

jdxj B<br />

@ jdyj A ¼ B<br />

jdzj B<br />

@ z<br />

B<br />

J. Wollnack – <strong>3D</strong>/<strong>6D</strong>-<strong>Visionsysteme</strong> <strong>und</strong> <strong>Lasermessverfahren</strong> <strong>in</strong> <strong>der</strong> <strong>Robotik</strong> <strong>und</strong> Fertigungstechnik <strong>der</strong> Luftfahrt<strong>in</strong>dustrie<br />

0<br />

B<br />

@<br />

Mx<br />

qxPx<br />

My<br />

qyPy<br />

Mx<br />

qxPx<br />

1<br />

C<br />

A<br />

þ My<br />

qyPy<br />

1<br />

C<br />

C;<br />

mit<br />

C<br />

A<br />

Mxy : ¼ Sichtfeldgröße im Weltkoord<strong>in</strong>atenmaßstab<br />

Pxy : ¼ Sensorpixelzahl<br />

qxy : ¼ Subpixelmessgenauigkeit ð4Þ<br />

bewährt. E<strong>in</strong>e „echte“ subpixelgenaue Positionsmessung<br />

beruht letztlich auf <strong>der</strong> Bestimmung des Wendepunktes<br />

e<strong>in</strong>es geeigneten Grauwertkantenmodells. Die Lage dieses<br />

Wendepunkts ist <strong>in</strong>variant gegenüber <strong>der</strong> optischen<br />

Bandbreite des Systems, weshalb nicht e<strong>in</strong>e maximale optische<br />

Bandbreite bzw. Bildschärfe, son<strong>der</strong>n e<strong>in</strong>e Verschleifung<br />

<strong>der</strong> optischen Sprungantwort auf 2–4 Pixel<br />

für die subpixelgenaue Kantenschätzung von Vorteil ist.<br />

Wird bei <strong>der</strong> Kantenschätzung e<strong>in</strong>e Interpolation <strong>der</strong><br />

Grauwerte auf Subpixelorten vorgenommen, so ist e<strong>in</strong>e<br />

alias<strong>in</strong>garme Ortsdiskretisierung <strong>und</strong> damit maximale<br />

Blendenzahl anzustreben. Die Genauigkeit <strong>der</strong> Positionsmessung<br />

wird bei PLL-synchronisiertem System auf ca.<br />

1/20 Pixel begrenzt. Unterhalb von 1/20 Pixel ist e<strong>in</strong>e<br />

digitale Datenübertragung, die heute Stand <strong>der</strong> Technik<br />

ist, erfor<strong>der</strong>lich. Die Genauigkeiten digitaler Systeme<br />

werden aufgr<strong>und</strong> von Inhomogenitäten <strong>der</strong> Beleuchtungsquellen<br />

<strong>und</strong> <strong>der</strong> optischen Eigenschaften <strong>der</strong> Materialien<br />

auf ca. 1/100 Pixel begrenzt. E<strong>in</strong>e weitere Genauigkeitssteigerung<br />

<strong>der</strong> Messung durch Anwendung von Rauschfilterverfahren<br />

lässt sich nur bei diesen Systemen vollziehen.<br />

Jedoch lassen sich bereits mit e<strong>in</strong>fachen <strong>und</strong> schnellen<br />

Flächenschwerpunktverfahren Subpixelgenauigkeiten<br />

von 1/10 bis zu e<strong>in</strong>em 1/25 Pixel umsetzen, sofern die Objektflächen<br />

nicht unter ca. 16 Pixel 2 geraten. Auch hier<br />

wird e<strong>in</strong>e Limitierung <strong>der</strong> optischen Bandbreite e<strong>in</strong>e Genauigkeitssteigerung<br />

bewirken. E<strong>in</strong>e möglichst genaue<br />

Positionsmessung bed<strong>in</strong>gt ebenso e<strong>in</strong>e weitgehende Nutzung<br />

<strong>der</strong> Grauwertdynamik des Bildaufnahmesystems.<br />

H<strong>in</strong>sichtlich <strong>der</strong> mechanischen Stabilität <strong>der</strong> Sensoren<br />

s<strong>in</strong>d für die <strong>in</strong>nere <strong>und</strong> äußere Geometrie über den Abbildungsmaßstab<br />

letztlich analoge technologische Anfor<strong>der</strong>ungen<br />

umzusetzen. Bei e<strong>in</strong>em nach <strong>der</strong> Kalibration auftretenden<br />

systematischen „Driftfehler“ von maximal<br />

e<strong>in</strong>em 1/10 Pixel muss bei CCD/CMOS Zellenabständen<br />

von 10 lm e<strong>in</strong>e <strong>in</strong>nere mechanische Stabilität von ca.<br />

1 lm vorliegen. Die äußere Stabilität kann <strong>in</strong> etwa um<br />

den Abbildungsmaßstab vergrößert angesetzt werden. Unterhalb<br />

von 1/20 Pixel können selbst <strong>in</strong>dustrietaugliche<br />

Kamerasysteme <strong>und</strong> Objektive, die nicht im H<strong>in</strong>blick<br />

auf diese Anfor<strong>der</strong>ungen konzipiert wurden, nur bed<strong>in</strong>gt<br />

zur Anwendung kommen. Auch dies macht deutlich, dass<br />

e<strong>in</strong>e vollautomatische Kalibration von Systemmodellen<br />

für die Praxis attraktiv ist.<br />

Für e<strong>in</strong>e <strong>3D</strong>-Positionsmessung müssen <strong>in</strong> <strong>der</strong> Videometrie<br />

die korrespondierenden idealen unverzerrten Sensorkoor-<br />

d<strong>in</strong>aten <strong>der</strong> Kamerasysteme aus den RAM-Koord<strong>in</strong>aten<br />

über das <strong>in</strong>verse <strong>in</strong>nere Kameramodell<br />

– Inverse Skalierungsfaktoren <strong>und</strong> Hauptkoord<strong>in</strong>aten<br />

x S<br />

y S<br />

¼<br />

Sxðx r HxÞ<br />

Syðy r HyÞ<br />

; ð5:1Þ<br />

– Inverse Kippw<strong>in</strong>kelfehler <strong>der</strong> realen Sensorebene<br />

ðx v y v Þ t ¼ðy I Sx yISyÞt ; mit y I S ¼ pI1 þ ðpI1 eIz ÞðpI1 ðpI 2<br />

p I 1 ¼ Dxð axÞDyð ayÞy<br />

0 v<br />

S<br />

; yv 0<br />

S ¼ðxS ; y S ; 0Þ t <strong>und</strong><br />

pI 2Þ; pI 1ÞeI ;<br />

z<br />

p I 2 ¼ð0; 0; bÞt ; ð5:2Þ<br />

– Inverse radiale L<strong>in</strong>senverzerrungen erster Ordnung<br />

xu yu 1<br />

¼<br />

1 þ vðrvÞ 2<br />

xv yv ; mit r e ffiffiffiffiffiffiffiffiffiffiffiffiffiffiffiffiffiffiffiffiffiffiffiffi<br />

¼ ðxeÞ 2 þðyeÞ 2<br />

q<br />

;<br />

e 2fu; vg; mit<br />

Hx; Hy : ¼ Hauptwerte<br />

Sx; Sy : ¼ Skalierungsfaktoren<br />

ax; ay : ¼ Kippw<strong>in</strong>kelfehler des Sensors<br />

v : ¼ Radiale L<strong>in</strong>senverzerrungen erster Ordnung<br />

b : ¼ Bildweite<br />

ð5:3Þ<br />

ermittelt werden. Mit den korrespondierenden idealen<br />

unverzerrten Sensorkoord<strong>in</strong>aten ðu mÞk ðxu uÞk ,<br />

k 2f1; ...; Kg, K 2 des Multikamerasystems lassen<br />

sich die Sehstrahlgleichungen<br />

r k ¼ðu m bÞ t<br />

ksk; k 2f1; ...; Kg; K 2 ð6Þ<br />

<strong>der</strong> <strong>3D</strong>-Geraden des k-ten Sensors im k-ten Sensorkoord<strong>in</strong>atensystem<br />

aufstellen. Nach Transformation dieser Koord<strong>in</strong>aten<br />

<strong>in</strong>s Referenzkoord<strong>in</strong>atensystem erhält man für<br />

den k-ten Sensor im Referenzkoord<strong>in</strong>atensystem R<br />

r R k ¼ DkR ðu m bÞt ksk þ t R k ; ð7Þ<br />

wor<strong>in</strong> D k R <strong>und</strong> tR k<br />

die Koord<strong>in</strong>atentransformation <strong>in</strong>s Referenzkoord<strong>in</strong>atensystem<br />

beschreiben. Für die Anwendung<br />

ist es zweckmäßig, e<strong>in</strong> Kamerakoord<strong>in</strong>atensystem<br />

zum Referenzkoord<strong>in</strong>atensystem zu erklären. Dessen<br />

Drehmatrix ist dann die E<strong>in</strong>heitsmatrix <strong>und</strong> dessen Translationsvektor<br />

ist null.<br />

Die überbestimmten Schnittpunktgleichungen lassen sich<br />

nicht analytisch lösen. Es muss daher e<strong>in</strong> M<strong>in</strong>imierungsansatz<br />

herangezogen werden. Geht man hierzu von den<br />

Schnittpunktgleichung des i,j-ten Kamerapaars im Referenzkoord<strong>in</strong>atensystem<br />

D i 0 1<br />

u<br />

@<br />

R m A D<br />

b<br />

j<br />

0<br />

0 1 1<br />

u<br />

B<br />

@<br />

@<br />

R m A C<br />

A<br />

b<br />

si<br />

¼ t<br />

sj<br />

R j t R j ;<br />

i<br />

j<br />

i; j 2f1; ...; Kg ð8Þ<br />

t<br />

aus, so kann <strong>der</strong> Lösungsvektor si sj des überbestimmten<br />

Gleichungssystems (8) mit <strong>der</strong> Pseudo<strong>in</strong>versen o<strong>der</strong><br />

<strong>der</strong> numerisch stabileren SVD-Zerlegung<br />

AVN 5/2009 179

J. Wollnack – <strong>3D</strong>/<strong>6D</strong>-<strong>Visionsysteme</strong> <strong>und</strong> <strong>Lasermessverfahren</strong> <strong>in</strong> <strong>der</strong> <strong>Robotik</strong> <strong>und</strong> Fertigungstechnik <strong>der</strong> Luftfahrt<strong>in</strong>dustrie<br />

si<br />

sj<br />

¼ D i 0 0<br />

B<br />

@ @<br />

R<br />

1<br />

u<br />

m A<br />

b<br />

i<br />

D j @<br />

R<br />

0<br />

1 1<br />

u<br />

m A C<br />

A<br />

b<br />

j<br />

1<br />

SVD<br />

ðt R i<br />

t R j<br />

Þ ð9Þ<br />

berechnet werden. Man erhält somit die <strong>3D</strong>-Koord<strong>in</strong>ate<br />

im Referenzkoord<strong>in</strong>atensystem zu:<br />

r R i ¼ Di Rðu m bÞt isi þ t R i<br />

o<strong>der</strong><br />

r R j<br />

¼ DjR<br />

ðu m bÞt jsj þ t R j<br />

bzw. <strong>in</strong> homogenisierter Form:<br />

r R ijH ¼ rR i þ rR j<br />

ð10:1Þ<br />

ð10:2Þ<br />

2<br />

: ð10:3Þ<br />

k : ¼ Kamera<strong>in</strong>dex<br />

bk :<br />

D<br />

¼ Bildweite<br />

k R : ¼ Rotationsmatrix vom Sensor- <strong>in</strong>s Referenzkoord<strong>in</strong>atensystem<br />

tR k : ¼ Translationsvektor vom Sensor- <strong>in</strong>s Referenzkoord<strong>in</strong>atensystem<br />

ðu mÞ t<br />

k : ¼ korrespondierende ideale, unverzerrte CCD/<br />

CMOS-Sensorkoord<strong>in</strong>ate<br />

Bei e<strong>in</strong>em Lichtstrahlprojektions- <strong>und</strong> Kamerasystem<br />

kann man den Sehstrahl des i-ten Kamerasystems durch<br />

den Projektionsstrahl im S<strong>in</strong>ne <strong>der</strong> <strong>in</strong>versen Kamera ersetzen.<br />

Dies gilt analog auch für Lichtebenen <strong>und</strong> projektive<br />

Systeme.<br />

Die <strong>3D</strong>-Positionsmessung korrespondieren<strong>der</strong> Messmarken<br />

x e<strong>in</strong>es Multikamerasystems kann somit als parametrische<br />

Vektorabbildung<br />

r R ¼ fCðp C; xCÞ; xC ¼ x r i yr i xr j yr j<br />

t<br />

C<br />

<strong>und</strong><br />

p C ¼ ðpt R Hx Hy Sx Sy ax ay b vÞ t<br />

i<br />

ðp t R Hx Hy Sx Sy ax ay b vÞ t<br />

j<br />

M<strong>in</strong>p C<br />

!<br />

ð11Þ<br />

gedeutet werden. Der Parametervektor pC des Sensormodells<br />

setzt sich aus den <strong>in</strong>ternen <strong>und</strong> externen Kameraparametern<br />

zusammen. Die externen Parameter s<strong>in</strong>d die<br />

Posen <strong>der</strong> Kamera- zum Referenz-KOS pk R <strong>und</strong> die <strong>in</strong>ternen<br />

s<strong>in</strong>d die Hauptwerte, Skalierungsfaktoren, Sensorkippw<strong>in</strong>kelfehler,<br />

Bildweite <strong>und</strong> radiale L<strong>in</strong>senverzerrungen<br />

erster Ordnung. Dies s<strong>in</strong>d 14 skalare Parameter pro<br />

Kamera. Bei e<strong>in</strong>em Zweikamerasystem, bei dem das<br />

Sensor-KOS <strong>in</strong> e<strong>in</strong>es <strong>der</strong> Kamerasysteme gelegt wird,<br />

s<strong>in</strong>d es somit 22 skalare Parameter.<br />

Die Kalibration des Sensormodells kann über e<strong>in</strong>e M<strong>in</strong>imierung<br />

( )<br />

X<br />

;<br />

m;n;p<br />

kfCðp C; xC mpÞ fCðp C; xC npÞk 2<br />

E<br />

D2 mn<br />

mit kyk 2<br />

E ¼ yty <strong>und</strong><br />

m; n : ¼ Marker<strong>in</strong>dizes<br />

p : ¼ Posen<strong>in</strong>dizes ð12Þ<br />

von im Referenz-KOS bekannten Distanzen Dmn m<strong>in</strong>destens<br />

zweier Messmarken erfolgen. In diesem Fall ist die<br />

Positioniergenauigkeit <strong>der</strong> Pose des Roboters ohne Bedeutung,<br />

weil die Distanzen <strong>in</strong>variant gegenüber Koord<strong>in</strong>atentransformationen<br />

s<strong>in</strong>d. Mit e<strong>in</strong>er re<strong>in</strong>en Distanzkalibration<br />

lassen sich jedoch nicht die maximalen Genauigkeiten<br />

erreichen, weil die systematischen Fehler des zu<br />

kalibrierenden Modells nur differenziell <strong>in</strong> das Gütemaß<br />

e<strong>in</strong>gehen.<br />

Bei <strong>der</strong> Verwendung von drei nicht auf e<strong>in</strong>er Geraden<br />

liegenden Messmarken lässt sich die Roboterpose als<br />

Referenzpose heranziehen, so dass sich die Fehlerpose<br />

Tð pÞ ¼T 1<br />

R TM zwischen Systemmodell <strong>und</strong> Roboter<br />

im S<strong>in</strong>ne von<br />

M<strong>in</strong> p t f pg<br />

mit TM ¼ Tðp TCP<br />

A Þ <strong>und</strong> TR ¼ Tðp TCP<br />

A SollÞ: ð13Þ<br />

m<strong>in</strong>imieren lässt. Hierbei werden die systematischen <strong>und</strong><br />

zufälligen Positionierfehler des Roboters die Genauigkeit<br />

<strong>der</strong> Sensorkalibration limitieren, sofern <strong>der</strong> Roboter nicht<br />

<strong>in</strong> die Kalibration mit e<strong>in</strong>bezogen wird. E<strong>in</strong>e M<strong>in</strong>imierung<br />

<strong>der</strong> Fehlerpose (13) anstatt <strong>der</strong> homogenen Fehlermatrix<br />

bietet den Vorteil, dass man sowohl auf e<strong>in</strong>fache Weise die<br />

Orthogonalität <strong>der</strong> Drehmatrix erzw<strong>in</strong>gt als auch die<br />

Mehrdeutigkeiten <strong>der</strong> Orientierung h<strong>in</strong>sichtlich <strong>der</strong> Periodizität<br />

<strong>in</strong> m2p <strong>und</strong> <strong>der</strong> existierenden zwei Lösungen<br />

umgeht.<br />

E<strong>in</strong>e Reduktion <strong>der</strong> zufälligen Messfehler kann man<br />

durch e<strong>in</strong>e überbestimmte Kalibration erzielen. Dabei<br />

wird bei näherungsweise normalverteilten Störungen<br />

die Überbestimmtheit quadratisch mit dem reziproken<br />

Vertrauens<strong>in</strong>tervall <strong>der</strong> Parameter wachsen. E<strong>in</strong>e nicht<br />

überbestimmte Kalibration erfor<strong>der</strong>t <strong>in</strong> diesen Fällen m<strong>in</strong>destens<br />

22 bzw. 6 unterschiedliche Roboterposen.<br />

Die geometrischen Kameramodelle s<strong>in</strong>d im allgeme<strong>in</strong>en<br />

h<strong>in</strong>sichtlich <strong>der</strong> Parameteridentifikation numerisch<br />

schlecht konditioniert, weil bei den typisch vorliegenden<br />

ger<strong>in</strong>gen (<strong>in</strong>ternen) Sensorkippw<strong>in</strong>kelfehlern (< 0,1 ) relativ<br />

starke Korrelationen zwischen <strong>der</strong> äußeren <strong>und</strong> <strong>in</strong>neren<br />

Orientierung, äußeren <strong>und</strong> <strong>in</strong>neren Positionen sowie<br />

dem z-Abstand, <strong>der</strong> Bildweite <strong>und</strong> den Skalenfaktoren bestehen.<br />

H<strong>in</strong>zukommt, dass die Pseudo<strong>in</strong>verse (9) letztlich<br />

e<strong>in</strong>e Least-Square-Schätzung vollzieht, weshalb Orientierungsän<strong>der</strong>ungen<br />

<strong>der</strong> Kamerasysteme zue<strong>in</strong>an<strong>der</strong> teilweise<br />

e<strong>in</strong>en relativ ger<strong>in</strong>gen E<strong>in</strong>fluss auf die <strong>3D</strong>-Positionsmessung<br />

nehmen.<br />

Diese Probleme lassen sich nur mit Hilfe <strong>der</strong> anfangs diskutierten<br />

strukturierten hierarchischen Kalibration entschärfen.<br />

Des Weiteren müssen die m<strong>in</strong>imalen Sehstrahlenabstände<br />

<strong>der</strong> <strong>3D</strong>-Koord<strong>in</strong>aten mit <strong>in</strong> das Gütekriterium<br />

<strong>der</strong> M<strong>in</strong>imierung e<strong>in</strong>bezogen werden.<br />

5 Vollautomatische Sensor-, Sensor-Greifer<strong>und</strong><br />

Roboter-Kalibration<br />

Die vollautomatische Sensor-, Sensor-Greifer- <strong>und</strong> Roboter-Kalibration<br />

nutzt die Möglichkeiten <strong>der</strong> strukturierten<br />

hierarchischen Modellkalibration sukzessive aus. Ausgehend<br />

von e<strong>in</strong>er ausreichenden Anzahl von Roboter- bzw.<br />

Messposen kann man das Gesamtsystem vollautomatisch<br />

kalibrieren, wobei man mit Hilfe <strong>der</strong> numerischen Ranga-<br />

180 AVN 5/2009

J. Wollnack – <strong>3D</strong>/<strong>6D</strong>-<strong>Visionsysteme</strong> <strong>und</strong> <strong>Lasermessverfahren</strong> <strong>in</strong> <strong>der</strong> <strong>Robotik</strong> <strong>und</strong> Fertigungstechnik <strong>der</strong> Luftfahrt<strong>in</strong>dustrie<br />

nalysen den Anwen<strong>der</strong> ohne tieferes Verständnis von den<br />

Zusammenhängen zu e<strong>in</strong>er s<strong>in</strong>nvollen Bewegungsstrategie<br />

führen kann.<br />

Damit lässt sich folgen<strong>der</strong> vollautomatischer Ablauf umsetzen:<br />

1. Nach Betätigung <strong>der</strong> Kalibrationstaste fährt <strong>der</strong> Roboter<br />

<strong>in</strong> die zur Kalibration def<strong>in</strong>ierten o<strong>der</strong> „ge-teachten“<br />

Posen. Die Robotersteuerung setzt nach Abschluss <strong>der</strong><br />

Bewegung e<strong>in</strong>en Messbefehl an das Sensorsystem ab,<br />

wodurch die Messmarkenkoord<strong>in</strong>aten im RAM-KOS<br />

gemessen werden. Die Daten <strong>der</strong> TCP-Sollposen,<br />

Messmarkenkoord<strong>in</strong>aten im RAM-KOS <strong>und</strong> die Masch<strong>in</strong>enkoord<strong>in</strong>aten<br />

e<strong>in</strong>schließlich <strong>der</strong> Roboter- <strong>und</strong><br />

Sensornamen <strong>und</strong> <strong>der</strong>en e<strong>in</strong>deutige Identifikationsbezeichnungen<br />

werden zur Kalibration <strong>und</strong> für die Dokumentation<br />

<strong>in</strong> e<strong>in</strong>em Datenfile gesichert. Die ersten zwei<br />

Bewegungen s<strong>in</strong>d so zu vollziehen, dass die analytische<br />

Identifikation im 3. Schritt möglich wird (Translation<br />

<strong>und</strong> zwei nicht l<strong>in</strong>ear abhängige Drehungen).<br />

2. Anschließend wird die hierarchische Identifikation <strong>in</strong>nerer<br />

Kameraparameter <strong>der</strong> Kamera C0 sowie <strong>in</strong>nerer<br />

<strong>und</strong> äußerer Kameraparameter <strong>der</strong> Kamera C1 mittels<br />

Distanzmaßen (Startwerte s<strong>in</strong>d konstruktive Nom<strong>in</strong>alwerte)<br />

dreier nicht auf e<strong>in</strong>er Geraden liegenden Messmarken<br />

gestartet. Nach Ablauf dieses Prozesses lässt<br />

sich e<strong>in</strong>e <strong>3D</strong>-Positionsmessung <strong>in</strong> Kamera C0 M verwirklichen.<br />

Kann man <strong>in</strong> <strong>der</strong> Anwendung mit <strong>der</strong> erreichten<br />

Genauigkeit dieses Verfahrens arbeiten, so<br />

ist e<strong>in</strong>e weitere strukturelle Variation des Kalibrationsmodells<br />

nicht erfor<strong>der</strong>lich, so dass man den 5. <strong>und</strong> 6.<br />

Prozessschritt auslassen kann.<br />

3. Mit den vorherigen Prozessschritten lassen sich die<br />

Messmarkenkoord<strong>in</strong>aten im Sensorkoord<strong>in</strong>atensystem<br />

M berechnen. An den drei nicht auf e<strong>in</strong>er Geraden liegenden<br />

o<strong>der</strong> mehreren Messmarken lässt sich e<strong>in</strong>e Posemessung<br />

umsetzen, womit die analytische Identifikation<br />

<strong>der</strong> Transformation Mess- zu TCP-KOS über die<br />

ersten zwei TCP-Soll-Bewegungen bzw. drei TCP-<br />

Soll-Posen möglich wird [37, 40]. Hierbei dient <strong>der</strong> Roboter<br />

letztlich als Referenzsystem.<br />

4. Nach Ausführung des vorherigen Schrittes lässt sich<br />

über die TCP-Soll-Pose e<strong>in</strong>e analytische Identifikation<br />

<strong>der</strong> Transformation Referenz- zu Robotersteuerungs-<br />

KOS bereits aus e<strong>in</strong>er Messstellung über TðpR AÞ¼ TðpTCP A ÞTðpM TCPÞTðpR MÞ berechnen. Der Roboter dient<br />

auch hier analog zu Schritt vier als Referenzsystem.<br />

5. Nach dem sämtliche Koord<strong>in</strong>atentransformationen bekannt<br />

s<strong>in</strong>d, lässt sich das Sensormodell mittels Posemessung<br />

anhand dreier Messmarken kalibrieren. Dabei<br />

können die <strong>in</strong> den vorherigen Prozessschritten identifizierten<br />

Parameter als hochwertige Schätzungen <strong>der</strong><br />

Startwerte des M<strong>in</strong>imierers herangezogen werden, weshalb<br />

e<strong>in</strong>e hierarchische Nachkalibration des Sensorsystems<br />

mit dem Roboter als Referenzsystem möglich<br />

wird. Typischerweise determ<strong>in</strong>ieren hierbei die systematischen<br />

Positionerfehler des Roboters die Kalibrationsgüten<br />

des Sensorsystems (Zufällige Positionierfehler<br />

fallen zumeist um e<strong>in</strong>e Größenordnung ger<strong>in</strong>ger<br />

aus).<br />

6. Nach Bedarf ließe sich <strong>in</strong> diesem Schritt das Robotermodell<br />

(2) mit <strong>in</strong> den Kalibrationsprozess <strong>in</strong>tegrieren.<br />

Abb. 4: Sensor-, TCP- Greif- <strong>und</strong> Referenz-KOS<br />

(G: ¼ Greif-KOS)<br />

Verzichtet man hierauf, so werden im Idealfall die systematischen<br />

Sensormessfehler <strong>in</strong> <strong>der</strong> Größenordnung<br />

<strong>der</strong> systematischen Positionierfehler des Robotersystems<br />

liegen [33]. Die <strong>in</strong> den vorherigen Schritten identifizierten<br />

Modellparameter können als hochwertige<br />

Schätzungen <strong>der</strong> Startwerte des M<strong>in</strong>imierers betrachtet<br />

werden, weshalb e<strong>in</strong>e hierarchische Nachkalibration<br />

des Gesamtsystems möglich wird, was im allgeme<strong>in</strong>en<br />

zu e<strong>in</strong>er deutlichen Genauigkeitssteigerung h<strong>in</strong>sichtlich<br />

systematischer Fehler führt. Hierbei entstünde jedoch<br />

e<strong>in</strong>e Mehrdeutigkeit im S<strong>in</strong>ne e<strong>in</strong>es Maßstabsfaktors,<br />

wenn man nicht die Distanzenfehler zwischen den Markern<br />

im Weltkoord<strong>in</strong>atenmaßstab mit <strong>in</strong> das Gütekriterium<br />

aufnimmt.<br />

7. Für die analytische Identifikation <strong>der</strong> TCP-Greiferbzw.<br />

Sensor-Greifer-Relation kann e<strong>in</strong> preiswerter Kalibrierkörper<br />

ebenfalls mit drei Messmarken e<strong>in</strong>gesetzt<br />

werden (siehe Abb. 4). Nachdem <strong>der</strong> Roboter den Kalibrierkörper<br />

aufgenommen hat, wird e<strong>in</strong>e Messung<br />

mit dem kalibrierten Sensorsystem vollzogen. Damit<br />

lässt sich dann die gesuchte Pose über T G TCP ¼<br />

T M TCP TR M TR G Þ 1 berechnen. Hierbei ließen sich ferner<br />

vorliegende Symmetrien berücksichtigen. In analoger<br />

Weise können an<strong>der</strong>e Werkzeuge vollautomatisch e<strong>in</strong>gemessen<br />

werden.<br />

Die Integration sowohl von <strong>3D</strong>-Positionsmesssystemen<br />

als auch die für die Kalibration <strong>und</strong> Roboterführung erfor<strong>der</strong>lichen<br />

Algorithmen ließe sich entwe<strong>der</strong> <strong>in</strong> <strong>der</strong> Robotersteuerung<br />

o<strong>der</strong> über Client-Server Applikation auf externen<br />

Rechnersysteme umsetzen (siehe Abb. 5). Ebenso<br />

s<strong>in</strong>d hybride Formen realisierbar. Die Kommunikation <strong>der</strong><br />

Systeme untere<strong>in</strong>an<strong>der</strong> kann z.B. auf Basis von XML-Protokollen,<br />

„Remote Procedure Calls“ o<strong>der</strong> speziell von den<br />

Roboterherstellern angebotenen Kommunikations-Interfacen<br />

(z.B: KUKA via XML <strong>und</strong> Fanuc via Fanuc Robot<br />

Server) verwirklicht werden.<br />

Mit dem vermehrten E<strong>in</strong>zug von PC-basierten Robotersteuerungssystemen<br />

wird mehr <strong>und</strong> mehr e<strong>in</strong>e Integration<br />

direkt <strong>in</strong> die Robotersteuerung im Bereich des Möglichen<br />

liegen. Letztlich ist dies sowohl wirtschaftlich als auch<br />

technologisch die attraktivste Lösung. Offene Steuerungssysteme<br />

sollten <strong>in</strong> diesem S<strong>in</strong>ne mehr als Chance für e<strong>in</strong>e<br />

AVN 5/2009 181

J. Wollnack – <strong>3D</strong>/<strong>6D</strong>-<strong>Visionsysteme</strong> <strong>und</strong> <strong>Lasermessverfahren</strong> <strong>in</strong> <strong>der</strong> <strong>Robotik</strong> <strong>und</strong> Fertigungstechnik <strong>der</strong> Luftfahrt<strong>in</strong>dustrie<br />

weitere Verbreitung <strong>der</strong> Robotertechnologien als e<strong>in</strong>e Gefahr<br />

gesehen werden. Für die Roboterhersteller wichtiges<br />

System-Know-how muss damit nicht preisgegeben werden.<br />

Im diesem S<strong>in</strong>ne kann die Initiative von Bill Gates auf<br />

dem Gebiet <strong>der</strong> <strong>Robotik</strong> e<strong>in</strong>en signifikanten Entwicklungsschub<br />

<strong>in</strong>duzieren [9], den etablierte Roboterhersteller<br />

rechtzeitig mit <strong>in</strong> ihre Überlegungen <strong>und</strong> Entwicklungen<br />

e<strong>in</strong>beziehen sollten. Bedenkt man, dass vermutlich <strong>in</strong><br />

ca. 5 bis 10 Jahren auf e<strong>in</strong>em Chip preiswert Rechnerleistungen<br />

zur Verfügung stehen [5], die heutigen Großrechnern<br />

vorbehalten s<strong>in</strong>d, so wird die Systemkalibration<br />

selbst hochkomplexer Systeme, iterative Inversenberechnung<br />

<strong>der</strong> k<strong>in</strong>ematischen Transformation des mit Achsw<strong>in</strong>kelfehlern<br />

behafteten k<strong>in</strong>ematischen Modells im Zusammenhang<br />

mit <strong>der</strong> Echtzeitbahn<strong>in</strong>terpolation bis h<strong>in</strong> zur<br />

Berechnung <strong>der</strong> k<strong>in</strong>ematischen Inversen an praxisrelevanten<br />

S<strong>in</strong>gularitäten <strong>der</strong> Masch<strong>in</strong>enkoord<strong>in</strong>aten, um nur e<strong>in</strong>iges<br />

zu nennen, unter den jeweils spezifischen Echtzeitanfor<strong>der</strong>ungen<br />

umgesetzt werden können.<br />

6 Technisch <strong>und</strong> wirtschaftliche Potenziale<br />

Nach Ausführung <strong>der</strong> o.g. Prozessschritte können sämtliche<br />

Modellparameter <strong>und</strong> Koord<strong>in</strong>atentransformationen<br />

des stationären Systemmodells als h<strong>in</strong>reichend genau bekannt<br />

betrachtet werden, womit das Robotersystem sensoriell<br />

<strong>in</strong> <strong>6D</strong> bzw. <strong>der</strong> Pose exakt zu führen ist.<br />

Mit e<strong>in</strong>em <strong>der</strong>art kalibrierten System lassen sich sowohl<br />

globale als auch lokale Objektposen messen <strong>und</strong> <strong>in</strong> Bezug<br />

auf e<strong>in</strong> Objekt def<strong>in</strong>ierte Bewegungsaufgaben mit <strong>der</strong> für<br />

die Praxis erfor<strong>der</strong>lichen Genauigkeit <strong>in</strong> das Roboter-<br />

Steuerungs-KOS überführen. Somit können entwe<strong>der</strong> aufwendige<br />

Teach-Vorgänge entfallen, was zu e<strong>in</strong>er hohen<br />

Produktflexibilität führt o<strong>der</strong> bereits „ge-teachte“ Prozesse<br />

auf e<strong>in</strong>fache Weise auf an<strong>der</strong>e Roboter o<strong>der</strong> roboterunterstützte<br />

Fertigungssysteme übertragen werden.<br />

Zudem können <strong>in</strong>dividuelle Fertigungstoleranzen <strong>der</strong> Objekte<br />

erfasst <strong>und</strong> im S<strong>in</strong>ne e<strong>in</strong>es Pose-Regelkreises ausgeglichen<br />

werden, womit e<strong>in</strong> adaptives Positionierverhalten<br />

erschlossen wird. Letztlich können auch temperatur-,<br />

schwerkraft- bzw. kraft- <strong>und</strong> momentenbed<strong>in</strong>gte Verfor-<br />

Abb. 5: Integrationsszenario<br />

mungen sowohl <strong>der</strong> Objekte als auch <strong>der</strong> Roboterk<strong>in</strong>ematik<br />

erfasst <strong>und</strong> ausgeglichen werden. Dies gilt bis h<strong>in</strong> zu<br />

Verän<strong>der</strong>ungen <strong>der</strong> Geometrierelationen zwischen den<br />

Anlagenteilen, wodurch e<strong>in</strong>e preiswerte F<strong>und</strong>amentierung<br />

<strong>und</strong> Leichtbauweise im Bereich des Möglichen liegt<br />

[34, 35, 36, 38, 39, 40].<br />

Die flexible, automatisierte Montage von Großbauteilen<br />

<strong>in</strong> <strong>der</strong> Luftfahr<strong>in</strong>dustrie erfor<strong>der</strong>t sowohl e<strong>in</strong>e Bauteilform-<br />

<strong>und</strong> Lagekorrektur als auch <strong>in</strong>dividuelle Erfassung<br />

<strong>der</strong> Bauteilgeometrien [35, 38]. Dies wird bei e<strong>in</strong>em zunehmenden<br />

E<strong>in</strong>satz von CFK-Bauteilen mehr <strong>und</strong> mehr<br />

an Bedeutung gew<strong>in</strong>nen. Zur Informationsbeschaffung<br />

werden verschiedene lokale <strong>und</strong> globale Sensoren e<strong>in</strong>gesetzt<br />

(siehe Abb. 6). Mit Hilfe dieser Sensoren wird e<strong>in</strong>e<br />

Form- <strong>und</strong> Lagekorrektur verwirklicht, wobei für die<br />

Formkorrektur überwiegend das globale Messsystem (Laser-Tracker)<br />

herangezogen wird.<br />

Lokale Sensoren (videometrische Messsysteme) werden<br />

<strong>in</strong> <strong>der</strong> letzten Phase <strong>der</strong> Posebahnführung e<strong>in</strong>gesetzt,<br />

Abb. 6: Flexible Flugzeugmontagezelle (Bauteilform- <strong>und</strong><br />

Lagekorrektur)<br />

182 AVN 5/2009

J. Wollnack – <strong>3D</strong>/<strong>6D</strong>-<strong>Visionsysteme</strong> <strong>und</strong> <strong>Lasermessverfahren</strong> <strong>in</strong> <strong>der</strong> <strong>Robotik</strong> <strong>und</strong> Fertigungstechnik <strong>der</strong> Luftfahrt<strong>in</strong>dustrie<br />

Abb. 7: Großbauteilhandl<strong>in</strong>g mit kooperierenden seriellen Robotern (Fotos: Roman Jupitz)<br />

um e<strong>in</strong>en Best-Fit-Ausgleich zwischen benachbarten Bauteilen<br />

bzw. <strong>der</strong>en Schnittstellen herstellen zu können. Um<br />

lokale Messmerkmale <strong>in</strong> e<strong>in</strong> geme<strong>in</strong>sames Koord<strong>in</strong>atensystem<br />

überführen zu können, müssen die Posebeziehungen<br />

<strong>der</strong> lokalen Sensoren zum Referenz-KOS bekannt<br />

se<strong>in</strong>. Diese Beziehungen können gezielt e<strong>in</strong>gemessen<br />

o<strong>der</strong> durch bekannte Bewegungen <strong>der</strong> Messmerkmale ermittelt<br />

werden. Die Messmerkmale repräsentieren hierbei<br />

geometrisch dreidimensionale Objekte, an dieser Stelle<br />

überwiegend <strong>3D</strong>-Raumpunkte bzw. <strong>der</strong>en Ortsvektoren.<br />

Obwohl kalibrierte Aktuatoren o<strong>der</strong> Roboter für iterativ<br />

lernende Ansätze ke<strong>in</strong>eswegs zw<strong>in</strong>gend s<strong>in</strong>d, führen diese<br />

zu e<strong>in</strong>er Beschleunigung iterativer Verfahren. Diese können<br />

durch Messung realer Bewegungen, wie oben gezeigt,<br />

kalibriert werden. Es können dabei serielle, parallele o<strong>der</strong><br />

serielle kartesische K<strong>in</strong>ematiken auch <strong>in</strong> hybri<strong>der</strong> Form<br />

zum E<strong>in</strong>satz kommen.<br />

Je nach Genauigkeitsanfor<strong>der</strong>ungen <strong>und</strong> Umweltbed<strong>in</strong>gungen<br />

müssen Eigenschaften verwendeter Systemmodelle<br />

als stark o<strong>der</strong> schwach zeitvariant betrachtet werden.<br />

Man denke hier z.B. an Temperaturschwankungen, lastbed<strong>in</strong>gte<br />

Verformungen <strong>der</strong> Anlagenteile o<strong>der</strong> auch tidenhubabhängige<br />

Bewegungen von Hallenf<strong>und</strong>amenten. Deshalb<br />

kann entwe<strong>der</strong> e<strong>in</strong>e E<strong>in</strong>messung <strong>der</strong> Systemmodelle<br />

nach dem Aufbau e<strong>in</strong>er Anlage vor dem E<strong>in</strong>takten e<strong>in</strong>es<br />

zu montierenden Bauteils o<strong>der</strong> onl<strong>in</strong>e während des Montageprozesses<br />

notwendig se<strong>in</strong>. In diesem Zusammenhang<br />

ist <strong>in</strong>sbeson<strong>der</strong>e e<strong>in</strong>e gezielte Kalibration ausschließlich<br />

sich verän<strong>der</strong>n<strong>der</strong> Parameter von wirtschaftlichem Interesse.<br />

Mit diesen Ansätzen wurde e<strong>in</strong>e flexible Großbauteilmontagezelle<br />

zusammen mit KUKA im Rahmen e<strong>in</strong>es 2004<br />

veranstalteten Symposiums demonstriert (siehe Abb. 7),<br />

e<strong>in</strong> Versuchstand zur Bauteilform- <strong>und</strong> Lagekorrektur<br />

(siehe Abb. 8), e<strong>in</strong>e Roboterkalibration <strong>und</strong> e<strong>in</strong>e sensoriell<br />

geführte Roboterzelle umgesetzt (siehe Abb. 9).<br />

Insgesamt liegen dezidierte Erfahrungen vor, die e<strong>in</strong>e<br />

Umsetzung <strong>in</strong> wirtschaftlich attraktive Produkte <strong>und</strong> Systemlösungen<br />

zulassen. Die oben erörterten Ansätze können<br />

sowohl für Sensoren am TCP als auch für im Raum<br />

stehende Sensorsysteme herangezogen werden. Lediglich<br />

die Messpose des Sensorsystems ist dann als <strong>in</strong>verse<br />

Transformation heranzuziehen. Letzteres ist mehr für<br />

die Luftfahrt<strong>in</strong>dustrie von Interesse.<br />

Insgesamt können die systematischen Posefehler typischerweise<br />

um e<strong>in</strong>e Größenordnung reduziert werden.<br />

Im Zusammenhang mit dem Pose-Regelkreis werden<br />

die systematischen Posefehler <strong>in</strong> die Größenordnung<br />

<strong>der</strong> Wie<strong>der</strong>holgenauigkeit streben [33, 40]. Das Konvergenzverhalten<br />

h<strong>in</strong>sichtlich <strong>der</strong> systematischen <strong>und</strong> zufälligen<br />

Fehler kommt den Anfor<strong>der</strong>ungen <strong>der</strong> Praxis entgegen<br />

[39]. Dies gilt <strong>in</strong> analoger Weise für die systematischen<br />

bzw. absoluten Posefehler des kalibrierten Robotermodells<br />

bzw. Gesamtsystems. Damit können bei nicht zu<br />

extremen Genauigkeitsanfor<strong>der</strong>ungen die E<strong>in</strong>satzbereiche<br />

von Industrierobotern sowohl zu Lasten <strong>der</strong> Son<strong>der</strong>- als<br />

auch Werkzeugmasch<strong>in</strong>en erweitert werden. Ebenso<br />

kann <strong>der</strong> Montageautomatisierung im Kontext mit e<strong>in</strong>er<br />

montagegerechten Konstruktion sowie dem zumeist bewusst<br />

e<strong>in</strong>geplanten Greiferspiel bzw. den Greiferelastizitäten<br />

e<strong>in</strong>e gewisse Konkurrenz durch sensoriell ergänzte<br />

Robotersysteme erwachsen. Diese Systemkalibration löst<br />

ebenso die Problematik, die bei „Walk<strong>in</strong>g Mach<strong>in</strong>es“ auftritt,<br />

da auch bei ihnen <strong>der</strong> Zusammenhang zwischen Bewegung,<br />

Sensor <strong>und</strong> Werkzeug hergestellt werden muss.<br />

E<strong>in</strong>e Erweiterung des videometrischen <strong>3D</strong>-Positionsmesssystems<br />

um Laser-Po<strong>in</strong>ter-, Laser-L<strong>in</strong>ien- (Light<br />

Amplification by Stimulated Emission of Radiation)<br />

<strong>und</strong> Muster-Projektoren lässt sich leicht bewerkstelligen,<br />

wenn man die Projektionse<strong>in</strong>heit nicht als <strong>in</strong>verse Kamera<br />

heranzieht (siehe Abb. 10).<br />

Man kann so auf e<strong>in</strong>fache <strong>und</strong> preiswerte Weise robuste<br />

topographische Geometriemessungen an Objekten vollziehen.<br />

Optische Verzerrungen <strong>der</strong> Projektionse<strong>in</strong>heit<br />

s<strong>in</strong>d dabei ohne Belang <strong>und</strong> e<strong>in</strong>e Kalibration des Projektormodells<br />

ist so nicht erfor<strong>der</strong>lich. Die Korrespondenz-<br />

Abb. 8: Versuchsstand Bauteilform- <strong>und</strong> Lagekorrektur<br />

(Fotos: Roman Jupitz)<br />

AVN 5/2009 183

J. Wollnack – <strong>3D</strong>/<strong>6D</strong>-<strong>Visionsysteme</strong> <strong>und</strong> <strong>Lasermessverfahren</strong> <strong>in</strong> <strong>der</strong> <strong>Robotik</strong> <strong>und</strong> Fertigungstechnik <strong>der</strong> Luftfahrt<strong>in</strong>dustrie<br />

Abb. 9: Videometrie <strong>und</strong> <strong>Robotik</strong> (Systemkalibration)<br />

Abb. 10: <strong>3D</strong>-Videoemetrie mit Multi-Kamera <strong>und</strong> Projektor<br />

bestimmung lässt sich über die Epipolare des kalibrierten<br />

Multikameramodells im Zusammenhang mit <strong>der</strong> Sehstrahlenabstandsberechnung<br />

sowohl evident beschleunigen<br />

als auch e<strong>in</strong>deutig lösen.<br />

Derartige Technologien werden mit hoher Wahrsche<strong>in</strong>lichkeit<br />

<strong>in</strong> den nächsten Jahren sowohl generell für die<br />

Automatisierung als auch speziell für die Weiterentwicklung<br />

des roboterunterstützten Laser-Remote-Schweißens<br />

bis h<strong>in</strong> zur Remote Schweißnahtverfolgung bedeutsam<br />

se<strong>in</strong> (siehe Abb. 11). Hiervon wird nicht zuletzt auch<br />

die Automobil- <strong>und</strong> Luftfahrt<strong>in</strong>dustrie profitieren können.<br />

Iteration <strong>und</strong> Lernvorgänge s<strong>in</strong>d auf e<strong>in</strong>er abstrakten Ebene<br />

äquivalent, weshalb man vermutlich sowohl <strong>in</strong> <strong>der</strong> belebten<br />

Natur als auch beim Menschen für das Lernen das<br />

Pr<strong>in</strong>zip <strong>der</strong> Wie<strong>der</strong>holung genutzt wird. Er<strong>in</strong>nern wir uns<br />

daran, wie oft wir e<strong>in</strong>en Ball fangen mussten, bis unsere<br />

Hand-Augen-Koord<strong>in</strong>ation e<strong>in</strong>igermaßen gut tra<strong>in</strong>iert<br />

war. Letztlich machen wir dies bei <strong>der</strong> Systemkalibration<br />

<strong>in</strong> gewisser Weise auch. Es liegt daher <strong>der</strong> E<strong>in</strong>satz e<strong>in</strong>es<br />

neuronalen Netzes als Systemmodell nahe. Dies macht <strong>in</strong><br />

<strong>der</strong> Technik <strong>in</strong> <strong>der</strong> Regel jedoch nur dann S<strong>in</strong>n, wenn zudem<br />

e<strong>in</strong> Struktur-Identifikationsproblem vorliegt.<br />

7 Empirisches Genauigkeitsverhalten<br />

Die Genauigkeitskontrolle des Gesamtsystems bestehend<br />

aus Industrieroboter <strong>und</strong> <strong>3D</strong>-Sensor kann durch e<strong>in</strong>en Vergleich<br />

mit e<strong>in</strong>em Referenzmesssystem, Referenznormalen<br />

o<strong>der</strong> Prüfkörpern erfolgen. Dabei lassen sich (äquidistant)<br />

im Messvolumen verteilte Messpunkte o<strong>der</strong> im<br />

Messvolumen def<strong>in</strong>ierte Messl<strong>in</strong>ien o<strong>der</strong> -ebenen heranziehen<br />

an bzw. auf denen das Verhalten des Systems charakterisiert<br />

wird. Durch den Vergleich von Ist- <strong>und</strong> Sollwerten<br />

können dann die das System beschreibenden Genauigkeitskenngrößen<br />

ermittelt werden.<br />

Abb. 11: Roboterunterstütztes<br />

Remote-Laser-Schweißen<br />

184 AVN 5/2009

J. Wollnack – <strong>3D</strong>/<strong>6D</strong>-<strong>Visionsysteme</strong> <strong>und</strong> <strong>Lasermessverfahren</strong> <strong>in</strong> <strong>der</strong> <strong>Robotik</strong> <strong>und</strong> Fertigungstechnik <strong>der</strong> Luftfahrt<strong>in</strong>dustrie<br />

Abb. 12: Positionierfehler D <strong>der</strong> Kugelradien (Sensor<strong>und</strong><br />

Roboterkalibration bzw. Systemkalibration mittels Referenzmarken)<br />

Für die Charakterisierung des Positionierverhaltens des<br />

unkalibrierten Industrieroboters wurde als Referenzsystem<br />

e<strong>in</strong> Laser-Tracker von Leica herangezogen. Da dessen<br />

Unsicherheiten um e<strong>in</strong>e Größenordnung ger<strong>in</strong>ger als<br />

die Genauigkeit des zu bewertenden Systems ausfallen,<br />

können diese <strong>in</strong> erster Näherung als sicher betrachtet werden<br />

(Unsicherheiten Kugelradien um Messpunkt:<br />

L 0 ¼ 5 l=m; r ¼ 5 lm; ca. 10 %-tigen Fehleranteil hat<br />

die Referenz). Die Posemessung erfolgte mittels dreier<br />

am Tool Center Po<strong>in</strong>t applizierten Tripelspiegeln.<br />

Zur Charakterisierung des absoluten Positionierverhaltens<br />

wurden im Raum liegende Diagonalen, die sich <strong>in</strong> <strong>der</strong> vor<strong>der</strong>en<br />

Sphäre des Arbeitsraumes des Industrieroboters bef<strong>in</strong>den,<br />

gewählt. Für die Berechnung des Fehlerverhaltens<br />

müssen die Soll- <strong>und</strong> gemessenen Ist-werte <strong>in</strong> e<strong>in</strong>em geme<strong>in</strong>samen<br />

Koord<strong>in</strong>atensystem beschrieben werden. Die<br />

hierfür zu bestimmende Koord<strong>in</strong>atentranformation wurde<br />

über e<strong>in</strong> M<strong>in</strong>imierungsansatz, <strong>der</strong> sämtliche Fehler zwischen<br />

den Ist- <strong>und</strong> Sollkoord<strong>in</strong>aten <strong>der</strong> Messpunkte m<strong>in</strong>imiert,<br />

ermittelt. Der mittlere systematische Positionsfehler<br />

<strong>der</strong> Kugelradien des ab Werk ausgelieferten Industrie-<br />

roboters lag je nach Lage <strong>der</strong> Geraden <strong>in</strong> <strong>der</strong> Größenordnung<br />

von 3–5 mm.<br />

Die Wie<strong>der</strong>holgenauigkeit des Industrieroboters wurde<br />

mit <strong>in</strong> <strong>der</strong> vor<strong>der</strong>en Sphäre des Arbeitsraumes liegenden<br />

55 Posen, die jeweils <strong>in</strong> Masch<strong>in</strong>enkoord<strong>in</strong>aten mit positiver<br />

<strong>und</strong> negativer Anfahrrichtung 10 mal angefahren<br />

wurden, über <strong>in</strong>sgesamt 550 Messungen ermittelt. Die<br />

Streuung <strong>der</strong> Kugelradien ergab sich zu r ¼ 77 lm <strong>und</strong><br />

entspricht von <strong>der</strong> Größenordnung <strong>der</strong> Spezifikation<br />

des Herstellers.<br />

Zur Charakterisierung des Positionierverhaltens des mit<br />

e<strong>in</strong>em Multikamerasystem ausgestatten Industrieroboters<br />

wurde e<strong>in</strong> Messvolumen von ca. 1 m 3 herangezogen (siehe<br />

auch Abb. 9). Die Systemkalibration erfolgte über 56<br />

im Messvolumen verteilte Aktuatorposen. E<strong>in</strong>e Kontrolle<br />

des Positionerverhaltens wurde zwischen diesen Posen<br />

vollzogen. Die Ergebnisse <strong>in</strong> Abb. 12 zeigen, dass die absoluten<br />

Positionerfehler um mehr als e<strong>in</strong>e Größenordnung<br />

abnehmen. Der mittlere systematische Positionsfehler <strong>der</strong><br />

Kugelradien liegt bei ca. 300 lm. Dieses Verhalten gilt<br />

analog auch für die W<strong>in</strong>kelfehler des TCP, die <strong>in</strong>sbeson<strong>der</strong>e<br />

bei größeren Greifergeometrien bzw. größeren zu<br />

handhabenden Objekten bedeutsam werden.<br />

Bei dem e<strong>in</strong>gesetzten LED-Beleuchtungssystem (Light<br />

Emitt<strong>in</strong>g Diode) besteht e<strong>in</strong> nicht zu vernachlässigendes<br />

Optimierungspotenzial im H<strong>in</strong>blick auf e<strong>in</strong>e verbesserte<br />

(homogenere) Ausleuchtung <strong>in</strong>sbeson<strong>der</strong>e auch <strong>in</strong> den<br />

Randbereichen <strong>der</strong> Kamerasichtfel<strong>der</strong> (LED-Beleuchtungs-<br />

auf Objektivöffnungsw<strong>in</strong>kel abstimmen). Es lässt<br />

sich absehen, dass man dann mit hoher Wahrsche<strong>in</strong>lichkeit<br />

bis <strong>in</strong> den Genauigkeitsbereich von ca. 200 lm vorstoßen<br />

kann.<br />

8 Zusammenfassung <strong>und</strong> Ausblick<br />

Die Videometrie, <strong>Robotik</strong>, Fertigungs- <strong>und</strong> Montagetechnik<br />

hat <strong>und</strong> wird von <strong>der</strong> Entwicklung <strong>der</strong> Elektronik <strong>und</strong><br />

<strong>der</strong>en Bauste<strong>in</strong>en auch <strong>in</strong> Zukunft profitieren. Neben den<br />

hochauflösenden videometrischen Messsystemen ließen<br />

sich aber auch bei nicht zu hohen Anfor<strong>der</strong>ungen an<br />

Abb. 13: Positionierfehler D <strong>in</strong> <strong>der</strong><br />

Ebene (Roboter-Kalibration mittels<br />

Laser-Tracker)<br />

AVN 5/2009 185

J. Wollnack – <strong>3D</strong>/<strong>6D</strong>-<strong>Visionsysteme</strong> <strong>und</strong> <strong>Lasermessverfahren</strong> <strong>in</strong> <strong>der</strong> <strong>Robotik</strong> <strong>und</strong> Fertigungstechnik <strong>der</strong> Luftfahrt<strong>in</strong>dustrie<br />

die Messgenauigkeit Low-Cost-CCD/CMOS-Kamera-<br />

Systeme (z.B. Internet-Kamera) durch e<strong>in</strong>e Kamerabzw.<br />

Systemkalibration essenziell <strong>in</strong> ihrer Genauigkeit<br />

verbessern <strong>und</strong> somit für Messaufgaben mit mittleren Genauigkeitsanfor<strong>der</strong>ungen<br />

heranziehen. Mit den videometrischen<br />

Messsystemen können roboterunterstützte Topographie-<br />

<strong>und</strong> Konturvermessung von Komponenten <strong>und</strong><br />

Werkzeugen auf Maßhaltigkeit im Masch<strong>in</strong>enbau <strong>und</strong><br />

<strong>der</strong> Elektronik realisiert werden. E<strong>in</strong>e Fertigungs- <strong>und</strong><br />

Montageautomatisierung auch für kle<strong>in</strong>e Losgrößen<br />

o<strong>der</strong> <strong>in</strong>dividuelle zu berücksichtigen Fertigungs- <strong>und</strong> Lagetoleranzen<br />

<strong>in</strong> <strong>3D</strong> bzw. <strong>6D</strong> liegt damit preiswert im Bereich<br />

des Möglichen. Ebenso lassen sich mittels e<strong>in</strong>er videometrischen<br />

Fugen- o<strong>der</strong> Schweißnahtvermessung semiautonome<br />

Schweißroboter bis h<strong>in</strong> zu flexiblen Laser<br />

Remote Schweißsystemen realisieren. Nicht zuletzt können<br />

von diesen Konzepten sowohl die Navigation als auch<br />

mediz<strong>in</strong>ische Roboteranwendungen profitieren.<br />

Insgesamt liegt hier e<strong>in</strong> attraktives technisch, wirtschaftliches<br />

Potenzial vor, welches mit hoher Wahrsche<strong>in</strong>lich<br />

e<strong>in</strong>e nicht unwichtige Technologie für die <strong>in</strong>ternationale<br />

Wettbewerbsfähigkeit <strong>der</strong> europäischen Fertigungs<strong>in</strong>dustrie<br />

speziell auch <strong>der</strong> Luftfahrt<strong>in</strong>dustrie spielen wird.<br />

Literatur<br />

[1] BERG, J. O.: E<strong>in</strong> Meß- <strong>und</strong> Berechnungsverfahren zur Bestimmung<br />

<strong>und</strong> Verbesserung spezieller Kenngrößen beliebiger<br />

Industrieroboter : Dissertation am Fachbereich<br />

Masch<strong>in</strong>enbau <strong>der</strong> Universität <strong>der</strong> B<strong>und</strong>eswehr Hamburg.<br />

Hamburg : 1990<br />

[2] BORGELT, C.; KLAWONN, F.; KRUSE, R.; NAUCK, D.: Neuro-<br />

Fuzzy-Systeme. Vieweg & Sohn Verlagsgesellschaft/<br />

GWV Fachverlag GmbH, 3. Auflage 2003<br />

[3] BOYER, K. L.; KAK, A. C.: Color-Encoded Structured<br />

Light for Rapid Active Rang<strong>in</strong>g. IEEE Transactions on<br />

PAMI, Vol. PAMI-9, 1987, Seiten 24–28<br />

[4] BREUCKMANN, B.: Optische <strong>3D</strong>-Meßsysteme für Onl<strong>in</strong>e-<br />

Anwendungen. tm 10/1990, R. Oldenbourg Verlag<br />

GmbH, 1990<br />

[5] Chip Onl<strong>in</strong>e: Details zum Prozessor-Prototyp mit 80 Kernen.<br />

http://www.chip.de/news/c1_news_24211637.html,<br />

März 2007<br />

[6] DENAVIT, J.; HARTENBERG, R. S.: A K<strong>in</strong>ematic Notation for<br />

Lower-Pair Mechanisms Based on Matrices. ASME J. of<br />

Applied Mechanics, June 1955, Seiten 215–221<br />

[7] JIANG, X.; BUNKE, H.: Dreidimensionales Computersehen.<br />

Spr<strong>in</strong>ger Verlag GmbH & Co. KG, Berl<strong>in</strong> Heidelberg<br />

New York, 1997<br />

[8] FÖHR, R.: Photogrammetrische Erfassung räumlicher Informationen<br />

aus Videobil<strong>der</strong>n. Friedr. Vieweg Verlag &<br />

Sohn Verlagsgesellschaft mbH, Wiesbaden, 1990<br />

[9] GATES, B.: Roboter für je<strong>der</strong>mann. Spektrum <strong>der</strong> Wissanschaft,<br />

März 2007, Seiten 36–45<br />

[10] GERDES, R.; OTTERBACH, R.; KAMMÜLLER, R.: Kalibrierung<br />

e<strong>in</strong>es digitalen Bildverarbeitungssystems mit CCD-Kamera.<br />

Technisches Messen R. Oldenbourg Verlag<br />

GmbH, 60, 6 <strong>und</strong> 7/8, 1993, Teil I Seiten 255–261<br />

<strong>und</strong> Teil II Seiten 283–288<br />

[11] GERDES, SIEGEN R.: Dreidimensionales Messen mit e<strong>in</strong>er<br />

Videokamera unter Ausnutzung geometrischer Randbed<strong>in</strong>gungen.<br />

Düsseldorf : VDI-Verlag GmbH, 1994<br />

[12] GOSSEL, O.: Steigerung <strong>der</strong> Genauigkeit von Industrierobotern<br />

basierend auf e<strong>in</strong>er durchgängigen Genauigkeitsanalyse.<br />

Dissertation am Arbeitsbereich Werkzeugmasch<strong>in</strong>en<br />

<strong>und</strong> Automatisierungstechnik FT II <strong>der</strong> Technischen<br />

Universität Hamburg-Harburg, Hamburg, 1996<br />

[13] GOSWANNI, A.; QUAID, A.; PESHKIN, M.: Complete Parameter<br />

Identification of a Robot from partial Pose Information.<br />

Proc. IEEE Int. Conf. On Robotics and Automation,<br />

1993, Seiten 169–173<br />

[14] HELLENDORN, H.; DRIANKOV, D.: Fuzzy Model Identification,<br />

Spr<strong>in</strong>ger Verlag, Berl<strong>in</strong> Heidelberg New York, 1997<br />

[15] HOLLERBACH, J. M.: A Survey of K<strong>in</strong>ematics Calibration.<br />

The Robotics Review MIT Press, 1988, Seiten 207–242<br />

[16] IZQUIERDO, M. A. G.; SANCHEZ, M. T.; IBANEZ, A.; ULLATE, L. G.:<br />

Sub-pixel measurement of <strong>3D</strong> surfaces by laser scann<strong>in</strong>g.<br />

Sensors and Actuators A: Physical, 76, 1999, Seiten 1–8<br />

[17] KÜHN, W.: Untersuchung von Evolutionsstrategien zur<br />

Identifikation des nichtl<strong>in</strong>earen Systemverhaltens 6-achsiger<br />

Gelenkarmroboter, Dissertation am Fachbereich<br />

Produktionstechnik <strong>der</strong> Universität Bremen, Reihe 8.<br />

Nr. 267. Düsseldorf : VDI-Verlag GmbH, 1991<br />

[18] LAWSON, C. L.; HANSON, R. J.: Solv<strong>in</strong>g Least Squares Problems.<br />

Englewood Cliffs: Prentice-Hall International<br />

Inc., 1974<br />

[19] LENZ, R.; TSAI, R. Y.: Techniques for Calibration of the<br />

Scale Factor and Image Center for High Accuracy <strong>3D</strong><br />

Mach<strong>in</strong>e Vision Metrology. IBM Research Report RC<br />

54867, 1986<br />

[20] LENZ, R.: Videometrie mit CCD-Sensoren <strong>und</strong> Ihre Anwendung<br />

<strong>in</strong> <strong>der</strong> <strong>Robotik</strong>, Habilitation am Lehrstuhl für<br />

Nachrichtentechnik <strong>der</strong> Technischen Universität München.<br />

München, 1988<br />

[21] LOTZE, W.: Beste<strong>in</strong>passung von geometrischen Formelementen<br />

<strong>und</strong> Bohrbil<strong>der</strong>n mit def<strong>in</strong>ierten Toleranzzonen.<br />

Technisches Messen 67, Oldenbourg Verlag, 2000<br />

[22] LUHMANN, T.: E<strong>in</strong> hochauflösendes automatisches Bildmeßsystem.<br />

Dissertation, Wissenschaftliche Arbeiten<br />

<strong>der</strong> Fachrichtung Vermessungswesen <strong>der</strong> Universität<br />