Il suono : generalità - Istituto Istruzione Superiore Maserati

Il suono : generalità - Istituto Istruzione Superiore Maserati

Il suono : generalità - Istituto Istruzione Superiore Maserati

You also want an ePaper? Increase the reach of your titles

YUMPU automatically turns print PDFs into web optimized ePapers that Google loves.

<strong>Il</strong> <strong>suono</strong> : <strong>generalità</strong><br />

<strong>Il</strong> <strong>suono</strong> (dal latino sonus) è la sensazione data dalla vibrazione di un corpo in oscillazione. Tale<br />

vibrazione, che si propaga nell'aria o in un altro mezzo elastico, raggiunge l'orecchio che, tramite un<br />

complesso meccanismo interno, è responsabile della creazione di una sensazione "uditiva"<br />

direttamente correlata alla natura della vibrazione.<br />

<strong>Il</strong> termine Vibrazione si riferisce in particolare ad una oscillazione meccanica attorno ad un punto<br />

d'equilibrio. L'oscillazione può essere periodica come il moto di un pendolo oppure casuale<br />

come il movimento di una gomma su di una strada asfaltata.<br />

Le vibrazioni rappresentano un fenomeno desiderato in molti casi. Ad esempio nel funzionamento<br />

del diapason, e di molti strumenti musicali, o nei coni degli speaker, necessari per il corretto<br />

funzionamento dei vari oggetti che li utilizzano.<br />

Più spesso, però, le vibrazioni non sono desiderate; possono disperdere energia e creare suoni e<br />

rumori indesiderati. Ad esempio, nel funzionamento dei motori e delle automobili in generale..<br />

Gli studi sul <strong>suono</strong> e sulle varie vibrazioni sono strettamente collegati. I Suoni, onde di pressione,<br />

sono generati da strutture vibranti (ad esempio le corde vocali) e le onde di pressione possono<br />

generare vibrazione di strutture. Quindi, quando si prova a ridurre un rumore, il problema è ridurre<br />

la vibrazione che lo provoca<br />

Come tutte le onde, anche quelle sonore sono caratterizzate da una frequenza (che nel caso del<br />

<strong>suono</strong> è in diretta, ma non esclusiva, relazione con la percezione dell'altezza) e un'intensità<br />

(che è in diretta, ma non esclusiva, relazione con il cosiddetto "volume" del <strong>suono</strong>). Inoltre,<br />

caratteristica saliente delle onde sonore è la forma d'onda stessa, che rende in gran parte<br />

ragione delle differenze cosiddette di timbro che si percepiscono tra diverse tipologie di <strong>suono</strong>.<br />

Onda sonora<br />

Per la fisica, il <strong>suono</strong> è un'oscillazione (un movimento nello spazio) compiuta dalle particelle<br />

(atomi e molecole) in un mezzo. Le oscillazioni sono spostamenti delle particelle, intorno alla<br />

posizione di riposo e lungo la direzione di propagazione dell'onda, provocati da movimenti<br />

vibratori, provenienti da un determinato oggetto, chiamato sorgente del <strong>suono</strong>, il quale trasmette il<br />

proprio movimento alle particelle adiacenti, grazie alle proprietà meccaniche del mezzo; le<br />

particelle a loro volta, iniziando ad oscillare, trasmettono il movimento alle altre particelle vicine e<br />

queste a loro volta ad altre ancora; in questo modo, un semplice movimento vibratorio si propaga<br />

meccanicamente dando vita all'onda sonora ( o onda acustica), che si definisce pertanto onda<br />

longitudinale.<br />

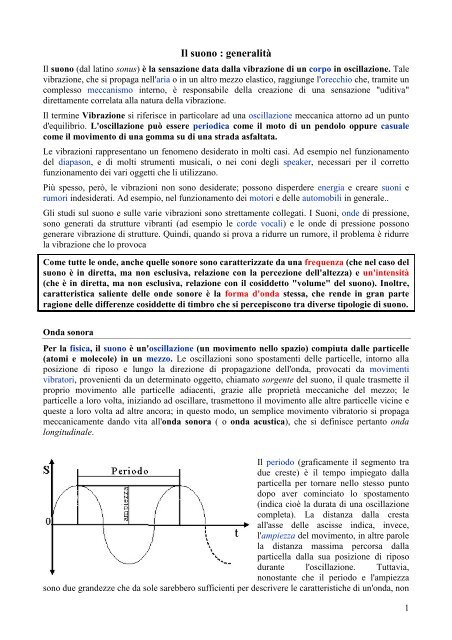

<strong>Il</strong> periodo (graficamente il segmento tra<br />

due creste) è il tempo impiegato dalla<br />

particella per tornare nello stesso punto<br />

dopo aver cominciato lo spostamento<br />

(indica cioè la durata di una oscillazione<br />

completa). La distanza dalla cresta<br />

all'asse delle ascisse indica, invece,<br />

l'ampiezza del movimento, in altre parole<br />

la distanza massima percorsa dalla<br />

particella dalla sua posizione di riposo<br />

durante l'oscillazione. Tuttavia,<br />

nonostante che il periodo e l'ampiezza<br />

sono due grandezze che da sole sarebbero sufficienti per descrivere le caratteristiche di un'onda, non<br />

1

sono frequentemente utilizzate, perlomeno non in forma pura, quando si sta trattando di un'onda<br />

sonora si preferisce, infatti, usare altre grandezze da queste derivate. Dal numero di periodi fatti in<br />

un secondo si ottiene la frequenza, misurata in hertz, che indica il numero d'oscillazioni compiute<br />

dalla particella in un secondo. Dall'ampiezza dell'onda, invece, otteniamo l'intensità, che nel caso<br />

dell'onda sonora è intesa come pressione esercitata dalla stessa su una superficie, se, infatti,<br />

l'ampiezza è misura lo spazio, tanto più sarà estesa, tanto maggiore sarà la pressione esercitata sulle<br />

particelle vicine e dunque pure la forza esercitata contro un ostacolo; la misura d'intensità delle<br />

onde sonore sono i decibel.<br />

Tipologie di onde sonore<br />

Esistono tre diverse tipologie di onde sonore e ognuna è identificabile da un particolare andamento<br />

grafico<br />

Le onde semplici: onde dal tracciato regolare: i picchi sono speculari alle valli e assume la<br />

caratteristica forma di sinusoide. Le principali caratteristiche sono appunto il grafico sinusoidale<br />

e la periodicità.<br />

Le onde complesse: sono sempre onde dal tracciato regolare, in quanto i picchi sono<br />

speculari alle valli, ma la loro forma risulta più complessa della precedente, perché presenta<br />

diverse anomalie nelle curve. Le caratteristiche sono: la periodicità e il grafico non sinusoidale.<br />

Le onde aperiodiche: sono onde non regolari: il tracciato ha forma caotica e zizzagante.<br />

Sono caratterizzate dall'assoluta irregolarità del grafico e dall'aperiodicità; sono tracciati<br />

caratteristici dei rumori.<br />

Per una descrizione delle onde semplici i parametri di frequenza e d'ampiezza sono sufficienti,<br />

mentre le onde aperiodiche, a causa della loro aperiodicità, non possono essere descritte da<br />

alcun parametro. Invece nella descrizione delle onde complesse sono sì utili sia la frequenza<br />

che l'ampiezza, ma date le anomalie del tracciato, questi due semplici parametri da soli non<br />

sono sufficientemente esaurienti, in quanto bisogna ricorrere alla scomposizione dell'onda<br />

fondamentale in una serie d'onde semplici, che sono invece analizzabili con le normali<br />

grandezze. Le onde semplici o formanti, ottenute dalla scomposizione di un'onda complessa,<br />

sono dette armoniche e nel loro insieme costituiscono, quello che è chiamato spettro dell'onda<br />

sonora. Una caratteristica molto importante delle armoniche è che le loro frequenze corrispondono<br />

sempre a multipli interi della frequenza dell'onda complessa, e sono indicate con f0, f1, f2, ecc. con il<br />

pedice che corrisponde al rapporto tra la frequenza dell'onda fondamentale e quella dell'armonica<br />

<strong>Il</strong> decibel (dB)<br />

<strong>Il</strong> decibel è la misura più usata in acustica, esso esprime secondo una scala logaritmica in base<br />

10, il rapporto fra due grandezze omogenee, che nel caso del <strong>suono</strong> sono l’intensità sonora.<br />

Ricordiamo che per definizione il logaritmo di un certo numero in una certa base, è l’esponente che<br />

occorre dare a quella base per ottenere il numero dato. Ad esempio il logaritmo in base 10 di 100 è<br />

2. Infatti 10 2 = 100.<br />

<strong>Il</strong> decibel è 10 volte il logaritmo in base 10 del rapporto di due grandezze omogenee.<br />

Supponiamo di voler esprimere in decibel la differenza fra due potenze: w1 e w2.<br />

dB = 10 Log10 (w1/ w2) dove w2 è la grandezza di riferimento<br />

Notiamo quindi che affinché la precedente espressione abbia senso occorre che esistano entrambe le<br />

grandezze w1 e w2 ed in particolare che sia w2 ≠ 0. Notiamo anche che non ha importanza di che<br />

tipo siano le grandezze w1 e w2 , occorre solo che siano omogenee, ossia dello stesso tipo.<br />

Qualche esempio pratico:<br />

2

w1=2 w2 3 dB<br />

w1=10 w2 10 dB<br />

w1=100 w2 20 dB (10log100=10*2)<br />

w1=1000 w2 30 dB (10log1000=10*3=30)<br />

w1=1/2 w2 -0,3 dB<br />

w1=1/10 w2 -10 dB<br />

w1=1/100 w2 -20 dB<br />

w1=1/100 w2 -30 dB<br />

Come abbiamo visto il<br />

decibel si può considerare<br />

una misura relativa, non<br />

dipende infatti da una<br />

sola grandezza ma dal<br />

rapporto di due<br />

grandezze omogenee.<br />

Tuttavia ci sono certi casi<br />

in cui tale misura si può<br />

immaginare assoluta.<br />

Questo avviene quando al<br />

denominatore si pone una<br />

misura stabilita per<br />

convenzione internazionale. Un esempio di misura assoluta in decibel è quella dell’intensità<br />

sonora, che convenzionalmente è espressa in riferimento alla soglia di udibilità.<br />

Propagazione del <strong>suono</strong>Abbiamo detto che il <strong>suono</strong> si propaga nei<br />

mezzi elastici, fra questi ovviamente l’aria. Per capire come questo<br />

avvenga in pratica consideriamo la struttura dell’aria. Questa è<br />

formata da tante molecole unite fra di loro da legami elastici.<br />

Possiamo immaginare le molecole di aria come sfere unite ad altre<br />

sfere tramite molle. Quando un corpo vibra, comunica il suo<br />

movimento alla prima molecola d’aria, (la prima sfera nel modello).<br />

Questa molecola spostandosi in avanti “spinge” la molecola<br />

successiva, la quale “spinge” quella a sua volta successiva, e così<br />

via. Un attimo dopo i legami elastici, (le molle nel modello),<br />

“richiamano” indietro la molecola nella sua posizione iniziale di equilibrio. Per effetto della forza<br />

d’inerzia la molecola supera il punto centrale di equilibrio, raggiungendo una posizione quasi<br />

speculare al punto di massima escursione in<br />

avanti. Questi movimenti si trasmettono alle<br />

molecole contigue in un certo tempo. Per<br />

effetto di tali movimenti avremo delle zone in<br />

cui vi è compressione dell’aria, e delle altre in<br />

cui vi è rarefazione.<br />

Queste diverse zone si ripeteranno a partire<br />

dalla sorgente, nel senso di propagazione del<br />

<strong>suono</strong>. Questo effetto prende il nome di onda<br />

longitudinale.<br />

Si chiama onda longitudinale quella in cui la direzione dell’oscillazione e quella della propagazione<br />

coincidono.<br />

3

Le onde si dicono quindi trasversali o longitudinali a seconda che la direzione di oscillazione<br />

sia parallela o perpendicolare rispetto alla direzione di propagazione. Un'onda longitudinale<br />

può essere solo meccanica: essa risulta infatti da successive compressioni (stati di densità e<br />

pressione massimi) e rarefazioni (stati di densità e pressione minimi) del mezzo. Le onde sonore ne<br />

sono un esempio tipico.<br />

Esempi di onde trasversali sono invece quelle che si propagano lungo una corda tesa o le onde<br />

elettromagnetiche, come la luce, i raggi X, o le onde radio.<br />

Data una sorgente di <strong>suono</strong>, questo si propaga allo stesso modo in tutte le direzioni. Possiamo<br />

dire che si propaga secondo fronti d’onda sferici. La superficie del fronte d’onda aumenta in<br />

proporzione col quadrato della distanza dalla sorgente. Di conseguenza l’energia che possiede il<br />

fronte d’onda si distribuisce su tutta la superficie, per cui su una singola unità di superficie<br />

avremo un’energia che decresce proporzionalmente al quadrato della distanza. Volendo<br />

esprimere in decibel questa variazione:<br />

• Raddoppiando la distanza, l’intensità sonora<br />

decresce di 6 dB<br />

• Decuplicando la distanza, l’intensità sonora<br />

decresce di 20 dB<br />

Quindi se ad esempio misuriamo un intensità di<br />

100 dB ad un metro da un diffusore acustico:<br />

• A due metri avremo 94 dB<br />

• A dieci metri avremo 80 dB<br />

Si nota quindi come il fattore distanza sia molto<br />

rilevante nell’attenuazione dell’intensità<br />

acustica.<br />

Velocità del <strong>suono</strong><br />

<strong>Il</strong> <strong>suono</strong> si propaga ad una velocità che dipende dalla natura<br />

del mezzo elastico in cui si diffonde. Inoltre tale velocità è<br />

influenzata, sebbene in misura minore, dalla temperatura,<br />

dalla pressione edall’umidità. In tabella la velocità del<br />

<strong>suono</strong> in alcuni mezzi.<br />

Lunghezza d’onda<br />

Un’altra grandezza importante legata alla<br />

propagazione del <strong>suono</strong> è la lunghezza<br />

d’onda. La lunghezza d'onda è la distanza<br />

tra due creste successive per le onde<br />

trasversali, e la distanza tra due<br />

compressioni successive o due rarefazioni<br />

successive per le onde longitudinali<br />

La lunghezza d’onda si misura in metri ed è<br />

funzione della frequenza e della velocità di<br />

propagazione secondo la formula:<br />

λ = v / f oppure λ = v * T<br />

(λ = lunghezza d’onda, v = velocità di propagazione, f = frequenza, T=periodo)<br />

Riproduciamo una tabella che mostra la lunghezza d’onda in aria libera, per alcune frequenze<br />

udibili.<br />

4

Capacità dell’udito umano<br />

Abbiamo fin qui esaminato il <strong>suono</strong> e la sua propagazione secondo dei principi fisici, definendone<br />

alcune grandezze fondamentali quali la frequenza e l’intensità. La domanda che ci poniamo ora è:<br />

Quali suoni sono in grado di essere percepiti dal nostro orecchio?<br />

La capacità dell’udito umano varia fortemente da individuo a individuo, e decade nelle prestazioni<br />

con l’aumentare dell’età. Appositi studi fonometrici hanno stabilito che mediamente l’uomo è in<br />

grado di udire suoni la cui frequenza è compresa dai 20 ai 20.000 Hz<br />

Tale gamma di suoni è chiamata gamma udibile. I suoni la cui frequenza è al di sotto dei 20<br />

Hz sono chiamati infrasuoni (o gamma subsonica). I suoni la cui frequenza eccede i 20.000 Hz<br />

sono chiamati ultrasuoni.<br />

Alcuni animali hanno una gamma udibile maggiore di quella dell’uomo, in particolare per quanto<br />

riguarda il limite superiore. Vi sono ad esempio alcuni ultrasuoni che possono essere uditi dai cani<br />

ma non dall’uomo.<br />

Se consideriamo i suoni compresi nella gamma udibile, ci accorgiamo che all’aumentare della<br />

frequenza, non aumenta linearmente la sensazione dell’altezza del <strong>suono</strong>. Per esempio fra un <strong>suono</strong><br />

a 20 Hz e un <strong>suono</strong> a 30 Hz, ad una differenza di 10 Hz corrisponde una chiara differenza<br />

nell’altezza del <strong>suono</strong> udito. Fra un <strong>suono</strong> di 6.000 Hz ed uno di 6.010 Hz, pur con una differenza<br />

sempre di 10 Hz, non corrisponde nessuna differenza udibile nell’altezza del <strong>suono</strong>. Dobbiamo<br />

quindi considerare la gamma udibile non come linearmente correlata alla sensazione dell’altezza dei<br />

suoni.<br />

L’acustica musicale ci suggerisce il modo di stabilire una relazione diretta fra frequenza e<br />

sensazione di altezza dei suoni. Musicalmente infatti la gamma udibile è divisa in un certo numero<br />

di ottave ed ogni ottava in un certo numero di note (12 nella scala temperata occidentale). È a tutti<br />

chiara l’affinità sonora che vi è fra le note corrispondenti di ottave diverse, ad esempio il do della<br />

prima ottava con il do della seconda. Possiamo in definitiva dire che la suddivisione della gamma<br />

udibile in ottave e note musicali, dal punto di vista dell’altezza del <strong>suono</strong>, soddisfa pienamente la<br />

nostra esigenza di avere intervalli di frequenze che rappresentino in qualunque punto della gamma,<br />

la stessa differenza come risultato sonoro.<br />

Presupposto fondamentale della divisione dei suoni in ottave e in note è che: data una nota<br />

appartenente ad un’ottava, la corrispondente nota appartenente all’ottava successiva avrà una<br />

frequenza doppia. Se, secondo le convenzioni internazionali, il la centrale ha frequenza di 440 Hz, il<br />

la dell’ottava successiva avrà frequenza di 880 Hz, e quello della seguente 1760 Hz.<br />

Possiamo finalmente dividere la nostra gamma udibile in un modo aderente alla sensazione che noi<br />

abbiamo dell’altezza dei suoni. Le ottave standardizzate internazionali hanno le seguenti estensioni:<br />

1. da 16 a 32 Hz<br />

2. da 32 a 64 Hz<br />

3. da 64 a 125 Hz<br />

4. da 125 a 250 Hz<br />

5. da 250 a 500 Hz<br />

6. da 500 Hz a 1 KHz<br />

7. da 1 Khz a 2 Khz<br />

5

8. da 2 Khz a 4 Khz<br />

9. da 4 Khz a 8 Khz<br />

10. da 8 Khz a 16 Khz<br />

La sensibilità del nostro orecchio<br />

non è costante per tutte le<br />

frequenze. <strong>Il</strong> digramma delle curve<br />

ipsofoniche rappresenta il variare<br />

della sensibilità a in funzione della<br />

frequenza. La linea tratteggiata<br />

rappresenta la soglia di udibilità,<br />

quindi possiamo osservare per<br />

esempio, che un <strong>suono</strong> avente una<br />

frequenza di 31,5 Hz ed<br />

un’intensità di 30 decibel non<br />

viene percepito dall’orecchio<br />

umano. Le curve del disegno<br />

uniscono i punti in cui alle varie<br />

frequenze la sensazione<br />

dell’intensità de <strong>suono</strong> sono uguali,<br />

ad esempio se un <strong>suono</strong> a 1000 Hz<br />

di intensità 20 dB mi produce una<br />

certa sensazione, per avere quella<br />

stessa sensazione a 63 Hz avrò<br />

bisogno di circa 45 dB.<br />

Fase di un <strong>suono</strong><br />

Due suoni possono differire oltre che per la frequenza, l’intensità e la<br />

composizione delle armoniche anche per il momento in cui vengono<br />

emessi. In genere si parla di fase quando questo tempo è minore del<br />

periodo, ossia del tempo necessario a compiere un ciclo completo. La<br />

differenza di tempo fra due suoni (figura a lato) dipende dal cosiddetto<br />

angolo di fase. La funzione che esprime una rappresentazione<br />

sinusoidale è :<br />

I = I0 sin (ωt + φ)<br />

La grandezza φ rappresenta appunto l’angolo di fase. Esprimere la fase<br />

come un angolo ci permette di prescindere da altre grandezze, tipo la<br />

frequenza, che definiscono il nostro <strong>suono</strong>. Infatti qualunque sia la<br />

frequenza, un angolo di fase pari a π/2 corrisponde a ¼ del periodo, un<br />

angolo di fase π corrisponde a metà del periodo, un angolo di fase 3/2 π<br />

corrisponde a ¾ del periodo, e un angolo di fase di 2 π all’intero<br />

periodo. É facilmente osservabile che il <strong>suono</strong> risultante fra due suoni<br />

uguali in tutto fuorché nella fase, è molto diverso dai suoni originari, in<br />

particolare nella composizione delle armoniche. Un caso<br />

particolarmente significativo si ha quando la differenza di fase fra i due<br />

suoni è pari a π/2. Si dice che i due suoni sono in opposizione di fase, o<br />

in controfase. <strong>Il</strong> <strong>suono</strong> risultante dalla somma di due suoni in controfase<br />

ha intensità nulla. Due suoni in controfase si cancellano vicendevolmente.<br />

6

Sintesi e analisi di Fourier<br />

L’uso di una serie di onde sinusoidali per rappresentare qualunque forma d’onda periodica fu<br />

scoperta dal fisico francese Jean Baptiste Joseph Fourier all’inizio del diciannovesimo secolo. Egli<br />

dimostrò matematicamente che una forma d’onda periodica può essere rappresentata come somma<br />

di onde sinusoidali con fasi, frequenze e ampiezze massime appropriate. <strong>Il</strong> metodo dell’analisi e<br />

della sintesi di Fourier prese il nome da lui.<br />

Secondo il teorema di Fourier, una qualunque funzione periodica s(t) di periodo T e frequenza<br />

fondamentale f0=1/T è pari alla somma di infinite cosinusoidi di frequenze multiple intere di f0,<br />

con ampiezze e fasi opportune più un termine costante:<br />

( π θ ) ( π θ ) ( π θ )<br />

s( t) = A + A cos 2 f t + + A cos 4 f t + + A cos 6 f t + + ... =<br />

0 1 0 1 2 0 2 3 0 3<br />

+∞<br />

∑<br />

( π θ )<br />

= A + A cos 2 kf t +<br />

0 k 0 k<br />

k = 1<br />

La costante A0 è detta componente continua o valor medio del segnale, il termine<br />

( π θ )<br />

A cos 2 f t + è detto prima armonica o armonica fondamentale, gli altri termini sono detti<br />

1 0 1<br />

armoniche secondarie.<br />

L’esempio grafico mostrato nella Figura 5 può aiutare a capire la sintesi di Fourier.<br />

Figura 5 Tre<br />

onde sinusoidali<br />

vengono sommate a<br />

ogni istante di tempo<br />

per creare una nuova<br />

forma d’onda. La<br />

seconda onda<br />

sinusoidale ha una<br />

frequenza tre volte<br />

superiore a quella<br />

della prima e<br />

FIG. 5<br />

un’ampiezza<br />

massima pari a un<br />

terzo di quella della<br />

prima. La terza onda<br />

sinusoidale ha una<br />

frequenza cinque<br />

volte superiore a<br />

quella della prima e un’ampiezza massima pari a un quinto di quella della prima. Poiché le onde<br />

sinusoidali aggiunte hanno frequenze armoniche via via più alte, l’onda risultante è molto simile a<br />

un’onda quadra.<br />

7

Iniziamo con un’onda sinusoidale a una frequenza fondamentale f, poi aggiungiamo una seconda<br />

onda sinusoidale a una frequenza di 3f e con un’ampiezza massima pari a un terzo di quella della<br />

fondamentale. La terza armonica evidenzia i picchi positivi e negativi di quella fondamentale e la<br />

forma d’onda risultante inizia ad assomigliare a un’onda quadra. Aggiungiamo poi una quinta<br />

armonica a una frequenza di 5f e con un’ampiezza massima di un quinto di quella fondamentale.<br />

Ciò squadra ancor di più gli angoli rendendo il risultato ancor più simile a un’onda quadra. <strong>Il</strong><br />

processo può continuare aggiungendo armoniche dispari con ampiezze massime inversamente<br />

proporzionali al numero delle armoniche. Con un numero infinito di armoniche si ottiene un’onda<br />

quadra perfetta tranne le improvvise discontinuità degli angoli; questo effetto è chiamato fenomeno<br />

di Gibbs.<br />

L’analisi di Fourier può essere applicata a qualsiasi forma d’onda periodica per determinare le<br />

frequenze armoniche esatte, le fasi e le ampiezze massime corrispondenti per ricreare o sintetizzare<br />

un segnale periodico.<br />

Spettro<br />

Consideriamo un’onda sinusoidale alla frequenza f e alla massima ampiezza A. Presupponiamo che<br />

non abbia alcun cambio di fase per un certo periodo di tempo. Potremmo disegnare la forma d’onda<br />

precisamente in funzione del tempo, ma questa operazione sarebbe noiosa perché tutti ora<br />

conosciamo l’aspetto di un’onda sinusoidale. Ciò che è interessante di un’onda sinusoidale sono la<br />

sua esatta frequenza e la sua massima ampiezza corrispondente e sono proprio questi dati a<br />

distinguere un’onda sinusoidale da un’altra. Vediamo ora un grafico che mostra l’ampiezza<br />

massima A dell’onda sinusoidale lungo l’asse delle y e la sua frequenza F lungo l’asse delle x<br />

(Figura 6). Nella figura una singola onda sinusoidale viene rappresentata come una linea verticale<br />

posta alla frequenza f e con una lunghezza pari alla massima ampiezza A.<br />

Figura 6 Possiamo rappresentare un’onda sinusoidale graficamente nel dominio del tempo<br />

disegnando la sua forma effettiva. Alternativamente possiamo rappresentarla nel dominio della<br />

frequenza come una linea verticale posta alla sua frequenza e con una lunghezza pari all’ampiezza<br />

massima.<br />

8

Grazie alla serie di Fourier una funzione periodica può essere rappresentata nel dominio della<br />

frequenza, poiché infatti le armoniche sono cosinusoidi, a ciascuna armonica corrisponde un<br />

impulso alla frequenza relativa kf0 di altezza Ak nello spettro di ampiezza e un impulso alla<br />

frequenza relativa di altezza θk nello spettro di fase. Di conseguenza questi spettri avranno<br />

l’aspetto di una serie di impulsi in generale distanziati di f0 (spettro a righe):<br />

Questa rappresentazione è chiamata spettro dell’onda sinusoidale. Dal principio dell’analisi e della<br />

sintesi di Fourier sappiamo che qualsiasi forma d’onda può essere rappresentata come la somma di<br />

molte onde sinusoidali. Lo spettro di una forma d’onda, quindi, rappresenta i vari componenti in<br />

frequenza insieme alle loro corrispondenti ampiezze massime. <strong>Il</strong> grafico nel dominio del tempo<br />

mostra la forma d’onda effettiva. Lo spettro nel dominio della frequenza mostra le ampiezze<br />

massime dei vari componenti sinusoidali della forma d’onda.<br />

Un segnale periodico ha uno spettro che consiste solo nei componenti ai multipli armonici della<br />

fondamentale. (In realtà non esiste un segnale perfettamente periodico, perché dovrebbe continuare<br />

per sempre). I segnali reali sono più complessi e terminano dopo un determinato periodo, alcuni<br />

sono periodici solo in un intervallo di tempo breve, altri non hanno alcun modello ripetitivo. I<br />

segnali reali hanno quindi spettri omogenei con molti componenti in frequenza.<br />

ESEMPI<br />

Un tipo molto importante di segnale periodico è la cosinusoide la cui espressione più generale è:<br />

9

( π θ )<br />

s( t) = Acos 2 f t +<br />

0<br />

dove A è l’ampiezza, f0 la frequenza, θ la fase; questi tre parametri caratterizzano completamente<br />

una cosinusoide.<br />

Nell’esempio in figura risultano essere A=5, f0=2 e θ=-π/4<br />

In questo caso s( t) 5cos ( 4 t ) π<br />

= π −<br />

Rappresentazione nel dominio della frequenza<br />

4<br />

Poiché una cosinusoide nel dominio del tempo t è completamente caratterizzata dai tre parametri<br />

di ampiezza A, frequenza f0 e fase θ, è possibile rappresentare la stessa cosinusoide nel dominio<br />

della frequenza f con un doppio grafico in ampiezza e fase, cioè con un impulso sulla frequenza f0<br />

di altezza A sul diagramma di ampiezza e un impulso sulla frequenza f0 di altezza θ sul<br />

diagramma di fase.<br />

Prendiamo come esempio la prima cosinusoide che abbiamo visto:<br />

s( t) 5cos ( 4 t<br />

4)<br />

π<br />

= π − i cui parametri risultano A=5, f0=2 e θ=-π/4<br />

Nel dominio della frequenza possiamo rappresentarla così:<br />

I due diagrammi vengono chiamati spettro di ampiezza e spettro di fase.<br />

10

Esempio: onda quadra<br />

La componente continua risulta pari a ½, mentre tutte le armoniche pari risultano avere ampiezza<br />

nulla (questo a causa della simmetria della forma d’onda).<br />

Le prime dieci armoniche dell’onda quadra sono mostrate in figura:<br />

Nella figura successiva sono mostrate le somme parziali delle armoniche partendo da quella<br />

fondamentale più la componente continua, via via che si aggiungono altre armoniche<br />

sommandosi a quella fondamentale queste modellano e aggiustano le armoniche precedenti con il<br />

risultato di approssimarsi complesivamente all'onda quadra. Tale obbiettivo lo si può raggiungere<br />

anche sommando un numero finito e ridotto di armoniche poichè le armoniche di ordine k,<br />

all'aumentare di k, contano sempre meno.<br />

11

<strong>Il</strong> <strong>suono</strong> digitale : tecnica PCM (PULSE CODE MODULATIN)<br />

La caratteristica fondamentale del <strong>suono</strong> analogico è la riproduzione, attraverso uno strumento<br />

elettrico o elettronico (come il microfono o la chitarra elettrica) del segnale sonoro secondo un<br />

"tempo continuo". Cosa significa? Se ad esempio percuotiamo la corda di una chitarra acustica, lo<br />

strumento musicale produce delle "vibrazioni" che generano delle variazioni di "pressione" dell'aria<br />

che circola fuori e dentro la cassa acustica. Queste variazioni di pressione si propagano fino a<br />

raggiungere l'orecchio. <strong>Il</strong> <strong>suono</strong> viene riconosciuto dal cervello come un segnale che si riproduce<br />

continuamente nel tempo fino a che le variazioni di pressione non cessano con il cessare delle<br />

vibrazioni. La chitarra elettrica (che è uno strumento analogico) sfrutta lo stesso principio di quella<br />

acustica con la differenza che le vibrazioni generano una variazione di "tensione" piuttosto che di<br />

pressione; in questo caso, nella variazione da 1 a 2 volt, la tensione può assumere infiniti stadi<br />

intermedi.<br />

Per trasformare un segnale analogico in un <strong>suono</strong> digitale è necessaria una scheda di acquisizione<br />

sonora. Essa avrà la funzione di "campionare" cioè<br />

suddividere in tante parti il <strong>suono</strong> analogico<br />

acquisito. L'operazione è quella di trasformare un<br />

segnale continuo nel tempo in una sequenza di 0 e 1<br />

che sono gli stadi caratteristici dell'informazione<br />

binaria che determinano il segnale discreto.<br />

Così si presenta graficamente la digitalizzazione del<br />

segnale analogico:<br />

L'onda sinusoidale rappresenta il segnale analogico<br />

(segnale tempo continuo); il <strong>suono</strong> digitale è<br />

rappresentato dagli scalini (segnale discreto).<br />

12

<strong>Il</strong> numero dei campioni audio acquisiti per ogni secondo si chiama "frequenza di<br />

campionamento" e si misura in Hz. I valori assunti dalle schede di acquisizione audio semi<br />

professionali sono i seguenti: 11,025 kHz; 22,050 kHz; 44,1 kHz; 48 kHz. Aumentando la<br />

frequenza, il numero dei campioni acquisiti sarà maggiore e quindi migliore sarà la qualità<br />

dell'audio.<br />

La frequenza di campionamento descrive quindi il numero di volte che un segnale audio in<br />

ingresso è misurato o "campionato" in un dato periodo di tempo. E' tipicamente indicata in<br />

kilohertz (kHz, migliaia di cicli per secondo) e per registrare in "CD-quality" audio, è richiesta una<br />

frequenza di campionamento di 44.1kHz.<br />

Un altro parametro che contribuisce a migliorare la qualità dell'audio digitale è la profondità<br />

di bit o “risoluzione”. Rappresenta il numero di bit che si utilizzano per rappresentare il<br />

segnale analogico. Anche la risoluzione assume diversi valori: principalmente 8 e 16 bit (con le<br />

schede di acquisizione audio di medio livello). Ovviamente, aumentando la risoluzione, il <strong>suono</strong><br />

acquisito risulterà più ricco di dettagli, perché a parità di variazione di ampiezza con 8 bit posso<br />

rappresentare 256 livelli analogici (2 8 ) , con 16 bit ne rappresento 65536 (2 16 ).<br />

La profondità di bit determina quindi l'accuratezza con quale è effettuata ciascuna<br />

misurazione o campione. Quando in un sistema PCM di audio digitale il convertitore A-D misura<br />

un segnale in ingresso e memorizza la misurazione come un numero, questo numero è rappresentato<br />

come una serie di 0 e 1, anche noti come numeri binari. La profondità di bit, perciò, si riferisce alla<br />

lunghezza delle parole binarie (cioè sequenze di 0 e 1) usate per descrivere ciascun campione del<br />

segnale d'ingresso preso dal convertitore A-D. Parole più lunghe permettono la rappresentazione di<br />

una serie più ampia di numeri, e quindi misurazioni più accurate e riproduzioni più fedeli di un<br />

segnale (maggior dinamica e minor distorsione). In un sistema a 16-bit, ciascun campione è<br />

rappresentato come una parola binaria lunga 16 cifre. Poichè ciascuna di queste 16 cifre può essere<br />

uno 0 o un 1, sono possibili 65.536 (2 16 ) valori per ciascun campione.<br />

13

In conclusione, la qualità complessiva dell'audio dipende dai due fattori (frequenza di<br />

campionamento e risoluzione) nel loro insieme. Nella tabella che segue possiamo vedere in pratica<br />

alcune differenze di qualità dell'audio:<br />

Frequenza<br />

(kHz)<br />

Risoluzione<br />

(bit)<br />

Qualità<br />

11,025 8 Telefono<br />

11,025 16 Tv<br />

22,050 16 Audiocassetta<br />

44,1 16 CD audio<br />

48 16 Registratore DAT<br />

<strong>Il</strong> nome generico per il sistema di registrazione digitale descritto precedentemente è Pulse Code<br />

Modulation (PCM), ed è usato in tutti i moderni campionatori, registratori digitali ed<br />

interfacce audio per computer. Per ottenere una riproduzione fedele di un segnale audio, la<br />

codifica PCM mira ad effettuare un'accurata lettura della forma d'onda del segnale.<br />

CONVERTITORE ANALOGICO DIGITALE<br />

<strong>Il</strong> dispositivo elettronico che ci permette di convertire un segnale analogico di una certa ampiezza<br />

nel corrispondente segnale digitale, rappresentato da un numero di n bit, si chiama convertitore<br />

analogico-digitale.<br />

Parametri importanti di un ADC sono il quanto, la tensione di fondo scala e il numero di bit<br />

(vedi da pag 194 a pag 201 del testo di Elettronica e telecomunicazioni). <strong>Il</strong> numero N che<br />

memorizza in calcolatore e l’ampiezza Vi del segnale analogico sono proporzionali attraverso il<br />

quanto Q<br />

Vi=Q*N dove Q=Vfs/2 n<br />

Teorema di Shannon<br />

La correlazione tra frequenza di campionamento e risposta in frequenza è data dal "Teorema di<br />

Shannon-Nyquist", secondo il quale, perché un segnale sia accuratamente riprodotto da PCM,<br />

devono essere presi almeno due campioni di ciascun ciclo di forma d'onda. Questo significa che la<br />

frequenza di campionamento deve essere almeno doppia della frequenza massima che si vuole<br />

digitalizzare<br />

fcamp>=fMAX<br />

In pratica perciò, la frequenza più alta che può essere accuratamente registrata è la metà della<br />

frequenza di campionamento usata. Questo è conosciuto come il Limite di Nyquist. Un "CDquality"<br />

convenzionale ottenuto dal tradizionale sistema di registrazione digitale, usa una<br />

frequenza di campionamento di 44.1 kHz, e quindi può solo riprodurre frequenze fino a 22.05<br />

kHz. Tutte le frequenze sopra questo limite sono scartate. Questo non è generalmente considerato<br />

14

un problema, dal momento che le ricerche hanno mostrato che la maggior parte degli esseri umani<br />

sono capace di udire poco o nulla sopra quella frequenza. Però, se la frequenza di campionamento è<br />

ridotta a 22.05 kHz, tutte le frequenze oltre 11.025 kHz saranno scartate, e questo comporterà una<br />

degradazione ben udibile nella qualità del <strong>suono</strong>. Molti strumenti musicali producono frequenze<br />

oltre questo intervallo, e le registrazioni fatte con una frequenza di campionamento ridotta possono<br />

restituire immagini sonore scarse per brillantezza e chiarezza.<br />

Provate a registrare un <strong>suono</strong> col microfono inserito nella scheda audio del vostro computer e poi<br />

cambiate i parametri, riprendendoli dalla tabella, e salvateli con nomi diversi. Potrete verificare la<br />

diversa qualità del <strong>suono</strong>, ma vedrete anche che le dimensioni dei file crescono con l'aumentare<br />

della qualità.<br />

Dimensione dei file audio<br />

Lo spazio che un file audio occupa su un disco rigido aumenta con l'aumentare della risoluzione e<br />

della frequenza di campionamento. Nella tabella sotto possiamo vedere come le dimensioni dello<br />

stesso frammento audio stereo, della durata di dieci secondi, variano con i diversi valori della<br />

frequenza e della risoluzione.<br />

Frequenza (kHz) Risoluzione (bit) Spazio occupato<br />

11,025 8 386 KB<br />

22,050 8 579 KB<br />

22, 050 16 1,1 MB<br />

44,1 16 1,8 MB<br />

Se vogliamo sapere quanto spazio occupa un file audio possiamo fare un calcolo<br />

approssimativo utilizzando la formula:<br />

dimensione del file = durata in secondi x numero di canali x frequenza di campionamento x<br />

risoluzione / 8.<br />

Per fare un esempio pratico, un minuto di un file audio stereo della qualità di un CD occupa 60 x 2<br />

x 44,1 x 16/8 = 10,6 MB.<br />

<strong>Il</strong> fatto che un file audio possa occupare tanto spazio fino a qualche anno fa poneva dei problemi per<br />

la sua registrazione e l'elaborazione. Oggi però la disponibilità a basso costo di hard disk capaci e<br />

veloci e di memoria RAM adeguata, insieme alla velocità crescente dei processori, rendono<br />

possibili queste operazioni praticamente a tutti con una buona qualità sonora. Ma ci sono ancora dei<br />

casi in cui la dimensione del file audio può essere un problema: se vogliamo inserire dei suoni nel<br />

sito internet della scuola, se vogliamo spedirli o renderli scaricabili, vista la velocità della maggior<br />

parte dei modem, ci vorrebbe troppo tempo. Per ovviare a questo problema dobbiamo ricorrere ai<br />

metodi che ci permettono di diminuire le dimensioni del file audio.<br />

15

Per rendere più maneggevoli i file audio, è necessario ridurre la loro dimensione, e ci sono<br />

vari modi per farlo.<br />

Un metodo è ridurre la frequenza di campionamento: se è dimezzata (22.05 k Hz invece di<br />

44.01 kHz), viene considerata la metà delle misurazioni del segnale in ingresso, e così è prodotta<br />

solo la metà dei dati (un altro modo è una registrazione monofonica, che dimezza ulteriormente la<br />

quantità di dati necessaria). Tuttavia, queste scelte hanno alcuni seri effetti collaterali sulla qualità<br />

del <strong>suono</strong>.<br />

<strong>Il</strong> range della voce umana varia dai 500 Hz ai 2 kHz. L'orecchio umano percepisce le frequenze che<br />

vanno dai 20 Hz ai 20 kHz, ed è più sensibile tra i 2 e i 4 kHz.<br />

<strong>Il</strong> range dinamico, ossia l'intervallo dal <strong>suono</strong> più basso al più alto percepibile, è di 96 dB<br />

(Decibel).<br />

In generale, frequenze di campionamento di 11025 Hz sono adatte per la registrazione del parlato,<br />

22050 Hz per ottenere una qualità tipo radio (o dei vecchi dischi 78 giri caratterizzati da risposta in<br />

frequenza tra 50-8000 kHz), mentre 44100 Hz per registrazioni di qualità CD.<br />

Ridurre a metà (da 44.1 a 22.05 kHz) la frequenza di campionamento comporta una perdita di<br />

risoluzione, e quindi una minore fedeltà durante la riproduzione. Sarebbe un'esagerazione dire che<br />

la qualità del <strong>suono</strong> è ridotta a metà, ma la registrazione è comunque in alcuni punti meno accurata<br />

per la metà. In particolare, la risposta in frequenza del sistema di registrazione è dimezzata. In<br />

effetti questo comporta che molte delle altre frequenze contente nel <strong>suono</strong> originale sono perdute e<br />

con esse molte armoniche, portando a registrazioni scarse per brillantezza e chiarezza.<br />

Un metodo alternativo di ridurre la dimensione di un file audio è ridurre la profondità di bit<br />

del sistema di registrazione usato per crearli. Per esempio, un campionamento a 8-bit può essere<br />

usato invece di uno a 16-bit. Proprio come la riduzione della frequenza di campionamento, questo<br />

ha indubbiamente l'effetto desiderato di ridurre l'ammontare di dati generati per fare una<br />

registrazione. Se ciascun campione del segnale in ingresso è memorizzato come un 8-bit piuttosto<br />

che un 16-bit di parola binaria, allora la registrazione produce solo un byte per campione piuttosto<br />

che due. Questo virtualmente raddoppia la capacità del mezzo del supporto di memorizzazione<br />

usato, in quanto dimezza realmente la grandezza dei file.<br />

Una riduzione nella profondità di bit, però comporta alcuni effetti indesiderabili per la qualità del<br />

<strong>suono</strong>. Come abbiamo visto, un sistema a 16-bit permette 65.536 o (2 16 ) valori possibili per ciascun<br />

campione preso. Si potrebbe pensare che un sistema a 8-bit permetta esattamente la metà della<br />

risoluzione audio, ma questo sarebbe ottimistico: una parola bianaria di 8-bit ha in effetti solo 256<br />

(2 8 ) valori possibili. Ciò comporta un campionamento notevolmente meno accurato del segnale in<br />

ingresso, e, per conseguenza, registrazioni di qualità inferiore. Questo comporta una riduzione nel<br />

rapporto segnale/disturbo del sistema, e conduce a registrazioni che producono un <strong>suono</strong> aspro,<br />

innaturale e con scarsa dinamica.<br />

A dispetto dei problemi inerenti la riduzione nella frequenza di campionamento e la<br />

profondità di bit del PCM audio, questi metodi sono usati spesso in applicazioni dove la<br />

qualità del <strong>suono</strong> è considerata un minore priorità rispetto alla conservazione delle risorse del<br />

sistema (per esempio, in commenti parlati, un campiionamento a 8 bit e 22.05 kHz è del tutto<br />

accettabile).<br />

Compressione audio digitale<br />

La compressione audio è una tecnica che permette di ridurre le dimensioni di un file audio o la<br />

banda passante richiesta per una trasmissione audio, anche di molto.<br />

16

Un file è una sequenza di cifre binarie (bit) utilizzata come veicolo di informazione. Comprimere<br />

significa ridurre il numero delle cifre (dei bit) che costituiscono la sequenza mantenendo<br />

l'informazione inalterata o in un intorno dell'informazione originaria (ossia facendo in modo che la<br />

nuova informazione approssimi quella precedente).<br />

I motivi della compressione sono:<br />

• occupare minor spazio in fase di immagazzinamento<br />

• impiegare minor tempo in fase di trasferimento dati.<br />

<strong>Il</strong> costo è l'aumento dei tempi di lettura/scrittura legati rispettivamente a tempi di<br />

decompressione/compressione. Nel caso di file audio si ha un costo anche in termini di qualità<br />

dell'audio.<br />

Per ottenere un file compresso occorre usare un programma che si chiama encoder, come si<br />

vede dalla figura seguente (il discorso è analogo per il file video).<br />

La chiave della codifica audio è il cosiddetto effetto di masking. Esso è dovuto alle caratteristiche<br />

dell'orecchio umano, per il quale un tono forte ad una determinata frequenza nasconde toni più<br />

deboli che si trovano nelle sue vicinanze, i quali, anche se effettivamente presenti, non vengono<br />

percepiti.<br />

Per tornare al file non compresso c’è un decoder, che utilizza le informazioni salvate<br />

dall’encoder per rifare il procedimento inverso.<br />

L'uscita del codificatore deve essere tale da poter essere interpretata dal decodificatore, cioè deve<br />

rispettare una ben precisa sintassi.<br />

I file di tipo .WAV o .AIFF (Machintosh) non sono compressi<br />

Esistono due tipi di compressione:<br />

• con perdita (lossy): quando l'informazione contenuta nel file compresso è minore di<br />

quella contenuta nel file di origine<br />

• senza perdita (lossless): quando l'informazione contenuta nel file compresso è identica a<br />

quella contenuta nel file di origine<br />

La prima permette compressioni maggiori, ma a scapito della qualità sonora.<br />

Usando un algoritmo di compressione senza perdita, dal risultato della compressione si può<br />

riottenere tutta l'informazione originaria. In questo caso la riduzione massima generalmente<br />

ottenibile, utilizzando algoritmi studiati appositamente per l'audio è all'incirca del 60%, ma solo<br />

con alcuni tipi di <strong>suono</strong>.<br />

17

Dal risultato della compressione audio con perdita non si può più ottenere un <strong>suono</strong> identico<br />

all'originale ma la riduzione ottenibile è molto spinta: con rapporti di compressione di 10 a 1, il<br />

risultato è quasi indistinguibile dall'originale ma ci si può spingere anche oltre a discapito della<br />

qualità.<br />

Gli studi di psicoacustica (la psicoacustica è lo studio della percezione soggettiva umana dei suoni,<br />

più precisamente è lo studio della psicologia della percezione acustica) hanno permesso di<br />

accertare che l'uomo non è sensibile nello stesso modo a tutte le frequenze e che un <strong>suono</strong> ad alta<br />

intensità ne maschera uno con frequenza vicina ma intensità più bassa. Sfruttando queste ed altre<br />

considerazioni, si può pensare di eliminare l'informazione che non verrebbe comunque percepita ed<br />

ottenere quindi un buon rapporto di compressione.<br />

Occorre distinguere fra segnali vocali e segnali musicali.<br />

Per i segnali musicali lo standard è il CD audio con una frequenza di campionamento di 44,1<br />

KHz e una profondità di bit di 16<br />

Esempi di compressori sono:<br />

• MP3 (MPEG-1 Layer III) è stato introdotto negli anni '80 ed è il più popolare. Essendo il più<br />

antico, è anche il meno efficiente e spesso il peggiore in termini di qualità.<br />

• Windows Media Audio (WMA) è molto diffuso sui sistemi Windows.<br />

• VORBIS è un codec più efficiente dell'mp3 ed è open source (ossia liberamente distribuibile<br />

e modificabile)<br />

• AAC è stato reso popolare dalla Apple. Apple's (iTunes Music Store)<br />

Per i segnali vocali lo standard è il sistema telefonico con una frequenza di campionamento di<br />

8 KHz e una profondità di bit di 8<br />

<strong>Il</strong> Global System for Mobile Communications (GSM) è attualmente lo standard di telefonia<br />

mobile più diffuso del mondo. Utilizza un bitrate di 9,6Kbit/sec con un tasso di compressione di<br />

1:14<br />

Bitrate<br />

I file multimediali sono per loro natura connessi al tempo che scorre. In altri termini ad ogni<br />

secondo è associato un certo contenuto informativo e quindi una certa sequenza di cifre binarie. <strong>Il</strong><br />

numero di cifre binarie che compongono queste sequenze è detto bitrate. In altre parole il bitrate è<br />

il numero di cifre binarie impiegate per immagazzinare un secondo di informazione. Questo<br />

può essere costante per tutta la durata del file o variare all'interno di esso. Ad esempio i cd musicali<br />

vengono campionati (registrati) ad una frequenza pari a 44,1KHz. Da ciò deriva che ad ogni<br />

secondo si hanno 44.100 valori registrati dall'ipotetico microfono che vanno poi moltiplicati per i 2<br />

canali del <strong>suono</strong> stereo che vanno a loro volta moltiplicati per 16 (poiché la registrazione avviene a<br />

16 bit) Quindi avremo:<br />

Bitrate= 44,1 x 2 x16= 1411kbit/sec=1,4Mbit/sec<br />

Questo significa che lo spazio necessario per registrare un minuto di audio è<br />

Bitrate x 60= 84 Mbit<br />

Per trovarlo in byte divido per 8 quindi ottengo circa 10 MByte<br />

La compressione, diminuendo la lunghezza globale del file, diminuirà di conseguenza la lunghezza<br />

media delle sottosequenze ossia diminuirà il bitrate medio. <strong>Il</strong> bitrate medio diventa dunque in<br />

questi casi l'indice dell'entità della compressione. Ad esempio se il file di origine possedesse un<br />

bitrate di 1411 Kbit/s e il file compresso possedesse un bitrate medio di 320 Kbit/s, allora avremmo<br />

18

idotto di un fattore pari a circa 4.5. (rapporto fra il bitrate del file non compresso e quello del file<br />

compresso).<br />

Moving Picture Experts Group : MPEG<br />

<strong>Il</strong> Moving Picture Experts Group, in sigla MPEG, nome ufficiale ISO/IEC JTC 1/SC 29/WG 11<br />

(titolo: "Coding of moving pictures and audio"), è un comitato tecnico congiunto delle<br />

organizzazioni internazionali ISO e IEC incaricato di definire degli standard per la rappresentazione<br />

in forma digitale di audio, video e altri tipi di contenuti multimediali, in grado di soddisfare<br />

un'ampia varietà di applicazioni.<br />

L'ISO, o Organizzazione internazionale per le standardizzazioni (in italiano, International Organization for<br />

Standardization in inglese, è la più importante organizzazione a livello mondiale per la definizione di standard<br />

industriali e commerciali. Suoi membri sono gli organismi nazionali di standardizzazione di 157 Paesi del mondo.<br />

Le norme ISO vengono recepite, armonizzate e diffuse in Italia dall'UNI (Ente nazionale italiano di unificazione), il<br />

membro che partecipa in rappresentanza dell'Italia all'attività normativa dell'ISO.<br />

La IEC, o Commissione Elettrotecnica Internazionale in italiano, International Electrotechnical Commission in inglese,<br />

è un'organizzazione internazionale per la definizione di standard in materia di elettricità, elettronica e tecnologie<br />

correlate. Molti dei suoi standard sono definiti in collaborazione con l'ISO (Organizzazione Internazionale per le<br />

Standardizzazioni).<br />

Questa commissione è formata da rappresentanti dei corpi di standardizzazione nazionali riconosciuti.<br />

<strong>Il</strong> comitato è stato costituito nel gennaio 1988 e normalmente si riunisce una media di quattro volte<br />

all'anno. Alla prima riunione hanno partecipato 25 membri. Attualmente alle riunioni vi partecipano<br />

oltre 350 membri in rappresentanza di più di 200 aziende e organizzazioni appartenenti a circa 20<br />

nazioni del mondo.<br />

Attualmente gli standard definiti dall'MPEG sono tra i più universalmente utilizzati.<br />

L'MPEG ha definito i seguenti standard:<br />

Nome comune Nome ISO Titolo ISO<br />

MPEG-1 ISO/IEC 11172<br />

Coding of moving pictures and associated audio at up to about 1.5<br />

Mbit/s<br />

MPEG-2 ISO/IEC 13818 Generic coding of moving pictures and associated audio<br />

MPEG-4 ISO/IEC 14496 Coding of audio-visual objects<br />

MPEG-7 ISO/IEC 15938 Multimedia Content Description Interface<br />

MPEG-21 ISO/IEC 21000 Multimedia Framework<br />

L'MPEG-1 è utilizzato nel Video CD (un formato a bassa qualità, analoga al sistema VHS).<br />

L'MPEG-2 è utilizzato nella televisione digitale satellitare, nel DVD-Video, nella televisione<br />

19

digitale terrestre ed ha una qualità superiore all'MPEG-1 ma richiede per contro una maggior<br />

quantità di risorse hardware.<br />

L'MPEG-4 è un'estensione dell'MPEG-1 in grado di gestire flussi audio/video eterogenei,<br />

contenuti 3D, flussi video a basso bitrate e diritti digitali.<br />

L'MPEG-21 è nato per sviluppare una piattaforma comune per le future applicazioni<br />

multimediali.<br />

Uno standard abbandonado è invece l'MPEG-3, inizialmente sviluppato per l'HDTV in seguito si<br />

è scoperto che l'MPEG-2 era sufficiente per tale applicazione.<br />

MP3 (è il layer 3 dell’MPEG-1) è il compressore più utilizzato in assoluto nella codifica<br />

musicale. E’ un algoritmo di compressione audio di tipo lossy in grado di ridurre drasticamente la<br />

quantità di dati richiesti per memorizzare un <strong>suono</strong>, rimanendo comunque una riproduzione fedele<br />

del file originale non compresso.<br />

Per l'MPEG-1 layer 3 i bitrate (MP3) disponibili sono: 32, 40, 48, 64, 80, 96, 112, 128, 160, 192,<br />

224, 256 e 320 kbit/s ( 103 bits per secondo ), e le frequenze campionate disponibili sono 32, 44.1<br />

e 48 Khz. La frequenza di campionamento a 44.1 kHz è quasi sempre utilizzata per i CD<br />

audio, mentre i 128 Kbit/s come una sorta di bitrate standard "abbastanza buono". L'MPEG-2<br />

e l'MPEG-2.5 (non-ufficiale) contemplano un numero maggiore di bitrate: 8, 16, 24, 32, 40, 48, 56,<br />

64, 80, 96, 112, 128, 144 e 160 kbit/s<br />

Gli algoritmi<br />

Gli algoritmi sviluppati dal gruppo MPEG sono tutti algoritmi a perdita di informazione<br />

(lossy).<br />

Elaborare il segnale nel dominio delle frequenze offre anche altri vantaggi. <strong>Il</strong> nostro orecchio non è<br />

uno strumento lineare, cioè non percepisce tutti i suoni e soprattutto non li percepisce tutti nello<br />

stesso modo. Da qui l'idea di eliminare tutte quelle componenti frequenziali che non possiamo<br />

udire. Questa è ovviamente una tecnica lossy: il <strong>suono</strong> compresso sarà diverso da quello<br />

originale ma i nostri sensi non riusciranno a percepirne la differenza. Si rende quindi<br />

necessario uno studio sul modello percettivo, cioè sulla percezione umana del <strong>suono</strong>. La banda di<br />

frequenze udibili va dai 16 Hz fino a 20 kHz. Nel modello MPEG-1 il primo taglio in frequenza<br />

viene effettuato eliminando le frequenze troppo basse o troppo alte. Affinché un <strong>suono</strong> sia<br />

percepibile deve essere sufficientemente forte, cioè deve esercitare un livello minimo di pressione<br />

sulla membrana del timpano dell'orecchio, tuttavia tale soglia non è costante ma, varia in funzione<br />

della frequenza.<br />

In figura è riportato un grafico qualitativo che mostra quale deve essere la pressione minima<br />

che un <strong>suono</strong> deve avere per poter essere percepito. Nelle ascisse (in scala logaritmica) ci sono le<br />

frequenze, mentre nelle ordinate ci sono i livelli di pressione sonora (in dB). Tutti i suoni che si<br />

trovano nella zona grigia possono essere eliminati.<br />

20

A questo va aggiunto che la percettività del <strong>suono</strong> non è costante nel tempo, ma varia in funzione di<br />

ciò che ascoltiamo. In pratica un tono forte copre i suoni d'intensità minore, non solo ad una<br />

determinata frequenza ma anche in quelle vicine, infatti come tutti i sensori, l'orecchio non ha tempi<br />

di reazione nulli cioè impiega un certo tempo per adattarsi alle nuove condizioni e soprattutto<br />

impiega tempo a tornare in quiete dopo una sollecitazione. Affinché un <strong>suono</strong> sia percepito è<br />

dunque necessario che si mantenga per un certo tempo senza disturbi. MPEG-1, in<br />

considerazione dei fattori sopra citati, filtra il <strong>suono</strong> digitale eliminando la parte<br />

dell'informazione che per l'orecchio umano è ininfluente.<br />

21