COMUNICAÇÕES 248 - VIRGÍNIA DIGNUM: IA RESPONSÁVEL PRECISA DE "REGRAS DE TRÂNSITO"

- Text

- Apdc

- Digitalbusinesscommunity

- Digital

- Artificial

- Ciberseguraunça

- Talento

- Inovação

- Território

- Experimentação

- Testbeds

- Tecnologia

a conversa Uma das

a conversa Uma das questões que se levanta é que a regulação vai ser muita má para a inovação… Voltando ao exemplo dos carros: quem é que quer andar num carro sem travões? Se tomarmos a regulação a sério, continuamos a poder desenvolver a tecnologia, tendo muito maior capacidade de garantir a segurança no que estamos a fazer. A regulação também pode, por outro lado, ser uma rampa de lançamento de inovação. Tenho estado a trabalhar na UE nas regras para IA de confiança, mas também trabalhei com a UNESCO nas regras para a ética. Nesses grupos, é bastante fácil concordar que a IA deve ser justa e dar garantia de privacidade. Toda a gente concorda com estes princípios. O que é extremamente difícil e não há, neste momento, capacidade de inovação suficiente é dizer: o que é que isso quer dizer quando estou a escrever o meu código? Tem a ver com a regulação, mas também com a implementação. Como posso garantir que o meu sistema é mais justo do que outro? Por enquanto ainda não podemos garantir, de forma matemática, que o que eu estou a fazer é justo. Como é que vou medir? É nisto que precisamos de inovação. Aqueles que têm vindo a público com ideias realmente assustadoras sobre o que a IA pode fazer no futuro, acha que em boa parte é marketing? Não é marketing, mas é uma maneira de focar a atenção num problema que não é real neste momento. Enquanto estamos todos a olhar para as citações do “terminator”, receando que a IA nos matará a todos quando acordarmos de manhã, ninguém está a tomar atenção ao que se está a fazer agora. Porque está tudo assustado com o que vai acontecer, potencialmente, talvez daqui a 100 anos e, entretanto, fazem o que quiserem. Sendo uma especialista na área, sabe muito mais do que a esmagadora maioria das pessoas. Esse conhecimento não é também uma fonte de inquietação? Ou pelo contrário? Acaba por ser “pelo contrário”. O que tento fazer nesses órgãos em que estou envolvida é demonstrar que nós somos responsáveis, não temos que estar a pôr medo e foco na máquina em si: afinal fomos nós que a fizemos. Temos de ter mais consciência da nossa responsabilidade e isso passa pela questão de decidirmos se vamos implementar IA nesta situação, ou não. Em muitos casos, teremos de ser capazes de dizer “não”. Neste momento, não temos a capacidade, ou as garantias, que o sistema seja usado de maneira certa – portanto, o melhor que temos a fazer é não o implementar. Disse, numa entrevista recente, que tem de haver regulação ao nível das empresas, dos setores, dos países e das regiões, com uma coordenação ao nível global, onde a futura agência da ONU terá uma palavra a dizer... Exatamente. Não se pode pensar que vamos fazer uma regulação de um tamanho único, que serve para tudo. Temos de ter em conta as diferentes realidades e situações. Uma regulação que se faz para um sistema médico não é igual à que se faz para aplicações financeiras. Temos de ter a capacidade de traduzir os princípios éticos e sociais de forma diferente para cada área. Tomando em conta também os contextos culturais. A ONU não vai decidir de maneira uniforme quais são a regras a observar por todos, mas sim uma forma de coordenar e integrar o que se faz num sítio e noutro. O que o secretário-geral nos pediu, foi: “Definam estruturas adequadas para este organismo internacional. Tendo em atenção o que são riscos e o que são oportunidades”. Também estamos a definir quais serão as funções deste organismo: deverá ter funções de monitorização, de sancionamento, de emergência. Se um dia tudo correr mal, deverá funcionar como uma Cruz Vermelha Internacional. É o que estamos a fazer neste momento. Quando se assume que, tecnicamente, ainda não é possível encontrar soluções para a implementação de certas coisas, no fundo o que se está a dizer é que em certas questões não se pode avançar em termos de regulação… Mas a regulação não tem de ser só sobre a técnica. A IA não é só uma questão de engenharia. A IA, neste momento, é um sistema social. Inclui as partes técnicas, mas também inclui as organizações, os engenheiros, os utilizadores, os juristas. Se não há possibilidade de resolver as coisas de forma técnica, tem de se resolver de outra maneira. Falando do nosso país: acha que esta instabilidade política poderá pôr em risco projetos como o consórcio liderado pela Unbabel? Penso que os consórcios que já estão a trabalhar não serão afetados. Mas estou extremamente preocupada com a instabilidade política não só em Portugal, mas também no mundo. Dentro dos próximos 12 meses vai haver eleições em 85 países. A IA vai ajudar pessoas a criar notícias falsas, portanto por aí vamos ver a utilização da IA que reflete a inconsciência das pessoas e o oportunismo. Esta instabilidade vai certamente influenciar a forma como o desenvolvimento desta tecnologia vai continuar. Essa instabilidade poderá influenciar medidas mais duras de controlo e regulação? Pode ter esse efeito ou o contrário. Depende para que lado a instabilidade política vai pender.• 24

As nossas melhores soluções começam consigo As nossas soluções digitais para o setor da saúde garantem o acesso à informação certa, no momento certo e pelas pessoas certas. Mais agilidade, mais eficiência, maior inovação e a garantia de conformidade com os requisitos regulamentares e de segurança. Descubra mais em cgi.com

- Page 1: MEDIA CONSEGUIRÁ A EUROPA PÔR ORD

- Page 4: sumario FICHA TÉCNICA COMUNICAÇÕ

- Page 7 and 8: CURIOSIDADE IA NO FRIGORIFICO AGILI

- Page 9 and 10: Os canais mais utilizados pelos cri

- Page 11 and 12: PRINCÍPIOS-CHAVE DA IA RESPONSÁVE

- Page 13 and 14: À frente da Google Cloud Portugal

- Page 15 and 16: A INTELIGÊNCIA ARTIFICIAL É O QUE

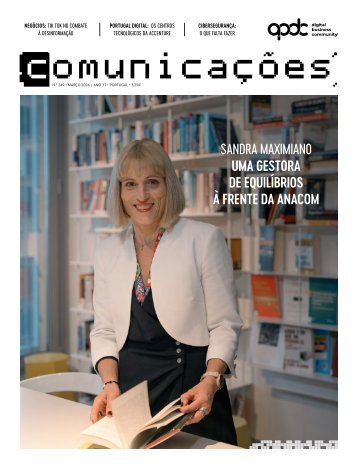

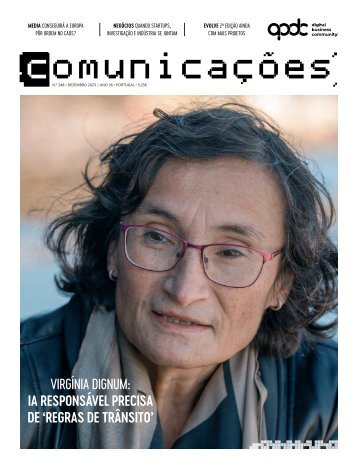

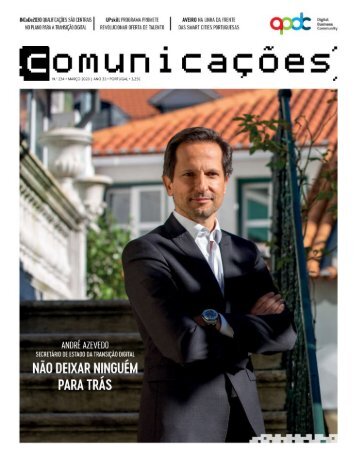

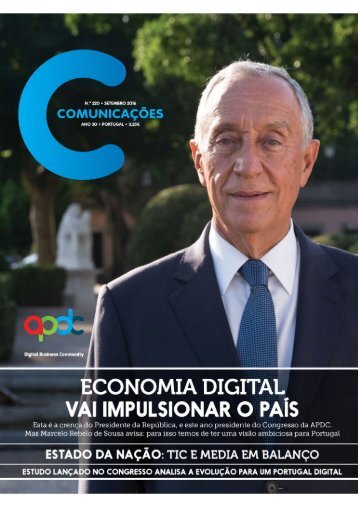

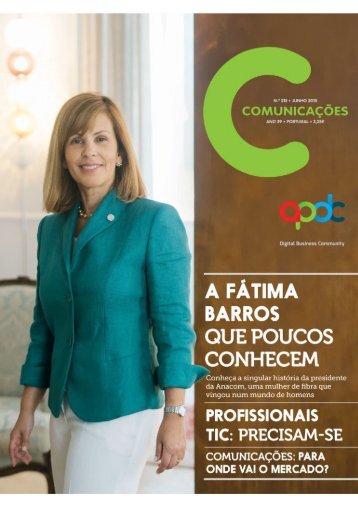

- Page 17 and 18: Quando Virgínia Dignum se interess

- Page 19 and 20: Como é que começou a interessar-s

- Page 21 and 22: “Um programa de computação não

- Page 23: Pegando na metáfora do carro: pode

- Page 27 and 28: EAN MEDIA FREEDOM ACT NSEGUIRÁ E P

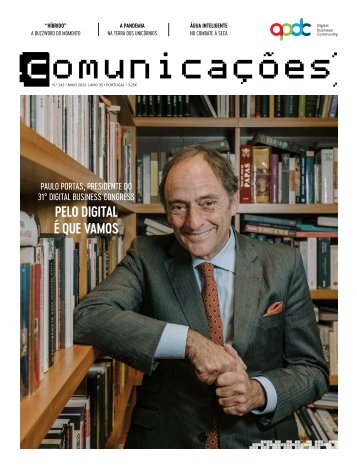

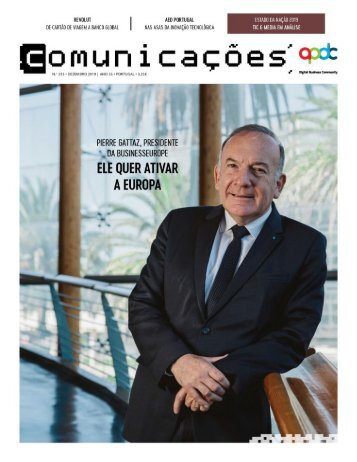

- Page 29 and 30: Nuno Santos (CNN Portugal), Ricardo

- Page 31 and 32: plataformas de distribuição, são

- Page 33 and 34: 33

- Page 35 and 36: Para acelerar a transformação dig

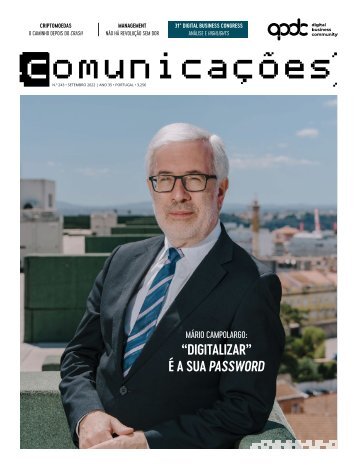

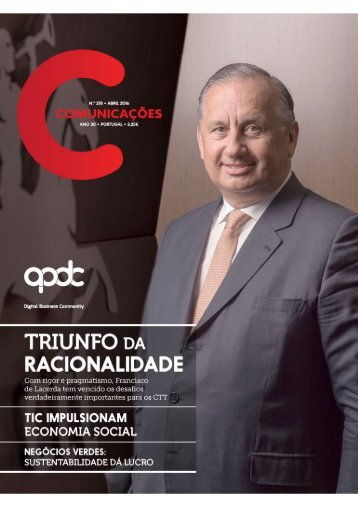

- Page 37 and 38: Paulo Cardoso do Amaral, que voltou

- Page 39 and 40: 17 ESTUDOS DE CASO PARA ALAVANCAR I

- Page 41 and 42: tiu obter “metas de performance m

- Page 43 and 44: se processos redundantes. Pusemos a

- Page 45 and 46: tratamento de dados, numa perspetiv

- Page 47 and 48: 47

- Page 49 and 50: Paulo Dimas: “Quando as pessoas e

- Page 51 and 52: ASSEGURAR O FUTURO COM SOLUÇÕES R

- Page 54 and 55: itech 54 PEDRO FAUSTINO: Paixão co

- Page 56 and 57: portugal digital 56

- Page 58 and 59: portugal digital Todos os anos a AP

- Page 60 and 61: portugal digital 60 situações em

- Page 62 and 63: apdc news ACORDO APDC, GOVERNO E IN

- Page 64 and 65: apdc news “Desde a montagem do pr

- Page 66 and 67: apdc news PORTUGAL AS A TECH HUB In

- Page 68 and 69: apdc news APDC & VDA | DIGITAL UNIO

- Page 70 and 71: apdc news 70 No tema da fair contri

- Page 72 and 73: apdc news 72 Todo o projeto está e

- Page 74:

apdc news 74 que tem por detrás um

- Page 77 and 78:

cidadania SAFEFOREST: robótica na

- Page 79 and 80:

ROBUSTECER PROJETO EDUCACIONAL INOV

- Page 82:

MANTEMOS A EUROPA CONECTADA, com um

Inappropriate

Loading...

Mail this publication

Loading...

Embed

Loading...