Théorie de Lyapunov, commande robuste et ... - LAAS CNRS

Théorie de Lyapunov, commande robuste et ... - LAAS CNRS

Théorie de Lyapunov, commande robuste et ... - LAAS CNRS

You also want an ePaper? Increase the reach of your titles

YUMPU automatically turns print PDFs into web optimized ePapers that Google loves.

<strong>Théorie</strong> <strong>de</strong> <strong>Lyapunov</strong>, comman<strong>de</strong> <strong>robuste</strong> <strong>et</strong> optimisation<br />

D. Arzelier<br />

<strong>LAAS</strong>-<strong>CNRS</strong> - UPR 8001<br />

Toulouse

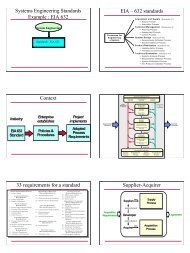

Quelques éléments <strong>de</strong> contexte 2<br />

Algèbre linéaire<br />

<strong>Théorie</strong> <strong>de</strong> la complexité<br />

<strong>Théorie</strong> <strong>de</strong> l’information<br />

R.E. Kalman<br />

<strong>Théorie</strong> <strong>de</strong> Wiener−Hopf−Kalman<br />

<strong>Théorie</strong> <strong>de</strong>s systèmes dynamiques<br />

Analyse numérique<br />

Perturbations<br />

A. Turing<br />

Système<br />

dynamique<br />

P( ∆ )<br />

N. Wiener<br />

Sorties<br />

C. Shannon<br />

<strong>Théorie</strong> <strong>de</strong> l’ interpolation<br />

<strong>Théorie</strong> <strong>de</strong>s fonctions analytiques<br />

Actions<br />

Loi <strong>de</strong><br />

comman<strong>de</strong><br />

K<br />

Mesures<br />

H. Black<br />

H. Bo<strong>de</strong><br />

G. Zames<br />

<strong>Théorie</strong> <strong>de</strong>s opérateurs<br />

J.L. Lagrange<br />

A. <strong>Lyapunov</strong><br />

Programmation mathématique<br />

H. Nyquist<br />

<strong>Théorie</strong> <strong>de</strong> <strong>Lyapunov</strong>, comman<strong>de</strong> <strong>robuste</strong> <strong>et</strong> optimisation<br />

JNMACS<br />

06/09/05

Le modèle standard 3<br />

Le modèle standard : [Doyle 1983]<br />

Formulation générale <strong>et</strong> unifiée <strong>de</strong>s problèmes <strong>de</strong> modélisation, d’analyse <strong>et</strong> <strong>de</strong> synthèse <strong>de</strong>s<br />

systèmes <strong>de</strong> comman<strong>de</strong> à contre-réaction multivariables<br />

Hypothèse :<br />

w<br />

P<br />

z<br />

Le modèle généralisé P <strong>et</strong> le correcteur généralisé K<br />

u<br />

y<br />

sont <strong>de</strong>s modèles LTI<br />

K<br />

Schéma standard<br />

- Synthèse <strong>de</strong>s approches fréquentielles (outils graphiques, sensibilité, <strong>robuste</strong>sse) <strong>et</strong> espace<br />

d’état (Optimalité, LQG, théorie <strong>de</strong> <strong>Lyapunov</strong>)<br />

- Optimisation pour l’analyse <strong>de</strong> performance (analyse pire-cas) <strong>et</strong> <strong>de</strong>scription <strong>de</strong> l’incertitu<strong>de</strong><br />

<strong>de</strong> modélisation<br />

- Utilisation systématique <strong>de</strong>s normes systèmes (H ∞ , H 2 ...)<br />

<strong>Théorie</strong> <strong>de</strong> <strong>Lyapunov</strong>, comman<strong>de</strong> <strong>robuste</strong> <strong>et</strong> optimisation<br />

JNMACS<br />

06/09/05

Modélisation incertaine, analyse <strong>et</strong> synthèse <strong>robuste</strong>s 4<br />

w<br />

w ∆<br />

∆<br />

P<br />

z ∆<br />

z<br />

Problème 1 (modélisation incertaine)<br />

Choisir (w, u, z, y, z ∆ ,w ∆ ), caractériser la causalité entrée-sortie<br />

u<br />

K<br />

y<br />

<strong>et</strong> décrire ∆ ∈ ∆<br />

Problème 2 (synthèse <strong>robuste</strong>)<br />

w<br />

P( ∆ )<br />

z<br />

Déterminer K conférant à l’interconnexion stabilité <strong>et</strong> perfor-<br />

u<br />

y<br />

mances <strong>robuste</strong>s<br />

K<br />

∆<br />

Problème 3 (analyse <strong>robuste</strong>)<br />

w<br />

w ∆<br />

N<br />

z ∆<br />

z<br />

Pour K donné, déterminer si l’interconnexion est <strong>robuste</strong> en<br />

stabilité <strong>et</strong> performance<br />

<strong>Théorie</strong> <strong>de</strong> <strong>Lyapunov</strong>, comman<strong>de</strong> <strong>robuste</strong> <strong>et</strong> optimisation<br />

JNMACS<br />

06/09/05

Analyse <strong>et</strong> synthèse <strong>robuste</strong>s 5<br />

- La synthèse H ∞ [Zames 1981]<br />

min<br />

K∈K<br />

‖T zw(K)‖ ∞<br />

➊ Problème d’interpolation <strong>de</strong> fonctions analytiques, techniques <strong>de</strong> Nevanlinna-Pick-Schur,<br />

théorie <strong>de</strong>s opérateurs <strong>de</strong> Sarason, AAK, BH, [FHZ 84], [Doyle 84]<br />

➋ Problème <strong>de</strong> Nehari-Hankel, théorie <strong>de</strong> la factorisation, paramétrisation <strong>de</strong> Youla,<br />

argument <strong>de</strong> séparation [BSS80], [Glover 84], [DGKF 89]<br />

➌ Emergence <strong>de</strong> la formulation LMI [Willems 71], [GA 94]<br />

- La µ-analyse : [Popov 61], [Sandberg 63], [Doyle 1982], [Safonov 1982]<br />

µ ∆ (P )=<br />

1<br />

min {σ(∆) : ∆ ∈ ∆, <strong>de</strong>t(1 − P ∆) = 0}<br />

➊ Analyse fonctionnelle, théorie <strong>de</strong>s opérateurs [Zames 63], [Narendra 64]<br />

➋ Optimisation globale <strong>et</strong> optimisation convexe [YD 90], [YND 91], [FTD 91], [Ferreres 99]<br />

<strong>Théorie</strong> <strong>de</strong> <strong>Lyapunov</strong>, comman<strong>de</strong> <strong>robuste</strong> <strong>et</strong> optimisation<br />

JNMACS<br />

06/09/05

Analyse <strong>et</strong> synthèse <strong>robuste</strong>s 6<br />

- <strong>Théorie</strong> <strong>de</strong> <strong>Lyapunov</strong> <strong>et</strong> stabilité quadratique [LP 47], [Barmish 1985], [BPG 89] [BB 1991]<br />

P ≻ 0 A ′ (∆,K)P + P A(∆,K) ≺ 0<br />

➊ Algèbre <strong>de</strong>s polynômes <strong>et</strong> métho<strong>de</strong>s graphiques [Yakubovich 62], [Kalman 63]<br />

➋ Algèbre linéaire <strong>et</strong> numérique [Willems 1971]<br />

➌ Prog. SDP :PI[BF 63], [NN 1994] <strong>et</strong> appr. non diff. [Kelley 1960], [Overton 88]<br />

➥ Approches littérales ≠ Approches numériques<br />

”a wi<strong>de</strong> (but incompl<strong>et</strong>e) class of linear controller <strong>de</strong>sign problems can be cast as convex optimization problems”<br />

Pb. <strong>de</strong> comman<strong>de</strong> = Pb. <strong>de</strong> programmation mathématique +métho<strong>de</strong> numérique efficace<br />

➦ Résultats faibles ≠ Résultats forts<br />

Complexité calculatoire : P=NP<strong>et</strong> démonstrabilité globale : convexité<br />

• Problèmes ”faciles” : alternative numérique aux solutions littérales usuelles<br />

• Problèmes ”durs” : relaxations convexes<br />

Nota : SIAM J. of Control <strong>de</strong>vient SIAM J. of Control and Optimization en 1976<br />

<strong>Théorie</strong> <strong>de</strong> <strong>Lyapunov</strong>, comman<strong>de</strong> <strong>robuste</strong> <strong>et</strong> optimisation<br />

JNMACS<br />

06/09/05

MPI + LMI = CR ou NLP + BMI = TC 7<br />

Bcp. <strong>de</strong> problèmes en comman<strong>de</strong> <strong>robuste</strong> sont encore non convexes (BMI) [Safonov 1994]<br />

I<strong>de</strong>ntification <strong>robuste</strong> :<br />

- I<strong>de</strong>ntification fréquentielle<br />

- Validation <strong>de</strong> modèle<br />

Synthèse :<br />

- µ-synthèse<br />

- Synthèse multiobjectifs<br />

- Synthèse avec contrainte <strong>de</strong> structure<br />

Analyse <strong>robuste</strong> en stabilité <strong>et</strong> performance :<br />

-Modèle incertain LFT : théorie du µ<br />

- Recherche <strong>de</strong> multiplieurs <strong>et</strong> théorie <strong>de</strong> la séparation <strong>de</strong>s graphes<br />

- Analyse <strong>robuste</strong> par les IQC’s<br />

<strong>Théorie</strong> <strong>de</strong> <strong>Lyapunov</strong>, comman<strong>de</strong> <strong>robuste</strong> <strong>et</strong> optimisation<br />

JNMACS<br />

06/09/05

Classes <strong>de</strong> problèmes d’optimisation non convexes 8<br />

Problème BMI : Problème avec contrainte <strong>de</strong> rang :<br />

min c ′ x<br />

min c ′ x<br />

sous<br />

n∑<br />

n∑ n∑<br />

F 0 + F i x i + G i,j x i x j ≻ 0<br />

sous F 0 +<br />

i=1<br />

i=1 j=i<br />

n∑<br />

F i x i ≻ 0<br />

i=1<br />

rang(G 0 +<br />

n∑<br />

G i x i ) ≤ N<br />

Problème <strong>de</strong> complémentarité conique : Minimisation concave :<br />

i=1<br />

min<br />

sous<br />

Trace(ZF)<br />

min f(x)<br />

(F , Z) ∈K ×K<br />

sous F 0 +<br />

n∑<br />

F i x i ≻ 0<br />

i=1<br />

f concave<br />

<strong>Théorie</strong> <strong>de</strong> <strong>Lyapunov</strong>, comman<strong>de</strong> <strong>robuste</strong> <strong>et</strong> optimisation<br />

JNMACS<br />

06/09/05

Exemple <strong>de</strong> problème LMI sous contrainte <strong>de</strong> rang 9<br />

10<br />

Ensemble réalisable :<br />

M ′ P M

✔ Les approches par relaxation :<br />

Quelques approches usuelles 10<br />

- Dualité <strong>et</strong> relaxation lagrangiennes<br />

<strong>Théorie</strong> <strong>de</strong> <strong>Lyapunov</strong>, S-procédure, lemme <strong>de</strong> Finsler <strong>et</strong> d’élimination, relaxation<br />

<strong>de</strong> rang<br />

- Les relaxations hiérarchiques<br />

Polynômes positifs, SOS, théorie <strong>de</strong>s moments<br />

- Les relaxations heuristiques<br />

Relaxations croisées <strong>et</strong> algorithmes <strong>de</strong> <strong>de</strong>scente coordonnée<br />

✔ Les approches algorithmiques :<br />

- La métho<strong>de</strong> du gradient conditionnel<br />

- Les métho<strong>de</strong>s <strong>de</strong> pénalité <strong>et</strong> <strong>de</strong> barrière<br />

- L’optimisation non différentiable<br />

- L’optimisation globale<br />

<strong>Théorie</strong> <strong>de</strong> <strong>Lyapunov</strong>, comman<strong>de</strong> <strong>robuste</strong> <strong>et</strong> optimisation<br />

JNMACS<br />

06/09/05

Dualité <strong>et</strong> relaxation Lagrangiennes 11<br />

p ∗ = inf<br />

x∈X<br />

f(x)<br />

sous h i (x) ≤ 0 i =1, ··· ,m<br />

Le Lagrangien : L(x, λ) =f(x)+<br />

Le problème dual :<br />

m∑<br />

λ i h i (x) λ i ≥ 0<br />

i=1<br />

d ⋆ =<br />

sup<br />

λ∈R +m<br />

inf<br />

x∈X<br />

L(x, λ) = sup<br />

λ∈R m+<br />

θ(λ)<br />

- La fonction duale θ(λ) est concave <strong>et</strong> semi-continue supérieurement<br />

- Résoudre le dual du dual revient àrésoudre une relaxation convexe du pb. primal<br />

- Dualité faiblep ⋆ ≥ d ⋆ , dualité forte, théorèmes <strong>de</strong>s alternatives<br />

- Dualité SDP(Application <strong>de</strong> la dualité conique)<br />

<strong>Théorie</strong> <strong>de</strong> <strong>Lyapunov</strong>, comman<strong>de</strong> <strong>robuste</strong> <strong>et</strong> optimisation<br />

JNMACS<br />

06/09/05

Relaxation lagrangienne : la S-procédure 12<br />

Proposition 1 : f(x) ≥ 0 ∀ x ≠0∈X |h i (x) ≥ 0, i =1, ··· ,m<br />

m∑<br />

Proposition 2 : ∃ τ i ≥ 0, i =1, ··· ,m | f(x) − τ i h i (x) ≥ 0<br />

i=1<br />

S-procedure 1 ([Yakubovich 71])<br />

Pour f(x) =x ′ Ax, h i (x) =x ′ B i x, i =1, ··· ,m <strong>et</strong> X = R n :<br />

- Si ∃ x ∈ R n tel que h 1 (x) > 0 alors pour m =1,laS-procédure n’est pas pessimiste<br />

- Si m =2,laS-procédure peut être pessimiste<br />

Pessimisme <strong>de</strong> la S-procédure = saut <strong>de</strong> dualité [Fradkov 73]<br />

inf<br />

h i (x)≤0<br />

f(x) ≥ sup<br />

τ j ≥0<br />

inf<br />

x∈X<br />

m f(x) − ∑<br />

τ j h j (x)<br />

j=1<br />

<strong>Théorie</strong> <strong>de</strong> <strong>Lyapunov</strong>, comman<strong>de</strong> <strong>robuste</strong> <strong>et</strong> optimisation<br />

JNMACS<br />

06/09/05

Preuve <strong>de</strong> la S-procédure : m =1 13<br />

Propriétés <strong>de</strong> convexité <strong>de</strong> l’image <strong>de</strong> B⊂K n par <strong>de</strong>s transformations quadratiques<br />

[Toeplitz 1919], [Hausdorff 1919]<br />

Théorème 1 ([Dines 41])<br />

Pour (A, B 1 ) ∈ S n × S n alors K = {(u, v) =(x ′ Ax, x ′ B 1 x) : x ∈ R n } est un cône<br />

convexe fermé <strong>de</strong> R 2<br />

v<br />

Supposons que x ′ Ax ≥ 0 ⇒ x ′ B 1 x ≥ 0.<br />

Q<br />

000000000000000000000<br />

111111111111111111111<br />

000000000000000000000<br />

111111111111111111111<br />

000000000000000000000<br />

111111111111111111111<br />

000000000000000000000<br />

111111111111111111111<br />

000000000000000000000<br />

111111111111111111111<br />

000000000000000000000<br />

111111111111111111111<br />

000000000000000000000<br />

111111111111111111111<br />

000000000000000000000<br />

111111111111111111111<br />

000000000000000000000<br />

111111111111111111111<br />

000000000000000000000<br />

111111111111111111111<br />

000000000000000000000<br />

111111111111111111111<br />

000000000000000000000<br />

000000000000000000000<br />

000000000000000000000<br />

111111111111111111111<br />

111111111111111111111<br />

111111111111111111111<br />

K<br />

000000000000000000000<br />

111111111111111111111<br />

000000000000000000000<br />

111111111111111111111<br />

000000000000000000000<br />

111111111111111111111<br />

000000000000000000000<br />

111111111111111111111<br />

000000000000000000000<br />

111111111111111111111<br />

000000000000000000000<br />

111111111111111111111<br />

000000000000000000000<br />

111111111111111111111<br />

000000000000000000000<br />

111111111111111111111<br />

u<br />

K∩Q= ∅ où Q = {v ≥ 0, u

Relaxation lagrangienne : théorèmes <strong>de</strong>s alternatives 14<br />

Soit l’application linéaire A : E → S<br />

A adj : S → E est l’application adjointe<br />

∀ x ∈ E, ∀ Z ∈ S, 〈A(x), Z〉 S<br />

=<br />

〈 〉<br />

x, A adj (Z)<br />

E<br />

Théorème 2 (Alternative forte)<br />

Une <strong>de</strong>s assertions suivantes est exactement vérifiée<br />

1- ∃ x ∈ E tel que A(x)+A 0 ≻ 0<br />

2- ∃ Z ∈ S +∗ telle que A adj (Z) =0 <strong>et</strong> 〈A 0 , Z〉 S<br />

≤ 0<br />

Théorème 3 (Alternative faible)<br />

Une <strong>de</strong>s assertions suivantes au plus est vérifiée<br />

1- ∃ x ∈ E tel que A(x)+A 0 0<br />

2- ∃ Z ∈ S +∗ telle que A adj (Z) =0 <strong>et</strong> 〈A 0 , Z〉 S<br />

≤ 0<br />

De plus, si A 0 = A(x 0 ) pour x 0 ∈ E ou si ̸ ∃ x ∈ E tel que A(x) 0 alors une seule <strong>de</strong>s<br />

assertions est exactement vraie.<br />

<strong>Théorie</strong> <strong>de</strong> <strong>Lyapunov</strong>, comman<strong>de</strong> <strong>robuste</strong> <strong>et</strong> optimisation<br />

JNMACS<br />

06/09/05

Relaxation lagrangienne <strong>et</strong> théorie <strong>de</strong> <strong>Lyapunov</strong> (I) 15<br />

Soit la sous-région D du plan complexe C<br />

D = {s ∈ C : d 0 + d 1 s + d ⋆ 1s ⋆ + d 2 s ⋆ s

Relaxation lagrangienne <strong>et</strong> théorie <strong>de</strong> <strong>Lyapunov</strong> (II) 16<br />

Formulation équivalente du problème <strong>de</strong> D-Stability :<br />

Λ(A) ⊂ D ssi µ ⋆ > 0 avec<br />

µ ⋆ = min<br />

s, q≠0<br />

sous<br />

q ⋆ (A − s1) ⋆ (A − s1)q<br />

s ∈ D C<br />

p = sq<br />

µ ⋆ = min<br />

p, q≠0<br />

[<br />

] ⎡<br />

q ⋆ p ⋆ ⎣ A′<br />

−1<br />

⎤<br />

⎦ [ A<br />

−1<br />

] ⎡ ⎣ q p<br />

⎤<br />

⎦<br />

sous<br />

[<br />

q<br />

p<br />

]<br />

D<br />

⎡<br />

⎣ q⋆<br />

p ⋆<br />

⎤<br />

⎦ ≽ 0<br />

<strong>Théorie</strong> <strong>de</strong> <strong>Lyapunov</strong>, comman<strong>de</strong> <strong>robuste</strong> <strong>et</strong> optimisation<br />

JNMACS<br />

06/09/05

Relaxation lagrangienne <strong>et</strong> théorie <strong>de</strong> <strong>Lyapunov</strong> (III) 17<br />

Posant A =[A<br />

− 1] <strong>et</strong> appliquant une relaxation lagrangienne<br />

Si ∃ P ∈ S + n telle que :<br />

⎡<br />

[ ]<br />

q ⋆ p ⋆ A ′ A ⎣ q p<br />

⎤ ⎡<br />

⎦ > trace ⎣P<br />

[<br />

q<br />

p<br />

]<br />

D<br />

⎡<br />

⎣ q⋆<br />

p ⋆<br />

⎤⎤<br />

⎦⎦<br />

alors µ ∗ > 0 <strong>et</strong> D ⊗ P −A ′ A≺0<br />

Par application du lemme <strong>de</strong> projection, une condition suffisante est<br />

∃ P ∈ S n |<br />

⎡<br />

⎢<br />

⎣<br />

[<br />

−<br />

1 A ′ ]<br />

D ⊗ P<br />

⎡<br />

⎣ 1 A<br />

⎤<br />

⎦ 0<br />

0 P<br />

⎤<br />

⎥<br />

⎦ ≻ 0<br />

La matrice <strong>de</strong> <strong>Lyapunov</strong> P une variable duale <strong>de</strong> Lagrange ou multiplieur <strong>de</strong> Lagrange<br />

<strong>Théorie</strong> <strong>de</strong> <strong>Lyapunov</strong>, comman<strong>de</strong> <strong>robuste</strong> <strong>et</strong> optimisation<br />

JNMACS<br />

06/09/05

Relaxation lagrangienne <strong>et</strong> théorie <strong>de</strong> <strong>Lyapunov</strong> (IV) 18<br />

Démonstration<strong>de</strong>lanécessité (saut <strong>de</strong> dualité nul)<br />

Théorème <strong>de</strong>s alternatives pour <strong>Lyapunov</strong> généralisé [Balakrishnan 03]<br />

1- ∃ P ∈ S n<br />

A(P )=<br />

⎡<br />

⎢<br />

⎣<br />

[<br />

−<br />

1 A ′ ]<br />

D ⊗ P<br />

⎡<br />

⎣ 1 A<br />

⎤<br />

⎦ 0<br />

⎤<br />

⎥<br />

⎦ ≻ 0<br />

0 P<br />

2- ∃ (Z 1 ,Z 2 ) ∈ S + n × S + n<br />

A adj (Z 1 , Z 2 )=Z 2 − [1 A]D ⊗ Z 1 [1 A] ′ = 0<br />

Si la proposition 2 est vérifiée (équivalent àlaproposition1nonvérifiée) alors le<br />

spectre <strong>de</strong> A n’est pas entièrement contenu dans D<br />

<strong>Théorie</strong> <strong>de</strong> <strong>Lyapunov</strong>, comman<strong>de</strong> <strong>robuste</strong> <strong>et</strong> optimisation<br />

JNMACS<br />

06/09/05

Relaxation lagrangienne <strong>et</strong> théorie <strong>de</strong> <strong>Lyapunov</strong> (V) 19<br />

⎡ ⎤<br />

⎤ ⎡ ⎤<br />

Soient Q =[1 0], P =[0 1] <strong>et</strong> F (P )= ⎣ Q ⎦ ⎣ d 0P d 1 P<br />

⎦ ⎣ Q ⎦ = D ⊗ P<br />

P d ⋆ 1P d 2 P P<br />

[<br />

La forme duale trace F (P )X = trace F D (X)P avec X = xx ⋆ (x ⋆ = q ⋆ p<br />

]) ⋆<br />

′ ⎡<br />

µ ⋆ = min<br />

X≠0<br />

sous<br />

trace A ′ AX<br />

F D (X) ≽ 0<br />

X ≽ 0<br />

rank X =1<br />

La relaxation <strong>de</strong> rang est duale <strong>de</strong> la relaxation lagrangienne<br />

<strong>Théorie</strong> <strong>de</strong> <strong>Lyapunov</strong>, comman<strong>de</strong> <strong>robuste</strong> <strong>et</strong> optimisation<br />

JNMACS<br />

06/09/05

Relaxation lagrangienne : le lemme <strong>de</strong> Finsler 20<br />

Soient H ∈ C n×m | rang(H) =r

Condition <strong>de</strong> stabilité étendue 21<br />

Théorème 4<br />

A est D-stable ssi ∃ P ∈ S n , F ∈ R n×n <strong>et</strong> G ∈ R n×n t.q.<br />

⎡<br />

⎢<br />

⎣<br />

D ⊗ P +<br />

⎡<br />

⎣ A′<br />

−1<br />

⎤<br />

⎦ [ F<br />

G<br />

]<br />

+<br />

⎡<br />

⎣ F ′<br />

G ′<br />

⎤<br />

⎦ [ A<br />

−1<br />

0 −P<br />

]<br />

0<br />

⎤<br />

⎥<br />

⎦ ≺ 0<br />

Nota ⎡:<br />

⎤<br />

P <strong>et</strong><br />

⎣ F G<br />

⎦ sont <strong>de</strong>s variables issues <strong>de</strong> relaxations Lagrangiennes successives!<br />

<strong>Théorie</strong> <strong>de</strong> <strong>Lyapunov</strong>, comman<strong>de</strong> <strong>robuste</strong> <strong>et</strong> optimisation<br />

JNMACS<br />

06/09/05

Condition <strong>de</strong> stabilité étendue : interprétation 22<br />

Théorème 5 ([Ebihara 05])<br />

A est D-stable ssi A 1 (s) =s1 − A est D-stable ssi ∃ F(s) multiplieur polynômial t.q.<br />

A ⋆ 1(s)F(s) + F ⋆ (s)A 1 (s) ≻ 0<br />

∀ s ∈ D C<br />

- Multiplieur polynômial d’ordre 1 : F(s) = F s + G<br />

- Multiplieur d’ordre supérieur :<br />

⎡<br />

F(s) = ⎣ s1 1<br />

⎤<br />

⎦<br />

⎡<br />

⎤<br />

⎣ H 11 F 11 G 11<br />

⎦ ⎢<br />

⎣<br />

H 10 F 10 G 10<br />

⋆ ⎡<br />

s 2 1<br />

s1<br />

1<br />

⎤<br />

⎥<br />

⎦<br />

Condition LMI équivalente :<br />

⎡<br />

⎢<br />

⎣<br />

1 0 0<br />

0 1 0<br />

0 1 0<br />

0 0 1<br />

⎤<br />

′<br />

⎥ D ⊗ P<br />

⎦<br />

⎡<br />

⎢<br />

⎣<br />

1 0 0<br />

0 1 0<br />

0 1 0<br />

0 0 1<br />

⎤<br />

⎡<br />

⎧⎪ ⎨ ⎥<br />

⎦ + He ⎢<br />

⎣<br />

⎪ ⎩<br />

⎤<br />

−1 0<br />

A ⋆ −1 ⎥<br />

⎦<br />

0 A ⋆<br />

[<br />

H11 F 11 G 11<br />

H 10 F 10 G 10<br />

] ⎫ ⎪ ⎬<br />

⎪ ⎭<br />

≺ 0<br />

<strong>Théorie</strong> <strong>de</strong> <strong>Lyapunov</strong>, comman<strong>de</strong> <strong>robuste</strong> <strong>et</strong> optimisation<br />

JNMACS<br />

06/09/05

Réduction du pessimisme <strong>de</strong>s relaxations 23<br />

Théorème 6 ([Peaucelle 00], [Ebihara 05])<br />

A ∈ A =co{A 1 , ··· ,A N } est D-stable <strong>de</strong> manière <strong>robuste</strong> si<br />

D ⊗ P i +<br />

[<br />

A<br />

′<br />

i<br />

−1<br />

] [<br />

F G<br />

]<br />

+<br />

[<br />

F<br />

′<br />

G ′ ] [<br />

A i −1<br />

]<br />

≺ 0<br />

- Fonction <strong>de</strong> <strong>Lyapunov</strong> dépendant <strong>de</strong>s paramètres P (δ) =<br />

N∑<br />

i=1<br />

δ i P i<br />

⎡<br />

⎢<br />

⎣<br />

1 0 0<br />

0 1 0<br />

0 1 0<br />

0 0 1<br />

⎤ ′ ⎡<br />

⎥ D ⊗ P i ⎢<br />

⎦ ⎣<br />

1 0 0<br />

0 1 0<br />

0 1 0<br />

0 0 1<br />

⎤<br />

⎡<br />

⎧⎪ ⎨ ⎥<br />

⎦ + He ⎢<br />

⎣<br />

⎪ ⎩<br />

−1 0<br />

A ⋆ i<br />

−1<br />

0 A ⋆ i<br />

⎤<br />

⎥<br />

⎦<br />

[<br />

H11 F 11 G 11<br />

H 10 F 10 G 10<br />

] ⎫ ⎪ ⎬<br />

⎪ ⎭<br />

≺ 0<br />

- Fonction <strong>de</strong> <strong>Lyapunov</strong> dépendant <strong>de</strong>s paramètres P (δ) =<br />

[<br />

A(δ)<br />

1<br />

] ⋆ ( N<br />

∑<br />

i=1<br />

δ i P i<br />

)[<br />

A(δ)<br />

1<br />

]<br />

<strong>Théorie</strong> <strong>de</strong> <strong>Lyapunov</strong>, comman<strong>de</strong> <strong>robuste</strong> <strong>et</strong> optimisation<br />

JNMACS<br />

06/09/05

Quelques enjeux <strong>de</strong> l’optimisation en Automatique 24<br />

Les enjeux théoriques <strong>et</strong> numériques liés à la non convexité<br />

- Approches directes<br />

Lagrangien augmenté (pénalité [Apkarian 02], barrière [Kočvara 02])<br />

Optimisation non différentiable [Oustry 00], [Overton 03]<br />

- Approches par relaxations convexes<br />

Evaluation systématique du pessimisme <strong>de</strong>s relaxations (successives) [Nesterov 97],<br />

[Ben-Tal 00]<br />

LMI <strong>et</strong> SDP représentabilité [Ben-Tal 01], [Helton 01]<br />

Au <strong>de</strong>là <strong>de</strong> la dualité SDP <strong>et</strong> Lagrangienne [Ramana 97]<br />

Les enjeux numériques liés aux LMI <strong>de</strong> gran<strong>de</strong> taille<br />

- Conditionnement numérique <strong>de</strong>s problèmes SDP [Miller 97], [Yildrim 03]<br />

- Temps <strong>de</strong> calcul, fiabilité, exploitation <strong>de</strong> la structure [Van<strong>de</strong>nberghe 02]<br />

Démarche transversale mélant concepts <strong>et</strong> outils<br />

<strong>Théorie</strong> <strong>de</strong> <strong>Lyapunov</strong>, comman<strong>de</strong> <strong>robuste</strong> <strong>et</strong> optimisation<br />

JNMACS<br />

06/09/05