COMUNICAÇÕES 248 - VIRGÍNIA DIGNUM: IA RESPONSÁVEL PRECISA DE "REGRAS DE TRÂNSITO"

- Text

- Apdc

- Digitalbusinesscommunity

- Digital

- Artificial

- Ciberseguraunça

- Talento

- Inovação

- Território

- Experimentação

- Testbeds

- Tecnologia

a conversa “Nem eu nem

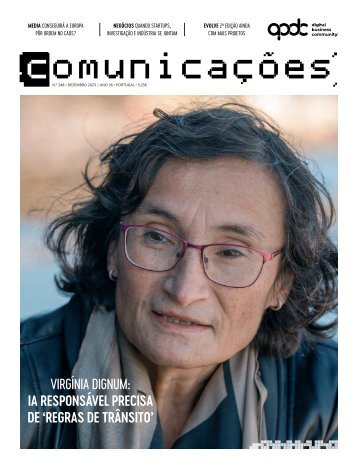

a conversa “Nem eu nem qualquer outro português que seja professor catedrático fora de Portugal pode ser integrado na academia. O António Damásio, por exemplo, se quisesse não podia” 22 Não tenho medo que os sistemas se levantem e fiquem conscientes. Tenho medo que pessoas e organizações utilizem esses sistemas para fazer mal, isso sim. É evidente que, a prazo, os computadores vão ultrapassar as capacidades humanas. Vamos deixar de ter uma relação de igual para igual. Isso não a perturba? Também não tenho uma relação de igualdade com o carro, que anda muito mais depressa do que eu. Nem com o avião, nem mesmo com o meu telefone, ou a calculadora, que faz raízes quadradas muito melhor do que eu… Neste momento já nem sequer ensinam os alunos a calcular raízes quadradas. Não é preciso. O que é preciso é ensiná-los a perceber o que é uma raiz quadrada e para que é necessário fazer esse cálculo e quando. Ao utilizar a IA, a intenção final é nossa, portanto a responsabilidade também. Se deixo o sistema tomar decisões automaticamente, como aconteceu na Holanda – em que as finanças pediram, por lapso, a muitas famílias para devolverem os subsídios que supostamente haviam recebido de modo fraudulento durante anos. Uma imprudência que teve consequências gravíssimas, como suicídios, divórcios e por fim a queda do governo. Se deixo isso acontecer a culpa não é da IA, mas das pessoas que decidiram que o sistema poderia funcionar sem supervisão. Portanto, aí é que temos de ter muita atenção e muito esforço, não só no desenvolvimento técnico, mas principalmente no desenvolvimento sociotécnico. O trabalho que estou agora a fazer com as Nações Unidas é exatamente o de criar os meios e a literacia para que as pessoas saibam como é que se usam estes sistemas. Neste momento, podemos comparar a IA com um carro que não tem travões, nem cintos de segurança e está a ser guiado por uma pessoa que não tem carta de condução e vai por uma rua abaixo que não tem sinais de trânsito. Temos que insistir com as empresas que desenvolvem estes sistemas, que têm de pôr cintos de segurança e travões, mas não nos podemos esquecer de que ao mesmo tempo, temos de investigar ou garantir que quem está a fazê-lo tem carta de condução. Também é preciso criar as regras de trânsito.

Pegando na metáfora do carro: poderá acontecer, no futuro, tudo isto evoluir para um carro de condução autónoma… Os carros de condução autónoma não começam a trabalhar sem ninguém lhes dar uma ordem para começar. Nessa altura temos de ter capacidade de garantir que os carros de condução autónoma têm carta de condução para saberem o que estão a fazer… Quem se dedica a estas áreas certamente que, em algum momento, se há-de interrogar sobre se o ser humano, em geral, tem idoneidade para lidar com tecnologias que nos podem levar a situações extremas... Sim, essa é uma questão extraordinariamente importante e devemos fazer uma reflexão contínua sobre esse assunto, mas ao mesmo tempo, também temos de ter humildade. Com as discussões que surgiram sobre a OpenAI, a ideia que eu começo a ter é que as pessoas envolvidas nisto, ao mais alto nível, começam a sentirse deuses que têm a capacidade de decidir sobre estes sistemas e sobre a Humanidade. As discussões sobre a mudança na direção da OpenAI são descritas como um problema da Humanidade, quando isto é só uma guerra entre administradores. Trata-se de manter a atenção no desenvolvimento da IA de forma exagerada. Temos de ter a humildade de pensar que isto não é bem assim… 2023 foi o ano do boom da IA. Toda a gente acordou para o potencial desta tecnologia. E, de repente, a realidade aumentada, de que tanto se falava, o cloud computing, todas essas áreas, saíram do foco. Parece que a IA secou tudo à volta. Como explica este fenómeno? Marketing, dinheiro (risos)… A grande diferença do momento em que estamos agora e o que acontecia há cerca de um ano é que qualquer pessoa no mundo tem agora a oportunidade de interagir com sistemas que, à primeira vista, reagem de uma forma quase humana. O ChatGPT, o Bard e afins, são aplicações feitas sobre aplicações de IA. Sem essas aplicações, que associaram a conversação humana à IA, a evidência de que estávamos a falar com uma máquina era muito maior. Está tudo feito de forma a aliciar-nos a trabalhar com os sistemas de IA. A questão é que isto dá muito dinheiro... Isso significa o quê? Estas aplicações que usam a linguagem são feitas para criar uma ilusão. Por um lado, têm por objetivo mostrar que é possível interagir com o sistema, da mesma maneira que interagimos uns com os outros e, assim, podemos todos beneficiar com isso. Isso é positivo. Mas também há uma forma negativa de ver a questão: eles querem-nos viciar e controlar. Porque é que o ChatGPT diz “desculpa”? A máquina não conhece o conceito, por isso não devia ter de pedir desculpa. O Google não diz desculpa quando se engana a dar uma resposta… Está tudo feito de forma a aliciar-nos a trabalhar com estes sistemas. A questão é que isto depois dá muito dinheiro… Em termos de computação, os sistemas de IA são extremamente pesados, portanto as empresas têm toda a vantagem em que haja cada vez mais sistemas de IA para venderem cada vez mais máquinas. O que é que a preocupa mais? Estamos a ficar muito dependentes. Já estávamos dependentes das redes sociais, que são de empresas em que não temos controlo democrático. Não temos capacidades democráticas de intervir nelas, porque são empresas privadas, comerciais, com fins lucrativos. Podem fazer o que quiserem. Temos de caminhar no sentido da regulação… Sim. Tem de ser uma regulação efetiva, que ao mesmo tempo permita aos reguladores, às empresas e ao cidadão comum ter voz no que está a acontecer. Não pode ser, como essas empresas querem, só uma questão de autorregulação. Também não podem ser os Estados, unilateralmente, a estabelecer as regras. Temos de caminhar para um diálogo que envolva também os cidadãos. Participou na parte inicial da conceção do AI Act. Acha que a Europa vai no bom caminho? Se me tivessem feito essa pergunta há duas semanas, dizia que sim, mas neste momento estou com imenso medo do que estas guerras podem implicar. Uma das grandes bases do AI Act é que temos de regular os riscos, independentemente da tecnologia. Se existe risco, o risco tem de ser regulado e garantido. É como com os carros: não interessa se são a diesel ou elétricos. Têm de ter travões. O AI Act estava bastante bem definido, mas há uns meses alguém resolveu modificar o texto e introduzir uma especificidade tecnológica que só tem criado confusão. Neste momento, estou preocupada com o que vai sair daqui. Entretanto, a China já tem regulação, os EUA também e a Europa está a perder a vantagem. 23

- Page 1: MEDIA CONSEGUIRÁ A EUROPA PÔR ORD

- Page 4: sumario FICHA TÉCNICA COMUNICAÇÕ

- Page 7 and 8: CURIOSIDADE IA NO FRIGORIFICO AGILI

- Page 9 and 10: Os canais mais utilizados pelos cri

- Page 11 and 12: PRINCÍPIOS-CHAVE DA IA RESPONSÁVE

- Page 13 and 14: À frente da Google Cloud Portugal

- Page 15 and 16: A INTELIGÊNCIA ARTIFICIAL É O QUE

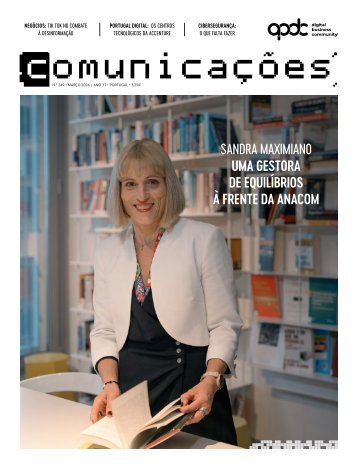

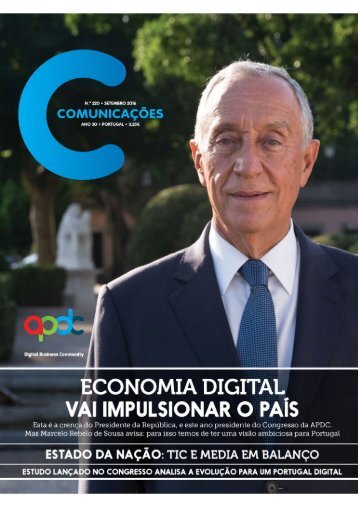

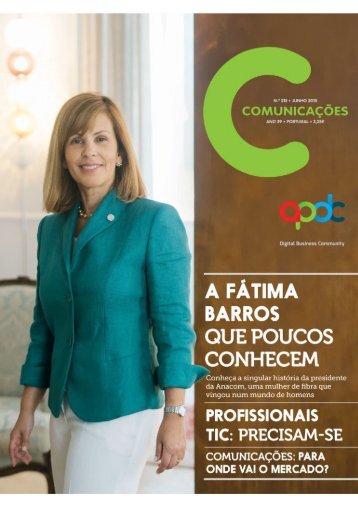

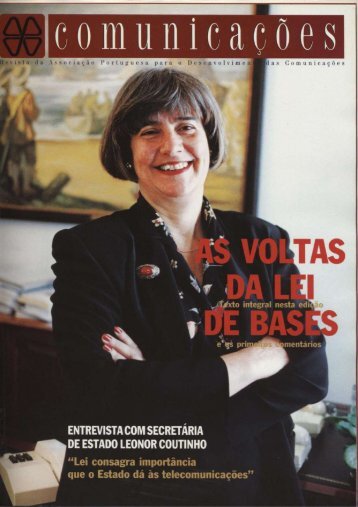

- Page 17 and 18: Quando Virgínia Dignum se interess

- Page 19 and 20: Como é que começou a interessar-s

- Page 21: “Um programa de computação não

- Page 25 and 26: As nossas melhores soluções come

- Page 27 and 28: EAN MEDIA FREEDOM ACT NSEGUIRÁ E P

- Page 29 and 30: Nuno Santos (CNN Portugal), Ricardo

- Page 31 and 32: plataformas de distribuição, são

- Page 33 and 34: 33

- Page 35 and 36: Para acelerar a transformação dig

- Page 37 and 38: Paulo Cardoso do Amaral, que voltou

- Page 39 and 40: 17 ESTUDOS DE CASO PARA ALAVANCAR I

- Page 41 and 42: tiu obter “metas de performance m

- Page 43 and 44: se processos redundantes. Pusemos a

- Page 45 and 46: tratamento de dados, numa perspetiv

- Page 47 and 48: 47

- Page 49 and 50: Paulo Dimas: “Quando as pessoas e

- Page 51 and 52: ASSEGURAR O FUTURO COM SOLUÇÕES R

- Page 54 and 55: itech 54 PEDRO FAUSTINO: Paixão co

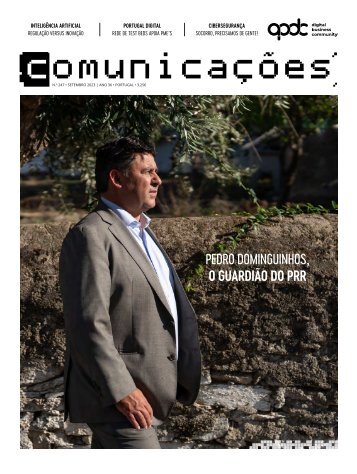

- Page 56 and 57: portugal digital 56

- Page 58 and 59: portugal digital Todos os anos a AP

- Page 60 and 61: portugal digital 60 situações em

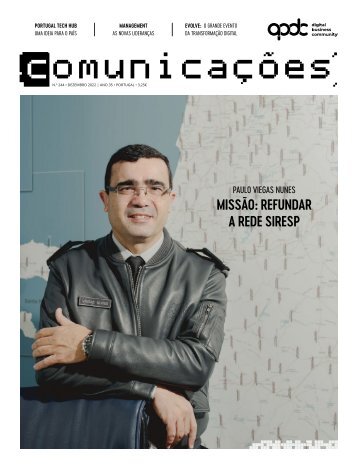

- Page 62 and 63: apdc news ACORDO APDC, GOVERNO E IN

- Page 64 and 65: apdc news “Desde a montagem do pr

- Page 66 and 67: apdc news PORTUGAL AS A TECH HUB In

- Page 68 and 69: apdc news APDC & VDA | DIGITAL UNIO

- Page 70 and 71: apdc news 70 No tema da fair contri

- Page 72 and 73:

apdc news 72 Todo o projeto está e

- Page 74:

apdc news 74 que tem por detrás um

- Page 77 and 78:

cidadania SAFEFOREST: robótica na

- Page 79 and 80:

ROBUSTECER PROJETO EDUCACIONAL INOV

- Page 82:

MANTEMOS A EUROPA CONECTADA, com um

Inappropriate

Loading...

Mail this publication

Loading...

Embed

Loading...