3. Nelinearni sistemi

3. Nelinearni sistemi

3. Nelinearni sistemi

You also want an ePaper? Increase the reach of your titles

YUMPU automatically turns print PDFs into web optimized ePapers that Google loves.

<strong>3.</strong>1 Reševanje nelinearnih sistemov<br />

Rešujemo sistem nelinearnih enačb<br />

f 1 (x 1 , x 2 , . . . , x n ) = 0<br />

f 2 (x 1 , x 2 , . . . , x n ) = 0<br />

.<br />

f n (x 1 , x 2 , . . . , x n ) = 0.<br />

Pišemo F (x) = 0, kjer je x ∈ R n in F : R n → R n .<br />

Za testni sistem bomo vzeli<br />

3x 1 − cos(x 1 x 2 ) − 0.6 = 0<br />

x 2 1 − 81(x 2 + 0.1) 2 + sin(x 3 ) + 1.1 = 0<br />

e −x 1 x 2<br />

+ 20x 3 + 9.1 = 0,<br />

ki ima rešitev α = (0.533332, 0.0054539, −0.504855).<br />

Bor Plestenjak - Numerična analiza 2004

Kako pridemo do začetnih približkov<br />

Več kot imamo enačb, težje pridemo do začetnih približkov, če ne poznamo še ozadja<br />

sistema, ki ga rešujemo.<br />

V primeru ene same enačbe f(x) = 0 lahko iz grafa določimo začetni približek.<br />

V primeru dveh enačb f 1 (x 1 , x 2 ) = 0 in f 2 (x 1 , x 2 ) = 0 iščemo presečišče dveh implicitno<br />

podanih krivulj. Uporabimo lahko metode za implicitno risanje krivulj in spet grafično<br />

določimo začetni približek. Če se da, lahko tudi iz ene enačbe izrazimo eno spremenljivko<br />

in jo vstavimo v drugo enačbo, da dobimo eno samo nelinearno enačbo.<br />

Če imamo več enačb, je situacija bolj zapletena. Nekaj možnosti:<br />

• redukcija na manjši sistem,<br />

• aproksimacija z linearnim modelom,<br />

• uporaba variacijskih metod,<br />

• metoda zveznega nadaljevanja.<br />

Bor Plestenjak - Numerična analiza 2004

<strong>3.</strong>2 Navadna oz. Jacobijeva iteracija<br />

Prva metoda je posplošitev navadne iteracije. Sistem F (x) = 0 zapišemo v ekvivalentni<br />

obliki x = G(x), kjer je G : R n → R n in tvorimo zaporedje približkov:<br />

x (r+1) = G(x (r) ), r = 0, 1, . . . .<br />

Če v našem testnem primeru iz i-te enačbe izrazimo x i , dobimo<br />

x (r+1)<br />

1<br />

= 1 3<br />

x (r+1)<br />

2<br />

= 1 9<br />

x (r+1)<br />

3<br />

= − 1<br />

20<br />

od koder lahko razberemo G(x).<br />

(<br />

cos(x (r)<br />

1 x(r)<br />

√<br />

(x (r)<br />

2 ) + 0.6 )<br />

1 )2 + sin(x (r)<br />

3<br />

) + 1.1 − 0.1<br />

(<br />

)<br />

e −x(r) 1 x(r) 2 + 9.1 ,<br />

Bor Plestenjak - Numerična analiza 2004

Jacobijeva iteracija in testni primer<br />

Če vzamemo začetni približek x (0) = (0.4, 0.1, −0.4), potem iz<br />

dobimo zaporedje<br />

x (r+1)<br />

1<br />

= 1 3<br />

x (r+1)<br />

2<br />

= 1 9<br />

x (r+1)<br />

3<br />

= − 1<br />

20<br />

(<br />

cos(x (r)<br />

1 x(r)<br />

√<br />

(x (r)<br />

2 ) + 0.6 )<br />

1 )2 + sin(x (r)<br />

3<br />

) + 1.1 − 0.1<br />

(<br />

)<br />

e −x(r) 1 x(r) 2 + 9.1 ,<br />

r<br />

3<br />

‖x (r) − x (r−1) ‖ ∞ ‖F (x (r) )‖ ∞<br />

1 0.533066702220 0.003672183829 −0.503039471957 1.3 · 10 −1 <strong>3.</strong>7 · 10 −1<br />

2 0.533332694686 0.005530371351 −0.504902219788 1.9 · 10 −3 1.3 · 10 −3<br />

3 0.533331883381 0.005451521829 −0.504852740886 7.9 · 10 −5 4.2 · 10 −5<br />

4 0.533331924436 0.005454006133 −0.504854837609 2.5 · 10 −6 1.8 · 10 −6<br />

5 0.533331923152 0.005453901274 −0.504854771543 1.0 · 10 −7 5.6 · 10 −8<br />

6 0.533331923206 0.005453904579 −0.504854774331 <strong>3.</strong>3 · 10 −9 2.4 · 10 −9<br />

7 0.533331923204 0.005453904439 −0.504854774243 1.4 · 10 −10 7.5 · 10 −11<br />

8 0.533331923204 0.005453904444 −0.504854774247 4.4 · 10 −12 <strong>3.</strong>2 · 10 −12<br />

x (r)<br />

1<br />

x (r)<br />

2<br />

x (r)<br />

Bor Plestenjak - Numerična analiza 2004

Konvergenca navadne iteracije za sisteme nelinearnih enačb<br />

Izrek 1.<br />

Če obstaja območje Ω ⊂ R n z lastnostima:<br />

a) x ∈ Ω ⇒ G(x) ∈ Ω,<br />

b) x ∈ Ω ⇒ ρ(JG(x)) ≤ m < 1, kjer je JG(x) Jacobijeva matrika<br />

⎡<br />

⎤<br />

∂g 1 (x)<br />

∂g<br />

∂x<br />

· · · 1 (x)<br />

⎢ 1 ∂xn<br />

⎥<br />

JG(x) = ⎣ .<br />

. ⎦<br />

∂gn(x)<br />

∂x<br />

· · ·<br />

1<br />

∂gn(x)<br />

∂xn<br />

in ρ spektralni radij (največja absolutna vrednost lastne vrednosti),<br />

potem ima G(x) = x v Ω natanko eno rešitev α, zaporedje x (r+1) = G(x (r) ),<br />

r = 0, 1, . . . , pa za vsak x (0) ∈ Ω konvergira k α.<br />

Red konvergence je odvisen od Jacobijeve matrike. V primeru JG(α) = 0 dobimo<br />

vsaj kvadratično konvergenco, ta pogoj pa je izpolnjen npr. pri Newtonovi metodi, ki je<br />

posplošitev tangentne metode.<br />

Bor Plestenjak - Numerična analiza 2004

Zadostni pogoj in ocena za napako<br />

Izrek 2.<br />

Če obstaja območje Ω ⊂ R n z lastnostima:<br />

a) x ∈ Ω ⇒ G(x) ∈ Ω,<br />

b) ‖JG(x)‖ ∞ ≤ m < 1 kar je ekvivalentno<br />

∣ n∑<br />

∂g j (x) ∣∣∣<br />

∣ ≤ m < 1, j = 1, . . . , n,<br />

∂x k<br />

k=1<br />

potem ima G(x) = x v Ω natanko eno rešitev α, zaporedje x (r+1) = G(x (r) ),<br />

r = 0, 1, . . . , za vsak x (0) ∈ Ω konvergira k α in velja ocena<br />

‖x (r) − α‖ ∞ ≤<br />

mr<br />

1 − m ‖x(1) − x (0) ‖ ∞ .<br />

Bor Plestenjak - Numerična analiza 2004

Testni primer<br />

Za testni primer imamo<br />

⎡<br />

JG(x) =<br />

⎢<br />

⎣<br />

− x 2<br />

3<br />

sin(x 1 x 2 ) − x 1<br />

3<br />

sin(x 1 x 2 ) 0<br />

x 1<br />

0<br />

9<br />

√x 2 1 +sin x 3 +1.1<br />

cos x<br />

√ 3<br />

9 x 2 1 +sin x 3 +1.1<br />

− x 2<br />

20 e−x 1 x 2 − x 1<br />

20 e−x 1 x 2 0<br />

⎤<br />

.<br />

⎥<br />

⎦<br />

Če vzamemo Ω = [−1, 1] × [−1, 1] × [−1, 1], potem za x ∈ Ω velja G(x) ∈ Ω.<br />

Če ocenimo absolutne vrednosti parcialnih odvodov G na Ω, dobimo ‖G(x)‖ ∞ ≤ m za<br />

m = 0.561.<br />

Iz ocene ‖x (8) − α‖ ∞ ≤ m8<br />

1−m ‖x(1) − x (0) ‖ ∞ sledi ‖x (8) − α‖ ∞ ≤ 2.9 · 10 −3 , kar je<br />

zelo slaba ocena.<br />

Bor Plestenjak - Numerična analiza 2004

Seidlova iteracija<br />

Če računamo komponente x (r) po vrsti, lahko izračunane komponente upoštevamo pri<br />

izračunu naslednjih:<br />

x (r+1)<br />

1<br />

= 1 3<br />

x (r+1)<br />

2<br />

= 1 9<br />

x (r+1)<br />

3<br />

= − 1<br />

20<br />

(<br />

cos(x (r)<br />

1 x(r)<br />

√<br />

(x (r+1)<br />

2 ) + 0.6 )<br />

1<br />

) 2 + sin(x (r)<br />

3<br />

) + 1.1 − 0.1<br />

(<br />

)<br />

e −x(r+1) 1<br />

x (r+1)<br />

2 + 9.1 .<br />

Temu postopku pravimo Seidlova iteracija.<br />

iteracija, obstajajo pa tudi protiprimeri.<br />

Ponavadi konvergira hitreje kot Jacobijeva<br />

Pri testnem primeru z x (0) = (0.4, 0.1, −0.4) dobimo zaporedje<br />

r<br />

3<br />

‖x (r) − x (r−1) ‖ ∞ ‖f(x (r) )‖ ∞<br />

1 0.533066702220 0.010818602012 −0.504712478046 1.3 · 10 −1 9.4 · 10 −2<br />

2 0.533327790230 0.005460936737 −0.504854588390 5.4 · 10 −3 1.2 · 10 −4<br />

3 0.533331919588 0.005453913740 −0.504854774000 7.0 · 10 −6 1.6 · 10 −7<br />

4 0.533331923200 0.005453904456 −0.504854774246 9.3 · 10 −9 2.1 · 10 −10<br />

5 0.533331923204 0.005453904443 −0.504854774247 1.2 · 10 −11 2.9 · 10 −13<br />

x (r)<br />

1<br />

x (r)<br />

2<br />

x (r)<br />

Bor Plestenjak - Numerična analiza 2004

<strong>3.</strong>3 Newtonova metoda<br />

Izpeljava Newtonove metode poteka preko Taylorjeve vrste. Denimo, da so vse f i dvakrat<br />

zvezno odvedljive v okolici rešitve. Tedaj lahko razvijemo:<br />

f i (x + ∆x) = f i (x) +<br />

n∑<br />

k=1<br />

∂f i (x)<br />

∂x k<br />

∆x k + · · · , i = 1, . . . , n.<br />

Če zanemarimo kvadratne in višje člene in želimo, da bo f(x + ∆x) = 0, dobimo linearni<br />

sistem za popravke<br />

⎡<br />

⎤<br />

⎢<br />

⎣<br />

∂f 1 (x)<br />

∂x<br />

· · ·<br />

1<br />

.<br />

∂fn(x)<br />

∂x<br />

· · ·<br />

1<br />

∂f 1 (x)<br />

∂xn<br />

.<br />

∂fn(x)<br />

∂xn<br />

⎥<br />

⎦<br />

⎡<br />

⎣<br />

⎤ ⎡<br />

∆x 1<br />

. ⎦ = − ⎣<br />

∆x n<br />

⎤<br />

f 1 (x)<br />

. ⎦ ,<br />

f n (x)<br />

nato pa popravimo približke v<br />

x k + ∆x k , k = 1, . . . , n.<br />

Bor Plestenjak - Numerična analiza 2004

Newtonova metoda<br />

Pri Newtonovi metodi tvorimo zaporedje<br />

x (r+1) = x (r) − JF (x (r) ) −1 F (x (r) ), r = 0, 1, . . . .<br />

V praksi ne računamo inverza Jacobijeve matrike, temveč rešujemo sistem:<br />

JF (x (r) )∆x (r) = −F (x (r) ),<br />

x (r+1) = x (r) + ∆x (r) , r = 0, 1, . . . .<br />

Tako kot pri tangentni metodi imamo tudi tukaj v bližini enostavne ničle zagotovljeno<br />

kvadratično konvergenco, težava pa je v tem, da moramo za konvergenco ponavadi poznati<br />

dovolj dober začetni približek.<br />

Bor Plestenjak - Numerična analiza 2004

Newtonova metoda in testni primer<br />

Za testni primer velja<br />

JF (x) =<br />

⎡<br />

⎤<br />

3 + x 2 sin(x 1 x 2 ) x 1 sin(x 1 x 2 ) 0<br />

⎢<br />

⎣ 2x 1 −162(x 2 + 0.1) cos(x 3 ) ⎥<br />

⎦ .<br />

− x 2 e −x 1 x 2 −x 1 e −x 1 x 2 20<br />

Če vzamemo začetni približek x (0) = (0.4, 0.1, −0.4), potem Newtonova metoda vrne<br />

r<br />

3<br />

‖x (r) − x (r−1) ‖ ∞ ‖f(x (r) )‖ ∞<br />

1 0.533277157343 0.027209850424 −0.503797935671 1.8 · 10 −1 4.1 · 10 −1<br />

2 0.533349540310 0.007317424279 −0.504802389730 2.0 · 10 −2 <strong>3.</strong>2 · 10 −2<br />

3 0.533332076670 0.005470116245 −0.504854320569 1.8 · 10 −3 2.8 · 10 −4<br />

4 0.533331923216 0.005453905692 −0.504854774212 1.6 · 10 −5 2.1 · 10 −8<br />

5 0.533331923204 0.005453904443 −0.504854774247 1.2 · 10 −9 1.8 · 10 −15<br />

6 0.533331923204 0.005453904443 −0.504854774247 1.2 · 10 −16 2.2 · 10 −16<br />

x (r)<br />

1<br />

x (r)<br />

2<br />

x (r)<br />

Bor Plestenjak - Numerična analiza 2004

Kantorovičev izrek<br />

Izrek <strong>3.</strong><br />

Denimo, da obstajajo taka števila a, b, c, da je h = abc < 1 2<br />

in da velja:<br />

a) F je v x (0) odvedljiva in ‖JF −1 (x (0) )‖ ∞ ≤ a,<br />

b) b = ‖x (1) − x (0) ‖ ∞ ,<br />

c) v okolici K ∞ (x (0) , 2b) = {x : ‖x − x (0) ‖ ∞ ≤ 2b} so funkcije f i dvakrat zvezno<br />

odvedljive in velja<br />

∣<br />

n∑<br />

∂ 2 f i (x) ∣∣∣∣ ≤ c , i, j = 1, . . . , n.<br />

∣∂x j ∂x k n<br />

k=1<br />

Potem ima sistem F (x) = 0 v K ∞ (x (0) , 2b) natanko eno rešitev α h kateri konvergira<br />

zaporedje {x (r) } in velja ocena<br />

‖x (r) − α‖ ∞ ≤ (2h)2r −1<br />

2 r−1 .<br />

Bor Plestenjak - Numerična analiza 2004

Zgled uporabe Kantorovičevega izreka<br />

Za naš testni primer velja<br />

f 1x1 x 1<br />

(x) = x 2 2 cos(x 1x 2 ) f 1x1 x 2<br />

(x) = x 1 x 2 cos(x 1 x 2 ) f 1x1 x 3<br />

(x) = 0<br />

f 1x2 x 2<br />

(x) = x 2 1 cos(x 1x 2 ) f 1x2 x 3<br />

(x) = 0 f 1x3 x 3<br />

(x) = 0<br />

f 2x1 x 1<br />

(x) = 2 f 2x1 x 2<br />

(x) = 0 f 2x1 x 3<br />

(x) = 0<br />

f 2x2 x 2<br />

(x) = −162 f 2x2 x 3<br />

(x) = 0 f 2x3 x 3<br />

(x) = − sin x 3<br />

f 3x1 x 1<br />

(x) = x 2 2 e−x 1 x 2 f 3x1 x 2<br />

(x) = x 1 x 2 e −x 1 x 2 f 3x1 x 3<br />

(x) = 0<br />

f 3x2 x 2<br />

(x) = x 2 1 e−x 1 x 2 f 3x2 x 3<br />

(x) = 0 f 3x3 x 3<br />

(x) = 0.<br />

Vzamemo lahko c = 486. Za a dobimo 0.3<strong>3.</strong> Če začnemo pri x(0) , izreka še ne moremo<br />

uporabiti, saj je potem h = 28.9. Če pa začnemo pri x (2) , dobimo h = 0.16. Po izreku<br />

potem dobimo oceno ‖x (5) − α‖ ∞ ≤ 7.7 · 10 −5 .<br />

Bor Plestenjak - Numerična analiza 2004

Kvazi–Newtonove metode<br />

Posebno pri velikih n imamo pri Newtonovi metodi veliko dela. Če je Jacobijeva matrika<br />

polna, potem moramo v vsakem koraku najprej izračunati n 2 parcialnih odvodov, potem pa<br />

še rešiti sistem z matriko n × n, za kar potrebujemo O(n 3 ) operacij.<br />

Zaradi tega in pa tudi ker ne poznamo nujno parcialnih odvodov, bi radi tudi tukaj žrtvovali<br />

nekaj konvergence za računanje brez parcialnih odvodov, podobno kot pri sekantni metodi.<br />

V ta namen obstaja mnogo kvazi–Newtonovih metod, ki ne uporabljajo parcialnih odvodov.<br />

Najbolj znana je Broydenova metoda.<br />

Kadar imamo velik n in je Jacobijeva matrika razpršena, potem se za reševanje linearnega<br />

sistema s to matriko ne splača uporabljati direktnih metod. Uporabljamo iterativne metode,<br />

kar pomeni, da v vsakem koraku namesto točnega popravka izračunamo le približek za<br />

popravek. Tovrstne metode so t.i. netočne Newtonove metode, primer je kombinacija<br />

Newtonove metode in metode GMRES.<br />

Bor Plestenjak - Numerična analiza 2004

Broydenova metoda<br />

Naj bo B r približek za JF (x (r) ). En korak kvazi–Newtonove metode je<br />

a) reši B r ∆x (r) = −F (x (r) ),<br />

b) x (r+1) = x (r) + ∆x (r) ,<br />

c) določi B r+1 za naslednji korak.<br />

Pri Broydenovi metodi za B r+1 vzamemo najbližjo matriko B r , ki zadošča t.i. sekantnemu<br />

pogoju<br />

B r+1 (x (r+1) − x (r) ) = F (x (r+1) ) − F (x (r) ).<br />

Rešitev je<br />

B r+1 = B r + F (x(r) )(∆x (r) ) T<br />

(∆x (r) ) T ∆x (r) .<br />

Na začetku za B 0 vzamemo čim boljšo aproksimacijo za JF (x (0) ), v najslabšem primeru<br />

pa kar I. Število operacij lahko zmanjšamo, če namesto direktnega posodabljanja B r<br />

posodobimo faktorizacijo, ki jo uporabljamo za reševanje sistema v točki a).<br />

Bor Plestenjak - Numerična analiza 2004

<strong>3.</strong>4 Variacijske metode<br />

Iščemo ekstrem funkcije F : R n − R n , kjer je F dvakrat zvezno odvedljiva na vse spremenljivke.<br />

Potreben pogoj za ekstrem je<br />

gradF (x) = 0<br />

oziroma<br />

∂F (x)<br />

∂x k<br />

= 0 za k = 1, . . . , n.<br />

Če je x stacionarna točka, potem o vrsti in obstoju ekstrema odloča Hessejeva matrika<br />

drugih odvodov<br />

⎡<br />

∂ 2 F (x)<br />

∂ ∂x<br />

HF (x) = ⎢<br />

2 · · ·<br />

2 ⎤<br />

F (x)<br />

∂x<br />

1<br />

1 ∂xn<br />

⎥<br />

⎣ .<br />

. ⎦ .<br />

∂ 2 F (x)<br />

∂x 1 ∂xn<br />

· · ·<br />

∂ 2 F (x)<br />

Iskanje ekstrema funkcij več spremenljivk lahko tako prevedemo na reševanje sistema<br />

nelinearnih enačb. Gre pa tudi obratno.<br />

Bor Plestenjak - Numerična analiza 2004<br />

∂x 2 n

Prevedba reševanja nelinearnega sistema na iskanje minimuma<br />

Iščemo rešitev sistema F (x) = 0, kjer je F : R n → R n . Funkcija<br />

G(x) =<br />

n∑<br />

f 2 i (x)<br />

i=1<br />

ima globalni minimum ravno v točkah, kjer je F (x) = 0, zato lahko ničlo F poiščemo<br />

tako, da poiščemo globalni minimum G.<br />

Bor Plestenjak - Numerična analiza 2004

Metode za iskanje minimuma gladke funkcije n spremenljivk<br />

Splošni nastavek je, da se iterativno monotono približujemo minimumu. Naj bo x (r) tekoči<br />

približek. Izberemo vektor (smer) v r ∈ R n in v tej smeri poiščemo naslednji približek<br />

tako da bo G(x (r+1) ) < G(x (r) ).<br />

x (r+1) = x (r) + λ r v r ,<br />

Pogledati moramo:<br />

• kako izberemo smer v r ,<br />

• kako določimo λ.<br />

Bor Plestenjak - Numerična analiza 2004

Izbira smeri<br />

Za izbiro smeri imamo med drugim naslednje možnosti:<br />

a) splošna metoda spusta: izberemo poljubno smer v r , le da ni pravokotna na<br />

gradG(x (r) ), saj v tej smeri ne moremo vedno dobiti manjše vrednosti.<br />

b) metoda najhitrejšega spusta oz. gradientna metoda: za smer izberemo negativni<br />

gradient v r = −gradG(x (r) ). Pri tem pristopu moramo poznati parcialne odvode<br />

funkcije G.<br />

c) metoda koordinatnega spusta: za smeri po vrsti ciklično izbiramo koordinatne smeri<br />

e 1 , e 2 , . . . , e n .<br />

Bor Plestenjak - Numerična analiza 2004

Določanje premika<br />

Pri določanju λ r imamo opravka s funkcijo ene spremenljivke<br />

g r (λ): = G(x (r) + λv r ).<br />

Iščemo tak λ r , da bo g r (λ r ) < g r (0). Nekaj metod je:<br />

a) metoda največjega spusta: poiščemo λ r , kjer funkcija g r doseže svoj minimum. Za to<br />

rešimo nelinearno enačbo g ′ r (λ r) = 0 ali pa uporabimo kakšno metodo za računanje<br />

minimuma funkcije ene spremenljivke, npr. metodo zlatega reza.<br />

b) metoda tangentnega spusta: za λ r vzamemo presečišče tangente na y = g r (λ) v točki<br />

λ = 0 z osjo x, oziroma λ r = −g r (0)/g ′ r (0). Če je g(λ r) ≥ g(0), potem λ r toliko<br />

časa razpolavljamo, dokler ne dobimo manjše vrednosti.<br />

Bor Plestenjak - Numerična analiza 2004

c) metoda paraboličnega spusta: najprej s tangentno metodo določimo α, potem pa skozi<br />

točke (0, g r (0)), (α/2, g(α/2)), (α, g(α)) potegnemo parabolo in za λ r vzamemo<br />

točko, kjer parabola doseže minimum.<br />

d) metoda diskretnega spusta: Izberemo h r . Če je g(h r ) < g(0), potem se premikamo<br />

naprej s korakom h r in za λ r vzamemo kh r , kjer je prvič g((k + 1)h r ) ≥ g(kh r ).<br />

Sicer pa h r razpolavljamo toliko časa, da je g(h r ) < g(0) in za λ r vzamemo h r .<br />

Bor Plestenjak - Numerična analiza 2004

Konvergenca<br />

Če iščemo minimum nenegativne funkcije, kar delamo, ko uporabimo variacijsko metodo<br />

za reševanje nelienarnega sistema, imamo zagotovljeno konvergenco ne glede na začetni<br />

približek, saj dobimo zaporedje približkov {x (r) }, za katere velja G(x (r+1) ) < G(x (r) ).<br />

Kar se tiče reda konvergence, je ta ponavadi linearen.<br />

Tako vedno dobimo nek lokalni minimum, nič pa nam ne zagotavlja, da bomo našli tudi<br />

globalni minimum.<br />

Ponavadi uporabimo kombinacijo variacijske metode in Newtonove metode ali kvazi–<br />

Newtonove metode. Variacijska metoda nas ne glede na kvaliteto začetnega približka<br />

pripelje v bližino rešitve, potem pa uporabimo hitrejšo metodo, ki potrebuje dobre začetne<br />

približke.<br />

Bor Plestenjak - Numerična analiza 2004

Uporabne formule<br />

Če rešujemo nelinearni sistem F (x) = 0, kjer je F : R n → R n , potem za<br />

G(x) = f 1 (x) 2 + · · · + f n (x) 2 velja<br />

Za gradient velja<br />

gradG(x) = 2<br />

⎡<br />

⎢<br />

⎣<br />

G(x) = F (x) T F (x).<br />

f 1 (x)f 1x1 (x) + f 2 (x)f 2x1 (x) + · · · + f n (x)f nx1 (x)<br />

f 1 (x)f 1x2 (x) + f 2 (x)f 2x2 (x) + · · · + f n (x)f nx2 (x)<br />

.<br />

f 1 (x)f 1x n(x) + f 2 (x)f 2x n(x) + · · · + f n (x)f nx n(x)<br />

⎤<br />

⎥<br />

⎦<br />

oziroma enostavneje<br />

gradG(x) = JF (x) T F (x).<br />

Če definiramo g(λ) = G(x + λz), potem dobimo<br />

g ′ (0) = 2F (x) T JF (x)z.<br />

Bor Plestenjak - Numerična analiza 2004

Testni primer in gradientna metoda<br />

Reševanje testnega primera lahko prevedemo na iskanje minimuma funkcije<br />

G(x) = f 1 (x) 2 + f 2 (x) 2 + f 3 (x) 2 ,<br />

kjer so<br />

f 1 (x) = 3x 1 − cos(x 1 x 2 ) − 0.6<br />

f 2 (x) = x 2 1 − 81(x 2 + 0.1) 2 + sin(x 3 ) + 1.1<br />

f 3 (x) = e −x 1 x 2<br />

+ 20x 3 + 9.1.<br />

Če vzamemo začetni približek x (0) = (0, 0, 0) potem po 20 korakih dobimo x (20) =<br />

(0.65079172132, −0.21305107190, −0.511385522215).<br />

Če to uporabimo za začetni približek za Newtonovo metodo, potem po 5 korakih dobimo<br />

rešitev α = (0.531357185580, −0.205028183876, −0.510754950476).<br />

Če bi namesto Newtonove metode še naprej uporabljali gradientno metodo, bi za enako<br />

natančnost potrebovali še 104 korake gradientne metode.<br />

Bor Plestenjak - Numerična analiza 2004

<strong>3.</strong>5 Reševanje nelinearnih enačb v Matlabu<br />

V standardni verziji so na voljo naslednje funkcije:<br />

• fminsearch: iskanje minimuma realne funkcije iz R n v R. Uporablja simpleksni<br />

algoritem.<br />

• fminbnd: iskanje minimuma funkcije ene spremenljivke. Uporablja kombinacijo metode<br />

zlatega reza in parabolične interpolacije.<br />

Če ga imamo, potem je v dodatnem paketu za optimizacijo na voljo še:<br />

• fsolve: reševanje sistema F (x) = 0 preko iskanja minimuma ‖F (x)‖ 2 .<br />

Primeri uporabe:<br />

• f=inline(’x(1)^2+x(2)^2’); fminsearch(f,[0.3;0.2])<br />

• f=inline(’(x(1)^2+x(2)^2-10*x(1)-1)^2+(x(1)^2-x(2)^2+10*x(2)-25)^2’);<br />

fminsearch(f,[2;4])<br />

Bor Plestenjak - Numerična analiza 2004

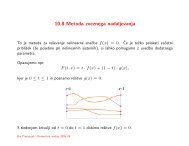

<strong>3.</strong>6 Metoda zveznega nadaljevanja<br />

To je metoda za reševanje nelinearne enačbe f(x) = 0. Če je težko poiskati začetni<br />

približek (še posebno pri nelinearnih <strong>sistemi</strong>h), si lahko pomagamo z uvedbo dodatnega<br />

parametra.<br />

Opazujemo npr.<br />

F (t, x) = t · f(x) + (1 − t) · g(x),<br />

kjer je 0 ≤ t ≤ 1 in poznamo rešitve g(x) = 0.<br />

S sledenjem krivulji od t = 0 do t = 1 dobimo rešitve f(x) = 0.<br />

Bor Plestenjak - Numerična analiza 2004

Metoda zveznega nadaljevanja in diferencialne enačbe<br />

Povezava z diferencialnimi enačbami je naslednja. Z odvajanjem po t dobimo<br />

kar nam da začetni problem<br />

kjer je g(x 0 ) = 0.<br />

F t (t, x) + F x (t, x) · ẋ = 0,<br />

ẋ = −F x (t, x) −1 · F t (t, x), x(0) = x 0 ,<br />

Z metodami za reševanje začetnih problemov lahko sledimo rešitvi, poleg tega pa pri vsaki<br />

vrednosti t lahko upoštevamo še, da mora za x(t) veljati F (t, x(t)) = 0.<br />

Bor Plestenjak - Numerična analiza 2004

Prediktor-korektor sledenje homotopske krivulje<br />

a) prediktor: Iz točke (t, x(t)) z eno izmed metod za reševanje začetnega problema (npr.<br />

z Eulerjevo metodo) izračunamo prediktor x (P ) (t + h), ki je približek za rešitev v točki<br />

t + h.<br />

b) korektor: Z eno izmed metod za reševanje nelinearnega sistema (npr. z Newtonovo<br />

metodo) rešimo sistem F (t + h, x(t + h)) = 0, za začetni približek pa vzamemo<br />

(t + h, x (P ) (t + h)).<br />

Bor Plestenjak - Numerična analiza 2004