Serie Storiche e Processi Stocastici

Serie Storiche e Processi Stocastici

Serie Storiche e Processi Stocastici

Create successful ePaper yourself

Turn your PDF publications into a flip-book with our unique Google optimized e-Paper software.

Introduzione<br />

<strong>Serie</strong> <strong>Storiche</strong> e <strong>Processi</strong> <strong>Stocastici</strong> – Federico Andreis<br />

Desiderando introdurre intuitivamente il concetto di serie storica basta fare riferimento a<br />

qualsiasi fenomeno misurabile che varia nel tempo e la cui registrazione costituisce, appunto, la<br />

serie storica. Tale successione di dati rappresenta una informazione statistica sulla quale potremmo<br />

avere interesse, oltre che nel descrivere, anche nell‟inferire (ovvero all‟applicare gli strumenti<br />

propri dell‟analisi statistica con scopi di previsione).<br />

Più precisamente, per serie storica o serie temporale intendiamo una successione di<br />

osservazioni ordinate logicamente secondo una variabile t, la quale nella maggior parte dei casi<br />

rappresenta il tempo. Risulta quindi di interesse lo studio della dinamica temporale di tale serie<br />

(analisi univariata) e delle eventuali connessioni con altre serie storiche ad essa collegate (analisi<br />

multivariata). Confluiscono in questa analisi gli strumenti e i contributi della statistica, del calcolo<br />

della probabilità, dell‟econometria e dell‟analisi matematica.<br />

Per questa trattazione le nozioni richieste in questi campi sono quelle di base di normali corsi<br />

universitari di analisi matematica, statistica descrittiva e inferenziale e qualche conoscenza di<br />

calcolo delle probabilità, principalmente con riguardo alle variabili casuali.<br />

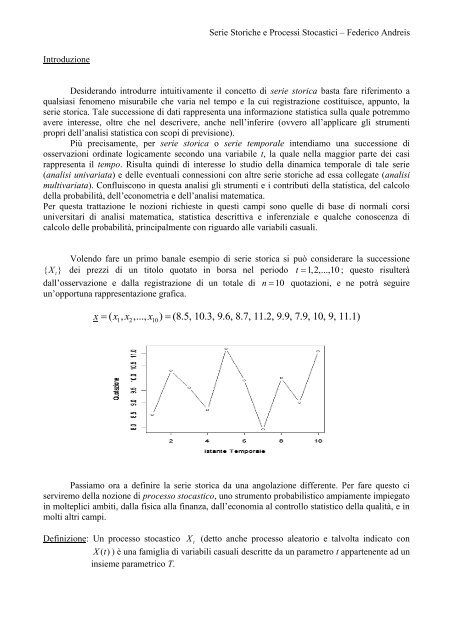

Volendo fare un primo banale esempio di serie storica si può considerare la successione<br />

{ X t}<br />

dei prezzi di un titolo quotato in borsa nel periodo t 1,2,...,10 ; questo risulterà<br />

dall‟osservazione e dalla registrazione di un totale di n 10 quotazioni, e ne potrà seguire<br />

un‟opportuna rappresentazione grafica.<br />

x ( x , x ,..., x ) (8.5, 10.3, 9.6, 8.7, 11.2, 9.9, 7.9, 10, 9, 11.1)<br />

1 2 10<br />

Passiamo ora a definire la serie storica da una angolazione differente. Per fare questo ci<br />

serviremo della nozione di processo stocastico, uno strumento probabilistico ampiamente impiegato<br />

in molteplici ambiti, dalla fisica alla finanza, dall‟economia al controllo statistico della qualità, e in<br />

molti altri campi.<br />

Definizione: Un processo stocastico X t (detto anche processo aleatorio e talvolta indicato con<br />

Xt () ) è una famiglia di variabili casuali descritte da un parametro t appartenente ad un<br />

insieme parametrico T.

<strong>Serie</strong> <strong>Storiche</strong> e <strong>Processi</strong> <strong>Stocastici</strong> – Federico Andreis<br />

Cosa significa tutto questo? Significa che un processo stocastico è una successione di<br />

variabili aleatorie ordinate secondo un parametro t T , solitamente identificato con il tempo. La<br />

conoscenza di un processo stocastico equivale alla conoscenza della distribuzione di probabilità<br />

multipla (multivariata) per qualsiasi sottoinsieme di T e per qualsiasi valore delle variabili casuali.<br />

Occorre caratterizzare però ulteriormente questa nozione di processo stocastico; per fare<br />

questo introduciamo delle distinzioni. Parleremo di processo stocastico continuo qualora le variabili<br />

casuali che lo compongono siano di natura continua, di processo stocastico discreto in caso<br />

contrario; distingueremo inoltre fra processi stocastici a tempo continuo e a tempo discreto, nei casi,<br />

rispettivamente, che il parametro t T abbia supporto continuo o discreto.<br />

Esempio: sia X t un processo stocastico che descrive le rilevazioni negli istanti temporali<br />

tT {1,2,3,...} di una qualche grandezza fisica e le cui realizzazioni siano<br />

caratterizzate da leggi di distribuzione gaussiane. Allora il processo in esame sarà da<br />

definirsi come processo stocastico continuo a tempo discreto.<br />

Un tale processo è quindi la famiglia di variabili casuali { X1, X 2,...}<br />

, per la cui conoscenza<br />

occorre specificare le funzioni di densità congiunte di ciascuna combinazione di esse. Formalmente<br />

un processo t X è noto se è nota la funzione di densità ( Xt , X ,..., )<br />

1 t X 2 t per ogni k e per ogni k-pla<br />

k<br />

di valori ( t1, t2,..., t k ) di variabili casuali (d‟ora in poi v.c.). Da questo si può già intuire l‟estrema<br />

complicazione dello studio di un processo stocastico nella sua generalità, e in particolare la pratica<br />

impossibilità di inferire direttamente su di esso.<br />

Volendo descrivere meglio la struttura probabilistica di X t possiamo osservare che, per<br />

esempio, fissando t 3,<br />

si ottiene la v.c. X 3 , che possiede una sua propria funzione di densità di<br />

probabilità (nel caso continuo, di massa di probabilità nel caso discreto) che sarà correlata oppure<br />

no alle altre, e così via. Su X 3 possiamo effettuare un esperimento e rilevare dei valori appartenenti<br />

al suo campo di variazione.<br />

Estendendo a tutto il processo, se fissiamo una prova da effettuare su X t (ovvero<br />

osserviamo la successione dei risultati campionari x1, x 2,...<br />

) otterremo una successione di valori,<br />

funzione della variabile t, chiamata realizzazione o traiettoria del processo. Risulta evidente che,<br />

dato un processo X t , esistono infinite possibili realizzazioni che sono precisamente tutte quelle<br />

osservabili ripetendo indefinitamente l‟esperimento. Segue un esempio grafico di due realizzazioni<br />

campionarie dal medesimo processo.

<strong>Serie</strong> <strong>Storiche</strong> e <strong>Processi</strong> <strong>Stocastici</strong> – Federico Andreis<br />

Infine, se in X t fissiamo t e contemporaneamente fissiamo la prova sperimentale (per<br />

esempio fissiamo t 3 ed osserviamo il valore risultante per X 3 ) otteniamo, ovviamente, un<br />

numero reale: cioè il valore realizzato per la v.c. fissata, ovvero il valore della realizzazione al<br />

tempo t fissato.<br />

Possiamo quindi introdurre a questo punto l‟intendimento di serie storica { x , t 1,2,..., N}<br />

come una parte finita di una realizzazione di un processo stocastico X t .<br />

Tale definizione concorda con quella fornita nell‟introduzione di serie storica come<br />

“successione di osservazioni ordinate logicamente secondo una variabile t” e qualifica inoltre in<br />

senso probabilistico la natura dei problemi che ci proponiamo di affrontare. Per esempio la<br />

previsione di un valore del fenomeno in esame al tempo t N 1 note che siano le osservazioni<br />

fino a t N diventa uno specifico problema di Calcolo delle Probabilità. Cioè: qual è la probabilità<br />

X assuma un determinato valore (e qui entra, ad esempio, la teoria dei test statistici)<br />

che la v.c. N 1<br />

se su tale variabile si hanno informazioni derivate dall‟insieme di v.c. ( X1, X 2,...,<br />

X N ) che hanno<br />

generato la realizzazione finita ( x1, x2,..., x N ) .<br />

Si noti d‟altro canto che una simile definizione mette in luce anche la limitazione delle<br />

informazioni sul processo le quali sono, in generale, desumibili dalla conoscenza della serie storica.<br />

Difatti essa non è altro che una parte finita di una singola realizzazione del processo; ci troviamo<br />

quindi a lavorare non solo con un campione unico della famiglia delle v.c. che caratterizzano il<br />

processo, ma si tratta anche di un campione troncato, poiché si osserva solo per t 1,2,..., N.<br />

Tutto<br />

questo impone quindi una limitazione della classe dei processi stocastici, perché solo per una parte<br />

più ristretta di essi sarà possibile dedurre informazioni “consistenti” dalle realizzazioni finite di cui<br />

disponiamo nelle applicazioni reali.<br />

Passiamo ora ad analizzare in modo più formale i processi stocastici e le loro<br />

caratterizzazioni fondamentali.<br />

t

<strong>Processi</strong> <strong>Stocastici</strong><br />

<strong>Serie</strong> <strong>Storiche</strong> e <strong>Processi</strong> <strong>Stocastici</strong> – Federico Andreis<br />

Rifacendoci alla definizione presentata nell‟introduzione di processo stocastico, andiamo a<br />

fornirne ora una sorta di classificazione, sulla base delle v.c. componenti un processo e dei loro<br />

legami.<br />

Una prima distinzione può essere fatta con riguardo all‟indipendenza o meno delle v.c.<br />

componenti il processo. Tale stato difficilmente si riscontra nella realtà, l‟unico processo a<br />

componenti incorrelate che tratteremo sarà il processo definito White Noise (rumore bianco) di<br />

valor medio nullo e varianza costante (cioè non dipendente da t). In seguito verrà indicato con<br />

A t e siglato con<br />

2<br />

t (0, A)<br />

2<br />

A<br />

A WN . Un processo stocastico WN è quindi caratterizzato come segue:<br />

EA ( ) 0<br />

t<br />

E( A ) Var( A ) <br />

2 2<br />

t t A<br />

0<br />

t s<br />

Cov( At , As ) E( At , As<br />

) 2<br />

<br />

A t s<br />

Non vengono fatte a priori ipotesi sulla distribuzione di A1, A 2,...<br />

, ma qualora si supponga<br />

che, per ogni t, A t sia anche una v.c. Normale, allora si parla di Processo White Noise Gaussiano.<br />

Poiché l‟incorrelazione di v.c. Normali implica l‟indipendenza, un processo WN Gaussiano è a<br />

componenti indipendenti.<br />

Una seconda distinzione riguarda la legge di probabilità delle v.c. componenti. Possiamo<br />

infatti ipotizzare una prefissata funzione di densità (nel caso continuo) per tali variabili e definire di<br />

conseguenza il processo risultante (un risultato teorico noto come Teorema di Kolmogorov ci<br />

garantisce che, per ogni n intero, note che siano le densità di probabilità n-variate<br />

f ( x , x ,..., x ; t , t ,..., t ) , il processo stocastico è completamente caratterizzato). L‟ipotesi più<br />

1 2 n 1 2 n<br />

comune è quella di suppore che le v.c. ( Xt , X ,..., )<br />

1 t X 2 t costituiscano una variabile aleatoria<br />

k<br />

Multinormale per ogni ( t1, t2,..., t k ) e per ogni k 1.<br />

In tal caso il processo stocastico X t si<br />

definisce processo Gaussiano e possiede funzione di densità multivariata<br />

<br />

f ( x , x ,..., x ) (2 ) exp ( x ) ( x ) <br />

1 2<br />

k<br />

2<br />

<br />

N 1 1<br />

2<br />

<br />

2 1<br />

x t t t t t<br />

dove ( EX ( )) è il vettore dei valori medi e [ Cov( X , X )] la matrice delle varianze e<br />

t ti<br />

ti tj<br />

covarianze del processo.<br />

E‟ interessante soffermarsi sul fatto che un processo Gaussiano è caratterizzato solo da t e<br />

e quindi, per esempio, un processo Gaussiano di valore medio 0 per ogni t è caratterizzato<br />

esclusivamente dalla matrice delle varianze e covarianze delle v.c. X , X componenti il<br />

ti tj<br />

processo. Questa osservazione è di particolare rilievo perché ci dice che in una classe particolare e<br />

limitata di processi stocastici (quella Gaussiana ad esempio) la conoscenza del processo stocastico<br />

(e quindi di tutte le funzioni del processo) può essere ricondotta alla conoscenza di una particolare<br />

categoria di funzioni (quali possono essere i momenti misti ad esempio), a loro volta stimabili dalle<br />

realizzazioni finite (e quindi dalle serie storiche).<br />

Altre distinzioni possono essere fatte con riguardo al comportamento della successione di<br />

v.c. rispetto al parametro t. Si tratta dunque di andare a vedere se le variabili risultino o meno in un

<strong>Serie</strong> <strong>Storiche</strong> e <strong>Processi</strong> <strong>Stocastici</strong> – Federico Andreis<br />

qualche equilibrio dinamico rispetto al tempo, in termini di valore atteso, di varianza, di entrambi o<br />

di altre misure ancora. Se un processo stocastico X t presenta una distribuzione di equilibrio quando<br />

t , ovvero sul piano delle realizzazioni è presente una certa “omogeneità temporale” di natura<br />

stocastica, allora potremo parlare di processo stocastico stazionario.<br />

Più precisamente parleremo di processo stocastico stazionario in senso stretto o forte<br />

qualora la distribuzione multivariata delle v.c. ( Xt , X ,..., )<br />

1 t X 2 t non sia funzione di ( t k<br />

1, t2,..., t k )<br />

per ogni k 1.<br />

Formalmente:<br />

( X , X ,..., X ) ( X , X ,..., X ) ( t , t ,..., t ) e j<br />

t1 t2 tk t1 j t2 j tk j 1 2 k<br />

Ne consegue, per k 1,<br />

che XtXt j , e quindi tutte le “marginali” del processo sono<br />

identicamente distribuite, da cui avranno uguale media e varianza<br />

2<br />

Var( Xt ) , t .<br />

EX ( t ) ,<br />

Analogamente, per k 2 , ( X , X ) ( X , X )<br />

t t t jt j . La distribuzione congiunta dipende<br />

1 2 1 2<br />

solamente da t2 t1<br />

e non dalla traslazione j. E così via crescendo in dimensione.<br />

Ne consegue che se si considerano le componenti ( Xt, Xt h)<br />

, ed esistono i momenti fino al secondo<br />

ordine, la covarianza dipende solo da h:<br />

Cov( X , X ) E[( X E( X ))][( X E( X ))] <br />

t th t t th th E[( X )( X )]<br />

<br />

<br />

h<br />

t th Per h 0 la covarianza coincide con la varianza di t X<br />

2<br />

0 Cov( Xt , Xt ) Var( Xt<br />

) <br />

Le covarianze di un processo stocastico stazionario in senso stretto sono funzioni di h 0, 1, 2,... .<br />

La funzione h appena introdotta viene denominata funzione di autocovarianza del processo<br />

ed è una funzione simmetrica, infatti<br />

<br />

Cov( X , X ) Cov( X , X ) <br />

h t th th t<br />

Cov( X s, X sh ) h<br />

(posto t h s )<br />

Si definisce analogamente anche una funzione di autocorrelazione come segue:<br />

{ : h 0, 1, 2,...}<br />

h<br />

Cov( X , X )/[ Var( X ) Var( X )] <br />

h t thtth ( ) <br />

12<br />

h 0 0 h 0<br />

Ed essendo inoltre 0 1 ed ancora h h.<br />

1<br />

2

<strong>Serie</strong> <strong>Storiche</strong> e <strong>Processi</strong> <strong>Stocastici</strong> – Federico Andreis<br />

La verifica dell‟ipotesi di stazionarietà in senso stretto è nella maggior parte dei casi reali<br />

quasi impossibile, ci si limita dunque spesso a controllare che siano verificate delle condizioni<br />

meno forti e riguardanti solo i momenti fino al secondo ordine (media, varianza, covarianza). Un<br />

processo che rispetti tali proprietà è definito processo stocastico stazionario in senso lato o debole.<br />

Generalmente si considera solo quest‟ultimo tipo di stazionarietà nelle applicazioni, riconducendo<br />

la verifica alle proprietà di media, varianza e autocovarianza. In particolare diremo che un processo<br />

è stazionario in senso lato se verifica le seguenti condizioni:<br />

1. EX ( t ) , per ogni t<br />

2. EX (<br />

2<br />

) 2<br />

, per ogni t<br />

t<br />

3. E[( Xt )( X s )] st , per ogni coppia ( ts , )<br />

La prima condizione richiede che il valor medio del processo sia costante e pari a al<br />

2<br />

finita e costante al variare di t;<br />

variare di t; la seconda impone che il processo abbia varianza<br />

l‟ultima condizione infine implica che per ogni t e s esista la funzione di autocovarianza fra le<br />

variabili t X e X s . Tutto questo implica l‟esistenza dei momenti fino al secondo ordine, ma non<br />

viene imposta alcuna condizione necessaria sulle funzioni di densità multivariate che caratterizzano<br />

il processo X t . Da questo discende che mentre la stazionarietà in senso stretto implica, quando<br />

esistano i momenti fino al secondo ordine, quella in senso lato, non vale il contrario.<br />

Per quale motivo nella pratica risultano solitamente sufficienti le condizioni deboli di<br />

stazionarietà del processo? Questo è giustificato dal ruolo fondamentale giocato dalla distribuzione<br />

Normale nello studio di molti fenomeni fisici e naturali, per i quali è valido il Teorema del Limite<br />

Centrale: dal momento che, sotto ipotesi di gaussianità, le condizioni di stazionarietà debole sono<br />

sufficienti per avere anche la stazionarietà in senso forte, questo garantisce di potere evitare la<br />

complicata (quando non impossibile) verifica in molteplici situazioni.<br />

Un‟altra proprietà che, come le precedenti, un processo può possedere o meno, è<br />

l‟invertibilità. Si tratta della possibilità di esprimere un processo X t tramite le v.c. precedenti<br />

secondo l‟ordine logico imposto dal parametro t (e quindi ad esempio precedenti temporalmente);<br />

formalmente significa che esistono una funzione lineare h () ed un processo WN A t tali che, per<br />

ogni t, sia possibile scrivere<br />

X h( X , X ,...) A<br />

t t1 t2 t<br />

Quindi la funzione h () collega X t con le variabili X s ( s t)<br />

, e a tale relazione si aggiunge il<br />

processo A t per rendere la stocasticità il processo (in assenza si tratterebbe né più né meno che di<br />

una funzione deterministica di t). L‟invertibilità diventa particolarmente rilevante nello studio di<br />

alcuni modelli che presenteremo in seguito, ma già da qui si può intuire come possa risultare<br />

importante in un‟ottica di previsione, in effetti si tratta della possibilità di regredire il nostro<br />

processo stocastico sui suoi valori passati.<br />

Esiste anche un‟altra classificazione che distingue i cosiddetti processi periodici.<br />

Formalmente diremo che X t è un processo periodico se esiste un valore s tale che, per ogni t<br />

Pr{ Xt Xts} <br />

1

<strong>Serie</strong> <strong>Storiche</strong> e <strong>Processi</strong> <strong>Stocastici</strong> – Federico Andreis<br />

Dunque un processo periodico si ripete identicamente dopo s unità temporali. Se questo s è<br />

esattamente parti all‟anno solare ( s 1 per dati annuali, s 2 per dati semestrali, s 4 per dati<br />

trimestrali, e così via) allora diremo che il processo periodico è stagionale.<br />

Esistono altri tipi di classificazione di cui non tratteremo, ad eccezione della proprietà di<br />

ergodicità che verrà presentata in seguito. Tutte queste definizioni fanno riferimento ai processi<br />

stocastici e non alle serie storiche, che ne costituiscono solo una realizzazione finita. Si consideri<br />

però che serie storiche stazionarie sono quelle generate da processi stazionari e che processi<br />

gaussiani producono realizzazioni finite che, statisticamente, possono essere ben approssimate da<br />

distribuzioni Normali, e così via. Tranne l‟invertibilità (che è soprattutto una caratteristica teorica<br />

che viene resa operativa dal problema della previsione) le condizioni di stazionarietà e Normalità<br />

del processo sono in genere agevolmente deducibili dalle serie storiche osservate.<br />

Verifica di Stazionarietà (debole) di un Processo<br />

La funzione di autocovarianza introdotta precedentemente ci fornisce uno strumento teorico<br />

per verificare se un processo stocastico X t sia stazionario o meno. Tale procedura può essere<br />

applicata ai dati della serie storica che noi supponiamo essere la realizzazione finita del processo.<br />

La verifica si articola nei seguenti tre passi:<br />

1. Verificare che il valor medio di X t non dipenda da t<br />

2. Calcolare 0 , ovvero Var( X t ) e verificare che sia finita<br />

3. Verificare che h , per h 1,2,... sia una funzione solo di h e non di t<br />

L‟autocovarianza misura il segno e l‟intensità del legame lineare che intercorre fra X t e<br />

X t hal<br />

variare di h; dunque esprime le connessioni fra le v.c. che compongo il processo stocastico<br />

al variare della distanza tra di esse.<br />

D‟ora in avanti considereremo soddisfatta l‟ipotesi di stazionarietà, la quale verrà sottintesa<br />

e non più ovunque specificata.<br />

Nell‟ottica di poter effettuare dei confronti fra più processi stocastici risulta più comodo<br />

affidarsi alla funzione di autocorrelazione la quale ha un campo di variazione ben definito, a<br />

differenza di quella di autocovarianza che ha come dominio tutto il campo reale. Richiamiamo<br />

quindi tale funzione già definita in precedenza come<br />

{ : h 0, 1, 2,...}<br />

h<br />

Cov( X t, X th )<br />

h<br />

<br />

Var( X ) Var( X )<br />

h h<br />

<br />

<br />

0 0<br />

t th 0

<strong>Serie</strong> <strong>Storiche</strong> e <strong>Processi</strong> <strong>Stocastici</strong> – Federico Andreis<br />

Questa funzione possiede proprietà notevoli, le più importanti delle quali sono:<br />

1. 0 1 <br />

Si tratta infatti di fare il rapporto tra 0 e sé stesso, inoltre 0 è il coefficiente di<br />

correlazione di X t con sé stesso.<br />

2. h h, per ogni h 0,1,2,...<br />

Difatti, come dimostrato in precedenza, h h per la simmetria della covarianza.<br />

3. h 1,<br />

per ogni h 0,1,2,...<br />

Da un punto di vista statistico, sappiamo che la correlazione è definita nel dominio [ 1,1] .<br />

4. ( aX b) ( X ) , per ogni h 0,1,2,... e per qualsiasi coppia reale ( ab , )<br />

h t h t<br />

Questo poiché essendo<br />

proprietà della covarianza, e dal momento che<br />

proprietà di cui sopra.<br />

Cov aX b aX b a Cov X X a X per le<br />

( t , th) 2<br />

( t, th) 2<br />

h( t )<br />

Var( aX t b) 2<br />

a Var( Xt )<br />

2<br />

a 0(<br />

X t )<br />

segue la<br />

5. La matrice di Toeplitz di ordine m associata alla funzione di autocorrelazione di un<br />

processo stazionario è definita positiva.<br />

Ricordiamo brevemente che la matrice di Toeplitz di ordine m, associata a h , è definita per<br />

ogni m 1,2,3,... come<br />

1 1 2 ... m1<br />

<br />

<br />

1 ... <br />

<br />

1 1 m2<br />

<br />

2 1 1 ... m3<br />

<br />

P( m) [ ], ( i, j) 1,2,..., m<br />

ij <br />

. . . ... .<br />

<br />

. . . ... . <br />

<br />

... 1 <br />

m1 m2 m3<br />

<br />

Si tratta quindi di una matrice simmetrica contenente i valori della funzione di<br />

autocorrelazione fino all‟ordine m 1.<br />

Commentiamo brevemente queste proprietà: la 1. e la 3. affermano che la funzione di<br />

autocorrelazione è normalizzata ad 1 e che questo massimo è raggiunto per h 0 . La 2. mostra<br />

che h è simmetrica, per cui la sua analisi viene sempre intrapresa per valori di h positivi. La<br />

proprietà 4. esplicita che l‟autocorrelazione è invariante per traslazione e cambiamento di scala,<br />

per cui un processo X t può essere studiato sotto l‟unità di misura di volta in volta più

<strong>Serie</strong> <strong>Storiche</strong> e <strong>Processi</strong> <strong>Stocastici</strong> – Federico Andreis<br />

conveniente. La 5. enuncia una serie di condizioni necessarie e sufficienti affinché una<br />

{1, , ,..., ,...} sia effettivamente la funzione di autocorrelazione di un processo<br />

successione 1 2<br />

m<br />

stazionario. In altri termini, mentre è necessario che sia verificata la 3. per ogni h affinché h<br />

sia una funzione di autocorrelazione, solo la condizione che la matrice di Toeplitz sia definita<br />

positiva per ogni m garantisce che esista un processo stazionario X t che possegga<br />

{ h, 0,1,2,...} h come propria funzione di autocorrelazione. Come è noto una matrice è<br />

definita positiva se e solo se tutti i minori principali di qualsiasi ordine sono positivi; svolgendo<br />

P definita sopra si nota per m 1,2 non risultano particolari<br />

i calcoli sulla generica matrice ( m)<br />

limitazioni sulla funzione h , mentre invece per m 3 discendono condizioni particolarmente<br />

restrittive. In effetti<br />

P<br />

(1)<br />

10 1 <br />

1 0 1 1<br />

1 2<br />

(2) 11 1<br />

1<br />

P<br />

1<br />

1 2<br />

(3) 1 1 2 2 2<br />

1<br />

P<br />

1 (1 )(1 2 ) 0<br />

<br />

2 1<br />

<br />

1<br />

121<br />

<br />

2<br />

2<br />

21 1<br />

E così via per P( ) 0, m<br />

4,5,... . Si nota quindi subito come, mentre per i primi due<br />

m<br />

ordini le condizioni sono banali o ricalcano altre proprietà, già da m 3 la questione si fa più<br />

complicata. La soluzione della disuguaglianza porta ad un vincolo ben preciso, che restringe in<br />

modo consistente lo spazio di definizione della funzione h (per essere precisi lo restringe<br />

esattamente da un‟area di definizione pari a 4 ad una di 10/3, riducendolo quindi di 1/6; per<br />

rendersene conto basti disegnare negli assi cartesiani ( xy , ) ( 2, 1)<br />

le condizioni per m 2 e<br />

m 3,<br />

ne risulterà un quadrato di lato 2 avente baricentro nell‟origine ed una parabola di vertice<br />

(0, 1) che porta l‟area di definizione a coincidere con la sua intersezione con il quadrato.<br />

Per fare un esempio numerico ed intuitivo, se 1 1 2 0,7071<br />

, allora 2 0 (poiché<br />

dalle condizioni per 3<br />

m risulta che dovrà aversi 2<br />

2<br />

<br />

2 1 2 1 2 1 2 2 1 0).<br />

2 1<br />

Questo è senz‟altro notevole ma risulta comunque ragionevole con riguardo all‟aspettativa che<br />

se la correlazione fra t X e X t<br />

1 (a distanza di una unità temporale l‟una dall‟altra, o 1 lag) è<br />

così elevata (circa 70,71%) risulta ragionevole pensare che la correlazione fra t X e X t<br />

2<br />

(distanti 2 lags) non può essere negativa; questo perché il processo in esame possiede quella<br />

omogeneità temporale che abbiamo identificato come la stazionarietà.<br />

Portiamo ora un semplice esercizio che serva ad applicare le nozioni finora acquisite. Sarà<br />

dato un processo stocastico e dovremo verificarne la stazionarietà e costruirne la matrice di<br />

Toeplitz.

Esempio<br />

e<br />

<strong>Serie</strong> <strong>Storiche</strong> e <strong>Processi</strong> <strong>Stocastici</strong> – Federico Andreis<br />

Siano e due v.c. Normali, indipendenti, di media zero e varianze, rispettivamente,<br />

2<br />

. Definiamo il processo stocastico<br />

X costsin t,<br />

t 1,2,...<br />

t<br />

In cui 0 2<br />

è un numero reale fissato. Trattandosi di una combinazione lineare di due v.c.<br />

Normali e indipendenti, il processo X t è ben definito e si potrebbe calcolarne la generale<br />

funzione di densità multivariata. Calcoliamone però i primi momenti che, dalla definizione del<br />

processo, risulteranno funzione dei momenti di e .<br />

Ricordiamo che, per ipotesi, vale<br />

E( ) E(<br />

) 0 ;<br />

Cov( , ) E(<br />

, ) 0<br />

Avremo quindi per il processo che<br />

Var( ) <br />

2<br />

;<br />

2<br />

Var( ) <br />

E( X ) cos tE( ) sin tE(<br />

) 0 t<br />

t<br />

2 2 2 2<br />

Var( X t ) cos t sin t t<br />

Cov( X , X ) E[( cos t sin t)( cos ( t h) sin (<br />

t h))]<br />

<br />

t th 2 2<br />

cost cos ( t h) E( ) sint sin (<br />

t h) E(<br />

) <br />

cos t cos ( t h) sin t sin ( t h)<br />

2 2<br />

<br />

Come si vede il valor medio è nullo e quindi costante ma varianza e autocovarianza variano<br />

al variare di t, pertanto, in generale, il processo X t è non stazionario.<br />

2<br />

Se tuttavia supponessimo che Var( ) Var( ) allora le espressioni precedenti<br />

diventerebbero<br />

2 2 2 2<br />

Var( X t ) (cos t sin t) t<br />

Cov X X t t h t t h <br />

2<br />

( t, th ) [cos cos ( ) sin sin (<br />

)]<br />

2 2<br />

cos[ ( )] cos<br />

<br />

t k t h t<br />

In definitiva, se Var( ) Var( ) il nostro processo risulta essere stazionario, dal momento<br />

che valgono la condizione 1. di costanza della media, la 2. di costanza e finitezza della varianza<br />

quale che sia t ed infine la 3., ovvero l‟autocovarianza tra t e t h dipende solamente dal lag e<br />

non dall‟istante temporale t.<br />

Sempre sotto le ipotesi suddette la funzione di autocorrelazione del processo risulterà essere<br />

definita da<br />

2

2<br />

h cos<br />

h<br />

2<br />

cos<br />

0 2<br />

<br />

<strong>Serie</strong> <strong>Storiche</strong> e <strong>Processi</strong> <strong>Stocastici</strong> – Federico Andreis<br />

h<br />

cos h,<br />

h0,1,2,3,...<br />

h<br />

h<br />

La funzione è esattamente periodica e risulta evidente come non sia funzione di t ma solo<br />

del lag h.<br />

A conferma della proprietà 5. riguardante la matrice di Toeplitz si osservi che<br />

P<br />

P<br />

(1)<br />

2 2<br />

(2) 1 cos sin 0 <br />

P<br />

(3)<br />

10 1 cos<br />

cos 1<br />

1 cos cos2<br />

2<br />

cos 1 cos (1 cos2 )(1 cos2 2cos ) 0<br />

cos2 cos 1<br />

1<br />

cos20 <br />

<br />

2<br />

1 cos2 2cos 0<br />

<br />

<br />

2<br />

Dal momento che cos2 2cos 1 l‟ultimo sistema è verificato per ogni appartenente<br />

all‟insieme di definizione che abbiamo fornito, ovvero 0 2<br />

.<br />

Stima della Funzione di Autocorrelazione e Concetto di Ergodicità<br />

Dal momento che la funzione di autocorrelazione h è una misura della struttura interna del<br />

processo stazionario X t assume particolare importanza la sua stima statistica a partire da una<br />

realizzazione finita, ovvero la nostra serie storica { xt , t 1,2,..., N}<br />

. Una considerazione va fatta<br />

prima di considerare i metodi di stima: i dati di cui disponiamo costituiscono una informazione<br />

congiunta sulle v.c. ( X1, X 2,...,<br />

X N ) e non sulla generica X t che definisce, al variare di t, il<br />

processo. La serie storica è quindi una successione ordinata di N campioni di dimensione<br />

unitaria su N distinte v.c. le quali, generalmente, fra loro non sono indipendenti né somiglianti.<br />

La complicazione di stima dei parametri di un processo si presenta quindi già nello studio dei<br />

primi momenti; si immagini cosa può succedere passando a intere funzioni dei parametri (quali<br />

ad esempio, appunto, l‟autocorrelazione). Le procedure classiche di stima da un campione non<br />

sono quindi generalmente utilizzabili, ma risulta d‟altra parte intuitivo supporre che, una volta<br />

verificata la stazionarietà del processo in esame, sia ragionevole aspettarsi che si possa<br />

pervenire ad utili informazioni sui parametri delle v.c. componenti il processo tramite le<br />

informazioni contenute nella serie storica, e questo in virtù della “omogeneità temporale” che<br />

identifichiamo con la stazionarietà, che garantisce una certa qual “stabilità” nei legami<br />

temporali fra le variabili.<br />

L‟esigenza di poter giungere a risultati utili disponendo di un insieme limitato di<br />

informazioni (la nostra serie storica) ha portato alla definizione dell‟importantissimo concetto di<br />

ergodicità, termine originario delle scienze fisiche che nello studio dei processi stocastici<br />

assume il seguente significato:

<strong>Serie</strong> <strong>Storiche</strong> e <strong>Processi</strong> <strong>Stocastici</strong> – Federico Andreis<br />

Definizione: Un processo stocastico X t è ergodico rispetto ad un parametro se la stima<br />

temporale del parametro, ottenuta da una serie storica, converge in media<br />

quadratica a quel parametro.<br />

Formalmente, dato ˆ( X T ) T 1,2,..., N stimatore del vero parametro e funzione dei dati della<br />

serie storica, diremo che la condizione di ergodicità è verificata qualora<br />

ˆ<br />

2<br />

lim E[ ( XT)<br />

] 0<br />

T<br />

Cos‟è dunque l‟ergodicità? Può essere intesa come una condizione che limita la memoria del<br />

processo: un processo non ergodico è tale da avere caratteristiche di persistenza così accentuate<br />

da far sì che un segmento del processo (nel nostro caso la serie storica) per quanto lungo, sia<br />

insufficiente a dire alcunché sulle sue caratteristiche distributive. In un processo ergodico, al<br />

contrario, la memoria del processo può essere intesa debole su lunghi orizzonti e all‟aumentare<br />

dell‟ampiezza del campione aumenta in modo significativo anche l‟informazione in nostro<br />

possesso. La considerazione che possiamo fare è quella di reputare virtualmente indipendenti<br />

eventi distanti tra di loro sull‟asse temporale in caso di ergodicità: sotto una simile ipotesi<br />

possiamo supporre possibile l‟osservazione di una parte consistente delle traiettorie che il<br />

processo può generare posta una evidenza campionaria sufficientemente grande. Formalmente<br />

la considerazione enunciata poco fa sull‟incorrelazione di eventi distanti nel tempo si traduce<br />

nella seguente condizione necessaria e sufficiente affinché il processo sia ergodico rispetto al<br />

valor medio è che la sua funzione di autocorrelazione tenda a zero al crescere del lag h.<br />

Esiste inoltre un teorema (detto appunto ergodico) che garantisce che se un processo è ergodico<br />

l‟osservazione di una sua realizzazione “abbastanza” lunga è equivalente, per i fini inferenziali,<br />

all‟osservazione di un grande numero di osservazioni.<br />

In linea generale possiamo dire che solo per processi ergodici e stazionari (nota: la<br />

stazionarietà non implica l‟ergodicità! ne è una prova l‟esempio di prima, in cui il processo era<br />

sì stazionario, ma la sua funzione di autocorrelazione era periodica e non tendeva a zero al<br />

divergere del lag) può porsi correttamente il problema dell‟inferenza statistica sulle serie<br />

storiche. L‟ergodicità garantisce che dall‟unica informazione disponibile, appunto le<br />

osservazioni che compongono la nostra serie storica, sarà possibile risalire a stime consistenti in<br />

senso statistico del processo stazionario X t .<br />

D‟ora in avanti supporremo che i processi con cui lavoreremo siano stazionari ed erodici<br />

fino almeno ai momenti del secondo ordine, di modo da dare un senso all‟approccio<br />

inferenziale.<br />

Passiamo dunque alla stima vera a propria della funzione di autocorrelazione h h 0 . Si<br />

tratta semplicemente di trovare uno stimatore soddisfacente per , 0,1,2,... e di lì ricavare<br />

. Premettiamo che per stimare il valor medio del processo EX ( ) impiegheremo la<br />

h<br />

media campionaria<br />

N<br />

t<br />

t1<br />

asintoticamente normale. Si noti però che la varianza di tale stimatore, che solitamente vale<br />

2<br />

N , viene ad essere alterata da un fattore moltiplicativo a causa della correlazione esistente<br />

h h<br />

x X N , il quale, come è noto, è non distorno, consistente ed<br />

fra le X t .<br />

Per comodità di notazione considereremo il processo scarto Zt Xt , il quale possiede<br />

media nulla e la stessa varianza, autocovarianza e autocorrelazione di X t ( trattandosi di una<br />

t

<strong>Serie</strong> <strong>Storiche</strong> e <strong>Processi</strong> <strong>Stocastici</strong> – Federico Andreis<br />

semplice traslazione). In letteratura sono stati proposti diversi stimatori dell‟autocovarianza, fra<br />

i quali citiamo<br />

ˆ <br />

ˆ <br />

ˆ <br />

1<br />

N<br />

(1)<br />

h ZZ t th N t1<br />

1<br />

Nh (2)<br />

h ZZ t th N h t1<br />

1<br />

Nh (3)<br />

h ZZ t th N t1<br />

Lo stimatore per l‟autocorrelazione sarà in ogni caso<br />

ˆ ih , i 1,2,3<br />

ˆ <br />

i h<br />

i<br />

0<br />

(1) ˆ h è dotato di notevoli proprietà teoriche, ma implica una condizione molto<br />

Lo stimatore<br />

restrittiva per il suo utilizzo, ovvero il processo deve ripetersi esattamente dopo N unità<br />

temporali, cioè deve essere del tipo ZN 1 Z1, ZN 2 Z2,..., ZN i<br />

Zi,...<br />

.<br />

Per quanto riguarda gli altri due stimatori si osservi che per N elevato rispetto a k vale<br />

(3) (2) ˆ ˆ , dunque la differenza risulta evidente solo nei piccoli campioni. E‟ stato dimostrato<br />

h h<br />

inoltre che<br />

(2) ˆ h è stimatore corretto per h ma<br />

(3) ˆ h , pur essendo distorto, garantisce un errore<br />

(2) ˆ h , risultando dunque più efficiente e, soprattutto,<br />

quadratico medio inferiore a quello di<br />

verifica la condizione per la quale P ˆ<br />

( m)<br />

, ovvero la matrice di Toeplitz stimata, è definita<br />

positiva, proprio come P ( m)<br />

; questo non avviene necessariamente costruendo P ˆ<br />

( m)<br />

con lo<br />

(2) ˆ h . Per questi motivi di norma la preferenza cade su<br />

stimatore<br />

funzione di autocorrelazione nel modo seguente:<br />

N hNh <br />

Z Z ( X x)( X x)<br />

ˆ <br />

ˆ , h 0,1,2,...<br />

(3)<br />

t thtth h t1 t1<br />

h (3) ˆ 0<br />

N<br />

2<br />

Zt N<br />

(<br />

X t<br />

2<br />

x)<br />

t1 t1<br />

(3) ˆ h e dunque si stima la<br />

Lo stimatore è simmetrico ( ˆ ˆ h h) e pertanto la stima viene effettuata solo per h positivo.<br />

In pratica come si procede? Nota la serie storica ( x1, x2,..., x N ) si costruisce la serie degli<br />

scarti z1 x1 x, calcola<br />

z2 x2 x, ..., zN xN x (dove x è la usuale media campionaria) quindi si<br />

Nh 1<br />

ˆ z z , h 0,1,2,...<br />

<br />

h t th N t1

<strong>Serie</strong> <strong>Storiche</strong> e <strong>Processi</strong> <strong>Stocastici</strong> – Federico Andreis<br />

fino ad un lag massimo che l‟esperienza pone pari a N 4 o al suo intero successivo. Fatto<br />

questo si costruiscono i rapporti ˆ ˆ ˆ<br />

h h 0 per h 0,1,2,..., N 4 e si riportano su di un grafico<br />

denominato correlogramma, solitamente a barre verticali per ciascun h per sottolineare che si<br />

tratta di stime in punti discreti; talvolta si uniscono i punti della funzione di autocorrelazione per<br />

evidenziarne l‟andamento complessivo.<br />

Esempio<br />

Sia xt (8.5, 10.3, 9.6, 8.7, 11.2, 9.9, 7.9, 10.9, 11.1, 10.4) la nostra serie storica il cui<br />

grafico è illustrato di qui di seguito<br />

e la quale media campionaria vale x 9.79 (tratteggiata nel grafico). La serie degli scarti è<br />

z ( 1.35, 0.45, 0.25, 1.15, 1.35, 0.05, -1.95, 1.05, 1.25, 0.55) . Dal momento che<br />

t<br />

N=10 N4 2.5 dunque avrà senso calcolare ˆ h solo per h 0,1,2,3 . Dunque<br />

1 1<br />

ˆ 0 <br />

N<br />

N<br />

10<br />

2 2<br />

zi zi<br />

i1 10 t1<br />

1 1.82250.20250.06251.32251.8225 <br />

10 0.0025 3.8025 1.1025 1.5625 0.3025<br />

<br />

1<br />

12.005 1.2<br />

10<br />

N 1<br />

9<br />

1 1<br />

ˆ z z z z <br />

<br />

1 t t1tt1 N i1 10 t1<br />

1 0.60750.11250.28751.55250.0675 <br />

10 0.0975 2.0475 1.3125 0.6875<br />

<br />

1<br />

2.0625 0.21<br />

10

N 2<br />

8<br />

1 1<br />

ˆ z z z z <br />

<br />

2 t t2tt2 N i1 10 t1<br />

<strong>Serie</strong> <strong>Storiche</strong> e <strong>Processi</strong> <strong>Stocastici</strong> – Federico Andreis<br />

1 0.33750.51750.33750.0575 <br />

10 2.6325 0.0525 2.4375 0.5775<br />

<br />

1<br />

5.015 0.5<br />

10<br />

N 3<br />

7<br />

1 1<br />

ˆ z z z z <br />

<br />

3 t t3 t 3<br />

N i1 10 t1<br />

1 1.55250.60750.01252.2425 <br />

10 1.4175 0.0625 1.0725<br />

<br />

1<br />

4.7975 0.48<br />

10<br />

Dunque le stime della funzione di autocorrelazione saranno:<br />

ˆ ˆ ˆ 1<br />

0 0 0<br />

ˆ ˆ ˆ 0.21 1.2 0.18<br />

1 1 0<br />

ˆ ˆ ˆ 0.5 1.2 0.42<br />

2 2 0<br />

ˆ ˆ ˆ 0.48 1.2 0.40<br />

3 3 0<br />

Il correlogramma sarà quindi, per i lags h 0,1,2,3 , il seguente:<br />

Le linee tratteggiate delimitano la regione di confidenza approssimata per l‟ipotesi<br />

0 : H Xt WN e si ottengono da 2 N 2 10 0.6325 . In ambiente R, ovvero il software<br />

impiegato per tracciare questi grafici, tale precisazione viene eseguita in automatico nel<br />

momento del calcolo della funzione di autocorrelazione; le bande così ampie, che porterebbero a<br />

non poter rifiutare l‟ipotesi di cui sopra, sono dovute ad un N così piccolo.

<strong>Serie</strong> <strong>Storiche</strong> e <strong>Processi</strong> <strong>Stocastici</strong> – Federico Andreis<br />

Passiamo ora a parlare di un altro importantissimo strumento dell‟analisi dei processi<br />

stazionari, ovvero la funzione di autocorrelazione parziale, il cui ruolo fondamentale risulterà<br />

più chiaro nel seguito, quando tratteremo dei cosiddetti modelli autoregressivi.<br />

Definiamo quindi la funzione di autocorrelazione parziale h al lag h, per h 0, 1, 2,... ,<br />

come la correlazione esistente fra t X e X t h al netto della correlazione esistente fra le v.c.<br />

“intermedie” tra t X e X t h.<br />

Se la definizione può risultare di non semplicissima comprensione, la forma analitica della<br />

funzione è estremamente semplice: la funzione di autocorrelazione parziale è data dal rapporto<br />

fra due determinanti<br />

Con<br />

P<br />

( h)<br />

P<br />

*<br />

( h)<br />

*<br />

P(<br />

h)<br />

h , h 0,1,2,...<br />

P<br />

( h)<br />

1 1 2 ... h1<br />

<br />

<br />

1 ... <br />

<br />

1 1 h2<br />

<br />

2 1 1 ... h3<br />

<br />

;<br />

<br />

. . . ... .<br />

<br />

. . . ... . <br />

<br />

... 1 <br />

h1 h2 h3<br />

<br />

1 1 2 ... 1<br />

<br />

<br />

1 ... <br />

<br />

1 1 2 <br />

2 1 1 ... 3<br />

<br />

<br />

<br />

. . . ... .<br />

<br />

. . . ... . <br />

<br />

... <br />

h1 h2 h3 h <br />

Dove P ( h)<br />

è la matrice di Toeplitz di ordine h, mentre<br />

P è la stessa matrice alla cui ultima<br />

colonna è stato sostituito il vettore composto dai valori della funzione di autocorrelazione fino al<br />

lag h. Dalla proprietà di simmetria di h discende anche quella di h , difatti vale h h,<br />

quindi anche in questo caso i calcoli verranno effettuati esclusivamente per valori positivi di h.<br />

E‟ ovviamente vero che 0 1 , mentre applicando la definizione per h 1,2,3 otteniamo:<br />

1<br />

1 1<br />

1<br />

<br />

1<br />

1<br />

2 <br />

1<br />

1<br />

2<br />

1 <br />

2<br />

2 1<br />

2<br />

1<br />

1<br />

1<br />

<br />

<br />

<br />

1<br />

*<br />

( h)

1<br />

1 1<br />

1 <br />

1 2<br />

<strong>Serie</strong> <strong>Storiche</strong> e <strong>Processi</strong> <strong>Stocastici</strong> – Federico Andreis<br />

1 2 2<br />

<br />

2<br />

2 <br />

<br />

2 1 3 3 1 1 1 2 2<br />

3 <br />

2 2<br />

1 1 2 1 1 1 2 21<br />

1 <br />

1 1<br />

2 1<br />

<br />

<br />

<br />

1<br />

<br />

Risultano inoltre univocamente determinabili i valori della funzione di autocorrelazione in<br />

funzione delle autocorrelazioni parziali fino allo stesso lag h:<br />

<br />

1 1<br />

1 <br />

<br />

2 2<br />

2<br />

1 2<br />

2 2 3<br />

2<br />

1 1 1 2 <br />

<br />

3 3 2 1 1 2 1 2 2<br />

E‟ possibile (per quanto non immediato) ricavare una forma analitica generale in modo da<br />

esplicitare h in funzione di h, h<br />

1,..., 1<br />

e viceversa; tale problema è sempre risolubile, per<br />

quanto non molto semplice.<br />

Come si può vedere dalla teoria esposta sino a qui h e h sono l‟una funzione dell‟altra:<br />

h non aggiunge nulla sulla conoscenza del processo che non sia già teoricamente deducibile da<br />

h ; come già accennato l‟importanza della funzione di autocorrelazione parziale risulterà<br />

evidente più avanti, nell‟ambito della stima dei modelli autoregressivi.<br />

Per quanto riguarda la stima della funzione di autocorrelazione parziale il metodo più<br />

immediato consiste nel ricavare le stime di h , ad esempio tramite lo stimatore introdotto<br />

prima, ed andarle a sostituire all‟interno delle matrici definite sopra, di modo da ottenere<br />

*<br />

Pˆ<br />

( h)<br />

ˆ h , h 0,1,2,...<br />

Pˆ<br />

( h)<br />

ˆ *<br />

P ( h)<br />

e P ˆ<br />

( h)<br />

sono, rispettivamente, la matrice di Toeplitz e la stessa modificata di cui già si è<br />

parlato, nelle quali sono stati inseriti i valori stimati della funzione di autocorrelazione.<br />

Analogamente al caso della funzione di autocorrelazione si rappresenta graficamente anche<br />

ˆ h per lo stesso numero di lags per cui è stata stimata h . Tale grafico viene denominato<br />

talvolta come correlogramma parziale.<br />

Esempio<br />

Riprendiamo i dati derivati dalla serie storica dell‟esempio precedente, per la quale avevamo<br />

già stimato i valori della funzione di autocorrelazione fino al lag h 3.

1 1 0<br />

2 2 0<br />

3 3 0<br />

<strong>Serie</strong> <strong>Storiche</strong> e <strong>Processi</strong> <strong>Stocastici</strong> – Federico Andreis<br />

ˆ ˆ ˆ 0.21 1.2 0.18<br />

ˆ ˆ ˆ 0.5 1.2 0.42<br />

ˆ ˆ ˆ 0.48 1.2 0.40<br />

Procedendo con i calcoli e sfruttando i risultati presentati in precedenza otteniamo le stime<br />

dell‟autocorrelazione parziale:<br />

ˆ 1<br />

ˆ ˆ<br />

1 1<br />

0.18<br />

1<br />

1 ˆ 1<br />

ˆ <br />

ˆ <br />

ˆ ˆ 0.42 ( 0.18)<br />

0.468<br />

2 2<br />

1 2 2 1<br />

2<br />

1 ˆ 1 2<br />

1 ˆ 1<br />

2<br />

1 ( 0.18)<br />

ˆ 1<br />

1<br />

1 ˆ 1 ˆ 1<br />

ˆ 1 1 ˆ 2<br />

ˆ <br />

ˆ <br />

ˆ ˆ <br />

<br />

ˆ ˆ ˆ ˆ ˆ <br />

<br />

1 2 2<br />

<br />

2<br />

2 <br />

1 1 2 <br />

2 1 3 3 1 1 1 2 2<br />

3<br />

1 ˆ 1 ˆ 2 2 ˆ 1 ˆ 2 2 ˆ 1<br />

ˆ 1 1 ˆ 1<br />

ˆ ˆ 1<br />

2 1<br />

<br />

2 <br />

2<br />

<br />

2<br />

<br />

2 2<br />

1 ( 0.18) 1 ( 0.42) 2( 0.18)<br />

<br />

0.40 1 ( 0.18) 0.18 ( 0.18) ( 0.42) 2( 0.42)<br />

0.398<br />

Come si può notare le stime delle due funzioni sono praticamente coincidenti, a meno di<br />

approssimazioni minime. Nel grafico che segue è riportato il correlogramma parziale del<br />

processo sulla base della serie storica data.

<strong>Serie</strong> <strong>Storiche</strong> e <strong>Processi</strong> <strong>Stocastici</strong> – Federico Andreis<br />

Anche in questo caso sono presenti i limiti approssimati della regione di confidenza al 95%<br />

H X WN . La costruzione è analoga a quella relativa alla funzione di<br />

per l‟ipotesi 0 : t<br />

autocorrelazione, le bande di confidenza sono poste a 2 N 2 10 0.6325 intorno allo<br />

zero; chiaramente nel nostro caso tale specificazione è superflua, dal momento che la serie<br />

storica che è stata impiegata per l‟esercizio è artificiale.<br />

La Classe dei Modelli ARMA<br />

Come si è già visto in precedenza lo scopo dell‟analisi delle serie storiche è quella di risalire<br />

ai processi stocastici che si suppone le abbiano generate; operativamente questo si traduce<br />

nell‟identificazione e nella stima di modelli statistici che garantiscano un accettabile grado di<br />

approssimazione della realtà in esame. Dunque dai dati non si perviene al processo bensì se ne<br />

costruisce una descrizione valida sino a prova contraria: una sintesi cioè ottimale solo fino a che<br />

nuovi dati non porteranno a costruire modelli più convincenti. In generale la conoscenza di un<br />

processo a partire dai dati è proibitiva, dunque si ripiega su di un particolare modello: il<br />

processo stocastico genera la serie storica quale sua realizzazione finita, il modello statistico si<br />

adegua alla serie storica secondo criteri di ottimalità e genera dati che sono simulazioni ottenute<br />

dal modello. Nel seguito presenteremo una classe di modelli statistici che trova il suo impiego<br />

nella descrizione dei processi stocastici, i modelli ARMA. Il passo seguente all‟identificazione è<br />

chiaramente costituito dalla validazione del modello scelto tramite opportune verifiche di<br />

ipotesi; una volta assicurata la bontà del modello si può infine passare alla previsione.<br />

Il Processo a Media Mobile<br />

Sia A t un processo white noise come già definito in precedenza e si consideri il seguente<br />

processo stocastico<br />

Yt At At dove , . Questa serie storica è definita processo a media mobile del primo ordine, e si<br />

indica con MA (1) . Il termine “media mobile” deriva dal fatto che Y t è costruito da una somma<br />

pesata, simile ad una media, dei due più recenti valori di A .<br />

Il valore atteso di Y t è dato da<br />

<br />

E Y E A A E A E A <br />

t t t1 t t1<br />

dal momento che abbiamo definito A t come un white noise, e quindi a media nulla per ogni t.<br />

La varianza di Y t , che coincide chiaramente con la funzione autocovarianza calcolata per un<br />

lag nullo, vale<br />

2 2 2 2 2<br />

t t t1 t 2<br />

t t1 t1<br />

<br />

E Y E A A E A A A A <br />

2 2 2<br />

0 <br />

1 <br />

<br />

2 2<br />

0<br />

1

La prima autocovarianza è<br />

<strong>Serie</strong> <strong>Storiche</strong> e <strong>Processi</strong> <strong>Stocastici</strong> – Federico Andreis<br />

<br />

E Y Y E A A A A <br />

t t1 t t1 t1 t2<br />

2 2 2<br />

t t1 t1 t t2 t1 t2<br />

<br />

E A A A A A A A <br />

0 0 0 <br />

2 2<br />

1<br />

Le autocovarianze di ordine superiore sono tutte identicamente nulle.<br />

Dal momento che la media e le autocovarianze non sono funzioni del tempo t, un processo<br />

MA (1) à stazionario quale che sia il valore di . Inoltre è chiaramente soddisfatta la seguente<br />

condizione di ergodicità rispetto alla media<br />

<br />

h<br />

<br />

,<br />

difatti h<br />

2 2 2<br />

1 <br />

<br />

h0<br />

h0<br />

supponendo finito (ed è una assunzione quasi scontata, altrimenti non avrebbe senso la<br />

2<br />

costruzione di un modello) e sapendo che è finito poiché stiamo considerando un disturbo di<br />

tipo white noise (analogo è il discorso sulla condizione di asintoticità verso lo zero: dal<br />

momento che h 0, h 1 è verificata anche quest‟ultima). Inoltre se supponiamo che il<br />

processo di rumore bianco sia anche gaussiano, allora l‟ergodicità è valida con rispetto a tutti i<br />

momenti.<br />

La funzione di autocorrelazione è pari all‟unità per h 0 , mentre per h 1 vale<br />

<br />

2<br />

1 <br />

1 <br />

2 2<br />

2<br />

0 1<br />

1 <br />

le autocorrelazioni di ordine superiore sono tutte identicamente nulle ed è possibile<br />

rappresentare h in un correlogramma.<br />

E‟ interessante notare come esistano sempre due distinti valori di tali da restituire il<br />

medesimo valore della funzione di autocorrelazione. Difatti se andiamo a sostituire a il valore<br />

1 notiamo che<br />

<br />

<br />

<br />

<br />

2<br />

11 <br />

11 11 1<br />

<br />

1 2<br />

2<br />

2<br />

2<br />

Per esempio, i processsi Yt autocorrelazione data da<br />

At 0.5At<br />

1<br />

e Yt At 2At<br />

1<br />

hanno la medesima funzione di<br />

2 0.5<br />

1 0.4<br />

2 2<br />

1210.5

Il grafico di 1<br />

2<br />

1<br />

è il seguente:<br />

<strong>Serie</strong> <strong>Storiche</strong> e <strong>Processi</strong> <strong>Stocastici</strong> – Federico Andreis<br />

Sono stati simulati quattro processi a media mobile del primo ordine sotto ipotesi di media<br />

nulla e con rumore bianco gaussiano (la stazionarietà non è richiesta in quanto sempre<br />

verificata); di seguito le rappresentazioni grafiche delle serie storiche per un totale di 300<br />

realizzazioni, con i rispettivi correlogrammi (ACF) e correlogrammi parziali (Partial ACF).<br />

Le funzioni di autocorrelazione (ACF) mostrano come, dopo il primo lag, i valori possano<br />

ritenersi ragionevolmente nulli (dal momento che non superano le bande di confidenza; è<br />

accettabile inoltre un valore “anomalo” ogni 20 lag, purché superi in modo non significativo i<br />

valori limite). Questo significa che abbiamo a che fare con modelli a media mobile di ordine 1<br />

(come in effetti sono per costruzione); la vera utilità di questo genere di considerazioni grafiche<br />

risiede nel fatto che nella cosiddetta fase di identificazione dei modelli possiamo essere in<br />

grado, semplicemente costruendo i correlogrammi campionari dalla nostra serie storica, di<br />

orientarci verso un tipo di modello o verso un altro a seconda della “forma” della funzione di<br />

autocorrelazione .<br />

Le funzioni di autocorrelazione parziale (Partial ACF), invece, mostrano un andamento<br />

decrescente e convergente verso lo zero: questo è tipico dei modelli a media mobile.

<strong>Serie</strong> <strong>Storiche</strong> e <strong>Processi</strong> <strong>Stocastici</strong> – Federico Andreis

<strong>Serie</strong> <strong>Storiche</strong> e <strong>Processi</strong> <strong>Stocastici</strong> – Federico Andreis

<strong>Serie</strong> <strong>Storiche</strong> e <strong>Processi</strong> <strong>Stocastici</strong> – Federico Andreis<br />

Definiamo ora il processo a media mobile di ordine q, che indicheremo con MA( q ) , nel<br />

seguente modo:<br />

Y A A A A<br />

t t 1 t1 2 t2 ... q<br />

tq Ovvero estendiamo ad un numero di q termini la somma pesata dei white noise che riteniamo<br />

descrivano la nostra Y t . In pratica viene aumentato il peso delle informazioni fornite dai disturbi<br />

più lontani nel tempo, fino ad un lag, appunto, pari a q. MA (1) è chiaramente un caso<br />

particolare di processo a media mobile di ordine q nel quale i pesi j risultino pari a zero per<br />

j 1.<br />

Calcoliamo il valore atteso del processo<br />

La varianza sarà<br />

t t 1 t1 2 t2 ... q<br />

tq <br />

E At 1EAt1... qE At<br />

q<br />

E Y E A A A A <br />

<br />

2<br />

2<br />

<br />

0 E Yt E At 1At 1 2At 2 ... q At<br />

q<br />

dal momento che, per ipotesi, i rumori bianchi sono incorrelati tra di loro la varianza della<br />

somma sarà semplicemente pari alla somma delle varianze, ovvero<br />

<br />

... 1 ... <br />

2 2 2 2 2 2 2 2 2 2 2<br />

0 1 2 q 1 2<br />

q<br />

Si ricava inoltre (non lo dimostriamo ma è semplice ottenerlo) che<br />

2<br />

h h h q qh 1 1 2 2 ... h1,2,..., q<br />

h <br />

0<br />

hq Per esempio in un processo MA (3) avremo che:<br />

1 <br />

<br />

<br />

2 2 2 2<br />

0 1 2 3<br />

<br />

2<br />

2<br />

2<br />

<br />

<br />

1 1 2 1 3 2<br />

<br />

2 2 3 1<br />

<br />

3 3<br />

... 0<br />

4 5<br />

La funzione di autocorrelazione segue automaticamente rapportando i valori di h alla<br />

varianza, ed è identicamente nulla per h q,<br />

dunque anche il processo MA( q ) risulta essere<br />

stazionario, quali che siano i valori dei parametri j ; inoltre, come già per il processo di ordine

<strong>Serie</strong> <strong>Storiche</strong> e <strong>Processi</strong> <strong>Stocastici</strong> – Federico Andreis<br />

1, se il disturbo è di tipo white noise gaussiano è rispettata anche l‟ergodicità rispetto a tutti i<br />

momenti.<br />

Di seguito quattro esempi di processo (2)<br />

MA ; le considerazioni sono le medesime già fatte<br />

per il caso del modello a media mobile di primo ordine e ancora una volta supponiamo valor<br />

medio nullo e disturbi di tipo white noise gaussiano.

<strong>Serie</strong> <strong>Storiche</strong> e <strong>Processi</strong> <strong>Stocastici</strong> – Federico Andreis

Il processo MA( q ) può essere scritto come<br />

Si consideri cosa succede quando q :<br />

<strong>Serie</strong> <strong>Storiche</strong> e <strong>Processi</strong> <strong>Stocastici</strong> – Federico Andreis<br />

Y A , 1<br />

t j t j<br />

j0<br />

q<br />

<br />

<br />

Y A A A A ...<br />

<br />

t j t j 0 t 1 t1 2 t2<br />

j0<br />

Questo può essere considerato un processo MA( ) , che risulta essere stazionario se è verificata<br />

la seguente condizione:<br />

<br />

<br />

j0<br />

<br />

2<br />

j<br />

<br />

Spesso si considera la condizione leggermente più restrittiva<br />

Una sequenza di coefficienti j<br />

j<br />

0<br />

<br />

<br />

<br />

j0<br />

<br />

j<br />

<br />

0<br />

che rispetti le condizioni sopraelencate viene definita,<br />

rispettivamente, di quadrato sommabile e assolutamente sommabile. Questo garantisce anche<br />

che sia rispettata la condizione di ergodicità rispetto alla media (<br />

<br />

<br />

h0<br />

<br />

h<br />

),<br />

in effetti anche le<br />

covarianze sono assolutamente sommabili. Il valor medio del processo MA( ) rimane<br />

comunque , mentre i momenti di ordine superiore basta far tendere ad infinito l‟ordine q nelle<br />

espressioni già ricavate e calcolare il limite.<br />

Il Processo Autoregressivo<br />

Un processo autoregressivo del primo ordine, indicato con AR (1) , soddisfa la seguente<br />

equazione:<br />

Y c Y A<br />

t t1 t<br />

Ancora una volta A t è il rumore bianco che soddisfa tutte le proprietà già discusse e c, .<br />

Come si può vedere si tratta di una equazione alle differenze finite di ordine 1, ed è noto<br />

dalla teoria che se 1 la conseguenza degli t A sulla Y t tenderanno ad accumularsi nel tempo<br />

piuttosto che tendere a zero. Dovrebbe risultare dunque sufficientemente intuitivo comprendere<br />

la seguente affermazione: qualora 1,<br />

allora non esiste un processo stazionario Y t che<br />

soddisfi l’equazione Yt Yt1 At<br />

.<br />

In caso invece sia 1,<br />

allora esiste un processo stazionario Y t che soddisfi l‟equazione e<br />

che sarà dato dalla soluzione stabile

<strong>Serie</strong> <strong>Storiche</strong> e <strong>Processi</strong> <strong>Stocastici</strong> – Federico Andreis<br />

1 2<br />

2 3<br />

3<br />

<br />

c1 <br />

A A<br />

2<br />

A<br />

3<br />

A ...<br />

Y c A c A c A c A ... <br />

t t t t t<br />

tt1<br />

t2 t3<br />

<br />

j<br />

Tale soluzione può essere vista come un processo MA( ) con . Qualora la condizione<br />

1 sia soddisfatta, allora avremo<br />

j 1<br />

<br />

1<br />

<br />

<br />

<br />

j<br />

j0 j0<br />

La convergenza di questa serie garantisce l‟esistenza della rappresentazione MA( ) e<br />

l‟ergodicità rispetto alla media del processo AR (1) .<br />

Calcolando il valore atteso della soluzione otteniamo che<br />

Dunque la media di un processo (1)<br />

La varianza invece è<br />

mentre la h-esima autocovarianza vale<br />

<br />

E Yt c1 0 0 ...<br />

AR stazionario vale c 1 <br />

.<br />

t<br />

2<br />

t t1 2<br />

t2 3<br />

t3<br />

... <br />

2 4 6 2<br />

1 ... <br />

<br />

2<br />

<br />

2 1 0<br />

E Y E A A A A <br />

t th t t1 2<br />

t2 ...<br />

h<br />

th h1 th 1 h2<br />

th 2<br />

... <br />

2<br />

At h Ath1 At<br />

h2 ... <br />

E Y Y E A A A A A A <br />

<br />

<br />

<br />

<br />

h h2h4 2<br />

... <br />

<br />

<br />

<br />

<br />

h 2 4 2<br />

1 ... <br />

1 <br />

<br />

<br />

<br />

h 2 2<br />

h<br />

Segue immediatamente l‟espressione della funzione di autocorrelazione, pari a<br />

0<br />

<br />

<br />

<br />

<br />

h 2 2 h 2 2<br />

<br />

11 h<br />

h<br />

h <br />

<br />

2 2 2 2<br />

11 j<br />

2

<strong>Serie</strong> <strong>Storiche</strong> e <strong>Processi</strong> <strong>Stocastici</strong> – Federico Andreis<br />

la quale rispetta la condizione di convergenza a 0, sotto ipotesi di stazionarietà, dal momento<br />

che si è supposto 1.<br />

Sono stati simulati quattro processi autoregressivi del primo ordine sotto ipotesi di<br />

stazionarietà, media nulla e con rumore bianco gaussiano; di seguito le rappresentazioni<br />

grafiche delle serie storiche per un totale di 300 realizzazioni, con i rispettivi correlogrammi<br />

(ACF) e correlogrammi parziali (Partial ACF).<br />

Si noti come le funzioni di autocorrelazione decrescono progressivamente e lentamente<br />

verso lo zero (l‟alternanza dei segni dipende unicamente dal segno del parametro ), questa è<br />

una caratteristica tipica dei processi di tipo AR ; le funzioni di autocorrelazione parziale invece<br />

presentano un solo valore significativamente al di fuori delle bande di confidenza, il primo,<br />

questo ci fornisce l‟indicazione che si tratti di processi del primo ordine. Nelle Partial ACF i<br />

valori successivi al primo non sono nulli come vorrebbe la teoria, ma questo è imputabile al<br />

caso, possiamo accettare l‟ipotesi di in correlazione temporale per lag superiori a 1 dal<br />

momento che, appunto, i valori della funzione non superano le bande di confidenza (è<br />

accettabile inoltre un valore “anomalo” ogni 20 lag, purché superi in modo non significativo i<br />

valori limite)

<strong>Serie</strong> <strong>Storiche</strong> e <strong>Processi</strong> <strong>Stocastici</strong> – Federico Andreis

<strong>Serie</strong> <strong>Storiche</strong> e <strong>Processi</strong> <strong>Stocastici</strong> – Federico Andreis<br />

Cosa succede però se la condizione di stazionarietà non è rispettata (ovvero se il parametro è<br />

tale che 1)?<br />

Il processo esplode. Nel grafico che segue sono state rappresentate le<br />

simulazioni di due processi autoregressivi con parametri superiori in modulo a 1, seppure di<br />

pochissimo.

<strong>Serie</strong> <strong>Storiche</strong> e <strong>Processi</strong> <strong>Stocastici</strong> – Federico Andreis<br />

Chiaramente la stazionarietà non è più rispettata, e sebbene le funzioni di autocorrelazione<br />

ed autocorrelazione parziale conservino un andamento che potremmo definire “ideale”, risulta<br />

evidente come l‟esplosione dei valori renda il modello assolutamente instabile.<br />

Analogamente al caso del processo a media mobile, possiamo estendere il concetto di<br />

autoregressione ad ordini superiori; rendiamo, cioè, significative informazioni sul processo più<br />

lontane nel tempo, fornendo loro pesi non nulli.<br />

Si definisce processo autoregressivo di ordine p e si indica con AR( p ) il seguente:<br />

Y c Y Y Y A<br />

t 1 t1 2 t2 ... p t p t<br />

Ovvero estendiamo ad un numero di p termini la somma pesata dei valori passati della nostra Y t ,<br />

con l‟aggiunta di un termine di disturbo white noise A t . Risulta evidente come il processo<br />

AR (1) presentato in precedenza altro non sia che un caso particolare di quest‟ultimo, con 0<br />

per 1<br />

j .<br />

A differenza del processo a media mobile, come si è già detto, la stazionarietà non è<br />

necessariamente rispettata; dobbiamo dunque imporre delle condizioni sui parametri del<br />

j

<strong>Serie</strong> <strong>Storiche</strong> e <strong>Processi</strong> <strong>Stocastici</strong> – Federico Andreis<br />

modello. In particolare richiederemo che i coefficienti j associati alle radici dell‟equazione<br />

omogenea associata<br />

2<br />

p<br />

1 12... p<br />

0<br />

siano tali da garantire che 1 j . In questo caso il processo non esplode e si mantiene<br />

j<br />

stazionario.<br />

Nel caso di un processo AR (2) questa condizione è graficamente rappresentabile in modo<br />

comprensibile; si tratta infatti della condizione che i due parametri 1 e 2 si trovino all‟interno<br />

del triangolo tratteggiato nella figura sottostantante.<br />

Sotto l‟ipotesi di stazionarietà il valore atteso del processo è:<br />

c<br />

EY <br />

t 1 ... <br />

1 2<br />

e sfruttando questa espressione l‟equazione che descrive il processo può essere riscritta nel<br />

modo seguente:<br />

<br />

Y Y Y Y A<br />

t 1 t 1 2 t 2 ... p t p t<br />

Le autocovarianze si possono quindi ottenere semplicemente moltiplicando ambo i membri<br />

Y e prendendone i valori attesi; ne risulta che:<br />

dell‟ultima equazione per <br />

th 1 h1 2 h2 ... p h p h 1,2,...<br />

h <br />

2<br />

1 1 2 2 ... pp h 0<br />

p<br />

) questo<br />

Sfruttando la nota proprietà di simmetria della funzione di autocovarianza ( h h<br />

sistema di equazioni può essere risolto per<br />

2<br />

0, 1,..., p in funzione di , 1, 2,..., p . Per<br />

ricavare la funzione di autocorrelazione basterà dividere per 0 , quindi:

chiaramente 0 1 .<br />

<strong>Serie</strong> <strong>Storiche</strong> e <strong>Processi</strong> <strong>Stocastici</strong> – Federico Andreis<br />

<br />

h 1 h1 2 h2 ... p h p<br />

L‟espressione precedente, esplicitata per h 1,2,... , dà origine al cosiddetto sistema di<br />

equazioni di Yule-Walker, che costituisce lo strumento fondamentale per la stima dei parametri<br />

del modello autoregressivo. Come già detto è possibile, noti che siano i parametri e la varianza<br />

del disturbo, stimare i valori della funzione di autocovarianza (e quindi di autocorrelazione); ciò<br />

che risulta invece di effettivo interesse operativo è proprio l‟operazione inversa, in effetti noi<br />

disponiamo della serie storica dei dati dalla quale, come si è già mostrato negli esempi, si<br />

possono stimare i valori della funzione di autocorrelazione. Tramite il sistema di equazioni di<br />

Yule-Walker abbiamo quindi la possibilità di stimare i parametri (ignoti) del modello<br />

autoregressivo che meglio approssimi il processo stocastico (a tutti gli effetti inconoscibile nella<br />

sua completezza) di cui la serie storica rappresenta una realizzazione finita.<br />

Il sistema di equazioni di Yule-Walker si presenta in forma lineare per il processo<br />

autoregressivo, e può essere esplicitato come segue:<br />

1 1 2 1 3 2 ... <br />

pp1 <br />

2 11 2 3 1 ... <br />

pp2 <br />

<br />

.....<br />

<br />

.....<br />

<br />

p 1 p1 2 p2 3 p3 ... <br />

<br />

p<br />

Dunque potremo sostituire ai valori j le loro stime ˆ j ottenute dalla serie storica, ed<br />

ottenere quindi le stime ˆ j dei parametri del modello. Si noti inoltri che la soluzione è unica, dal<br />

momento che la matrice del sistema altro non è che la matrice di Toeplitz di ordine p, P ( p)<br />

, la<br />

quale è definita positiva per ogni p quando il processo è stazionario.<br />

L‟approccio di Yule-Walker per la stima dei parametri è applicabile anche ai processi a<br />

media mobile, si ricava però un sistema non lineare di equazioni, che richiede una procedura di<br />

calcolo iterativa particolare. Risulta così più laborioso determinare le stime ˆ j, j 1,2,..., q in<br />

base a stime delle autocorrelazioni ˆ j, j 1,2,..., q determinate dall‟evidenza campionaria (la<br />

nostra serie storica).<br />

Seguono alcuni esempi di processi autoregressivi del secondo ordine; le considerazioni sono<br />

esattamente le stesse già presentate per quelli del primo ordine (stazionarietà, media nulla,<br />

disturbo white noise gaussiano). Le quattro simulazioni sono state effettuate con alternanza di<br />

segni dei parametri 1, 2 per rendere evidenti le differenti forme delle funzioni di<br />

autocorrelazione.

<strong>Serie</strong> <strong>Storiche</strong> e <strong>Processi</strong> <strong>Stocastici</strong> – Federico Andreis

<strong>Serie</strong> <strong>Storiche</strong> e <strong>Processi</strong> <strong>Stocastici</strong> – Federico Andreis<br />

Abbiamo presentato in precedenza la condizione affinché un processo autoregressivo del<br />

, si trovi all‟interno del<br />

secondo ordine sia stazionario, ovvero che il punto di coordinate 1 2<br />

triangolo tratteggiato in figura. Analogamente al caso dei processi di tipo AR 1 anche quelli di<br />

ordine superiore esplodono qualora non siano rispettate le condizioni sui parametri, ne vediamo<br />

di seguito qualche esempio grafico:

<strong>Serie</strong> <strong>Storiche</strong> e <strong>Processi</strong> <strong>Stocastici</strong> – Federico Andreis

<strong>Serie</strong> <strong>Storiche</strong> e <strong>Processi</strong> <strong>Stocastici</strong> – Federico Andreis<br />

Volendo riassumere brevemente quanto detto finora possiamo sottolineare il carattere di<br />

dualità tra i processi AR e MA .<br />

I processi di tipo AR rispondono al tentativo di spiegare il presente in funzione del<br />

passato, fino ad una certa “distanza” p, per contro i modelli di tipo MA rappresentano un<br />

tentativo di spiegare il presente come risultante da una successione incontrollata di<br />

impulsi casuali, statisticamente riassunti nel white noise A t .<br />

In un processo AR( p ) non sono imposte condizioni per i parametri in modo da<br />

assicurare l‟invertibilità, mentre si richiedono per la stazionarietà.<br />

In un processo MAq non sono imposte condizioni sui parametri per quanto riguarda la<br />

stazionarietà, mentre le si impongono per l‟invertibilità.<br />

Per ogni processo AR( p ) stazionario esiste una rappresentazione unica del tipo<br />

MA , e per ogni processo MAq invertibile ne esiste una del tipo AR .<br />

Nei processi MAq teorici il correlogramma si annulla bruscamente per h q,<br />

il<br />

correlogramma parziale invece decresce lentamente con andamento dipendente dal<br />

segno dei parametri j .<br />

Nei processi AR( p ) teorici il correlogramma parziale si annulla bruscamente per h q<br />

mentre il correlogramma decresce lentamente con andamento dipendente dal segno dei<br />

parametri j .<br />

All‟atto pratico si considerano come nulle, al fine dell‟identificazione del modello a<br />

partire dai dati, quelle autocorrelazioni che restino comprese fra le due bande tratteggiate<br />

nei correlogrammi, con un livello di confidenza del 95%.<br />

I Modelli Autoregressivi a Media Mobile<br />

Un modello del tipo autoregressivo a media mobile di ordini p e q, indicato con<br />

ARMA( p, q ) , è un costrutto statistico che comprende sia termini autoregressivi che a media<br />

mobile e può essere espresso come segue:<br />

Y c Y Y ... Y A A A ... A<br />

t 1 t1 2 t2 p t p t 1 t1 2 t2 q tq Per comodità di rappresentazione introduciamo ora l‟operatore retrocessore o backward B<br />

secondo la seguente definizione:<br />

0<br />

B X t Yt<br />

BX Y<br />

t t1<br />

2<br />

B X t Yt2<br />

...<br />

k<br />

B X t Yt<br />

k<br />

Trattandosi di un operatore lineare vale la seguente: <br />

0 1B Xt 0X t 1X t1<br />

.<br />

Se consideriamo il processo MA( q ) Y t con media supposta nulla possiamo scriverlo<br />

sfruttando l‟operatore B come

<strong>Serie</strong> <strong>Storiche</strong> e <strong>Processi</strong> <strong>Stocastici</strong> – Federico Andreis<br />

Y A A A ... <br />

A<br />

t t 1 t1 2 t2 q tq Y A BA B A ... <br />

B A<br />

2<br />

q<br />

t t 1 t 2 t q t<br />

Y<br />

<br />

B<br />

<br />

A<br />

<br />

Y B A<br />

q<br />

t 1j j1<br />

j<br />

t<br />

t t<br />

mentre un processo AR( p ) Y t con termine c pari a zero può essere rappresentato come<br />

Y Y Y ... Y A<br />

t 1 t1 2 t2 p t p t<br />

Y BY B Y ... B Y A<br />

2<br />

p<br />

t 1 t 2 t p t t<br />

<br />

p<br />

j<br />

1jBYt At<br />

j1<br />

<br />

<br />

B Y A<br />

t t<br />

Notiamo anche in questa sede la dualità già discussa in precedenza: le funzioni B e<br />

B sono dei filtri lineari che, in questa formulazione, nel caso dei modelli AR( p ) filtrano<br />

l‟informazione passata e restituiscono “l‟innovazione” sotto forma di un rumore bianco, nel<br />

caso dei modelli MA( q ) filtrano i disturbi passati e restituiscono l‟informazione al tempo<br />

presente. L‟utilità di questa rappresentazione risulta evidente qualora ci interessasse ricavare i<br />

parametri del modello di ordine infinito di tipo AR associato al MA di ordine finito (qualora<br />

sia rispettata l‟invertibilità) o viceversa; si noti infatti che le relazioni definite prima permettono<br />

di scrivere:<br />

B Yt<br />

At<br />

B B At At<br />

BB1 B 1BB1B <br />

<br />

<br />

<br />

Seguendo la notazione appena introdotta potremo quindi esprimere il processo di tipo<br />

ARMA( p, q ) come segue:<br />

Y Y Y ... Y c A A A ... <br />

A<br />