GEOmedia_5_2018

La prima rivista italiana di geomatica.

La prima rivista italiana di geomatica.

You also want an ePaper? Increase the reach of your titles

YUMPU automatically turns print PDFs into web optimized ePapers that Google loves.

Rivista bimestrale - anno XXII - Numero 5/<strong>2018</strong> - Sped. in abb. postale 70% - Filiale di Roma<br />

TERRITORIO CARTOGRAFIA<br />

GIS<br />

CATASTO<br />

3D<br />

INFORMAZIONE GEOGRAFICA<br />

FOTOGRAMMETRIA<br />

URBANISTICA<br />

GNSS<br />

BIM<br />

RILIEVO TOPOGRAFIA<br />

CAD<br />

REMOTE SENSING SPAZIO<br />

EDILIZIA<br />

WEBGIS<br />

UAV<br />

SMART CITY<br />

AMBIENTE<br />

NETWORKS<br />

LiDAR<br />

BENI CULTURALI<br />

LBS<br />

Sett/Ott <strong>2018</strong> anno XXII N°5<br />

La prima rivista italiana di geomatica e geografia intelligente<br />

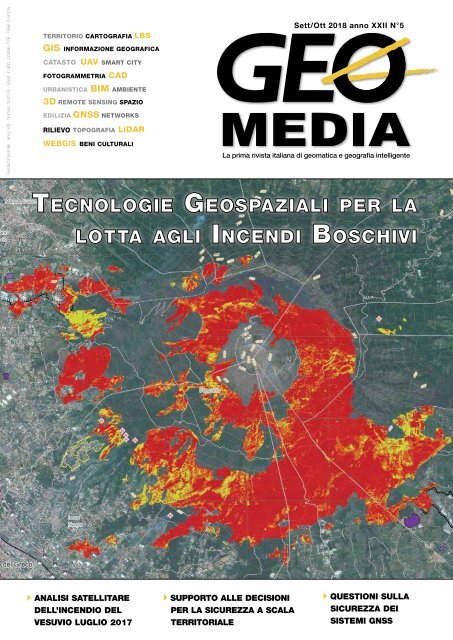

Tecnologie Geospaziali per la<br />

lotta agli Incendi Boschivi<br />

ANALISI SATELLITARE<br />

DELL’INCENDIO DEL<br />

VESUVIO LUGLIO 2017<br />

SUPPORTO ALLE DECISIONI<br />

PER LA SICUREZZA A SCALA<br />

TERRITORIALE<br />

QUESTIONI SULLA<br />

SICUREZZA DEI<br />

SISTEMI GNSS

X-PAD Ultimate<br />

Tutto in un unico software<br />

X-PAD Ultimate è un software modulare, facile da<br />

usare per lavori topografici e del cantiere, come rilievi,<br />

tracciamenti, catasto, controlli BIM, strade, mappe,<br />

batimetria e GIS.<br />

Il software è disponibile sulla piattaforma Android e<br />

porta le migliori tecnologie direttamente in campo<br />

nella tua mano: una completa visualizzazione 3D ed<br />

un sistema CAD per visualizzare e modificare i disegni,<br />

integrazione dei tuoi dati con tutte le tipologie di<br />

mappe, supporti per la realtà aumentata e molto altro.<br />

XPad Ultimate ti assicura la produttività e ti permette di<br />

avere una perfetta integrazione con tutti gli strumenti.<br />

Disponibile in due versioni, una dedicata a chi lavora nel<br />

campo della topografia ed una dedicata alle imprese di<br />

costruzioni, offrendo ad entrambi delle caratteristiche<br />

dedicate.<br />

geomax-positioning.it<br />

©<strong>2018</strong> Hexagon AB and/or its subsidiaries<br />

and affiliates. All rights reserved.<br />

Per trovare un distributore nella vostra zona, visitate il nostro sito web: geomax-positioning.it

Quintilioni di dati nel mondo del geospatial<br />

L'industria mondiale del geospatial continua a crescere e non ci sono segni al momento di una<br />

probabile recessione. Contemporaneamente cresce la quantità di dati che produciamo ogni giorno,<br />

raggiungendo numeri sbalorditivi.<br />

Ci sono 2,5 quintilioni di byte di dati creati ogni giorno, ma questo numero è destinato a crescere<br />

con l'Internet of Things (IoT). Bernard Marr su Forbes, poco tempo fa diceva che solo negli ultimi<br />

due anni è stato generato il 90% dei dati nel mondo. E i quintilioni nel gergo di Forbes dovrebbero<br />

corrispondere a 10 elevato alla 30a potenza e non alla 18a potenza, come invece si usa in Italia<br />

definendo un quintilione uguale a miliardo di miliardi. Un numero talmente grande che si stenta<br />

anche a definire in modo univoco.<br />

Oltre 3,7 miliardi di esseri umani utilizzano Internet con un tasso di crescita annuo del 7,5%. In<br />

tutto il mondo ci sono 5 miliardi di ricerche al giorno. In media, Google elabora più di 40.000<br />

ricerche ogni secondo (3,5 miliardi di ricerche al giorno). Mentre il 77% delle ricerche sono<br />

condotte su Google, sarebbe trascurato non ricordare che anche altri motori di ricerca stanno<br />

contribuendo alla nostra generazione quotidiana di dati.<br />

Per non parlare dei social, tra i quali non possiamo non notare l’impressionante crescita di<br />

Instagram di proprietà ora del grande social network Facebook (2 miliardi di utenti attivi) che ha<br />

superato i 600 milioni di utenti attivi, definiti Instagrammers, 400 milioni di persone che ogni<br />

giorno condividono su Instagram 95 milioni di foto e video.<br />

L'Internet of Things con i suoi dispositivi "intelligenti" connessi, sta esplodendo passando da 2<br />

miliardi di dispositivi nel 2006 a 200 miliardi previsti entro il 2020.<br />

Tutto il flusso dei dati è relazionato al “dove”, in un modo approssimato o preciso in funzione della<br />

situazione governata dal geospatial. Un mondo i cui attori hanno business evoluti, come abbiamo<br />

visto nell'ultima fiera INTERGEO che ha raggruppato oltre 20.000 partecipanti provenienti da<br />

oltre 100 paesi del mondo, o come ha dimostrato recentemente a Las Vegas la Trimble Dimensions<br />

<strong>2018</strong> User Conference, che con un evento di tre giorni ha riunito oltre 4.400 partecipanti. Oltre<br />

18.000 persone hanno partecipato alla recente Esri User Conference negli USA con il motto diffuso<br />

“Science of Where”.<br />

La richiesta di mappe dettagliate, aggiornate e tridimensionali di città, strade e grandi strutture è in<br />

costante crescita. Questa domanda è anche alimentata dalla continua diminuzione esponenziale del<br />

costo della raccolta di nuvole di punti raccolte da sistemi di mappatura mobile, solitamente montati<br />

su un'automobile, un furgone o altro veicolo che può viaggiare alla normale velocità del traffico<br />

su strade e autostrade. Inoltre la continua miniaturizzazione di sensori ed elettronica connessa sta<br />

portando alla costruzione di scanner laser che sono abbastanza leggeri da essere montati su sistemi<br />

aerei senza equipaggio, ma anche su zaini o aste tenute in mano per catturare stanze, corridoi e<br />

molti altri spazi interni o esterni.<br />

Oggi il rilievo, con l'acquisizione di nuvole di punti, non è più un dominio esclusivo degli<br />

specialisti della geomatica. La chiave di questa evoluzione è nei sensori affidabili e facili da usare,<br />

accompagnati da software sempre più intelligenti. Di conseguenza il ruolo dello specialista<br />

geomatico si sta spostando da operatore a consulente e sviluppatore di software.<br />

Lo spettro delle conoscenze riguarda la comprensione del nocciolo dei dati geospaziali, la loro<br />

fusione con altri dati e le esigenze di archiviazione delle grandi moli di dati.<br />

Una corretta analisi di questi dati, può servire certamente a direzionare flussi commerciali,<br />

rispondere ad esigenze della popolazione, indirizzare la necessaria pianificazione del territorio, oltre<br />

che a rispondere alla primaria esigenza di analisi per la prevenzione e la difesa della popolazione<br />

dagli eventi catastrofici.<br />

Buona lettura,<br />

Renzo Carlucci

In questo<br />

numero...<br />

FOCUS<br />

REPORT<br />

LE RUBRICHE<br />

Tecnologie<br />

geospaziali per<br />

l’ottimizzazione della<br />

DISTRIBUZIONE di<br />

risorse (squadre a terra<br />

e Dos) per la lotta agli<br />

incendi boschivi nella<br />

rete delle sedi del<br />

Corpo Nazionale dei<br />

Vigili del Fuoco<br />

di Michele Fasolo<br />

6<br />

46 AGENDA<br />

Nello sfondo vediamo Città<br />

del Messico ripresa dalla<br />

missione Sentinel-1 del<br />

programma europeo Copernicus.<br />

Questa capitale<br />

intensamente popolata e di<br />

grandi dimensioni si può riconoscere<br />

nella parte in alto a<br />

destra dell’immagine. Ospita<br />

quasi 9 milioni di abitanti,<br />

con l’area metropolitana circostante<br />

- chiamata Greater<br />

Mexico City - in cui si registra<br />

una popolazione di oltre 21<br />

milioni di individui. Questa<br />

circostanza la rende la città di<br />

lingua ispanica più grande al<br />

mondo. (Credits ESA)<br />

16<br />

Studio<br />

comparativo tra<br />

lo stato dei luoghi<br />

prima e dopo<br />

l’incendio del<br />

Vesuvio tramite<br />

analisi satellitare<br />

di Massimiliano Moraca,<br />

Antonio Pepe<br />

In copertina, la mappa di<br />

valutazione dei danni "damage<br />

grade assesment" nell'area del<br />

Vesuvio derivata da immagini<br />

satellitare GeoEye Pre-event<br />

image: GeoEye © Digital Globe,<br />

Inc. (2016) (26/04/2016 at 10:01,<br />

GSD 0.5 m, 21.8° off-nadir angle)<br />

fornita in COPERNICUS by the<br />

European Union and ESA.<br />

Post-event image: WorldView-2<br />

© Digital Globe, Inc. (2017)<br />

(16/07/2017 at 09:49, GSD 0.5<br />

m, 26.6° off-nadir angle) fornita in<br />

COPERNICUS by the European<br />

Union and ESA.<br />

30<br />

Sicurezza a scala<br />

territoriale: il ruolo<br />

degli strumenti<br />

di supporto alle<br />

decisioni<br />

di Stefano Marsella,<br />

Marcello Marzoli<br />

geomediaonline.it<br />

<strong>GEOmedia</strong>, bimestrale, è la prima rivista italiana di geomatica.<br />

Da 20 anni pubblica argomenti collegati alle tecnologie dei<br />

processi di acquisizione, analisi e interpretazione dei dati,<br />

in particolare strumentali, relativi alla superficie terrestre.<br />

In questo settore <strong>GEOmedia</strong> affronta temi culturali e tecnologici<br />

per l’operatività degli addetti ai settori dei sistemi informativi<br />

geografici e del catasto, della fotogrammetria e cartografia,<br />

della geodesia e topografia, del telerilevamento aereo e<br />

spaziale, con un approccio tecnico-scientifico e divulgativo.

INSERZIONISTI<br />

34 "...IN ERRORE<br />

PERSEVERARE"<br />

di Attilio Selvini<br />

aerRobotix 26<br />

Epsilon 41<br />

Esri Italia 37<br />

Geogrà 29<br />

3DTarget 27<br />

Geomax 2<br />

GIS3W 33<br />

Gter 24<br />

Planetek Italia 15<br />

Elaborazione di<br />

Piattaforma GIS<br />

sul fattore di<br />

Rischio alluvionale<br />

nel comprensorio<br />

del Comune di<br />

Sora (Fr)<br />

di Fabio Cuzzocrea,<br />

38<br />

Stonex 47<br />

Studio SIT 36<br />

Teorema 46<br />

Topcon 48<br />

Stefano Lucidi<br />

42<br />

Aspetti di sicurezza<br />

nell'utilizzo dei<br />

sistemi di navigazione<br />

satellitare<br />

di Mauro Leonardi<br />

28<br />

L'aerofototeca<br />

nazionale racconta…<br />

la telefotografia,<br />

prima della Grande<br />

Guerra<br />

di Elizabeth J. Shepherd<br />

ERRATA CORRIGE<br />

Nel numero precedente <strong>GEOmedia</strong> 4 <strong>2018</strong> a pag. 5 nel sommario invece<br />

di "Giovanni Nicolai” si legga “Francesca Pompilio” come autore nella<br />

rubrica l'aerofototeca nazionale racconta...<br />

una pubblicazione<br />

Science & Technology Communication<br />

Direttore<br />

RENZO CARLUCCI, direttore@rivistageomedia.it<br />

Comitato editoriale<br />

Vyron Antoniou, Fabrizio Bernardini, Mario Caporale,<br />

Luigi Colombo, Mattia Crespi, Luigi Di Prinzio, Michele<br />

Dussi, Michele Fasolo, Marco Lisi, Flavio Lupia, Luigi<br />

Mundula, Beniamino Murgante, Aldo Riggio, Mauro<br />

Salvemini, Domenico Santarsiero, Attilio Selvini,<br />

Donato Tufillaro<br />

Direttore Responsabile<br />

FULVIO BERNARDINI, fbernardini@rivistageomedia.it<br />

Redazione<br />

VALERIO CARLUCCI, GIANLUCA PITITTO,<br />

redazione@rivistageomedia.it<br />

Diffusione e Amministrazione<br />

TATIANA IASILLO, diffusione@rivistageomedia.it<br />

Comunicazione e marketing<br />

ALFONSO QUAGLIONE, marketing@rivistageomedia.it<br />

Progetto grafico e impaginazione<br />

DANIELE CARLUCCI, dcarlucci@rivistageomedia.it<br />

MediaGEO soc. coop.<br />

Via Palestro, 95 00185 Roma<br />

Tel. 06.64871209 - Fax. 06.62209510<br />

info@rivistageomedia.it<br />

ISSN 1128-8132<br />

Reg. Trib. di Roma N° 243/2003 del 14.05.03<br />

Stampa: SPADAMEDIA srl<br />

VIA DEL LAVORO 31, 00043 CIAMPINO (ROMA)<br />

Editore: mediaGEO soc. coop.<br />

Condizioni di abbonamento<br />

La quota annuale di abbonamento alla rivista Science è di € & 45,00. Technology Communication<br />

Il prezzo di ciascun fascicolo compreso nell’abbonamento è di € 9,00. Il prezzo di<br />

ciascun fascicolo arretrato è di € 12,00. I prezzi indicati si intendono Iva inclusa.<br />

L’editore, al fine di garantire la continuità del servizio, in mancanza di esplicita<br />

revoca, da comunicarsi in forma scritta entro il trimestre seguente alla scadenza<br />

dell’abbonamento, si riserva di inviare il periodico anche per il periodo successivo.<br />

La disdetta non è comunque valida se l’abbonato non è in regola con i pagamenti.<br />

Il rifiuto o la restituzione dei fascicoli della Rivista non costituiscono disdetta<br />

dell’abbonamento a nessun effetto. I fascicoli non pervenuti possono essere<br />

richiesti dall’abbonato non oltre 20 giorni dopo la ricezione del numero successivo.<br />

Gli articoli firmati impegnano solo la responsabilità dell’autore. È vietata la<br />

riproduzione anche parziale del contenuto di questo numero della Rivista in<br />

qualsiasi forma e con qualsiasi procedimento elettronico o meccanico, ivi inclusi i<br />

sistemi di archiviazione e prelievo dati, senza il consenso scritto dell’editore.<br />

Rivista fondata da Domenico Santarsiero.<br />

Numero chiuso in redazione il 5 Dicembre <strong>2018</strong>.

FOCUS<br />

FOCUS<br />

Tecnologie geospaziali per<br />

l’ottimizzazione della<br />

distribuzione<br />

distribuione di risorse (squadre<br />

a terra e Dos) per la lotta agli<br />

incendi boschivi nella rete<br />

delle sedi del Corpo<br />

Nazionale dei Vigili del Fuoco<br />

di Michele Fasolo<br />

Fig. 1 - Territorio del comune di Patti (ME) percorso dal<br />

fuoco nell’incendio del 30.06.2017 (rielaborazione in falsi<br />

colori immagine Sentinel 2A del 03.08.2017 con combinazione<br />

di bande nell’infrarosso. Aree percorse dal fuoco in<br />

verde scuro).<br />

Negli ultimi decenni la<br />

letteratura sui sistemi di<br />

soccorso ha registrato<br />

un grandissimo numero<br />

di contributi che hanno<br />

utilizzato, pur declinandola<br />

secondo prospettive<br />

differenti, la Teoria delle code<br />

per approntare procedure e<br />

modelli utili a comprenderne<br />

il comportamento, misurare<br />

e ottimizzare le prestazioni<br />

in termini di efficienza del<br />

servizio reso nel territorio da<br />

queste particolari strutture<br />

sistemiche così importanti<br />

sotto il profilo sociale. Si<br />

tratta di strutture molto<br />

complesse a causa dei fattori<br />

prevedibili e imprevedibili di<br />

variabilità che vi intervengono<br />

sia a livello di numero di<br />

richieste che di tempo<br />

Il problema fondamentale<br />

che si pone nell’analisi e<br />

nella modellazione teorica è<br />

proprio il loro essere caratterizzate<br />

dall’irrompere casuale nel<br />

loro sistema di quegli eventi che<br />

determinano la loro attivazione,<br />

con la possibilità di formazione<br />

di una coda (o fila) in attesa,<br />

quando il numero di eventi diviene<br />

troppo elevato o troppo<br />

concentrato nell’unità di tempo<br />

in rapporto alle risorse operative<br />

disponibili per lo svolgimento<br />

del servizio richiesto. L’obiettivo<br />

dello studio di questi sistemi è<br />

dunque finalizzato all’analisi dei<br />

regimi di servizio per dimensionare<br />

correttamente le risorse al<br />

fine di far fronte alle richieste<br />

nella misura più efficace possibile,<br />

nel rispetto dei vincoli<br />

complessivi (quali p.e. il numero<br />

complessivo di risorse impiegabili<br />

o il livello minimo accettabile<br />

della qualità di risposta che il<br />

sistema deve poter garantire) .<br />

Sorge dunque la necessità di<br />

calcolare su base probabilistica<br />

una distribuzione ottima delle<br />

risorse tra i vari nodi della rete in<br />

modo che queste non risultino<br />

carenti laddove sarebbero previsionalmente<br />

più necessarie e,<br />

al contrario, poi effettivamente<br />

sottoutilizzate laddove alla luce<br />

delle probabili esigenze si presentino<br />

sovrabbondanti. Una distribuzione<br />

ottima basata in ogni<br />

caso su criteri oggettivi, razionali<br />

e scientifici. e supportata da consolidati<br />

modelli matematici.<br />

necessario a soddisfarle.<br />

Figg. 2,3 - Patti (ME) incendio boschivo del 30.06.2017.<br />

6 6 <strong>GEOmedia</strong> n°5-<strong>2018</strong> n°4-<strong>2018</strong>

FOCUS<br />

Una possibile soluzione è<br />

quella di costruire un modello<br />

matematico (analitico) di ottimizzazione,<br />

di tipo stocastico,<br />

attraverso variabili e relazioni<br />

logico–matematiche che siano<br />

corrispondenti alle relazioni del<br />

modo reale, in grado di descrivere<br />

in modo semplificato ma<br />

soddisfacente il funzionamento<br />

e i fenomeni che lo influenzano<br />

e supportare le eventuali decisioni<br />

a riguardo.<br />

La teoria delle code con l’applicazione<br />

del tipo di modello di<br />

file d’attesa (c.d. a code) risponde<br />

con risultati convincenti a<br />

tali esigenze. Consente infatti di<br />

misurare le prestazioni in termini<br />

di efficienza del servizio reso<br />

nel territorio di competenza da<br />

ciascun nodo della rete.<br />

Tra i metodi possibili si propone<br />

qui e si valuta un procedimento<br />

dedicato di ottimizzazione fondato<br />

sulla “Teoria delle Code”,<br />

formulato come problema di<br />

Programmazione Lineare, .denominato<br />

dal suo autore Fabrizio<br />

Di Liberto, “Metodo delle<br />

Code”.<br />

Il metodo è stato applicato nel<br />

contesto della lotta attiva agli<br />

incendi boschivi per affrontare<br />

il problema della dotazione<br />

operativa ottimale delle sedi del<br />

Corpo nazionale dei vigili del<br />

fuoco (CNVVF) esistenti sul<br />

territorio italiano, in termini di<br />

squadre antincendio boschivo<br />

(AIB) e di direttori delle operazioni<br />

di spegnimento (DOS), in<br />

base alle necessità di copertura<br />

operativa conseguenti alla analisi<br />

di rischio di incendio nel<br />

territorio e delle capacità di servizio<br />

delle sedi, entrambe elaborate<br />

utilizzando le statistiche del<br />

fenomeno negli ultimi anni.<br />

zionalmente è stato utilizzato<br />

dall’uomo per sfruttare l’ambiente<br />

naturale modificandolo a<br />

proprio vantaggio.<br />

Anche il territorio italiano è<br />

afflitto ogni anno da incendi<br />

devastanti che interessano decine<br />

di migliaia di ettari di zone<br />

boscate e in generale vegetate,<br />

costituendo una tra le più impegnative<br />

criticità ambientali con<br />

cui devono confrontarsi i cittadini<br />

e le istituzioni.<br />

Un’emergenza che va affrontata<br />

su più piani, da quello sociale<br />

ed economico, a quello della<br />

repressione criminale per i tantissimi<br />

eventi dolosi e le attività<br />

delle ecomafie, con il concorso<br />

sinergico di più attori istituzionali<br />

con il rafforzamento delle<br />

attività di programmazione e di<br />

prevenzione.<br />

Quadro normativo e nuove<br />

competenze del CNVVF<br />

In Italia la normativa in materia<br />

di incendi boschivi è risultata<br />

per molti anni insufficiente e<br />

inadeguata alla gravità del fenomeno<br />

sino all’approvazione<br />

della legge 21 novembre 2000,<br />

n. 353 (Legge-quadro sugli<br />

incendi boschivi), che ha apportato<br />

importantissimi elementi<br />

di innovazione e di contrasto<br />

all’aberrante circolo vizioso<br />

degli interessi economici che<br />

sorgono intorno al fuoco tra cui<br />

quelli, affatto secondari, sintetizzati<br />

dall’ossimoro “bruciare<br />

per spegnere”. Tra gli aspetti<br />

più rilevanti stabiliti dalla legge<br />

quadro c’è il completo riordino<br />

delle competenze Stato-Regioni<br />

Fig. 4 - Superficie ha bruciata per anno; periodo 2010-2016<br />

( Fonte dati Corpo Forestale dello Stato le Regioni italiane a<br />

statuto ordinario).<br />

Fig. 5 - Numero incendi boschivi per quota sul s.l.m ogni<br />

100 km2 (Fonte dati Corpo Forestale dello Stato le Regioni<br />

italiane a statuto ordinario).<br />

Fig. 6 - Numero incendi boschivi per Regione; periodo<br />

2010-2016 (Fonte dati Corpo Forestale dello Stato le Regioni<br />

italiane a statuto ordinario).<br />

Gli incendi boschivi in Italia<br />

L’incendio boschivo è un fenomeno<br />

globale, sempre presente,<br />

comune a molti Paesi europei e<br />

in particolare a quelli del bacino<br />

del Mediterraneo dove tradicon<br />

trasferimento a queste ultime<br />

di tutte le competenze in<br />

materia di previsione, prevenzione<br />

e lotta attiva contro gli<br />

incendi boschivi, lasciando allo<br />

Stato il concorso in particolare<br />

allo spegnimento degli incendi<br />

con il supporto della flotta aerea<br />

antincendio di Stato. Ciascuna<br />

Tab. 1 - Distribuzione mensile numero incendi boschivi a livello regionale; periodo 2010-2016.<br />

<strong>GEOmedia</strong> n°5-<strong>2018</strong> n°4-<strong>2018</strong> 7

FOCUS<br />

Regione affronta il contrasto<br />

agli incendi boschivi secondo<br />

un’organizzazione peculiare e<br />

sulla base di norme regionali<br />

che prevedono anche la possibilità<br />

di stipulare specifiche<br />

convenzioni con enti pubblici<br />

ma anche privati come le associazioni<br />

di volontariato AIB<br />

Rispetto a questo impianto<br />

normativo che individua nelle<br />

Regioni i soggetti responsabili<br />

dello spegnimento a terra, lasciando<br />

allo Stato il concorso<br />

con la flotta aerea di Stato, la<br />

revisione normativa apportata<br />

dal decreto legislativo 19 agosto<br />

2016 n. 177 con l’assorbimento<br />

del Corpo Forestale dello Stato<br />

nell’Arma dei carabinieri, e il<br />

contestuale trasferimento al<br />

Corpo Nazionale dei Vigili del<br />

fuoco (CNVVF) delle competenze<br />

CFS in tema di lotta<br />

attiva agli incendi boschivi<br />

ha comportato il mutamento<br />

dell’interlocutore statale, oggi<br />

unicamente il CNVVF, per<br />

la estinzione degli incendi, la<br />

direzione delle operazioni di<br />

spegnimento, il coordinamento<br />

Fig. 7 - Suddivisione del territorio italiano mediante<br />

il metodo dei poligoni di Thiessen, imperniati sulla<br />

posizione delle 459 sedi territoriali VVF<br />

delle forze regionali di volontariato,<br />

la collaborazione all’interno<br />

di ciascuna Sala operativa<br />

unificata permanente (SOUP).<br />

Il concorso del CNVVF al<br />

dispositivo di antincendio boschivo<br />

delle Regioni e degli Enti<br />

parco viene regolato attraverso<br />

accordi di programma che fanno<br />

riferimento alle principali<br />

norme in materia di antincendio<br />

boschivo.<br />

Unitamente al d.lgs.177/2016<br />

la revisione del d.lgs 139/2006<br />

ha reso necessario per il<br />

CNVVF la predisposizione di<br />

un dispositivo coordinato di<br />

risposta in materia AIB con una<br />

revisione e un rafforzamento<br />

degli assetti organizzativi e funzionali<br />

con una distribuzione<br />

mirata del personale..<br />

L’attuale dislocazione sul<br />

territorio delle strutture del<br />

CNVVF è infatti studiata per<br />

il soccorso tecnico urgente alle<br />

popolazioni, con una conseguente<br />

minore prossimità alle<br />

aree boschive che, solitamente,<br />

sono contraddistinte da un basso<br />

grado di urbanizzazione.<br />

In conclusione il problema è<br />

quello di individuare, al fine di<br />

rafforzare le azioni di prevenzione<br />

e di spegnimento un nuovo<br />

assetto ottimale del dispositivo<br />

di lotta attiva AIB rafforzandolo<br />

in particolare nelle Regioni e<br />

nelle Province a maggior rischio<br />

in modo da consentire, con<br />

interventi più rapidi a elevata<br />

capacità operativa in territori<br />

impervi e con poche vie di penetrazione,<br />

l’estinzione degli<br />

incendi nelle fasi iniziali, contenendo<br />

al minimo i danni.<br />

Di estrema importanza risulta<br />

in particolare il calcolo delle<br />

risorse aggiuntive da mettere<br />

in campo ovvero la stima delle<br />

esigenze da quantificare con le<br />

Regioni competenti e da definire<br />

negli Accordi Convenzionali<br />

da stipulare.<br />

Questo calcolo è stato impostato<br />

in questo studio a partire<br />

dalle statistiche degli incendi<br />

verificatisi nel periodo 2010-<br />

2016 nei singoli ambiti di<br />

competenza territoriale delle<br />

sedi VVF in particolare a partire<br />

dagli indici di rischio e dalla<br />

capacità relativa del sistema di<br />

servizio delle sedi.<br />

Il modello e la sua<br />

applicazione<br />

Secondo la procedura adottata<br />

in questo studio, applicando il<br />

Metodo delle Code, la rete dei<br />

presidi di soccorso territoriali è<br />

modellizzata come un network<br />

di sistemi di servizio cui giungono<br />

in istanti aleatori richieste<br />

di intervento. La Teoria delle<br />

Code è in grado di descrivere<br />

processi stocastici (cd. “senza<br />

memoria” o “markoviani”) di<br />

questo tipo di sistema di servizio<br />

a mezzo di equazioni differenziali<br />

ordinarie.<br />

Per approntare il modello si<br />

sono innanzitutto definiti i territori<br />

di competenza di ciascuna<br />

sede territoriale di soccorso<br />

tecnico urgente VVF (100<br />

Comandi + 358 distaccamenti<br />

permanenti + 1 distaccamento<br />

misto). Per farlo si è suddiviso<br />

(utilizzando la piattaforma<br />

ArcGis 10.5) il territorio italiano<br />

(dominio B=boundary)<br />

mediante il metodo dei poligoni<br />

di Thiessen, imperniati sulla<br />

posizione delle sedi territoriali<br />

VVF {m J<br />

}, in k entità di discretizzazione<br />

{b k<br />

} (nodi).<br />

Un altro possibile metodo di<br />

discretizzazione delle aree di<br />

competenza delle singole sedi di<br />

servizio, qui non utilizzato per<br />

ragioni di speditezza è quello di<br />

individuarle come porzioni di<br />

territorio accessibili dalla posizione<br />

di ciascuna sede stimate<br />

in funzione della rete stradale a<br />

parità di tempo rispetto a quella<br />

da ciascuna altra sede circostante<br />

e senza sovrapposizioni (superfici<br />

isocrone).<br />

8 <strong>GEOmedia</strong><br />

<strong>GEOmedia</strong><br />

n°4-<strong>2018</strong><br />

n°5-<strong>2018</strong>

FOCUS<br />

Si è comunque riscontrato che<br />

ciscun poligono della discretizzazione<br />

secondo il metodo di<br />

Thiessen corrisponde a un’area<br />

di accessibilità isocrona media<br />

di 28-30 minuti.<br />

A ciascuna sede territoriale del<br />

CNVVF {m J<br />

} è stata quindi<br />

assegnata una quantità {U J<br />

} di<br />

unità di soccorso (partenze o<br />

squadre) (due per i comandi e<br />

le sedi classificate SD5, una per<br />

tutte le altre) pronte all’impiego<br />

in caso di necessità conseguenti<br />

a incendi boschivi localizzati<br />

nell’intorno definito dal poligono<br />

corrispondente a ciascuna<br />

sede {R J<br />

} (raggio operativo).<br />

Per la ricerca si sono utilizzati i<br />

dati relativi ai 28.806 incendi<br />

censiti dal Corpo Forestale dello<br />

Stato nel territorio delle 15 Regioni<br />

a statuto ordinario negli<br />

anni dal 2010 al 2016 (archivio<br />

AIB-FN Foglio Notizie AntIncendi<br />

Boschivi). L’archivio AIB-<br />

FN è stato realizzato per vari<br />

decenni raccogliendo i dati che,<br />

il personale Forestale intervenuto<br />

sull’incendio e responsabile<br />

delle operazioni di spegnimento<br />

compilava dettagliatamente.<br />

Si tratta di una fonte di dati<br />

ricchissima di voci e quindi rilevante<br />

con informazioni omogenee<br />

e facilmente trattabili per<br />

l’elaborazione statistica.<br />

I dati sono stati riportati al<br />

contesto dell’attuale dispositivo<br />

di soccorso VVF a seguito<br />

delle nuove funzioni assegnate<br />

dal d.lgs.177/2016 e dalla revisione<br />

del d.lgs 139/2006. Per<br />

ciascuno dei 459 nodi-poligoni<br />

del dominio di discretizzazione<br />

i dati sono stati quindi geolocalizzati<br />

su piattaforma Gis,<br />

previa loro normalizzazione<br />

ed eliminazione di quelli non<br />

trattabili perché affetti da varie<br />

incongruenze,<br />

Si sono quindi analizzate al fine<br />

di calcolare le diverse variabili<br />

aleatorie del processo le occorrenze<br />

degli incendi boschivi che<br />

Fig. 8 - Particolare della discretizzazione di una porzione del territorio dell’Italia centrale attraverso il<br />

metodo dei poligoni di Thiessen imperniati sulla posizione delle sedi operative VVF (triangoli rossi) (in<br />

rosso gli ambiti dei Comandi e in azzurro i limiti regionali)<br />

si sono presentati mediamente<br />

nel periodo considerato 2010-<br />

2016 all’interno di ciascuna<br />

area di competenza (poligono)<br />

di ciascuna sede. Il carico<br />

medio di incendi per ciascuna<br />

sede corrisponde al carico di<br />

lavoro cui la sede è chiamata a<br />

farsi carico. Sempre avvalendosi<br />

della predetta banca dati, sono<br />

stati quindi definiti: il corrispondente<br />

tempio medio di<br />

risposta {T run }, per ogni coppia<br />

J<br />

{b k<br />

;m<br />

j<br />

}, i tempi medi necessari<br />

{T dst } alle unità di soccorso<br />

jk<br />

per raggiungere nel periodo di<br />

riferimento (mese) le località<br />

dell’incendio da ciascuna sede<br />

m j<br />

e quelli di ritorno dalle località<br />

alla sede di servizio maggiorati<br />

rispetto ai precedenti<br />

del 50%, dato il mancato uso<br />

della sirena in questi tragitti,<br />

entrambi questi ultimi due stimati<br />

in base alle caratteristiche<br />

di velocità ed autonomia dei<br />

mezzi di soccorso impiegati e<br />

delle caratteristiche di ciascun<br />

arco del grafo stradale utilizzato<br />

per la modellizzazione della rete<br />

stradale; il tempo medio necessario,<br />

alle unità di soccorso per<br />

espletare un intervento localizzato<br />

nel nodo k-mo nel periodo<br />

di riferimento, {T emg }, nonchè<br />

J<br />

il tempo medio necessario alle<br />

unità di soccorso rientrate in<br />

base per ridisporsi in prontezza<br />

operativa {T chk }. Dalla somma<br />

J<br />

di questi quattro tempi si è ricavato<br />

il valore del tempo medio<br />

totale di servizio m Tser<br />

.<br />

Per la stima dei tempi necessari<br />

ai tragitti di andata e di ritorno<br />

delle unità di soccorso tra ciascuna<br />

sede operativa e le località<br />

di incendio boschivo e viceversa<br />

Fig. 9 - Incendi boschivi in Italia 2010-2016 (Fonte dati<br />

Corpo Forestale dello Stato)<br />

<strong>GEOmedia</strong> n°5-<strong>2018</strong> n°4-<strong>2018</strong> 9

FOCUS<br />

Fig. 10 - Procedura di stima del tempo medio dei tragitti tra la sede operativa VVF e ciascuna località<br />

ricadente nel poligono di competenza in cui si è verificato nel periodo 2010-2016 un incendio boschivo.<br />

si è utilizzato il tool Network<br />

Analyst di Arcgis 10.5. applicato<br />

al grafo stradale della rete<br />

viaria nazionale, con riferimento<br />

ai nodi di collocazione dei<br />

presidi operativi del CNVVF.<br />

In particolare è stata utilizzata<br />

la funzione Closest facility per<br />

stimare i tempi medi dei tragitto<br />

tra la sede di servizio (facility)<br />

e ciascuno degli incendi boschivi<br />

(incidents) verificatisi nel<br />

periodo 2010-2016 e ricadenti<br />

nell’ambito di competenza.<br />

Si è resa necessaria a tale riguardo<br />

per lo studio una modellizzazione<br />

della rete stradale<br />

tramite il grafo OpenStreetMap<br />

(OSM).<br />

Con questi due strumenti si è<br />

effettuata la modellizzazione<br />

che ha adottato criteri di compromesso<br />

tra la precisione dei<br />

risultati e la minimizzazione<br />

dei costi, in termini di impiego<br />

di requisiti informativi, risorse<br />

hardware, tempo uomo e tempo<br />

macchina, necessari alla sua<br />

implementazione e pertanto si<br />

è ritenuto di non spingere verso<br />

un livello di dettaglio elevato la<br />

schematizzazione che pure non<br />

ha escluso alcun tipo degli archi<br />

della rete presente nella base di<br />

dati di OSM optando però per<br />

una valutazione prestazionale<br />

semplificata del deflusso imperniata<br />

sul tempo di percorrenza<br />

determinato dai due soli attributi<br />

concorrenti, lunghezza e<br />

velocità e rinunciando a forme<br />

funzionali delle funzioni di<br />

costo più sofisticate. Ogni arco<br />

della rete è stato quindi tipizzato<br />

in base alla classifica tecnico<br />

funzionale, ovvero in funzione<br />

del livello amministrativo e delle<br />

caratteristiche funzionali (velocità)<br />

con aggiornamento della<br />

relativa matrice. A ogni arco<br />

sono stati associati una serie di<br />

attributi tra cui il tempo di percorrenza<br />

(minutes). Per fare ciò<br />

le tabelle di attributi degli shape<br />

Fig. 11 - Particolare tabella attributi modificata della rete stradale OSM in funzione della velocità e dei<br />

tempi di percorrenza attribuiti a ogni singolo arco.<br />

files del grafo stradale sono state<br />

importate in un database di Microsoft<br />

Access e attraverso una<br />

macro si è associata la velocità<br />

massima consentita dal Codice<br />

della strada a ciascun corrispondente<br />

arco. Contestualmente<br />

si è suddivisa la lunghezza di<br />

ciascun arco per la velocità in<br />

minuti (tre cifre decimali). Successivamente<br />

le tabelle modificate<br />

sono state esportate in dbf<br />

e associate agli shape file. A partire<br />

dalla feature class lineare in<br />

formato shape che costituisce la<br />

rete è stato definito e costruito<br />

in ArcCatalog di ArcGis il network<br />

dataset e quindi attraverso<br />

la voce del menù di Network<br />

Analyst “Closest Facility” si<br />

sono calcolati individuandone<br />

i relativi percorsi (feature class<br />

lineare Route) la distanza e il<br />

tempo tra la sede VVF (facility)<br />

e ciascun incendio (incident)<br />

ricadente nel poligono di competenza.<br />

Gli incendi boschivi nel territorio<br />

sono stati caratterizzati<br />

come eventi aleatori, assumendo<br />

che:<br />

1. si distribuiscano aleatoriamente<br />

nel giorno medio<br />

secondo una legge di Poisson<br />

di parametro λ h<br />

pari alla<br />

densità media oraria locale<br />

di accadimento;<br />

2. a ciascun incendio boschivo<br />

corrisponda una<br />

richiesta di primo soccorso<br />

che giunge al sistema con<br />

un ritardo aleatorio, comunque<br />

trascurabile ai fini<br />

dello studio;<br />

3. La durata T ser<br />

delle missioni<br />

di soccorso sia aleatoria e<br />

distribuita secondo una<br />

legge esponenziale di parametro<br />

μ, inversamente<br />

proporzionale al tempo<br />

medio di durata m Tser<br />

delle<br />

missioni stesse.<br />

Nell’ambito di queste ipotesi<br />

in ciascuno dei nodi {b k<br />

} risulta<br />

10 <strong>GEOmedia</strong> n°4-<strong>2018</strong> n°5-<strong>2018</strong>

FOCUS<br />

pertanto definito una successione<br />

temporale di eventi flusso<br />

{F λ } che può essere schematizzato<br />

con buona approssimazio-<br />

J<br />

ne come un flusso aleatorio elementare<br />

definito dalla legge di<br />

Poisson con un certo intervallo<br />

temporale di riferimento {λ} J<br />

.<br />

ovvero indicando con P k<br />

(m,λ)<br />

la probabilità che si verifichino<br />

nel nodo k m richieste di intervento<br />

per incendio boschivo<br />

con media l (ponendo λ=l) si ha<br />

(1)<br />

Quindi tramite la suddetta formula<br />

di Poisson (1) ponendo<br />

m=0, è stato possibile calcolare<br />

la probabilità che nel nodo<br />

k-mo NON AVVENGA AL-<br />

CUN EVENTO:<br />

e da questa, passando all’evento<br />

contrario, è stato possibile calcolare<br />

la probabilità che nel nodo<br />

k-mo si verifichi ALMENO<br />

UN EVENTO:<br />

Quest’ultima relazione) esprime,<br />

al variare di λ, la propensione<br />

statistica al verificarsi di eventiemergenze<br />

in un ambito territoriale<br />

(nodo) soggetto in media<br />

ad un numero λ di eventi/periodo.<br />

Il valore P k<br />

(λ) rappresenta<br />

dunque un “indice di pericolosità”<br />

per ogni nodo b k<br />

del dominio<br />

di discretizzazione.<br />

L’indice di pericolosità è stato<br />

stimato in base alle serie storiche<br />

locali degli eventi ed è<br />

stato assunto per quantificare<br />

il carico di lavoro potenziale<br />

delle sedi territoriali di soccorso<br />

VVF nel raggio operativo (area)<br />

di competenza (corrispondente<br />

al rispettivo poligono di Thiessen).<br />

Il valore dell’indice di<br />

pericolo può essere poi pesato<br />

e corretto a seconda delle esigenze<br />

di modellizzazione al fine<br />

di ottenere il corrispondente<br />

“indice di rischio territoriale”<br />

come prodotto della pericolosità<br />

per il danno atteso (R=P*D).<br />

Nel presente studio l’indice di<br />

rischio è stato calcolato in particolare<br />

moltiplicando la pericolosità<br />

(percentuale di incendi<br />

verificatesi in area di competenza<br />

di ciascuna sede di servizio<br />

VVF sul totale nazionale) per<br />

il danno (superfici complessive<br />

percorse dal fuoco dal fuoco in<br />

km 2 ). Per la classificazione delle<br />

sedi in base all’indice di rischio<br />

si è utilizzato il metodo Quantile.<br />

Misura statistico-probabilistica<br />

di efficienza globale della<br />

rete CNVVF in relazione ai<br />

carichi di servizio valutati su<br />

scala locale. Risultati.<br />

La risposta in termini operativi<br />

che la rete deve fornire al carico<br />

di lavoro potenziale, derivante<br />

dall’indice di rischio territoriale,<br />

tramite le risorse U J<br />

distribuite<br />

nelle varie sedi VVF m J ,<br />

ovvero<br />

il livello di servizio, funzione<br />

del numero di richieste che<br />

giungono (carico di servizio),<br />

del tempo medio di espletamento<br />

del servizio richiesto (tempo<br />

di servizio) e del numero di<br />

unità di servizio (canali) che<br />

agiscono nel sistema, può essere<br />

limitata da alcuni vincoli dati<br />

di varia natura ma determinano<br />

sempre la difficoltà se non l’impossibilità<br />

di corrispondere con<br />

la voluta efficienza ed efficacia<br />

alla domanda di prestazione richiesta.<br />

Il rapporto tra le richieste<br />

che giungono e quelle che<br />

il sistema riesce a servire in un<br />

certo lasso temporale definisce<br />

la capacità relativa di ciascuna<br />

sede.<br />

A tale riguardo ciascuna sede<br />

della rete nazionale del CNVVF<br />

è stata considerata alla stregua<br />

di un sistema di servizio ad n<br />

canali e a richieste rifiutate.<br />

Calcolata la media temporale di<br />

incendi boschivi nella zona di<br />

competenza operativa di ciascuna<br />

sede VVF (flussi di richieste)<br />

e il numero di squadre o partenze<br />

in essa operative (canali),<br />

si può calcolarne il regime limite<br />

di servizio corrispondente.<br />

A partire quindi dai parametri<br />

statistici del processo di soccorso<br />

ricavati dalle statistiche CFS<br />

2010-2016 (flusso di richieste,<br />

canali, tempo di servizio) si<br />

è utilizzata a questo punto la<br />

formula di Erlang per calcolare<br />

il regime limite di saturazione<br />

del sistema di servizio ideale<br />

corrispondente. Nella formula<br />

compare, oltre al numero n di<br />

canali attivi, la densità ridotta a<br />

di richieste, ottenuta moltiplicando<br />

la densità oraria λ h<br />

per il<br />

tempo medio di servizio m Tser.<br />

Si<br />

sono in questo modo calcolati i<br />

valori della capacità relativa Q rel<br />

di ciascuna delle sedi per diversi<br />

valori di λ e per un numero n<br />

variabile di canali attivi, in generale<br />

diversi da sede a sede.<br />

I dati sono stati calcolati con riferimento<br />

ai mesi in cui nei vari<br />

anni si sono verificati gli incendi<br />

in modo da poter calibrare<br />

l’ottimizzazione secondo archi<br />

temporali specifici e ristretti.<br />

I dati di fonte CFS (AIB-fn) per<br />

le regioni a statuto ordinario<br />

sono stati inseriti i una tabella<br />

ovvero i un foglio elettronico<br />

in cui è stata convertita la<br />

formulazione del problema di<br />

ottimizzazione. Il foglio elettronico<br />

è stata utilizzato per<br />

misurare le prestazioni del sistema<br />

di servizio delle reti delle<br />

<strong>GEOmedia</strong> n°5-<strong>2018</strong> n°4-<strong>2018</strong> 11

FOCUS<br />

Fig. 12 - Indice di rischio R = pericolosità (% incendi<br />

per Comando VVF su totale nazionale) per danno<br />

(aree percorse dal fuoco in km2) (metodo di classificazione<br />

Quantile).<br />

Fig. 13 - Indice di rischio R = pericolosità (% incendi<br />

per Sede VVF su totale nazionale) per danno (aree<br />

percorse dal fuoco in km2) (metodo di classificazione<br />

Quantile).<br />

Fig. 14 - Capacità relativa del sistema di servizio<br />

delle Sedi VVF (metodo di classificazione Quantile).<br />

sedi operative territoriali VVF<br />

e per ottimizzare la distribuzione<br />

delle risorse. Le prime tre<br />

colonne (A,B,C) contengono<br />

i dati rispettivamente relativi a<br />

Regione, Provincia, Comando<br />

VVF competente di ciascuna<br />

Sede operativa territoriale VVF<br />

(colonna D) con indicata la Categoria<br />

funzionale (colonna E).<br />

Assunto il parametro l della legge<br />

di Poisson pari alla media di<br />

incendi boschivi registrata in un<br />

dato arco temporale nel territorio<br />

di competenza individuato<br />

per ciascuna sede (poligono) nel<br />

periodo 2010-2016, le colonne<br />

da F a Q riportano il numero<br />

assoluto di incendi boschivi<br />

nei singoli mesi dell’anno, la<br />

colonna R il totale incendi nel<br />

periodo 2010-2016, la colonna<br />

S la superficie totale percorsa<br />

dal fuoco in ettari nel periodo<br />

2010-2016, le colonne da T ad<br />

AE le medie mensili nei singoli<br />

mesi dell’anno e nelle colonne<br />

AF e AG rispettivamente la media<br />

eventi totale mensili per il<br />

periodo 2010-16 (λ) e la media<br />

eventi oraria per lo stesso periodo<br />

2010-16 (λ). In questo modo<br />

è stato possibile calcolare un<br />

“coefficiente di pericolosità” per<br />

singole scale spazio-temporali<br />

(mese, ora) che esprime quantitativamente<br />

la propensione al<br />

verificarsi di eventi di incendio<br />

boschivo che insiste su un dato<br />

territorio in un certo periodo<br />

dell’anno . La colonna AH<br />

contiene per ciascuna sede la<br />

Fig. 15 - Capacità relativa del sistema di servizio delle Sedi VVF (metodo di classificazione Quantile).<br />

Funzione P(La) (λ) probabilità<br />

eventi (1-Exp(-La)). E possibile<br />

identificare tale coefficiente in<br />

maniera diretta anche come<br />

“indice di rischio” con il danno<br />

della perdita del bene “bosco”. I<br />

risultati ottenuti rappresentano<br />

una misura del carico medio<br />

di incendi ovvero il carico di<br />

lavoro (commisurato al rischio<br />

territoriale) cui ciascuna sede<br />

VVF è chiamata a corrispondere<br />

con le proprie risorse (partenze)<br />

sempre occorre sottolinearlo<br />

in base ai dati statistici<br />

del fenomeno incendi boschivi<br />

e della loro durata provenienti<br />

dal disciolto Corpo Forestale<br />

dello Stato e ai dati dei tempi di<br />

raggiungimento delle località di<br />

incendio dalle sedi VVF stimati<br />

grazie al modello di rete stradale.<br />

Seguono le colonne da AI<br />

ad AO utilizzate per definire il<br />

tempo medio di servizio m Tser<br />

..<br />

Innanzitutto nella colonna AI il<br />

tempio medio di risposta {T run J }<br />

tra la segnalazione dell’incendio<br />

e l’uscita dalla sede operativa<br />

della squadra d’intervento.<br />

Essendo il lavoro riferito alle<br />

sedi VVF non si sono in questo<br />

caso usati i dati di provenienza<br />

12 <strong>GEOmedia</strong> n°4-<strong>2018</strong><br />

12 <strong>GEOmedia</strong> n°5-<strong>2018</strong>

FOCUS<br />

CFS è si è usato sulla base delle<br />

statistiche VVF il tempo medio<br />

di 5 minuti per tutte le sedi. La<br />

colonna AJ contiene il tempo di<br />

arrivo medio stimato (sulla base<br />

del modello di rete stradale approntato<br />

per la network analysis<br />

descritto in precedenza) in minuti<br />

della squadra d’intervento,<br />

la colonna AK il tempo medio<br />

in minuti necessario alla squadra<br />

intervenuta per espletare un<br />

intervento {T emg }, la colonna<br />

AL il tempo di rientro in<br />

J<br />

sede medio stimato (sulla base<br />

del modello di rete stradale approntato<br />

per la network analysis<br />

descritto in precedenza e convenzionalmente<br />

aumentato del<br />

50% per il mancato uso della<br />

sirena sulla base delle statistiche<br />

d’intervento VVF) in minuti<br />

della squadra , la colonna AM<br />

il tempo medio necessario alla<br />

squadra rientrata in sede per<br />

ridisporsi in prontezza operativa<br />

{T chk }, Seguono le colonne<br />

J<br />

AN tempo medio di servizio in<br />

minuti (somma delle precedenti<br />

colonne da AI ad AM), AO<br />

tempo medio di servizio in ora<br />

e centesimi di ora. La colonna<br />

AP contiene i valori della densità<br />

eventi ridotta (λ) del flusso<br />

in ora e cent. di ora definita<br />

come il prodotto della densità λ h<br />

per il tempo di servizio m Tser<br />

,. I<br />

valori di λ che descrivono i flussi<br />

di richieste per ciascuna sede<br />

possono essere trattati separatamente<br />

per periodi di riferimento.<br />

A partire dalla formula di Erlang<br />

sono stati quindi calcolati<br />

nelle colonne da AQ ad AU i<br />

valori della capacità relativa Q rel<br />

di ciascuna delle sedi per diversi<br />

valori di λ e per un numero di<br />

canali attivi (partenze/squadre<br />

AIB), le variabili di decisione<br />

comprese nel range fissato da 1<br />

a 5 e assegnate alle colonne AZ-<br />

BD.<br />

L’ottimizzazione della rete delle<br />

sedi può a questo punto essere<br />

effettuata utilizzando come pesi<br />

Tab. 2 - Sedi ad aree a rischio elevato, estremo e con bassa<br />

capacità relativa di risposta.<br />

i fattori di capacità con l’obiettivo<br />

da massimizzare (funzione<br />

obiettivo) identificato con la<br />

somma delle capacità relative<br />

delle basi (cella obiettivo nella<br />

colonna BQ) e tra i vincoli<br />

quello del numero complessivo<br />

di risorse da ottimizzare (numero<br />

di squadre già disponibili<br />

nelle sedi operative incrementato<br />

da quelle previste in aggiunta<br />

in base agli accordi convenzionali)<br />

(colonna BE).<br />

Due mappe sintetizzano questi<br />

dati. La prima è relativa all’indice<br />

di rischio per ambito di<br />

competenza delle sedi VVF<br />

(Indice di rischio R = pericolosità<br />

(% incendi per sede VVF<br />

su totale nazionale per danno<br />

ovvero aree percorse dal fuoco<br />

in km 2 ) (metodo di classificazione<br />

in cinque classi Quantile)<br />

mentre la seconda è relativa alla<br />

capacità relativa del sistema di<br />

servizio delle sedi VVF (metodo<br />

di classificazione in cinque classi<br />

Quantile: estremo, elevato,<br />

medio, basso e trascurabile).<br />

Convertita la formulazione del<br />

problema di ottimizzazione<br />

in un foglio elettronico sono<br />

diversi i sistemi di calcolo automatici<br />

che possono fornire<br />

una soluzione ottima della distribuzione<br />

di risorse aggiuntive<br />

da concordare con le Regioni,<br />

tale da massimizzare la somme<br />

delle capacità relative delle sedi<br />

della rete. Tra i più elementari<br />

linguaggi di modellizzazione si<br />

è scelto quello di ottimizzazione<br />

con il risolutore inserito nel<br />

programma di foglio elettronico<br />

Microsoft Excel.<br />

E’ anche possibile basare empiricamente<br />

e visivamente la distribuzione<br />

ottimale delle risorse<br />

a partire dall’ordinamento delle<br />

capacità relative del sistema di<br />

servizio dal valore più piccolo<br />

al più grande per singoli ambiti<br />

nel foglio elettronico utilizzato<br />

oppure massimizzare l’efficienza<br />

complessiva del sistema individuandola<br />

e fissandola a priori in<br />

una soglia minima di capacità<br />

relativa per tutte le sedi.<br />

Tab. 3 – Sedi ad aree a rischio estremo<br />

con bassa capacità relativa di risposta<br />

<strong>GEOmedia</strong> n°5-<strong>2018</strong> n°4-<strong>2018</strong> 13

FOCUS<br />

Conclusioni<br />

Nel caso del nostro studio<br />

l’applicazione del “metodo<br />

delle code”, procedimento dedicato<br />

di ottimizzazione nella<br />

prospettiva della Teoria delle<br />

Code, non solamente è riuscita<br />

nonostante alcuni restrizioni a<br />

modellizzare la realtà del fenomeno<br />

incendi boschivi e del suo<br />

contrasto attraverso la rete delle<br />

sedi di servizio del CNVVF in<br />

modo attendibile ma ha fornito<br />

con i suoi risultati indicazioni<br />

che confrontate con i dati della<br />

stagione AIB 2017 sono risultate<br />

del tutto soddisfacenti per lo<br />

scopo prefisso.<br />

Avrebbero permesso infatti<br />

di calibrare in maniera più<br />

adeguata la stima delle risorse<br />

da richiedere in convenzione<br />

da parte delle varie Regioni al<br />

CNVVF e la loro distribuzione,<br />

nel territorio e nei vari periodi<br />

della campagna AIB. Il dispositivo<br />

operativo prefigurato attraverso<br />

l’applicazione del metodo<br />

delle code non risulta una ipotesi<br />

irrealistica rispetto al livello<br />

fissato nella stagione AIB 2017<br />

attraverso le convenzioni<br />

A differenza di Candide-<br />

Pangloss siamo coscienti che la<br />

soluzione di ottimizzazione trovata<br />

possa non essere la migliore<br />

di quelle possibili.<br />

In ogni caso l’aderenza alla realtà<br />

del modello previsionale è<br />

correlata strettamente alla quantità<br />

e qualità delle informazioni<br />

disponibili.<br />

L’impatto dell’uso del Gis è<br />

stato rilevante in quanto ha<br />

permesso l’utilizzo pieno della<br />

dimensione spaziale dei dati per<br />

perseguire l’obiettivo dell’ottimizzazione<br />

.<br />

Va soggiunto che presso molte<br />

Direzioni Regionali VVF allo<br />

scopo di monitorare in tempo<br />

reale il fenomeno degli incendi<br />

boschivi e delle sue dinamiche<br />

sul territorio sono stati predisposti<br />

sistemi informative su<br />

piattaforma dedicate Gis AS-<br />

SET AIB che hanno riproposto<br />

la positiva esperienza maturata<br />

nel sisma del centro Italia 2016<br />

consentendo di ottimizzare<br />

l’allocazione e uso delle risorse<br />

disponibili con continue rimodulazioni<br />

e ottimizzazioni dei<br />

tempi di risposta del dispositivo<br />

e delle modalità di intervento<br />

delle squadre sul territorio.<br />

Ovvero la tecnologia sta consentendo<br />

di affiancare alla fase<br />

di pianificazione previsionale<br />

ex ante una fase di gestione in<br />

continua revisione e miglioramento.<br />

Le indicazioni di metodo per<br />

valutare il dimensionamento<br />

delle risorse possono sicuramente<br />

essere riproposte e nell’ambito<br />

di studi volti a migliorare<br />

l’efficienza dell’intera rete di<br />

soccorso tecnico urgente.<br />

NOTE<br />

1 Lo studio riprende l’impostazione teorica e il metodo (“Metodo delle<br />

code”) approntato e utilizzato da Fabrizio Di Liberto per l’ottimizzazione<br />

della dislocazione stagionale ottimale sul territorio nazionale<br />

della flotta aerea Antincendi Boschivi dello Stato: F. Di Liberto, “Lo<br />

schieramento strategico ottimale per le flotte aeree antincendi boschivi”<br />

in Silvae, anno I n. 1 (gennaio-aprile 2005), pp. 164-195.<br />

BIBLIOGRAFIA<br />

Adacher, L. http://ad acher.dia.uniroma3.it/automazione1/TeoriaCode.pdf.<br />

Biagini, F. & M. Campanino (2006), Elementi di probabilità e statistica.<br />

Springer.<br />

Cesti, G. (1999), Antincendio boschivo, Musumeci Editore, 1999.<br />

Conti Guglia, F. (2004) Manuale Antincendio Boschivo, sito internet:<br />

www.ambientediritto.it.<br />

Di Liberto, F. (gennaio-aprile 2005) “Lo schieramento strategico ottimale<br />

per le flotte aeree antincendi boschivi” in Silvae, anno I n. 1,<br />

pp. 164-195.<br />

Kleinrock, L. (1992) Sistemi a coda : introduzione alla teoria delle<br />

code, Milano, 1992.<br />

Ventsel, E.S. (1983) Teoria delle probabilita, Edizioni Mir.<br />

Fonti Dati statistici:<br />

• Sistema Informativo della Montagna (SIM-FEI / AIBfn), (fonte:<br />

CFS)<br />

• Dati statistici Parchi Nazionali – Sito istituzionale DPN, (fonte:<br />

MATTM)<br />

• EFFIS – European Forest Fires Information System, (fonte: EFFIS-<br />

UE)<br />

Nelle mappe le aree in bianco segnalano la mancanza di dati.<br />

ABSTRACT<br />

In recent decades the literature on rescue systems has recorded a very<br />

large number of contributions that have used, while declining according<br />

to different perspectives, the Queue Theory to prepare procedures<br />

and models to understand their behavior, measure and optimize performance<br />

in terms of efficiency of the service rendered in the territory<br />

by these particular systemic structures so important from a social point<br />

of view.<br />

These are very complex structures because of the predictable and<br />

unpredictable factors of variability that intervene both in terms of the<br />

number of requests and the time necessary to satisfy them.<br />

PAROLE CHIAVE<br />

Incendi; tecnologie geospaziali; distribuzione risorse; ottimizzazione<br />

AUTORE<br />

Michele Fasolo<br />

michelefasolo@gmail.com<br />

14 <strong>GEOmedia</strong> n°5-<strong>2018</strong><br />

14 <strong>GEOmedia</strong> n°4-<strong>2018</strong>

FOCUS<br />

<strong>GEOmedia</strong> n°5-<strong>2018</strong> 15

REPORT<br />

Studio comparativo tra lo stato dei<br />

luoghi prima e dopo l’incendio del<br />

Vesuvio tramite analisi satellitare<br />

di Massimiliano Moraca, Antonio Pepe<br />

Un incendio di vaste proporzioni ha<br />

interessato il Vesuvio ed il Monte Somma<br />

a metà Luglio 2017, distruggendo vaste<br />

aree di vegetazione sia all’interno che<br />

all’esterno del Parco Nazionale del<br />

Vesuvio: in questo elaborato è stato<br />

effettuato uno studio comparativo tra<br />

lo stato dei luoghi prima dell’incendio<br />

e dopo l’incendio, mediante immagini<br />

satellitari multispettrali relative ai rilievi<br />

Landsat 8 del 5 maggio e del 24 luglio.<br />

Fig. 1 - RGB relativo allo stato dei luoghi al 24 luglio 2017.<br />

A<br />

metà luglio 2017 un<br />

incendio di vaste proporzioni<br />

ha interessato<br />

il Vesuvio ed il Monte Somma<br />

distruggendo vaste aree di vegetazione<br />

all’interno del Parco<br />

Nazionale del Vesuvio. Lo scopo<br />

di questo studio è ottenere una<br />

valutazione degli indici NDVI,<br />

indice utile a valutare lo stato<br />

fisiologico delle foreste e NBR,<br />

uno degli indici più utilizzati<br />

per mappare la severità di aree<br />

incendiate, in modo da stimare<br />

l’estensione dei danni provocati<br />

dall’incendio.<br />

Per questo studio sono state<br />

usate immagini satellitari<br />

multispettrali relative ai rilievi<br />

Landsat 8 del 5 maggio e del 24<br />

luglio 2017. Si è scelta la piattaforma<br />

Landsat 8 piuttosto che<br />

la Sentinel 2 nonostante i rilievi<br />

della seconda abbiano una risoluzione<br />

migliore della prima.<br />

Questa scelta è stata fatta per tre<br />

ordini di motivi:<br />

4nei mesi subito precedenti<br />

i giorni degli incendi, per i<br />

Sentinel 2, non erano disponibili<br />

dati liberamente scaricabili<br />

che non avessero copertura<br />

nuvolosa sul Vesuvio o sul<br />

Somma;<br />

4si è appositamente scelto di<br />

non effettuare operazioni di<br />

mascheramento della copertura<br />

nuvolosa per non alterare<br />

i risultati relativi a NDVI e<br />

NBR;<br />

4non si è voluto andare a<br />

ritroso nel tempo per non<br />

intercettare i danni provocati<br />

dagli incendi estivi degli anni<br />

precedenti il 2017.<br />

Abbiamo voluto fare, quindi,<br />

una fotografia del pre-post<br />

incendio usando dati quanto<br />

più vicini e confrontabili tra<br />

loro. Le immagini sono state<br />

processate usando il metodo<br />

DOS, per rimuovere i disturbi<br />

dovuti all’atmosfera terrestre, e<br />

successivamente si è proceduto<br />

ad una loro ulteriore elaborazione,<br />

con il Pan-sharpening,<br />

mirata a ridurre la risoluzione<br />

delle immagini satellitari portandola<br />

così da 30m/px a 15m/<br />

px. Il processo elaborativo è<br />

stato condotto usando esclusivamente<br />

il software open source<br />

QGIS, nella versione 2.18, ed il<br />

Semi-Automatic Classification<br />

Plug-in.<br />

Remote Sensing<br />

L’essere umano riesce ad identi-<br />

16 <strong>GEOmedia</strong> n°5-<strong>2018</strong>

REPORT<br />

ficare ed interpretare il territorio<br />

grazie al processo di elaborazione<br />

della luce effettuato dall’occhio.<br />

L’occhio umano è assimilabile<br />

al sensore che, montato su<br />

un satellite o su un aeromobile,<br />

analizza la luce solare e ne restituisce<br />

un input interpretato dal<br />

cervello.<br />

La luce, cioè la radiazione visibile,<br />

è una piccola parte della<br />

radiazione elettromagnetica<br />

ed insieme ad altre tipologie<br />

di radiazioni forma lo spettro<br />

elettromagnetico. Parliamo di<br />

radiazione poichè facciamo riferimento<br />

a quel processo fisico<br />

per cui l’energia è trasportata da<br />

un corpo ad un altro attraverso<br />

il vuoto, quindi non per contatto<br />

tra i corpi.<br />

Con lo spettro elettromagnetico<br />

andiamo a rappresentare su un<br />

asse le lunghezze d’onda dei vari<br />

tipi di radiazioni.<br />

Lo spettro del visibile è solo<br />

una piccolissima parte dello<br />

spettro elettromagnetico<br />

che va dai raggi Y, con lunghezza<br />

d’onda nell’ordine<br />

dell’Å(ångström), alle onde<br />

radio, con lunghezza d’onda superiore<br />

ai 100km. Per il remote<br />

sensing le regioni significative<br />

vanno dall’ultravioletto(UV) al<br />

microonde(MW).<br />

La radiazione elettromagnetica<br />

risulta quindi fondamentale per<br />

questo tipo di studi, essa risulta<br />

essere trasportata dai fotoni,<br />

secondo la teoria quantistica, e<br />

l’energia trasmessa attraverso di<br />

essi è detta energia radiante, Q.<br />

A noi interessa una grandezza<br />

ben specifica derivante dall’energia<br />

radiante e cioè il flusso<br />

di energia radiante, , che è la<br />

quantità di energia trasportata<br />

in un certo tempo:<br />

passa attraverso una certa area.<br />

Se esso fuoriesce da una fonte<br />

energetica abbiamo l’exitanza,<br />

M, misurata in:<br />

Se invece un corpo ne è colpito<br />

abbiamo l’irradianza, E,<br />

anch’essa espressa in:<br />

Una ulteriore grandezza radiometrica<br />

fondamentale per il<br />

remote sensing, anche perchè<br />

risulta essere quella effettivamente<br />

misurata dal sensore, è<br />

la radianza, L, e cioè il flusso<br />

radiante attraverso un’area ed<br />

un certo angolo di osservazione.<br />

Tale grandezza è espressa in in<br />

cui sr è lo steradiante 1 :<br />

in cui q è l’angolo di osservazione<br />

e w è la normale alla superficie<br />

osservata.<br />

Tutto i corpi che sono ad una<br />

temperatura superiore allo<br />

zero assoluto emettono energia<br />

elettromagnetica, in particolare<br />

ogni tipologia di materiale<br />

emette una propria firma<br />

spettrale(Dainelli, 2011).<br />

DOS e Pan-sharpening<br />

Nell’utilizzo dei dati da rilievo<br />

satellitare è importante andare<br />

a rimuovere gli effetti deteriorativi<br />

della qualità dell’immagine<br />

che l’atmosfera terrestre<br />

imprime su di esse. L’atmosfera<br />

Fig. 2 - Lo spettro elettromagnetico. Da “L’osservazione<br />

della Terra – Telerilevamento.”<br />

Fig. 3 - Firme spettrali di alcuni materiali.<br />

terrestre infatti attiva effetti<br />

di dispersione, assorbimento<br />

e riflessione della radiazione<br />

elettromagnetica. Tali effetti<br />

vanno rimossi per una corretta<br />

analisi dei dati. In questo<br />

studio è stata usato il metodo<br />

DOS - Dark Object Subtraction<br />

- ideato da Pat S. Chavez jr nel<br />

1996 (Pat S.Chaver, 1996) ed<br />

i cui algoritmi sono riportati<br />

nel plugin di QGIS “Semi-<br />

Automatic Classification Plugin”<br />

(Congedo, 2016).<br />

Il metodo DOS rimuove i pixel<br />

neri dalle immagini rendendola<br />

più nitida poichè parte dal<br />

presupposto che alcuni pixel<br />

riproducono aree che sono in<br />

completa ombra e la radiazione<br />

al satellite è dovuta all’effetto<br />

di dispersione atmosferica; ciò<br />

è combinato con il fatto che<br />

pochissimi target al suolo sono<br />

Tale flusso è espresso in Watt.<br />

E’ di rilievo considerare anche<br />

il flusso di energia radiante che<br />

Fig. 4 - Comparazione delle bande multispettrali delle missioni Landsat.<br />

<strong>GEOmedia</strong> n°5-<strong>2018</strong> 17

REPORT<br />

di un nero intenso, è ipotizzata<br />

quindi una riflettanza 2 dell’1%.<br />

In gergo tecnico si dice che<br />

con la rimozione dei disturbi si<br />

“portano le immagini al di sotto<br />

dell’atmosfera terrestre”. Per i<br />

dati rilevati da aeromobile non<br />

è necessario utilizzare nessuna<br />

tecnica di rimozione degli effetti<br />

di disturbo dell’atmosfera<br />

terrestre.<br />

Per migliorare la qualità<br />

dell’output del nostro studio<br />

è stata usata la tecnica del<br />

Pan-Sharpening per ridurre<br />

la risoluzione delle immagini<br />

Landsat 8. Il Pan-Sharpening<br />

o Panchromatic Sharpening è<br />

una tecnica che sfrutta la banda<br />

pancromatica combinandola<br />

con le bande multispettrali<br />

andando così a ridurre la risoluzione<br />

spaziale delle bande<br />

multispettrali. Anche per i processi<br />

relativi al Pan-Sharpening<br />

è stato usato il Semi-Automatic<br />

Classification Plug-in.<br />

Landsat 8<br />

Il programma Landsat fornisce<br />

immagini satellitari della superficie<br />

terrestre da 45 anni; è<br />

ampia e varia la comunità degli<br />

utilizzatori dei dati Landsat<br />

si va dai settori del business a<br />

quelli della scienza e ricerca, il<br />

governo del territorio e la sicurezza<br />

nazionale.<br />

Il programma Landsat prevede<br />

l’acquisizione continua ed in<br />

bande multispettrali di immagini<br />

dell’intero globo terrestre,<br />

producendo il più vasto archivio<br />

di rilievi satellitari accessibile<br />

per lo più gratuitamente da<br />

chiunque.<br />

Fig. 6 - Comparazione tra bande Landsat 7 e 8 (Landsat 8 Data<br />

Users Handbook).<br />

Il programma Landsat è gestito<br />

dall’USGS - United States<br />

Geological Survey - e dalla<br />

NASA - National Aeronautics<br />

and Space Administration - e<br />

vede il lancio del primo satellite,<br />

il Landsat 1, nel 1972; l’ultimo,<br />

il Landsat 8, è stato messo<br />

in orbita nel 2013.<br />

Il Landsat 1 aveva una risoluzione<br />

al suolo di 80m/px e 4<br />

bande multispettrali; Landsat<br />

2 e 3, lanciati rispettivamente<br />

nel 1975 e nel 1978, avevano<br />

una configurazione simile al<br />

Landsat 1. Landsat 4, lanciato<br />

nel 1984 aveva una risoluzione<br />

di 30m/px e 7 bande multispettrali;<br />

Landsat 5 era una copia<br />

del 4 e fu lanciato nello stesso<br />

anno. Landsat 6 andò perso<br />

subito dopo il lancio nel 1993<br />

perchè non riuscì a marcare<br />

l’orbita. Landsat 7, lanciato nel<br />

1999, aveva 8 bande multispettrali<br />

a 30m/px di cui una pancromatica<br />

a 15m/px.<br />

Landsat 8 effettua un passaggio<br />

sullo stesso punto della superficie<br />

terrestre ogni 16 giorni, è<br />

posto su un’orbita quasi polare,<br />

elio-sincrona, circolare, ad una<br />

quota di 705 km e rileva immagini<br />

multispettrali a 11 bande.<br />

Landsat 8 monta due importanti<br />

sensori passivi 3 : OLI<br />

- Operational Land Imager - e<br />

TIRS - Thermal Infrared Sensor.<br />

L’OLI ha un telescopio a quattro<br />

specchi ed elabora immagini<br />

a 12bit rispetto agli 8bit dei<br />

sensori TM & ETM+.<br />

Raccoglie immagini in 9 bande<br />

multispettrali di cui 8 con risoluzione<br />

pari a 30m/px ed una,<br />

la banda pancromatica, a risoluzione<br />

di 15m/px.<br />

In particolare la banda pancromatica<br />

è una risoluzione<br />

minore rispetto alle altre<br />

per accentuare il contrasto<br />

tra aree vegetate ed aree senza<br />

copertura vegetale.<br />

La comparazione tra le<br />

bande del Landsat 7 e del<br />

Fig. 5 - Sensoristica a bordo del Landsat 8 (Landsat<br />

8 Data Users Handbook).<br />

Landsat 8 mettono in evidenza<br />

le differenze tra le due piattaforme<br />

presenti non solo per la<br />

differente lunghezza d’onda<br />

della sensoristica ma anche per<br />

la presenza di ulteriori bande;<br />

nello specifico la banda 1, la 9<br />

e le bande 10 ed 11 relative al<br />

TIRS.<br />

La banda 1 è stata introdotta<br />

per l’osservazione degli oceani,<br />

la banda 9 è utile invece per<br />

l’osservazione delle coperture<br />

nuvolose anche sottili.<br />

Le bande 10 ed 11, relative al<br />

sensore TIRS, sono usate per<br />

monitorare la temperatura della<br />

superficie terrestre. TIRS utilizza<br />

fotorivelatori a infrarossi<br />

quantici QWIP - Quantum<br />

Well Infrared Photodetectors - per<br />

misurare l’energia termica a<br />

infrarossi a onde lunghe (TIR) <br />

emessa dalla superficie terrestre.<br />

I QWIP di TIRS sono sensibili<br />

a due bande di lunghezza d’onda<br />

dell’infrarosso termico, consentendo<br />

la separazione della<br />

temperatura della superficie terrestre<br />

da quella dell’atmosfera.<br />

Dati usati e metodologia<br />

Lo studio è stato condotto secondo<br />

le seguenti fasi:<br />

18 <strong>GEOmedia</strong> n°5-<strong>2018</strong>

REPORT<br />

1. Individuazione del periodo<br />

di interesse;<br />

a. Raccolta dei tiles<br />

Landsat 8;<br />

b. Scrematura degli<br />

stessi finalizzata<br />

all’individuazione di<br />

due dataset riferiti ad<br />

altrettanti giorni utili<br />

ai nostri scopi;<br />

2. Pre-processamento dei<br />

dataset;<br />

a. Rimozione dei disturbi<br />

dell’atmosfera<br />

tramite DOS;<br />

b. Aumento della risoluzione<br />

del dataset tramite<br />

Pan-Sharpening;<br />

3. Post-processamento dei<br />

dataset;<br />

a. Calcolo di NDVI,<br />

NBR;<br />

b. Campionamento<br />

della temperatura al<br />

suolo;<br />

c. Intersezione tra NBR<br />

e Corine Land Cover.<br />

I dati per il nostro studio sono<br />

stati prelevati dal sito web<br />

EarthExplorer dell’USGS effettuando<br />

una prima scrematura<br />

dei tile prima del download.<br />

Successivamente con l’utilizzo<br />

congiunto di QGIS e del Semiautomatic<br />

Classification Plugin<br />

è stato applicato il metodo<br />

DOS sia al tile del 5 maggio<br />

2017 sia a quello del 24 luglio<br />

2017, metodo applicato ad<br />

ognuna delle 11 bande dei singoli<br />

tile.<br />

L’output di questo primo processo<br />

è stato rielaborato con il<br />

Pan-Sharpening per ottenere<br />

un output finale ad una risoluzione<br />

di 15m/px, dimezzando<br />

la risoluzione rispetto ai 30m/<br />

px iniziali. Per questo processo<br />

è stata combinata la banda 8,<br />

la banda pancromatica, con le<br />

bande da 2 a 7, cioè le bande<br />

multispettrali.<br />

Nell’immagine che segue è<br />

indicato il flusso di lavoro per<br />

Fig .7 - Flusso di lavoro sui dati Landsat 8.<br />

entrambe le operazioni appena<br />

indicate.<br />

Il nuovo set di bande è stato riutilizzato<br />

per la determinazione<br />

degli indici NDVI - Normalized<br />

DIfference Vegetation Index - e<br />

NBR - Normalized Burn Ratio<br />

-, indici che verranno approfonditi<br />

nel paragrafo successivo.<br />

Una delle prime analisi effettuate<br />

è stata quella relativa alla<br />

comparazione della temperatura<br />

al suolo pre e post incendio<br />

sfruttando la banda 10 TIRS.<br />

Abbiamo rilevato 5 punti di<br />

campionamento a cui abbiamo<br />

associato il dato termico pre e<br />

post incendio tramite join spaziale.<br />

L’indice NBR ci ha consentito<br />

di individuare, tramite differenza<br />

pre-post incendio, l’area del<br />

Parco Nazionale del Vesuvio in<br />

cui si sono avuti i maggiori danni;<br />

successivamente abbiamo<br />

riclassificato e vettorializzato il<br />

raster di differenza ottenuto in<br />

Fig. 8 - Bande su cui si è condotto lo studio.<br />

modo da avere una copertura<br />

di tipo poligonale e vettoriale<br />