lezione 8

lezione 8

lezione 8

Create successful ePaper yourself

Turn your PDF publications into a flip-book with our unique Google optimized e-Paper software.

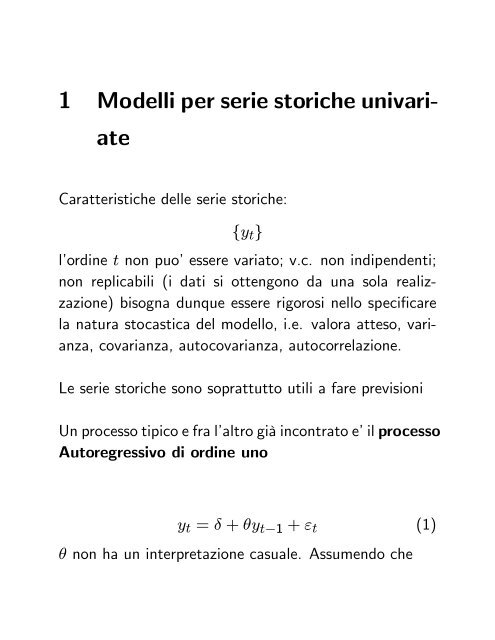

1 Modelli per serie storiche univari-<br />

ate<br />

Caratteristiche delle serie storiche:<br />

fytg<br />

l’ordine t non puo’essere variato; v.c. non indipendenti;<br />

non replicabili (i dati si ottengono da una sola realizzazione)<br />

bisogna dunque essere rigorosi nello speci…care<br />

la natura stocastica del modello, i.e. valora atteso, varianza,<br />

covarianza, autocovarianza, autocorrelazione.<br />

Le serie storiche sono soprattutto utili a fare previsioni<br />

Un processo tipico e fra l’altro già incontrato e’il processo<br />

Autoregressivo di ordine uno<br />

yt = + yt 1 + "t (1)<br />

non ha un interpretazione casuale. Assumendo che

1. j j < 1<br />

2. "t e’un processo white noise, omoschedastico e privo<br />

di autocorrelazione.<br />

Otteniamo:<br />

= E(yt) = + E(yt 1) + "t<br />

E(yt) = + E(yt 1)<br />

= 1<br />

de…nendo cyt come yt centrato cyt = yt<br />

la (1) come<br />

cyt = cyt 1 + "t<br />

V (yt) = V ( + yt 1 + "t)<br />

= ( 2 V (yt 1) + 2 )<br />

dato che V (yt) = V (yt 1)<br />

V (yt) =<br />

1 2<br />

Cov(ytyt 1) = E(cyt cyt 1)<br />

2<br />

riscriviamo

= E [( cyt 1 + "t) (cyt 1)]<br />

= V (yt)<br />

=<br />

1 2<br />

potete ottenere allo stesso modo che<br />

2<br />

Cov(ytyt k) = k<br />

1 2<br />

cioe’la Cov(ytyt k) dipende solo da k e non da t.<br />

Processo a Media Mobile di ordine uno<br />

yt = + "t + "t 1<br />

V (yt) = E("t + "t 1) 2<br />

= E("t) 2 + 2 E("t 1) 2<br />

= (1 + 2 ) 2<br />

Cov(ytyt 1) = E [("t + "t 1) ("t 1 + "t 2)]<br />

= E h i<br />

=<br />

Cov(ytyt 2) = 0<br />

2<br />

" 2 t 1<br />

Cov(yty t k) = 0 per k = 2; 3; 4::<br />

2

Se j j < 1 un processo AR puo’essere riscritto come un<br />

processo MA per sostituzione di yt 1 = + yt 2+"t 1;<br />

yt 1 = (yt 2 ) + "t 1 in (1) otteniamo<br />

yt = + 2 (yt 2 ) + "t + "t 1<br />

sostituendo ancora yt 2 = (yt 3 ) + "t 2<br />

abbiamo<br />

yt = + 2 ( (yt 3 ) + "t 2) + "t + "t 1<br />

= + 3 (yt 3 ) + "t + "t 1 + 2 "t 2<br />

continuando le sostituzioni si ottiene<br />

dove<br />

n 1<br />

P<br />

j=0<br />

yt = + n (yt n ) +<br />

n 1<br />

P<br />

j=0<br />

j "t j e’una componente MA<br />

j "t j

1.0.1 Operatore ritardo<br />

Un modo alternativo di rappresentazione<br />

Lyt = yt 1<br />

L j yt = yt j<br />

AR(1) ) yt = 1yt 1 + "t<br />

yt 1yt 1 = "t<br />

(1 1L)yt = "t<br />

1.1 Stazionarieta’<br />

yt =<br />

"t<br />

1 1L<br />

La stazionarieta’e’importantissima per la previsione

In senso stretto l’intera distribuzione di probabilita’congiunta<br />

a qualsiasi insieme di date non e’in‡uenzata da<br />

uno slittamento arbitrario lungo l’asse del tempo.<br />

In senso debole Media, Varianza e Covarianza sono indipendenti<br />

dal tempo. La covarianza dipende solo dalla<br />

lunghezza dell’intervallo che separa due osservazioni.<br />

E(yt) = < 1<br />

V (yt) = 0 < 1<br />

Cov(yty t k) = k; k = 1; 2; 3::<br />

Stazionarieta’in senso debole. Esempio Processo White<br />

Noise<br />

autocovarianza<br />

autocorrelazione<br />

"t N(0; 2 " )<br />

k = Cov(yt; y t k) = Cov(y t k; yt)<br />

k = Cov(yt; y t k)<br />

V (yt)<br />

= k<br />

0

Funzione di autocorrelazione ACF: autocorrelazioni in funzione<br />

di k. Descrive la dipendenza fra le osservazioni.<br />

Per k = 2; 3; 4::<br />

processo AR(1)<br />

yt = + yt 1 + "t<br />

k = k<br />

0<br />

=<br />

k<br />

2<br />

1 2<br />

2<br />

1 2<br />

= k

processo MA(1)<br />

yt = + "t + "t 1<br />

1 = 1<br />

0<br />

e k = k<br />

0<br />

2<br />

=<br />

(1 + 2 ) 2 = 1 + 2<br />

0<br />

=<br />

(1 + 2 = 0<br />

) 2

1.2 Stazionarieta’e radici unitarie<br />

I processi MA(1) sono sempre stazionari.<br />

Un processo AR(1) si dice stazionario quando j j < 1<br />

yt = + yt 1 + "t<br />

Processi autoregressivi non stazionari:

1. Processi Di¤erenza Stazionari (DS), (in (1) =<br />

1)<br />

Es.:<br />

Random Walk yt = yt 1 + "t<br />

Random Walk plus drift yt = + yt 1 + "t<br />

V (cyt) = V (cyt 1) + 2<br />

Non c’è soluzione a meno che 2 = 0, la varianza è<br />

in…nita sia che = 1 e > 1.<br />

In alcuni casi e’ su¢ ciente calcolare le di¤erenze per<br />

trasformare una serie non stazionaria in stazionaria. Un<br />

random walk (processo non stazionario) si trasforma in<br />

un white noise ( processo stazionario)<br />

yt yt 1 = + "t<br />

Integrato di ordine uno I(1) yt = (yt yt 1)<br />

Integrato di ordine due I(2)<br />

2<br />

yt = ( yt yt 1)

1. Processi Trend Stazionari (TS). Processi di lungo<br />

periodo che hanno la media non costante nel tempo.<br />

yt = + t + "t<br />

f + tg trend deterministico. E’un processo trend<br />

stazionario nel senso che basta inserire un trend e<br />

diventa stazionario. Detrendizzazione

1.3 Test di radice unitaria<br />

Per il processo AR(1)<br />

yt = + yt 1 + "t<br />

= 1 corrisponde al test di radice unitaria. Dickey Fuller<br />

(1979) dimostrano che, dato che yt non e’stazionario, lo<br />

stimatore OLS di ^ non ha una distribuzione t. Dunque<br />

in alternativa e’stata proposta la seguente statistica<br />

DF =<br />

1<br />

s:e:(^)<br />

dove ^ e’stimato tramite un OLS ma i valori critici sono<br />

ricavati da una distribuzione corretta.<br />

H0 : = 1 Random Walk DS<br />

H1 : j j < 1 Stazionario<br />

al 5% t DF = 2; 86

Per convenienza di solito si riscrive il modello come<br />

dato che<br />

yt = + ( 1) yt 1 + "t (2)<br />

yt yt 1 = + yt 1 yt 1 + "t<br />

e si sottopone a test H0 : ( 1) = 0: Nota che questa<br />

speci…cazione e’ robusta a problemi di autocorrelazione<br />

dei residui.<br />

Di solito siamo interessati a 2 casi in particolare:<br />

1. Processo stazionario attorno ad una intercetta<br />

yt = + yt 1 + "t<br />

H0 : Random Walk<br />

H1 : Stazionario con intercetta<br />

yt = + ( 1) yt 1 + "t<br />

H0 : = ( 1) = 0<br />

si procede con un F test

2. Processo stazionario attorno ad un trend con intercetta<br />

yt = + yt 1 + t + "t<br />

H0 : Random Walk<br />

H1 : Stazionario ad un trend con intercetta<br />

yt = + ( 1) yt 1 + t + "t<br />

H0 : = ( 1) = = 0<br />

Le statistiche di DW sono dunque , , t ed F<br />

Nota che poiche’i test di radice unitaria hanno potenza<br />

piu’bassa dei test di signi…cativita’dei coe¢ cienti e’stata

proposta una alternativa: il KPSS. Questo test si basa<br />

sull’idea che ogni serie storica e’una somma di un trend<br />

deterministico, un random walk e un termine d’errore<br />

stazionario. Sotto H0 di processo stazionario attorno ad<br />

un trend o no<br />

1. primo passo OLS yt = + t + "t ) ^"t = et<br />

2. somme parziali st = P t s=1 es per ogni t:<br />

KP SS =<br />

P Tt=1 s 2 t<br />

^ 2<br />

e’una statistica LM:^ 2 Newey West standard error.<br />

1.4 Processi AR di ordine superiore al primo<br />

yt = c + 1yt 1 + 2yt 2 + "t<br />

"t W N(0; 2 ")

e’un AR(2). Utilizzando gli operatori del ritardo ricaviamo<br />

le condizioni necessarie e su¢ cienti per la stazionarita’.<br />

Un processo AR(2) si dice stazionario se tutte le radici<br />

di<br />

(1 1L 2L 2 ) = 0<br />

cadono al di fuori del cerchio unitario nel campo complesso.<br />

yt = c + 1yt 1 + 2yt 2 + ::: pyt p + "t<br />

"t W N(0; 2 " )<br />

e’un AR(p).<br />

(1 1L 2L 2 ::: pL p ) = 0<br />

(L)yt = c + "t<br />

cioe’ le cui radici devono cadere al di fuori del cerchio<br />

unitario nel campo complesso<br />

AR(p) e’un processo stazionario solo se<br />

1P<br />

i=0<br />

j ij < 1

se almeno una radice e’uguale a 1 1P<br />

i=0<br />

j ij = 1<br />

Il Test di Dickey Fuller per un AR(p) si basa sulla seguente<br />

speci…cazione (seguendo gli stessi passaggi visti per (2))<br />

yt = + t + 'yt 1 +<br />

dove ' =<br />

pP<br />

i=1 i<br />

!<br />

1.5 Processi ARMA<br />

ARMA(1,1)<br />

ARMA(p,q)<br />

p 1<br />

P<br />

1; i = p P<br />

i=1 i<br />

yt = + yt 1 + "t + "t 1<br />

i=1 i yt i + "t<br />

yt = + 1yt 1 + 2yt 2 + :: + pyt p<br />

+"t + 1"t 1 + :: + q"t q

1.6 Funzione di autocorrelazione parziale<br />

Autocorrelazione parziale fra yt e yt p denominata pp e’<br />

un legame di correlazione fra yt e yt p al netto dell’in‡uenza<br />

esercitata dai termini intermedi yt 1; :::yt p+1<br />

yt = + 1yt 1 + "t ) ^ 11<br />

yt = + 1yt 1 + 2yt 2 + "t ) ^ 22 stima di 2<br />

Nota che per un AR(p) il ^ kk = 0 8k > p .<br />

Per esempio AR(1) il ^ 22 = ^ 33 = ::: = 0<br />

Per un MA(1) PACF convergono verso zero piu’o meno<br />

rapidamente<br />

In un ARMA (p,q) sia la ACF che la PACF non tagliano<br />

mai zero ma convergono a zero asintoticamente.

2 Speci…cazione stima e controllo<br />

diagnostico - Regole generali<br />

1) Identi…cazione<br />

2) Stima<br />

3) Controllo diagnostico<br />

2.1 Identi…cazione<br />

E’una procedura iterativa<br />

Scelta del tipo di modello AR o MA e del loro ordine.<br />

Guardare le AFC e PACF e confrontare

1. AR (p) stazionaria la ACF decade geometricamente<br />

la PACF taglia dopo p periodi<br />

2. MA(q) ACF taglia dopo q periodi mentre la PACF<br />

decade geometricamente<br />

3. ARMA(p,q) non c’è in nessuno dei due casi un taglio<br />

netto<br />

2.2 Stima ARMA<br />

1. AR(p) OLS corretto consistente ed e¢ ciente MLE<br />

2. MA(q) OLS non e’possibile perche’i regressori sono<br />

incogniti. Si utilizza la stima MLE che richiede<br />

un’ipotesi sulla distribuzione dei termini di disturbo<br />

e procedure numeriche di massimizzazione<br />

3. ARMA(p,q) vedi punto 2

2.3 Controllo diagnostico<br />

La speci…cazione scelta e’adatta ai …ni previsivi?<br />

1. SOVRAPARAMETRIZZATO i coe¢ cienti sono signi…cativi?<br />

coe¢ cienti relativi all’ordine p o q scelti<br />

! se i coe¤ relativi agli ordini troppo alti sono non<br />

signi…cativi si possono ridurre i parametri da stimare<br />

t test o F test<br />

2. SOTTOPARAMETRIZZATO<br />

yt = ^c + ^ 1yt 1 + ^ 2yt 2 + ^ 3yt 3 +<br />

^"t + ^ 1^"t 1 + ^ 2^"t 2 + ^ 3^"t 3 + ^ 4^"t 4<br />

^ 4 e’ signi…cativo? La parsimonia e’ un principio<br />

fondamentale<br />

Veri…care l’ipotesi di autocorrelazione dei residui<br />

=)errata speci…cazione

Model selection criteria: Akaike Information Criterion<br />

e Schwarz Bayesian Criterion<br />

AIC(p) = T log(^ 2 ) + 2p<br />

SBC(p) = T log(^ 2 ) + p log T<br />

^ 2 = RSS=(n p). La regole e’ di scegliere il<br />

modello con piu’basso AIC e SBC<br />

3 Modelli dinamici con variabili stazionar<br />

Modello autoregressivo a ritardi distribuiti<br />

yt = + yt 1 + 0xt + 1xt 1 + "t (3)<br />

dove "t W N indipendente da yt 1; yt 2 e xt; xt 1.<br />

Calcolando le derivate parziali possiamo calcolare il moltiplicatore<br />

d’impatto. E¤etto di xt su yt<br />

@yt<br />

@xt<br />

= 0

L’e¤etto dopo un periodo e’dato da<br />

@yt+1<br />

@xt<br />

dopo due periodi<br />

= @yt<br />

@xt<br />

@yt+2<br />

+ 1 = 0 + 1<br />

= ( 0 + 1)<br />

@xt<br />

Se j j < 1 gli e¤etti superiori al primo sono decrescent.<br />

iIl moltiplicatore di lungo periodo (o moltiplicatore di<br />

equilibrio) e’<br />

@yt<br />

@xt<br />

+ @yt+1<br />

@xt<br />

+ @yt+2<br />

@xt<br />

+ ::: =<br />

0 + ( 0 + 1) + ( ( 0 + 1)) + ::: = 0 + 1<br />

1<br />

Allo stesso risultato si giunge calcolando il valore atteso<br />

della (3)<br />

E(yt) = + E(yt 1) + 0E(xt) + 1E(xt 1)<br />

= 1<br />

+ 0 + 1<br />

E(xt)<br />

1<br />

Il modello (3) puo’essere stimato con il metodo OLS a<br />

condizione che E(xt"t) = 0

![[ ]](https://img.yumpu.com/14935362/1/184x260/-.jpg?quality=85)