Archeomatica 2 2022

Tecnologie per i Beni Culturali

Tecnologie per i Beni Culturali

Create successful ePaper yourself

Turn your PDF publications into a flip-book with our unique Google optimized e-Paper software.

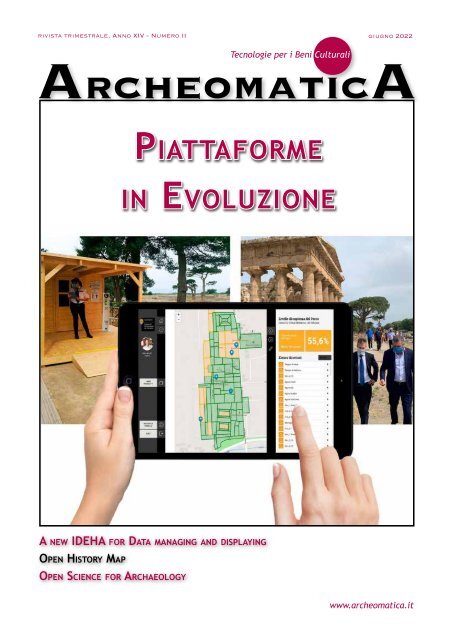

ivista trimestrale, Anno XIV - Numero II giugno <strong>2022</strong><br />

ArcheomaticA<br />

Tecnologie per i Beni Culturali<br />

Piattaforme<br />

in Evoluzione<br />

A new IDEHA for Data managing and displaying<br />

Open History Map<br />

Open Science for Archaeology<br />

www.archeomatica.it

EDITORIALE<br />

Diritto d'autore e Digitale<br />

Questo numero di <strong>Archeomatica</strong> tocca, con l’articolo di Paolo Rosati dal titolo Open<br />

science for archeology, il complesso tema delle Creative Commons Licences. Quante e di<br />

che tipo sono le licenze in Open access, che il Web ha ottenuto di diffondere. Quasi tutte<br />

dispensano la licenza di utilizzo in tutto o in parte di un lavoro letterario o scientifico,<br />

purché siano rispettate le dichiarazioni dei crediti autoriali o, per meglio dire, i crediti<br />

delle istituzioni, fondazioni ed editori che li detengono. Lo spartiacque fondamentale è<br />

tra le edizioni ante e post 1940, ma non per tutti i paesi è ugualmente regolamentato ed<br />

anche per una buona fetta di opere anteriori al 1940, se non tutte, per poterle consultare<br />

il lettore e lo studente dovranno registrarsi e dichiarare di non volerne fare un uso<br />

commerciale per poterle scaricare. Non è chiaro perchè, dal momento che quasi nessuna<br />

delle istituzioni e degli editori coinvolti potrebbero dimostrare di aver mai acquistato i<br />

diritti autoriali delle opere e la loro acquisizione è per lo più soggetta a legislazioni di<br />

singoli stati, mirate alla diffusione pubblica del bene, conditio sine qua non di un uso<br />

commerciale. In altre parole, autori ed editori pioneristici che ne hanno suffragato la<br />

creazione, la pubblicazione e la riproduzione possono continuare a crepare di fame per<br />

generazioni ed il pubblico dovrà continuare a pagare il prezzo di un disagio anche quando<br />

l’accessibilità e i diritti di riproduzione siano scaduti da tempo. Un dato di fatto è che la<br />

fruizione sia un bene commerciale e che le schiere di riproduttori siano schiere di fruitori<br />

che contribuiscono al valore di un’opera. Voler limitare l’accessione ad un prodotto<br />

autoriale da parte di chi non ne è autore, al contrario, è un’operazione commerciale a<br />

tutto tondo. Se opere enciclopediche come Wikipedia hanno mostrato quanto lento sia<br />

l’aggiornamento culturale di una produzione dai confini sempre più illimitati, hanno d’altra<br />

parte dimostrato anche che quasi mai nessuno sa chi ha detto che. E’ che il grosso del<br />

lavoro di ogni autore è tracciare l’identikit di un prodotto culturale, afferrare chi, dove e<br />

quando ne abbia detto che, per finire a scoprire che molte volte i più autorevoli ideatori e<br />

interpreti siano i più taciuti e gratuiti. La letteratura è un lavoro di copia e incolla, dove<br />

il plagio è all’ordine del giorno e forse è proprio questo a fare della ricerca in open access<br />

la novità della crescita di una comunità scientifica: la misura di una fruizione simultanea<br />

di una mole prima d’ora quasi imperscrutabile di dati, in cui anche l’autore neofita possa<br />

addentrarsi come uno scolaretto e raggiungere il bene di leggerla a portata di mano,<br />

ripagando gli autori e gli editori che l’hanno realizzata a questo fine e nessun altro. Il Web<br />

è quel buon padre di famiglia che mette nel nostro scaffale un’indice di opere in un modo o<br />

nell’altro proibite, frutto di un'umanità intera, in cui trovare non tanto e non solo qualcosa<br />

di nuovo da dire, ma le ragioni del nostro dire più pressante, che, dopo aver letto e riletto,<br />

ci sembrerà sempre meno uguale e sempre più comprensibile ad altri, meno divulgativo che<br />

mai. Un obbiettivo fondamentale del web, da non cambiare, è che nessun altro dispensi<br />

un’opera se non chi l’ha creata e che il più acuto dei lettori ne sia anche il suo inventore.<br />

La fruizione digitale non sostituisce il contatto diretto con l’opera d’arte e nemmeno<br />

le possibilità d’investimento commerciale nel prodotto. La sua portata rivoluzionaria e’<br />

paragonabile all’invenzione della stampa tipografica: ci aiuterà a scoprire, come buoni<br />

indagatori, qualcosa di falso in quello che la storia ha riconosciuto vero. Un nuovo impegno<br />

nell’esercizio d’immaginazione, ma con una memoria meno ingombrante nello spazio fisico<br />

che ci circonda e, soprattutto, senza rifiuti.<br />

Buona lettura,<br />

Francesca Salvemini

IN QUESTO NUMERO<br />

DOCUMENTAZIONE<br />

6 Uno strumento per<br />

la digitalizzazione e<br />

gestione<br />

del Patrimonio<br />

Culturale nel Parco<br />

Archeologico<br />

di Paestum e Velia: la<br />

piattaforma HERA di Gabriel Zuchtriegel,<br />

Francesco Uliano Scelza, Riccardo Auci, Cristiano Benedetto De Vita<br />

In copertina dimostrazione del Tablet per la<br />

gestione dei flussi di fruizione della<br />

piattaforma Hera, utilizzata nel Parco<br />

Archeologico di Paestum e Velia.<br />

GUEST Paper<br />

12 Full immersion in<br />

Cultural Heritage<br />

environments:<br />

A new IDEHA for<br />

data managing and<br />

displaying<br />

By Luca Bevilacqua, Bruno<br />

Fanini, Nicola Mariniello, Augusto Palombini, Vladimiro Scotto di Carlo,<br />

Giuseppe Scardozzi, Antonio Sorgente, Paolo Vanacore<br />

Segui l'account di <strong>Archeomatica</strong><br />

su Twitter, Facebook e Instagram<br />

ArcheomaticA<br />

Tecnologie per i Beni Culturali<br />

Anno XIV, N° 2 - GIUGNO <strong>2022</strong><br />

<strong>Archeomatica</strong>, trimestrale pubblicata dal 2009, è la prima rivista<br />

italiana interamente dedicata alla divulgazione, promozione<br />

e interscambio di conoscenze sulle tecnologie per la tutela,<br />

la conservazione, la valorizzazione e la fruizione del patrimonio<br />

culturale italiano ed internazionale. Pubblica argomenti su<br />

tecnologie per il rilievo e la documentazione, per l'analisi e la<br />

diagnosi, per l'intervento di restauro o per la manutenzione e,<br />

in ultimo, per la fruizione legata all'indotto dei musei e dei<br />

parchi archeologici, senza tralasciare le modalità di fruizione<br />

avanzata del web con il suo social networking e le periferiche<br />

"smart". Collabora con tutti i riferimenti del settore sia italiani<br />

che stranieri, tra i quali professionisti, istituzioni, accademia,<br />

enti di ricerca e pubbliche amministrazioni.<br />

Direttore<br />

Renzo Carlucci<br />

dir@archeomatica.it<br />

Direttore Responsabile<br />

Michele Fasolo<br />

michele.fasolo@archeomatica.it<br />

comItAto scIentIfIco<br />

Giuseppe CeRaudo, annalisa CipRiani, MauRizio<br />

FoRte, BeRnaRd FRisCheR, Giovanni ettoRe<br />

GiGante, MaRio MiCheli, steFano Monti,<br />

luCa papi, MaRCo RaMazzotti,<br />

antonino saGGio, FRanCesCa salveMini,<br />

RodolFo MaRia stRollo<br />

Redazione<br />

Maria Chiara Spezia<br />

redazione@archeomatica.it<br />

Matteo Serpetti<br />

matteo.serpetti@archeomatica.it<br />

Valerio Carlucci<br />

valerio.carlucci@archeomatica.it

RUBRICHE<br />

28 AZIENDE E<br />

PRODOTTI<br />

Soluzioni allo Stato<br />

dell'Arte<br />

32 AGORÀ<br />

16 Open History Map – Status of the Project<br />

by Marco Montanari, Lucia Marsicano, Raffaele Trojanis,<br />

Silvia Bernardoni, Lorenzo Gigli<br />

Notizie dal mondo delle<br />

Tecnologie dei Beni<br />

Culturali<br />

40 EVENTI<br />

22 Open Science for<br />

Archaeology:<br />

an up-to-date guide<br />

(<strong>2022</strong>)<br />

by Paolo Rosati<br />

INSERZIONISTI<br />

Esri 27<br />

GEC Software 11<br />

GEOMAX 31<br />

gter 15<br />

Hubstract 36<br />

Nais solutions 40<br />

Planetek 2<br />

Stonex 35<br />

Teorema 38<br />

TechnlogyForAll 39<br />

una pubblicazione<br />

Science & Technology Communication<br />

Science & Technology Communication<br />

Diffusione e Amministrazione<br />

Tatiana Iasillo<br />

diffusione@archeomatica.it<br />

MediaGEO soc. coop.<br />

Via Palestro, 95<br />

00185 Roma<br />

tel. 06.64.87.12.09<br />

fax. 06.62.20.95.10<br />

www.archeomatica.it<br />

Progetto grafico e impaginazione<br />

Daniele Carlucci<br />

daniele@archeomatica.it<br />

Editore<br />

MediaGEO soc. coop.<br />

<strong>Archeomatica</strong> è una testata registrata al<br />

Tribunale di Roma con il numero 395/2009<br />

del 19 novembre 2009<br />

ISSN 2037-2485<br />

Stampa<br />

System Graphic Srl<br />

Via di Torre Santa Anastasia 61 00134 Roma<br />

Condizioni di abbonamento<br />

La quota annuale di abbonamento alla rivista è di<br />

€ 45,00. Il prezzo di ciascun fascicolo compreso<br />

nell’abbonamento è di € 12,00.<br />

Il prezzo di ciascun fascicolo arretrato è di<br />

€ 15,00. I prezzi indicati si intendono Iva inclusa.Per<br />

abbonarsi: www.archeomatica.it<br />

Gli articoli firmati impegnano solo la responsabilità<br />

dell’autore. È vietata la riproduzione anche parziale<br />

del contenuto di questo numero della Rivista<br />

in qualsiasi forma e con qualsiasi procedimento<br />

elettronico o meccanico, ivi inclusi i sistemi di<br />

archiviazione e prelievo dati, senza il consenso scritto<br />

dell’editore.<br />

Data chiusura in redazione: 30 settembre <strong>2022</strong>

DOCUMENTAZIONE<br />

Uno strumento per la digitalizzazione e gestione<br />

del Patrimonio Culturale nel Parco Archeologico<br />

di Paestum e Velia: la piattaforma HERA<br />

di Gabriel Zuchtriegel, Francesco Uliano Scelza, Riccardo Auci, Cristiano Benedetto De Vita<br />

La digitalizzazione del Patrimonio<br />

Culturale sta cambiando<br />

radicalmente i luoghi e gli attori<br />

del sistema Cultura. Tale processo<br />

ha innescato nuovi percorsi di<br />

conoscenza e di valorizzazione,<br />

ponendo l’accento sulla necessità<br />

di individuare strumenti e<br />

metodologie innovative atte a<br />

garantire una razionalizzazione<br />

Fig. 1 - HERA PAESTUM. Schema di sintesi delle caratteristiche e delle funzionalità del<br />

sistema<br />

delle attività alla base del<br />

funzionamento degli Enti<br />

Culturali. Da questo punto di<br />

vista, HERA, la piattaforma di<br />

gestione del Parco Archeologico<br />

di Paestum e Velia, sta<br />

fissando nuovi standard per<br />

la digitalizzazione, per la<br />

la digitalizzazione,<br />

per la conoscenza<br />

e la gestione del<br />

Pat- rimonio.<br />

conoscenza e la gestione del<br />

Paestum e Velia,<br />

sta fissando nuovi<br />

standard per<br />

Patrimonio.<br />

l’accento sulla necessità di individuare strumenti e metodologie<br />

innovative atte a garantire una razionalizzazione delle attività alla base<br />

del funzionamento degli Enti Culturali. Da questo punto di vista, HERA,<br />

la piattaforma di<br />

ges- tione del Parco<br />

Ar- cheologico di<br />

a digitalizzazione del Patrimonio Culturale sta cambiando radicalmente<br />

i luoghi e gli attori del sistema Cultura. Tale processo ha innescato<br />

nuovi percorsi di conoscenza e di valorizzazione, ponendo<br />

L<br />

La forte spinta alla digitalizzazione e lo sviluppo delle<br />

nuove tecnologie per la gestione di big data ha<br />

portato negli ultimi anni a un’ampia rilettura delle<br />

necessità e delle criticità del lavoro degli Enti Culturali,<br />

con l’obiettivo di individuare soluzioni in grado di migliorare<br />

il complesso di attività e di processi che si svolgono<br />

quotidianamente al loro interno. Si riconosce oggi nel digitale<br />

un mezzo per incrementare la cura e la diffusione<br />

del Patrimonio, due degli obiettivi principali di qualunque<br />

Istituzione culturale.<br />

In questo contesto, da alcuni anni il Parco Archeologico di<br />

Paestum e Velia ha avviato la progettazione di uno strumento<br />

digitale di razionalizzazione delle attività e dei<br />

compiti. Il processo ha avuto inizio dall’analisi della complessità<br />

che caratterizza questo Ente: una complessità<br />

riconoscibile in un patrimonio composito costituito da tre<br />

aree archeologiche con i loro monumenti e stratigrafie;<br />

una documentazione scientifica prodotta in almeno cento<br />

anni di attività e un complesso di reperti e manufatti<br />

ricchissimo, in parte esposto e per lo più conservato nei<br />

depositi; e, ancora, strutture, spazi espositivi, laboratori,<br />

documentazione amministrativa.<br />

6 ArcheomaticA N°2 Giugno <strong>2022</strong>

Tecnologie per i Beni Culturali 7<br />

Fig. 2 - Interfaccia schedografica, con visualizzazione dei reperti catalogati (schede MINP e RA)<br />

Rispetto a tale quadro di così grande eterogeneità nelle sue<br />

forme e nelle sue criticità è emerso l’obiettivo di costruire<br />

una piattaforma che potesse collazionare il patrimonio e<br />

gestirne le attività connesse, sia in fase di programmazione,<br />

sia in quelle di progettazione ed esecuzione; sia rivolte<br />

alla tutela, sia alla fruizione e valorizzazione. Scavi archeologici,<br />

catalogazione, restauri, manutenzione, sono operazioni,<br />

alcune esemplificative di un ventaglio ampio di attività,<br />

che richiedono protocolli e procedure che possano<br />

soddisfare, in termini di efficienza e di risultati, l’impiego<br />

di risorse economiche e umane anche consistenti.<br />

Inoltre, è risultato fondamentale creare un sistema digitale<br />

interoperabile con altre piattaforme già esistenti e con<br />

il mondo esterno al parco, con quell’ampio pubblico che è<br />

il destinatario ultimo delle finalità di tutela e valorizzazione<br />

del patrimonio.<br />

In collaborazione con Visivalab, il Parco ha così progettato<br />

e sviluppato HERA, una piattaforma digitale realizzata per<br />

razionalizzare il Patrimonio dell’Istituto e garantirne la gestione,<br />

la cura e la diffusione.<br />

HERA è formulata secondo un approccio multiutente e dinamico<br />

per cui garantisce un accesso globale al Patrimonio<br />

per differenti livelli di utilizzo, e per distinti trasferimenti<br />

e aggiornamenti. La struttura del sistema si articola su<br />

quattro macro blocchi: area archeologica, sale espositive,<br />

deposito ed archivio. Ciascun raggruppamento ha propri<br />

apparati documentali e regole di utilizzo. Le singole sezioni<br />

sono realizzate per soddisfare gli obblighi di legge di<br />

tutela e di valorizzazione: conoscenza (inventario, catalogo,<br />

ricerca, etc.); conservazione (stoccaggio, monitoraggio,<br />

manutenzione, restauro, etc.); fruizione (diffusione,<br />

riproduzione, studio, uso, etc.).<br />

I dati sono raccolti in un sistema web che permette di<br />

gestire le informazioni sul patrimonio con un’interfaccia<br />

grafica intuitiva. Non si tratta solo di un database online,<br />

bensì di uno strumento dinamico, che permette di utilizzare<br />

i dati disponibili, di crearne di nuovi, di ricercarli e<br />

di organizzarli.<br />

Secondo un’ottica GIS based, HERA è costituita da due interfacce<br />

principali: quella schedografica e quella cartografica.<br />

La prima accoglie tutta la documentazione suddivisa<br />

per categorie specifiche. Più di 27.000 elementi ad oggi<br />

importati sono catalogati secondo schede strutturate sugli<br />

standard ICCD. I dati spaziano dalle planimetrie e disegni<br />

agli archivi di tipo scientifico e amministrativo, dalla bibliografia<br />

alle fotografie, ai reperti mobili, alle indagini<br />

archeologiche. Grazie al lavoro dei funzionari e degli archeologi,<br />

è stato possibile organizzare i database presenti<br />

all’interno degli archivi del Parco, e di sistematizzare le<br />

informazioni inedite o raccolte in maniera asistematica.<br />

Le schede di questa sezione possono essere modificate,<br />

esportate e incrementate. Funzionalità aggiuntive della<br />

sezione permettono di avviare attività di catalogazione con<br />

gruppi di reperti che possono poi essere esportati all’interno<br />

del SIGECweb dell’ICCD. Simili procedure possono<br />

essere attivate per le informazioni legate alle indagini di<br />

scavo e alla documentazione scientifica e amministrativa.<br />

La seconda interfaccia è di tipo cartografico, implementata<br />

attraverso una pianta georiferita della città antica,<br />

la più aggiornata possibile, prodotta attraverso la raccolta<br />

di supporti cartacei e digitali. È disponibile anche la<br />

pianta dei depositi del Museo, che riproduce gli ambienti,<br />

la disposizione degli scaffali e dei ripiani sui quali sono<br />

conservati i reperti mobili. La cartografia è aggiornabile: è<br />

possibile aggiungere e sovrapporre ulteriori supporti multiscalari<br />

e multitemporali (rilievi, mappe catastali, carte<br />

tecniche regionali).<br />

Particolare attenzione è stata data anche al territorio, in<br />

quanto la rappresentazione cartografica non ha limiti spaziali,<br />

ed è dunque possibile aggiungere informazioni relative<br />

all’esterno del perimetro dell’area archeologica.<br />

Le basi cartografiche costituiscono i supporti su cui sono<br />

distribuiti i dati: ogni elemento schedato (che sia un reperto,<br />

uno scavo, un monumento, etc.) è rappresentato<br />

vettorialmente, è geolocalizzato ed è individuabile tramite<br />

ricerca o navigazione libera. Elementi topografici e

Fig. 3 - Interfaccia cartografica: in rosso i poligoni riferibili ai saggi di scavo effettuati nell’area archeologica.<br />

indagini (quasi 500 tra scavo e prospezioni, e più di 1000<br />

monumenti e sepolture) sono rappresentati da poligoni, visualizzabili<br />

attraverso una tabella dei layer.<br />

I reperti sono collegati al contesto di rinvenimento e al<br />

luogo di conservazione o di esposizione. Ciò significa che<br />

uno stesso reperto archeologico può essere correlato a<br />

molteplici informazioni di localizzazione (multiple georeferenced<br />

information) relative al luogo di provenienza e<br />

ai luoghi di fruizione. In pratica, questa soluzione segue<br />

la storia di ciascun reperto e ne prevede lo sviluppo. Difatti<br />

è contemplata la possibilità di variare le informazioni<br />

spaziali in funzione dei movimenti che il reperto affronta,<br />

come nei casi di restauri, mostre ed esposizioni. Al tempo<br />

stesso è fissato il collegamento con i contesti di provenienza.<br />

All’interno di questa costruzione, la mappatura dei depositi<br />

e degli spazi espositivi costituisce un elemento essenziale,<br />

poiché fornisce le informazioni di destinazione del<br />

patrimonio mobile. Come già detto, ogni singolo scaffale<br />

o supporto è stato riprodotto digitalmente sotto forma di<br />

poligoni vettoriali ed è consultabile sulla mappa. I poligoni<br />

rappresentano dei veri e propri contenitori nei quali<br />

sono inseriti i reperti e le cassette. Si possono effettuare<br />

ricerche direttamente sulla schermata dei depositi,<br />

Fig. 4 - Gestione dei contenitori e della pianta dei depositi, attraverso l’utilizzo di supporti mobile.<br />

8 ArcheomaticA N°2 Giugno <strong>2022</strong>

Tecnologie per i Beni Culturali 9<br />

Fig. 5 - Il sistema SIMOVI per la gestione dei flussi di visita all’interno dell’area archeologica.<br />

verificare la posizione dei materiali dalle schede di riferimento<br />

o navigare liberamente nella pianta. Il prossimo<br />

aggiornamento del sistema prevede l’applicazione di QR<br />

code o RFID ad ogni singola cassetta. In questo modo, le<br />

operazioni di movimentazione, individuazione, collazione<br />

e riorganizzazione dei materiali saranno rese ancora più<br />

controllate e immediate.<br />

La massa di documentazione importata e i processi di acquisizione<br />

e presentazione del dato archeologico sono stati<br />

validati attraverso una fase di testing. Una seconda fase<br />

di verifica si è svolta insieme ai funzionari e agli operatori<br />

del Parco col fine di sperimentare e di rendere il sistema il<br />

più duttile possibile.<br />

Proprio perché rivolto a destinatari differenti, HERA presenta<br />

un accesso multiutente, con livelli di sicurezza scalari.<br />

Quello minimo garantisce al pubblico la consultazione<br />

del catalogo e dell’apparato cartografico (consultabili<br />

all’indirizzo https://hera.beniculturali.it/catalogo). Per<br />

le funzionalità di gestione e di ricerca sono predisposti<br />

profili specifici con i quali gli operatori del Parco o eventuali<br />

concessionari possono accedere.<br />

Gli utenti avanzati – i funzionari del parco – decidono in<br />

ogni momento cosa pubblicare e come farlo, gestiscono gli<br />

spazi di lavoro in modalità condivisa - evitando così la duplicazione<br />

di informazioni – e possono effettuare ricerche<br />

congiunte o attraverso indici specializzati per tipologia di<br />

materiale.<br />

Un ulteriore modulo del sistema è dedicato alla creazione<br />

di progetti individuali. Questa funzione permette di organizzare<br />

attività di lavoro, come ad esempio restauri, prestiti,<br />

scavi archeologici, etc., poiché consente di raggruppare<br />

in maniera rapida tutte le informazioni necessarie a<br />

procedere con il lavoro. Queste schede di progettazione<br />

sono condivisibili con gruppi di lavoro interni.<br />

È in fase di test un modulo per la gestione delle attività<br />

di manutenzione e la pianificazione di restauri su reperti e<br />

monumenti, che sfrutterà come base l’apparato cartografico,<br />

e si munirà di un sistema di calendarizzazione degli<br />

interventi e di alert nel caso delle emergenze, queste ultime<br />

segnalabili da tutti i tipi di utenti.<br />

Infine, una fondamentale feature che rende HERA flessibile<br />

in rapporto al tema della valorizzazione è la sua integrazione<br />

con l’app di visita PAESTUM. Questo legame rende<br />

semplice la migrazione di contenuti dalla piattaforma<br />

all’applicazione mobile, con la possibilità di creare nuovi<br />

percorsi e punti di interesse, mostre digitali e altro.<br />

Il modulo chiamato SIMOVI consente, tramite la geolocalizzazione<br />

dell’app di visita, il controllo dei flussi dei visitatori<br />

all’interno dell’area archeologica. La raccolta dei<br />

dati, nel totale rispetto della privacy, è stata resa necessaria<br />

con l’inasprirsi della pandemia di Covid-19 a partire<br />

dal marzo del 2020. Proprio il monitoraggio dei flussi ha<br />

permesso al Parco di aprire in sicurezza e di garantire la<br />

visita.<br />

SIMOVI funziona attraverso la perimetrazione in poligoni<br />

dell’area archeologica. Ad ogni poligono è assegnato un<br />

indice di densità massimo delle presenze. Quando questo<br />

indice viene raggiunto, il sistema invia automaticamente<br />

ai visitatori presenti nell’area e agli addetti alla vigilanza<br />

un allarme di sicurezza.<br />

Le informazioni sui flussi si dimostrano utili per riconoscere<br />

le aree a maggior concentrazione e quindi soggette<br />

a maggior degrado, ma anche per individuare quali sono i<br />

percorsi più apprezzati dai visitatori o i punti di interesse

maggiormente evocativi. Si possono così aprire nuovi percorsi,<br />

pianificare la valorizzazione di nuove aree, perimetrare<br />

i cantieri, e molto altro.<br />

La struttura in moduli e la possibilità di aggiornamenti<br />

continui, la logica di georeferenziazione e l’utilizzo di<br />

standard catalografici rendono la piattaforma HERA altamente<br />

scalabile e replicabile, applicabile al singolo Museo,<br />

al Parco, all’Archivio. I moduli possono essere selezionati e<br />

aggiunti, e questo rende anche più semplice la possibilità<br />

di costruire uno strumento via via più completo.<br />

Per concludere, la piattaforma HERA è strutturata con l’intento<br />

di rendere il patrimonio il più possibile permeabile,<br />

gestibile e conoscibile. Il suo utilizzo si configura in un<br />

movimento circolare che permette di passare da un ambito<br />

di interesse ad un altro attraverso legami tematici,<br />

informativi, spaziali. Non esiste un “vicolo cieco” nell’uso<br />

e nella fruizione del patrimonio, ma un processo di conoscenza<br />

e gestione continuo e reiterabile. Sono questi<br />

movimenti, valorizzati nel mondo digitale, che accrescono<br />

il valore storico del Patrimonio di Paestum. Per dirla con<br />

altre parole, attraverso HERA i contesti di produzione del<br />

dato, i processi di acquisizione del patrimonio, il lavoro di<br />

tutela, sono unificati e valorizzati. In HERA l’individuazione,<br />

la catalogazione e la pubblicazione del dato sono integrate<br />

quali funzioni di un processo in continuo svolgimento<br />

che costantemente si alimenta sia dalla ricerca, sia dalla<br />

fruizione.<br />

METADESCRIPTION<br />

HERA è la piattaforma di catalogazione e gestione del patrimonio<br />

archeologico del Parco di Paestum.<br />

BREVE SCHEDA DELL’AZIENDA<br />

Il Parco Archeologico di Paestum e Velia ha demandato la costruzione<br />

della struttura tecnologica di HERA a Visivalab.<br />

La collaborazione è stata avviata con la direzione di Gabriel<br />

Zuchtriegel nel 2019. Le funzionalità del sistema sono state<br />

implementate dall’azienda attraverso le proposte progettuali<br />

dei funzionari del parco, e su indirizzo di Francesco Uliano<br />

Scelza. Visivalab ha collaborato anche nella progettazione<br />

dell’APP di visita e fornisce continuo supporto, didattica e<br />

aggiornamenti sul sistema HERA.<br />

Visivalab è un laboratorio di esperienze che unisce le persone<br />

con le istituzioni culturali e i brand grazie alla fusione di<br />

design e tecnologia specializzata. Dal 2010 offre un'assistenza<br />

completa ai clienti che ha lo scopo di arricchire il lavoro<br />

in tutte le sue fasi, da quelle di indagine ed elaborazione a<br />

quelle di implementazione, installazione e supporto. Tra gli<br />

obiettivi principali di Visivalab è la costruzione di esperienze<br />

immersive capaci di creare un vincolo armonico tra Patrimonio,<br />

utenti e istituzioni. Le priorità sono quelle di garantire<br />

risultati concreti in grado di lasciare il segno nella memoria<br />

del singolo utente, e di migliorare i processi che coinvolgono<br />

l’operato degli esperti dei Beni Culturali.<br />

Piattaforme digitali, sistemi di catalogazione, Realtà Aumentata<br />

e Virtuale, Smart Track, Video Mapping, Assistenti Virtuali,<br />

sono solo alcune delle tecnologie che Visivalab declina<br />

a seconda delle esigenze.<br />

Abstract<br />

The digitization of the Cultural Heritage is radically changing places and workers/professionals/operators<br />

of the italian cultural system. This process has<br />

activated new paths of knowledge and valorization, placing the emphasis on<br />

the need to identify innovative tools and methodologies, and to ensure a rationalization<br />

of activities of Cultural Institutions. From this point of view,<br />

HERA, the digital platform of the Parco Archeologico di Paestum e Velia, is<br />

setting new standards for digitization, knowledge and management of the<br />

Heritage.<br />

Parole Chiave<br />

Digitalizzazione; HERA; Paestum; Database; Patrimonio Culturale<br />

Autore<br />

Gabriel Zuchtriegel<br />

gabriel.zuchtriegel@cultura.gov.it<br />

Direttore Parco Archeologico di Pompei (ex Direttore Parco Archeologico di<br />

Paestum e Velia)<br />

Francesco Uliano Scelza<br />

francescouliano.scelza@cultura.gov.it<br />

Funzionario archeologo Parco Archeologico di Paestum e Velia<br />

Riccardo Auci<br />

riccardo@visivalab.com<br />

Responsabile Visivalab SL<br />

Cristiano Benedetto De Vita<br />

cristiano@visivalab.com<br />

Archeologo, Visivalab SL<br />

10 ArcheomaticA N°2 Giugno <strong>2022</strong>

Tecnologie per i Beni Culturali 11

GUEST PAPER<br />

Full immersion in Cultural Heritage<br />

environments: A new IDEHA for<br />

data managing and displaying<br />

By Luca Bevilacqua, Bruno Fanini, Nicola Mariniello,<br />

Augusto Palombini, Vladimiro Scotto di Carlo,<br />

Giuseppe Scardozzi, Antonio Sorgente, Paolo Vanacore<br />

Fig. 1 - Equirectangular projection of a scene of the viewer (case study of Santa marinella, latium, Italy), with icons targeted<br />

to different kind of media contents.<br />

IDEHA (Innovation for Data<br />

Elaboration in Heritage Areas),<br />

is a PON project coordinated by<br />

CNR, aimed to an open platform<br />

for real-time aggregation<br />

of Cultural Heritage elements<br />

(sites, monuments, etc.) data,<br />

and their "packaging" in sets of<br />

informations for different targets<br />

of outlined public.<br />

THE IDEHA PROJECT<br />

The IDEHA project (“Innovations<br />

for Data Elaboration in Heritage<br />

Area”, PON FSC 2018-<strong>2022</strong> www.<br />

ideha.cnr.it), started in 2018,<br />

funded by the Italian Ministry of<br />

University and Research, under<br />

the coordination of the Italian<br />

National Research Council (CNR),<br />

and involving as partners many research<br />

institutions, as: Università<br />

degli Studi di Firenze, Università<br />

degli Studi di Modena and Reggio<br />

Emilia, Università degli Studi di<br />

Palermo, Università degli Studi di<br />

Bologna; and enterprises as: Engineering<br />

Ingegneria Informatica<br />

S.p.A.; 2038 Innovation Company<br />

S.r.l., Demetrix s.r.l., Centro di<br />

Ricerca, Sviluppo e Studi Superiori<br />

in Sardegna, Innovaway S.p.A.<br />

The overall aim of the project was<br />

an open source real time aggregator<br />

of data from different sources<br />

(archives, social networks, digital<br />

libraries, IoT sensors, etc.), related<br />

to specific CH items (sites,<br />

monuments, objects); to group<br />

them in “packages” tailored for<br />

specific targets of public, according<br />

to their profile (tourists,<br />

scholars, technicians, etc.). The<br />

project was organized in 8 operating<br />

unities (defined as "OR")<br />

12 ArcheomaticA N°2 Giugno <strong>2022</strong>

Tecnologie per i Beni Culturali 13<br />

OR1 Archiving, indexing & semantics<br />

OR2 HBIM for CH<br />

OR3 Open middleware for immersive<br />

& mobile apps<br />

OR4 Smart assisted visits<br />

OR5 Deep learning & Computer Vision<br />

OR6 AR technologies (Visualization<br />

tool)<br />

OR7 Business models for CH<br />

OR8 Case studies coordination<br />

The present communication is Focused<br />

on the work carried on by<br />

OR6, targeted to the creation of a<br />

visualization tool, to represent the<br />

project's output, and touches as<br />

well part of the OR8 activity, in relation to the fieldwork<br />

case studies. The entire pipeline is the result of a joint work<br />

intersecting WP 3,6,8, and, starting from the general need<br />

for a data visualization, it finally evolved to become a new<br />

kind of immersive interactive viewer, useful for different<br />

kinds of data representation in many areas of Cultural Heritage<br />

dissemination and analysis.<br />

The general IDEHA working flow concept<br />

consists in a pipeline that starts<br />

from the harvesting of different<br />

data sources, then setting up their<br />

semantic definition, and grouping<br />

them into 'packages' tailored for different<br />

categories of users, according<br />

to their profile (Fig.1).<br />

In such a context, the data viewer<br />

was conceived as a 360° immersive<br />

interactive environment (Mazzoleni<br />

et al.2006, Skola et al. 2020), to enjoy<br />

multimedia contents of any kind,<br />

through space and time, thanks to<br />

many different narrative metaphors.<br />

The viewer is capable of playing high<br />

definition 360° videos with different<br />

categories of contents embedded, to<br />

be activated through specific icons<br />

by the user. The content type may<br />

consist in any kind of media html5<br />

compatible, including pictures,<br />

texts, audio in the user's language<br />

through real-time translators and<br />

synthesizers, and so on; as well as<br />

the typical "virtual tour" transition<br />

icons to translate the users through<br />

different points of view (Fig. 2).<br />

Fig. 2 - The IDEHA working pipeline (see text for details)<br />

damental importance in the global tourism competition.<br />

Several venues are starting to offer usable digital versions<br />

of their Cultural Heritage site and collections content in<br />

Extended Reality to arouse interest and emotion. The rapid<br />

hardware and software evolution in telecommunication networks<br />

and XR-capable devices provide opportunities to gain<br />

THE VIEWER DEVELOPMENT<br />

Dealing with the data visualization<br />

tool planning, it was immediately<br />

evident the opportunity of creating<br />

a tool whose power could go over<br />

the simple project needs, and conceiving<br />

an immersive framework for<br />

different kinds of CH data. Such an<br />

aim implied a deeper reflection on<br />

the state-of-the art.<br />

For some years now, digital technologies<br />

have become a tool of fun-<br />

Fig. 3 - Screenshot of Web Interface: (a) texts stored in the knowledge base; (b) meta-information<br />

associated with a content

Fig. 4 - Endpoints for retrieving content from the knowledge base<br />

competitive positions in innovation but expose investments<br />

to obsolescence risk. Establishing and maintaining a relevant<br />

presence in the current and foreseeable cultural heritage<br />

metaverse is then a managerial and technical challenge.<br />

Reducing the obsolescence of digital content (videos,<br />

photos, 3D models) and allowing the reuse of existing digital<br />

content while gradually producing more advanced formats<br />

can be very useful.<br />

In the IDEHA project, CNR and Engineering adopted this<br />

strategic drive obtaining technical results that are:<br />

• open and based on standards,<br />

• cloud-native, and therefore very cost-effective,<br />

• horizontally scalable, from single sites to large regions,<br />

• able to manage the life cycle of digital content,<br />

reducing its obsolescence and facilitating its reuse.<br />

The IDEHA system can flexibly repurpose digital CH content,<br />

extending its life cycle by adopting standards to produce<br />

and preserve it, making it easy to create XR experiences<br />

that leverage digital content realized over time. Our current<br />

prototype features the possibility to define and deliver<br />

XR (immersive, interactive) visit experiences, featuring:<br />

- immersive digital content, such as 360° photos and videos,<br />

enriched by overlapping interactive elements, adding<br />

complementary audio and video, multimedia windows<br />

or panels, and links to other interactive scenes,<br />

- multilanguage ML-optimized Text-to-Speech audio descriptions,<br />

- seamless integration of XR experiences with traditional<br />

multimedia stories,<br />

- optimized delivery: high-resolution immersive pictures<br />

and video (up to 16384x8192 pixels), automatic adaptation<br />

to the user device (in terms of language and display<br />

resolutions), transcoding for optimal media delivery (basis<br />

texture formats for immersive static scenes, MPEG-<br />

DASH, or HLS for video scenes)<br />

- reuse of all digital content, immersive or traditional,<br />

maintaining the possibility to refine and update each item<br />

on its own while merging them "on the fly" in the overall<br />

experience,<br />

- html5 output containers to be used in websites, mobile<br />

apps, or virtual reality applications,<br />

- Artificial Intelligence models to reduce the obsolescence<br />

of digital content.<br />

TEXTUAL CONTENT MANAGEMENT<br />

The viewer described so far was conceived and created for<br />

managing and perceiving multimedia contents. Nevertheless,<br />

the different kinds of data produced in the project, in<br />

particular the semantic elaboration of texts, arose the need<br />

of adding a specific service to make textual materials as<br />

enjoyable as pictures and 3d models.<br />

One of the most natural ways to deliver cultural content is<br />

in natural language, particularly through speech. Therefore,<br />

enriching the fruition systems with audio contents that<br />

describe the artworks and/or the environments that are visited<br />

represents an added value.<br />

To this end, a microservices platform has been designed and<br />

developed to provide text and audio content when keyword<br />

queries are made on meta information.<br />

The platform allows the definition of a textual knowledge<br />

base and the organization of information through meta-information<br />

(tags described by a key-value pair) which will be<br />

used for the recovery of the texts. To facilitate use, a userfriendly<br />

web interface has been defined (Fig. 3) that is useful<br />

for managing and creating contents, and REST API services<br />

that allow the retrieval of the contents through program, so<br />

it can be integrated into any software platform (Fig. 4).<br />

For the generation of the audio content, a Text-To-Speech<br />

(TTS) service has been defined which allows us to obtain a<br />

vocal synthesis (audio stream) of the stored texts.<br />

The implemented service is an abstraction of TTS, that is,<br />

it defines a generic interface to which it is possible to connect<br />

and then use third-party services that perform speech<br />

synthesis. In the proposed implementation, TTS Google and<br />

Amazon Polly were added to the service.<br />

Fig.5: The ATON framework (snapshot representing the 3d model of the Augustus Forum virtual reconstruction)<br />

14 ArcheomaticA N°2 Giugno <strong>2022</strong>

TELERILEVAMENTO<br />

Tecnologie per i Beni Culturali 15<br />

The adoption of a Microservices architecture has made it<br />

possible to obtain a highly scalable and integrable system,<br />

oriented towards real-time interaction environments.<br />

This latter issue is particularly relevant in the context of<br />

the IDEHA project.<br />

FUTURE PERSPECTIVES AND MULTIPLE VIEWERS<br />

INTEGRATION<br />

Looking forward, the system may be improved in different<br />

ways. One of the main ones is the interaction with<br />

other viewers and browsers. In fact, any interactive icon<br />

in the 360 panorama may be conceived as an URL, moving<br />

the user towards a different viewpoint, also generated by<br />

another framework. In this way, different viewers, with<br />

their own peculiarities may be connected.<br />

The interactive 360° viewer was developed focusing on<br />

the capabilities of high definition 360° shooting, allowed<br />

by the last generation spherical cameras. Thus, the movie<br />

player skills of the system have been considered as<br />

fundamental, instead of other kinds of functions, such as<br />

browsing digital models in a 3d environment. Nevertheless<br />

the “time machine” function, allowing the user to<br />

observe the same landscape in a different time, is a further<br />

good task to achieve.<br />

Since some ten years, the ISPC-CNR has been developing<br />

the ATON 3d framework (http://osiris.itabc.cnr.it/aton/):<br />

open source, cross-platform, working without plugins and,<br />

again, compatible with all html5 media formats (Fanini et<br />

al. 2021) (Fig.5). Such a tool resulted as a very smart tool<br />

for 3d reconstruction of past environments and, generally,<br />

interactive visual storytelling (Palombini and Fanini<br />

2019, Fanini et al. 2019).<br />

Differently from the IDEHA viewer, ATON is mainly conceived<br />

for 3d landscape browsing. The next step is then<br />

the connection of the two frameworks, in order to allow,<br />

from the HR 2D movie player, to reach the reconstructed<br />

conditions of the same context, modeled and placed as to<br />

be reachable from the same position.<br />

References<br />

Fanini B., Ferdani D., Demetrescu E., Berto S., d’Annibale E. (2021) ATON:<br />

An Open-Source Framework for Creating Immersive, Collaborative and<br />

Liquid Web-Apps for Cultural Heritage. Applied Sciences 11, 22<br />

Fanini B., Pescarin S., Palombini A. (2019) A cloud-based architecture for<br />

processing and dissemination of 3D landscapes online. DAACH (Digital<br />

Applications in Archaeology and Cultural Heritage), 14<br />

Mazzoleni P., Valtolina S., Franzoni S., Mussio P., Bertino E. (2006) Towards<br />

a contextualized access to the cultural heritage world using 360 Panoramic<br />

Images. Proceedings of the Eighteenth International Conference on<br />

Software Engineering and Knowledge Engineering, San Francisco, CA, USA,<br />

July 5-7, 2006.<br />

Palombini A., Fanini B. (2019) Il Museo virtuale dell’Alta Valle del Calore.<br />

Archeologia e Calcolatori 30, 487-490<br />

Škola F., Rizvic S., Cozza M., Barbieri L., Bruno F., Skarlatos D., Liarokapis<br />

F. (2020) Virtual Reality with 360-Video Storytelling in Cultural Heritage:<br />

Study of Presence, Engagement, and Immersion. Sensors 20, 5851<br />

Abstract<br />

IDEHA (Innovation for Data Elaboration in Heritage Areas), is a PON project<br />

coordinated by CNR, aimed to an open platform for real-time aggregation of<br />

Cultural Heritage elements (sites, monuments, etc.) data, and their "packaging"<br />

in sets of informations for different targets of outlined public. The main<br />

tool conceived for displaying data (spread from different sources: news, digital<br />

libraries, IoT, etc.) is an immersive viewer capable of displaying 360° images<br />

and videos, all multimedia inserts html5-compatible, and multi-language<br />

audio-synthesized messages. Such a tool is presented here. It has been planned<br />

thanks to the effort of CNR and Engineering, and will be released in order<br />

to become a trigger of further initiatives both commercial and free.<br />

Keywords<br />

Cultural Heritage; 360° photography; semantics; interactivity; immersivity<br />

Autore<br />

Luca Bevilacqua(1), Bruno Fanini(2), Nicola Mariniello(1), Augusto Palombini(2),<br />

Vladimiro Scotto di Carlo(1), Giuseppe Scardozzi(2), Antonio Sorgente(3), Paolo<br />

Vanacore(1)<br />

(1) Engineering ingegneria informatica S.p.a. [name.surname@eng.it]<br />

(2) CNR- Institute of Heritage Science (ISPC) [name.surname@cnr.it]<br />

(3) CNR- Institute of Cybernetics (ICIB) [name.surname@cnr.it]<br />

MONITORAGGIO 3D<br />

GIS E WEBGIS<br />

www.gter.it<br />

info@gter.it<br />

GNSS<br />

FORMAZIONE<br />

RICERCA E INNOVAZIONE

GUEST PAPER<br />

Open History Map –<br />

Status of the Project<br />

by Marco Montanari, Lucia Marsicano, Raffaele Trojanis, Silvia Bernardoni, Lorenzo Gigli<br />

Open History Map, an open map of the past that<br />

was already presented as a concept a few years<br />

ago, is now in its first year of functioning infrastructure<br />

and collects around 150GB of data from<br />

around 90 sources. The platform is open in all of<br />

its aspects and enables research groups to create<br />

new importers for their own open datasets.<br />

Open History Map aims to be a platform that collects<br />

and displays data about our past with modern tools<br />

and considering several user groups as reference.<br />

This means that, unlike classic “collaborative” approaches,<br />

it does not rely on a users single contribution but<br />

more on blocks of contributions that are bound to research<br />

and to possible publications. This also means that despite<br />

the original approach wanted to be very ontology-centric<br />

[Montanari et al. 2015] and [Bernardoni et al. 2017], this<br />

maximalist requirement had to be changed to a more realistic<br />

and bottom-up approach, where several research<br />

groups use different ontologies and different representations<br />

for similar aspects, as each research group can give a<br />

very specific insight into one specific point of view on the<br />

same phenomenon in history or, on the contrary, similar<br />

points of view on very distant phenomena over time.<br />

This led us to a less strict integration methodology, where<br />

the ontology is still there, on our side, to enable the<br />

interpretation of the data in different ways and to guide<br />

users in the interoperability aspects of data cleaning.<br />

On the other hand, this lead us to a completely different<br />

approach to the infrastructure and to the architecture<br />

of the platform. Specifically, it meant Open History Map<br />

was no longer just “the map” and the data connected to<br />

it, but also the classification system, the importers, the<br />

methodology, the tools around the map itself. Choosing<br />

to open the doors to difference made the platform more<br />

robust and more solid. This also opened up for different<br />

elements we had not, at the beginning, considered. The<br />

“map” usually contains only “things that are there”, i.e.<br />

buildings, trees, objects that shape the world. What about<br />

all those elements that do shape the world in a non-direct<br />

way? Part of the context we aspired to create about things<br />

happening in our past with the original project is defined<br />

by the events that happened, because the “material”<br />

world and the “ephemeral” world are incredibly interwoven<br />

and interconnected.<br />

All these elements brought us to rework some of the concepts<br />

behind the platform itself. Open History Map is now<br />

an ecosystem of tools and points of view on the various<br />

aspects of data. This locates the project at a crossroads<br />

of several branches of knowledge and study, that can be<br />

summed up in the broad concept of Digital/Spatial Humanities.<br />

Nonetheless the platform is built with the idea not<br />

to force providers to bring data in a specific form, but to<br />

have every provider keeping her ontologies and formats in<br />

order to facilitate the work on the leaves of the ecosystem<br />

despite giving more work to the data integrator [Zundert,<br />

2012].<br />

16 ArcheomaticA N°2 Giugno <strong>2022</strong>

Tecnologie per i Beni Culturali 17<br />

Specifically, the ecosystem is now comprised of the following<br />

components:<br />

4Open History Map Data Index, to classify data sources<br />

and papers;<br />

4Open History Map Data Importer, to define transformations<br />

and extractors for the datasets;<br />

4Open History Map Viewer, to display photos, paintings<br />

and reconstructions of moments or views of the past<br />

located correctly in time and space;<br />

4Open History Map Event Index, to collect references to<br />

anthropic and natural events in time and their connections<br />

and relationships;<br />

4Open History Map, the core map of the project.<br />

In addition to these already existing parts, the following<br />

components are either planned or built but being rewritten<br />

to be integrated into the broader platform:<br />

4Open History Map Data Collector, to contain statistical<br />

data about several phenomena about the various time<br />

periods in the various places collected;<br />

4Open History Map Public History Toolkit, a tool to help<br />

researchers and groups to collect data about historical<br />

events and periods in a structured manner;<br />

4GeoContext [Marsicano 2018], a tool to create simple<br />

visualizations of self contained research data; this will<br />

be integrated into the OHM Public History Toolkit in order<br />

to make the datasets created explorable and navigable<br />

as single platforms.<br />

All of these components are different points of view and<br />

different ways to read the data contained in the core<br />

data storage. Technically it is not just one database but<br />

it is a constellation of databases interconnected via high<br />

level APIs enabling the maximization of the data throughput<br />

for the end-user.<br />

Every single one of these components has a well defined<br />

structural core ontology, on which we can rely to do the<br />

majority of the work, and a weaker “content” ontology<br />

part, where elements can be mapped or assigned in various<br />

ways and with varying degrees of quality. The core<br />

part is the one that the components use to define the<br />

main activities for their own function and the general<br />

purpose APIs that interconnect the infrastructure, the<br />

rest gives the possibility to expand and adapt the specific<br />

dataset or data point into a more complex and advanced<br />

structure without requiring the infrastructure to change.<br />

This flexibility is radically important in the first phases of<br />

the project, as the ontology can emerge from the data<br />

collected and can be fixed over time.<br />

The core map has the largest amount of data, being a<br />

collection of polygons, lines and points representing the<br />

structure of the past in its various moments described<br />

by historians, documents and digitized maps. Technically,<br />

the information stored is described in a way that is<br />

very similar to the openstreetmap ontology, except for<br />

the fact that for every dataset imported the source is an<br />

identifier that references one specific dataset described<br />

in the Data Index.<br />

The other major data collectors are the Event Index<br />

and the Viewer. For each the geometries are simpler,<br />

being points, and the API transforms these points into<br />

more complex structures connected either by the same<br />

subject, by context or by other references. This gives<br />

the possibility to visualize connections between items and<br />

create lines and convex containers representing the area<br />

of a specific phenomenon (i.e. a war, a cultural presence)<br />

or the track of a specific object over time (ship, person,<br />

army unit).<br />

The smallest data collection is the one related to the Data<br />

Index. It contains only metadata about the data sources<br />

that are imported into the system. This component is one<br />

of the core elements of the whole system because it is<br />

on this that the definition of the system relies, as the infrastructure<br />

does not in itself have OHM-owned data. The<br />

importer relies on this component to define the import<br />

methodologies for specific datasets.<br />

THE DATA INDEX<br />

The original Open History Map infrastructure did not define<br />

a repository for data sources, while the data quality had<br />

to be considered as a secondary element in the definition<br />

of the map itself. The infrastructure already had a defined<br />

hierarchy of data quality definitions, but this definition<br />

was more addressed towards the quality of the single<br />

specific geographic information, than the source itself as a<br />

whole. The change of paradigm in the import of the data<br />

required a radical change in the quality assessment itself,<br />

because obviously reliable primary sources are way more<br />

useful than unreliable ones, and these are themselves<br />

more useful than reliable hearsay sources, for example.<br />

For this reason, the definition of source reliability and<br />

source quality depend on several important factors and<br />

are the result of a series of simplifications based on the<br />

most common models for the evaluation of data quality. In<br />

addition to a general model for Digital Humanities, a broader<br />

information and data quality paradigm was analyzed,<br />

looking also into metrics for the world wide web, as many<br />

elements could be applied in the Data Index, as it is more<br />

generic than a specific collector.<br />

This considered, [Knight, s.d.] defines 20 dimensions for<br />

Information and Data Quality. Some of these are very weboriented<br />

(i.e. Consistency, Security, Timeliness and others)<br />

and as such not relevant in our specific case. Other dimensions<br />

are, on the other hand, very topic specific (i.e. Concise,<br />

Completeness, Relevancy) and this depends on what<br />

the research we are collecting is about: a study of a very

specific topic relevant to a small number of cities in the<br />

ancient roman age will be way more concise than a broad<br />

study on a very common phenomenon in modern ages.<br />

In [Akoka et al. 2021] a 7-level hierarchy is defined for the<br />

categorization of imprecise temporal assertions in an application<br />

to the prosopographical database definition area.<br />

Based on these two approaches, with the latest iteration<br />

of the Open History Map platform, the Data Index was introduced,<br />

creating the structure to collect, classify and<br />

evaluate the data quality of the various sources that the<br />

platform collects and imports. The importance of an external<br />

metadata information collector is incredibly important<br />

in order to be able to define methodologies and criteria<br />

to uniform the import modes for the single datasets or<br />

dataset groups.<br />

The dimensions defined for this collector are divided into<br />

three classes, Objective, subjective and process and these<br />

into six dimensions. The subdivision is the following:<br />

Space coverage is done using Geonames Identifiers and as<br />

such creating a dynamically populated tree of areas covering<br />

the various researches. For the period a beginning<br />

time and end time of the period covered are the elements<br />

classified.<br />

The topics that are being collected as of now are the following:<br />

4Agriculture - These datasets and researches regard the<br />

area of agriculture, such as for example identification of<br />

agricultural land use or of crops cultivated in the past in<br />

specific areas.<br />

4Climate - These datasets and research cover the changes<br />

in climate in the past.<br />

4Economy - These datasets and researches regard the<br />

changes in economy and the possible normalizations of<br />

the past with modern economic conditions.<br />

4Entertainment - These datasets and researches regard<br />

the world of entertainment, from circus to theatre to<br />

cinema.<br />

4Industry - These datasets and research cover the changes<br />

in the industrial complex of the past.<br />

4Infrastructures - These datasets and researches regard<br />

the transportation infrastructure and its evolution. It is<br />

further subdivided in air, water and land transport.<br />

4Politics - These datasets and researches regard the<br />

changes in borders.<br />

4Religion - These datasets and researches cover the distribution<br />

and activities related to religion<br />

4Urban - These datasets and researches regard urban<br />

evolution over time.<br />

4Ephemeral - These datasets and researches regard movements<br />

of people, ships and anything mobile<br />

4War - These datasets and researches regard detailed<br />

aspects of war.<br />

4Geography - These datasets and researches regard the<br />

changes in nature, both totally natural and anthropic<br />

Class Dimension Meaning<br />

Objective Spatial Coverage What area or areas does the research cover?<br />

Period<br />

Topic<br />

Subtopic<br />

What time frame or time frames does the research cover?<br />

What topic or topics does the research cover?<br />

What kind of information is collected about the topic?<br />

Process Reliability How reliable is the research? What methodologies have been used?<br />

Subjective Quality How precise is the information collected?<br />

18 ArcheomaticA N°2 Giugno <strong>2022</strong>

Tecnologie per i Beni Culturali 19<br />

All of these topics have specific sub-classifiers defining<br />

the kinds of elements collected. Specifically, these subclassifiers<br />

are:<br />

4Location - These researches and datasets give us the<br />

punctual localization of analyzed items.<br />

4Structure - This subtopic regards research that resulted<br />

in the creation of open datasets of the planimetries<br />

of buildings, cities, areas.<br />

4Model - This subtopic regards activities that resulted<br />

in the creation or the collection of 3D models for specific<br />

buildings or items of the main topic.<br />

4Events - These datasets and researches give us timelines<br />

(as datasets or not) about the specific topic in the<br />

specific analyzed period.<br />

4Usage - These datasets and researches give us context<br />

and modes for the fruition.<br />

4Indexes - These datasets and researches analyze specific<br />

indicators, such as for example salary over time<br />

or GDP normalized or population.<br />

4General - These datasets and researches covering the<br />

main topic in general or without a specific viewpoint.<br />

These four levels of classification enable the positioning<br />

of the specific dataset in a multidimensional grid. This<br />

enables the creation of the main visualization of the<br />

Data Index.<br />

The quality and reliability evaluation are given as two<br />

values ranging from 1 to 6. The reliability score is divided<br />

as follows:<br />

46 - Academic peer-reviewed research / Excavation Report;<br />

45 - In-period source material;<br />

44 - Review papers;<br />

43 - Non peer-reviewed research;<br />

42 - Local public history activities, eventually supervised,<br />

but not guaranteed in any way;<br />

41 - Hearsay and oral tradition.<br />

While the data quality is divided as follows:<br />

46 - Precise dataset with well defined and documented<br />

tools, with a validatable high level accuracy<br />

45 - Lower fine granularity of data; data is available<br />

but less precise.<br />

44 - Verifiably incomplete data, some information is<br />

missing for accurate identification<br />

43 - Uncertain data, specification of uncertainty in a<br />

major part of the data.<br />

42 - Uncertain data with no references to other datasets<br />

for cross-validation.<br />

41 - Low quality dataset, with obvious discrepancies and/<br />

or errors<br />

The reliability descriptor represents the intrinsic quality of<br />

the methodology applied in the publication of the data. On<br />

the other hand the data quality depends on the precision<br />

of the published data.<br />

The current infrastructure is currently based on the storage<br />

of items in a public Zotero collection where all the<br />

collected researches are described as structured tags.<br />

The following is the description of the CLIWOC dataset:<br />

The datasets can not be described from the front-end<br />

and for this reason these are currently defined by a name<br />

and, in addition to the previously mentioned ontology a<br />

descriptor for the single dataset or for the whole collection<br />

of datasets associated with the project.<br />

A CLOUD FIRST ARCHITECTURE FOR THE DH<br />

One of the key principles of cloud-first infrastructure design<br />

is to rely on pre-existing services already available<br />

within the cloud infrastructure we are working with. This<br />

is in principle optimal for high burn-rate startups with<br />

huge funding but it might not be an ideal solution for low<br />

budget digital humanities projects. For this reason we<br />

designed an infrastructure that could take advantage of<br />

an abstraction of this basic principle and of other general<br />

principles of software architecture in order to create an<br />

efficient architecture that complies with the needs and<br />

requirements that define the Open History Map platform in<br />

all of its aspects [Montanari 2021] but can also offer some<br />

of the high-level tools that cloud infrastructures typically<br />

lack for use in Digital Humanities.<br />

One of the main factors taken into account during the architectural<br />

planning process was the importance of delaying<br />

and deferring decisions as much as possible both for<br />

us, using the architecture as well as for the architecture<br />

expandability itself [Martin 2017]. This principle is true<br />

when designing an application, an API and a complex architecture.<br />

For this reason most of the API orchestration is<br />

delegated to the various interfaces that use the data and<br />

compose the element in the way that fits best. For example,<br />

the map front-end uses the Data Index API in order to<br />

display information about a given source, using its id as<br />

symbolic reference (which is in itself a symbolic reference<br />

to the identifier defined in Zotero). This means a partial<br />

delegation of the knowledge of the inner workings of one<br />

specific part of the infrastructure to other elements that<br />

might not have to know, in principle, anything of it, but on<br />

the other hand, being part of the same ecosystem means<br />

that many elements can be cross referenced between various<br />

interfaces.<br />

Space coverage ohm:area geonames:6295630<br />

Time coverage ohm:from_time 1750<br />

ohm:to_time 1855<br />

Topic classification ohm:topic ephemeral<br />

ohm:topic:topic<br />

location<br />

Data quality ohm:source_quality 6<br />

Data reliability ohm:source_reliability 5

The infrastructure is divided into several macro-areas,<br />

each of whom covers one specific aspect of the platform.<br />

Wherever possible the vertical architecture of the macroarea<br />

has been structured with the same pattern:<br />

4Database (postgres/mongodb/redis/filesystem/influxdb)<br />

4Writing API, that also controls the database initialization<br />

infrastructure (a python/flask microservice)<br />

4Reading API (a python/flask microservice) with eventually<br />

Tile Server<br />

4Front end (an angular application)<br />

This very basic template may or may not have all of its<br />

components, as for example, a service might not need to<br />

write to a backend, while another service might only be<br />

using interaction-less writing operations, and as such might<br />

not need a direct reading API. Obviously, if the reading operations<br />

are simple enough, they are integrated into the writing<br />

component and vice-versa.<br />

The less cross-depending macro-area is the already explained<br />

Data Index, being simply a visualization of the data<br />

collected in the Zotero collection representing the sources<br />

used for populating all other areas. The infrastructure is<br />

totally stateless, it has no persistent database and downloads<br />

the current collection of sources once the docker image<br />

starts, creating just an on-the-fly database. The api only<br />

exposes the endpoints used by the interface and the APIs<br />

for other macro-areas to get source-specific data to display<br />

on their interfaces. All areas beyond this rely on its presence<br />

and on its being up-to-date.<br />

The main user of the Data Index API is the Data Importer,<br />

an interface-less system that does the heavy lifting of transforming<br />

and importing data into the various databases coordinating<br />

the use of the various APIs. This service is stateless<br />

as well, not having a persistent database, yet it does<br />

connect to the local Docker socket, as it uses the Docker-indocker<br />

methodology to spawn the machines that do the real<br />

ETL operations as well as the test database and test-APIs in<br />

case of import testing. The ETL code is downloaded from a<br />

repository and for each source identifier or source dataset<br />

identifier taken from the Data Index API the importer builds<br />

the specific docker image and launches it, writing, if already<br />

tested, directly on the various production APIs.<br />

The other areas are all full stack infrastructures, as all rely<br />

on one or more databases, APIs and specific front-ends.<br />

Starting from the map, the data is stored in a PostGIS database<br />

configured automatically via the API module and<br />

already set up to be distributed across a cloud infrastructure<br />

via partitioning. The partitioning configuration is done<br />

both on layers (that are bound to topics) and year the dataset<br />

starts being valid. Setting up a variable grain to the<br />

time-dependent partitions enables a major optimization of<br />

the resources for the infrastructure, giving the possibility<br />

to move the storage of data-heavy periods (wars, moments<br />

of major changes) into separate databases. The API relies,<br />

in the writing part, on the possibility of using a redis-based<br />

buffer to have a workload manager deciding when to import<br />

specific items. This is very important because many<br />

polygons are very detailed, and the possibility to do an<br />

indirect upload of data gives the client better feedback on<br />

operations even in very complicated cases. The tile server<br />

is completely separated from the rest of the API and uses<br />

a stored procedure defined in the db-initialization part of<br />

the API. This enables an enormous optimization of the activities,<br />

as it relies on the database-native generation of<br />

MVT tiles for the specific requested tile.<br />

Beyond the main map, all other tools are always cartographic<br />

as well, being the Event Index and the Historical<br />

Street View. Both contain mainly points, in contrast with<br />

the multiple types of geometries stored by the main map.<br />

The data, in the two cases, is bound to mapping events in<br />

time and (not always) in space and mapping documentation<br />

of the form of the world in history, respectively.<br />

The Event Index collects data from various sources enabling<br />

the location of specific events in time and space, but<br />

also tracking particular subjects in their activities in time.<br />

For example it is possible to visualize the course of a specific<br />

ship over time, such as, in this case, the course of the<br />

Endeavour over its travels to New Zealand.<br />

In addition to movements, the layer also contains data<br />

about events caused by anthropic causes of change (wars,<br />

battles, murders, births and deaths) as well as by natural<br />

causes (quakes, volcanic eruptions, various forms of disasters).<br />

This layer is a pure collection of time-space coordinates<br />

with general information about the event and<br />

a reference to the external source. This block contains a<br />

20 ArcheomaticA N°2 Giugno <strong>2022</strong>

Tecnologie per i Beni Culturali 21<br />

modified tileserver, slightly different from the main map<br />

one, optimized for point management.<br />

Finally, the Historical Street View macro-area is, like the<br />

Event Index, simply a point storage for not just space<br />

and time coordinates, but also the reference to external<br />

sources for documents, being photos, paintings of views,<br />

videos. These multimedia sources are not stored or cached<br />

in the system and are visualized directly from other providers.<br />

This is very important in order to guarantee the<br />

maximum independence from local storage.<br />

In conclusion, the defined architecture guarantees a great<br />

amount of flexibility in case of additions to the system<br />

as well as simplicity, based on the templatization of the<br />

single structures. The transformation of the various parts<br />

into microservices gives the whole system additional reliability<br />

and resilience, enabling possible changes to the<br />

implementation and horizontal growth without stopping<br />

the infrastructure.<br />

References<br />

Bernardoni, Silvia, M. Montanari, & R. Trojanis. «Open History Map».<br />

Archeologia e Calcolatori n. XXVIII.2 - 2017. Edizioni All’Insegna del Giglio,<br />

20172-01-01. https://doi.org/10.19282/AC.28.2.2017.44.<br />

Montanari M., Raffaele Trojanis, Silvia Bernardoni, & Luca Tepedino.<br />

«Open history map - a new approach to open access for archaeology and<br />

cultural heritage». In 2015 Digital Heritage, 2:479–80, 2015. https://doi.<br />

org/10.1109/DigitalHeritage.2015.7419557.<br />

Zundert, J. «If You Build It, Will We Come? Large Scale Digital<br />

Infrastructures as a Dead End for Digital Humanities». Historical Social<br />

Research / Historische Sozialforschung 37, n. 3 (141) (2012): 165–86.<br />

Akoka J., Isabelle Comyn-Wattiau, Stéphane Lamassé, & Cédric Du<br />

Mouza. ‘Conceptual Modeling of Prosopographic Databases Integrating<br />

Quality Dimensions’. Journal of Data Mining & Digital Humanities Special<br />

Issue on Data Science... (7 May 2021): 5078. https://doi.org/10.46298/<br />

jdmdh.5078.<br />

Franke M., Ralph Barczok, Steffen Koch, & Dorothea Weltecke. ‘Confidence<br />

as First-Class Attribute in Digital Humanities Data’. In Workshop on<br />

Visualization for the Digital Humanities (VIS4DH), 2019.<br />

Knight, S.. ‘Developing a Framework for Assessing Information Quality on<br />

the World Wide Web’, n.d., 14.<br />

Naumann F., & Claudia R. ‘Assessment Methods for Information Quality<br />

Criteria’, 27 October 2000.<br />

Therón S., Roberto, Alejandro Benito Santos, Rodrigo Santamaría Vicente,<br />

& Antonio Losada Gómez. ‘Towards an Uncertainty-Aware Visualization<br />

in the Digital Humanities’. Informatics 6, no. 3 (September 2019): 31.<br />

https://doi.org/10.3390/informatics6030031.<br />

Martin, Robert C. Clean Architecture : A Craftsman’s Guide to Software<br />

Structure and Design. 1° edition. London, England: Addison-Wesley, 2017.<br />

Abstract<br />

Open History Map, an open map of the past that was already presented as a<br />

concept a few years ago, is now in its first year of functioning infrastructure<br />

and collects around 150GB of data from around 90 sources. The platform is<br />

open in all of its aspects and enables research groups to create new importers<br />

for their own open datasets. In addition to that, OHM enables the visualization<br />

of "ephemeral" datasets, i.e. representation of vicinity for historical<br />

characters and vehicles, battles and events. The present work will analyze<br />

the status of the project and the contributions it is doing to the general DH<br />

and PH sector, specifically on source quality management and general cloud<br />

first architectures.<br />

OHM is based on the collection of open datasets available online. The geographic<br />

precision as well as the informational quality varies a lot between<br />

sources, research teams, projects. These factors higlight the need of a tool<br />

to manage the data quality, which we called OHM Open Data Index, (https://<br />

index.openhistorymap.org) where we collect all sources we find and all datasets<br />

we import in order to analyze and display the general quality and/or<br />

lack of data.<br />

The complexity of the infrastructure behind a project such as Open History<br />

Map required an original and cloud-first approach, enabling the optimization<br />

of every single aspect of the development as well as the deployment and the<br />

usage of the system. For this reason a cloud-first approach was used, trying<br />

to harness all the features of the most common FLOS software platforms in<br />

order to maximize the quality of the final product.<br />

Keywords<br />

Digital Humanities; Digital Archaeology; GIS; GLAM; Data quality;<br />

Software Architecture<br />

Author<br />

Marco Montanari, Lucia Marsicano, Raffaele Trojanis,<br />

Silvia Bernardoni, Lorenzo Gigli<br />

University of Bologna

GUEST PAPER<br />

Open Science for Archaeology:<br />

an up-to-date guide (<strong>2022</strong>)<br />

by Paolo Rosati<br />

This paper was born by<br />

the Open Science author’s<br />

recent research experiences,<br />

post-doc fellow for the<br />

‘PAThs Project’, the ‘Mirrolab<br />

project’ in Sapienza of Rome<br />

and member of the Archeo-<br />