You also want an ePaper? Increase the reach of your titles

YUMPU automatically turns print PDFs into web optimized ePapers that Google loves.

Rivista bimestrale - anno XX - Numero 6/<strong>2016</strong> - Sped. in abb. postale 70% - Filiale di Roma<br />

TERRITORIO CARTOGRAFIA<br />

GIS<br />

CATASTO<br />

3D<br />

INFORMAZIONE GEOGRAFICA<br />

FOTOGRAMMETRIA<br />

URBANISTICA<br />

GNSS<br />

BIM<br />

RILIEVO TOPOGRAFIA<br />

CAD<br />

REMOTE SENSING SPAZIO<br />

EDILIZIA<br />

WEBGIS<br />

UAV<br />

SMART CITY<br />

AMBIENTE<br />

NETWORKS<br />

LiDAR<br />

BENI CULTURALI<br />

LBS<br />

Nov/Dic <strong>2016</strong> anno XX N°6<br />

La prima rivista italiana di geomatica e geografia intelligente<br />

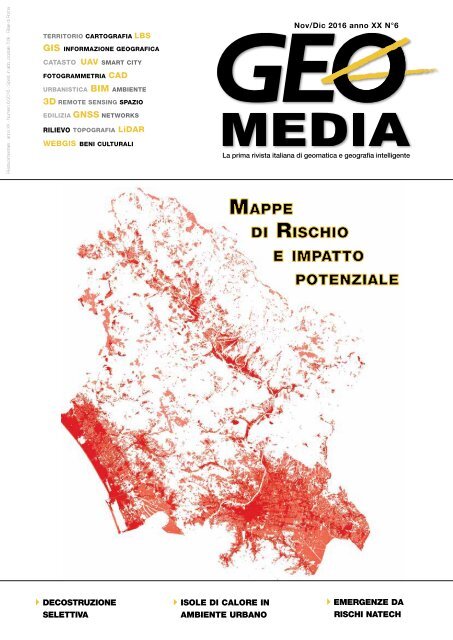

Mappe<br />

di Rischio<br />

e impatto<br />

potenziale<br />

DECOSTRUZIONE<br />

SELETTIVA<br />

ISOLE DI CALORE IN<br />

AMBIENTE URBANO<br />

EMERGENZE DA<br />

RISCHI NATECH

trimBle SX10<br />

la rivoluzione<br />

è appena cominciata<br />

abbiamo creato uno strumento innovativo, versatile<br />

e integrato. trimble SX10 coniuga la tecnologia di una<br />

Stazione totale robotica di alta precisione con quella di uno<br />

Scanner ad alta velocità e funzionalità imaging reale, senza<br />

alcun compromesso prestazionale.<br />

noleggialo, anche solo per un giorno.<br />

Soluzioni innovative per il rilievo, la misura e la modellazione.<br />

Transforming the way the world works<br />

Spektra Srl, a Trimble Company<br />

039.625051 | info@trimble-italia.it | www.trimble-italia.com

Chi è il garante dell’infrastruttura geografica?<br />

Il potenziamento dell’Infrastruttura di dati territoriali, con il dettaglio e l’accuratezza che serve a fornire<br />

cartografie e mappe del territorio affidabili per gli interventi istituzionali, è una operazione che deve<br />

essere garantita con norme di uniformazione ed omogeneizzazione, nonché di produzione, che siano<br />

rispettate ed applicate in maniera uniforme sul territorio nazionale.<br />

Attualmente il lavoro di produzione di specifiche e norme sui dati territoriali non è tutelato e<br />

garantito ma solamente condiviso ed approvato, in un consesso allargato di tecnici ed esperti del<br />

settore, che hanno prodotto una serie di documenti con prescrizioni e suggerimenti che basterebbe<br />

aggiornare al vaglio delle opportune tecnologie che si sono oggi rese disponibili, per renderli applicabili<br />

universalmente.<br />

Siamo carenti anche di un elemento istituzionale di raccordo dei vari organi, enti e amministrazioni che<br />

operano sulla acquisizione di Dati Territoriali e possa fungere da interfaccia per il raccordo istituzionale<br />

internazionale.<br />

Numerose amministrazioni, ignare o a vario titolo impossibilitate dalla farraginosità di meccanismi<br />

burocratici, non riescono ad avvalersi di quanto già rilevato da altre amministrazioni e viene spesso<br />

duplicata o triplicata la spesa globale in tale settore.<br />

La attuale situazione si origina, come molti di noi sanno bene, da uno stato di confusione generato<br />

dalla mancata riorganizzazione dei servizi cartografici, seguita all'abrogazione di Enti considerati inutili<br />

avvenuta durante il primo passaggio legislativo di competenze dallo Stato alle Regioni negli anni ‘70.<br />

All’epoca gli organi cartografici nazionali erano solo 5 (Istituto Geografico Militare, Istituto Idrografico<br />

della Marina, Servizio geo-topo-cartografico dell’Aeronautica Militare, Servizio Geologico di Stato,<br />

Catasto), oggi incrementati di almeno 20 organi cartografici delle Regioni oltre a vari altri organi di<br />

amministrazioni che operano a vario titolo acquisendo dati territoriali. Abbiamo però finalmente<br />

un organo centrale come catalogo di dati territoriali che sta spingendo fortemente sulla creazione di<br />

metadati che possano riuscire ad aiutare nella ricerca dei dati territoriali già in possesso della PA. Il<br />

Repertorio Nazionale dei Dati Territoriali (RNDT) è l’unica novità di rilievo che possiamo notare nel<br />

settore proponendosi come ente istituzionale e rappresentativo in grado di acquisire informazioni da<br />

tutte le amministrazioni. Ma quello che ci chiediamo è se questa istituzione abbia poi il potere effettivo<br />

di far rispettare a tutti la compilazione e l’uso del sistema centralizzato.<br />

Una carenza che si manifesta, oltre che nelle normali operazioni di pianificazione del territorio, in<br />

occasione delle emergenze per disastri naturali. Valga per tutti considerare la necessaria realizzazione<br />

di modelli idrografici del territorio, per un effettivo piano di prevenzione del rischio idrogeologico,<br />

basato su un quadro di riferimento dato da modelli digitali del terreno che oggi è possibile realizzare con<br />

accuratezza estrema.<br />

La problematica della gestione dell’emergenza in caso di disastri naturali è evidente nel momento in<br />

cui squadre di soccorso ed operatori dell’emergenza non dispongono di dati affidabili, come purtroppo<br />

di nuovo ha dimostrato il recente sisma in Italia Centrale, verificatosi a cavallo di ben 4 Regioni,<br />

non riuscendo nelle poche ore a disposizione per i primi soccorsi, ad interrogare un sistema centrale<br />

affidabile, né ad integrare la realtà di organizzazioni che si prodigano per mappare il territorio con<br />

operazioni di volontariato geografico.<br />

Un garante del coordinamento dell’infrastruttura geografica territoriale nell’emergenza dovrebbe far si<br />

che tutta la documentazione territoriale sia disponibile immediatamente in caso di emergenze e che si<br />

colmino lacune ormai primordiali, come ad esempio la carenza dell’assegnazione di numeri civici e la<br />

loro georeferenziazione.<br />

la prossima volta<br />

#mappiamoprima<br />

http://rivistageomedia.it/cartografia-per-emergenza<br />

Buona lettura,<br />

Renzo Carlucci

In questo<br />

numero...<br />

FOCUS<br />

REPORT<br />

GUEST<br />

LE RUBRICHE<br />

Nuove prospettive<br />

per l’utilizzo del<br />

remote sensing<br />

nella gestione delle<br />

emergenze da rischi<br />

Natech e l’uso della<br />

terminologia specifica<br />

di Sabina Di Franco,<br />

lena Rapisardi,<br />

Rosamaria Salvatori<br />

6<br />

11 TECHNOLOGY for ALL<br />

24 ASSOCIAZIONI<br />

26 IMMAGINE ESA<br />

42 MERCATO<br />

48 SMART CITY<br />

50 AGENDA<br />

Il 20 gennaio 2017, il Moderate<br />

Resolution Imaging Spectroradiometer<br />

(MODIS) a bordo del<br />

satellite Aqua della NASA ha catturato<br />

una immagine true-color<br />

della neve nell'Europa centrale.<br />

Le nuvole sovrastano l'Italia<br />

orientale innevata, mentre le<br />

Alpi sono ricoperte da una fitta<br />

coltre di bianco. La neve si estende,<br />

ad Est, sopra la Slovenia, la<br />

Croatia e la Bosnia Erzegovina.<br />

14 Telerilevamento<br />

e GIS per la<br />

valutazione e il<br />

monitoraggio delle<br />

isole di calore in<br />

ambiente urbano<br />

di Sabrina Adelfio,<br />

Caterina Enea, Giuseppe Bazan,<br />

Pietro Orlando<br />

Crediti immagine: Jeff Schmaltz,<br />

MODIS Land Rapid Response<br />

Team, NASA GSFC<br />

In copertina una<br />

rappresentazione della<br />

mappa del rischio di impatto<br />

potenziale del cinghiale<br />

in formato raster, circa il<br />

comprensorio di Lucca.<br />

20<br />

Soluzioni<br />

informatiche<br />

innovative a supporto<br />

della Decostruzione<br />

Selettiva<br />

di Antonio Bottaro<br />

geomediaonline.it<br />

<strong>GEOmedia</strong>, bimestrale, è la prima rivista italiana di geomatica.<br />

Da 20 anni pubblica argomenti collegati alle tecnologie dei<br />

processi di acquisizione, analisi e interpretazione dei dati,<br />

in particolare strumentali, relativi alla superficie terrestre.<br />

In questo settore <strong>GEOmedia</strong> affronta temi culturali e tecnologici<br />

per l’operatività degli addetti ai settori dei sistemi informativi<br />

geografici e del catasto, della fotogrammetria e cartografia,<br />

della geodesia e topografia, del telerilevamento aereo e<br />

spaziale, con un approccio tecnico-scientifico e divulgativo.

INSERZIONISTI<br />

3D Target 52<br />

28<br />

Analisi GIS<br />

applicate alla<br />

gestione faunistica<br />

Le mappe di rischio<br />

di impatto degli<br />

ungulati<br />

di Alessandro Giugni, Marco<br />

Ferretti, Leonardo Conti<br />

AerRobotix 37<br />

Aeropix 50<br />

Epsilon 42<br />

Esri Italia 41<br />

Flytop 43<br />

GEOCART 48<br />

ME.S.A 40<br />

Planetek Italia 13<br />

Sinergis 51<br />

Sistemi Territoriali 49<br />

Teorema 47<br />

Topcon 23<br />

UNIcuIque<br />

SUUM<br />

di Attilio Selvini<br />

38<br />

Trimble 2<br />

34<br />

A Digital “New World”<br />

The Big Fusion between<br />

Ubiquitous Localization<br />

(GNSS), Sensing (IOT)<br />

and Communications<br />

(5G) by Marco Lisi<br />

una pubblicazione<br />

Science & Technology Communication<br />

Direttore<br />

RENZO CARLUCCI, direttore@rivistageomedia.it<br />

Comitato editoriale<br />

Vyron Antoniou, Fabrizio Bernardini, Mario Caporale,<br />

Luigi Colombo, Mattia Crespi, Luigi Di Prinzio,<br />

Michele Dussi, Michele Fasolo, Marco Lisi, Flavio Lupia,<br />

Beniamino Murgante, Aldo Riggio, Mauro Salvemini,<br />

Domenico Santarsiero, Attilio Selvini, Donato Tufillaro<br />

Direttore Responsabile<br />

FULVIO BERNARDINI, fbernardini@rivistageomedia.it<br />

Redazione<br />

VALERIO CARLUCCI, GIANLUCA PITITTO,<br />

redazione@rivistageomedia.it<br />

Diffusione e Amministrazione<br />

TATIANA IASILLO, diffusione@rivistageomedia.it<br />

Comunicazione e marketing<br />

ALFONSO QUAGLIONE, marketing@rivistageomedia.it<br />

Progetto grafico e impaginazione<br />

DANIELE CARLUCCI, dcarlucci@rivistageomedia.it<br />

MediaGEO soc. coop.<br />

Via Palestro, 95 00185 Roma<br />

Tel. 06.64871209 - Fax. 06.62209510<br />

info@rivistageomedia.it<br />

ISSN 1128-8132<br />

Reg. Trib. di Roma N° 243/2003 del 14.05.03<br />

Stampa: SPADAMEDIA srl<br />

VIA DEL LAVORO 31, 00043 CIAMPINO (ROMA)<br />

Editore: mediaGEO soc. coop.<br />

Condizioni di abbonamento<br />

La quota annuale di abbonamento alla rivista Science è di € & 45,00. Technology Communication<br />

Il prezzo di ciascun fascicolo compreso nell’abbonamento è di € 9,00. Il prezzo di<br />

ciascun fascicolo arretrato è di € 12,00. I prezzi indicati si intendono Iva inclusa.<br />

L’editore, al fine di garantire la continuità del servizio, in mancanza di esplicita<br />

revoca, da comunicarsi in forma scritta entro il trimestre seguente alla scadenza<br />

dell’abbonamento, si riserva di inviare il periodico anche per il periodo successivo.<br />

La disdetta non è comunque valida se l’abbonato non è in regola con i pagamenti.<br />

Il rifiuto o la restituzione dei fascicoli della Rivista non costituiscono disdetta<br />

dell’abbonamento a nessun effetto. I fascicoli non pervenuti possono essere<br />

richiesti dall’abbonato non oltre 20 giorni dopo la ricezione del numero successivo.<br />

Gli articoli firmati impegnano solo la responsabilità dell’autore. È vietata la<br />

riproduzione anche parziale del contenuto di questo numero della Rivista in<br />

qualsiasi forma e con qualsiasi procedimento elettronico o meccanico, ivi inclusi i<br />

sistemi di archiviazione e prelievo dati, senza il consenso scritto dell’editore.<br />

Rivista fondata da Domenico Santarsiero.<br />

Numero chiuso in redazione il 22 gennaio <strong>2016</strong>.

FOCUS<br />

Nuove prospettive per l’utilizzo del remote<br />

sensing nella gestione delle emergenze da<br />

rischi Natech e l’uso della terminologia specifica<br />

di Sabina Di Franco, Elena Rapisardi, Rosamaria Salvatori<br />

Le tecniche di remote sensing hanno assunto un ruolo fondamentale<br />

nella gestione dei rischi, come è dimostrato anche dal programma<br />

Copernicus, fase operativa del GMES (Global Monitoring for<br />

Environment and Security), che offe tra i suoi servizi l’Emergency<br />

Management Service.<br />

Fig. 1 - Ciclo dell’emergenza.<br />

La gestione del rischio è<br />

un’attività complessa che<br />

richiede un approccio<br />

multidisciplinare. Quando avviene<br />

un disastro ogni minuto<br />

è fondamentale per salvare vite<br />

umane, limitare i danni, proteggere<br />

persone, cose e ambiente.<br />

Gli eventi che si susseguono<br />

durante il verificarsi di un<br />

disastro sono, in una certa misura,<br />

ripetitivi e possono essere<br />

schematizzati in un ciclo: il cosiddetto<br />

“ciclo dell’emergenza”<br />

o del disastro. Il ciclo dell’emergenza<br />

può essere suddiviso<br />

in quattro fasi: mitigazione e<br />

prevenzione (prima dell’evento)<br />

e risposta e recupero, ripristino<br />

o superamento (post evento)<br />

(Di Franco, Salvatori, 2015).<br />

La mitigazione consiste in tutte<br />

quelle azioni necessarie per ridurre<br />

l’impatto dei disastri futuri<br />

(Menoni et al., 2012). La fase<br />

di prevenzione comprende le<br />

attività necessarie per ridurre gli<br />

impatti in previsione o nell’imminenza<br />

di eventi disastrosi. La<br />

fase di risposta attiene a tutte<br />

quelle azioni intraprese durante,<br />

o immediatamente dopo l’evento,<br />

con l’intento primario di<br />

salvare e proteggere le vite umane.<br />

Infine il termine recupero<br />

riguarda le attività relative al<br />

processo di ripristino dei servizi,<br />

alla ricostruzione delle opere e<br />

la riparazione dei danni, dopo<br />

l’evento (Alexander, 2002).<br />

Nella letteratura internazionale<br />

vengono definiti rischi Natech<br />

(Natural - Technological) quegli<br />

incidenti tecnologici innescati<br />

da disastri naturali, si tratta di<br />

tutti quegli incidenti che si verificano<br />

in impianti, nella rete<br />

di distribuzione o durante il<br />

trasporto di sostanze pericolose,<br />

a seguito del verificarsi di un<br />

terremoto, un’alluvione, uno<br />

tsunami o altro evento naturale.<br />

(Clerc, Le Claire, 1994; Lindell,<br />

Perry, 1996; Cruz et al., 2004).<br />

Questi rischi sembrano essere<br />

in aumento, non solo per la<br />

crescita delle zone industrializzate,<br />

ma anche in relazione<br />

ai cambiamenti climatici<br />

(Karusman et al., 2011, Salzano<br />

et al., 2013). Le peculiari caratteristiche<br />

degli eventi Natech,<br />

rapidità di svolgimento, possibilità<br />

dell’innesco di catene di<br />

eventi, variabilità dell’estensione<br />

areale, rendono la loro gestione<br />

particolarmente complessa. Il<br />

Joint Research Centre - JRC<br />

della Commissione Europea ha<br />

Fig. 2 - Incendio di un serbatoio di gas naturale a seguito del terremoto del 2011 a Ichihara,<br />

Prefettura di Chiba, Giappone. Foto: Reuters.<br />

6 <strong>GEOmedia</strong> n°6-<strong>2016</strong>

FOCUS<br />

Fig. 3 - Numero di eventi calamitosi per attività industriali. (2002–2012) eMARSJRC –<br />

European Commission, MajorAccidentHazardsBureau.<br />

richiesto nel 2004 alle autorità<br />

nazionali europee, l’identificazione<br />

delle aree potenzialmente<br />

soggette a questi eventi e ha<br />

sviluppato RAPID-N, uno<br />

strumento per mapppare e valutare<br />

rapidamente i danni, che<br />

opera a scala globale (Girgin,<br />

Krausmann, 2013).<br />

Il contributo della comunità<br />

scientifica e l’uso di tecnologie<br />

innovative come quelle connesse<br />

all’osservazione della terra,<br />

sono di importanza strategica<br />

durante tutte le fasi della gestione<br />

dell’emergenza (Joyce et<br />

al., 2009). Gli eventi causati<br />

dai rischi Natech sono caratterizzati<br />

da una rapida dinamica<br />

evolutiva con scenari che si<br />

modificano in un breve arco di<br />

tempo, e in molti casi il lavoro<br />

dei soccorritori è ritardato o<br />

reso particolarmente difficile<br />

dall’impossibilità di raggiungere<br />

le zone colpite e di operare in<br />

sicurezza. Ad esempio, nel caso<br />

di un incidente con rilascio<br />

di sostanze tossiche nell’aria,<br />

le squadre di soccorso devono<br />

evacuare rapidamente i residenti<br />

dell’area a rischio, di cui vanno<br />

definiti dimensioni e contorni.<br />

Per fare ciò è necessario avere<br />

informazioni come il punto<br />

di emissione, la direzione e la<br />

velocità del vento e le condizioni<br />

meteorologiche generali<br />

nel momento del verificarsi<br />

dell’evento. E’ anche necessario<br />

conoscere le caratteristiche geografiche<br />

dell’area, la presenza e<br />

lo stato delle reti stradali e delle<br />

infrastrutture, la cartografia, di<br />

base e tematica è quindi indispensabile.<br />

Inoltre la complessità intrinseca<br />

nei rischi Natech, rende particolarmente<br />

efficace l’uso di<br />

strumenti terminologici dedicati<br />

come glossari e thesauri che<br />

facciano chiarezza sui concetti e<br />

sui termini specifici del dominio,<br />

specialmente nel momento<br />

del verificarsi dell’emergenza.<br />

Le tecnologie<br />

dell’osservazione della<br />

terra e la gestione dei<br />

rischi Natech<br />

I sistemi per l’osservazione della<br />

terra nell’ambito della gestione<br />

delle emergenze rivestono un<br />

ruolo di importanza crescente,<br />

attraverso di essi si possono ricavare<br />

dati tempestivi e accurati<br />

non solo per la valutazione dei<br />

danni durante un evento, ma<br />

anche tutte le informazioni necessarie<br />

per le attività pre e post<br />

emergenziali.<br />

I satelliti orbitanti intorno alla<br />

Terra sono numerosi ed equipaggiati<br />

con sensori attivi e passivi<br />

che operano coprendo tutte<br />

le lunghezze d’onda dall’ultravioletto<br />

alle microonde, si può<br />

supporre quindi che la superficie<br />

della terra sia monitorata<br />

dallo spazio, anche nei momenti<br />

e nei luoghi in cui accadono<br />

le emergenze. Le missioni spaziali<br />

in atto sono versatili e utili<br />

per vari obiettivi, i sensori montati<br />

sui satelliti, possono essere<br />

dedicati a tematiche specifiche<br />

(es. l’osservazione del ghiaccio<br />

polare, la vegetazione, la qualità<br />

dell’acqua, ecc.). I dati attualmente<br />

provenienti dai sensori<br />

sono comparabili con i dati<br />

provenienti dalle prime missioni<br />

spaziali, questo consente di<br />

eseguire analisi multi-temporali<br />

impossibili fino a poco tempo<br />

fa, come la misura dell’urban<br />

sprawl o l’estensione delle calotte<br />

polari.<br />

Le missioni dell’ESA<br />

(European Space Agency),<br />

dell’EUMETSAT (European<br />

Organisation for the<br />

Exploitation of Meteorological<br />

Satellites), della NASA<br />

(National Aeronautics and<br />

Space Administration), del<br />

NOAA (National Oceanic and<br />

Fig. 4 - Numero di eventi per tipo di incidente. (2002–2012) eMARSJRC – European<br />

Commission, MajorAccidentHazardsBureau.<br />

<strong>GEOmedia</strong> n°6-<strong>2016</strong> 7

FOCUS<br />

Atmospheric Administration),<br />

del DLR (Deutschen Zentrum<br />

für Luft- und Raumfahrt),<br />

e dell’ASI (Agenzia Spaziale<br />

Italiana), forniscono un’ampia<br />

varietà di sistemi osservativi che<br />

verrano ulteriormente arricchiti<br />

dalle missioni Sentinel, nell’ambito<br />

del programma europeo<br />

Copernicus. La maggior parte<br />

dei programmi spaziali europei<br />

sono indirizzati verso la gestione<br />

delle emergenze, non solo<br />

da un punto di vista tecnicoscientifico,<br />

ma anche come<br />

impegno economico da parte di<br />

paesi ed imprese. Ad esempio<br />

nel programma GMES (Global<br />

Monitoring for Environment<br />

and Security), ora Copernicus,<br />

la gestione delle emergenze<br />

ha avuto da subito un ruolo<br />

cruciale, è infatti uno dei “Fast<br />

Track Services”, i servizi forniti<br />

e finanziati dal programma. Il<br />

servizio è attualmente operativo<br />

e svolge attività di “rapid<br />

mapping”, a richiesta fornisce<br />

informazioni geospaziali immediatamente<br />

dopo (ore o giorni)<br />

il verificarsi di un evento: dal<br />

2012 il servizio ha fornito<br />

mappe a seguito di circa un<br />

centinaio di richieste, correlate<br />

ad eventi idro-meteorologici e a<br />

incendi (European Commision.<br />

Copernicus Emergency<br />

Management Service - www.<br />

emergency.copernicus.eu). In<br />

quest’ambito la geomatica sta<br />

studiando come migliorare,<br />

semplificare e rendere più rapidi<br />

ed efficienti i flussi per la realizzazione<br />

di mappe tematiche<br />

(Ajmar et al., 2015).<br />

Le immagini satellitari non solo<br />

sono utili nel fornire dati “realtime”,<br />

o “near real-time” per la<br />

gestione dei disastri, ma diventano<br />

fondamentali anche nelle<br />

fasi di prevenzione e mitigazione<br />

(Showalter et al., 1999). Gli<br />

incidenti industriali, sia quelli<br />

causati direttamente dalle attività<br />

umane che quelli innescati<br />

da eventi naturali, ad eccezione<br />

degli sversamenti di petrolio in<br />

mare aperto, sono meno “imprevedibili”<br />

dal punto di vista<br />

della localizzazione spaziale,<br />

poiché avvengono in aree industriali<br />

note e definite (Marzo et<br />

al., 2015).<br />

I fenomeni naturali, anche se<br />

intrinsecamente caratterizzati da<br />

una maggiore “imprevedibilità”<br />

geografica, di solito coinvolgono<br />

porzioni di territorio più<br />

ampie e grazie alla loro scala è<br />

stato possibile utilizzare i satelliti<br />

anche quando le risoluzioni<br />

delle immagini non avevano<br />

il dettaglio e la scala di quelle<br />

odierne. Proprio il progresso<br />

tecnologico su risoluzione e scala,<br />

nonché il maggior numero<br />

Fig. 5 - Campi di applicazione dei dati dell’osservazione della terra. Modificato da Sandau (2010).<br />

di satelliti disponibili, permette<br />

l’uso di questi ultimi anche per<br />

l’analisi e il monitoraggio dei rischi<br />

industriali e, di conseguenza,<br />

dei cosiddetti Natech.<br />

Nell’ambito del progetto<br />

GEOSS i sensori satellitari<br />

attualmente disponibili sono<br />

stati utilizzati sia per attività di<br />

prevenzione, che per il monitoraggio<br />

dei danni provocati<br />

da disastri naturali (terremoti,<br />

piene, incendi boschivi, ecc…).<br />

Gli eventi Natech possono essere<br />

più complessi da analizzare<br />

in remoto, in quanto l’area in<br />

cui avviene l’incidente innescato<br />

dalle cause naturali può essere<br />

piccola. Se però si considera la<br />

durata nel tempo dell’evento e<br />

gli effetti che l’evento produce,<br />

l’area che subisce danni può<br />

essere anche molto estesa. Per<br />

analizzare le zone colpite dagli<br />

eventi calamitosi è necessario<br />

avere cognizione di causa del<br />

tipo di dati da utilizzare in<br />

relazione anche all’estensione<br />

geografica e alla risoluzione<br />

spettrale. Ad esempio immagini<br />

multispettrali ad alta risoluzione<br />

possono essere utilizzate per ottenere<br />

delle mappe dell’uso del<br />

suolo necessarie per derivarne<br />

mappe multi-rischio (Sengupta,<br />

2007).<br />

I grandi incidenti negli impianti<br />

industriali, sia innescati da<br />

eventi naturali che antropici,<br />

provocano spesso la repentina<br />

fuoriuscita di sostanze chimiche<br />

pericolose e possono innescare<br />

degli “effetti domino”, che<br />

causano danni gravi ed estesi<br />

(Antonioni et al., 2009); i dati<br />

del telerilevamento, anche se<br />

difficilmente possono venire<br />

usati per le attività di “previsione”<br />

di questi incidenti, sono<br />

però fondamentali, se raccolti<br />

tempestivamente, nella fase<br />

di intervento per formulare le<br />

strategie di azione e migliorare<br />

le attività di primo soccorso.<br />

Sono inoltre essenziali per la<br />

8 <strong>GEOmedia</strong> n°6-<strong>2016</strong>

FOCUS<br />

valutazione dei danni sia sulle<br />

costruzioni, sia sull’ambiente -<br />

aria, acqua, suolo - (Galderisi et<br />

al., 2008).<br />

Opportunità future: piccoli<br />

satelliti e UAV<br />

Considerando quanto detto nei<br />

paragrafi precedenti, tra i servizi<br />

di EO, in caso di incidenti in<br />

cui è necessaria un’informazione<br />

immediata, possono essere<br />

molto utili i dati forniti dalle<br />

costellazioni di “piccoli” satelliti<br />

(Kucera et al., 2012); i satelliti<br />

tradizionali infatti hanno tempi<br />

di rivisitazione non adatti per<br />

questo tipo di servizio. Le missioni<br />

con i “piccoli” satelliti, di<br />

contro, possono essere appositamente<br />

progettate per un scopo<br />

specifico quale, ad esempio, il<br />

monitoraggio di un’area industriale<br />

(Sandau, 2010) utilizzando<br />

tecnologie già pronte, le<br />

cosiddette (off-the-shelf technologies).<br />

E’ possibile, inoltre,<br />

creare sistemi molto piccoli (bus<br />

and payload) rivedendo l’ingegneria<br />

di sistemi già esistenti e<br />

cercando di miniaturizzarli. In<br />

generale, piccoli satelliti sono<br />

equipaggiati con spettroradiometri<br />

in VIS-nearIR e i dati<br />

sono disponibili in giornata; in<br />

futuro, si prevede di aumentare<br />

la capacità di elaborazione a<br />

bordo e inviare i dati agli utenti<br />

già corretti ed appositamente<br />

elaborati per la specifica applicazione<br />

(Sandau, 2006). Nei<br />

prossimi anni lo sviluppo di<br />

missioni con piccoli satelliti sarà<br />

inoltre favorita dalla comparsa<br />

sul mercato di nuovi sistemi di<br />

lancio dedicati dalla necessità<br />

di “testare” le diverse componenti<br />

prima di una missione<br />

più articolata e costosa, dallo<br />

sviluppo di sistemi interconnessi<br />

di piccole stazioni di ricezione<br />

e, ultimo ma non meno importante,<br />

dalla richiesta di dati<br />

in tempo reale per gli eventi<br />

con rapida evoluzione, come<br />

incidenti industriali o disastri<br />

naturali (Sandau, 2010). Verrà<br />

sicuramente implementata l’interferometria<br />

3D che può essere<br />

estremamente utile nel monitoraggio<br />

dei cambiamenti di uso<br />

del suolo, tra cui lo studio delle<br />

deformazioni in aree urbanoindustriale<br />

e la stima dei danni<br />

derivanti da incidenti industriali<br />

(Sandau e Briess, 2010).<br />

In futuro, aumentando della<br />

risoluzione spaziale delle immagini<br />

aumenterà la domanda di<br />

dati ottici da integrare con i dati<br />

acquisiti dai sensori a microonde<br />

e con i dati rilevati dai sensori<br />

montati su droni ((Lewis,<br />

2011, Sandau, Briess, 2008)<br />

o UAV (Unmanned Aerial<br />

Vehicle). In particolare, i micro-<br />

UAV (peso inferiore a 2 kg) rappresentano<br />

l’ultima frontiera per<br />

l’osservazione della Terra ad alta<br />

risoluzione e bassa quota. Su i<br />

micro-UAV possono essere installati,<br />

infatti, vari sensori che li<br />

rendono utilissimi per le attività<br />

di monitoraggio del territorio<br />

nelle aree urbane e naturali.<br />

Recentemente i micro-UAV<br />

hanno avuto un notevole sviluppo<br />

in seguito alla maggiore<br />

affidabilità e ai costi ridotti per<br />

l’utilizzo di sensori basati sulle<br />

nano-tecnologie (AA. VV.,<br />

2011).<br />

Con UAV, è anche possibile<br />

Fig. 6 - Il termine e le sue relazioni, un diagramma.<br />

osservare la superficie terrestre,<br />

con vista nadirale e prospettica,<br />

ottimi requisiti per valutare i<br />

danni derivanti da incidenti<br />

industriali quali, ad esempio il<br />

crollo degli edifici. I dati prodotti<br />

possono inoltre essere condivisi<br />

come livelli informativi<br />

su piattaforma web (geoSDI) in<br />

pochissimo tempo (dell’ordine<br />

di dieci minuti) fondamentali in<br />

caso di emergenza, poichè hanno<br />

una risoluzione molto alta<br />

ed un corretto posizionamento<br />

geografico (AA. VV., 2011).<br />

I dati acquisiti con gli UAV<br />

saranno sempre più richiesti in<br />

particolare per eventi calamitosi,<br />

sia di origine naturale, antropica<br />

o Natech. Essi, infatti, possono<br />

montare a bordo contemporaneamente<br />

sia fotocamere sia<br />

strumenti dedicati ad acquisire<br />

informazioni specifiche sull’evento<br />

da analizzare. In caso di<br />

incidenti su aree industriali, per<br />

esempio, in cui è possibile la<br />

fuoriuscita di gas tossici e nocivi,<br />

noti in precedenza, i sensori<br />

possono essere progettati ad hoc<br />

per campionare il particolato<br />

atmosferico, rilevare la concentrazione<br />

delle sostanze tossiche e<br />

raccogliere campioni da analizzare<br />

in laboratorio (Wang et al.,<br />

2013). Questi sensori possono<br />

quindi fornire informazione sulle<br />

aree in cui particolato (fumo<br />

<strong>GEOmedia</strong> n°6-<strong>2016</strong> 9

FOCUS<br />

e ceneri) e/o inquinanti possono<br />

ricadere, con evidenti vantaggi<br />

per l’organizzazione delle procedure<br />

di intervento sul territorio.<br />

Inoltre possono monitorare le<br />

zone a rischio più elevato dove è<br />

impossibile l’accesso ai soccorritori.<br />

L’uso di questi mezzi è particolarmente<br />

efficace nel caso di<br />

incidenti in cui si prevede una<br />

reazione a catena (esplosioni,<br />

incendi e crolli) per la formulazione<br />

di un piano di ricerca e<br />

salvataggio e per la prevenzione<br />

dell’effetto domino stesso.<br />

Durante gli incidenti in impianti<br />

che contengono sostanze<br />

chimiche pericolose, possono<br />

essere prodotti gas facilmente<br />

infiammabili, che generano<br />

esplosioni. Queste esplosioni<br />

causano improvvisi movimenti<br />

delle masse d’aria e temperature<br />

molto elevate. Gli UAV, però,<br />

spesso non sono in grado di far<br />

fronte a temperature elevate;<br />

non possono nemmeno mantenere<br />

la stabilità sufficiente per<br />

minimizzare le deformazioni<br />

delle immagini. L’equilibrio, la<br />

stabilità e il controllo del velivolo<br />

durante il volo nonché la durata<br />

delle batterie sono oggetto<br />

di studio per poter minimizzare<br />

questi inconvenienti (AA. VV.,<br />

2011). Di contro, questi velivoli<br />

possono essere di notevole<br />

supporto in quanto, volando<br />

a bassa quota, a differenza dei<br />

satelliti, possono acquisire<br />

immagini sotto la copertura<br />

nuvolosa e sono estremamente<br />

meno costosi di aeromobili con<br />

equipaggio.<br />

Lo sviluppo di sistemi unmanned<br />

non richiede fondi eccessivi<br />

e potrebbe combinare gli<br />

interessi del mondo scientifico<br />

e di quello industriale. Nel<br />

caso di monitoraggio pre- o<br />

post- incidente, infatti, la possibilità<br />

di utilizzare dati acquisiti<br />

da sensori dedicati prevede il<br />

coinvolgimento della piccola e<br />

media industria; la possibilità<br />

di finalizzare le acquisizioni a<br />

specifici utilizzi può diversificare<br />

e aumentare notevolmente i<br />

potenziali utenti.<br />

Fig. 7 - Il Natural Hazards Wikisaurus (NHW), (Wiki + Thesaurus), propone un set di strumenti<br />

terminologici per la conoscenza dei pericoli naturali (http://www.nhwikisaurus.com/).<br />

La terminologia<br />

Le parole assumono significati<br />

diversi a seconda del contesto<br />

nel quale sono utilizzate e molte<br />

ambiguità emergono quando il<br />

dominio di conoscenza al quale<br />

appartengono è complesso o<br />

poco chiaro. Gli strumenti terminologici,<br />

ovvero strumenti<br />

come glossari, lessici e thesauri,<br />

aiutano sia chi produce, organizza<br />

e cataloga l’informazione,<br />

qualunque essa sia, sia quanti<br />

usufruiscano delle informazioni<br />

stesse. In particolare rendono<br />

la ricerca di queste ultime efficace<br />

e rapida, minimizzando<br />

l’effetto del rumore di fondo<br />

e massimizzando la precisione<br />

nel recupero delle informazioni<br />

cercate. Questi concetti, validi<br />

ogni qual volta si utilizzi il linguaggio<br />

per la comunicazione,<br />

divengono ancora più discriminanti<br />

in domini che utilizzano<br />

termini specialistici e tecnici<br />

come quelli legati alle attività<br />

di osservazione della terra e<br />

della gestione delle emergenze.<br />

Inoltre, la necessità di liberare<br />

il campo da ogni “ambiguità<br />

semantica” diventa ancora più<br />

pressante nel momento della<br />

pianificazione del rischio e del<br />

soccorso. La mole di dati attualmente<br />

a disposizione è un vero<br />

e proprio tesoro di informazioni,<br />

ma un tesoro di cui non<br />

possediamo la mappa, un modo<br />

per costruirla è partire dalle<br />

“parole”. Le parole sono quelle<br />

che usiamo quando facciamo<br />

una ricerca e sono i machinereadable<br />

metadata come le key<br />

words associate a i prodotti e<br />

servizi relativi all’earth observation<br />

(EO), che ci permettono<br />

di trovare le informazioni ricercate;<br />

usiamo le parole quando<br />

classifichiamo e organizziamo le<br />

informazioni; usiamo le parole e<br />

le relazioni tra i concetti definiti<br />

da esse quando organizziamo i<br />

contenuti.<br />

Molto si sta facendo nel<br />

campo dell’informatica dove<br />

con le SDI (Spatial Data<br />

Infrastructure) si è raggiunto<br />

un elevato grado di interoperabilità<br />

anche grazie al brokering<br />

approach (Nativi et al., 2013),<br />

per il recupero e la gestione<br />

dei dati. Queste infrastrutture<br />

10 <strong>GEOmedia</strong> n°6-<strong>2016</strong>

FOCUS<br />

permettono, anche attraverso<br />

l’uso di ontologie, la gestione<br />

semantica del sistema, ma alcuni<br />

bisogni rimangono ancora<br />

non soddisfatti soprattutto<br />

quando le query vertono su<br />

qualcosa di molto specifico,<br />

o al contrario quando non si<br />

è esperti nel settore e non si<br />

sa bene cosa cercare. Di fatto<br />

la “componente umana” del<br />

sistema utilizza i termini per<br />

interrogare il sistema stesso e<br />

avere a disposizione un chiara<br />

semantica sui rischi e sui sistemi<br />

di EO, significa innanzitutto<br />

avere dei risultati migliori nel<br />

recupero delle informazioni ed<br />

impegnarsi in una prospettiva<br />

di «conoscenza resiliente», in<br />

grado di usare le conoscenze<br />

scientifiche e degli esperti in<br />

un ottica di «spiegazione» e<br />

«comprensione», elementi chiave<br />

per prendere la decisione<br />

migliore di fronte a un disastro.<br />

Se in qualche modo tecniche e<br />

conoscenze scientifiche hanno<br />

una sorta di “interoperabilitàcontestuale”,<br />

le gestione del rischio<br />

e le attività operative sono<br />

strettamente legate ai domini<br />

semantici determinati anche da<br />

differenze politiche e culturali;<br />

ciò significa che vi è la necessità<br />

di rendere esplicite le relazioni<br />

esatte e precise tra concetti (e<br />

termini) appartenenti ad una<br />

ampia gamma di discipline e<br />

anche a lingue diverse.<br />

Si propongono qui due strumenti<br />

utili per affrontare le<br />

criticità connesse al corretto<br />

utilizzo di linguaggi specifici:<br />

l’NHWikisaurus (http://www.<br />

nhwikisaurus.com/) e Earth<br />

Observation Systems Thesaurus<br />

- EOSterm (http://thesaurusonline.iia.cnr.it/vocabs/eosterm/en/index.php).<br />

Il NHWikisaurus, nasce dalla<br />

collaborazione tra la facoltà<br />

di Scienze della Terra dell’<br />

Università di Torino e del’IIA<br />

- CNR (Rapisardi et al., 2014)<br />

e propone un prototipo collaborativo<br />

di produzione dei<br />

contenuti nella parte wiki e per<br />

gli articoli di approfondimento,<br />

mentre nel contempo offre strumenti<br />

teminologici “classici”<br />

(thesaurus, glossario e ontologia),<br />

per una corretta comprensione<br />

dei concetti e delle parole<br />

legate ai rischi naturali. In una<br />

tematica complessa come quella<br />

della gestione dei pericoli e dei<br />

rischi, lo sforzo di costruire una<br />

mappa tra i concetti aiuta molto<br />

a ridurre ed organizzare la complessità<br />

di tutto il sistema, nelle<br />

sue diverse fasi dalla prevenzione,<br />

alla gestione dell’emergenza,<br />

dal superamento delle crisi<br />

all’analisi migliorativa del processo.<br />

Sono stati identificati i<br />

fenomeni, i processi, gli attori e<br />

le azioni e sono state costruite le<br />

relazioni tra questi “entità”.<br />

EOSterm - Earth Observation<br />

Systems Thesaurus, nasce da un<br />

progetto del CNR IIA (Plini<br />

et al., 2007, 2014), volto alla<br />

costruzione di un sistema terminologico<br />

per telerilevamento<br />

e GIS. I termini selezionati<br />

ed organizzati con relazioni<br />

gerarchiche, di equivalenza e<br />

associative, contiene circa 3.000<br />

termini in italiano ed inglese.<br />

Le principali fonti dalle quali<br />

è stata ricavata la terminologia<br />

sono le seguenti: AGI, CCRS<br />

Remote Sensing Glossary of<br />

Canada Centre, ATIS Telecom<br />

glossary 2000, Glossary of<br />

Cartographic Terms” of Texas<br />

University, Dictionary of<br />

Abbreviations and Acronyms<br />

in GIS, Cartography and<br />

Remote Sensing of the<br />

University of California,<br />

Glossary of Oceanography,<br />

Climatology and the Related<br />

Geosciences, GIS Glossary”<br />

of Environmental Systems<br />

Research Institute Inc. (ESRI),<br />

Glossary of GIS and Metadata<br />

terms of Environmental On-<br />

Line Services (ERIN).<br />

Conclusioni<br />

Negli ultimi anni si è dimostrato<br />

come l’integrazione ed il confronto<br />

delle immagini raccolte<br />

attraverso diverse piattaforme,<br />

satelliti, aeroplani, elicotteri,<br />

UAV, possa fornire informazioni<br />

utili ai soccorritori e a chi<br />

gestisce l’emergenza. Inoltre l’e-<br />

Fig. 8 - EOSterm - Thesaurus su i sistemi di osservazione della terra (http://thesaurusonline.iia.cnr.<br />

it/vocabs/eosterm/it/index.php).<br />

<strong>GEOmedia</strong> n°6-<strong>2016</strong> 11

FOCUS<br />

laborazione dei dati provenienti<br />

dall’EO costituisce una base<br />

conoscitiva per creare scenari<br />

incidentali, individuare le zone<br />

a rischio Natech e di conseguenza<br />

creare piani per la pianificazione<br />

dell’emergenza, dalla<br />

prevenzione alla ricostruzione,<br />

così come fornisce dati utili per<br />

le analisi post evento. La visone<br />

di insieme mostra chiaramente<br />

come i dati del remote sensing<br />

siano una fonte di informazioni<br />

sempre più importante, sia per i<br />

rischi Natech che per tutte le altre<br />

tipologie di rischio, in tutte<br />

le fasi del ciclo dell’emergenza,<br />

dalla fase di prevenzione a quella<br />

della gestione dell’emergenza,<br />

alla ricostruzione, per poi tornare<br />

di nuovo alla prevenzione<br />

secondo un ciclo di miglioramento<br />

continuo.<br />

Una delle sfide cruciali dei prossimi<br />

anni sarà quella di pianificare<br />

accuratamente le missioni<br />

dei micro-satelliti al fine di<br />

massimizzarne l’uso per l’osservazione<br />

delle aree potenzialmente<br />

a rischio per migliorarne<br />

la valutazione e la gestione e per<br />

studiare i fattori di causalità e le<br />

connessioni tra rischi antropici<br />

e rischi naturali.<br />

Inoltre gli UAV sembrano essere<br />

particolarmente adatti nelle<br />

operazioni di soccorso, anche in<br />

quelle situazioni o luoghi dove<br />

per le squadre di soccorso non<br />

è sicuro intervenire (ad esempio<br />

per la presenza di crolli o sostanze<br />

nocive).<br />

Inoltre la gran mole di dati a<br />

disposizione rende utile l’uso<br />

di strumenti terminologici che,<br />

attraverso i concetti e i termini<br />

in essi contenuti, ne facilitino<br />

la catalogazione, la gestione e il<br />

recupero, in modo da rendere le<br />

informazioni fruibili in tempi<br />

rapidi. Sarebbe utile disporre di<br />

glossari e thesauri relativi specificamente<br />

ai rischi Natech e alla<br />

tecnologia necessaria per la loro<br />

gestione.<br />

BIBLIOGRAFIA<br />

AA. VV. (2011), “Dipartimento IUAV per la Ricerca. Unità di Ricerca: Nuove tecnologie per la conoscenza del territorio e<br />

dell’ambiente. “City Sensing” e “Near Mapping” microdrone i-uav piattaforma aerea leggera a bassa quota per il monitoraggio citta’<br />

ambiente e territorio, rilievi di parchi, infrastrutture, aree industriali, edifici, aree in dissesto idrogeologico, applicazioni tematiche<br />

di protezione civile”, Rapporto Conclusivo, http://www.ricercasit.it/smartcities/ricerca/Pervasive%20Real%20Time%20Sensing/<br />

MicrodroneUAV/Progetto%20I-UAV.pdf<br />

Alexander D. (2002), “From civil defence to civil protection and back again”, Disaster Prevention and Management, 11, (3): 209-213<br />

Ajmar A, Boccardo P, Disabato F, Giulio Tonolo F. (2015), “Rapid Mapping: geomatics role and research opportunities”, Geodesy<br />

And Geomatics To The Edge. Rendiconti Lincei, 26, 1: 63-73 DOI: 10.1007/s12210-015-0410-9<br />

Antonioni G, Bonvicini S, Spadoni G, Cozzani V. (2009), “Development of a framework for the risk assessment of Na-Tech accidental<br />

events”, Reliability Engineering & System Safety, 94, 9: 1442-1450<br />

Clerc A, Le Claire G. (1994), “The environmental impacts of natural and technological (Na-tech) disasters”, Background discussion<br />

paper for The World Conference on Natural Disaster Reduction, Yokohama, Japan, 23–27 May 1994<br />

Cruz AM, Steinberg LJ, Vetere Arellano L, Nordvik JP, Pisano F. (2004), “State of the Art in Natech Risk Management (NATECH:<br />

Natural Hazard Triggering a Technological Disaster)”, EUR 21292 EN, © European Communities<br />

Di Franco S, Salvatori R. (2015), “Current situation and needs in man-made and Natech risks management using Earth<br />

Observation techniques”, Remote Sensing Applications: Society and Environment, 1: 72–84. DOI: http://dx.doi.org/10.1016/j.rsase.2015.06.004<br />

European Commision. Copernicus Emergency Management Service, http://emergency.copernicus.eu/mapping/#zoom=2&lat=20.<br />

25728&lon=17.0555&layers=0B000000T<br />

Galderisi A, Ceudech A, Pistucci M. (2008), “A method for Na-tech risk assessment as supporting tool for land use planning mitigation<br />

strategies”, Nat Hazards, DOI 10.1007/s11069-008-9224-8<br />

Girgin S, Krausmann E. (2013), “RAPID-N: Rapid Natech risk assessment and mapping framework”, Journal of Loss Prevention in<br />

the Process Industries, 26: 949 - 960, DOI:10.1016/j.jlp.2013.10.004<br />

Joyce KE, Wright KC, Samsonov SV, Ambrosia VG. (2009), Remote sensing and the disaster management cycle. Advances in Geoscience<br />

and Remote Sensing, Gary Jedlovec (Ed.), ISBN: 978-953-307-005-6, InTech, DOI: 10.5772/8341<br />

Krausmann E, Cozzani V, Salzano E, Renni E. (2011), “Industrial accidents triggered by natural hazards: an emerging risk issue”,<br />

Nat. Hazards Earth Syst. Sci., 11: 921–929, DOI:10.5194/nhess-11-921-2011<br />

Kucera J, Lemoine G, Kemper T. (2012), “Post-Disaster Needs Assessment: the role of remote sensing and geospatial information”,<br />

IPSC - Institute for the Protection and Security of the Citizen. JRC- European Commission. Vienna, PDNA training, https://www.gfdrr.<br />

org/sites/gfdrr.org/files/3_JRC-Remote_Sensing.pdf<br />

Lewis PE. (2011), “The Evolution of Airborne Chemical and Radiological Remote Sensing For Emergency and Natural<br />

Disaster Response”, National Geospatial-Intelligence Agency (NGA) - USA. SPIE 2011 Remote Sensing PlenaryTalk, http://spie.org/<br />

Documents/AboutSPIE/PDF/ERS11-plenary-Lewis.pdf<br />

Lindell MK, Perry RW. (1996), “Identifying and managing conjoint threats: earthquake-induced hazardous materials releases”. The<br />

US. J Hazard Mater 50: 31–46<br />

Marzo E, Busini V, Rota R. (2015)), “Definition of a short-cut methodology for assessing the vulnerability of a territory in naturaltechnological<br />

risk estimation”, Reliability Engineering and System Safety, 134: 92–97<br />

Menoni S, Molinari D, Parker D, Ballio F, Tapsell S. (2012), “Assessing multifaceted vulnerability and resilience in order to design<br />

risk-mitigation strategies”, Nat Hazards, 64: 2057–2082, DOI 10.1007/s11069-012-0134-4<br />

Nativi S, Craglia M, Pearlman J. (2013), “Earth Science Infrastructures Interoperability: The Brokering Approach”, IEEE Journal of<br />

selected topics in applied earth observations and remote sensing, 6, 3, DOI: 10.1109/JSTARS.2013.2243113<br />

Plini P, Di Franco S, De Santis V, Salvatori R. (2015), “EOSterm - Earth Observation Systems Thesaurus”, http://thesaurusonline.<br />

iia.cnr.it/vocabs/eosterm/en/index.php<br />

Plini P, Salvatori R, Di Franco S, De Santis V. (2007), “L’organizzazione di metadati e dati relativi a piattaforme aeree e satellitari per<br />

il telerilevamento”, 11ª Conferenza Nazionale ASITA, Torino<br />

Rapisardi E, Di Franco S, Giardino M. (2014), “Web Participatory Framework for Disaster Resilience: Coping with Information<br />

Deluge”, Conference: IAEG 2014, Engineering Geology for Society and Territory, 7<br />

Salzano E, Basco A, Busini V, Cozzani V, Marzo E, Rota R, Spadoni G. (2013), “Public awareness promoting new or emerging<br />

risks: Industrial accidents triggered by natural hazards (Natech)”, Journal of Risk Research, 16, 3-4: 469-485, DOI:<br />

10.1080/13669877.2012.729529<br />

Sandau R. (2006), International Study on Cost-Effective Earth Observation Missions, Balkema A.A. Publishers, Taylor & Francis<br />

Group, Leiden, The Netherlands, 160. ISBN10:0-415-39136-9, ISBN13:9-78-0-415-39136-8<br />

Sandau R, Briess K. (2008), “Potential for advancements in remote sensing using small satellites”, The International Archives of the<br />

Photogrammetry, Remote Sensing and Spatial Information Sciences. XXXVII, B1, Beijing<br />

Sandau R, Briess K. (2010). “The role of small satellite mission in global change studies- Advances”, Chuvieco, E., Li, J., Yang, X.<br />

(Eds). Earth Observation of Global Change. Springer Science & Business Media, 298<br />

Sandau R. (2010), “Status and trends of small satellite missions for Earth observation”, Acta Astronautica, 66: 1 - 12<br />

Sengupta A. (2007), “Industrial hazard, vulnerability and Risk Assessment for land use Planning: A case study old Haldia, west<br />

Bengal, India”, International Institute for Geo-information Science and Earth Observation (ITC), http://www.itc.nl/library/papers_2007/msc/iirs/sengupta.pdf<br />

Showalter PS, Ramspott M. (1999), “The use of remote sensing in detecting and analyzing natural hazards and disaster, 1972-<br />

1998. A partially annotated Bibliography”. J.M. Lovell Center for Environmental Geography and Hazards Research, Southwest Texas<br />

State University., 1<br />

Wang L, Zhou W, Zhao S.(2013), “Application of Mini-UAV in Emergency Rescue of Major Accidents of Hazardous Chemicals”,<br />

International Conference on Remote Sensing, Environment and Transportation Engineering (RSETE 2013)<br />

ABSTRACT<br />

The Earth Observation (EO) techniques are becoming increasingly important in risk management activities not only for natural hazards<br />

and natural disaster monitoring but also to ride out industrial and Natech accidents. The latest development in the aerospace industry such<br />

as sensors miniaturization and high spatial and temporal resolution missions devoted to monitoring areas of specific interest, have made the<br />

use of EO techniques more efficient and ready to use in near real time conditions. This paper summarize the current state of knowledge on<br />

how EO data can be useful in manage all the phases of the Natech disaster, from the environmental conditions before the accident strikes to<br />

the post accident relief, from the scenario setting and planning stage to damage assessment. Moreover some terminological tools are proposed<br />

NHWikisaurus and EOSterm thesaurus, that could be useful for semantic knowledge spreading in EO and risk managment.<br />

PAROLE CHIAVE<br />

Gestione del rischio; Natech; remote sensing; telerilevamento; Copernicus; GMES; emergenza<br />

AUTORE<br />

Sabina Di Franco<br />

difranco@iia.cnr.it<br />

Rosamaria Salvatori<br />

Istituto sull'InquinamentoAtmosferico – CNR<br />

via salaria Km 29,300<br />

Elena Rapisardi<br />

NatRisk, Università di Torino<br />

NOTA REDAZIONE<br />

Il tema di questo articolo è stato presentato per la prima volta nella XIX Conferenza ASITA.<br />

12 <strong>GEOmedia</strong> n°6-<strong>2016</strong>

FOCUS<br />

<strong>GEOmedia</strong> n°6-<strong>2016</strong> 13

REPORT<br />

Telerilevamento e GIS per la<br />

valutazione e il monitoraggio delle<br />

isole di calore in ambiente urbano<br />

di Sabrina Adelfio, Caterina Enea, Giuseppe Bazan, Pietro Orlando<br />

Fig. 1 – Strisciata immagine MIVIS 2002.<br />

Le tecniche di analisi spaziale e di telerilevamento costituiscono uno strumento molto utile per la conoscenza e lo<br />

studio del fenomeno dell’isola di calore urbano (indicata anche come UHI, dall’acronimo inglese Urban Heat Island).<br />

Nel presente studio, tra le molteplici cause che portano alla generazione di questo fenomeno, sono state approfondite<br />

quelle relative alle caratteristiche fisiche delle superfici e alla presenza delle diverse coperture di uso del suolo.<br />

Negli ultimi secoli l’aumento<br />

demografico<br />

mondiale e la crescita<br />

incontrollata delle città hanno<br />

causato significativi cambiamenti<br />

del territorio da parte dell’uomo.<br />

Una delle conseguenze provocate<br />

da questa trasformazione è la<br />

formazione dell’UHI. Questa si<br />

presenta come un evento microclimatico<br />

che si verifica nelle aree<br />

urbanizzate e consiste in un notevole<br />

aumento della temperatura<br />

nell’ambito urbano rispetto alla<br />

periferia della città e, in particolare,<br />

alle aree rurali circostanti<br />

(Oke, 1973). Nonostante il fenomeno<br />

sia noto almeno dal XIX<br />

secolo, solamente negli ultimi<br />

decenni ha suscitato l’interesse<br />

del mondo scientifico, divenendo<br />

una problematica su cui i pianificatori<br />

urbani stanno ponendo<br />

una grande attenzione. Gli studi<br />

finora effettuati ne distinguono<br />

tre tipologie:<br />

4Isola di calore atmosferica<br />

(Atmospheric UHI - AUHI),<br />

che si distingue ulteriormente<br />

in:<br />

o Isola di calore dello strato<br />

limite urbano, situato al<br />

di sopra dell’altezza media<br />

degli edifici (Urban<br />

Boundary Layer – UBL);<br />

o Isola di calore dello strato<br />

della copertura urbana,<br />

ubicato sotto l’altezza<br />

media degli edifici (Urban<br />

Canopy Layer - UCL);<br />

4Isola di calore di superficie<br />

o epidermica (Surface UHI –<br />

SUHI);<br />

4Isola di calore del sottosuolo<br />

(Subsurface UHI).<br />

Questi diversi tipi di isola di<br />

calore sono certamente correlati,<br />

infatti l’interazione tra il<br />

Boundary Layer, il Canopy Layer e<br />

il Surface Layer genera o meno la<br />

presenza sopra la città di un’isola<br />

di colore. Tuttavia è importante<br />

distinguerli, poiché differiscono<br />

per cause, strumenti di misurazione<br />

e dinamiche temporali.<br />

Le isole di calore atmosferiche<br />

si manifestano in prevalenza di<br />

notte e possono essere negative<br />

di giorno, viceversa quelle di superficie<br />

raggiungono la massima<br />

intensità durante le ore diurne.<br />

Per dedurre con sufficiente precisione<br />

la temperatura superficiale<br />

delle coperture al suolo è stato<br />

utilizzato il Telerilevamento<br />

Termico (Thermal Remote Sensing<br />

- TRS), effettuato con sensori che<br />

acquisiscono informazioni nella<br />

sottobanda dell’infrarosso termico.<br />

Il TRS permette, dunque, di<br />

misurare la quantità di radiazione<br />

elettromagnetica emessa dalla superficie<br />

terrestre nelle lunghezze<br />

d’onda che appartengono alla<br />

regione dell’infrarosso termico.<br />

In seguito, attraverso l’utilizzo<br />

integrato delle tecnologie di telerilevamento<br />

implementate in<br />

ambiente GIS, è stato possibile<br />

analizzare le caratteristiche della<br />

struttura urbana e, in particolare,<br />

comprendere come variano le<br />

temperature all’aumentare della<br />

distanza dalle aree verdi.<br />

14 <strong>GEOmedia</strong> n°6-<strong>2016</strong>

REPORT<br />

Area di studio<br />

La città di Palermo si trova ad<br />

una latitudine di 38°06’56”N<br />

e longitudine di 13°21’41”E,<br />

con un’altitudine di 14 m s.l.m.<br />

Il Comune si estende per una<br />

superficie pari a 160,59 Km 2<br />

con una popolazione di 678 492<br />

abitanti. La città è caratterizzata<br />

da un clima temperato delle medie<br />

latitudini con estati asciutte e<br />

calde e inverni freschi e piovosi.<br />

Nell’analisi condotta è stata presa<br />

in considerazione una strisciata<br />

corrispondente alla zona Ovest di<br />

Palermo delimitata a nord dalla<br />

borgata marinara di Mondello e a<br />

sud dalla valle del fiume Oreto.<br />

La scelta dell’area è stata orientata<br />

dalla presenza di differenti tipologie<br />

di tessuto urbano, al fine<br />

di verificare il comportamento<br />

delle temperature al variare delle<br />

differenti coperture di uso del<br />

suolo. Sono, infatti, presenti aree<br />

consolidate ad alta densità, con<br />

tessuto diffuso a media e bassa<br />

densità e aree verdi di notevole<br />

estensione. Tra le infrastrutture<br />

presenti, Viale della Regione<br />

Siciliana è quella che segna<br />

maggiormente il territorio,<br />

attraversandolo da nord a sud.<br />

Questa, se da un lato rappresenta<br />

un fondamentale elemento di<br />

decongestionamento del traffico<br />

urbano, dall’altro provoca un inquinamento<br />

acustico e atmosferico<br />

tale da ridurre la qualità della<br />

vita e della salute dei cittadini.<br />

Tale impatto viene testimoniato<br />

da dati relativi alle emissioni di<br />

CO (g/Km) ricavate con l’applicazione<br />

del metodo COPERT<br />

II (COmputer Programme to<br />

calculate Emission from Road<br />

Traffic) nell’ambito delle attività<br />

del progetto CORINAIR<br />

(COoRdination Information<br />

AIR) (Corriere, 2011). Da qui la<br />

necessità di eseguire analisi più<br />

approfondite con l’obiettivo di<br />

quantificare le variazioni di temperatura<br />

dovute all’aumento delle<br />

distanze dalla vegetazione.<br />

Materiali e metodologia<br />

L’immagine è stata acquisita dal<br />

sensore MIVIS (Multispectral<br />

Infrared and Visible Immaging<br />

Spectrometer) che opera con<br />

un’elevata risoluzione spettrale<br />

e spaziale. I dati sono stati rilevati<br />

con un volo effettuato sulla<br />

città di Palermo nel luglio del<br />

2002, intorno alle ore 12, ora<br />

che ha permesso di ridurre le<br />

zone d’ombra data la posizione<br />

zenitale del sole. L’immagine è<br />

stata calibrata radiometricamente<br />

e corretta geometricamente al<br />

fine di eliminare le distorsioni<br />

geometriche e radiometriche<br />

dovute al sistema di acquisizione,<br />

al mezzo di propagazione del<br />

segnale, all’angolo di ripresa e<br />

all’effetto della curvatura terrestre.<br />

Successivamente l’immagine<br />

MIVIS è stata georeferenziata<br />

nel sistema cartografico di riferimento<br />

WGS84 UTM33.<br />

Per elaborare l’immagine in<br />

esame si è fatto uso del software<br />

ENVI (Environment for<br />

Visualizing Images), realizzato<br />

dalla Research Systems Inc., nella<br />

versione 4.3. Questa è stata<br />

sottoposta inizialmente ad una<br />

fase di calibrazione mediante<br />

l’utilizzo del metodo empirico<br />

lineare che rimuove approssimativamente<br />

l’irradianza solare,<br />

l’assorbimento atmosferico, gli<br />

effetti di scattering e permette di<br />

passare da valori di radianza a valori<br />

di riflettenza. A tal proposito<br />

si è fatto riferimento ad alcune<br />

misurazioni condotte su alcune<br />

porzioni di asfalto, messo in opera<br />

da poco, e su della ghiaia.<br />

Sono state compiute molteplici<br />

elaborazioni con le tecniche di<br />

classificazione pixel-based, utilizzando<br />

i differenti algoritmi implementati<br />

nel software ENVI, al<br />

fine di valutare e confrontare le<br />

mappe tematiche risultanti dalle<br />

differenti metodologie di classificazione.<br />

Si è potuto constatare<br />

che il risultato qualitativamente<br />

migliore e più rappresentativo<br />

per il territorio osservato è stato<br />

ottenuto con l’algoritmo SAM.<br />

Questo richiede come input un<br />

numero di aree di prova (training<br />

areas) o spettri di riferimento,<br />

derivanti da specifiche ROI<br />

(Region of Interest). Nel presente<br />

studio gli spettri input<br />

sono stati ricavati da ROI<br />

individuate nella scena, dove la<br />

metodologia seguita si è avvalsa<br />

di un’analisi visiva di sintesi<br />

additive in RGB. Ogni ROI è<br />

costituita da raggruppamenti di<br />

pixel il più possibile omogenei<br />

e rappresentativi, che serviranno<br />

ad addestrare l’algoritmo di<br />

classificazione affinché associ<br />

ogni pixel dell’immagine ad<br />

una data categoria. Le ROI<br />

utilizzate per la classificazione<br />

fanno riferimento a 5 classi<br />

di copertura del suolo (Asfalto,<br />

Vegetazione, Edifici con Tetto<br />

bianco, Edifici con Tetto rosso)<br />

più la classe Ombra. La distinzione<br />

tra Tetti rossi e Tetti<br />

bianchi è servita non solo ad individuare<br />

la tipologia di uso del<br />

suolo, ma anche ad analizzare<br />

le caratteristiche termiche dei<br />

ROI NAME COLOR PIXELS POLYGONOS FILL ORIEN ORIENT<br />

Ombra Sea Green 38 3/38 Solid 45 0.10<br />

Asfalto Magenta 186 4/186 Solid 45 0.10<br />

Vegetazione Green 472 12/147 Solid 45 0.10<br />

Edifici con Cyan 60 5/60 Solid 45 0.10<br />

tetto bianco<br />

Edifici con Red 30 3/30 Solid 45 0.10<br />

tetto rosso<br />

Suolo nudo Yellow 34 2/34 Solid 45 0.10<br />

Fig. 2 – ROI strisciata immagine MIVIS 2002<br />

<strong>GEOmedia</strong> n°6-<strong>2016</strong> 15

REPORT<br />

materiali utilizzati. Anche la<br />

classe Ombra, fornisce più che<br />

informazioni relative all’uso del<br />

suolo, informazioni termiche,<br />

in quanto temperature inferiori<br />

nella classe dell’asfalto o dell’urbanizzato<br />

non sarebbe state<br />

altrimenti spiegate.<br />

Nel processo decisionale di<br />

classificazione sono state utilizzate<br />

le bande da 1 a 32 e da 93<br />

a 102. Le bande centrali sono<br />

state escluse al fine di evitare sovrapposizioni<br />

tra le firme spettrali,<br />

con conseguenti errori di classificazione<br />

dei pixel. Attraverso<br />

il processo di classificazione si<br />

passa da un’immagine composta<br />

da Digital Number ad un’immagine<br />

di classi corrispondenti<br />

alle categorie di usi del suolo.<br />

Nonostante la classificazione<br />

ottenuta mediante l’utilizzo<br />

dell’algoritmo SAM sia stata la<br />

migliore, si è potuto riscontrare<br />

come una medesima classe tematica<br />

fosse al suo interno molto<br />

variegata e risultasse costituita da<br />

classi spettrali differenti fra loro.<br />

L’errore che può essere commesso<br />

durante il processo di classificazione<br />

è quello di assegnare un<br />

pixel ad una categoria o classe<br />

diversa da quella a cui appartiene.<br />

Per avere contezza dell’errore<br />

commesso, si ricorre alla “verifica<br />

di accuratezza” che prevede la<br />

realizzazione di una matrice di<br />

confusione, ovvero una matrice<br />

quadrata in cui vengono riportati<br />

i risultati dal confronto tra<br />

la mappa tematica prodotta in<br />

seguito alla classificazione e la<br />

verità di riferimento. La matrice<br />

ha dimensione q×q, dove q è il<br />

numero delle classi o categorie<br />

nella mappa; le colonne rappresentano<br />

i dati di riferimento<br />

(verità), mentre le righe rappresentano<br />

i dati della classificazione.<br />

Il software ENVI può calcolare<br />

una matrice di confusione<br />

utilizzando la ground true image<br />

oppure le ground true ROIs. Nel<br />

presente lavoro è stato utilizzato<br />

CLASS TETTI SUOLO ASFALTO OMBRA TETTI VEGETAZIONE TOTALE<br />

ROSSI NUDO<br />

BIANCHI<br />

Unclassified 0 0 0 0 69 0 69<br />

Tetti rossi 127 0 0 0 0 0 127<br />

Suolo nudo 40 111 0 0 0 0 151<br />

Asfalto 0 54 46 0 0 0 100<br />

Ombra 0 35 55 108 0 0 198<br />

Tetti bianchi 0 0 0 0 50 0 50<br />

Vegetazione 0 0 0 0 0 175 175<br />

Totale 167 200 101 108 119 175 870<br />

Fig. 3 – Ground Truth (pixels).<br />

il secondo metodo che prevede la<br />

realizzazione di ulteriori ROI di<br />

verità a terra, che saranno confrontate<br />

con le ROI utilizzate per<br />

la classificazione delle immagini.<br />

Il prodotto dell’analisi comprende<br />

una valutazione di accuratezza<br />

totale in percentuale (Overall<br />

Accuracy), data dal rapporto tra<br />

i pixel classificati correttamente<br />

e i pixel totali; il coefficiente<br />

kappa; la matrice di confusione,<br />

nella cui diagonale vengono<br />

rappresentati i pixel classificati<br />

correttamente; gli errori di commissione<br />

(percentuale di pixel<br />

in più nella classe); gli errori di<br />

omissione (percentuale di pixel<br />

lasciati fuori dalla classe di appartenenza);<br />

le precisioni producer<br />

and user (utente e produttore)<br />

per ogni classe. La precisione<br />

producer è la probabilità che un<br />

pixel nell’immagine classificata<br />

venga assegnato alla classe x<br />

dato che la classe di verità a<br />

terra è x. La precisione user è la<br />

probabilità che la classe di verità<br />

a terra sia x dato che il pixel è<br />

CLASS<br />

COMMISSION<br />

stato assegnato alla classe x nella<br />

classificazione.<br />

Di seguito si riportano la verifica<br />

di accuratezza dell’intera strisciata<br />

presa in esame.<br />

Overall Accuracy: (617/870)<br />

70,9195%; Coefficiente Kappa:<br />

0,6547<br />

Si è cercato a questo punto di<br />

migliorare i risultati fin qui ottenuti<br />

eseguendo un’operazione<br />

di filtraggio che consiste nell’eliminare<br />

i pixel che in realtà non<br />

appartengono alla classe corretta.<br />

Tale operazione sfrutta, per determinare<br />

il valore del pixel di<br />

destinazione, il valore di alcuni<br />

pixel ad esso più vicini. Nel caso<br />

specifico si è scelto un quadrato<br />

di 3x3 pixel in cui quello in esame<br />

si trova in posizione centrale.<br />

In questo modo è stato possibile<br />

risolvere le problematiche connesse<br />

alla presenza di pixel isolati<br />

presenti in altre classi.<br />

Successivamente l’immagine<br />

classificata è stata importata in<br />

ambiente GIS come shapefile,<br />

elaborata con il software ArcGis<br />

OMISSION<br />

COMMISSION<br />

OMISSION<br />

%<br />

%<br />

(pixels)<br />

(pixels)<br />

Tetti rossi 0 23,95 0/127 40/167<br />

Suolo nudo 26,49 44,50 40/151 89/200<br />

Asfalto 54,00 54,46 54/100 55/101<br />

Ombra 45,45 0 90/198 0/108<br />

Tetti bianchi 0 57,98 0/50 69/119<br />

Vegetazione 0 0 0/175 0/175<br />

Fig. 4 – Errori di commissione e omissione.<br />

16 <strong>GEOmedia</strong> n°6-<strong>2016</strong>

REPORT<br />

10.0 e ulteriormente corretta,<br />

in quanto sono state riscontrate<br />

anomalie nella classificazione del<br />

suolo nudo, erroneamente individuato<br />

come Edifici con tetto<br />

rosso. È stata quindi fatta una<br />

query selezionando tutti i poligoni<br />

classificati come Tetti rossi<br />

che presentavano una superficie<br />

maggiore di 5000 mq, per verificare<br />

di volta in volta la reale<br />

classe di appartenenza. Si sono<br />

riscontrati, inoltre, degli errori<br />

relativi alla classe dell’Asfalto che<br />

spesso presentava al suo interno<br />

porzioni rocciose di Suolo nudo;<br />

anche queste sono state di volta<br />

in volta verificate e corrette.<br />

Non avendo, inoltre, inserito<br />

all’interno delle ROI la classe<br />

Acqua il mare viene classificato<br />

come Ombra. In questa fase di<br />

correzione, pertanto, il mare è<br />

stato ritagliato dall’immagine<br />

in modo da non tenerne conto<br />

nelle successive elaborazioni. Pur<br />

non essendo l’Ombra, una tipologia<br />

di copertura di uso del suolo,<br />

è stato necessario mantenerla<br />

come classe a sé, in quanto le<br />

zone d’ombra creavano dei problemi<br />

nella classificazione. Sono<br />

state così ottenute le immagini<br />

finali, sulle quali sono state calcolate<br />

le percentuali di coperture<br />

di uso del suolo. Nella strisciata<br />

si ha il 27,80% di Suolo nudo,<br />

il 22,53% di Vegetazione, il<br />

19,52% di Ombra, il 13,03% di<br />

Asfalto, il 9,52% di Edifici con<br />

tetto rosso e il 7,60% di Edifici<br />

con tetto bianco.<br />

Dall’immagine MIVIS è stata<br />

poi realizzata una termografia<br />

prendendo in considerazione le<br />

bande dell’infrarosso termico<br />

CLASS PROD. ACC.<br />

%<br />

USER. ACC.<br />

%<br />

PROD. ACC. USER. ACC.<br />

(pixels<br />

(pixels)<br />

Tetti rossi 76,05 100,00 127/167 127/127<br />

Suolo nudo 55,50 73,51 111/200 111/151<br />

Asfalto 45,54 46,00 46/101 46/100<br />

Ombra 100,00 54,55 108/108 108/198<br />

Tetti bianchi 42,02 100,00 50/119 50/50<br />

Vegetazione 100,00 100,00 175/175 175/175<br />

Fig. 5 – Precisioni utente e produttore.<br />

(dalla 93 alla 102 corrispondenti<br />

alle lunghezze d’onda comprese<br />

tra 8,2 e 12,7 μm). In particolare<br />

estraendo la banda 93 (con<br />

lunghezza d’onda compresa tra<br />

8,20 e 8,60 μm) è stato possibile<br />

ricavare valori di emissività delle<br />

superfici, ossia valori di temperatura.<br />

Le informazioni ottenute<br />

con la realizzazione dell’immagine<br />

termica sono servite a comprendere<br />

come le componenti<br />

del paesaggio urbano influenzino<br />

le dinamiche della radiazione<br />

termica e come vi sia dunque<br />

una forte correlazione tra caratteristiche<br />

delle superfici urbane<br />

e temperatura. Per rappresentare<br />

le variazioni di temperatura è<br />

stata utilizzata una graduazione<br />

di colori che va dal verde delle<br />

zone più fredde al rosso delle<br />

zone più calde. Importando le<br />

immagini in ambiente GIS è<br />

stato possibile calcolare le temperature<br />

medie di ogni classe<br />

di uso del suolo. Nell’intera<br />

strisciata la temperatura media<br />

più elevata si ha per il Suolo<br />

nudo con 36,99°, seguono gli<br />

Edifici con tetto rosso e l’Asfalto<br />

con 36,02°, gli Edifici<br />

con tetto bianco con 34,47°,<br />

la Vegetazione con 30,81° e per<br />

ultima l’Ombra con 28,99°.<br />

Nonostante il Suolo nudo sia<br />

caratterizzato da una superficie<br />

permeabile in cui si ha il processo<br />

di evapotraspirazione, l’assenza<br />

totale di vegetazione e di zone<br />

d’ombra lo rende la superficie<br />

più calda. Gli Edifici con tetto<br />

rosso hanno una temperatura<br />

più elevata rispetto a quelli con<br />

Tetto bianco, in quanto superfici<br />

con vernici o materiali chiari<br />

riflettono gran parte della radiazione<br />

proveniente dal sole,<br />

assorbendone quantità irrisorie.<br />

Inoltre, un tessuto a bassa densità<br />

intervallato da vegetazione<br />

può contribuire all’abbassamento<br />

delle temperature; tuttavia<br />

anche il tessuto consolidato<br />

presenta temperature inferiori a<br />

causa della formazione di zone<br />

d’ombra tra gli edifici. L’asfalto<br />

delle strade e dei grandi parcheggi<br />

crea delle vaste superfici<br />

impermealizzate e assorbe una<br />

quantità notevole di radiazione,<br />

a causa del colore scuro dei manti<br />

bituminosi. Al contrario i tetti<br />

bianchi, per le loro proprietà<br />

riflettenti, e la vegetazione presentano<br />

temperature inferiori.<br />

Quest’ultima, infatti, caratterizza<br />

i suoli permeabili favorendo<br />

Fig. 6 – Classificazione finale – Strisciata immagine MIVIS 2002.<br />

<strong>GEOmedia</strong> n°6-<strong>2016</strong> 17

REPORT<br />

Fig. 7 – Termografia – Strisciata immagine MIVIS 2002.<br />

il processo di evapotraspirazione<br />

e garantisce la presenza di zone<br />

d’ombra. Le informazioni ottenute<br />

dall’analisi termica hanno<br />

confermato la presenza di elevate<br />

temperature in corrispondenza<br />

di forti emissioni di CO, nello<br />

specifico l’attenzione è stata<br />

rivolta su due tratti stradali di<br />

Viale della Regione Siciliana,<br />

quantificando le variazioni di<br />

temperatura dovute all’aumento<br />

delle distanze dalla vegetazione.<br />

Al fine di verificare il comportamento<br />

delle temperature in aree<br />

con tipologie di tessuto urbano a<br />

bassa densità edilizia e in assenza<br />

di forti emissioni di CO, sono<br />

state prese in considerazione due<br />

porzioni di territorio caratterizzate<br />

dalla presenza di aree verdi.<br />

L’analisi prevede innanzitutto<br />

di estrapolare la vegetazione<br />

dalla classificazione effettuata<br />

precedentemente e importarla in<br />

ambiente GIS, dove saranno costruiti<br />

cinque buffer con larghezza<br />

di 3 m attorno alle aree verdi,<br />

aumentando progressivamente la<br />

distanza da queste. Il primo parte<br />

direttamente dal limite esterno<br />

della vegetazione (si indicherà<br />

in seguito a una distanza di 0<br />