GEOmedia_6_2021

Rivista Italiana di Geomatica

Rivista Italiana di Geomatica

Create successful ePaper yourself

Turn your PDF publications into a flip-book with our unique Google optimized e-Paper software.

Rivista bimestrale - anno XXV - Numero - 6/<strong>2021</strong> - Sped. in abb. postale 70% - Filiale di Roma<br />

TERRITORIO CARTOGRAFIA<br />

GIS<br />

CATASTO<br />

3D<br />

INFORMAZIONE GEOGRAFICA<br />

FOTOGRAMMETRIA<br />

URBANISTICA<br />

EDILIZIA<br />

GNSS<br />

BIM<br />

RILIEVO TOPOGRAFIA<br />

CAD<br />

REMOTE SENSING SPAZIO<br />

WEBGIS<br />

UAV<br />

SMART CITY<br />

AMBIENTE<br />

NETWORKS<br />

LiDAR<br />

BENI CULTURALI<br />

LBS<br />

Nov/Dic <strong>2021</strong> anno XXV N°6<br />

Infrastrutture<br />

di Dati Territoriali<br />

MAPPATURA AMIANTO<br />

CON GIS E AI<br />

TECNICHE DI RILIEVO PER<br />

PROCESSI SCAN-TO-BIM<br />

ATTUALITA' DELLA<br />

NAVIGAZIONE ASTRONOMICA

Il futuro delle IDT<br />

Se pensiamo al grande lavoro intrapreso negli ultimi 50 anni per la realizzazione dei<br />

Geodatabase topografici che costituiscono l’ossatura portante delle Infrastrutture dei Dati<br />

Territoriali, non possiamo tralasciare un aggiornamento programmatico. Aggiungendo la<br />

necessità di corredare i Geodatabase delle informazioni territoriali connesse si costruisce<br />

un assioma che dovrebbero costituire il fondamento degli obiettivi delle amministrazioni<br />

responsabili ai vari livelli, dallo Stato al singolo Comune.<br />

Sappiamo bene che dopo una lunga fase di incertezza istituzionale, compensata in parte dalle<br />

azioni condotte nei Gruppi di Lavoro promossi da AGID e attivati nel maggio del 2014, nel<br />

corso del 2018 si avviarono i lavori della Consulta Nazionale per l’Informazione Territoriale ed<br />

Ambientale (CNITA) in attuazione della Direttiva INSPIRE.<br />

Le attività dell’organismo presieduto dal Ministero dell’Ambiente si esplicano attraverso<br />

6 sezioni tecniche. La prima è presieduta dall’ISPRA, che opera per il raccordo tra il<br />

livello nazionale e il livello territoriale per la realizzazione dell’infrastruttura nazionale per<br />

l’informazione territoriale e del monitoraggio ambientale. Segue l’AGID per la raccolta delle<br />

istanze italiane sui metadati da trasmettere in sede europea attraverso il Repertorio Nazionale<br />

dei Dati Territoriali preparando il rapporto annuale INSPIRE. Viene quindi l’IGM che propone<br />

l’attribuzione univoca della responsabilità di produzione e mantenimento dei dati di interesse<br />

generale, predisponendo un sistema di monitoraggio per la verifica dell’aggiornamento dei<br />

dati territoriali esistenti e dei dati territoriali raccolti ex novo in conformità alle disposizioni di<br />

esecuzione europee con raccordo e reportistica per la preparazione dell’annuale report INSPIRE.<br />

Il CISIS segue i servizi di rete per la ricerca e il download dei dati a livello nazionale, curandone<br />

la conformità INSPIRE. Le altre sezioni tecniche di CNIPA, AGID e ISPRA predispongono<br />

la comunicazione che il Ministero dell’ambiente invia alla Commissione europea entro il 15<br />

maggio di ogni anno.<br />

Insomma, tutte le attività delle sezioni tecniche menzionate sembrano essere spinte dalla sola<br />

aderenza europea alla convenzione INSPIRE, che non chiedeva altro che omogeneizzare i dati<br />

per l’interscambio tra le nazioni europee.<br />

Possibile che l’unico motore rimasto oggi in Italia per avere una documentazione dello stato di<br />

fatto aggiornato del territorio sia quello della necessità di non essere multati dalla Commissione<br />

Europea per la mancata adesione alle Direttive?<br />

Le numerose commissioni, consulte e comitati esistenti apportano il loro contributo, ma<br />

quello che sembra assolutamente inesistente è la volontà di attuare programmi globali per la<br />

documentazione dello stato del territorio atto ad una vera pianificazione e controllo. Eppure<br />

tempo fa c’erano regole (e leggi regionali) molto semplici, come quella che obbligava le Regioni<br />

ad eseguire voli aerofotogrammetrici a cadenza biennale per il controllo dell’attività urbanistica.<br />

Guardiamo al futuro e orientiamoci oggi verso una vera attività programmatica<br />

dell’aggiornamento delle IDT che dovrebbero guardare alle nuove tecnologie di rilievo e alle<br />

necessità emergenti del 3D per le città nell’ambito del BIM.<br />

Le ultime regole tecniche sono state emanate più di 15 anni fa ed erano relative agli ambiti<br />

di competenza regionale, oggi abbiamo bisogno di entrare nel dettaglio delle città, degli<br />

agglomerati urbani, per renderli intelligenti conoscendone più informazioni che dati, sì, ma<br />

aggiornando il dato di base.<br />

Buona lettura,<br />

Renzo Carlucci

FOCUS<br />

In questo<br />

numero...<br />

FOCUS<br />

REPORT<br />

INTERVISTA<br />

LE RUBRICHE<br />

Mappatura Amianto<br />

con tecniche GIS e di<br />

Intelligenza Artificiale<br />

di Enrico Bonansea, Luca<br />

Forestello, Ivan Cerato, Manuela<br />

Livorno, Gabriele Nicolò,<br />

Fulvio Raviola, Isabella Tinetti,<br />

Teo Ferrero, Roberto Cassulo,<br />

Marcella Alibrando, Massimiliano<br />

Carrino, Stefano Masera,<br />

Maria Cristina Prola<br />

6<br />

44 MERCATO<br />

46 TERRA E SPAZIO<br />

50 AGENDA<br />

14<br />

Interviste ad alcuni<br />

responsabili di IDT<br />

regionali: presente<br />

e prospettive<br />

a cura di Franco Vico<br />

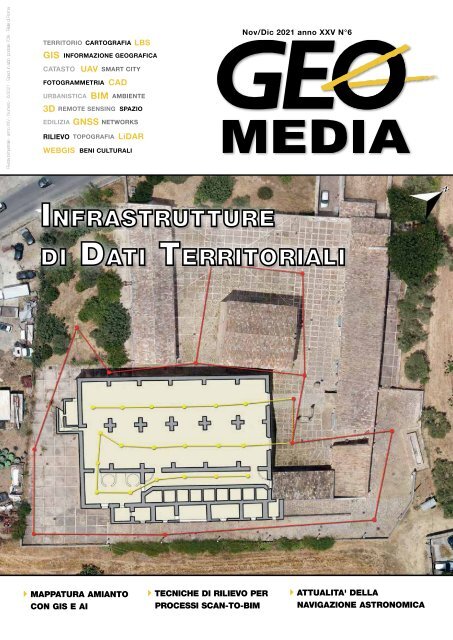

In copertina gli schemi<br />

topografici realizzati per il<br />

modello parametrico HBIM della<br />

“Real Cantina Borbonica” di<br />

Partinico in provincia di Palermo.<br />

Il rilievo laser scanner è stato<br />

eseguito con uno strumento<br />

Topcon GLS-2000; sfruttando<br />

l'approccio topografico per la<br />

registrazione delle scansioni<br />

disponibile con questo<br />

strumento, il rilievo laser scanner<br />

è stato eseguito in modo tale<br />

che tutti i punti di scansione<br />

fossero collegati per formare una<br />

poligonale topografica interna<br />

all’edificio.<br />

La linea sacra<br />

di San Michele e la<br />

sfericità terrestre<br />

di Fabio Crosilla<br />

24<br />

geomediaonline.it<br />

4 <strong>GEOmedia</strong> n°6-<strong>2021</strong><br />

<strong>GEOmedia</strong>, bimestrale, è la prima rivista italiana di geomatica.<br />

Da più di 20 anni pubblica argomenti collegati alle tecnologie dei<br />

processi di acquisizione, analisi e interpretazione dei dati,<br />

in particolare strumentali, relativi alla superficie terrestre.<br />

In questo settore <strong>GEOmedia</strong> affronta temi culturali e tecnologici<br />

per l’operatività degli addetti ai settori dei sistemi informativi<br />

geografici e del catasto, della fotogrammetria e cartografia,<br />

della geodesia e topografia, del telerilevamento aereo e<br />

spaziale, con un approccio tecnico-scientifico e divulgativo.

INSERZIONISTI<br />

Codevintec 29<br />

30<br />

Topografia<br />

Applicata al<br />

Soccorso: la<br />

formazione del<br />

Vigile del Fuoco<br />

di Daniele Mercuri<br />

Datronix 2<br />

Epsilon 45<br />

ESRI 49<br />

Geomax 44<br />

GIS3W 38<br />

Gter 32<br />

ISPRS 33<br />

NAIS 13<br />

Planetek Italia 39<br />

Stonex 51<br />

StrumentiTopografici 52<br />

Topo4qgis-un plugin<br />

per QGIS utile<br />

all'elaborazione di<br />

libretti PreGeo e alla<br />

trattazione di liste di<br />

punti mediante opportuna<br />

rototraslazione<br />

ai minimi quadrati<br />

di Marco Lombardi,<br />

Gianluca Beccaria<br />

34<br />

40<br />

Tecniche di rilievo<br />

integrato per processi<br />

Scan-to-BIM<br />

Teorema 50<br />

ESA - Ghiacciaio Kangerlussuaq<br />

(16 gennaio 2022)<br />

Il ghiacciaio Kangerlussuaq,<br />

uno dei più vasti ghiacciai<br />

di sbocco di marea della<br />

Groenlandia, è mostrato in<br />

questa immagine in falsi colori<br />

acquisita dalla missione<br />

Copernicus Sentinel-1. Kangerlussuaq<br />

si traduce ‘grande<br />

fiordo’ nella lingua groenlandese<br />

ed il suo ghiacciaio<br />

fluisce dentro la parte alta del<br />

Fiordo di Kangerlussuaq, il<br />

secondo fiordo della Groenlandia<br />

orientale in termini di<br />

dimensioni.<br />

Ciascun satellite Sentinel-1<br />

trasporta una strumentazione<br />

radar avanzata, che fornisce<br />

immagini della superficie terrestre<br />

in condizioni di luce sia<br />

diurna che notturna. Il Telerilevamento<br />

consente di monitorare<br />

la calotta di ghiaccio<br />

terrestre e di tenere traccia di<br />

tutti gli stadi di modificazione<br />

- dal rilevamento di crepe<br />

alla rottura di iceberg – come<br />

pure di effettuare la misura<br />

della copertura di ghiaccio e<br />

della deriva degli iceberg.<br />

Crediti:<br />

ESA - Image of the week.<br />

di Mauro Lo Brutto<br />

Traduzione: Gianluca Pititto<br />

una pubblicazione<br />

Science & Technology Communication<br />

<strong>GEOmedia</strong>, la prima rivista italiana di geomatica.<br />

ISSN 1128-8132<br />

Reg. Trib. di Roma N° 243/2003 del 14.05.03<br />

Direttore<br />

RENZO CARLUCCI, direttore@rivistageomedia.it<br />

Comitato editoriale<br />

Vyron Antoniou, Fabrizio Bernardini, Mario Caporale,<br />

Roberto Capua, Luigi Colombo, Mattia Crespi, Luigi Di<br />

Prinzio, Michele Dussi, Michele Fasolo, Marco Lisi, Flavio<br />

Lupia, Luigi Mundula, Beniamino Murgante, Aldo Riggio,<br />

Mauro Salvemini, Attilio Selvini, Donato Tufillaro<br />

Direttore Responsabile<br />

FULVIO BERNARDINI, fbernardini@rivistageomedia.it<br />

Redazione<br />

VALERIO CARLUCCI, GIANLUCA PITITTO,<br />

redazione@rivistageomedia.it<br />

Diffusione e Amministrazione<br />

TATIANA IASILLO, diffusione@rivistageomedia.it<br />

Progetto grafico e impaginazione<br />

DANIELE CARLUCCI, dcarlucci@rivistageomedia.it<br />

Editore<br />

MediaGEO soc. coop.<br />

Via Palestro, 95 00185 Roma<br />

Tel. 06.64871209 - Fax. 06.62209510<br />

info@rivistageomedia.it<br />

Stampa: System Graphics Srl<br />

Via di Torre Santa Anastasia 61 00134 Roma<br />

Condizioni di abbonamento<br />

La quota annuale di abbonamento alla rivista Science è di € & 45,00. Technology Communication<br />

Il prezzo di ciascun fascicolo compreso nell’abbonamento è di € 9,00. Il prezzo di<br />

ciascun fascicolo arretrato è di € 12,00. I prezzi indicati si intendono Iva inclusa.<br />

L’editore, al fine di garantire la continuità del servizio, in mancanza di esplicita<br />

revoca, da comunicarsi in forma scritta entro il trimestre seguente alla scadenza<br />

dell’abbonamento, si riserva di inviare il periodico anche per il periodo successivo.<br />

La disdetta non è comunque valida se l’abbonato non è in regola con i pagamenti.<br />

Il rifiuto o la restituzione dei fascicoli della Rivista non costituiscono disdetta<br />

dell’abbonamento a nessun effetto. I fascicoli non pervenuti possono essere<br />

richiesti dall’abbonato non oltre 20 giorni dopo la ricezione del numero successivo.<br />

Gli articoli firmati impegnano solo la responsabilità dell’autore. È vietata la<br />

riproduzione anche parziale del contenuto di questo numero della Rivista in<br />

qualsiasi forma e con qualsiasi procedimento elettronico o meccanico, ivi inclusi i<br />

sistemi di archiviazione e prelievo dati, senza il consenso scritto dell’editore.<br />

Rivista fondata da Domenico Santarsiero.<br />

Numero chiuso in redazione il 24 gennaio <strong>2021</strong>.

FOCUS<br />

MAIA: Mappatura Amianto con<br />

tecniche GIS e di Intelligenza Artificiale<br />

di Enrico Bonansea, Luca Forestello, Ivan Cerato, Manuela Livorno, Gabriele Nicolò, Fulvio Raviola, Isabella Tinetti,<br />

Teo Ferrero, Roberto Cassulo, Marcella Alibrando, Massimiliano Carrino, Stefano Masera, Maria Cristina Prola<br />

Arpa Piemonte ha avviato nel 2019<br />

un’attività sperimentale finalizzata allo<br />

studio e messa a punto di tecniche<br />

di analisi di immagini basate su deep<br />

learning e reti neurali. Nel 2020 il<br />

progetto ha portato alla realizzazione<br />

ed applicazione del modello<br />

denominato MAIA (Mappatura Amianto<br />

Fig. 1 - Nella figura si vedono due coperture in cemento amianto sulle quali è stata segnalata<br />

la presenza di MCA (evidenziata dalla stellina). Il riquadro rosso rappresenta la porzione<br />

di territorio corrispondente ad un quadrato di 10m x 10m attorno al punto riportato nella<br />

segnalazione (Immagini Ortofoto AGEA 2015).<br />

con tecniche GIS e di Intelligenza<br />

Artificiale) sull’intero territorio<br />

regionale.<br />

L’<br />

amianto rappresenta una<br />

problematica ambientale<br />

e sanitaria di particolare<br />

rilievo in diverse aree del territorio<br />

nazionale.<br />

Con l’emanazione della legge n.<br />

257/1992 che vieta l’estrazione,<br />

la produzione e la commercializzazione<br />

dell’amianto ed<br />

il successivo DM 101/2003 è<br />

iniziata un’importante opera di<br />

monitoraggio e tutela ambientale<br />

attraverso l’avvio del processo<br />

di mappatura della presenza di<br />

amianto sul territorio e la bonifica<br />

dei siti più rilevanti.<br />

La Regione Piemonte si è dotata,<br />

dal 2008, di una specifica<br />

legge per affrontare le problematiche<br />

relative all’amianto<br />

(L.R. n. 30/2008 “Norme per la<br />

tutela della salute, il risanamento<br />

dell’ambiente, la bonifica e<br />

lo smaltimento dell’amianto”).<br />

Da tale legge discende il Piano<br />

Regionale Amianto [1] con cui<br />

la Regione ha posto le basi per la<br />

mappatura dell’amianto di origine<br />

antropica su tutto il territorio<br />

regionale.<br />

Arpa Piemonte ha avviato già<br />

a partire dal 2013 la prima fase<br />

del progetto di mappatura delle<br />

coperture contenenti cementoamianto<br />

(in seguito abbreviato<br />

MCA). La procedura, basata<br />

sull’analisi e classificazione automatica<br />

di tipo object oriented<br />

di ortoimmagini, ha riguardato<br />

un’area di indagine (definita<br />

“area prioritaria”) di circa<br />

10.000 kmq e ha portato all’individuazione<br />

di circa 120.000<br />

coperture georeferenziate di edifici<br />

potenzialmente contenenti<br />

cemento amianto.<br />

Nel 2019 è stata avviata un’attività<br />

sperimentale finalizzata allo<br />

studio e messa a punto di nuove<br />

tecniche di analisi di immagine<br />

basate su deep learning con reti<br />

neurali per il riconoscimento e<br />

la classificazione delle coperture<br />

in cemento amianto.<br />

Nel 2020 l’attività di definizione<br />

metodologica è stata affinata e<br />

completata portando alla realizzazione<br />

ed applicazione del<br />

modello denominato MAIA<br />

(Mappatura Amianto con<br />

tecniche GIS e di Intelligenza<br />

Artificiale) sull’intero territorio<br />

regionale al fine di realizzare<br />

la mappatura a scala regionale,<br />

estendendo lo studio a tutti i<br />

territori non inclusi nella prima<br />

area di studio prioritaria (circa<br />

15.000 kmq), e monitorare nel<br />

tempo le trasformazioni delle coperture<br />

in amianto già oggetto di<br />

verifica con sopralluogo all’interno<br />

dell’area prioritaria.<br />

Metodi<br />

Le reti neurali utilizzano algoritmi<br />

ispirati alla struttura e al<br />

funzionamento delle reti neurali<br />

biologiche. Come queste, la rete<br />

neurale artificiale, è quindi un<br />

“sistema complesso” in grado<br />

di acquisire capacità di analisi<br />

attraverso una fase di addestramento<br />

basata su dati di input<br />

iniziali (training set) e quindi di<br />

analizzare, e classificare, tipologie<br />

di oggetti predefiniti senza<br />

la necessità di imporre modelli<br />

6 <strong>GEOmedia</strong> n°6-<strong>2021</strong>

FOCUS<br />

Fig. 2 - I riquadri verdi identificano una porzione di territorio senza CMA di 10m x 10m (Immagini Ortofoto AGEA 2015).<br />

unità volumetriche del database<br />

topografico della cartografia tecnica<br />

regionale (BDTRE, edizione<br />

2020) [3].<br />

L’intero progetto è stato sviluppato<br />

e gestito attraverso le sole<br />

risorse di calcolo del Sistema<br />

Informativo Geografico di Arpa<br />

Piemonte. La gestione complessiva<br />

dei processi di elaborazione,<br />

analisi immagini, fotointerpretazione<br />

e gestione dei servizi di<br />

editing dei dati geografici, è stata<br />

realizzata attraverso le componenti<br />

dell’infrastruttura geografica<br />

agenziale basata su piattamatematici<br />

ed equazioni predeterminate.<br />

Nel campo dell’analisi delle<br />

immagini le reti neurali possono<br />

infatti essere efficacemente<br />

addestrate per individuare o<br />

classificare oggetti specifici, ad<br />

esempio, attraverso l’analisi delle<br />

sole caratteristiche geometriche,<br />

cromatiche, tessiturali etc.<br />

Il progetto di Arpa Piemonte si è<br />

posto l’obiettivo di definire una<br />

metodologia di analisi integrata<br />

con strumenti di remote sensing,<br />

GIS ed Intelligenza artificiale<br />

per l’analisi e classificazione<br />

automatica di immagini aeree<br />

disponibili su scala regionale. La<br />

metodologia MAIA ha portato<br />

allo sviluppo di un modello di<br />

rete neurale in grado apprendere,<br />

riconoscere e classificare coperture<br />

con potenziale presenza<br />

di amianto, attraverso l’analisi<br />

multitemporale di più serie di<br />

ortoimmagini.<br />

La procedura si basa su una<br />

fase preliminare che prevede la<br />

preparazione dei dati (raccolta,<br />

elaborazione e strutturazione di<br />

tutti i dati di input necessari),<br />

la progettazione e l’allestimento<br />

dell’infrastruttura, lo sviluppo degli<br />

strumenti e dei modelli di calcolo<br />

con reti neurali e una fase di<br />

applicazione del modello su scala<br />

regionale suddivisa in più stadi:<br />

• Addestramento: fasi di<br />

ricerca dei campioni (training<br />

set), addestramento<br />

della rete neurale, valutazione<br />

e ottimizzazione delle<br />

prestazioni.<br />

• Classificazione: preparazione<br />

dei dati di input e applicazione<br />

della rete neurale<br />

sull’intera area di studio.<br />

• Verifica dei dati: integrazione<br />

ed elaborazione dei<br />

risultati in ambiente GIS,<br />

verifica e correzione tramite<br />

fotointerpretazione<br />

• Analisi dei risultati: analisi<br />

statistica dei dati, valutazione<br />

delle performance<br />

Dati di input e strumenti<br />

Per l’addestramento del modello<br />

su base multitemporale sono<br />

state utilizzate tutte le ortoimmagini<br />

disponibili su scala regionale<br />

nel periodo di riferimento ed<br />

in particolare le riprese del volo<br />

regionale ICE del 2010 [2], le<br />

riprese AGEA 2015, 2018 e le<br />

più recenti immagini disponibili<br />

sul territorio regionale del servizio<br />

Google Maps (date variabili<br />

2018-2020, "Map data ©<br />

2018,2019,2020 Google").<br />

L’obiettivo di tale approccio è<br />

duplice: seguire e monitorare nel<br />

tempo le trasformazioni delle coperture,<br />

ricostruendo così su tutto<br />

il territorio regionale lo stesso<br />

quadro di conoscenza e riferimento<br />

temporale, e minimizzare<br />

i potenziali errori di classificazione<br />

introdotti dalla variabilità delle<br />

singole immagini appartenenti<br />

alla stessa ripresa fotogrammetrica<br />

(ombre, coperture arboree,<br />

problemi di ortorettifica, etc ...).<br />

Il livello di riferimento adottato<br />

per l’individuazione vettoriale<br />

delle impronte degli edifici su<br />

scala regionale è il dataset delle<br />

Fig. 3 – Grafici relativi al monitoraggio risultati nella<br />

fase di addestramento della rete neurale (in alto si vede<br />

l’accuratezza di uno dei modelli utilizzati superiore al<br />

95% e in basso la valutazione degli errori compiuti dal<br />

modello vicino allo 0%).<br />

<strong>GEOmedia</strong> n°6-<strong>2021</strong> 7

FOCUS<br />

Fig. 4 - Esempio di evoluzione delle coperture nel tempo e casi di potenziale bonifica intercorsi tra<br />

2010 e 2015.<br />

forma Esri (ArcGISPro, ArcGIS<br />

Enterprise, ArcGIS Online).<br />

Per l’estrazione delle porzioni<br />

di immagini utilizzate in fase di<br />

training e classificazione è stato<br />

utilizzato anche il software Qgis<br />

ed in particolare la funzione del<br />

layout di stampa denominata<br />

Atlante.<br />

La rete neurale è stata invece<br />

implementata con Keras[4],<br />

un framework per Python che<br />

permette di definire e addestrare<br />

vari tipi di modelli di deep learning.<br />

Keras consente di eseguire lo<br />

stesso codice utilizzando diverse<br />

librerie di basso livello<br />

(Tensorflow, Theano, CNTK,<br />

…). Nel presente progetto sperimentale<br />

Arpa ha adottato la<br />

libreria Tensorflow utilizzando il<br />

modello denominato VGG16,<br />

appartenente alla categoria delle<br />

Convolutional Neural Network<br />

[5] specializzate nella classificazione<br />

delle immagini.<br />

Applicazione modello MAIA<br />

a scala regionale<br />

Addestramento<br />

L’addestramento è la fase in cui<br />

la rete neurale impara a svolgere<br />

il compito per cui è stata progettata,<br />

a partire dall’analisi dei<br />

campioni di training set.<br />

Occorre quindi definire e predisporre<br />

i training set attraverso la<br />

selezione di un numero significativo<br />

di campioni di immagini sia<br />

di coperture contenenti amianto,<br />

sia realizzate con altri materiali<br />

(tegole, coppi, lamiere, etc.).<br />

Grazie al lavoro di mappatura e<br />

verifica in campo già realizzato<br />

negli anni precedenti è stato<br />

possibile selezionare dalla banca<br />

dati un numero consistente di<br />

coperture in amianto accertate<br />

ed estrarre da questi i relativi<br />

campioni di immagini a partire<br />

dalle singole serie di ortofoto di<br />

riferimento.<br />

La preparazione dei campioni<br />

di immagini del training set<br />

prevedere l’estrazione di una immagine<br />

quadrata (chips) di 10m<br />

x 10m (Fig. 1) per ciascun punto<br />

centroide rispetto alla copertura<br />

dell’edificio.<br />

Per la preparazione dei training<br />

set relativi a coperture non<br />

contenenti amianto sono stati<br />

identificati campioni rappresentativi<br />

di tetti realizzati con i più<br />

svariati materiali (tetti in tegole,<br />

lamiere, materiali verniciati, rivestimenti<br />

bituminati, pannelli<br />

solari, etc.) e di immagini di<br />

porzioni di terreno libero: prati,<br />

strade, campi coltivati, campi<br />

sportivi, etc… (Fig. 2).<br />

Nel corso del progetto è emersa<br />

inoltre la necessità di fornire ulteriori<br />

campioni di training utili<br />

alla differenziazione di particolari<br />

coperture tipiche di molte aree<br />

collinari e montane realizzate<br />

con materiali litoidi. Tali coperture,<br />

infatti, possono risultare a<br />

livello di ortoimmagini di medio<br />

dettaglio, molto simili alle coperture<br />

in amianto, introducendo<br />

errori nelle fasi di training e<br />

classificazione.<br />

Complessivamente sono stati<br />

creati tre training set (coperture<br />

in MCA, coperture senza MCA,<br />

coperture in materiali litoidi) per<br />

ciascuna serie temporale delle<br />

ortoimmagini di riferimento,<br />

ciascuno contenente oltre 1000<br />

campioni.<br />

In fase di addestramento si vanno<br />

a tarare progressivamente i<br />

diversi parametri in modo da ottimizzare<br />

la risposta della rete.<br />

Tale attività comporta più cicli<br />

di analisi e di valutazione del<br />

livello di accuratezza dei risultati<br />

ottenuti attraverso il confronto<br />

tra immagini di training e immagini<br />

di test.<br />

L’addestramento ottimale di una<br />

rete prevede l’utilizzo di enormi<br />

quantità di dati e ingenti capacità<br />

di elaborazione. Per ridurre<br />

almeno in parte queste necessità<br />

è stata utilizzata la tecnica denominata<br />

fine tuning [6] [7], che<br />

consiste nell’utilizzare i pesi (cioè<br />

i parametri utilizzati dalle reti per<br />

effettuare le elaborazioni) di un<br />

modello già addestrato a riconoscere<br />

diverse tipologie di oggetti<br />

(Fig. 3). Le reti neurali procedono<br />

su livelli di elaborazione in<br />

sequenza: nel modello sono stati<br />

modificati i 4 livelli finali per<br />

adattarli alle esigenze progettuali<br />

e addestrando quest’ultimi a riconoscere<br />

solo due tipologie di<br />

classi principali (tetti con MCA<br />

e tetti senza MCA).<br />

Al fine di ottimizzare la classificazione<br />

di immagini tramite rete<br />

neurale e per evitare il fenomeno<br />

di over fitting (cioè il problema<br />

che si può verificare quando la<br />

rete impara a riconoscere solo<br />

le immagini su cui è stata addestrata<br />

a causa, ad esempio, di<br />

uno scarso numero di campioni<br />

8 <strong>GEOmedia</strong> n°6-<strong>2021</strong>

FOCUS<br />

Fig. 5 - Esempio dell’applicazione WebGIS per l’editing multitemporale (dall’alto in basso le 4 schermate con ortofoto 2010-2015-<br />

2018 e 2020 "Map data © 2020 Google")<br />

forniti) sono state adottate due<br />

tecniche: data augmentation<br />

(prevede la modifica delle immagini<br />

durante l’addestramento<br />

con algoritmi specifici al fine di<br />

aumentare in modo considerevole<br />

il numero di immagini a<br />

disposizione) e dropout (consiste<br />

nell’ignorare in modo casuale<br />

alcune fasi del modello durante<br />

l’addestramento).<br />

Classificazione<br />

Terminato l’addestramento è stata<br />

avviata la classificazione automatica<br />

di tutti gli edifici presenti<br />

sul territorio regionale attraverso<br />

due procedure distinte.<br />

La prima, prevede l’applicazione<br />

della metodologia su Resto<br />

Regione, quindi, l’estensione<br />

della mappatura su tutto il territorio<br />

regionale esterno all’area<br />

prioritaria (oltre 15.000 kmq);<br />

ha comportato un complesso<br />

processo computazionale suddiviso<br />

su più catene di calcolo<br />

in grado di elaborare milioni<br />

di immagini riferite ai singoli<br />

edifici (otre 1.300.000 unità)<br />

per ciascun anno di riferimento<br />

temporale.<br />

La seconda, consiste nell’applicazione<br />

sull’Area Prioritaria cioè<br />

l’applicazione del modello per<br />

il monitoraggio delle trasformazioni<br />

relative a tutte le coperture<br />

in amianto già verificate in<br />

campo con sopralluogo da parte<br />

dei Dipartimenti nel periodo<br />

2013-2020, per un totale di oltre<br />

41.000 punti.<br />

Il processo generale di classificazione<br />

ha restituito per ciascun<br />

edificio analizzato e per ciascun<br />

anno di riferimento, un indice<br />

numerico (variabile tra 0 ed 1)<br />

rappresentativo della probabilità<br />

di appartenenza alla classe delle<br />

coperture con presenza amianto.<br />

Terminata la fase di calcolo, i risultati<br />

prodotti dalla rete neurale<br />

sono stati rielaborati in ambiente<br />

GIS e quindi analizzati al fine<br />

di definire valori soglia e range<br />

di attendibilità differenti per<br />

ciascuno anno di riferimento, in<br />

base alle differenti caratteristiche<br />

spaziali, spettrali e tessiturali delle<br />

diverse serie di ortoimmagini<br />

utilizzate.<br />

Definiti i valori soglia, i risultati<br />

sono stati rielaborati associando<br />

ad ogni edificio e per ciascun<br />

anno di riferimento, la classificazione<br />

finale:<br />

• copertura con potenziale<br />

presenza di amianto<br />

• copertura senza amianto.<br />

Dal confronto multitemporale<br />

dei dataset sono inoltre stati<br />

indentificati range di valori e<br />

combinazioni degli stessi utili a<br />

identificare possibili trasformazioni<br />

delle coperture nel tempo.<br />

Ciò ha consentito di introdurre<br />

una nuova classe riferita alle potenziali<br />

bonifiche intercorse nel<br />

periodo di riferimento.<br />

Ad esempio, nel caso di una copertura<br />

positiva nel 2010 (valori<br />

indice alti e quindi classificata<br />

come “copertura con potenziale<br />

presenza di amianto”), ma negativa<br />

nel 2015, 2018 e 2020<br />

(indice basso e quindi classificata<br />

in quegli anni come “copertura<br />

senza amianto”), la metodologia<br />

prevede la segnalazione e riclassificazione<br />

della copertura come<br />

“potenziale bonifica” (Fig. 4).<br />

In questo modo è possibile<br />

ricomporre un quadro cronologico<br />

coerente su scala regionale<br />

<strong>GEOmedia</strong> n°6-<strong>2021</strong> 9

FOCUS<br />

in grado di mettere a confronto<br />

i dati della prima fase della mappatura<br />

regionale in area prioritaria<br />

con quelli della nuova mappatura<br />

sul resto della Regione<br />

nel decennio 2010-2020.<br />

Inoltre, si possono identificare<br />

non solo le coperture ad oggi<br />

contenenti cemento-amianto,<br />

ma anche quelle che negli ultimi<br />

dieci anni hanno dato evidenza<br />

di potenziale presenza di MCA e<br />

su cui sono state effettuate operazioni<br />

di bonifica e quindi avere<br />

un quadro complessivo delle<br />

attività di riduzione dell’amianto<br />

in Piemonte.<br />

Infine, la procedura consente<br />

di disporre di dati storici su<br />

presenza di potenziali bonifiche<br />

rilevanti, per volumi coinvolti o<br />

situazioni di particolare vulnerabilità<br />

territoriale, su cui eventualmente<br />

effettuare indagini<br />

circa modalità e tempistiche dei<br />

lavori di bonifica.<br />

Verifica dati e collaudo<br />

A partire dai risultati della fase<br />

di classificazione è stata avviata<br />

l’attività di validazione dei<br />

risultati tramite verifica con<br />

fotointerpretazione. Le attività<br />

di correzione e integrazione sono<br />

state realizzate attraverso editing<br />

geografico sul 100% dei risultati<br />

da modello (circa 86.000 punti).<br />

L’attività ha permesso così di migliorare<br />

e consolidare la classificazione<br />

finale degli edifici ed eliminare<br />

dai risultati un numero<br />

significativo di casi catalogabili<br />

come “falsi positivi”. Tali casi,<br />

Tab. 1<br />

PERCENTUALI<br />

VERITÀ<br />

CAMPIONE<br />

STATISTICO<br />

Verità<br />

Amianto<br />

Verità<br />

bonificati<br />

Verità Falso<br />

Positivo<br />

Previsti<br />

come già evidenziato durante la<br />

fase di messa a punto metodologica,<br />

sono riconducibili in gran<br />

parte a problemi locali di consistenza<br />

e georeferenziazione degli<br />

edifici cartografati in BDTRE o<br />

dall’impossibilità di disporre di<br />

un corretto allineamento degli<br />

stessi rispetto alle varie serie di<br />

ortoimmagini utilizzate dalla<br />

metodologia.<br />

Tenuto conto della dimensione<br />

dei dati su cui effettuare la verifica<br />

e della necessità di accedere<br />

a strumenti a supporto della<br />

fotointerpretazione e dell’editing<br />

multitemporale anche da remoto,<br />

è risultato indispensabile progettare<br />

una piattaforma idonea<br />

basata su servizi ed applicazioni<br />

web oriented fruibili anche da<br />

postazioni di lavoro “leggere”.<br />

È stata pertanto sviluppata una<br />

applicazione web basata su API<br />

JS per ArcGIS che consente l’editing<br />

geografico e alfanumerico<br />

attraverso 4 finestre contemporanee<br />

e sincronizzate, ciascuna<br />

riportante i feature services e le<br />

ortofoto dei relativi anni di riferimento<br />

(Fig. 5).<br />

Per garantire il monitoraggio<br />

dell’avanzamento lavori e definire<br />

modifiche alla pianificazione<br />

effettuata è stata sviluppata<br />

un’apposita dashboard di analisi<br />

in tempo reale, in grado di fornire<br />

lo stato di lavorazione delle attività<br />

di verifica totali per singolo<br />

fotointerprete e i dati inerenti<br />

alla quantità e tipo di correzioni<br />

effettuate sul dataset originario<br />

(Fig. 6).<br />

ESITO MODELLO MAIA<br />

Previsti<br />

Falso<br />

Amianto Bonificati Positivo<br />

95,9 2,6 1,5 100.0<br />

11,8 88,2 0,0 100,0<br />

12,5 0,8 86,7 100,0<br />

Analisi statistica e documentazione<br />

dei risultati<br />

La fase finale della metodologia<br />

prevede la verifica e il collaudo<br />

statistico dei dati al fine di valutare<br />

quantitativamente l’accuratezza<br />

e l’attendibilità dei risultati<br />

ottenuti dalla metodologia.<br />

A tal fine dal dataset inziale dei<br />

risultati dell’Area di indagine<br />

(resto regione) è stato pertanto<br />

estratto un campione statistico<br />

casuale di 384 punti corrispondente<br />

ad un livello di confidenza<br />

del 95% con un intervallo di<br />

confidenza del 5%[8].<br />

Su questo campione è stata<br />

quindi avviata l’attività di collaudo<br />

tramite verifica puntuale<br />

dei risultati attraverso una nuova<br />

fase di fotointerpretazione. Per<br />

ciascun punto è stato quindi registrato<br />

l’esito del collaudo.<br />

Gli esiti sono stati quindi rielaborati<br />

per calcolare le percentuali<br />

di accuratezza su ciascuna<br />

classe (Tab. 1).<br />

L’analisi di tipo statistico fornisce<br />

chiaramente una prima<br />

valutazione dell’accuratezza del<br />

lavoro effettuato nell’applicare<br />

la metodologia in tutte le sue<br />

fasi: la verifica stessa dei risultati<br />

è basta su fotointerpretazione e<br />

quindi anche gli errori riscontrati<br />

sono di fatto interpretati attraverso<br />

la sola lettura del territorio<br />

da immagini telerilevate a media<br />

risoluzione.<br />

Analizzando i risultati inerenti la<br />

classe dei punti con potenziale<br />

presenza di amianto la percentuale<br />

di accuratezza è risultata<br />

del 95,9%.<br />

Nel 2,6% dei casi in cui il modello<br />

ha fornito indicazioni di<br />

potenziale bonifica la verifica ha<br />

indicato presenza di amianto:<br />

tali casi seppur percentualmente<br />

minimi non incidono sul risultato<br />

atteso finale, individuando<br />

comunque coperture su cui si<br />

intende indirizzare l’attività di<br />

verifica con sopralluogo. Solo<br />

l’1.5% dei casi riguarda invece<br />

10 <strong>GEOmedia</strong> n°6-<strong>2021</strong>

FOCUS<br />

situazioni in cui in cui il modello<br />

non ha individuato coperture<br />

con amianto rispetto alla realtà<br />

riscontrata con il controllo finale.<br />

Per quanto concerne la classe<br />

delle potenziali bonifiche la<br />

percentuale di accuratezza netta<br />

risulta pari all’88,2%. Tale valore<br />

apparentemente inferiore<br />

ai valori di accuratezza registrati<br />

sulle coperture in amianto, va<br />

però analizzato congiuntamente<br />

alle altre percentuali riportate in<br />

tabella: l’11,8 % dei punti non<br />

classificati come bonifica rientrano<br />

infatti nella classe delle coperture<br />

con amianto, mentre la<br />

percentuale di erronea classificazione<br />

(copertura non in amianto<br />

o falso positivo) è pari allo 0%.<br />

Ciò significa che la totalità dei<br />

casi (100%) indica comunque la<br />

presenza di amianto ad una certa<br />

data, fornendo quindi una corretta<br />

indicazione per lo svolgimento<br />

delle attività di sopralluogo<br />

e verifica in campo da parte<br />

dei Dipartimenti Territoriali.<br />

Risultati<br />

L’applicazione della metodologia<br />

MAIA per l’estensione e il<br />

completamento della mappatura<br />

sulla scala regionale ha permesso<br />

di individuare circa 33.000 nuovi<br />

edifici di cui circa 27.000 con<br />

attuale presenza di MCA.<br />

Attraverso l’analisi multitemporale<br />

la metodologia ha consentito<br />

di identificare inoltre<br />

circa 6200 casi di coperture che<br />

hanno subito nell’arco temporale<br />

considerato (2010-2020), delle<br />

trasformazioni legate a potenziali<br />

processi di bonifica.<br />

Sono state riscontrate molte<br />

situazioni, anche con caratteristiche<br />

dimensionali rilevanti<br />

(coperture industriali di migliaia<br />

di mq), che allo stato attuale<br />

sarebbero difficilmente rilevabili<br />

con le sole attività di verifica in<br />

campo in quanto ormai totalmente<br />

rinnovate e senza traccia<br />

delle situazioni pregresse.<br />

Fig. 6 - Esempio di dashboard per il monitoraggio in tempo reale delle attività di verifica dei risultati.<br />

Ciò consente da una parte di<br />

avere elementi di conoscenza<br />

utili a valutare i procedimenti di<br />

bonifica attuati, dall’altra di ricostruire<br />

e aggiornare nel tempo<br />

un quadro di riferimento dello<br />

stato del territorio e delle sue<br />

evoluzioni.<br />

L’applicazione della metodologia<br />

all’interno dell’area prioritaria<br />

già oggetto della prima mappatura<br />

si è posta invece l’obiettivo<br />

di individuare potenziali cambiamenti<br />

intercorsi sulle coperture<br />

in amianto già verificate da parte<br />

di Arpa negli anni passati.<br />

Tale ipotesi progettuale nasce dal<br />

fatto che tali coperture possono<br />

aver subito, in data successiva al<br />

controllo in campo, trasformazioni<br />

e bonifiche non segnalate o<br />

non ancora verificate.<br />

Attraverso l’applicazione del modello<br />

MAIA su ortofoto di anni<br />

diversi è stato possibile analizzare<br />

e confrontare l’evoluzione nel<br />

tempo degli indici di probabilità<br />

di presenza di amianto sulla<br />

stessa copertura ed individuare<br />

così i casi potenziali di bonifica o<br />

rimozione dell’edificio.<br />

In questo modo sono stati identificati<br />

circa 4.900 casi di nuove<br />

potenziali bonifiche ed è stata<br />

confermata la presenza di MCA<br />

su oltre 36.400 coperture. I successivi<br />

sopralluoghi e controlli<br />

in campo da parte dei tecnici<br />

dell’Agenzia potranno confermare<br />

o meno il processo di bonifica<br />

dell’amianto e aggiornare il<br />

quadro di conoscenza sullo stato<br />

della presenza dell’amianto su<br />

base regionale.<br />

A termine dei lavori, tutti i risultati<br />

sono stati quindi elaborati<br />

ed integrati nel geodatabase del<br />

Sistema Informativo Mappatura<br />

Amianto [9] e messi a disposizione<br />

dei dipartimenti territoriali<br />

per l’avvio delle nuove fasi di<br />

sopralluogo, verifica e analisi.<br />

Conclusioni<br />

L’esperienza maturata in<br />

Piemonte negli anni ha dimostrato<br />

le potenzialità e l’efficacia<br />

del telerilevamento e delle<br />

tecnologie di analisi GIS, quali<br />

strumenti fondamentali per l’analisi<br />

speditiva su vasta scala e in<br />

particolare per i processi di mappatura<br />

a scala regionale, come<br />

richiesto dalla normativa vigente.<br />

Il processo di riconoscimento e<br />

classificazione delle coperture in<br />

cemento amianto, sia in loco e<br />

ancor più da telerilevamento, è<br />

tuttavia fortemente condizionato<br />

dalla complessità e dall’estrema<br />

variabilità delle differenti<br />

tipologie di prodotti e materiali<br />

impiegati in edilizia nel corso dei<br />

decenni. Per tali motivi, anche<br />

<strong>GEOmedia</strong> n°6-<strong>2021</strong> 11

FOCUS<br />

durante le attività di sopralluogo<br />

per la verifica in campo delle<br />

coperture è frequente la necessita<br />

di dover ricorrere, oltre all’analisi<br />

visiva e fisico-meccanica, a specifici<br />

campionamenti e successive<br />

analisi chimico-fisiche di laboratorio<br />

per accertare con sicurezza<br />

la presenza dei minerali asbestiformi<br />

nei materiali.<br />

Ciononostante, quanto realizzato<br />

nello sviluppo del modello<br />

MAIA, dimostra come l’utilizzo<br />

integrato del remote sensing e<br />

delle nuove tecnologie di deep<br />

learning possano aprire possibilità<br />

e scenari di analisi assolutamente<br />

sorprendenti.<br />

La capacità delle reti neurali di<br />

apprendere e analizzare in modo<br />

massivo grandi moli di dati, attraverso<br />

la sola lettura di immagini,<br />

consente di attuare processi<br />

di analisi che per dimensioni e<br />

scala non sarebbero altrimenti<br />

attuabili con metodi tradizionali.<br />

Selezionare e discriminare fra<br />

milioni di oggetti permette di<br />

aumentare la capacità predittiva<br />

e di individuare quelle tipologie<br />

di coperture su cui concentrare<br />

le verifiche, guidando in modo<br />

mirato e più efficiente le campagne<br />

di controllo in campo.<br />

Il progetto, realizzato con sole<br />

risorse interne e senza investimenti<br />

aggiuntivi, ha permesso<br />

di completare in tempi molto<br />

ridotti la mappatura sull’intero<br />

territorio regionale e di impostare<br />

un modello per il monitoraggio<br />

periodico dei processi di<br />

bonifica.<br />

In questo senso riteniamo che<br />

il lavoro effettuato e i risultati<br />

raggiunti rappresentino oltre che<br />

un modello innovativo di ricerca<br />

applicata replicabile anche in<br />

altre realtà regionali, uno strumento<br />

fondamentale per l’azione<br />

di Arpa e più in generale per il<br />

perseguimento degli obiettivi<br />

definiti dal Piano Regionale<br />

Amianto.<br />

RIFERIMENTI E SITOGRAFIA<br />

Piano regionale Amianto: https://www.regione.piemonte.it/web/temi/ambiente-territorio/ambiente/amianto-bonifiche-terre-rocce-scavo/amianto<br />

Regione Piemonte: Ripresa Aerea Ice 2009-2011 Ortofoto RGB e NIR: http://www.<br />

geoportale.piemonte.it/geocatalogorp/?sezione=catalogo<br />

http://www.geoportale.piemonte.it/geonetworkrp/srv/ita/metadata.show?uuid=r_<br />

piemon:ec27a3da-2bd8-4f7d-8905-3ac28f488943<br />

Regione Piemonte - BDTRE: https://www.geoportale.piemonte.it/cms/bdtre/bdtre-2<br />

Keras - https://keras.io/<br />

https://www.sciencedirect.com/topics/computer-science/convolutional-neural-networks<br />

https://learnopencv.com/keras-tutorial-fine-tuning-using-pre-trained-models/<br />

https://keras.io/guides/transfer_learning/<br />

https://www.quadernodiepidemiologia.it/epi/campion/dimens.htm<br />

https://webgis.arpa.piemonte.it/amianto_storymap_webapp/<br />

BIBLIOGRAFIA<br />

BONANSEA E., 2018 - “Il Progetto di mappatura dell’amianto in Piemonte” in<br />

ECOSCIENZA, Volume 1 - Anno 2018, edito da Arpa Emilia Romagna, marzo<br />

2018<br />

Radovic, M.; Adarkwa, O.; Wang, Q. “Object Recognition in Aerial Images Using<br />

Convolutional Neural Networks.” J. Imaging 2017, 3, 21. https://doi.org/10.3390/<br />

jimaging3020021<br />

Pirotti, F., Zanchetta, C., Previtali, M., and Della Torre, S.: DETECTION OF<br />

BUILDING ROOFS AND FACADES FROM AERIAL LASER SCANNING<br />

DATA USING DEEP LEARNING, Int. Arch. Photogramm. Remote Sens. Spatial<br />

Inf. Sci., XLII-2/W11, 975–980, https://doi.org/10.5194/isprs-archives-XLII-<br />

2-W11-975-2019, 2019.<br />

Partovi, Tahmineh und Fraundorfer, Friedrich und Azimi, Seyedmajid und Marmanis,<br />

Dimitrios und Reinartz, Peter (2017) Roof Type Selection based on patch-based classsification<br />

using deep learning for high Resolution Satellite Imagery. In: International<br />

Archives of the Photogrammetry, Remote Sensing and Spatial Information Sciences -<br />

ISPRS Archives, XLII-1 (W1), Seiten 653-657. Copernicus Publications. ISPRS Hannover<br />

Workshop: HRIGI 17, 06.-09. Juni 2017, Hannover, Germany. doi: 10.5194/<br />

isprs-archives-XLII-1-W1-653-2017.<br />

Francois Chollet - Deep learning with python, Novembre 2017<br />

PAROLE CHIAVE<br />

Intelligenza Artificiale; Sistemi Informativi; Ortofoto; Amianto<br />

ABSTRACT<br />

In 2013 Arpa Piemonte launched a first mapping of buildings potentially containing<br />

asbestos cement that identified over 120.000 roofs in the most densely populated<br />

areas of Regione Piemonte. The map was based on supervised image classification<br />

techniques and traditional photo interpretation.<br />

In 2020 (based on an experimental activity launched in 2019), Arpa Piemonte created<br />

and applied a model called MAIA (Mapping of Asbestos with GIS and Artificial Intelligence<br />

techniques) aimed at extending the mapping started in 2013 to the whole Piemonte<br />

area and including the monitoring of asbestos roofs transformation over time,<br />

already subjected to inspection, located in the areas analyzed in the first mapping.<br />

MAIA has identified over 26.600 new buildings on a regional scale with potential<br />

presence of asbestos and over 6.200 buildings whose roofs have undergone, potential<br />

remediation processes between 2010 and 2020. In the area already subjected to<br />

inspection, the model confirmed the presence of asbestos in over 36.400 roofs and it<br />

has identified over 4.900 cases of new potential remediation.<br />

AUTORE<br />

Enrico Bonansea, Luca Forestello*, Ivan Cerato, Manuela Livorno, Gabriele<br />

Nicolò, Fulvio Raviola, Isabella Tinetti, Teo Ferrero, Roberto Cassulo, Marcella<br />

Alibrando, Massimiliano Carrino, Stefano Masera, Maria Cristina Prola<br />

*Autore corrispondente: l.forestello@arpa.piemonte.it<br />

Arpa Piemonte - Sistema Informativo Ambientale e Geografico, Comunicazione e<br />

Educazione Ambientale<br />

12 <strong>GEOmedia</strong> n°6-<strong>2021</strong>

FOCUS<br />

<strong>GEOmedia</strong> n°6-<strong>2021</strong> 13

INTERVISTA<br />

Interviste ad alcuni responsabili<br />

di IDT regionali: presente e<br />

prospettive<br />

a cura di Franco Vico<br />

Le infrastrutture di dati geografici di livello<br />

regionale sono un tassello fondamentale nel<br />

sistema complessivo di produzione, catalogazione,<br />

distribuzione dell’informazione geografica. Questo<br />

è certamente vero in Italia, ma anche in altri paesi<br />

europei. Le regioni hanno le capacità finanziarie e<br />

tecniche necessarie, quelle capacità che spesso<br />

mancano ai livelli sotto-ordinati, ad es. ai comuni.<br />

Mentre il livello nazionale è più lontano dal territorio e<br />

ha altri ruoli.<br />

Con questo in mente, abbiamo chiesto ai responsabili<br />

di alcune IDT regionali di parlarci delle loro<br />

esperienze, presentandole nella loro realtà concreta.<br />

In questo numero sono pubblicate le interviste<br />

relative alle Regioni Basilicata, Lazio e Lombardia,<br />

mentre le interviste relative alle Regioni Veneto e<br />

Piemonte sono già state pubblicate nel numero<br />

5/<strong>2021</strong> di <strong>GEOmedia</strong> (https://www.yumpu.com/<br />

it/document/read/66063687/geomedia-5-<strong>2021</strong>).<br />

Abbiamo anche chiesto ai responsabili delle IDT,<br />

parlandoci delle loro esperienze, di confrontarsi con<br />

i “punti di convergenza” del dibattito internazionali<br />

sul futuro delle Spatial Data Infrastructure, individuati<br />

nell’articolo Oltre le SDI: quali prospettive, pubblicato<br />

sullo stesso numero 5/<strong>2021</strong> di <strong>GEOmedia</strong>. Questo<br />

ha fatto sì che le domande che abbiamo rivolto ai<br />

responsabili delle 5 IDT, siano state più o meno<br />

sempre le stesse. Anche l’ordine delle domande è<br />

più o meno sempre lo stesso. Tutto ciò dovrebbe<br />

rendere più facilmente confrontabili le interviste. E noi<br />

sappiamo che è il confronto che fa capire le cose.<br />

La Infrastruttura<br />

per l’Informazione<br />

Territoriale (IIT) della<br />

Regione Lombardia<br />

Colloquio con Fabio Conzi<br />

e Piera Belotti, Struttura<br />

SIT Integrato di Regione<br />

Lombardia<br />

<strong>GEOmedia</strong> (G):<br />

Cominciamo con un inquadramento<br />

della vostra<br />

esperienza nel suo contesto.<br />

Regione Lombardia<br />

(RL): La Lombardia<br />

con la l.r. 12/2005 per il<br />

Governo del Territorio è<br />

stata tra le prime a sviluppare<br />

l’embrione (ovvero<br />

il SIT) di quella che poi<br />

sarebbe stata istituita dalla<br />

Direttiva INSPIRE/2007<br />

quale “Infrastruttura<br />

per l’Informazione<br />

Territoriale” (IIT), che<br />

costituisce la base dati per<br />

la progettazione del Piano<br />

Territoriale Regionale,<br />

strumento di attuazione<br />

territoriale della strategia<br />

regionale di sviluppo<br />

sostenibile inserita nel<br />

programma regionale<br />

di sviluppo (PRS). Dal<br />

punto di vista organizzativo<br />

l’IIT si colloca nella<br />

Direzione competente in<br />

materia urbanistico-edilizia,<br />

ed è stata concepita<br />

per sostenere le politiche<br />

regionali di governo e<br />

sviluppo del territorio,<br />

attraverso svariati strumenti/servizi<br />

rivolti ad<br />

una pluralità di utenti,<br />

in particolare ai professionisti<br />

e agli enti locali<br />

che pianificano le scelte<br />

di sviluppo urbanistico a<br />

scala locale. Basti pensare<br />

al fatto che tutti i piani<br />

urbanistici per il governo<br />

14 <strong>GEOmedia</strong> n°6-<strong>2021</strong>

INTERVISTA<br />

del territorio e gli studi<br />

di settore vengono<br />

raccolti all’interno<br />

del medesimo Portale<br />

“Multiplan” accessibile<br />

a tutti, dai regolamenti<br />

edilizi comunali ad<br />

altri servizi che interoperano<br />

con sistemi<br />

terzi, tra cui merita<br />

citare il “Cruscotto<br />

delle Emergenze” condiviso<br />

con i soggetti<br />

preposti al soccorso/<br />

sicurezza e protezione<br />

civile. I servizi geografici<br />

realizzati dalla IIT<br />

lombarda supportano<br />

anche applicazioni<br />

verticali in uso presso<br />

altre Direzioni, quali<br />

la D.G. Welfare (applicazioni<br />

geografiche<br />

per il sistema veterinario<br />

e a supporto della<br />

prevenzione), la D.G.<br />

Formazione e Lavoro<br />

(applicativi di supporto<br />

all’offerta formativa<br />

e sistema duale alternanza<br />

scuola lavoro),<br />

la DG Infrastrutture<br />

(sistema della mobilità<br />

e dei trasporti),<br />

la DG Ambiente e<br />

Clima (es. gestione<br />

istanze di VIA), la DG<br />

Agricoltura (applicativi<br />

gestionali di ambito<br />

agro-ambientale).<br />

Tecnologicamente<br />

l’attuale IIT lombarda<br />

si fonda sulla piattaforma<br />

“Regional<br />

Enterprise platform<br />

for Geographic<br />

Information Services”<br />

(REGIS) offrendo servizi<br />

digitali geografici<br />

alla PA, ai professionisti<br />

alle imprese e<br />

ai cittadini, grazie al<br />

supporto della propria<br />

società in house ARIA<br />

Spa.<br />

Per garantire prodotti<br />

e servizi necessari, sia<br />

internamente a Regione<br />

sia agli enti collegati<br />

del territorio, la scelta<br />

è ricaduta molti anni fa<br />

sulla piattaforma ESRI<br />

che assicura un sistema<br />

scalabile, affidabile e<br />

basato su standard di<br />

mercato. Di recente si è<br />

aperto anche al mercato<br />

Open Source, ad es.<br />

predisponendo la distribuzione<br />

del Database<br />

Topografico in formato<br />

gpkg (Geopackage) che<br />

permette di superare le<br />

considerando che il<br />

concetto di utente<br />

unico assume sfumature<br />

differenti in funzione<br />

dello strumento<br />

di misura (in RL ci<br />

si avvale di Google<br />

Analytics per questo<br />

tipo di conteggio).<br />

Non essendo richiesta<br />

profilazione/registrazione<br />

per l’accesso<br />

al Geoportale, non<br />

siamo in grado di<br />

individuare con precisione<br />

le specifiche<br />

tipologie di utente,<br />

tuttavia sappiamo che<br />

‟La maggior parte<br />

dei dati della IIT è<br />

open, ad eccezione di<br />

informazioni che non<br />

sono di proprietà di<br />

Regione.<br />

limitazioni del formato<br />

shapefile, sviluppando<br />

un SW gratuito in via<br />

di sperimentazione,<br />

per predisporre gli elaborati<br />

del PGT.<br />

G: Un mantra del dibattito<br />

internazionale<br />

sulle infrastrutture di<br />

dati territoriali è “user<br />

centric”: che cosa sapete<br />

sugli utilizzatori<br />

della vostra IIT?<br />

RL: Gli utilizzatori<br />

sono circa 17.000<br />

nuovi utenti/mese,<br />

ma è più significativo<br />

l’elevato numero di<br />

accessi/mese, pari a<br />

circa 25.000/mese,<br />

‟<br />

si tratta - principalmente<br />

- di professionisti<br />

e tecnici degli<br />

Enti locali, studenti/<br />

ricercatori, imprese e<br />

grandi player di mercato.<br />

Altrettanto vale<br />

per quanto riguarda<br />

l’utilizzo dei dati: non<br />

si ha un quadro preciso,<br />

ma il feedback<br />

degli utenti che comunicano<br />

attraverso<br />

la casella mail “contattaci”<br />

consente di<br />

conoscerne la provenienza,<br />

con l’ulteriore<br />

vantaggio di migliorare<br />

il Geoportale o<br />

di rilevarne eventuali<br />

malfunzionamenti.<br />

Ad esempio, la de-<br />

cisione di predisporre<br />

“basi cartografiche<br />

semplificate” partendo<br />

dal DBT da utilizzare<br />

per la redazione degli<br />

elaborati della pianificazione<br />

è emersa<br />

proprio dalle proposte<br />

di tecnici/professionisti<br />

che operano in questo<br />

ambito.<br />

G: Anche colleghi di<br />

altre IDT regionali<br />

hanno rilevato questa<br />

contraddizione: la<br />

scelta della massima<br />

apertura, il fatto di<br />

non richiedere registrazione<br />

si porta dietro<br />

un effetto negativo, si<br />

conoscono poco utenti<br />

e utilizzi. Sono state<br />

comunque intraprese<br />

azioni specifiche per<br />

conoscere meglio utenti<br />

e utilizzi?<br />

RL: Stiamo valutando<br />

la riprogettazione del<br />

Geoportale per semplificarne<br />

l’utilizzo, ampliarne<br />

i servizi in base<br />

alle diverse tipologie di<br />

utenza, non rivolgendosi<br />

esclusivamente a<br />

tecnici comunali e professionisti.<br />

Più in specifico<br />

ogni anno viene<br />

svolta una “Customer<br />

Satisfaction Survey”,<br />

con la quale valutiamo<br />

la soddisfazione relativa<br />

a 5 parametri: trasparenza<br />

(la reperibilità<br />

delle informazioni sul<br />

servizio); accessibilità<br />

(la facilità di utilizzo<br />

del servizio); tempestività<br />

(tempi di risposta<br />

del servizio durante<br />

l’utilizzo per la ricerca,<br />

il caricamento e il<br />

download dei dati); efficacia<br />

(corrispondenza<br />

del servizio rispetto alle<br />

<strong>GEOmedia</strong> n°6-<strong>2021</strong> 15

INTERVISTA<br />

aspettative); assistenza<br />

(la qualità complessiva<br />

del servizio di assistenza).<br />

Le percentuali<br />

di soddisfazione sono<br />

tutte superiori all’80%;<br />

solo la valutazione della<br />

tempestività è un po’<br />

più bassa.<br />

G: Caratterizziamo i<br />

contenuti della IIT:<br />

quali sono i dataset<br />

presenti e quali i dataset<br />

più utilizzati?<br />

RL: I dataset più scaricati<br />

sono:<br />

4Carta Tecnica<br />

Regionale 1:10.000<br />

- CT10<br />

4Tavola delle<br />

Previsioni di Piano<br />

dei Piani di Governo<br />

del Territorio (a livello<br />

del comune)<br />

4Tavole piani territoriali<br />

coordinamento<br />

provinciali (PTCP)<br />

4Aree Protette<br />

4 Strade, ferrovie e<br />

metropolitane<br />

4Reticolo idrografico<br />

regionale unificato<br />

4Limiti amministrativi<br />

2020-<strong>2021</strong><br />

4Vincoli paesaggistici<br />

4Piano paesaggistico<br />

regionale<br />

4Piano di tutela e uso<br />

delle acque (PTUA<br />

2016)<br />

Con accesso dal singolo<br />

metadato:<br />

4Database<br />

Topografico (DBT)<br />

regionale: data di rilievo/aggiornamento<br />

4Direttiva Alluvioni<br />

2007/60/CE -<br />

Revisione 2020<br />

4Direttiva alluvioni<br />

2007/60/CE -<br />

Revisione 2015<br />

4Evoluzione temporale<br />

ortofoto<br />

4Mappe catastali<br />

4Carta Base da DBT<br />

(raster)<br />

4Aree Protette<br />

4Ortofoto AGEA<br />

2018<br />

4Uso e copertura del<br />

suolo 2018 (DUSAF<br />

6.0)<br />

4Reticolo Idrografico<br />

Regionale Unificato<br />

Tutti questi dati trovano<br />

corrispondenza<br />

nei temi INSPIRE: il<br />

Geoportale facilita la<br />

ricerca mettendo a<br />

disposizione la sezione<br />

delle categorie ISO e<br />

INSPIRE all’interno<br />

della quale è possibile<br />

utilizzare specifici filtri.<br />

G: Quali sono i servizi<br />

presenti e servizi più<br />

utilizzati?<br />

RL: Detto che la IIT<br />

di Regione Lombardia<br />

eroga oltre 700 servizi<br />

di mappa configurabili<br />

con tutti gli standard<br />

(es. WMS, WMTS,<br />

WFS), sono presenti<br />

tutti i servizi che ci<br />

si aspetta: servizio di<br />

consultazione del catalogo<br />

dei metadati;<br />

servizio di download<br />

dati vettoriali/raster;<br />

servizi OGC; Galleria<br />

delle mappe; statistiche<br />

del Geoportale, tool<br />

che evidenzia le parole<br />

chiave più usate.<br />

G: Nella costruzione<br />

di una IDT, in particolare<br />

al livello di una<br />

Regione, è normale<br />

scoprire che esistono<br />

dataset che in parte si<br />

sovrappongono, gestiti<br />

da soggetti diversi che<br />

non si parlano... Cosa<br />

state facendo in materia?<br />

RL: La “Struttura SIT<br />

Integrato” partecipa<br />

come rappresentante di<br />

RL agli incontri della<br />

Consulta Nazionale per<br />

l’Informazione Territoriale<br />

ed Ambientale<br />

(CNITA), che, attraverso<br />

diverse sezioni<br />

tecniche, ha ruolo di<br />

governance dell’informazione<br />

geografica<br />

a livello nazionale,<br />

rispondendo in primis<br />

alla direttiva INSPIRE;<br />

si sta attivando un coordinamento<br />

regionale<br />

in merito alla produzione<br />

di informazioni<br />

e dati cartografici tra<br />

tutti i soggetti che li<br />

detengono, partendo<br />

dalla mappatura delle<br />

competenze e delle<br />

materie delegate. Questo<br />

implica il raccordo<br />

con tutte le PA locali e<br />

le società controllate/<br />

partecipate lombarde<br />

che gestiscono dati<br />

geografici utili a tutti e<br />

che ancora non li condividono.<br />

G: Harvesting di dataset<br />

di altri soggetti PA<br />

(Comuni, ASL…)?<br />

RL: Scambiamo informazioni<br />

geografiche<br />

con tutte le PA lombarde<br />

(e non) tramite applicativi<br />

web ma anche<br />

manualmente, ai fini<br />

della messa a disposizione<br />

nel Geoportale<br />

o in aggiornamento di<br />

prodotti quali, ad es., il<br />

Database Topografico.<br />

Il DBT regionale di<br />

primo impianto è nato<br />

credendo in un modello<br />

“bottom up” fondato<br />

sulle capacità delle PA<br />

locali di gestire, attraverso<br />

consorzi, appalti<br />

di produzione con<br />

il co-finanziamento<br />

regionale. La frammentazione<br />

a volte ha funzionato<br />

bene, a volte<br />

meno, il risultato ha<br />

portato alla produzione<br />

parziale del DBT e alla<br />

disomogeneità nei contenuti<br />

e nella qualità,<br />

che si rileva osservando<br />

il DBT attuale. Non a<br />

caso si prevede di adeguarlo<br />

puntando anche<br />

ad un raccordo con il<br />

Catasto per future integrazioni<br />

tra le banche<br />

dati di rispettiva competenza.<br />

Purtroppo, a<br />

causa principalmente<br />

dell’endemica carenza<br />

di competenze (in particolare<br />

in ambito GIS)<br />

nelle PA, RL è dovuta<br />

intervenire per completare<br />

il DBT, e analoga<br />

azione verrà portata<br />

avanti con l’appalto per<br />

il suo aggiornamento,<br />

già programmato.<br />

Concludendo, la scala<br />

regionale è quella migliore<br />

per la produzione/aggiornamento<br />

di<br />

uno strumento come<br />

il DBT, ma è necessario<br />

coinvolgere le PA<br />

locali nella verifica dei<br />

contenuti, e in futuro<br />

nell’aggiornamento<br />

puntuale, partendo<br />

dalla necessaria diffusione<br />

delle competenze<br />

in ambito GIS. Un<br />

passo indietro per<br />

poterne fare uno più<br />

significativo in avanti.<br />

G: Chi finanzia e chi<br />

gestisce la IDT?<br />

16 <strong>GEOmedia</strong> n°6-<strong>2021</strong>

INTERVISTA<br />

RL: La copertura dei<br />

contratti di gestione<br />

e manutenzione evolutiva<br />

della IIT è in<br />

buona parte finanziata<br />

con risorse autonome.<br />

Grazie alla partecipazione<br />

a progetti della<br />

UE (Interreg, POR),<br />

si riesce ad intercettare<br />

risorse utili. La carenza<br />

maggiore si riscontra<br />

per le risorse umane<br />

e la formazione, con<br />

particolare riferimento<br />

all’attività di coordinamento<br />

e ai tavoli di<br />

lavoro citati in precedenza.<br />

G: Open data, qual è la<br />

situazione?<br />

RL: La maggior parte<br />

dei dati della IIT è<br />

open, ad eccezione di<br />

informazioni che non<br />

sono di proprietà di<br />

Regione. Di recente<br />

abbiamo modificato la<br />

licenza per i dati aperti<br />

in CC 4.0 internazionale.<br />

G: INSPIRE compliant:<br />

che cosa è stato<br />

fatto? Quanto rilevante<br />

in pratica è valutato<br />

questo aspetto?<br />

RL: Per quanto riguarda<br />

i metadati, si è<br />

lavorato per essere conformi<br />

alle specifiche<br />

INSPIRE almeno per<br />

quanto riguarda i priority<br />

dataset (come indicato<br />

da AgID/RNDT)<br />

in modo da contribuire<br />

all’harvesting annuale.<br />

Siamo consapevoli<br />

di che cosa si debba<br />

realizzare; dobbiamo<br />

investire molte risorse/<br />

attività nella creazione<br />

di servizi in quanto - al<br />

momento - disponiamo<br />

di molti servizi<br />

di consultazione che<br />

aggregano più livelli<br />

informativi (in questo<br />

caso il metadato non<br />

è associato al singolo<br />

dataset ma al servizio).<br />

Successivamente si<br />

dovrà investire nell’aggiornamento<br />

dei dati<br />

coinvolgendo i produttori<br />

dei dati e sull’armonizzazione.<br />

G: Si dice, non dati ma<br />

informazione. Quali<br />

tools di visualizzazione,<br />

analisi, simulazione…<br />

utili per rendere più facile,<br />

ma soprattutto più<br />

efficace l’uso dell’informazione<br />

geografica<br />

della IIT, avete messo<br />

in campo o state progettando?<br />

RL: Dal Geoportale si<br />

accede ai servizi della<br />

rete interregionale di<br />

stazioni permanenti<br />

GNSS (SPIN3 GNSS)<br />

che integra in un unico<br />

centro di gestione le<br />

stazioni di Piemonte,<br />

Lombardia e Valle d’Aosta,<br />

e fornisce all’utenza<br />

pubblica/privata<br />

il posizionamento di<br />

precisione e diffusione<br />

delle coordinate nel<br />

sistema di riferimento<br />

ufficiale.<br />

Abbiamo realizzato dei<br />

tools che consentono<br />

di confrontare tra loro<br />

ortofoto storiche, l’evoluzione<br />

storica dei<br />

limiti amministrativi<br />

(fusioni dei comuni nel<br />

tempo), l’uso agricolo<br />

del suolo.<br />

Abbiamo sviluppato<br />

due applicativi, il<br />

primo, l’ ”Attestato<br />

del Territorio”, consente<br />

di ottenere, su<br />

un punto definito<br />

dall’utente, una serie<br />

di informazioni che<br />

inquadrano il territorio<br />

nei suoi aspetti legati<br />

all’atmosfera (vento,<br />

precipitazioni, fulmini,<br />

inquinanti, classificazione<br />

acustica), al suolo<br />

(quota, pendenza,<br />

numero del mappale<br />

catastale, uso del suolo,<br />

max altezza neve, frane,<br />

aree allagabili, classe<br />

di fattibilità geologica,<br />

interferometria radar,<br />

vincoli), al sottosuolo<br />

(accelerazione sismica,<br />

geologia, radon). Il<br />

secondo applicativo,<br />

"Interroga il Territorio"<br />

(a breve diventerà<br />

“Interroga il Territorio<br />

e il Paesaggio”), analogamente<br />

al precedente,<br />

evidenzia la vincolistica<br />

urbanistica, paesaggistica,<br />

ambientale presente.<br />

Entrambi gli applicativi<br />

producono una<br />

reportistica che aiuta la<br />

consultazione integrata<br />

di informazioni geografiche,<br />

e aiuta nella<br />

corretta progettazione<br />

del territorio.<br />

G: Il concetto del<br />

Geospatial Ecosystem,<br />

inteso come integrazione<br />

di dati provenienti<br />

da crowdsourcing, da<br />

fonti commerciali o<br />

private..., è una prospettiva<br />

praticabile?<br />

RL: Al momento<br />

Regione Lombardia<br />

non ha collaborazioni<br />

attive con soggetti<br />

privati in tal<br />

senso, o iniziative di<br />

crowdsourcing. In realtà<br />

un primo ecosistema<br />

digitale era stato realizzato<br />

in occasione di<br />

EXPO Milano 2015, il<br />

Cruscotto Emergenze,<br />

per gestire sicurezza/<br />

emergenze legate all’evento.<br />

Certamente<br />

c’è l’intenzione di<br />

proseguire il percorso<br />

creando ecosistemi<br />

che integrino le informazioni<br />

geografiche<br />

e non, a disposizione<br />

delle diverse Direzioni<br />

Generali dell’Ente.<br />

Idealmente, in RL si<br />

potrebbero individuare<br />

5 “ecosistemi digitali”:<br />

Ambiente e Clima,<br />

Casa, Mobilità sostenibile<br />

e qualità dell’Aria,<br />

Safe&Security e Tutela<br />

e valorizzazione del<br />

Territorio.<br />

Siamo ben consapevoli<br />

dei benefici ottenibili<br />

lavorando per ecosistemi<br />

digitali: scambio di<br />

patrimonio informativo<br />

tra soggetti/Enti<br />

diversi; incidere sulle<br />

“sinergie” dei sistemi<br />

più maturi e strategici,<br />

agevolando il raccordo<br />

tra le politiche digitali<br />

delle diverse Direzioni<br />

Regionali/Enti e<br />

Società del Sistema<br />

regionale allargato.<br />

Siamo altrettanto consapevoli<br />

delle difficoltà<br />

connesse alla carenza<br />

di competenze e personale<br />

all’interno della<br />

PA, e non solo: oltre a<br />

sensibilizzare i decisori<br />

politici, ai vari livelli<br />

istituzionali, della necessità<br />

di valorizzazione<br />

delle competenze dei<br />

funzionari tecnici e<br />

dei loro responsabili,<br />

occorre incentivare for-<br />

<strong>GEOmedia</strong> n°6-<strong>2021</strong> 17

INTERVISTA<br />

me di collaborazione<br />

pubblico/privato che<br />

accrescano le capacità<br />

di gestire la pianificazione<br />

territoriale negli<br />

ambiti locali in cui ciò<br />

avviene, quindi presso i<br />

Comuni e gli Enti che<br />

operano sul territorio.<br />

In Lombardia ci sono<br />

diversi esempi che<br />

hanno attuato queste<br />

politiche realizzando<br />

sinergie virtuose con<br />

ricadute molto positive<br />

sul territorio, sia<br />

per chi lo amministra,<br />

sia per chi lo vive e ci<br />

lavora.<br />

G: Per concludere,<br />

parlando della vostra<br />

IIT, quale è l’aspetto<br />

che vorreste mettere in<br />

evidenza?<br />

LR: Ha per certi versi<br />

a che vedere con le origini<br />

della IIT. Regione<br />

Lombardia, facendo seguito<br />

alla riforma della<br />

propria legislazione in<br />

materia urbanistica, avvenuta<br />

come detto nel<br />

2005, ha scelto di costituire<br />

una banca dati<br />

della pianificazione<br />

comunale/provinciale<br />

attraverso la collaborazione<br />

diretta degli<br />

Enti Locali, ai quali<br />

viene chiesta la fornitura<br />

dei dati secondo<br />

specifiche comuni.<br />

Questo, per citare un<br />

caso di successo, ha<br />

permesso di progettare<br />

il Piano Territoriale<br />

Regionale per la riduzione<br />

del consumo di<br />

suolo con i dati reali<br />

delle previsioni urbanistiche<br />

dei singoli<br />

Comuni (oltre 1500 in<br />

Lombardia). Il processo<br />

vede l’acquisizione<br />

di una media di 400<br />

diversi piani/varianti<br />

di piano urbanistici<br />

all’anno, consentendo<br />

di ottenere una banca<br />

dati con un grado di<br />

aggiornamento adeguato;<br />

recentemente si<br />

è resa automatica l’acquisizione<br />

delle informazioni<br />

sul consumo<br />

di suolo dai Comuni.<br />

Al fine di migliorarne<br />

ulteriormente la precisione<br />

e soprattutto per<br />

aumentare la velocità<br />

con cui avvengono le<br />

forniture, come sopra<br />

detto è in corso un<br />

progetto di prima sperimentazione<br />

volto alla<br />

realizzazione di un software<br />

che permetterà<br />

la redazione dei PGT<br />