IT-Nachwuchsforschung in Österreich

Das OCG Journal ist die Mitgliederzeitschrift der Österreichischen Computer Gesellschaft (OCG). Das erste OCG Journal des Jahres widmet sich erneut der IT-Nachwuchsforschung in Österreich. Ausgewählte Jungforscher*innen präsentieren ihre spannende Arbeit im Bereich der Informatik.

Das OCG Journal ist die Mitgliederzeitschrift der Österreichischen Computer Gesellschaft (OCG). Das erste OCG Journal des Jahres widmet sich erneut der IT-Nachwuchsforschung in Österreich. Ausgewählte Jungforscher*innen präsentieren ihre spannende Arbeit im Bereich der Informatik.

Erfolgreiche ePaper selbst erstellen

Machen Sie aus Ihren PDF Publikationen ein blätterbares Flipbook mit unserer einzigartigen Google optimierten e-Paper Software.

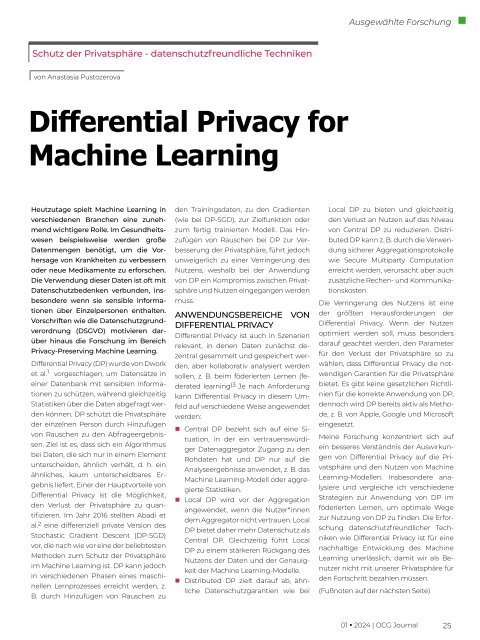

Ausgewählte Forschung<br />

Schutz der Privatsphäre - datenschutzfreundliche Techniken<br />

von Anastasia Pustozerova<br />

Differential Privacy for<br />

Mach<strong>in</strong>e Learn<strong>in</strong>g<br />

Heutzutage spielt Mach<strong>in</strong>e Learn<strong>in</strong>g <strong>in</strong><br />

verschiedenen Branchen e<strong>in</strong>e zunehmend<br />

wichtigere Rolle. Im Gesundheitswesen<br />

beispielsweise werden große<br />

Datenmengen benötigt, um die Vorhersage<br />

von Krankheiten zu verbessern<br />

oder neue Medikamente zu erforschen.<br />

Die Verwendung dieser Daten ist oft mit<br />

Datenschutzbedenken verbunden, <strong>in</strong>sbesondere<br />

wenn sie sensible Informationen<br />

über E<strong>in</strong>zelpersonen enthalten.<br />

Vorschriften wie die Datenschutzgrundverordnung<br />

(DSGVO) motivieren darüber<br />

h<strong>in</strong>aus die Forschung im Bereich<br />

Privacy-Preserv<strong>in</strong>g Mach<strong>in</strong>e Learn<strong>in</strong>g.<br />

Differential Privacy (DP) wurde von Dwork<br />

et al. 1 vorgeschlagen, um Datensätze <strong>in</strong><br />

e<strong>in</strong>er Datenbank mit sensiblen Informationen<br />

zu schützen, während gleichzeitig<br />

Statistiken über die Daten abgefragt werden<br />

können. DP schützt die Privatsphäre<br />

der e<strong>in</strong>zelnen Person durch H<strong>in</strong>zufügen<br />

von Rauschen zu den Abfrageergebnissen.<br />

Ziel ist es, dass sich e<strong>in</strong> Algorithmus<br />

bei Daten, die sich nur <strong>in</strong> e<strong>in</strong>em Element<br />

unterscheiden, ähnlich verhält, d. h. e<strong>in</strong><br />

ähnliches, kaum unterscheidbares Ergebnis<br />

liefert. E<strong>in</strong>er der Hauptvorteile von<br />

Differential Privacy ist die Möglichkeit,<br />

den Verlust der Privatsphäre zu quantifizieren.<br />

Im Jahr 2016 stellten Abadi et<br />

al. 2 e<strong>in</strong>e differenziell private Version des<br />

Stochastic Gradient Descent (DP-SGD)<br />

vor, die nach wie vor e<strong>in</strong>e der beliebtesten<br />

Methoden zum Schutz der Privatsphäre<br />

im Mach<strong>in</strong>e Learn<strong>in</strong>g ist. DP kann jedoch<br />

<strong>in</strong> verschiedenen Phasen e<strong>in</strong>es masch<strong>in</strong>ellen<br />

Lernprozesses erreicht werden, z.<br />

B. durch H<strong>in</strong>zufügen von Rauschen zu<br />

den Tra<strong>in</strong><strong>in</strong>gsdaten, zu den Gradienten<br />

(wie bei DP-SGD), zur Zielfunktion oder<br />

zum fertig tra<strong>in</strong>ierten Modell. Das H<strong>in</strong>zufügen<br />

von Rauschen bei DP zur Verbesserung<br />

der Privatsphäre, führt jedoch<br />

unweigerlich zu e<strong>in</strong>er Verr<strong>in</strong>gerung des<br />

Nutzens, weshalb bei der Anwendung<br />

von DP e<strong>in</strong> Kompromiss zwischen Privatsphäre<br />

und Nutzen e<strong>in</strong>gegangen werden<br />

muss.<br />

ANWENDUNGSBEREICHE VON<br />

DIFFERENTIAL PRIVACY<br />

Differential Privacy ist auch <strong>in</strong> Szenarien<br />

relevant, <strong>in</strong> denen Daten zunächst dezentral<br />

gesammelt und gespeichert werden,<br />

aber kollaborativ analysiert werden<br />

sollen, z. B. beim föderierten Lernen (federated<br />

learn<strong>in</strong>g )3 Je nach Anforderung<br />

kann Differential Privacy <strong>in</strong> diesem Umfeld<br />

auf verschiedene Weise angewendet<br />

werden:<br />

• Central DP bezieht sich auf e<strong>in</strong>e Situation,<br />

<strong>in</strong> der e<strong>in</strong> vertrauenswürdiger<br />

Datenaggregator Zugang zu den<br />

Rohdaten hat und DP nur auf die<br />

Analyseergebnisse anwendet, z. B. das<br />

Mach<strong>in</strong>e Learn<strong>in</strong>g-Modell oder aggregierte<br />

Statistiken.<br />

• Local DP wird vor der Aggregation<br />

angewendet, wenn die Nutzer*<strong>in</strong>nen<br />

dem Aggregator nicht vertrauen. Local<br />

DP bietet daher mehr Datenschutz als<br />

Central DP. Gleichzeitig führt Local<br />

DP zu e<strong>in</strong>em stärkeren Rückgang des<br />

Nutzens der Daten und der Genauigkeit<br />

der Mach<strong>in</strong>e Learn<strong>in</strong>g-Modelle.<br />

• Distributed DP zielt darauf ab, ähnliche<br />

Datenschutzgarantien wie bei<br />

Local DP zu bieten und gleichzeitig<br />

den Verlust an Nutzen auf das Niveau<br />

von Central DP zu reduzieren. Distributed<br />

DP kann z. B. durch die Verwendung<br />

sicherer Aggregationsprotokolle<br />

wie Secure Multiparty Computation<br />

erreicht werden, verursacht aber auch<br />

zusätzliche Rechen- und Kommunikationskosten.<br />

Die Verr<strong>in</strong>gerung des Nutzens ist e<strong>in</strong>e<br />

der größten Herausforderungen der<br />

Differential Privacy. Wenn der Nutzen<br />

optimiert werden soll, muss besonders<br />

darauf geachtet werden, den Parameter<br />

für den Verlust der Privatsphäre so zu<br />

wählen, dass Differential Privacy die notwendigen<br />

Garantien für die Privatsphäre<br />

bietet. Es gibt ke<strong>in</strong>e gesetzlichen Richtl<strong>in</strong>ien<br />

für die korrekte Anwendung von DP,<br />

dennoch wird DP bereits aktiv als Methode,<br />

z. B. von Apple, Google und Microsoft<br />

e<strong>in</strong>gesetzt.<br />

Me<strong>in</strong>e Forschung konzentriert sich auf<br />

e<strong>in</strong> besseres Verständnis der Auswirkungen<br />

von Differential Privacy auf die Privatsphäre<br />

und den Nutzen von Mach<strong>in</strong>e<br />

Learn<strong>in</strong>g-Modellen. Insbesondere analysiere<br />

und vergleiche ich verschiedene<br />

Strategien zur Anwendung von DP im<br />

föderierten Lernen, um optimale Wege<br />

zur Nutzung von DP zu f<strong>in</strong>den. Die Erforschung<br />

datenschutzfreundlicher Techniken<br />

wie Differential Privacy ist für e<strong>in</strong>e<br />

nachhaltige Entwicklung des Mach<strong>in</strong>e<br />

Learn<strong>in</strong>g unerlässlich, damit wir als Benutzer<br />

nicht mit unserer Privatsphäre für<br />

den Fortschritt bezahlen müssen.<br />

(Fußnoten auf der nächsten Seite)<br />

01 • 2024 | OCG Journal<br />

25