Calculul valorilor si vectorilor proprii

Calculul valorilor si vectorilor proprii

Calculul valorilor si vectorilor proprii

You also want an ePaper? Increase the reach of your titles

YUMPU automatically turns print PDFs into web optimized ePapers that Google loves.

Capitolul 4<br />

<strong>Calculul</strong> <strong>valorilor</strong> şi<br />

<strong>vectorilor</strong> <strong>proprii</strong><br />

Valorile şi vectorii <strong>proprii</strong> joacă un rol fundamental în descriereamatematică a unor<br />

categoriifoartelargide procese tehnice, economice, biologiceetc. Astfel, proprietăţi<br />

esenţiale (cum este, e.g. stabilitatea)ale modelelormatematice cunoscutesub denumirea<br />

de <strong>si</strong>steme dinamice se exprimă în raport cu valorile <strong>proprii</strong> ale unor matrice.<br />

În acestcontext, calculul câtmaieficient şimai exactal<strong>valorilor</strong>şi <strong>vectorilor</strong><strong>proprii</strong><br />

se impune cu nece<strong>si</strong>tate.<br />

Cadrul cel mai natural de abordare a problemei este cel al matricelor complexe,<br />

în care caz valorile şi vectorii <strong>proprii</strong> sunt, în general, numere complexe, respectiv<br />

vectori complecşi. Totuşi, majoritatea problemelor tehnice conduc la nece<strong>si</strong>tatea<br />

calculului <strong>valorilor</strong> şi <strong>vectorilor</strong> <strong>proprii</strong> pentru matrice reale. Deşi valorile <strong>proprii</strong><br />

şi vectorii <strong>proprii</strong> asociaţi ai unei matrice reale pot fi numere complexe, respectiv<br />

vectori complecşi, calculul cu numere complexe este sen<strong>si</strong>bil mai puţin eficient şi,<br />

din acest motiv, în cazul datelor iniţiale reale, dezvoltările procedurale vor urmări<br />

utilizarea, practic exclu<strong>si</strong>vă, a calculului cu numere reale.<br />

4.1 Formularea problemei<br />

4.1.1 Valori şi vectori <strong>proprii</strong><br />

Valorileşi vectorii<strong>proprii</strong>pentru o matricepătratăA ∈ IC n×n sunt noţiuni introduse<br />

în capitolul 1 în contextul prezentării unor algoritmi de calcul elementari (secţiunea<br />

1.10). Problemadeterminării <strong>valorilor</strong>şi <strong>vectorilor</strong><strong>proprii</strong>poate fi apreciatăca fiind<br />

<strong>si</strong>mplă numai pentru matrice cu structură triunghiulară, caz care a şi fost tratat în<br />

capitolul menţionat (v. algoritmul 1.23).<br />

Cu riscul de a ne repeta, reluăm câteva definiţii şi rezultate fundamentale introduse<br />

în §1.10 cu dezvoltările corespunzătoare necesare abordării problemei în cazul<br />

general.

210 CAPITOLUL 4. VALORI ŞI VECTORI PROPRII<br />

Definiţia 4.1 Fie o matrice A ∈ IC n×n . Un număr λ ∈ IC se numeşte valoare<br />

proprie a matricei A, dacă există un vector nenul x ∈ IC n astfel încât<br />

Ax = λx. (4.1)<br />

Un vector x ≠ 0 care satisface (4.1) se numeşte vector propriu al matricei A asociat<br />

valorii <strong>proprii</strong> λ.<br />

Valorile <strong>proprii</strong> ale matricei A ∈ IC n×n , conform teoremei 1.13, sunt zerourile<br />

polinomului caracteristic<br />

p(λ) = det(λI n −A), (4.2)<br />

care este un polinom de gradul n cu coeficienţi complecşi 1 . În consecinţă, orice<br />

matrice A ∈ IC n×n are exact n valori <strong>proprii</strong> complexe, nu neapărat distincte.<br />

Dacă matricea este reală, atunci polinomul caracteristic are coeficienţii reali şi<br />

valorile <strong>proprii</strong>complexe apar înperechi complex-conjugate 2 . Dacă x = u+iv ∈ IC n<br />

cu u, v ∈ IR n , este un vector propriu asociat valorii <strong>proprii</strong> λ = α+iβ, α, β ∈ IR,<br />

β ≠ 0, a unei matrice reale, atunci ¯x = u−iv este un vector propriu asociat valorii<br />

<strong>proprii</strong> ¯λ = α−iβ (verificaţi!).<br />

Ordinuldemultiplicitate n i alrădăciniiλ i apolinomuluicaracteristicsenumeşte<br />

multiplicitate algebrică a valorii <strong>proprii</strong> respective. Dacă n i = 1 valoarea proprie λ i<br />

se numeşte <strong>si</strong>mplă.<br />

Mulţimea<br />

λ(A) = {λ 1 ,λ 2 ,...,λ n } = {λ ∈ IC | det(λI −A) = 0} (4.3)<br />

a <strong>valorilor</strong> <strong>proprii</strong> ale unei matrice A ∈ IC n×n se numeşte spectrul matricei A, iar<br />

numărul real nenegativ<br />

ρ(A) = max(|λ 1 |,|λ 2 |,...,|λ n |) (4.4)<br />

se numeşte raza spectrală a matricei A. Deci, în planul complex IC, valorile <strong>proprii</strong><br />

ale unei matrice A sunt <strong>si</strong>tuate în discul închis de rază ρ(A) cu centrul în origine.<br />

Se poate arăta imediat că valorile <strong>proprii</strong> ale unei matrice A ∈ IC n×n satisfac<br />

relaţiile<br />

n∑<br />

λ i =<br />

i=1<br />

n∑<br />

i=1<br />

a ii<br />

def<br />

= tr(A),<br />

n∏<br />

λ i = det(A), (4.5)<br />

unde tr(A) este, prin definiţie, urma matricei A. În particular, o matrice este<br />

<strong>si</strong>ngulară dacă şi numai dacă are (cel puţin) o valoare proprie nulă.<br />

Vectorii <strong>proprii</strong> introduşi prin definiţia 4.1 sunt denumiţi uneori vectori <strong>proprii</strong><br />

la dreapta ai matricei A şi satisfac <strong>si</strong>stemul liniar omogen <strong>si</strong>ngular<br />

i=1<br />

(λI n −A)x = 0. (4.6)<br />

Deci, fiecăreivalori<strong>proprii</strong>îicorespundecelpuţinunvectorpropriu. Vectorii<strong>proprii</strong><br />

asociaţi <strong>valorilor</strong> <strong>proprii</strong> distincte sunt liniar independenţi.<br />

1 Ecuaţia p(λ) = 0 se numeşte ecuaţie caracteristică a matricei A.<br />

2 O mulţime de numere (reale şi complexe) în care numerele complexe apar în perechi complexconjugate<br />

va fi numită în continuare mulţime <strong>si</strong>metrică.

4.1. FORMULAREA PROBLEMEI 211<br />

În acest context, vectorii <strong>proprii</strong> la stânga sunt vectorii nenuli y ∈ IC n ce satisfac<br />

condiţia<br />

y H A = λy H , (4.7)<br />

unde H reprezintă operatorul cumulat de transpunere şi conjugare. Aplicând operatorul<br />

H relaţiei (4.7) obţinem<br />

A H y = ¯λy, (4.8)<br />

i.e. vectorii <strong>proprii</strong> la stânga ai matricei A asociaţi valorii <strong>proprii</strong> λ sunt vectori<br />

<strong>proprii</strong> (la dreapta) ai matricei A H asociaţi valorii <strong>proprii</strong> ¯λ ∈ λ(A H ). De aici<br />

rezultă<br />

λ(A H ) = ¯λ(A), (4.9)<br />

adică valorile <strong>proprii</strong> ale matricei A H sunt conjugatele <strong>valorilor</strong> <strong>proprii</strong> ale matricei<br />

A.<br />

Întrucât det(λI n − A) = det(λI n − A T ) matricele A şi A T au acelaşi polinom<br />

caracteristic şi, deci, aceleaşi valori <strong>proprii</strong> dar vectorii <strong>proprii</strong>, în general, diferă.<br />

Cum un vector propriu y al matricei A T asociat valorii <strong>proprii</strong> λ satisface A T y = λy<br />

sau y T A = λy T vectorii <strong>proprii</strong> reali ai matricei A T sunt vectori <strong>proprii</strong> la stânga<br />

ai matricei A.<br />

Dacă x i este un vector propriu al matricei A asociat valorii <strong>proprii</strong> λ i , vectorul<br />

y i = αx i este, de asemenea, un vector propriu al matricei A asociat aceleiaşi valori<br />

<strong>proprii</strong> λ i , oricare ar fi α ∈ IC, α ≠ 0. Mai mult, este clar că mulţimea <strong>vectorilor</strong><br />

<strong>proprii</strong> asociaţi unei valori <strong>proprii</strong> λ i împreună cu vectorul nul din IC n formează<br />

subspaţiul liniar V i = Ker(λ i I n −A) ⊂ IC n numit subspaţiul propriu asociat valorii<br />

<strong>proprii</strong> λ i . Dimen<strong>si</strong>unea ν i = dimV i a subspaţiului propriu, i.e. numărul de vectori<br />

<strong>proprii</strong> liniar independenţi asociaţi lui λ i , se numeşte multiplicitate geometrică a<br />

valorii <strong>proprii</strong> λ i . Este evident că<br />

ν i ≤ n i . (4.10)<br />

4.1.2 Subspaţii invariante<br />

Subspaţiile <strong>proprii</strong> sunt subspaţii A-invariante în sensul definiţiei următoare<br />

(v. şi §1.10).<br />

Definiţia 4.2 Fie o matrice A ∈ IC n×n . Un subspaţiu liniar V ⊂ IC n se numeşte<br />

subspaţiu invariant al matricei A sau, pe scurt, subspaţiu A-invariant dacă<br />

AV ⊂ V i.e. Ax ∈ V, ∀x ∈ V. (4.11)<br />

Cum IR n ⊂ IC n , pot exista subspaţii A-invariante în IR n pentru matrice A complexe.<br />

De asemenea, pentru matrice A reale pot exista subspaţii A-invariante care nu sunt<br />

în IR n . Dintre proprietăţile subspaţiilor A-invariante amintim următoarele.

212 CAPITOLUL 4. VALORI ŞI VECTORI PROPRII<br />

Propoziţia 4.1 Fie matricea A ∈ IC n×n .<br />

1 ◦ . Dacă x 1 , x 2 , ... ,x p sunt vectori <strong>proprii</strong> ai matricei A, atunci subspaţiul<br />

S = Im[x 1 x 2 ... x p ] ⊂ IC n este A-invariant.<br />

2 ◦ . Dacă S este un subspaţiu A-invariant cu dimS = p şi coloanele matricei<br />

(monice) V = [v 1 v 2 ... v p ] ∈ IC n×p formează o bază a lui S, atunci există o matrice<br />

B ∈ IC p×p astfel încât<br />

AV = VB. (4.12)<br />

Mai mult, avem<br />

λ(B) ⊂ λ(A). (4.13)<br />

(Matricea B se numeşte restricţia matricei A la subspaţiul A-invariant S şi se<br />

notează B = A|S.)<br />

În particular, orice subspaţiu A-invariant nenul (i.e. p ≥ 1) conţine un vector<br />

propriu al matricei A. Reciproc, dacă are loc o relaţie de forma (4.12), atunci ImV<br />

este un subspaţiu A-invariant.<br />

3 ◦ Complementul ortogonal T = S ⊥ în IC n al subspaţiului A-invariant S este un<br />

subspaţiu A H -invariant.<br />

În cazul real un subspaţiu A-invariant generat de vectori <strong>proprii</strong> reali este, evident,<br />

real. Dacă x 1,2 = v 1 ± iv 2 , v 1 , v 2 ∈ IR n , sunt vectori <strong>proprii</strong> asociaţi unei<br />

perechi de valori <strong>proprii</strong> complex conjugate λ 1,2 = α ± iβ, α, β ∈ IR, β ≠ 0,<br />

atunci vectorii v 1 , v 2 sunt liniar independenţi şi S = Im[v 1 v 2 ] este un subspaţiu<br />

A-invariant. Mai mult, dacă are loc o relaţie de forma (4.12), unde coloanele lui<br />

V ∈ IR n×p formează o bază a unui subspaţiu A-invariant S ⊂ IR n , atunci restricţia<br />

B ∈ IR p×p a lui A la S satisface (4.13) cu λ(B) o mulţime <strong>si</strong>metrică. În sfârşit,<br />

complementul ortogonal T = S ⊥ în IR n al subspaţiului A-invariant real S este un<br />

subspaţiu A T -invariant.<br />

Demonstraţie. Proprietatea 1 ◦ este evidentă. Pentru a arăta 2 ◦ să observăm<br />

că Av j ∈ S, de unde rezultă Av j = Vb j , j = 1 : p, i.e. (4.12) este adevărată.<br />

Dacă z ∈ IC p este un vector propriu al matricei B, i.e. Bz = µz, asociat valorii<br />

<strong>proprii</strong> µ ∈ λ(B), atunci din (4.12) avem AVz = µVz. Cum z ≠ 0 iar V este<br />

monică, rezultă y = Vz ≠ 0, i.e. y este un vector propriu al lui A conţinut în<br />

S. În consecinţă, S conţine un vector propriu al matricei A şi avem µ ∈ λ(A),<br />

deci (4.13) este adevărată. Acum, dacă are loc o relaţie de forma (4.12), atunci<br />

AVz = VBz = Vw ∈ ImV, ∀z ∈ IC p , i.e. ImV este A-invariant. 3 ◦ . Fie x ∈ S,<br />

y ∈ T doi vectori arbitrari. Atunci Ax ∈ S şi, deci, y H Ax = (A H y) H x = 0. Cum<br />

x ∈ S este arbitrar, rezultă A H y ⊥ S, respectiv A H y ∈ T , i.e. T este A H -invariant.<br />

În cazul real, din A(v 1 ±iv 2 ) = (α±iβ)(v 1 ±iv 2 ) rezultă<br />

{ [ ]<br />

Av1 = αv 1 −βv 2<br />

α −β<br />

, i.e. AV = VB cu B = . (4.14)<br />

Av 2 = βv 1 +αv 2 β α<br />

Dacă v 1 , v 2 sunt liniar dependenţi, atunci v 2 = γv 1 cu γ ≠ 0 şi din (4.14) rezultă<br />

β(1 + γ 2 )v 1 = 0. Cum β ≠ 0, obţinem v 1 = 0, de unde v 2 = 0 şi x 1,2 = 0, ceea<br />

ce contrazice definiţia <strong>vectorilor</strong> <strong>proprii</strong>. Celelalte afirmaţii se demonstrează <strong>si</strong>milar<br />

cazului complex.<br />

✸

4.1. FORMULAREA PROBLEMEI 213<br />

Exemplul 4.1 Se con<strong>si</strong>deră matricea<br />

⎡<br />

A = 1 6<br />

care are polinomul caracteristic<br />

⎣ 5 25 9<br />

−1 −5 −9<br />

0 24 24<br />

p(λ) = det(λI 3 −A) = λ 3 −4λ 2 +6λ−4<br />

şi valorile <strong>proprii</strong> λ 1 = 2, λ 2,3 = 1±i. Vectorii<br />

⎡<br />

def<br />

x 1 = v 1 = ⎣ −1 ⎤<br />

−1<br />

2<br />

⎦, x 2,3<br />

def<br />

= v 2 ±iv 3 =<br />

⎤<br />

⎦<br />

⎡<br />

⎣ 5<br />

−1<br />

2<br />

⎤<br />

⎦±i<br />

⎡<br />

⎣ 2 2<br />

−2<br />

sunt vectori <strong>proprii</strong> ai matricei A asociaţi <strong>valorilor</strong> <strong>proprii</strong> λ 1 şi, respectiv, λ 2,3 . Fie<br />

V 1 = v 1 şi V 23 = [v 2 v 3 ]. Avem următoarele relaţii de tipul (4.12) (verificaţi!):<br />

[ ]<br />

1 1<br />

AV 1 = V 1 B 1 cu B 1 = 2, AV 23 = V 23 B 23 cu B 23 =<br />

−1 1<br />

şi, prin urmare, S 1 = ImV 1 şi S 23 = ImV 23 (vezi fig.4.1) sunt subspaţii A-invariante,<br />

⎤<br />

⎦<br />

✻3<br />

IR<br />

❅<br />

S 3<br />

1 =ImV 1<br />

✘✘ ✘✘✘ ✘ ✘✘✘ ✘ ✘✘ ❈<br />

❅ ❈❈❈❈❈❈❈❈<br />

❅ S 23 =ImV 23<br />

❈ ❅❅■<br />

v 1<br />

v 2<br />

❈❈ ❅<br />

✘ ✘✘✘ ✘✘✿<br />

❅<br />

❈<br />

✑<br />

0<br />

✑ ❈<br />

❈❈❈❈❈ ✑ ❈❈❈❲<br />

✑<br />

✑ v 3<br />

✑<br />

✑<br />

✑✰ ✑ ✘ ✘ ✘ ✘✘✘ ✘ ✘✘✘ ✘✘<br />

2<br />

❅<br />

❅<br />

❅<br />

✲1<br />

Fig. 4.1: Vectori <strong>proprii</strong> şi subspaţii A-invariante pentru matricea A din exemplul<br />

4.1.<br />

iar B 1 = A|S 1 şi B 23 = A|S 23 sunt restricţii ale matricei A la cele două subspaţii<br />

(sunt aceste restricţii unic determinate). Propunem cititorului să calculeze complementele<br />

ortogonale înIR 3 ale celordouă subspaţii şi săverificecă acestesubspaţii<br />

sunt A T -invariante.<br />

✸<br />

Problema de calcul care face obiectul acestui capitol este determinarea <strong>valorilor</strong><br />

şi <strong>vectorilor</strong> <strong>proprii</strong> ai unei matrice date. Deşi pentru calculul unei valori <strong>proprii</strong>

214 CAPITOLUL 4. VALORI ŞI VECTORI PROPRII<br />

sau al unui grup de valori <strong>proprii</strong> pot fi utilizate tehnici specifice, ne vom concentra<br />

demersul nostru, în principal, asupra problema de calcul al întregului spectru. Problema<br />

calculului <strong>vectorilor</strong> <strong>proprii</strong> va fi tratată în sub<strong>si</strong>diar, ţinând seama şi de<br />

faptul că în multe aplicaţii calculul explicit al <strong>vectorilor</strong> <strong>proprii</strong> poate fi (şi este bine<br />

să fie) evitat.<br />

4.1.3 Matrice asemenea<br />

Urmând metodologia generală de reducere a unei probleme de calcul la alte probleme<br />

mai <strong>si</strong>mple, utilizată şi în capitolele precedente, suntem interesaţi să evidenţiem<br />

transformările matriceale care conservă spectrul unei matrice date.<br />

Aşa cum s-a specificat şi în §1.10, valorile <strong>proprii</strong> sunt conservate de transformările<br />

de asemănare definite mai jos.<br />

Definiţia 4.3 Două matrice A,B ∈ IC n×n se numesc asemenea dacă există o matrice<br />

ne<strong>si</strong>ngulară T ∈ IC n×n astfel încât<br />

B = T −1 AT. (4.15)<br />

Dacă matricea de transformare T este unitară, atunci matricele A şi B se numesc<br />

unitar asemenea. În cazul real, dacă matricea de transformare T este ortogonală,<br />

matricele A şi B se numesc ortogonal asemenea.<br />

Într-adevăr,conformteoremei1.14,dacămatriceleA,B ∈ IC n×n satisfacorelaţie<br />

de forma (4.15), i.e. sunt asemenea, atunci ele au acelaşi spectru 3<br />

λ(A) = λ(B) (4.16)<br />

şi dacă x este un vector propriu al matricei A asociat valorii <strong>proprii</strong> λ ∈ λ(A),<br />

atunci vectorul<br />

y = T −1 x (4.17)<br />

este un vector propriu al matricei B, asociat aceleiaşi valori <strong>proprii</strong>.<br />

În dezvoltările din această lucrare vom in<strong>si</strong>sta asupra cazului generic al matricelorde<br />

ordinn careadmit un set (complet) de n vectori<strong>proprii</strong>liniar independenţi.<br />

Aşa cum s-a demonstrat în teorema 1.15, în acest caz, utilizând în (4.15) ca matrice<br />

de transformare T = X, unde X este o matrice având drept coloane n vectori<br />

<strong>proprii</strong> liniar independenţi ai matricei A, obţinem o matrice diagonală:<br />

X −1 AX = Λ = diag(λ 1 ,λ 2 ,...,λ j ,...,λ n ) ∈ IC n×n . (4.18)<br />

Astfel de matrice se numesc diagonalizabile (peste IC). Dacă o matrice n×n are n<br />

valori <strong>proprii</strong> distincte, atunci este diagonalizabilă dar reciproca nu este, în general,<br />

adevărată 4 .<br />

3 De remarcat faptul că transformările uzuale cum ar fi multiplicările cu matrice (la stânga<br />

sau la dreapta) alterează spectrul matricei date. În particular, operaţiile elementare cu linii sau<br />

coloane, inclu<strong>si</strong>v permutările, pot modifica valorile şi vectorii <strong>proprii</strong>.<br />

4 O matrice cu toate valorile <strong>proprii</strong> <strong>si</strong>mple (i.e. distincte) se numeşte cu spectru <strong>si</strong>mplu, iar<br />

matricele care admit seturi complete de vectori <strong>proprii</strong> liniar independenţi sunt cunoscute sub<br />

denumirea de matrice <strong>si</strong>mple. În acest din urmă caz multiplicităţile algebrice ale <strong>valorilor</strong> <strong>proprii</strong><br />

distincte coincid cu multiplicităţile lor geometrice. Evident, matricele cu spectru <strong>si</strong>mplu sunt<br />

<strong>si</strong>mple dar nu şi reciproc.

4.1. FORMULAREA PROBLEMEI 215<br />

În cazul general, structura ”fină” a unei matrice, care poate fi dezvăluită prin<br />

transformărideasemănarecorespunzătoare,estedatădeaşanumitaformă canonică<br />

Jordan. Deşi forma canonică Jordan joacă un rol esenţial în analiza matriceală,<br />

conţinând maximum de informaţie structurală privitor la o matrice dată, totuşi<br />

rolul ei în calculul numeric este mult diminuat de sen<strong>si</strong>bilitatea structurii Jordan la<br />

perturbaţii numerice în elementele matricei iniţiale, perturbaţii inerente în calcule<br />

efectuate pe un calculator datorită reprezentării informaţiei numerice în virgulă<br />

mobilă. Acesta este motivul pentru care în toate dezvoltările numerice se preferă<br />

o structură mult mai robustă şi anume forma Schur reală sau complexă prezentată<br />

într-una din secţiunile următoare 5 .<br />

4.1.4 Valorile <strong>proprii</strong> ale matricelor <strong>si</strong>metrice şi hermitice<br />

Prezentăm în continuare câteva rezultate referitoare la valorile şi vectorii <strong>proprii</strong><br />

pentru matricele hermitice (<strong>si</strong>metrice). Matricele hermitice (<strong>si</strong>metrice) se întâlnesc<br />

în numeroase aplicaţii şi prezintă particularităţi remarcabile.<br />

Definiţia 4.4 Fie A ∈ IC n×n . Matricea A se numeşte normală dacă<br />

A H A = AA H . (4.19)<br />

În cazul real, matricea A ∈ IR n×n este normală dacă<br />

A T A = AA T . (4.20)<br />

În acest context reamintim că matricea A se numeşte hermitică dacă A H = A<br />

şi <strong>si</strong>metrică dacă A T = A. De asemenea, o matrice A ∈ IC n×n se numeşte unitară<br />

dacă A H A = I n şi ortogonală dacă A T A = I n .<br />

Se constată imediat că matricele hermitice şi cele unitare sunt matrice normale.<br />

Matricele hermitice au proprietatea că elementele <strong>si</strong>metrice faţă de diagonala principală<br />

sunt complex conjugate, i.e. a ij = ā ji , i,j ∈ 1 : n, deci elementele diagonale<br />

ale matricelor hermitice sunt reale. O matrice hermitică reală este <strong>si</strong>metrică. O<br />

matrice unitară reală este ortogonală. Prin urmare matricele reale <strong>si</strong>metrice sau<br />

ortogonale sunt normale. Există [ matrice ] normale care nu sunt nici <strong>si</strong>metrice nici<br />

1 −1<br />

ortogonale, de exemplu A = .<br />

1 1<br />

Prezentăm în continuare câteva rezultate fundamentale, urmând ca aspectele<br />

specifice legate de calculul efectiv al <strong>valorilor</strong> şi <strong>vectorilor</strong> <strong>proprii</strong> pentru matrice<br />

hermitice (<strong>si</strong>metrice) să fie date în două secţiuni distincte (§4.8 şi §4.9), iar cele<br />

legate de condiţionare şi stabilitate în §4.10 şi §4.11.<br />

Teorema 4.1 O matrice n×n complexă A este normală dacă şi numai dacă admite<br />

un set complet de n vectori <strong>proprii</strong> ortogonali, adică există o matrice unitară Q ∈<br />

∈ IC n×n ale cărei coloane sunt vectori <strong>proprii</strong> ai matricei A astfel încât<br />

Q H AQ = Λ = diag(λ 1 ,λ 2 ,...,λ n ) ∈ IC n×n . (4.21)<br />

5 Algoritmii de reducere la forma canonică Jordan, prezentaţi în unele lucrări de matematică<br />

(vezi, e.g. [XVI]) nu prezintă interes practic decât în contextul unor medii de calcul exact. Pentru<br />

detalii privitoare la aspectele numerice şi algoritmice ale calculului formei canonice Jordan, vezi<br />

secţiunea 4.7.

216 CAPITOLUL 4. VALORI ŞI VECTORI PROPRII<br />

Altfel spus, matricele normale sunt matricele unitar diagonalizabile (peste IC).<br />

În cazul real, matricea A este normală dacă şi numai dacă satisface aceleaşi<br />

condiţii, i.e. este unitar diagonalizabilă.<br />

Demonstraţie.<br />

Presupunem că matricea A este normală. Demonstrăm mai întâi următorul<br />

rezultat preliminar.<br />

Lema 4.1 Dacă S este un subspaţiu <strong>si</strong>multan A-invariant şi A H -invariant, atunci<br />

A şi A H admit un vector propriu comun x conţinut în S 6 . Dacă Ax = λx atunci<br />

A H x = ¯λx.<br />

Subspaţiul S fiind A-invariant, în conformitate cu propoziţia 4.1, punctul 2 ◦ , există<br />

un vector propriu x al matricei A (i.e. care satisface Ax = λx, x ≠ 0) conţinut în<br />

S. Din (4.19) rezultă imediat că A(A H ) k = (A H ) k A. Deci A(A H ) k x = λ(A H ) k x,<br />

k = 0,1,2,..., i.e. y k = (A H ) k x ≠ 0 sunt vectori <strong>proprii</strong> ai matricei A asociaţi<br />

aceleiaşi valori <strong>proprii</strong> λ. Cum subspaţiul S este şi A H -invariant rezultă că toţi<br />

vectorii y k sunt conţinuţi în S. Fie p întregul pentru care y 0 ,y 1 ,...,y p−1 sunt<br />

liniar independenţi, iar y p este o combinaţie liniară a acestora. Atunci, subspaţiul<br />

S ′ = ImY ⊂ S, unde Y = [y 0 y 1 ... y p−1 ] este A-invariant (conform propoziţiei<br />

4.1, punctul 1 ◦ ) şi, fiind generat de vectori <strong>proprii</strong> asociaţi aceleiaşi valori <strong>proprii</strong>,<br />

orice vector nenul din S ′ este vector propriu al lui A. Pe de altă parte, S ′ este<br />

şi A H -invariant întrucât ∀x = Yu ∈ S avem A H x = A H Yu = Yv ∈ S ′ . În<br />

consecinţă, conform propoziţiei 4.1, 2 ◦ , există o matrice B astfel încât A H Y = YB,<br />

de unde rezultă A H Yz = YBz = µYz pentru orice vector propriu z al ei asociat<br />

valorii <strong>proprii</strong> µ ∈ λ(B). Prin urmare, notând x = Yz avem A H x = µx cu µ ∈<br />

∈ λ(B) ⊂ λ(A H ). Altfel spus, există un vector propriu al matricei A H conţinut<br />

în S ′ . Cum toţi vectorii nenuli din S ′ sunt vectori <strong>proprii</strong> ai lui A, am arătat că<br />

matriceanormalăAşimatriceaA H au(cel puţin) un vectorpropriucomunconţinut<br />

în S ′ , deci şi în S. Mai mult, din Ax = λx şi A H x = µx cu acelaşi x ≠ 0, avem<br />

λ‖x‖ 2 = λx H x = x H Ax = (A H x) H x = (µx) H x = ¯µ‖x‖ 2 , de unde rezultă µ = ¯λ.<br />

Demonstraţia lemei este completă.<br />

Vom construi acum un set complet de vectori <strong>proprii</strong> ortogonali ai matricei<br />

normale A.<br />

Pasul 1 ◦ . Spaţiul IC n fiind <strong>si</strong>multan A- şi A H -invariant, conform lemei de mai sus<br />

matricele A şi A H admit un vector propriu comun x 1 care poate fi normat:<br />

Ax 1 = λ 1 x 1 , A H x 1 = ¯λ 1 x 1 , ‖x 1 ‖ = 1.<br />

Subspaţiul S 1 = Im[x 1 ] este <strong>si</strong>multan A-invariant şi A H -invariant. Conform propoziţiei<br />

4.1, 3 ◦ complementul său ortogonal T 1 = S ⊥ 1 în ICn este, de asemenea,<br />

<strong>si</strong>multan A- şi A H -invariant. În consecinţă matricele A şi A H admit un vector<br />

propriu (normat) comun x 2 ∈ T 1 , i.e. ortogonal cu x 1 :<br />

Ax 2 = λ 2 x 2 , A H x 2 = ¯λ 2 x 2 , ‖x 2 ‖ = 1, x 2 ⊥ x 1 .<br />

6 Un rezultat mai general este următorul: două matrice care comută admit un vector propriu<br />

comun (v. exerciţiul 4.7).

4.1. FORMULAREA PROBLEMEI 217<br />

Pasul k ◦ . Presupunem că am construit un set de k < n vectori <strong>proprii</strong> ortogonali<br />

x 1 , x 2 , ... ,x k ai matricei normale A (şi, <strong>si</strong>multan, ai matricei A H ). Subspaţiul<br />

S k = Im[x 1 x 2 ... x k ] este <strong>si</strong>multan A-invariant şi A H -invariant. Cu aceleaşi argumente,<br />

complementul său ortogonal T k = S ⊥ k în ICn este, de asemenea, <strong>si</strong>multan A-<br />

şi A H -invariant. În consecinţă, matricele A şi AH admit un vector propriu(normat)<br />

comun x k+1 ∈ T 1 , i.e. ortogonal cu x 1 , x 2 , ... ,x k :<br />

Ax k+1 = λ k+1 x k+1 , A H x k+1 = ¯λ k+1 x k+1 , ‖x k+1 ‖ = 1, x k+1 ⊥ S k .<br />

Procesul recurent de construcţie a <strong>vectorilor</strong> <strong>proprii</strong> ortogonali conduce după k =<br />

= n−1paşiladeterminareaunui setortogonalcompletdevectori<strong>proprii</strong>aimatricei<br />

A şi, <strong>si</strong>multan, ai matricei A H . Notând cu Q matricea <strong>vectorilor</strong> <strong>proprii</strong>, implicaţia<br />

directă este demonstrată.<br />

Reciproc, presupunem că matricea A admite un set complet de vectori <strong>proprii</strong><br />

ortogonali x i , i ∈ 1 : n, respectiv o matrice unitară Q def<br />

= X = [x 1 x 2 ··· x n ] de<br />

vectori <strong>proprii</strong>. Avem<br />

de unde rezultă<br />

X H AX = Λ = diag(λ 1 ,λ 2 ,...,λ n ) ∈ IC n×n ,<br />

X H A H X = ¯Λ.<br />

Din ultimele două relaţii avem Λ¯Λ = ¯ΛΛ = X H AA H X = X H A H AX, i.e. AA H =<br />

= A H A şi teorema este complet demonstrată. ✸<br />

Observaţia 4.1 Demonstraţiaprezentatămaisusevidenţiază,printrealtele,următoarele<br />

proprietăţi suplimentare ale matricelor normale:<br />

1 ◦ Dacă A este normală, atunci matricele A şi A H au aceiaşi vectori <strong>proprii</strong>.<br />

2 ◦ Dacă S este un subspaţiu A-invariant, atunci şi complementul său ortogonal<br />

în IC n este A-invariant.<br />

✸<br />

Teorema 4.2 O matrice n × n complexă A este hermitică dacă şi numai dacă<br />

admite un set complet de n vectori <strong>proprii</strong> ortogonali şi toate valorile <strong>proprii</strong> sunt<br />

reale adică există o matrice unitară Q, ale cărei coloane sunt vectori <strong>proprii</strong>, astfel<br />

încât<br />

Q H AQ = Λ = diag(λ 1 ,λ 2 ,...,λ n ) ∈ IR n×n . (4.22)<br />

Altfel spus, matricele hermitice sunt matricele unitar diagonalizabile cu spectru real.<br />

În cazul real matricea A este <strong>si</strong>metrică dacă şi numai dacă admite un set complet<br />

de n vectori <strong>proprii</strong> ortogonali reali şi toate valorile <strong>proprii</strong> sunt reale adică există<br />

o matrice ortogonală Q, ale cărei coloane sunt vectori <strong>proprii</strong>, astfel încât<br />

Q T AQ = Λ = diag(λ 1 ,λ 2 ,...,λ n ) ∈ IR n×n , (4.23)<br />

i.e. matricele reale <strong>si</strong>metrice 7 sunt matricele ortogonal diagonalizabile cu spectru<br />

real.<br />

7 Matricele complexe <strong>si</strong>metrice sunt matrice cu multe proprietăţi esenţial diferite de cele ale<br />

matricelor hermitice sau ale matricelor reale <strong>si</strong>metrice (vezi [I], [II] şi exerciţiul 4.31).

218 CAPITOLUL 4. VALORI ŞI VECTORI PROPRII<br />

Demonstraţie. Matricele hermitice fiind normale, conform teoremei precedente<br />

sunt unitar diagonalizabile, i.e. are loc (4.21). Acum, din A H = A rezultă că Λ H =<br />

Λ, i.e. spectrul este real. În cazul realaceastaare drept consecinţă faptul că vectorii<br />

<strong>proprii</strong> sunt reali. Reciproc, din (4.22) rezultă Λ H = Λ, i.e. Q H AQ = Q H A H Q, de<br />

unde obţinem A H = A.<br />

✸<br />

Faptul că matricele hermitice (în cazul real, <strong>si</strong>metrice) au spectrul real şi sunt<br />

unitar(ortogonal)diagonalizabileareimplicaţiimajoreasupratehnicilordecalculal<br />

<strong>valorilor</strong> <strong>proprii</strong>, a<strong>si</strong>gurând o complexitate relativ redusă a algoritmilor şi o precizie<br />

ridicată a rezultatelor. Pentru dezvoltarea algoritmilor de calcul se vor dovedi utile<br />

rezultatele prezentate în continuare. Formularea rezultatelor şi demonstraţiile vor<br />

fi prezentate pentru matricele hermitice, particularizarea pentru matricele reale<br />

<strong>si</strong>metrice (care se reduce, în esenţă, la înlocuirea mulţimii IC cu mulţimea IR şi<br />

a operatorului hermitic H cu operatorul de transpunere T ) fiind lăsată în sarcina<br />

cititorului.<br />

Fie matricea hermitică A ∈ IC n×n şi funcţia reală de n variabile complexe<br />

µ : IC\{0} → IR definită de µ(x) = xH Ax<br />

x H . Vom fi interesaţi de extremele funcţiei<br />

x<br />

µ. Pentru determinarea acestora, observăm mai întâi că µ(x) = µ(αx) pentru toţi<br />

α nenuli din IC. În consecinţă, este suficient să ne rezumăm la vectorii x de normă<br />

euclidiană unitară, i.e. să con<strong>si</strong>derăm funcţia<br />

µ : S → IR, x ↦→ µ(x) = x H Ax, (4.24)<br />

unde<br />

S = { x ∈ IC n ‖x‖ 2 = x H x = 1 } (4.25)<br />

estesferaderazăunitarădinIC n . Vomcon<strong>si</strong>deracăspectrulλ(A) = {λ 1 ,λ 2 ,...,λ n }<br />

al matricei A este ordonat descrescător, i.e.<br />

λ 1 ≥ λ 2 ≥ ... ≥ λ n , (4.26)<br />

şi fie q j ∈ IC n , j = 1 : n un set complet de vectori <strong>proprii</strong>, de normă euclidiană<br />

unitară, ai matricei A, asociaţi <strong>valorilor</strong> <strong>proprii</strong> λ j . Vom nota<br />

Q = [ ]<br />

q 1 q 2 ··· q n , Q<br />

′<br />

k = Q(:,1 : k), Q ′′<br />

k = Q(:,k +1 : n). (4.27)<br />

Avem următorul rezultat.<br />

Teorema 4.3 Valorile extreme absolute ale funcţiei µ definite în (4.24), (4.25) sunt<br />

date de<br />

M = max<br />

x ∈ S xH Ax = λ 1 , m = min<br />

x ∈ S xH Ax = λ n . (4.28)<br />

Mai mult, dacă W k = ImQ ′′<br />

k este subspaţiul A-invariant asociat <strong>valorilor</strong> <strong>proprii</strong><br />

λ j , j = k +1 : n, atunci<br />

max x H Ax = λ k+1 . (4.29)<br />

x ∈ S ∩W k

4.1. FORMULAREA PROBLEMEI 219<br />

Demonstraţie. Conform teoremei 4.2, matricea Q este unitară, A = QΛQ H unde<br />

Λ = diag(λ 1 ,λ 2 ,...,λ n ) şi, prin urmare,<br />

µ(x) = x H Ax = y H Λy =<br />

n∑<br />

λ k |y (k) | 2 , y = Q H x = [y (1) y (2) ··· y (n) ] T .<br />

k=1<br />

(4.30)<br />

Cum vectorii x şi y din (4.30) se află într-o relaţie biunivocă, iar transformările<br />

unitare conservă norma euclidiană, rezultă că extremele funcţiei µ coincid cu extremele<br />

funcţiei ν : S → IR, ν(y) = y H Λy. Din faptul că vectorii y sunt de normă<br />

unitară, i.e. ∑ n<br />

j=1 |y(j) | 2 = 1, rezultă<br />

ν(y) = λ 1 −<br />

n∑<br />

n−1<br />

∑<br />

(λ 1 −λ j )|y (j) | 2 = (λ j −λ n )|y (j) | 2 +λ n . (4.31)<br />

j=2<br />

Întrucât sumele din relaţia (4.31) sunt, datorită (4.26), nenegative, iar valoarea<br />

nulă a acestor sume se poate realiza, e.g. pentru y (j) = 0, j = 2 : n în primul<br />

caz şi j = 1 : n − 1 în cel de al doilea, avem egalităţile (4.28). Dacă valorile<br />

<strong>proprii</strong> maximă, respectiv minimă, sunt <strong>si</strong>mple, atunci valorile extreme ale funcţiei<br />

ν se ating pentru vectorii y de forma y 1 = [y (1) 0 ··· 0] T = e iθ1 e 1 , respectiv<br />

y n = [0 ··· 0 y (n) ] T = e iθn e n , cu θ 1 , θ n ∈ IR. Prin urmare, cele două extreme ale<br />

funcţiei µ se ating pentru vectorii x de forma x 1 = e iθ1 q 1 şi, respectiv x n = e iθn q n .<br />

Dacă λ 1 are multiplicitatea s, iar λ n multiplicitatea t, atunci maximul se atinge<br />

pentru orice vector x de normă unitară din V s = ImQ ′ s, i.e. subspaţiul A-invariant<br />

asociat <strong>valorilor</strong> <strong>proprii</strong> λ j , j = 1 : s, iar minimul se atinge pentru orice vector de<br />

normă unitară din W n−t .<br />

Pentru cea de a doua parte a teoremei, dacă x ∈ W k = V ⊥ k atunci xH Q ′ k = 0 şi<br />

y = Q H x = [0 ··· 0 y (k+1) ··· y (n) ] T . Prin urmare,<br />

µ(x) = ν(y) = λ k+1 −<br />

n∑<br />

j=k+2<br />

j=1<br />

de unde, cu aceleaşi argumente ca mai sus, se obţine (4.29).<br />

(λ k+1 −λ j )|y (j) | 2 , (4.32)<br />

Rezultatul următor prezintă o interesantă caracterizareminimax a <strong>valorilor</strong><strong>proprii</strong><br />

ale unei matrice hermitice (în cazul real, <strong>si</strong>metrice) şi este util prin consecinţele<br />

sale. Notăm, generic, cu V subspaţiile liniare ale spaţiului IC n şi cu W = V ⊥ complementele<br />

lor ortogonale în IC n . De asemenea, vom nota cu V S = V ∩S şi, respectiv,<br />

W S = W ∩S, mulţimile <strong>vectorilor</strong> de normă euclidiană unitară din V şi W.<br />

Teorema 4.4 (Courant – Fisher) Dacă matricea hermitică A ∈ IC n×n are valorile<br />

<strong>proprii</strong> ordonate ca în (4.26) atunci pentru toţi k ∈ 1 : n avem<br />

λ k = max<br />

dimV = k<br />

min x H Ax = min<br />

x ∈ V S dimV = k<br />

✸<br />

max x H Ax 8 . (4.33)<br />

x ∈ W S<br />

8 Întrucât oricărui subspaţiu n − k dimen<strong>si</strong>onal din IC n îi corespunde un complement ortogonal<br />

k dimen<strong>si</strong>onal, ultimul termen al egalităţilor (4.33) poate fi scris şi în forma λ k =<br />

= min dimV = n−k max x ∈ VS x H Ax.

220 CAPITOLUL 4. VALORI ŞI VECTORI PROPRII<br />

Demonstraţie. Fie V un subspaţiu arbitrar de dimen<strong>si</strong>une k şi v j , j = 1 : k, o bază<br />

a lui V. Fie, de asemenea, w j , j = 1 : n−k, o bază a lui W. Notăm cu V ∈ IC k ,<br />

respectiv W ∈ IC n−k , matricele <strong>vectorilor</strong> care formează bazele celor două subspaţii<br />

complementare. Conform teoremei precedente<br />

λ n ≤ x H Ax ≤ λ 1 (4.34)<br />

pentru toţi x din S, i.e. funcţia µ este mărginită pe compactul V S şi, în consecinţă,<br />

îşi atinge marginile pe această mulţime. La fel ca în demonstraţia teoremei precedente,<br />

fie y = Q H x, unde Q este o matrice unitară de vectori <strong>proprii</strong>, ordonaţi<br />

conform (4.26). Avem, evident, ‖y‖ = ‖x‖ şi x = Qy ∈ V dacă şi numai dacă este<br />

ortogonal pe W, i.e.<br />

W H x = W H Qy = 0. (4.35)<br />

[ ]<br />

Întrucât W este monică, factorizarea QR a matricei ˜W = Q H W = ˜Q R<br />

are<br />

0<br />

matriceasuperior triunghiularăR ∈ IC (n−k)×(n−k) ne<strong>si</strong>ngulară. În consecinţă, (4.35)<br />

devine [<br />

R H 0 ] ˜QH y = 0. (4.36)<br />

Notând z def<br />

= ˜Q H y relaţia (4.36) impune z(1 : n−k) = 0. Notând, încă o dată,<br />

u def<br />

= z(n−k +1 : n) ∈ IC k şi ţinând seama de faptul că transformările unitare<br />

conservă norma euclidiană, din (4.35), (4.36) rezultă că x = Qy = Q˜Qz = ˆQu, unde<br />

ˆQ = Q˜Q(:,n−k+1 : n), aparţine mulţimii V S dacă şi numai dacă ‖u‖ = 1, fără<br />

nici o altă restricţie asupra lui u. Acum, putem alege u astfel încât y(1 : k−1) = 0.<br />

Într-adevăr, y = ˜Q(:,n−k+1: n)u şi orice soluţie normată(i.e. de normă euclidiană<br />

unitară)a<strong>si</strong>stemuluisubdeterminat ˆQ(1 : k−1,,n−k+1 : n)u = 0a<strong>si</strong>gurăsatisfacerea<br />

acestei condiţii. Cu această alegere a lui u, pentru vectorul corespunzător x din V S ,<br />

avem<br />

n∑<br />

µ(x) = x H Ax = y H Λy = λ k − (λ k −λ j )|y (j) | 2 ≤ λ k , (4.37)<br />

j=k+1<br />

unde am ţinut seama de faptul că ∑ n<br />

j=k |y(j) | 2 = ‖y‖ 2 = 1 şi de ordonarea descrescătoare<br />

a <strong>valorilor</strong> <strong>proprii</strong>. Natural, din (4.37) rezultă<br />

min x H Ax ≤ λ k (4.38)<br />

x ∈ V S<br />

şi, cum subspaţiul V, de dimen<strong>si</strong>une k, era arbitrar, inegalitatea (4.38) are loc în<br />

toate subspaţiile de aceeaşi dimen<strong>si</strong>une sau, altfel spus,<br />

max<br />

dimV = k<br />

min x H Ax ≤ λ k . (4.39)<br />

x ∈ V S<br />

Rămâne să arătăm că această margine este atinsă efectiv. Aceasta se întâmplă în<br />

subspaţiul A-invariant asociat primelor k valori <strong>proprii</strong> din secvenţa (4.26). Întradevăr,<br />

fie V = ImQ ′ k şi x = Q′ k z cu ‖z‖ = 1. Rezultă ‖x‖ = 1, i.e. x ∈ V S şi<br />

k−1<br />

∑<br />

µ(x) = x H Ax = (λ j −λ k )|z (j) | 2 +λ k ≥ λ k , (4.40)<br />

j=1

4.1. FORMULAREA PROBLEMEI 221<br />

de unde, în acest subspaţiu,<br />

min x H Ax ≥ λ k (4.41)<br />

x ∈ V S<br />

egalitatea obţinându-se pentru z = [0 ··· 0 1] T . Prima egalitate din (4.33) este<br />

demonstrată. Demonstraţia celei de a doua egalităţi (4.33) urmează aceleaşi idei.<br />

Întrucât dimW = n−k, există un vector x ∈ W S astfel încât vectorul y = Q H x are<br />

componentele k+1 : n nule (demonstraţi!). Pentru această alegere a lui x avem o<br />

relaţie de forma (4.40)<br />

de unde rezultă<br />

k−1<br />

∑<br />

µ(x) = x H Ax = y H Λy = (λ j −λ k )|y (j) | 2 +λ k ≥ λ k , (4.42)<br />

j=1<br />

max x H Ax ≥ λ k . (4.43)<br />

x ∈ W S<br />

Cum subspaţiul (n−k)-dimen<strong>si</strong>onal W a fost arbitrar, rezultă că inegalitatea (4.43)<br />

are loc în toate subspaţiile de această dimen<strong>si</strong>une sau, altfel spus,<br />

min<br />

dimV = k<br />

max x H Ax ≥ λ k . (4.44)<br />

x ∈ W S<br />

Adăugând faptul că marginea din (4.44) se atinge efectiv în subspaţiul W = ImQ ′′<br />

k ,<br />

cea de a doua egalitate (4.33), şi o dată cu ea întreaga teoremă, sunt complet<br />

demonstrate.<br />

✸<br />

Teorema Courant – Fisher este importantă, în contextul calculatoriu al acestei<br />

lucrări, prin consecinţele sale, dintre care câteva sunt prezentate în continuare.<br />

Notăm A [k] def<br />

= A(1:k,1:k) submatricele lider principale de ordinul k ale matricei<br />

hermitice A ∈ IC n×n , care sunt la rândul lor, evident, hermitice. Presupunem<br />

că spectrele λ(A [k] ) = {λ [k]<br />

1 ,λ[k] 2 ,...,λ[k] k<br />

} (evident, reale) ale submatricelor lider<br />

principale sunt, şi ele, ordonate descrescător, i.e.<br />

λ [k]<br />

1 ≥ λ [k]<br />

2 ≥ ... ≥ λ [k]<br />

k . (4.45)<br />

Teorema 4.5 (Teoremade separare) Valorile <strong>proprii</strong> ale submatricelor lider principale<br />

de ordinul k ale unei matrice hermitice separă valorile <strong>proprii</strong> ale submatricelor<br />

lider principale de ordinul k +1, i.e.<br />

λ [k+1]<br />

1 ≥ λ [k]<br />

1 ≥ λ [k+1]<br />

2 ≥ λ [k]<br />

2 ≥ ... ≥ λ [k]<br />

k−1 ≥ λ[k+1] k<br />

≥ λ [k]<br />

k ≥ λ[k+1] k+1 , (4.46)<br />

pentru toţi k ∈ 1 : n−1.<br />

Demonstraţie. Este suficient să con<strong>si</strong>derăm cazul k = n−1. Pentru <strong>si</strong>mplificarea<br />

notaţiilor, fie λ ′ def<br />

i = λ [n−1]<br />

i , i = 1 : n−1. Cu aceste notaţii, este suficient să dovedim<br />

inegalităţile<br />

λ i ≥ λ ′ i ≥ λ i+1 , i = 1 : n−1. (4.47)

222 CAPITOLUL 4. VALORI ŞI VECTORI PROPRII<br />

Avem, evident,<br />

x H A [n−1] x = [ x H<br />

0 ] [ x<br />

A<br />

0<br />

]<br />

, ∀x ∈ IC n−1 . (4.48)<br />

Pe această bază, între mulţimile<br />

M i = { µ ∈ IR<br />

µ = max x∈WS x H Ax, W ⊂ IC n , dimW = n−i<br />

}<br />

, (4.49)<br />

M ′ i ={ µ ′ ∈ IR µ ′ =max x∈WS x H A [n−1] x, W ⊂ IC n−1 , dimW = n−1−i } ,<br />

(4.50)<br />

există relaţiile<br />

M i ⊆ M ′ i ⊆ M i+1, (4.51)<br />

de unde rezultă<br />

minM i+1 ≤ minM ′ i ≤ minM i , (4.52)<br />

inegalităţi care, în baza teoremei Courant-Fisher, sunt echivalente cu (4.47). Teorema<br />

este demonstrată.<br />

✸<br />

O relaţie dintre valorile <strong>proprii</strong> a două matrice hermitice şi valorile <strong>proprii</strong> ale<br />

sumei lor, utilă în aprecierea influenţei perturbaţiilor numerice hermitice, este dată<br />

în teorema următoare.<br />

Teorema 4.6 Dacă matricele hermitice A,E ∈ IC n×n au spectrele ordonate descrescător,<br />

atunci, cu notaţii evidente, avem<br />

pentru toţi k ∈ 1 : n.<br />

λ k (A)+λ 1 (E) ≥ λ k (A+E) ≥ λ k (A)+λ n (E) (4.53)<br />

Demonstraţie. Conform teoremei Courant-Fisher<br />

λ k (A+E) =<br />

≤<br />

≤<br />

min<br />

dimV = k<br />

max x H (A+E)x ≤<br />

x ∈ W S<br />

min<br />

dimV = k ( x max x H Ax+ max x H Ex) ≤<br />

∈ W S x ∈ W S<br />

min<br />

dimV = k ( x max x H Ax+λ 1 (E)) = λ k (A)+λ 1 (E). (4.54)<br />

∈ W S<br />

Pentru a demonstra a doua inegalitate (4.53) avem, <strong>si</strong>milar,<br />

λ k (A+E) = max<br />

dimV = k<br />

min x H (A+E)x ≥<br />

x ∈ V S<br />

≥ max<br />

dimV = k ( min<br />

x ∈ V S<br />

x H Ax+ min<br />

x ∈ V S<br />

x H Ex) ≥<br />

≥ max<br />

dimV = k ( x min x H Ax+λ n (E)) = λ k (A)+λ n (E).<br />

∈ V S<br />

(4.55)<br />

Teorema este demonstrată.<br />

✸<br />

În sfârşit, cu notaţiile utilizate în teorema 4.8, formulăm următorul rezultat<br />

util, de asemenea, în evaluarea influenţelor perturbaţiilor numerice asupra <strong>valorilor</strong><br />

<strong>proprii</strong> ale matricelor hermitice.

4.1. FORMULAREA PROBLEMEI 223<br />

Teorema 4.7 (Wielandt – Hoffmann) Dacă matricele A,E ∈ IC n×n sunt hermitice,<br />

atunci<br />

n∑<br />

(λ j (A+E)−λ j (A)) 2 ≤ ‖E‖ 2 F, (4.56)<br />

∑ i−1<br />

j=1 |e ij| 2 = √ ∑ n<br />

i=1 λ2 i (E) este norma Fro-<br />

unde ‖E‖ F =<br />

benius a matricei E.<br />

j=1<br />

√ ∑n<br />

i=1 |e ii| 2 +2 ∑ n<br />

i=2<br />

Demonstraţie. Pentru demonstraţie se poate consulta [IV].<br />

Un rezultat remarcabil, de o factură aparte, se referă la inerţia unei matrice.<br />

Inerţia unei matrice hermitice A ∈ IC n×n se defineşte prin tripletul (n − ,n 0 ,n + )<br />

unde n − este numărul <strong>valorilor</strong> <strong>proprii</strong> negative, n 0 este numărul <strong>valorilor</strong> <strong>proprii</strong><br />

nule şi, respectiv, n + este numărul <strong>valorilor</strong> <strong>proprii</strong> pozitive ale matricei A. De<br />

asemenea, se spune că două matrice (hermitice) A,B ∈ IC n×n sunt congruente dacă<br />

există o matrice ne<strong>si</strong>ngulară T ∈ IC n×n astfel încât B = T H AT. Rezultatul, datorat<br />

lui Sylvester, are următorul enunţ.<br />

Teorema 4.8 Două matrice hermitice congruente au aceeaşi inerţie.<br />

Demonstraţie. Fie A ∈ IC n×n hermitică, B = T H AT cu T ne<strong>si</strong>ngulară şi λ k (A)<br />

o valoare proprie nenulă a matricei A. Presupunem că spectrele matricelor A şi B<br />

sunt ordonate descrescător. Conform teoremei Courant-Fisher avem<br />

λ k (B) = max<br />

dimV = k<br />

min x H Bx ≥ min x H x H Bx<br />

Bx = min<br />

x ∈ V S x ∈ ṼS x ∈ Ṽ∗ x H x , (4.57)<br />

unde Ṽ este orice subspaţiu particular de dimen<strong>si</strong>une k, iar Ṽ∗ = Ṽ \ {0}. Con<strong>si</strong>derând<br />

Ṽ = ImT−1 Q ′ k , cu Q′ k definit în (4.27), avem x ∈ Ṽ∗ dacă şi numai dacă<br />

x = T −1 Q ′ k z cu z ∈ ICk , z ≠ 0. Pe de altă parte, matricea R def<br />

= TT H este hermitică,<br />

pozitiv definită (i.e. x H Rx > 0, ∀x ≠ 0) şi, prin urmare, are spectrul real şi<br />

pozitiv (demonstraţi!) aceleaşi proprietăţi avându-le şi matricea R −1 = T −H T −1 .<br />

Cu aceste precizări, pentru toţi x ∈ Ṽ∗ , avem<br />

{<br />

x H Bx = x H T H QΛ A Q H Tx = z H diag(λ 1 (A),λ 2 (A),...,λ k (A))z<br />

x H x = z H Q ′H<br />

k R−1 Q ′ k z, , (4.58)<br />

de unde, ţinând seama de ordonarea <strong>valorilor</strong> <strong>proprii</strong>, rezultă<br />

✸<br />

Cu aceste inegalităţi, din (4.57), obţinem<br />

⎧<br />

⎪⎨<br />

⎪⎩<br />

x H Bx ≥ λ k (A)z H z<br />

λ min (R −1 )z H z ≤ x H x ≤ λ max (R −1 )z H z.<br />

λ k (B) ≥<br />

λ k(A)<br />

λ max (R −1 ) , dacă λ k(A) > 0<br />

λ k (B) ≥ λ k(A)<br />

λ min (R −1 ) , dacă λ k(A) < 0.<br />

(4.59)<br />

(4.60)

224 CAPITOLUL 4. VALORI ŞI VECTORI PROPRII<br />

Schimbând rolul matricelor A şi B, cu un raţionament analog obţinem următoarele<br />

corespondente ale relaţiilor (4.60)<br />

{<br />

λk (B) ≤ λ max (R)λ k (A), dacă λ k (A) > 0<br />

(4.61)<br />

λ k (B) ≤ λ min (R)λ k (A), dacă λ k (A) < 0.<br />

În concluzie, în toate cazurile, αλ k (A) ≤ λ k (B) ≤ βλ k (A) cu α > 0, β > 0, i.e.<br />

λ k (A) şi λ k (B) au acelaşi semn. Rezultă că A şi B au aceeaşi inerţie. ✸<br />

În contextul acestuiparagrafeste natural săintroducem matriceleantihermitice,<br />

respectiv anti<strong>si</strong>metrice în cazul real.<br />

Definiţia 4.5 Matricea A ∈ IC n×n se numeşte antihermitică dacă<br />

A H = −A. (4.62)<br />

În cazul real, matricea A ∈ IR n×n se numeşte anti<strong>si</strong>metrică dacă<br />

A T = −A. (4.63)<br />

O matrice antihermitică are elementele diagonale pur imaginare. Este uşor de observat<br />

că dacă matricea complexă A este antihermitică, atunci matricea B = −iA<br />

este hermitică. În consecinţă, A este unitar diagonalizabilă şi are toate valorile<br />

<strong>proprii</strong> pur imaginare. Matricele antihermitice sunt normale.<br />

În cazul real, o matrice anti<strong>si</strong>metrică are elementele diagonale nule. Dacă A<br />

este anti<strong>si</strong>metrică, atunci B = −iA este o matrice complexă hermitică. Rezultă<br />

că A este unitar diagonalizabilă şi are toate valorile <strong>proprii</strong> pur imaginare. Cum,<br />

în această <strong>si</strong>tuaţie, valorile <strong>proprii</strong> apar în perechi complex conjugate rezultă că o<br />

matrice anti<strong>si</strong>metrică de ordin impar are, în mod necesar, o valoare proprie nulă,<br />

i.e. este <strong>si</strong>ngulară. Evident, o matrice anti<strong>si</strong>metrică este normală.<br />

Ultimulrezultatpecareîlprezentămsereferălavalorileşivectorii<strong>proprii</strong>pentru<br />

matricele unitare şi ortogonale.<br />

Teorema 4.9 O matrice n×n complexă A este unitară dacă şi numai dacă admite<br />

un set complet de n vectori <strong>proprii</strong> ortogonali şi toate valorile <strong>proprii</strong> sunt de modul<br />

unitar, adică este unitar diagonalizabilă cu spectru unitar, respectiv există o matrice<br />

unitară Q ∈ IC n×n astfel încât<br />

Q H AQ = Λ = diag(λ 1 ,λ 2 ,...,λ n ) cu |λ i | = 1, ∀ λ i . (4.64)<br />

În cazul real matricea A este ortogonală dacă şi numai satisface aceleaşi condiţii,<br />

i.e. este unitar diagonalizabilă cu spectru unitar.<br />

Demonstraţie. O matrice unitară A ∈ IC n×n fiind normală, conform teoremei<br />

4.1, este unitar diagonalizabilă, i.e. există o matrice unitară Q ∈ IC n×n astfel încât<br />

Q H AQ = Λ = diag(λ 1 ,λ 2 ,...,λ n ), de unde rezultă A = QΛQ H . În plus, din<br />

A H A = I n obţinem ¯ΛΛ = I n , i.e. ¯λj λ j = |λ j | 2 = 1, de unde rezultă |λ j | = 1,<br />

j = 1 : n. Deci toate valorile <strong>proprii</strong> sunt de modul unitar, i.e. pot fi scrise sub<br />

forma λ j = e iθj , cu θ j ∈ IR, j = 1 : n. Reciproc, dacă avem Q H AQ = Λ, cu Q

4.1. FORMULAREA PROBLEMEI 225<br />

unitară şi Λ diagonală cu elementele diagonale de modul unitar, atunci prin calcul<br />

direct rezultă imediat A H A = I n , i.e. A este unitară. În cazul real demonstraţia<br />

este identică cu <strong>si</strong>ngura menţiune suplimentară că alături de orice valoare proprie<br />

complexă λ j = e iθj ∈ IC\IR apare şi conjugata ei λ j = e −iθj . ✸<br />

Observaţia 4.2 Este <strong>si</strong>mplu de constatat că dacă o matrice complexă A este<br />

normală, hermitică sau unitară, atunci orice matrice B unitar asemenea cu A are<br />

aceleaşi proprietăţi. Similar, în cazul real, proprietăţile de normalitate, <strong>si</strong>metrie şi<br />

ortogonalitate sunt conservate de transformările ortogonale de asemănare. Această<br />

invarianţă explică utilizarea exclu<strong>si</strong>vă a transformărilor unitare (ortogonale) în demersul<br />

calculatoriu legat de valorile şi vectorii <strong>proprii</strong>.<br />

✸<br />

Încheiem acest paragraf cu precizarea că principala proprietate comună a celor<br />

trei tipuri de matrice menţionate mai sus, indusă de proprietatea de normalitate,<br />

constă în faptul că toate admit seturi complete de vectori <strong>proprii</strong> ortogonali, fapt<br />

care le conferă o perfectă condiţionare a spectrelor de valori <strong>proprii</strong> (v. § 4.10).<br />

4.1.5 Localizarea <strong>valorilor</strong> <strong>proprii</strong><br />

În finalul acestei secţiuni introductive vom prezenta câteva rezultate privitoare la<br />

localizarea <strong>valorilor</strong> <strong>proprii</strong> în planul complex, rezultate utile atât prin ele însele cât<br />

şi în contextul stabilirii iniţializărilor pentru diverse metode iterative de calcul sau<br />

al analizei sen<strong>si</strong>bilităţii <strong>valorilor</strong> <strong>proprii</strong> la perturbaţii în matricea dată.<br />

Unele din cele mai cunoscute rezultate în această privinţă sunt oferite de teoremele<br />

următoare.<br />

Teorema 4.10 Oricare ar fi matricea A ∈ IC n×n şi ‖·‖ o familie arbitrară de norme<br />

con<strong>si</strong>stente avem<br />

ρ(A) ≤ ‖A‖. (4.65)<br />

Demonstraţie. Din proprietatea de con<strong>si</strong>stenţă a familiei de norme pentru orice<br />

λ ∈ λ(A) şi vector propriu asociat x cu ‖x‖ = 1 avem |λ| = ‖λx‖ = ‖Ax‖ ≤<br />

≤ ‖A‖‖x‖ = ‖A‖, de unde rezultă (4.65) 9 .<br />

✸<br />

Teorema 4.11 (Gershgorin) Valorile <strong>proprii</strong> ale unei matrice A ∈ IC n×n sunt <strong>si</strong>tuate<br />

în domeniul D din planul complex definit de<br />

D =<br />

n⋃<br />

D i , (4.66)<br />

i=1<br />

9 Există şi un rezultat, datorat lui Householder (v. exerciţiul 4.32), care arată că pentru<br />

orice ε > 0 există o normă con<strong>si</strong>stentă ‖ · ‖ astfel încât ‖A‖ ≤ ρ(A) + ε, relaţie care, împreună<br />

cu (4.65), permite aproximarea oricât de bună a razei spectrale a unei matrice cu ajutorul unei<br />

norme a acesteia. Din păcate, această normă este o normă specială care depinde de A şi ε, astfel<br />

că rezultatul menţionat are o valoare în primul rând teoretică.

226 CAPITOLUL 4. VALORI ŞI VECTORI PROPRII<br />

unde D i sunt discurile<br />

numite discuri Gershgorin.<br />

D i = {z ∈ IC | |z −a ii | ≤<br />

n∑<br />

|a ij |}, i = 1 : n, (4.67)<br />

j=1<br />

j≠i<br />

Demonstraţie. Fie x un vector propriu asociat valorii <strong>proprii</strong> λ ∈ λ(A). Atunci<br />

linia i a relaţiei Ax = λx se scrie<br />

(λ−a ii )x i =<br />

n∑<br />

a ij x j , (4.68)<br />

de unde rezultă |λ − a ii ||x i | ≤ ∑ n<br />

j=1 |a ij ||x j |. Alegând linia i astfel încât |x i | =<br />

j≠i<br />

= max k=1:n (|x k |) ≠ 0, rezultă<br />

|λ−a ii | ≤<br />

j=1<br />

j≠i<br />

n∑<br />

|a ij | |x j|<br />

n<br />

|x i | ≤ ∑<br />

|a ij |, (4.69)<br />

j=1<br />

j≠i<br />

j=1<br />

j≠i<br />

i.e. λ ∈ D i .<br />

✸<br />

Dacă o linie a matricei A are elementele extradiagonale nule, atunci elementul<br />

diagonal este o valoare proprie a matricei A, iar discul Gershgorin corespunzător<br />

liniei respective se reduce la punctul {a ii }. De asemenea, se poate arăta [I] că dacă<br />

m discuri Gershgorin formează o mulţime disjunctă de mulţimea celorlalte n −m<br />

discuri, atunci exact m valori <strong>proprii</strong> se găsesc <strong>si</strong>tuate în reuniunea celor m discuri.<br />

În particular, un disc disjunct de celelalte conţine exact o valoare proprie 10 .<br />

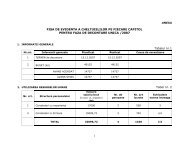

✻Imλ<br />

✻Imλ<br />

✬✩ ✬✩<br />

λ 2<br />

✓✏ ✓✏ ✓✏λ 2<br />

✓✏<br />

× λ 1 Reλ<br />

× ✲ × λ 1 Reλ<br />

× ✲<br />

×<br />

×<br />

λ 3 ✒✑ ✒✑ ✒✑λ 3 ✒✑<br />

✫✪ ✫✪<br />

a) b)<br />

Fig. 4.2: Utilizarea discurilor Gershgorin ”pe linii” (a) şi ”pe coloane” (b) pentru<br />

localizarea <strong>valorilor</strong> <strong>proprii</strong> ai matricei din exemplul 4.2.<br />

10 Discurile Gershgorin (4.67) ar putea fi denumite discuri-linie întrucât sunt construite cu<br />

ajutorul liniilor matricei date. Cum transpusa matricei are acelaşi spectru, aplicând teorema<br />

4.11 matricei transpuse obţinem o localizare a <strong>valorilor</strong> <strong>proprii</strong> în reuniunea discurilor Gershgorin<br />

definite pe coloane. Evident, o localizare mai bună se obţine intersectând cele două domenii.

4.2. FORMA SCHUR 227<br />

Exemplul 4.2 Con<strong>si</strong>derăm matricea<br />

⎡<br />

A =<br />

⎣ 1 0 1<br />

1 5 0<br />

−1 1 −1<br />

pentru care cele trei discuri Gershgorinsunt D 1 de centru 1 şi rază1, D 2 de centru 5<br />

şirază1şiD 3 decentru-1şirază2(v. fig. 4.2), iarvalorile<strong>proprii</strong>suntλ 1 = 5.0394,<br />

λ 2,3 = −0.0197± 0.4450i. Raza spectrală este deci ρ(A) = 5.0394, inferioară e.g.<br />

normei ‖A‖ F<br />

= 5.5678.<br />

✸<br />

Teoremalui Gershgorineste utilă, de exemplu, pentru deciziile de neglijareaelementelor<br />

extradiagonale la o precizie fixată a <strong>valorilor</strong> <strong>proprii</strong> calculate în tehnicile<br />

de diagonalizareiterativăprintransformăride asemănare. Generalizărialeteoremei<br />

4.11 fac obiectul exerciţiilor 4.40 şi 4.41. Alte rezultate privind localizarea <strong>valorilor</strong><br />

<strong>proprii</strong> se pot gă<strong>si</strong> în [I], [II].<br />

⎤<br />

⎦<br />

4.2 Forma Schur<br />

Transformările de asemănare unitare, respectiv ortogonale în cazul real, prezintă<br />

marele avantaj de a conserva condiţionarea spectrului de valori <strong>proprii</strong> ale unei<br />

matrice date (v. §4.10). De aceea vom fi interesaţi în utilizarea lor exclu<strong>si</strong>vă pentru<br />

determinarea <strong>valorilor</strong> <strong>proprii</strong>. Pe de altă parte, structurile canonice, cum este<br />

formaJordan, nuse pot obţine, îngeneral, prin astfelde transformări 11 . Rezultatul<br />

principalalacestuiparagrafaratăcăoricematriceesteunitar asemeneacuomatrice<br />

triunghiulară, numită forma Schur. În acest fel este po<strong>si</strong>bilă evidenţierea <strong>valorilor</strong><br />

<strong>proprii</strong> ale unei matrice (elementele diagonale ale formei sale Schur), utilizând o<br />

secvenţă de transformări unitare de asemănare.<br />

4.2.1 Forma Schur (complexă)<br />

<strong>Calculul</strong> <strong>valorilor</strong> <strong>proprii</strong> ale unei matrice este intim legat de calculul <strong>vectorilor</strong><br />

<strong>proprii</strong> asociaţi. Dacă λ ∈ λ(A) este cunoscută, atunci vectorul propriu asociat este<br />

o soluţie nenulă a unui <strong>si</strong>stem liniar omogen. Dacă se cunoaşte un vector propriu x<br />

al matricei A, atunci valoarea proprie asociată poate fi calculată cu relaţia<br />

x H Ax<br />

x H x = xH λx<br />

x H x = λ (4.70)<br />

care, pentru x de normă euclidiană unitară, i.e. ‖x‖ = 1, devine<br />

λ = x H Ax. (4.71)<br />

Întrucât valorile <strong>proprii</strong> sunt rădăcinile unei ecuaţii algebrice, calculul lor pentru<br />

matrice de ordin superior lui patru, în absenţa cunoaşterii <strong>vectorilor</strong> <strong>proprii</strong>, este<br />

11 Matricele normale, care sunt unitar diagonalizabile (v. teorema 4.10), nu constituie un caz<br />

generic.

228 CAPITOLUL 4. VALORI ŞI VECTORI PROPRII<br />

în mod necesar un proces (iterativ) infinit, aceeaşi <strong>si</strong>tuaţie apărând şi la calculul<br />

<strong>vectorilor</strong> <strong>proprii</strong> fără a se cunoaşte valorile <strong>proprii</strong> asociate.<br />

De aceea, una din ideile aflate la baza a<strong>si</strong>gurării eficienţei tehnicilor de calcul<br />

a <strong>valorilor</strong> şi <strong>vectorilor</strong> <strong>proprii</strong> este exploatarea rezultatelor parţiale prin reducerea<br />

corespunzătoare a dimen<strong>si</strong>unii problemei. În sprijinul aplicării acestei idei vin<br />

următoarele rezultate.<br />

Propoziţia 4.2 Fie A ∈ IC n×n şi X ⊂ IC n un subspaţiu A-invariant p-dimen<strong>si</strong>onal<br />

dat printr-o bază ortogonală x 1 , x 2 , ..., x p . Atunci există o matrice unitară Q ∈<br />

∈ IC n×n cu Q(:,j) = x j , j = 1:p, astfel încât<br />

[ ]<br />

Q H S11 S<br />

AQ = 12<br />

, (4.72)<br />

0 S 22<br />

cu S 11 ∈ IC p×p .<br />

În cazul real, i.e. A ∈ IR n×n şi X ⊂ IR n , matricea Q poate fi reală (i.e. ortogonală),<br />

iar matricea reală Q T AQ are structura (4.72).<br />

Demonstraţie. Fie Q(:,1:p) = X def<br />

= [x 1 x 2 ··· x p ] şi Y ∈ IC n×(n−p) o bază<br />

ortogonală a complementului ortogonal Y = X ⊥ al lui X în IC n . Atunci matricea<br />

Q = [X Y ] este unitară. Conform propoziţiei 4.1, punctul 2 ◦ , există o matrice<br />

S 11 ∈ IC p×p cu λ(S 11 ) ⊂ λ(A) astfel încât AX = XS 11 , i.e. X H AX = S 11 . În plus<br />

Y H AX = Y H XS 11 = 0. În consecinţă avem<br />

[ ]<br />

S=Q H X<br />

H<br />

AQ=<br />

Y H A [ X Y ] [ ] [ ]<br />

X<br />

=<br />

H AX X H AY S11 S<br />

Y H AX Y H = 12<br />

AY 0 S 22<br />

(4.73)<br />

unde, evident, S 12 = X H AY, S 22 = Y H AY. q.e.d.<br />

În cazul real, conform aceleiaşi propoziţii 4.1, toate subspaţiile implicate în<br />

demonstraţia de mai sus sunt în IR n , iar matricea Q este ortogonală. Evident, în<br />

acest caz spectrul matricei S 11 este o submulţime <strong>si</strong>metrică a spectrului matricei A.<br />

Demonstraţia este completă.<br />

✸<br />

Observaţia 4.3 <strong>Calculul</strong>matriceiunitaredeasemănareQestecondiţionatesenţial<br />

de cunoaşterea unei baze V = [v 1 v 2 ··· v p ] a subspaţiului A-invariant X. În acest<br />

caz, construcţia unei baze ortogonale X a lui X şi a unei completări ortogonale Y<br />

se poate face după recomandările din capitolul 3. Concret, dacă<br />

[ ]<br />

R1<br />

V = Q<br />

0<br />

este factorizarea QR (complexă) a matricei V, unde Q ∈ IC n×n este unitară, iar<br />

R 1 ∈ IC p×p este ne<strong>si</strong>ngulară, atunci X = Q(:,1 : p), Y = Q(:,p +1 : n) sunt<br />

cele două baze ortogonale căutate, iar Q este matricea de transformare unitară de<br />

asemănare din (4.72).<br />

✸<br />

Pentru p = 1 baza V a subspaţiului A-invariant din propoziţia 4.2 se reduce<br />

la un vector propriu x de normă unitară asociat valorii <strong>proprii</strong> λ. În acest caz<br />

propoziţia 4.2 se particularizează în următoarea lemă.

4.2. FORMA SCHUR 229<br />

Lema 4.2 (Deflaţie unitară) Fie A ∈ IC n×n şi λ ∈ λ(A). Atunci există o matrice<br />

unitară Q ∈ IC n×n astfel încât<br />

[ ] λ<br />

Q H S12<br />

AQ = . (4.74)<br />

0 S 22<br />

Conform observaţiei 4.3, matricea de transformare poate fi Q = U H 1 , unde U 1 este<br />

reflectorul (complex) care anulează elementele 2 : n ale vectorului propriu x asociat<br />

valorii <strong>proprii</strong> λ.<br />

Aplicarea consecventă a lemei 4.2 ne conduce la următorul rezultat important.<br />

Teorema 4.12 (Forma Schur) Oricare ar fi matricea A ∈ IC n×n există o matrice<br />

unitară Q ∈ IC n×n astfel încât matricea<br />

Q H AQ = S, (4.75)<br />

este superior triunghiulară. Elementele diagonale ale matricei S sunt valorile <strong>proprii</strong><br />

ale matricei A şi pot fi dispuse în orice ordine predeterminată.<br />

Matricea S se numeşte forma Schur (FS) a matricei A, iar coloanele matricei<br />

de transformare Q se numesc vectori Schur ai matricei A asociaţi formei Schur S.<br />

Demonstraţie. Pasul 1 ◦ . Conform lemei 4.2, dacă λ 1 ∈ λ(A), atunci există o<br />

matrice unitară Q 1 astfel încât<br />

⎡ ⎤<br />

S 1 = Q H 1 AQ 1 = ⎣ λ 1 S (1)<br />

12<br />

0 S (1) ⎦,<br />

22<br />

realizându-se o deflaţie în prima coloană.<br />

Pasul k ◦ . Presupunem că în primii k − 1 paşi am realizat triangularizarea în<br />

primele k −1 coloane prin transformări unitare de asemănare<br />

S k−1 = Q H k−1 ... Q H 2 Q H 1 AQ 1 Q 2 ... Q k−1 =<br />

⎡<br />

⎣ S(k−1) 11 S (k−1)<br />

12<br />

0 S (k−1)<br />

22<br />

⎤<br />

⎦,<br />

unde S (k−1)<br />

11 ∈ IC (k−1)×(k−1) este superior triunghiulară. Vom aplica lema 4.2 pentru<br />

a realiza deflaţia în coloana k. Pentru aceasta, dacă λ k ∈ λ(S (k−1)<br />

22 ), atunci există<br />

o matrice unitară ˜Q k astfel încât<br />

˜Q H k S(k−1) 22<br />

˜Q k =<br />

[<br />

λk Ŝ (k)<br />

12<br />

0 S (k)<br />

22<br />

]<br />

.<br />

Acum, matricea<br />

Q k =<br />

[<br />

Ik−1 0<br />

0 ˜Qk<br />

]<br />

∈ IC n×n

230 CAPITOLUL 4. VALORI ŞI VECTORI PROPRII<br />

este unitară şi<br />

S k = Q H k S k−1 Q k =<br />

[<br />

(k) S 11 S (k)<br />

12<br />

0 S (k)<br />

22<br />

este superior triunghiulară în primele k coloane.<br />

Procesul de triangularizare prin transformări unitare de asemănare, iniţiat conform<br />

pasului 1 ◦ şi continuat conform celor prezentate la pasul k ◦ , produce după<br />

n−1 paşi matricea superior triunghiulară<br />

unde matricea<br />

S = Q H AQ,<br />

Q = Q 1 Q 2 ... Q n−1 , (4.76)<br />

este unitară ca produs de matrice unitare.<br />

Evident, ordinea elementelor diagonale ale matricei S poate fi aleasă în mod<br />

arbitrar prin selectarea corespunzătoare a <strong>vectorilor</strong> <strong>proprii</strong> în aplicarea lemei 4.2.<br />

Demonstraţia este completă.<br />

✸<br />

Încheiem paragrafulsubliniind faptul că oricematrice pătrată este unitar asemeneacu<br />

omatricesuperiortriunghiulară. DacămatriceaAeste reală,darareşivalori<br />

<strong>proprii</strong> complexe, atunci forma Schur S este complexă ca şi matricea de transformare<br />

Q. În acest caz se spune că S este forma Schur complexă (FSC) a matricei A.<br />

]<br />

4.2.2 Forma Schur reală<br />

În majoritateaaplicaţiilor încareestenecesarcalculul<strong>valorilor</strong><strong>proprii</strong>, matriceaare<br />

elementele reale. În aceste <strong>si</strong>tuaţii este mult mai eficientă utilizarea unei aritmetici<br />

reale. Pentru aceasta, perechile de valori <strong>proprii</strong> complexe şi perechile de vectori<br />

<strong>proprii</strong>asociaţi(care,dupăcums-amaiprecizat,potficon<strong>si</strong>deraţi, larândullor,sub<br />

forma unor vectori complex conjugaţi) trebuie şi pot fi tratate în mod unitar, într-o<br />

aritmetică reală, prin intermediul unor blocuri matriceale 2 ×2, respectiv al unor<br />

subspaţii A-invariantereale. Corespondentulformei Schurdin cazulcomplex devine<br />

o matrice cva<strong>si</strong>-superior triunghiulară în care perechile de valori <strong>proprii</strong> complex<br />

conjugate sunt evidenţiate prin blocuri diagonale 2×2, numită forma Schur reală.<br />

În acest context vom formula şi, în măsura încare apar aspecte noi, vom demonstra<br />

corespondentele ”reale” ale lemei 4.2 şi teoremei 4.12.<br />

Lema 4.3 (Deflaţie ortogonală) Fie A ∈ IR n×n .<br />

a) Dacă λ ∈ λ(A)∩IR, atunci există o matrice ortogonală Q ∈ IR n×n astfel încât<br />

[ ]<br />

Q T λ S12<br />

AQ = . (4.77)<br />

0 S 22<br />

b) Dacă λ 1,2 = α±iβ ∈ λ(A), β ≠ 0, atunci există o matrice ortogonală Q ∈ IR n×n<br />

astfel încât<br />

[ ]<br />

Q T S11 S<br />

AQ = 12<br />

, (4.78)<br />

0 S 22

4.2. FORMA SCHUR 231<br />

unde<br />

S 11 ∈ IR 2×2 , cu λ(S 11 ) = {λ 1 ,λ 2 }. (4.79)<br />

Demonstraţie. Prima parte a lemei se demonstreazăla fel cu lema 4.2 con<strong>si</strong>derând<br />

o matrice ortogonală Q a cărei primă coloană este un vector propriu de normă<br />

euclidiană unitarăasociat valorii<strong>proprii</strong>λ. Pentruadouaparte a lemei con<strong>si</strong>derăm<br />

vectorii <strong>proprii</strong> x 1,2 = v 1 ± iv 2 asociaţi <strong>valorilor</strong> <strong>proprii</strong> complex conjugate λ 1,2 şi<br />

Y = [y 1 y 2 ] ∈ IR n×2 o bază ortogonală a subspaţiului liniar A-invariant S = ImV,<br />

unde V = [v 1 v 2 ] ∈ IR n×2 şi Z ∈ IR n×(n−2) o bază ortogonală a complementului<br />

ortogonal T = S ⊥ a lui S în IR n 12 . Evident, matricea Q = [Y Z] este ortogonală.<br />

Pe de altă parte, întrucât vectorii v 1 şi v 2 sunt liniar independenţi (vezi propoziţia<br />

4.1), există o matrice ne<strong>si</strong>ngulară P[ ∈ IR 2×2 astfel ] încât V = YP. În consecinţă,<br />

α −β<br />

din (4.14) avem AV = VB cu B = . Rezultă<br />

β α<br />

unde<br />

şi, deci,<br />

A 1 = Q T AQ =<br />

AY = AVP −1 = VBP −1 = YS 11 ,<br />

[<br />

α −β<br />

S 11 = P<br />

β α<br />

[ ]<br />

Y<br />

T<br />

Z T A [ Y Z ] [<br />

Y<br />

=<br />

T AY Y T AZ<br />

0 Z T AZ<br />

]<br />

P −1 . (4.80)<br />

]<br />

=<br />

[ ]<br />

S11 S 12<br />

,<br />

0 S 22<br />

(4.81)<br />

punându-se în evidenţă blocul diagonal de ordinul 2 real S 11 având valorile <strong>proprii</strong><br />

complexe λ 1,2 .<br />

✸<br />

<strong>Calculul</strong> matricei ortogonale de asemănare Q din lema de mai sus este condiţionat<br />

esenţial de cunoaşterea unui vector propriu (real) x asociat valorii <strong>proprii</strong> reale<br />

evidenţiate respectiv a parţii reale <strong>si</strong> a celei imaginare a unui vector propriu asociat<br />

unei valori <strong>proprii</strong> complexe. Altfel spus, po<strong>si</strong>bilitatea deflaţiei este condiţionată de<br />

cunoaşterea subspaţiului A-invariant corespunzător.<br />

Procedând ca în demonstraţia teoremei 4.12, i.e. efectuând deflaţia matricei<br />

A pentru valorile <strong>proprii</strong> reale, respectiv pentru perechile de valori <strong>proprii</strong> complexe,<br />

prin aplicarea <strong>si</strong>stematică a lemei de mai sus, până la epuizarea întregului<br />

spectru şi cumulând transformările ortogonale parţiale, obţinem următorul rezultat<br />

important.<br />

Teorema 4.13 (Forma Schurreală) Oricare ar fi matricea reală A ∈ IR n×n , există<br />

o matrice ortogonală Q ∈ IR n×n astfel încât<br />

⎡ ⎤<br />

S 11 S 12 ··· S 1p<br />

Q T AQ = S = ⎢ 0 S 22 ··· S 2p<br />

⎥<br />

⎣ ··· ··· ··· ··· ⎦ , (4.82)<br />

0 0 ··· S pp<br />

12 Pentru construcţia acestor baze vezi observaţia 4.3.

232 CAPITOLUL 4. VALORI ŞI VECTORI PROPRII<br />

unde S ii ∈ IR 1×1 sau S ii ∈ IR 2×2 şi toate blocurile diagonale 2×2 au valorile <strong>proprii</strong><br />

complexe. Avem, evident,<br />

λ(A) = λ(S) =<br />

p⋃<br />

λ(S ii ). (4.83)<br />

Matricea cva<strong>si</strong>-superior triunghiulară S se numeşte forma Schur reală (FSR) a matricei<br />

A, iar coloanele matricei de transformare Q se numesc vectori Schur ai matricei<br />

A asociaţi formei Schur reale S.<br />

Evident, ordinea paşilor de deflaţie fiind arbitrară, forma Schur reală a unei<br />

matrice poate avea blocurile diagonale în orice ordine predeterminată.<br />

Conform (4.83) valorile <strong>proprii</strong> reale ale unei matrice pot fi determinate prin<br />

<strong>si</strong>mplăinspecţieaelementelordiagonalealeformeisaleSchurreale,iarcelecomplexe<br />

se pot calcula prin rezolvarea ecuaţiilor caracteristice (de gradul 2) ale blocurilor<br />

diagonale ale acesteia.<br />

Procedura de deflaţie sugerează o tehnică de calcul a <strong>valorilor</strong> <strong>proprii</strong> ale unei<br />

matrice prin reducerea acesteia la forma Schur (reală). Din păcate, punerea în<br />

evidenţă a fiecărei valori <strong>proprii</strong> nece<strong>si</strong>tă cunoaşterea unui vector propriu asociat,<br />

care, la rândul său, nu poate fi calculat direct fără a cunoaşte valoarea proprie<br />

respectivă. De aceea, procedura de deflaţie trebuie să fie completată cu o metodă<br />

de calcul a unui vector propriu fără cunoaşterea valorii <strong>proprii</strong> asociate.<br />

Metodelecelemaifolo<strong>si</strong>tedecalculiterativalunuivectorpropriusuntcunoscute<br />

sub denumirile de metoda puterii şi metoda puterii inverse.<br />

i=1<br />

4.3 Metoda puterii. Metoda puterii inverse<br />

În această secţiune vom prezenta două modalităţi de construcţie recurentă a unor<br />

şiruri de vectori convergente, în condiţii precizate, către un vector propriu al unei<br />

matrice date. Aceste metode se bazează pe următorul rezultat <strong>si</strong>mplu, a cărui<br />

demonstraţie face obiectul exerciţiului 4.11.<br />

Lema 4.4 Fie o matrice A ∈ IC n×n cu spectrul<br />

λ(A) = {λ 1 ,λ 2 ,...,λ n }. (4.84)<br />

Atuncimatricele A k , k ∈ IN ∗ , A−µI n , µ ∈ IC, şi, în cazul în care A este ne<strong>si</strong>ngulară,<br />

A −1 au aceiaşi vectori <strong>proprii</strong> cu matricea A şi spectrele<br />

λ(A k ) = {λ k 1 ,λk 2 ,...,λk n }, (4.85)<br />

λ(A−µI n ) = {λ 1 −µ,λ 2 −µ,...,λ n −µ}, (4.86)<br />

{ } 1<br />

λ(A −1 1 1<br />

) = , ,..., .<br />

λ 1 λ 2 λ n<br />

(4.87)

4.3. METODA PUTERII. METODA PUTERII INVERSE 233<br />

4.3.1 Metoda puterii<br />

Con<strong>si</strong>derăm o matrice A ∈ IC n×n care are o valoare proprie dominantă, i.e. o valoare<br />

proprie de modul strict superior modulelor tuturor celorlalte. Numerotăm valorile<br />

<strong>proprii</strong> ale matricei A în ordinea descrescătoare a modulelor<br />

|λ 1 | > |λ 2 | ≥ |λ 3 | ≥ ... ≥ |λ n |. (4.88)<br />

Fie y (0) ∈ IC n un vector de normă euclidiană unitară a cărui proiecţie ortogonală<br />

pe ”direcţia” vectorului propriu x 1 asociat valorii <strong>proprii</strong> dominante λ 1 ∈ λ(A) este<br />

nenulă, i.e. x H 1 y(0) ≠ 0. Generic, un vector aleator normat satisface o astfel de<br />

condiţie. Dacă A este o matrice <strong>si</strong>mplă, i.e. există o bază a spaţiului IC n formată<br />

din vectorii <strong>proprii</strong> x 1 , x 2 , ..., x n ai acesteia, atunci y (0) poate fi descompus, în mod<br />

unic, în raport cu acestă bază<br />

unde<br />

y (0) =<br />

n∑<br />

γ i x i , (4.89)<br />

i=1<br />

Dacă definim şirul vectorial (y (k) ) k∈IN prin<br />

γ 1 ≠ 0. (4.90)<br />

y (k) = ρ k Ay (k−1) , k = 1,2,··· (4.91)<br />

cu iniţializarea y (0) şi ρ k un factor de normare definit de<br />

ρ k =<br />

atunci, folo<strong>si</strong>nd inducţia, este uşor de arătat că<br />

1<br />

‖Ay (k−1) ‖ , (4.92)<br />

y (k) = ˜ρ k A k y (0) , (4.93)<br />

unde ˜ρ k este un factor de normare cumulat ˜ρ k = 1/‖A k y (0) ‖. Din (4.89), (4.93) şi<br />

lema 4.2 rezultă<br />

∑ n n<br />

( )<br />

∑<br />

n∑<br />

y (k) = ˜ρ k A k x i = ˜ρ k γ i λ k i x i = ˜ρ k λ k 1 γ 1 x 1 + γ i ( λ i<br />

) k x i . (4.94)<br />

λ 1<br />

i=1<br />

i=1<br />

∣ ∣∣<br />

Utilizând (4.88) obţinem ∣ λi<br />

λ 1<br />

< 1, i = 2 : n, de unde rezultă<br />

şi<br />

i=2<br />

( ) k λi<br />

lim = 0, i = 2 : n, (4.95)<br />

k→∞ λ 1<br />

lim<br />

k→∞ y(k) = γx 1 , (4.96)<br />

în care γ este un scalar nenul astfel încât ‖γx 1 ‖ = 1. Prin urmare, şirul vectorial<br />

construit cu schema de calcul

234 CAPITOLUL 4. VALORI ŞI VECTORI PROPRII<br />

MP 1. Pentru k = 1,2,...<br />

1. Se calculează vectorul y (k) = Ay (k−1)<br />

2. y (k) ← y (k) /‖y (k) ‖<br />

bazată pe relaţia de recurenţă (4.91), care defineşte metoda puterii, este convergent<br />

către vectorul propriu (4.95) asociat valorii <strong>proprii</strong> dominante a matricei A. Viteza<br />

de convergenţă este determinată de raportul |λ 2 /λ 1 |, fiind cu atât mai mare cu cât<br />

acest raport este mai mic. În consecinţă, metoda este eficientă în cazul matricelor<br />

care au o valoare proprie net dominantă şi o structură cu multe elemente nule (în<br />

vederea unei implementări eficiente a produsului Ay (k−1) ).<br />

Pentru oprirea iterării este necesar un criteriu care să a<strong>si</strong>gure o precizie de calcul<br />

impusă. Având în vedere faptul că un vector propriu de normă unitară este<br />

determinat până la o multiplicare cu un număr de modul unitar (i.e. e iθ cu θ ∈ IR<br />

în cazul complex şi ±1 în cazul real), un criteriu po<strong>si</strong>bil este a<strong>si</strong>gurarea unei colinearităţi<br />

impuse între vectorii calculaţi la doi paşi consecutivi. Cum, în cazul<br />

complex unghiul dintre doi vectori u şi v este definit de φ(u,v) = arccos<br />

iar în cazul real de φ(u,v) = arccos<br />

v H u<br />

‖u‖·‖v‖<br />

v T u<br />

, condiţia de oprire a iterării poate fi<br />

‖u‖·‖v‖<br />

e k = |1−|(y (k) ) H y (k−1) || < tol, respectiv e k = |1−|(y (k) ) T y (k−1) || < tol,<br />

(4.97)<br />

unde tol esteotoleranţăprescrisă(vezi şiexerciţiul 4.48). Introducândşi abandonul<br />

iterării la atingerea unui număr maxim de iteraţii, obţinem următorul algoritm.<br />

Algoritmul 4.1 (Metoda puterii) (Dată o matrice A ∈ IC n×n , un<br />

niveldetoleranţătol ∈ IR, tol > 1,şiunnumărmaximadmismaxiterde<br />

iteraţii, algoritmul calculează un vector propriu unitar y asociat valorii<br />

<strong>proprii</strong>dominanteamatricei date sautipăreşteun mesajdacăobiectivul<br />

nu a fost atins în numărul de iteraţii admis.)<br />

1. Se alege aleator un vector y ∈ IC n .<br />

2. y ← y/‖y‖<br />

3. i = 0, e = 1<br />

4. C^at timp e > tol<br />

1. Dacă i > maxiter atunci<br />

1. Tipăreşte ’S-a atins numărul maxim de iteraţii fără a se<br />

fi obţinut nivelul prescris al toleranţei.’<br />

2. Stop<br />

2. z = Ay<br />

3. z ← z/‖z‖<br />

4. e = |1−|z H y||<br />

5. y ← z<br />

6. i ← i+1

4.3. METODA PUTERII. METODA PUTERII INVERSE 235<br />

Comentarii. Având în vedere <strong>si</strong>mplitatea relaţiei de recurenţă, metoda puterii<br />

se poate dovedi atractivă dacă se cunoaşte apriori existenţa unei valori <strong>proprii</strong> net<br />

dominante. În caz contrar, viteza de convergenţă poate fi nesatisfăcătoare, iar în<br />