messtechnik & emv - EuE24.net

messtechnik & emv - EuE24.net

messtechnik & emv - EuE24.net

Sie wollen auch ein ePaper? Erhöhen Sie die Reichweite Ihrer Titel.

YUMPU macht aus Druck-PDFs automatisch weboptimierte ePaper, die Google liebt.

M E S S T E C H N I K & E M V<br />

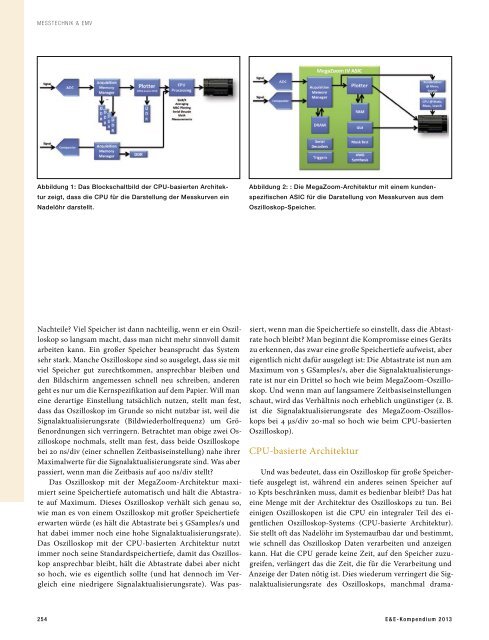

Abbildung 1: Das Blockschaltbild der CPU-basierten Architektur<br />

zeigt, dass die CPU für die Darstellung der Messkurven ein<br />

Nadelöhr darstellt.<br />

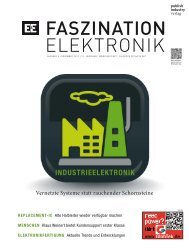

Abbildung 2: : Die MegaZoom-Architektur mit einem kundenspezifischen<br />

ASIC für die Darstellung von Messkurven aus dem<br />

Oszilloskop-Speicher.<br />

Nachteile? Viel Speicher ist dann nachteilig, wenn er ein Oszilloskop<br />

so langsam macht, dass man nicht mehr sinnvoll damit<br />

arbeiten kann. Ein großer Speicher beansprucht das System<br />

sehr stark. Manche Oszilloskope sind so ausgelegt, dass sie mit<br />

viel Speicher gut zurechtkommen, ansprechbar bleiben und<br />

den Bildschirm angemessen schnell neu schreiben, anderen<br />

geht es nur um die Kernspezifikation auf dem Papier. Will man<br />

eine derartige Einstellung tatsächlich nutzen, stellt man fest,<br />

dass das Oszilloskop im Grunde so nicht nutzbar ist, weil die<br />

Signalaktualisierungsrate (Bildwiederholfrequenz) um Größenordnungen<br />

sich verringern. Betrachtet man obige zwei Oszilloskope<br />

nochmals, stellt man fest, dass beide Oszilloskope<br />

bei 20 ns/div (einer schnellen Zeitbasiseinstellung) nahe ihrer<br />

Maximalwerte für die Signalaktualisierungsrate sind. Was aber<br />

passiert, wenn man die Zeitbasis auf 400 ns/div stellt?<br />

Das Oszilloskop mit der MegaZoom-Architektur maximiert<br />

seine Speichertiefe automatisch und hält die Abtastrate<br />

auf Maximum. Dieses Oszilloskop verhält sich genau so,<br />

wie man es von einem Oszilloskop mit großer Speichertiefe<br />

erwarten würde (es hält die Abtastrate bei 5 GSamples/s und<br />

hat dabei immer noch eine hohe Signalaktualisierungsrate).<br />

Das Oszilloskop mit der CPU-basierten Architektur nutzt<br />

immer noch seine Standardspeichertiefe, damit das Oszilloskop<br />

ansprechbar bleibt, hält die Abtastrate dabei aber nicht<br />

so hoch, wie es eigentlich sollte (und hat dennoch im Vergleich<br />

eine niedrigere Signalaktualisierungsrate). Was passiert,<br />

wenn man die Speichertiefe so einstellt, dass die Abtastrate<br />

hoch bleibt? Man beginnt die Kompromisse eines Geräts<br />

zu erkennen, das zwar eine große Speichertiefe aufweist, aber<br />

eigentlich nicht dafür ausgelegt ist: Die Abtastrate ist nun am<br />

Maximum von 5 GSamples/s, aber die Signalaktualisierungsrate<br />

ist nur ein Drittel so hoch wie beim MegaZoom-Oszilloskop.<br />

Und wenn man auf langsamere Zeitbasiseinstellungen<br />

schaut, wird das Verhältnis noch erheblich ungünstiger (z. B.<br />

ist die Signalaktualisierungsrate des MegaZoom-Oszilloskops<br />

bei 4 µs/div 20-mal so hoch wie beim CPU-basierten<br />

Oszilloskop).<br />

CPU-basierte Architektur<br />

Und was bedeutet, dass ein Oszilloskop für große Speichertiefe<br />

ausgelegt ist, während ein anderes seinen Speicher auf<br />

10 Kpts beschränken muss, damit es bedienbar bleibt? Das hat<br />

eine Menge mit der Architektur des Oszilloskops zu tun. Bei<br />

einigen Oszilloskopen ist die CPU ein integraler Teil des eigentlichen<br />

Oszilloskop-Systems (CPU-basierte Architektur).<br />

Sie stellt oft das Nadelöhr im Systemaufbau dar und bestimmt,<br />

wie schnell das Oszilloskop Daten verarbeiten und anzeigen<br />

kann. Hat die CPU gerade keine Zeit, auf den Speicher zuzugreifen,<br />

verlängert das die Zeit, die für die Verarbeitung und<br />

Anzeige der Daten nötig ist. Dies wiederum verringert die Signalaktualisierungsrate<br />

des Oszilloskops, manchmal drama-<br />

2 5 4 E & E - K o m p e n d i u m 2 0 13