Datenkommunikation - FET

Datenkommunikation - FET

Datenkommunikation - FET

Erfolgreiche ePaper selbst erstellen

Machen Sie aus Ihren PDF Publikationen ein blätterbares Flipbook mit unserer einzigartigen Google optimierten e-Paper Software.

Zielausgang weiter. Dieses Vorgehen eignet sich besonders für Single-Chip-Lösungen, sie kommen bei einem 8-Port Switch<br />

typischerweise mit zwei MByte Gesamtpuffer aus.<br />

Einfache Switches basieren in der Regel auf einer Busarchitektur mit hoher Bandbreite, da diese vom Schaltungsaufwand geringer<br />

ist. Dabei fließen die Rahmen von den Eingängen über den ersten Bus an einen zentralen Puffer und von dort über einen<br />

zweiten Bus zu den Ausgängen. Für High-End-Switches kommen häufig Crossbars mit zentraler oder verteilter Pufferung<br />

zum Einsatz, die in der Regel mittels speziell konstruierter Chips (Application Specific Integrated Circuits, ASICs) aufgebaut<br />

werden.<br />

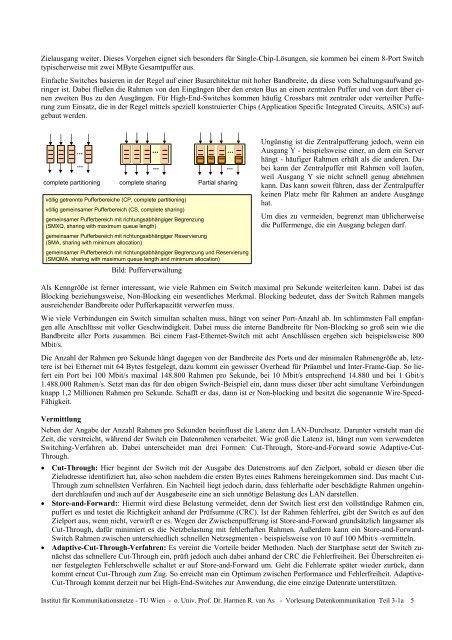

complete partitioning complete sharing Partial sharing<br />

völlig getrennte Pufferbereiche (CP, complete partitioning)<br />

völlig gemeinsamer Pufferbereich (CS, complete sharing)<br />

gemeinsamer Pufferbereich mit richtungsabhängiger Begrenzung<br />

(SMXQ, sharing with maximum queue length)<br />

gemeinsamer Pufferbereich mit richtungsabhängiger Reservierung<br />

(SMA, sharing with minimum allocation)<br />

gemeinsamer Pufferbereich mit richtungsabhängiger Begrenzung und Reservierung<br />

(SMQMA, sharing with maximum queue length and minimum allocation)<br />

Bild: Pufferverwaltung<br />

Ungünstig ist die Zentralpufferung jedoch, wenn ein<br />

Ausgang Y - beispielsweise einer, an dem ein Server<br />

hängt - häufiger Rahmen erhält als die anderen. Dabei<br />

kann der Zentralpuffer mit Rahmen voll laufen,<br />

weil Ausgang Y sie nicht schnell genug abnehmen<br />

kann. Das kann soweit führen, dass der Zentralpuffer<br />

keinen Platz mehr für Rahmen an andere Ausgänge<br />

hat.<br />

Um dies zu vermeiden, begrenzt man üblicherweise<br />

die Puffermenge, die ein Ausgang belegen darf.<br />

Als Kenngröße ist ferner interessant, wie viele Rahmen ein Switch maximal pro Sekunde weiterleiten kann. Dabei ist das<br />

Blocking beziehungsweise, Non-Blocking ein wesentliches Merkmal. Blocking bedeutet, dass der Switch Rahmen mangels<br />

ausreichender Bandbreite oder Pufferkapazität verwerfen muss.<br />

Wie viele Verbindungen ein Switch simultan schalten muss, hängt von seiner Port-Anzahl ab. Im schlimmsten Fall empfangen<br />

alle Anschlüsse mit voller Geschwindigkeit. Dabei muss die interne Bandbreite für Non-Blocking so groß sein wie die<br />

Bandbreite aller Ports zusammen. Bei einem Fast-Ethernet-Switch mit acht Anschlüssen ergeben sich beispielsweise 800<br />

Mbit/s.<br />

Die Anzahl der Rahmen pro Sekunde hängt dagegen von der Bandbreite des Ports und der minimalen Rahmengröße ab, letztere<br />

ist bei Ethernet mit 64 Bytes festgelegt, dazu kommt ein gewisser Overhead für Präambel und Inter-Frame-Gap. So liefert<br />

ein Port bei 100 Mbit/s maximal 148.800 Rahmen pro Sekunde, bei 10 Mbit/s entsprechend 14.880 und bei 1 Gbit/s<br />

1.488.000 Rahmen/s. Setzt man das für den obigen Switch-Beispiel ein, dann muss dieser über acht simultane Verbindungen<br />

knapp 1,2 Millionen Rahmen pro Sekunde. Schafft er das, dann ist er Non-blocking und besitzt die sogenannte Wire-Speed-<br />

Fähigkeit.<br />

Vermittlung<br />

Neben der Angabe der Anzahl Rahmen pro Sekunden beeinflusst die Latenz den LAN-Durchsatz. Darunter versteht man die<br />

Zeit, die verstreicht, während der Switch ein Datenrahmen verarbeitet. Wie groß die Latenz ist, hängt nun vom verwendeten<br />

Switching-Verfahren ab. Dabei unterscheidet man drei Formen: Cut-Through, Store-and-Forward sowie Adaptive-Cut-<br />

Through.<br />

• Cut-Through: Hier beginnt der Switch mit der Ausgabe des Datenstroms auf den Zielport, sobald er diesen über die<br />

Zieladresse identifiziert hat, also schon nachdem die ersten Bytes eines Rahmens hereingekommen sind. Das macht Cut-<br />

Through zum schnellsten Verfahren. Ein Nachteil liegt jedoch darin, dass fehlerhafte oder beschädigte Rahmen ungehindert<br />

durchlaufen und auch auf der Ausgabeseite eine an sich unnötige Belastung des LAN darstellen.<br />

• Store-and-Forward:: Hiermit wird diese Belastung vermeidet, denn der Switch liest erst den vollständige Rahmen ein,<br />

puffert es und testet die Richtigkeit anhand der Prüfsumme (CRC). Ist der Rahmen fehlerfrei, gibt der Switch es auf den<br />

Zielport aus, wenn nicht, verwirft er es. Wegen der Zwischenpufferung ist Store-and-Forward grundsätzlich langsamer als<br />

Cut-Through, dafür minimiert es die Netzbelastung mit fehlerhaften Rahmen. Außerdem kann ein Store-and-Forward-<br />

Switch Rahmen zwischen unterschiedlich schnellen Netzsegmenten - beispielsweise von 10 auf 100 Mbit/s -vermitteln.<br />

• Adaptive-Cut-Through-Verfahren: Es vereint die Vorteile beider Methoden. Nach der Startphase setzt der Switch zunächst<br />

das schnellere Cut-Through ein, prüft jedoch auch dabei anhand der CRC die Fehlerfreiheit. Bei Überschreiten einer<br />

festgelegten Fehlerschwelle schaltet er auf Store-and-Forward um. Geht die Fehlerrate später wieder zurück, dann<br />

kommt erneut Cut-Through zum Zug. So erreicht man ein Optimum zwischen Performance und Fehlerfreiheit. Adaptive-<br />

Cut-Through kommt derzeit nur bei High-End-Switches zur Anwendung, die eine einzige Datenrate unterstützen.<br />

Institut für Kommunikationsnetze - TU Wien - o. Univ. Prof. Dr. Harmen R. van As - Vorlesung <strong>Datenkommunikation</strong> Teil 3-1a 5