Statistik I

Statistik I

Statistik I

Erfolgreiche ePaper selbst erstellen

Machen Sie aus Ihren PDF Publikationen ein blätterbares Flipbook mit unserer einzigartigen Google optimierten e-Paper Software.

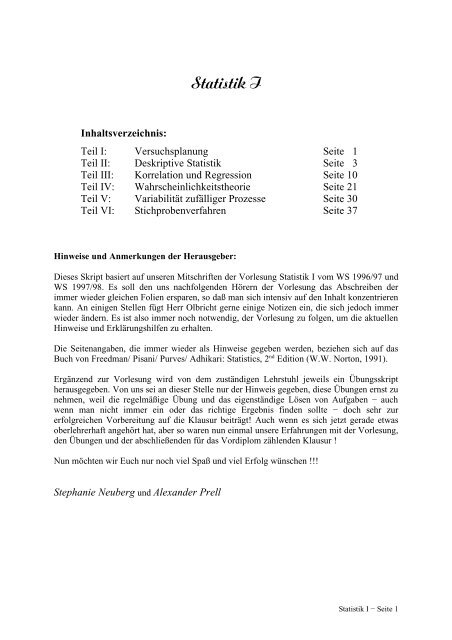

Inhaltsverzeichnis:<br />

<strong>Statistik</strong> I<br />

Teil I: Versuchsplanung Seite 1<br />

Teil II: Deskriptive <strong>Statistik</strong> Seite 3<br />

Teil III: Korrelation und Regression Seite 10<br />

Teil IV: Wahrscheinlichkeitstheorie Seite 21<br />

Teil V: Variabilität zufälliger Prozesse Seite 30<br />

Teil VI: Stichprobenverfahren Seite 37<br />

Hinweise und Anmerkungen der Herausgeber:<br />

Dieses Skript basiert auf unseren Mitschriften der Vorlesung <strong>Statistik</strong> I vom WS 1996/97 und<br />

WS 1997/98. Es soll den uns nachfolgenden Hörern der Vorlesung das Abschreiben der<br />

immer wieder gleichen Folien ersparen, so daß man sich intensiv auf den Inhalt konzentrieren<br />

kann. An einigen Stellen fügt Herr Olbricht gerne einige Notizen ein, die sich jedoch immer<br />

wieder ändern. Es ist also immer noch notwendig, der Vorlesung zu folgen, um die aktuellen<br />

Hinweise und Erklärungshilfen zu erhalten.<br />

Die Seitenangaben, die immer wieder als Hinweise gegeben werden, beziehen sich auf das<br />

Buch von Freedman/ Pisani/ Purves/ Adhikari: Statistics, 2 nd Edition (W.W. Norton, 1991).<br />

Ergänzend zur Vorlesung wird von dem zuständigen Lehrstuhl jeweils ein Übungsskript<br />

herausgegeben. Von uns sei an dieser Stelle nur der Hinweis gegeben, diese Übungen ernst zu<br />

nehmen, weil die regelmäßige Übung und das eigenständige Lösen von Aufgaben − auch<br />

wenn man nicht immer ein oder das richtige Ergebnis finden sollte − doch sehr zur<br />

erfolgreichen Vorbereitung auf die Klausur beiträgt! Auch wenn es sich jetzt gerade etwas<br />

oberlehrerhaft angehört hat, aber so waren nun einmal unsere Erfahrungen mit der Vorlesung,<br />

den Übungen und der abschließenden für das Vordiplom zählenden Klausur !<br />

Nun möchten wir Euch nur noch viel Spaß und viel Erfolg wünschen !!!<br />

Stephanie Neuberg und Alexander Prell<br />

<strong>Statistik</strong> I − Seite 1

Teil I: Versuchsplanung<br />

1. Kontrollierte Experimente<br />

Wie gewinnt man „gesicherte Erkenntnisse“ ?<br />

→ Vergleich unter identischen Bedingungen<br />

Zuordnung zu Gruppen (Behandlungsgruppe − Kontrollgruppe):<br />

Kontrollierte Zuordnung durch den Experimentator oder<br />

Randomisierte Zuordnung, explizit „zufällig“, dies schließt bias, und<br />

somit vermengte (confounded) Effekte weitgehend aus.<br />

Bsp.: Polio − Impfstoff<br />

ist ein randomisierter, kontrollierter doppeltblinder Versuch<br />

2. Beobachtungsstudien<br />

doppelt − blind: weder Versuchsperson noch Auswerter kennen die<br />

Zugehörigkeit zu Kontroll− und Behandlungsgruppe<br />

(hier: Verwendung von Placebos)<br />

Manchmal liegt die Zuordnung nicht in der Hand des Experimentators, z. B.<br />

Raucher / Nichtraucher<br />

Ein vermengender Faktor kann manchmal durch Unterteilung in kleinere<br />

homogene Gruppen „kontrolliert“ werden.<br />

<strong>Statistik</strong> I − Seite 2

Teil II: Deskriptive <strong>Statistik</strong><br />

Ziel: Darstellung und Aufbereitung von Datenmaterial<br />

Einordnung:<br />

Daten Modell<br />

→ deskriptive <strong>Statistik</strong> → Wahrscheinlichkeitstheorie<br />

Schluß<br />

→ analytische <strong>Statistik</strong><br />

Daten: Untersuchungseinheiten<br />

Merkmale (Variablen)<br />

Merkmalsausprägungen („Daten“)<br />

Klassifikationen:<br />

a) Meßskalenniveau<br />

− nominal (m, w) ungeordnet<br />

− ordinal (1, ..., 6) geordnet<br />

− metrisch<br />

+ Intervallskala → Differenzen sinnvoll<br />

+ Ratio Skala → Intervallskala mit Nullpunkt, Differenzen<br />

und Verhältnisse sinnvoll<br />

b) Art des Merkmals<br />

− quantitativ („Zahl“)<br />

+ diskret<br />

+ stetig<br />

− qualitativ („Status, Eigenschaft“)<br />

+ geordnet<br />

+ ungeordnet<br />

c) Art der Messung<br />

− analog<br />

− digital<br />

⇒ alle Daten lassen sich numerisch kodieren, d. h. Daten sind ein Haufen von<br />

Zahlen.<br />

<strong>Statistik</strong> I − Seite 3

3. Histogramme<br />

Bsp.: mathematisches Seminar<br />

10 Teilnehmer mit folgenden Kontoständen in HDM<br />

2, 3, 3, 4, 5, 5, 5, 8, 9, 10<br />

VWL−Vorlesung<br />

271 Teilnehmer mit folgenden Kontoständen in HDM<br />

9, 9, 9, 9, 9, 10, 15, 200, 200, ...<br />

Gibt es „mehr“ 9 bei Mathe oder VWL<br />

→ Vergleiche standardisieren → Prozentwerte<br />

a) Stabdiagramm<br />

b) Säulendiagramm<br />

c) Histogramm<br />

− Histogramm stellt Prozentzahlen als Flächen dar<br />

− die verteilte Skala ist die „Dichteskala“:<br />

→ Prozentzahl der Fläche pro Einheit der horizontalen Skala<br />

− Höhe des Blocks ergibt sich durch Division:<br />

→ Höhe * Grundseite = Prozentzahl der Fälle in dem betr.<br />

Intervall<br />

− die Gesamtfläche ist 1 bzw. 100% !<br />

− Anwendung der Histogramme:<br />

Histogramme werden zur Darstellung von Daten und zum<br />

Vergleich von Populationen verwendet. Sie werden allerdings<br />

schichtweise verglichen.<br />

(siehe Beispiele im Buch: Zusammenhang zwischen Blutdruck<br />

und Pille, intelligente und dumme Raten)<br />

4. Arithmetisches Mittel und Standardabweichung<br />

Beschreibung von Daten durch:<br />

a) Lagemaße („typischer Wert“)<br />

b) Streuungsmaße („Abweichungen“)<br />

Dies ist aber wenig sinnvoll bei mehrgipfligen Histogrammen !<br />

a) Lagemaß: arithmetisches Mittel<br />

arithmetisches Mittel =<br />

Interpretation und Eigenschaften des arithmetischen Mittels:<br />

− balanciert das Histogramm aus<br />

− Schwerpunkt der Verteilung<br />

− hängt stark von extremen Werten ab (Hebelwirkung)<br />

− ungeeignet für stark „schiefe“ Verteilungen<br />

<strong>Statistik</strong> I − Seite 4

Median: − Zentralwert des Histogramms<br />

− jeweils 50% der Daten liegen links und rechts vom<br />

Median<br />

− unempfindlich gegen extreme Werte<br />

Modus: − Lage des Gipfels des Histogramms<br />

− häufigster Wert<br />

b) Streuungsmaß: Standardabweichung<br />

root mean square ( r.m.s.) =<br />

SD =<br />

Eigenschaften der SD:<br />

− selbe Einheit wie die Daten<br />

− mißt die Streuung der Daten um das Mittel<br />

− vielfach liegen<br />

68% der Datenwerte nicht weiter als 1 SD<br />

95% der Datenwerte nicht weiter als 2 SD<br />

vom arithmetischen Mittel entfernt<br />

5. Normalapproximation von Histogrammen<br />

mathematische Definition:<br />

f(x) =<br />

graphisch: Glockenkurve<br />

Eigenschaften:<br />

− symmetrisch um 0<br />

− Fläche unter der Kurve ist 1, bzw. 100%<br />

− Fläche zwischen −1 und 1 ist ≈ 68%<br />

− Fläche zwischen −2 und 2 ist ≈ 95%<br />

− Fläche zwischen −3 und 3 ist ≈ 99%<br />

− Fläche außerhalb [−4;4] ist verschwindend klein<br />

Verallgemeinerung:<br />

Es gibt eigentlich viele Glockenkurven, die sich nur durch die Lage des<br />

Scheitelpunktes und die Breite unterscheiden.<br />

Die Formel ist:<br />

g(x) =<br />

<strong>Statistik</strong> I − Seite 5

...<br />

Der obige Spezialfall (µ = 0, σ = 1) reicht aus, wenn Standardeinheiten<br />

benutzt werden.<br />

Standardeinheiten:<br />

− geben dasjenige Vielfache der Standardabweichungen an, um das im<br />

Wert über ( + ) oder unter ( − ) dem arithmetischen Mittel liegt<br />

− Beispiel: HANES− Daten: ave = 63,5, SD = 2,5<br />

Dann ist 68,5 = 63,5 + 2 * 2,5, also +2 in Standardeinheiten<br />

61,0 = 63,5 − 1 * 2,5, also −1 in Standardeinheiten<br />

Umgekehrt: −1,5 in Standardeinheiten entspricht 63,5 − 1,5 * 2,5 ≈<br />

59,75<br />

− Vorteil: man braucht nur eine Glockenkurve und nur eine Tabelle<br />

Flächenberechnung:<br />

prinzipiell: Integration<br />

aber: kein genereller Ausdruck für Integral möglich<br />

→ daher Verwendung von Tabellen<br />

ACHTUNG: unterschiedlicher Aufbau der Tabellen<br />

Normalapproximation von Histogrammen:<br />

Quantile:<br />

Verfahren: − Ersetze Histogramme durch die Normalverteilung<br />

(NV)<br />

− Berechne Flächenanteil durch NV<br />

Beispiel: MW = 69; SD = 3<br />

Gesucht: Prozentsatz zwischen 63 und 72 ?<br />

Bemerkung: − Falls Histogramm der NV− Kurve folgt, fassen ave und<br />

SD alle Informationen gut zusammen<br />

− gilt nicht immer !<br />

Problem: Wie faßt man eine „nichtnormale“ Verteilung zusammen?<br />

Beispiel: Einkommensverteilung<br />

1% Quantil: $ 1.300, d.h. 1% verdienen nicht mehr als<br />

... ...<br />

99% Quantil: $ 125.600, d.h. ...<br />

<strong>Statistik</strong> I − Seite 6

6. Meßfehler<br />

Definition: Das a % − Quantil ist der Wert, unter dem a % und über<br />

dem ( 100 − a ) % der Daten liegen.<br />

Spezialfälle: 25% − Quantil: „unteres Quartil“<br />

50% − Quantil: „Median“<br />

75% − Quantil: „oberes Quartil“<br />

Streuungsmaß: Quartilsabstand = oberes Quartil − unteres Quartil<br />

Deshalb halten wir fest:<br />

a) zufällige Fehler<br />

Ein a % − Quantil ist ein Wert, „unter“ (im Sinne von ≤) dem<br />

mindestens a % der Daten und „über“ (im Sinne von ≥) dem<br />

mindestens (100 − a) % der Daten liegen.<br />

Falls es mehrere solche Werte gibt, bilden diese ein Intervall.<br />

Das a % − Quantil ist der Intervallmittelpunkt.<br />

Wie gehen die Zufallsfehler in die Messung ein ?<br />

⇒ Meßwert = wahrer Wert + Zufallsfehler<br />

≈ ⏐<br />

Mittelwert beschrieben durch<br />

die Standardabweichung<br />

b) Ausreißer<br />

Definition: Ein Wert, der zu einem anderen Grundelement gehört<br />

aber: Wie wird das festgestellt ?<br />

Effekt: große Standardabweichung, verzerrte Werte<br />

c) systematische Fehler<br />

→ niemals Werte ohne Grund ausschließen, evtl. robuste<br />

Verfahren verwenden<br />

− stets derselbe Fehler<br />

− nicht aus Daten zu entnehmen, höchstens durch Vergleiche<br />

Meßwert = wahrer Wert + systematischer Fehler + Zufallsfehler<br />

Genauigkeit und Präzision:<br />

Genauigkeit bei systematischen Fehler<br />

Präzision bei zufälligem Fehler<br />

<strong>Statistik</strong> I − Seite 7

7. Hinweise zur Analyse, Darstellung und Präsentation von Daten und<br />

Ergebnissen<br />

a) Explorative Datenanalyse<br />

Stem − and − Leaf Displays:<br />

5 5 2 8 ...<br />

6 5 3 ...<br />

7 ...<br />

8 ...<br />

9 ...<br />

10 ...<br />

Bemerkungen:<br />

− ist den Histogrammen ähnlich<br />

− zeigt die vollen Daten<br />

− leichtes Ablesen von Median und Quantilen<br />

b) 5 − Number − Summaries<br />

Ziel: Gesamteindruck von den Daten<br />

Definition:<br />

Median<br />

unteres Quantil oberes Quantil<br />

Minimum Maximum<br />

Bemerkung:<br />

− mehrfaches Halbieren<br />

− häufig etwas anderes definiert mittels huiges (statt Quantilen),<br />

aber komplizierter<br />

− 7− number− summaries analog<br />

<strong>Statistik</strong> I − Seite 8

c) Boxplots<br />

Ziel: zeichnerische Umsetzung der 5− number− summaries<br />

⏐ ⏐ ⏐ ⏐ ⏐<br />

52 62 68,5 78 93<br />

= Q1 = Q 2 = Q 3<br />

1. Kasten (Box) aus Median (Q 2) und Quartilen (Q1, Q3)<br />

2. Ablesen des Quartilenabstandes (Q3 − Q1). Anlegen des 1,5−<br />

fachen Quartilenabstandes an Q1 bzw. Q3 definiert die<br />

„Normalbereiche“. Streiche den extremsten Datenpunkt<br />

innerhalb dieser Bereiche.<br />

Bemerkung:<br />

− auch vertikal möglich<br />

− zeigt: a) Zentralwert<br />

b) Streuung (durch Q3 − Q1)<br />

c) Symmetrie<br />

d) Ausreißer<br />

− vergleichende Boxplots<br />

⇒ mehrere nebeneinander (oder übereinander)<br />

<strong>Statistik</strong> I − Seite 9

Teil III: Korrelation und Regression<br />

8. Korrelation und Regression<br />

a) Streuungsdiagramm (scatter plot)<br />

→ graphische Darstellung der Beziehung zwischen Größe und Gewicht<br />

Aussage: Lage der Datenwolke<br />

Form der Datenwolke<br />

Assoziation / Neigung<br />

Ausreißer<br />

b) Korrelationskoeffizient<br />

→ Beschreibung der Datenwolke durch Kennzahlen<br />

− für die x− Werte: arithmetisches Mittel und SD<br />

− für die y− Werte: arithmetisches Mittel und SD<br />

→ steckt den Rahmen ab<br />

− Korrelationskoeffizient (r) ist ein relatives Maß (−1 bis +1) der<br />

Häufung um eine Gerade<br />

− schwer zu interpretieren !!!<br />

⇒ aber je näher an −1 oder +1, desto „stärker“ sind die<br />

Datenpunkte um eine Gerade gehäuft<br />

c) SD − Gerade (oder SD − Linie)<br />

Falls r = 1 (bzw. r = −1) wird eine exakte lineare Beziehung bestehen.<br />

Dann kann man (in SD− Einheiten) x und y schnell ineinander<br />

umrechnen (vgl. auch Resultate der Übungen).<br />

SDx<br />

SDy<br />

r = 1 r = −1<br />

Definition:<br />

durch den Punkt (Mittel von x , Mittel von y), mit der Steigung<br />

a) falls r > 0<br />

b) − falls r < 0<br />

SDx<br />

c) eines der obigen , falls r = 0<br />

SDy<br />

<strong>Statistik</strong> I − Seite 10

d) Berechnung des Korrelationskoeffizienten<br />

9. Mehr über Korrelation<br />

− x−und y−Werte in SD− Einheiten umrechnen<br />

− Mittel der Produkte bilden<br />

r = Mittel [( x in SD− Einheiten ) * ( y in SD− Einheiten )]<br />

Bemerkung:<br />

r > 0: wenn gleichsinnige Abweichungen<br />

r < 0: wenn gegensinnige Abweichungen<br />

vom Mittelwert vorherrschen<br />

ausgeschlossen:<br />

Falls SDx = 0 oder SDy = 0, so ist r nicht definiert. Es<br />

muß also wenigstens zwei verschiedene x− bzw. y−<br />

Werte geben.<br />

a) Eigenschaften des Korrelationskoeffizienten<br />

Der Korrelationskoeffizient basiert auf den in SD− Einheiten<br />

umgerechneten Werten. Daher bleibt er unverändert !, wenn man<br />

− die x−Werte (oder die y−Werte) mit der gleichen positiven<br />

Zahl multipliziert → Verzerrung<br />

− zu den x−Werten (oder y−Werten) die gleiche Zahl addiert<br />

→ Verschiebung<br />

− die Variablen x und y vertauscht (aber nicht nur einzelne<br />

Paare !!!)<br />

b) Aussehen der Streuungsdiagramme<br />

− kann durchaus verschieden sein, z. B. gespiegelt<br />

− kann insbesondere bei unterschiedlichen Standardabweichungen<br />

variieren<br />

→ SD´en „gleich“ denken, wie in Standardbeispiel S. 119 / 121<br />

c) Probleme beim Gebrauch des Korrelationskoeffizienten<br />

− kann durch Ausreißer verfälscht werden<br />

− zeigt nur lineare Assoziationen<br />

⇒ Deswegen nicht zu verwenden, falls folgende Situationen eintreten:<br />

+ + +<br />

+ + +<br />

+ + +<br />

+ + + +<br />

+ + +<br />

Ausreißer nichtlinearer<br />

Zusammenhang<br />

⇒ Deshalb ist ein Streuungsdiagramm immer hilfreich !!!<br />

<strong>Statistik</strong> I − Seite 11

d) „ökologische“ Korrelation<br />

→ Korrelationskoeffizient für Durchschnitte oder Raten, also<br />

zusammengefaßte Größen<br />

Dies unterdrückt einen Teil der Streuung und übertreibt i. a. die<br />

Assoziation (→ problematisch).<br />

Beispiel:<br />

A B<br />

C C<br />

B C B C<br />

A B<br />

A B<br />

A A<br />

vorher nachher<br />

e) Korrelation und Verursachung<br />

→ Assoziation Ø Kausalbeziehung<br />

(Dies folgt schon aus der Symmetrie !)<br />

Beispiele: Größe − Gewicht<br />

Anzahl Störche − Anzahl Geburten<br />

10. Regression<br />

Problemstellung: Welche lineare Beziehung besteht ?<br />

→ Die SD−Linie ist nicht notwendigerweise der beste<br />

Kandidat<br />

Bsp.: HANES− Daten für Größe und Gewicht<br />

Männer mit der Größe 73 = 70 + 3<br />

(MW) (SD)<br />

haben im Durchschnitt das Gewicht<br />

176 = 162 + 0,47 * 30<br />

(MW) (r) (SD)<br />

a) Regressionsgerade von y auf x<br />

− gibt zu jedem x den Durchschnittswert der zugehörigen y an<br />

− geht durch den Punkt (Mittel der x−Werte ; Mittel der y−Werte)<br />

− hat die Steigung<br />

b) Spezialfälle<br />

r = 0: kein linearer Zusammenhang, Kenntnis von x−Werten ist<br />

nutzlos<br />

r = 1: eine Gerade, nämlich die SD−Gerade<br />

r = −1: analog<br />

<strong>Statistik</strong> I − Seite 12

c) Kurve der arithmetischen Mittel<br />

Für jeden kleinen vertikalen Streifen um x bildet man den Durchschnitt<br />

der dazu gehörigen y−Werte. Dies liefert eine „vergröberte“<br />

Datenwolke bzw. Kurve von Durchschnitten (→ vgl. „ökologische<br />

Korrelation)<br />

Regressionsgerade:<br />

− ist geglättete Form dieser Kurve<br />

− sollte nicht zu sehr von der Kurve abweichen; bei deutlicher<br />

Nichtlinearität ist (lineare) Regression gefährlich<br />

d) Schätzungen für einige x− Werte<br />

− problemlos berechenbar mittels Regression<br />

− aber sehr bedenklich, wenn extrapoliert wird (über den Bereich der<br />

Herkunft der Daten hinaus)<br />

Bsp.: Schätzung der Quantilrängen<br />

e) Regressionsfehlschluß<br />

SAT, GPA jeweils „normal“<br />

Korrelationskoeffizient = 0,40<br />

Student Schlau liegt beim SAT beim 90% − Quantil<br />

Wo wird er beim GPA liegen ?<br />

→ Er liegt 1,3 SD über dem Mittel<br />

Wird also voraussichtlich 0,40 * 1,3 ≈ 0,5 SD´en über dem<br />

Mittel abschließen, d. h. bei ≈ 69%.<br />

Betrachte: wiederholtes Testen<br />

dann wird sehr oft: Spitzengruppe im Durchschnitt relativ schlechter<br />

Schlußlichtgruppe im Durchschnitt relativ besser<br />

Dies trifft zu bei (und liegt an):<br />

− „Zwetschgenform“ der Datenwolke<br />

− Regression des zweiten Resultats (y) auf das erste (x) sog.<br />

Regressionseffekt<br />

Bsp.: Größe von Vätern und Söhnen<br />

zur Plausibilität:<br />

beobachtetes Testergebnis = wahres Ergebnis + Zufallsfehler<br />

<strong>Statistik</strong> I − Seite 13

Annahme: wahres Ergebnis in der Bevölkerung normalverteilt mit<br />

Mittel = 100 und SD = 15;<br />

⇒ Zufallsfehler = ± 5<br />

beobachtet: 140<br />

kann sein: 135 + 5 oder 145 − 5<br />

135<br />

145<br />

aber es gibt mehr Leute mit ≈ 135 als wahrem Ergebnis<br />

⇒ Durchschnitt der „Gruppe 140“ wird bei Wiederholung niedriger<br />

liegen<br />

f) Regressionsfehlschluß<br />

Annahme, daß der Regressionseffekt eine „wirkliche“ Ursache hat.<br />

g) Die zwei Regressionen<br />

Symmetrie: Es gibt auch die Regressionsgerade von x auf y. Diese sagt<br />

x−Werte aus gewissen y−Werten hervor.<br />

Situation:<br />

Regression SD− Gerade<br />

von x auf y<br />

Datenwolke<br />

Regression<br />

von y auf x<br />

Statt vertikale, jetzt horizontale Streifen. Dies sind<br />

unterschiedliche Teilbereiche.<br />

<strong>Statistik</strong> I − Seite 14

11. Der r. m. s.− Fehler bei Regression<br />

→ Residuen und der r. m. s.− Fehler<br />

a) Definitionen<br />

Residuum<br />

= beobachteter Wert − Vorhersage<br />

= vertikaler Abstand zwischen Punkt und Regressionsgerade<br />

mit Vorzeichen<br />

Beobachteter<br />

Wert<br />

+<br />

r. m. s.− Fehler der Regressionsgeraden<br />

= r. m. s. der Residuen<br />

1rms<br />

Regressionsgerade<br />

von y auf x<br />

68% − 95% − Regel<br />

Für viele (nicht alle) Streuungsdiagramme gilt:<br />

∼ 68% der Punkte liegen innerhalb ± 1 r. m. s.− Fehler<br />

um die Regressionsgerade<br />

∼ 95% der Punkte liegen innerhalb ± 2 r. m. s.− Fehler<br />

um die Regressionsgerade<br />

Regressionsgerade<br />

<strong>Statistik</strong> I − Seite 15

) Zusammenhang mit Mittelwert und SD<br />

Mittel<br />

+ +<br />

X1<br />

+ +<br />

Dies ist gerade der Fall „r = 0“ (= unkorreliert).<br />

Die Regressionsgerade kann sich den Datenpunkten besser anpassen als<br />

eine „nur horizontale“ Gerade<br />

bzw.: Korrelation „hilft“ bei der Vorhersage<br />

also: r. m. s. der Regressionsgeraden wird ≤ SDy sein<br />

c) Berechnung des r. m. s.− Fehlers<br />

r. m. s.− Fehler der Regressionsgeraden von y auf x = * SDy<br />

(Einheit also wie y)<br />

Spezialfälle: r = ± 1 , dann = 0<br />

r = 0, dann = 1<br />

d) PLOTS der Residuen<br />

Verfahren:<br />

X2<br />

X3<br />

X1<br />

X2<br />

X3<br />

Regressions<br />

gerade von<br />

auf x<br />

<strong>Statistik</strong> I − Seite 16

Eigenschaften:<br />

a) Mittelwert ist 0<br />

b) Regressionsgerade (der Residuen auf x) ist die x− Achse<br />

Ziel: Überprüfung des Modells<br />

− alles o. k., dies erwartet man<br />

− nichtlinearer, (quadratischer) Anteil<br />

− Zeiteffekt (Neukalibrierung)<br />

− unterschiedliche Präzision, siehe oben<br />

<strong>Statistik</strong> I − Seite 17

f) Vertikale Streifen<br />

Bsp.: Größe von Vätern und Söhnen (siehe S. 179)<br />

Histogramme für die Größe der Söhne, deren Väter 64 bzw. 72<br />

inches groß sind.<br />

% per inch<br />

67<br />

71<br />

⇒ verschoben, aber ähnliche Form und gleiche SD´s<br />

allgemein heißt dies: Homoskedastizität<br />

Das Gegenteil wäre: Heteroskedastizität<br />

Dann: unterschiedliche Präzision der Vorhersagen, d. h. der r. m. s.−<br />

Fehler stellt nur einen Durchschnitt dar.<br />

(Bemerkung: man müßte gewichten.)<br />

g) Normalapproximation für vertikale Streifen<br />

Voraussetzung: „zwetschgenförmiges“ Diagramm, ⇒ dann:<br />

homoskedastisch etc.<br />

Insbesondere entspricht jeder vertikale Streifen einer Normalverteilung,<br />

etwa so:<br />

Verfahren:<br />

Man braucht lediglich: neuen Mittelwert<br />

neue Standardabweichung<br />

<strong>Statistik</strong> I − Seite 18

Bsp.: x = LSATscore y = first−year score<br />

zwetschgenförmiges Diagramm mit Mittel der x = 32,<br />

Mittel der y = 68,<br />

SDx = 6,<br />

SDy = 10 und<br />

r = 0,6<br />

12. Die Regressionsgerade<br />

a) Steigung und Achsenabschnitt<br />

b) Nutzen<br />

Wieviel Prozent der Studenten mit LSAT ≈ 35 hatten first− year<br />

scors über 75 ?<br />

neues Mittel: 35 = 32 + 0,5 * 6 , also 0,5 SE<br />

daher: 68 + 0,6 * 0,5 * 10 = 71<br />

neue SD: * 10 = 8<br />

Also wie gewohnt: = 0,5 SE; ergibt ≈ 31%<br />

Wir wissen schon: Die Regressionsgerade<br />

− geht durch den Punkt (Mittel von x, Mittel von y)<br />

− hat die Steigung<br />

Regressionsgleichung:<br />

y = ax + b mit a =<br />

b = ( Mittel von y ) − a * ( Mittel von x )<br />

= Vorhersagewert für x = 0<br />

(Achsenabschnitt)<br />

− Vereinfachung bei häufiger Anwendung<br />

− manchmal aber nicht immer) direkte Interpolationsmöglichkeit für a<br />

und b (Vorsicht bei Beobachtungsstudien)<br />

c) technische Anmerkung<br />

(lineare) Regression von y auf x:<br />

⇒ Auflösen nach y<br />

(lineare) Regression von x auf y:<br />

⇒ Auflösen nach x<br />

<strong>Statistik</strong> I − Seite 19

d) Methode der kleinsten Quadrate<br />

Ziel: Anpassung einer Gerade an Punkte<br />

Schätzung der Parameter<br />

Idee:<br />

zur Vorhersage von y aus x:<br />

Minimiere die Summe der quad. vert. Abstände, d. h.<br />

minimiere den r. m. s.− Fehler<br />

denke nach frage Mathematiker<br />

Lösung: Regressionsgerade von y auf x !<br />

Bsp.: Hooke´sches Gesetz<br />

Sprechweise: Geschätzt nach der Methode der kleinsten Quadrate<br />

(„KQ − Schätzer“)<br />

e) Sinn und Unsinn von Regression<br />

Bsp.: Fläche und Umfang von Rechtecken<br />

20 „typische Rechtecke“<br />

Regressionsgleichung: Fläche = a * Umfang + b<br />

− ergibt scheinbar ziemlich brauchbaren Zusammenhang<br />

Konsequenz:<br />

− stets kritisch prüfen<br />

− Situation beachten<br />

− Regression ist ein wichtiges, verallgemeinerungsfähiges<br />

Hilfsmittel, aber kein Allheilmittel !<br />

<strong>Statistik</strong> I − Seite 20

Teil IV: Wahrscheinlichkeitstheorie<br />

13. Wahrscheinlichkeit<br />

a) Zur „Semantik“ des Begriffs „Wahrscheinlichkeit“<br />

Verwendung:<br />

− in der Alltagssprache in sehr vielen Situationen,<br />

z. B. Wahrscheinlichkeit für „Regen“<br />

− Bedeutung nicht immer klar<br />

z. B. „Überlebenschance 90% bei Operationen“<br />

Historisch:<br />

besonders in der Theorie der Glücksspiele, aber auch in der<br />

„Stochastik“ = Kunst des vernünftigen Vermuten<br />

gemeinsame Eigenschaften:<br />

− falls ein Zufallsphänomen über lange Zeit unter den gleichen<br />

Bedingungen wiederholt wird, gibt die Wahrscheinlichkeit<br />

eines Ereignisses die relative Häufigkeit dieses Ergebnisses in<br />

der Zeit an<br />

− Wahrscheinlichkeiten werden in Prozent zwischen 0% und<br />

100% ausgedrückt (bzw. zwischen 0 und 1)<br />

− Summe der Wahrscheinlichkeiten für ein Ereignis und das<br />

Komplementärereignis (d. h. das Ereignis tritt nicht ein) ist<br />

100%<br />

Betrachtung auf lange Sicht:<br />

Bsp. 1: Urne 1 mit 3 roten und 2 blauen Kugeln sowie Urne 2 mit 30<br />

roten und 20 blauen Kugeln.<br />

Eine Kugel wird zufällig gezogen. Bei ROT Gewinn 1 DM.<br />

Welche Urne ist günstiger ?<br />

→ kein Unterschied, da es nur auf das Verhältnis ankommt.<br />

Dies ist jeweils (dies gilt nur, wenn das Verhältnis sich nicht<br />

ändert).<br />

Bsp. 2: Schachtel mit Zetteln 1 , 2 , 3. Wir ziehen zwei Zettel. Der<br />

erste ist 3. Dann zwei Varianten:<br />

a) Ziehen mit Zurücklegen<br />

b) Ziehen ohne Zurücklegen<br />

b) Bedingte Wahrscheinlichkeiten<br />

Bsp.: Zwei Karten ohne Zurücklegen zufällig ziehen (Kartenspiel mit<br />

52 Karten). Falls die zweite Karte Herz− Dame ist, Gewinn.<br />

a) Gewinnchance ?<br />

Jede der 52 Karten kann mit der gleichen Wahrscheinlichkeit<br />

die zweite sein ⇒ Gewinnchance<br />

<strong>Statistik</strong> I − Seite 21

) die erste Karte ist Herz− Dame<br />

⇒ Gewinnchance (bei zweiter Ziehung) = 0<br />

c) die erste Karte ist Kreuz− Sieben<br />

⇒ Gewinnchance =<br />

In b) und c) bedingte Wahrscheinlichkeit, da sie von Ausgang<br />

der ersten Ziehung abhängt.<br />

Sprechweise:<br />

− Wahrscheinlichkeit eines Ereignisses unter der Bedingung,<br />

daß ein anderes Ereignis eingetreten ist<br />

− Wahrscheinlichkeit für Ereignis A gegeben Ereignis B<br />

Schreibweise:<br />

P (A | B) heißt „bedingte Wahrscheinlichkeit von A bei<br />

gegebenen B“.<br />

Bsp.: einmaliges Ziehen aus 1, 2 (grün) und 3, 4 (rot)<br />

⇒ P (1 | rot) = 0, P (1 | grün) = und P (1) =<br />

c) Multiplikationsregel<br />

Bsp.: Wie oben (2 Karten aus 52)<br />

Wahrscheinlichkeit dafür, daß erste Karte Kreuz−Sieben und die<br />

zweite Karte Herz−Dame ist ?<br />

⇒ in der Fälle: erste Karte ist Kreuz−Sieben; in der Fälle:<br />

zweite Karte ist Herz− Dame.<br />

⇒ insgesamt: * =<br />

Multiplikationsregel:<br />

d) Unabhängigkeit<br />

Wk ( zwei Ereignisse treten gemeinsam ein )<br />

= Wk ( erstes Ereignis ) * bedingte Wk ( das zweite Ereignis<br />

tritt ein, gegeben das erste Ereignis )<br />

Definition:<br />

Zwei Ereignisse heißen unabhängig, falls Wahrscheinlichkeit für das<br />

Zweite nicht davon beeinflußt wird, ob das erste Ereignis eingetreten<br />

ist oder nicht.<br />

Oder präziser:<br />

Falls die bedingte Wahrscheinlichkeit (zweites Ereignis, gegeben erstes<br />

Ereignis) nicht vom Ausgang des ersten Ereignisses abhängt.<br />

<strong>Statistik</strong> I − Seite 22

Beispiele:<br />

a) Zweimaliger Wurf einer Münze: unabhängig<br />

b) Einmaliges Ziehen aus 1, 2 (grün) und 1, 2 (rot)<br />

Wk (rot) = + Wk (rot | 1) = Wk (rot | 2)<br />

Wk (grün) = + Wk (grün | 1) = Wk (grün | 2)<br />

Farbe und Wert sind unabhängig.<br />

c) Einmaliges Zeihen aus 1, 1 (grün) und 2, 2 (rot)<br />

Wert verrät die Farbe (wird umgekehrt); nicht unabhängig,<br />

also abhängig.<br />

e) Unabhängiges Ziehen mit bzw. ohne Zurücklegen<br />

→ Ziehen mit Zurücklegen in der Regel unabhängig<br />

Ziehen ohne Zurücklegen in der Regel abhängig<br />

(Beispiele siehe oben)<br />

f) Multiplikationsregel bei Unabhängigkeit<br />

Wk (zwei Ereignisse treten gemeinsam ein) =<br />

Wk (erstes Ereignis tritt ein) * Wk (zweites Ereignis tritt ein)<br />

Bsp.: in Teil b)<br />

Wk (1rot) = Wk (1) * Wk (rot) =<br />

⇒ erhebliche Vereinfachung−beim Ziehen mit Zurücklegen anwendbar<br />

g) Anwendbarkeit von Wahrscheinlichkeitstheorien; Überlegungen<br />

häufig identische Wiederholungen → i. d. R. unproblematisch<br />

Beispiele: Qualitätskontrolle, Medizin, Glücksspiele<br />

aber: Einzelfälle sehr problematisch<br />

14. Mehr über Wahrscheinlichkeit<br />

a) Vollständige Listen<br />

Für viele Zufallsvorgänge kann man sämtliche Resultate aufschreiben<br />

und als gleichwahrscheinlich ansehen (sog. LAPLACE − Experiment).<br />

<strong>Statistik</strong> I − Seite 23

Dann gilt für ein Ereignis:<br />

Wk(Ereignis) = relative Häufigkeit des Ereignisses<br />

=<br />

Bemerkung: etwas zirkulär<br />

Beispiele:<br />

b) Additionsregel<br />

a) einmaliges Würfeln<br />

Wahrscheinlichkeit für eine gerade Zahl ?<br />

günstige Fälle: 2, 4, 6<br />

mögliche Fälle: 1, 2, 3, 4, 5, 6<br />

also: Wk (gerade Zahl) =<br />

b) zweimal Würfeln<br />

Wk (Augensumme 4) =<br />

c) dreimal Würfeln<br />

Wk (Augensumme 9) =<br />

Wk (Augensumme 10) =<br />

genauer: mögliche Fälle: 216 (=6*6*6)<br />

günstige Fälle für 9: 25<br />

günstige Fälle für 10: 27<br />

(⇒ Betrachtung der günstigen Trippel)<br />

Definition:<br />

Zwei Ereignisse schließen sich gegenseitig aus, wenn sie nicht<br />

gleichzeitig eintreten können.<br />

Additionsregel:<br />

Falls sich die Ereignisse E1 und E2 gegenseitig ausschließen, so gibt<br />

Wk (wenigstens E1 oder E2) = Wk (E1) + Wk (E2)<br />

Beispiele:<br />

a) einmaliges Würfeln<br />

Wk (1 oder 2) = Wk (1) + Wk (2) =<br />

b) zweimaliges Würfeln<br />

Wk (wenigstens einmal die 6) =<br />

(beim 1. Wurf die 6 und beim 2. Wurf die 6 schließen sich<br />

nicht aus ⇒ Formel nicht anwendbar)<br />

direkte Lösung:<br />

<strong>Statistik</strong> I − Seite 24

c) Zur Berechnung von komplexen Wahrscheinlichkeiten<br />

Problem:<br />

n−maliges Würfeln<br />

Gesucht: Wk (wenigstens einmal die 6) = ?<br />

(Additionsregel nicht anwendbar (Prüfe n > 6)<br />

Lösung:<br />

Wk (wenigstens einmal die 6) = 1 − Wk (keinmal die 6) =<br />

= 1 − Wk (nicht im 1. Wurf) − ... − Wk (nicht im n− ten Wurf)<br />

=<br />

= 1 − () n<br />

bei n = 1:<br />

bei n = 2:<br />

d) Historische Beispiele<br />

vgl. Paradox des Chevalier de Méré<br />

Ist Gleichwahrscheinlichkeit realistisch ??<br />

e) Baumdiagramme<br />

Ziel: Veranschaulichung mehrstufiger Zufallsexperimente<br />

Bsp.: Zweimaliger Münzwurf<br />

*<br />

Allgemeiner:<br />

1/2<br />

1/2<br />

P (A1)<br />

P (A2)<br />

K<br />

Z<br />

1/2<br />

1/2<br />

1/2<br />

1/2<br />

P (B1 | A1)<br />

P (B2 | A1)<br />

K<br />

Z<br />

K<br />

Z<br />

Wk (KK) = 1/4<br />

Wk (KZ) = 1/4<br />

Wk (ZK) = 1/4<br />

Wk (ZZ) = 1/4<br />

Wk (wenigstens 1x K) = Wk (KK) + Wk (KZ) + Wk (ZK) =<br />

⇒ Multiplikationsregel und Additionsregel übertragen sich auf<br />

den Pfad<br />

*<br />

A1<br />

A2<br />

B1<br />

B2<br />

also: P (B1 | A1) =<br />

Manchmal ist es bequem, mit absoluten Zahlen zu rechnen:<br />

Bsp.: Geburtenkontrolle<br />

<strong>Statistik</strong> I − Seite 25

einfacher: Münzwurf, bei K Stopp, bei Z noch einmal und dann Stopp<br />

*<br />

1000<br />

Baumdiagramm: 0,99 pos<br />

0,0001<br />

0,9999<br />

1/2<br />

1/2<br />

K<br />

500<br />

Z<br />

500<br />

1/2<br />

1/2<br />

0,01<br />

0,02<br />

0,98<br />

K also: 750 K, 750 Z<br />

250<br />

Z<br />

250<br />

⇒ an Wahrscheinlichkeit (Jungen | Mädchen) ändert sich nichts,<br />

ich blende nur einen Teil aus<br />

f) Berechnung inverser Wahrscheinlichkeiten (Bayes − Theorem)<br />

Bsp.: Virusinfektion<br />

Bevölkerung: 100 Mio.<br />

Infiziert: 10.000<br />

Test: pos. neg.<br />

infiziert 99% 1%<br />

nicht inf. 2% 98%<br />

Ein zufällig ausgewählter Patient hat positives Resultat<br />

Bedeutung ? Wahrscheinlichkeit (infiziert | pos. Resultat)<br />

inf<br />

nicht inf<br />

neg<br />

pos<br />

neg<br />

Wk (infiziert | positiv) = ≈ 0,0049 ≈ 0,5%<br />

Wegen der Größe der nicht infizierten Gruppe kommen auch die<br />

meisten positiven Resultate aus dieser Gruppe.<br />

<strong>Statistik</strong> I − Seite 26

15. Binominalkoeffizienten<br />

a) mathematische Grundlagen<br />

n! = n * (n − 1) * ... * 1 Definiere: 0! = 1<br />

n! Möglichkeiten n verschiedene Objekte zuordnen:<br />

n Objekte , k und n −k seien gleich<br />

Wie viele Anordnungsmöglichkeiten gibt es ?<br />

( ):= Gesprochen: „ n über k“<br />

Der Binominalkoeffizient ( ):= gibt an, wie viele Möglichkeiten es<br />

gibt, n Objekte, von denen jeweils k bzw. (n − k) gleich sind, in einer<br />

Reihe anzuordnen. (Beachte Konvention: 0! = 1.)<br />

b) Binominalformel<br />

Situation:<br />

− ein Versuch wird n− mal identisch wiederholt<br />

− ein bestehendes Ereignis tritt jeweils mit Wahrscheinlichkeit p<br />

ein<br />

− die Versuche sind unabhängig<br />

Aussage:<br />

Dann ist die Wahrscheinlichkeit, daß das Ereignis genau k−mal<br />

eintritt, durch die<br />

Herleitung:<br />

Binominalformel<br />

* p k * (1 − p) n−k gegeben.<br />

Eintreten:= 1; Nicht Eintreten:= 0<br />

Dann: k− mal 1 und (n − k)− mal 0 anordnen. Die Wahrscheinlichkeit<br />

für (1, ... , 1, 0, ... , 0) ist p k * (1 − p) n−k und es gibt ()<br />

Anordnungen ⇒ () * p k * (1 − p) n−k<br />

Beispiele:<br />

a) zehnmaliger Münzwurf<br />

Wk (3x K) = () * () 3 * () 7 = * () 10 =<br />

b) zehnmaliges Würfeln<br />

Wahrscheinlichkeit (2x 6) = () * () 2 * () 8<br />

c) zweimal Ziehen ohne Zurücklegen aus Schachtel mit vier<br />

Zetteln<br />

Wk (1x 3) = ?<br />

⇒ nicht unabhängig, daher nicht anwendbar !!!<br />

<strong>Statistik</strong> I − Seite 27

d) viermaliges Münzwerfen<br />

Wk (mind. 1x K) = 1 − () * () 0 * () 4<br />

= 1 − () 4 =<br />

Teil V: Variabilität zufälliger Prozesse<br />

16. Das Gesetz der großen Zahlen<br />

Bsp.: Kerichs Münzwurf−Experiment<br />

Resultat:<br />

Anzahl der Würfe Anz. d. Köpfe Anz. Köpfe − * Anz.<br />

Würfe<br />

10 4 − 1<br />

100 44 − 6<br />

200 98 − 2<br />

... ... ...<br />

5000 2533 33<br />

... ... ...<br />

10000 5067 67<br />

Dies beweist nichts, illustriert aber folgendes:<br />

− die Anzahl von K schwankt um * Anzahl der Würfe; es gilt:<br />

Anzahl von K = * Anzahl der Würfe + Zufallsfehler<br />

− die Größe des Zufallsfehlers nimmt mit steigender Zahl der Würfe zu<br />

− bezogen auf die Anzahl der Würfe (d. h. ausgedrückt in % der<br />

Wurfanzahl) nimmt die Größe des Zufallsfehlers jedoch ab.<br />

− quantitativ ist der Zufallsfehler bei 100 ungefähr 5; bei 10.000<br />

ungefähr 50. Hundertmal mehr Würfe führen also zu einem um den<br />

Faktor = 10 vergrößerten Zufallsfehler.<br />

− Andersherum:<br />

Will man den relativen Fehler halbieren, muß man die Wurfanzahl<br />

vervierfachen !!!<br />

Ferner illustrieren Kerich´s Resultate:<br />

Es gibt keine „Kompensation“ durch das Gesetz der großen Zahlen. Auf<br />

eine lange Folge von Kopf muß keineswegs Zahl folgen.<br />

<strong>Statistik</strong> I − Seite 28

Zufallsprozesse und Schachtelmodelle<br />

− zufällige Prozesse treten in vielen Formen auf:<br />

Münzwurf, Würfeln, Geburt, „Stichprobe“, ...<br />

− einheitliche Beschreibung möglich durch:<br />

Schachtelmodelle und Ziehungen daraus<br />

...<br />

Man sieht:<br />

− „zufällig“ (d. h. jeder Zettel mit gleicher Wahrscheinlichkeit)<br />

− mit Zurücklegen<br />

⇒ relevante Größe ist die Summe der Ziehungen; deren<br />

Zufallsschwankung kann dann analysiert werden.<br />

Dazu nötige Angaben:<br />

− welche Zahlen treten in der Schachtel auf ?<br />

− wie oft kommen sie vor ?<br />

− wie oft wird gezogen ?<br />

b) Aufstellung eines Schachtelmodells<br />

Bsp.: Nevada−Roulette<br />

(38 Felder, davon 18 rot, 18 schwarz, 2 grün)<br />

1) 10 mal setzen von $1 auf rot<br />

Gewinnquote 1: 1<br />

⇒ also lauten die Zahlen auf dem Zettel: + 1 Gewinn<br />

⇒ insgesamt also: 18 x +1 und 20 x −1<br />

Es wird zehnmal gezogen.<br />

− 1 Verlust<br />

→ Nettogewinn = Summe der Ziehungen (in $)<br />

2) Fünfmaliges Setzen auf eine einzelne Zahl in neuem<br />

Schachtelmodell:<br />

1 x +35 und 37 x −1<br />

Es wird fünfmal gezogen.<br />

→ Nettogewinn = Summe der Ziehungen (in $)<br />

<strong>Statistik</strong> I − Seite 29

17. Erwartungswert und Standardfehler<br />

a) Erwartungswert<br />

Hintergrund: für Daten: für Zufallsprozeß:<br />

Bsp.: 100 Ziehungen aus 1 1 1 5<br />

→ 25 * 5 + 75 * 1 = 200<br />

Formel:<br />

b) Standardfehler<br />

Mittelwert Erwartungswert<br />

Standardabweichung Standardfehler<br />

Erwartungswert für eine Summe der Ziehungen mit<br />

Zurücklegen aus einer Schachtel = (Anzahl der Ziehungen) *<br />

(Mittelwert der Schachtel)<br />

[Mittelwert der Schachtel = arithm. Mittel der Werte in der<br />

Schachtel]<br />

Bsp.: 25x Ziehen mit Zurücklegen aus 0 2 3 4 6<br />

Erwartungswert der Summe: 25 * (0 + 2 + 3 + 4 + 6) = 75<br />

Schwankung ???<br />

Summe = Erwartungswert + Zufallsfehler<br />

Größenordnung des Zufallsfehlers ? → Standardfehler („SE“)<br />

Formel:<br />

Beim Ziehen mit Zurücklegen aus einem Schachtelmodell ist<br />

der Standardfehler für die Summe der Ziehungen gleich:<br />

* (SD der Schachtel)<br />

[SD der Schachtel = Standardabweichung der Werte in der<br />

Schachtel] → „Quadratwurzelregel“<br />

Hinweis: SE nimmt zu mit<br />

− der Anzahl der Ziehungen<br />

− der SD der Schachtel<br />

Bemerkung: Oft wird nicht zwischen SD und SE unterschieden<br />

Bsp.: siehe oben<br />

<strong>Statistik</strong> I − Seite 30

Mittelwert der Schachtel = 3<br />

SD der Schachtel =<br />

=<br />

SE für die Summe von 25 Ziehungen: * 2 = 10<br />

also: Summe = 75 + Zufallsfehler (SE = 10)<br />

Illustration: siehe Tabelle auf S. 267<br />

Hintergrund: SE wächst nur langsam mit der Anzahl der<br />

Ziehungen, weil Fehlerauslöschung<br />

(Kompensation) wirksam wird.<br />

c) Benutzung der Normalverteilung<br />

Bsp.: 25 Ziehungen aus 0 2 3 4 6<br />

Wie viele Werte (der Summe) liegen zwischen 50 und 100 ?<br />

Idee: Normalverteilung benutzen<br />

Voraussetzung: Anzahl der Ziehungen ist nicht „zu klein“<br />

Verfahren: Umrechnen auf SD−Einheiten<br />

Bsp.: Gewinnerwartung eines Casinos<br />

Benutzung der Normalverteilung ⇒ Fläche 99 %<br />

bei 10.000 Spielen, jeweils 1 DM auf rot<br />

Wk (Gewinn des Kasinos ≥ 250 DM) = ???<br />

Schachtel: 20 x +1 und 18 x −1; 10.000 Ziehungen<br />

Mittelwert der Schachtel ≈ 0,05 DM<br />

SD der Schachtel ≈ 1,00 DM<br />

also: Erwartungswert d. Summe ≈ 10.000 * 0,05 DM = 500 DM<br />

SE der Summe ≈ * 1,00 DM = 100 DM<br />

<strong>Statistik</strong> I − Seite 31

eine Vereinfachung:<br />

Situation: Schachtel mit genau zwei verschiedenen Arten von<br />

Zetteln<br />

SD der Schachtel =<br />

Bsp.: 1 1 1 5 ≈ 1,73<br />

Herleitung: Es reicht, Schachteln mit k Einsen und (n − k)<br />

Nullen zu betrachten (wegen<br />

Multiplikation und Addition mit<br />

Konstanten)<br />

Dann gilt:<br />

Mittel =<br />

SD = =<br />

= =<br />

d) Klassifikations− und Abzählprobleme<br />

Beispiel: 60x Würfeln<br />

a) Summe = ??? (Erwartungswert ± SE)<br />

Schachtel: 1 2 3 4 5 6, 60 Ziehungen<br />

Mittel der Schachtel: 3,5<br />

SD der Schachtel: 1,71<br />

Erwartungswert der Summe: 60 * 3,5 = 210<br />

SE der Summe: * 1,71 ≈ 13<br />

b) Anzahl der 6 = ??? (Erwartungswert ± SE)<br />

Dies kann wieder als „Summe“ von Ziehungen geschrieben werden,<br />

indem man die Schachtel modifiziert und die günstigen Ereignisse<br />

zählt.<br />

1 2 3 4 5 6<br />

↓ ↓ ↓ ↓ ↓ ↓<br />

0 0 0 0 0 1<br />

Betrachte 60 Ziehungen; Anzahl der 6 entspricht der Summe der<br />

grünen Zettel.<br />

Mittelwert der grünen Schachtel =<br />

SD der grünen Schachtel = ≈ 0,37<br />

<strong>Statistik</strong> I − Seite 32

also bei 60 Ziehungen:<br />

Anzahl der 6 = Summe der grünen Zettel<br />

Erwartungswert: 60 * = 10<br />

SE: * 0,37 ≈ 3<br />

e) Beziehung zum Gesetz der großen Zahl<br />

Quadratwurzelregel − Gesetz der großen Zahlen<br />

Bsp.: Anzahl der "K" bei n−Münzwürfen<br />

Schachtel: 0 1<br />

Mittelwert = , SE =<br />

Anzahl der Würfe Erwartungswert in % der Anzahl<br />

± SE der Würfe<br />

100 50 ± 5 50 % ± 5 %<br />

10000 5000 ± 50 50 % ± 0,5 %<br />

1000000 500000 ± 500 50 % ± 0,05 %<br />

18. Normalapproximation von Wahrscheinlichkeitshistogrammen<br />

a) Wahrscheinlichkeitshistogramme<br />

Bsp.: n−maliger Münzwurf, bzw. (Summe aus einmaligen) Ziehen aus<br />

0, 1; n−mal wiederholt<br />

Fazit: Das Wahrscheinlichkeitshistogramm repräsentiert<br />

Wahrscheinlichkeiten durch Flächen. Bei Betrachtung auf lange<br />

Sicht nähert sich das Daten−Histogramm immer mehr dem<br />

Wahrscheinlichkeits−Histogramm an.<br />

(vgl. auch Buch S. 287)<br />

b) Normalapproximation für Wahrscheinlichkeits−Histogramme<br />

Situation: Summe aus k−maligem Ziehen aus 0 1, n−mal wiederholt<br />

für n → ∞: Wahrscheinlichkeits−Histogramm<br />

für k → ∞: ???<br />

Fazit: Beim Ziehen aus einem Schachtelmodell nähert sich das<br />

Wahrscheinlichkeits−Histogramm für die Summe aus k<br />

Ziehungen mit wachsendem k stets der Normalverteilung an.<br />

Der Inhalt der Schachtel spielt keine entscheidende Rolle.<br />

<strong>Statistik</strong> I − Seite 33

Bsp.: 100−maliger Münzwurf<br />

1) Wk (45 (K ( 55) = ???<br />

2) Wk (45 < K < 55) = ???<br />

3) Wk (K = 50) = ???<br />

Summe aus 100−maligem Ziehen aus 0 1, angenähert<br />

normalverteilt mit Erwartungswert = 50 und<br />

SE = 5<br />

dann umrechnen auf Standardeinheiten<br />

zu 1): 45 ⇒ 44,5 entspricht − 1,1 Standardeinheiten<br />

55 ⇒ 55,5 entspricht + 1,1 Standardeinheiten<br />

⇒ Fläche ≈ 72,87 %<br />

zu 2): 45 ⇒ 45,5 entspricht − 0,9 Standardeinheiten<br />

55 ⇒ 54,5 entspricht + 0,9 Standardeinheiten<br />

⇒ Fläche ≈ 63,19 %<br />

zu 3): 50 ⇒ 49,5 entspricht − 0,1 Standardeinheiten<br />

50 ⇒ 50,5 entspricht + 0,1 Standardeinheiten<br />

Zusatzbemerkung:<br />

⇒ Fläche ≈ 7,97 %<br />

− k muß hinreichend groß sein (hängt vom Inhalt der Schachtel<br />

ab)<br />

− gilt nur für Summen, nicht für Produkte<br />

− entscheidende Größen<br />

a) Mittelwert der Schachtel<br />

b) SD der Schachtel ((0)<br />

c) Anzahl der Ziehungen<br />

→ Dies bestimmt Erwartungswert und SE.<br />

<strong>Statistik</strong> I − Seite 34

Teil VI : Stichprobenverfahren<br />

19. Stichprobenuntersuchung<br />

a) Grundbegriffe<br />

b) Probleme<br />

− Grundgesamtheit (Population)<br />

= Menge von Personen, Gegenständen oder Meßwerten, über<br />

die man etwas erfahren möchte (z. B. Wähler in Bayern)<br />

− Parameter<br />

= numerischer Kennwert einer Grundgesamtheit (z. B. Anteil<br />

der Wähler der Partei K); i. a. können Parameter nicht exakt<br />

bestimmt werden, sondern müssen geschätzt werden.<br />

− Stichprobe<br />

= Teil der Grundgesamtheit<br />

− Statistische Größe<br />

= Kennwert einer Stichprobe, kann (nach Ziehen) berechnet<br />

werden und zur Schätzung eines Parameters dienen.<br />

Grundgesamtheit Ziehen<br />

Stichprobe<br />

(Parameter) (stat. Größe)<br />

− Wie zählt man eine Stichprobe ?<br />

− Wie zieht man Rückschlüsse von der Stichprobe auf die<br />

Grundgesamtheit ?<br />

c) Umfrage des „Literary Digest“<br />

1936 : Roosevelt ↔ London<br />

Prognose : 43% zu 57%<br />

Resultat : 62% zu 38%<br />

Genauer :<br />

Rückschluß<br />

Prozentsatz Roosevelt<br />

Prognose Digest 43<br />

Prognose Gallup für die D. P. 44<br />

Prognose Gallup 56<br />

Wahlergebnis 62<br />

<strong>Statistik</strong> I − Seite 35

− Methode Digest<br />

10 Millionen Fragebögen per Post verschickt an Adressen aus<br />

Telefonbüchern, Automobilclubs mit dem Rücklauf von 2,4<br />

Millionen<br />

− Gallup : Zufallsstichprobe<br />

− 50.000 Wähler für die Prognose befragt<br />

− 3.000 Wähler für die Prognose der D. P. befragt<br />

− Problem bei Digest − Umfrage<br />

− Verzerrung durch ungeeignete Auswahl (selection bias)<br />

− Verzerrung durch Nichtbeantwortung (non − response bias)<br />

− Probleme bei Gallup<br />

Man sieht :<br />

− keine für die Prognose der D. P.<br />

− Nichtbeantwortung für die eigene Prognose<br />

(und natürlich das Auswahlproblem)<br />

große Stichproben sind nicht notwendigerweise „gut“ !!!<br />

und man sollte stets fragen :<br />

− Was ist die Grundgesamtheit, was die Parameter ?<br />

− Wie wurde Stichprobe ausgewählt ?<br />

− Wie hoch war die Antwortrate ?<br />

und auch noch :<br />

− Wann wurde gefragt ?<br />

− Was / Wie wurde gefragt ?<br />

− Wer war der Auftraggeber ?<br />

d) Beispiel : Präsidentschaftswahlen 1948 in den USA<br />

Resultate : Tabelle 2 auf Seite 309<br />

Erklärung : Es wurden Quotenstichproben verwendet, d. h. innerhalb<br />

bestimmter Vorgaben (z. B. Geschlechterverhältnis)<br />

suchen die Interviewer die Befragten „nach Gutdünken“<br />

aus.<br />

Aber : Dies kann einen systematischen Fehler verursachen. (In<br />

diesem Fall in Richtung der „Republikaner“); vgl.<br />

Tabelle 3 auf Seite 311<br />

⇒ nicht empfehlenswert !!!<br />

<strong>Statistik</strong> I − Seite 36

e) Wahrscheinlichkeitsmethoden<br />

Kennzeichen: Für jedes Individuum kann die Wahrscheinlichkeit<br />

berechnet werden, daß es für die Stichprobe ausgewählt<br />

wird.<br />

einfache Zufallsauswahl (simple random sampling):<br />

zufälliges Auswählen (mit gleichen<br />

Wahrscheinlichkeiten) „ohne Zurücklegen“ einfach, aber<br />

oft nicht praktikabel, da die Grundgesamtheit nicht<br />

erfaßt werden kann.<br />

mehrstufiges Verfahren (multistage cluster sampling):<br />

man wählt zunächst zufällig eine Stadt, Bezirk, usw.;<br />

siehe Bsp. Gallup, Seite 313).<br />

Klumpenverfahren:<br />

man wählt zunächst einen Bezirk, dann ein Haus, aber<br />

dann alle Bewohner des Hauses.<br />

geschichtete Stichproben:<br />

Grundgesamtheit wird zunächst in Schichten unterteilt,<br />

aus denen dann separat Stichproben gezogen werden.<br />

Bemerkung:<br />

− viele Variationen<br />

− Auswahlkriterien : Kosten und Zielsetzung der Untersuchung<br />

f) Güte der Wahrscheinlichkeitsmethoden<br />

Beispiel : Gallup Prognosen, Tabelle 4 auf S. 314<br />

Fazit : erstaunlich gut<br />

aber : auch gegenläufige Entwicklungen (mehr Antwortausfall,<br />

weniger Stabilität)<br />

− Gallup−Fragebogen<br />

→ S. 317 / 319<br />

− Telefonumfragen<br />

Vorteil : geringe Kosten<br />

Achtung : Telefonnummernvergabe beachten (Schema ?)<br />

→ sehr verbreitet<br />

Ausblick : auch hier gilt :<br />

Schätzung = Parameter + Bias + Zufallsfehler<br />

zum Bias (systematischer Fehler) vgl. oben und<br />

zum Zufallsfehler vgl. unten (Kapitel 20)<br />

<strong>Statistik</strong> I − Seite 37

20. Zufallsfehler bei Stichprobenverfahren<br />

Beispiel : Aus Daten von 6.672 Amerikanern [3.091 (= 46%) Männer und<br />

3.581 (= 54%) Frauen] sollen 100 ausgewählt werden.<br />

→ einfaches Zufallsmodell<br />

a) Wie sieht es dann mit der Anzahl der Männer unter diesen 100 aus ?<br />

bias : nicht zu erwarten<br />

Zufallsfehler ?<br />

SE ?<br />

Schachtelmodell :<br />

3.091 x 1 und 3.581 x 0, daraus 100 Ziehungen ohne<br />

Zurücklegen<br />

Wir betrachten aber zunächst den Fall :<br />

100 Ziehungen mit Zurücklegen<br />

⇒ MW = 0,46<br />

SD = ≈ 0,50<br />

EW = 100 * 0,46 = 46<br />

SE = * 0,5 = 5<br />

⇒ Man erwartet :<br />

46 ± 5 Männer oder als Prozentsatz 46% ± 5%<br />

Um den SE für einen Prozentsatz (in Prozentpunkten) zu<br />

bestimmen, rechnet man zunächst mit den absoluten Zahlen und<br />

dann auf % um !<br />

⇒ Was passiert bei 400 Ziehungen ?<br />

EW = 400 * 0,46 = 184<br />

SE = * 0,5 = 10<br />

⇒ Man erwartet 184 ± 10 Männer oder als Prozentsatz<br />

ausgedrückt : 46% ± 2,5%<br />

also : Multiplikation der Stichprobengröße mit 4 führt zur<br />

Division des SE durch = 2<br />

Hintergrund : Gesetz der großen Zahlen, Quadratwurzelregel<br />

Mit welcher Wahrscheinlichkeit ist der Anteil der Männer in der<br />

Stichprobe zwischen 41% und 51%<br />

⇒ NV− Tabelle ⇒ Fläche ≈ 95%<br />

<strong>Statistik</strong> I − Seite 38

) Korrekturfaktor<br />

− bisher mit Zurücklegen, aber eigentlich ohne Zurücklegen<br />

− Bsp.:1,25 Mill. Wähler in RP<br />

12,5 Mill. Wähler in NRW<br />

⇒ Annahme : Anteil der Partei X = 50%<br />

Stichprobe 2.500 Wähler für RP (1 von 500)<br />

→ Wie groß muß die Stichprobe für NRW sein, wenn die<br />

Genauigkeit gleich gut sein soll ?<br />

Antwort : 2.500 (1 von 5.000 !), denn :<br />

RP 625.000 x 1 und 625.000 x 0<br />

NRW 625.0000 x 1 und 625.0000 x 0<br />

Falls wir mit Zurücklegen ziehen, können wir auch 1 x 0 und 1 x 1<br />

betrachten, es ergibt sich jeweils das Gleiche.<br />

Beim Ziehen ohne Zurücklegen gibt es einen kleinen Unterschied, es<br />

gilt nämlich :<br />

Dabei ist der Korrekturfaktor :<br />

SEohne = Korrekturfaktor * SEmit<br />

Dieser Korrekturfaktor ist meist nahe bei 1.<br />

Ausnahme: Stichprobe ist Großteil der Grundgesamtheit.<br />

Bemerkung:<br />

− andere Prozentsätze der Parteien ändern das Bild der<br />

Schachtel kaum (SD bleibt ≈ 0,5)<br />

− intuitiv eigentlich klar<br />

21. Zur Genauigkeit von hochgerechneten Prozentsätzen<br />

a) Hintergrund<br />

bisher: Zufallsfehler beim Ziehen einer Stichprobe<br />

nun : Fehler beim Rückschluß auf die Population<br />

Bsp.: Wahl eines Bürgermeisters<br />

Kandidat „K“ möchte „sichergehen“<br />

100.000 Wähler → Stichprobe 2.500<br />

? % Stimmen für K ← 1.328 für K (≅ 53%)<br />

⇒ Schätzung : 53% ± Zufallsfehler<br />

<strong>Statistik</strong> I − Seite 39

) Schachtelmodell<br />

? x 1 und ? x 0 (in der Bedeutung 1 = für K , 0 = gegen K) mit<br />

insgesamt 100.000 Zetteln, aus denen 2.500 Ziehungen vorgenommen<br />

werden.<br />

Zur Berechnung von SE brauchen wir aber SD der Schachtel.<br />

also :<br />

SD =<br />

Ausweg : wir schätzen SD aus der Stichprobe<br />

SD = ≈ 0,5<br />

SE = * 0,5 = 25<br />

25 entspricht 1% von 2.500, also ⇒ Schätzung : 53% ± 1%<br />

Idee war: Verhältnisse in der Stichprobe auf die Schachtel<br />

übertragen. Dies ist in Ordnung, wenn die Stichprobe<br />

nicht allzu klein ist.<br />

Was kann man tun, wenn die Stichprobe zu klein ist ? → Dann kann<br />

man SD nicht mehr schätzen, aber abschätzen, d. h. man nimmt<br />

den „schlechtesten Fall“ an.<br />

Anteil der „0“ ⇒ SD =<br />

Wie groß kann SD im schlechtesten werden ?<br />

SD<br />

Sei p = Anteil der „1“, also ist 1 − p =<br />

p(1−p)<br />

¼ max. für p = ½<br />

1/2 1<br />

Also : Abschätzung SD ó 0,5 ist möglich<br />

Bemerkung : Obige Schätzungen gelten für einfache<br />

Zufallsstichproben, nicht ohne weiteres für kompliziertere<br />

Stichprobenverfahren.<br />

p<br />

<strong>Statistik</strong> I − Seite 40

c) Konfidenzintervalle<br />

Situation:<br />

Prozentsatz in = Prozentsatz in ± Zufallsfehler<br />

der Stichprobe der Population<br />

53 % = 52 % + 1 %<br />

= 51 % + 2 %<br />

= 55 % − 2 %<br />

= 40 % + 13 %<br />

= 83 % − 30 %<br />

Alle diese Situationen sind möglich, aber da SE ≈ 1% sind nicht<br />

alle Möglichkeiten in gleicher Weise „zu erwarten“<br />

Idee: Wir fassen die „am ehesten zu erwartenden“ Möglichkeiten in<br />

einem Intervall zusammen.<br />

Definition:<br />

Prozentsatz in der ± 1 SE : 68 % − Konfidenzintervall<br />

± 2 SE : 95% − Konfidenzintervall<br />

± 3 SE : 99% − Konfidenzintervall<br />

usw. ( → in Anlehnung an die Normalverteilung)<br />

Manchmal sagt man auch :<br />

− „Konfidenzintervall zum Niveau x %“<br />

− „x % − Vertrauensintervall“<br />

Bemerkung:<br />

nur approximativ zu sehen, da<br />

− SE geschätzt und<br />

− Normalverteilung benutzt wird<br />

d) Interpretation<br />

− „mit WK 95% liegt der wahre Prozentsatz für Kandidat K im<br />

Intervall [51%; 55 %]“; naheliegend, aber nicht ganz richtig, denn<br />

der „wahre“ Prozentsatz liegt fest, er ist keine Zufallsgröße.<br />

− zufällig, d. h. von der Stichprobe abhängig, sind die<br />

Intervallgrenzen!<br />

<strong>Statistik</strong> I − Seite 41

⇒ also sollte man sagen :<br />

„mit WK 95% überdeckt (enthält) das Intervall [51%; 55 %] den<br />

wahren Prozentsatz“<br />

und meinen: „95% aller derart gebildeten Intervalle leisten dies“<br />

⇒ somit: Aussage über die Qualität der Methode, nicht über den<br />

Einzelfall!!!<br />

− Bsp.: Abb. 1 auf Seite 352<br />

− Randnotiz: Falls man Wahrscheinlichkeit nicht nur als relative<br />

Häufigkeit auffaßt, ist eine andere Interpretation möglich.<br />

− WARNUNG:<br />

Die obigen Methoden gelten für einfache Zufallsstichproben.<br />

Für andere Verfahren erhält man i. a. deutlich schlechtere<br />

Ergebnisse.<br />

Bsp.: Gallup−Poll Resultate, S. 356<br />

22. Arbeitsmarktstatistik für die USA<br />

Hinweis : Details von Interesse, zeigt im wesentlichen :<br />

− Komplexität realer Untersuchungen<br />

− auftretende Schwierigkeiten<br />

a) Stichprobenplan des „current population survey“<br />

1973 Primary sampling limits (PSU)<br />

gruppiert in<br />

715 Schichten<br />

715 PSU werden mit Wahrscheinlichkeitsverfahren gewählt<br />

(i. w. proportional zur Bevölkerungszahl).<br />

"einige" Ultimate SU (USU) werden mit<br />

Wahrscheinlichkeitsverfahren gewählt (i.w. so, daß die<br />

Chance für jede Einzelperson gleich ist − und daß alle 51<br />

Staaten mit etwa gleicher Genauigkeit abgedeckt<br />

werden).<br />

Durchführung : ∼ 67.000 housing units<br />

∼ 53.000 können befragt werden<br />

∼ 115.000 Personen<br />

<strong>Statistik</strong> I − Seite 42

) Abgrenzungsprobleme<br />

Wer ist „arbeitslos“, „arbeitssuchend“, „beschäftigt“ usw. ?<br />

⇒ Aufschlüsselungsproblem : Kriterien ?<br />

Gewichtung : Ziel : Reduzierung des Zufallsfehlers<br />

Methode : i. w. „nachträgliche Schichtung“<br />

Berechnung der Standardfehler :<br />

Es handelt sich um eine Klumpenstichprobe ...<br />

23. Genauigkeit arithmetischer Mittel<br />

bisher: Schachtel → Ziehungen Summe der Ziehungen<br />

EW und SE<br />

Normalapproximation<br />

0 1 − Schachtel → Ziehungen Prozentsatz der „1“<br />

EW und SE<br />

Normalapproximation<br />

Stichprobe aus<br />

0 1 − Schachtel<br />

(Ziehungen)<br />

jetzt: Stichprobe aus<br />

beliebiger<br />

Schachtel<br />

(Ziehungen)<br />

→ Rückschluß auf<br />

Grundgesamtheit<br />

(Schachtel)<br />

→ Rückschluß auf<br />

Grundgesamtheit<br />

Bsp.: Schachtel 1 2 3 4 5 6 7, daraus 25 Ziehungen<br />

Der (arithmetische) Mittelwert ist ... ± ... ?<br />

Prozentsatz der „1“ in der<br />

Grundgesamtheit,<br />

approximative<br />

Konfidenzintervalle dafür<br />

MW der Schachtel,<br />

approximative Konfidenz<br />

intervalle dafür<br />

MW = 4 also EW (für Summe aus 25 Zieh.) = 25 * 4 = 100<br />

SD = 2also SE (für die Summe aus 25 Zieh.) = * 2 = 10<br />

daher: Summe = 100 ± 10<br />

und somit: MW = * SE = 4 ± 0,4<br />

Erinnerung : Änderung von Mittelwert, SD und einer Liste, wenn jede Zahl<br />

mit derselben Konstanten multipliziert wird.<br />

<strong>Statistik</strong> I − Seite 43

Resultat : Beim Ziehen aus einem Schachtelmodell gilt :<br />

EW des Mittels der Ziehungen = MW der Schachtel<br />

SE des Mittels der Ziehungen =<br />

a) Normalapproximation<br />

entspricht derjenigen für die Summe! Der Faktor () spielt keine Rolle und fällt<br />

beim Umrechnen in Standardeinheiten heraus.<br />

b) Ziehen aus einer Schachtel<br />

1) oftmalige Wiederholung → Wk−Histogramm<br />

2) Summe einer großen Anzahl von Ziehungen<br />

Wk−Histogramm → Normalverteilung<br />

3) oftmalige Wiederholung einer Summe einer großen Anzahl von<br />

Ziehungen<br />

Daten−Histogramm → Normalverteilung<br />

Bsp.: 100 Ziehungen aus obiger Schachtel<br />

a) Summe ungefähr : 100 * 4 = 400 ± * 2 = 20<br />

Mittel ungefähr : 400 : 100 = 4 ± 20 : 100 = 0,2<br />

b) Wk (Mittel ≥ 4,2) =<br />

→ umrechnen in Standardeinheiten ⇒ 1 Standardeinheit<br />

⇒ Fläche ≈ 16 %<br />

Vergleich von 25 und 100 Ziehungen (=Effekt des Vervierfachens des<br />

Stichprobenumfangs):<br />

MW: bleibt unverändert<br />

SE: Division durch 2 (Grund : = )<br />

Ziehen ohne Zurücklegen:<br />

c) Stichprobenmittel<br />

Seohne = Korrekturfaktor * Semit<br />

Bsp.: Durchschnittseinkommen von Familien einer Stadt (25.000<br />

Familien); einfache Zufallsstichprobe von 900 Familien<br />

MW = 32.400 DM und SE = 18.000 DM<br />

Schätzung : 32.400 DM ± ... DM ?<br />

<strong>Statistik</strong> I − Seite 44

SE für die Summe = * SD der Schachtel<br />

SD der Schachtel kann wieder aus der Stichprobe geschätzt<br />

werden (sog. Bootstrap− Methode):<br />

SD der Schachtel ≈ 18.000 DM<br />

SE der Summe ≈ * 18.000 DM ≈ 540.000 DM<br />

SE des Mittels = = 600<br />

⇒ 95%− Konfidenzintervall: 32.400 DM ± 600 DM<br />

ACHTUNG !!! Dies bedeutet nicht, daß ca. 95% der Familien ein<br />

Einkommen von 31.200 DM bis 33.600 DM haben. Sondern für<br />

ca. 95% der Stichproben würde ein so gebildetes Intervall den<br />

wahren Wert für das Durchschnittseinkommen einschließen.<br />

Die Normalapproximation darf i.a. benutzt werden, auch wenn die<br />

Daten selbst nicht der Normalverteilung folgen.<br />

Bsp.: Stichprobe vom Umfang 400 für das Bildungsniveau (siehe S.<br />

383)<br />

d) Verschiedene Standardfehler<br />

Für Schachtelmodelle sind zu unterscheiden :<br />

SE der Summe = * SD der Schachtel<br />

SE des Mittels =<br />

SE der Anzahl der „1“ = SE der Summe „1“ für 0 1− Schachtel<br />

SE des Prozentsatzes = * 100%<br />

beim Rückschluß von der Stichprobe auf die Population muß SD<br />

geschätzt werden.<br />

WARNUNG : All das gilt nur für einfache Zufallsauswahl !!!<br />

<strong>Statistik</strong> I − Seite 45